第六章 近邻法

近邻法

(2)采用抽样的办法,使之能自适应选择k;

“科研反哺教学”,将自己的研究工作融入课堂;

6.3.2 核近邻法(续)

贝叶斯 决策器

学习 方法

4 3 2

分类 错误率 5.5% 4.6% 4.1%

KNN (k=3) BKNN 贝叶斯决策器

KNN

1 0 -1

三种方法的分类错误率比较

BKNN

-2 -3 -4 -4

本人解决方案:

NN (Fix, 1951)

KNN (Yu,2002) (Peng,2004) BNN (Homes,2002)

定义最优核距离 (本章) 核化 (本章)

BKNN (本章)

(1)推导出“最优核距离”:

1 rko x , xl rko x, xl N A1 1 NA B x, xi , xl B x, xi , xl N i 1 A i 1

J. Peng. Adaptive Quasiconformal Kernel Nearest Neighbor Classification. IEEE Trans PAMI[J]. 2004, 26(5): 656 - 661.

Rd

x1 , t1 1 x5 , t5 1 1

6.1.1 关于近邻法

1951年Fix和Hodges首次提出

第 w1 类

第 w2 类

最经典的模式识别方法之一 方法简单,便于理论分析

x

x1

x4

是其它模式识别方法的标尺

“距离”的度量方式有很多种

近邻法原理示意图

6.1.2 近邻法应用实例:人脸表情识别

欲解决的问题:

七 类 表 情

近邻分类法

对“data3.m”数据,采用剪辑法、压缩法生成参考集,近似描绘其决策面,并用所有数据测试其分类效果。

1.近邻法算法:

近邻法NN(nearest neighborhood)的基本思想是:以全部训练样本作为代表点,计算测试样本与这些代表点的距离,即所有样本的距离,并以最近邻者的类别作为决策。最初的近邻法是由Cover和Hart与1968年提出的。

步骤3:结束过程。若Grabbag中所有样本在执行步骤2时没有发生转入Store的现象,或Grabbag已称空集,则算法终止,否则转入步骤2.

2.近邻法参考核心程序:

3.近邻法分类实验结果:

两分剪辑近邻法:

步骤1将原始样本随机分为两个集合:预测集T和参考集R,分别含有 和 个样本,设两个集合所含样本数量之比为 。来自预测集T合参考集R的样本分别完成考试和参考任务,相互独立。

步骤2对预测及T中的任一个样本 ,利用参考集R采用近邻对其进行分类决策,判定 所属类别为 ,而样本 自身实际所属类别为 ,如 和 不相同,则将不相容样本 从预测集T中删除,预测及T样本数量 减1。对预测集中所有样本依次进行判定,直至删除所有的不相容样本的,得到经过剪辑的考试样本集TE。

步骤1:初始化。Store是空集,原样本集存入Grabbag;从Grabbag中任意选择一样本放入Store中作为新样本集得第一个样本。样本集生成,在Grabbag中取出第i各样本用Store中的当前样本集按最近邻法。

步骤2:分类。若分类错误,则将该样本从Grabbag转入Store中,若分类正确,则将该样本放回Grabbag中。

步骤3利用经过剪辑的考试样本集TE,采用最近邻法对测试样本X做出分类决策。

重复剪辑近邻法:当采用两分剪辑近邻法,预测集T和参考集R所含的样本是由总样本随机产生的,剪辑只针对预测集T中的样本,而参考集R中的样本则经过剪辑。为进一步提高近邻法的分类性能,在样本数量足够多的情况下,可以针对所有样本重复地执行剪辑程序。

第6章_近邻法

i

K近邻法

(1)已知N个已知 类别样本X

(2)输入未知类别 样本x

(3)计算x到 xiX,(i=1, 2,…,N)的 距离di(x)

(6) 判xω2 (4)找出x的k个最近邻 元Xk={xi,i=1,2,…,k} (5)看Xk中属于哪一类的样 本最多k1=3<k2=4

讨论k为奇数时的两类问题

xi X p

第二阶段用搜索算法

检验未知样本x的最近邻是否在X p中的两个规则。 规则1:如果存在 B rp D x, M p 则xi X p 不可能是x的最近邻。其中B是在算法执行过程 中,对于已涉及到的那些样本集X p中的样本到x 的最近 距离。初始B可置为, 以后的B在算法中求得。

c * P P P 2 P c 1 * 其中P 为贝叶斯错误率,c为类数。

* *

可以证明,当样本数相当多时,近邻法错误 率与贝叶斯错误率存在以下关系:

• 上式表明,当样本数相当多时,近邻法的错误 率在贝叶斯错误率和两倍的贝叶斯错误率之间。

最近邻法错误率上下界与贝叶斯错误率的关系

5在目录表中选择最近节点p, 它使D x, M p 最小化,并

称该p为当前执行节点,从目录表中去掉p。如果当前 的水平L是最终水平,则转步骤6。否则置L L 1,转 步骤2。

6对现在执行节点p中的每个x,利用规则2作如下检验。

如果

D x, M p D xi , M p B

规则2:如果存在

B xi , M p D x, M p

其中xi X p,则xi 不是x的最近邻。 D x, xi D x, M p D xi , M p B D xi , M p 在计算rp中已用到,并可存储在机器中。

第6章近邻法

(6)检验

对当前执行结点p '中的每个xi , 利用规则2作如下检验: 如果 D x, M p B D xi , M p 则xi不是x的最近邻,从而不计算D x, xi 。 否则 计算D x, xi , 若D x, xi B, 则置NN i和B D x, xi 。在当前执行结点中 所有的xi 被检验之后,转步骤(3)。

计算机学院信息科学研究所

模式识别

第6章 近邻法

6.3.2 剪辑近邻法 1.两分剪辑近邻法

NR NT , 样本分为独立的参考集和考试集:

(1)剪辑:用参考集 NR 中的样本对考试集 NT 中的样本进行近邻法分类,剪掉 NT 中被错分 的样本, NT 中剩余样本构成 -剪辑样本集 NTE (2)分类:利用剪辑样本集 NTE 和近邻法对未 知样本x进行分类

计算机学院信息科学研究所

模式识别

第6章 近邻法

6.2 k-近邻法

• 最近邻法的推广。在已知N个样 本中,找出测试样本x的k个近 邻,其中k个近邻中属于各类别 的个数分别为k1, k2 ,…, kc

N1 N 2 N c N 判别函数:gi x ki , i 1, 2, , c 决策规则:若 g j x max ki,则 x ω j

计算机学院信息科学研究所

模式识别

第6章 近邻法

可以证明: c * P P P 2 P c 1 其中:P*为贝叶斯错误率,c为类别数,

* *

P是N 时最近邻法的错误率(渐近的平均错误率)

一般情况下P*很小, 因此上式可粗略表示为: P * P 2P * 即:最近邻法的错误率在 贝叶斯错误率的2倍之内

• 如右图,红点表示A类训练样本,蓝点表 示B类训练样本,而绿点O表示待测样本。 • 若以欧式距离来衡量, O 的最近邻是 A3,其次是B1,因此O应该属于A类。 • 但若A3被拿开,O就会被判为B类

k-近邻法求解互信息的计算过程

K-近邻法是一种常用的机器学习算法,它在分类和回归问题中有着广泛的应用。

而互信息是一种用于衡量两个随机变量之间关联性的指标,它在特征选择、信息检索等领域具有重要的作用。

本文将以k-近邻法为基础,探讨如何利用k-近邻法来求解互信息的计算过程。

1. 什么是K-近邻法K-近邻法(K-nearest neighbors, KNN)是一种基本的分类与回归方法。

在K-近邻法中,对于一个未知样本,通过计算它与训练集中所有样本的距离,然后选择与它距离最近的k个样本,最后根据这k个样本的类别来对该未知样本进行分类或回归预测。

2. 什么是互信息互信息(Mutual Information, MI)是信息论中的一个重要概念,用于衡量两个随机变量之间的相关性。

互信息的定义如下:对于离散型随机变量X和Y,其联合概率分布为P(X, Y),边缘概率分布分别为P(X)和P(Y),则X和Y的互信息I(X; Y)定义为:I(X; Y) = ΣΣP(X, Y)log(P(X, Y) / (P(X)P(Y)))对于连续型随机变量X和Y,互信息的定义稍有不同,这里不做详细展开。

3. K-近邻法与互信息的关联K-近邻法的关键在于样本之间的距离度量,通常使用的距离度量有欧氏距离、曼哈顿距离、闵可夫斯基距离等。

而互信息则可以用于衡量两个随机变量之间的关联程度。

我们可以利用K-近邻法来近似计算互信息。

4. K-近邻法求解互信息的计算过程我们假设有两个随机变量X和Y,它们分别有n个样本。

现在,我们希望利用K-近邻法来计算它们之间的互信息。

步骤一:计算X和Y的联合概率分布在K-近邻法中,我们需要计算样本之间的距离。

对于X和Y的每一个样本Xi和Yi,我们可以根据它们的特征值计算它们之间的距离,得到一个距离矩阵。

假设我们选择欧氏距离作为距离度量,那么对于Xi和Yi,它们之间的距离可以表示为:d(Xi, Yi) = sqrt(Σ(Xij - Yij)^2)其中,Xij和Yij分别表示Xi和Yi的第j个特征值。

清华大学模式识别课件-07_近邻法

(6 20)

因为 P 与

P 2 i | x 有关,若寻求 P 与 P* 的关系,首先可以寻求 P 2 i | x 与 P* 的关

i 1 i 1

系。现利用式(6-18),式(6-20)的结果来推导,有

P | x P

2 2 i 1 i

c

m

| x P i | x 1 P e | x

以上两式对我们的启发是:对已知的 P m | x 而言,

*

P | x 的最小值对应着 P 的最大值。

2 i 1 i

c

如能求出 P 的最大值,就把贝叶斯错误率 P 和最近邻法错误率 P 联系起来了。 若记

P | x P

2 2 i 1 i

c

m

| x P 2 i | x

x's

p x' dx'

N

(6 8)

P x1 , x2 , …,x N 1 Ps

当 N→∞时,这一概率趋于零。由于 s 可以任意小,所以 N→∞时, x' 落在以 x 为中心无限小区域

中的概率趋于 1。就是说 x' 以概率为 1 收敛于 x,从而

N

lim p x' | x x' - x

(6 9)

现在来计算条件错误概率 PN e | x, x' 。当我们说有 N 个独立抽取并有类别标记的样本时,意 思是说有 N 对随机变量 x1 , 1 , x2 , 2 , …, x N , N ,其中 xi 是独立抽取的样本,i 是 xi 的类别 标记,且 i 是 c 个类别状态 1 , 2 …,c 之一。现在假定抽取一对 x, ,并假定标以 ' 的 x' 是 x 的最近邻。由于抽出 x' 时,它的类别状态和 x 无关。因此有

模式识别课件(第六章 NO1)(最近邻法)

二. 剪辑近邻法

此类方法的基本思想是:剪掉(清理)两类间的边界,取 掉类别混杂的样本,使两类边界更清晰。

1. 两分剪辑近邻法(亦称剪辑最近邻法) 基本过程为: 设N个样本分成c类

æ

N

N , N ,……, = { æ1 æ2 æcN }

1

2

c

(N1+N2+……,+Nc= N)

N

step1:剪辑。利用已知样本集æ 中的样本进行预分 类,并剪辑掉被错分类的样本,留下的样本构成 NE æ 剪辑样本集 step2:分类。利用 æ

6.3 近邻法的改进算法

共同特点是如何尽快地找出最近邻可能存在的小的空间, 减少搜索的范围,从而达到减少近邻法中的计算量和存储量的 问题。 一. 快速近邻算法 该算法对最近邻法和k-近邻法都适用。下面以最近邻法为 例来讨论。 1. 基本思想 将全部已知样本按级分成一些不相交的子集,并在子集的 基础上进行搜索。也就是说,该算法由两个阶段组成: 第一阶段:将样本集按级分解,形成树状结构。

二. 最近邻法的决策规则 设有c类模式样本, ω1, ω2,……, ωc 每类有Ni个样本(i=1,2,……,c),则最近邻法的(ωi类)判别 函数为:

gi ( X ) min X X ik

k

(k 1,2,...... , Ni )

式中X ik 表示ωi类中的第k个样本。

对应的决策规则为: 如果 则决策

X i 。

具体就是:设k1,k2,......,kc分别为X的k个最近邻样本中属于

1 , 2 ,......, c

类的样本数,

则定义 i (i 1,2,......,c) 类的判别函数为:

g i ( X ) ki

模式识别7.近邻法

则

8

【最近邻法决策规则 】

计算量:最近邻法在原理上最直观,方法上也十分简单,只

要对所有样本进行

次距离运算,然后以最小距离者的

பைடு நூலகம்

类别作决策。

用‖·‖表示距离,采用任何一种相似性的度量,一般以欧氏距 离为相似性度量。

由于特征向量各个分量之间对应的物理意义很可能不一致, 因此究竟采用何种相似性度量要看问题而定。

本节如何减少模板样本数目,从而可同时减少分类时 的计算量及模板样本的存储量,同时还能进一步改进分类 器的性能,如降低错误率等要求。

本节讨论的剪辑近邻法除了在样本数量上有一定程度的减 少外,更主要的优点是错误率的降低。

21

【基本原理】

剪辑近邻法的基本思想是从这样一个现象出发的,即当 不同类别的样本在分布上有交迭部分的,分类的错误率主 要来自处于交迭区中的样本。

搜索算法过程: 当搜索树形样本集结构由高层次向低层次 深入时,对同一层次的所有结点,可以利用规则1排除掉 一些不可能包含待识别样本的近邻的结点(样本子集)。但 是这往往不能做到只留下唯一的待搜索结点,因此必须选 择其中某一结点先深入搜索,以类似于深度优先的方法确 定搜索路径直至叶结点。然而在该叶结点中找到的近邻并 不能保证确实是全样本集中的最近邻者,所找到的该近邻 样本需要在那些有可能包含最近邻的样本子集中核对与修 正,直至找到真正的最近邻样本为止。

18

【讨论 】

1. 分级数目增多,结点增多,最终结点对应的样 本数减少。

2. 分级数目增少,结点增少,最终结点对应的样 本数增多。

3. 推广到 -近邻

19

3. 剪辑近邻法

20

【概念的提出 】

以上讨论的快速算法只是研究如何减少计算量的问题 ,而不考虑存储量的压缩。实际上由于对样本进行分层次 分组,并附有一些参数,实际的存储量还有可能增加。

机器学习与模式识别-第6章_近邻法

最近邻法的错误率

• 可以证明 当样本数相当多时,近邻法的错误率在 贝叶斯错误率和2倍的贝叶斯错误率之间。

最近邻法的错误率

6.2 K-近邻法

6.2 K-近邻法

对于一个待识别模式x, 分别计算它与 N N i 个已知类别的样本 x j 的距离, 取k个最近邻样本,这k

(i )

i 1 c

•它定义两个存储器,一个用来存放即将生成 的样本集,称为Store;另一存储器则存放原 样本集,称为Grabbag。

6.3.3 压缩近邻法

•算法的实现

•其算法是:

•1.[初始化]Store是空集,原样本集存入Grabbag;从 Grabbag中任意选择一样本放入Store中作为新样本集的第一 个样本。 •2.[样本集生成]在Grabbag中取出第i个样本用Store中的 当前样本集按最近邻法分类。若分类错误,则将该样本从 Grabbag转入Store中,若分类正确,则将该样本放回 Grabbag中,对Grabbag中所有样本重复上述过程。 •3.[结束过程]若Grabbag中所有样本在执行第二步时没有 发生转入Store的现象,或Grabbag已成空集,则算法终止, 否则转入第二步。

6.3.3 压缩近邻法

6.3.1 近邻法的快速算法

•实现快速搜索近邻的基本思路

•需要有方法快速判断某个样本子集是否是该 待识样本的可能近邻样本集,从而可将无关的 样本子集尽快排除。 •另一方面在某样本子集内寻找哪个样本是近 邻时,需快速排除不可能为近邻的样本 •这两个快速判别算法可用两个规则表示

6.3.1 近邻法的快速算法

剪辑的最近邻法的错误率 • 重复使用最近邻法,把落在 j类区域中 i 类的样本剪掉,其错误率的情况为

6.3.3 压缩近邻法

模式识别第五章 近邻法

压缩近邻算法

数据经MultiEdit算法剪辑后再使用 Condensing压缩近邻算法的结果

25

5.4 小结

近邻法是典型的非参数法 在原理上最直观,方法上也十分简单, 明显的缺点就是计算量大,存储量大; 近邻法

26

习题

1.

设在一个二维空间,A类有三个训练样本,图 中用红点表示,B类四个样本,图中用蓝点表 示。试问:

规则2: 如果满足:D(x, M p ) B D(xi , M p ) 则xi不是x的最近邻

14

树搜索算法

1. 2.

3. 4.

5.

6.

置B=∞,L=0,p=0 将当前结点的所有直接后继结点放入一个目录表中, 并对这些结点计算D(x,Mp) 根据规则1从目录表中去掉step2中的某些结点 如果目录表已无结点则置L=L-1,如果L=0则停止, 否则转Step3。如果目录表有一个以上的结点,则转 step5 在目录表中选出最近结点p’为当前执行结点。如果当 前的水平L是最终水平,则转Step6,否则置L=L+1, 转Step2 对当前执行结点p’中的每个xi,根据规则2决定是否 计算D(x, xi)。若D(x, xi)<B,则置NN=i和B= D(x, xi), 处理完当前执行结点中的每个xi后转Step3

P* P 0

当各类后验概率分布为均匀分布时:

1 P(i | x) C

C 1 P* P C

7

5.2 k-近邻法

k-近邻法: 最近邻法的扩展,其基本规 则是,在所有N个样本中找到与测试样本 的k个最近邻者,其中各类别所占个数表 示成ki, i=1,…,c。定义判别函数为: gi(x)=ki, i=1, 2,…,c。

k-近邻法

k-近邻法

k-近邻法(k-nearest neighbors, k-NN)是一种基本的分类和回

归方法。

其核心思想是在特征空间中,将一个样本的类别标识为其k个最近邻样本中类别最多的那个。

k-近邻法的基本步骤如下:

1. 计算训练集中每个样本与待分类样本的距离,一般采用欧氏距离或曼哈顿距离。

2. 选择距离最近的k个样本作为待分类样本的邻近样本。

3. 统计k个邻近样本中各类别的出现次数。

4. 将待分类样本归为出现次数最多的类别,即频率最高的类别。

k-近邻法的优点是简单、直观,易于理解和实现。

同时,对于

样本不平衡、多类别等问题,k-NN具有较好的适应性。

缺点

是分类速度较慢,尤其是当训练集较大时,需要计算大量距离。

此外,k-NN对样本的特征缩放和选取合适的k值较为敏感。

k-近邻法的应用场景广泛,包括图像分类、文本分类、推荐系

统等。

最近邻法和k-近邻法

最近邻法和k-近邻法一.基本概念:最近邻法:对于未知样本x,比较x与N个已知类别的样本之间的欧式距离,并决策x 与距离它最近的样本同类。

K近邻法:取未知样本x的k个近邻,看这k个近邻中多数属于哪一类,就把x归为哪一类。

K取奇数,为了是避免k1=k2的情况。

二.问题分析:要判别x属于哪一类,关键要求得与x最近的k个样本(当k=1时,即是最近邻法),然后判别这k个样本的多数属于哪一类。

可采用欧式距离公式求得两个样本间的距离s=sqrt((x1-x2)^2+(y1-y2)^2)三.算法分析:该算法中任取每类样本的一半作为训练样本,其余作为测试样本。

例如iris中取每类样本的25组作为训练样本,剩余25组作为测试样本,依次求得与一测试样本x距离最近的k 个样本,并判断k个样本多数属于哪一类,则x就属于哪类。

测试10次,取10次分类正确率的平均值来检验算法的性能。

四.MATLAB代码:最近邻算实现对Iris分类clc;totalsum=0;for ii=1:10data=load('iris.txt');data1=data(1:50,1:4);%任取Iris-setosa数据的25组rbow1=randperm(50);trainsample1=data1(rbow1(:,1:25),1:4);rbow1(:,26:50)=sort(rbow1(:,26:50));%剩余的25组按行下标大小顺序排列testsample1=data1(rbow1(:,26:50),1:4);data2=data(51:100,1:4);%任取Iris-versicolor数据的25组 rbow2=randperm(50); trainsample2=data2(rbow2(:,1:25),1:4);rbow2(:,26:50)=sort(rbow2(:,26:50));testsample2=data2(rbow2(:,26:50),1:4);data3=data(101:150,1:4);%任取Iris-virginica数据的25组rbow3=randperm(50);trainsample3=data3(rbow3(:,1:25),1:4);rbow3(:,26:50)=sort(rbow3(:,26:50));testsample3=data3(rbow3(:,26:50),1:4);trainsample=cat(1,trainsample1,trainsample2,trainsample3);%包含75组数据的样本集testsample=cat(1,testsample1,testsample2,testsample3);newchar=zeros(1,75);sum=0;[i,j]=size(trainsample);%i=60,j=4[u,v]=size(testsample);%u=90,v=4for x=1:ufor y=1:iresult=sqrt((testsample(x,1)-trainsample(y,1))^2+(testsample(x,2)-trainsample(y,2))^2+(testsampl e(x,3)-trainsample(y,3))^2+(testsample(x,4)-trainsample(y,4))^2); %欧式距离newchar(1,y)=result;end;[new,Ind]=sort(newchar);class1=0;class2=0;class3=0;if Ind(1,1)<=25class1=class1+1;elseif Ind(1,1)>25&&Ind(1,1)<=50class2=class2+1;elseclass3=class3+1;endif class1>class2&&class1>class3m=1;ty='Iris-setosa';elseif class2>class1&&class2>class3m=2;ty='Iris-versicolor';elseif class3>class1&&class3>class2m=3;ty='Iris-virginica';elsem=0;ty='none';endif x<=25&&m>0disp(sprintf('第%d组数据分类后为%s类',rbow1(:,x+25),ty));elseif x<=25&&m==0disp(sprintf('第%d组数据分类后为%s类',rbow1(:,x+25),'none'));endif x>25&&x<=50&&m>0disp(sprintf('第%d组数据分类后为%s类',50+rbow2(:,x),ty));elseif x>25&&x<=50&&m==0disp(sprintf('第%d组数据分类后为%s类',50+rbow2(:,x),'none'));endif x>50&&x<=75&&m>0disp(sprintf('第%d组数据分类后为%s类',100+rbow3(:,x-25),ty));elseif x>50&&x<=75&&m==0disp(sprintf('第%d组数据分类后为%s类',100+rbow3(:,x-25),'none'));endif (x<=25&&m==1)||(x>25&&x<=50&&m==2)||(x>50&&x<=75&&m==3)sum=sum+1;endenddisp(sprintf('第%d次分类识别率为%4.2f',ii,sum/75)); totalsum=totalsum+(sum/75);enddisp(sprintf('10次分类平均识别率为%4.2f',totalsum/10));测试结果:第3组数据分类后为Iris-setosa类第5组数据分类后为Iris-setosa类第6组数据分类后为Iris-setosa类第7组数据分类后为Iris-setosa类第10组数据分类后为Iris-setosa类第11组数据分类后为Iris-setosa类第12组数据分类后为Iris-setosa类第14组数据分类后为Iris-setosa类第16组数据分类后为Iris-setosa类第18组数据分类后为Iris-setosa类第19组数据分类后为Iris-setosa类第20组数据分类后为Iris-setosa类第23组数据分类后为Iris-setosa类第24组数据分类后为Iris-setosa类第26组数据分类后为Iris-setosa类第28组数据分类后为Iris-setosa类第30组数据分类后为Iris-setosa类第31组数据分类后为Iris-setosa类第34组数据分类后为Iris-setosa类第37组数据分类后为Iris-setosa类第39组数据分类后为Iris-setosa类第41组数据分类后为Iris-setosa类第44组数据分类后为Iris-setosa类第45组数据分类后为Iris-setosa类第49组数据分类后为Iris-setosa类第51组数据分类后为Iris-versicolor类第53组数据分类后为Iris-versicolor类第54组数据分类后为Iris-versicolor类第55组数据分类后为Iris-versicolor类第57组数据分类后为Iris-versicolor类第58组数据分类后为Iris-versicolor类第59组数据分类后为Iris-versicolor类第60组数据分类后为Iris-versicolor类第61组数据分类后为Iris-versicolor类第62组数据分类后为Iris-versicolor类第68组数据分类后为Iris-versicolor类第70组数据分类后为Iris-versicolor类第71组数据分类后为Iris-virginica类第74组数据分类后为Iris-versicolor类第75组数据分类后为Iris-versicolor类第77组数据分类后为Iris-versicolor类第79组数据分类后为Iris-versicolor类第80组数据分类后为Iris-versicolor类第84组数据分类后为Iris-virginica类第85组数据分类后为Iris-versicolor类第92组数据分类后为Iris-versicolor类第95组数据分类后为Iris-versicolor类第97组数据分类后为Iris-versicolor类第98组数据分类后为Iris-versicolor类第99组数据分类后为Iris-versicolor类第102组数据分类后为Iris-virginica类第103组数据分类后为Iris-virginica类第105组数据分类后为Iris-virginica类第106组数据分类后为Iris-virginica类第107组数据分类后为Iris-versicolor类第108组数据分类后为Iris-virginica类第114组数据分类后为Iris-virginica类第118组数据分类后为Iris-virginica类第119组数据分类后为Iris-virginica类第124组数据分类后为Iris-virginica类第125组数据分类后为Iris-virginica类第126组数据分类后为Iris-virginica类第127组数据分类后为Iris-virginica类第128组数据分类后为Iris-virginica类第129组数据分类后为Iris-virginica类第130组数据分类后为Iris-virginica类第133组数据分类后为Iris-virginica类第135组数据分类后为Iris-virginica类第137组数据分类后为Iris-virginica类第138组数据分类后为Iris-virginica类第142组数据分类后为Iris-virginica类第144组数据分类后为Iris-virginica类第148组数据分类后为Iris-virginica类第149组数据分类后为Iris-virginica类第150组数据分类后为Iris-virginica类k近邻法对wine分类:clc;otalsum=0;for ii=1:10 %循环测试10次data=load('wine.txt');%导入wine数据data1=data(1:59,1:13);%任取第一类数据的30组rbow1=randperm(59);trainsample1=data1(sort(rbow1(:,1:30)),1:13);rbow1(:,31:59)=sort(rbow1(:,31:59)); %剩余的29组按行下标大小顺序排列testsample1=data1(rbow1(:,31:59),1:13);data2=data(60:130,1:13);%任取第二类数据的35组rbow2=randperm(71);trainsample2=data2(sort(rbow2(:,1:35)),1:13);rbow2(:,36:71)=sort(rbow2(:,36:71));testsample2=data2(rbow2(:,36:71),1:13);data3=data(131:178,1:13);%任取第三类数据的24组rbow3=randperm(48);trainsample3=data3(sort(rbow3(:,1:24)),1:13);rbow3(:,25:48)=sort(rbow3(:,25:48));testsample3=data3(rbow3(:,25:48),1:13);train_sample=cat(1,trainsample1,trainsample2,trainsample3);%包含89组数据的样本集test_sample=cat(1,testsample1,testsample2,testsample3); k=19;%19近邻法newchar=zeros(1,89);sum=0;[i,j]=size(train_sample);%i=89,j=13[u,v]=size(test_sample);%u=89,v=13for x=1:ufor y=1:iresult=sqrt((test_sample(x,1)-train_sample(y,1))^2+(test_sample(x,2)-train_sample(y,2))^2+(test_ sample(x,3)-train_sample(y,3))^2+(test_sample(x,4)-train_sample(y,4))^2+(test_sample(x,5)-train _sample(y,5))^2+(test_sample(x,6)-train_sample(y,6))^2+(test_sample(x,7)-train_sample(y,7))^2+ (test_sample(x,8)-train_sample(y,8))^2+(test_sample(x,9)-train_sample(y,9))^2+(test_sample(x,10)-train_sample(y,10))^2+(test_sample(x,11)-train_sample(y,11))^2+(test_sample(x,12)-train_sa mple(y,12))^2+(test_sample(x,13)-train_sample(y,13))^2); %欧式距离newchar(1,y)=result;end;[new,Ind]=sort(newchar); class1=0; class 2=0; class 3=0;for n=1:kif Ind(1,n)<=30class 1= class 1+1;elseif Ind(1,n)>30&&Ind(1,n)<=65class 2= class 2+1;elseclass 3= class3+1;endendif class 1>= class 2&& class1>= class3m=1;elseif class2>= class1&& class2>= class3m=2;elseif class3>= class1&& class3>= class2m=3;endif x<=29disp(sprintf('第%d组数据分类后为第%d类',rbow1(:,30+x),m));elseif x>29&&x<=65disp(sprintf('第%d组数据分类后为第%d类',59+rbow2(:,x+6),m));elseif x>65&&x<=89disp(sprintf('第%d组数据分类后为第%d类',130+rbow3(:,x-41),m));endif (x<=29&&m==1)||(x>29&&x<=65&&m==2)||(x>65&&x<=89&&m==3)sum=sum+1;endenddisp(sprintf('第%d次分类识别率为%4.2f',ii,sum/89));totalsum=totalsum+(sum/89);enddisp(sprintf('10次分类平均识别率为%4.2f',totalsum/10));第2组数据分类后为第1类第4组数据分类后为第1类第5组数据分类后为第3类第6组数据分类后为第1类第8组数据分类后为第1类第10组数据分类后为第1类第11组数据分类后为第1类第14组数据分类后为第1类第19组数据分类后为第1类第20组数据分类后为第3类第21组数据分类后为第3类第22组数据分类后为第3类第26组数据分类后为第3类第27组数据分类后为第1类第28组数据分类后为第1类第30组数据分类后为第1类第33组数据分类后为第1类第36组数据分类后为第1类第37组数据分类后为第1类第43组数据分类后为第1类第44组数据分类后为第3类第45组数据分类后为第1类第46组数据分类后为第1类第49组数据分类后为第1类第52组数据分类后为第1类第54组数据分类后为第1类第56组数据分类后为第1类第57组数据分类后为第1类第60组数据分类后为第2类第61组数据分类后为第3类第63组数据分类后为第3类第65组数据分类后为第2类第66组数据分类后为第3类第67组数据分类后为第2类第71组数据分类后为第1类第72组数据分类后为第2类第74组数据分类后为第1类第76组数据分类后为第2类第77组数据分类后为第2类第79组数据分类后为第3类第81组数据分类后为第2类第82组数据分类后为第3类第83组数据分类后为第3类第84组数据分类后为第2类第86组数据分类后为第2类第87组数据分类后为第2类第88组数据分类后为第2类第93组数据分类后为第2类第96组数据分类后为第1类第98组数据分类后为第2类第99组数据分类后为第3类第104组数据分类后为第2类第105组数据分类后为第3类第106组数据分类后为第2类第110组数据分类后为第3类第113组数据分类后为第3类第114组数据分类后为第2类第115组数据分类后为第2类第116组数据分类后为第2类第118组数据分类后为第2类第122组数据分类后为第2类第123组数据分类后为第2类第124组数据分类后为第2类第133组数据分类后为第3类第134组数据分类后为第3类第135组数据分类后为第2类第136组数据分类后为第3类第139组数据分类后为第3类第140组数据分类后为第3类第142组数据分类后为第3类第144组数据分类后为第2类第145组数据分类后为第1类第146组数据分类后为第3类第148组数据分类后为第3类第149组数据分类后为第2类第152组数据分类后为第2类第157组数据分类后为第2类第159组数据分类后为第3类第161组数据分类后为第2类第162组数据分类后为第3类第163组数据分类后为第3类第164组数据分类后为第3类第165组数据分类后为第3类第167组数据分类后为第3类第168组数据分类后为第3类第173组数据分类后为第3类第174组数据分类后为第3类五:问题和收获:该算法的优缺点总结为:优点:算法简单且识别率较高;缺点:算法需要计算未知样本x与周围每个样本的距离,然后排序选择最近的k个近邻,计算量和时间复杂度高。

k-近邻算法 欧式距离

k-近邻算法欧式距离

k-近邻算法是一种常用的机器学习算法,它可以用于分类和回归问题。

在k-近邻算法中,我们通过计算样本点之间的欧式距离来确定最近的k个邻居。

欧式距离是一种常用的距离度量方法,也叫欧几里得距离。

它是在坐标空间中测量两个点之间的直线距离。

欧式距离计算公式为:

距离 = sqrt((x2-x1)^2 + (y2-y1)^2)

其中,(x1, y1)和(x2, y2)分别表示两个样本点的坐标。

通过计算每个样本点与目标点的欧式距离,我们可以找到与目标点最近的k个邻居。

然后,根据这k个邻居的分类标签或者数值,我们可以预测目标点的分类或者数值。

需要注意的是,k-近邻算法中的k值是一个重要的参数。

较小的k值可能会导致对噪声敏感,而较大的k值可能会导致低估样本点的局部特性。

总的来说,k-近邻算法通过欧式距离计算来确定最近的k个邻居,并根据邻居的标签或者数值进行预测。

这种算法在许多实际问题中都有应用,如图像识别、推荐系统等。

第6章_近邻法

类别的样本之间的欧氏距离,并决策x与离它最 近的样本同类。

最近邻方法

(1) N个已知类别 样本X

(2)输入未知类别 样本x

(3)计算x到 xiX,(i=1, 2,…,N)的 距离di(x)

(5) 判xωm (4)找出最小距离 dm(x)=min{di(x)}

6.1.2 最近邻法的错误率分析

可以证明,当样本数相当多时,近邻法错误率 与贝叶斯错误率存在以下关系:

c * P P P 2 P c 1 * 其中P 为贝叶斯错误率,c为类数。

* *

• 上式表明,当样本数相当多时,近邻法的错误 率在贝叶斯错误率和两倍的贝叶斯错误率之间。

最近邻法错误率上下界与贝叶斯错误率的关系

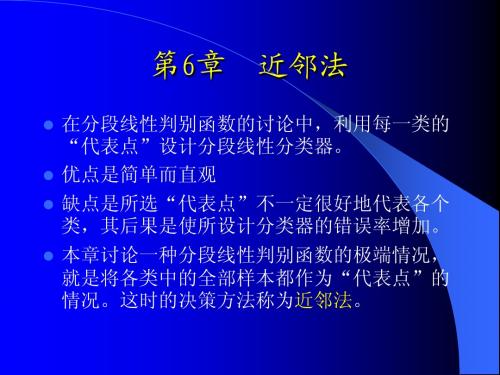

第6章 近邻法

在分段线性判别函数的讨论中,利用每一类的 “代表点”设计分段线性分类器。 优点是简单而直观 缺点是所选“代表点”不一定很好地代表各个 类,其后果是使所设计分类器的错误率增加。 本章讨论一种分段线性判别函数的极端情况, 就是将各类中的全部样本都作为“代表点”的 情况。这时的决策方法称为近邻法。

xi X p

第二阶段用搜索算法

检验未知样本x的最近邻是否在X p中的两个规则。 规则1:如果存在 B rp D x, M p 则xi X p 不可能是x的最近邻。其中B是在算法执行过程 中,对于已涉及到的那些样本集X p中的样本到x 的最近 距离。初始B可置为, 以后的B在算法中求得。

最初的近邻法是由Cover和Hart于1968年提出

的,随后得到理论上深入的分析与研究,是 非参数法中最重要的方法之一。

6.1 最近邻法

6.1.1 最近邻决策规则

6.1.2 最近邻法的错误率分析

第六章 近邻法

6.1 最近邻法

§6.1 最近邻法

在二维情况下,最近邻规则算法使得二维空间被分割成了 许多Voronoi网格,每一个网格代表的类别就是它所包含 的训练样本点所属的类别。

最近邻法的错误率

最近邻法的错误率是比较难计算的,这是因为训练样本集 的数量总是有限的,有时多一个少一个训练样本对测试样本 分类的结果影响很大。 红点表示A类训练样本,蓝点表 示B类训练样本,而绿点O表示待 测样本。

最近邻法的基本思想:以全部训练样本作为“代表点”, 计算测试样本与这些“代表点”,即所有样本的距离,并 以最近邻者的类别作为决策。 近邻法是由Cover和Hart于1968年提出的,随后得到理论 上深入的分析与研究,是非参数法中最重要的方法之一。

§6.1 最近邻法

将与测试样本最近邻样本的类别作为决策的方 法称为最近邻法。

快速搜索近邻法

规则1: 如果存在 则 不可能是X的近邻。其中B是待识别样本在搜索近邻过

程中的当前近邻距离,B在搜索过程中不断改变与缩小。算法 开始可将B设为无穷大。 表示待识样本X到结点

的均值点距离。

快速搜索近邻法

规则2:如果 其中Xi∈ ,则Xi不可能是X的近邻。 中的每个样本Xi到其均值

由此可见,只要将每个样本子集

极端情况,将所有样本都作为代表点---- 近邻法

§6.1 最近邻法

问题描述:

特征向量 X=(0.1,0.1)

类别 ?

特征向量 (0.1,0.2 ) (0.2,0.1) (0.4,0.5) (0.5,0.4)

类别 W1 W1 W2 W2

§6.1 最近邻法

最小距离分类器:将各类训练样本划分成若干子类,并在 每个子类中确定代表点,一般用子类的质心或邻近质心的 某一样本为代表点。测试样本的类别则以其与这些代表点 距离最近作决策。该法的缺点是所选择的代表点并不一定 能很好地代表各类,其后果将使错误率增加。

KNN(最近邻算法)

KNN(最近邻算法)KNN是最简单的机器学习算法之⼀。

在模式识别中,K-近邻算法(或近邻的简称)是⼀种⽤于分类和回归的⾮参数⽅法。

[ 1 ]在这两种情况下,输⼊包含k个最近的训练样本在特征空间中。

输出取决于近邻是⽤于分类或回归:l 在kNN分类中,输出的是⼀个分类的关系。

⼀个对象是由其邻居投票进⾏分类,被分类到最近的K个最近邻对象(k是⼀个正整数,通常⼩的)。

如果k = 1,那么对象只是分配到单个最近邻。

l 在KNN回归中, 输出该对象的属性值,这个值是k个邻居的平均值。

K-NN是⼀种基于实例的学习,或懒惰的学习,其中函数是近似的局部和所有计算递延⾄分类。

K-NN算法是其中最简单的机器学习算法。

K-NN算法是最简单的机器学习算法之⼀。

⽤于分类和回归,它可以根据分类贡献权重到最近的邻居,所以,附近的邻居有助于平均⽐更遥远的。

例如,⼀个普通的加权⽅案是给每个邻居重1 / D,其中D是邻居的距离。

邻居是从⼀组对象的类(k-NN分类)或对象的属性值(k-NN回归)是已知的。

这可以看作是对算法的训练,虽然没有明确的训练步骤是必需的。

⼀个缺点是K-NN算法是对数据的局部结构敏感。

不能与k-均值混为⼀谈,另⼀种流⾏的机器学习技术。

算法⼀个KNN分类的⽰例,测试样本(绿⾊的园)应该分类到哪⼀个类别,蓝⾊的正⽅形或者红⾊的三⾓形。

如果k=3,(实线圈) 他会被分到第⼆类中,因为有两个三⾓形但是只有⼀个⽅形在这个圈⾥⾯。

如果k=5,(虚线圈)他会被分到类别1(在圈⾥⾯有3个正⽅形,2个三⾓形)。

训练样本是在多维空间中的⼀组向量。

每个样本有⼀个分类类别。

在算法训练阶段值包括特征向量和训练样本的分类类别。

在分类阶段,K是⽤户⾃定义的⼀个常数,和⼀组未标⽰的向量(查询或者测试点)指定标签在离查询点最近的K个样本中出现频率最⾼的那个类,⼀种常⽤的连续变量距离度量是欧⽒距离。

对于离散变量,如⽂本分类,另⼀个度量可以使⽤,如重叠度量(或汉明距离)。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

P

P

*

最近邻与k-近邻法分类效果

最近邻

3-近邻

§6.1 近邻法原理及其决策规则

6.1.4. 近邻法中的几个问题

• 问题1:如何度量两个向量的相似性? • 各种距离度量

已知两个样本

X X

i

(X (X

, X i1

i2

, , X

in

)

jn

T

j

, X j1

, , X j2

)

T

① s阶明考夫斯基距离

d ij ( s )

|X

k 1

n

ik

X jk |

s

1/ s

② 绝对值距离(城市距离、棋盘距离) ③ 欧几里德距离 ④ 切比雪夫距离

d ij

m1

g(x)=0

x x

m2

最近邻分类器(nearest neighborhood classifier, nnc): 最小距离 分类器的一种极端的情况,以全部训练样本作为代表点, 计算测试样本与所有样本的距离,并以最近邻者的类别作 为决策。 最初的近邻法是由Cover和Hart于1968年提出的,随后得到 理论上深入的分析与研究,是非参数法中最重要的方法之 一。

i

• k-近邻一般采用k为奇数,跟投票表决一样,避免因两种票 数相等而难以决策。

§6.1.3 K近邻法

• 从样本点x开始生长,不断扩大区域,直到包含进k个训练 样本点为止,并且把测试样本点x的类别归为这最近的k个 训练样本点中出现频率最大的类别。

§6.1.3 K近邻法

k-近邻法错误率

• 最近邻法和k-近邻法的错误率上下界都是在一倍到两倍 贝叶斯决策方法的错误率范围内。

i

Xj

§6.1 近邻法原理及其决策规则

问题2 几种距离度量之间的关系

每一个彩色的平面由距离原点为1的点所形成。

§6.1 近邻法原理及其决策规则

问题3 计算复杂性

• N个样本,每一个样本是d维,在对于一个未知样本判别 时,需要的计算量为? • 当样本量N非常大时,如何实时(在线)完成识别任务? • 对于分类来说,每一个样本都有价值吗?

模式识别

第六章近邻法

第六章 近邻法

第六章 近邻法

§6.1 近邻法原理及其决策规则

6.1.1. 问题描述 特征向量 (0.1,0.2 ) (0.2,0.1) (0.4,0.5) (0.5,0.4) 类别 W1 W1 W2 W2 特征向量 • X=(0.1,0.1) 类别 ?

最小距离分类器: 它将各类训练样本划分成若干子类,并在 每个子类中确定代表点。未知样本的类别则以其与这些代 表点距离最近作决策。该方法的缺点是所选择的代表点并 不一定能很好地代表各类,其后果将使错误率增加。

最终目标:去掉两类边界附近的样本

§6.2 改进的近邻法

6.2.3压缩近邻法

基本思想是:利用现有样本集,逐渐生成一个新的样本集,使该样本

集在保留最少量样本的条件下,仍能对原有样本的全部用最近邻法正 确分类,那末该样本集也就能对待识别样本进行分类,并保持正常识 别率。 最终目标:将靠近类别中心的对分类不起作用的样本去掉。

§6.1 近邻法原理及其决策规则

6.1.2.最近邻法的决策规则

将与测试样本最近邻样本的类别作为决策的方法称为最近邻法。 对一个C类别问题,每类有Ni个样本,i=1,…,C,则第i类 ωi的判别函数 k

g i ( x ) m in x

其中Xik表示是ωi类的第k个样本。 以上式为判别函数的决策规则为:

§6.2 改进的近邻法

改进的方法大致分为两种原理: 一种是对样本集进行组织与整理,分群分层,尽可能将计 算压缩到在接近测试样本邻域的小范围内,避免盲目地与训 练样本集中每个样本进行距离计算。 另一种原理则是在原有样本集中挑选出对分类计算有效的 样本,使样本总数合理地减少,以同时达到既减少计算量, 又减少存储量的双重效果。

B3

§6.1 近邻法原理及其决策规则

小结

模式识别(机器自动分类)的基本方法有两大类: I. 将特征空间划分成决策域,需要确定判别函数或确定分界面方程。 II. 模板匹配,即将待分类样本与标准模板进行比较,看跟哪个模板 匹配度更好些,从而确定待测试样本的分类。 前面讨论的方法可以说都是将特征空间划分为决策域,并用判别 函数或决策面方程表示决策域的方法。 近邻法则在原理上属于模板匹配。它将训练样本集中的每个样 本都作为模板,用测试样本与每个模板做比较,看与哪个模板最 相似(即为近邻),就按最近似的模板的类别作为自己的类别。

§6.2 改进的近邻法

6.2.2.剪辑近邻法

基本思想是:当不同类别的样本在分布上有交迭部分的,分类 的错误率主要来自处于交迭区中的样本。由于交迭区域中不同 类别的样本彼此穿插,导致用近邻法分类出错。因此如果能将 不同类别交界处的样本以适当方式筛选,可以实现既减少样本 数又提高正确识别率的双重目的。为此可以利用现有样本集对 其自身进行剪辑。

优点:在模板数量很大时其错误率指标还是相当不错的。这就是 说近邻法有存在的必要。

缺点:要存储的模板很多,每个测试样本要对每个模板计算一次 相似度,因此在模板数量很大时,距离计算量也很大的。

趋利避害,保留其优点,克服或改进其缺点呢?剪辑近邻法与压 缩近邻法就是两种有代表性的改进方法。

第六章 近邻法

d ij

n

| X ik X jk |

k 1

n

k 1

X ik X jk

2

d ij ( X i , X j ) m ax | X ik X jk |

1 k n

s趋向无穷大时明氏距离的极限情况 ⑤ 马哈拉诺比斯距离

d ij ( M )

XX

i j

T

X

1

第六章 近邻法

6.2.1.快速搜索近邻法

这种方法着眼于减少计算量,但不能减少存储量。

基本思想:将样本集按邻近关系分解成组,给出每组的质心所在, 以及组内样本至该质心的最大距离。这些组又可形成层次结构,即 组又分子组。因而待识别样本可将搜索近邻的范围从某一大组,逐 渐深入到其中的子组,直至树的叶结点所代表的组,确定其相邻关 系。

§6.1 近邻法原理及其决策规则

6.1.3. k-近邻法决策规则

• k-近邻法: 最近邻法的扩展,其基本规则是,在所有N个 样本中找到与测试样本的k个最近邻者,其中各类别所 占个数表示成ki, i=1,…,c。 • 定义判别函数为: gi(x)=ki, i=1, 2,…,c。 • 决策规则为: g j ( x ) m ax g i ( x ), i 1, ..., c

§6.1.2 近邻法决策规则

最近邻法错误率

• 最近邻法的错误率高于贝叶斯错误率,可以证明以下关 系式成立: C * * *

P P P (2

P :贝叶斯错误率

*

C 1 P: 最 近 邻 法 错 误 率

P )

• 由于一般情况下P*很小,因 此又可粗略表示成:

P P 2P

* *

• 可粗略说最近邻法的渐近平 均错误率在贝叶斯错误率的 两倍之内。

如果

g j ( x ) m in g i ( x ) i 1, , c

i

则决策 x j

最近邻法在原理上最直观,方法上也十分简单,只要对所 有样本(共N=∑Ni)进行N次距离运算,然后以最小距离者 的类别作决策。

§6.1 近邻法原理及其决策规则

在二维情况下,最近邻规则算法使得二维空间被分割成了 许多Voronoi网格,每一个网格代表的类别就是它所包含 的训练样本点所属的类别。

§6.1 近邻法原理及其决策规则

6.1.5 近邻法的应用举例

例1:人脸识别 • 第一步:把人脸图像映射到一个低维的字空间中,成为 空间中的一个向量; • 第二步:使用近邻法对于未知的人脸图像分类。

例2:

B2

A2 B4 B1 A1 A3

B3

§6.1.5 近邻法应用举例

B2 A2 B4 B1 A1 A3