第十六章 logistic回归

logistics回归的原理

logistics回归的原理

Logistic回归是一种用于解决二元分类问题的机器学习算法。

它基于逻辑函数(也称为sigmoid函数)的概念,并通过最大

似然估计来确定模型参数。

Logistic回归的原理可以概括为以下步骤:

1. 数据准备:收集并准备训练数据集,包括输入特征(自变量)和对应的类别标签(因变量)。

2. 特征缩放:对输入特征进行缩放,以确保它们在相似的范围内。

3. 参数初始化:初始化模型的权重和截距。

4. Sigmoid函数:定义Sigmoid函数,它将输入转换为0到1

之间的概率值。

5. 模型训练:使用最大似然估计法来最小化损失函数,以找到最佳模型参数。

通常使用梯度下降等优化算法来实现。

6. 模型预测:使用训练得到的模型参数,对新的输入样本进行预测。

根据预测概率值,可以将样本分类为两个类别之一。

Logistic回归的核心思想是通过sigmoid函数将线性回归模型

的输出映射到概率。

它假设数据服从伯努利分布,并对给定输入特征的条件下属于某个类别的概率进行建模。

通过最大似然估计,可以找到最优的模型参数,使得预测的概率尽可能接近真实标签的概率。

总结起来,Logistic回归的原理是利用最大似然估计来建模分

类问题中的概率,并使用sigmoid函数将线性模型的输出映射到概率范围内。

logistic回归模型方程

logistic回归模型方程1. 简介Logistic回归是一种用于建立分类模型的统计方法,广泛应用于机器学习和数据分析领域。

它的主要目标是预测一个二元变量的概率,即将输入的数据映射到[0,1]区间。

本文将介绍logistic回归模型的数学原理和其在实际应用中的一些重要特点。

2. 原理Logistic回归模型将线性回归模型的输出通过一个逻辑函数进行转换,以求解分类问题。

假设我们有一个自变量X和一个因变量Y,其中Y只能取0或1的值。

我们希望找到一个合适的函数f,将X映射到[0,1]区间,使得Y的概率能够由f(X)来表示。

2.1 逻辑函数逻辑函数,也称为Sigmoid函数,是logistic回归模型的核心。

它的表达式如下所示:f(x)=11+e−x逻辑函数具有S型曲线,当自变量趋近于无穷大时,函数的值接近于1;当自变量趋近于负无穷大时,函数的值接近于0。

通过逻辑函数,我们可以将线性回归模型的输出转换为概率。

2.2 模型参数在logistic回归模型中,我们需要估计一组参数来确定函数f的形状。

具体而言,我们需要找到一组权重参数W和偏置参数b,使得对于给定的输入X,模型能够输出一个适当的概率。

2.3 模型方程logistic回归模型的方程可以表示为:P(Y=1|X)=11+e−WX−b其中,P(Y=1|X)表示给定输入X时Y等于1的概率,W表示权重参数矩阵,b表示偏置参数向量。

模型的参数估计可以利用最大似然估计或梯度下降等方法进行求解。

3. 特点和应用logistic回归模型具有许多重要的特点,使得它在实际应用中得到广泛使用。

3.1 线性决策边界logistic回归模型在特征空间中建立一个线性决策边界,将不同类别的数据分开。

这使得模型在处理线性可分的分类问题时非常有效。

3.2 高效的计算logistic回归模型的计算速度相对较快,因为它是一个凸优化问题,并且可以应用随机梯度下降等高效的算法进行求解。

3.3 可解释性强logistic回归模型的参数具有明确的物理或实际含义,使得模型的结果易于解释。

logistic回归原理

logistic回归原理

Logistic回归是一种有效的、相对简单的数据分类技术,用于确定某个事件或观测值属于某类的概率。

它可以解释二元数据和多类数据,并且能够应用于各种场景,比如风险分析、金融建模、社会研究等等。

Logistic回归源自线性模型,它是一种称为逻辑斯蒂(logit)模型的回归模型,该模型基于概率理论。

Logistic回归模型是由概率对数函数构建而成的,即:

Y = log(P/(1-P))

其中,P代表事件Y发生的概率。

Logistic归模型在数据分析中最主要的用途就是用于分类,它的原理是:假定输入的数据可以用一个线性函数来描述,并且拟合一条S型函数来获得概率,这个概率决定了每个样本点属于某一类的概率大小。

在使用Logistic回归之前,首先要处理好数据集,确保它具有足够的观测值,并且有合理的分类标签(例如“是”、“否”)。

接下来,要使用回归的模型,先把正确的观测值用正向的系数系数,将错误的观测值用负向的系数进行编码。

然后,确定正确的估计量结果,比如系数、拟合度指标和参数检验,以及误差分析。

最后,定义一个提升指标来评估结果,例如:准确率、召回率和精确率。

Logistic回归在机器学习中有各种应用,比如文本分类、情感分析和预测分析;在图像识别中,它可以用于目标检测、纹理识别和

边缘检测;在金融行业,它可以应用于信贷分析、欺诈检测和市场风险分析。

它也可以用于生物药物研究、病毒鉴别;在医学领域,它可以用于数据分析、诊断分析和临床预测等。

简而言之,Logistic回归是一种用于预测任意事件的概率发生的有效模型,可以用于多类数据的分类,在数据挖掘领域扮演着重要的角色,是结构化数据建模的常用工具。

logistic 回归函数

logistic 回归函数Logistic回归函数是一种常用的分类算法,它可以根据输入变量的线性组合来预测二元分类的概率。

在本文中,我们将介绍Logistic 回归函数的原理、应用场景以及如何使用Python来实现。

让我们来了解一下Logistic回归函数的原理。

Logistic回归函数可以看作是在线性回归模型的基础上加上了一个非线性的映射函数,该映射函数被称为Logistic函数或Sigmoid函数。

Logistic函数的表达式为:$$f(x) = \frac{1}{1+e^{-x}}$$其中,x为输入变量的线性组合。

Logistic函数的特点是将输入的实数映射到了(0,1)的区间内,这个区间可以看作是一个概率的范围。

当x趋向于正无穷时,f(x)趋向于1;当x趋向于负无穷时,f(x)趋向于0。

因此,我们可以将f(x)看作是预测样本属于某个类别的概率。

Logistic回归函数的应用场景非常广泛。

一般来说,当我们需要对一个样本进行分类,并且样本的特征是连续的或者离散的,都可以考虑使用Logistic回归函数。

例如,我们可以使用Logistic回归函数来预测用户点击广告的概率,或者预测某个疾病的患病概率等等。

接下来,让我们通过一个具体的例子来演示如何使用Python来实现Logistic回归函数。

假设我们有一个数据集,其中包含了一些患有某种疾病的人的年龄和血压信息,我们的目标是根据这些信息来判断一个人是否患有该疾病。

首先,我们需要导入必要的库和加载数据集:```import numpy as npimport pandas as pdimport matplotlib.pyplot as pltdata = pd.read_csv('data.csv')```接下来,我们需要对数据进行预处理,包括数据清洗、特征选择和数据划分等步骤。

然后,我们可以使用sklearn库中的LogisticRegression类来构建Logistic回归模型,并进行训练和预测:```from sklearn.linear_model import LogisticRegressionfrom sklearn.model_selection import train_test_split# 特征选择X = data[['age', 'blood_pressure']]y = data['disease']# 数据划分X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=0)# 构建模型model = LogisticRegression()# 模型训练model.fit(X_train, y_train)# 模型预测y_pred = model.predict(X_test)```我们可以使用一些评估指标来评估模型的性能,例如准确率、精确率、召回率和F1值等:```from sklearn.metrics import accuracy_score, precision_score, recall_score, f1_score# 计算准确率accuracy = accuracy_score(y_test, y_pred)# 计算精确率precision = precision_score(y_test, y_pred)# 计算召回率recall = recall_score(y_test, y_pred)# 计算F1值f1 = f1_score(y_test, y_pred)```通过以上步骤,我们就可以完成Logistic回归函数的实现和模型评估。

logistic回归基本概念

逻辑回归是一种广泛使用的统计工具,其核心在于利用多维特征对结果进行建模。

它是机器学习中的一个重要组成部分,常被用于金融预测、市场营销以及健康保险理赔等。

与决策树等其他算法相比,逻辑回归具有更强的可解释性,能够清晰地揭示各个特征对结果的影响。

逻辑回归基于一组输入变量(也称为特征或自变量),通过训练数据集估计出一条或几条直线,以此为基础对新的样本进行分类或预测。

这种算法具有直观、简洁和可解释性强的优点,而且适合处理各种数据类型,无论是连续的还是离散的。

在逻辑回归中,因变量通常是二分类的,例如“是否购买某商品”或“是否患某种疾病”。

通过训练数据集,模型可以学习到各个特征与这个二分类因变量之间的关联。

这种关联被表示为权重,它们揭示了每个特征对结果的贡献程度。

通过这些权重,我们不仅能了解各个特征的重要性,还能根据新样本的特征预测其属于正类(通常记为1)或负类(通常记为0)的概率。

逻辑回归在许多领域都有广泛的应用。

例如,在金融领域,它被用来预测客户是否可能违约;在医疗领域,它被用来预测患者患某种疾病的风险;在市场营销领域,它被用来预测消费者是否可能购买某产品。

通过这些预测,企业和研究人员可以更好地理解客户、病人或消费者的行为和需求,从而制定更有效的策略。

总的来说,逻辑回归是一种强大而灵活的统计工具,具有广泛的应用前景。

它不仅能帮助我们更好地理解数据和预测结果,还能提供可解释性和透明度,使决策者能够基于坚实的证据做出决策。

无论是在

学术研究、商业决策还是日常生活中,逻辑回归都发挥着重要的作用。

logistic回归原理

logistic回归原理

Logistic回归,又称为逻辑回归,是一种广泛应用的机器学习算法,主要用于分类问题。

它将一个数值变量预测为两个或多个二元变量值之一,例如:通过观察一个变量,我们可以预测另一个变量为正类/负类。

Logistic回归是一种函数拟合技术,它可以根据给定的输入数据,建立一个模型以预测数据的输出值。

它使用一个逻辑函数(也称为S形函数)来将连续的输入变量映射到二元类别输出中,形成一个只具有两个类别的模型。

Logistic回归的基本原理是,我们根据输入特征(例如年龄、性别、学历等)来预测输出(例如好/坏借款人)。

在Logistic回归模型中,输入特征是一个变量,而输出是一个二元变量,即只有两个值-0或1。

为了使Logistic回归模型正确地对数据进行建模,需要在训练阶段对参数进行估计。

估计的方式多种多样,但最常用的是最大似然估计(MLE)。

在MLE中,我们根据给定的训练数据找到最可能产生该数据的参数,也就是找到能够最好地拟合训练数据的参数。

一旦参数被估计出来,就可以使用该模型来预测新数据。

预测时,通常使用两个概念来描述预测:概率和似然估计。

概率表示新数据属于某个类别的可能性,即预测出的结果是0还是1的概率。

而似然估计则表示特定参数的可信度,即该参数产生观测数据的可能性。

总之,Logistic回归是一种广泛应用于分类问题的机器学习算

法,它将一个数值变量预测为两个或多个二元变量值之一。

它使用一个函数来将连续的输入变量映射到二元类别输出中,以预测数据的输出值。

在Logistic回归模型中,我们使用最大似然估计来估计参数,以及概率和似然估计来预测新数据。

Logistic回归分析及应用-精选文档

•

注:是否患病中,‘0’代表否,‘1’代表是。 性别中‘1’代表男,‘0’代表女,吸烟中‘1’ 代表吸烟,‘0’代表不吸烟。地区中,‘1’代 表农村,‘0’代表城市。

•

• • • • • • • • • • •

表4 配对资料(1:1) 对子号 病例 对照 x1 x2 x3 x1 x2 x3 1 1 3 0 1 0 1 2 0 3 1 1 3 0 3 0 1 2 0 2 0 … … … … … … … 10 2 2 2 0 0 0 注:X1蛋白质摄入量,取值:0,1,2,3 X2不良饮食习惯,取值:0,1,2,3 X3精神状况 ,取值:0,1,2

'

b Si为 Xi的标准差 i b i *S i / Sy ,其中 Sy为 y 的标准差。

5.假设检验

• (1)回归方程的假设检验 i 0 0 , i 0 , 1 , 2 , , p • H0:所有 H :某个 i 1 • 计算统计量为:G=-2lnL,服从自由度等于n-p 2 • 的 分布 • (2)回归系数的假设检验 • H0: i 0 H1:i 0 2 计算统计量为:Wald ,自由度等于1。

第十六章 Logistic回归分析

Logistic

regression

1

复习

•

多元线性回归

(multiple linear regression)

在医学实践中,常会遇到一个应变量与 多个自变量数量关系的问题。如医院住院 人数不仅与门诊人数有关 , 而且可能与病 床周转次数 , 床位数等有关;儿童的身高 不仅与遗传有关还与生活质量,性别,地 区,国别等有关;人的体表面积与体重、 身高等有关。

2

• 1

表1 y1

logistic回归法

logistic回归法Logistic回归法是一种常用的分类算法,广泛应用于各个领域。

它通过构建一个逻辑回归模型来预测某个事件发生的概率。

本文将介绍Logistic回归法的原理、应用场景以及优缺点。

一、Logistic回归法的原理Logistic回归法是基于线性回归的一种分类算法,它使用sigmoid 函数将线性回归的结果映射到[0,1]之间。

sigmoid函数的公式为:$$f(x) = \frac{1}{1+e^{-x}}$$其中,x为线性回归的结果。

通过这个映射,我们可以将线性回归的结果解释为某个事件发生的概率。

二、Logistic回归法的应用场景Logistic回归法常用于二分类问题,如预测某个疾病的发生与否、判断邮件是否为垃圾邮件等。

它也可以通过一些改进来应用于多分类问题。

在实际应用中,Logistic回归法非常灵活,可以根据需要选择不同的特征和参数,以达到更好的分类效果。

同时,它对特征的要求相对较低,可以处理连续型和离散型的特征,也可以处理缺失值。

三、Logistic回归法的优缺点1. 优点:- 计算简单、效率高:Logistic回归法的计算量相对较小,算法迭代速度快,适用于大规模数据集。

- 解释性强:Logistic回归模型可以得到各个特征的权重,从而可以解释每个特征对结果的影响程度。

- 可以处理离散型和连续型特征:Logistic回归法不对特征的分布做出假设,可以处理各种类型的特征。

- 可以处理缺失值:Logistic回归法可以通过插补等方法处理缺失值,不需要将含有缺失值的样本剔除。

2. 缺点:- 容易出现欠拟合或过拟合:当特征过多或特征与目标变量之间存在非线性关系时,Logistic回归模型容易出现欠拟合或过拟合问题。

- 对异常值敏感:Logistic回归模型对异常值比较敏感,可能会对模型造成较大的干扰。

- 线性关系假设:Logistic回归模型假设特征与目标变量之间的关系是线性的,如果实际情况并非线性关系,模型的预测效果可能较差。

16章 Logistic 回归分析

优势比OR(odds ratio)

流行病学衡量危险因素作用大小的比数比例指标。 计算公式为:

P 1 /(1 P 1) OR j P0 /(1 P0 )

式中 P1 和 P0 分别表示在 X j 取值为 c1 及 c0 时 的发病概率, OR j 称作多变量调整后的优势比, 表示扣除了其他自变量影响后危险因素的作用。

1

OR 95 可信区间 : :可信区间 exp[b1 u0.05 / 2 Sb ] exp(0.8856 1.96 0 1的 OR 的 95 可信区间 : OR 的 95 : OR 的 95 可信区间 1 1 1

1

exp[b1exp[ ub ] exp(0.8856 1.96 1.96 0.1500) (1.81, 3.25) 饮酒与不饮酒的优势比 :3.25) exp[ b u exp(0.8856 1.96 0.1500) (1.81, 3.25 / 2S b u S ] exp(0.8856 0.1500) (1.81, 1 1 0.05 / 2 Sb ] exp[b1 0.05 u1 S ] exp(0.8856 1.96 0.1500) (1.81, 3.25) 0.05 / 2 b 1 0.05 / 2 b1

L Pkd k (1 Pk ) nk d k

k 1 g

Yi 1Yi L P (1 P ) i i i 1

n

ln L

[Y

i 1

n

i

ln Pi (1 Yi ) ln(1 Pi )]

采用 Newton-Raphson 迭代方法使对数似然函数 达 到 极 大 值 , 此 时 参 数 的 取 值 b0 , b1 , b2 , , bm 即 为

《logistic回归》课件

易于理解和实现: 由于基于逻辑函数,模型输出结 果易于解释,且实现简单。

Logistic回归的优势与不足

• 稳定性好: 在数据量较小或特征维度较高 时,Logistic回归的预测结果相对稳定。

Logistic回归的优势与不足

01

不足:

02

对数据预处理要求高: 需要对输入数据进行标准化或归一化处理,以 避免特征间的尺度差异对模型的影响。

模型假设

01

线性关系

因变量与自变量之间存在线性关系 。

无自相关

因变量与自变量之间不存在自相关 。

03

02

无多重共线性

自变量之间不存在多重共线性,即 自变量之间相互独立。

随机误差项

误差项是独立的,且服从二项分布 。

04

模型参数求解

最大似然估计法

通过最大化似然函数来求解模型参数。

梯度下降法

通过最小化损失函数来求解模型参数。

特征选择与降维

在处理大数据集时,特征选择和降维是提高模 型性能和可解释性的重要手段。

通过使用诸如逐步回归、LASSO回归等方法, 可以自动选择对模型贡献最大的特征,从而减 少特征数量并提高模型的泛化能力。

降维技术如主成分分析(PCA)可以将高维特 征转换为低维特征,简化数据结构并揭示数据 中的潜在模式。

迭代法

通过迭代的方式逐步逼近最优解。

牛顿法

利用牛顿迭代公式求解模型参数。

模型评估指标

准确率

正确预测的样本数占总样本数的比例 。

精度

预测为正例的样本中实际为正例的比 例。

召回率

实际为正例的样本中被预测为正例的 比例。

F1分数

精度和召回率的调和平均数,用于综 合评估模型性能。

logistic回归基础知识

0.00

概率

11.11

A 35 4 16 7 8 22.86 4.590 0.032 42.86 10.769 0.001

04

B 35 10 22 2 1 2.86

8.57

合 A 112 14 39 30 29 25.89 24.291* 0.000 52.68 37.251* 0.000

计 B 112 26 70 13 3 2.68

the estimate.

2019/9/10

23

表 3.11.1 各试验中心两组病人用药后主要疗效评价(FAS)

中组 例

评价

基愈率

有效率

心

别

数

无好显基 效 转 效 愈 率(%)

2

P 率(%) 2

P

A 22 5 6 4 7 31.82 3.819 0.051 50.00 4.956 0.026

吸烟 不Байду номын сангаас烟 合计

病人 非病人 合计 231 125 356 183 296 479 414 421 835

2019/9/10

7

计算举例

例3-3某锡矿的矿工肺癌发病率308.39/10万,

非矿工的肺癌发病率为25.48/10万,试计算发

病的相对危险度。

RR=308.39/25.48=12.10

01

B 22 6 12 3 1 4.55

18.18

A 19 0 6 8 5 26.32 确切 0.180 68.42 确切 0.022

02 B 19 3 11 4 1

5.26

概率

26.32 概率

A 36 5 11 11 9 25.00 确切 0.002 55.56 16.000 0.000

医学统计学16-logistic回归

B:回归系数。当其他变量保持不变时,Xj每增加

a. Variable(s) entered on step 1: X2. b. Variable(s) entered on step 2: X4.

或减少1个单位时,OR值自然对数的平均变化量。 Exp (B):OR值(经校正的,或调整的OR值, B 2.096 e Exp ( B ) e 8.13 adjusted odds ratio) lnExp( B) B SE:回归系数的标准误 Wald值:对回归系数进行假设检验的统计量

2. SPSS的操作步骤

Logistic regression 对话框

将Y选入Dependent栏,X1 ~X5选入 Covariate栏,选择Forward:LR法。 单击Options按钮。

Options对话框

单击Continue按钮

单击OK按钮

3. SPSS的结果与分析 (1)数据基本情况

当缺失值没有或很少时逐步多因素logistic回归0步时的分析结果结果没有缺失值score统计量的结果与卡方检验一致无缺失值的情况下三多因素分析筛选独立的自变量进入模型例如动物脂肪摄入和体重指数在单因素分析都有统计学意义但多因素分析时只有动物脂肪摄入这个因素被引入模型

第十六章 logistic回归分析

11.17

8.14

0.044

0.054

1.07~116.44

0.97~ 68.62

表1 肾细胞癌转移的多因素logistic回归分析

影响因素 肾细胞血管内皮生长因子 OR值(95%CI) P值

11.17 (1.07~116.44)

0.044

肾癌细胞核组织学分级

8.14 ( 0.97~ 68.62 )

logistics回归解释

logistics回归解释Logistic回归是统计学中一个常用的分类算法,用于预测二元变量的结果。

例如,它可以用于预测一个人是否喜欢某个产品,或是否患有某种疾病。

Logistic回归的本质是一种线性模型,它通过将自变量的线性组合(在这里通常指特征值)传递到logistic函数中来预测响应变量。

这个函数的输出可以被解释为响应变量是二元的概率。

logistic函数(也称为逻辑斯蒂函数)将线性组合作为输入,并将其“挤压”到介于0和1之间的范围内,它的输出值表示响应变量是1的概率:$$ f(\mathrm{x}) = \frac{1}{1+\mathrm{e}^{-\mathrm{x}}} $$其中x是自变量的线性组合,它的定义可以写成:$$ \mathrm{x} = w_0 + w_1x_1 + w_2x_2 + ... + w_px_p $$其中,w是每个特征的权重,x是每个特征值。

这个方程中的第一个项(w0)是截距项,它确保对于所有的特征值为0的情况下,响应变量的概率为基本值。

当w0+w1x1+w2x2+...wp> 0时,logistic函数的输出为1,并且响应变量被预测为阳性(即响应变量等于1)。

反之,如果w0+w1x1+w2x2+...wp< 0,算法将预测响应变量等于0。

在训练Logistic回归模型时,我们需要确定每个特征的重要程度,以及最佳的随机误差项权重。

我们可以使用最大似然估计(MLE)算法来解决这个问题。

该算法将基于样本数据,逐步调整其参数,直到达到接近最佳拟合的状态。

总之,Logistic回归是一种流行的分类算法,可以处理许多不同的问题,例如预测身患某种疾病的人数,或预测客户对一种产品的反应。

它的输出值可以转化为比率或概率,这使得它非常灵活和可解释。

logistic回归 原理

logistic回归原理Logistic回归是一种常用的分类算法,它基于Logistic函数进行建模,用于解决二分类问题。

本文将介绍Logistic回归的原理及其应用。

一、Logistic回归原理Logistic回归是一种广义线性模型,它的目标是通过对数据进行拟合,得到一个能够将输入数据映射到0和1之间的函数,从而进行分类。

其基本思想是通过线性回归模型的预测结果,经过一个Logistic函数(也称为Sigmoid函数)进行转换,将预测结果限制在0和1之间。

Logistic函数的定义如下:$$f(x) = \frac{1}{1+e^{-x}}$$其中,$e$是自然对数的底数,$x$是输入值。

Logistic函数的特点是在$x$接近正负无穷时,函数值趋近于1和0,而在$x=0$时,函数值为0.5。

这样,我们可以将Logistic函数的输出视为样本属于正类的概率。

而Logistic回归模型的表达式为:$$h_{\theta}(x) = f(\theta^Tx) = \frac{1}{1+e^{-\theta^Tx}}$$其中,$h_{\theta}(x)$表示预测值,$\theta$表示模型参数,$x$表示输入特征。

二、Logistic回归的应用Logistic回归广泛应用于二分类问题,例如垃圾邮件分类、疾病诊断、信用评估等。

下面以垃圾邮件分类为例,介绍Logistic回归的应用过程。

1. 数据预处理需要对邮件数据进行预处理。

包括去除HTML标签、提取文本特征、分词等操作。

将每封邮件表示为一个向量,向量的每个元素表示对应词汇是否出现。

2. 特征工程在特征工程中,可以通过选择合适的特征、进行特征组合等方式,提取更有用的特征。

例如,可以统计邮件中出现的特定词汇的频率,或者使用TF-IDF等方法进行特征提取。

3. 模型训练在模型训练阶段,需要将数据集划分为训练集和测试集。

通过最大似然估计或梯度下降等方法,求解模型参数$\theta$,得到训练好的Logistic回归模型。

logistic回归模型

logistic回归模型一、模型简介在实际分析中,有时候因变量为分类变量,例如阴性阳性、性别、血型等,此时使用线性回归模型进行拟合会出现问题。

因此,我们需要找出其他解决思路,那就是logit变换(逻辑变换)。

逻辑变换将某种结果出现的概率和不出现的概率之比称为优势比P/(1-P),并取其对数,使之与自变量之间呈线性关系,从而解决了线性回归模型无法保证因变量只有两个取值的问题。

经过逻辑变换的线性模型称为logistic回归模型(逻辑回归模型),属于广义线性回归模型的范畴。

逻辑回归可以预测某个结果出现的概率,对因变量进行变换的方法很多,并不只有逻辑变换一种。

二、模型估计方法逻辑回归不能使用普通最小二乘估计,而使用极大似然估计或迭代重加权最小二乘法IRLS(XXX)。

使用极大似然估计的好处是,这是一种概率论在参数估计中的应用,正好和我们对因变量的概率预测相符合。

极大似然估计基于这样的思想:如果某些参数能使这个样本出现的概率最大,那就把这个参数作为估计的真实值。

三、优势比odds根据因变量的取值不同,逻辑回归可以分为四种:二分类逻辑回归、有序多分类逻辑回归、无序多分类逻辑回归、配对逻辑回归。

优势比odds是逻辑回归中的一个重要概念,指某种结果出现的概率和不出现的概率之比,通过逻辑变换,优势比可以被用作因变量进行拟合。

对于一些特殊情况,还需具体问题具体分析,不能一味地使用逻辑变换。

在二分类逻辑回归中,自变量可以是连续变量、二分类变量和多分类变量。

对于多分类变量,需要引入哑变量进行处理。

哑变量也称为虚拟变量,取值通常为0或1,代表参照分类和比较分类。

需要注意避免共线性,定义k-1个哑变量(包含截距)或k个哑变量(不包含截距)。

有序多分类变量指各因变量之间存在等级或程度差异。

对于因变量为有序分类变量的数据,可以通过拟合因变量个数-1个的逻辑回归模型,称为累积逻辑模型来进行。

这种方式依次将因变量按不同的取值水平分割成若干个二分类变量,然后再依次拟合二分类逻辑回归模型。

logistic回归计算讲解

logistic回归计算讲解Logistic回归是一种广泛用于分类问题的机器学习算法。

它可以用于二分类问题,也可以通过一些修改用于多分类问题。

下面是Logistic回归的计算过程的简要讲解:1. 数据准备:首先,收集和准备用于训练和测试的数据集。

每个数据样本应该包括特征和对应的类别标签。

特征可以是连续值或离散值。

2. 特征缩放:如果特征具有不同的量纲或取值范围,可以对特征进行缩放,以便更好地使用Logistic回归算法。

常见的缩放方法包括标准化和归一化。

3. 参数初始化:初始化Logistic回归模型的参数,通常为权重(也称为系数)和偏置(也称为截距)。

4. 假设函数:定义Logistic回归的假设函数,它将特征值映射到预测的类别概率。

通常使用sigmoid函数作为Logistic回归的假设函数。

5. 成本函数:使用成本函数(也称为损失函数)来度量模型预测的错误程度。

对于Logistic回归,常用的成本函数是逻辑损失函数(Log Loss)或交叉熵损失函数。

6. 梯度下降:使用梯度下降算法或其他优化算法来最小化成本函数,从而找到最佳的模型参数。

梯度下降算法通过计算参数的梯度,沿着梯度的反方向更新参数,逐步调整参数值以降低成本。

7. 模型训练:使用训练数据集来训练Logistic回归模型。

通过迭代优化算法来更新参数,重复计算成本函数和梯度下降步骤,直到达到停止条件(如达到最大迭代次数或成本函数的变化很小)。

8. 模型预测:使用训练好的Logistic回归模型来进行预测。

将新的输入特征传递给假设函数,计算预测的类别概率。

通常,如果概率大于一个阈值,将样本预测为正类;否则,预测为负类。

常见的阈值是0.5。

以上是Logistic回归算法的主要计算步骤。

在实践中,还需要考虑特征选择、模型评估和调优等方面,以获得更好的分类性能。

第十六章-Logistic回归

匹配的特征必须是已知的混杂因子,或者有充分的理由怀疑其为混 杂因子,否则不应匹配。

(三)巢式病例对照研究

也称为队列内的病例对照研究,是将队列研究和病例对照研究相结 合的方法。

OR>1,说明 该因素是疾病的危险性增加,为危险因素; OR<1,说明 该因素是疾病的危险性减小,为保护因素;

OR与RR之关系

病例对照研究资料

暴露

疾病 . 病例 对照 合计

+ 合计

a c a+c=m1

b d b+d=m0

a+b=n1 c+d=n0

t

a/(ac)

OR

c/(ac) b/(bd)

a/c b/ d

在医学研究中经常遇到应变量为二项分类的资 料,如治愈与未治愈、生存与死亡、发病与未发病等, 可以概括为阳性与阴性两种互斥结果,同时存在可能 对分类结果发生概率影响的因素即自变量。这类资料 由于d(Y)是二项分布,适宜用Logistic回归分析进 行。

• logistic回归:是研究因变量为二分类或多分类观察结果与影响 因素(自变量)之间关系的一种多变量分析方法,属概率型非线 性回归。

lo g it(P )0 1 X 1 p X p

当p=0或1时,logit(P)=ln[P/(1-P)]此式失效 Logistic 回归模型实际上普通多元线性回归模型的推广

Logit是“Logistic概率单位 ”,英文Logistic probability unit存头取尾 的缩写。 Logit(P)即“Logistic概率单位” ,简称LogitP。 Logit变换使得P在(0~1)范围内→(-∞,+ ∞)

logistic回归模型

–累积概率满足: P(Y 1) P(Y J ) 1 –累积概率的模型并不利用最后一个概率,因为它必然

等于1

多项logit模型

【例】研究性别和两种治疗方法(传统疗法与新疗法) 对某种疾病疗效的影响,84个病人的数据见表。

ln

pˆ 1 pˆ

11.536

0.124A

0.711M1

0.423M 2

0.021M 3

含有有序数据的logit

• Logit模型的协变量也可以是有序数据 • 对有序数据的赋值可以按顺序用数0,1,2,3,4分别

表示 【例】某地某年各类文化程度的死亡人数见表,试

建立logit模型。 • 建立死亡率关于年龄和文化程度的logit模型

ln

p2 p3

0.603 0.635 x3

• 然后,将x1和x3的取值代入上式,可以进一步对三个属性之间的关系加 以分析。

– 学校2与学校3的学生在自修与上课两种学习方式上偏好相同;

– 学校1比学校2和3更偏好上课(1.727>0.593);

– 课程计划中,常规课程与附加课程相比,常规课程学生更偏好自修;

– 小组与上课相比,三个学校没有差别;常规课程学生更偏好小组学 习。

多项logit模型

• 当响应变量为定性有序变量时,多项logit模型的处理会与 名义变量有所不同。

• 有序响应变量的累积logit模型 –当变量为有序变量时,logit可以利用这一点,得到比 基线-类别有更简单解释的模型; –Y的累积概率是指Y落在一个特定点的概率,对结果为 类别j时,其累积概率为:

单位,响应变量在任意给定类别下的优势比将为e 。

logistic回归分析

控制饮酒因素后, 吸烟与不吸烟相比 患食管癌的优势比 为2.4倍

exp(0.5261) OR 1.6923

OR的可信区间估计

吸烟与不吸烟患食管癌OR的95%可信区间:

exp(b1 u /2Sb1 ) exp(0.8856 1.960.15) (1.81,3.25)

2. 优势比(OR)及可信区间的估计

OR e

❖ 如X=1,0两分类,则OR的1-α可信区间估计公式

e(bj u / 2Sbj )

S 为回归系数 bj 的标准误

(公式16-10)

例:讲义表16-1资料

一个研究吸烟、饮酒与食道癌关系的病例-对照资料 (886例),试作logistic回归分析。

❖ 变量的赋值

2.模型中参数的意义

ln P 1 P

=

0

1 X 1

Β0(常数项):暴露因素Xi=0时,个体发病 概率与不发病概率之比的自然对数比值。

ln

P(y 1/ x 1 P(y 0 /

x

0) 0)

=

0

与Xii=0的相含比义,:发某生危某险结因果素(,如暴发露病水)平优变势化比时的,对即数X值i=。1

2.两值因变量的logistic回归模型方程

❖ 一个自变量与Y关系的回归模型 如:y:发生=1,未发生=0 x : 有=1,无=0, 记为p(y=1/x)表示某暴露因素状态下,结果y=1

的概率(P)模型。

或

P(

y

1/

x)

e0 x 1 e0 x

1

p(y 1/ x)

1 exp[(0 x)]

模型描述了应变量p与x的关系

P( y

0/ x

logistic 回归函数

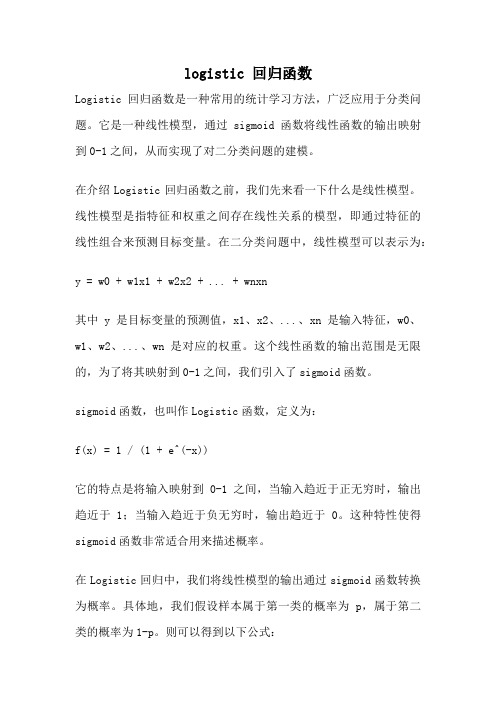

logistic 回归函数Logistic回归函数是一种常用的统计学习方法,广泛应用于分类问题。

它是一种线性模型,通过sigmoid函数将线性函数的输出映射到0-1之间,从而实现了对二分类问题的建模。

在介绍Logistic回归函数之前,我们先来看一下什么是线性模型。

线性模型是指特征和权重之间存在线性关系的模型,即通过特征的线性组合来预测目标变量。

在二分类问题中,线性模型可以表示为:y = w0 + w1x1 + w2x2 + ... + wnxn其中y是目标变量的预测值,x1、x2、...、xn是输入特征,w0、w1、w2、...、wn是对应的权重。

这个线性函数的输出范围是无限的,为了将其映射到0-1之间,我们引入了sigmoid函数。

sigmoid函数,也叫作Logistic函数,定义为:f(x) = 1 / (1 + e^(-x))它的特点是将输入映射到0-1之间,当输入趋近于正无穷时,输出趋近于1;当输入趋近于负无穷时,输出趋近于0。

这种特性使得sigmoid函数非常适合用来描述概率。

在Logistic回归中,我们将线性模型的输出通过sigmoid函数转换为概率。

具体地,我们假设样本属于第一类的概率为p,属于第二类的概率为1-p。

则可以得到以下公式:p = 1 / (1 + e^(-(w0 + w1x1 + w2x2 + ... + wnxn)))通过最大似然估计等方法,我们可以求解出最优的权重值,从而得到最优的Logistic回归模型。

在实际应用中,我们可以使用梯度下降等方法来求解。

Logistic回归函数的优点在于模型简单、计算量小、预测速度快。

它可以处理线性可分和线性不可分的分类问题,并且可以用于特征选择和特征工程。

此外,Logistic回归还可以通过引入正则化项来解决过拟合问题。

然而,Logistic回归也有一些限制。

首先,它只适用于二分类问题,无法直接处理多分类问题。

其次,它假设特征与目标变量之间存在线性关系,对于非线性关系的建模效果有限。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

应用及其注意事项

应变量为(二项)分类的资料 (预测、判别、危险因素分析等等)

流行病与卫生统计学系

2013年8月2日

注意事项

1. 分类自变量的哑变量编码

为了便于解释,对二项分类变量一 般按0、1编码,一般以0表示阴性或较 轻情况,而1表示阳性或较严重情况。 如果对二项分类变量按+1与-1编码,那 么所得的 OR exp( 2 ),容易造成错误的 解释。

流行病与卫生统计学系 2013年8月2日

参数估计的公式

流行病与卫生统计学系

2013年8月2日

三、回归参数的假设检验

流行病与卫生统计学系

2013年8月2日

优势比及其可信区间

流行病与卫生统计学系

2013年8月2日

标准化回归参数

用于评价各自变量对模型的贡献大小

流行病与卫生统计学系

2013年8月2日

流行病与卫生统计学系

2013年8月2日

注意事项

3.交互作用 交互作用的分析十分复杂,应 根据临床意义与实际情况酌情使用。

( 5.8896 0.6443X 1 1.91Байду номын сангаас9X 8 )

流行病与卫生统计学系

2013年8月2日

The LOGISTIC Procedure

Analysis of Maximum Likelihood Estimates

表 16-2

变 量 名 常 数 项 X _ R AY GRADE S TA G E AGE ACID

流行病与卫生统计学系

2013年8月2日

流行病与卫生统计学系

2013年8月2日

五、整个回归模型的假设检验

流行病与卫生统计学系

2013年8月2日

似然比检验(likelihood ratio test)

流行病与卫生统计学系

2013年8月2日

ROC曲线模型评价

编 (i) 1 2 3 4 5 6 7 8 9 10 11 12 13 14 号 预 ( 报 实 际 ( 编 号 (i) 15 16 17 18 19 20 21 22 23 24 25 26 27 预 ( 报 实 际 ( 编 号 (i) 28 29 30 31 32 33 34 35 36 37 38 39 40 预 ( 报 实 际 ( 编 号 (i) 41 42 43 44 45 46 47 48 49 50 51 52 53 预 ( 报 实 际 (

0.726 0.536 0.869 0.894 0.921 0.950 0.139 0.323 0.878 0.803 0.299 0.942 0.767

流行病与卫生统计学系

2013年8月2日

ROC曲线模型评价

1 0.8

灵敏度

0.6 0.4 0.2 0 0 0.2 0.4 0.6 0.8 1-特异度 1

流行病与卫生统计学系 2013年8月2日

那么,事件发生Pr(Y 1)是事件不发生Pr(Y 0)比较

优势比改变exp(j)个单位

流行病与卫生统计学系 2013年8月2日

Pr (Y 1) (odds) 优势 1 Pr (Y 0) exp( 5.8896 0.6443 X 1 1.9169 X 8 ) 令X 2~X 8保持不变,年龄X 1改变1个单位( 岁), 10 如年龄从50岁提高到60岁(X 1分别为2, 3),患冠心病的 概率增加了exp (0.6443 (3 2)) 1.9047 2倍

SAS程序

流行病与卫生统计学系

2013年8月2日

The LOGISTIC Procedure

Analysis of Maximum Likelihood Estimates

流行病与卫生统计学系

2013年8月2日

预报模型

exp( 5.8896 0.6443 X 1 1.9169 X 8 ) 1 exp( 5.8896 0.6443 X 1 1.9169 X 8 ) 1 1 exp (5.8896 0.6443 X 1 1.9169 X 8 ) 1 1 e

图16-2

Logistic回归预报能力的ROC曲线

2013年8月2日

流行病与卫生统计学系

六、logistic逐步回归(变量筛选)

MODEL语句加入选项“ SELECTION=STEPWISE SLE=0.10 SLS=0.10;” 常采用似然比检验:

2 LR 2(ln L0 ln L1 ) (2 ln L0 ) (2 ln L1 )

( 0 1 X 1 p X p )

流行病与卫生统计学系

2013年8月2日

二、模型的参数估计

Logistic回归参数的估计通常采用 最大似然法(maximum likelihood, ML)。最大似然法的基本思想是先建 立似然函数与对数似然函数,再通过 使对数似然函数最大求解相应的参数 值,所得到的估计值称为参数的最大 似然估计值。

Logistic回归

Logistic regression

研究生《医学统计学》

第一节.非条件logistic回归 第二节.条件logistic回归 第三节. 应用及其注意事项

流行病与卫生统计学系

2013年8月2日

什么情况下采用Logistic回归

医学研究中常碰到应变量的可能取值 仅有两个(即二分类变量),如发病与未 发病、阳性与阴性、死亡与生存、治愈与 未治愈、暴露与未暴露等,显然这类资料 不满足多元(重)回归的条件

0.035 0.513 0.531 0.036 0.321 0.368 0.066 0.868 0.131 0.580 0.097 0.078 0.451

0.100 0.180 0.331 0.193 0.471 0.545 0.695 0.157 0.849 0.218 0.465 0.200 0.518

哑变量化

姓名 张山 李四 王五 刘六 赵七 1 1 0 0 1

性别 年龄

孙八

0

29

西

孙八

0

29

1

0

流行病与卫生统计学系

2013年8月2日

注意事项

2.自变量的筛选 不同的筛选方法有时会产生不同的模 型。实际工作中可同时采用这些方法,然 后根据专业的可解释性、模型的节约性和 资料采集的方便性等,决定采用何种方法 的计算结果。

b j

0.0003 6.4208 0.9759 4.0835 1.4320 3.4230

0.5128 0.2054 0.4352 -0.2355 0.3517

7.732 2.141 4.778 0.933 1.025

1.589 0.473 1.048 0.833 0.999

37.614 9.700 21.783 1.045 1.051

参数估计值与优势比

Wa l d

OR 值

OR j 值 OR j 的 9 5 % C I

下 限 上 限

bj

0.0618 2.0453 0.7614 1.5641 -0.0693 0.0243

SE(b j )

3.4599 0.8072 0.7708 0.7740 0.0579 0.0132

值

2

P值

0.9857 0 . 0 11 3 0.3232 0.0433 0.2314 0.0643

流行病与卫生统计学系

2013年8月2日

实例

Brown(1980)在术前检查了53例前列腺 癌患者,拟用年龄(AGE)、酸性磷酸酯酶 (ACID)两个连续型的变量,X射线(X_RAY)、 术前探针活检病理分级(GRADE)、直肠指检 肿瘤的大小与位置(STAGE)三个分类变量与 手术探查结果变量NODES(1、0分别表示癌 症淋巴结转移与未转移 )建立淋巴结转移 的预报模型。

j 1 m

流行病与卫生统计学系

2013年8月2日

1:3配对的例子

流行病与卫生统计学系

2013年8月2日

1:2配对的例子

流行病与卫生统计学系

2013年8月2日

表16-7条件logistic回归的SAS程序

流行病与卫生统计学系

2013年8月2日

结果

流行病与卫生统计学系

2013年8月2日

第三节

一、logistic回归模型

流行病与卫生统计学系

2013年8月2日

概率预报模型

exp( 0 1 X 1 p X p ) 1 exp( 0 1 X 1 p X p )

1 1 exp[ ( 0 1 X 1 p X p )] 1 1 e

流行病与卫生统计学系

2013年8月2日

四、回归参数的意义

当只有一个自变量时,以相应的预报 概率 为纵轴,自变量 X 为横轴,可绘 制出一条S形曲线。回归参数的正负符号与 绝对值大小,分别决定了S形曲线的方向与 1 形状

0.8 0.6 0.4 0.2 0 -2.5 -1.5 -0.5 0.5 流行病与卫生统计学系 1.5

ˆ i)

Yi )

0 0 0 0 0 0 0 0 0 0 0 0 0 0

ˆ i)

Yi )

0 0 0 0 0 0 0 0 0 0 0 0 0

ˆ i)

Yi )

0 0 0 0 0 0 1 1 1 1 1 1 1

ˆ i)

Yi )

1 1 1 1 1 1 1 1 1 1 1 1 1

0.255 0.146 0.218 0.065 0.034 0.280 0.052 0.093 0.036 0.061 0.137 0.201 0.304 0.072

X

预报概率

Logistic回归曲线 中心线