中科院 国科大 黄庆明 模式识别与机器学习 期末考点 复习

模式识别期末试题

模式识别期末试题1.模式识别系统的基本构成单元包括模式采集、特征提取与选择和模式分类。

这些构成单元一起协作,以确定输入模式的类别或特征。

2.统计模式识别中,描述模式的方法一般使用特征向量;而句法模式识别中,模式描述方法一般有串、树、网等。

3.聚类分析算法属于无监督分类;判别域代数界面方程法属于统计模式识别方法。

4.若描述模式的特征量为0-1二值特征量,则一般采用匹配测度进行相似性度量。

5.准则函数可以作为聚类分析中的判别标准,常用的有距离准则、均值准则和连通性准则。

6.Fisher线性判别函数的求解过程是将N维特征向量投影在一维空间中进行。

7.感知器算法只适用于线性可分情况;而积累位势函数法既适用于线性可分,也适用于线性不可分情况。

8.满足文法定义的四元组包括:起始符号、非终结符号集合、终结符号集合和产生式规则集合。

其中,第一、二、四个四元组满足文法定义。

9.影响层次聚类算法结果的主要因素包括计算模式距离的测度、聚类准则、类间距离门限和预定的类别数目。

10.欧式距离具有平移不变性和旋转不变性;马式距离具有平移不变性、旋转不变性、尺度缩放不变性和不受量纲影响的特性。

11.线性判别函数的正负和数值大小的几何意义是正(负)表示样本点位于判别界面法向量指向的正(负)半空间中;绝对值正比于样本点到判别界面的距离。

12.感知器算法适用于线性可分和线性不可分的情况。

13.积累位势函数法相较于H-K算法的优点是该方法可用于非线性可分情况,也可用于线性可分情况。

位势函数K(x,xk)与积累位势函数K(x)的关系为K(x) = ∑αkK(x,xk),其中xk∈X。

14、XXX判决准则适用于一种判决错误比另一种判决错误更为重要的情况,而最小最大判决准则适用于先验概率未知的情况。

15、特征个数越多并不一定有利于分类。

特征选择的主要目的是从n个特征中选出最有利于分类的m个特征(m<n),以降低特征维数。

在可分性判据对特征个数具有单调性且特征个数远小于样本数的情况下,可以使用分支定界法以减少计算量。

中科院模式识别第二章 黄庆明

2.3 基于试探的聚类搜索算法

2.3.1 按最近邻规则的简单试探法 • 讨论(续)

– 距离阈值T对聚类结果的影响

2.3 基于试探的聚类搜索算法

2.3.2 最大最小距离算法 • 基本思想:以试探类间欧Leabharlann 距离为最大 作为预选出聚类中心的条件。

2.2 模式相似性的测度和 聚类准则

2.2.2 聚类准则 • 试探方法 凭直观感觉或经验,针对实际问题定义一种 相似性测度的阈值,然后按最近邻规则指定 某些模式样本属于某一个聚类类别。

– 例如对欧氏距离,它反映了样本间的近邻性,但 将一个样本分到不同类别中的哪一个时,还必须 规定一个距离测度的阈值作为聚类的判别准则。

2.5.1 K-均值算法

• 思想:基于使聚类性能指标最小化,所 用的聚类准则函数是聚类集中每一个样 本点到该类中心的距离平方之和,并使 其最小化。 • 算法

2.5.1 K-均值算法

• [举例]

– 对如图模式 样本用K-均 值算法进行 分类

2.5.1 K-均值算法

• 讨论

– K-均值算法的结果受如下选择的影响:

2.2 模式相似性的测度和 聚类准则

2.2.2 聚类准则 • 聚类准则函数法

– 依据:由于聚类是将样本进行分类以使类别间可 分离性为最大,因此聚类准则应是反映类别间相 似性或分离性的函数; – 由于类别是由一个个样本组成的,因此一般来说 类别的可分离性和样本的可分离性是直接相关的; – 可以定义聚类准则函数为模式样本集{x}和模式类 别{Sj, j=1,2,…,c}的函数,从而使聚类分析转化为 寻找准则函数极值的最优化问题。

模式识别复习提纲2

(2)使用最近邻规则将所有样本分配到各聚类中心所代表的类

ωj(l)中,各类所包含的样本数为Nj(l);

(3)计算各类的重心(均值向量),并令该重心为新的聚类中

心,即:

Zj(l+1)=N-j(1l)∑xi j=1,2,…,c xi∈ωj(l)

(4)如zj(l+1)≠zj(l),表示尚未得到最佳聚类结果,则返回步骤 (2),继续迭代;

(1)绝对可分:

➢ 每个模式类都可用单一判别函数与其他模式类区分开。 ➢ 如是M类分类,则有M个判别函数

x2

d3(X)=0

1

d1(X)=0

2 d2(X)=0

3

x1

判别函数的性质:

di(X)=Wi*TX*

>0, X∈ωi

<0, =0,

X不∈定ωj,j≠i

i,j=1,2,……,M

在模式空间S中,若给定N个样本,如能按 照样本间的相似程度,将S划分为k个决策 区域Si(i=1,2,…..,k),使得各样本 均能归入其中一个类,且不会同时属于两 个类。即 S1∪S2∪S3∪……∪Sk=S

Si∩Sj=0,i≠j

数据聚类的依据是样本间的“相似度”

2、数据聚类的特点:

无监督学习 数据驱动 聚类结果多样化:特征选取、相似度的度 量标准,坐标比例;

dij(X)= -dji(X)

分类决策规则:

x2

d23(X)=0 1 3

d12(X)=0

2 d13(X)=0

IR

x1

分类决策规则:

X∈ω1: d12(X)>0, d13(X)>0,

X∈ω2: d21(X)>0, d23(X)>0,

模式识别期末复习总结

1、贝叶斯分类器贝叶斯分类器的定义:在具有模式的完整统计知识的条件下,按照贝叶斯决策理论进行设计的一种最优分类器。

贝叶斯分类器的分类原理:通过某对象的先验概率,利用贝叶斯公式计算出其后验概率,即该对象属于某一类的概率,选择具有最大后验概率的类作为该对象所属的类。

贝叶斯分类器是各种分类器中分类错误概率最小或者在预先给定代价的情况下平均风险最小的分类器。

贝叶斯的公式:什么情况下使用贝叶斯分类器:对先验概率和类概率密度有充分的先验知识,或者有足够多的样本,可以较好的进行概率密度估计,如果这些条件不满足,则采用最优方法设计出的分类器往往不具有最优性质。

2、K近邻法kNN算法的核心思想:如果一个样本在特征空间中的k个最相邻的样本中的大多数属于某一个类别,则该样本也属于这个类别,并具有这个类别上样本的特性。

假设有N个已知样本分属c个类,考察新样本x在这些样本中的前K个近邻,设其中有个属于类,则类的判别函数就是决策规则:若则∈什么情况下使用K近邻法:kNN只是确定一种决策原则,在确定分类决策上只依据最邻近的一个或者几个样本的类别来决定待分样本所属的类别,并不需要利用已知数据事先训练出一个判别函数,这种方法不需要太多的先验知识。

在样本数量不足时,KNN法通常也可以得到不错的结果。

但是这种决策算法需要始终存储所有的已知样本,并将每一个新样本与所有已知样本进行比较和排序,其计算和存储的成本都很大。

对于类域的交叉或重叠较多的待分样本集来说,kNN方法较其他方法更为适合。

3、PCA和LDA的区别Principal Components Analysis(PCA):uses a signal representation criterionLinear Discriminant Analysis(LDA):uses a signal classification criterionLDA:线性判别分析,一种分类方法。

它寻找线性分类器最佳的法线向量方向,将高维数据投影到一维空间,使两类样本在该方向上的投影满足类内尽可能密集,类间尽可能分开。

模式识别期末考试试题

模式识别期末考试试题# 模式识别期末考试试题## 一、选择题(每题2分,共20分)1. 模式识别中,特征提取的目的是什么?A. 降低数据维度B. 提高计算效率C. 增强数据的可解释性D. 以上都是2. 在K-近邻算法中,K值的选择对结果的影响是什么?A. 无影响B. 影响分类的准确性C. 影响算法的运行时间D. 影响数据的可读性3. 决策树算法中,信息增益的计算是基于以下哪个概念?A. 熵B. 互信息C. 条件熵D. 联合熵4. 支持向量机(SVM)的主要思想是?A. 寻找数据点之间的最大间隔B. 寻找数据点之间的最小间隔C. 寻找数据点的平均间隔D. 寻找数据点的中心点5. 以下哪个算法属于聚类算法?A. K-近邻B. 决策树C. K-均值D. 支持向量机## 二、简答题(每题10分,共30分)1. 描述主成分分析(PCA)的基本原理及其在模式识别中的应用。

2. 解释什么是过拟合(Overfitting)现象,并给出避免过拟合的几种常用方法。

3. 给出神经网络在模式识别中的基本工作原理,并说明其优缺点。

## 三、计算题(每题25分,共50分)1. 给定以下数据点,使用K-均值算法将它们分为两个簇,并说明算法的步骤:- 数据点:(1, 2), (2, 3), (5, 6), (8, 7), (9, 8)2. 假设有一个二维数据集,其中包含两类数据点,分别用圆形和三角形表示。

数据点的特征如下表所示:| 特征1 | 特征2 | 类别 || | | - || 1.5 | 2.5 | 圆形 || 2.0 | 3.0 | 圆形 || 3.5 | 4.5 | 三角形 || 4.0 | 5.0 | 三角形 |使用线性判别分析(LDA)方法,找出最佳线性边界,并将数据点分为两类。

## 四、论述题(共30分)1. 论述深度学习在图像识别领域的应用,并讨论其与传统机器学习方法相比的优势和局限性。

## 五、案例分析题(共30分)1. 假设你是一名数据科学家,你的团队正在开发一个用于识别手写数字的系统。

中科院 国科大 黄庆明 模式识别与机器学习 期末考点 复习

SVR:一般形式及其对偶问题 Multi-class SVM:一对多。 VC dimension:一般而言, VC 维 越大, 学习能力就 越强,学习也越复杂;可以通过 VC 维 计算学习风 险的上界

概念 K-means:形式化,思想 高斯混合模型及EM算法(思想,步骤)

模式识别系统的基本构成

数据 获取 预处理

分类器设 计

特征提取和 选择

分类决 策

机器学习的基本构成

环境 学习 知识库 执行与评价

数据聚类 统计分类 结构模式识别 神经网络 监督学习 无监督学习 半监督学习 集成学习 增强学习 深度学习

在贝叶斯分类器中,构造分类器需要知道类概率密 度函数。

流形学习

◦ ◦ ◦ ◦ ◦ Multidimensional Scaling(MDS): 点对距离 Kernel PCA Isomap:保持内在几何结构(测地距离) LLE:映射到低维空间时要保持局部线性结构 LPP:保持局部结构

半监督学习 假设:平滑假设 Disagreement-based 方法:Co-training Low-density separation方法:transductive SVM Graph-based SSL:加入不同的正则项得到不同的 方法

分类方法

◦ 感知器算法:

perceptron criterion 随机梯度下降求解 缺点

分类方法

◦ Logistic regression

MLE+SGD求解 多类logistic regression: Cross Entropy Loss Function

中科院_黄庆明_模式识别_考试试卷总结_国科大

的

k j

来计算:

kh

w

hj

k j

j

因此,算出

kh

后,

k h

也就求出了。

如果前面还有隐蔽层,用

k h

再按上述方法计算

kl

和

k l

,以此类

推,一直将输出误差δ一层一层推算到第一隐蔽层为止。各层的δ

求得后,各层的加权调节量即可按上述公式求得。由于误差

k j

相当

于由输出向输入反向传播,所以这种训练算法成为误差反传算法

第四步:返回第二步,重复计算及合并,直到得到满意的分类结

果。(如:达到所需的聚类数目,或 D(n)中的最小分量超过给定阈值

D 等。)

聚类准则函数

(1)最短距离法:设 H 和 K 是两个聚类,则两类间的最短距离定义

为:

DH,K min{ d u,v}, u H, v K 其中,du,v 表示 H 类中的样本 xu 和 K 类中的样本 xv 之间的距离, DH,K 表示 H 类中的所有样本和 K 类中的所有样本之间的最小距 离。

k j

y

k j

)

2

1 2

{T

k j

k, j

F[

h

whj F (

i

wih xik )]}2

为了使误差函数最小,用梯度下降法求得最优的加权,权值先从

输出层开始修正,然后依次修正前层权值,因此含有反传的含义。

根据梯度下降法,由隐蔽层到输出层的连接的加权调节量为:

w

hj

E w hj

模式试卷总结

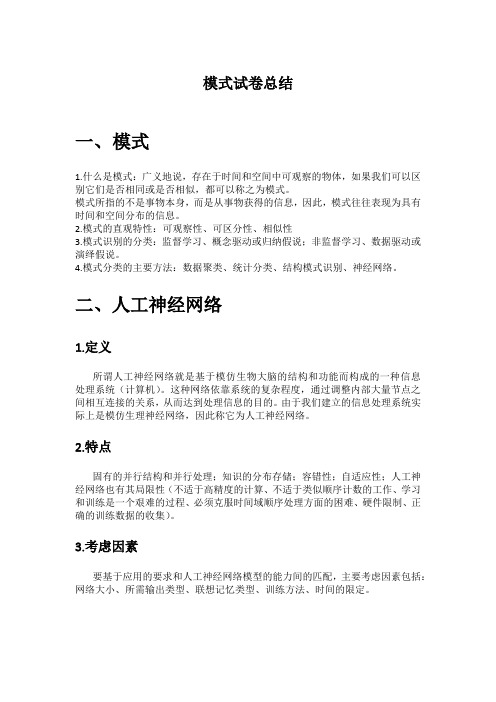

一、 模式

1.什么是模式:广义地说,存在于时间和空间中可观察的物体,如果我们可以区 别它们是否相同或是否相似,都可以称之为模式。 模式所指的不是事物本身,而是从事物获得的信息,因此,模式往往表现为具有 时间和空间分布的信息。 2.模式的直观特性:可观察性、可区分性、相似性 3.模式识别的分类:监督学习、概念驱动或归纳假说;非监督学习、数据驱动或 演绎假说。 4.模式分类的主要方法:数据聚类、统计分类、结构模式识别、神经网络。

模式识别期末复习

1.模式是值得具体的摸一个物体,比如,李论是学生,李论是模式,学生是模式类。

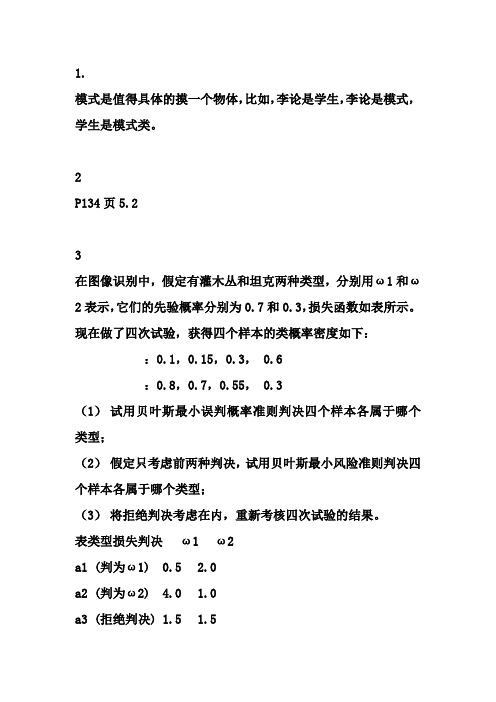

2P134页5.23在图像识别中,假定有灌木丛和坦克两种类型,分别用ω1和ω2表示,它们的先验概率分别为0.7和0.3,损失函数如表所示。

现在做了四次试验,获得四个样本的类概率密度如下::0.1,0.15,0.3, 0.6:0.8,0.7,0.55, 0.3(1)试用贝叶斯最小误判概率准则判决四个样本各属于哪个类型;(2)假定只考虑前两种判决,试用贝叶斯最小风险准则判决四个样本各属于哪个类型;(3)将拒绝判决考虑在内,重新考核四次试验的结果。

表类型损失判决ω1 ω2a1 (判为ω1) 0.5 2.0a2 (判为ω2) 4.0 1.0a3 (拒绝判决) 1.5 1.5解:(1)两类问题的Bayes最小误判概率准则为如果,则判,否则判。

由已知数据,q12=0.3/0.7=3/7,样本x1:∵ l12(x1)=0.1/0.8<q12=3/7 \ x1Îω2样本x2:∵ l12(x2)=0.15/0.7<q12=3/7 \ x2Îω2样本x3:∵ l12(x3)=0.3/0.55>q12=3/7 \ x3Îω1样本x4:∵ l12(x4)=0.6/0.3>q12=3/7 \ x4Îω1(2)不含拒绝判决的两类问题的Bayes最小风险判决准则为如果,则判,否则判。

由已知数据,q12=0.3´(2 - 1)/[0.7´(4 - 0.5)]=3/24.5,样本x1:∵ l12(x1)=1/8>q12=6/49 \ x1Îω1样本x2:∵ l12(x2)=3/14>q12=6/49 \ x2Îω1样本x3:∵ l12(x3)=6/11>q12=6/49 \ x3Îω1样本x4:∵ l12(x4)=6/3>q12=6/49 \ x4Îω1(3)含拒绝判决的两类问题的Bayes最小风险判决准则为其中条件风险:后验概率:记 (4.7-1)则,含拒绝判决的两类问题的Bayes最小风险判决准则为对四个样本逐一列写下表,用(4.7-1)式计算r(aj|x)。

模式识别期末复习笔记

模式识别期末复习笔记模式识别ch2 贝叶斯决策1.贝叶斯公式2.贝叶斯决策的特例a)先验概率相同(均匀先验概率):决策仅依赖于类条件概率密度b)类条件概率密度相同:决策仅依赖于先验概率3.计算题(医学测试⽅法)4.计算题(车⾝⾼低)5.贝叶斯决策的最优性a)最⼩化误差概率的⾓度i.每次均选择概率⼤的类做判断结果,因此错误概率永远是最⼩的b)最⼩化风险的⾓度i.每次均选择条件风险最⼩的结果,因此总风险最⼩6.对于两类分类问题,最⼩风险贝叶斯决策a)可以基于似然⽐进⾏决策b)p(x|ω1)p(x|ω2)≥λ12?λ22λ21?λ11p(ω2)p(ω1)则判断为1类,否则为2类c)似然⽐超过某个阈值(θ),那么可判决为ω1类7.0-1损失(误判是等价的):最⼩化风险就是最⼤化后验,也就是选择后验最⼤的a)最⼩化误差概率与最⼩化风险等价,即选择最⼤后验的分类,即满⾜最⼩误差概率,也满⾜最⼩风险8.先验概率未知时如何设计风险最⼩的分类器?a)使先验概率取任意值时的总风险的最坏情况尽可能⼩b)极⼩化极⼤准则:i.极⼩化指的是贝叶斯风险,因为它是总风险的最⼩值ii.极⼤化指的是使贝叶斯风险达到最⼤iii.贝叶斯风险是和先验有关的,其最⼤也就是其极值,就是导数等于0 的时候c)极⼩化极⼤风险是最坏的贝叶斯风险9.从最⼩化误差概率的意义上讲,贝叶斯是最优的;贝叶斯决策得到的总风险也是最⼩的10.判别函数a)对于两类分类,根据判别函数的正负进⾏类的判断;对于多类问题,两两组成两类问题b)两类问题下:g(x)=g1(x)?g2(x)i.若g(x)≥0,即g1(x)≥g2(x),则判断为1类,否则为2类c)g1(x),g2(x)的设计i.最⼩总风险贝叶斯分类器1.g1(x)=?R(α1|x),风险的相反数ii.最⼩误差概率贝叶斯分类器1. g 1(x )=p (ω1|x )2. g 1(x )=p (x|ω1)p (ω1)3. g 1(x )=log(p (x|ω1))+log(p (ω1))11.12. 计算题(决策边界为何下偏)ch3 参数估计1. 模式分类的途径(截图)2. 当可⽤数据很多以⾄于减轻了先验知识的作⽤时,贝叶斯估计可退化为最⼤似然估计。

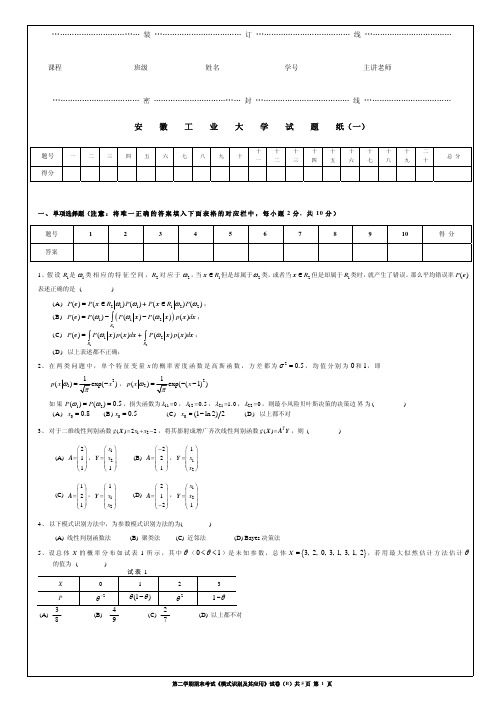

10-11学年第二学期期末考试《模式识别及其应用》试卷(B)(1)

……………………………… 密 ……………………………… 封 ………………………………… 线 ……………………………… 安 徽 工 业 大 学 试 题 纸(二)

二 、 简答题 ( 任 选 四 个 小 题 作 答 , 每 小 题 5 分 , 共 3 0 分 ) (1)试说明应用线性判别函数方法和 Bayes 决策方法进行模式分类各自的前提是什么? (2)为什么要进行特征选择与特征提取?特征选择的基本原则是什么? (3)定性说明基于参数方法和非参数方法的概率密度估计有什么区别,用于模式识别各有什么优缺点。 (4)试给出线性分类器中,Fisher 准则、感知器准则和最小平方误差准则函数的具体定义形式。 (5)对于M 类( ω1 ,……, ωM )的分类问题,假设将第 j 类样本分到第 i 类的损失为 λij ,给定每一类的先验概率 P(ωi ) 和条件概率密度 p ( x ωi ) 。请用公 式叙述基于最小风险的贝叶斯决策过程,说明在什么情况下最小风险决策等价于最大后验概率决策。 (6)试说明基于统计方法的模式识别系统主要由哪几部分构成,各有什么功能?

(4)设 ωmax 为类别状态,此时对所有的 i ( i =1 ,…, c ) ,有 P(ωmax x ) ≥ P(ωi x) , ①证明 P(ωmax x ) ≥1 c ; ②证明对于最小错误率的 Bayes 决策规则,平均误差概率为 P(e ) =1− ∫ P(ωmax x ) p ( x )d x ; ③利用这两个结论证明 P (e ) ≤ (c −1) c 。

……………………………… 密……………………………… 封 ………………………………… 线 ……………………………… 安

三、非主观题: 本大题 8 分) ( 似然比决策准则为:若 l ( x ) =

1模式识别与机器学习思考题及参考答案

模式识别与机器学习期末考查思考题1:简述模式识别与机器学习研究的共同问题和各自的研究侧重点。

机器学习是研究让机器(计算机)从经验和数据获得知识或提高自身能力的科学。

机器学习和模式识别是分别从计算机科学和工程的角度发展起来的。

然而近年来,由于它们关心的很多共同问题(分类、聚类、特征选择、信息融合等),这两个领域的界限越来越模糊。

机器学习和模式识别的理论和方法可用来解决很多机器感知和信息处理的问题,其中包括图像/视频分析、(文本、语音、印刷、手写)文档分析、信息检索和网络搜索等。

近年来,机器学习和模式识别的研究吸引了越来越多的研究者,理论和方法的进步促进了工程应用中识别性能的明显提高。

机器学习:要使计算机具有知识一般有两种方法;一种是由知识工程师将有关的知识归纳、整理,并且表示为计算机可以接受、处理的方式输入计算机。

另一种是使计算机本身有获得知识的能力,它可以学习人类已有的知识,并且在实践过程中不总结、完善,这种方式称为机器学习。

机器学习的研究,主要在以下三个方面进行:一是研究人类学习的机理、人脑思维的过程;和机器学习的方法;以及建立针对具体任务的学习系统。

机器学习的研究是在信息科学、脑科学、神经心理学、逻辑学、模糊数学等多种学科基础上的。

依赖于这些学科而共同发展。

目前已经取得很大的进展,但还没有能完全解决问题。

模式识别:模式识别是研究如何使机器具有感知能力,主要研究视觉模式和听觉模式的识别。

如识别物体、地形、图像、字体(如签字)等。

在日常生活各方面以及军事上都有广大的用途。

近年来迅速发展起来应用模糊数学模式、人工神经网络模式的方法逐渐取代传统的用统计模式和结构模式的识别方法。

特别神经网络方法在模式识别中取得较大进展。

理解自然语言计算机如能“听懂”人的语言(如汉语、英语等),便可以直接用口语操作计算机,这将给人们带来极大的便利。

计算机理解自然语言的研究有以下三个目标:一是计算机能正确理解人类的自然语言输入的信息,并能正确答复(或响应)输入的信息。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

分类方法

◦ 感知器算法:

perceptron criterion 随机梯度下降求解 缺点

分类方法

◦ Logistic regression

MLE+SGD求解 多类logistic regression: Cross Entropy Loss Function

产生式方法

◦ 高斯判别分析(GDA):用多变量正态分布对p(x|y)进行建模, 通过MLE求解。 ◦ GDA VS LR ◦ 朴素贝叶斯(Naï ve Bayes):X是离散情况时的GDA ◦ NB VS LR

Bagging Boosting AdaBoost Active Learning

分类器设计时重采样技术

Estimating and comparing classifiers

◦ Cross validation

深度学习(DL)及其应用 前沿 DL在CV领域应用的启 示 关键算法介绍

层次聚类:

◦ agglomerative clustering:逐渐合并 ◦ divisive clustering:逐渐拆分

DBSCAN (Density-Based Spatial Clustering of Applications with Noise)思想

Mean-Shift Clustering: The main idea: iteratively locate the maxima of a density function given data samples A Recent Clustering Algorithm:

◦ 类概率密度是正态分布,均值向量和协方差矩阵

均值和协方差矩阵的非随机参数的估计

◦ 均值和协方差矩阵的估计量定义 ◦ 均值和协方差矩阵估计量的迭代运算

均值向量和协方差矩阵的贝叶斯学习

◦ 一般概念 ◦ 单变量正态密度函数的均值学习

贝叶斯判别别

ቤተ መጻሕፍቲ ባይዱ

贝叶斯最小风险判别:当考虑到对于某一类的错误判

决要比对另一类的判决更为关键时,就需要把最小错误概 率的贝叶斯判别做一些修正,提出条件平均风险rj(x)

第一章

概论 第二章 统计判别 第三章 判别函数 第四章 特征选择和提取 第五章 句法模式识别 第六章 统计学习理论基础 第七章 有监督学习基础算法 第八章 支持向量机 第九章 无监督学习与半监督学习 第十章 图模型基础 第十一章 集成学习 第十二章 神经网络与深度学习

◦ SMO: Sequential Minimal

SVR:一般形式及其对偶问题 Multi-class SVM:一对多。 VC dimension:一般而言, VC 维 越大, 学习能力就 越强,学习也越复杂;可以通过 VC 维 计算学习风 险的上界

概念 K-means:形式化,思想 高斯混合模型及EM算法(思想,步骤)

掌握相关的概念:模式、机器学习、基本构成 例如模式的概念:

◦ 广义地说,存在于时间和空间中可观察的物体,如果我 们可以区别它们是否相同或是否相似,都可以称之为模 式。 ◦ 模式所指的不是事物本身,而是从事物获得的信息,因 此,模式往往表现为具有时间和空间分布的信息。 ◦ 模式的直观特性:

可观察性 可区分性 相似性

◦ Perceptron及学习算法 ◦ 多层感知机(MLP)及其BP 算法 ◦ Auto-Encoder ◦ CNN及其主要变种

关于DL的思考与讨论

1.18日,13:30-15:30

◦ 从d维空间到一维空间的一般数学变换方法 ◦ Fisher准则函数的定义 ◦ 基于最佳变换向量的投影

◦ 线性判别函数的感知器赏罚训练算法

感知器算法 采用感知器算法的多类模式的分类 可训练的确定性分类器的迭代算法

◦ 梯度法 ◦ 固定增量的逐次调整算法 ◦ 最小平方误差算法

势函数法

◦ 判别函数的产生

经验风险最小化(Empirical Risk Minimization) 结构风险最小化(Structural Risk Minimization):所谓的结构风险最小 化就是在保证分类精度(经验风险)的同时,降低学习机器的 VC 维, 可以使学习机器在整个样本集上的期望风险得到控制。

Statistical Machine Learning

回归方法(regression method)

◦ 线性回归(Linear Regression):

梯度下降求解:closed form solution 随机梯度下降:Stochastic Gradient Descent 在高斯噪声的情形下,最小化均方误差(LMS)的和与最大化似然 (MLE)得到的解是一样的。 Regularized LMS 与最大化后验MAP在先验为 时,等价。

◦ local density ◦ its distance from points of higher density:

◦ All points within the cluster are mutually densityconnected; ◦ If a point is density-reachable from any point of the cluster, it is part ofthe cluster as well.

分析步骤

势函数的选择

◦ 第一类势函数:对称的有限多项式展开 ◦ 第二类势函数:双变量的对称函数

决策树简介

◦ 概念 ◦ 二叉树

概念、意义 模式类别可分性的测度:类内散度矩阵、类间散度 矩阵

特征选择:定义可分性准则函数,如类内距离小, 类距离大

特征提取:K-L变换(PCA)

◦ 思想:选取变换矩阵,使得降维后的新向量在最小均方差条件下

模式识别系统的基本构成

数据 获取 预处理

分类器设 计

特征提取和 选择

分类决 策

机器学习的基本构成

环境 学习 知识库 执行与评价

数据聚类 统计分类 结构模式识别 神经网络 监督学习 无监督学习 半监督学习 集成学习 增强学习 深度学习

在贝叶斯分类器中,构造分类器需要知道类概率密 度函数。

离散的有限K-L展开 K-L展开式的性质

◦ K-L展开式系数的计算步骤

按K-L展开式选择特征

◦ 三条结论 ◦ 实例

不考

Machine Learning(概念、学习方法的分类、历史) Statistical Machine Learning ◦ 一般框架、形式化: ◦ 产生式、判别式模型:前者先推断p(x,y),再利用贝叶斯求p(y|x);后 者直接求解p(y|x) ◦ 过拟合和正则项(Overtting and Regularization):

线性判别函数

◦ 用判别函数分类的概念 ◦ 线性判别函数的一般形式和分类问题

两类问题 多类情况:三类情况

广义线性判别函数

◦ 基本思想 ◦ 广义线性判别函数的意义

线性的判别函数 判别函数选用二次多项式函数 判别函数选用r次多项式函数

分段线性判别函数 模式空间和权空间

Fisher线性判别

◦ 偏差方差分解(Bias and Variance Decomposition)

Trade-off:

◦ A good insight into model complexity issue:

Very flexible models having low bias and high variance. Relatively rigid models having high bias and low variance. The model with the optimal predictive capacity is the one that leads to the best balance between bias and variance.

接近原来的向量x

离散K-L变换

◦ 将原来的特征做正交变换,获得的每个数据都是原来n个数 据的线性组合,然后从新的数据中选出少数几个,使其尽可 能多地反映各类模式之间的差异,而这些特征间又尽可能相 互独立,则比单纯的选择方法更灵活、更有效。 ◦ K-L变换就是一种适用于任意概率密度函数的正交变换。

流形学习

◦ ◦ ◦ ◦ ◦ Multidimensional Scaling(MDS): 点对距离 Kernel PCA Isomap:保持内在几何结构(测地距离) LLE:映射到低维空间时要保持局部线性结构 LPP:保持局部结构

半监督学习 假设:平滑假设 Disagreement-based 方法:Co-training Low-density separation方法:transductive SVM Graph-based SSL:加入不同的正则项得到不同的 方法

◦ Manifold regularization ◦ Laplacian Regularization least squares

Bayesian 网络:推断、分类 Markov 链:HMM

◦ Likelihood evaluation: --前向、后向算法 ◦ 最佳路径求解--动态规划,viterbi ◦ 参数估计 – Baum-Welch

Markov随机场

◦ 条件独立 ◦ 分解 ◦ 例子