Flink学习笔记-Window简单示例

Flink学习(十四)Flink窗口、时间和水位线

Flink学习(⼗四)Flink窗⼝、时间和⽔位线Flink 框架中⽀持事件时间、摄⼊时间和处理时间三种。

⽽当我们在流式计算环境中数据从 Source 产⽣,再到转换和输出,这个过程由于⽹络和反压的原因会导致消息乱序。

因此,需要有⼀个机制来解决这个问题,这个特别的机制就是“⽔位线”。

Flink 的窗⼝和时间根据窗⼝数据划分的不同,⽬前 Flink ⽀持如下 3 种:滚动窗⼝,窗⼝数据有固定的⼤⼩,窗⼝中的数据不会叠加;滑动窗⼝,窗⼝数据有固定的⼤⼩,并且有⽣成间隔;会话窗⼝,窗⼝数据没有固定的⼤⼩,根据⽤户传⼊的参数进⾏划分,窗⼝数据⽆叠加。

Flink 中的时间分为三种:事件时间(Event Time),即事件实际发⽣的时间;摄⼊时间(Ingestion Time),事件进⼊流处理框架的时间;处理时间(Processing Time),事件被处理的时间。

下⾯的图详细说明了这三种时间的区别和联系:事件时间(Event Time事件时间(Event Time)指的是数据产⽣的时间,这个时间⼀般由数据⽣产⽅⾃⾝携带,⽐如 Kafka 消息,每个⽣成的消息中⾃带⼀个时间戳代表每条数据的产⽣时间。

Event Time 从消息的产⽣就诞⽣了,不会改变,也是我们使⽤最频繁的时间。

利⽤ Event Time 需要指定如何⽣成事件时间的“⽔印”,并且⼀般和窗⼝配合使⽤,具体会在下⾯的“⽔印”内容中详细讲解。

我们可以在代码中指定 Flink 系统使⽤的时间类型为 EventTime:final StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();//设置时间属性为 EventTimeenv.setStreamTimeCharacteristic(TimeCharacteristic.EventTime);DataStream<MyEvent> stream = env.addSource(new FlinkKafkaConsumer09<MyEvent>(topic, schema, props));stream.keyBy( (event) -> event.getUser() ).timeWindow(Time.hours(1)).reduce( (a, b) -> a.add(b) ).addSink(...);Flink 注册 EventTime 是通过 InternalTimerServiceImpl.registerEventTimeTimer 来实现的可以看到,该⽅法有两个⼊参:namespace 和 time,其中 time 是触发定时器的时间,namespace 则被构造成为⼀个 TimerHeapInternalTimer 对象,然后将其放⼊KeyGroupedInternalPriorityQueue 队列中。

flink的windowall的用法

Flink的windowAll的用法什么是Flink的windowAllFlink是一个快速且可扩展的开源流处理框架,它提供了丰富的窗口操作函数来处理无限流数据。

窗口操作是流处理中的一个重要概念,它允许我们按照一定的规则将数据划分为有限大小的“窗口”,并对每个窗口进行聚合、转换或分析操作。

在Flink中,窗口操作可以根据不同的需求进行定义,如时间窗口、计数窗口和会话窗口等。

而windowAll是Flink提供的一种特殊的窗口操作,它与其他窗口操作不同之处在于,windowAll针对整个流数据集进行操作,而不对个别元素或者特定的键进行操作。

windowAll可以将所有来自输入流的元素分配到窗口中,然后执行聚合、排序或者其他操作,最后产生输出结果。

在本文中,我们将深入探讨Flink中windowAll的用法及实例,并介绍如何使用它来解决实际的数据处理问题。

使用windowAll的场景windowAll适用于那些不需要按照特定的键或者条件对数据进行分组操作,而是希望对整个数据集进行窗口操作的场景。

通常情况下,windowAll用于以下两种场景:1.数据预处理:在一些应用中,我们可能希望在对数据进行分组和聚合之前,对整个数据集进行一些数据清洗或者准备工作。

这时候可以使用windowAll对整个数据集进行操作,将不同的数据归并到一起,然后进行预处理操作。

2.数据分析和排序:有时候,我们需要对整个数据集进行一些全局性的分析或者排序操作。

例如,我们要对一个无限的数字流进行累加操作,不关心元素之间的关系,只需要将所有输入元素累加起来。

这种情况下,windowAll非常适合。

除了以上两种场景,还有其他一些特殊的应用场景,可能需要使用windowAll来处理数据。

在实际使用中,我们需要根据具体的需求来决定是否使用windowAll。

windowAll的使用方法使用windowAll的关键是定义窗口的类型和规则。

Flink支持多种窗口类型,如时间窗口、计数窗口、会话窗口等,每种窗口都有其特定的属性和使用条件。

Flink学习笔记

一、计算引擎的发展首先第一代的计算引擎,无疑就是 Hadoop 承载的 MapReduce。

这里大家应该都不会对MapReduce 陌生,它将计算分为两个阶段,分别为 Map 和 Reduce。

对于上层应用来说,就不得不想方设法去拆分算法,甚至于不得不在上层应用实现多个 Job 的串联,以完成一个完整的算法,例如迭代计算。

由于这样的弊端,催生了支持 DAG 框架的产生。

因此,支持 DAG 的框架被划分为第二代计算引擎。

如 Tez 以及更上层的 Oozie。

这里我们不去细究各种 DAG 实现之间的区别,不过对于当时的 Tez 和 Oozie 来说,大多还是批处理的任务。

接下来就是以 Spark 为代表的第三代的计算引擎。

第三代计算引擎的特点主要是 Job 内部的DAG 支持(不跨越Job),以及强调的实时计算。

在这里,很多人也会认为第三代计算引擎也能够很好的运行批处理的 Job。

随着第三代计算引擎的出现,促进了上层应用快速发展,例如各种迭代计算的性能以及对流计算和 SQL 等的支持。

Flixxxxnk 的诞生就被归在了第四代。

这应该主要表现在 Flixxxxnk 对流计算的支持,以及更一步的实时性上面。

当然Flixxxxnk 也可以支持 Batch 的任务,以及DAG 的运算。

①DAG是什么DAG(Directed Acyclic Graph)有向无环图。

有向无环图指的是一个无回路的有向图。

如果有一个非有向无环图,且A点出发向B经C可回到A,形成一个环。

将从C到A的边方向改为从A到C,则变成有向无环图。

有向无环图的生成树个数等于入度非零的节点的入度积。

在中,如果一个无法从某个顶点出发经过若干条边回到该点,则这个图是一个有向无环图(DAG图)。

图是数据结构中最复杂的,泛指无组织的结构体由关联关系形成图。

DAG(有向无环图)是拓扑图的一种,比较有规律,适合做血缘关系描述。

深度挖掘,机器学习,统计学都是跟图有关的,由于图不像其他数据结构一样有一个合理的组织,因此寻址的时间复杂度和空间复杂度一般都超过O(n的平方),就是要用双倍的内存或时间来查找整个图。

flink window 代码实例

flink window 代码实例Flink是一个比较优秀的分布式流处理框架,它的window窗口是一个很重要的特性。

它允许我们对无界流数据进行切分,以一定的规则对这些数据进行分析计算,这也是实时流处理的核心问题。

那么下面我们就来看一下如何通过flink的window API来实现这个特性。

首先我们要明确两个概念:窗口和触发器。

窗口是一个固定大小的区间,而触发器是一种可以定义何时执行计算的规则。

窗口的划分方式有很多种,例如按照时间、按照数据数量、按照事件等方式来划分。

而触发器可以根据需求设定,例如固定时间触发、数据数量触发等等。

接下来,我们就将分步骤来具体讲解如何实现flink的window 功能。

1. 引入依赖在pom.xml中增加以下依赖:```<dependency><groupId>org.apache.flink</groupId><artifactId>flink-java</artifactId><version>${flink.version}</version></dependency><dependency><groupId>org.apache.flink</groupId><artifactId>flink-streaming-java_${scala.binary.version}</artifactId><version>${flink.version}</version></dependency>```2. 连接到Flink集群我们需要首先连接到一个Flink集群才能进行后续操作:```StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();env.setParallelism(1); // 设置并行数为1env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime); // 设置时间属性为EventTime```3. 定义数据流可以从文件中读取数据,也可以从其他数据源中读取数据。

FlinkCumulateWindow

FlinkCumulateWindowFlink 累计窗⼝之前⼀直⽐较遗憾,Flink Sql 没有 Trigger 功能,长时间的窗⼝不能在中途触发计算,输出中间结果。

⽽很多实时指标是⼩时、天级的累集窗⼝,⽐如⼤屏中的当⽇ pv、uv,整体是⼀天中所有访问的次数和⽤户数,但是需要实时更新,⽐如每 10S 更新⼀次截⽌到当前的pv、uv。

这种场景使⽤ Streaming Api 很容易实现,就是个天的翻滚窗⼝加上 10S 的 Trigger 就可以了.windowAll(TumblingEventTimeWindows.of(Time.days(1), Time.hours(-8))).trigger(ContinuousProcessingTimeTrigger.of(Time.seconds(10)))Flink 1.13 版本以前,Sql 中还不能实现这个功能,1.13 添加了 CUMULATE 窗⼝,可以⽀持这种场景。

(感谢 antigeneral 同学提醒有这个功能)以下为官⽹介绍:累积窗⼝在某些情况下⾮常有⽤,例如在固定窗⼝间隔内提前触发的滚动窗⼝。

例如,每⽇仪表板绘制从 00:00 到10:00 处每分钟累积的 UV, UV 表⽰从 00:00 到 10:00 的 UV 总数。

这可以通过 CUMULATE 窗⼝轻松地实现。

CUMULATE 函数将元素分配给覆盖初始步长间隔内的窗⼝,并每⼀步扩展到⼀个步长(保持窗⼝开始固定),直到最⼤窗⼝⼤⼩。

您可以将 CUMULATE 函数视为⾸先应⽤ TUMBLE 最⼤窗⼝⼤⼩的窗⼝,然后将每个滚动窗⼝拆分为具有相同窗⼝开例如,您可以有⼀个 1 ⼩时步长和 1 天最⼤⼤⼩的累积窗⼝,并且您将获得每天的窗⼝:[00:00, 01:00), [00:00, 02:00), [00:00, 03:00), ..., [00:00, 24:00)。

这些CUMULATE函数根据列分配窗⼝。

flink的windowall的用法

flink的windowall的用法Flink中的`WindowAll`是一种窗口类型,它适用于在整个数据流上执行滚动窗口计算。

与其他窗口类型不同,`WindowAll`不需要将输入流分区,因此适用于全局计算场景。

要使用`WindowAll`,需要使用`ExecutionEnvironment`创建一个批处理环境,并使用`env.fromElements()`将数据加载到DataSet 中。

然后,可以使用`windowAll()`方法指定窗口大小和滑动间隔,并通过`apply()`方法传递自定义的窗口函数来执行计算。

例如,以下代码将创建一个DataSet,并使用`WindowAll`在整个数据集上执行滚动窗口计算:```val env = ExecutionEnvironment.getExecutionEnvironmentval data: DataSet[(String, Int)] = env.fromElements(("A", 1), ("B", 2), ("C", 3), ("D", 4), ("E", 5))// 每两个元素作为一个窗口,滑动步长为1val result = data.windowAll(SlidingProcessingTimeWindows.of(Time.seconds(2), Time.seconds(1))).apply(new WindowFunction[(String, Int), String, TimeWindow] {override def apply(window: TimeWindow, input:Iterable[(String, Int)], out: Collector[String]): Unit = {var sum = 0for (elem <- input) {sum += elem._2}out.collect(s"Window ${window.getStart}-${window.getEnd}: $sum")}})```此代码将会在每两个元素作为一个窗口,滑动步长为1的情况下,统计数据集合中每个窗口的元素值之和。

flink sql window join写法

flink sql window join写法一、概述Flink SQL窗口连接(Window Join)是一种在Flink SQL中实现窗口操作和连接的语法,用于对数据进行窗口化处理并执行连接操作。

窗口连接允许在数据窗口内对数据进行聚合、过滤和比较,从而获得更精细的数据分析结果。

二、窗口连接语法Flink SQL窗口连接的语法如下:```sqlSELECT 列1, 列2, ..., 窗口函数(列)FROM 表WINDOW window_name AS (PARTITION BY 列1 ORDER BY 列2)```其中,`SELECT`语句用于指定要选择的列和窗口函数;`FROM`语句指定要连接的表;`WINDOW`语句定义了窗口名称和窗口定义,包括分区(`PARTITION BY`)和排序(`ORDER BY`)子句。

三、窗口函数的用法窗口函数用于在窗口内对数据进行操作,常见的窗口函数包括聚合函数(如`SUM`、`AVG`、`COUNT`等)、过滤函数(如`FILTER`)和比较函数(如`RANK`、`ROW_NUMBER`等)。

以下是一个使用窗口函数的示例:```sqlSELECT product_id, SUM(sales_amount) OVER (PARTITION BYproduct_category ORDER BY sale_date) AS total_salesFROM sales_tableWINDOW product_category AS (PARTITION BY product_id), sale_date AS (ORDER BY sale_time)```上述示例中,使用`SUM`聚合函数对每个产品类别内的销售金额进行求和,并按销售日期进行排序。

通过窗口连接,可以在一个查询中获取每个产品类别在不同时间段的总销售额。

四、注意事项在使用窗口连接时,需要注意以下几点:1. 窗口函数的参数可以自定义,根据需要选择合适的函数和参数。

flux.window的用法

flux.window的用法Flux是一款流行的前端框架,用于构建现代化的Web应用程序。

在Flux 中,window对象用于管理应用程序的全局状态和事件。

本文将介绍flux.window 的用法,包括其基本概念、使用方法和常见用法示例。

一、基本概念Flux.window是Flux框架中的一个重要组成部分,它提供了一种用于管理应用程序全局状态和事件的方式。

在Flux应用程序中,window对象通常作为应用程序的根容器,用于容纳其他组件和状态管理对象。

Flux.window对象具有以下特点:1.它是应用程序的根容器,容纳其他组件和状态管理对象。

2.它提供了访问应用程序状态和事件的方法,例如getAppState()和handleEvent()。

3.它允许组件之间进行通信和交互,从而实现应用程序的协作和一致性。

二、使用方法使用Flux.window对象,您可以轻松地管理应用程序的状态和事件。

以下是使用Flux.window的一些基本方法:1.创建Flux.window对象:您可以使用Flux框架提供的构造函数来创建一个window对象。

例如:varwindow=newFlux.Window();2.访问应用程序状态:您可以使用getAppState()方法来访问应用程序的状态。

该方法返回一个包含应用程序状态的对象的引用。

例如:varappState=window.getAppState();3.处理应用程序事件:您可以使用handleEvent()方法来处理应用程序的事件。

该方法接受一个事件对象作为参数,并返回一个布尔值表示是否处理了该事件。

例如:window.handleEvent(eventObject);4.注册组件:您可以将组件注册到窗口对象中,以便在需要时访问它们的状态和事件。

例如:window.registerComponent("myComponent",MyComponent);5.发布事件:您可以使用窗口对象来发布自定义事件,以便其他组件可以监听这些事件并进行相应的处理。

flink水位线和窗口时间的例题讲解

flink水位线和窗口时间的例题讲解假设我们有一批数据表示不同用户购买商品的记录,数据格式如下:```userId, purchaseTime, purchaseAmount1, 2021-01-01 10:00:00, 10.01, 2021-01-01 10:30:00, 20.02, 2021-01-01 11:00:00, 15.02, 2021-01-01 11:30:00, 5.0```我们想要计算每个用户在过去1个小时内的购买总金额。

首先,我们需要定义一个窗口,表示每个用户在过去1个小时的窗口。

窗口的起始时间可以通过当前事件的时间减去1个小时得到。

然后,我们可以将每个事件分发到对应用户的窗口中。

Flink中可以使用`window`函数来定义窗口,比如使用`TumblingProcessingTimeWindows.of(Time.hours(1))`表示大小为1小时的滚动窗口。

然后,我们使用`keyBy`函数将数据按照用户ID进行分组,以便将相同用户的数据发送到同一个流中。

然后,我们可以使用`window`函数对该流进行分窗。

Flink提供了多种类型的窗口操作符,根据实际需求选择合适的窗口操作符。

在本例中,我们使用的是处理时间窗口操作符`window(TumblingProcessingTimeWindows.of(Time.hours(1)))`。

接下来,我们可以使用`reduce`函数将同一窗口中的事件进行聚合。

在聚合函数中,我们可以计算购买金额的总和。

具体实现如下:```javaDataStream<Tuple3<Integer, String, Double>> result = stream.keyBy(0).window(TumblingProcessingTimeWindows.of(Time.hours(1))) .reduce(new ReduceFunction<Tuple3<Integer, String, Double>>() {@Overridepublic Tuple3<Integer, String, Double>reduce(Tuple3<Integer, String, Double> value1, Tuple3<Integer, String, Double> value2) throws Exception {return new Tuple3<>(value1.f0, value1.f1, value1.f2 + value2.f2);}});```最后,我们可以使用`print`函数输出结果。

flux.window用法 -回复

flux.window用法-回复Flux是一种用于构建用户界面的Java库。

它通过使用一种称为React的声明式编程模型来管理状态和UI更新。

在Flux中,窗口管理是一项重要的任务,它允许我们定义和控制在应用程序中显示的界面元素。

在本文中,我们将一步一步地回答关于Flux窗口的用法和实践。

第一步:了解Flux窗口的概念Flux窗口是指应用程序中的一个可视化单元。

它可以是一个全屏窗口,也可以是一个部分窗口,用于在应用程序中显示和交互。

Flux窗口可以包含各种UI元素,如文本框、按钮、下拉菜单等。

通过管理窗口,我们可以改变应用程序的状态并更新用户界面。

第二步:创建一个Flux窗口在Flux中,我们使用窗口工厂来创建窗口对象。

窗口工厂是一个工厂函数,它返回一个窗口对象。

我们可以使用工厂的静态方法来创建窗口对象,例如:javaWindowFactory factory = new WindowFactory();Window window = factory.createWindow();在这个例子中,我们首先实例化一个窗口工厂对象,然后使用工厂的`createWindow()`方法创建一个窗口对象。

第三步:设置窗口的属性和样式创建窗口之后,我们可以设置窗口的属性和样式。

通过窗口对象,我们可以访问和修改窗口的各种属性,如标题、大小、位置等。

例如:javawindow.setTitle("My Window");window.setSize(800, 600);window.setPosition(100, 100);在这个例子中,我们使用窗口的`setTitle()`方法设置窗口的标题为"My Window",使用`setSize()`方法设置窗口的大小为800x600像素,使用`setPosition()`方法设置窗口的位置为(100, 100)像素。

此外,我们还可以设置窗口的样式,如背景颜色、字体、边框等。

flink会话窗口案例

flink会话窗口案例Apache Flink 是一个流处理和批处理的开源框架。

会话窗口(Session Window)是一种时间窗口的类型,主要应用在有数据产生的时间间隔未知或者非固定的场景。

以下是一个简单的 Flink 会话窗口的案例:假设有一个应用程序需要跟踪用户在网站上的活动。

如果用户在连续的10分钟内没有任何活动,那么该会话将被关闭。

这个应用程序可以使用会话窗口来实现。

首先,我们需要定义一个时间间隔,比如10分钟,作为会话的超时时间。

然后,我们可以使用 Flink 的时间窗口函数来对数据进行分组,使得相同用户的活动都在同一个窗口中。

如果在一个窗口中没有新的活动记录,那么这个窗口就可以被认为是一个关闭的会话。

在 Flink 中,可以使用TumblingProcessingTimeWin dows 函数来创建一个时间窗口,并使用window() 函数来指定窗口的触发器。

例如:java复制代码DataStream<Tuple2<String, Long>> result = inp ut.keyBy(0) // 按用户ID进行分组.window(TumblingProcessingTimeWindows.of(Time.minutes(10))) // 创建10分钟的时间窗口.trigger(ProcessingTimeTrigger.create()) // 使用处理时间触发器.sum(1); // 对每个窗口中的活动数量进行求和这个例子中,keyBy(0) 函数用于按用户ID对数据进行分组,TumblingProcessingTimeWindows.of(Time.minute s(10)) 函数用于创建一个10分钟的时间窗口,Processin gTimeTrigger.create() 函数用于创建一个处理时间触发器。

最后,sum(1) 函数用于对每个窗口中的活动数量进行求和。

flink入门实例-Windows下本地模式跑SocketWordCount

flink⼊门实例-Windows下本地模式跑SocketWordCount⼀般情况下,开发⼤数据处理程序,我们希望能够在本地编写代码并调试通过,能够在本地进⾏数据测试,然后在⽣产环境去跑“⼤”数据。

⼀、nc⼯具使⽤命令开始nc制定端⼝为9000(nc -L -p 9000 -v)启动插件⼆、idea中配置,代码以及设置参数maven配置:<?xml version="1.0" encoding="UTF-8"?><project xmlns="/POM/4.0.0"xmlns:xsi="/2001/XMLSchema-instance"xsi:schemaLocation="/POM/4.0.0 /xsd/maven-4.0.0.xsd"><modelVersion>4.0.0</modelVersion><groupId>lims</groupId><artifactId>flink-project</artifactId><version>1.0-SNAPSHOT</version><properties><flink.version>1.7.2</flink.version></properties><dependencies><!--log4j--><dependency><groupId>log4j</groupId><artifactId>log4j</artifactId><version>1.2.17</version></dependency><!--flink--><dependency><groupId>org.apache.flink</groupId><artifactId>flink-java</artifactId><version>${flink.version}</version></dependency><dependency><groupId>org.apache.flink</groupId><artifactId>flink-streaming-java_2.11</artifactId><version>${flink.version}</version></dependency><dependency><groupId>org.apache.flink</groupId><artifactId>flink-clients_2.11</artifactId><version>${flink.version}</version></dependency><dependency><groupId>org.apache.flink</groupId><artifactId>flink-connector-wikiedits_2.11</artifactId><version>${flink.version}</version></dependency></dependencies></project>WordCount:package flink;import mon.functions.FlatMapFunction;import org.apache.flink.api.java.utils.ParameterTool;import org.apache.flink.streaming.api.datastream.DataStream;import org.apache.flink.streaming.api.datastream.DataStreamSource;import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;import org.apache.flink.streaming.api.windowing.time.Time;import org.apache.flink.util.Collector;/*** @Description: TODO* @Date: 2019/2/25 23:49*/public class WordCount {public static void main(String[] args) throws Exception {//定义socket的端⼝号int port;try{ParameterTool parameterTool = ParameterTool.fromArgs(args);port = parameterTool.getInt("port");}catch (Exception e){System.err.println("没有指定port参数,使⽤默认值9000");。

flink window 代码实例

flink window 代码实例Flink Window代码实例Flink是一个分布式流处理框架,它提供了丰富的API和工具,使得开发者可以轻松地构建和管理大规模的实时数据处理应用程序。

其中,Window是Flink中非常重要的一个概念,它可以帮助我们对数据流进行分组、聚合和处理,从而实现更加复杂的数据分析和处理任务。

下面,我们将通过一个简单的Flink Window代码实例来介绍Window的基本用法和实现方式。

我们需要定义一个数据源,这里我们使用Flink提供的SocketTextStreamFunction来模拟一个实时的数据流。

具体代码如下:```DataStream<String> text = env.socketTextStream("localhost", 9999); ```接下来,我们可以使用Flink提供的Window API来对数据流进行分组和聚合。

这里我们使用TumblingWindow来实现每5秒钟对数据流进行一次聚合操作。

具体代码如下:```text.keyBy(0).window(TumblingProcessingTimeWindows.of(Time.seconds(5))) .sum(1).print();```在上面的代码中,我们首先使用keyBy函数对数据流进行分组,然后使用window函数来定义窗口的类型和大小,这里我们使用TumblingProcessingTimeWindows来定义一个大小为5秒钟的窗口。

最后,我们使用sum函数对窗口内的数据进行求和操作,并使用print函数将结果输出到控制台。

完整的代码如下:```import org.apache.flink.streaming.api.datastream.DataStream;importorg.apache.flink.streaming.api.environment.StreamExecutionEnviron ment;importorg.apache.flink.streaming.api.windowing.assigners.TumblingProcess ingTimeWindows;import org.apache.flink.streaming.api.windowing.time.Time;public class WindowExample {public static void main(String[] args) throws Exception {final StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();DataStream<String> text = env.socketTextStream("localhost", 9999);text.keyBy(0).window(TumblingProcessingTimeWindows.of(Time.seconds (5))).sum(1).print();env.execute("Window Example");}}```在运行上面的代码之前,我们需要先启动一个Socket服务器,并将数据发送到9999端口。

flink入门(四)——window概念和时间、水位线

flink⼊门(四)——window概念和时间、⽔位线⼀、窗⼝概述

窗⼝的概念:⽤来将⽆限流切分为有限流,分发到有限⼤⼩的桶中进⾏处理

窗⼝的分类:⼤致分为时间窗⼝和计数窗⼝

窗⼝的边界:左闭右开

⼆、窗⼝介绍

1.滚动时间窗⼝

由固定的窗⼝长度控制,不会有重叠

2.滑动时间窗⼝

由窗⼝size和滑动距离控制,元素会有重叠,当然,步长=size的时候,将会是没有重叠的滚动时间窗⼝

3.会话窗⼝

超过⼀定距离,就视为⼀个窗⼝,⼀个会话

三、window的使⽤

1.使⽤⼊门⽰例:(根据参数个数可以知道是哪种类型的窗⼝)

2.创建各种类型的window⽰例:

3.窗⼝函数

四、flink中的时间

时间概念;

在代码中设置event TIme的⽅法:

当然,有时候是会出现event Time受⽹络等影响,出现乱序问题!

类似做班车时,到了发车时间点,却发现乘客还有⼀些未到齐,此时通常会有“等⼏分钟”的操作。

这个操作对⽐在flink中就是通过⽔位线watermark,

来实现等⼏分钟的操作,等乱序的元素进⼊窗⼝了再“发车”!

3.⽔位线的概念

⽔位线的特点:

图中⽰例:右边数据1来的时候,插⼊⼀个⽔位2,表⽰2以前的数据都来了,后续的watermark类似的原理

在⾯对多分区时,会以⽔位最低的分区的watermark作为最终的watermark,类似⽊桶理论,以最短的为准。

watermark代码中的实践:。

Flink窗口介绍及应用

Flink窗⼝介绍及应⽤Windows是Flink流计算的核⼼,本⽂将概括的介绍⼏种窗⼝的概念,重点只放在窗⼝的应⽤上。

本实验的数据采⽤⾃拟电影评分数据(userId, movieId, rating, timestamp),userId和movieId范围分别为1-100和1-200的随机数,rating范围为[0:0.5:5.0]⼀共10个档位,timestamp为10000-20000之间的随机数,且数据顺序采⽤timestamp的升序排列。

(2.1-2.6节的数据是乱序)⼀、窗⼝(window)的类型对于窗⼝的操作主要分为两种,分别对于Keyedstream和Datastream。

他们的主要区别也仅仅在于建⽴窗⼝的时候⼀个为.window(...),⼀个为.windowAll(...)。

对于Keyedstream的窗⼝来说,他可以使得多任务并⾏计算,每⼀个logical key stream将会被独⽴的进⾏处理。

stream.keyBy(...) <- keyed versus non-keyed windows.window(...)/.windowAll(...) <- required: "assigner"[.trigger(...)] <- optional: "trigger" (else default trigger)[.evictor(...)] <- optional: "evictor" (else no evictor)[.allowedLateness(...)] <- optional: "lateness" (else zero)[.sideOutputLateData(...)] <- optional: "output tag" (else no side output for late data).reduce/aggregate/fold/apply() <- required: "function"[.getSideOutput(...)] <- optional: "output tag"按照窗⼝的Assigner来分,窗⼝可以分为Tumbling window, sliding window,session window,global window,custom window每种窗⼝⼜可分别基于processing time和event time,这样的话,窗⼝的类型严格来说就有很多。

FlinkSQLWindow源码全解析

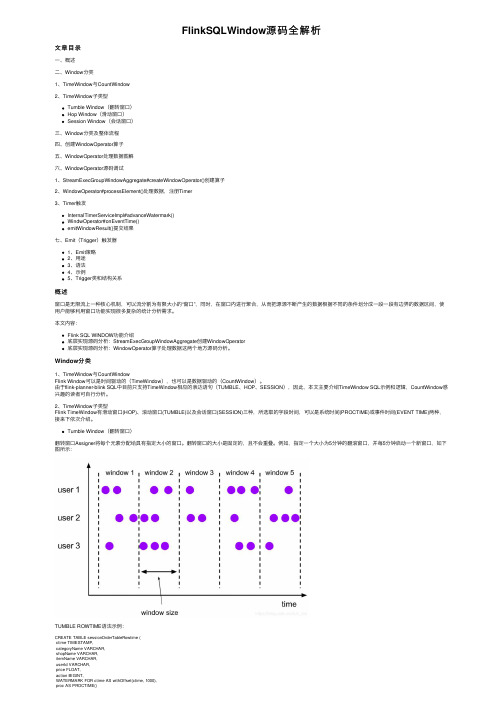

FlinkSQLWindow源码全解析⽂章⽬录⼀、概述⼆、Window分类1、TimeWindow与CountWindow2、TimeWindow⼦类型Tumble Window(翻转窗⼝)Hop Window(滑动窗⼝)Session Window(会话窗⼝)三、Window分类及整体流程四、创建WindowOperator算⼦五、WindowOperator处理数据图解六、WindowOperator源码调试1、StreamExecGroupWindowAggregate#createWindowOperator()创建算⼦2、WindowOperator#processElement()处理数据,注册Timer3、Timer触发InternalTimerServiceImpl#advanceWatermark()WindwOperator#onEventTime()emitWindowResult()提交结果七、Emit(Trigger)触发器1、Emit策略2、⽤途3、语法4、⽰例5、Trigger类和结构关系概述窗⼝是⽆限流上⼀种核⼼机制,可以流分割为有限⼤⼩的“窗⼝”,同时,在窗⼝内进⾏聚合,从⽽把源源不断产⽣的数据根据不同的条件划分成⼀段⼀段有边界的数据区间,使⽤户能够利⽤窗⼝功能实现很多复杂的统计分析需求。

本⽂内容:Flink SQL WINDOW功能介绍底层实现源码分析:StreamExecGroupWindowAggregate创建WindowOperator底层实现源码分析:WindowOperator算⼦处理数据这两个地⽅源码分析。

Window分类1、TimeWindow与CountWindowFlink Window可以是时间驱动的(TimeWindow),也可以是数据驱动的(CountWindow)。

由于flink-planner-blink SQL中⽬前只⽀持TimeWindow相应的表达语句(TUMBLE、HOP、SESSION),因此,本⽂主要介绍TimeWindow SQL⽰例和逻辑,CountWindow感兴趣的读者可⾃⾏分析。

彻底搞清Flink中的Window

彻底搞清Flink中的Window关注公众号:⼤数据技术派,回复: 资料,领取1024G资料。

本⽂⾸发于我的个⼈博客:窗⼝在流处理应⽤中,数据是连续不断的,因此我们不可能等到所有数据都到了才开始处理。

当然我们可以每来⼀个消息就处理⼀次,但是有时我们需要做⼀些聚合类的处理,例如:在过去的1分钟内有多少⽤户点击了我们的⽹页。

在这种情况下,我们必须定义⼀个窗⼝,⽤来收集最近⼀分钟内的数据,并对这个窗⼝内的数据进⾏计算。

Flink 认为 Batch 是 Streaming 的⼀个特例,所以 Flink 底层引擎是⼀个流式引擎,在上⾯实现了流处理和批处理。

⽽窗⼝(window)就是从 Streaming 到 Batch 的⼀个桥梁。

⼀个Window代表有限对象的集合。

⼀个窗⼝有⼀个最⼤的时间戳,该时间戳意味着在其代表的某时间点——所有应该进⼊这个窗⼝的元素都已经到达Window就是⽤来对⼀个⽆限的流设置⼀个有限的集合,在有界的数据集上进⾏操作的⼀种机制。

window⼜可以分为基于时间(Time-based)的window以及基于数量(Count-based)的window。

Flink DataStream API提供了Time和Count的window,同时增加了基于Session的window。

同时,由于某些特殊的需要,DataStream API也提供了定制化的window操作,供⽤户⾃定义window。

窗⼝的组成窗⼝分配器assignWindows将某个带有时间戳timestamp的元素element分配给⼀个或多个窗⼝,并返回窗⼝集合getDefaultTrigger 返回跟WindowAssigner关联的默认触发器getWindowSerializer返回WindowAssigner分配的窗⼝的序列化器窗⼝分配器定义如何将数据元分配给窗⼝。

这是通过WindowAssigner 在window(...)(对于被Keys化流)或windowAll()(对于⾮被Keys化流)调⽤中指定您的选择来完成的。

flux.window用法 -回复

flux.window用法-回复“flux.window用法”是指Flux库中的window函数的用法。

Flux是一个专门用于处理数据流的库,它提供了许多方便的函数来处理和操作数据流。

其中window函数可以用于将数据流进行分块处理和分析。

在本文中,我将一步一步回答关于flux.window用法的问题,并提供一些示例来帮助读者更好地理解。

首先,我们需要了解window函数的基本作用和用法。

window函数用于将数据流分成固定大小的块,并对这些块进行处理和分析。

它接受两个参数:size和step。

size参数指定了每个窗口的大小,而step参数指定了每次滑动的步长。

通过调整这两个参数,我们可以灵活地控制窗口的大小和间隔。

接下来,让我们详细地介绍一下window函数的使用方法。

首先,我们需要导入flux模块,并创建一个数据流。

可以使用flux.from_sequence函数创建一个简单的数据流,也可以从其他数据源中读取数据创建。

pythonimport fluxdata = flux.from_sequence(range(10))接下来,我们可以使用window函数对数据流进行分块处理。

我们可以通过传递size和step参数来指定窗口的大小和步长。

pythonwindows = data.window(size=3, step=2)通过上述代码,我们创建了一个窗口大小为3,步长为2的窗口。

这意味着我们将原始数据流分成了4个窗口,每个窗口包含3个元素,并且每个窗口之间相隔2个元素。

接下来,我们可以通过遍历窗口来处理和分析数据。

例如,我们可以使用map函数对每个窗口进行求和操作。

pythonresults = windows.map(sum)通过上述代码,我们将每个窗口中的元素求和,并将结果保存在一个新的数据流中。

接下来,我们可以通过订阅这个数据流来查看结果。

pythonresults.subscribe(print)通过上述代码,我们将结果打印输出。

flink 开窗函数

flink 开窗函数摘要:1.简介2.Flink 开窗函数的类型3.滚动窗口4.会话窗口5.滑动窗口6.计算示例7.总结正文:Flink 是一种流处理框架,广泛应用于大数据处理领域。

在Flink 中,开窗函数是一种重要的数据处理操作,能够对数据按照时间或者事件顺序进行分组和聚合。

本文将介绍Flink 开窗函数的相关知识。

Flink 开窗函数主要分为以下几种类型:1.滚动窗口(Tumbling Windows):按照固定时间间隔对数据进行分组,适用于处理固定时间间隔的数据。

2.会话窗口(Session Windows):按照事件顺序对数据进行分组,适用于处理具有会话性质的数据,例如用户访问网站的行为。

3.滑动窗口(Sliding Windows):按照时间或事件顺序对数据进行分组,适用于处理连续的数据。

下面我们通过一个简单的例子来了解这三种窗口的具体应用:假设我们有一个用户行为的日志数据,包括用户ID、行为类型和发生时间。

我们想要计算每个用户在一段时间内的行为次数。

使用滚动窗口:我们可以设定一个固定时间间隔(例如5 分钟),然后对每个用户的行为记录进行分组。

在每组数据中,我们可以计算用户在这5 分钟内的行为次数。

最后,我们可以将所有组的结果汇总,得到每个用户在一段时间内的行为次数。

使用会话窗口:我们可以设定一个会话超时时间(例如30 分钟),然后对每个用户的行为记录按照时间顺序进行分组。

在每组数据中,我们可以计算用户在这段时间内的行为次数。

最后,我们可以将所有组的结果汇总,得到每个用户在一段时间内的行为次数。

使用滑动窗口:我们可以设定一个滑动时间间隔(例如10 分钟),然后对每个用户的行为记录按照时间顺序进行分组。

在每组数据中,我们可以计算用户在这10 分钟内的行为次数。

我们可以不断调整滑动时间间隔,计算不同时间范围内的行为次数。

总之,Flink 开窗函数为大数据处理提供了强大的时间序列分析能力。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Flink学习笔记-Window简单示例WindowFlink中Window可以将无限流切分成有限流,是处理有限流的核心组件,现在Flink中Window可以是时间驱动的Time Window,也可以是数据驱动的Count Window。

基于时间的窗口操作:在每个相同的时间间隔对Stream中的记录进行处理,通常各个时间间隔内的窗口操作处理的记录数不固定。

基于数据驱动的窗口操作:可以在Stream中选择固定数量的记录作为一个窗口,对该窗口中的记录进行处理。

窗口类型Tumbling Window(滚动窗口):窗口间的元素无重复一个翻滚窗口分配器的每个数据元分配给指定的窗口的窗口大小。

翻滚窗具有固定的尺寸,不重叠。

Sliding Window(滑动窗口):窗口间的元素可能重复该滑动窗口分配器分配元件以固定长度的窗口。

与翻滚窗口分配器类似,窗口大小由窗口大小参数配置。

附加的窗口滑动参数控制滑动窗口的启动频率。

因此,如果幻灯片小于窗口大小,则滑动窗口可以重叠。

在这种情况下,数据元被分配给多个窗口。

Session Window(会话窗口)在会话窗口中按活动会话分配器组中的数据元。

与翻滚窗口和滑动窗口相比,会话窗口不重叠并且没有固定的开始和结束时间。

相反,当会话窗口在一段时间内没有接收到数据元时,即当发生不活动的间隙时,会关闭会话窗口。

会话窗口分配器可以配置静态会话间隙或会话间隙提取器函数,该函数定义不活动时间段的长度。

当此期限到期时,当前会话将关闭,后续数据元将分配给新的会话窗口。

Global Window(全局窗口)一个全局性的窗口分配器分配使用相同的Keys相同的单个的所有数据元全局窗口。

此窗口方案仅在您还指定自定义触发器时才有用。

否则,将不执行任何计算,因为全局窗口没有我们可以处理聚合数据元的自然结束。

Window Function在窗口触发后,负责对窗口内的元素进行计算。

Window Function分为两类: 增量聚合和全量聚合。

增量聚合: 窗口不维护原始数据,只维护中间结果,每次基于中间结果和增量数据进行聚合。

如: ReduceFunction、AggregateFunction等。

全量聚合: 窗口需要维护全部原始数据,窗口触发进行全量聚合。

如:ProcessWindowFunction。

Time的分类Event-Time :事件时间是每个事件在其生产设备上发生的时间。

Ingestion-Time :摄取时间是事件进入Flink的时间。

Processing-Time :处理时间是指执行相应算子操作的机器的系统时间。

不设置Time 类型,默认是processingTime。

可以如下方式修改时间特性:env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime);Watermark主要解决延迟数据、乱序问题Watermark是Apache Flink为了处理EventTime窗口计算提出的一种机制,本质上也是一种时间戳,由Apache Flink Source或者自定义的Watermark生成器按照需求Punctuated或者Periodic两种方式生成的一种系统Event,与普通数据流Event一样流转到对应的下游算子,接收到Watermark Event的算子以此不断调整自己管理的EventTime Clock。

Watermark两种生成方式:Periodic - 周期性(一定时间间隔或者达到一定的记录条数)产生一个Watermark,默认周期为200毫秒。

在实际的生产中Periodic的方式必须结合时间和积累条数两个维度继续周期性产生Watermark,否则在极端情况下会有很大的延时。

接口 AssignerWithPeriodicWatermarksPunctuated:数据流中每一个递增的EventTime都会产生一个Watermark。

没有时间周期规律,可打断的生成Watermark。

在实际的生产中Punctuated方式在TPS很高的场景下会产生大量的Watermark在一定程度上对下游算子造成压力,所以只有在实时性要求非常高的场景才会选择Punctuated的方式进行Watermark 的生成。

接口 AssignerWithPunctuatedWatermarks在基于Event-Time的流处理应用中,每个数据有两个必需的信息:时间戳:事件发生的时间Watermark:算子通过Watermark推断当前的事件时间。

Watermark用于通知算子没有比水位更小的时间戳的事件会发生了。

基于时间的窗口会根据事件时间将一个数据分配给某个窗口。

每个时间窗口都有一个开始时间戳和结束时间戳。

所有内置的窗口分配器都会提供一个默认的触发器,一旦时间超过某个窗口的结束时间,触发器就会触发对这个窗口的计算。

API简单示例import java.sql.Timestampimport java.text.SimpleDateFormatimport java.util.Propertiesimport mon.functions.AggregateFunctionimport mon.serialization.SimpleStringSchemaimport mon.state.{ListState, ListStateDescriptor}import org.apache.flink.configuration.Configurationimport org.apache.flink.streaming.api.TimeCharacteristicimportorg.apache.flink.streaming.api.functions.timestamps.BoundedOutOfOrdernessTimestampExtractor import org.apache.flink.streaming.api.functions.{AssignerWithPeriodicWatermarks, AssignerWithPunctuatedWatermarks, KeyedProcessFunction}import org.apache.flink.streaming.api.scala._import org.apache.flink.streaming.api.scala.function.WindowFunctionimport org.apache.flink.streaming.api.watermark.Watermarkimport org.apache.flink.streaming.api.windowing.time.Timeimport org.apache.flink.streaming.api.windowing.windows.TimeWindowimport org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumerimport org.apache.flink.util.Collectorimport scala.collection.mutable.ListBuffercase class UserBehavior(userId:Long, itemId:Long, behavior:String, timestamp:Long)case class ItemCount(itemId:Long, count:Long, timestamp:Long)object TopNHotItemsGenerator {def main(args: Array[String]): Unit = {val env = StreamExecutionEnvironment.getExecutionEnvironmentenv.setParallelism(1)// 设置水位间隔,默认200毫秒env.getConfig.setAutoWatermarkInterval(100)// 设置时间特性env.setStreamTimeCharacteristic(TimeCharacteristic.EventTime)val dateFormat = new SimpleDateFormat("yyyy-MM-dd hh:mm:ss")val properties = new Properties()properties.setProperty("bootstrap.servers", "192.168.0.1:9092")properties.setProperty("group.id", "tmp-1")properties.setProperty("key.deserializer","mon.serialization.StringDeserializer")properties.setProperty("value.deserializer","mon.serialization.StringDeserializer")properties.setProperty("auto.offset.reset", "latest")val dataStream = env.addSource(new FlinkKafkaConsumer[String]("tmp1", new SimpleStringSchema(), properties)).map(data => {val dataArray = data.split(",")UserBehavior(dataArray(0).trim().toLong, dataArray(1).trim().toLong,dataArray(2).trim(), dateFormat.parse(dataArray(3).trim()).getTime)}).assignAscendingTimestamps(_.timestamp) // 数据中提取时间戳/** 定义水位生成方式.assignTimestampsAndWatermarks(newBoundedOutOfOrdernessTimestampExtractor[UserBehavior](Time.seconds(1)) {override def extractTimestamp(t: UserBehavior): Long = {t.timestamp}}).assignAscendingTimestamps(new PeriodicWatermarksAssigner()).assignAscendingTimestamps(new PunctuatedWatermarksAssigner())*/dataStream.print()val aggregateStream = dataStream.filter(_.behavior == "click").keyBy(_.itemId).timeWindow(Time.hours(1), Time.minutes(5)).aggregate(new CountAggregate(), new WindowAggregateResult()) // 窗口聚合aggregateStream.print()val processStream = aggregateStream.keyBy(_.timestamp).process(new TopNHotItemsProcessFunction(2))processStream.print()env.execute("topn hot items")}}class CountAggregate() extends AggregateFunction[UserBehavior, Long, Long] {override def createAccumulator(): Long = 0Loverride def add(in: UserBehavior, acc: Long): Long = acc + 1override def getResult(acc: Long): Long = accoverride def merge(acc: Long, acc1: Long): Long = acc + acc1}class AvgAggregate() extends AggregateFunction[UserBehavior, (Long, Long), Double] {override def createAccumulator(): (Long, Long) = (0L, 0L)override def add(in: UserBehavior, acc: (Long, Long)): (Long, Long) = (acc._1 + in.timestamp, acc._2 + 1)override def getResult(acc: (Long, Long)): Double = acc._1 / acc._2override def merge(acc: (Long, Long), acc1: (Long, Long)): (Long, Long) = (acc._1 + acc1._1, acc._2 + acc1._2)}class WindowAggregateResult() extends WindowFunction[Long, ItemCount, Long, TimeWindow] {override def apply(key: Long, window: TimeWindow, input: Iterable[Long], out: Collector[ItemCount]): Unit = {out.collect(ItemCount(key, input.iterator.next(), window.getEnd))}}class TopNHotItemsProcessFunction(topN: Int) extends KeyedProcessFunction[Long, ItemCount, String] {var itemsState:ListState[ItemCount] = _override def open(parameters: Configuration): Unit = {super.open(parameters)itemsState = getRuntimeContext.getListState(new ListStateDescriptor[ItemCount]("hot-items-state", classOf[ItemCount]))}override def processElement(value: ItemCount, context: KeyedProcessFunction[Long, ItemCount, String]#Context, collector: Collector[String]): Unit = {itemsState.add(value)// 注册事件时间定时器context.timerService().registerEventTimeTimer(value.timestamp + 1)}override def onTimer(timestamp: Long, ctx: KeyedProcessFunction[Long, ItemCount, String]#OnTimerContext, out: Collector[String]): Unit = {val items:ListBuffer[ItemCount] = new ListBuffer[ItemCount]()import scala.collection.JavaConversions._for (item <- itemsState.get()) {items += item}val topNHotItems = items.sortBy(_.count)(Ordering.Long.reverse).take(topN)val result: StringBuilder = new StringBuilder()result.append("time: ").append(new Timestamp(timestamp - 1)).append("\n")for (i <- topNHotItems.indices) {val hotItem = topNHotItems(i)result.append("top%d: itemId %d count %d".format(i + 1, hotItem.itemId, hotItem.count)).append("\n")}result.append("====================")out.collect(result.toString())itemsState.clear()}}class PeriodicWatermarksAssigner extends AssignerWithPeriodicWatermarks[UserBehavior] {val bound: Long = 60000; //延时一分钟var maxTs: Long = Long.MinValue //最大时间戳override def getCurrentWatermark: Watermark = {new Watermark(maxTs - bound)}override def extractTimestamp(element: UserBehavior, l: Long): Long = {maxTs = maxTs.max(element.timestamp)element.timestamp}}class PunctuatedWatermarksAssigner extends AssignerWithPunctuatedWatermarks[UserBehavior] { val bound: Long = 60000; //延时一分钟override def checkAndGetNextWatermark(element: UserBehavior, l: Long): Watermark = {if (element.behavior == "") {new Watermark(l - bound)} else {null}}override def extractTimestamp(element: UserBehavior, l: Long): Long = element.timestamp}// 侧输出流处理class CProcessFunctioin extends ProcessFunction[(String, Int), String] {lazy val outputTag: OutputTag[String] = new OutputTag[String]("coutput")override def processElement(element: (String, Int), context: ProcessFunction[(String, Int), String]#Context, collector: Collector[String]): Unit = {if (element._2 < 15) {context.output(outputTag, "cot %s %d".format(element._1, element._2))} else {collector.collect("%s %d".format(element._1, element._2))}}}。