Hadoop 集群基本操作命令-王建雄-2016-08-22

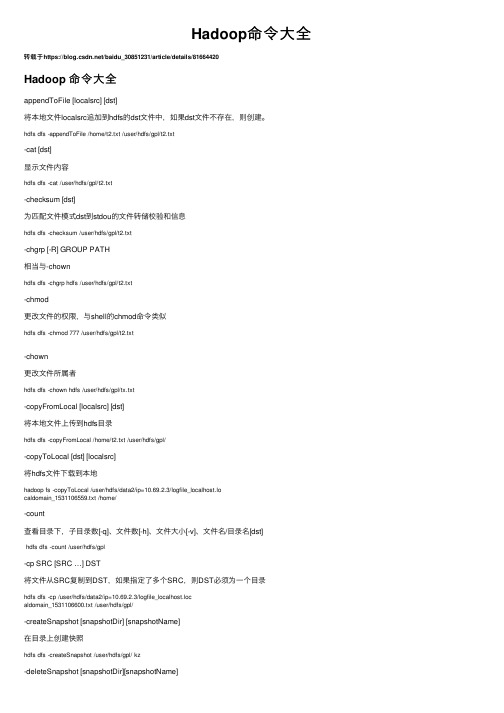

Hadoop命令大全

Hadoop命令⼤全转载于https:///baidu_30851231/article/details/81664420Hadoop 命令⼤全appendToFile [localsrc] [dst]将本地⽂件localsrc追加到hdfs的dst⽂件中,如果dst⽂件不存在,则创建。

hdfs dfs -appendToFile /home/t2.txt /user/hdfs/gpl/t2.txt-cat [dst]显⽰⽂件内容hdfs dfs -cat /user/hdfs/gpl/t2.txt-checksum [dst]为匹配⽂件模式dst到stdou的⽂件转储校验和信息hdfs dfs -checksum /user/hdfs/gpl/t2.txt-chgrp [-R] GROUP PATH相当与-chownhdfs dfs -chgrp hdfs /user/hdfs/gpl/t2.txt-chmod更改⽂件的权限,与shell的chmod命令类似hdfs dfs -chmod 777 /user/hdfs/gpl/t2.txt-chown更改⽂件所属者hdfs dfs -chown hdfs /user/hdfs/gpl/tx.txt-copyFromLocal [localsrc] [dst]将本地⽂件上传到hdfs⽬录hdfs dfs -copyFromLocal /home/t2.txt /user/hdfs/gpl/-copyToLocal [dst] [localsrc]将hdfs⽂件下载到本地hadoop fs -copyToLocal /user/hdfs/data2/ip=10.69.2.3/logfile_localhost.localdomain_1531106559.txt /home/-count查看⽬录下,⼦⽬录数[-q]、⽂件数[-h]、⽂件⼤⼩[-v]、⽂件名/⽬录名[dst]hdfs dfs -count /user/hdfs/gpl-cp SRC [SRC …] DST将⽂件从SRC复制到DST,如果指定了多个SRC,则DST必须为⼀个⽬录hdfs dfs -cp /user/hdfs/data2/ip=10.69.2.3/logfile_localhost.localdomain_1531106600.txt /user/hdfs/gpl/-createSnapshot [snapshotDir] [snapshotName]在⽬录上创建快照hdfs dfs -createSnapshot /user/hdfs/gpl/ kz-deleteSnapshot [snapshotDir][snapshotName]在⽬录上删除快照hdfs dfs -deleteSnapshot /user/hdfs/gpl/kz-df显⽰⽂件系统的容量、空闲空间和使⽤空间hdfs dfs -df /user/hdfs/gpl-du显⽰该⽬录中每个⽂件或⽬录的⼤⼩hdfs dfs -du -s -h /user/hdfs-expunge清空回收站,⽂件被删除时,它⾸先会移到临时⽬录.Trash/中,当超过延迟时间之后,⽂件才会被永久删除 hdfs dfs -expunge-find查找与指定表达式匹配的所有⽂件hdfs dfs -find /user/hdfs -name t2.txt-get将hdfs⽂件下载到本地与-copyToLocal 类似hadoop fs -get /user/hdfs/data2/ip=10.69.2.3/logfile_localhost.localdomain_1531106559.txt /home/-getfacl [-R] [path]显⽰⽂件和⽬录的访问控制列表(acl)。

hadoop命令及使用方法

hadoop命令及使用方法Hadoop是一个分布式计算框架,用于存储和处理大规模数据集。

下面是一些常用的Hadoop命令及其使用方法:1. hdfs命令:- hdfs dfs -ls <路径>:列出指定路径下的文件和目录。

- hdfs dfs -mkdir <路径>:创建一个新的目录。

- hdfs dfs -copyFromLocal <本地路径> <HDFS路径>:将本地文件复制到HDFS 上。

- hdfs dfs -copyToLocal <HDFS路径> <本地路径>:将HDFS上的文件复制到本地。

- hdfs dfs -cat <文件路径>:显示HDFS上的文件内容。

2. mapred命令:- mapred job -list:列出当前正在运行的MapReduce作业。

- mapred job -kill <job_id>:终止指定的MapReduce作业。

3. yarn命令:- yarn application -list:列出当前正在运行的应用程序。

- yarn application -kill <application_id>:终止指定的应用程序。

4. hadoop fs命令(与hdfs dfs命令功能相似):- hadoop fs -ls <路径>:列出指定路径下的文件和目录。

- hadoop fs -cat <文件路径>:显示HDFS上的文件内容。

- hadoop fs -mkdir <路径>:创建一个新的目录。

- hadoop fs -put <本地文件路径> <HDFS路径>:将本地文件复制到HDFS上。

- hadoop fs -get <HDFS路径> <本地文件路径>:将HDFS上的文件复制到本地。

hadoop集群的基本操作

hadoop集群的基本操作

Hadoop是一个开源的分布式计算系统,采用HDFS存储数据,通过MapReduce实现大规模数据处理和分析。

以下是Hadoop集群的一些基本操作:

1. 启动与关闭Hadoop集群:使用start-all.sh脚本启动Hadoop集群,使用stop-all.sh脚本关闭Hadoop集群。

2. 管理HDFS文件系统:使用hadoop fs命令可以对HDFS文件系统进行管理,如创建目录、上传下载文件、删除文件等。

3. 提交MapReduce作业:使用hadoop jar命令提交MapReduce 作业,需要指定作业的jar包、输入输出路径、作业配置等参数。

4. 监控Hadoop集群:可以通过Web界面查看Hadoop集群的运行状态,包括HDFS存储容量、MapReduce作业状态等。

5. 配置Hadoop集群:可以通过修改Hadoop集群的配置文件来改变集群运行的参数,如增加数据备份、优化作业调度等。

6. 维护Hadoop集群:定期进行日志清理、备份数据、优化集群配置等操作,保证集群的高可靠性和高性能。

以上是Hadoop集群的一些基本操作,可以帮助用户快速上手Hadoop分布式计算系统。

简述启动和关闭hadoop集群的方式以及使用的相关指令。

简述启动和关闭hadoop集群的方式以及使用的相关指令。

Hadoop是一个开源的分布式数据处理框架,通常用于存储和处理大规模的数据集。

启动和关闭Hadoop集群是使用Hadoop框架的关键步骤。

本文将一步一步回答如何启动和关闭Hadoop集群,以及使用的相关指令。

一、Hadoop集群启动方式Hadoop集群可以通过两种方式进行启动:单节点启动和多节点启动。

1. 单节点启动单节点启动适用于在本地主机运行Hadoop的开发和测试环境。

在单节点启动方式下,所有Hadoop的组件都运行在一台主机上。

以下是单节点启动Hadoop集群的步骤:1. 安装Java开发环境在启动Hadoop之前,首先需要在机器上安装Java开发环境。

Hadoop依赖于Java来运行。

可以从Oracle官方网站下载并安装Java Development Kit(JDK)。

2. 配置Hadoop环境下载Hadoop的最新版本,并解压到本地目录。

接下来,需要配置Hadoop的环境变量。

打开Hadoop的安装目录,在conf目录下找到hadoop-env.sh文件。

通过编辑这个文件,设置正确的JAVA_HOME 路径。

3. 配置Hadoop集群在启动单节点Hadoop集群之前,需要配置Hadoop集群的相关参数。

打开conf目录下的core-site.xml和hdfs-site.xml文件,分别进行配置。

主要包括配置Hadoop文件系统的URL,配置Hadoop的本地文件夹路径,以及配置Hadoop的端口号等。

4. 格式化Hadoop文件系统在单节点模式下,需要手动初始化Hadoop文件系统。

在Hadoop 的安装目录下,使用命令`bin/hdfs namenode -format` 来格式化文件系统。

5. 启动Hadoop集群在Hadoop的安装目录下,使用命令`sbin/start-all.sh`来启动Hadoop集群。

这个命令会启动Hadoop的所有组件,包括NameNode,DataNode,SecondaryNameNode,以及JobTracker 等。

hadoop集群安装配置的主要操作步骤-概述说明以及解释

hadoop集群安装配置的主要操作步骤-概述说明以及解释1.引言1.1 概述Hadoop是一个开源的分布式计算框架,主要用于处理和存储大规模数据集。

它提供了高度可靠性、容错性和可扩展性的特性,因此被广泛应用于大数据处理领域。

本文旨在介绍Hadoop集群安装配置的主要操作步骤。

在开始具体的操作步骤之前,我们先对Hadoop集群的概念进行简要说明。

Hadoop集群由一组互联的计算机节点组成,其中包含了主节点和多个从节点。

主节点负责调度任务并管理整个集群的资源分配,而从节点则负责实际的数据存储和计算任务执行。

这种分布式的架构使得Hadoop可以高效地处理大规模数据,并实现数据的并行计算。

为了搭建一个Hadoop集群,我们需要进行一系列的安装和配置操作。

主要的操作步骤包括以下几个方面:1. 硬件准备:在开始之前,需要确保所有的计算机节点都满足Hadoop的硬件要求,并配置好网络连接。

2. 软件安装:首先,我们需要下载Hadoop的安装包,并解压到指定的目录。

然后,我们需要安装Java开发环境,因为Hadoop是基于Java 开发的。

3. 配置主节点:在主节点上,我们需要编辑Hadoop的配置文件,包括核心配置文件、HDFS配置文件和YARN配置文件等。

这些配置文件会影响到集群的整体运行方式和资源分配策略。

4. 配置从节点:与配置主节点类似,我们也需要在每个从节点上进行相应的配置。

从节点的配置主要包括核心配置和数据节点配置。

5. 启动集群:在所有节点的配置完成后,我们可以通过启动Hadoop 集群来进行测试和验证。

启动过程中,我们需要确保各个节点之间的通信正常,并且集群的各个组件都能够正常启动和工作。

通过完成以上这些操作步骤,我们就可以成功搭建一个Hadoop集群,并开始进行大数据的处理和分析工作了。

当然,在实际应用中,还会存在更多的细节和需要注意的地方,我们需要根据具体的场景和需求进行相应的调整和扩展。

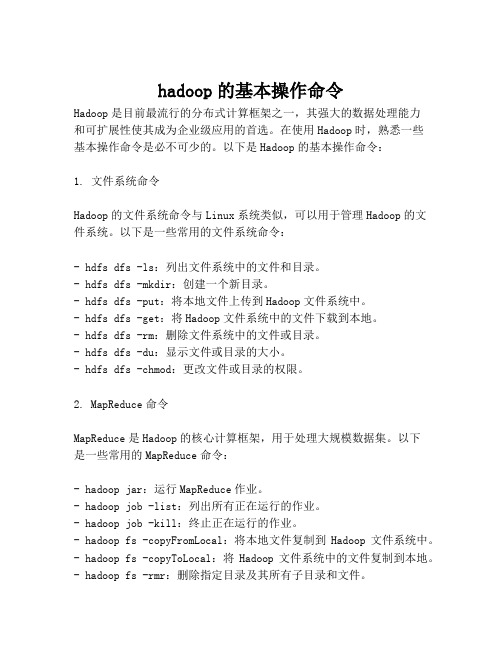

hadoop的基本操作命令

hadoop的基本操作命令Hadoop是目前最流行的分布式计算框架之一,其强大的数据处理能力和可扩展性使其成为企业级应用的首选。

在使用Hadoop时,熟悉一些基本操作命令是必不可少的。

以下是Hadoop的基本操作命令:1. 文件系统命令Hadoop的文件系统命令与Linux系统类似,可以用于管理Hadoop的文件系统。

以下是一些常用的文件系统命令:- hdfs dfs -ls:列出文件系统中的文件和目录。

- hdfs dfs -mkdir:创建一个新目录。

- hdfs dfs -put:将本地文件上传到Hadoop文件系统中。

- hdfs dfs -get:将Hadoop文件系统中的文件下载到本地。

- hdfs dfs -rm:删除文件系统中的文件或目录。

- hdfs dfs -du:显示文件或目录的大小。

- hdfs dfs -chmod:更改文件或目录的权限。

2. MapReduce命令MapReduce是Hadoop的核心计算框架,用于处理大规模数据集。

以下是一些常用的MapReduce命令:- hadoop jar:运行MapReduce作业。

- hadoop job -list:列出所有正在运行的作业。

- hadoop job -kill:终止正在运行的作业。

- hadoop fs -copyFromLocal:将本地文件复制到Hadoop文件系统中。

- hadoop fs -copyToLocal:将Hadoop文件系统中的文件复制到本地。

- hadoop fs -rmr:删除指定目录及其所有子目录和文件。

3. YARN命令YARN是Hadoop的资源管理器,用于管理Hadoop集群中的资源。

以下是一些常用的YARN命令:- yarn node -list:列出所有节点的状态。

- yarn application -list:列出所有正在运行的应用程序。

- yarn application -kill:终止正在运行的应用程序。

hadoop 操作手册

hadoop 操作手册Hadoop 是一个分布式计算框架,它使用 HDFS(Hadoop Distributed File System)存储大量数据,并通过 MapReduce 进行数据处理。

以下是一份简单的 Hadoop 操作手册,介绍了如何安装、配置和使用 Hadoop。

一、安装 Hadoop1. 下载 Hadoop 安装包,并解压到本地目录。

2. 配置 Hadoop 环境变量,将 Hadoop 安装目录添加到 PATH 中。

3. 配置 Hadoop 集群,包括 NameNode、DataNode 和 JobTracker 等节点的配置。

二、配置 Hadoop1. 配置 HDFS,包括 NameNode 和 DataNode 的配置。

2. 配置 MapReduce,包括 JobTracker 和 TaskTracker 的配置。

3. 配置 Hadoop 安全模式,如果需要的话。

三、使用 Hadoop1. 上传文件到 HDFS,使用命令 `hadoop fs -put local_file_path/hdfs_directory`。

2. 查看 HDFS 中的文件和目录信息,使用命令 `hadoop fs -ls /`。

3. 运行 MapReduce 作业,编写 MapReduce 程序,然后使用命令`hadoop jar my_` 运行程序。

4. 查看 MapReduce 作业的运行结果,使用命令 `hadoop fs -cat/output_directory/part-r-00000`。

5. 从 HDFS 中下载文件到本地,使用命令 `hadoop fs -get/hdfs_directory local_directory`。

6. 在 Web 控制台中查看 HDFS 集群信息,在浏览器中打开7. 在 Web 控制台中查看 MapReduce 作业运行情况,在浏览器中打开四、管理 Hadoop1. 启动和停止 Hadoop 集群,使用命令 `` 和 ``。

cdh集群常用命令

cdh集群常用命令以下是CDH集群中常用的命令:1. hdfs dfs -ls: 列出HDFS文件系统中的文件和目录。

2. hdfs dfs -mkdir: 在HDFS中创建新目录。

3. hdfs dfs -put: 将文件从本地文件系统上传到HDFS。

4. hdfs dfs -get: 将文件从HDFS下载到本地文件系统。

5. hdfs dfs -rm: 从HDFS中删除文件或目录。

6. hdfs dfs -chown: 更改文件或目录的所有者。

7. hdfs dfs -chmod: 更改文件或目录的权限。

8. hdfs dfs -cat: 查看文件的内容。

9. hdfs dfs -tail: 查看文件的末尾内容。

10. hdfs dfs -du: 估算文件或目录的大小。

11. hdfs dfs -mv: 移动文件或目录。

12. hdfs dfsadmin -report: 获取HDFS的报告,包括集群的容量、使用情况等信息。

13. yarn node -list: 列出YARN集群中的节点。

14. yarn application -list: 列出YARN集群中正在运行的应用程序。

15. yarn application -kill: 终止指定的YARN应用程序。

16. hadoop fsck: 检查HDFS中的文件完整性和一致性。

17. hadoop job -list: 列出运行中的Hadoop作业。

18. hadoop job -kill: 终止指定的Hadoop作业。

这些是CDH集群中常用的命令,可以帮助您管理和操作HDFS和YARN。

根据您的需求,可以使用这些命令进行文件操作、权限管理、作业管理等任务。

hadoop的基本操作命令

hadoop的基本操作命令Hadoop的基本操作命令Hadoop是一个分布式计算框架,常用于大数据处理。

本文将介绍Hadoop的基本操作命令,包括文件系统操作、作业管理、信息查看等。

一、文件系统操作1.创建目录在Hadoop中,可以使用mkdir命令创建目录。

具体用法如下:hadoop fs -mkdir /path/to/directory其中,/path/to/directory是要创建的目录路径。

2.上传文件使用put命令上传本地文件到Hadoop文件系统中。

用法如下:hadoop fs -put /path/to/local/file /path/to/hdfs/directory其中,/path/to/local/file是要上传的本地文件路径,/path/to/hdfs/directory是要上传到的Hadoop文件系统路径。

3.下载文件使用get命令将Hadoop文件系统中的文件下载到本地。

用法如下:hadoop fs -get /path/to/hdfs/file /path/to/local/directory其中,/path/to/hdfs/file是要下载的Hadoop文件系统文件路径,/path/to/local/directory是要下载到的本地文件夹路径。

4.列出目录内容使用ls命令列出指定目录下的文件和子目录。

用法如下:hadoop fs -ls /path/to/directory其中,/path/to/directory是要列出内容的目录路径。

5.删除文件或目录使用rm命令删除指定的文件或目录。

用法如下:hadoop fs -rm /path/to/file或hadoop fs -rm -r /path/to/directory其中,/path/to/file是要删除的文件路径,/path/to/directory是要删除的目录路径。

二、作业管理1.提交作业使用jar命令提交作业。

hadoop常用指令

HDFS 常用文件操作命令前言HDFS命令基本格式:hadoop fs -cmd < args >ls 命令hadoop fs -ls /列出hdfs文件系统根目录下的目录和文件hadoop fs -ls -R /列出hdfs文件系统所有的目录和文件put 命令hadoop fs -put < local file > < hdfs file >hdfs file的父目录一定要存在,否则命令不会执行hadoop fs -put < local dir >...< hdfs dir >hdfs dir 一定要存在,否则命令不会执行hadoop fs -put - < hdsf file>从键盘读取输入到hdfs file中,按Ctrl+D结束输入,hdfs file不能存在,否则命令不会执行moveFromLocal 命令hadoop fs -moveFromLocal < local src > ... < hdfs dst >与put相类似,命令执行后源文件local src 被删除,也可以从从键盘读取输入到hdfsfile中copyFromLocal 命令hadoop fs -copyFromLocal < local src > ... < hdfs dst >与put相类似,也可以从从键盘读取输入到hdfs file中get 命令hadoop fs -get < hdfs file > < local dir>local file不能和hdfs file名字不能相同,否则会提示文件已存在,没有重名的文件会复制到本地hadoop fs -get < hdfs dir > ... < local dir >拷贝多个文件或目录到本地时,本地要为文件夹路径注意:如果用户不是root,local 路径要为用户文件夹下的路径,否则会出现权限问题,moveToLocal 命令当前版本中还未实现此命令copyToLocal 命令hadoop fs -copyToLocal < local src > ... < hdfs dst >与get相类似rm 命令hadoop fs -rm < hdfs file > ...hadoop fs -rm -r < hdfs dir>...每次可以删除多个文件或目录mkdir 命令hadoop fs -mkdir < hdfs path>只能一级一级的建目录,父目录不存在的话使用这个命令会报错hadoop fs -mkdir -p < hdfs path>所创建的目录如果父目录不存在就创建该父目录getmerge 命令hadoop fs -getmerge < hdfs dir > < local file >将hdfs指定目录下所有文件排序后合并到local指定的文件中,文件不存在时会自动创建,文件存在时会覆盖里面的内容hadoop fs -getmerge -nl < hdfs dir > < local file >加上nl后,合并到local file中的hdfs文件之间会空出一行cp 命令hadoop fs -cp < hdfs file > < hdfs file >目标文件不能存在,否则命令不能执行,相当于给文件重命名并保存,源文件还存在hadoop fs -cp < hdfs dir >... < hdfs dir >目标文件夹要存在,否则命令不能执行mv 命令hadoop fs -mv < hdfs file > < hdfs file >目标文件不能存在,否则命令不能执行,相当于给文件重命名并保存,源文件不存在hadoop fs -mv < hdfs dir >... < hdfs dir >源路径有多个时,目标路径必须为目录,且必须存在。

hadoop基本命令_建表-删除-导数据

HADOOP表操作1、hadoop简单说明hadoop 数据库中的数据是以文件方式存存储。

一个数据表即是一个数据文件。

hadoop目前仅在LINUX 的环境下面运行。

使用hadoop数据库的语法即hive语法。

(可百度hive语法学习)通过s_crt连接到主机。

使用SCRT连接到主机,输入hive命令,进行hadoop数据库操作。

2、使用hive 进行HADOOP数据库操作3、hadoop数据库几个基本命令show datebases; 查看数据库内容; 注意:hadoop用的hive语法用“;”结束,代表一个命令输入完成。

usezb_dim;show tables;4、在hadoop数据库上面建表;a1: 了解hadoop的数据类型int 整型; bigint 整型,与int 的区别是长度在于int;int,bigint 相当于oralce的number型,但是不带小数点。

doubble 相当于oracle的numbe型,可带小数点;string 相当于oralce的varchar2(),但是不用带长度;a2: 建表,由于hadoop的数据是以文件有形式存放,所以需要指定分隔符。

create table zb_dim.dim_bi_test_yu3(id bigint,test1 string,test2 string)row format delimited fields terminated by '\t' stored as textfile; --这里指定'\t'为分隔符a2.1 查看建表结构: describeA2.2 往表里面插入数据。

由于hadoop的数据是以文件存在,所以插入数据要先生成一个数据文件,然后使用SFTP将数据文件导入表中。

数据文件的生成,第一步,在EXECLE中按表的顺序依次放入要需要的数据,然后复制到UE编码器中生成文件,保存格式为TXT。

Hadoop命令大全

Hadoop命令大全本节比较全面的向大家介绍一下Hadoop命令,欢迎大家一起来学习,希望通过本节的介绍大家能够掌握一些常见Hadoop命令的使用方法。

下面是Hadoop命令的详细介绍。

Hadoop命令大全1、列出所有HadoopShell支持的命令$bin/hadoopfs-help2、显示关于某个命令的详细信息$bin/hadoopfs-helpcommand-name3、用户可使用以下命令在指定路径下查看历史日志汇总$bin/hadoopjob-historyoutput-dir这条命令会显示作业的细节信息,失败和终止的任务细节。

4、关于作业的更多细节,比如成功的任务,以及对每个任务的所做的尝试次数等可以用下面的命令查看$bin/hadoopjob-historyalloutput-dir5、格式化一个新的分布式文件系统:$bin/hadoopnamenode-format6、在分配的NameNode上,运行下面的Hadoop命令启动HDFS:$bin/start-dfs.shbin/start-dfs.sh脚本会参照NameNode上${HADOOP_CONF_DIR}/slaves文件的内容,在所有列出的slave上启动DataNode守护进程。

7、在分配的JobTracker上,运行下面的命令启动Map/Reduce:$bin/start-mapred.shbin/start-mapred.sh脚本会参照JobTracker上${HADOOP_CONF_DIR}/sla ves文件的内容,在所有列出的slave上启动TaskTracker守护进程。

8、在分配的NameNode上,执行下面的Hadoop命令停止HDFS:$bin/stop-dfs.shbin/stop-dfs.sh脚本会参照NameNode上${HADOOP_CONF_DIR}/slaves文件的内容,在所有列出的slave上停止DataNode守护进程。

Hadoop集群的使用与管理

Hadoop集群的使用与管理一:Hadoop集群的启动、关闭方法1) 启动NameNode, DataNode2) 启动JournalNode, JournalNode在hdfs-site.xml中指定edits log存储的位置,主备NameNode共享数据,方便同步3) 启动DFSZKFailoverController, HA会启用ZooKeeper Failover Controller4) 启动YARN守护进程ResourceManager, NodeManager启动/停止HDFS集群:start-dfs.sh stop-dfs.sh据说如果ResourceManager和NameNode不在同一台机器上,那NameNode上无法直接使用start-yarn.sh启动ResourceManager,但NodeManager可以启动,ResourceManager需要在ResourceManager节点上启动,这一点待考证节点启动NameNode: hadoop-daemon.sh start namenode启动DataNode: hadoop-daemon.sh start datanode启动JournalNode节点: hadoop-daemon.sh start journalnode启动zkfc节点:hadoop-daemon.sh start zkfc启动ResourceManager: yarn-daemon.sh start resourcemanager启动NodeManager: yarn-daemon.sh start nodemanager启动ZooKeeper节点:zkServer.sh start 启动QuorumPeerMain进程查看ZooKeeper节点状态:zkServer.sh status 查看leader和follower状态格式化HDFS: hdfs namenode -format格式化ZKFC:hdfs zkfc -formatZK查看NameNode和DataNode信息:hdfs dfsadmin -report查看高可用NameNode状态:hdfs haadmin -getServiceState nn1 (active/standby)疑难小结:sudo /etc/init.d/iptables stop关闭防火墙,或:service iptables stop(立即生效),chkconfig iptables off(重启后生效)df -hl查看系统空间是否足够jps查看进程:服务是否都启动了,datanode数(为2)是否在safemode下:hadoop dfsadmin -safemode leave,离开sofemodehadoop dfsadmin -report不用start-all.sh启动全部服务,而是单独先后启动服务:hadoop-daemon.sh start namenodehadoop-daemon.sh start datanodehadoop-daemon.sh start secondarynamenodehadoop-daemon.sh start jobtrackerhadoop-daemon.sh start tasktracker查看启动日志(我的启动日志位于/usr/local/hadoop/logs文件夹下):hadoop-root-datanode-localhost.log 可在日志文件中定位和查看错误原因。

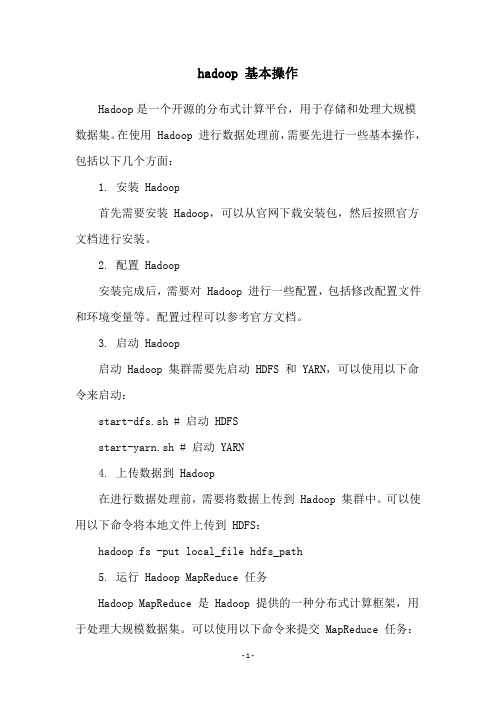

hdoop的hdfs中的常用操作命令

hdoop的hdfs中的常用操作命令Hadoop的HDFS(Hadoop Distributed File System)中常用的操作命令包括:1. ls:列出HDFS上的文件和目录`hadoop fs -ls <path>`2. mkdir:创建一个新目录`hadoop fs -mkdir <path>`3. cp:将文件从本地文件系统复制到HDFS或者在HDFS之间复制文件`hadoop fs -cp <source> <destination>`4. mv:将文件从一个位置移动到另一个位置(可以在HDFS内部或者HDFS与本地文件系统之间移动)`hadoop fs -mv <source> <destination>`5. rm:删除指定的文件或目录`hadoop fs -rm <path>`6. cat:将文件的内容打印到控制台上`hadoop fs -cat <path>`7. tail:显示文件的最后几行`hadoop fs -tail <path>`8. get:将文件从HDFS复制到本地文件系统`hadoop fs -get <source> <destination>`9. put:将文件从本地文件系统复制到HDFS`hadoop fs -put <source> <destination>`10. chmod:更改文件的权限`hadoop fs -chmod <mode> <path>`以上是HDFS中常用的操作命令。

可以使用命令`hadoop fs -help`查看更多的HDFS命令及其用法。

Hadoop常用命令及范例

Hadoop常⽤命令及范例 hadoop中的zookeeper,hdfs,以及hive,hbase都是hadoop的组件,要学会熟练掌握相关的命令及其使⽤规则,下⾯就是⼀些常⽤命令及对hbase和hive的操作语句,同时也列出了⼀些范例。

start-dfs.sh NameNode 进程启动:hadoop-daemon.sh start namenode DataNode 进程启动:hadoop-daemon.sh start datanode HA ⾼可⽤环境中需要启动的进程: zookeeper: zkServer.sh start 启动 zkServer.sh stop 停⽌ zkServer.sh status 查看状态 leader follwer journalnode 集群命令 hadoop-daemon.sh start journalnode 启动 hadoop-daemon.sh stop journalnode 停⽌ ZKFC 启动 zkfc 进程: hadoop-daemon.sh start zkfc 停⽌ zkfc 进程: hadoop-daemon.sh stop zkfc 1. shell命令管理和 HDFS 的⽂件管理。

(1)启动 Zookeeper zkServer.sh start (2)启动 HDFS 的命令 start-dfs.sh (3)启动 Yarn 的命令 start-yarn.sh (4)显⽰ HDFS 中/data/test ⽬录信息 hadoop fs -mkdir /data/test hadoop fs -lsr /data/test (5)将本地⽂件/tmp/log.txt ⽂件上传到/data/test ⽬录中 hadoop fs -put /tmp/log.txt /data/test (6)设置⽂件/data/test/log.txt 的副本数为 3 hadoop fs -setrep -w 3 /data/test/log.txt (7)显⽰/data/test/log.txt ⽂件内容 hadoop fs -cat /data/test/log.txt (8)将/data/test/log.txt ⽂件移动到集群/user/hadoop ⽬录下 hadoop fs -mkdir /user/hadoop hadoop fs -mv /data/test/log.txt /user/hadoop (9)将/data/test/log.txt ⽂件下载到/home/hadoop ⽬录下 hadoop fs -copyToLocal /data/test/log.txt /home/hadoop/ (10)关闭 HDFS 命令 stop-dfs.sh (11)停⽌ Zookeeper zkServer.sh stop 2.将学⽣数据存储到 Hive 数据仓库中,信息包括(学号,姓名,性别,年龄,联系⽅式, 邮箱),创建表语法如下: 启动 hive 前切记要先启动 mysql 数据库 create table student(sno string ,name string ,sex string ,age int ,phone string, email string) row format delimited fields terminated by ',' ;(1)将本地数据“/tmp/student.dat”加载到 student 表,写出操作语句 load data local inpath '/tmp/student.dat' overwrite into table student; (2)写 HQL 语句查询全部学⽣信息 select * from student; (3)写 HQL 语句查询各个年龄及对应学⽣数量 (4) select age,count(*) from student group by age; (5)写 HQL 语句查询全部学⽣的姓名和性别 select name,sex from student; (6)写 HQL 语句查询年龄为 18 的学⽣姓名和联系⽅式 select name,phone from student where age=18; (7)写 HQL 语句查看 student 表结构 describe student; (8)写 HQL 语句删除 student 表 drop table student; (9)导出⽣地/home/hadoop/out ⽬录,写出语 from student insert overwrite local directory '/home/hadoop/out' select *; 3.员⼯表 employee 包含两个列族 basic 和 info,使⽤ shell 命令完成以下操作。

hadoop 基本操作

hadoop 基本操作Hadoop是一个开源的分布式计算平台,用于存储和处理大规模数据集。

在使用 Hadoop 进行数据处理前,需要先进行一些基本操作,包括以下几个方面:1. 安装 Hadoop首先需要安装 Hadoop,可以从官网下载安装包,然后按照官方文档进行安装。

2. 配置 Hadoop安装完成后,需要对 Hadoop 进行一些配置,包括修改配置文件和环境变量等。

配置过程可以参考官方文档。

3. 启动 Hadoop启动 Hadoop 集群需要先启动 HDFS 和 YARN,可以使用以下命令来启动:start-dfs.sh # 启动 HDFSstart-yarn.sh # 启动 YARN4. 上传数据到 Hadoop在进行数据处理前,需要将数据上传到 Hadoop 集群中。

可以使用以下命令将本地文件上传到 HDFS:hadoop fs -put local_file hdfs_path5. 运行 Hadoop MapReduce 任务Hadoop MapReduce 是 Hadoop 提供的一种分布式计算框架,用于处理大规模数据集。

可以使用以下命令来提交 MapReduce 任务:hadoop jar jar_file input_path output_path其中,jar_file 是 MapReduce 任务的 Jar 包,input_path 是输入数据所在的路径,output_path 是输出结果的路径。

6. 下载结果数据当 MapReduce 任务完成后,可以使用以下命令将结果数据下载到本地:hadoop fs -get result_path local_path以上就是 Hadoop 的基本操作,通过掌握这些基本操作,可以更好地使用 Hadoop 进行大规模数据处理。

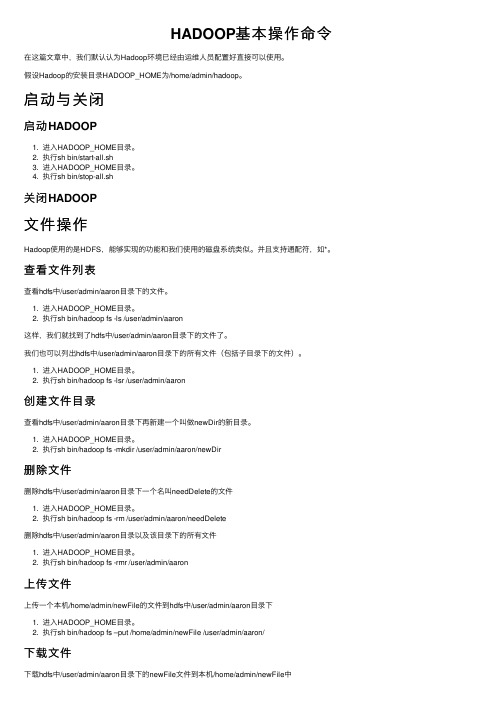

HADOOP基本操作命令

HADOOP基本操作命令在这篇⽂章中,我们默认认为Hadoop环境已经由运维⼈员配置好直接可以使⽤。

假设Hadoop的安装⽬录HADOOP_HOME为/home/admin/hadoop。

启动与关闭启动HADOOP1. 进⼊HADOOP_HOME⽬录。

2. 执⾏sh bin/start-all.sh3. 进⼊HADOOP_HOME⽬录。

4. 执⾏sh bin/stop-all.sh关闭HADOOP⽂件操作Hadoop使⽤的是HDFS,能够实现的功能和我们使⽤的磁盘系统类似。

并且⽀持通配符,如*。

查看⽂件列表查看hdfs中/user/admin/aaron⽬录下的⽂件。

1. 进⼊HADOOP_HOME⽬录。

2. 执⾏sh bin/hadoop fs -ls /user/admin/aaron这样,我们就找到了hdfs中/user/admin/aaron⽬录下的⽂件了。

我们也可以列出hdfs中/user/admin/aaron⽬录下的所有⽂件(包括⼦⽬录下的⽂件)。

1. 进⼊HADOOP_HOME⽬录。

2. 执⾏sh bin/hadoop fs -lsr /user/admin/aaron创建⽂件⽬录查看hdfs中/user/admin/aaron⽬录下再新建⼀个叫做newDir的新⽬录。

1. 进⼊HADOOP_HOME⽬录。

2. 执⾏sh bin/hadoop fs -mkdir /user/admin/aaron/newDir删除⽂件删除hdfs中/user/admin/aaron⽬录下⼀个名叫needDelete的⽂件1. 进⼊HADOOP_HOME⽬录。

2. 执⾏sh bin/hadoop fs -rm /user/admin/aaron/needDelete删除hdfs中/user/admin/aaron⽬录以及该⽬录下的所有⽂件1. 进⼊HADOOP_HOME⽬录。

2. 执⾏sh bin/hadoop fs -rmr /user/admin/aaron上传⽂件上传⼀个本机/home/admin/newFile的⽂件到hdfs中/user/admin/aaron⽬录下1. 进⼊HADOOP_HOME⽬录。

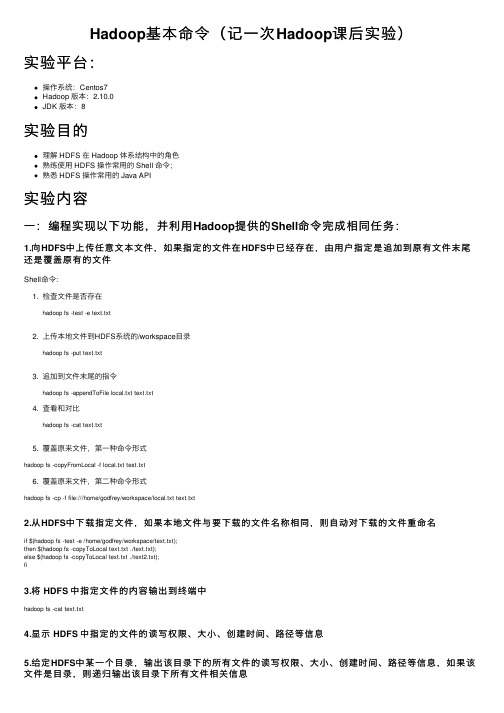

Hadoop基本命令(记一次Hadoop课后实验)

Hadoop基本命令(记⼀次Hadoop课后实验)实验平台:操作系统:Centos7Hadoop 版本:2.10.0JDK 版本:8实验⽬的理解 HDFS 在 Hadoop 体系结构中的⾓⾊熟练使⽤ HDFS 操作常⽤的 Shell 命令;熟悉 HDFS 操作常⽤的 Java API实验内容⼀:编程实现以下功能,并利⽤Hadoop提供的Shell命令完成相同任务:1.向HDFS中上传任意⽂本⽂件,如果指定的⽂件在HDFS中已经存在,由⽤户指定是追加到原有⽂件末尾还是覆盖原有的⽂件Shell命令:1. 检查⽂件是否存在hadoop fs -test -e text.txt2. 上传本地⽂件到HDFS系统的/workspace⽬录hadoop fs -put text.txt3. 追加到⽂件末尾的指令hadoop fs -appendToFile local.txt text.txt4. 查看和对⽐hadoop fs -cat text.txt5. 覆盖原来⽂件,第⼀种命令形式hadoop fs -copyFromLocal -f local.txt test.txt6. 覆盖原来⽂件,第⼆种命令形式hadoop fs -cp -f file:///home/godfrey/workspace/local.txt text.txt2.从HDFS中下载指定⽂件,如果本地⽂件与要下载的⽂件名称相同,则⾃动对下载的⽂件重命名if $(hadoop fs -test -e /home/godfrey/workspace/text.txt);then $(hadoop fs -copyToLocal text.txt ./text.txt);else $(hadoop fs -copyToLocal text.txt ./text2.txt);fi3.将 HDFS 中指定⽂件的内容输出到终端中hadoop fs -cat text.txt4.显⽰ HDFS 中指定的⽂件的读写权限、⼤⼩、创建时间、路径等信息5.给定HDFS中某⼀个⽬录,输出该⽬录下的所有⽂件的读写权限、⼤⼩、创建时间、路径等信息,如果该⽂件是⽬录,则递归输出该⽬录下所有⽂件相关信息hadoop fs -ls -R -h /6.提供⼀个HDFS内的⽂件的路径,对该⽂件进⾏创建和删除操作。

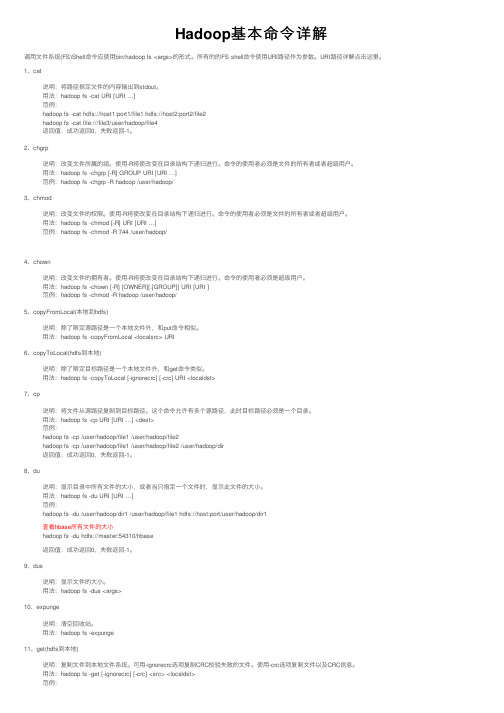

Hadoop基本命令详解

Hadoop基本命令详解调⽤⽂件系统(FS)Shell命令应使⽤bin/hadoop fs <args>的形式。

所有的的FS shell命令使⽤URI路径作为参数。

URI路径详解点击这⾥。

1、cat说明:将路径指定⽂件的内容输出到stdout。

⽤法:hadoop fs -cat URI [URI …]范例:hadoop fs -cat hdfs://host1:port1/file1 hdfs://host2:port2/file2hadoop fs -cat file:///file3/user/hadoop/file4返回值:成功返回0,失败返回-1。

2、chgrp说明:改变⽂件所属的组。

使⽤-R将使改变在⽬录结构下递归进⾏。

命令的使⽤者必须是⽂件的所有者或者超级⽤户。

⽤法:hadoop fs -chgrp [-R] GROUP URI [URI …]范例:hadoop fs -chgrp -R hadoop /user/hadoop/3、chmod说明:改变⽂件的权限。

使⽤-R将使改变在⽬录结构下递归进⾏。

命令的使⽤者必须是⽂件的所有者或者超级⽤户。

⽤法:hadoop fs -chmod [-R] URI [URI …]范例:hadoop fs -chmod -R 744 /user/hadoop/4、chown说明:改变⽂件的拥有者。

使⽤-R将使改变在⽬录结构下递归进⾏。

命令的使⽤者必须是超级⽤户。

⽤法:hadoop fs -chown [-R] [OWNER][:[GROUP]] URI [URI ]范例:hadoop fs -chmod -R hadoop /user/hadoop/5、copyFromLocal(本地到hdfs)说明:除了限定源路径是⼀个本地⽂件外,和put命令相似。

⽤法:hadoop fs -copyFromLocal <localsrc> URI6、copyToLocal(hdfs到本地)说明:除了限定⽬标路径是⼀个本地⽂件外,和get命令类似。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Hadoop 集群基本操作命令列出所有Hadoop Shell支持的命令$ bin/hadoop fs -help(注:一般手动安装hadoop大数据平台,只需要创建一个用户即可,所有的操作命令就可以在这个用户下执行;现在是使用ambari安装的dadoop大数据平台,安装过程中会自动创建hadoop生态系统组件的用户,那么就可以到相应的用户下操作了,当然也可以在root用户下执行。

下面的图就是执行的结果,只是hadoop shell 支持的所有命令,详细命令解说在下面,因为太多,我没有粘贴。

)显示关于某个命令的详细信息$ bin/hadoop fs -help command-name(注:可能有些命令,不知道什么意思,那么可以通过上面的命令查看该命令的详细使用信息。

例子:这里我用的是hdfs用户。

)注:上面的两个命令就可以帮助查找所有的haodoop命令和该命令的详细使用资料。

创建一个名为 /daxiong 的目录$ bin/hadoop dfs -mkdir /daxiong查看名为 /daxiong/myfile.txt 的文件内容$ bin/hadoop dfs -cat /hadoop dfs -cat /user/haha/part-m-00000上图看到的是我上传上去的一张表,我只截了一部分图。

注:hadoop fs <..> 命令等同于hadoop dfs <..> 命令(hdfs fs/dfs)显示Datanode列表$ bin/hadoop dfsadmin -report$ bin/hadoop dfsadmin -help 命令能列出所有当前支持的命令。

比如:-report:报告HDFS的基本统计信息。

注:有些信息也可以在NameNode Web服务首页看到运行HDFS文件系统检查工具(fsck tools)用法:hadoop fsck [GENERIC_OPTIONS] <path> [-move | -delete | -openforwrite] [-files [-blocks [-locations | -racks]]]命令选项描述<path> 检查的起始目录。

-move 移动受损文件到/lost+found-delete 删除受损文件。

-openforwrite 打印出写打开的文件。

-files 打印出正被检查的文件。

-blocks 打印出块信息报告。

-locations 打印出每个块的位置信息。

-racks 打印出data-node的网络拓扑结构。

打印版本信息用法:hadoop version运行集群平衡工具。

管理员可以简单的按Ctrl-C来停止平衡过程(balancer)用法:hadoop balancer [-threshold <threshold>]命令选项描述-threshold <threshold> 磁盘容量的百分比。

这会覆盖缺省的阀值。

官网详解FS Shell调用文件系统(FS)Shell命令应使用 bin/hadoop fs <args>的形式。

所有的的FS shell命令使用URI路径作为参数。

URI格式是scheme://authority/path。

对HDFS文件系统,scheme是hdfs,对本地文件系统,scheme是file。

其中scheme和authority参数都是可选的,如果未加指定,就会使用配置中指定的默认scheme。

一个HDFS文件或目录比如/parent/child可以表示成hdfs://namenode:namenodeport/parent/child,或者更简单的/parent/child(假设你配置文件中的默认值是namenode:namenodeport)。

大多数FS Shell命令的行为和对应的Unix Shell 命令类似,不同之处会在下面介绍各命令使用详情时指出。

出错信息会输出到stderr,其他信息输出到stdout。

cat使用方法:hadoop fs -cat URI [URI …]将路径指定文件的内容输出到stdout。

示例:hadoop fs -cat hdfs://host1:port1/file1 hdfs://host2:port2/file2hadoop fs -cat file:///file3 /user/hadoop/file4返回值:成功返回0,失败返回-1。

chgrp使用方法:hadoop fs -chgrp [-R] GROUP URI [URI …] Change group association of files. With -R, make the change recursively through the directory structure. The user must be the owner of files, or else a super-user. Additional information is in thePermissions User Guide. -->改变文件所属的组。

使用-R将使改变在目录结构下递归进行。

命令的使用者必须是文件的所有者或者超级用户。

更多的信息请参见HDFS权限用户指南。

chmod使用方法:hadoop fs -chmod [-R] <MODE[,MODE]... | OCTALMODE> URI [URI …]改变文件的权限。

使用-R将使改变在目录结构下递归进行。

命令的使用者必须是文件的所有者或者超级用户。

更多的信息请参见HDFS权限用户指南。

chown使用方法:hadoop fs -chown [-R] [OWNER][:[GROUP]] URI [URI ]改变文件的拥有者。

使用-R将使改变在目录结构下递归进行。

命令的使用者必须是超级用户。

更多的信息请参见HDFS权限用户指南。

copyFromLocal使用方法:hadoop fs -copyFromLocal <localsrc> URI除了限定源路径是一个本地文件外,和put命令相似。

copyToLocal使用方法:hadoop fs -copyToLocal [-ignorecrc] [-crc] URI <localdst>除了限定目标路径是一个本地文件外,和get命令类似。

cp使用方法:hadoop fs -cp URI [URI …] <dest>将文件从源路径复制到目标路径。

这个命令允许有多个源路径,此时目标路径必须是一个目录。

示例:hadoop fs -cp /user/hadoop/file1 /user/hadoop/file2hadoop fs -cp /user/hadoop/file1 /user/hadoop/file2 /user/hadoop/dir返回值:成功返回0,失败返回-1。

du使用方法:hadoop fs -du URI [URI …]显示目录中所有文件的大小,或者当只指定一个文件时,显示此文件的大小。

示例:hadoop fs -du /user/hadoop/dir1 /user/hadoop/file1 hdfs://host:port/user/hadoop/dir1返回值:成功返回0,失败返回-1。

dus使用方法:hadoop fs -dus <args>显示文件的大小。

expunge使用方法:hadoop fs -expunge清空回收站。

请参考HDFS设计文档以获取更多关于回收站特性的信息。

get使用方法:hadoop fs -get [-ignorecrc] [-crc] <src> <localdst>复制文件到本地文件系统。

可用-ignorecrc选项复制CRC校验失败的文件。

使用-crc选项复制文件以及CRC信息。

示例:hadoop fs -get /user/hadoop/file localfilehadoop fs -get hdfs://host:port/user/hadoop/file localfile返回值:成功返回0,失败返回-1。

getmerge使用方法:hadoop fs -getmerge <src> <localdst> [addnl]接受一个源目录和一个目标文件作为输入,并且将源目录中所有的文件连接成本地目标文件。

addnl是可选的,用于指定在每个文件结尾添加一个换行符。

ls使用方法:hadoop fs -ls <args>如果是文件,则按照如下格式返回文件信息:文件名<副本数> 文件大小修改日期修改时间权限用户ID 组ID如果是目录,则返回它直接子文件的一个列表,就像在Unix中一样。

目录返回列表的信息如下:目录名<dir> 修改日期修改时间权限用户ID 组ID示例:hadoop fs -ls /user/hadoop/file1 /user/hadoop/file2 hdfs://host:port/user/hadoop/dir1 /nonexistentfile返回值:成功返回0,失败返回-1。

lsr使用方法:hadoop fs -lsr <args>ls命令的递归版本。

类似于Unix中的ls -R。

mkdir使用方法:hadoop fs -mkdir <paths>接受路径指定的uri作为参数,创建这些目录。

其行为类似于Unix的mkdir -p,它会创建路径中的各级父目录。

示例:hadoop fs -mkdir /user/hadoop/dir1 /user/hadoop/dir2hadoop fs -mkdir hdfs://host1:port1/user/hadoop/dir hdfs://host2:port2/user/hadoop/dir返回值:成功返回0,失败返回-1。

movefromLocal使用方法:dfs -moveFromLocal <src> <dst>输出一个”not implemented“信息。

mv使用方法:hadoop fs -mv URI [URI …] <dest>将文件从源路径移动到目标路径。

这个命令允许有多个源路径,此时目标路径必须是一个目录。

不允许在不同的文件系统间移动文件。

示例:hadoop fs -mv /user/hadoop/file1 /user/hadoop/file2hadoop fs -mv hdfs://host:port/file1 hdfs://host:port/file2 hdfs://host:port/file3 hdfs://host:port/dir1 返回值:成功返回0,失败返回-1。