大数据scala编程实验

java与scala混合编译

java与scala混合编译Java和Scala是两种常用的编程语言,它们都运行在Java虚拟机(JVM)上,并且可以相互调用和混合编译。

本文将介绍Java和Scala混合编译的相关概念、优势和使用方法。

一、Java和Scala的特点Java是一种面向对象的编程语言,它具有简单、可移植、安全和强大的特点。

Java广泛应用于企业级应用开发、Android应用开发等领域。

Scala是一种多范式编程语言,它结合了面向对象编程和函数式编程的特点。

Scala具有简洁、灵活、高效和可扩展的特点,适用于大规模数据处理、并发编程等场景。

二、Java和Scala的混合编译1. 概念Java和Scala混合编译是指在同一个项目中同时使用Java和Scala 编写代码,并将它们一起编译成可执行的程序。

混合编译可以充分发挥Java和Scala各自的优势,提高开发效率和代码质量。

2. 优势(1)兼容性:Java和Scala可以无缝地相互调用,Java代码可以直接调用Scala代码,Scala代码也可以调用Java代码。

这使得项目迁移、代码重用等工作更加方便。

(2)灵活性:Java和Scala可以根据具体需求选择使用,Java适用于简单的业务逻辑,Scala适用于复杂的算法和数据处理。

混合编译可以充分发挥两者的优势,提高代码的可读性和可维护性。

(3)性能优化:Scala具有更高的抽象能力和表达能力,能够编写出更加优雅和高效的代码。

在性能敏感的场景下,可以使用Scala 编写核心代码,提升程序的性能。

3. 使用方法(1)建立项目:使用IDE或命令行工具创建一个Java项目,然后将Scala源文件添加到项目中。

(2)配置构建工具:如果使用Maven或Gradle等构建工具,需要配置相应的插件和依赖项,以支持Scala的编译和打包。

(3)编写代码:根据项目需求,使用Java和Scala分别编写代码。

Java代码和Scala代码可以在同一个包下,相互调用。

mapreduce编程实验报告心得

mapreduce编程实验报告心得【实验报告心得】总结:本次mapreduce编程实验通过实际操作,使我对mapreduce编程框架有了更深入的理解。

在实验过程中,我学会了如何编写map和reduce函数,并利用这些函数从大数据集中进行数据提取和聚合分析。

通过这个实验,我还掌握了如何调试和优化mapreduce任务,以提高数据处理效率和性能。

一、实验目的:本次实验的目的是掌握mapreduce编程框架的使用方法,理解其实现原理,并在实际编程中熟练运用map和reduce函数进行数据处理和分析。

二、实验环境和工具:本次实验使用Hadoop分布式计算框架进行mapreduce编程。

使用的工具包括Hadoop集群、HDFS分布式文件系统以及Java编程语言。

三、实验过程:1. 实验准备:在开始实验前,我首先了解了mapreduce的基本概念和特点,以及Hadoop集群的配置和使用方法。

2. 实验设计:根据实验要求,我选择了一个适当的数据集,并根据具体需求设计了相应的map和reduce函数。

在设计过程中,我充分考虑了数据的结构和处理逻辑,以保证mapreduce任务的高效完成。

3. 实验编码:在实验编码过程中,我使用Java编程语言来实现map 和reduce函数。

我按照mapreduce编程模型,利用输入键值对和中间结果键值对来进行数据处理。

在编码过程中,我注意了代码的规范性和可读性,并进行了适当的优化。

4. 实验测试:完成编码后,我在Hadoop集群上部署和运行了我的mapreduce任务。

通过对数据集进行分析和处理,我验证了自己编写的map和reduce函数的正确性和性能。

5. 实验总结:在实验结束后,我对本次实验进行了总结。

我分析了实验中遇到的问题和挑战,并提出了相应的解决方法。

我还对mapreduce编程框架的优缺点进行了评估,并给出了自己的观点和建议。

四、实验结果和观点:通过本次实验,我成功实现了对选定数据集的mapreduce处理。

《Spark大数据编程基础(Scala版)》第六章SparkSQL

6.1.2 程序主入口SparkSession

在启动进入spark-shell后,spark-shell默认提供了一个Spa rkSession对象,名称为spark,因此在进入spark-shell之后进行 各种数据操作,可以依据代码6-1声明创建一个SparkSession对 象,也可以直接使用spark-shell提供的默认的SparkSession对象, 即spark。

6.1.1 Spark SQL架构

Spark SQL与传统的DBMS的“查询优化器+执行器” 的架构较为相似,只不过其执行器是在分布式环境中实 现,并采用Spark作为执行引擎。Spark SQL的执行优化 器是Catalyst,其基于Scala语言开发的,可以灵活利用 Scala原生的语言特性扩展功能,奠定了Spark SQL的发展 空间。所有的Spark SQL语句最终都通过Catalyst解析、 优化生成可以执行的Java字节码。

Spark大数据编程基础(Scala版)

本章对Spark SQL进行了概述,包括架构、特点和程 序主入口等,以及Spark SQL的DataFrame编程抽象;然 后介绍了DataFrame与RDD的区别,从外部数据源创建 DataFrame的方法,以及RDD转换为DataFrame的两种方 法;再对DataFrame的Transformation操作、Action操作 和保存操作进行了介绍;最后用综合实例对整章内容进 行总结概括。

6.1.2 程序主入口SparkSession

SparkSession对象不仅为用户提供了创建Data Frame对象、读取外部数据源并转化为DataFrame 对象以及执行sql查询的API,还负责记录着用户希 望Spark应用在Spark集群运行的控制、调优参数, 是Spark SQL的上下文环境,是运行的基础。

编程实验报告总结模板

实验名称:________________________实验日期:________________________实验地点:________________________实验目的:________________________一、实验背景简要介绍实验所涉及的编程语言、开发环境、相关理论知识等。

二、实验准备1. 编程语言及开发环境:(1)编程语言:________________________(2)开发环境:________________________2. 实验资料:(1)实验指导书:________________________(2)相关文献:________________________三、实验过程1. 实验步骤:(1)第一步:________________________(2)第二步:________________________(3)第三步:________________________……2. 实验代码:```python# 以下是实验代码示例,请根据实际实验内容进行修改def main():# 实验代码passif __name__ == '__main__':main()```3. 实验结果分析:(1)结果展示:________________________(2)结果分析:________________________四、实验总结1. 实验收获:(1)掌握了________________________(2)提高了________________________(3)解决了________________________2. 实验不足:(1)在________________________方面存在不足(2)对________________________理解不够深入(3)实验过程中遇到了________________________问题3. 改进措施:(1)针对________________________方面的问题,提出以下改进措施:a. __________________________b. __________________________c. __________________________(2)加强对________________________的学习,提高自己的编程能力五、实验拓展1. 实验拓展内容:(1)对实验中存在的问题进行改进,实现以下功能:a. __________________________b. __________________________c. __________________________(2)将实验内容应用于实际项目中,解决实际问题2. 实验拓展代码:```python# 以下是实验拓展代码示例,请根据实际实验内容进行修改def extended_function():# 实验拓展代码passif __name__ == '__main__':extended_function()```六、参考文献[1] __________________________[2] __________________________[3] __________________________(注:以上模板仅供参考,请根据实际实验内容进行修改和完善。

Scala语言在软件开发中的应用

智慧就在我们手中——大象2001版六年级科学下册教案一、教学目标1.了解科技在人类生产和日常生活中的应用,认识智能家电和家居智能系统,探索科技带给我们的方便和快捷。

2.培养学生对科技的兴趣和好奇心,激发学生创新和实践意识。

3.学生掌握科学实验的方法和过程,提高实验能力和科学素养。

二、教学重点和难点教学重点1.了解科技在生活中的应用。

2.通过实验认识智能家电和家居智能系统的原理和应用。

3.养成通过实验和探究掌握科学知识的习惯和能力。

教学难点1.实验过程中需要注意安全措施和正确操作方法。

2.探究智能家电和智能家居系统的原理和功能,涉及到物理、数学等多学科知识。

三、教学内容和学习过程学习内容1.科技在生产和日常生活中的应用。

2.探究智能家电和家居智能系统。

3.实验探究科学知识。

学习过程第一课时1.引入(5分钟)引导学生思考科技在生活中的应用,例如手机、电视、电脑等。

2.讲解(30分钟)教师通过讲解和PPT展示,展示智能家电和家居智能系统的原理和应用。

并引导学生思考科技给我们生活带来的变化和方便。

3.小组讨论(15分钟)组织学生小组讨论,探究智能家电和家居智能系统的原理和功能,并让学生分享自己家中的智能家电和家居智能系统。

4.作业布置(5分钟)让学生完成课后阅读《智慧就在我们身边》和《科技改变生活》。

第二课时1.实验前讲解安全知识和实验要求(10分钟)教师向学生讲解实验前需要注意的安全知识和实验要求,特别是“智能家电的用电安全”。

2.组织实验(40分钟)(1)将小型家电如电饭煲、微波炉、电烤箱等,用西瓜、香蕉、面包进行加热,检查结论。

(2)模拟环境控制,开发环境变化,如改变温度等,观察实验结果。

(3)检查实验报告及相关数据。

3.总结(10分钟)让学生分享实验过程和结果,认识智能家电和家居智能系统的原理和应用。

4.作业布置(5分钟)让学生完成课后阅读《科技创新,激发灵感》。

四、教学手段和要求教学手段1.PPT展示2.实验教学3.小组探讨4.课堂讲解教学要求1.教师要求学生阅读文献和实验数据,培养学生科学思维和科学实验精神。

《Spark大数据编程基础(Scala版)》第三章 Scala语言基础

3.1.2 Scala运行方式

使用scalac命令编译Demo.scala文件,并使用scala命令执行:

scalac Demo.scala //编译Scala文件命令 scala -classpath . HelloWorld //执行命令

执行命令中一定要加入“-classpath .”,否则会出现“No such file or class on classpath: HelloWorld”。命令执行后,会 在屏幕上打印出“Hello, World!”。

3.1.1 Scala特点

Scala的优势是提供了REPL(Read-Eval-Print Loop, 交互式解释器),因此,在Spark Shell中可进行交互式 编程,即表达式计算完成就会输出结果,而不必等到整 个程序运行完毕,因此可即时查看中间结果,并对程序 进行修改。这样可以在较大程度上提升开发效率。

由于本书只对Scala语言的常用语法知识进行讲解, 不涉及太过复杂的Scala程序,在Scala Shell里便可完成相 关知识的学习。

本小节以输出HelloWorld为例,介绍三种Scala代码编译 执行的方式。

3.1.2 Scala运行方式

1. Scala解释器中直接运行代码

登录Linux系统,打开命令行终端并输入scala进入Scala 解释器。输入代码:

3.1.1 Scala特点

Spark的设计目的之一就是使程序编写更快更容易,这 也是Spark选择Scala的原因所在。Scala的主要优点包括: (1)Scala具备强大的并发性,支持函数式编程,可以更 好地支持分布式系统。 (2)Scala语法简洁,能提供优雅的API。 (3)Scala能够无缝集成Java语言,运行速度快,且能融 合到Hadoop生态圈中。

scala应用场景

scala应用场景Scala应用场景:大数据处理与分析在当今信息爆炸的时代,大数据处理和分析已经成为许多企业和组织的重要任务之一。

Scala作为一种功能强大且灵活的编程语言,被广泛应用于大数据处理和分析领域。

下面将介绍一些Scala在大数据处理与分析中的应用场景。

1. 数据清洗与转换:在大数据处理过程中,数据往往来自不同的来源,格式各异。

Scala提供了丰富的数据处理库和函数,可以帮助用户对数据进行清洗和转换,使其符合分析的需求。

通过Scala的函数式编程特性,用户可以轻松地编写复杂的数据处理逻辑,提高数据处理的效率和可靠性。

2. 分布式计算:大数据处理通常需要利用分布式计算框架来处理海量数据。

Scala与Apache Spark等分布式计算框架的结合,为用户提供了强大的分布式计算能力。

用户可以利用Scala编写Spark应用程序,实现并行计算和分布式数据处理,加快数据分析的速度。

3. 机器学习与人工智能:随着人工智能技术的发展,机器学习在大数据处理和分析中扮演着重要角色。

Scala提供了丰富的机器学习库和工具,如Apache Spark MLlib和ScalaNLP,帮助用户构建复杂的机器学习模型,并进行数据挖掘和预测分析。

通过Scala的函数式编程特性,用户可以轻松地实现各种机器学习算法,提高数据分析的准确性和效率。

4. 实时数据处理:随着互联网的发展,实时数据处理变得越来越重要。

Scala与Apache Kafka等流式处理框架的结合,为用户提供了强大的实时数据处理能力。

用户可以利用Scala编写实时数据处理应用程序,监控和处理实时数据流,实现实时数据分析和反馈。

总的来说,Scala在大数据处理与分析领域具有广泛的应用场景。

通过其强大的函数式编程特性,Scala帮助用户实现复杂的数据处理逻辑,加速数据分析的过程。

结合分布式计算框架和机器学习库,Scala为用户提供了丰富的工具和资源,帮助他们处理和分析海量数据,挖掘数据背后的价值。

编程深入实验报告总结

一、实验背景随着信息技术的飞速发展,编程已经成为现代社会不可或缺的技能。

为了提高自己的编程能力,我参加了本次编程深入实验。

通过本次实验,我对编程有了更深入的理解,掌握了一些高级编程技巧,并提升了代码质量。

二、实验目的1. 深入理解编程语言的基本原理和特性;2. 掌握高级编程技巧,提高代码质量和执行效率;3. 培养良好的编程习惯,提高编程能力。

三、实验内容1. 编程语言特性分析本次实验涉及多种编程语言,如Python、Java、C++等。

通过对这些编程语言的基本原理和特性的分析,我深刻理解了不同编程语言的优势和适用场景。

2. 高级编程技巧在实验过程中,我学习了以下高级编程技巧:(1)面向对象编程(OOP):通过学习OOP,我掌握了类和对象的概念,学会了如何定义类、创建对象、封装、继承和多态等编程思想。

(2)设计模式:了解了常用的设计模式,如单例模式、工厂模式、观察者模式等,学会了如何在实际项目中应用这些设计模式。

(3)代码优化:通过学习代码优化技巧,如使用合适的数据结构、算法优化、避免重复代码等,提高了代码质量和执行效率。

(4)版本控制:学习了Git版本控制工具,掌握了代码的提交、分支、合并等操作,提高了团队协作效率。

3. 编程实践在实验过程中,我完成了以下编程实践项目:(1)Python爬虫:使用Python实现了针对某个网站的爬虫程序,实现了数据抓取、解析和存储等功能。

(2)Java Web项目:使用Java、Spring框架和MyBatis等技术,实现了一个小型在线商城项目,包括商品管理、订单管理、用户管理等模块。

(3)C++游戏开发:使用C++和OpenGL技术,开发了一个简单的2D游戏,实现了游戏画面渲染、角色控制、碰撞检测等功能。

四、实验总结1. 提升了编程能力:通过本次实验,我对编程有了更深入的理解,掌握了多种编程语言和高级编程技巧,提高了自己的编程能力。

2. 培养了良好的编程习惯:在实验过程中,我学会了如何阅读代码、编写规范代码、进行代码优化等,培养了良好的编程习惯。

大数据 Spark编程基础(Scala版)

80

60 40 20 0.9

0

Hadoop

Spark

图 Hadoop与Spark执行逻辑回归的时间对比

1.6.3 Flink

Flink架构图

1.6.3 Flink

Flink生态系统

1.6.3 Flink

Flink与Spark的比较

1.6.3 Flink

性能对比 首先它们都可以基于内存计算框架进行实时计算,所以都拥有非常 好的计算性能。经过测试,Flink计算性能上略好。

1.6.1 Hadoop——YARN

•YARN的目标就是实现“一个集群多个框架”,即在一个集群上部署一个统 一的资源调度管理框架YARN,在YARN之上可以部署其他各种计算框架 •由YARN为这些计算框架提供统一的资源调度管理服务,并且能够根据各种 计算框架的负载需求,调整各自占用的资源,实现集群资源共享和资源弹性 收缩 •可以实现一个集群上的不同应用负载混搭,有效提高了集群的利用率 •不同计算框架可以共享底层存储,避免了数据集跨集群移动

根据IDC作出的估测,数据一直都在以每年50%的速度增长,也就是说每两年就增长一倍(大数 据摩尔定律) 人类在最近两年产生的数据量相当于之前产生的全部数据量 预计到2020年,全球将总共拥有35ZB的数据量,相较于2010年,数据量将增长近30倍

1.2.2 数据类型繁多

大数据是由结构化和非结构化数据组成的 – 10%的结构化数据,存储在数据库中 – 90%的非结构化数据,它们与人类信 息密切相关 科学研究 –基因组 –LHC 加速器 –地球与空间探测 企业应用 –Email、文档、文件 –应用日志 –交易记录 Web 1.0数据 –文本 –图像 –视频 Web 2.0数据 –查询日志/点击流 –Twitter/ Blog / SNS –Wiki

csdn 实验5 mapreduce初级编程实践

CSDN 实验5 MapReduce初级编程实践一、实验背景在大数据时代,数据处理是非常重要的任务。

MapReduce是一种用于处理大规模数据集的编程模型,它可以有效地分解任务并进行并行化处理。

通过MapReduce编程,可以实现大规模数据的分布式处理,提高数据处理的效率和速度。

二、实验目的本实验旨在让学生掌握MapReduce的基本原理和编程方法,通过实际的编程操作,运用MapReduce处理大规模数据集,并理解MapReduce在数据处理中的重要作用。

三、实验内容1. 环境准备在进行MapReduce编程之前,需要搭建好相应的开发环境。

首先需要安装Hadoop,搭建Hadoop集裙环境。

然后安装MapReduce程序的开发工具,如Eclipse等。

2. 编程任务任务一:WordCount编写一个简单的MapReduce程序,对给定的文本文件进行词频统计,统计每个单词出现的次数。

任务二:InvertedIndex编写一个MapReduce程序,对给定的文本文件进行倒排索引生成。

将每个单词与出现该单词的文档进行关联,生成倒排索引表。

任务三:TopN编写一个MapReduce程序,对给定的数据集中找出出现频率最高的前N个单词。

3. 实验步骤步骤一:环境搭建在实验开始前,搭建好Hadoop集裙环境,安装并配置MapReduce 程序的开发环境。

步骤二:WordCount编程根据给定的文本文件,编写MapReduce程序,实现对文本中单词出现次数的统计。

步骤三:InvertedIndex编程编写MapReduce程序,实现对文本中单词的倒排索引生成。

步骤四:TopN编程编写MapReduce程序,实现对文本中出现频率最高的前N个单词的统计。

步骤五:程序调试与测试编写完毕MapReduce程序后,进行程序的调试与测试,确保程序运行正确并得到期望的结果。

四、实验总结通过本次实验,我深入理解了MapReduce的编程模型和原理。

Scala语言与Spark实践

Scala语言与Spark实践概述Scala语言是一种新兴的面向对象编程语言,它结合了Java语言的静态类型特征和函数式编程范式。

使用Scala语言可以更加快速地编写高效的代码。

而Spark是当前最流行的分布式计算框架之一,具有高可伸缩性、高效性、强大的数据处理能力等优点。

本文将探讨Scala语言与Spark实践的相关问题。

Scala语言介绍Scala语言全称为Scalable Language,是一种现代化、强类型的面向对象编程语言。

它由Martin Odersky于2004年开发,旨在提供一种更加高效的编程方式。

Scala语言融合了Java语言的优点,同时还支持函数式编程方式,使得代码更加简洁、易读、易扩展。

Scala语言在学术界、商业界都得到了广泛应用,已经成为了一种重要的编程语言。

Spark实践介绍Spark是目前最流行的Apache基金会的分布式计算框架,是一种高速、通用的计算引擎,具有高可伸缩性、高效性、强大的数据处理能力等优点。

Spark的核心是对于大数据的分布式计算,包括实时计算、短周期的批处理计算等。

Spark支持多种编程语言,包括Java、Scala、Python等。

Scala语言与Spark实践的结合Scala语言与Spark实践的结合可以带来很多优势。

Scala语言的静态类型特征可以使得代码更加可靠、易读,可以减少错误,提高代码的可维护性。

同时,Scala语言支持函数式编程方式,这种编程方式可以使得代码更加简洁、易读、易维护。

Spark框架适合处理海量数据,可以实现大数据量的处理,而Scala语言的高效性则可以更好地利用Spark框架的分布式处理能力。

Scala语言在Spark中的应用Scala语言与Spark的结合非常紧密,Spark支持Scala作为其主要编程语言之一。

Scala语言的一些特性可以使得在Spark框架下的编程更加方便。

比如Scala语言的隐式转换可以使得对于RDD的各种操作更加简洁、易读。

实验16-Spark实验:Spark综例

实验十六Spark实验:Spark综例16.1 实验目的1.理解Spark编程思想;2.学会在Spark Shell中编写Scala程序;3.学会在Spark Shell中运行Scala程序。

16.2 实验要求实验结束后,能够编写Scala代码解决一下问题,并能够自行分析执行过程。

有三个RDD,要求统计rawRDDA中“aa”、“bb”两个单词出现的次数;要求对去重后的rawRDDA再去掉rawRDDB中的内容;最后将上述两个结果合并成同一个文件然后存入HDFS中。

16.3 实验原理16.3.1 ScalaScala是一门多范式的编程语言,一种类似java的编程语言,设计初衷是实现可伸缩的语言、并集成面向对象编程和函数式编程的各种特性。

Scala有几项关键特性表明了它的面向对象的本质。

例如,Scala中的每个值都是一个对象,包括基本数据类型(即布尔值、数字等)在内,连函数也是对象。

另外,类可以被子类化,而且Scala还提供了基于mixin的组合(mixin-based composition)。

与只支持单继承的语言相比,Scala具有更广泛意义上的类重用。

Scala允许定义新类的时候重用“一个类中新增的成员定义(即相较于其父类的差异之处)”。

Scala称之为mixin类组合。

Scala还包含了若干函数式语言的关键概念,包括高阶函数(Higher-Order Function)、局部套用(Currying)、嵌套函数(Nested Function)、序列解读(Sequence Comprehensions)等等。

Scala是静态类型的,这就允许它提供泛型类、内部类、甚至多态方法(Polymorphic Method)。

另外值得一提的是,Scala被特意设计成能够与Java和.NET互操作。

Scala可以与Java互操作。

它用scalac这个编译器把源文件编译成Java的class文件。

你可以从Scala中调用所有的Java类库,也同样可以从Java应用程序中调用Scala的代码。

scala程序设计课程标准

scala程序设计课程标准以下是一个可能的Scala程序设计课程的标准:

课程目标:

1. 掌握Scala编程语言的基本语法和编程范式;

2. 掌握Scala中函数式编程的概念和技巧;

3. 掌握Scala中面向对象编程的概念和技巧;

4. 掌握Scala中并发编程的概念和技巧;

5. 了解Scala在Web开发、大数据处理等领域的应用。

课程大纲:

第一部分:Scala基础

1. Scala简介和安装配置

2. Scala基本语法和数据类型

3. 函数和函数式编程

4. 面向对象编程基础

5. 模式匹配和异常处理

6. 集合和流式处理

7. 泛型和类型系统

第二部分:Scala进阶

1. 高阶函数和闭包

2. 函数式编程技巧和不可变性

3. 面向对象编程进阶

4. 并发编程基础

5. Akka框架和Actor模型

6. 数据库交互和Web开发

7. 大数据处理和Spark框架第三部分:项目实践

1. 项目需求分析和设计

2. 项目开发和实现

3. 项目测试和调试

4. 项目演示和总结

课程评价:

1. 平时作业:根据课程进度布置相应的编程练习题,要求学生按时完成,并进行代码审查;

2. 期中考试:对学生掌握的Scala基础知识进行测试,要求达到一定的及格分数;

3. 期末考试:对学生掌握的Scala高级知识和应用进行测试,要求达到一定的及格分数;

4. 项目评价:对学生完成的实践项目进行评估,要求项目具有一定的功能性和创新性。

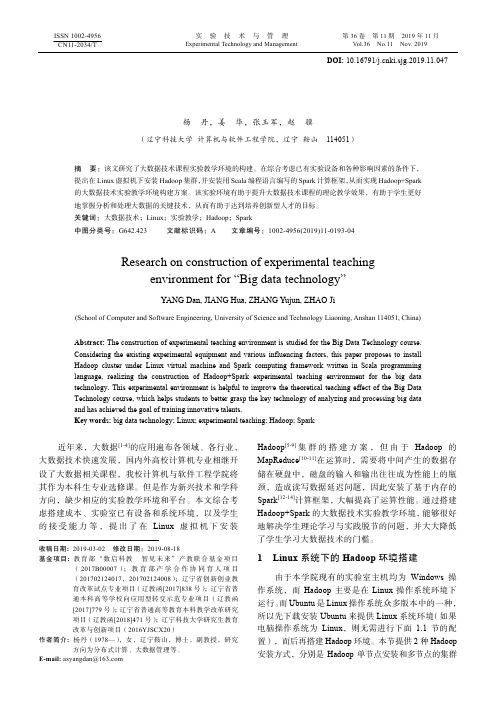

“大数据技术”实验教学环境构建研究

实 验 技 术 与 管 理 第36卷 第11期 2019年11月Experimental Technology and Management Vol.36 No.11 Nov. 2019ISSN 1002-4956 CN11-2034/TDOI: 10.16791/ki.sjg.2019.11.047“大数据技术”实验教学环境构建研究杨 丹,姜 华,张玉军,赵 骥(辽宁科技大学 计算机与软件工程学院,辽宁 鞍山 114051)摘 要:该文研究了大数据技术课程实验教学环境的构建。

在综合考虑已有实验设备和各种影响因素的条件下,提出在Linux 虚拟机下安装Hadoop 集群,并安装用Scala 编程语言编写的Spark 计算框架,从而实现Hadoop+Spark 的大数据技术实验教学环境构建方案。

该实验环境有助于提升大数据技术课程的理论教学效果,有助于学生更好地掌握分析和处理大数据的关键技术,从而有助于达到培养创新型人才的目标。

关键词:大数据技术;Linux ;实验教学;Hadoop ;Spark中图分类号:G642.423 文献标识码:A 文章编号:1002-4956(2019)11-0193-04Research on construction of experimental teachingenvironment for “Big data technology”YANG Dan, JIANG Hua, ZHANG Yujun, ZHAO Ji(School of Computer and Software Engineering, University of Science and Technology Liaoning, Anshan 114051, China)Abstract: The construction of experimental teaching environment is studied for the Big Data Technology course. Considering the existing experimental equipment and various influencing factors, this paper proposes to install Hadoop cluster under Linux virtual machine and Spark computing framework written in Scala programming language, realizing the construction of Hadoop+Spark experimental teaching environment for the big data technology. This experimental environment is helpful to improve the theoretical teaching effect of the Big Data Technology course, which helps students to better grasp the key technology of analyzing and processing big data and has achieved the goal of training innovative talents.Key words: big data technology; Linux; experimental teaching; Hadoop; Spark近年来,大数据[1-4]的应用遍布各领域、各行业,大数据技术快速发展,国内外高校计算机专业相继开设了大数据相关课程,我校计算机与软件工程学院将其作为本科生专业选修课。

Scala语言的应用和原理分析

Scala语言的应用和原理分析Scala语言的应用和原理分析摘要:Scala是一种多范式的编程语言,拥有强大的面向对象和函数式编程特性。

在本文中,我们将探讨Scala语言的应用和原理分析,并介绍该语言在现代应用开发中的优势。

1.简介Scala是一种基于JVM的多范式编程语言,拥有面向对象、函数式编程和命令式编程的特性。

该语言于2004年由Martin Odersky率领的一支瑞士团队开发,目的是设计一种能兼顾面向对象和函数式编程特性的新型语言。

Scala语言流行于现代应用开发中,特别是数据分析、机器学习和大数据等领域。

2.应用2.1数据分析Scala语言在数据分析中具有广泛应用。

它能通过Spark等大数据框架进行分布式数据处理和分析,同时Scala自身的函数式编程特性也使得处理复杂数据结构变得更加简洁可读。

此外,Scala的类型安全特性使得数据类型错误更易被捕捉到,从而增强了代码的健壮性。

2.2机器学习Scala在机器学习领域也有广泛应用。

它能够通过Spark等框架进行分布式机器学习,并且Scala语言的函数式编程特性也使得机器学习算法的实现更加简单有效。

Scala还提供了许多数据处理和机器学习的库,例如Breeze和Smile,使得开发者能够更轻松地实现机器学习算法。

2.3 Web开发Scala在Web开发中也有广泛应用。

它能够通过许多框架,如Play Framework、Lift、Scalatra等构建Web应用。

同时,由于Scala拥有强大的类型系统和函数式编程特性,使得开发人员能够更轻松地编写可维护性高、健壮性强的Web应用。

3.原理分析3.1强类型系统Scala拥有强大的类型系统,能够在编译期发现很多类型错误。

这种强类型系统使得Scala的代码更加健壮,能够避免大量运行时错误。

3.2面向对象编程Scala是一种纯面向对象的语言,它支持对象的继承、多态、组合等特性。

Scala还支持Trait(类似于Java的接口),使得开发者能够更灵活地实现类的组合。

scala 写rtl代码

scala 写rtl代码【最新版】目录1.Scala 简介2.RTL 代码概念3.Scala 编写 RTL 代码的优势4.示例:使用 Scala 编写简单的 RTL 代码正文1.Scala 简介Scala 是一种现代编程语言,设计初衷是为了解决 Java 中存在的一些问题,同时提供与 Java 的互操作性。

Scala 具有强大的功能,可以支持面向对象编程、函数式编程和并发编程等多种编程范式。

这使得 Scala 在许多领域都得到了广泛应用,如大数据处理、分布式系统等。

2.RTL 代码概念RTL(Register-Transfer Level)代码是一种硬件描述语言,主要用于描述数字电路和数字信号处理系统的行为。

RTL 代码通常包括寄存器、数据通路和控制逻辑等组成部分,可以描述算法和数据的流动过程。

RTL 代码的优势在于它可以在高级抽象层面描述硬件行为,而不需要关心底层的硬件实现细节。

3.Scala 编写 RTL 代码的优势使用 Scala 编写 RTL 代码有以下几个优势:a.语法简洁:Scala 的语法简洁易懂,使得 RTL 代码更容易阅读和编写。

b.强大的函数式编程支持:Scala 的函数式编程特性可以帮助编写者更容易地实现并行计算和数据流处理,这在数字信号处理和硬件描述语言中非常重要。

c.高阶抽象:Scala 可以提供较高层次的抽象,使得编写 RTL 代码时更容易关注算法和数据结构的设计,而不需要过多关注底层硬件实现。

d.与 Java 兼容:Scala 可以与 Java 无缝集成,这意味着可以使用 Java 库和框架来支持 RTL 代码的编写。

4.示例:使用 Scala 编写简单的 RTL 代码以下是一个使用 Scala 编写的简单 RTL 代码示例,实现了一个 4 位加法器的功能:```scalaimport scala.register.{Register, Wire}class FourBitAdder(inputA: Wire, inputB: Wire, carryIn: Wire, output: Wire) extends Module {val sum = Wire(0)val carry = Wire(0)def apply(): Unit = {val cin = carryIn & inputA & inputBval cout = carry & inputA & inputB | carryIn & ~inputA & inputB | ~carryIn & inputA & ~inputB | ~carryIn & ~inputA & ~inputB sum := cin | coutcarry := coutoutput := sum}}```上述代码中,我们定义了一个名为 FourBitAdder 的硬件模块,它接受两个输入信号(inputA 和 inputB),一个进位信号(carryIn)和一个输出信号(output)。

实验2Scala编程初级实践

实验2Scala编程初级实践实验 2 Scala 编程初级实践⼀、实验⽬的1.掌握 Scala 语⾔的基本语法、数据结构和控制结构;2.掌握⾯向对象编程的基础知识,能够编写⾃定义类和特质;3.掌握函数式编程的基础知识,能够熟练定义匿名函数。

熟悉 Scala 的容器类库的基本层次结构,熟练使⽤常⽤的容器类进⾏数据;4.熟练掌握 Scala 的 REPL 运⾏模式和编译运⾏⽅法。

⼆、实验平台已经配置完成的 Scala 开发环境。

Scala 版本为 2.11.8.三、实验内容和要求1. 计算级数请⽤脚本的⽅式编程计算并输出下列级数的前 n 项之和 Sn,直到 Sn 刚好⼤于或等于 q 为⽌,其中 q 为⼤于 0 的整数,其值通过键盘输⼊。

例如,若 q 的值为 50.0 ,则输出应为: Sn=50.416695 。

请将源⽂件保存为 exercise2-1.scala,在REPL模式下测试运⾏,测试样例:q=1时,Sn=2;q=30时,Sn=30.891459; q=50 时,Sn=50.416695。

import io.StdIn._object lab2{def main(args:Array[String]){var Sn:Float = 0var n:Float = 1println("Input a number for q:")var q = readInt()while(Sn < q){Sn += (n+1)/nn += 1}println(s"Sn = $Sn")}}2. 模拟图形绘制对于⼀个图形绘制程序,⽤下⾯的层次对各种实体进⾏抽象。

定义⼀个 Drawable 的特质,其包括⼀个 draw ⽅法,默认实现为输出对象的字符串表⽰。

定义⼀个 Point 类表⽰点,其混⼊了 Drawable 特质,并包含⼀个 shift ⽅法,⽤于移动点。

所有图形实体的抽象类为Shape,其构造函数包括⼀个 Point 类型,表⽰图形的具体位置(具体意义对不同的具体图形不⼀样)。

大数据技术实践实验报告

实验报告课程名称:大数据技术实践实验项目:大数据平台实验仪器: PC机学院:计算机学院专业:计算机科学与技术班级姓名: *学号: *日期: 2019-5-9 指导教师: *成绩:一. 实验目的1. 熟练掌握大数据计算平台相关系统的安装部署2. 理解大数据MapReduce计算模型,并掌握MapReduce程序开发3. 掌握Hive的查询方法4. 掌握Spark的基本操作二. 实验内容1. Hadoop完全分布模式安装2. Hadoop开发插件安装3. MapReduce代码实现4. Hive安装部署5. Hive查询6. Spark Standalone模式安装7. Spark Shell操作三. 实验过程Hadoop开发插件安装实验步骤:1.Eclipse开发工具以及Hadoop默认已经安装完毕,安装在/apps/目录下。

2.在Linux本地创建/data/hadoop3目录,用于存放所需文件。

切换目录到/data/hadoop3目录下,并使用wget命令,下载所需的插件hadoop-eclipse-plugin-2.6.0.jar。

2.将插件hadoop-eclipse-plugin-2.6.0.jar,从/data/hadoop3目录下,拷贝到/apps/eclipse/plugins的插件目录下。

3.进入ubuntu图形界面,双击eclipse图标,启动eclipse。

5.在Eclipse窗口界面,依次点击Window => Open Perspective => Other。

弹出一个窗口。

选择Map/Reduce,并点击OK,可以看到窗口中,有三个变化。

(左侧项目浏览器、右上角操作布局切换、面板窗口)如果在windows下,则需要手动调出面板窗口Map/Reduce Locations面板,操作为,点击window => show view => Other。

在弹出的窗口中,选择Map/Reduce Locations选项,并点击OK。

Scala程序编译运行

Scala程序编译运⾏Scala 解释器开始Scala最简单的⽅法是使⽤Scala解释器,它是⼀个编写Scala表达式和程序的交互式“shell”。

简单地在解释器⾥输⼊⼀个表达式,它将计算这个表达式并打印结果值。

Scala的交互式shell就叫做scala。

你可以在命令提⽰符⾥输⼊scala使⽤它:⽰例:C:\Users\4cv748wpd3>scalaWelcome to Scala 2.12.6 (Java HotSpot(TM) 64-Bit Server VM, Java 1.8.0_111).Type in expressions for evaluation. Or try :help.scala> 1+2res0: Int = 3scala>说明:⼀个⾃动产⽣的或⽤户定义的名称说明计算的值(res0,表⽰结果 0),⼀个冒号(:),跟着表达式的类型(Int)⼀个等号(=)计算表达式所得到的结果(3)。

Int类型指代了scala包的类Int。

Scala⾥的包与Java⾥的包很相似:它们把全局命名空间分区并提供了信息隐藏的机制。

类Int的值对应着Java的int值。

更⼴泛意义上来说,所有的Java原始类型在scala包⾥都有对应的类。

例如,scala.Boolean对应着Java的boolean。

scala.Float对应着Java的float。

当你把你的Scala代码编译成Java字节码,Scala编译器将使⽤Java的原始类型以便获得其带来的性能益处。

resX 识别符还将⽤在后续的代码⾏中。

例如,既然 res0 已在之前设为 3,res0 * 3 就是9:scala> res0 * 3res1: Int = 9scala>打印必要的,却不仅此⽽已的,Hello, world! 贺词,输⼊:scala> println("Hello,world!")Hello,world!scala>println函数在标准输出上打印传给它的字串,就跟 Java⾥的System.out.println⼀样。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

301625 male 72 54 100

301626 male 76 66 73

301627 male 82 87 79

301628 female 62 80 54

301629 male 89 77 72

完成情况截图:

出现的问题:

因为是第一次用scala语言进行编程,虽然和java有着很大的相似性,但是具体的函数名以及具体的语法使用还是不明白,去看了官方的参考代码后看懂了他的思路后对照着写,我最开始的用的java的类挨个进行功能编写,虽然也可以得出最后答案但是基本上没有答案的这么快捷,但是参考答案用的放发比较难懂,花了一些时间去读懂领悟,比如参考答案里的切词方法是直接用的head取学号和课程名,而我最开始用的distinct进行过滤筛选,以及tail将这两个值返回到容器中,以及之后的zip,感觉scala更快捷但是也不是很易读懂,看了参考代码后发现自己在新语言的掌握严重不足,在课下会花更多的时间来学习scala

301616 female 73 81 75

301617 female 69 77 75

301618 male 73 61 65

301619 male 74 69 68

301620 male 76 62 76

301621 male 73 69 91

301622 male 55 69 61

301623 male 50 58 75

Id gender Math English Physics

301610 male 80 64 78

301611 female 65 87 58 ...

给定任何一个如上格式的清单(不同清单里课程数量可能不一样),要求尽可能采用函 数式编程,统计出各门课程的平均成绩,最低成绩,和最高成绩;另外还需按男女同学分开, 分别统计各门课程的平均成绩,最低成绩,和最高成绩。 测试样例 1 如下:

Id gender Math English Physics

301610 male 80 64 78

301611 female 65 87 58

301612 female 44 71 77

301613 female 66 71 91

301614 female 70 71 100

301615 male 72 77 72

《Spaቤተ መጻሕፍቲ ባይዱk编程基础》实验报告

题目:

scala编程初级实验

姓名:

学号:

日期:2019/4/12

实验环境:

操作系统:Centos7.0

Spark版本:2.1.0

实验内容与完成情况:

1.统计学生成绩

学生的成绩清单格式如下所示,第一行为表头,各字段意思分别为学号、性别、课程名1、课程名2等,后面每一行代表一个学生的信息,各字段之间用空白符隔开

解决方案:

在出现的问题后已给出解决方案

总结:

在spark编程中,scala语言有点像java和C的结合,有着java的大量易扩充的函数功能,大大缩减了代码长度,但是在底层的原理以及概念上还没有理解,仅仅是可以看懂代码但是自己的编写还是会有一定的难度,争取在大量的实践之后可以做到更加熟练于心。