异构计算综述

异构网络联合呼叫接纳控制算法综述

了为 用户 提供 传统 的语音 业 务 ,还 能够 为用 户提 供

多种其 他类 型 的业 务 。它 们 与传统语 音业 务 的结构 不同, 其上 、 下行 需求 不对 称 , 同时各 网络 的上 、 下行 链 路 的容 量也不 同 ,而且 这类业 务所 占 比例有 日趋

增 大 的趋势 。文 献 [ 1 ] 中提 出一 种 “ 伪 拥堵 ” 现象, 异 构 网络 的 总体 资源还 很充 足 ,但 是各 网络 的负 载 已 经 饱和 , 不 能再接 人新 的呼 叫请求 。

研 究 学者 提 出了 以负载均 衡为 基础 的 J C AC 负载 均衡 策略 又可分 为 网络 问的负 载均衡 和链 路 间的负 载均衡 。早 期 的负载 均衡 策略 一般 以 网络

信 赖 的第 三 方通信 服务 提供 商代 理拍 卖 ,运 营 商作

为投 标方 ,用 户为 买家 ,以能提供 的 带宽作 为 Q o S 保障, 运 营商 提供一 系 列不 同定价 的带 宽服 务 . 一 轮 轮 竞标 , 最 终 由用 户选 择 满 足 其 O o S要 求 的 、 出价 最低 的 网络 。 然 而这 种算 法 , 网络每 投标 一次都 要计

2 . 2 基 于用 户偏 好 的 J C AC

困难 , 并 非所 有 的参数 都是 客观 可量 化 的 , 参数 间关

系 的量 化也并 非 简单 的“ 非 此 即彼 ” 的关系 , 因此 , 为 了表 述不 同参 数 间 、 参数 与选 择结 果 间的关 系 . 引入 了模 糊 逻辑理 论 。 以模 糊逻 辑为 代表 的基 于智 能计 算的 J C AC算法 ,使得 表征 不一 的参 数 可 以转 化 为

间 的负载均 衡为 主 。分为 两个 阶段 , 第一个 阶段 , 新 呼 叫到 达重 叠覆 盖 区域 时 ,为新 呼 叫到达 选择 合适

异构格里芬四词条-解释说明

异构格里芬四词条-概述说明以及解释1.引言1.1 概述概述异构格里芬四词条是一篇探讨异构计算和格里芬的关系、优势以及应用领域的长文。

异构计算是指利用不同类型的处理器或计算单元来完成计算任务的一种计算模式,而格里芬是一种用于高性能计算的编程模型和框架。

本文旨在介绍异构格里芬的基本原理和原则,深入探讨其在科学研究、工程技术和商业应用等领域的应用情况,并展望其未来的发展潜力。

在本文的正文部分中,我们首先将阐述异构计算的概念及其背后的原理。

异构计算通过同时使用不同类型的处理器,如CPU、GPU和FPGA 等,来实现更高效的计算。

其中,GPU作为一种高度并行的处理器,具有强大的计算能力,已经成为异构计算中的重要角色。

接着,我们将介绍格里芬作为一种特定的编程模型和框架,如何与异构计算结合,从而实现高效的数据并行计算。

接下来,我们将详细探讨异构格里芬的优势所在。

异构格里芬的核心思想是通过将任务细化为多个子任务,并将这些子任务分配到合适的处理器上并行执行,从而实现更高的计算效率和性能。

相比传统的单一处理器计算模式,异构格里芬能够充分利用不同处理器的特点和优势,提高计算速度和能效,并在科学研究、工程技术和商业应用等领域发挥重要作用。

此外,本文还将探讨异构格里芬在不同应用领域的具体应用实例。

我们将介绍异构格里芬在天文学、物理学、医学、人工智能等领域中的应用案例,并分析其在这些领域中取得的成果和效果。

这些实例将进一步展示异构格里芬在各个领域中的广泛应用和巨大潜力。

在结论部分,我们将对异构格里芬的重要性进行总结。

异构格里芬作为一种高效的计算模式,已经成为科学研究和工程技术领域的重要工具。

同时,我们也将展望异构格里芬未来的发展潜力,并指出应该进一步研究和探索的方向。

结论的重要性在于对整个文章的核心观点和论证进行总结和强调,同时也为未来的研究提供了一定的指导。

综上所述,本文将介绍异构格里芬的概念、原理和优势,探讨其在不同应用领域的应用实例,并为进一步研究提供了方向。

异构计算模型在云计算中的性能优化研究

异构计算模型在云计算中的性能优化研究随着云计算的快速发展和对计算资源的不断需求增加,对云计算性能优化的研究也变得愈发重要。

异构计算模型作为一种新颖的计算模型,在云计算中展现出巨大的潜力。

本文将研究异构计算模型在云计算中的性能优化问题,探讨如何利用异构计算模型提升云计算性能。

1. 异构计算模型概述异构计算模型是指将多种不同类型的计算资源组合在一起,形成一个拥有不同处理器、内存和存储器的计算系统。

这样的系统能够更好地适应各种类型的计算任务,并将任务分配给最适合处理的资源。

异构计算模型的核心思想是利用不同类型计算资源的优势互补,提高计算效率和性能。

2. 异构计算模型在云计算中的应用2.1 异构计算模型的优势在云计算中,应用程序的需求多种多样,包括大数据处理、机器学习、图形渲染等。

而传统的计算平台往往无法提供高效处理这些任务所需的计算资源。

而异构计算模型正好能够弥补这一差距。

通过将多种不同类型的处理器和硬件设备组合起来,异构计算模型能够更好地解决不同类型任务的需求,提高处理效率。

2.2 异构计算模型在云计算中的应用案例在云计算中,异构计算模型广泛应用于以下领域:2.2.1 大数据处理对于大数据处理任务来说,异构计算模型能够更好地利用GPU等高性能设备,通过并行计算的方式提高数据处理速度。

例如,在数据的预处理和分析阶段,使用GPU进行高速数据计算,可以大大加快数据处理的速度。

2.2.2 机器学习机器学习需要大量的计算资源来训练模型和进行推理。

异构计算模型通过将CPU和GPU等设备进行协同工作,可以提供更高效的计算和更快的训练速度。

例如,在深度学习模型训练过程中,使用GPU进行并行计算可以大大加快训练速度。

2.2.3 图形渲染对于图形渲染任务来说,GPU是更适合处理的设备。

异构计算模型可以将图形渲染任务分配给GPU进行加速处理,提高渲染效果和渲染速度。

同时,CPU可以负责其他任务,实现多任务的协同工作。

3. 异构计算模型性能优化方法为了更好地利用异构计算模型优化云计算性能,以下是几种值得尝试的方法:3.1 任务调度优化任务调度是指将不同的计算任务分配给最适合处理的计算资源。

异构网络集成与优化技术综述

异构网络集成与优化技术综述随着信息技术的不断发展和日益深入应用,计算机网络多样化和异构网络集成的技术需求不断增长。

异构网络集成技术不仅将不同种类的网络连接在一起,而且可协同优化网络性能和资源利用效率。

本文将从异构网络集成的需求,异构网络集成的方法和优化技术三个方面进行综述。

一.异构网络集成的需求1.协同优化的需求网络的性能优化需协同多种技术,如:传输控制协议(TCP)、云计算、网络虚拟化等。

采用异构集成技术可以协同运用这些技术,以提高网络的传输效率、减少网络拥塞和优化网络资源管理。

2.多样性需求不同网络在性能、速度等方面存在很大差异。

如有线网络的传输速度远高于无线网络。

除此之外,网络的部署方式,网络藩篱,网络安全性等差异也需要异构网络集成的技术来协同处理。

3.网络间互联需求在网络的多样性中,网络间互联是重要的方面。

比如需要连接内部的局域网和外部的广域网,或连接不同部门间的网络等。

这些要求需要采用不同的网络连接方式,这就需要异构网络集成技术。

二.异构网络集成的方法1.网络协议转换技术网络协议转换技术是一种快速实现不同网络间连接的方法。

有些网络协议如TCP/IP协议,仅有数据包和数据帧的相对位置不同,通过简单的协议转换技术就可以将两个不同类型的网络连接在一起。

还有一些协议互不兼容,则需要在网络协议转换设备上对数据包进行各种处理,重新封装成另一种数据包,以兼容不同网络的协议。

2.虚拟化技术虚拟化技术能够将一台物理计算机通过虚拟机的方式,划分出多个独立的虚拟机。

在虚拟机里运行的操作系统和应用程序不会影响其他虚拟机。

网络虚拟化技术可实现不同虚拟机的网络隔离和网络之间的连接。

3.无线网络与有线网络间连接技术无线互联技术在物理环境、设备和组网方式等方面都不同于有线网络。

不同于基于有线的互联技术,无线互联技术的特殊性使得它在异构网络集成中显得更为重要。

无线网络与有线网络可以通过多种不同的方式进行连接,如无线局域网(WLAN)和WiMAX等无线网络技术,以及光纤技术和网络互联设备等有线网络技术。

异构计算的优化方法及应用

异构计算的优化方法及应用随着计算机技术的不断发展,人们对于计算机的需求也在不断提高。

传统的计算机已经无法满足人们日益增长的需求,因此出现了新的计算方式——异构计算。

异构计算是利用不同结构、性能、功能的计算单元或计算系统进行计算,旨在优化计算的性能、灵活性和能源效率。

本文将重点探讨异构计算的优化方法及应用。

一、异构计算的优化方法1. 异构计算的架构异构计算的架构主要分为两种:主机与协处理器、集群和网格。

在主机与协处理器架构中,主机为整个系统的核心,协处理器则为辅助计算单元,主要负责计算密集型的任务。

集群和网格架构则是将多台计算机连接起来形成一个总体,进行计算任务分配和管理。

这种架构可以利用计算机之间的并行计算来提高整个系统的计算效率。

2. CPU+GPU异构计算架构CPU+GPU异构计算架构是目前应用最广泛的异构计算架构之一。

在这种架构中,CPU作为整个系统的核心,承担一些复杂的控制任务和少量的计算任务,而GPU则作为计算单元,主要负责计算密集型的任务。

CPU+GPU异构计算架构的优势在于可以利用GPU强大的并行计算能力来优化整个系统的性能。

3. 异构计算的编程模型异构计算的编程模型主要有两种:MPI(Message Passing Interface)和OpenCL(Open Computing Language)。

MPI主要用于集群和网格架构,并且已经在传统计算领域有广泛的应用。

OpenCL则是用于CPU+GPU异构计算架构的编程模型,主要是基于C语言的一种编程模型,可以更好地利用GPU的并行计算能力。

4. 异构计算的性能优化异构计算的性能优化主要分为两个方面:算法优化和计算资源管理。

算法优化主要是对于计算任务的优化,利用一些新的算法来提高整个系统的性能。

计算资源管理则是针对系统中的计算资源进行管理,包括了任务分配和负载均衡等。

二、异构计算的应用1. 科学计算异构计算在科学计算领域有广泛的应用,特别是在天文学、地球物理学、气象学等方面。

异构计算并行编程模型综述

异构计算并行编程模型综述异构计算并行编程模型是指基于异构计算平台的、利用并行编程技术实现高性能计算的一种模型。

异构计算平台通常由多种类型的处理器(如CPU、GPU、FPGA等)组成,每种处理器具有自己的特点和优势,通过合理利用这些处理器,可以提升计算性能和效率。

在过去的几年中,随着GPU的广泛应用和性能的不断提升,异构计算并行编程模型逐渐引起了人们的关注。

这种编程模型通过将任务分解成多个可以并行执行的子任务,并在不同类型的处理器上进行任务分配和调度,从而实现并行计算。

异构计算并行编程模型的应用非常广泛,包括科学计算、图形处理、机器学习、数据挖掘等领域。

异构计算并行编程模型一般有三种主要的编程模型:CUDA、OpenCL和HSA。

CUDA是由NVIDIA公司推出的一种编程模型,用于实现在NVIDIA GPU上的并行计算。

CUDA具有良好的性能和灵活的编程接口,但只适用于NVIDIA GPU。

OpenCL是一种开放的异构计算编程模型,可以在多种类型的处理器上进行并行编程,包括CPU、GPU、FPGA等。

OpenCL具有良好的跨平台性和可移植性,但编程复杂度较高。

HSA是一种新兴的异构计算编程模型,由AMD、ARM等公司共同推动。

HSA致力于实现不同类型的处理器之间的协同计算,提供了更高层次的抽象和编程模型。

在使用异构计算并行编程模型时,需要注意以下几个方面。

首先,要合理选择处理器类型和数量,不同类型的处理器具有不同的优势和适用场景,需要根据具体的需求进行选择。

其次,要合理划分任务,将任务划分成多个可以并行执行的子任务,提高并行性和计算效率。

此外,还要注意数据传输和同步,异构计算平台通常由多个处理器组成,需要进行数据传输和同步,以保证计算的正确性和一致性。

因此,异构计算并行编程模型在实际应用中具有重要意义和指导价值。

通过合理利用异构计算平台的处理能力,可以实现高性能计算,提高计算效率和效果。

同时,也需要深入研究和开发更高效、更易用的异构计算并行编程模型,以满足不断增长的计算需求和复杂的应用场景。

异构计算平台的统一体系结构框架

异构计算平台的统一体系结构框架一、异构计算平台概述异构计算平台是指将不同类型的处理器或计算资源集成在一个系统中,以实现更高效的计算性能和更优的能效比。

这种平台通常包括CPU、GPU、FPGA、ASIC等多种计算单元,它们各自擅长处理不同类型的任务。

异构计算平台的发展,不仅能够推动计算技术的进步,还将对整个信息技术产业产生深远的影响。

1.1 异构计算平台的核心特性异构计算平台的核心特性主要包括以下几个方面:灵活性、并行性、能效比和可扩展性。

灵活性是指平台能够根据不同的计算任务需求,动态调整资源分配。

并行性是指平台能够同时执行多个任务,提高计算效率。

能效比是指在完成相同计算任务的情况下,平台消耗的能量更少。

可扩展性是指平台可以根据需求增加更多的计算资源。

1.2 异构计算平台的应用场景异构计算平台的应用场景非常广泛,包括但不限于以下几个方面:- 大数据处理:处理大规模数据集,进行数据挖掘和分析。

- :支持深度学习、机器学习等算法的计算需求。

- 科学计算:进行复杂的数值模拟和科学实验的计算。

- 图形渲染:提供高性能的图形处理能力,满足游戏和专业图形设计的需求。

二、异构计算平台的体系结构异构计算平台的体系结构是实现其高效运行的关键。

一个统一的体系结构框架能够确保不同计算单元之间的有效协同工作。

2.1 异构计算平台的硬件架构硬件架构是异构计算平台的基础,包括CPU、GPU、FPGA 等不同计算单元的集成方式。

这些计算单元通过高速互联技术连接,如PCIe、NVLink等,以实现快速的数据交换。

2.2 异构计算平台的软件架构软件架构是异构计算平台的大脑,负责管理和调度不同计算单元的资源。

它包括操作系统、编译器、运行时系统等,能够根据任务的特点,自动选择最合适的计算单元执行。

2.3 异构计算平台的通信机制通信机制是确保异构计算平台内部各计算单元高效协作的关键。

它涉及到数据传输、同步、任务调度等多个方面。

高效的通信机制可以减少数据传输的延迟,提高计算任务的执行效率。

人工智能开发技术中的异构计算与加速策略

人工智能开发技术中的异构计算与加速策略随着科技的不断进步和发展,人工智能(Artificial Intelligence, AI)已经成为了当今社会的热门话题。

人们利用机器学习、深度学习等技术,使计算机能够模仿人类的智能,具备像人一样的思考、判断和决策能力。

然而,在实际的AI开发过程中,面临着巨大的挑战。

其中一个重要的问题是如何提高AI计算的效率和速度。

在这方面,异构计算和加速策略成为了关键的解决方案。

一、异构计算的概念和意义异构计算是指利用多种不同类型的处理器或计算资源来协同工作,以达到提高计算效率和性能的目的。

在AI开发中,异构计算的意义非常重大。

由于AI任务通常需要大量的计算和运算,传统的计算机处理器往往无法满足需求。

而通过利用异构计算的方法,可以充分发挥各种计算资源的优势,提升整体的计算能力。

二、常见的异构计算架构常见的异构计算架构包括CPU(Central Processing Unit)、GPU(Graphics Processing Unit)和FPGA(Field Programmable Gate Array)。

不同的架构在运算能力、功耗和内存带宽等方面有所不同,适合处理不同类型的计算任务。

CPU是任何计算机系统的核心处理器,具有较高的通用性和灵活性。

对于一些需要复杂逻辑判断和多线程处理的AI任务,CPU是不可或缺的。

GPU作为图形处理器,在提供高性能图像处理能力的同时,也具备了并行计算的优势。

这使得GPU成为了训练深度神经网络时常用的计算资源。

由于神经网络计算具有良好的并行性,GPU能够同时处理大量的矩阵运算,加快了AI任务的处理速度。

FPGA则是一种可编程逻辑芯片,在加速特定应用方面具备极高的性能和灵活性。

通过在底层硬件上进行定制化的设计,FPGA可以提供定制化的运算能力,使得AI任务能够在硬件级别上得到加速。

三、加速策略的研究和应用除了利用异构计算架构,还需要研究和应用各种加速策略,以进一步提高AI计算的效率。

异构计算架构的研究与应用

异构计算架构的研究与应用异构计算架构是一种计算机架构的形式,它采用了多种不同类型的处理器来协同工作,以获得更高的计算能力和效率。

不同类型的处理器可以是不同的CPU、GPU、FPGA等,各自负责不同类型的计算任务。

异构计算架构因其卓越的性能优势,在大规模数据处理、人工智能、机器学习等领域受到极大的关注和应用。

一、异构计算架构的设计异构计算架构的设计基于两个核心思想:性能提升和能耗优化。

性能提升意味着更好的计算速度和效率,这是通过采用多核处理器以及并行计算方法来实现的。

能耗优化意味着更好的电能利用效率,这是通过采用低功耗处理器、功耗监控和分级调速等方法来实现的。

在进行异构计算架构设计时,需要考虑硬件和软件两个方面。

硬件方面包括处理器的种类、数量、功耗控制、通信互联等;软件方面包括并行计算算法的设计、资源调度、任务分配等。

相应地,异构计算架构的关键技术包括处理器设计、通信互联技术、并行计算算法、资源调度和任务分配算法等。

二、异构计算架构的应用异构计算架构的最大优势在于其高效的计算能力,因此在多种领域都有着广泛的应用。

下面分别从大规模数据处理、人工智能、机器学习三个方面介绍异构计算架构的应用。

1. 大规模数据处理对于大规模数据处理,异构计算架构可以提供高效的计算能力和低延迟的通信速度。

例如,在分布式数据库中,可以使用GPU处理与图像相关的任务,使用FPGA处理与数据压缩相关的任务,加速整个系统的性能。

此外,在大规模数据处理中,还可以使用并行计算模型和分布式系统将数据分割成小块处理,从而使系统更加高效。

2. 人工智能在人工智能领域,异构计算架构可以大大提升神经网络的训练速度和识别准确率。

例如,在图像识别任务中,可以使用GPU来处理卷积层和池化层,使用FPGA来处理全连接层,从而提高识别速度。

此外,在自动驾驶、人脸识别等任务中,也可以使用异构计算来提高性能。

3. 机器学习在机器学习领域,异构计算架构可以提供更高效的训练速度和更精确的预测结果。

异构计算并行编程模型综述

异构计算并行编程模型综述【实用版】目录一、引言二、异构计算并行编程模型的概念与分类1.异构计算体系结构2.异构并行编程模型的类型三、异构计算并行编程模型的关键技术1.编程模型与语言2.运行时管理3.性能优化四、异构计算并行编程模型的应用场景1.人工智能和大数据2.计算机图形学和图像处理3.物联网和边缘计算五、总结与展望正文一、引言随着信息技术的飞速发展,计算需求呈现出快速增长的趋势。

传统的单一计算体系已经无法满足现代应用对计算能力的需求,因此,异构计算并行编程模型应运而生。

这种模型能够充分利用多种计算资源,提高计算效率,满足不同应用场景的需求。

本文将对异构计算并行编程模型进行综述,探讨其概念、分类、关键技术以及应用场景。

二、异构计算并行编程模型的概念与分类(1)异构计算体系结构异构计算体系结构是指由不同类型的计算单元组成的系统,这些计算单元可以是 CPU、GPU、DSP、FPGA 等。

它们可以协同工作,共同完成计算任务。

异构计算体系结构可以根据不同的需求进行配置,以满足不同应用场景的要求。

(2)异构并行编程模型的类型根据不同的编程需求和应用场景,异构并行编程模型可以分为以下几种类型:1.CPU/协处理器模型:在这种模型中,CPU负责执行主线程,协处理器负责执行子线程,二者协同完成并行任务。

2.CPU/众核处理器模型:众核处理器将多个CPU核心集成在一块芯片上,可以同时执行多个线程,提高计算效率。

3.CPU/ASC模型:ASC(Accelerated System Connections)是一种高速连接技术,可以实现 CPU 与其他计算单元的快速通信,提高系统性能。

4.CPU/FPGA模型:FPGA(Field Programmable Gate Array)是一种可编程逻辑门阵列,可以根据需要实时调整硬件结构,适应不同的计算需求。

三、异构计算并行编程模型的关键技术(1)编程模型与语言为了更好地利用异构计算资源,需要设计适合的编程模型和语言。

异构计算技术的研究与应用

异构计算技术的研究与应用1. 异构计算技术的定义异构计算技术是指利用不同种类的处理器、加速器、存储器等不同种类的计算单元协同工作,从而提高计算能力、降低能耗、加速应用程序的执行速度等。

异构计算技术通过将不同性质的计算单元结合在一起,可以充分发挥各自的优势,提高计算效率,是当前计算领域的一个重要研究方向之一。

2. 异构计算技术的研究现状在异构计算技术研究方面,目前主要集中在以下几个方面的探索:(1)计算单元的异构结构设计和优化:异构计算系统中不同种类的计算单元具有不同的结构特点,如何在设计时考虑到计算单元间的数据交换和任务划分,使异构系统能够得到更好的运行效率,是目前研究的一个重要问题。

(2)异构计算系统中的数据共享和传输:由于异构计算系统中的不同计算单元结构、内部连接方式、存储器大小等存在差异,如何实现异构系统中数据的高效传输和共享,是异构计算技术研究的一个难点和瓶颈。

(3)异构计算系统的编程模型:由于异构计算系统中的不同计算单元都有各自特定的编程模型,如何实现对异构计算系统的编程是一个重要的问题。

目前,OpenCL、CUDA、HIP等编程模型逐渐成为异构计算编程的主流模型。

3. 异构计算技术的应用异构计算技术在科学计算、机器学习、图像处理、数据分析等领域都得到了广泛的应用。

以下是异构计算技术在几个领域的应用举例:(1)科学计算:异构计算技术在科学计算领域的应用非常广泛,如天体物理学、气象学、计算流体力学等。

异构计算技术可以利用GPU等高性能计算单元,提高科学计算的运算速度和精度。

(2)机器学习:随着大数据时代的到来,人工智能、机器学习等技术的发展越来越受到关注。

异构计算技术可以利用GPU或者其他加速器加速机器学习算法的计算,提高模型的训练速度和准确率。

(3)图像处理:图像处理是计算机视觉领域的重要研究方向。

异构计算技术可以利用GPU等高性能计算单元,加速图像处理算法的执行速度,提升图像处理的效果和质量。

异构计算技术的研究与应用

异构计算技术的研究与应用异构计算技术简介异构计算技术是指同时使用多种不同计算架构的设备来处理计算任务。

其中,计算架构指的是处理器和加速器等组件的组合。

异构计算技术在高性能计算、科学计算、人工智能、深度学习、云计算等领域得到了广泛的应用。

异构计算技术的分类异构计算技术可以根据处理器和加速器的类型进行分类。

1. CPU+GPUCPU+GPU是指使用中央处理器(CPU)和图形处理器(GPU)来处理计算任务。

CPU是一种通用处理器,可以运行操作系统、文件传输、网络通讯等任务。

GPU则是一种专用处理器,主要用于图像处理和计算密集型任务。

由于GPU具有高并行度和高密度,因此可以大大提高计算速度。

2. CPU+FPGACPU+FPGA是指使用中央处理器和现场可编程逻辑门阵列来处理计算任务。

FPGA可以在设计时进行重构,从而实现特定的计算任务。

这使得FPGA在高性能计算、图像处理、高速通信和数字信号处理等应用中具有广泛的应用。

3. CPU+ASICCPU+ASIC是指使用中央处理器和应用特定集成电路来处理计算任务。

ASIC是一种专用芯片,能够高效地完成特定的计算任务。

由于ASIC没有通用性,因此不能用于一般计算任务。

但是,在数字信号处理、通讯和密码学等领域,ASIC具有出色的性能。

异构计算技术的应用异构计算技术在许多领域都有重要的应用。

1. 高性能计算在高性能计算中,使用异构计算技术可以大幅提高计算机集群的计算性能。

例如,在科学计算中,异构计算技术可以用于提高模拟计算的效率和精度。

在天气预报、气象、航空航天和能源等领域,异构计算技术也得到广泛的应用。

2. 人工智能在人工智能领域,深度学习是一种需要大量计算资源的技术。

GPU具有高并行度和高密度,可以大幅提高深度学习的训练速度。

异构计算技术可以结合CPU和GPU,提高模型的训练速度和效果。

此外,异构计算技术还可以用于语音识别、图像识别、自然语言处理和智能推荐等任务。

异构计算体系结构

异构计算体系结构

异构计算体系结构是指在一个计算系统中,使用多种不同类型、不同结构的硬件和软件组件,这些组件可能包括不同的处理器、内存、操作系统、应用程序等。

这种体系结构的主要优点是可以充分利用各种硬件和软件的优势,提高系统的性能和效率。

然而,这也带来了一些挑战,如系统的复杂性增加,组件之间的兼容性问题等。

在异构计算体系结构中,主要有以下几种类型:

1. 多核处理器:这是一种使用多个处理器核心的处理器,可以同时执行多个线程或任务,从而提高系统的性能。

2. 多处理器系统:这是一种使用多个处理器的工作站或计算机系统,这些处理器可以独立工作,也可以协同工作,以提高系统的性能和可靠性。

3. 集群计算:这是一种使用多台计算机组成的系统,这些计算机可以独立工作,也可以协同工作,以提高系统的性能和可靠性。

4. 云计算:这是一种通过互联网提供计算服务的模式,用户可以按需使用计算资源,如计算能力、存储空间等。

5. 边缘计算:这是一种将计算任务分布在网络边缘的设备上的模式,这样可以减少数据传输的延迟,提高系统的性能和可靠性。

以上只是一些基本的类型,具体的异构计算体系结构可能会根据应用的需求和环境的限制来定制。

异构计算综述

异构计算(Heterogeneous computing)摘要异构计算(Heterogeneous computing)技术从80年代中期产生,由于它能经济有效地获取高性能计算能力、可扩展性好、计算资源利用率高、发展潜力巨大,目前已成为并行/分布计算领域中的研究热点之一。

本文主要介绍了CPU+GPU基础知识及其异构系统体系结构(CUDA)和基于OpenCL的异构系统,并且总结了两种结构的特点,从而对异构计算有了更深的理解。

关键词:异构计算CUDA OpenCL1、引言异构计算主要是指使用不同类型指令集和体系架构的计算单元组成系统的计算方式。

常见的计算单元类别包括CPU、GPU等协处理器、DSP、ASIC、FPGA 等。

我们常说的并行计算正是异构计算中的重要组成部分异构计算近年来得到更多关注,主要是因为通过提升CPU时钟频率和内核数量而提高计算能力的传统方式遇到了散热和能耗瓶颈。

而与此同时,GPU等专用计算单元虽然工作频率较低,具有更多的内核数和并行计算能力,总体性能/芯片面积的比和性能/功耗比都很高,却远远没有得到充分利用。

CPU的设计让其比较擅长于处理不规则数据结构和不可预测的存取模式,以及递归算法、分支密集型代码和单线程程序。

这类程序任务拥有复杂的指令调度、循环、分支、逻辑判断以及执行等步骤。

而GPU擅于处理规则数据结构和可预测存取模式。

而APU的设计理念则正是让CPU和GPU完美合作,集合两者的长处,用异构计算来达到整体性能的最佳化。

目前,已经有50款领先的应用能够利用AMD APU进行加速,而后续的应用也将陆续到来——异构计算普及的一刻应该是近在咫尺了。

1.1 CPU和GPU的本质区别(1) CPU特点a) CPU的目标是快速执行单一指令流;b) CPU将其用于乱序执行、寄存器重命名、分支预测以及巨大的cache上,这些设计都是为了加速单一线程的执行速度c) CPU利用cache来降低内存访问延迟d) CPU通过大量的cache和分支预测来降低延迟,这些机制消耗了大量的晶体管的电能;e) CPU每个核心支持1~2个线程;f) CPU切换线程的代价是数百个时钟周期;g) CPU通过SIMD(单指令多数据)来处理矢量数据;h)Intel的CPU没有集成内存控制器(2)GPU特点a) GPU的目标是快速执行大量的并行指令流。

同构计算技术和异构计算技术

同构计算技术和异构计算技术在计算机的世界里,咱们常常听到“同构计算技术”和“异构计算技术”,这俩词一听就觉得高深莫测。

其实它们就像两个不同的朋友,虽然各自有自己的特点,但都是为了让咱们的生活更加方便和快捷。

同构计算技术就像是一位老实本分的朋友,咱们可以想象他在一条直路上跑,专心致志,绝不偏离轨道。

大家伙儿都知道,处理数据时,速度快、效率高是最重要的。

这个同构的家伙,喜欢用同样的“套路”来解决问题。

比如说,如果你要做一个计算,它会把所有的处理器都像调皮的孩子一样,排成一排,齐心协力,一起完成任务。

听起来是不是很简单?大家一起干活,工作效率可想而知,简直是快得飞起。

不过,缺点也是有的,像是一个人喝水,虽然能喝得快,但喝多了也容易肚子不舒服,偶尔也会遇到“瓶颈”——这就是同构计算的限制。

然后咱们再聊聊异构计算技术,嘿,这个可就有趣多了!它就像是一群个性鲜明的朋友聚在一起,咱们可以想象一下,一个擅长唱歌的,一个擅长跳舞的,还有一个擅长画画的,他们各司其职,发挥各自的特长。

异构计算就是这样,利用不同类型的处理器来完成任务。

一个处理器负责做繁重的计算,另一个负责处理数据流,还有的可能负责图形渲染,真的是各有所长,互相配合,效率那是杠杠的!这样的团队合作,简直像是一场华丽的舞蹈,配合得天衣无缝,搭配得好,成果也不简单。

但问题来了,这种协调可不是一件容易的事,像是一个团体活动,大家都得跟着节拍走,不然就会“踩到脚”,得不偿失,真是让人捉急。

说到这,咱们不禁要问,究竟哪个更厉害呢?嘿,这可真是仁者见仁,智者见智。

对于一些简单的任务,搞搞同构计算就能应付了事,像是在家里吃快餐,方便又快捷。

可是,当任务变得复杂,数据量增加,异构计算就像是一道美味的盛宴,虽然准备麻烦点,但绝对能给你带来更好的体验。

不同的情况需要不同的解决方案,这才是科技的魅力所在。

说到这里,咱们就像是在品尝不同的美食,各有各的风味,让人欲罢不能。

这两种技术各有千秋,最终目的都是为了让咱们的生活更加智能化,让机器更懂人类的需求,省时省力。

异构计算技术的发展与应用

异构计算技术的发展与应用随着科技的不断发展,计算机技术也在不断更新换代,同时也衍生了各种新型计算技术。

异构计算技术就是其中之一,它的出现让计算机的应用范围得以进一步扩展,也带来了许多新的应用场景。

1. 异构计算技术的起源和定义异构计算技术最早可以追溯到20世纪70年代,当时的超级计算机由于计算能力限制,需要将计算任务分配给不同的处理器来完成。

这种处理器的结构和性能都不同,就需要用到异构计算技术来进行协同计算,提高系统的计算性能。

基于这种需求,硬件厂商推出了不同类型的处理器,包括中央处理器(CPU)、图形处理器(GPU)、数字信号处理器(DSP)等,这些处理器都有各自的优点,可以用来处理不同类型的计算任务。

异构计算技术的定义是指在计算机系统中,采用不同类型的处理器来协同完成各种计算任务的技术。

这些处理器的性能、结构、指令集等方面都有所不同,需要通过特定的软件技术来实现各种计算任务的分配和调度。

2. 异构计算技术的应用场景异构计算技术的应用越来越广泛,尤其是在人工智能、大数据、科学计算等领域,都有着广泛的应用场景。

(1)人工智能:人工智能需要进行大量的计算和数据处理,这些数据通常是非结构化的,需要采用深度学习等算法来进行处理。

图形处理器可以高效地完成这些任务,可以大幅提高人工智能应用的性能和效率。

(2)大数据:处理海量数据需要高性能计算能力,通常需要结合CPU和GPU来进行分布式计算。

例如,一些大型的数据中心都采用异构计算技术来进行并行计算和分布式存储。

(3)科学计算:科学计算需要进行高精度的数值计算和模拟,需要用到高性能计算机来完成。

异构计算技术可以通过多个处理器协同计算,极大地提高了科学计算的效率。

3. 异构计算技术的优势和挑战异构计算技术有以下优势:(1)高性能:异构计算技术可以将不同类型的处理器组合使用,实现分布式计算和并行计算,提高了计算系统的性能。

(2)灵活性:异构计算技术可以在不同的场景下使用不同类型的处理器来完成计算任务,具备很高的灵活性。

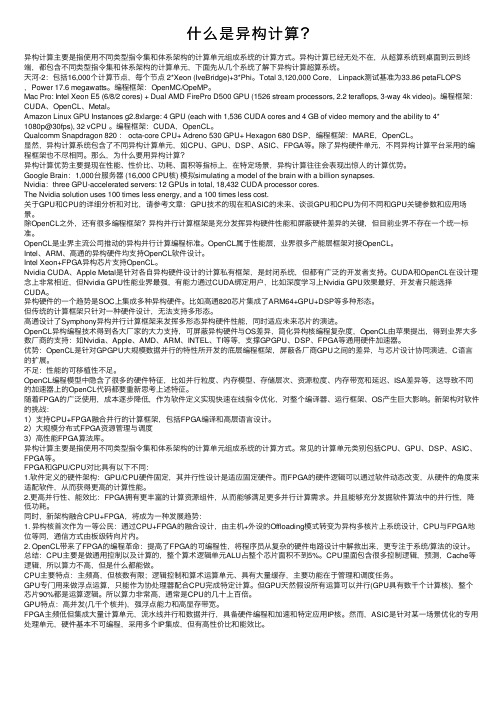

什么是异构计算?

什么是异构计算?异构计算主要是指使⽤不同类型指令集和体系架构的计算单元组成系统的计算⽅式。

异构计算已经⽆处不在,从超算系统到桌⾯到云到终端,都包含不同类型指令集和体系架构的计算单元,下⾯先从⼏个系统了解下异构计算超算系统。

天河-2:包括16,000个计算节点,每个节点 2*Xeon (IveBridge)+3*Phi。

Total 3,120,000 Core, Linpack测试基准为33.86 petaFLOPS,Power 17.6 megawatts。

编程框架:OpenMC/OpeMP。

Mac Pro: Intel Xeon E5 (6/8/2 cores) + Dual AMD FirePro D500 GPU (1526 stream processors, 2.2 teraflops, 3-way 4k video)。

编程框架:CUDA、OpenCL、Metal。

Amazon Linux GPU Instances g2.8xlarge: 4 GPU (each with 1,536 CUDA cores and 4 GB of video memory and the ability to 4*1080p@30fps), 32 vCPU 。

编程框架:CUDA,OpenCL。

Qualcomm Snapdragon 820 : octa-core CPU+ Adreno 530 GPU+ Hexagon 680 DSP,编程框架:MARE,OpenCL。

显然,异构计算系统包含了不同异构计算单元,如CPU、GPU、DSP、ASIC、FPGA等。

除了异构硬件单元,不同异构计算平台采⽤的编程框架也不尽相同。

那么,为什么要⽤异构计算?异构计算优势主要提现在性能、性价⽐、功耗、⾯积等指标上,在特定场景,异构计算往往会表现出惊⼈的计算优势。

Google Brain:1,000台服务器 (16,000 CPU核) 模拟simulating a model of the brain with a billion synapses.Nvidia:three GPU-accelerated servers: 12 GPUs in total, 18,432 CUDA processor cores.The Nvidia solution uses 100 times less energy, and a 100 times less cost.关于GPU和CPU的详细分析和对⽐,请参考⽂章:GPU技术的现在和ASIC的未来、谈谈GPU和CPU为何不同和GPU关键参数和应⽤场景。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

异构计算(Heterogeneous computing)摘要异构计算(Heterogeneous computing)技术从80年代中期产生,由于它能经济有效地获取高性能计算能力、可扩展性好、计算资源利用率高、发展潜力巨大,目前已成为并行/分布计算领域中的研究热点之一。

本文主要介绍了CPU+GPU基础知识及其异构系统体系结构(CUDA)和基于OpenCL的异构系统,并且总结了两种结构的特点,从而对异构计算有了更深的理解。

关键词:异构计算CUDA OpenCL1、引言异构计算主要是指使用不同类型指令集和体系架构的计算单元组成系统的计算方式。

常见的计算单元类别包括CPU、GPU等协处理器、DSP、ASIC、FPGA 等。

我们常说的并行计算正是异构计算中的重要组成部分异构计算近年来得到更多关注,主要是因为通过提升CPU时钟频率和内核数量而提高计算能力的传统方式遇到了散热和能耗瓶颈。

而与此同时,GPU等专用计算单元虽然工作频率较低,具有更多的内核数和并行计算能力,总体性能/芯片面积的比和性能/功耗比都很高,却远远没有得到充分利用。

CPU的设计让其比较擅长于处理不规则数据结构和不可预测的存取模式,以及递归算法、分支密集型代码和单线程程序。

这类程序任务拥有复杂的指令调度、循环、分支、逻辑判断以及执行等步骤。

而GPU擅于处理规则数据结构和可预测存取模式。

而APU的设计理念则正是让CPU和GPU完美合作,集合两者的长处,用异构计算来达到整体性能的最佳化。

目前,已经有50款领先的应用能够利用AMD APU进行加速,而后续的应用也将陆续到来——异构计算普及的一刻应该是近在咫尺了。

1.1 CPU和GPU的本质区别(1) CPU特点a) CPU的目标是快速执行单一指令流;b) CPU将其用于乱序执行、寄存器重命名、分支预测以及巨大的cache上,这些设计都是为了加速单一线程的执行速度c) CPU利用cache来降低内存访问延迟d) CPU通过大量的cache和分支预测来降低延迟,这些机制消耗了大量的晶体管的电能;e) CPU每个核心支持1~2个线程;f) CPU切换线程的代价是数百个时钟周期;g) CPU通过SIMD(单指令多数据)来处理矢量数据;h)Intel的CPU没有集成内存控制器(2)GPU特点a) GPU的目标是快速执行大量的并行指令流。

b)GPU将晶体管用于处理器阵列、多线程管理、共享内存、内存控制器,这些设计并不着眼于提高单一线程的执行速度,而是为了使GPU可以同时执行成千上万的线程,实现线程间通信,并提供极高的内存带宽。

c) GPU使用cache来放大内存带宽d) GPU通过同时运行上千个线程来隐藏延迟,等待内存访问的线程会被切换掉,e) GPU切换线程不耗时间。

f)对于支持CUDA的GPU,每个流处理器可以同时处理1024个线程。

g) GPU切换线程的代价是0,事实上GPU通常每个时钟周期都切换线程。

h) GPU则使用SIMT(单指令多线程),SIMT的好处是无需开发者费力把数据凑成合适的矢量长度,并且SIMT允许每个线程有不同的分支。

j) 支持CUDA的GPU集成有8个内存控制器,GPU的内存带宽通常是CPU 的十倍1.2 GPU计算模型内核是执行模型的核心,能在设备上执行。

当一个内核执行之前,需要指定一个N-维的范围(NDRange)。

一个NDRange是一个一维、二维或三维的索引空间。

还需要指定全局工作节点的数目,工作组中节点的数目。

如图NDRange 所示,全局工作节点的范围为{12, 12},工作组的节点范围为{4, 4},总共有9个工作组。

如果定义向量为1024维,特别地,我们可以定义全局工作节点为1024,工作组中节点为128,则总共有8个组。

定义工作组主要是为有些仅需在组内交换数据的程序提供方便。

当然工作节点数目的多少要受到设备的限制。

如果一个设备有1024个处理节点,则1024维的向量,每个节点计算一次就能完成。

而如果一个设备仅有128个处理节点,那么每个节点需要计算8次。

合理设置节点数目,工作组数目能提高程序的并行度。

图1.GPU计算模型CPU的长项是整数计算,GPU的优势则是浮点计算。

对于整机性能而言,CPU和GPU都是性能的保障,合理的搭配才是重中之重,才能给用户带来最强的综合性能。

1.3异构计算分类及发展方向目前的趋势,增加并行的性能,而不是时钟频率。

我们的重点是在一个节点,几乎是充分利用指令级并行性。

这意味着,提高性能,必须来自多芯片,多核或多上下文并行。

Flynn的分类法在硬件定义了四个级别的并行:(1)单指令单数据(SISD)(2)单指令多数据流(SIMD)(3)多指令单数据(MISD)(4)多指令多数据(MIMD)此外,两个细分MIMD单程序多数据(SPMD),以及多个程序多数据(MPMD),我们使用这些术语来描述架构。

图2.架构单芯片CBEA,如图所示(a),由一个传统的CPU核心和8个SIMD加速器核心。

这是一个非常灵活的架构,每个核心可以运行单独MPMD时尚和沟通方案,快速通过片上总线。

其主要设计标准得到了最大限度降低消耗的功率。

图中(b)显示了多线程SIMD加速器结合一个标准的多核CPU核心的GPU。

GPU 具有优异的带宽和计算性能,对很少或根本没有同步运行的SPMD方案进行了优化。

它是专为高性能的图形,其中的数据吞吐量是关键。

最后,图中(c)显示了FPGA逻辑块阵列组成和一个标准的多核心CPU的组合。

FPGA的片上,也可以纳入正规的CPU核心,使得它本身就是一个异构芯片。

FPGA可视为用户定义的应用程序的专用集成电路(ASIC)的可重构。

他们提供充分确定性的表现,是专为高吞吐量,例如,在电信方面的应用。

目前异构并行计算向着以下几个方向发展:(1)集群计算。

这是传统高性能计算的领域。

但是今天高性能计算已经演变成了异构并行计算的一部分,越来越多的高性能计算集群使用GPU、MIC、FPGA等。

(2)单机计算。

推动单机计算向异构并行计算发展的主要动力是游戏、计算机辅助设计等,而主要表现是GPU+CPU的异构计算。

(3)移动计算。

近几年发展表明,人们对手机的需求比对PC的需求更大。

目前几乎所有的移动芯片解决方案都是异构的,除了有CPU、GPU之外,还有视频编解码单元、音频处理单元。

倾向于把更多工作内容转移到手机上,但是为了保证续航时间,移动处理器的设计一开始就不是以高性能为目标,这使得要在移动处理器上获取高性能是比较困难的。

(4)嵌入式计算。

在一些恶劣工作环境下,只有DSP和FPGA能够满足要求。

2、异构计算系统2.1 CPU+GPU 异构系统体系结构计算机系统一般都配置了CPU 和GPU,GPU传统上只负责图形渲染,大部分的仸务都由CPU 来完成。

随着图形渲染的数据量越来越大、计算也越来越复杂,GPU 的可编程性和幵行性也随之增强。

目前,主流GPU 的计算能力、存储带宽、性价比与同期的CPU 相比更具竞争力。

下面以支持CUDA(Computing Unified Device Architecture) 的GPU为例来说明CPU+GPU 异构计算系统的体系结构。

支持CUDA 的GPU 通常由数个线程处理器簇。

TPC(Thread Processor Cluster)组成,如:NVIDIA GeForce 9800 GX2 由2个TPC组成双核GPU;NVIDIA GeForce 9800 GTX 只含有一个TPC。

每个TPC 由若干流多处理器SM(Streaming Multi-processor)组成,一个SM 包含8个线程处理器TP(threaded processor)和一定大小的共享存储空间(Shared Memory),另外,GPU还提供了全局的存储器(Global Memory or Video Memory)和一定数量的全局只读的纹理缓存(Texture Cache)和常缓存(Constant Cache)。

GPU与CPU间的数据传输通过PCIE 通道来完成,该数据传输通道可能成为性能瓶颈。

CPU+GPU 异构系统的整体结构如下图所示。

图3.CPU+GPU异构系统体系结构2.1.2 CUDA执行模型CUDA 源程序由运行于host(CPU)上的控制程序和运行于device(GPU)上的计算核心(kernel)两部分组成。

每一个kernel 由一组相同大小的线程块(thread block)来幵行执行,同一线程块里面的线程通过共享存储空间来协作完成计算,线程块间是相互独立的。

运行时,每一个线程块会被分派到一个流多处理器SM上运行,它们共享大小为16KB 的共享存储空间。

为了管理运行各种不同程序的数百个线程,SM 采用了一种称为SIMT(single instruction multiple thread,SIMT)的新架构。

SIMT 单元以32 个幵行线程为一组来创建、管理、调度和执行线程,这样的线程组称为warp 块。

多个warp 块可以组成一个线程块,一个线程块将会分派到一个SM 上,SM 会将各线程映射到一个TP核心上,各TP 使用自己的指令地址和寄存器状态独立执行。

构成SIMT warp块的各个线程在同一个程序地址一起启动,也可随意分支、独立执行。

为一个SM 指定了一个或多个要执行的线程块时,它会将其分成warp 块,幵由SIMT单元迚行调度。

将块分割为warp 块的方法总是相同的,每个warp 块都包含连续的线程,递增线程ID,第一个warp 块中包含线程0。

每収出一条指令时,SIMT单元都会选择一个已准备好执行的warp 块,幵将下一条指令収送到该warp 块的活动线程,其执行调度过程示意如下图所示。

图4.CUDA执行模型2.1.3 协作框架由于PCIE 数据传输通道会成为CPU+GPU 异构系统的性能瓶颈,因此,保证通信传输开销取得最优解的情况下,更有利于优化通信开销取得期望解,GPU与CPU如何协作完成求解问题,最大限度较少数据在CPU 与GPU之间的频繁传输显得尤为重要。

为此参考文献之处写作框架如下:图5.CPU+GPU协作框架2.2.3 实验评估分析为了验证本文提出的协作框架的有效性和高效性,选择了计算密集型应用图像置乱变换作为测试用例。

实验环境配置如下:(1) Intel Core2 Quad 2.33Ghz ,4GB内存,Microsoft Visual Studio 2005(2) GeForce GTX280,1GB 显存,16KB Shared Memory,CUDA toolkit 和SDK 2.0,NVIDIA Driver for Microsoft Windows XP(177.98)图6.运行时间比较2.3 基于OpenCL的异构系统并行编程使用GPU进行通用计算是近些年的热点研究领域。