注水定理和矩阵分解

注水定理算法步骤

注水定理算法步骤

注水定理在信息论等领域可是个很有趣的东西呢。

那它的算法步骤大概是这样的。

我们得先确定一些东西哦。

要知道信道的一些特性,就像是你要了解一个小伙伴的脾气秉性一样。

这里要知道信道的噪声功率谱密度之类的参数。

然后呢,我们要构建一个关于功率分配的函数。

这个函数就像是一个魔法配方,根据不同的信道状况,把总功率分配到不同的子信道上去。

这就好比你有一堆糖果,要根据小伙伴们的喜好,分给不同的小伙伴。

接着呀,这个函数会在一些条件的约束下达到最优。

比如说,总功率是有限制的,不能无限制地分配。

这就像你手里的糖果数量是有限的,不能凭空变出来更多去分给大家。

在实际计算的时候,我们可能会用到一些数学工具,像拉格朗日乘子法之类的。

不过可别被这个名字吓到啦,就把它当成一个小帮手。

它能帮助我们找到那个最优的功率分配方案。

再然后呢,根据计算出来的结果,我们就知道每个子信道应该分配多少功率啦。

就像是每个小伙伴都拿到了属于自己的那份糖果,大家都开开心心的。

矩阵分解的方法和应用

矩阵分解的方法和应用在机器学习和数据分析领域,矩阵分解是一个常用的技术手段。

通过对数据矩阵进行分解,我们可以得到数据的潜在特征和规律,从而更好地理解和利用数据。

本文将介绍矩阵分解的常见方法和应用。

一、基本概念矩阵分解是指将一个矩阵表示为若干个小矩阵(或向量)的乘积的形式。

这些小矩阵一般是具有特定结构或意义的,例如对称矩阵、正定矩阵、特征矩阵等等。

矩阵分解可以应用到各种场景,例如数据降维、矩阵压缩、矩阵重构、协同过滤等等。

二、矩阵分解的方法常见的矩阵分解方法有以下几种:1. 奇异值分解(SVD)奇异值分解是一种基础的矩阵分解方法。

它将一个矩阵分解为三个小矩阵的乘积形式:$A=U\Sigma V^T$,其中$U$和$V$是正交矩阵,$\Sigma$是奇异值矩阵。

通过特征值分解可以得到奇异值矩阵,从而实现矩阵分解。

奇异值分解可以用来进行数据降维和矩阵重构。

例如,我们可以将一个高维度的数据矩阵分解为低维度的奇异向量,从而实现数据降维;或者我们可以使用奇异向量重构原始的矩阵,从而实现数据压缩。

2. QR分解QR分解是一种将矩阵分解为正交矩阵和上三角矩阵的方法。

具体来说,对于一个矩阵$A$,可以分解为$A=QR$,其中$Q$是正交矩阵,$R$是上三角矩阵。

QR分解可以应用到求解线性方程组、估计模型参数等领域。

3. 特征值分解(EVD)特征值分解是指将一个方阵分解为正交矩阵和对角矩阵的乘积形式。

具体来说,对于一个方阵$A$,可以分解为$A=V\LambdaV^{-1}$,其中$V$是正交矩阵,$\Lambda$是对角矩阵,对角线上的元素就是矩阵$A$的特征值。

特征值分解可以用于矩阵压缩和数据降维。

三、矩阵分解的应用1. 推荐系统推荐系统是一种常见的应用场景,它可以根据用户历史行为和兴趣,向用户推荐可能感兴趣的物品。

矩阵分解可以应用到推荐系统中,其基本思路是利用用户对物品的评分矩阵,对其进行分解,得到用户和物品的特征向量,然后通过计算余弦距离等方法,计算出用户和物品之间的相似度,从而推荐给用户可能感兴趣的物品。

矩阵分解的常用方法(全文)

矩阵分解的常用方法一、矩阵的三角分解定义:如果方阵可分解成一个下三角形矩阵L和上三角形矩阵U的的乘积,则称可作三角分解或LU分解。

定理1:高斯消元过程能够进行到底的充分必要条件是的前n-1个顺序主子式都不为零,即k ≠0,k=1,2,…,n-1。

(1)当条件(1)满足时,有L(n-1)…L(2)L(1)=U。

其中U为上三角形矩阵L(k)=lik=,i=k+1,…,n。

容易得出,detL(k)≠0(k=1,2,…,n-1),故矩阵L(k)可逆,于是有=(L(1))-1(L(2))-1…(L(N-1))-1U。

由于(L(K))-1是下三角形矩阵,故它们的连乘积仍然是下三角矩阵。

令L=(L(1))-1(L(2))-1…(L(N-1))-1=则得=LU。

即分解成一个单位下三角形矩阵L和一个上三角形矩阵U的的乘积。

二、矩阵的QR(正交三角)分解定义:如果实(复)非奇异矩阵能化成正交(酉)矩阵Q 与实(复)非奇异上三角矩阵R的乘积,即=QR,则称上式为的QR分解。

定理2:任何实的非奇异n阶矩阵可以分解成正交矩阵Q 和上三角形矩阵R的乘积,且除去相差一个对角线元素之绝对值等于1的对角矩阵D外,分解成=QR是唯一的。

矩阵QR的分解具体做法如下:令的各列向量依次为α1,α2,…,αn,由于是非奇异的,所以α1,α2,…,αn线性无关,按照施密特正交法正交化得到个标准的正交向量β1,β2,…,βn,且β=bαβ=bα+b22α2β=bα+b2nα2+…+bnnαn这里bij都是常数,且由正交化过程知bii≠0(i=1,2,…,n)写成矩阵形式有(β1,β2,…,βn)=(α1,α2,…,αn)β,即Q=B。

其中B=是上三角矩阵(bii≠0,i=1,2,…,n)。

显然B可逆,而且B=R-1也是上三角矩阵,由于Q的各列标准正交,所以Q 正交矩阵,从而有=QR。

三、矩阵的奇异值分解定理3 (奇异之分解定理)设是一个m×n的矩阵,且r ()=r,则存在m阶酉矩阵U和n阶酉矩阵V,使得UHV=(2),其中?撞=dig(1…r),且1≥2≥…≥r≥0。

矩阵分解的原理及其应用

矩阵分解的原理及其应用一、矩阵分解的原理矩阵分解是将一个矩阵拆解为多个矩阵相乘的过程,通过分解原矩阵,可以提取隐含在矩阵中的潜在信息。

常见的矩阵分解方法有奇异值分解(Singular Value Decomposition, SVD)、QR分解、LU分解等。

1. 奇异值分解(SVD)奇异值分解是矩阵分解中应用最广泛的方法之一。

它将一个矩阵分解为三个矩阵的乘积,即A=UΣV^T,其中U和V是正交矩阵,Σ是对角矩阵。

在奇异值分解中,U矩阵包含了原矩阵A的左奇异向量,V矩阵包含了原矩阵A的右奇异向量,Σ矩阵中的对角线元素称为奇异值。

2. QR分解QR分解将一个矩阵分解为一个正交矩阵Q和一个上三角矩阵R的乘积,即A=QR。

其中Q的列向量是正交的,R是上三角矩阵。

QR分解常用于求解线性方程组、矩阵的逆以及最小二乘问题等。

3. LU分解LU分解将一个矩阵分解为一个下三角矩阵L和一个上三角矩阵U的乘积,即A=LU。

其中L是单位下三角矩阵,U是上三角矩阵。

LU分解常用于求解线性方程组。

二、矩阵分解的应用矩阵分解在数据分析、机器学习、推荐系统等领域中有着广泛的应用。

1. 数据压缩奇异值分解可以用于数据压缩,通过提取矩阵的主要特征,可以将原矩阵表示为一个较小的低秩近似矩阵。

这样可以减少存储空间和计算成本,并且在一定程度上保留了原矩阵的信息。

2. 推荐系统矩阵分解在推荐系统中有广泛的应用。

通过对用户-物品评分矩阵进行分解,可以得到用户和物品的隐含特征向量,进而可以进行个性化推荐。

常见的矩阵分解方法如协同过滤(Collaborative Filtering)和隐语义模型(Latent Semantic Model)等。

3. 图像处理矩阵分解在图像处理中也有重要的应用。

例如,图像压缩算法JPEG使用了奇异值分解来减小图像文件的大小。

此外,矩阵分解还可以用于图像的降噪、图像融合等方面。

4. 信号处理在信号处理中,矩阵分解可以用于信号的分解与重构。

矩阵分解公式

矩阵分解公式

(原创实用版)

目录

1.矩阵分解公式的概述

2.矩阵分解公式的类型

3.矩阵分解公式的应用

4.矩阵分解公式的举例

正文

矩阵分解公式是一种重要的数学工具,它在诸多领域中都有着广泛的应用。

矩阵分解公式可以帮助我们将一个矩阵分解成一些简单的矩阵的乘积,这对于理解和操作矩阵而言是非常有帮助的。

矩阵分解公式主要有两种类型,一种是矩阵的 LU 分解,另一种是矩阵的 QR 分解。

矩阵的 LU 分解是将一个矩阵分解成一个下三角矩阵和一个上三角矩阵的乘积,而矩阵的 QR 分解则是将一个矩阵分解成一个正交矩阵和一个上三角矩阵的乘积。

这两种分解方法各有其优点和适用范围,需要根据具体情况选择合适的分解方法。

矩阵分解公式在许多领域都有着广泛的应用,例如在数值分析中,矩阵分解可以帮助我们求解线性方程组;在机器学习中,矩阵分解可以用来对数据进行降维处理;在图像处理中,矩阵分解可以用来对图像进行压缩和增强等。

举个例子,假设我们有一个 3x3 的矩阵 A,我们需要将其进行 LU 分解。

首先,我们需要求出矩阵 A 的主对角线元素,然后将主对角线元素组成一个新的矩阵 L,接着求出矩阵 L 的逆矩阵,最后将矩阵 A 乘以矩阵 L 的逆矩阵,就可以得到一个下三角矩阵,这个下三角矩阵的乘积再乘以矩阵 L,就等于矩阵 A。

这就是矩阵的 LU 分解。

注水算法原理

注水算法原理注水算法(Water Filling Algorithm)是一种常用的信号处理算法,主要用于无线通信系统中的功率分配问题。

其原理是根据信道的信噪比情况,将总功率按照一定的规则分配到各个子载波上,以达到最优的传输性能。

本文将介绍注水算法的基本原理和应用。

首先,我们来看一下注水算法的基本原理。

在无线通信系统中,信道的信噪比是一个非常重要的参数,它直接影响到信号的传输质量。

在一个多载波的通信系统中,不同的子载波的信道质量是不同的,有些子载波的信道质量较好,有些子载波的信道质量较差。

注水算法的基本思想就是将总功率按照信道质量的大小进行分配,即在信道质量较好的子载波上分配更多的功率,在信道质量较差的子载波上分配较少的功率,以达到整体传输性能的最优化。

其次,我们来看一下注水算法的应用。

注水算法主要应用于多载波通信系统中的功率分配问题,例如正交频分复用(OFDM)系统、多载波码分多址(MC-CDMA)系统等。

在这些系统中,由于信道的多样性,不同的子载波之间的信道质量存在较大差异,因此需要采用注水算法来进行功率分配,以提高系统的整体传输性能。

在实际应用中,注水算法需要考虑的因素有很多,例如信道的动态变化、用户间的干扰、系统的功率限制等。

因此,如何设计高效的注水算法成为了无线通信系统中的一个重要问题。

目前,针对不同的通信系统和应用场景,研究人员提出了许多改进的注水算法,如基于子载波分组的注水算法、考虑干扰的注水算法等,这些算法在不同的场景下都取得了一定的成果。

总的来说,注水算法作为一种常用的功率分配算法,在无线通信系统中发挥着重要的作用。

通过合理地分配功率,可以有效地提高系统的传输性能,提高系统的容量和覆盖范围。

随着通信技术的不断发展,注水算法也将会得到进一步的改进和应用,为无线通信系统的发展做出更大的贡献。

通过本文的介绍,相信读者对注水算法的原理和应用有了一定的了解。

希望本文能够对相关领域的研究和应用工作有所帮助。

矩阵分解的原理与应用

矩阵分解的原理与应用矩阵是线性代数中最基本的数据结构,在机器学习,推荐系统,图像处理等领域都有广泛应用。

矩阵分解就是将一个大的矩阵分解成多个小的矩阵,通常用于降维、特征提取、数据压缩等任务。

我们现在就来详细探讨矩阵分解的原理和应用。

一、基本概念与背景1. 矩阵的基本概念矩阵是由多行和多列构成,每行和每列的数值称为元素。

用数的矩形阵列来表示的数学对象称为矩阵。

2. 矩阵的类型在数据分析中,矩阵有不同的分类,如稠密矩阵、稀疏矩阵、分块矩阵等。

3. 矩阵分解的背景通过矩阵分解,我们可以将一个大的矩阵分解成多个小的矩阵,这些小矩阵可以更方便的处理。

同时,矩阵分解也可以用来进行数据压缩、降维、特征提取等任务。

二、矩阵分解的基本思想矩阵分解的基本思想是将大的矩阵分解成多个小的矩阵,通常是将原始数据矩阵分解成两个或以上的低维矩阵。

其中,最基本的矩阵分解方法包括奇异值分解(Singular Value Decomposition,简称SVD)和QR分解(QR Decomposition)。

1. 奇异值分解(SVD)奇异值分解是将任意矩阵分解为三个矩阵之积的算法。

SVD可以分解任意的矩阵X为X=UΣV*的形式,其中U和V是两个矩阵,Σ是一个对角矩阵,其对角线上的元素称为奇异值。

这里,U、V都是酉矩阵,U、V*在原始矩阵的意义下构成一个对称双正交矩阵(或称为正交矩阵)。

其中,U是原始矩阵XXT的特征向量组成的矩阵,V是原始矩阵XTX的特征向量组成的矩阵。

奇异值则是U和V之间的关联,它是一个对角矩阵,其中的元素由矩阵的奇异值所组成。

SVD的一个重要应用是在推荐系统中的协同过滤算法中。

在协同过滤算法中,我们可以将用户-物品评分矩阵分解为两个矩阵,以此来实现推荐。

2. QR分解(QR Decomposition)QR分解是将矩阵分解为正交矩阵和上三角矩阵之积的算法。

将矩阵A分解为A=QR,其中Q是正交矩阵,R是上三角矩阵。

矩阵分解的原理和实现

矩阵分解的原理和实现矩阵分解即将一个矩阵分解成多个矩阵的乘积,这是很多数据科学问题中经常采用的一种技术。

矩阵分解有很多种方法,其中比较知名的有奇异值分解(SVD)、QR分解和LU分解等。

矩阵分解的原理是将一个复杂的矩阵转化为简单的矩阵,这样能够更好的对矩阵进行处理。

例如在推荐系统中,我们常常需要对一个二维矩阵中的空白位置进行填充,矩阵分解可以帮助我们得到这些缺失值,进而提升推荐系统的效果。

SVD是矩阵分解中应用最广泛的方法,可以将一个复杂的矩阵分解成三个矩阵的乘积:U、S和Vᵀ。

其中U和V是正交矩阵,S 是对角线上排列着矩阵奇异值的矩阵。

SVD的实现一般有两种方法:基于迭代的方法和基于随机化的方法。

在大数据量的情况下,基于随机化的方法更加高效,可以大大提高计算效率。

除了奇异值分解外,QR分解和LU分解也是矩阵分解常用的方法。

QR分解是将一个方阵分解成一个正交矩阵Q和一个上三角矩阵R的乘积。

而LU分解则是将一个方阵分解成一个下三角矩阵L 和一个上三角矩阵U的乘积。

这两种分解都有其适用范围,可以满足不同场景下的需求。

矩阵分解的实现方法有很多种,其中最常用的是基于矩阵乘法的方法,它可以同时处理多个矩阵,并且计算效率较高。

这种方法的主要思想是将大矩阵划分成若干个子矩阵,将子矩阵减小到足够小的尺寸,然后利用多线程或分布式计算进行矩阵乘法运算,最终将子矩阵的结果汇总得到大矩阵的解。

除了基于矩阵乘法的方法,还有其它的实现方法,如基于梯度下降的方法、基于随机梯度下降的方法和交替最小二乘法等。

这些方法在不同的场景下都有一定的优势和不同的适用范围。

总之,矩阵分解是数据科学中非常重要的技术之一,可以应用于推荐系统、降维分析、图像处理等领域。

不同的矩阵分解方法有其适用场景和不同的特点,需要根据实际问题选用不同的方法。

在实现矩阵分解时,我们需要充分利用计算机的并行计算能力,通过多线程或分布式计算等方式来提高计算效率,以便更好的完成数据科学问题的解决。

(完整word版)矩阵分解及其简单应用

对矩阵分解及其应用矩阵分解是指将一个矩阵表示为结构简单或具有特殊性质若干矩阵之积或之和,大体分为三角分解、QR 分解、满秩分解和奇异值分解。

矩阵的分解是很重要的一部分内容,在线性代数中时常用来解决各种复杂的问题,在各个不同的专业领域也有重要的作用。

秩亏网平差是测量数据处理中的一个难点,不仅表现在原理方面,更表现在计算方面,而应用矩阵分解来得到未知数的估计数大大简化了求解过程和难度。

1. 矩阵的三角分解如果方阵A可表示为一个下三角矩阵L和一个上三角矩阵U之积,即A=LU 则称A可作三角分解。

矩阵三角分解是以Gauss消去法为根据导出的,因此矩阵可以进行三角分解的条件也与之相同,即矩阵A的前n-1个顺序主子式都不为0, 即?k工0.所以在对矩阵A进行三角分解的着手的第一步应该是判断是否满足这个前提条件,否则怎么分解都没有意义。

矩阵的三角分解不是唯一的,但是在一定的前提下,A=LDU勺分解可以是唯一的,其中D是对角矩阵。

矩阵还有其他不同的三角分解,比如Doolittle 分解和Crout 分解,它们用待定系数法来解求 A 的三角分解,当矩阵阶数较大的时候有其各自的优点,使算法更加简单方便。

矩阵的三角分解可以用来解线性方程组Ax=b。

由于A=LU,所以Ax=b可以变换成LU x=b,即有如下方程组:Ly = b{{Ux = y先由Ly = b依次递推求得y i, y2, ........ ,y n,再由方程Ux = y依次递推求得X n,x n-1 , ... ,X1 .必须指出的是,当可逆矩阵A不满足?k工0时,应该用置换矩阵P左乘A以便使PA 的n个顺序主子式全不为零,此时有:Ly = pb{{ Ux = y 这样,应用矩阵的三角分解,线性方程组的解求就可以简单很多了。

2. 矩阵的QF分解矩阵的QR分解是指,如果实非奇异矩阵A可以表示为A=QR其中Q为正交矩阵,R为实非奇异上三角矩阵。

QR分解的实际算法各种各样,有Schmidt正交方法、Give ns方法和Householder方法,而且各有优点和不足。

矩阵的分解——精选推荐

矩阵的分解§9. 矩阵的分解矩阵分解是将⼀个矩阵分解为⽐较简单的或具有某种特性的若⼲矩阵的和或乘积,这是矩阵理论及其应⽤中常见的⽅法。

由于矩阵的这些特殊的分解形式,⼀⽅⾯反映了原矩阵的某些数值特性,如矩阵的秩、特征值、奇异值等;另⼀⽅⾯矩阵分解⽅法与过程往往为某些有效的数值计算⽅法和理论分析提供了重要的依据,因⽽使其对分解矩阵的讨论和计算带来极⼤的⽅便,这在矩阵理论研究及其应⽤中都有⾮常重要的理论意义和应⽤价值。

这⾥我们主要研究矩阵的三⾓分解、谱分解、奇异值分解、满秩分解及特殊矩阵的分解等。

⼀、矩阵的三⾓分解——是矩阵的⼀种有效⽽应⽤⼴泛的分解法。

将⼀个矩阵分解为⾣矩阵(或正交矩阵)与⼀个三⾓矩阵的乘积或者三⾓矩阵与三⾓矩阵的乘积,这对讨论矩阵的特征、性质与应⽤必将带来极⼤的⽅便。

⾸先我们从满秩⽅阵的三⾓分解⼊⼿,进⽽讨论任意矩阵的三⾓分解。

定义1 如果(1,2,,)ii a i n = 均为正实数,()(,1,2,1;∈<=- ij a C R i j i n1,2,),=++ j i i n 则上三⾓矩阵1112122200=n nnn a a a a a R a 称为正线上三⾓复(实)矩阵,特别当1(1,2,,)ii a i n == 时,R 称为单位上三⾓复(实)矩阵。

定义2如果(1,2,,)ii a i n = 均为正实数,()(,1,2,1;∈>=- ij a C R i j i n1,2,),=++ j i i n 则下三⾓矩阵11212212000?? ?=n n nn a a a L a a a称为正线下三⾓复(实)矩阵,特别当1(1,2,,)ii a i n == 时,L 称为单位下三⾓复(实)矩阵。

定理1设,?∈n n n A C 则A 可唯⼀地分解为1=A U R其中1U 是⾣矩阵,R 是正线上三⾓复矩阵;或者A 可唯⼀地分解为2=A LU其中2U 是⾣矩阵,L 是正线下三⾓复矩阵。

线性代数中的矩阵分解理论

线性代数中的矩阵分解理论矩阵分解是线性代数中的一个重要概念和技术,通常用于将一个矩阵拆解成简化形式。

在许多应用领域,矩阵分解都具有广泛的应用,例如信号处理、数据压缩、机器学习等。

本文将介绍线性代数中的矩阵分解理论及其应用。

一、矩阵分解的基本原理在线性代数中,矩阵分解是将一个给定的矩阵拆分为多个矩阵的乘积的过程。

常见的矩阵分解方法有LU分解、QR分解和奇异值分解等。

这些分解方法都具有不同的特点和适用范围。

1. LU分解LU分解是将一个矩阵A拆解为两个矩阵L和U的乘积。

其中L是一个下三角矩阵,U是一个上三角矩阵。

LU分解常用于求解线性方程组,通过分解后的矩阵可以对方程组进行简化和求解。

2. QR分解QR分解是将一个矩阵A拆解为一个正交矩阵Q和一个上三角矩阵R的乘积。

QR分解常用于求解最小二乘问题和矩阵的特征值等。

3. 奇异值分解奇异值分解是将一个矩阵A拆解为一个酉矩阵U、一个对角矩阵Σ和另一个酉矩阵V的转置的乘积。

奇异值分解是矩阵分解中最广泛应用的方法之一,可以用于降维、数据压缩和图像处理等领域。

二、矩阵分解的应用领域矩阵分解在许多应用领域中都有重要的应用,下面介绍几个常见的应用领域。

1. 信号处理在信号处理中,矩阵分解常用于信号的降噪和信号的重构。

通过将观测到的信号矩阵进行分解,可以得到信号的主要成分和噪声的成分,从而实现信号的处理和分析。

2. 数据压缩矩阵分解在数据压缩领域中被广泛应用。

通过将一个高维的数据矩阵进行分解,可以提取出数据的主要成分,从而实现数据的降维和压缩。

常用的数据压缩方法之一就是基于奇异值分解的方法。

3. 机器学习在机器学习中,矩阵分解被广泛应用于推荐系统和聚类分析等任务中。

通过将用户-物品的评分矩阵进行分解,可以得到潜在的用户兴趣和物品特征,从而实现个性化推荐和相似物品的聚类分析。

三、矩阵分解的扩展除了上述介绍的常见矩阵分解方法外,还有许多其它的矩阵分解方法被提出和应用。

例如,非负矩阵分解、稀疏矩阵分解等。

3、注水原理推导,功率和比特分配算法

三、注水原理推导,功率和比特分配算法1、注水原理推导当发射端已知CSI 时,可以采用注水原理来分配各个发送天线的功率,在功率受限的情况下,注水原理可以通过MIMO 信道容量最大化推导出来。

注水原理的推导:(在信道容量推导的基础上)功率满足:m1i i P P ==∑信道容量: 221log 1mii i P C λσ=⎛⎫=+ ⎪⎝⎭∑ 寻求使容量C 最大化的i P 的值: 利用拉格朗日乘数法引入函数:2211log 1(P )NN i i i i i P Z L P λσ==⎡⎤=++-⎢⎥⎣⎦∑∑ 令0i Z P ∂=∂,有:2210ln 21i i i Z L P P λσλσ∂=•-=∂+ 得:221L ln 2i i iP σσμλλ=-=-•,其中μ为常数 推导得到:+2i i P σμλ⎛⎫=- ⎪⎝⎭ 式中,+a 指()0,m ax a ,μ称为注水平面,i λ是信道矩阵的第i 个特征值,2σ是噪声方差。

2、基于注水原理的功率分配算法m 1i i P P ==∑=1221()mm i i i i m σλμσμλ===--∑∑ 21P+=i mi m σλμ=∑+2i i P σμλ⎛⎫=- ⎪⎝⎭ 算法可以描述如下:Step1: 初始化,设第k 个时刻定总功率为()1P k =;Step2: 根据)(H SVD =λ并由注水定理可得出每根天线上分配的功率),(k P i 且有)()(1k P k P ri i =∑=;Step3: 对式))(1(log 22σλk P m i i i ⋅Γ+=进行量化可得出每根天线分配到的比特)(k R i ; Step4: 根据式(3.9)计算系统数据速率;Step5 : 1k k =+()1P k =,跳转至Step2实际上这种算法时把信道 H 分解成了))((H rank m 个相互之间独立并行的子信道并根据各个子信道的好坏来分配不同的发送功率。

矩阵分解公式

矩阵分解公式摘要:一、矩阵分解公式简介1.矩阵分解的定义2.矩阵分解的意义二、矩阵分解的几种方法1.奇异值分解(SVD)2.谱分解(eigenvalue decomposition)3.非负矩阵分解(NMF)三、矩阵分解在实际应用中的案例1.图像处理2.信号处理3.数据降维四、矩阵分解的发展趋势和挑战1.高维数据的处理2.矩阵分解算法的优化3.新型矩阵分解方法的研究正文:矩阵分解公式是线性代数中一个重要的概念,它涉及到矩阵的诸多操作,如矩阵的乘法、求逆、迹等。

矩阵分解的意义在于将一个复杂的矩阵简化为易于处理的形式,从而便于进行矩阵运算和数据分析。

本文将介绍几种常见的矩阵分解方法,并探讨它们在实际应用中的案例和发展趋势。

首先,我们来了解一下矩阵分解的定义。

设A是一个m×n的矩阵,矩阵分解就是将A表示为若干个矩阵的乘积,即A = UΣV*,其中U是m×m的酉矩阵(满足UU* = I),Σ是m×n的非负实对角矩阵,对角线上的元素称为奇异值,V是n×n的酉矩阵(满足VV* = I),V*是V的共轭转置。

通过矩阵分解,我们可以得到矩阵A的秩、奇异值、特征值等信息。

矩阵分解有多种方法,其中较为常见的有奇异值分解(SVD)、谱分解(eigenvalue decomposition)和非负矩阵分解(NMF)。

奇异值分解是将矩阵A分解为三个矩阵的乘积:UΣV*,其中U和V是酉矩阵,Σ是对角矩阵。

谱分解是将矩阵A分解为两个矩阵的乘积:A = UΣV*,其中U和V是酉矩阵,Σ是对角矩阵,对角线上的元素是矩阵A的特征值。

非负矩阵分解是将矩阵A分解为两个非负矩阵的乘积:A = WH,其中W和H都是非负矩阵。

矩阵分解在实际应用中有着广泛的应用,尤其在图像处理、信号处理和数据降维等领域。

在图像处理中,矩阵分解可以用于图像压缩、去噪和特征提取等任务。

在信号处理中,矩阵分解可以用于信号降噪、特征提取和频谱分析等任务。

矩阵分解及应用

引言数学是人类历史中发展最早,也是发展最为庞大的基础学科。

许多人说数学是万理之源,因为许多学科的研究都是以数学做为基础,有了数学的夯实基础,人类才铸就起了众多学科的高楼大厦,所以数学的研究和发展一直在不断的发展壮大。

在数学中有一支耀眼的分支,那就是矩阵。

在古今矩阵的研究发展长河中产生了许多闪耀星河的大家。

英国数学大家詹姆斯·约瑟夫·西尔维斯特,一个数学狂人,正是他的孜孜不倦的研究使得矩阵理论正式被确立并开启了矩阵发展的快速发展通道。

凯莱和西尔维斯特是非常要好的朋友,他也是一位非常伟大的数学大师,正是他们伟大的友谊,加上两人的齐心协力最后他们共同发展了行列式和矩阵的理论。

后来高斯在矩阵方面的研究取得重要的成就,尤其是高斯消去法的确立,加速了矩阵理论的完善和发展。

而在我国,矩阵的概念古已有之。

从最早的数学大家刘徽开始我们古代数学大家都已或多或少的研究了矩阵。

尤其在数学大家刘徽写的《九章算术》中,它最早提出了矩阵的类似定义。

而且是将矩阵的类似定义用在了解决遍乘直除问题里了。

这已经开始孕育出了最早的矩阵形式。

随着时间转移,矩阵的理论不断的完善,在对于那些大型矩阵的计算中如果用基本方法显得过于繁重,于是发展出了矩阵的分解,随着对矩阵分解的不断研究完善,矩阵分解方法和理论也日趋成熟矩阵经常被当做是数学工具,因为在数学问题中要经常用上矩阵的知识。

矩阵是一个表格,要掌握其运算法则,作为表格的运算与数的运算既有联系又有差别,在所有矩阵的运算方法中,矩阵的分解是他们中一种最重要并且也是应用最广泛。

矩阵分解主要是对高斯消去法的延续和拓展。

在一些大型的矩阵计算中,其计算量大,化简繁杂,使得计算非常复杂。

如果运用矩阵的分解,将那些大型矩阵分解成简单的矩阵的乘积形式,则可大大降低计算的难度以及计算量。

这就是矩阵分解的主要目的。

而且对于矩阵的秩的问题,特征值的问题,行列式的问题等等,通过矩阵的分解后都可以清楚明晰的反应出来。

矩阵分解的方法

矩阵分解的方法我折腾了好久矩阵分解的方法,总算找到点门道。

说实话,矩阵分解这事儿,我一开始也是瞎摸索。

我最早知道的一种矩阵分解方法叫做LU分解。

当时就觉得好难啊。

我光是看那些数学定义就头大,什么下三角矩阵L,上三角矩阵U,它们乘起来等于原矩阵A。

我就自己按照书上的公式试着分解一个简单的矩阵,结果总是出错。

后来我发现啊,在做消元的过程中,顺序特别重要,就像搭积木一样,你得一块一块按顺序来,要是消元的顺序错了,得到的L和U就不对了。

然后我又试过QR分解。

这中间也出了不少岔子。

QR分解是把矩阵分解成一个正交矩阵Q和一个上三角矩阵R。

我当时搞混了正交矩阵的定义,以为只要随便几个垂直的向量组成矩阵就是正交矩阵了,结果怎么算结果都不对。

其实啊,正交矩阵是要满足Q的转置乘以Q等于单位矩阵才行呢。

再来就是奇异值分解(SVD)了。

这个可把我折磨惨了。

它要把一个矩阵A分解成三个矩阵的乘积,一个是左奇异向量组成的矩阵U,一个是包含奇异值的对角矩阵S,还有一个是右奇异向量组成的矩阵V的转置。

我在求奇异值的时候就非常迷茫,这个其实涉及到一些矩阵的特征值计算。

我本来对特征值的概念就不是特别清楚,结果计算就总是错。

后来我只能重新把特征值那部分知识拿出来复习,还找了很多具体的二维矩阵的例子去算。

比如说一个简单的2×2矩阵,我就一步一步按照求特征向量和特征值的步骤来,然后再去求奇异值分解。

这就有点像走迷宫,南墙碰多了,最后也就找到出口了。

所以我的建议就是,要是想掌握矩阵分解方法,先把那些基础的概念,像三角矩阵的性质、正交性、特征值特征向量这些搞清楚。

而且在做计算的时候,一定要沉下心仔细按照步骤来,每一步都不能马虎。

还有就是多做些简单的例子,这样就更容易理解这些复杂的方法。

我还在继续学习矩阵分解,如果以后有新的经验,再跟你分享。

注水算法

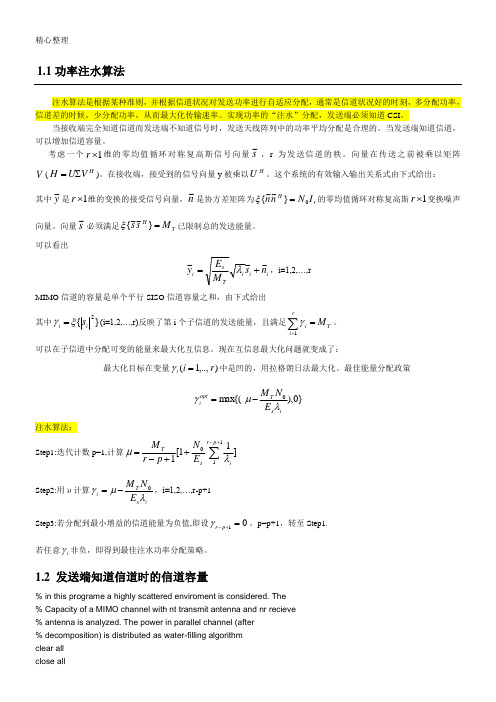

1.1功率注水算法 注水算法是根据某种准则,并根据信道状况对发送功率进行自适应分配,通常是信道状况好的时刻,多分配功率,信道差的时候,少分配功率,从而最大化传输速率。

实现功率的“注水”分配,发送端必须知道CSI 。

当接收端完全知道信道而发送端不知道信号时,发送天线阵列中的功率平均分配是合理的。

当发送端知道信道,可以增加信道容量。

考虑一个1⨯r 维的零均值循环对称复高斯信号向量s ~,r 为发送信道的秩。

向量在传送之前被乘以矩阵V (H V U H ∑=)。

在接收端,接受到的信号向量y 被乘以H U 。

这个系统的有效输入输出关系式由下式给出:其中y ~是r ~H~~1变换噪声向量。

向量可以看出MIMO 其中i ξγ=注水算法: Step1:Step2:用μis Step3:若分配到最小增益的信道能量为负值,即设01=+-p r γ,p=p+1,转至Step1.若任意i γ非负,即得到最佳注水功率分配策略。

1.2 发送端知道信道时的信道容量% in this programe a highly scattered enviroment is considered. The% Capacity of a MIMO channel with nt transmit antenna and nr recieve% antenna is analyzed. The power in parallel channel (after% decomposition) is distributed as water-filling algorithmclear allclose allclcnt_V = [1 2 3 2 4];nr_V = [1 2 2 3 4];N0 = 1e-4;B = 1;Iteration = 1e2; % must be grater than 1e2SNR_V_db = [-10:3:20];SNR_V = 10.^(SNR_V_db/10);color = ['b';'r';'g';'k';'m'];notation = ['-o';'->';'<-';'-^';'-s'];for(k = 1 : 5)nt = nt_V(k);endendendgrid onset(f1,'color',[1 1 1])xlabel('SNR in dB')ylabel('Capacity bits/s/Hz')注水算法子函数function [Capacity PowerAllo] = WaterFilling_alg(PtotA,ChA,B,N0); %% WaterFilling in Optimising the Capacity%===============% Initialization%===============ChA = ChA + eps;NA = length(ChA); % the number of subchannels allocated toH = ChA.^2/(B*N0); % the parameter relate to SNR in subchannels % assign the power to subchannelPowerAllo = (PtotA + sum(1./H))/NA - 1./H;while(length(find(PowerAllo < 0 ))>0)IndexN = find(PowerAllo <= 0 );IndexP = find(PowerAllo > 0);MP = length(IndexP);PowerAllo(IndexN) = 0;ChAT = ChA(IndexP);HT = ChAT.^2/(B*N0);PowerAlloT = (PtotA + sum(1./HT))/MP - 1./HT;PowerAllo(IndexP) = PowerAlloT;nr = nr_V(k);for(i = 1 : length(SNR_V))Pt = N0 * SNR_V(i);for(j = 1 : Iteration)H = random('rayleigh',1,nr,nt);Capacity(i,j)=log2(det(eye(nr)+Pt/(nt*B*N0)* H*H'));endendf2= figure(2);hold onplot(SNR_V_db,mean(Capacity'),notation(k,:),'color',color(k,:)) clear landasf2= figure(2)legend_str = [];for( i = 1 : length(nt_V))legend_str =[ legend_str ;...{['nt = ',num2str(nt_V(i)),' , nr = ',num2str(nr_V(i))]}];endlegend(legend_str)grid onset(f2,'color',[1 1 1])xlabel('SNR in dB')ylabel('Capacity bits/s/Hz')landas(:,j) = diag(V);Capacity_uninf(i,j)=log2(det(eye(nr)+Pt/(nt*B*N0)* H*H'));[Capacity(i,j) PowerAllo] = WaterFilling_alg(Pt,landas(:,j),B,N0);endendf1 = figure(1);hold onplot(SNR_V_db,mean(Capacity'),notation(k,:),'color',color(k,:))hold onplot(SNR_V_db,mean(Capacity_uninf'),notation_uninf (k,:),'color',color(k,:)) clear landasendset(f1,'color',[1 1 1])xlabel('SNR in dB')ylabel('Capacity bits/s/Hz')f1 = figure(1)legend_str = [];for( i = 1 : length(nt_V))legend_str =[ legend_str ;...{['nt = ',num2str(nt_V(i)),' , nr = ',num2str(nr_V(i))]}]; endlegend(legend_str)grid on1.已知2.3.。

矩阵分解_拉普拉斯正则_概述及解释说明

矩阵分解拉普拉斯正则概述及解释说明1. 引言1.1 概述矩阵分解是一种重要的数学方法,用于将一个复杂的矩阵分解为多个简化的子矩阵,以便更好地理解和处理数据。

而拉普拉斯正则作为一种常见的正则化技术,则广泛应用于机器学习、数据挖掘等领域。

该正则化方法在保持模型泛化能力的同时,能够降低模型的过拟合风险。

1.2 文章结构本文将首先介绍矩阵分解的定义和背景知识,包括常见的矩阵分解方法及其应用领域。

接着,我们将详细讲解拉普拉斯正则化技术的原理与公式推导,并探讨其在机器学习中的具体应用。

随后,我们会对拉普拉斯正则化进行优缺点及改进方法的讨论。

最后,我们将概述和解释说明矩阵分解与拉普拉斯正则之间的关系,并通过实例来说明它们在实际问题中的作用和效果。

此外,我们也会对矩阵分解和拉普拉斯正则化存在的局限性和潜在问题展开讨论。

最后,我们将总结本文的主要研究结果,并提出对未来研究的建议。

1.3 目的本文的目的是全面概述和解释矩阵分解和拉普拉斯正则化技术,分析它们在不同领域中的应用,并探讨它们之间的关系。

通过对这些方法进行详细研究和讨论,旨在为读者深入了解矩阵分解和拉普拉斯正则化提供一定的理论基础和实践指导。

同时,在总结文章主要内容和提出未来研究建议之后,我们希望能够促进相关领域工作者们对这两种方法在实际问题中更深入、更广泛的应用探索。

2. 矩阵分解2.1 定义与背景矩阵分解是一种数学运算方法,用于将一个矩阵表示为几个小规模的矩阵相乘的形式。

它在数学、计算机科学和统计学领域有广泛的应用。

通过矩阵分解,我们可以将复杂的数据结构转化为易于处理和理解的形式。

2.2 常见的矩阵分解方法常见的矩阵分解方法包括奇异值分解(Singular Value Decomposition, SVD)、QR分解(QR Decomposition)、LU分解(LU Decomposition)等。

这些方法基于不同的原理和应用场景,能够帮助我们提取出矩阵中隐藏的信息,并进行数据压缩、特征提取等操作。

注水算法

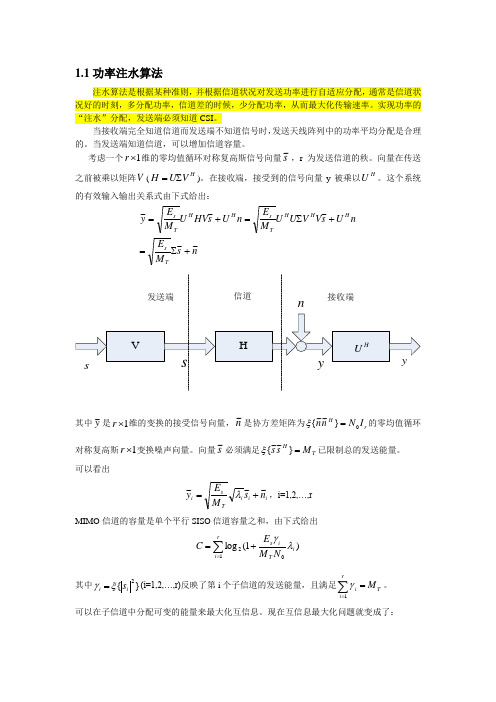

1.1功率注水算法注水算法是根据某种准则,并根据信道状况对发送功率进行自适应分配,通常是信道状况好的时刻,多分配功率,信道差的时候,少分配功率,从而最大化传输速率。

实现功率的“注水”分配,发送端必须知道CSI 。

当接收端完全知道信道而发送端不知道信号时,发送天线阵列中的功率平均分配是合理的。

当发送端知道信道,可以增加信道容量。

考虑一个1⨯r 维的零均值循环对称复高斯信号向量s ~,r 为发送信道的秩。

向量在传送之前被乘以矩阵V (H V U H ∑=)。

在接收端,接受到的信号向量y 被乘以H U 。

这个系统的有效输入输出关系式由下式给出:n s M E n U s V V U U M E n U s HV U M E y Ts H H HTs H H T s ~~~~~+∑=+∑=+=其中y ~是1⨯r 维的变换的接受信号向量,n ~是协方差矩阵为r H I N n n 0}~~{=ξ的零均值循环对称复高斯1⨯r 变换噪声向量。

向量s ~必须满足T HM s s =}~~{ξ已限制总的发送能量。

可以看出ii i Tsi n s M E y ~~~+=λ,i=1,2,…,r MIMO 信道的容量是单个平行SISO 信道容量之和,由下式给出∑=+=ri i T is N M E C 12)1(log λγ其中}{2i i s ξγ=(i=1,2,…,r)反映了第i 个子信道的发送能量,且满足T ri iM =∑=1γ。

可以在子信道中分配可变的能量来最大化互信息。

现在互信息最大化问题就变成了:∑==+∑==ri i T i s M N M E C r i T i 1)2)1(log max 1λγγ最大化目标在变量),..,1(r i i =γ中是凹的,用拉格朗日法最大化。

最佳能量分配政策}0),max{(0i s T opt i E N M λμγ-= ∑==ri T opt iM 1γ注水算法:Step1:迭代计数p=1,计算]11[1110∑+-++-=p r isTE N p r M λμStep2:用μ计算is T i E N M λμγ0-=,i=1,2,…,r -p+1 Step3:若分配到最小增益的信道能量为负值,即设01=+-p r γ,p=p+1,转至Step1. 若任意i γ非负,即得到最佳注水功率分配策略。

功率受限注水定理

功率受限“注水”定理1“注水”定理阐述“注水”定理适用于如下情形:1. 1信道条件信道输入平稳随机序列12,,N X X X X =,输出的平稳随机序列12,,N Y Y Y Y =,噪声序列为12,,N n n n n =为零均值的高斯加性噪声。

定义组合加性高斯白噪声信道(等价于多维无记忆高斯加型连续信道)为:信道中各单元时刻()1,2,i N =上的加性噪声为均值为零,方差为各不相同的()1,2,ni P i N =的高斯噪声,且各分量统计独立。

1. 2约束条件当且仅当信道输入平稳随机序列12,,N X X X X =中各分量统计独立,各加性噪声为均值为零,方差为各不相同的()1,2,ni P i N =的高斯噪声时,信道容量为:()2max ;1 log 1 (1.1)2ii ns in C I X Y P P =⎛⎫=+⎪ ⎪⎝⎭∑ 1. 3“注水”定理各个输入信号的总体平均功率21 N i i E X =⎡⎤⎢⎥⎣⎦∑受限,因此存在一个约束条件为21 (1.2) N i i P E X =⎡⎤=⎢⎥⎣⎦∑要计算()max ;C I X Y =,就是计算式(1.1)在约束条件式(1.2)下的最大值。

引用拉格朗日乘数法求解此问题,做辅助函数()1221,,log 1 (1.3)2iNi i nn s s s s s ii n P J P P P P P λ⎛⎫=++ ⎪ ⎪⎝⎭∑∑ 其中2i s i P E X ⎡⎤=⎣⎦为各个时刻的信号平均功率,λ为参数,即拉格朗日乘子,对辅助函数()12,,N s s s J P P P 逐一求i s P 的导数,使之等于零: ()()12,,0 1,2,(1.4)Nis s s s J P P P i N P ∂==∂即得到:()110 1,2,(1.5)2i in s i N P P λ+==+1(1.6)2i i i s n n P P v P λ=--=- 其中v 为常数,由于式(1.6)中的i s P 可能为负值,这表明并联信道中,某一新到的平均噪声功率i n P 大于信道分配到的信号平均功率时,信号将淹没在噪声中而无法利用。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

随机信号、非周期信号、准周期信号和周期信号,由于其时间是无限的,总为功率信号

能量信号只可能是有限时间内存在的确定性信号

1 AWGN 信道

离散事件加性高斯白噪声信道:[i][i][i]y x n =+ ,信道容量由香农公式得出:

2log (1)C B γ=+

接收信噪比定义为x [i ]的功率除以n [i ]的功率,即用公式(1)可计算N 次观测下出信号和噪声的功率,但由于白噪声单边功率谱密度为N 0/2,所以噪声功率可用N 0B 表示。

信道容量和注水定理

信道容量就是下面这个公式:

C=log(1+P/N)

其中C 是信道容量,P 是信号功率,N 是噪声功率。

这几个字母,是香农老人家最牛逼的成果,指引着通信技术的发展方向。

如果信号的功率为P=P1+P2,可以验证一个公式:

C=log(1+(P1+P2)/N)=log(1+P1/N)+log(1+P2/(P1+N))=C1+C2。

C1=log(1+P1/N)可理解为信号功率P1,噪声为N 时的容量,C2=log(1+P2/(P1+N))可理解为信号功率P2,噪声为(P1+N)时的容量。

有人把这个叫superposition coding 。

也就是说,这两份功率,第一份功率产生了一个容量,同时等效成了对第二份功率的噪声。

了解了这个结论,我们来想,如果有N 个并行的信道,这N 个信道上已经有一些噪声或者信号的功率。

如果我再有一小份功率,把它分配到哪个信道上能获得最大的信道容量呢?从上面的分析我们知道,已经存在的功率,无论是噪声还是信号,对后来的信号来说都是噪声,因此,这一小份功率分配到累计功率最小的信道上获得的容量最大。

这样分配的结果就是N 个信道上的功率是相同的,就是注水定理。

注水定理可以看作是信道容量的动态过程。

matlab 中的矩阵分解

矩阵分解是指根据一定的原理用某种算法将一个矩阵分解成若干个矩阵的乘积。

常见的矩阵分解有LU 分解(三角分解)、QR 分解(正交变换)、Cholesky 分解,以及Schur 分解、Hessenberg 分解、奇异分解等。

(1) LU 分解(三角分解)

矩阵的LU 分解就是将一个矩阵表示为一个交换下三角矩阵和一个上三角矩阵的乘积形式。

线性代数中已经证明,只要方阵A 是非奇异(即行列式不等于0)的,LU 分解总是可以进行的。

MATLAB 提供的lu 函数用于对矩阵进行LU 分解,其调用格式为:

[L,U]=lu(X):产生一个上三角阵U 和一个变换形式的下三角阵L(行交换),使之满足X=LU 。

注意,这里的矩阵X 必须是方阵。

[L,U,P]=lu(X):产生一个上三角阵U和一个下三角阵L以及一个置换矩阵P,使之满足PX=LU。

当然矩阵X同样必须是方阵。

(设P 是一个 m×n 的 (0,1) 矩阵,如 m≤n且 P*P′=E,则称 P为一个 m×n的置换矩阵。

)

实现LU分解后,线性方程组Ax=b的解x=U\(L\b)或x=U\(L\Pb),这样可以大大提高运算速度。

例7-2 用LU分解求解例7-1中的线性方程组。

命令如下:

A=[2,1,-5,1;1,-5,0,7;0,2,1,-1;1,6,-1,-4];

b=[13,-9,6,0]';

[L,U]=lu(A);

x=U\(L\b)

或采用LU分解的第2种格式,命令如下:

[L,U ,P]=lu(A);

x=U\(L\P*b)

(2) QR分解(正交变换)

对矩阵X进行QR分解,就是把X分解为一个正交矩阵Q和一个上三角矩阵R的乘积形式。

QR分解只能对方阵进行。

MATLAB的函数qr可用于对矩阵进行QR分解,其调用格式为:

[Q,R]=qr(X):产生一个一个正交矩阵Q和一个上三角矩阵R,使之满足X=QR。

[Q,R,E]=qr(X):产生一个一个正交矩阵Q、一个上三角矩阵R以及一个置换矩阵E,使之满足XE=QR。

实现QR分解后,线性方程组Ax=b的解x=R\(Q\b)或x=E(R\(Q\b))。

例7-3 用QR分解求解例7-1中的线性方程组。

命令如下:

A=[2,1,-5,1;1,-5,0,7;0,2,1,-1;1,6,-1,-4];

b=[13,-9,6,0]';

[Q,R]=qr(A);

x=R\(Q\b)

或采用QR分解的第2种格式,命令如下:

[Q,R,E]=qr(A);

x=E*(R\(Q\b))

(3) Cholesky分解

如果矩阵X是对称正定的,则Cholesky分解将矩阵X分解成一个下三角矩阵和上三角矩阵的乘积。

设上三角矩阵为R,则下三角矩阵为其转置,即X=R'R。

MATLAB函数chol(X)用于对矩阵X进行Cholesky 分解,其调用格式为:

R=chol(X):产生一个上三角阵R,使R'R=X。

若X为非对称正定,则输出一个出错信息。

[R,p]=chol(X):这个命令格式将不输出出错信息。

当X为对称正定的,则p=0,R与上述格式得到的结果相同;否则p为一个正整数。

如果X为满秩矩阵,则R为一个阶数为q=p-1的上三角阵,且满足R'R=X(1:q,1:q)。

实现Cholesky分解后,线性方程组Ax=b变成R‘Rx=b,所以x=R\(R’\b)。

例7-4 用Cholesky分解求解例7-1中的线性方程组。

命令如下:

A=[2,1,-5,1;1,-5,0,7;0,2,1,-1;1,6,-1,-4];

b=[13,-9,6,0]';

R=chol(A)

??? Error using ==> chol

Matrix must be positive definite

命令执行时,出现错误信息,说明A为非正定矩阵。

(4) 任意方阵的Schur分解

任意一个n阶方阵X可以分解为X=URU',其中U为酉矩阵,R为上三角schur矩阵且其主对角线上的元素为X的特征值。

酉矩阵的相关性质:

设有A,B矩阵

(1)若A是酉矩阵,则A的逆矩阵也是酉矩阵

(2)若A,B是酉矩阵,则AB也是酉矩阵

(3)若A是酉矩阵,则|detA|=1

(4)A是酉矩阵的充分必要条件是,它的n个列向量是两两正交的单位向量

[U,R]=schur(X)

(5) 任意方阵的Hessenberg分解

任意一个n阶方阵X可以分解为X=PHP', 其中P为酉矩阵, H的第一子对角线下的元素均为0,即H 为Hessenberg矩阵。

[P,H]=hess(X)

(6) 任意方阵的特征值分解EVD

任意一个n阶方阵X可以分解为XV=VD,其中D为X的特征值对角阵,V为X的特征向量矩阵。

[V,D]=eig(X)

[V,D]=eig(X,Y)计算广义特征值矩阵D和广义特征值向量矩阵V,使得XV=YVD。

(7)任意矩阵的奇异值分解SVD

任意一个m*n维的矩阵X可以分解为X=USV',U,V均为酉矩阵,S为m*n维的对角矩阵,其对角线元素为X的从大到小排序的非负奇异值。

U,V为正交阵,S为对角阵,svd(A)恰好返回S的对角元素,而且就是A的奇异值(定义为:矩阵A’*A的特征值的算数平方根)

[U,S,V]=svd(X)

(8) 任意矩阵的几何均值分解GMD

任意矩阵m*n维的矩阵X可以分解为X=QRP', Q,P均为酉矩阵,R为k*k维的实正线上三角矩阵,其主对角线元素均等于X的所有K个正奇异值的几何均值,k=rank(X)。

(PS: 一个n × n的实对称矩阵 M 是正定的当且仅当对于所有的非零实系数向量z,都有 zTMz > 0。

其中zT 表示z的转置。

对于复数的情况,定义则为:一个n × n的埃尔米特矩阵 M 是正定的当且仅当对于每个非零的复向量z,都有z*Mz > 0。

其中z* 表示z的共轭转置。

由于 M是埃尔米特矩阵,经计算可知,对于任意的复向量z,z*Mz必然是实数,从而可以与0比较大小。

因此这个定义是自洽的。

正定方阵M的所有的特征值λi都是正的。

)。