MPI笔记

MPI培训教材课程

a.out

p1 p2 p3 SPMD

p1 p2 p3 MPMD: Mster/slave

p1 p2 p3 MPMD: Couple Analysis

a.out

A process • Read array a() from

the input file • Set is=1 and ie=6 • Process from

Distributed memory

NUMA(Non-Uniform MPP(Massively Parallel

Memory Access)

Processors)

Coherent Shared Memory CPU 1 CPU 2

Memory

Easy to Program Hard to Scale Hardware

the input file

the input file

the input file

• Get my rank

• Get my rank

• Get my rank

• If(rank.eq.0)is=1,ie= • If(rank.eq.0)is=1,ie= • If(rank.eq.0)is=1,ie=

the input file

the input file

• Get my rank

• Get my rank

• Get my rank

• is=2*rank+1,ie=2*ra • is=2*rank+1,ie=2*ra • is=2*rank+1,ie=2*ra

nk+2

nk+2

nk+2

• Process from a(is)to • Process from a(is)to • Process from a(is)to

助理收益管理师学习笔记

助理收益管理师学习笔记第一节课:收益管理的起源与行业管理应用一、收益管理的起源:起源于美国的航空业。

二、收益管理的适用性1、需求变化2、市场可以细分3、生产规模固定4、产品不可储存5、产品可以细分6、高固定成本低变动成本7、产品可以预售8、市场可以规划管理三、收益管理概念与关键指标1、团体标准对酒店收益管理概念的定义:通过对产品(服务)价格的优化和资源有效的分配,平衡市场对该产品(服务)的供给和需求,使酒店收益最大化的管理方法。

2、收益管理的5个合适(1)合适的时间(2)合适的产品(3)合适的价格(4)合适的渠道/方式(5)合适的客户3、收益管理指标的应用场景(1)客房环节(2)餐饮环节(3)康体娱乐及场馆环节4、酒店收益关键指标——单房收益(RevPAR)指平均每间可售房产生的收入贡献。

同等出租率情况下,平均房价越高,单房收益率越高,酒店利润越高。

同等平均房价情况下,出租率越高,单房收益越高,酒店利润越高(应扣减部分变动成本)。

5、酒店收益关键指标——酒店内部数据指标(1)出租率出租率=已售房间数/可供出租房间数*100%例如:酒店有100间房,昨天销售了85间房。

昨天有值班房1间,维修房1间,免费房1间,老板预留房1间,昨天的可售房间数为97间,求昨天的出租率。

85/97*100%=87.63%(2)平均房价平均房价=客房净收入/已售房间数例如:昨天客房实际收入19000元,实际销售85间房;求平均房价。

19000/82=223.53(3)单房收益(RevPAR)①单房收益=平均房价*出租率=223.53*87.63%=195.87②单房收益=客房净收入/可供出租房间数=19000/97=195.87单房收益反映酒店平均房价与出租率最佳匹配关系。

也是酒店客房库存与价格策略应用是否有效的综合表现。

5、酒店收益关键指标——酒店收益率(1)酒店收益率:指规定时间内的实际收入与潜在客房收入的百分比。

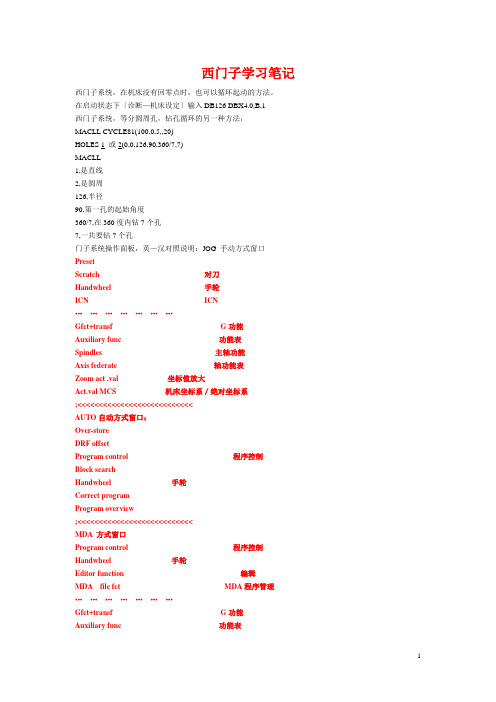

西门子系统数控机床学习笔记

西门子学习笔记西门子系统,在机床没有回零点时,也可以循环起动的方法。

在启动状态下〔诊断—机床设定〕输入DB126 DBX4.0,B,1西门子系统,等分圆周孔,钻孔循环的另一种方法,MACLL CYCLE81(100,0,5,,20)HOLES 1 或2(0,0,126,90,360/7,7)MACLL1,是直线2,是圆周126,半径90,第一孔的起始角度360/7,在360度内钻7个孔7,一共要钻7个孔门子系统操作面板,英—汉对照说明:JOG 手动方式窗口PresetScratch 对刀Handwheel 手轮ICN ICN…………………Gfct+transf G功能Auxiliary func 功能表Spindles 主轴功能Axis federate 轴功能表Zoom act .val 坐标值放大Act.val MCS 机床坐标系/绝对坐标系;<<<<<<<<<<<<<<<<<<<<<<<<<<<AUTO自动方式窗口:Over-storeDRF offsetProgram control 程序控制Block searchHandwheel 手轮Correct programProgram overview;<<<<<<<<<<<<<<<<<<<<<<<<<<<MDA 方式窗口Program control 程序控制Handwheel 手轮Editor function 编辑MDA file fct MDA程序管理…………………Gfct+transf G功能Auxiliary func 功能表Spindles 主轴功能Axis federate 轴功能表Zoom act .val 坐标值放大Act.val MCS 机床坐标系/绝对坐标系Delete MDA buffer 删除MDA缓冲区;<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<按区域转换键后的窗口:Machine 机床Parameter 参数Program 程序Services 效劳Diagnosis 诊断Startup 起动…………………AUTO 自动方式MDA MDA方式JOG 手动方式REF;<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<按Parameter参数选择键后的窗口:Magazine list 刀具补偿R parameter R参数Setting data 设定数据〔维修时用〕Zero offset 零点偏置User data 用户数据Actire ZO+compens 坐标激活Tool manageme 刀具管理…………………Axes+ 轴+Axes- 轴-Rotation scale mirr Base ZOSet ZO;<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<按Program程序选择键后的窗口:Work—pieces 工件Part programs 工件程序Sub—programs 子程序User cycles 用户循环Clip—board 剪粘板Log 记录…………………Interactiv programing 对话式编程New 新的Copy 复制Inserl 粘贴Delete 删除Rename 重命名AlterenableInteractiv programing 对话式编程New 新的Load 装载Unload 卸载Smulation 模拟Manage programs 程序管理Seleet 选择Save setup data 保存数据;<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<按Services效劳选择键后的窗口:Data in 数据输入Data out 数据输出Manage data 数据管理Data selection 数据选择Interface 接口…………………V24 RS232C接口PG 编程器Disk 磁盘Archive…文档NC card NC卡;<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<按Diagnosis诊断选择键后的窗口:Alarms 报警Messages 信息Alarm log 报警记录Serrice displays 效劳显示Plc status PLC状态…………………Display newStore logSort young—old;<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<按Program control程序控制,选择键后的窗口:☐Skp:skip block 跳过语句☐Dry:dry run federate 空运行☐ROV:rap:trat o/ride 快速倍率☐M01:program stop 程序停止☐DRF:DRF offset DRF偏差☐PRT: program test 程序测试●SBL1: 每一个机床切削后停止●SBL2: 每一条语句后停止●SBL3: 循环停止Display 显示●Display all blocks 显示所有程序段●Display erav bloks anly 仅显示程序段移动;〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈西门子系统翻开两个程序窗口,可以相互复制程序段的操作步骤:新建一个文件或翻开一个文件—→按“双页面键〞—→翻开第二个文件—→按“程序段选择键〞,选中要复制的程序段—→按“复制程序段〞键—→按NEXT/Window键,也就是把光标换到另一个文件下面—→按粘贴程序段键—→按“确定软键〞。

西门子MPI通讯

❖ 通讯是PLC应用过程中非常重要的 部分,本章重点介绍了MPI通讯的基本 概念,组建MPI网络的基本方法,分别 介绍了无阻态的单边通讯和双边通讯的 方法,通过一个项目详细介绍了全局数 据通讯的实现过程。

7.1 MPI通讯简介

❖

本节首先绍MPI通讯网络的

基本概念和如何设置MPI参数,

7) 在将一个新的节点接入MPI网络之前, 必须关掉电源。

2.MPI网络参数及编址

❖ MPI网络苻合RS-485标准,具有多点通 信的性质,MPI的波特率固定地设为 187.5kbps(连接S7-200时为19.2kbps)。

❖ 每个MPI网有—个分支网络号,以区别不 同的MPI分互网;在MPI分互网或称MPI网上 的每一个节点都有一个网络地址,称为MPI 地址。MPI地址的编址规则:

❖ 4) 如果机架上安装有功能模块(FM) 和通信模板,则它们的MPI地址是由 CPU的MPI地址顺序加1构成, 如图7.3所 示。

CPU

CP

CP

MPI

MPI

MPI

地址

地址+1

地址+2

图7.3 为可编程模板自动分配MPI地址

5)表7.1 给出了出厂时一些装置 的MPI地址缺省值。

❖ 表7.1 缺省的MPI地址

S7-300

S7-300

OP

2

1

3

S7-300

11 0 PG

S7-300

OP

10

9

S7-300

OP

4

5

S7-300

6

S7-300

OP

8

7

图7.4 MPI网络连接示例

3.MPI网络连接部件

PLC之间的MPI通信详解

PLC之间的MPI通信详解1.MPI概述MPI(MultiPoint Interface)通信是当通信速率要求不高、通信数据量不大时,可以采用的一种简单经济的通信方式。

MPI通信可使用PLC S7-200/300/ 400、操作面板TP/OP及上位机MPI/PFOFIBUS通信卡,如CP5512/CP5611/CP561 3等进行数据交换。

MPI网络的通信速率为19.2kbit/s~12Mbit/s,通常默认设置为187.5kbit/s,只有能够设置为PROFIBUS接口的MPI网络才支持12Mbit/s 的通信速率。

MPI网络最多可以连接32个节点,最大通信距离为50米,但是可以通过中继器来扩展长度。

通过MPI实现PLC之间通信有三种方式:全局数据包通信方式、无组态连接通信方式和组态连接通信方式。

PLC之间的网络配置如图所示。

2.硬件和软件需求硬件:CPU412-2 DP、CPU313C-2DP、MPI电缆软件:STEP7 V5.2 SP1以上3.设置MPI参数可分为两部分:PLC侧和PC侧的参数设置。

(1)PLC侧参数设置在硬件组态时可通过点击图中“Properties”按钮来设置CPU的MPI属性,包括地址及通信速率,具体操作如图所示。

注意:整个MPI网络中通信速率必须保持一致,且MPI地址不能冲突。

(2)PC侧参数设置在PC侧痛要也要设置MPI参数,在“控制面板”→“Set PG/PC Interfac e”中选择所用的编程卡,这里为CP5611,访问点选择“S7ONLIEN”,4.全局数据包通信方式对于PLC 之间的数据交换,我们只关心数据的发送区和接收区,全局数据包的通讯方式是在配置PLC 硬件的过程中,组态所要通讯的PLC 站之间的发送区和接收区,不需要任何程序处理,这种通讯方式只适合S7-300/400 PLC之间相互通讯。

实验步骤如下:①建立MPI网络首先打开编程软件STEP7,建立一个新项,在此项目下插入两个PLC 站分别为SIMATIC 400/CPU412-2DP 和 SIMATIC 300/CPU313C-2D P,并分别插入CPU 完成硬件组态,配置MPI 的站号和通讯速率,在本例中MPI 的站号分别设置为5号站和4 号站,通讯速率为187.5Kbit/S 。

MPI使用操作流程

《mpi使用操作流程》xx年xx月xx日contents •MPI介绍•MPI安装与配置•MPI基本使用方法•MPI并行文件IO操作•MPI并行计算实例•MPI错误处理与调试目录01 MPI介绍Multiple Processor Interface:一种并行计算编程模型,用于多处理器或多线程并行计算。

Message Passing Interface:一种消息传递编程模型,用于分布式或并行计算系统中的进程间通信。

MPI含义MPI标准由美国Argonne国家实验室开发,成为并行计算领域的重要工具。

1993年MPI-2标准发布,增加了对异步通信和动态进程管理的支持。

1997年MPI-3标准发布,优化了并行计算性能和可扩展性。

2008年MPI发展历程MPI应用场景并行数据库MPI可以用于并行数据库系统中的数据分发和通信,提高数据处理速度和效率。

并行图处理MPI可以用于大规模图处理中的并行计算,提高图算法的效率和速度。

高性能计算MPI是高性能计算中常用的并行计算编程模型,被广泛应用于天气预报、物理模拟、数据分析等领域。

02MPI安装与配置确认操作系统版本和支持的MPI版本准备MPI安装所需组件和工具确认网络连接和远程访问能力下载对应版本的MPI安装包解压缩MPI安装包执行安装脚本,如`.bin/install.sh`等待安装过程完成,不要手动中断按照提示进行下一步操作,如选择安装路径、配置环境变量等MPI配置步骤进入MPI安装目录下的`etc`子目录编辑`mpd.conf`文件,配置MPI守护进程的参数配置MPI启动脚本,如`mpd.sh`、`mpdstart.sh`等设置启动脚本属性为可执行,如`chmod +x mpd.sh`使用启动脚本启动MPI守护进程,如`./mpd.sh &`确认MPI守护进程是否成功启动,可以使用`ps -ef |grep mpd`命令查看进程状态03MPI基本使用方法MPI运行环境设置安装MPI选择适合的MPI版本并按照说明进行安装。

MPI使用操作流程

MPI的编程语言与环境

总结词

MPI的编程语言与环境包括使用C/C、Fortran等编程语言编写MPI程序,以及使用MPI开发环境进行 调试和优化等操作。

详细描述

MPI是一种并行计算编程接口,支持多种编程语言,如C、C和Fortran等。在使用MPI进行并行程序设 计时,需要了解MPI提供的各种函数和库,以及相应的使用方法。同时,还需要掌握如何使用MPI开 发环境进行程序的调试和优化,以确保程序的正确性和性能。

数据分析

MPI还可以用于大规模数据 分析,如处上述领域,MPI还在金 融、医疗、图像处理等领域 得到了应用。

02

MPI的基本原理

MPI的通信方式

点对点通信

MPI允许两个进程之间直接发送和接收消息,实现同步通信。

广播和汇聚通信

MPI也支持广播和汇聚操作,让一个进程发送消息给所有其他进程或让所有进 程聚集到一个进程。

MPI将进一步推动标准化和开放性发展,促进不同厂商 和平台的互操作性和兼容性,以降低使用门槛和成本。

可扩展性和灵活性

MPI将进一步增强可扩展性和灵活性,支持更大规模和 不同类型的并行计算任务,以满足不断增长的计算需求 。

安全性与可靠性

MPI将进一步关注安全性与可靠性,确保并行计算过程 中的数据安全和系统稳定性,以满足重要应用的需求。

3

处理单元与通信单元分离

MPI将处理单元和通信单元分离,让程序员更 加专注于算法实现,而不需要过多考虑通信细 节。

03

MPI的使用方法

MPI的安装与配置

总结词

MPI的安装与配置是使用MPI进行并行计算的第一步 ,包括安装MPI运行时环境、设置环境变量和配置网 络等步骤。

详细描述

mpi规约

MPI规约1. 什么是MPIMPI(Message Passing Interface)是一种用于并行计算的通信协议和编程模型。

它定义了一组函数、常量和数据类型,用于在并行计算中进行进程间的通信和同步操作。

MPI的目标是提供一个标准化的并行编程接口,使得开发者可以方便地编写并行程序,并在不同的计算平台上进行移植。

MPI最初由一些高性能计算领域的研究人员发起,目前已成为广泛使用的并行编程框架之一。

MPI的设计理念是基于消息传递的分布式内存模型,它允许开发者在多个进程之间进行通信,通过发送和接收消息来共享数据和进行协作计算。

2. MPI的特点MPI具有以下几个特点:2.1 并行性MPI是一种并行编程模型,它允许开发者将计算任务划分为多个子任务,并在多个进程之间进行并行计算。

每个进程都可以独立地执行指定的计算任务,通过消息传递来交换数据和协调计算。

2.2 分布式内存模型MPI采用分布式内存模型,每个进程都拥有独立的内存空间。

进程之间通过消息传递来进行通信,而不需要共享内存。

这种模型使得MPI程序可以在分布式计算环境中运行,充分利用多台计算机的计算资源。

2.3 灵活性MPI提供了丰富的通信和同步操作函数,开发者可以根据具体需求选择合适的函数来实现进程间的通信和同步。

MPI支持点对点通信、广播、规约、散射、聚集等常见的通信模式,同时也支持自定义通信操作。

2.4 可移植性MPI的标准化设计使得开发者可以方便地编写可移植的并行程序。

只要目标计算平台支持MPI标准,就可以在该平台上运行MPI程序,而不需要对程序进行修改。

这种可移植性使得MPI成为并行计算领域的重要工具。

3. MPI的规约操作MPI规约操作(MPI Reduction)是一种在并行计算中常用的操作,用于将多个进程的数据合并为一个结果。

MPI规约操作可以用于求和、求积、求最大值、求最小值等各种聚合计算。

MPI规约操作的基本思想是将多个进程的数据按照指定的操作进行合并,然后将合并结果发送给指定的进程。

mptsas驱动阅读笔记

1. MPTSAS概述本文主要对1000系列软RAID产品中所涉及的LSISAS1068E SAS控制器驱动部分作了分析。

限于项目需求与时间,本文重点分析了MPTSAS驱动的结构、SAS 控制器初始化过程、以及磁盘热插拔事件的响应过程。

LSISAS1068E是一个基于Fusion-MPT架构的SAS控制器。

Fusion-MPT技术由LSI Logic开发,旨在为客户提供更为容易的实现SCSI和Fibre Channel的解决方案。

这种开放式的Fusion-MPT架构具有高I/O性能,同时还能降低产品验证的时间和推向市场的时间。

LSI Fusion-MPT基于行业标准的ARM处理器技术,支持Ultra320 SCSI,Fibre Channel,SAS接口,并可以对将来出现的其他接口扩展。

Fusion-MPT技术主要包括Fusion-MPT固件,SAS、U320 SCSI、Fibre Channel 硬核,和操作系统级的驱动程序等部分。

如图1.1所示,Fusion-MPT架构中使用统一的固件及驱动来支持所有基于Fusion-MPT技术的I/O控制器。

图1.1 Fusion-MPT 架构如图1.2所示,Fusion-MPT架构可分为操作系统层和硬件层两部分,而从驱动程序设计的角度,又可进一步将其分为驱动、固件和硬件三个功能层次。

图1.2 Fusion-MPT架构框图Fusion-MPT在硬件层之上构建独有的固件层,不同的固件为上层驱动程序提供对SCSI或FC的支持,以及高级的集成RAID等功能。

固件层有效地将驱动程序同硬件隔离,对上层驱动程序提供统一的MPI ( Message Passing Interface )接口,使同一驱动程序可以应用于不同的底层硬件系统,有助于加速应用开发。

驱动层对上层操作系统提供功能函数接口,通过MPI访问固件层,实现操作系统对硬件的访问,并且按照通信协议实现相关的帧封装和拆解。

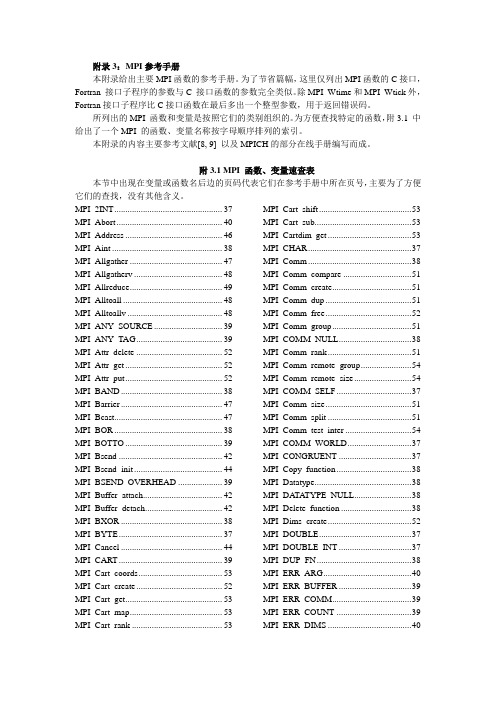

MPI参考手册

附录3:MPI参考手册本附录给出主要MPI函数的参考手册。

为了节省篇幅,这里仅列出MPI函数的C接口,Fortran 接口子程序的参数与C 接口函数的参数完全类似。

除MPI_Wtime和MPI_Wtick外,Fortran接口子程序比C接口函数在最后多出一个整型参数,用于返回错误码。

所列出的MPI 函数和变量是按照它们的类别组织的。

为方便查找特定的函数,附3.1 中给出了一个MPI 的函数、变量名称按字母顺序排列的索引。

本附录的内容主要参考文献[8, 9] 以及MPICH的部分在线手册编写而成。

附3.1 MPI 函数、变量速查表本节中出现在变量或函数名后边的页码代表它们在参考手册中所在页号,主要为了方便它们的查找,没有其他含义。

MPI_2INT (37)MPI_Abort (40)MPI_Address (46)MPI_Aint (38)MPI_Allgather (47)MPI_Allgatherv (48)MPI_Allreduce (49)MPI_Alltoall (48)MPI_Alltoallv (48)MPI_ANY_SOURCE (39)MPI_ANY_TAG (39)MPI_Attr_delete (52)MPI_Attr_get (52)MPI_Attr_put (52)MPI_BAND (38)MPI_Barrier (47)MPI_Bcast (47)MPI_BOR (38)MPI_BOTTO (39)MPI_Bsend (42)MPI_Bsend_init (44)MPI_BSEND_OVERHEAD (39)MPI_Buffer_attach (42)MPI_Buffer_detach (42)MPI_BXOR (38)MPI_BYTE (37)MPI_Cancel (44)MPI_CART (39)MPI_Cart_coords (53)MPI_Cart_create (52)MPI_Cart_get (53)MPI_Cart_map (53)MPI_Cart_rank ......................................... 53 MPI_Cart_shift (53)MPI_Cart_sub (53)MPI_Cartdim_get (53)MPI_CHAR (37)MPI_Comm (38)MPI_Comm_compare (51)MPI_Comm_create (51)MPI_Comm_dup (51)MPI_Comm_free (52)MPI_Comm_group (51)MPI_COMM_NULL (38)MPI_Comm_rank (51)MPI_Comm_remote_group (54)MPI_Comm_remote_size (54)MPI_COMM_SELF (37)MPI_Comm_size (51)MPI_Comm_split (51)MPI_Comm_test_inter (54)MPI_COMM_WORLD (37)MPI_CONGRUENT (37)MPI_Copy_function (38)MPI_Datatype (38)MPI_DATA TYPE_NULL (38)MPI_Delete_function (38)MPI_Dims_create (52)MPI_DOUBLE (37)MPI_DOUBLE_INT (37)MPI_DUP_FN (38)MPI_ERR_ARG (40)MPI_ERR_BUFFER (39)MPI_ERR_COMM (39)MPI_ERR_COUNT (39)MPI_ERR_DIMS (40)MPI_ERR_IN_STA TUS (40)MPI_ERR_INTERN (40)MPI_ERR_LASTCODE (40)MPI_ERR_OP (40)MPI_ERR_OTHER (40)MPI_ERR_PENDING (40)MPI_ERR_RANK (39)MPI_ERR_REQUEST (40)MPI_ERR_ROOT (39)MPI_ERR_TAG (39)MPI_ERR_TOPOLOGY (40)MPI_ERR_TRUNCATE (40)MPI_ERR_TYPE (39)MPI_ERR_UNKNOWN (40)MPI_Errhandler (38)MPI_Errhandler_create (40)MPI_Errhandler_free (41)MPI_Errhandler_get (41)MPI_ERRHANDLER_NULL (38)MPI_Errhandler_set (41)MPI_Error_class (41)MPI_Error_string (41)MPI_ERRORS_ARE_FATAL (38)MPI_ERRORS_RETURN (38)MPI_Finalize (40)MPI_FLOAT (37)MPI_FLOAT_INT (37)MPI_Gather (47)MPI_Gatherv (48)MPI_Get_count (47)MPI_Get_elements (47)MPI_Get_processor_name (40)MPI_GRAPH (39)MPI_Graph_create (54)MPI_Graph_get (54)MPI_Graph_map (54)MPI_Graph_neighbors (54)MPI_Graph_neighbors_count (54)MPI_Graphdims_get (54)MPI_Group (38)MPI_Group_compare (50)MPI_Group_difference (50)MPI_GROUP_EMPTY ............................ 37 MPI_Group_free . (51)MPI_Group_incl (50)MPI_Group_intersection (50)MPI_GROUP_NULL (38)MPI_Group_range_excl (50)MPI_Group_range_incl (50)MPI_Group_rank (50)MPI_Group_size (50)MPI_Group_translate_ranks (51)MPI_Group_union (51)MPI_Handler_function (38)MPI_HOST (39)MPI_Ibsend (42)MPI_IDENT (37)MPI_Init (40)MPI_Initialized (40)MPI_INT (37)MPI_Intercomm_create (54)MPI_Intercomm_merge (54)MPI_IO (39)MPI_Iprobe (44)MPI_Irecv (42)MPI_Irsend (42)MPI_Isend (42)MPI_Issend (43)MPI_Keyval_create (52)MPI_Keyval_free (52)MPI_KEYV AL_INV ALID (39)MPI_LAND (38)MPI_LB (37)MPI_LONG (37)MPI_LONG_DOUBLE (37)MPI_LONG_DOUBLE_INT (37)MPI_LONG_INT (37)MPI_LONG_LONG_INT (37)MPI_LOR (38)MPI_LXOR (38)MPI_MAX (38)MPI_MAX_ERROR_STRING (39)MPI_MAX_PROCESSOR_NAME (39)MPI_MAXLOC (38)MPI_MIN (38)MPI_MINLOC (38)MPI_NULL_DELETE_FN (38)MPI_Op (38)MPI_Op_create (49)MPI_Op_free (50)MPI_OP_NULL (38)MPI_Pack (46)MPI_Pack_size (46)MPI_PACKED (37)MPI_Probe (42)MPI_PROC_NULL (39)MPI_PROD (38)MPI_Recv (41)MPI_Recv_init (44)MPI_Reduce (48)MPI_Reduce_scatter (49)MPI_Request (38)MPI_Request_free (44)MPI_REQUEST_NULL (38)MPI_Rsend (42)MPI_Rsend_init (45)MPI_Scan (49)MPI_Scatter (48)MPI_Scatterv (48)MPI_Send (41)MPI_Send_init (44)MPI_Sendrecv (41)MPI_Sendrecv_replace (42)MPI_SHORT (37)MPI_SHORT_INT (37)MPI_SIMILAR (37)MPI_Ssend (42)MPI_Ssend_init (45)MPI_Start (44)MPI_Startall (44)MPI_Status (38)MPI_SUCCESS (39)MPI_SUM (38)MPI_TAG_UB (39)MPI_Test (43)MPI_Test_cancelled (43)MPI_Testall (43)MPI_Testany (43)MPI_Testsome .......................................... 43 MPI_Type_commit (46)MPI_Type_contiguous (45)MPI_Type_dup (47)MPI_Type_extent (47)MPI_Type_free (46)MPI_Type_hindexed (45)MPI_Type_hvector (45)MPI_Type_indexed (45)MPI_Type_lb (47)MPI_Type_size (47)MPI_Type_struct (46)MPI_Type_ub (47)MPI_Type_vector (45)MPI_UB (37)MPI_UNDEFINED (39)MPI_UNDEFINED_RANK (39)MPI_UNEQUAL (37)MPI_Unpack (46)MPI_UNSIGNED (37)MPI_UNSIGNED_CHAR (37)MPI_UNSIGNED_LONG (37)MPI_UNSIGNED_SHORT (37)MPI_User_function (38)MPI_Wait (43)MPI_Waitall (43)MPI_Waitany (43)MPI_Waitsome (44)MPI_Wtick (55)MPI_Wtime (55)MPI_WTIME_IS_GLOBAL (39)附3.2 MPI 预定义的变量及类型附3.2.1 C语言MPI原始数据类型C语言中表示MPI数据类型的变量类型是MPI_Datatype。

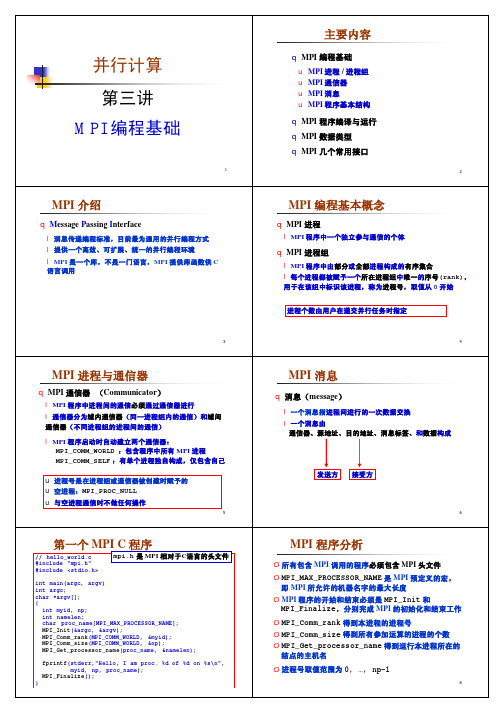

MPI教程

1

并行计算第三讲MPI 编程基础

3

MPI 介绍

q M essage P assing I nterface

l 消息传递编程标准,目前最为通用的并行编程方式l 提供一个高效、可扩展、统一的并行编程环境l MPI 是一个库,不是一门语言,MPI 提供库函数供C 语言调用

5

MPI 进程与通信器

q MPI 通信器(Communicator )

l MPI 程序中进程间的通信必须通过通信器进行l 通信器分为域内通信器(同一进程组内的通信)和域间通信器(不同进程组的进程间的通信)

l MPI 程序启动时自动建立两个通信器:

MPI_COMM_WORLD :包含程序中所有MPI 进程

MPI_COMM_SELF :有单个进程独自构成,仅包含自己u 进程号是在进程组或通信器被创建时赋予的u 空进程:MPI_PROC_NULL u 与空进程通信时不做任何操作。

第五章MPI—面向计算的高性能集群技术

第五章MPI—面向计算的高性能集群技术第五章介绍了MPI(Message Passing Interface)技术,这是一种面向计算的高性能集群技术。

MPI是一种消息传递编程模型,用于并行计算领域,可以在分布式内存系统中实现进程之间的通信和同步。

MPI技术最早是由高性能计算机领域的研究者们发起的,目的是为了实现在分布式计算环境中进行并行计算。

MPI标准由MPI论坛负责制定和维护,是一个开放的并行编程接口规范。

MPI在高性能计算领域的广泛应用使得它成为了事实上的标准。

MPI的核心思想是使用消息传递来进行进程间的通信。

在MPI中,所有的通信操作必须通过显式的函数调用来实现,而不是由操作系统自动完成。

这种显式的通信模式使得MPI可以细粒度地控制通信行为,以及实现高性能的并行计算。

MPI提供了一系列的函数来进行消息传递操作,包括发送和接收消息、同步和非阻塞操作、数据类型定义和派生等。

MPI还提供了一些用于进程管理和环境查询的函数,例如进程数量的获取、进程标识的获取等。

MPI的好处在于它非常适合于分布式内存系统中的高性能计算,可以充分利用计算集群中的计算资源。

MPI具有易于使用、高性能、标准化等优点,因此在很多科学和工程领域得到了广泛的应用。

然而,MPI也存在一些挑战和局限性。

首先,MPI需要编写一些复杂的代码来处理消息传递和同步等操作,对开发人员的要求相对较高。

其次,MPI在通信效率方面不如一些共享内存模型,因为消息传递涉及到数据的拷贝和网络的传输等开销。

此外,MPI编写的程序通常不够灵活和可移植,不适合于一些非常动态的应用场景。

总之,MPI是一种面向计算的高性能集群技术,适用于分布式内存系统中的并行计算。

MPI通过消息传递和显式的通信模式实现进程间的通信和同步,具有易于使用、高性能、标准化等优点。

尽管MPI也存在一些挑战和局限性,但它在高性能计算领域得到了广泛的应用。

[MPI]群集通信

![[MPI]群集通信](https://img.taocdn.com/s3/m/d1463bfef9c75fbfc77da26925c52cc58bd6903a.png)

[MPI]群集通信

学习资料《并⾏算法实践》(陈国良等)

学习笔记

群集通信(Collective Communications)是⼀个进程组中的所有进程都参加的全局通信操作。

群集通信涉及的进程组以及通信上下⽂,都是由群集通信函数的通信域参数决定。

群集通信⼀般实现三个功能:通信、聚集和同步。

通信功能主要完成组内数据的传输;聚集功能稍微要显得负责⼀点,要在通信的基础上对给定的数据完成⼀定的操作;⽽同步功能实现组内所有进程在特定的地点在执⾏进度上取得⼀致。

MPI中的群集通信函数

1)通信

MPI_Bcast:⼀对多⼴播同样的消息

MPI_Gather:多对⼀收集各个进程的消息

MPI_Gatherv:MPI_Gather的⼀般化

MPI_Allgather:全局收集

MPI_Allgatherv:MPI_Allgather 的⼀般化

MPI_Scatter:⼀对多散播不同的消息

MPI_Scatterv:MPI_Scatter的⼀般化

MPI_Alltoall:多对多全局交换消息

MPI_Alltoallv:MPI_Alltoall的⼀般化

2)聚集

MPI_Reduce:多对⼀归约

MPI_Allreduce:MPI_Reduce的⼀般化

MPI_Reduce_scatter: 归约并散播

MPI_Scan:扫描

3)同步

MPI_Barrier:路障同步。

mpi基本用法 -回复

mpi基本用法-回复MPI基本用法MPI(Message Passing Interface)是一种常用的并行计算编程模型,它允许在分布式内存系统中进行进程间通信。

MPI被广泛应用于科学计算、高性能计算以及大规模数据处理等领域。

本文将介绍MPI的基本用法,为大家一步一步解释如何使用MPI进行并行计算。

第一步:MPI的安装和设置1.1 安装MPI库首先,要在计算机上安装MPI库。

常用的MPI库包括Open MPI、MPICH 和Intel MPI等。

根据操作系统的不同,可以选择合适的MPI库进行安装。

1.2 环境变量设置安装完成后,需要设置相应的环境变量。

将MPI的安装目录添加到系统路径(PATH)中,以便系统可以找到MPI的执行程序。

同时,还需要设置LD_LIBRARY_PATH环境变量,以指定MPI库的位置。

第二步:MPI的编程模型MPI的编程模型基于进程间的消息传递。

每个进程都有自己的地址空间,并且可以通过MPI的函数进行相互通信。

MPI定义了一系列的函数和数据类型,用于实现进程间的消息传递和同步操作。

2.1 初始化MPI环境在开始使用MPI之前,需要调用MPI的初始化函数来建立MPI的运行环境。

可以通过以下代码来完成初始化操作:c#include <mpi.h>int main(int argc, char argv) {MPI_Init(&argc, &argv);TODO: MPI代码MPI_Finalize();return 0;}在这段代码中,`MPI_Init()`函数用于初始化MPI环境,`MPI_Finalize()`函数用于关闭MPI环境。

`argc`和`argv`是命令行参数,通过它们可以传递程序运行所需的参数。

2.2 进程间通信MPI提供了一系列的通信函数,用于实现进程间的消息传递。

常用的通信函数包括`MPI_Send()`、`MPI_Recv()`、`MPI_Bcast()`和`MPI_Reduce()`等。

MPI并行编程入门

S SISD

S I

MISD

M 指令个数

SMP- Symmetric MultiProcessing

多个CPU连接于统一的内存总线 内存地址统一编址,单一操作系统映像 可扩展性较差,一般CPU个数少于32个 目前商用服务器多采用这种架构

聚集方式:

归约

扫描

通信模式

一对一:点到点(point to point) 一对多:广播(broadcast),播撒(scatter) 多对一:收集(gather), 归约(reduce) 多对多:全交换(Tatal Exchange), 扫描(scan) , 置

换/移位(permutation/shift)

Work Pool

P1

P2

并行算法

• 并行算法设计基本原则

– 与体系结构相结合——线性结构,二维网络结 构……

– 具有可扩展性——并行算法是否随处理机个数 增加而能够线性或近似线性的加速

– 粗粒度——通常情况,粒度越大越好 – 减少通信——减少通信量和通信次数 – 优化性能——单机计算效率和并行效率

流水线计算示意图

并行化分解方法

– 分而治之方法:

• 以一个简单的求和问题为例,说明什么是分而治之方法。假设在q = 2*2*2个处理机上计算:

可以将计算依次分解为两个小的求和问题,用下图简单的描述(图中给出 的是处理机号)。在图中,从上至下是分解的过程,从下至上是求部分 和的过程。这就是有分有治的一个简单过程,也既是一种分而治之方法。

sp (q) q

–

MPI编程入门&MPI编程进阶

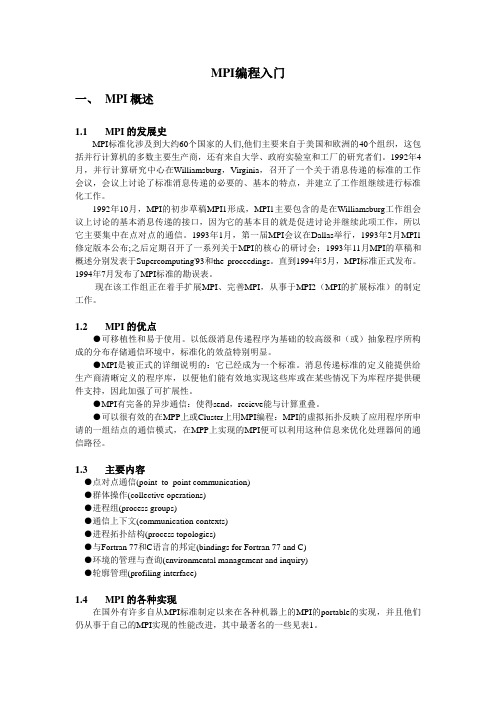

MPI编程入门一、MPI概述1.1 MPI的发展史MPI标准化涉及到大约60个国家的人们,他们主要来自于美国和欧洲的40个组织,这包括并行计算机的多数主要生产商,还有来自大学、政府实验室和工厂的研究者们。

1992年4月,并行计算研究中心在Williamsburg,Virginia,召开了一个关于消息传递的标准的工作会议,会议上讨论了标准消息传递的必要的、基本的特点,并建立了工作组继续进行标准化工作。

1992年10月,MPI的初步草稿MPI1形成,MPI1主要包含的是在Williamsburg工作组会议上讨论的基本消息传递的接口,因为它的基本目的就是促进讨论并继续此项工作,所以它主要集中在点对点的通信。

1993年1月,第一届MPI会议在Dallas举行,1993年2月MPI1修定版本公布;之后定期召开了一系列关于MPI的核心的研讨会;1993年11月MPI的草稿和概述分别发表于Supercomputing'93和the proceedings。

直到1994年5月,MPI标准正式发布。

1994年7月发布了MPI标准的勘误表。

现在该工作组正在着手扩展MPI、完善MPI,从事于MPI2(MPI的扩展标准)的制定工作。

1.2 MPI的优点●可移植性和易于使用。

以低级消息传递程序为基础的较高级和(或)抽象程序所构成的分布存储通信环境中,标准化的效益特别明显。

●MPI是被正式的详细说明的:它已经成为一个标准。

消息传递标准的定义能提供给生产商清晰定义的程序库,以便他们能有效地实现这些库或在某些情况下为库程序提供硬件支持,因此加强了可扩展性。

●MPI有完备的异步通信:使得send,recieve能与计算重叠。

●可以很有效的在MPP上或Cluster上用MPI编程:MPI的虚拟拓扑反映了应用程序所申请的一组结点的通信模式,在MPP上实现的MPI便可以利用这种信息来优化处理器间的通信路径。

1.3 主要内容●点对点通信(point_to_point communication)●群体操作(collective operations)●进程组(process groups)●通信上下文(communication contexts)●进程拓扑结构(process topologies)●与Fortran 77和C语言的邦定(bindings for Fortran 77 and C)●环境的管理与查询(environmental management and inquiry)●轮廓管理(profiling interface)1.4 MPI的各种实现在国外有许多自从MPI标准制定以来在各种机器上的MPI的portable的实现,并且他们仍从事于自己的MPI实现的性能改进,其中最著名的一些见表1。

mpi常用函数 -回复

mpi常用函数-回复MPI(Message Passing Interface)是一种用于并行计算的通信协议。

它定义了一系列常用函数,用于在并行计算中进行进程之间的通信和同步操作。

本文将围绕MPI常用函数展开,一步一步解释其主要功能和使用方法。

一、MPI_Init和MPI_Finalize函数MPI_Init和MPI_Finalize函数是MPI通信库的入口和退出函数。

在使用MPI库函数之前,首先需要调用MPI_Init函数进行初始化;而在MPI程序执行完毕后,需要通过调用MPI_Finalize函数进行清理和释放资源。

这两个函数的基本使用方法如下:int MPI_Init(int *argc, char *argv);int MPI_Finalize();其中,函数MPI_Init的参数argc和argv是命令行参数的数量和参数值,通常情况下可以将其置为NULL。

MPI_Finalize函数不接受任何参数。

二、MPI_Comm_size和MPI_Comm_rank函数MPI_Comm_size和MPI_Comm_rank函数用于获取通信域中进程的数量和进程的标识符。

通信域是一个逻辑上的进程组,用于进程之间的通信和同步操作。

使用这两个函数可以得到当前进程在通信域中的编号。

这两个函数的具体用法如下:int MPI_Comm_size(MPI_Comm comm, int *size);int MPI_Comm_rank(MPI_Comm comm, int *rank);参数comm是一个通信域的句柄,用于标识一组进程。

参数size是一个指向整型变量的指针,用于存储通信域中进程的数量。

参数rank是一个指向整型变量的指针,用于存储当前进程的标识符。

三、MPI_Send和MPI_Recv函数MPI_Send和MPI_Recv函数用于发送和接收消息。

发送方使用MPI_Send函数发送消息给接收方,接收方使用MPI_Recv函数接收消息。

西门子系统数控机床学习笔记

西门子学习笔记西门子系统,在机床没有回零点时,也可以循环起动的方法。

在启动状态下(诊断—机床设定)输入DB126 DBX4.0,B,1西门子系统,等分圆周孔,钻孔循环的另一种方法,MACLL CYCLE81(100,0,5,,20)HOLES 1 或2(0,0,126,90,360/7,7)MACLL1,是直线2,是圆周0,起始角度0,起始点Z值126,半径90,第一孔的起始角度360/7,在360度内钻7个孔7,一共要钻7个孔西门子系统按键说明:区域转换键菜单扩展键返回键加工显示键自动方式单段运行手动方式;〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈门子系统操作面板,英—汉对照说明:JOG 手动方式窗口:PresetScratch 对刀Handwheel 手轮ICN ICN…………………Gfct+transf G功能Auxiliary func 功能表Spindles 主轴功能Axis federate 轴功能表Zoom act .val 坐标值放大Act.val MCS 机床坐标系/绝对坐标系;<<<<<<<<<<<<<<<<<<<<<<<<<<<AUTO自动方式窗口:Over-storeDRF offsetProgram control 程序控制Block searchHandwheel 手轮Correct programProgram overview…………………Gfct+transf G功能Auxiliary func 功能表Spindles 主轴功能Axis federate 轴功能表Zoom act .val 坐标值放大Act.val MCS 机床坐标系/绝对坐标系;<<<<<<<<<<<<<<<<<<<<<<<<<<<MDA 方式窗口Program control 程序控制Handwheel 手轮Editor function 编辑MDA file fct MDA程序管理…………………Gfct+transf G功能Auxiliary func 功能表Spindles 主轴功能Axis federate 轴功能表Zoom act .val 坐标值放大Act.val MCS 机床坐标系/绝对坐标系Delete MDA buffer 删除MDA缓冲区;<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<< 按区域转换键后的窗口:Machine 机床Parameter 参数Program 程序Services 服务Diagnosis 诊断Startup 起动…………………AUTO 自动方式MDA MDA方式JOG 手动方式R.EPOSREF;<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<< 按Parameter参数选择键后的窗口:Magazine list 刀具补偿R parameter R参数Setting data 设定数据(维修时用)Zero offset 零点偏置User data 用户数据Actire ZO+compens 坐标激活Tool manageme 刀具管理…………………Axes+ 轴+Axes- 轴-Rotation scale mirr Base ZOSet ZO;<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<< 按Program程序选择键后的窗口:Work—pieces 工件Part programs 工件程序Sub—programs 子程序User cycles 用户循环Clip—board 剪粘板Log 记录…………………Interactiv programing 对话式编程New 新的Copy 复制Inserl 粘贴Delete 删除Rename 重命名AlterenableInteractiv programing 对话式编程New 新的Load 装载Unload 卸载Smulation 模拟Manage programs 程序管理Seleet 选择Save setup data 保存数据;<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<< 按Services服务选择键后的窗口:Data in 数据输入Data out 数据输出Manage data 数据管理Data selection 数据选择Interface 接口…………………V24 RS232C接口PG 编程器Disk 磁盘Archive…文档NC card NC卡;<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<< 按Diagnosis诊断选择键后的窗口:Alarms 报警Messages 信息Alarm log 报警记录Serrice displays 服务显示Plc status PLC状态…………………Display newStore logSort young—old;<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<<按Program control程序控制,选择键后的窗口:☐Skp:skip block 跳过语句☐Dry:dry run federate 空运行☐ROV:rap:trat o/ride 快速倍率☐M01:program stop 程序停止☐DRF:DRF offset DRF偏差☐PRT: program test 程序测试●SBL1: 每一个机床切削后停止●SBL2: 每一条语句后停止●SBL3: 循环停止Display 显示●Display all blocks 显示所有程序段●Display erav bloks anly 仅显示程序段移动;〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈〈西门子系统打开两个程序窗口,可以相互复制程序段的操作步骤:新建一个文件或打开一个文件—→按“双页面键”—→打开第二个文件—→按“程序段选择键”,选中要复制的程序段—→按“复制程序段”键—→按NEXT/Window键,也就是把光标换到另一个文件下面—→按粘贴程序段键—→按“确定软键”。

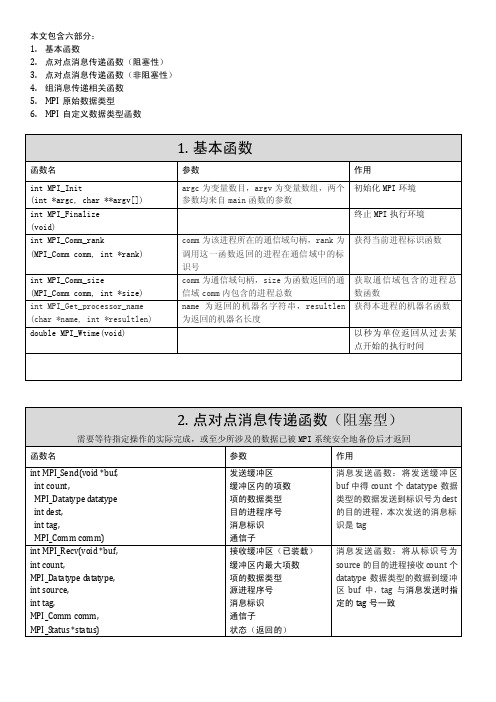

MPI函数汇总(1)

4. 组消息传递相关函数

参数 通信子

接收缓冲区(已装载) 缓冲区内最大项数 项的数据类型 根进程序号 通信子

发送缓冲区 发送缓冲区内元素数 发送元素的数据类型 接收缓冲区(已装载) 每次接收的元素数 接收元素的数据类型 通信子

发送缓冲区 发送缓冲区内元素数 发送元素的数据类型 接收缓冲区(已装载) 每次接收的元素数 接收元素的数据类型 接收进程序号 通信子

作用 障 碍 同步 ,阻 塞通 信体 中所 有 进 程 , 直到 所有 的进 程组 成员 都 调 用 了 它。 仅当 进程 组所 有的 成 员 都 进 入了 这个 调用 后, 各个 进 程 中这个调用才可以返回。 是从一个序号为 root 的进程将 一 条 消息 广播 发送 到进 程组 内 的 所有进程

从 根 进程 部分 地散 播缓 冲区 中 的 值到进程组。 相关例程: MPI _Sc at ter v( )从散 播根进程 按 特 定部 分散 播缓 冲区 中的 值 到 进程组 MPI_Reduce_scatter() 规 约 值并散播结果

将 组 内每 个进 程输 入缓 冲区 中 的 数据按 op 操作组合起来,并将 其结果返回到序号为 root 的进 程的输出缓冲区中。 相关例程: MPI_ALLreduce() 规约 成单个 值并返回给所有进程

发送缓冲区 发送缓冲区内元素数 发送元素的数据类型 接收缓冲区(已装载) 每次接收的元素数 接收元素的数据类型 接收进程序号 通信子

发送缓冲区地址 接收缓冲区地址 发送缓冲区内元素数 发送元素的数据类型 规约操作 存放结果的根进程号 通信子 Op 包括:

MPI_MAX 最大 MPI_MIN 最小 MPI_SUM 求和 MPI_PROD 求积 MPI_LAND 逻辑与 MPI_BAND 按位与 MPI_LOR 逻辑或 MPI_BOR 按位或 MPI_LXOR 逻辑异或 MPI_BXOR 按位异或

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

MPI_Wait(&request,&status);//必须调用此函数,以确保真的取消了

MPI_Test_cancelled(&status,&flag);

if (flag)

{

printf("%d\n",request);//若取消成功后,两者一样

printf("%d\n",MPI_REQUEST_NULL);//若取消成功后,两者一样

19.MPI并行程序的两种基本模式

对等模式:MPI程序的各个进程的功能、地位相同或相近,MPI程序的代码也应该是相近的,所不同的只是处理的对象和操作的数据。

主从模式:MPI程序的各个进程所起的作用和地位并不相同,一个或者一些进程完成一类任务,而另外的进程完成其它的任务,这些功能或者地位不同的进程所对应的代码也有较大的差别。

}

MPI_Buffer_attach(buffer,bsize+MPI_BSEND_OVERHEAD);

MPI_Bsend(&se,1,MPI_INT,1,99,MPI_COMM_WORLD);

MPI_Buffer_detach(&dbuffer,&dsize);

}

else

{

int re;

MPI_Recv(&re, 1, MPI_INT, 0, 99,MPI_COMM_WORLD, &status);

{

int id,size;

MPI_Status status;

MPI_Init(&argc,&argv);

MPI_Comm_rank(MPI_COMM_WORLD, &id);

if(id==0)

{

int se=100;

int *buffer,*dbuffer,bsize,dsize;

MPI_Pack_size(1,MPI_INT,MPI_COMM_WORLD,&bsize);

buffer=(int *)malloc(bsize+MPI_BSEND_OVERHEAD);

if(!buffer)

{

fprintf(stderr,"Can't allocate bsend buffer of size %d\n",bsize);

MPI_Abort(MPI_COMM_WORLD,1);

重复非阻塞通信需要如下步骤:

消息真正开始通信是由MPI_START触发的;消息的完成操作并不释放相应的非阻塞通信对象只是将其状态置为非活动状态。

初始化重复非阻塞通信

MPI_Send_init:

类型匹配规则可以概括为:

有类型数据的通信,发送方和接收方均使用相同的数据类型。

无类型数据的通信,发送方和接收方均以MPI_BYTE作为数据类型。

打包数据的通信,发送方和接收方均使用MPI_PACKED。

发送MPI_PACKED格式的数据可以用任意数据类型来接收,只要它和实际接收到的消息的数据类型相匹配;以任何类型发送的消息(包括MPI_PACKED类型)都可以用MPI_PACKED类型接收。

9.关键字值

10.无效对象

11.预定义常量

12.拓扑类型

13.MPI状态,MPI_Status数据类型的结构,它包括三个成员

14.其它类型与函数

15.MPI错误代码

16.MPI的类型匹配规则

MPI_BYTE和MPI_PACKED可以和任何以字节为单位的存储相匹配,包含这些字节的类型是任意的,MPI_TYPE用于不加修改地传送内存中的二进制值,MPI_PACK用于数据的打包和解包(MPI_UNPACK)。

MPI_WAITSOME:只要有一个或多个非阻塞通信完成,则该调用就返回。

MPI_TESTANY:测试非阻塞通信对象表中是否有任何一个对象已经完成,如真则令flag=ture,否则为false。

MPI_TESTALL:当所有的非阻塞通信对象都完成时,才使得flag=true返回,并且释放所有的查询对象;只要有任何一个没有完成,则为false返回。

阻塞检查MPI_PROBE:是一个阻塞调用,只有找到一个匹配的消息到达之后它才会返回。

非阻塞通信有序接收的语义约束:根据程序的书写顺序,先发送的消息一定被先匹配的接收调用接收。若在实际运行过程中后发送的消息先到达,它也只能等待。

26.重复非阻塞通信

如果一个通信会被重复执行如循环结构内的通信调用,MPI对这样的通信进行优化。

20.虚拟进程

虚拟进程(MPI_PROC_NULL)是不存在的假想进程,在MPI中的主要作用是充当真实进程通信的目或源。一个真实进程向虚拟进MPI_PRC_NULL发送消息时会立即成功返回,一个真实进程从虚拟进程MPI_PROC_NULL的接收消息时也会立即成功返回,并且对接收缓冲区没有任何改变。

21.MPI的四种通信模式

非阻塞缓存通信:需要程序员主动为该发送操作提供发送缓冲区。

非阻塞就绪通信:MPI_IRSEND,当调用启动之前相应的接收操作必须已经启动。

23.非阻塞通信的MPI_ WAIT与MPI_TEST

单个非阻塞通信:

MPI_ WAIT:等到非阻塞通信完成后才返回,同时释放该阻塞通信对象。

MPI_TEST:若该非阻塞通信已经结束,则它和MPI_WAIT的效果完全相同,完成标志flag=true;若非阻塞通信还没有完成,不必等待该非阻塞通信的完成而是可以直接返回,但是完成标志flag=false,同时也不释放相应的非阻塞通信对象。

2.MPI预定义的与C一致的数据类型

附加的数据类型:MPI_LONG_LONG_INT long long int

其他:复数型(MPI_COMPLEX)、逻辑型(MPI_LOGICAL)、浮点型(MPI_REAL、MPI_DOUBLE_PRECISION)

3.MPI_MAXLOC和MPI_MINLOC在C中用到的类型

1.数据类型

MPI_Status状态类型

MPI_Aint地址偏移类型

MPI_Datatype数据类型

MPI_Comm通信域类型

MPI_Group组类型

MPI_Op归约操作类型

MPI_Request

MPI_Errhandler

MPI_Copy_function

MPI_Delete_function

MPI_User_function

MPI_TESTSOME:测试有几个非阻塞通信对象已完成。

24.非阻塞通信对象MPI_Request *

非阻塞通信对象是MPI内部的对象,通过一个句柄存取,可以识别各种通信操作和判断相应的非阻塞操作是否完成。所有的非阻塞发送或接收通信都会返回一个“非阻塞通信对象“。

非阻塞通信的取消MPI_Cancel:若取消操作调用时相应的非阻塞通信已经开始,则它会正常完成,不受取消操作的影响;若取消操作调用时相应的非阻塞通信还没有开始,则可以释放通信占用的资源,取消该非阻塞通信。对于非阻塞通信,即使调用了取消操作,也必须调用非阻塞通信的完成操作或查询对象的释放操作来释放查询对象。

22.非阻塞通信

阻塞通信:

非阻塞通信:主要用于计算和通信的重叠,在该通信硬件完成该通信操作的同时,处理机可以同时进行计算操作。由于当非阻塞通信调用返回时一般该通信操作还没有完成,因此对于非阻塞的发送操作,发送缓冲区必须等到发送完成后才能释放。同理对于非阻塞的接收操作,该调用返回后并不意味着接收消息已全部到达,必须等到消息到达后才可以引用接收到的消息数据。

如果一个非阻塞通信已经被执行了取消操作,则该通信的MPI_WAIT或MPI_TEST将释放取消通信的非阻塞通信对象,并且在返回结果status中指明该通信已经被取消。

判断是否取消MPI_TEST_CANCELLED:若返回结果flag=true,则表明该通信已经被成功取消,否则说明该通信还没有被取消。

if(id==0)

{

int sbuf=100;

MPI_Send(&sbuf, 1, MPI_INT, 1, 99, MPI_COMM_WORLD );

}

else

{

int rbuf;

MPI_Irecv( &rbuf, 1, MPI_INT, 0, 99,MPI_COMM_WORLD, &request);

17.MPI通信域

MPI通信域包括两部分:进程组和通信上下文。进程组即所有参加通信的进程的集合。通信上下文提供一个相对独立的通信区域,不同的消息在不同的上下文中进行传递,不同上下文的消息互不干涉,通信上下文可以将不同的通信区别开来。

18.安全的通信调用次序

当两个进程需要相互交换数据时,一个进程的发送操作在前,接收操作在后;而另一个进程的接收操作在前,发送操作在后,前后两个发送和接收操作要相互匹配。

4.特别的数据类型

5.通信域,在C中其类型为MPI_Comm

6.进程组,进程组在C中是MPI_Group类型

7.进程组比较结果

8.组调用,一些组调用要进行运算操作(MPI_REDUCE,MPI_ALLREDUCE,MPI_REDUCE_SCAnclude "mpi.h"

#include <stdio.h>

int main (int argc, char *argv[])

{

int id,size,flag;

MPI_Request request;

MPI_Status status;

MPI_Init(&argc,&argv);

MPI_Comm_rank(MPI_COMM_WORLD, &id);

非阻塞标准通信:

MPI_ISEND:调用返回立即返回,并不意味着消息已经成功发送它只表示该消息可被发送。