统计学习方法 第8章 Adaboost提升方法

了解集成学习中的Adaboost算法

了解集成学习中的Adaboost算法集成学习是机器学习领域中的一项重要技术,它的主要目的是将多个弱学习器集成在一起,构建出一个更加准确和稳定的强学习器模型。

其中,Adaboost算法是一种经典的集成学习算法,被广泛应用于分类和回归等预测问题中。

本文将从Adaboost算法的基本原理、算法流程以及优化策略等方面介绍Adaboost在集成学习中的应用。

一、Adaboost算法基本原理Adaboost算法是一种迭代的集成学习算法,它通过按照一定的权重训练多个弱学习器,然后将其组合起来,生成一个强学习器。

Adaboost 的主要思想是:对于原始数据集中的每个样本,根据其分类错误的情况,调整下一轮迭代中样本的权重。

即分类错误的样本权重会得到加强,而分类正确的样本权重会得到削弱。

经过多轮迭代,Adaboost算法将弱学习器的预测结果进行加权求和,得到最终的集成预测结果。

二、Adaboost算法流程Adaboost算法的流程如下:(1)初始化样本权重。

对于含有N个样本的训练集,每个样本的权重初始化为1/N。

(2)对于T轮迭代,依次执行如下过程:(a)在当前数据集及其样本权重的情况下,训练出一个弱学习器。

(b)计算该弱学习器的错误率err_t,并计算其权重alpha_t,其中alpha_t = 0.5 * ln((1-err_t)/err_t)。

(c)根据该弱学习器的权重alpha_t,调整样本的权重。

对于分类错误的样本,其权重会得到加强,即w_i ← w_i * exp(alpha_t),而对于分类正确的样本,其权重会得到削弱,即w_i ← w_i * exp(-alpha_t),其中w_i表示当前第i个样本的权重。

然后,对所有样本的权重进行归一化操作,使得它们之和等于1。

(d)重复执行以上步骤,在更新完样本权重后开始下一轮迭代。

(3)将每个弱学习器的预测结果与其权重alpha_t相乘,得到最终权重和。

即对于每个样本进行预测,所有弱学习器的预测结果将分别被乘上其对应的权重alpha_t,然后将这些结果进行加权求和,得到最终的集成预测结果。

adaboost算法参数

adaboost算法参数【最新版】目录1.AdaBoost 算法简介2.AdaBoost 算法的参数3.参数的作用及对算法性能的影响4.参数调整的实践建议正文AdaBoost 算法是一种集成学习方法,其全称为 Adaptive Boosting,即自适应提升。

它通过加权训练样本和基函数的组合来提高分类器的性能。

在 AdaBoost 算法中,有几个重要的参数需要调整,这些参数对算法的性能有着重要的影响。

首先,是基函数的选择。

AdaBoost 算法支持多种基函数,如线性基函数、多项式基函数、指数基函数等。

不同的基函数对应着不同的问题类型,例如线性基函数适用于线性可分的问题,多项式基函数适用于多项式可分的问题。

因此,选择合适的基函数对于问题解决的效果至关重要。

其次,是基函数的权重。

在 AdaBoost 算法中,每个基函数都有一个对应的权重,这个权重决定了该基函数在集成学习中的重要性。

权重的设置可以根据预先设定的规则进行,也可以根据训练集的错误率进行动态调整。

再次,是迭代的次数。

AdaBoost 算法的迭代次数决定了基函数的个数,即集成学习中的弱学习器个数。

通常情况下,迭代次数越多,集成学习的效果越好,但同时也会增加计算的复杂度。

最后,是正则化参数。

正则化是用来防止过拟合的一种技术,它可以防止模型对训练集过于拟合,从而提高模型在测试集上的泛化能力。

在AdaBoost 算法中,正则化参数的设置可以采用 L1 正则化、L2 正则化等方式。

总的来说,AdaBoost 算法的参数设置是一个需要综合考虑的问题,需要根据具体问题的特性和需求来进行选择和调整。

通俗理解adaboost算法

通俗理解adaboost算法AdaBoost算法简介AdaBoost(自适应提升)是一种机器学习算法,用于提高分类器的性能。

它通过对数据中的不同实例加权,然后训练多个弱分类器来实现这一目标。

工作原理AdaBoost算法通过以下步骤工作:1. 初始化:为所有数据实例分配相同的权重。

2. 训练弱分类器:训练一个弱分类器,它可以略微优于随机猜测。

3. 更新权重:根据弱分类器的性能更新数据实例的权重。

预测错误的实例会得到更高的权重,以强制模型在 subsequent iterations中更加关注这些实例。

4. 组合分类器:将训练过的弱分类器组合成一个加权投票方案。

具有较高权重的分类器在最终预测中会有更大的影响。

5. 迭代:重复上述步骤,直到达到所需的数量的弱分类器或性能达到令人满意的水平。

优势AdaBoost算法有几个优点:提高准确性:通过结合多个弱分类器,AdaBoost可以提高整体分类器的准确性。

处理不平衡数据:AdaBoost可以通过调整实例的权重来有效处理不平衡数据集,其中一个类明显比其他类多。

无需特征选择:AdaBoost不需要显式特征选择,因为它会自动学习哪些特征对于分类任务最重要。

例子为了更好地理解AdaBoost的运作方式,考虑一个例子,其中我们试图预测电子邮件是否是垃圾邮件。

1. 初始化:给每个电子邮件分配相同的权重。

2. 训练弱分类器:训练一个弱分类器来检查发件人的电子邮件地址是否包含“.ru”后缀。

3. 更新权重:预测错误的电子邮件的权重增加,而预测正确的电子邮件的权重保持不变。

4. 组合分类器:将训练过的弱分类器组合成一个加权投票方案。

来自“.ru”后缀弱分类器的投票比其他弱分类器的投票更有影响力。

5. 迭代:重复上述步骤,训练更多的弱分类器,例如检查电子邮件中单词“免费”的出现。

通过结合这些弱分类器的加权预测,AdaBoost可以创建一个强大的分类器,比单独的弱分类器更准确地预测电子邮件是否为垃圾邮件。

利用AdaBoost提高分类性能

利用AdaBoost提高分类性能AdaBoost是一种常用的集成学习方法,通过构建多个弱分类器来提升分类性能。

本文将介绍AdaBoost的基本原理、算法流程以及应用案例,以展示AdaBoost在提高分类性能方面的优势。

1. 引言在机器学习领域,分类是一项重要的任务。

为了提高分类性能,研究者们提出了各种机器学习算法。

AdaBoost作为一种经典的集成学习方法,通过结合多个弱分类器的结果,进一步提升整体分类性能。

2. AdaBoost的原理AdaBoost的基本原理是通过迭代训练一系列弱分类器,并将它们进行组合,以获得更强的分类能力。

在每一轮迭代中,AdaBoost会根据前一轮分类结果的表现,调整样本的权重,使错误分类的样本得到更高的权重,从而使得下一轮的分类器更关注于错误分类的样本。

3. AdaBoost算法流程(1) 初始化样本权重:对于有N个样本的训练数据集,初始化每个样本的权重为1/N。

(2) 进行迭代训练:对于每一轮迭代t=1,2,...,T(a) 训练弱分类器:根据当前样本权重,训练一个弱分类器。

(b) 计算分类误差率:计算该弱分类器在训练数据集上的分类误差率。

(c) 更新样本权重:根据分类误差率,更新每个样本的权重,使错误分类的样本权重增加。

(d) 计算分类器权重:计算该弱分类器的权重,表示其分类能力。

(3) 构建最终分类器:将所有弱分类器进行加权组合,形成最终的强分类器。

4. AdaBoost的应用案例AdaBoost已经在许多实际问题中取得了良好的效果,以下是一些应用案例:(1) 人脸识别:AdaBoost可以用于训练弱分类器,将其组合成一个强分类器,实现高效准确的人脸识别。

(2) 文本分类:通过使用AdaBoost,可以将多个分类器结合起来,提高文本分类的准确性和鲁棒性。

(3) 医学诊断:AdaBoost可以用于医学图像的分类,辅助医生进行疾病诊断,提高预测准确度。

5. 总结本文介绍了AdaBoost的基本原理、算法流程和应用案例。

adaboost算法公式

adaboost算法公式Adaboost算法是一种常用的集成学习方法,它通过结合多个弱分类器来构建一个强分类器。

该算法在机器学习领域有着广泛的应用,本文将介绍Adaboost算法的原理和应用。

Adaboost算法的基本思想是通过迭代训练一系列弱分类器,并根据分类器的性能对训练样本进行加权,使得分类器对分类错误的样本有更高的关注度。

在每一轮迭代中,Adaboost算法会根据上一轮分类器的性能调整样本的权重,使得分类错误的样本在下一轮训练中更有可能被正确分类。

最终,将所有弱分类器的结果进行加权组合,得到一个强分类器。

Adaboost算法的具体步骤如下:Step1:初始化样本权重。

将每个样本的权重初始化为相等值,表示对每个样本的关注度相同。

Step2:迭代训练弱分类器。

在每一轮迭代中,Adaboost算法会根据上一轮分类器的性能调整样本的权重,并使用调整后的样本训练一个新的弱分类器。

具体来说,对于分类错误的样本,其权重会增加,而对于分类正确的样本,其权重会减小。

Step3:计算弱分类器权重。

根据每个弱分类器的分类错误率,计算其权重,错误率越低的分类器权重越高。

Step4:组合弱分类器。

将所有弱分类器的结果进行加权组合,得到一个强分类器。

加权的方式可以根据弱分类器的权重进行。

Adaboost算法的优点在于可以有效地提高分类器的性能,尤其在处理复杂的分类问题时表现出色。

其原理基于对样本的加权处理,能够更加关注分类错误的样本,从而提高分类的准确率。

此外,Adaboost算法还具有较强的泛化能力,能够很好地适应新的样本数据。

Adaboost算法的应用非常广泛,尤其在人脸识别、目标检测和文本分类等领域取得了很好的效果。

在人脸识别中,Adaboost算法可以通过训练一系列弱分类器来检测人脸的关键特征点,从而实现人脸的准确识别。

在目标检测中,Adaboost算法可以通过训练一系列弱分类器来检测目标物体的存在与否,从而实现目标的自动识别。

流量识别的AdaBoost算法参数调优

流量识别的AdaBoost算法参数调优AdaBoost算法是一种常用的流量识别算法,通过迭代训练多个弱分类器并结合它们的结果来构建一个更强大的分类器。

在使用AdaBoost算法进行参数调优时,可以考虑以下几个方面。

1. 弱分类器的选择:在AdaBoost算法中,弱分类器的选择对整个算法的性能影响较大。

可以尝试使用不同的弱分类器作为基分类器,比如决策树、支持向量机等。

不同的弱分类器适用于不同的数据集和任务,根据具体情况选择适合的分类器。

2. 学习率(Learning Rate)的设置:学习率是AdaBoost算法中用于控制弱分类器权重更新幅度的参数。

通过调整学习率的大小可以影响算法的收敛速度和稳定性。

一般来说,较小的学习率会增加算法的稳定性,但可能需要更多的迭代次数才能达到较好的性能。

可以尝试不同的学习率,观察其对算法性能的影响。

3. 样本权重的更新方式:AdaBoost算法通过更新样本权重来使得分类器对错误分类的样本有更高的关注度。

常见的样本权重更新方式有指数损失和对数损失等。

可以根据具体需求选择合适的样本权重更新方式,并观察其对算法性能的影响。

4. 弱分类器的数量:AdaBoost算法通过迭代训练多个弱分类器,并将它们组合成一个强分类器。

可以尝试不同数量的弱分类器,观察其对算法性能的影响。

需要注意的是,当弱分类器数量过多时,可能会导致过拟合的问题,需要进行适当的正则化处理。

5. 特征选择和特征提取:在流量识别的任务中,特征的选择和提取对算法性能至关重要。

可以结合领域知识和特征工程的技巧,选择适合的特征,并进行相应的预处理。

比如,可以使用降维技术来减少特征的维度,或使用特征选择方法来筛选出最具有代表性的特征。

总之,AdaBoost算法的参数调优需要结合具体的数据集和任务来进行。

在调优过程中需要反复尝试不同的参数组合,并根据实验结果进行评估和选择。

通过合理调整算法参数,可以提高流量识别算法的准确性和性能。

adaboost算法原理

聚类和分类的区别是什么?一般对已知物体类别总数的识别方式我们称之为分类,并且训练的数据是有标签的,比如已经明确指定了是人脸还是非人脸,这是一种有监督学习。

也存在可以处理类别总数不确定的方法或者训练的数据是没有标签的,这就是聚类,不需要学习阶段中关于物体类别的信息,是一种无监督学习。

Haar分类器实际上是Boosting算法的一个应用,Haar分类器用到了Boosting算法中的AdaBoost算法,只是把AdaBoost算法训练出的强分类器进行了级联,并且在底层的特征提取中采用了高效率的矩形特征和积分图方法。

在2001年,Viola和Jones两位大牛发表了经典的《Rapid Object D etection u sing a Boosted》【2】,在AdaBoost》【1】和《Robust Real-Time Face DetectionCascade of Simple Features算法的基础上,使用Haar-like小波特征和积分图方法进行人脸检测,他俩不是最早使用提出小波特征的,但是他们设计了针对人脸检测更有效的特征,并对AdaBoost训练出的强分类器进行级联。

这可以说是人脸检测史上里程碑式的一笔了,也因此当时提出的这个算法被和Jochen Maydt两位大牛将这个称为Viola-Jones检测器。

又过了一段时间,Rainer Lienhart检测器进行了扩展《An Extended Set of Haar-like Features for Rapid Object Detection》【3】,最终形成了OpenCV现在的Haar分类器。

Haar分类器 = Haar-like特征 + 积分图方法 + AdaBoost + 级联;Haar分类器算法的要点如下:①使用Haar-like特征做检测。

)对Haar-like特征求值进行加速。

②使用积分图(Integral Image③使用AdaBoost算法训练区分人脸和非人脸的强分类器。

提升方法

本周报告本周主要学习了有关提升方法的知识。

提升方法的思想是从得到的一系列基本分类器出发,组合这些分类器构成强分类器来提高分类的正确性。

AdaBoost 是一种经典的提升方法,其做法是提高那些被前一轮基本分类器错误分类的样本的权值,同时降低被正确分类样本的权值;而对于基本分类器的组合,AdaBoost 方法加大分类误差率小的弱分类器的权值,使其在表决中起较大的作用,减小分类误差率大的若分类器的权值,使其在表决中起较小的作用。

具体地,假设训练数据集()()(){}N N y x y x y x T ,,,,,,2211⋯=,每个样本点由实例和标记组成,实例χ∈i x ,标记{}1,1+-=∈Y y i ,求最终分类器()x G 。

⒈ 初始化训练的权值()N i Nw w w w D i N ⋯==⋯=,2,1,1,11,12111,。

⒉ 使用m D 学习得到基本分类器()x G m ;计算分类误差率()()()()i i m Ni mi i m m y x G I w y x G P e ≠=≠=∑=1;计算系数mmm e e -=1lg21α;更新训练数据集的权值分布()N m i m m m w w w D ,1,11,11,,++++⋯⋯=,()()N i x G y Z w w i m i m m miim ⋯=-=+,2,1,exp ,1α,其中()()i m i m Ni mi m x G y w Z α-=∑=exp 。

⒊ 构建基本分类器的线性组合()()x G x f m Mm m ∑==1α,最终分类器()()()()⎪⎭⎫⎝⎛==∑=M m mm x G s i g n x f s i g n x G 1α。

m α表示()x G m 在最终分类器中的重要性,当0≥m α时,m α随着m e 的减小而增大,所以分类误差率越小的基本分类器在最终分类器中的作用越大,特别说明的是在此所有的m α之和并不为1。

Adaboost

2 Adaboost算法2.1基本介绍Boosting是一种提高任意给定学习算法准确度的方法,其思想起源于Valiant 提出的PAC ( Probably Approxi mately Correct)学习模型。

Valiant和Kearns提出了弱学习和强学习的概念:识别错误率小于0.5也即准确率仅比随机猜测略高的学习算法称为弱学习算法,识别准确率很高并能在多项式时间内完成的学习算法称为强学习算法。

同时,Valiant和Kearns首次提出了PAC学习模型中弱学习算法和强学习算法的等价性问题,即任意给定仅比随机猜测略好的弱学习算法,是否可以将其提升为强学习算法?如果二者等价,那么只需找到一个比随机猜测略好的弱学习算法就可以将其提升为强学习算法,而不必寻找很难获得的强学习算法。

1990年, Schapire最先构造出一种多项式级算法,对该问题做了肯定的证明,这就是最初的Boosting算法。

一年后,Freund提出了一种效率更高的Boosting 算法。

但是,这两种算法存在共同的实践上的缺陷,那就是都要求事先知道弱学习算法学习正确的下限。

1995年,Freund和Schapire改进了Boosting算法,提出了AdaBoost (Adap tive Boosting)算法,该算法效率和Freund于1991年提出的Boosting算法几乎相同,但不需要任何关于弱学习器的先验知识,因而更容易应用到实际问题当中。

之后,Freund和Schapire进一步提出了改变Boosting投票权重的AdaBoost . M1、AdaBoost . M2等算法,在机器学习领域受到了极大的关注。

Adaboost是一种迭代算法,其核心思想是针对同一个训练集训练不同的弱分类器(识别率大于0.5的基分类器),然后把这些弱分类器集合起来,构成一个更强的最终分类器(强分类器)。

其算法本身是通过改变数据分布来实现的,它根据每次训练集之中每个样本的分类是否正确,以及上次的总体分类的准确率,来确定每个样本的权值。

AdaBoost算法原理及推导

AdaBoost算法原理及推导AdaBoost(Adaptive Boosting):⾃适应提升⽅法。

1、AdaBoost算法介绍AdaBoost是Boosting⽅法中最优代表性的提升算法。

该⽅法通过在每轮降低分对样例的权重,增加分错样例的权重,使得分类器在迭代过程中逐步改进,最终将所有分类器线性组合得到最终分类器,Boost算法框架如下图所⽰:图1.1 Boost分类框架(来⾃PRML)2、AdaBoost算法过程:1)初始化每个训练样例的权值,共N个训练样例。

2)共进⾏M轮学习,第m轮学习过程如下:A)使⽤权值分布为Wm的训练样例学习得到基分类器Gm。

B)计算上⼀步得到的基分类器的误差率:(此公式参考PRML,其余的来⾃统计学习⽅法)C)计算Gm前⾯的权重系数:D)更新训练样例的权重系数,E)重复A)到D)。

得到⼀系列的权重参数am和基分类器Gm4)将上⼀步得到的基分类器根据权重参数线性组合,得到最终分类器:3、算法中的两个权重分析:1)关于基分类器权重的分析上⾯计算的am表⽰基分类器在最终的分类器中所占的权重,am的计算根据em⽽得到,由于每个基分类器的分类性能要好于随机分类器,故⽽误差率em<0.5.(对⼆分类问题)当em<0.5时,am>0且am随着em的减⼩⽽增⼤,所以,分类误差率越⼩的基分类器在最终的分类器中所占的权重越⼤。

注:此处的所有am之后并不为1。

2)训练样例的权重分析根据公式可知,样例分对和分错,权重相差倍(统计学习⽅法上此公式有误)。

由于am>0,故⽽exp(-am)<1,当样例被基本分类器正确分类时,其权重在减⼩,反之权重在增⼤。

通过增⼤错分样例的权重,让此样例在下⼀轮的分类器中被重点关注,通过这种⽅式,慢慢减⼩了分错样例数⽬,使得基分类器性能逐步改善。

4、训练误差分析关于误差上界有以下不等式,此不等式说明了Adaboost的训练误差是以指数的速度下降的,推导过程⽤到的公式有:具体推导过程请看统计学习⽅法课本!5、AdaBoost算法推导过程AdaBoost算法使⽤加法模型,损失函数为指数函数,学习算法使⽤前向分步算法。

adaboost超参数优化方法

adaboost超参数优化方法AdaBoost是一种迭代的集成学习算法,通过构建多个弱分类器组合成一个强分类器。

在AdaBoost中,超参数优化主要涉及到弱学习器数量、学习率等。

以下是一些AdaBoost超参数优化的方法:1.网格搜索(Grid Search):这是一种通过穷举所有可能的参数组合来找到最优参数的方法。

你可以设定一个参数网格,例如弱学习器的数量(n_estimators)和学习率(learning_rate),然后使用交叉验证来评估每种参数组合的性能。

2.随机搜索(Random Search):与网格搜索不同,随机搜索是在参数空间中随机采样一定数量的参数组合,然后评估它们的性能。

这种方法在参数空间很大或者不是所有参数都对模型性能有显著影响时非常有用。

3.贝叶斯优化(Bayesian Optimization):这是一种基于贝叶斯定理的参数优化方法,它通过构建一个目标函数的后验分布来找到使目标函数最大化的参数。

贝叶斯优化在参数空间不是非常大的情况下非常有效。

在进行超参数优化时,你还需要考虑以下几点:•验证集(Validation Set):你需要一个验证集来评估不同参数组合的性能。

通常,你可以将数据集分为训练集、验证集和测试集。

训练集用于训练模型,验证集用于选择最优的模型(即最优的参数组合),测试集用于评估最优模型的性能。

•交叉验证(Cross-Validation):这是一种通过多次训练和验证来评估模型性能的方法。

在每次迭代中,你将训练集分为训练子集和验证子集,然后在训练子集上训练模型,在验证子集上评估模型的性能。

•早停(Early Stopping):在训练过程中,如果模型的性能在验证集上连续多个迭代都没有提高,那么你可以提前停止训练,以节省计算资源。

以上都是超参数优化的一般方法,你可以根据你的具体任务和数据集来选择合适的方法。

统计学习中的Boosting方法应用

统计学习中的Boosting方法应用在统计学习中,Boosting(提升)方法是一种常用的机器学习算法。

它通过将一组较弱的学习器(弱分类器)进行迭代组合,形成一个强分类器,从而提高整体的学习性能。

Boosting方法的核心思想是,通过调整样本权重和弱分类器的权重,逐步学习并聚焦于难以分类的样本。

一开始,所有样本被赋予相等的权重,并采用基础的弱分类器进行初始训练。

训练完成后,根据分类的准确性,调整样本的权重。

被错误分类的样本将获得更高的权重,而被正确分类的样本将获得较低的权重。

接下来,在新的权重下,再次训练一个弱分类器,重复该过程直至达到指定的学习器数量或达到预定的性能要求。

Boosting方法的一个重要算法是AdaBoost(Adaptive Boosting,自适应提升)。

AdaBoost通过调整样本权重以及基分类器的权重,实现了对弱分类器的加权组合。

在每一轮迭代中,AdaBoost根据前一轮分类结果的准确性,调整对应样本的权重,并通过最小化加权分类误差来选择最佳的基分类器。

而最终的强分类器则是基于所有基分类器的加权组合。

除了AdaBoost,还有一些其他的Boosting方法,如Gradient Boosting(梯度提升)和XGBoost等。

Gradient Boosting通过梯度下降的方式,逐步优化损失函数,从而提高整体的性能。

XGBoost则是一种可扩展的Gradient Boosting方法,通过引入正则化项、近似算法等,进一步提升了性能和效率。

Boosting方法在实际应用中具有广泛的应用场景。

例如在人脸识别中,通过结合多个弱分类器的输出来提高识别准确性;在文字识别中,通过Boosting方法可以有效地提高字符识别的准确率;在金融领域,通过Boosting方法可以用于信用评分、风险预测等。

然而,Boosting方法也存在一些挑战和限制。

由于Boosting方法的训练过程依赖于前一轮的结果,因此训练过程中的错误传递可能会导致过拟合问题。

第八章 提升方法《统计学习方法》课件

提升方法的基本思路

u怎样组合弱分类器?

u多专家组合 一种并行结构,所有的弱分类器都给出各自的预测 结果,通过“组合器”把这些预测结果转换为最终 结果。 eg.投票(voting)及其变种、混合专家模型

u多级组合 一种串行结构,其中下一个分类器只在前一个分类 器预测不够准(不够自信)的实例上进行训练或检 测。 eg. 级联算法(cascading)

AdaBoost算法

1990年,Schapire最先构造出一种多项式级的算法, 即最初的Boost算法;

1993年,Drunker和Schapire第一次将神经网络作为 弱学习器,应用Boosting算法解决OCR问题;

1995年,Freund和Schapire提出了 Adaboost(Adaptive Boosting)算法,效率和原来 Boosting算法一样,但是不需要任何关于弱学习器性 能的先验知识,可以非常容易地应用到实际问题中。

一个概念(类),如果存在一个多项式的学习算法能够学习它,学 习的正确率仅比随机猜测略好,则称这个概念是弱可学习的。

1989, Schapire,证明:

在PAC学习的框架下,一个概念是强可学习的充分必要条件是这个 概念是弱可学习。

提升方法的基本思路

问题的提出: 只要找到一个比随机猜测略好的弱学习算法就可以

Weak classifiers

HT

(x)

sign

T t 1

t

ht

(

x)

strong classifier

slightly better than random

AdaBoost算法

两个问题如何解决:

每一轮如何改变训练数据的权值或概率分布? AdaBoost:提高那些被前一轮弱分类器错误分类样本的

提升方法

可知:被基本分类器Gm(x)误分类样本的权值得以扩大,而被正确分类样本的权值却得以缩小

AdaBoost算法例子

AdaBoost算法例子

当m=1,进行第一轮迭代

AdaBoost算法例子

当m=2,进行第二轮迭代

AdaBoost算法例子

当m=3,进行第三轮迭代

AdaBoost算法例子图解

AdaBoost

AdaBoost

AdaBoost

AdaBoost

AdaBoost

AdaBoost

提升方法AdaBoost算法

提升方法AdaBoost算法

提升方法AdaBoost算法说明

算法步骤说明:步骤2 (b) 分类误差率:Gm(x)误分类样本的权值之和,表明权值分布Dm与分类误差率em的关系。 (c)可知,当em<=1/2时,am>=0,并且am随着分类误差率em的减小而增大,所以,em越小的基 本分类器在最终分类器中的作用越大。 (d) 更新训练数据的权值分布为下一轮作准备,式(8.4}可以写成

提升方法

使用场景

提升(boosting)方法: 通过改变训练样本的权重,学习多个分类器,并将这些分类器进行线性组合,提 高分类的性能。

AdaBoost方法: 一是:在每一轮改变训练数据的权值或概率分布(提高那些被前一轮弱分类器错 误分类样本的权值,而降低那些被正确分类样本的权值) 二是:将弱分类器组合成一个强分类器(采取加权例子图解

AdaBoost算法例子图解

AdaBoost的训练误差分析

AdaBoost的训练误差界定理

AdaBoost的训练误差分析

AdaBoost的训练误差界定理证明参考

AdaBoost的训练误差分析

adaboost原理

adaboost原理

Boosting是迭代学习技术中一种很重要的方法,它主要通过结合一系列弱学习

器来构建一个强化的学习器,而Adaboost(adaptive boosting)则是其中最具影响

力的算法。

Adaboost方法具有很好的鲁棒性,能够从弱分类器中提取有效的特征集,对不同数据集的学习有很好的鲁棒性能。

它的流程如下:

首先,准备一组样本数据,使用模型f1进行分类处理,计算误差率e1。

接下来,根据算法规则,对数据中出现错误的样本,进行加权处理。

在这个过程中,弱学习器f2会从f1这个分类器中学习到f1中出现的错误样本,计算出误差率e2。

然后,以f2和f1的加权结合,作为f3弱学习器,同样会对f2中出现的错误样本进行加权,当新的弱学习器f3学习之后,计算出误差率e3。

最后,Adaboost会不断地重复上述策略,即多个弱学习器的组合,通过不断地加权,最终获得一个更强大的强学习器,从而达到最优分类效果。

Adaboost以某种程度上将简单的弱学习器组合起来,以不断增强分类器强度,而非一次性训练一个强学习器,使得分类器的健壮性能更加优异。

因此,Adaboost 方法具有较高的实用性,被广泛应用于监督学习任务,包括二元分类和多类别分类。

李航-统计学习方法-笔记-8:提升方法

李航-统计学习⽅法-笔记-8:提升⽅法提升⽅法简述:提升⽅法(boosting)是⼀种常⽤的统计学习⽅法,应⽤⼴泛且有效。

在分类问题中,它通过改变训练样本的权重,学习多个分类器,并将这些分类器进⾏线性组合,提⾼分类的性能。

本章(1)介绍boosting⽅法的思路和代表性的boosting算法AdaBoost(2)通过训练误差分析探讨AdaBoost为什么能提⾼学习精度(3)从前向分布加法模型的⾓度解释AdaBoost(4)最后叙述boosting⽅法更具体的实例——boosting tree(提升树)boosting基本思路:boosting基于这样⼀种思想:对于⼀个复杂任务来说,将多个专家的判断进⾏适当的综合所得出的判断,要⽐其中任何⼀个专家单独的判断好。

实际上就是“三个臭⽪匠,顶个诸葛亮”的道理。

强可学习:在概率近似正确(probably approximately correct,PAC)学习的框架中,⼀个概念,如果存在⼀个多项式的学习算法能够学习它,并且正确率很⾼,那么称这个概念是强可学习的。

弱可学习:⼀个概念,如果存在⼀个多项式的学习算法能够学习它,学习的正确率仅⽐随机猜测略好,那么称为弱可学习的。

强可学习和弱可学习:Schapire证明了强可学习与弱可学习是等价的,也就是说,在PAC学习的框架下,⼀个概念是强可学习的充要条件是这个概念是弱可学习的。

从弱学习到强学习:可将“弱学习”提升为“强学习”,弱学习算法通常⽐强学习算法容易得多。

具体如何实施提升,便称为开发提升⽅法时要解决的问题。

有很多提升算法被提出,最具代表性的就是AdaBoost。

提升⽅法就是从弱学习算法出发,反复学习,得到⼀系列弱分类器(⼜称为基分类器),然后组合这些弱分类器,构成⼀个强分类器。

⼤多数的提升⽅法都是改变训练数据的概率分布(训练数据的权重分布),针对不同的训练数据分布,调⽤弱学习算法学习⼀系列弱分类器。

这⾥就有两个问题。

AdaBoost装袋提升算法

AdaBoost装袋提升算法参开资料:更多挖掘算法:介绍在介绍AdaBoost算法之前,需要了解⼀个类似的算法,装袋算法(bagging),bagging是⼀种提⾼分类准确率的算法,通过给定组合投票的⽅式,获得最优解。

⽐如你⽣病了,去n个医院看了n个医⽣,每个医⽣给你开了药⽅,最后的结果中,哪个药⽅的出现的次数多,那就说明这个药⽅就越有可能性是最由解,这个很好理解。

⽽bagging算法就是这个思想。

算法原理⽽AdaBoost算法的核⼼思想还是基于bagging算法,但是他⼜⼀点点的改进,上⾯的每个医⽣的投票结果都是⼀样的,说明地位平等,如果在这⾥加上⼀个权重,⼤城市的医⽣权重⾼点,⼩县城的医⽣权重低,这样通过最终计算权重和的⽅式,会更加的合理,这就是AdaBoost算法。

AdaBoost算法是⼀种迭代算法,只有最终分类误差率⼩于阈值算法才能停⽌,针对同⼀训练集数据训练不同的分类器,我们称弱分类器,最后按照权重和的形式组合起来,构成⼀个组合分类器,就是⼀个强分类器了。

算法的只要过程:1、对D训练集数据训练处⼀个分类器Ci2、通过分类器Ci对数据进⾏分类,计算此时误差率3、把上步骤中的分错的数据的权重提⾼,分对的权重降低,以此凸显了分错的数据。

为什么这么做呢,后⾯会做出解释。

完整的adaboost算法如下最后的sign函数是符号函数,如果最后的值为正,则分为+1类,否则即使-1类。

我们举个例⼦代⼊上⾯的过程,这样能够更好的理解。

adaboost的实现过程: 图中,“+”和“-”分别表⽰两种类别,在这个过程中,我们使⽤⽔平或者垂直的直线作为分类器,来进⾏分类。

第⼀步: 根据分类的正确率,得到⼀个新的样本分布D2,⼀个⼦分类器h1 其中划圈的样本表⽰被分错的。

在右边的途中,⽐较⼤的“+”表⽰对该样本做了加权。

算法最开始给了⼀个均匀分布 D 。

所以h1 ⾥的每个点的值是0.1。

ok,当划分后,有三个点划分错了,根据算法误差表达式得到误差为分错了的三个点的值之和,所以ɛ1=(0.1+0.1+0.1)=0.3,⽽ɑ1 根据表达式的可以算出来为0.42. 然后就根据算法把分错的点权值变⼤。

利用Adaboost提高分类性能

利⽤Adaboost提⾼分类性能Adaboost为⼀种集成算法,是对其他算法进⾏组合的⼀种⽅式。

本⽂将通过单层决策树分类器建⽴⼀个Adaboost优化算法,即利⽤多个弱分类器构建⼀个强分类器。

弱分类器:分类器性能⽐随机猜测要略好,但是也不会好太多。

强分类器:分类器性能⽐随机猜测好很多。

下⾯结合代码说明Adaboost算法原理和思路:单层决策树是⼀种简单的决策树,仅基于单个特征来做决策。

⾸先加载简单的训练数据。

def loadSimpleData():dataMat = np.mat([ [1.0,2.1],[2.0,1.1],[1.3,1.0],[1.0,1.0],[2.0,1.0]])classLabels = [1.0,1.0,-1.0,-1.0,1.0]return dataMat,classLabels训练数据:训练数据⼤⼩为(5, 2),即 m = 5, n = 2,同时返回的还有每个数据点对应的类别所组成的向量。

为了⽅便使⽤,我们⾸先构造单层决策树的代码:def buildStump(dataArr, classLabels, D):dataMatrix = np.mat(dataArr)labelMatrix = np.mat(classLabels).Tm,n = np.shape(dataArr)numSteps = 10.0bestStump = {}bestCalssEst = np.mat(np.zeros((m,1)))minError = math.inf # 正⽆穷⼤for i in range(n): # 遍历所有的特征rangeMin = dataArr[ : ,i].min()rangeMax = dataArr[ : ,i].max()stepSize = (rangeMax - rangeMin) / numStepsfor j in range(-1,int(numSteps) + 1): # 该维度上分隔线能取的范围内移动for inequal in ['lt','gt']: # 指定分类的⽅向threshVal = (rangeMin + float(j) * stepSize) # 计算阈值predictedVals = stumpClassify(dataMatrix,i,threshVal,inequal)errArr = np.mat(np.ones((m,1)))errArr[predictedVals == labelMatrix] = 0weightedError = D.T * errArr # 根据权重值计算误差print('split: dim %d, thresh %.2f, thresh ineqal: %s, the weighted error is %.3f'%(i,threshVal,inequal,weightedError))if weightedError < minError:minError = weightedErrorbestCalssEst = predictedVals.copy()bestStump['dim'] = ibestStump['thresh'] = threshValbestStump['ineq'] = inequalreturn bestStump,minError,bestCalssEst上⾯代码执⾏的流程:该函数传⼊三个参数:训练数据集(dataArr), 类别数据集(classLabels), 每个样本点权重组成的向量(D)。

AdaBoost算法及提升树

N

M

前向分步算法

• 但是求解这个问题非常复杂。而前向分步 算法的思想是每次只学习一组参数,保证 每一轮都最优,然后逐步逼近最优目标函 N 数,即 min L(y i , G(x ))

, G(x ) i 1

• 注意前后两个公式的差别

前向分步算法

• 定理8.3的证明中,8.21、8.22。

2 2

前向分步算法

• AdaBoost算法中的基本分类器的线性组合为

f(x ) mG m(x ) m

1 Mቤተ መጻሕፍቲ ባይዱ

这是一个加法模型。在给定训练数据及损失 函数L(y,f(x))条件下,学习加法模型f(x)成为损 失函数极小化问题

m , G m (x )

min

L(y i , mG m ) i m

AdaBoost算法

Gm ( x)系数 m 1 ln 1 em

2 em

权值更新

当正确分类时, m yiGm ( xi ) 0 ,相应的权值会降低, 相反相应的权值会增大

wm1,i

wmi exp( m yi Gm ( xi )) Zm

M

Z m wmi exp( m yiGm ( xi ))

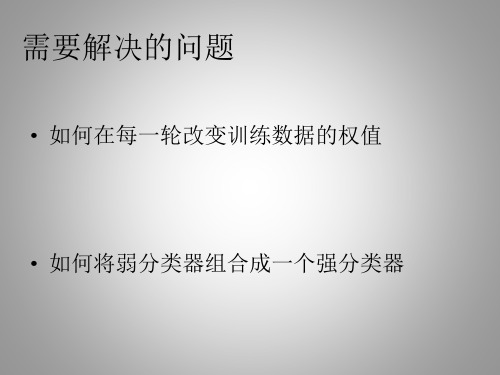

需要解决的问题

• 如何在每一轮改变训练数据的权值

• 如何将弱分类器组合成一个强分类器

AdaBoost算法的解决方案

• 如何在每一轮改变训练数据的权值

提高前一轮弱分类器错误分类样本的权值,降 低被正确分类样本的权值

• 如何将弱分类器组合成强分类器

增加分类误差率小的弱分类器的权值,使其起 较大的决定作用,同时减小分类误差率大的弱分类 器的权值。

m 1 m m m 1

AdaBoost

AdaBoost⼀直想写Adaboost来着,但迟迟未能动笔。

其算法思想虽然简单“听取多⼈意见,最后综合决策”,但⼀般书上对其算法的流程描述实在是过于晦涩。

昨⽇11⽉1⽇下午,邹博在我组织的机器学习班第8次课上讲决策树与Adaboost,其中,Adaboost讲得酣畅淋漓,讲完后,我知道,可以写本篇博客了。

⽆⼼啰嗦,本⽂结合邹博之决策树与Adaboost的PPT跟《统计学习⽅法》等参考资料写就,可以定义为⼀篇课程笔记、读书笔记或学习⼼得,有何问题或意见,欢迎于本⽂评论下随时不吝指出,thanks。

1 Adaboost的原理1.1 Adaboost是什么AdaBoost,是英⽂"Adaptive Boosting"(⾃适应增强)的缩写,由Yoav Freund和Robert Schapire在1995年提出。

它的⾃适应在于:前⼀个基本分类器分错的样本会得到加强,加权后的全体样本再次被⽤来训练下⼀个基本分类器。

AdaBoost是⼀种迭代算法,在每⼀轮中加⼊⼀个新的弱分类器,直到达到某个预定的⾜够⼩的错误率。

每⼀个训练样本都被赋予⼀个权重,表明它被某个分类器选⼊训练集的概率。

如果某个样本点已经被准确地分类,那么在构造下⼀个训练集中,它被选中的概率就被降低;相反,如果某个样本点没有被准确地分类,那么它的权重就得到提⾼。

在具体实现上,最初令每个样本的权重都相等,对于第k次迭代操作,我们就根据这些权重来选取样本点,进⽽训练分类器。

然后就根据这个分类器,来提⾼被它分错的的样本的权重,并降低被正确分类的样本权重。

然后,权重更新过的样本集被⽤于训练下⼀个分类器。

整个训练过程如此迭代地进⾏下去。

1.2 Adaboost算法流程给定⼀个训练数据集T={(x1,y1), (x2,y2)…(xN,yN)},其中实例,⽽实例空间,yi属于标记集合{-1,+1},Adaboost的⽬的就是从训练数据中学习⼀系列弱分类器或基本分类器,然后将这些弱分类器组合成⼀个强分类器。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

AdaBoost: 1.提高那些被前一轮弱分类器错分的样本权值,而降低那

些被正确分类样本的权值. 2.采用加权多数表决的办法。具体地,加大分类误差率

小的弱分类器的权值,使其在表决中其较大的作用,减小分 类误差率大的分类器的权值,使其在表决中起较小的作用。

2020/6/8

2020/6/8

39

install.packages("DMwR")

library(DMwR)

manyNAs(data) #查看缺失值>20%的行

sub<-sample(1:nrow(data),round(nrow(data)/4))

#

抽取其中1/4的样本为测试集

length(sub)

data_train<-data[-sub,]

2020/6/8

38

• 'data.frame': 4521 obs. of 17 variables: • $ age : int 30 33 35 30 59 35 36 39 41 43 ... • $ job : Factor w/ 12 levels "admin.","blue-collar",..: 11 8 5 5 2 5 7 10 3 8 ... • $ marital : Factor w/ 3 levels "divorced","married",..: 2 2 3 2 2 3 2 2 2 2 ... • $ education: Factor w/ 4 levels "primary","secondary",..: 1 2 3 3 2 3 3 2 3 1 ... • $ default : Factor w/ 2 levels "no","yes": 1 1 1 1 1 1 1 1 1 1 ... • $ balance : int 1787 4789 1350 1476 0 747 307 147 221 -88 ... • $ housing : Factor w/ 2 levels "no","yes": 1 2 2 2 2 1 2 2 2 2 ... • $ loan : Factor w/ 2 levels "no","yes": 1 2 1 2 1 1 1 1 1 2 ... • $ contact : Factor w/ 3 levels "cellular","telephone",..: 1 1 1 3 3 1 1 1 3 1 ... • $ day : int 19 11 16 3 5 23 14 6 14 17 ... • $ month : Factor w/ 12 levels "apr","aug","dec",..: 11 9 1 7 9 4 9 9 9 1 ... • $ duration : int 79 220 185 199 226 141 341 151 57 313 ... • $ campaign : int 1 1 1 4 1 2 1 2 2 1 ... • $ pdays : int -1 339 330 -1 -1 176 330 -1 -1 147 ... • $ previous : int 0 4 1 0 0 3 2 0 0 2 ... • $ poutcome : Factor w/ 4 levels "failure","other",..: 4 1 1 4 4 1 2 4 4 1 ... • $ y : Factor w/ 2 levels "no","yes": 1 1 1 1 1 1 1 1 1 1 ...

3 4 5本身对应的类(Y)是-1,因它们本身都大于2.5, 所以被G1(x)分在了相应的类“-1”中,分对了。

但6 7 8本身对应类(Y)是1,却因它们本身大于2.5而被 G1(x)分在了类"-1"中,所以这3个样本被分错了。 9本身对应的类(Y)是-1,因它本身大于2.5,所以被G1(x) 分在了相应的类“-1”中,分对了。

率 bag$class[105:110,] #模型bag对于第105至110个样本的预测类别 bag$samples[105:110]#模型bag中第105至110个样本在5次迭代中的抽

2020/6/8

31

2020/6/8

32

2020/6/8

33

2020/6/8

34

8.4.3梯度提升

2020/6/8

35

2020/6/8

36

2020/6/8

37

AdaBoost的R语言实现

setwd(“D:/集成学习") data<-read.csv("bank.csv",header=T,sep=";") dim(data) head(data) summary(data) str(data)

2020/6/8

20

$8.2 Adaboost训练误差分析

2020/6/8

$8.3 Adaboost算法解释

模型为加法模型

二 分 类 学 习 损失函数为指数函数 方 法

学习方法为前向分步算法

2020/6/8

22

8.3.1前向分步算法

2020/6/8

23

2020/6/8

24

2020/6/8

25

提升方法

将弱分类器进行重新组合。通过改变训练数据 的概率分布(训练数据的权值分布),针对不同 的训练数据分布调用若学习算法学习一些列弱分 类器。

2020/6/8

4

两个需要回答的问题

1. 在每一轮如何改变训练数据的权值或者概率分布; 2. 如何将弱分类器组合成一个强分类器。

2020/6/8

5

代表算法:AdaBoost

阈值v取5.5时误差率最低为0.0455*4(x > 5.5时取1, x < 5.5时取-1,则0 1 2 9分错,误差率为0.0455*3 + 0.0715),

阈值v取8.5时误差率为0.1667*3(x < 8.5时取1,x > 8.5时取-1,则3 4 5分错,误差率为0.1667*3)。

所以,阈值v取5.5时误差率最低,故第三个基本分类 器为

data_test<-data[sub,]

dim(data_train<-data[-sub,]) dim(data_test<-data[sub,])

2020/6/8

40

install.packages('adabag') install.packages("rpart") library(rpart) library(adabag) bag<-bagging(y~.,data_train,mfinal=5)#使用

阈值v取8.5时误差率为0.3(x < 8.5时取1,x > 8.5时取-1,则3 4 5分错, 误差率为0.3)。

所以无论阈值v取2.5,还是8.5,总得分错3个样本,故可任取其中任意 一个

(a)如2.5,弄成第一个基本分类器为:

2020/6/8

13

上面说阈值v取2.5时则6 7 8分错,所以误差率为0.3,更加详 细的解释是:因为样本集中0 1 2对应的类(Y)是1,因它们 本身都小于2.5,所以被G1(x)分在了相应的类“1”中,分对 了。

2020/6/8

16

2020/6/8

17

迭代过程3

对于m=3,在权值分布为D3 = (0.0455, 0.0455, 0.0455, 0.1667, 0.1667, 0.01667, 0.1060, 0.1060, 0.1060, 0.0455)的训练数据上,经过计算可得:

阈值v取2.5时误差率为0.1060*3(x < 2.5时取1,x > 2.5时取-1,则6 7 8分错,误差率为0.1060*3),

拿到这10个数据的训练样本后,根据 X 和 Y 的对应关系,要把 这10个数据分为两类,一类是“1”,一类是“-1”,根据数据的特 点发现:“0 1 2”这3个数据对应的类是“1”,“3 4 5”这3个数 据对应的类是“-1”,“6 7 8”这3个数据对应的类是“1”,9是比 较孤独的,对应类“-1”。抛开孤独的9不讲,“0 1 2”、“3 4 5”、“6 7 8”这是3类不同的数据,分别对应的类是1、-1、1,直 观上推测可知,可以找到对应的数据分界点,比如2.5、5.5、8.5 将 那几类数据分成两类。当然,这只是主观臆测,下面实际计算下这个 过程。

从而得到G1(x)在训练数据集上的误差率(被G1(x)误分类样 本“6 7 8”的权值之和)e1=P(G1(xi)≠yi) = 3*0.1 = 0.3。

2020/6/8

14

从上述第一轮的整个迭代过程可以看出:被误分类样本的权值之和影响 误差率,误差率影响基本分类器在最终分类器中所占的权重。

2020/6/8

6

2020/6/8

7

误分点个数

2020/6/8

8

2020/6/8

9

2020/6/8

10

2020/6/8

11

8.1.3 AdaBoost的例子

求解过程: 初始化训练数据的权值分布,令每个权值W1i = 1/N = 0.1,其

中,N = 10,i = 1,2, ..., 10,然后分别对于m = 1,2,3, ...等值 进行迭代。

阈值v取5.5时误差率最低为0.0715*4(x > 5.5时取1,x < 5.5时取-1,则0 1 2 9分错,误差率为0.0715*3 + 0.0715),