storm原理与实战

storm 处理流数据的工作机制

Storm 处理流数据的工作机制Storm 是一个开源的分布式实时计算系统,被广泛应用于处理实时流数据。

它具有高容错性、高吞吐量和低延迟的特点,适用于各种实时数据处理场景。

本文将详细介绍 Storm 处理流数据的工作机制。

1. Storm 概述Storm 是由 Apache 开源的,用于处理实时流数据的分布式计算系统,它能够在集群中处理连续不断的数据流,并实时地进行分析和计算。

它具有可伸缩性、容错性和高性能的特点,广泛应用于大规模数据处理领域。

2. Storm 架构Storm 运行在分布式集群中,通常由主节点(Master Node)和工作节点(Worker Node)组成。

Storm 采用主从架构,主节点负责任务分配和协调,而工作节点负责实际的数据处理。

2.1 Spout 组件在 Storm 中,Spout 组件用于从数据源中读取流数据,并将其发送给后续的数据处理组件。

Spout 组件可以读取各种类型的数据源,例如消息队列、文件系统或网络流。

2.2 Bolt 组件Bolt 组件是 Storm 中的数据处理单元,负责对传入的数据流进行处理和转换。

Bolt 组件可以执行各种计算、过滤、聚合和输出等操作,可以单独使用或者通过拓扑结构串连多个 Bolt 组件形成任务流水线。

2.3 Topology 拓扑Storm 中的任务被称为拓扑(Topology),它由一组 Spout 组件和一组 Bolt 组件构成。

通过定义这些组件之间的连接关系,可以形成一个完整的数据处理流程。

3. Storm 的工作流程Storm 的工作流程可以概括为以下几个步骤:1.主节点将任务拓扑提交给 Storm 集群。

2.Storm 集群将任务拓扑分发给工作节点。

3.每个工作节点负责执行一部分任务,并创建对应的任务线程。

4.Spout 组件从数据源中读取流数据,并将其发送给后续的 Bolt 组件。

5.Bolt 组件对接收到的数据流进行处理和转换,并将结果发送给下一个 Bolt组件或最终输出。

02、Storm入门到精通storm3-0

• Storm 记录级容错原理

在storm的topology中有一个系统级组件,叫做acker。 这个acker的任务就是追踪从spout中流出来的每一个 message id绑定的若干tuple的处理路径,如果在用户设置 的最大超时时间内这些tuple没有被完全处理,那么acker 就会告知spout该消息处理失败 了,相反则会告知spout该 消息处理成功了。在刚才的描述中,我们提到了”记录 tuple的处理路径”,如果曾经尝试过这么做的同学可以仔 细地思考一下 这件事的复杂程度。但是storm中却是使用 了一种非常巧妙的方法做到了。在说明这个方法之前,我 们来复习一个数学定理。

Storm深入学习

• Storm 记录级容错原理

举个例子。在图中,在 spout由message 1绑定的tuple1 和tuple2经过了bolt1和bolt2的处理生成两个新的tuple,并 最终都流向了bolt3。当这个过程完成处理完时,称 message 1被完全处理了。

Storm深入学习

nimbus.supervisor.timeout supervisor的心跳超时时间,一旦超过nimbus会认为该supervisor已死并停 .secs 止为它分发新任务.

unch.secs

nimbus.reassign

task启动时的一个特殊超时设置.在启动后第一次心跳前会使用该值来临 时替代nimbus.task.timeout.secs.

storm 面试题

storm 面试题Storm面试题1. Introduction to StormStorm是一个开源的分布式实时计算系统,用于处理大规模实时数据流。

它是一个可靠和高效的系统,可以将海量数据在分布式集群上进行并行处理,实现实时分析和计算。

本文将介绍Storm的工作原理、应用场景以及面试常见问题。

2. Storm的工作原理Storm使用了一种称为"Topology"的数据处理模型,其中包含多个组件,包括Spout、Bolt和Stream。

Spout负责数据源的读取和发送,Bolt负责数据转换和处理,Stream用于在Spout和Bolt之间传递数据。

Storm的工作流程如下:(1) 数据流入系统,由Spout接收数据并发送给Bolt。

(2) Bolt对接收到的数据进行处理和计算。

(3) 处理完成后,Bolt可以发送数据到其他Bolt,形成数据流的连续处理。

(4) 最后,数据可以被存储到数据库、文件系统或其他外部系统中。

Storm的分布式架构使得它能够处理大规模数据流,并实现高可用性和容错性。

它将工作负载分散到集群中的多台计算机上,并通过消息传递机制实现组件间的通信。

3. Storm的应用场景Storm在实时数据分析和处理方面具有广泛的应用场景,包括但不限于以下几个方面:(1) 金融领域:Storm可以用于实时风险管理、交易监控和欺诈检测。

它能够对流式数据进行复杂计算和规则验证,以实现实时预警和决策支持。

(2) 电信领域:Storm可以用于网络监控和故障诊断,实时分析和处理大量网络数据。

它可以帮助运营商及时发现并解决网络问题,提高网络运行的稳定性和可靠性。

(3) 电商领域:Storm可以用于实时推荐系统、广告投放和用户行为分析。

它能够根据用户的实时行为和偏好生成个性化推荐,提高用户购物体验和销售转化率。

(4) 物联网领域:Storm可以用于实时监测和分析传感器数据,实现设备状态监控和异常检测。

storm项目实战教程 storm开发实例 7、实例讲解Grouping策略及并发度

并发度

场景分析: 单线程下:加减乘除,和任何处理类Operate,汇总 多线程下: 1、局部加减乘除 2、做处理类Operate,如split 3、持久化,如入DB 以WordCountTopology.java 为例讲解 思考题:如何计算:word总数和word个数 ?并且在高并发下完成 前者是总行数,后者是去重word个数 类似企业场景:计算网站PV和UV Storm流计算从入门到精通 课程链接: /goods-427.html

Spout读文件:学习用,其他无用 读文件:1、分布式应用无法读;2、spout开并发会重复读

Stream grouping 策略

stream grouping就是用来定义一个stream应该如果分配给Bolts上面的多个 Executors(多线程,并发度) 注:不是一个spout或bolt emit到多个bolt(广播方式)。 storm里面有6种类型的stream grouping。 单线程下均等同于All Grouping 1.Shuffle Grouping 轮询,平均分配。随机派发stream里面的tuple,保证每个bolt接收到的tuple数目相同。 2. Non Grouping: 无分组, 这种分组和Shuffle grouping是一样的效果,多线程下不 平均分配。 3. Fields Grouping:按Field分组,比如按word来分组, 具有同样word的tuple会被分 到相同的Bolts, 而不同的word则会被分配到不同的Bolts。 作用:1、过滤,从源端(Spout或上一级Bolt)多输出Fields中选择某些Field 2、相同的tuple会分发给同一个Executer或task处理 典型场景: 去重操作、Join

欢迎访问我们的官方网站

storm原理

storm原理

Storm是一个开源的分布式实时计算系统,它可以用于实时大数据处理、分布式计算、流式计算等场景。

Storm的核心是一个分布式实时流数据处理引擎,它可以支持高可用、高可靠、高吞吐等特性。

Storm采用了类似于MapReduce的数据处理模型,但是它能够实现更高的计算速度和更低的延迟。

Storm的架构包含了多个组件,包括Zookeeper、Nimbus、Supervisor、Worker等。

其中,Zookeeper用于存储Storm的元数据,Nimbus是Storm的主节点,负责协调各个组件的工作,Supervisor 是Storm的工作节点,负责接收和处理任务,Worker是Supervisor 的子进程,用于具体的数据处理和计算。

Storm的计算模型包含了两种基本的数据类型:流和批。

流式数据是指实时产生的数据流,例如传感器数据、日志数据等。

批式数据则是指离线生成的数据集,例如Hadoop中的数据集。

Storm的计算单元是一个个“Bolt”和“Spout”。

Bolt用于处理数据,例如计算、聚合、过滤等操作,Spout用于产生数据流,例如从消息队列或者网络中获取数据。

Storm的工作流程是这样的:Spout从数据源获取数据,然后将数据发送给Bolt进行处理。

Bolt处理数据后,可以再次发送给下一个Bolt或者输出结果。

Storm可以支持多层嵌套的Bolt和Spout,从而实现复杂的数据处理和计算任务。

总之,Storm是一款强大的分布式实时计算系统,它可以帮助用

户快速实现数据处理和分析,提高数据处理的效率和准确性。

10-Storm-实战Hadoop2.0

与Hadoop的关系

• Storm用于实时计算领域,Hadoop常用于离线 分析和数据持久化。

场景

现有一组应用程序“应用1”、“应用2”和“应用3”,它们可以是门户 网站、微博等,这些应用的后台都使用了logback(http://logback.ch)将结 构化的日志消息写入磁盘(访问记录、错误消息等)。现有如下两种方式 处理这些日志。

cslave4

正在执行两个Storm-App的Storm集群

SpoutA SpoutB

BoltA

BoltB

Spout

WCTopology TopNTopology

BoltA

BoltB

BoltC

正在运行两个Topology的Storm集群 Worker为进程 Executor为隶属于Worker的线程 E-指的是Executor-

Nimbus k

cmaster0

l

Supervisor

E-SpoutA

Worker

Quorum PeerMain

Quorum PeerMain

Quorum PeerMain

zookeeper0

zookeeper1

zookeeper2

m u

n

Supervisor

E-SpoutB

Worker

E-BoltC

离线方式(Hadoop方式) 实时方式(Storm方式)

新浪新闻手机客户端 新浪新闻手机客户端

Hadoop离线分析

线上应用(如新浪三台线上服务器)

应用1

Flume

应用2

Flume

Flume 应用3

HDFS 集群

MapReduce框架

Hive客户端 公司办公室

Storm的原理与使用

Storm 的原理与使用--李孟简介Storm是一个分布式计算框架,主要由Clojure编程语言编写。

最初是由Nathan Marz及其团队创建于BackType,该项目在被Twitter取得后开源。

它使用用户创建的“管(spouts)”和“螺栓(bolts)”来定义信息源和操作来允许批量、分布式处理流式数据。

最初的版本发布于2011年9月17日。

Storm应用被设计成为一个拓扑结构,其接口创建一个转换“流”。

它提供与MapReduce作业类似的功能,当遇到异常时该拓扑结构理论上将不确定地运行,直到它被手动终止。

2013年,Apache软件基金会将Storm纳入它的孵化计划。

Clojure它是一个函数式多用途的语言。

可以执行于Java虚拟机。

一、总体结构Storm集群由一个主节点和多个工作节点组成。

主节点运行了一个名为“Nimbus”的守护进程,用于分配代码、布置任务及故障检测。

每个工作节点都运行了一个名为“Supervisor”的守护进程,用于监听工作,开始并终止工作进程。

Nimbus和Supervisor都能快速失败,而且是无状态的,这样一来它们就变得十分健壮,两者的协调工作是由ZooKeeper 来完成的。

Storm的术语包括Stream、Spout、Bolt、Worker、Executor、T ask、Stream Grouping和Topology。

Stream是被处理的数据。

Spout是数据源。

Bolt封装数据处理逻辑。

Worker是工作进程。

一个工作进程可以包含一个或多个Executor 线程。

Executor是运行Spout、Bolt处理逻辑的线程。

T ask是storm中的最小逻辑处理单元。

一个Executor可以包含一个或多个T ask,消息的分发都是从一个T ask到另外一个T ask。

Stream Grouping 规定了Bolt 接收什么东西作为输入数据。

数据可以随机分配(术语为Shuffle ),或者根据字段值分配(术语为Fields ),或者广播(术语为All ),或者总是发给一个T ask (术语为Global ),也可以不关心该数据(术语为None ),或者由自定义逻辑来决定(术语为Direct )。

storm原理

storm原理Storm是一个分布式实时计算系统,它可以处理海量的实时数据流,并且能够在毫秒级别内对数据进行处理和分析。

Storm的原理是基于流处理模型,它将数据流分成一系列的小批次,然后对每个小批次进行处理和分析,最终将结果输出到目标系统中。

Storm的核心组件是Nimbus和Supervisor。

Nimbus是Storm的主节点,它负责管理整个集群的拓扑结构和任务分配。

Supervisor是Storm的工作节点,它负责接收Nimbus分配的任务,并且在本地执行任务。

Storm的数据流模型是基于DAG(有向无环图)的,每个节点代表一个数据处理单元,节点之间的边代表数据流。

Storm的拓扑结构是由Spout和Bolt组成的。

Spout是数据源,它从外部数据源中读取数据,并将数据发送到Bolt中进行处理。

Bolt是数据处理单元,它接收Spout发送的数据,并且对数据进行处理和分析,最终将结果输出到目标系统中。

Storm的数据流模型是基于流处理模型的,它可以实现实时数据处理和分析。

Storm的数据流模型是基于DAG的,它可以实现高效的数据处理和分析。

Storm的拓扑结构是由Spout和Bolt组成的,它可以实现灵活的数据处理和分析。

Storm的优点是可以实现实时数据处理和分析,它可以处理海量的实时数据流,并且能够在毫秒级别内对数据进行处理和分析。

Storm的缺点是需要一定的技术水平才能使用,而且需要一定的硬件资源才能支持。

总之,Storm是一个非常强大的分布式实时计算系统,它可以处理海量的实时数据流,并且能够在毫秒级别内对数据进行处理和分析。

Storm的原理是基于流处理模型,它将数据流分成一系列的小批次,然后对每个小批次进行处理和分析,最终将结果输出到目标系统中。

Storm的优点是可以实现实时数据处理和分析,它可以处理海量的实时数据流,并且能够在毫秒级别内对数据进行处理和分析。

Storm的缺点是需要一定的技术水平才能使用,而且需要一定的硬件资源才能支持。

Storm(三)Storm的原理机制

Storm(三)Storm的原理机制⼀.Storm的数据分发策略1. Shuffle Grouping随机分组,随机派发stream⾥⾯的tuple,保证每个bolt task接收到的tuple数⽬⼤致相同。

轮询,平均分配2. Fields Grouping按字段分组,⽐如,按"user-id"这个字段来分组,那么具有同样"user-id"的 tuple 会被分到相同的Bolt⾥的⼀个task,⽽不同的"user-id"则可能会被分配到不同的task。

3. All Grouping⼴播发送,对于每⼀个tuple,所有的bolts都会收到4. Global Grouping全局分组,把tuple分配给task id最低的task 。

5. None Grouping不分组,这个分组的意思是说stream不关⼼到底怎样分组。

⽬前这种分组和Shuffle grouping是⼀样的效果。

有⼀点不同的是storm会把使⽤none grouping的这个bolt放到这个bolt的订阅者同⼀个线程⾥⾯去执⾏(未来Storm如果可能的话会这样设计)。

6. Direct Grouping指向型分组,这是⼀种⽐较特别的分组⽅法,⽤这种分组意味着消息(tuple)的发送者指定由消息接收者的哪个task处理这个消息。

只有被声明为 Direct Stream 的消息流可以声明这种分组⽅法。

⽽且这种消息tuple必须使⽤ emitDirect ⽅法来发射。

消息处理者可以通过TopologyContext 来获取处理它的消息的task的id (OutputCollector.emit⽅法也会返回task的id)7. Local or shuffle grouping本地或随机分组。

如果⽬标bolt有⼀个或者多个task与源bolt的task在同⼀个⼯作进程中,tuple将会被随机发送给这些同进程中的tasks。

storm框架原理

storm框架原理Storm是一个开源分布式实时计算系统,它能够处理海量的实时数据流。

Storm的基本原理是通过将数据流分为不同的task进行并行处理,同时提供可靠性保证和容错处理。

Storm的架构包括Master节点和Worker节点。

Master节点是集群中的一个节点,负责分配任务和监控整个系统的状态。

Worker节点是执行计算任务的节点,可以有多个。

Storm的数据流由不同的Spout和Bolt组成。

Spout是数据源,可以从文件、数据库、消息队列等获取数据,然后将数据发送到Bolt进行处理。

Bolt是数据处理单元,可以进行过滤、转换、计算等操作。

Spout和Bolt都可以并行执行。

Storm通过可配置的拓扑结构来定义数据流的处理逻辑。

拓扑结构由Spout和Bolt构成的有向无环图。

数据流从Spout开始,经过一系列的Bolt处理,最后输出结果或发送到其他Bolt。

在Storm中,数据流是以Tuple的形式进行传递和处理的。

Tuple是一个具有字段的数据结构,可以包含任意类型的数据。

Tuple通过Stream进行传递,一个Stream是一组具有相同类型的Tuple。

为了实现可靠性保证,Storm引入了ACK机制和Tuple树结构。

当Bolt完成对Tuple的处理后,会向前一个Bolt发送ACK消息确认处理成功。

如果一个Bolt没有收到ACK消息,说明前一个Bolt还没有处理完成,它会重发Tuple,直到收到ACK消息。

这样可以确保数据的可靠传递和处理。

当一个Bolt发生故障时,Storm会自动重新分配任务到其他可用的节点,以保持系统的可用性和容错性。

这涉及到Master节点重新分配任务,Worker节点接收并执行新的任务。

Storm在分配任务时会考虑节点的负载情况,尽量平衡节点的负载。

Storm还提供了可扩展性和灵活性的特性。

它可以在大规模集群上运行,并且可以动态地增加或减少Worker节点来适应负载的变化。

大数据开发技术之Storm原理与实践

大数据开发技术之Storm原理与实践一、Storm简介1. 引例在介绍Storm之前,我们先看一个日志统计的例子:假如我们想要根据用户的访问日志统计使用斗鱼客户端的用大数据培训户的地域分布情况,一般情况下我们会分这几步:•取出访问日志中客户端的IP•把IP转换成对应地域•按照地域进行统计Hadoop貌似就可以轻松搞定:•map做ip提取,转换成地域•reduce以地域为key聚合,计数统计•从HDFS取出结果如果有时效性要求呢?•小时级:还行,每小时跑一个MapReduce Job•10分钟:还凑合能跑•5分钟:够呛了,等槽位可能要几分钟呢•1分钟:算了吧,启动Job就要几十秒呢•秒级:… 要满足秒级别的数据统计需求,需要•进程常驻运行;•数据在内存中Storm正好适合这种需求。

2. 特性Storm是一个分布式实时流式计算平台。

主要特性如下:•简单的编程模型:类似于MapReduce降低了并行批处理复杂性,Storm降低了实时处理的复杂性,只需实现几个接口即可(Spout实现ISpout接口,Bolt实现IBolt接口)。

•支持多种语言:你可以在Storm之上使用各种编程语言。

默认支持Clojure、Java、Ruby和Python。

要增加对其他语言的支持,只需实现一个简单的Storm通信协议即可。

•容错性:nimbus、supervisor都是无状态的, 可以用kill -9来杀死Nimbus和Supervisor进程, 然后再重启它们,任务照常进行; 当worker失败后, supervisor会尝试在本机重启它。

•分布式:计算是在多个线程、进程和服务器之间并行进行的。

•持久性、可靠性:消息被持久化到本地磁盘,并且支持数据备份防止数据丢失。

•可靠的消息处理:Storm保证每个消息至少能得到一次完整处理。

任务失败时,它会负责从消息源重试消息(ack机制)。

•快速、实时:Storm保证每个消息能能得到快速的处理。

storm架构及原理

storm架构及原理storm 架构与原理1 storm简介1.1 storm是什么如果只⽤⼀句话来描述是什么的话:分布式 && 实时计算系统。

按照作者的说法,storm对于实时计算的意义类似于hadoop对于批处理的意义。

Hadoop(⼤数据分析领域⽆可争辩的王者)专注于批处理。这种模型对许多情形(⽐如为⽹页建⽴索引)已经⾜够,但还存在其他⼀些使⽤模型,它们需要来⾃⾼度动态的来源的实时信息。为了解决这个问题,就得借助 Nathan Marz 推出的 storm(现在已经被Apache 孵化)storm 不处理静态数据,但它处理连续的流数据。

1.2 storm 与传统的⼤数据storm 与其他⼤数据解决⽅案的不同之处在于它的处理⽅式。

Hadoop 在本质上是⼀个批处理系统。数据被引⼊ Hadoop ⽂件系统(HDFS) 并分发到各个节点进⾏处理。当处理完成时,结果数据返回到 HDFS 供始发者使⽤。

storm ⽀持创建拓扑结构来转换没有终点的数据流。

不同于 Hadoop 作业,这些转换从不停⽌,它们会持续处理到达的数据。

Hadoop 的核⼼是使⽤ Java™ 语⾔编写的,但⽀持使⽤各种语⾔编写的数据分析应⽤程序。

⽽ Twitter Storm 是使⽤ Clojure语⾔实现的。

Clojure 是⼀种基于虚拟机 (VM) 的语⾔,在 Java 虚拟机上运⾏。

但是,尽管 storm 是使⽤ Clojure 语⾔开发的,您仍然可以在 storm 中使⽤⼏乎任何语⾔编写应⽤程序。所需的只是⼀个连接到 storm 的架构的适配器。

已存在针对 Scala,JRuby,Perl 和 PHP 的适配器,但是还有⽀持流式传输到 Storm 拓扑结构中的结构化查询语⾔适配器。

2 Hadoop 架构的瓶颈Hadoop是优秀的⼤数据离线处理技术架构,主要采⽤的思想是“分⽽治之”,对⼤规模数据的计算进⾏分解,然后交由众多的计算节点分别完成,再统⼀汇总计算结果。

storm的原理及应用发展

Storm的原理及应用发展1. 简介Storm是一种开源的分布式实时计算系统,也被称为“流处理框架”。

它最初由Twitter开发,目前已经成为Apache软件基金会的顶级项目之一。

Storm的设计目标是提供一个高效且可靠的实时流处理框架,能够处理海量的数据并保证低延迟。

本文将介绍Storm的原理以及其应用发展的情况。

2. 原理Storm基于分布式消息驱动的编程模型,主要由三个核心组件组成:Spout、Bolt和Topology。

Spout用于从数据源获取数据并将其发送给Bolt进行处理,Bolt负责对数据进行处理和转换,而Topology则将Spout和Bolt组织成一个有向无环图(DAG),定义了数据处理的流程和数据流向。

SpoutSpout是Storm的数据源组件,可以从各种数据源中读取数据,如消息队列、数据库、文件系统等。

Spout可以以多线程的方式并行读取数据,并将读取到的数据发送给Bolt进行处理。

Spout还可以设置可靠性语义,保证数据的可靠处理。

BoltBolt是Storm的处理组件,可以对Spout发送过来的数据进行处理和转换。

Bolt可以进行计算、过滤、聚合等操作,并将处理结果发送给下一个Bolt或最终存储系统。

Bolt也可以以多线程的方式并行处理数据,提高数据处理的吞吐量。

TopologyTopology是Storm的数据处理流程描述,由多个Spout和Bolt组成的有向无环图(DAG)。

Topology定义了数据处理的流程和数据流向,可以灵活地组织数据处理逻辑。

通过调整Topology中的组件之间的关系和并发度,可以实现不同的数据处理需求。

3. 应用发展Storm作为一种高效且可靠的实时计算系统,已经在许多大规模数据处理场景中得到了广泛应用。

以下是一些Storm应用的典型案例:实时流处理Storm可以处理实时流数据,对于需要在数据到达时立即进行处理和分析的场景非常适用。

例如,电商平台可以利用Storm来实时分析用户的购买行为、即时推送个性化的推荐信息,从而提升用户体验和销售效果。

storm成像原理

storm成像原理Storm是一个开源的分布式实时计算系统,最初由Twitter开发。

它被设计用于处理大规模的流式数据,并以其高吞吐量、低延迟和可扩展性而闻名。

Storm的成像原理是基于流式数据处理的。

在传统的批处理系统中,数据是按照批次进行处理的,而流式数据则是实时产生的,需要即时处理。

Storm采用了一种称为“拓扑”的抽象模型来处理流式数据。

拓扑是由多个组件组成的有向图,每个组件可以是数据源、数据处理器或数据存储器。

在Storm中,数据通过一个叫做“流”的概念进行传递。

流是一系列无限的元组,每个元组包含一个或多个字段。

拓扑中的每个组件都可以接收和发送流,通过定义输入和输出流来实现数据的传递。

每个组件可以进行各种数据处理操作,例如过滤、转换、聚合等。

Storm的成像原理可以类比为一个水流的过程。

数据源相当于水的源头,数据处理器相当于水流经过的各个加工设备,数据存储器相当于最终的目的地。

数据源将数据源源不断地产生,并通过流的方式传递给数据处理器。

数据处理器对数据进行加工处理,然后将处理结果发送给下一个组件。

最后,数据存储器将处理结果保存下来,供后续使用。

为了实现高吞吐量和低延迟,Storm采用了分布式架构。

拓扑可以在多台机器上运行,每个组件可以分布在不同的机器上。

这样可以利用集群的计算能力来并行处理数据,并且通过数据的分片和复制来实现容错性。

Storm还提供了动态的负载均衡和故障恢复机制,保证系统的稳定性和可靠性。

除了高吞吐量和低延迟,Storm还具有良好的可扩展性。

拓扑可以根据需要进行水平扩展,增加机器和组件的数量来处理更多的数据。

Storm还支持动态的调优和配置,可以根据实际情况进行参数的调整,以达到最佳的性能和资源利用率。

Storm的成像原理是基于流式数据处理的分布式实时计算系统。

它通过拓扑的方式将数据源、数据处理器和数据存储器连接起来,实现数据的实时处理和分布式计算。

通过高吞吐量、低延迟和可扩展性,Storm在处理大规模流式数据方面具有重要的应用价值。

storm框架原理

storm框架原理Storm 是一种分布式实时计算系统,广泛应用于大数据处理和流式数据分析领域。

其核心原理可以概括如下:1. 任务拓扑:Storm 架构基于任务拓扑,将大任务拆分为多个小任务,形成一个有向无环图(DAG)。

拓扑由多个组成的Spout 和 Bolt 组成,Spout 负责数据的产生和发送,Bolt 负责数据的处理和传递。

2. 流式传递:Storm 使用 Tuple 进行数据传递,在拓扑中流动传递。

Tuple 是一个特定格式的数据结构,可以携带任意类型的数据。

Tuple 在拓扑中通过流进行传递,Bolt 可以选择订阅特定的流,在接收到 Tuple 后进行处理,并可以生成新的Tuple 发送给下一个 Bolt。

3. 可靠性保证:Storm 提供了可靠性保证机制,确保数据的可靠处理和处理结果的准确性。

其中,Spout 和 Bolt 可以进行数据的持久化、重发和确认操作。

当数据处理失败时,Storm 可以重新发送数据,保证数据不丢失。

在数据处理完成后,Bolt 可以向 Spout 发送确认消息,以确保数据的完整性。

4. 容错机制:Storm 提供了容错机制来处理故障和节点失效。

在一个 Storm 集群中,拓扑的组件分布在多个节点上,每个节点都可以处理一个或多个 Spout 或 Bolt。

当节点失效时,Storm 会重新分配任务到其他节点上,确保拓扑的高可用性和稳定性。

5. 可扩展性:Storm 架构具有良好的扩展性,可以根据实际需求扩展集群的规模和处理能力。

通过添加更多的节点和拓扑组件,可以提高系统的吞吐量和并发处理能力。

总的来说,Storm 的原理是基于任务拓扑、流式传递、可靠性保证、容错机制和可扩展性构建的分布式实时计算系统。

它提供了高吞吐量、低延迟和高容错性的特性,广泛应用于大规模数据处理和实时数据分析场景。

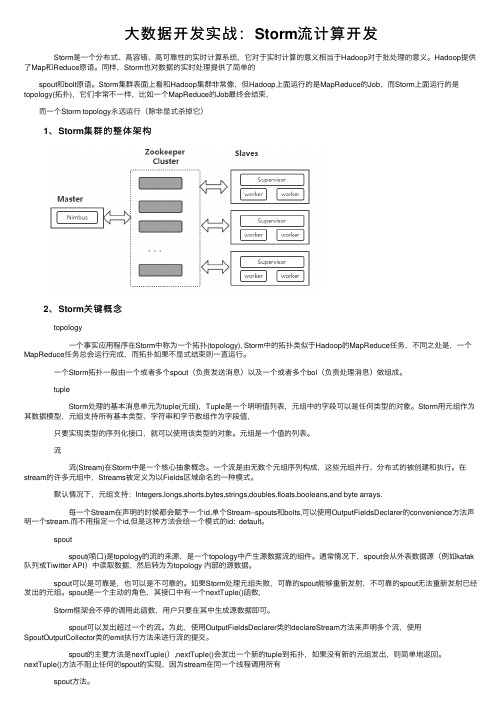

大数据开发实战:Storm流计算开发

⼤数据开发实战:Storm流计算开发 Storm是⼀个分布式、⾼容错、⾼可靠性的实时计算系统,它对于实时计算的意义相当于Hadoop对于批处理的意义。

Hadoop提供了Map和Reduce原语。

同样,Storm也对数据的实时处理提供了简单的 spout和bolt原语。

Storm集群表⾯上看和Hadoop集群⾮常像,但Hadoop上⾯运⾏的是MapReduce的Job,⽽Storm上⾯运⾏的是topology(拓扑),它们⾮常不⼀样,⽐如⼀个MapReduce的Job最终会结束, ⽽⼀个Storm topology永远运⾏(除⾮显式杀掉它) 1、Storm集群的整体架构 2、Storm关键概念 topology ⼀个事实应⽤程序在Storm中称为⼀个拓扑(topology), Storm中的拓扑类似于Hadoop的MapReduce任务,不同之处是,⼀个MapReduce任务总会运⾏完成,⽽拓扑如果不显式结束则⼀直运⾏。

⼀个Storm拓扑⼀般由⼀个或者多个spout(负责发送消息)以及⼀个或者多个bol(负责处理消息)做组成。

tuple Storm处理的基本消息单元为tuple(元组),Tuple是⼀个明明值列表,元组中的字段可以是任何类型的对象。

Storm⽤元组作为其数据模型,元组⽀持所有基本类型、字符串和字节数组作为字段值, 只要实现类型的序列化接⼝,就可以使⽤该类型的对象。

元组是⼀个值的列表。

流 流(Stream)在Storm中是⼀个核⼼抽象概念。

⼀个流是由⽆数个元组序列构成,这些元组并⾏、分布式的被创建和执⾏。

在stream的许多元组中,Streams被定义为以Fields区域命名的⼀种模式。

默认情况下,元组⽀持:Integers,longs,shorts,bytes,strings,doubles,floats,booleans,and byte arrays. 每⼀个Stream在声明的时候都会赋予⼀个id,单个Stream--spouts和bolts,可以使⽤OutputFieldsDeclarer的convenience⽅法声明⼀个stream.⽽不⽤指定⼀个id,但是这种⽅法会给⼀个模式的id: default。

storm原理

Storm原理一、什么是StormStorm是一种开源的、分布式的实时计算系统。

它可以在大规模的集群环境下处理数据流,并提供了可靠的容错机制。

Storm具有高度可伸缩性和可编程性,使用户能够灵活地处理实时数据。

二、Storm的基本概念在深入探讨Storm的原理之前,我们需要先了解一些Storm的基本概念。

1. Topology(拓扑)在Storm中,拓扑(Topology)是指实时计算的一个任务或应用程序。

拓扑由多个组件组成,每个组件负责一部分计算任务。

拓扑中的组件可以是数据源、数据处理器、数据存储器等。

拓扑可以包含多个层次和多个任务,形成一个复杂的计算图。

2. Spout(喷口)Spout是拓扑中的数据源组件,它从外部数据源接收数据,并将数据发送给下游的Bolt组件。

Spout可以从文件、消息队列、Socket等数据源中读取数据,并实时地将数据发送给Bolt进行处理。

3. Bolt(螺栓)Bolt是拓扑中的数据处理组件,它接收Spout发送的数据,并对数据进行处理。

Bolt可以执行各种计算任务,例如过滤、聚合、计数等。

Bolt可以有多个实例,每个实例只处理一部分数据,并可以进行并行计算。

4. Tuple(元组)在Storm中,数据以Tuple的形式在组件之间传递。

Tuple是一个数据结构,可以包含多个字段。

每个Tuple都有一个唯一的ID和标识符,用于在拓扑中进行传递和追踪。

5. Stream(数据流)Stream是由一系列Tuple组成的序列。

在拓扑中,数据流用于将数据在组件之间传递。

每个数据流都有一个唯一的ID和标识符,用于在拓扑中进行传递和追踪。

三、Storm的工作原理Storm的工作原理可以分为两个阶段:拓扑发布和拓扑执行。

1. 拓扑发布拓扑发布是指将编写好的拓扑提交到Storm的集群环境中运行的过程。

在拓扑发布阶段,Storm会将拓扑的代码、配置信息等发布到集群的各个节点上,并启动拓扑的执行。

storm的用法和搭配

storm的用法和搭配Storm 是一个开源的、分布式的实时计算系统,具有高容错性、可伸缩性和低延迟的特点。

它在处理大规模数据流的实时计算任务中得到了广泛应用。

本文将介绍 Storm 的用法和搭配,包括 Storm 的基本概念、组件及其相互关系,并阐述Storm 与其他相关技术的结合。

一、Storm 简介与基本概念1.1 Storm 简介Storm 是一个开源分布式实时大数据处理框架,由 Twitter 公司开发并于 2011年开源发布。

它是一种高度可靠且可伸缩的实时流处理系统,可以在大规模数据集上执行复杂计算任务。

1.2 Storm 组成部分Storm 主要由以下几个组件组成:- Nimbus:负责资源分配和任务调度,是整个 Storm 集群的主节点。

- Supervisor:运行在集群工作节点上,负责启动和监控工作进程(Worker),并向 Nimbus 汇报状态信息。

- ZooKeeper:提供协调服务,用于管理Nimbus 和Supervisor 节点之间的通信。

- Topology:描述 Storm 的计算任务模型,包含多个 Spout 和 Bolt 组件构成的有向无环图。

二、Storm 的使用方法2.1 创建 Topology创建一个 Storm Topology 需要以下步骤:- 定义 Spout:Spout 是数据源,可以从消息队列、日志文件等地方获取实时数据流并发送给下游的 Bolt。

通常,你需要实现一个自定义的 Spout 类来满足应用的需求。

- 定义 Bolt:Bolt 是对接收到的数据流进行处理和转换的组件。

在 Bolt 中,你可以执行计算、过滤和聚合等操作,并将处理后的结果发送给其他 Bolt 或外部存储系统。

- 连接 Spout 和 Bolt:通过指定 Spout 和 Bolt 之间的连接关系,形成有向无环图。

2.2 配置 Topology在创建 Topology 时,还需要进行相关配置。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

需要implements接口BaseBasicBolt 或者IBolt public void execute();// 执行消息处理逻辑 public void declareOutputFields (); // 消息发射 的格式声明

The stream is the core abstraction in Storm. A stream is an unbounded sequence of tuples that is processed and created in parallel in a distributed fashion. Streams are defined with a schema that names the fields in the stream's tuples. By default, tuples can contain integers, longs, shorts, bytes, strings, doubles, floats, booleans, and byte arrays. You can also define your own serializers so that custom types can be used natively within tuples.

storm使用zookeeper来协调整个集群, 但是要注意的是storm并不用 zookeeper来传递消息。所以zookeeper上的负载是非常低的,单个节 点的zookeeper在大多数情况下 都已经足够了, 但是如果你要部署大一 点的storm集群, 那么你需要的zookeeper也要大一点。关于如何部署 zookeeper,可以看/doc /r3.3.3/zookeeperAdmin.html 部署zookeeper有些需要注意的地方: 1、对zookeeper做好监控非常重要, zookeeper是fail-fast的系统, 只要出现什么错误就会退出, 所以实际场景中要监控,更多细节看 /doc/r3.3.3 /zookeeperAdmin.html#sc_supervision 2、实际场景中要配置一个cron job来压缩zookeeper的数据和业务 日志。zookeeper自己是不会去压缩这些的,所以你如果不设置一个 cron job, 那么你很快就会发现磁盘不够用了,更多细节可以查看 /doc/r3.3.3 /zookeeperAdmin.html#sc_maintenance

storm UI 只提供对topology的监控和统计。

代码实例:

/xeseo/article/details/17683049

推荐系统日志解析:git@:hf-devdata/datacenter-storm.git

Storm源码: https:///apache/storm

需要implements接口BaseRichSpout 或者 IRichSpout public void open(); // spout初始化 public void close(); // spout结束前的收尾工作 public void nextTuple() // 发射消息 public void ack(); // 消息处理成功后的处理方案 public void fail(); //消息处理失败后的处理方案

• 页面交互

定时调 度服务

• 定时任务 • 监控

Storm是一个分布式的、可靠的、容错的数据流处 理系统 Storm与传统关系型数据库

传统关系型数据库是先存后计算,而storm则是先算后存,甚至 不存 传统关系型数据库很难部署实时计算,只能部署定时任务统计分 析窗口数据 关系型数据库重视事务,并发控制,相对来说Storm比较简陋 原理URL:/lib/view/open1430095563146.html

Serialization Common patterns Clojure DSL Using non-JVM languages with Storm Distributed RPC Transactional topologies Hooks Metrics State Checkpointing Windowing Blobstore(Distcahce)

Apache Kafka Integration, New Kafka Consumer Integration Apache HBase Integration Apache HDFS Integration Apache Hive Integration Apache Solr Integration Apache Cassandra Integration JDBC Integration JMS Integration Redis Integration Event Hubs Intergration Elasticsearch Integration MQTT Integration Mongodb Integration OpenTSDB Integration Kinesis Integration Druid Integration Kestrel Integration

Storm集群中有两种节点,一种是控制节点(Nimbus节点),另一种是工 作节点(Supervisor节点)。所有Topology任务的 提交必须在Storm客户 端节点上进行(需要配置 storm.yaml文件),由Nimbus节点分配给其他 Supervisor节点进行处理。 Nimbus节点首先将提交的Topology进行分 片,分成一个个的Task,并将Task和Supervisor相关的信息提交到 zookeeper集群上,Supervisor会去zookeeper集群上认领自己的Task, 通知自己的Worker进程进行Task的处理。 和同样是计算框架的MapReduce相比,MapReduce集群上运行的是 Job,而Storm集群上运行的是Topology。但是Job在运行结束之后会自 行结束,Topology却只能被手动的kill掉,否则会一直运行下去 Storm不处理计算结果的保存,这是应用代码需要负责的事情,如果 数据不大,你可以简单地保存在内存里,也可以每次都更新数据库,也 可以采用NoSQL存储。这部分事情完全交给用户。

谢谢

/releases/2.0.0SNAPSHOT/Guaranteeing-messageprocessing.html

/releases/2.0.0-SNAPSHOT/Understanding-the-parallelism-of-a-Storm-topology.html

Shuffle grouping Fields grouping Partial Key grouping All grouping Global grouping None grouping Direct grouping Local or shuffle grouping

YARN Integration, YARN Integration via Slider Mesos Integration Docker Integration Kubernetes Integration

Flux Data Driven Topology Builder SQL

--数据中心

日志解析(推荐的日志解析场景详解) 网站指标的实时解析(PV、UV、等) 增量处理

从kafka 读取app 埋点日志 解析日志, 转换为用 户访问房 详情信息

Mongo 保存

用户活跃 更新

通知推荐 引擎重新 推荐

有哪些问题?

流式计 算

• p请求