OpenCV环境下CUDA编程示例

cuda使用教程

cuda使用教程CUDA(Compute Unified Device Architecture)是一种用于并行计算的平台和编程模型,可以利用GPU(Graphics Processing Unit,图形处理器)的强大计算能力来加速各种应用程序。

本文将为读者介绍如何使用CUDA进行并行计算,并提供一些基本的教程和示例。

要使用CUDA进行并行计算,我们需要一个支持CUDA的显卡。

大多数NVIDIA的显卡都支持CUDA,可以到NVIDIA官方网站查看显卡的兼容性列表。

另外,我们还需要安装NVIDIA的CUDA Toolkit,这是一个开发和运行CUDA程序的软件包。

安装完CUDA Toolkit后,我们就可以开始编写CUDA程序了。

CUDA 程序主要由两部分组成:主机代码(Host Code)和设备代码(Device Code)。

主机代码运行在CPU上,用于控制和管理CUDA设备;设备代码运行在GPU上,用于实际的并行计算。

在CUDA中,我们使用C/C++语言来编写主机代码,使用CUDA C/C++扩展来编写设备代码。

CUDA C/C++扩展是一种特殊的语法,用于描述并行计算的任务和数据的分配。

通过在设备代码中定义特定的函数(称为内核函数),我们可以在GPU上并行地执行这些函数。

下面是一个简单的示例,展示了如何使用CUDA计算两个向量的和:```c++#include <stdio.h>__global__ void vectorAdd(int* a, int* b, int* c, int n) { int tid = blockIdx.x * blockDim.x + threadIdx.x;if (tid < n) {c[tid] = a[tid] + b[tid];}}int main() {int n = 1000;int *a, *b, *c; // Host arraysint *d_a, *d_b, *d_c; // Device arrays// Allocate memory on hosta = (int*)malloc(n * sizeof(int));b = (int*)malloc(n * sizeof(int));c = (int*)malloc(n * sizeof(int));// Initialize host arraysfor (int i = 0; i < n; i++) {a[i] = i;b[i] = i;}// Allocate memory on devicecudaMalloc((void**)&d_a, n * sizeof(int));cudaMalloc((void**)&d_b, n * sizeof(int));cudaMalloc((void**)&d_c, n * sizeof(int));// Copy host arrays to devicecudaMemcpy(d_a, a, n * sizeof(int), cudaMemcpyHostToDevice);cudaMemcpy(d_b, b, n * sizeof(int), cudaMemcpyHostToDevice);// Launch kernelint block_size = 256;int grid_size = (n + block_size - 1) / block_size;vectorAdd<<<grid_size, block_size>>>(d_a, d_b, d_c, n); // Copy result back to hostcudaMemcpy(c, d_c, n * sizeof(int), cudaMemcpyDeviceToHost);// Print resultfor (int i = 0; i < n; i++) {printf("%d ", c[i]);}// Free memoryfree(a);free(b);free(c);cudaFree(d_a);cudaFree(d_b);cudaFree(d_c);return 0;}```在这个示例中,我们首先定义了一个内核函数`vectorAdd`,用于计算两个向量的和。

opencv 编译 cuda

opencv 编译cuda在编译OpenCV 时启用CUDA 支持,你需要确保以下条件满足:1. 安装CUDA Toolkit:在你的系统上安装NVIDIA CUDA Toolkit。

请确保你的GPU 支持CUDA,并选择与你的GPU 兼容的CUDA 版本。

CUDA Toolkit 包括了CUDA 编译器`nvcc` 和CUDA 运行时库。

2. 安装cuDNN(可选):如果你计划使用cuDNN(CUDA Deep Neural Network library)加速深度学习模块,你需要安装cuDNN 并确保OpenCV 在编译时能够找到它。

3. 安装OpenCV 依赖:安装OpenCV 编译所需的其他依赖项,如OpenBLAS、Eigen、TBB 等。

下面是一个简单的编译步骤:```bash# 克隆OpenCV 仓库git clone# 进入OpenCV 目录cd opencv# 创建build 目录mkdir build# 进入build 目录cd build# 配置OpenCV 编译参数,启用CUDA 支持cmake -D CMAKE_BUILD_TYPE=RELEASE -D CMAKE_INSTALL_PREFIX=/usr/local -D WITH_CUDA=ON ..# 编译make -j8 # 使用-j 参数可以并行编译,加快编译速度,根据CPU 核心数调整# 安装sudo make install```在上述的`cmake` 命令中,`WITH_CUDA=ON` 表示启用CUDA 支持。

你可以根据需要通过添加其他参数来启用或禁用其他模块,如`WITH_CUDNN=ON` 来启用cuDNN 支持。

请注意,确保在`cmake` 之前,你已经安装了必需的依赖项,并且你的系统上已正确配置了CUDA。

根据你的系统和需求,可能需要调整一些其他的CMake 参数。

此外,建议在编译前查看OpenCV 的官方文档,以确保使用正确的编译选项和版本。

cuda代码示例

cuda代码示例CUDA是一种并行计算框架,可以在NVIDIA GPU上进行高效的并行计算。

下面是一个简单的CUDA代码示例:```c#include <stdio.h>#include <cuda_runtime.h>__global__ void add(int *a, int *b, int *c){int i = threadIdx.x;c[i] = a[i] + b[i];}int main(){int a[3] = {1, 2, 3};int b[3] = {4, 5, 6};int c[3] = {0, 0, 0};int *dev_a, *dev_b, *dev_c;cudaMalloc((void**)&dev_a, 3 * sizeof(int)); cudaMalloc((void**)&dev_b, 3 * sizeof(int)); cudaMalloc((void**)&dev_c, 3 * sizeof(int));cudaMemcpy(dev_a, a, 3 * sizeof(int), cudaMemcpyHostToDevice);cudaMemcpy(dev_b, b, 3 * sizeof(int), cudaMemcpyHostToDevice);add<<<1, 3>>>(dev_a, dev_b, dev_c);cudaMemcpy(c, dev_c, 3 * sizeof(int), cudaMemcpyDeviceToHost);printf("%d %d %d\n", c[0], c[1], c[2]);cudaFree(dev_a);cudaFree(dev_b);cudaFree(dev_c);return 0;}```这个示例程序实现了向量加法,将两个长度为3的向量相加。

如何使用opencv的gpu模块

如何使用opencv的gpu模块Email:zhangping_bnu@Blog:/s/blog_5c6f79380101asun.html本文主要讲述如何使OpenCV支持CUDA高速运算,有问题可以发邮件。

我们将要使用的工具除了常规编译方式使用的工具外,还要使用CUDA tookit和GPU Computing SDK,如本人使用的版本分别为cudatoolkit_4.2.9_win_64.msi和gpucomputingsdk_4.2.9_win_64.exe(我的电脑是64位系统),相关文件可以从官网下载。

下载完成后并安装,确保CUDA SDK的bin目录(“C:\ProgramData\NVIDIA Corporation\NVIDIA GPU Computing SDK4.2\C\common\bin”)已经添加到环境变量中后,我们就开始编译支持CUDA高速运算的OpenCV。

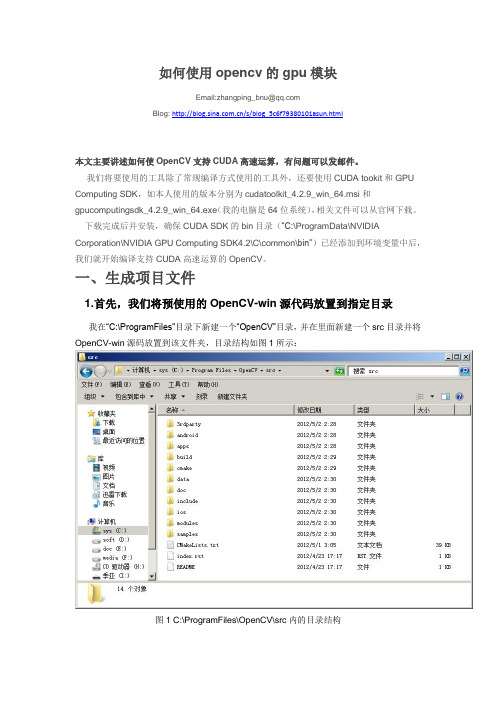

一、生成项目文件1.首先,我们将预使用的OpenCV-win源代码放置到指定目录我在“C:\ProgramFiles”目录下新建一个“OpenCV”目录,并在里面新建一个src目录并将OpenCV-win源码放置到该文件夹,目录结构如图1所示:图1 C:\ProgramFiles\OpenCV\src内的目录结构2.下载并安装配置inteltbb这里我把inteltbb解压后的文件夹放置到“C:\Program Files”目录下(如图2所示),然后将inteltbb的bin目录添加到系统环境变量,在桌面上右击“计算机”,选择“属性-高级系统设置”,进入“高级”选项卡,“环境变量-系统变量”,如图3所示:图2 tbb40_20120408oss内的目录结构图3 系统环境变量编辑“Path”变量,在最后添加inteltbb的bin(注意要深入到最内层目录,如Visual2005的话应该为“C:\ProgramFiles\tbb40_20120408oss\bin\ia32\vc8”,Visual Studio 2008应为“C:\ProgramFiles\tbb40_20120408oss\bin\ia32\vc9”)目录所在全路径。

onnxruntime cuda c++案例

ONNX Runtime 是一个开源的、跨平台的运行时,用于运行ONNX (Open Neural Network Exchange) 模型。

它支持多种后端,包括 CPU 和 GPU。

为了在 CUDA(NVIDIA的并行计算平台和API)上使用ONNX Runtime,您需要确保安装了合适的CUDA 版本,并且ONNX Runtime 配置为使用CUDA。

以下是一个简单的ONNX Runtime CUDA C++ 示例,用于加载一个 ONNX 模型,然后使用 CUDA 后端进行推理:```cpp#include <iostream>#include <onnxruntime/core/session/onnxruntime_cxx_api.h> #include<onnxruntime/core/providers/cuda/cuda_provider_factory.h>int main() {// 1. 创建 InferenceSession 对象Ort::Env env(ORT_LOGGING_LEVEL_WARNING, "CUDA_C++_example");Ort::SessionOptions session_options;session_options.SetIntraOpNumThreads(1);session_options.SetGraphOptimizationLevel(GraphOptimizat ionLevel::ORT_ENABLE_ALL);session_options.SetExecutionMode(ExecutionMode::ORT_SE QUENTIAL);session_options.SetRunOptions("{\"use_cuda\":true}", "{\"cuda_device_id\":0}");std::string model_path = "path_to_your_onnx_model.onnx"; // 请替换为您的ONNX 模型路径Ort::Session session(env, model_path, session_options);// 2. 创建输入张量std::vector<float> input = {1.0, 2.0, 3.0, 4.0, 5.0, 6.0}; // 请根据您的模型输入调整此输入数据Ort::MemoryInfo memory_info = Ort::MemoryInfo::CreateCpu(OrtArenaAllocator, OrtMemTypeDefault);Ort::Value input_tensor =Ort::Value::CreateTensor<float>(memory_info, input.data(), input.size(), nullptr, nullptr);// 3. 进行推理std::vector<Ort::Value> input_tensors{input_tensor};std::vector<Ort::Value> output_tensors = session.Run(Ort::RunOptions{nullptr}, input_tensors);// 4. 处理输出张量float* output_data = output_tensor.GetTensorMutableData<float>();for (float value : output_data) {std::cout << value << " "; // 输出推理结果}return 0;}```请注意,您需要将`"path_to_your_onnx_model.onnx"` 替换为您的ONNX 模型的路径。

cuda实例程序

cuda实例程序CUDA(Compute Unified Device Architecture)是NVIDIA提供的并行计算平台和编程模型,用于利用NVIDIA GPU进行通用目的计算。

以下是一个简单的CUDA示例程序,演示了在GPU上执行向量加法的基本概念。

#include <iostream>#include <cmath>// CUDA核函数,用于在GPU上执行向量加法__global__ void vectorAdd(float *a, float *b, float *c, int n) {// 获取线程的全局索引int i = blockIdx.x * blockDim.x + threadIdx.x;// 确保索引在向量范围内if (i < n) {c[i] = a[i] + b[i];}}int main() {// 向量大小int n = 100000;// 主机上的输入向量float *h_a, *h_b, *h_c;h_a = new float[n];h_b = new float[n];h_c = new float[n];// 初始化输入向量for (int i = 0; i < n; ++i) {h_a[i] = sin(i);h_b[i] = cos(i);}// 在设备上分配内存float *d_a, *d_b, *d_c;cudaMalloc(&d_a, n * sizeof(float)); cudaMalloc(&d_b, n * sizeof(float)); cudaMalloc(&d_c, n * sizeof(float));// 将输入向量从主机复制到设备cudaMemcpy(d_a, h_a, n * sizeof(float), cudaMemcpyHostToDevice);cudaMemcpy(d_b, h_b, n * sizeof(float), cudaMemcpyHostToDevice);// 定义块大小和网格大小int blockSize = 256;int gridSize = (n + blockSize - 1) / blockSize;// 调用CUDA核函数vectorAdd<<<gridSize, blockSize>>>(d_a, d_b, d_c, n);// 将结果从设备复制回主机cudaMemcpy(h_c, d_c, n * sizeof(float), cudaMemcpyDeviceToHost);// 打印一些结果for (int i = 0; i < 10; ++i) {std::cout << h_c[i] << " ";}std::cout << std::endl;// 释放内存delete[] h_a;delete[] h_b;delete[] h_c;cudaFree(d_a);cudaFree(d_b);cudaFree(d_c);return 0;}这个示例程序执行了一个简单的向量加法,将两个输入向量(h_a 和h_b)相加,结果存储在输出向量(h_c)中。

cuda atomic 示例

cuda atomic 示例"CUDA Atomic 示例"介绍CUDA(Compute Unified Device Architecture)是一种用于并行计算的并行计算架构和编程模型。

它允许开发人员利用GPU(Graphics Processing Unit)的强大并行性能来加速各种计算任务。

在CUDA中,有许多方法可以实现并行计算,其中之一就是原子操作。

原子操作是一种特殊的操作,可以保证多个线程并发访问内存时的数据正确性。

在并行编程中,一个常见的问题是多个线程同时访问同一内存位置,这可能导致数据的竞争条件(Race Condition)和不一致性结果。

为了解决这个问题,CUDA提供了一些原子操作,以确保多个线程访问同一内存位置时的数据一致性。

在这篇文章中,我们将介绍一个使用CUDA原子操作的示例,并逐步解释其实现过程。

步骤1:设置CUDA环境在开始编写CUDA代码之前,首先需要安装CUDA开发环境,并确保我们的硬件支持CUDA功能。

同时,还需要一个支持CUDA的编译器,如NVCC(NVIDIA Compiler)。

在安装完成后,我们可以开始编写CUDA 代码。

步骤2:编写核函数最基本的CUDA程序包含一个称为核函数(Kernel Function)的函数。

核函数是在GPU上并行执行的代码单元。

在我们的示例中,我们将编写一个核函数来对一个数组进行递增操作。

以下是一个简单的递增核函数的示例:c++__global__void incrementArray(int* array, int size){int tid = blockIdx.x * blockDim.x + threadIdx.x;if (tid < size){atomicAdd(&array[tid], 1);}}在这个核函数中,我们首先计算当前线程的索引(tid)。

然后,我们使用`atomicAdd`原子操作对数组中的元素进行原子递增。

基于GPU加速的计算机视觉编程:使用OpenCV和CUDA实

2.7总结 2.8测验题

2.2.1 CUDA C中的双变量加法程序 2.2.2内核调用 2.2.3配置内核参数 2.2.4 CUDA API函数 2.2.5将参数传递给CUDA函数

2.4.1通用设备信息 2.4.2内存相关属性 2.4.3线程相关属性

2.5.1两个向量加法程序 2.5.2对比CPU代码和GPU代码的延迟 2.5.3对向量的每个元素进行平方

2.6.1映射 2.6.2收集 2.6.3分散式 2.6.4蒙板 2.6.5转置

3.2线程

3.1技术要求

3.3存储器架构

0 1

3.4线程同 步

0 2

3.5常量内 存

0 3

3.6纹理内 存0Fra bibliotek43.7向量点 乘和矩阵乘 法实例

0 5

3.8总结

0 6

3.9测验题

3.3.1全局内存 3.3.2本地内存和寄存器堆 3.3.3高速缓冲存储器

基于GPU加速的计算机视觉编程:使用OpenCV和CUDA实时处理复杂图像数据包米克·维迪雅 1个笔记 ◆测验 题答案其实看起来并不难啊,随书github上面有代码,花了一天时间粗略看完了。或许真的就是如推测所说:调 用的是硬件的解码api,该api就只给你40%,你即使多开进程也没法再提高。

目录分析

6.8测验题

6.4.1图像大小调整 6.4.2图像平移与旋转

6.5.1对图像的卷积运算 6.5.2对图像进行低通滤波操作 6.5.3对图像进行高通滤波操作

7.1技术要求

7.2对象检测和跟踪 简介

7.3基于颜色的对象 检测和跟踪

7.4基于形状的对象 检测和跟踪

7.5关键点检

1

测器和描述符

opencv编译cuda

opencv编译cuda摘要:1.OpenCV 简介2.CUDA 简介3.OpenCV 与CUDA 的关系4.编译OpenCV with CUDA 的步骤5.总结正文:1.OpenCV 简介OpenCV(Open Source Computer Vision Library)是一个开源的计算机视觉和机器学习软件库,包含了丰富的图像处理、视频分析和特征提取等功能。

它被广泛应用于实时计算机视觉、人脸识别、物体跟踪等领域。

2.CUDA 简介CUDA(Compute Unified Device Architecture)是NVIDIA 推出的一种通用并行计算架构,允许开发人员利用NVIDIA GPU 进行高性能计算。

CUDA 可以让开发者更方便地编写高性能的并行程序,特别是在机器学习和图像处理领域。

3.OpenCV 与CUDA 的关系OpenCV 提供了对CUDA 的支持,用户可以通过编译OpenCV with CUDA,使得OpenCV 在运行时能够调用NVIDIA GPU 进行并行计算,从而提高计算性能。

4.编译OpenCV with CUDA 的步骤4.1 安装NVIDIA CUDA Toolkit首先需要安装NVIDIA CUDA Toolkit,它可以从NVIDIA 官网下载。

在安装过程中,请确保安装CUDA 版本的兼容性。

4.2 安装cuDNNVIDIA 提供了一个名为cuDNN 的GPU 加速神经网络库,可以与CUDA 一起使用。

在安装cuDNN 时,请确保安装的版本与CUDA 版本相匹配。

4.3 配置OpenCV在编译OpenCV 之前,需要对OpenCV 进行配置。

需要设置CMAKE_CUDA_ARCH_BINARY、CMAKE_CUDA_TOOLKIT_ROOT_DIR 等变量,指向安装的CUDA 和cuDNN 的路径。

4.4 编译OpenCV在配置好OpenCV 后,可以使用CMake 进行编译。

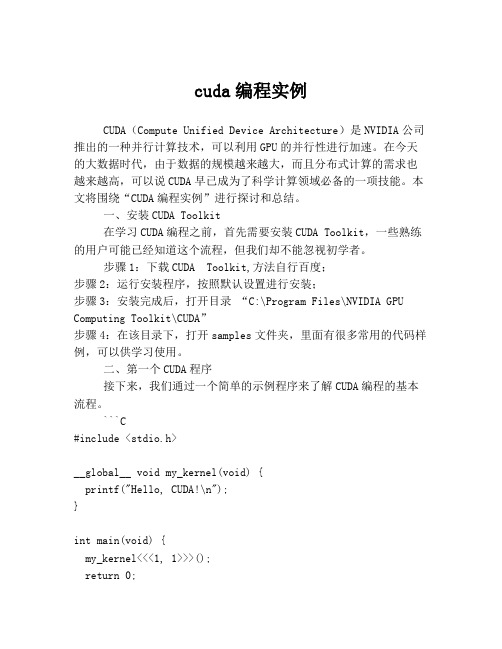

cuda编程实例

cuda编程实例CUDA(Compute Unified Device Architecture)是NVIDIA公司推出的一种并行计算技术,可以利用GPU的并行性进行加速。

在今天的大数据时代,由于数据的规模越来越大,而且分布式计算的需求也越来越高,可以说CUDA早已成为了科学计算领域必备的一项技能。

本文将围绕“CUDA编程实例”进行探讨和总结。

一、安装CUDA Toolkit在学习CUDA编程之前,首先需要安装CUDA Toolkit,一些熟练的用户可能已经知道这个流程,但我们却不能忽视初学者。

步骤1:下载CUDA Toolkit,方法自行百度;步骤2:运行安装程序,按照默认设置进行安装;步骤3:安装完成后,打开目录“C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA”步骤4:在该目录下,打开samples文件夹,里面有很多常用的代码样例,可以供学习使用。

二、第一个CUDA程序接下来,我们通过一个简单的示例程序来了解CUDA编程的基本流程。

```C#include <stdio.h>__global__ void my_kernel(void) {printf("Hello, CUDA!\n");}int main(void) {my_kernel<<<1, 1>>>();return 0;}```这是一个最简单的CUDA程序。

在CUDA中,使用“__global__”作为函数指示符号,指示它的代码将在GPU上执行。

在该函数内,使用printf()函数在控制台上输出文本。

在主函数中,调用__global__函数来产生要执行的代码。

我们使用一组小的参数<<<1,1>>>来启动一个GPU核心,这是CUDA中的核心数量。

三、矩阵的乘法现在我们来看看一个更加实用的例子。

cuda并行计算 例子

cuda并行计算例子摘要:1.CUDA 并行计算简介2.CUDA 并行计算的例子3.总结正文:一、CUDA 并行计算简介CUDA(Compute Unified Device Architecture)是NVIDIA 推出的一种通用并行计算架构,它允许开发人员利用NVIDIA GPU 进行高性能的并行计算。

CUDA 并行计算具有高度的并行性,可以有效地加速计算密集型任务,例如大规模数据处理、图像处理和深度学习等。

二、CUDA 并行计算的例子以下是一个简单的CUDA 并行计算例子,用于求解一个线性方程组:```cpp#include <iostream>#include <cuda_runtime.h>__global__ void solve_linear_equations(float *A, float *B, float *X, int N) {int i = blockIdx.x * blockDim.x + threadIdx.x;if (i < N) {X[i] = A[i] * B[i];}}int main() {int N = 100;float A[N][N], B[N][N], X[N][N];// 初始化矩阵A、B 和向量X//...// 为CUDA 并行计算分配内存float *A_gpu, *B_gpu, *X_gpu;cudaMalloc((void**)&A_gpu, N * N * sizeof(float));cudaMalloc((void**)&B_gpu, N * N * sizeof(float));cudaMalloc((void**)&X_gpu, N * N * sizeof(float));// 将矩阵A 和B 从CPU 复制到GPUcudaMemcpy(A_gpu, A, N * N * sizeof(float), cudaMemcpyHostToDevice);cudaMemcpy(B_gpu, B, N * N * sizeof(float), cudaMemcpyHostToDevice);// 定义CUDA 并行计算的线程块和网格尺寸dim3 blockSize(256);dim3 gridSize((N + blockSize.x - 1) / blockSize.x);// 在GPU 上执行CUDA 并行计算solve_linear_equations<<<gridSize, blockSize>>>(A_gpu,B_gpu, X_gpu, N);// 将计算结果从GPU 复制回CPUcudaMemcpy(X, X_gpu, N * N * sizeof(float), cudaMemcpyDeviceT oHost);// 验证计算结果//...// 释放GPU 内存cudaFree(A_gpu);cudaFree(B_gpu);cudaFree(X_gpu);return 0;}```三、总结CUDA 并行计算为开发人员提供了强大的GPU 计算能力,可以大幅提高计算密集型任务的执行速度。

cuda编译opencv的dct函数

cuda编译opencv的dct函数要在CUDA上编译OpenCV的DCT(Discrete Cosine Transform)函数,我们需要做以下几个步骤:2.检查CUDA的可用性:使用以下命令检查CUDA是否正确安装并可用于编译:```nvcc --version```如果能够正确显示CUDA版本信息,说明CUDA已经安装成功。

3. 配置OpenCV支持CUDA:默认情况下,OpenCV不支持CUDA。

因此,我们需要重新编译OpenCV以启用CUDA支持。

这需要使用CMake来配置编译选项。

b. 创建一个用于编译OpenCV的新目录,并进入该目录。

例如:```mkdir buildcd build```c. 使用CMake配置编译选项。

将以下命令复制到终端,并根据需要修改`/path/to/opencv/source`和`/path/to/opencv/build`为正确的路径。

```cmake -D WITH_CUDA=ON -D CUDA_ARCH_BIN=<arch> -DCUDA_ARCH_PTX=<arch> -D BUILD_opencv_world=OFF/path/to/opencv/source````WITH_CUDA=ON`表示启用CUDA支持,`CUDA_ARCH_BIN`和`CUDA_ARCH_PTX`用于指定CUDA架构(GPU的计算能力),可以根据您的GPU类型进行设置。

d. 运行CMake生成Makefile。

```make -j8```这将根据配置选项编译OpenCV。

4. 编写CUDA加速的DCT函数:接下来,我们需要编写一个用CUDA 加速的DCT函数,以替换OpenCV的标准DCT函数。

CUDA编程使用CUDA C/C++语言,我们需要在C++代码中嵌入CUDA C/C++代码。

以下是一个简单的示例代码:```C++#include <opencv2/core/core.hpp>#include <opencv2/highgui/highgui.hpp>#include <opencv2/imgproc/imgproc.hpp>#include <opencv2/cudaarithm.hpp>void cudaDCT(cv::Mat& input, cv::Mat& output) cv::cuda::GpuMat d_input(input);cv::cuda::GpuMat d_output;cv::cuda::dct(d_input, d_output);d_output.download(output);}int maicv::Mat input = cv::imread("input.jpg", cv::IMREAD_GRAYSCALE);cv::Mat output;cudaDCT(input, output);cv::imshow("Input", input);cv::imshow("Output", output);cv::waitKey(;return 0;}```这个示例代码首先导入了OpenCV相关的头文件,并定义了一个名为`cudaDCT`的函数来执行CUDA DCT计算。

cuda编译opencv的dct函数

CUDA编译OpenCV的DCT函数1. 简介在计算机视觉和图像处理中,离散余弦变换(Discrete Cosine Transform,DCT)是一种常用的信号处理技术,常用于图像压缩、特征提取等领域。

OpenCV是一个流行的计算机视觉库,提供了对DCT的支持。

为了提高DCT的性能,OpenCV中的DCT函数可以使用CUDA进行加速。

本文将详细介绍CUDA编译OpenCV的DCT函数,包括函数的定义、用途和工作方式等。

2. 函数定义在OpenCV中,DCT函数的定义如下:void cv::dct(InputArray src, OutputArray dst, int flags=0);参数说明: - src:输入图像或数组,数据类型为CV_32F或CV_64F,单通道或多通道。

- dst:输出图像或数组,与输入图像类型相同。

- flags:DCT的标志位,可选参数,默认为0。

可以通过设置不同的标志位来控制DCT的变换类型。

3. 函数用途DCT是一种将空域信号转换为频域信号的技术,它可以将图像或信号分解为一系列频率分量。

DCT在图像压缩中被广泛应用,例如JPEG压缩算法就是基于DCT的。

DCT还可以用于图像特征提取、图像处理等领域。

OpenCV的DCT函数提供了对图像或数组的DCT变换操作,可以方便地进行DCT变换和逆变换。

通过CUDA编译OpenCV的DCT函数,可以利用GPU的并行计算能力,加速DCT的计算过程。

4. 函数工作方式CUDA编译OpenCV的DCT函数的工作方式如下:1.检查输入参数的合法性。

函数首先会检查输入参数的数据类型和通道数是否满足要求,如果不满足则会报错。

2.分配内存空间。

根据输入图像的大小和数据类型,函数会在GPU上分配相应的内存空间用于存储输入和输出数据。

3.数据传输。

将输入图像数据从主机内存传输到GPU的全局内存中,以便GPU可以对其进行计算。

4.并行计算。

c++ cuda 例子

c++ cuda 例子C++和CUDA是两种编程语言,它们可以用来开发高性能并行计算程序。

下面是一些关于C++和CUDA的例子和相关的参考内容。

1. CUDA并行程序示例:在CUDA中,可以使用GPU来加速计算任务。

以下是一个简单的向量加法的示例程序:```c++#include <iostream>#include <cuda.h>__global__ void vectorAdd(int* a, int* b, int* c, int n) {int i = threadIdx.x;if (i < n)c[i] = a[i] + b[i];}int main() {int n = 100;int* a, * b, * c; // host vectorsint* d_a, * d_b, * d_c; // device vectors// Allocate memory on the hosta = new int[n];b = new int[n];c = new int[n];// Initialize host vectorsfor (int i = 0; i < n; ++i) {a[i] = i;b[i] = i;}// Allocate memory on the devicecudaMalloc(&d_a, sizeof(int) * n);cudaMalloc(&d_b, sizeof(int) * n);cudaMalloc(&d_c, sizeof(int) * n);// Copy input vectors from host to device memory cudaMemcpy(d_a, a, sizeof(int) * n, cudaMemcpyHostToDevice);cudaMemcpy(d_b, b, sizeof(int) * n, cudaMemcpyHostToDevice);// Launch the kernel on the devicevectorAdd<<<1, n>>>(d_a, d_b, d_c, n);// Copy result vector from device to host memory cudaMemcpy(c, d_c, sizeof(int) * n, cudaMemcpyDeviceToHost);// Print the resultfor (int i = 0; i < n; ++i) {std::cout << c[i] << " ";}std::cout << std::endl;// Clean up memorydelete[] a;delete[] b;delete[] c;cudaFree(d_a);cudaFree(d_b);cudaFree(d_c);return 0;}```该程序使用CUDA的核函数(`__global__`)实现了向量加法。

cv2 cuda 函数

cv2 cuda 函数

OpenCV(Open Source Computer Vision Library)是一个开源

的计算机视觉库,它包含了很多用于图像处理和计算机视觉任务的

函数和工具。

CUDA是NVIDIA提供的并行计算平台和应用程序编程

接口,用于利用NVIDIA GPU的并行计算能力。

在OpenCV中,cv2.cuda模块提供了与CUDA相关的函数和类,

用于利用GPU进行加速计算。

这些函数和类可以帮助开发者利用

GPU的并行计算能力来加速图像处理和计算机视觉任务。

cv2.cuda模块中包含了各种函数,比如用于图像处理的滤波器、边缘检测、特征匹配等。

这些函数可以在GPU上并行执行,从而加

快处理速度。

除了图像处理,cv2.cuda还提供了一些机器学习相关的函数,

比如支持向量机、K均值聚类等。

这些函数可以在GPU上并行执行,加速机器学习算法的训练和推理过程。

总的来说,cv2.cuda模块为开发者提供了利用GPU进行并行计

算加速的工具和函数,可以大大提高图像处理和机器学习任务的性

能和效率。

开发者可以通过调用cv2.cuda模块中的函数来利用GPU 进行加速计算,从而更快地完成各种计算机视觉和图像处理任务。

cuda gdb源码编译

cuda gdb源码编译

要在CUDA中使用GDB进行源码调试,首先你需要安装CUDA工

具包和GDB。

然后,你需要确保你的代码是使用可调试选项编译的。

接下来,你需要使用nvcc编译器来编译你的CUDA源代码,同时使

用-g选项来生成调试信息。

这样可以确保GDB能够正确地识别和调

试你的CUDA程序。

接下来,你可以使用以下命令来编译你的CUDA程序:

shell.

nvcc -g -G source.cu -o executable.

这将会生成一个带有调试信息的可执行文件。

接下来,你可以

使用GDB来调试这个可执行文件。

你可以使用以下命令来启动GDB

调试:

shell.

gdb ./executable.

然后,你可以使用GDB的命令来设置断点,单步执行代码,查

看变量的值等等。

在CUDA程序中,你也可以使用GDB的CUDA扩展

来进行GPU核心级别的调试。

需要注意的是,CUDA和GDB的调试过程可能会比普通的C/C++

程序复杂一些,因为涉及到GPU和并行计算的特性。

因此,你可能

需要花一些时间来熟悉CUDA和GDB的调试技巧和命令。

总的来说,要在CUDA中使用GDB进行源码调试,你需要确保正

确地编译你的CUDA程序,并且熟悉GDB的基本用法以及CUDA特有

的调试技巧。

希望这些信息能够帮助到你进行CUDA程序的调试工作。

cuda 三维插值例子

CUDA(Compute Unified Device Architecture,计算统一设备架构)是由NVIDIA开发的并行计算平台和编程模型,用于利用GPU的强大并行计算能力加速各种计算任务。

三维插值是指在给定的离散数据点网格中,通过插值方法计算出非网格点的数值。

在CUDA中进行三维插值,可以利用GPU的并行计算能力快速完成计算。

以下是一个简单的三维插值的例子,使用CUDA进行计算:

假设我们有一个三维数据网格,包含了离散的数据点,并且我们希望在网格之外的位置进行插值计算。

我们可以使用三线性插值方法来计算非网格位置的数值。

1. 首先,我们将数据点数据加载到GPU的全局内存中,形成一维数组。

2. 创建一个CUDA的核函数,将该函数作为CUDA的计算单元,运行在GPU上的多个线程之间。

3. 在核函数中,每个线程负责计算一个非网格位置的数值。

可以通过线程的索引来计算该非网格位置对应的坐标。

4. 对于每个非网格位置,使用三线性插值方法,根据其在网格中的最近邻点,计算出插值结果。

这需要在核函数中进行插值计算的具体逻辑。

5. 将插值结果保存到结果数组中,可以将结果数组复制回主机内存,以获得最终的插值结果。

进行CUDA编程时,需要考虑数据的内存布局、线程之间的协作与同步、数据的访问模式等问题,以充分利用GPU的计算资源,并确保程序正确性。

10分钟学会OpenCVCUDA编程

10分钟学会OpenCVCUDA编程CUDA⽀持模块01OpenCV4⽀持通过GPU实现CUDA加速执⾏,实现对OpenCV图像处理程序的加速运⾏,当前⽀持加速的模块包括如下:图像背景分割视频编解码特征2D卷积滤波图像处理对象检测光流双⽬视觉基本上包含了OpenCV图像处理的主要功能,这⾥有⼀个地⽅需要特别注意,就是编译时候选择不同的CUDA版本,对上述模块的⽀持略微不同。

⽐如最新的CUDA10.0来说已经不⽀持级联检测器的加速啦。

要想利⽤GPU实现CUDA OpenCV加速,第⼀步当然是重新编译OpenCV源码实现对CUDA的⽀持,这个可以参考我之前发的⽂章OpenCV4 | 如何让传统图像处理实现三⼗倍加速的顶级技能收到⼤家的反馈,觉得视频⽐较好,所以⼜录制了⼀个OpenCV4 + CUDA加速编译与配置的视频教程,B站可以免费看:https:///video/av71643385代码演⽰教程02检测CUDA设备⽀持,代码如下:cuda::printCudaDeviceInfo(cuda::getDevice());int count = cuda::getCudaEnabledDeviceCount();printf("GPU Device Count : %d \n", count);运⾏截图:CUDA处理图像的时候,⾸先需要把Mat图像上载到CUDA数据单元GpuMat对象中去,然后调⽤CUDA⽀持的相关API进⾏处理,处理完成之后,再从GpuMat下载数据到原始Mat对象中,完成后续操作。

以图像灰度转换为例,代码演⽰如下:// 灰度转换Mat src_host = imread("D:/images/test.png");GpuMat src, gray;src.upload(src_host);cuda::cvtColor(src, gray, COLOR_BGR2GRAY);Mat gray_host;gray.download(gray_host);imshow("src", src_host);imshow("gray", gray_host);waitKey(0);效果演⽰如下:CUDA⽀持各种卷积处理,卷积处理⽀持盒⼦模糊、⾼斯模糊、图像梯度(Soble\Scharr)、⼆阶导数算⼦-拉普拉斯算⼦、以⾼斯模糊为例,代码演⽰如下:cv::Mat h_img1 = cv::imread("D:/images/test1.png");cv::cuda::GpuMat d_img1, d_result3x3, d_result5x5, d_result7x7;// 加载数据d_img1.upload(h_img1);// 创建⾼斯auto filter3x3 = cv::cuda::createGaussianFilter(CV_8UC3, CV_8UC3, cv::Size(3, 3), 5);auto filter5x5 = cv::cuda::createGaussianFilter(CV_8UC3, CV_8UC3, cv::Size(5, 5), 5);auto filter7x7 = cv::cuda::createGaussianFilter(CV_8UC3, CV_8UC3, cv::Size(7, 7), 5);// 执⾏filter3x3->apply(d_img1, d_result3x3);filter5x5->apply(d_img1, d_result5x5);filter7x7->apply(d_img1, d_result7x7);// 获取结果cv::Mat h_result3x3, h_result5x5, h_result7x7;d_result3x3.download(h_result3x3);d_result5x5.download(h_result5x5);d_result7x7.download(h_result7x7);// 显⽰cv::imshow("Original Image ", h_img1);cv::imshow("Blurred with kernel size 3x3", h_result3x3);cv::imshow("Blurred with kernel size 5x5", h_result5x5);cv::imshow("Blurred with kernel size 7x7", h_result7x7);waitKey(0);return;CUDA⽀持图像的⾓点检测,⽀持Harris与shi-tomas⾓点检测,以shi-tomas⾓点检测为例,代码演⽰如下:Mat src_host = imread("D:/images/building.png");imshow("input", src_host);GpuMat src, gray, corners;Mat dst;src.upload(src_host);cuda::cvtColor(src, gray, COLOR_BGR2GRAY);auto corner_detector = cuda::createGoodFeaturesToTrackDetector(gray.type(), 1000, 0.01, 15, 3);corner_detector->detect(gray, corners);corners.download(dst);printf("detected corners %d....\n", corners.cols);for (int i = 0; i < dst.cols; i++) {int r = rng.uniform(0, 255);int g = rng.uniform(0, 255);int b = rng.uniform(0, 255);Point2f pt = dst.at<Point2f>(0, i);circle(src_host, pt, 3, Scalar(b, g, r), 2, 8, 0);}imshow("corner detect", src_host);waitKey(0);return;效果显⽰如下:我们都知道OpenCV中的双边模糊是处理速度⽐较慢的边缘保留算法,但是它的CUDA版本完全可以做到实时运⾏⽆压⼒,在线美颜很轻松,代码演⽰如下:try {Mat src_host = imread("D:/images/example.png");imshow("input", src_host);GpuMat src(src_host);GpuMat dst;cuda::bilateralFilter(src, dst, 0, 100, 15, 4);Mat dst_host;dst.download(dst_host);imshow("result", dst_host);}catch (const Exception& ec) {std::cout << "Error" << ec.what() << std::endl;}waitKey(0);return;运⾏结果如下:CUDA还⽀持各种特征匹配,以ORB特征匹配为例,实现CUDA版本的特征匹配会⽐没有CUDA版本的速度快到10倍以上,基本也可以达到实时级别。

opencv编译cuda

opencv编译cuda由于CUDA的复杂性和C++的难度,从C++到CUDA的编译过程并不是一件容易的事情。

幸运的是,OpenCV是一个功能强大的计算机视觉库,可以帮助我们简化CUDA代码的编译过程。

在使用OpenCV之前,我们需要先安装CUDA。

我们可以从NVIDIA的官方网站下载CUDA安装程序,根据我们的系统版本选择适合的版本,然后按照安装程序的指导进行安装。

下载并安装完CUDA之后,我们可以编写一个简单的CUDA程序来演示如何使用OpenCV和CUDA之间的交互。

下面是一个简单的CUDA程序,用于在屏幕上绘制一个红色的CUDA数组:```#include<iostream>#include<cuda_runtime.h>using namespace std;__global__void kernel(int*d_array,int length){int index=blockIdx.x*blockDim.x*offsetInGrid;if(index<length){d_array[index]=1.0;}}int main(){int canvasWidth=800;int canvasHeight=600;//Create a new CUDA device and a contextint deviceId=(int)(0.5*(double)get_device_count()); CUDA_CALL(deviceId,cudaSetIndexMode(deviceId, CUDA_INDEX_MODE_BILINEAR));CUDA_CALL(deviceId,cudaCreateCUDAContext(deviceId));//Read an image from diskfloat*h=new float[canvasHeight];for(int i=0;i<canvasHeight;i++){h[i]=sin(i/20.0);}//Compile the kernel to run on the GPU__global__void kernel2(float*d_array,int length){int index=blockIdx.x*blockDim.x*offsetInGrid;if(index<length){d_array[index]=kernel(d_array,length)[index];}}//Initialize the CUDA device and contextCUDA_CALL(deviceId,cudaSetMem非常好的性(deviceId, CUDA_MEM_SET_Always));CUDA_CALL(deviceId,cudaMemcpyToSymbol(deviceId, CUDA_SYMBOL_POINT_IN_GRID,h,canvasHeight));//Set the block and grid sizesint blockSize=(int)((canvasWidth-2)/128);int numBlocks=(int)((canvasHeight-1)/128);//Compile the CUDA kernel to run on the GPUCUDA_CALL(deviceId,cudaMemcpyToSymbol(deviceId, CUDA_SYMBOL_KERNEL_TRANSPARENT,kernel2,sizeof(kernel2)), NULL);//Set the offset and block dimensions for the GPU kernel int offsetInGrid=0;int blockDimInGrid=1;//Run the CUDA kernelCUDA_CALL(deviceId,cudaLaunchKernel(deviceId, CUDA_KERNEL_POOL_DEFAULT,offsetInGrid,blockDimInGrid, blockSize,numBlocks),NULL);//Print the result on the screenfloat redPixel=0.0f;for(int i=0;i<canvasHeight;i++){for(int j=0;j<canvasWidth;j++){float pixelValue=(float)(sin(i/20.0)*0.8+(float)i/ 200.0);redPixel+=pixelValue;}}//Enable outputCUDA_CALL(deviceId,cudaEnableOutput(deviceId));//Print the final image on the screenfor(int i=0;i<canvasHeight;i++){for(int j=0;j<canvasWidth;j++){float pixelValue=(float)(sin(i/20.0)*0.8+(float)i/ 200.0);cout<<pixelValue<<"";}cout<<endl;}//Clean upCUDA_CALL(deviceId,cudaMemcpyToSymbol(deviceId, CUDA_SYMBOL_POINT_IN_GRID,h,canvasHeight));CUDA_CALL(deviceId,cudaMemcpyToSymbol(deviceId, CUDA_SYMBOL_KERNEL_TRANSPARENT,kernel2,sizeof(kernel2)), NULL);//Copy the memory back to the host memoryCUDA_CALL(deviceId,cudaMemcpyToSymbol(deviceId, CUDA_SYMBOL_COPY_BACKWARDS,h,canvasHeight));//Free the deviceCUDA_CALL(deviceId,cudaFree(deviceId));return0;}```OpenCV和CUDA之间的交互比直接使用C++编写的CUDA代码更为复杂。

python 指定openv cuda硬解码编译 及开发示例

python 指定openv cuda硬解码编译及开发示例在Python中,若要使用OpenCV库的CUDA硬解码功能,首先需确保OpenCV库在编译时已启用CUDA支持,并且你的机器上安装了兼容的NVIDIA显卡驱动和CUDA工具包。

编译OpenCV with CUDA支持下载OpenCV源代码:访问OpenCV的GitHub仓库,下载最新的源代码。

安装依赖项:安装CMake、NVIDIA CUDA Toolkit、NVIDIA Video Codec SDK(如果需要硬件加速视频编解码)以及其他必要的依赖项。

配置CMake:创建一个构建目录,并在该目录中运行CMake 来配置项目。

确保在CMake配置时启用CUDA和硬件解码选项。

bashmkdir build && cd buildcmake -D WITH_CUDA=ON -D ENABLE_FAST_MATH=1 -D CUDA_FAST_MATH=1 -D WITH_CUBLAS=1 -D WITH_NVCUVID=ON ..注意:-D WITH_NVCUVID=ON 是启用NVIDIA Video Codec SDK的关键选项,用于硬件解码。

如果不需要硬件编码,则无需额外配置。

编译OpenCV:使用make工具编译OpenCV。

bashmake -j$(nproc)sudo make install设置环境变量:确保OpenCV库和Python绑定正确安装,并且LD_LIBRARY_PATH环境变量包含OpenCV库的路径。

开发示例以下是一个使用OpenCV CUDA硬解码功能的Python示例。

注意,这只是一个概念性的示例,实际代码可能需要根据OpenCV 版本和API进行调整。

pythonimport cv2import cv2.cuda_codec as cuda_codec# 确保OpenCV是支持CUDA的版本if not cv2.cuda.getCudaEnabledDeviceCount():print("CUDA is not available.")exit()# 创建CUDA视频解码器decoder = cuda_codec.createVideoDecoder(cuda_codec.VideoReader_API_FF MPEG, 'path_to_video.mp4')# 获取视频流信息frame_size = (decoder.getWidth(), decoder.getHeight())stream = cuda_codec.VideoStream(decoder)# 循环解码视频帧while stream.more():# 解码一帧frame = stream.read()# 在这里处理解码后的帧,例如转换为灰度图像if frame is not None:frame_gray = cv2.cuda_cvtColor(frame, cv2.COLOR_BGR2GRAY)# 更多的处理...# 释放当前帧frame.release()# 释放视频流和解码器stream.release()decoder.release()请注意,上述代码中的cuda_codec模块和相关的函数可能在不同的OpenCV版本中有所不同。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

OpenCV环境下CUDA编程示例在CUDA平台上对图像算法进行并行加速是目前并行计算方面比较简单易行的一种方式,而同时利用OpenCV提供的一些库函数的话,那么事情将会变得更加easy。

以下是我个人采用的一种模板,这个模板是从OpenCV里的算法CUDA源码挖掘出来的,我感觉这个用起来比较傲方便,所以经常采用。

首先大牛们写的源码都很鲁棒,考虑的比较全面(如大部分算法将1,3,4通道的图像同时搞定),感觉还有一个比较神奇的地方在于CPU端GpuMat和GPU端PtrStepSzb的转换,让我欲罢不能,一个不太理想的地方在于第一帧的初始化时间比较长,应该是CPU到GPU的数据传输。

代码中有考虑流,但貌似没有使用。

我使用的是赵开勇的CUDA_VS_Wizard,主函数还是用的cu文件。

以下代码是对Vibe背景建模算法的并行,背景建模算法是目前接触到易于并行的一类,如GMM等,而且加速效果不错,因为一个线程执行的数据就是对应一个像素点。

代码如下:sample.cu[cpp] view plaincopy<spanstyle="font-size:14px;">/***************************** *************************************** * sample.cu * This is a example of the CUDA program.*************************************************** ******************/ #include <stdio.h> #include <stdlib.h> #include <cutil_inline.h> #include<iostream> #include <string> #include "opencv2/core/core.hpp" #include "opencv2/gpu/gpu.hpp"#include "opencv2/highgui/highgui.hpp" #include"Vibe_M_kernel.cu" #include "Vibe_M.h" using namespace std; using namespace cv; using namespace cv::gpu;enum Method { FGD_STAT, MOG,MOG2, VIBE, GMG }; int main(int argc, const char** argv) { cv::CommandLineParser cmd(argc, argv, "{ c | camera | flase | use camera }" "{ f | file | 768x576.avi | input video file }" "{ m | method | vibe | method (fgd, mog, mog2, vibe, gmg) }" "{ h | help | false | print help message }"); if (cmd.get<bool>("help")){ cout << "Usage : bgfg_segm [options]"<< endl; cout << "Avaible options:"<< endl; cmd.printParams(); return0; } bool useCamera =cmd.get<bool>("camera"); string file =cmd.get<string>("file"); string method =cmd.get<string>("method"); if (method != "fgd"&& method != "mog" && method != "mog2" && method != "vibe" && method != "gmg") { cerr << "Incorrect method" << endl; return -1; }Method m = method == "fgd" ? FGD_STAT : method == "mog" ? MOG : method == "mog2" ? MOG2 : method == "vibe" ? VIBE : GMG; VideoCapture cap; if (useCamera) cap.open(0); elsecap.open(file); if (!cap.isOpened()){ cerr << "can not open camera or video file" << endl; return -1; } Mat origin, frame; cap >> origin;cvtColor(origin,frame,CV_BGR2GRAY); GpuMatd_frame(frame); Vibe_M vibe; GpuMat d_fgmask; Mat fgmask; Mat fgimg; Mat bgimg;switch (m) { case VIBE:vibe.initialize(d_frame); break; } namedWindow("image", WINDOW_NORMAL);namedWindow("foreground mask", WINDOW_NORMAL); for(;;) { cap >> origin; if (origin.empty()) break;cvtColor(origin,frame,CV_BGR2GRAY);d_frame.upload(frame); //update the model switch (m) { case VIBE:vibe(d_frame, d_fgmask); break; } d_fgmask.download(fgmask); imshow("image", frame); imshow("foreground mask", fgmask);int key = waitKey(30); if (key == 27)break; else if(key == ' '){ cvWaitKey(0); } }exit(0); } </span> Vibe_M.cpp[cpp] view plaincopy<spanstyle="font-size:14px;">#include "Vibe_M.h" namespace cv { namespace gpu { namespace device{ namespace vibe_m { void loadConstants(int nbSamples, int reqMatches, int radius, int subsamplingFactor); void init_gpu(PtrStepSzb frame, int cn, PtrStepSzb samples, PtrStepSz<unsignedint> randStates, cudaStream_t stream); void update_gpu(PtrStepSzb frame, int cn, PtrStepSzb fgmask, PtrStepSzb samples, PtrStepSz<unsigned int> randStates, cudaStream_t stream); } }}} namespace{ const int defaultNbSamples = 20; const int defaultReqMatches = 2; const int defaultRadius = 20; const int defaultSubsamplingFactor = 16; }Vibe_M::Vibe_M(unsigned long rngSeed) : frameSize_(0, 0), rngSeed_(rngSeed) { nbSamples = defaultNbSamples; reqMatches = defaultReqMatches; radius = defaultRadius; subsamplingFactor = defaultSubsamplingFactor; } void Vibe_M::initialize(const GpuMat& firstFrame,Stream& s) { using namespacecv::gpu::device::vibe_m; CV_Assert(firstFrame.type() == CV_8UC1 || firstFrame.type() == CV_8UC3 || firstFrame.type() == CV_8UC4); //cudaStream_t stream = StreamAccessor::getStream(s);loadConstants(nbSamples, reqMatches, radius, subsamplingFactor); frameSize_ = firstFrame.size();if (randStates_.size() != frameSize_){ cv::RNG rng(rngSeed_); cv::Math_randStates(frameSize_, CV_8UC4);rng.fill(h_randStates, cv::RNG::UNIFORM, 0, 255); randStates_.upload(h_randStates); } int ch = firstFrame.channels(); int sample_ch = ch == 1 ? 1 : 4; samples_.create(nbSamples * frameSize_.height,frameSize_.width, CV_8UC(sample_ch));init_gpu(firstFrame, ch, samples_, randStates_, 0); } void Vibe_M::operator()(const GpuMat& frame, GpuMat& fgmask, Stream& s) { using namespacecv::gpu::device::vibe_m; CV_Assert(frame.depth() == CV_8U); int ch = frame.channels(); int sample_ch = ch == 1 ? 1 : 4; if (frame.size() != frameSize_ || sample_ch != samples_.channels())initialize(frame); fgmask.create(frameSize_,CV_8UC1); update_gpu(frame, ch, fgmask, samples_, randStates_, StreamAccessor::getStream(s)); } voidVibe_M::release() { frameSize_ = Size(0, 0); randStates_.release(); samples_.release(); }</span> Vibe_M.h[cpp] view plaincopy<spanstyle="font-size:14px;">#ifndef _VIBE_M_H_ #define_VIBE_M_H_ #ifndef SKIP_INCLUDES #include<vector> #include <memory> #include<iosfwd> #endif #include "opencv2/core/core.hpp"#include "opencv2/core/gpumat.hpp" #include"opencv2/gpu/gpu.hpp" #include"opencv2/imgproc/imgproc.hpp" #include"opencv2/objdetect/objdetect.hpp" #include"opencv2/features2d/features2d.hpp" using namespace std; using namespace cv; using namespace cv::gpu; class Vibe_M { public: //! the default constructorexplicit Vibe_M(unsigned long rngSeed = 1234567); //! re-initiaization method void initialize(constGpuMat& firstFrame, Stream& stream = Stream::Null()); //! the update operator void operator()(const GpuMat& frame, GpuMat& fgmask, Stream& stream = Stream::Null()); //! releases all inner buffers void release(); int nbSamples;// number of samples per pixel int reqMatches;// #_min int radius; // R int subsamplingFactor; // amount of random subsampling private: Size frameSize_; unsigned long rngSeed_; GpuMat randStates_; GpuMat samples_; };#endif</span> Vibe_M.cu[html] view plaincopy<spanstyle="font-size:14px;">#include "Vibe_M.h" #include "opencv2/gpu/stream_accessor.hpp" namespace cv{ namespace gpu { namespace device { namespace vibe_m { void loadConstants(int nbSamples, int reqMatches, int radius, int subsamplingFactor);void init_gpu(PtrStepSzb frame, int cn, PtrStepSzb samples, PtrStepSz<unsigned int> randStates, cudaStream_t stream); void update_gpu(PtrStepSzb frame, int cn, PtrStepSzb fgmask, PtrStepSzb samples, PtrStepSz<unsigned int> randStates, cudaStream_t stream); } }}} namespace{ const int defaultNbSamples = 20; const int defaultReqMatches = 2; const int defaultRadius = 20; const int defaultSubsamplingFactor = 16; }Vibe_M::Vibe_M(unsigned long rngSeed) : frameSize_(0, 0), rngSeed_(rngSeed) { nbSamples = defaultNbSamples; reqMatches = defaultReqMatches; radius = defaultRadius; subsamplingFactor = defaultSubsamplingFactor; } void Vibe_M::initialize(const GpuMat& firstFrame,Stream& s) { using namespacecv::gpu::device::vibe_m; CV_Assert(firstFrame.type() == CV_8UC1 || firstFrame.type() == CV_8UC3 || firstFrame.type() == CV_8UC4); cudaStream_t stream = cv::gpu::StreamAccessor::getStream(s);loadConstants(nbSamples, reqMatches, radius, subsamplingFactor); frameSize_ = firstFrame.size(); if (randStates_.size() != frameSize_){ cv::RNG rng(rngSeed_); cv::Math_randStates(frameSize_, CV_8UC4);rng.fill(h_randStates, cv::RNG::UNIFORM, 0, 255); randStates_.upload(h_randStates); } int ch = firstFrame.channels(); int sample_ch = ch == 1 ? 1 : 4; samples_.create(nbSamples * frameSize_.height,frameSize_.width, CV_8UC(sample_ch));init_gpu(firstFrame, ch, samples_, randStates_, stream); } void Vibe_M::operator()(const GpuMat& frame, GpuMat& fgmask, Stream& s) { using namespace cv::gpu::device::vibe_m;CV_Assert(frame.depth() == CV_8U); int ch = frame.channels(); int sample_ch = ch == 1 ? 1 : 4;if (frame.size() != frameSize_ || sample_ch !=samples_.channels()) initialize(frame);fgmask.create(frameSize_, CV_8UC1);update_gpu(frame, ch, fgmask, samples_, randStates_,cv::gpu::StreamAccessor::getStream(s)); } voidVibe_M::release() { frameSize_ = Size(0, 0); randStates_.release(); samples_.release(); }</span> Vibe_M_kernel.cu[cpp] view plaincopy<spanstyle="font-size:14px;">#include"opencv2/gpu/device/common.hpp" #include"opencv2/gpu/device/vec_math.hpp" namespace cv{ namespace gpu { namespace device { namespace vibe_m { __constant__ int c_nbSamples;__constant__ int c_reqMatches; __constant__ intc_radius; __constant__ int c_subsamplingFactor; void loadConstants(int nbSamples, int reqMatches, int radius, int subsamplingFactor){ cudaSafeCall( cudaMemcpyToSymbol(c_nbS amples, &nbSamples, sizeof(int)) );cudaSafeCall( cudaMemcpyToSymbol(c_reqMatches,&reqMatches, sizeof(int)) );cudaSafeCall( cudaMemcpyToSymbol(c_radius, &radius, sizeof(int)) );cudaSafeCall( cudaMemcpyToSymbol(c_subsamplingFactor,&subsamplingFactor, sizeof(int)) ); }__device__ __forceinline__ uint nextRand(uint& state) { //const unsigned int CV_RNG_COEFF = 4164903690U;//已经定义state = state *CV_RNG_COEFF + (state >> 16);return state; } __constant__ intc_xoff[9] = {-1, 0, 1, -1, 1, -1, 0, 1, 0};__constant__ int c_yoff[9] = {-1, -1, -1, 0, 0, 1, 1, 1, 0};__device__ __forceinline__ int2 chooseRandomNeighbor(int x, int y, uint& randState, int count = 8){ int idx = nextRand(randState) % count; return make_int2(x + c_xoff[idx], y + c_yoff[idx]); } __device__ __forceinline__ uchar cvt(uchar val){ return val; }__device__ __forceinline__ uchar4 cvt(const uchar3& val) { return make_uchar4(val.x, val.y, val.z,0); } __device__ __forceinline__ uchar4 cvt(const uchar4& val){ return val; }template <typename SrcT, typename SampleT>__global__ void init(const PtrStepSz<SrcT> frame, PtrStep<SampleT> samples, PtrStep<uint> randStates) { const int x = blockIdx.x * blockDim.x + threadIdx.x; const int y = blockIdx.y * blockDim.y + threadIdx.y;if (x >= frame.cols || y >= frame.rows)return; uint localState = randStates(y, x);for (int k = 0; k < c_nbSamples; ++k){ int2 np = chooseRandomNeighbor(x, y, localState, 9); np.x= ::max(0, ::min(np.x, frame.cols - 1));np.y = ::max(0, ::min(np.y, frame.rows - 1));SrcT pix = frame(np.y, np.x); samples(k * frame.rows + y, x) = cvt(pix); } randStates(y, x) = localState; }template <typename SrcT, typename SampleT>void init_caller(PtrStepSzb frame, PtrStepSzb samples, PtrStepSz<uint> randStates, cudaStream_t stream){ dim3 block(32, 8); dim3 grid(divUp(frame.cols, block.x), divUp(frame.rows, block.y)); cudaSafeCall( cudaFuncSetCacheConfig(init<SrcT,SampleT>, cudaFuncCachePreferL1) );init<SrcT, SampleT><<<grid, block, 0,stream>>>((PtrStepSz<SrcT>) frame, (PtrStepSz<SampleT>) samples, randStates); cudaSafeCall( cudaGetLastError() ); if (stream == 0)cudaSafeCall( cudaDeviceSynchronize() ); }void init_gpu(PtrStepSzb frame, int cn, PtrStepSzb samples, PtrStepSz<uint> randStates, cudaStream_t stream){ typedef void (*func_t)(PtrStepSzb frame, PtrStepSzb samples, PtrStepSz<uint> randStates, cudaStream_t stream); static const func_t funcs[] = { 0,init_caller<uchar, uchar>, 0, init_caller<uchar3, uchar4>, init_caller<uchar4,uchar4> };funcs[cn](frame, samples, randStates, stream); } __device__ __forceinline__ int calcDist(uchar a, uchar b) { return ::abs(a - b); }__device__ __forceinline__ int calcDist(const uchar3& a, const uchar4& b) { return (::abs(a.x - b.x) + ::abs(a.y - b.y) + ::abs(a.z - b.z)) /3; } __device__ __forceinline__ int calcDist(const uchar4& a, const uchar4& b){ return (::abs(a.x - b.x) + ::abs(a.y - b.y)+ ::abs(a.z - b.z)) / 3; } template<typename SrcT, typename SampleT>__global__ void update(const PtrStepSz<SrcT> frame, PtrStepb fgmask, PtrStep<SampleT> samples,PtrStep<uint> randStates){ const int x = blockIdx.x * blockDim.x + threadIdx.x; const int y = blockIdx.y * blockDim.y + threadIdx.y; if (x >= frame.cols || y >= frame.rows) return; uint localState = randStates(y, x); SrcT imgPix = frame(y, x); // comparison with the model int count = 0; for (int k = 0; (count < c_reqMatches) && (k <c_nbSamples); ++k){ SampleT samplePix = samples(k * frame.rows + y, x); int distance = calcDist(imgPix, samplePix); if (distance < c_radius)++count; } // pixelclassification according to reqMatchesfgmask(y, x) = (uchar) (-(count < c_reqMatches));//当count<2时,为前景当计数器count>=2时,为背景if (count >= c_reqMatches){ // the pixel belongs to the background// gets a random number between 0 and subsamplingFactor-1int randomNumber = nextRand(localState) %c_subsamplingFactor; // update of the current pixel model if (randomNumber == 0) { // random subsampling int k =nextRand(localState) % c_nbSamples;samples(k * frame.rows + y, x) =cvt(imgPix); } // update of a neighboring pixel modelrandomNumber = nextRand(localState) % c_subsamplingFactor; if (randomNumber == 0){ // random subsampling// chooses a neighboring pixel randomlyint2 np = chooseRandomNeighbor(x, y, localState);np.x = ::max(0, ::min(np.x, frame.cols - 1));np.y = ::max(0, ::min(np.y, frame.rows - 1));// chooses the value to be replaced randomlyint k = nextRand(localState) % c_nbSamples;samples(k * frame.rows + np.y, np.x) =cvt(imgPix); } } randStates(y, x) = localState; }template <typename SrcT, typename SampleT>void update_caller(PtrStepSzb frame, PtrStepSzb fgmask, PtrStepSzb samples, PtrStepSz<uint> randStates, cudaStream_t stream) { dim3 block(32, 8); dim3 grid(divUp(frame.cols, block.x), divUp(frame.rows, block.y));cudaSafeCall( cudaFuncSetCacheConfig(update<SrcT, SampleT>, cudaFuncCachePreferL1) );update<SrcT, SampleT><<<grid, block, 0, stream>>>((PtrStepSz<SrcT>) frame, fgmask, (PtrStepSz<SampleT>) samples, randStates); cudaSafeCall( cudaGetLastError() ); if (stream == 0)cudaSafeCall( cudaDeviceSynchronize() ); }void update_gpu(PtrStepSzb frame, int cn, PtrStepSzb fgmask, PtrStepSzb samples, PtrStepSz<uint> randStates, cudaStream_t stream) { typedefvoid (*func_t)(PtrStepSzb frame, PtrStepSzb fgmask, PtrStepSzb samples, PtrStepSz<uint> randStates, cudaStream_t stream); static const func_t funcs[] = { 0,update_caller<uchar, uchar>, 0, update_caller<uchar3, uchar4>, update_caller<uchar4,uchar4> };funcs[cn](frame, fgmask, samples, randStates,stream); } } }}} </span>。