数学建模 用幂法 和法 根法求特征值特征向量

幂法求特征值和特征向量

幂法求特征值和特征向量

幂法是一种用于求解特征值和特征向量的迭代算法。

它可以应用于任何具有特征值和特征向量的方阵,并且在实际应用中被广泛使用。

首先,我们需要了解什么是特征值和特征向量。

对于一个n阶方阵A,如果存在一个非零向量x,使得Ax = λx,其中λ是一个实数,那么λ称为A的特征值,x称为对应于特征值λ的特征向量。

幂法的基本思想是通过迭代过程得到一个向量序列,使得每一次迭代后的向量越来越接近于所需的特征向量。

具体步骤如下:

1. 选择一个非零向量b作为初始向量。

2. 迭代计算b的下一个近似向量b' = Ab,即将初始向量乘以

矩阵A。

3. 归一化向量b',即将b'除以其模长,得到新的向量b。

4. 重复步骤2和步骤3,直到向量b的变化趋于稳定。

在每次迭代过程中,向量b的模长会越来越接近于最大的特征值。

此外,向量b也收敛到与最大特征值对应的特征向量。

需要注意的是,幂法只能找到矩阵A的最大特征值和对应的特征向量。

如果需要找到其他特征值和特征向量,可以通过将矩阵A进行位移变换,使得所需的特征值成为矩阵A的最大特征值。

幂法的收敛速度取决于矩阵A的特征值的大小差异。

如果特征值之间的差异很大,那么幂法将很快收敛。

然而,如果特征值之间的差异很小,那么幂法的收敛速度将较慢。

总之,幂法是一种简单而有效的方法,用于求解矩阵的特征值和

特征向量。

它在很多实际问题中都得到了广泛的应用,例如在机器学习、信号处理和物理学等领域。

matlab幂法求特征值与特征向量 -回复

matlab幂法求特征值与特征向量-回复Matlab幂法求特征值与特征向量Matlab是一种常用的数学软件,它提供了一系列强大的数值计算工具和函数,旨在简化数学建模和计算的过程。

其中,求解特征值与特征向量是矩阵分析与线性代数中的重要问题之一。

在此,我们将介绍如何使用Matlab中的幂法来求解矩阵的特征值与特征向量。

特征值与特征向量是矩阵分析的基本概念。

给定一个矩阵A,如果存在一个非零向量x,使得Ax=λx,其中λ是一个实数,则称λ为A的特征值,x 为相应于特征值λ的特征向量。

在Matlab中,计算矩阵的特征值与特征向量可以使用`eig`函数。

这个函数能够计算矩阵所有特征值的值,其中特征值按照降序排列。

对于复杂特征值,这个函数会返回具有相应特征向量的V矩阵。

然而,幂法是一种迭代方法,可用于估计矩阵A的最大特征值λ和相应的特征向量x。

幂法的基本思想是利用矩阵的特征值分解性质中最大特征值的绝对值大于其他特征值的绝对值,从而将问题简化为求解最大特征值及其特征向量。

下面,我们将以以下步骤详细介绍如何使用Matlab中的幂法求解矩阵的特征值与特征向量:步骤1:定义初始向量x0首先定义一个非零的初始向量x0。

该向量可以是随机生成的,或者是具有合理初始值的向量。

步骤2:计算矩阵的迭代利用初始向量x0和矩阵A,计算下一个迭代向量x1。

具体而言,使用x0得到x1通过以下公式计算:x1 = A * x0步骤3:归一化迭代向量计算归一化的迭代向量x1。

这可以通过除以向量中的最大元素来完成。

归一化向量可以确保以后的计算产生可靠结果。

x1 = x1 / max(x1)步骤4:计算特征值估计计算特征值的估计值λ。

这可以通过计算x1的无穷范数与x0的无穷范数之比来实现:λ= norm(x1,Inf) / norm(x0,Inf)步骤5:收敛判断判断计算得到的特征值估计是否收敛。

这可以通过设定一个容差值来实现,在误差满足一定条件时停止迭代计算。

数值方法课程设计幂法反幂法计算矩阵特征值和特征向量-附Matlab程序

矩阵的特征值与特征向量的计算摘要物理,力学,工程技术中的很多问题在数学上都归结于求矩阵特征值的问题,例如振动问题(桥梁的振动,机械的振动,电磁振动等)、物理学中某些临界值的确定问题以及理论物理中的一些问题。

矩阵特征值的计算在矩阵计算中是一个很重要的部分,本文使用幂法和反幂法分别求矩阵的按模最大,按模最小特征向量及对应的特征值。

幂法是一种计算矩阵主特征值的一种迭代法,它最大的优点是方法简单,对于稀疏矩阵比较合适,但有时收敛速度很慢。

其基本思想是任取一个非零的初始向量。

由所求矩阵构造一向量序列。

再通过所构造的向量序列求出特征值和特征向量。

反幂法用来计算矩阵按模最小特征向量及其特征值,及计算对应于一个给定近似特征值的特征向量。

本文中主要使用反幂法计算一个矩阵的按模最小特征向量及其对应的特征值。

计算矩阵按模最小特征向量的基本思想是将其转化为求逆矩阵的按模最大特征向量。

然后通过这个按模最大的特征向量反推出原矩阵的按模最小特征向量。

关键词:矩阵;特征值;特征向量;冥法;反冥法THE CALCULATIONS OF EIGENVALUE AND EIGENVECTOR OF MATRIXABSTRACTPhysics, mechanics, engineering technology in a lot of problems in mathematics are attributed to matrix eigenvalue problem, such as vibration (vibration of the bridge, mechanical vibration, electromagnetic vibration, etc.) in physics, some critical values determine problems and theoretical physics in some of the problems. Matrix eigenvalue calculation is a very important part in matrix computation. In this paper, we use the power method and inverse power method to calculate the maximum of the matrix, according to the minimum characteristic vector and the corresponding characteristic value.Power method is an iterative method to calculate the eigenvalues of a matrix. It has the advantage that the method is simple and suitable for sparse matrices, but sometimes the convergence rate is very slow. The basic idea is to take a non - zero initial vector. Construct a vector sequence from the matrix of the matrix. Then the eigenvalues and eigenvectors are obtained by using the constructed vector sequence.The inverse power method is used to calculate the minimum feature vectors and their eigenvalues of the matrix, and to calculate the eigenvalues of the matrix. In this paper, we use the inverse power method to calculate the minimum eigenvalue of a matrix and its corresponding eigenvalues. The basic idea of calculating the minimum characteristic vector of a matrix is to transform it to the maximum characteristic vector of the modulus of the inverse matrix. Then, according to the model, the minimum feature vector of the original matrix is introduced.Key words: Matrix;Eigenvalue;Eigenvector;Iteration methods;目录1 引言 (1)2 相关定理。

数学建模作业及答案

数学建模作业姓名:叶勃学号:班级:024121一:层次分析法1、 分别用和法、根法、特征根法编程求判断矩阵1261/2141/61/41A ⎡⎤⎢⎥=⎢⎥⎢⎥⎣⎦11/2433217551/41/711/21/31/31/52111/31/5311A ⎡⎤⎢⎥⎢⎥⎢⎥=⎢⎥⎢⎥⎢⎥⎣⎦的特征根和特征向量(1)冪法求该矩阵的特征根和特征向量 程序为:#include<iostream> #include<math.h> using namespace std;#define n 3 //三阶矩阵#define N 20 #define err 0.0001 //幂法求特征值特征向量 void main(){cout<<"**********幂法求矩阵最大特征值及特征向量***********"<<endl; int i,j,k;double A[n][n],X[n],u,y[n],max;cout<<"请输入矩阵:\n"; for(i=0;i<n;i++) for(j=0;j<n;j++)cin>>A[i][j]; //输入矩阵 cout<<"请输入初始向量:\n"; for(i=0;i<n;i++)cin>>X[i]; //输入初始向量 k=1; u=0;while(1){ max=X[0]; for(i=0;i<n;i++) {if(max<X[i]) max=X[i]; //选择最大值 }for(i=0;i<n;i++)y[i]=X[i]/max; for(i=0;i<n;i++)X[i]=0;for(j=0;j<n;j++)X[i]+=A[i][j]*y[j]; //矩阵相乘}if(fabs(max-u)<err){cout<<"A的特征值是 :"<<endl; cout<<max<<endl; cout<<"A的特征向量为:"<<endl; for(i=0;i<n;i++) cout<<X[i]/(X[0]+X[1]+X[2])<<" ";cout<<endl;break;}else{if(k<N) {k=k+1;u=max;} else {cout<<"运行错误\n";break;}}} }程序结果为:(2)和法求矩阵最大特征值及特征向量程序为:#include<stdio.h>#include<iostream>#include<math.h> using namespace std;#define n 3 //三阶矩阵#define N 20void main(){int i,j,k;double A[n][n],w[n],M[n],u[n],W[n][n],max;cout<<"********和法求矩阵的特征根及特征向量*******"<<endl;cout<<"请输入矩阵:\n";for(i=0;i<n;i++)for(j=0;j<n;j++)cin>>A[i][j]; //输入矩阵 //计算每一列的元素和M[0]=0;M[1]=0;M[2]=0;for(i=0;i<n;i++)for(j=0;j<n;j++){M[i]+=A[j][i];}//将每一列向量归一化for(i=0;i<n;i++)for(j=0;j<n;j++){W[j][i]=A[j][i]/M[i];}//输出按列归一化之后的矩阵Wcout<<"按列归一化后的矩阵为:"<<endl;for(i=0;i<n;i++)for(j=0;j<n;j++){cout<<W[i][j]<<" ";if(j==2)cout<<endl;} //求特征向量w[0]=0;w[1]=0;w[2]=0;for(i=0;i<n;i++)for(j=0;j<n;j++){w[i]+=W[i][j];}cout<<"特征向量为:"<<endl; for(i=0;i<n;i++){u[i]=w[i]/(w[0]+w[1]+w[2]);cout<<u[i]<<" "<<endl;}//求最大特征值max=0;for(i=0;i<n;i++){w[i] = 0;for(j=0;j<n;j++){w[i] += A[i][j]*u[j];}}for(i = 0;i < n;i++){max += w[i]/u[i];}cout<<"最大特征根为:"<<endl;cout<<max/n<<endl; }运行结果为:(3)根法求矩阵最大特征值及特征向量:程序为:#include<stdio.h>#include<iostream>#include<math.h>using namespace std;#define n 3 //三阶矩阵#define N 20void main(){int i,j;double A[n][n],w[n],M[n],u[n],W[n][n],max;cout<<"********根法求矩阵的特征根及特征向量*******"<<endl; cout<<"请输入矩阵:\n";for(i=0;i<n;i++)for(j=0;j<n;j++)cin>>A[i][j]; //输入矩阵//计算每一列的元素和M[0]=0;M[1]=0;M[2]=0;for(i=0;i<n;i++)for(j=0;j<n;j++){M[i]+=A[j][i];}//将每一列向量归一化for(i=0;i<n;i++)for(j=0;j<n;j++){W[j][i]=A[j][i]/M[i];}//输出按列归一化之后的矩阵Wcout<<"按列归一化后的矩阵为:"<<endl;for(i=0;i<n;i++)for(j=0;j<n;j++){cout<<W[i][j]<<" ";if(j==2)cout<<endl;}//求特征向量//w[0]=A[0][0];w[1]=A[0][1];w[2]=A[0][2];w[0]=1;w[1]=1;w[2]=1;for(i=0;i<n;i++){for(j=0;j<n;j++){w[i]=w[i]*W[i][j];}w[i]=pow(w[i], 1.0/3);}cout<<"特征向量为:"<<endl;for(i=0;i<n;i++){u[i]=w[i]/(w[0]+w[1]+w[2]);cout<<u[i]<<" "<<endl;}//求最大特征值max=0;for(i=0;i<n;i++){w[i] = 0;for(j=0;j<n;j++){w[i] += A[i][j]*u[j];}}for(i = 0;i < n;i++){max += w[i]/u[i];}cout<<"最大特征值为:"<<endl; cout<<max/n;}运行结果为:2、编程验证n阶随机性一致性指标RI:运行结果:3、考虑景色、费用、居住、饮食、旅途五项准则,从桂林、黄山、北戴河三个旅游景点选择最佳的旅游地。

特征值和特征向量计算的数值方法

特征值和特征向量计算的数值方法在数学和计算机科学领域中,特征值和特征向量是非常重要的概念。

特征值和特征向量的计算有许多不同的数值方法,本文将介绍其中一些常见的数值方法,并分析它们的优劣和适用范围。

一、特征值和特征向量的定义在矩阵理论中,给定一个n×n的矩阵A,如果存在一个非零向量v和一个标量λ,使得Av=λv,那么称v为矩阵A的特征向量,λ为矩阵A的特征值。

特征值和特征向量的计算可以帮助我们理解矩阵的性质以及解决一些实际问题。

二、幂法幂法是计算特征值和特征向量的常用数值方法之一。

幂法的基本思想是通过多次迭代,逐渐逼近矩阵的特征值和特征向量。

具体操作如下:1. 初始化一个非零向量b0;2. 进行迭代计算:bi+1 = A * bi / ||A * bi||;3. 取出近似特征向量的最后一列:v = bn;4. 进行迭代计算特征值:λ = (Av)T * v / (vT * v)。

幂法的主要优点是简单易懂,且只需要进行矩阵向量乘法和内积计算。

然而,幂法仅能求取具有最大特征值的特征向量,而且对于存在多个特征值相等的情况并不适用。

三、反幂法反幂法是幂法的一种改进方法,用于求取矩阵A的最小特征值和对应的特征向量。

反幂法的基本步骤如下:1. 初始化一个非零向量b0;2. 进行迭代计算:bi+1 = (A - μI)^-1 * bi / ||(A - μI)^-1 * bi||;3. 取出近似特征向量的最后一列:v = bn;4. 进行迭代计算特征值:λ = (Av)T * v / (vT * v)。

反幂法的改进之处在于引入了矩阵的逆运算,通过使用矩阵A减去一个合适的常数μ乘以单位矩阵来实现。

反幂法适用于矩阵A的特征值接近于μ的情况。

四、QR方法QR方法也是一种常用的特征值计算方法,它适用于求解所有特征值以及对应的特征向量。

QR方法的基本思想是将一个矩阵分解为正交矩阵Q和上三角矩阵R的乘积,然后迭代地将矩阵A转化为更接近上三角形的形式。

特征值与特征向量矩阵特征值与特征向量的求解方法

特征值与特征向量矩阵特征值与特征向量的求解方法特征值和特征向量是线性代数中重要的概念,广泛应用于许多领域,如物理学、工程学和计算机科学等。

在本文中,我们将探讨特征值和特征向量的定义、求解方法及其在实际问题中的应用。

一、特征值与特征向量的定义特征值是一个矩阵所具有的与矩阵的线性变换性质有关的一个数值,特征向量是对应于特征值的非零向量。

对于一个n阶矩阵A,如果存在一个非零向量x和一个数λ,使得满足Ax=λx,那么λ就是矩阵A的一个特征值,x是对应于特征值λ的特征向量。

二、求解特征值与特征向量的方法有几种方法可以求解特征值和特征向量,其中比较常用的是特征多项式法和迭代法。

1. 特征多项式法特征多项式法是通过求解特征方程的根来得到特征值。

对于一个n阶矩阵A,其特征多项式定义为det(A-λI)=0,其中I是n阶单位矩阵,det表示行列式运算。

将特征多项式置为零,可以得到n个特征值λ1,λ2,...,λn。

将每个特征值代入原矩阵A-λI,解线性方程组(A-λI)x=0,就可以得到对应的特征向量。

2. 迭代法迭代法是通过不断迭代矩阵的特征向量逼近实际的特征向量。

常用的迭代方法包括幂法、反幂法和Rayleigh商迭代法。

幂法是通过不断迭代向量Ax的归一化来逼近特征向量,其基本原理是向量Ax趋近于特征向量。

反幂法是幂法的反向操作,通过求解(A-λI)y=x逼近特征向量y。

Rayleigh商迭代法是通过求解Rayleigh商的最大值来逼近特征向量,其中Rayleigh商定义为R(x)=x^T Ax/(x^T x),迭代公式为x(k+1)=(A-λ(k)I)^(-1)x(k),其中λ(k)为Rayleigh商的最大值。

三、特征值与特征向量的应用特征值与特征向量在实际问题中有广泛的应用。

其中,特征值可以用于判断矩阵是否可逆,当且仅当矩阵的所有特征值均不为零时,矩阵可逆。

特征向量可用于描述矩阵的稳定性和振动状态,如在结构工程中可以通过求解特征值和特征向量来分析物体的固有频率和振动模态。

求特征值和特征向量

求特征值和特征向量求特征值和特征向量是线性代数中的重要概念和操作。

在很多数学和工程问题中,需要通过求解特征值和特征向量来解决一系列相关的问题。

本文将详细介绍特征值和特征向量的定义、性质以及求解方法。

首先,我们来定义特征值和特征向量。

设A是一个n阶方阵。

如果存在一个非零向量x,使得Ax等于x的常数倍,即Ax=λx,其中λ是一个常数,那么我们称λ为矩阵A的一个特征值,x称为对应于特征值λ的特征向量。

特别地,如果λ是A的特征值,那么满足(A-λI)x=0的非零向量x称为属于特征值λ的零空间。

特征值和特征向量是矩阵A的一个固有性质,对于不同的特征值,对应的特征向量也是不同的。

接下来,我们来讨论特征值和特征向量的性质。

首先,特征值和特征向量一般是成对出现的,即对于矩阵A的一个特征值λ,一定存在对应的特征向量x。

特征向量的长度不影响其特征性质,即如果x 是特征向量,那么kx也是特征向量,其中k是一个非零常数。

特征值和特征向量具有重要的几何意义,特征向量决定了矩阵A的变换方向,特征值表示特定方向上的伸缩比例。

然后,我们来介绍求解特征值和特征向量的方法。

求解特征值和特征向量的常用方法有直接解特征方程和迭代法。

对于一个n阶矩阵A,要求解其特征值和特征向量,可以通过解特征方程det(A-λI)=0来得到特征值λ的值,其中I是n阶单位矩阵。

通过特征值,我们可以求出对应的特征向量。

特征向量的求解可以通过向量空间的方法,即解方程组(A-λI)x=0。

在实际计算中,我们可以利用数值计算软件来求解特征值和特征向量。

另外,对于特征值和特征向量的求解也可以通过迭代法来实现。

迭代法是一种基于数值计算的方法,通过迭代计算逼近矩阵的特征值和特征向量。

常见的迭代法有幂法、反幂法和QR方法。

幂法是一种基于逼近特征值和特征向量的迭代过程,通过不断迭代计算可以得到特征值和特征向量的逼近值。

反幂法和幂法类似,只是在每次迭代中求解矩阵的逆。

QR方法是一种通过矩阵的QR分解来求解特征值和特征向量的方法。

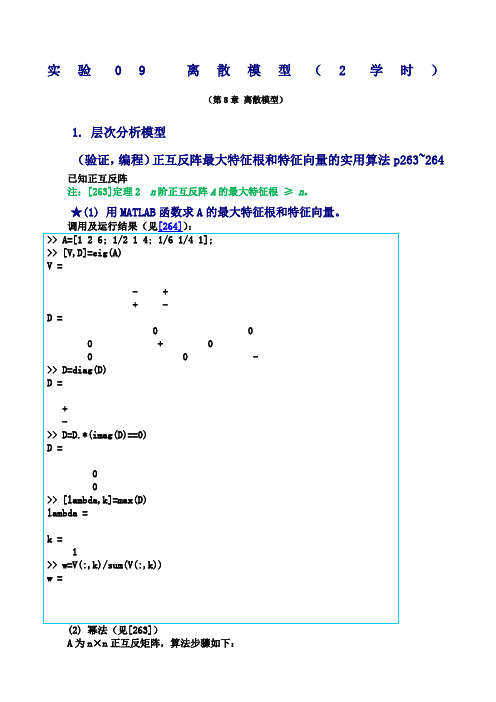

数学建模实验答案离散模型

实验09离散模型(2学时)(第8章离散模型)1. 层次分析模型(验证,编程)正互反阵最大特征根和特征向量的实用算法p263~264已知正互反阵注:[263]定理2 n阶正互反阵A的最大特征根≥n。

★(1) 用MATLAB函数求A的最大特征根和特征向量。

A为n×n正互反矩阵,算法步骤如下:a. 任取n 维非负归一化初始列向量(分量之和为1)(0)w ;b. 计算(1)(),0,1,2,k k wAw k +==%L ; c. (1)k w +%归一化,即令(1)(1)(1)1k k n k ii ww w+++==∑%%; d. 对于预先给定的精度ε,当(1)()||(1,2,,)k k i i w w i n ε+-<=L 时,(1)k w +即为所求的特征向量;否则返回到步骤b ;e. 计算最大特征根(1)()11k n i k i i w n w λ+==∑%。

注:☆(2) 用幂法函数求A 的最大特征根和特征向量。

A 为n×n 正互反矩阵,算法步骤如下:a. 将A 的每一列向量归一化得∑==n i ijij ij a a w 1~;b. 对ijw ~按行求和得∑==nj ij i w w 1~~; c. 将i w ~归一化T n n i i i i w w w w ww w ),,,(,~~211Λ==∑=即为近似特征向量;d. 计算∑==n i ii w Aw n 1)(1λ,作为最大特征根的近似值。

☆(3) 用和法函数求A 的最大特征根和特征向量。

根法(见[264])A 为n×n 正互反矩阵,算法步骤如下:a. 将A 的每一列向量归一化得∑==n i ijij ij a a w 1~; b. 对ijw ~按行求积并开n 次方得∏==n j nij i w w 11)~(~; c. 将i w ~归一化T n n i ii i w w w w w w w ),,,(,~~211Λ==∑=即为近似特征向量;d. 计算∑==n i ii w Aw n 1)(1λ,作为最大特征根的近似值。

用幂法求解矩阵特征值和特征向量

x= -0.3930 -0.9774 0.2921 1.0000 第五题 A=[-1 2 1; 2 -4 1; 1 1 -6 ]; v0=[1 1 1]'; tol=1e-4; [lda,x]=mifa(A,v0,tol) lda = -6.4209

第4页

数值分析实验指导

x= -0.0463 -0.3746 000

( 1, 0, 1, 0, 0, 1 )T 105

1 21.30525 6 1.62139 x1 0.8724,0.5401,0.9973,0.5644,0.4972,1.0 T

第1页

数值分析实验指导

2 1 1 2 1 (3) A= 1 2 1 1 2 1 1 2 T 0 104 取 =( 1, 1, 1, 1, 1 ) 参考结果: 3.7321 3 4 2 1 1 3 1 5 (4) A= 3 1 6 2 4 5 2 1 T 2 取 0 =( 1, 1, 1, 1 ) , 10 。

第3页

数值分析实验指导

x= 0.5000 -0.8660 1.0000 -0.8660 0.5000 第四题 A=[2 1 3 4; 1 -3 1 5; 3 1 6 -2; 4 5 -2 -1 ]; v0=[1 1 1 1]'; tol=1e-2; [lda,x]=mifa(A,v0,tol) lda = -8.0136

下面再考虑主特征值 1 的的计算,用 (vk )i 表示 vk 的第 i 个分量,则

( x ) ( k 1 )i (vk 1 )i 1 1 1 i , (vk )i 1 ( x1 )i ( k )i

故

特征向量和特征值的求法

特征向量和特征值的求法在线性代数中,特征向量和特征值是非常重要的概念。

它们在矩阵的分析和应用中有着广泛的应用。

本文将介绍特征向量和特征值的定义、求法以及它们的应用。

特征向量和特征值的定义对于一个n阶方阵A,如果存在一个非零向量x,使得Ax=kx,其中k为一个常数,那么x就是A的一个特征向量,k就是A的对应的特征值。

特征向量和特征值是成对出现的,一个特征向量对应一个特征值。

特征向量和特征值的求法求解特征向量和特征值的方法有很多种,下面介绍两种常用的方法。

方法一:特征多项式法对于一个n阶方阵A,其特征多项式为f(λ)=|A-λI|,其中I为n阶单位矩阵。

求解特征值就是求解f(λ)=0的根。

求解特征向量就是将特征值代入(A-λI)x=0中,解出x。

方法二:幂法幂法是一种迭代方法,用于求解矩阵的最大特征值和对应的特征向量。

具体步骤如下:1. 任意选择一个非零向量x0作为初始向量。

2. 迭代计算xk+1=Axk/||Axk||,其中||Axk||为Axk的模长。

3. 当xk+1与xk的差距小于某个阈值时,停止迭代。

此时xk+1就是A的最大特征值对应的特征向量。

特征向量和特征值的应用特征向量和特征值在矩阵的分析和应用中有着广泛的应用。

下面介绍几个常见的应用。

1. 矩阵的对角化对于一个n阶方阵A,如果存在n个线性无关的特征向量,那么A 可以对角化,即存在一个对角矩阵D和一个可逆矩阵P,使得A=PDP^-1。

对角化后的矩阵D的对角线上的元素就是A的特征值。

2. 矩阵的相似性如果存在一个可逆矩阵P,使得A=PBP^-1,那么A和B是相似的。

相似的矩阵具有相同的特征值,但不一定具有相同的特征向量。

3. 矩阵的谱半径矩阵的谱半径是指矩阵的所有特征值的模长的最大值。

谱半径在控制论、信号处理等领域有着广泛的应用。

总结本文介绍了特征向量和特征值的定义、求法以及应用。

特征向量和特征值在矩阵的分析和应用中有着广泛的应用,掌握它们的求法和应用可以帮助我们更好地理解和应用线性代数的知识。

matlab幂法求特征值和特征向量方法实现和函数表示

matlab幂法求特征值和特征向量方法实现和函数表示1. 引言在数值分析中,求解特征值和特征向量是一项重要而且经常出现的任务。

特征值和特征向量在矩阵和线性代数中有着广泛的应用,涉及到许多领域,如机器学习、信号处理、结构动力学等。

在matlab中,幂法是一种常用的求解特征值和特征向量的方法,同时也有对应的函数可以实现这一过程。

2. 幂法的原理幂法是一种迭代方法,它利用矩阵的特征值和特征向量的性质,通过不断地迭代计算,逼近矩阵的主特征值和对应的特征向量。

具体来说,假设A是一个n阶矩阵,它的特征值λ1>λ2≥...≥λn,并且对应着线性无关的特征向量v1,v2,...,vn。

如果选择一个任意的非零初始向量x0,并进行以下迭代计算:```x(k+1) = Ax(k) / ||Ax(k)||```其中,||.||表示向量的模长。

不断迭代计算后,x(k)将收敛到矩阵A的主特征向量v1上,并且相应的特征值即为A的主特征值λ1。

3. matlab实现幂法求解特征值和特征向量在matlab中,幂法的实现也非常简单。

可以使用自带的eig函数,该函数可以直接求解矩阵的特征值和特征向量。

使用方法如下:```[V,D] = eig(A)```其中,A为待求解的矩阵,V为特征向量矩阵,D为特征值矩阵。

利用eig函数,即可一步到位地求解矩阵的特征值和特征向量,非常简单方便。

4. 函数表示幂法求解特征值和特征向量的过程可以表示为一个matlab函数。

通过封装相关的迭代算法和收敛判据,可以方便地实现幂法的函数表示。

可以定义一个名为powerMethod的函数:```matlabfunction [lambda, v] = powerMethod(A, x0, maxIter, tol)% 初始化k = 1;x = x0;% 迭代计算while k <= maxItery = A * x;lambda = norm(y, inf);x = y / lambda;% 检查收敛性if norm(A * x - lambda * x) < tolbreak;endk = k + 1;endv = x;end```利用这个函数,就可以自己实现幂法求解特征值和特征向量的过程。

幂法求特征值和特征向量例题

幂法求特征值和特征向量例题

幂法是一种用于估计矩阵的最大特征值和对应的特征向量的迭代方法。

它是一种迭代方法,通过不断地对向量进行矩阵乘法和归一化来逼近最大特征值和特征向量。

下面我将通过一个例题来说明幂法求特征值和特征向量的过程。

假设我们有一个矩阵A,我们希望通过幂法来求解其最大特征值和对应的特征向量。

首先,我们需要选择一个初始向量x(0),通常选择一个非零向量作为初始向量。

然后,我们通过以下迭代过程来逼近最大特征值和特征向量:

1. 计算向量y(k) = Ax(k),其中A是矩阵A,x(k)是第k次迭代得到的向量。

2. 计算新的向量x(k+1) = y(k) / ||y(k)||,其中||y(k)||表示向量y(k)的范数。

重复以上步骤直到满足收敛条件,通常是当x(k+1)与x(k)的差别很小或者达到预先设定的迭代次数。

举个例子,假设我们有如下矩阵A:

A = [3, 1]

[1, 2]

我们选择初始向量x(0) = [1, 1]。

然后按照上述步骤进行迭代计算,直到满足收敛条件。

经过多次迭代计算,我们最终得到收敛的特征向量和特征值,它们分别是矩阵A的最大特征值和对应的特征向量。

这就是使用幂法来求解特征值和特征向量的基本过程。

需要注意的是,幂法只能用来求解最大特征值和对应的特征向量,对于其他特征值和特征向量需要使用其他方法来求解。

matlab用规范化乘幂法求以下矩阵的按模最大特征值及其特征向量

matlab用规范化乘幂法求以下矩阵的按模最大特征值及其特征向量竭诚为您提供优质文档/双击可除matlab用规范化乘幂法求以下矩阵的按模最大特征值及其特征向量篇一:幂法,反幂法求解矩阵最大最小特征值及其对应的特征向量数值计算解矩阵的按模最大最小特征值及对应的特征向量一.幂法1.幂法简介:当矩阵a满足一定条件时,在工程中可用幂法计算其主特征值(按模最大)及其特征向量。

矩阵a需要满足的条件为:(1)|1||2|...|n|0,i为a的特征值xn(2)存在n个线性无关的特征向量,设为x1,x2,...,1.1计算过程:n对任意向量x,有x(0)(0)iui,i不全为0,则有i1x(k1)ax(k)...ak1x(0)aαiuiαiλik1uik1i1i1nnnk12k1λ1u1()a2u2()anun11k111u1k112|越小时,收敛越快;且当k充分大时,有可见,当|1 (k1)k111u1x(k1)x(k1)(k)x1(k),对应的特征向量即是。

kxx11u1 2算法实现(1).输入矩阵a,初始向量x,误差限,最大迭代次数n(2).k1,0;y(k)x(k)max(abs(x(k))(3).计算xay,max(x);(4).若||,输出,y,否则,转(5)(5).若kn,置kk1,,转3,否则输出失败信息,停机.3matlab程序代码function[t,y]=lpowera,x0,eps,n)%t为所求特征值,y 是对应特征向量k=1;z=0;%z相当于y=x0./max(abs(x0));%规范化初始向量x=a*y;%迭代格式b=max(x);%b相当于ifabs(z-b) t=max(x);return;endwhileabs(z-b)>epsz=b;y=x./max(abs(x));x=a*y;b=max(x);end[m,index]=max(a(matlab用规范化乘幂法求以下矩阵的按模最大特征值及其特征向量)bs(x));%这两步保证取出来的按模最大特征值t=x(index);%是原值,而非其绝对值。

数值代数中的特征值计算算法

数值代数中的特征值计算算法在数值代数中,特征值计算是一项重要的任务,它在很多领域中都有广泛的应用,如物理学、工程学和计算机科学等。

特征值计算的目标是找到一个方阵的特征值以及对应的特征向量。

在本文中,我们将介绍几种常用的特征值计算算法,并对它们进行比较和评估。

一、幂法幂法是一种最简单且最常用的特征值计算算法之一。

它的基本思想是通过迭代过程逐渐逼近矩阵的最大特征值。

具体步骤如下:1. 初始化一个非零向量x,并对其进行归一化。

2. 计算矩阵A与向量x的乘积Ax。

3. 更新向量x为Ax,并进行归一化。

4. 重复步骤2和3,直到收敛或达到预设的迭代次数。

幂法的收敛条件是向量x的变化趋于稳定,即x的模长变化小于设定的阈值。

该算法的缺点是对于矩阵存在多个特征值的情况,只能收敛到模长最大的特征值对应的特征向量。

二、反幂法反幂法是幂法的一个变种,它用于计算矩阵的最小特征值。

相比于幂法,反幂法的迭代过程中需要对矩阵A的逆进行操作。

具体步骤如下:1. 初始化一个非零向量x,并对其进行归一化。

2. 计算矩阵A的逆与向量x的乘积A^(-1)x。

3. 更新向量x为A^(-1)x,并进行归一化。

4. 重复步骤2和3,直到收敛或达到预设的迭代次数。

与幂法类似,反幂法的收敛条件也是向量x的变化趋于稳定。

反幂法常用于计算矩阵的最小特征值,但对于特征值过接近零的情况,该算法可能会发散。

三、QR算法QR算法是一种迭代算法,用于计算一个方阵的特征值。

其基本思想是通过相似变换将方阵转化为上三角矩阵,从而容易求解特征值。

具体步骤如下:1. 初始化矩阵A为原始方阵。

2. 对矩阵A进行QR分解,得到矩阵Q和上三角矩阵R。

3. 计算矩阵R与Q的乘积QR。

4. 更新矩阵A为QR,并重复步骤2和3。

5. 当矩阵A的对角线元素收敛时,这些元素就是矩阵A的特征值。

QR算法的优点是适用于一般的方阵,并且通常具有较快的收敛速度。

但对于特征值重复且接近的情况,QR算法可能会产生不稳定的结果。

求解特征值矩阵的技巧

求解特征值矩阵的技巧特征值矩阵是线性代数中重要的概念,它在许多领域中都有广泛的应用,如物理、工程、计算机科学等。

解特征值矩阵的问题是线性代数中一个经典且基础的问题,下面将介绍几种常用的求解特征值矩阵的技巧。

1. 特征值与特征向量的定义特征值矩阵是指满足 Ax = λx 的特征向量x和特征值λ的矩阵A。

其中,A是一个n×n的矩阵,x是一个n维非零向量,λ是一个标量。

2. 计算特征值的方法求解特征值的方法有很多种,常见的方法包括特征值分解法、幂法和QR分解法。

2.1 特征值分解法特征值分解是一种常用的求解特征值的方法。

对于一个n×n的矩阵A,可以将其分解为 A = PDP^(-1) 的形式,其中P是一个由特征向量组成的矩阵,D是一个对角矩阵,对角线上的元素是矩阵A的特征值。

2.2 幂法幂法是一种迭代方法,用于求解特征值问题。

它通过不断迭代矩阵A乘以一个向量,并取结果向量的模长作为特征值的估计值。

具体步骤如下:- 选择一个n维随机向量x(0)。

- 标准化向量x(0),即令x(0) = x(0)/||x(0)||,其中||x(0)||表示x(0)的模长。

- 迭代计算,直到收敛:1. 计算向量y(k) = Ax(k)。

2. 计算特征值的估计值λ(k) = (y(k))^T x(k)。

3. 标准化向量x(k+1) = y(k)/||y(k)||。

2.3 QR分解法QR分解是一种将矩阵分解为正交矩阵Q和上三角矩阵R的方法。

它可以用于求解特征值问题。

具体步骤如下:- 对矩阵A进行QR分解,得到A = QR。

- 迭代计算:1. 计算矩阵A(k) = R(k)Q(k),其中A(k)是矩阵A的第k次迭代结果。

2. 将矩阵A(k)分解为QR,得到A(k) = Q(k+1)R(k+1)。

3. 重复步骤1和2,直到满足收敛条件。

3. 求解特征向量的方法对于已知的特征值,可以通过一些方法求解对应的特征向量,如幂法、反幂法和QR分解法。

幂法求矩阵A按模最大的特征值及其特征向量

幂法求矩阵A按模最大的特征值及其特征向量幂法(Power Method)是一种求解矩阵特征值的迭代算法,在数值线性代数中被广泛使用。

它利用矩阵的特征向量的特性,通过迭代过程逼近矩阵按模最大的特征值及其对应的特征向量。

假设我们要求解一个n阶矩阵A的按模最大的特征值及其特征向量,其中特征值的绝对值最大,特征向量对应的是这个特征值。

我们设矩阵A的特征值为λ,对应的特征向量为x。

幂法的基本思想是:通过连续的矩阵向量乘法,不断迭代一个向量,使其逼近于x。

迭代过程中,向量的每个元素都会趋近于特征向量对应的分量,最终收敛到x。

下面是幂法的具体步骤:1.选择一个初始向量b0,可以是任意向量,但最好与特征向量接近。

2.进行迭代过程,直到满足终止条件:a) 计算向量bn(第n次迭代):bn = Abn-1b) 计算归一化因子:cn = ,bn,(向量bn的欧几里得范数)c) 归一化向量:xn = bn / cn(将向量bn除以归一化因子,得到归一化向量)3. 判断是否满足收敛要求,如果满足,算法终止,特征值λ的近似值为λ≈cn,特征向量x的近似值为x≈xn。

接下来,我们通过一个数值示例来说明幂法的计算过程。

假设有以下3x3矩阵A:A=[0.80.30.2]0.10.70.40.10.00.5我们将使用幂法来计算矩阵的按模最大的特征值及其特征向量。

步骤1:选择初始向量b0。

我们选择初始向量为b0=[1,1,1],即x 的两个分量值为1步骤2:进行迭代过程。

a)计算向量b1:b1=Ab0b1=[0.8*1+0.3*1+0.2*1,0.1*1+0.7*1+0.4*1,0.1*1+0.0*1+0.5*1] =[1.3,1.9,0.6]b)计算归一化因子c1:c1=,b1,=√(1.3^2+1.9^2+0.6^2)≈2.498c)归一化向量:x1=b1/c1x1=[1.3/2.498,1.9/2.498,0.6/2.498]=[0.520,0.760,0.240]步骤3:判断是否满足收敛要求。

求矩阵特征向量的三种方法数学专业

求矩阵特征向量的三种方法数学专业求矩阵的特征向量是线性代数中的一个重要问题。

特征向量是指矩阵在线性变换下只发生缩放的向量,即满足Av=λv,其中A是矩阵,v是特征向量,λ是对应的特征值。

本文将介绍三种常用的求解矩阵特征向量的方法:特征方程法、幂法和雅可比迭代法。

一、特征方程法特征方程法是一种常用的求解矩阵特征向量的方法。

它的基本思想是通过求解特征方程来得到矩阵的特征值和特征向量。

对于一个 n 阶方阵 A,假设λ 是其特征值,v 是对应的特征向量。

由特征向量的定义可得Av = λv,也即 (A-λI)v = 0,其中 I 是单位矩阵。

由于 v 不为零向量,所以 (A-λI) 的行列式为零,即 det(A-λI) = 0。

因此,首先我们需要求解特征方程 det(A-λI) = 0,得到矩阵的特征值λ1, λ2, ..., λn。

接下来,我们需要求解每个特征值对应的特征向量。

对于每个特征值λi,我们需要求解方程组(A-λiI)v=0。

通过高斯消元法或其他求解线性方程组的方法,可以求得特征值对应的特征向量。

需要注意的是,矩阵A的特征值一共有n个,但是通过求解特征方程得到的特征值可能有重复或复数特征值。

为了得到n个线性无关的特征向量,需要用其他方法进行补充。

二、幂法幂法是一种迭代方法,用于求解矩阵的主特征向量(即对应最大特征值的特征向量)。

它的基本思想是通过迭代过程逼近主特征向量。

假设A是一个n阶方阵,对于任意初始向量x(0),迭代过程为x(k+1)=Ax(k),其中x(k)是第k次迭代得到的向量。

那么当k趋近于无穷大时,x(k)会收敛到主特征向量v1,即Av1=λ1v1,其中λ1是最大特征值。

为了实现幂法,我们需要选择一个合适的初始向量x(0)。

通常可以选择一个随机向量作为初始向量,然后进行迭代过程,直至收敛。

在每次迭代中,需要对x(k)进行归一化处理,以避免其模长趋于无穷大。

归一化可以通过将x(k)除以其模长实现。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

数学建模作业

计算机学院信计1102班姜圣涛

(1)幂法求矩阵最大特征值及特征向量:

程序为:

#include<iostream>

#include<math.h>

using namespace std;

#define n 3 //三阶矩阵

#define N 20

#define err 0.0001

//幂法求特征值特征向量

void main(){

cout<<"**********幂法求矩阵最大特征值及特征向量***********"<<endl; int i,j,k;

double A[n][n],X[n],u,y[n],max;

cout<<"请输入矩阵:\n";

for(i=0;i<n;i++)

for(j=0;j<n;j++)

cin>>A[i][j]; //输入矩阵

cout<<"请输入初始向量:\n";

for(i=0;i<n;i++)

cin>>X[i]; //输入初始向量

k=1;

u=0;

while(1){

max=X[0];

for(i=0;i<n;i++)

{

if(max<X[i]) max=X[i]; //选择最大值 }

for(i=0;i<n;i++)

y[i]=X[i]/max;

for(i=0;i<n;i++)

{

X[i]=0;

for(j=0;j<n;j++)

X[i]+=A[i][j]*y[j]; //矩阵相乘}

if(fabs(max-u)<err)

{

cout<<"A的特征值是 :"<<endl;

cout<<max<<endl;

cout<<"A的特征向量为:"<<endl;

for(i=0;i<n;i++)

cout<<X[i]/(X[0]+X[1]+X[2])<<" ";

cout<<endl;

break;

}

else

{

if(k<N) {k=k+1;u=max;}

else {

cout<<"运行错误\n";

break;

}

}

}

}

程序结果为:

(2)和法求矩阵最大特征值及特征向量

程序为:

#include<stdio.h>

#include<iostream>

#include<math.h>

using namespace std;

#define n 3 //三阶矩阵#define N 20

void main(){

int i,j,k;

double A[n][n],w[n],M[n],u[n],W[n][n],max;

cout<<"********和法求矩阵的特征根及特征向量*******"<<endl; cout<<"请输入矩阵:\n";

for(i=0;i<n;i++)

for(j=0;j<n;j++)

cin>>A[i][j]; //输入矩阵

//计算每一列的元素和

M[0]=0;M[1]=0;M[2]=0;

for(i=0;i<n;i++)

for(j=0;j<n;j++)

{

M[i]+=A[j][i];

}

//将每一列向量归一化

for(i=0;i<n;i++)

for(j=0;j<n;j++)

{

W[j][i]=A[j][i]/M[i];

}

//输出按列归一化之后的矩阵W

cout<<"按列归一化后的矩阵为:"<<endl;

for(i=0;i<n;i++)

for(j=0;j<n;j++)

{

cout<<W[i][j]<<" ";

if(j==2)

cout<<endl;

}

//求特征向量

w[0]=0;w[1]=0;w[2]=0;

for(i=0;i<n;i++)

for(j=0;j<n;j++)

{

w[i]+=W[i][j];

}

cout<<"特征向量为:"<<endl;

for(i=0;i<n;i++)

{

u[i]=w[i]/(w[0]+w[1]+w[2]); cout<<u[i]<<" "<<endl;

}

//求最大特征值

max=0;

for(i=0;i<n;i++)

{

w[i] = 0;

for(j=0;j<n;j++)

{

w[i] += A[i][j]*u[j];

}

}

for(i = 0;i < n;i++)

{

max += w[i]/u[i];

}

cout<<"最大特征根为:"<<endl;

cout<<max/n<<endl;

}

运行结果为:

(3)根法求矩阵最大特征值及特征向量:

程序为:

#include<stdio.h>

#include<iostream>

#include<math.h>

using namespace std;

#define n 3 //三阶矩阵

#define N 20

void main(){

int i,j;

double A[n][n],w[n],M[n],u[n],W[n][n],max;

cout<<"********根法求矩阵的特征根及特征向量*******"<<endl; cout<<"请输入矩阵:\n";

for(i=0;i<n;i++)

for(j=0;j<n;j++)

cin>>A[i][j]; //输入矩阵

//计算每一列的元素和

M[0]=0;M[1]=0;M[2]=0;

for(i=0;i<n;i++)

for(j=0;j<n;j++)

{

M[i]+=A[j][i];

}

//将每一列向量归一化

for(i=0;i<n;i++)

for(j=0;j<n;j++)

{

W[j][i]=A[j][i]/M[i];

}

//输出按列归一化之后的矩阵W

cout<<"按列归一化后的矩阵为:"<<endl;

for(i=0;i<n;i++)

for(j=0;j<n;j++)

{

cout<<W[i][j]<<" ";

if(j==2)

cout<<endl;

}

//求特征向量

//w[0]=A[0][0];w[1]=A[0][1];w[2]=A[0][2]; w[0]=1;w[1]=1;w[2]=1;

for(i=0;i<n;i++) {

for(j=0;j<n;j++)

{

w[i]=w[i]*W[i][j];

}

w[i]=pow(w[i], 1.0/3);

}

cout<<"特征向量为:"<<endl;

for(i=0;i<n;i++)

{

u[i]=w[i]/(w[0]+w[1]+w[2]); cout<<u[i]<<" "<<endl;

}

//求最大特征值

max=0;

for(i=0;i<n;i++)

{

w[i] = 0;

for(j=0;j<n;j++)

{

w[i] += A[i][j]*u[j];

}

}

for(i = 0;i < n;i++)

{

max += w[i]/u[i];

}

cout<<"最大特征值为:"<<endl; cout<<max/n;

}

运行结果为:。