卷积神经网络n代码解析

简述卷积神经网络(CNN)和循环神经网络(RNN)的原理及应用场景

简述卷积神经网络(CNN)和循环神经网络(RNN)的原理及应用场景卷积神经网络(CNN)和循环神经网络(RNN)是当前深度学习领域最为重要和广泛应用的两种神经网络模型。

它们分别在计算机视觉和自然语言处理等领域取得了巨大的成功。

本文将从原理和应用场景两个方面进行详细介绍。

一、卷积神经网络(CNN)的原理及应用场景卷积神经网络(CNN)是一种专门用于处理具有网格结构数据的深度学习模型。

它最初是为了解决计算机视觉中的图像分类问题而提出的,但现在已经广泛应用于图像识别、目标检测、语义分割等多个领域。

1.1 原理卷积神经网络(CNN)主要由卷积层、池化层和全连接层组成。

其中,卷积层是CNN最重要的组成部分,它通过一系列滤波器对输入数据进行特征提取。

滤波器通过与输入数据进行点乘操作,得到特征图(feature map),从而捕捉到输入数据中的局部特征。

池化层用于减小特征图的尺寸,并保留重要特征。

常见的池化操作有最大池化和平均池化。

最大池化选择每个区域中的最大值作为输出,平均池化则选择每个区域的平均值作为输出。

这样可以减小特征图的尺寸,减少参数数量,从而降低计算复杂度。

全连接层将特征图转换为一维向量,并通过一系列全连接层进行分类或回归等任务。

全连接层中的每个神经元都与上一层中所有神经元相连,这样可以充分利用上一层提取到的特征进行分类。

1.2 应用场景卷积神经网络(CNN)在计算机视觉领域有着广泛应用。

其中最典型的应用场景是图像分类和目标检测。

在图像分类任务中,CNN可以通过学习到的特征提取器将输入图像分为不同类别。

例如,在ImageNet数据集上进行分类任务时,CNN可以实现对1000个不同类别进行准确分类。

在目标检测任务中,CNN可以识别并定位输入图像中存在的多个目标。

通过在卷积网络之后加入额外的回归和分类层,可以实现对目标位置和类别进行同时预测。

此外,在语义分割、人脸识别、图像生成等领域,CNN也有着广泛的应用。

卷积神经网络算法分析及图像处理示例

卷积神经网络算法分析及图像处理示例卷积神经网络(Convolutional Neural Network, CNN)是一种广泛应用于图像处理、语音识别等领域的深度神经网络,在计算机视觉中被广泛应用。

它的特殊之处在于,它的网络结构与人类的视觉神经结构有异曲同工之妙,能够有效提取图片中的图像特征。

下面将介绍我们是如何应用卷积神经网络对图像进行处理的,并对算法进行分析。

首先来看卷积神经网络的基本算法思想。

卷积神经网络是由卷积层、池化层、全连接层等基本组件构成的,其中卷积层是卷积神经网络的核心,因为它负责特征提取。

这么说可能还不是很清楚,下面就来详细分析一下卷积神经网络的算法。

卷积神经网络的算法分析主要分为两个方面:卷积层的算法和反向传播算法。

1. 卷积层的算法卷积神经网络的卷积层基本操作是使用固定大小的窗口在输入特征图(inputfeature map)的每个位置上对应进行卷积,然后将这些卷积结果组合成输出特征图(output feature map)。

一个卷积滤波器(卷积核)从输入特征图的左上角开始移动,每次向右移动一个像素,然后再向下移动一个像素。

卷积核内的值与输入特征值相乘之和(即内积)即为卷积结果,而这个卷积结果则成为输出特征值。

在卷积过程中,卷积核通常是可以学习的,也就是说,网络会自适应地训练卷积核以自动提取有用的特征。

这个训练过程是通过反向传播实现的。

2. 反向传播算法反向传播算法是卷积神经网络使用的一种优化算法,用于计算网络的误差梯度,以便对网络进行调整。

反向传播算法主要分为两个步骤:前向传播和反向传播。

前向传播是卷积神经网络中的重要环节,通过这一步骤可以得到每个节点的输出(forward pass)。

它通过不断迭代多次前向传播来计算最终输出。

反向传播是指统计误差并利用误差信息来训练网络(backward pass)。

它通过计算误差的反向传播,逐层更新每个节点的权重来训练网络,完成优化操作。

nnunet代码讲解

nnU-Net 是一种用于医学图像分割的深度学习模型,其名称中的"nn" 表示 "neural network",而 "U-Net" 是一种经典的图像分割网络结构。

nnU-Net 在 U-Net 的基础上引入了一些改进,以进一步提高性能。

以下是 nnU-Net 代码的基本结构:```pythonimport torchimport torch.nn as nnclass UNet(nn.Module):def __init__(self, in_channels, out_channels):super(UNet, self).__init__()# 定义卷积层和反卷积层等网络结构# ...def forward(self, x):# 前向传播逻辑# ...return xclass nnUnet(nn.Module):def __init__(self, in_channels, out_channels, n_levels): super(nnUnet, self).__init__()# 定义 nnU-Net 的网络结构# ...def forward(self, x):# 前向传播逻辑# ...return x```在 nnU-Net 中,主要包含两个类:`UNet` 和 `nnUnet`。

`UNet` 是用于实现 U-Net 结构的类,而 `nnUnet` 是用于实现 nnU-Net 结构的类。

在 `UNet` 类中,可以定义卷积层、反卷积层等网络结构,并实现前向传播逻辑。

在 `nnUnet` 类中,可以定义 nnU-Net 的网络结构,包括多个级别的 U-Net 结构,并实现前向传播逻辑。

需要注意的是,上述代码仅为示例,实际的 nnU-Net 代码可能包含更多的网络结构和优化技巧。

此外,为了训练 nnU-Net 模型,还需要定义损失函数、优化器等,并进行训练和测试。

一文看懂卷积神经网络-CNN(基本原理独特价值实际应用)

⼀⽂看懂卷积神经⽹络-CNN(基本原理独特价值实际应⽤)卷积神经⽹络 – CNN 最擅长的就是图⽚的处理。

它受到⼈类视觉神经系统的启发。

CNN 有2⼤特点:能够有效的将⼤数据量的图⽚降维成⼩数据量能够有效的保留图⽚特征,符合图⽚处理的原则⽬前 CNN 已经得到了⼴泛的应⽤,⽐如:⼈脸识别、⾃动驾驶、美图秀秀、安防等很多领域。

CNN 解决了什么问题?在 CNN 出现之前,图像对于⼈⼯智能来说是⼀个难题,有2个原因:图像需要处理的数据量太⼤,导致成本很⾼,效率很低图像在数字化的过程中很难保留原有的特征,导致图像处理的准确率不⾼下⾯就详细说明⼀下这2个问题:需要处理的数据量太⼤图像是由像素构成的,每个像素⼜是由颜⾊构成的。

现在随随便便⼀张图⽚都是 1000×1000 像素以上的,每个像素都有RGB 3个参数来表⽰颜⾊信息。

假如我们处理⼀张 1000×1000 像素的图⽚,我们就需要处理3百万个参数!1000×1000×3=3,000,000这么⼤量的数据处理起来是⾮常消耗资源的,⽽且这只是⼀张不算太⼤的图⽚!卷积神经⽹络 – CNN 解决的第⼀个问题就是「将复杂问题简化」,把⼤量参数降维成少量参数,再做处理。

更重要的是:我们在⼤部分场景下,降维并不会影响结果。

⽐如1000像素的图⽚缩⼩成200像素,并不影响⾁眼认出来图⽚中是⼀只猫还是⼀只狗,机器也是如此。

保留图像特征图⽚数字化的传统⽅式我们简化⼀下,就类似下图的过程:图像简单数字化⽆法保留图像特征图像的内容假如有圆形是1,没有圆形是0,那么圆形的位置不同就会产⽣完全不同的数据表达。

但是从视觉的⾓度来看,图像的内容(本质)并没有发⽣变化,只是位置发⽣了变化。

(本质)并没有发⽣变化,只是位置发⽣了变化所以当我们移动图像中的物体,⽤传统的⽅式的得出来的参数会差异很⼤!这是不符合图像处理的要求的。

⽽ CNN 解决了这个问题,他⽤类似视觉的⽅式保留了图像的特征,当图像做翻转,旋转或者变换位置时,它也能有效的识别出来是类似的图像。

神经网络算法的代码实现详解

神经网络算法的代码实现详解神经网络算法是一种模拟人脑神经系统的计算模型,它通过构建多层神经元网络来实现对数据的学习与预测。

本文将对神经网络算法的代码实现进行详细解析,通过Python语言实现。

1.数据准备首先,我们需要准备训练数据和测试数据。

训练数据是用来训练神经网络的样本,通常包含一组输入数据和对应的输出数据。

测试数据则是用来测试训练后的神经网络模型的准确性。

2.构建神经网络结构接下来,我们需要构建神经网络的结构。

神经网络通常由多层神经元组成,每层神经元与上一层的神经元全连接。

我们可以使用Python的Numpy库来创建神经网络的结构,其中的矩阵运算能够高效地实现神经网络算法。

3.定义激活函数神经网络中,每个神经元都需要一个激活函数来对输入数据进行处理,并输出非线性的结果。

常用的激活函数有sigmoid函数、ReLU 函数等。

我们可以在构建神经网络结构时定义激活函数。

4.前向传播前向传播是指从输入层开始,逐层计算神经元的输出,直到输出层为止。

这一过程可以通过矩阵运算实现,其中每一层的输出都是上一层输出与权重矩阵的乘积再经过激活函数处理得到。

最终,输出层的输出即为神经网络的预测结果。

5.反向传播反向传播是指根据预测结果,逐层更新权重矩阵,以使得预测结果与实际结果尽可能接近。

反向传播算法通过计算误差项,逆向更新权重矩阵。

误差项的计算根据损失函数的不同而有所差异,常用的损失函数有均方误差、交叉熵等。

6.更新权重矩阵根据反向传播算法计算得到的误差项,我们可以更新每一层的权重矩阵。

更新的方法一般是使用梯度下降算法,通过计算每个权重的梯度值以及学习率,来逐步调整权重的取值。

7.训练神经网络模型在完成以上步骤后,我们可以开始训练神经网络模型。

训练过程即是重复进行前向传播和反向传播,以不断更新权重矩阵。

通过多次迭代,使得神经网络模型的预测结果逼近真实结果。

8.测试神经网络模型在训练完成后,我们需要使用测试数据对神经网络模型进行测试,以评估其性能。

Python中的CNN网络实现方法

Python中的CNN网络实现方法卷积神经网络(Convolutional Neural Network,CNN)是一种深度学习算法,已经在图像识别、自然语言处理、语音识别等领域取得了非常好的效果。

本文将介绍Python中CNN网络的实现方法,并且通过实例展示如何构建CNN网络。

1.卷积神经网络的基本概念卷积神经网络主要由卷积层、池化层、全连接层组成,其中卷积层是最关键的部分。

卷积层的主要作用是提取特征,输入数据经过多次卷积和池化操作后,最终得到的是一个特征图。

卷积神经网络是通过多组卷积核来提取输入数据的特征的。

卷积核是一个小型的矩阵,用于和输入的数据进行卷积。

卷积的结果是一个特征图,这个特征图不仅仅是输入数据的副本,而是提取了输入数据的各种特征,可以用这个特征图来进行下一步的处理。

池化层是在卷积层之后添加的,主要作用是为了进一步降维,减少神经网络的计算量,同时不影响特征图的特征信息。

全连接层是将池化层的输出进行展开,然后进行前向传递和反向传播。

在反向传播时,每一个全连接层的节点将会计算出其对下一层中所有节点的误差,并将其向前传递。

2. Python中实现卷积神经网络的步骤在Python中实现CNN网络的具体步骤如下:1)数据预处理:将数据准备好作为CNN网络的模型输入。

这个步骤通常包括数据归一化、数据增强、数据划分等操作。

2)构建CNN模型:CNN模型主要由卷积层、池化层、全连接层等模块组成。

在Python中,可以使用Keras或TensorFlow等框架来构建CNN模型,这些框架提供了许多预定义的卷积层、池化层等模块,大大简化了模型搭建的流程。

3)编译CNN模型:在构建CNN模型后,需要使用compile方法对模型进行编译,需要指定损失函数、优化函数和评估指标等。

4)训练CNN模型:训练CNN模型需要调用fit方法,传入训练数据和标签进行训练。

在训练过程中,需要指定批次大小、训练次数等参数。

【机器学习基础】卷积神经网络(CNN)基础

【机器学习基础】卷积神经⽹络(CNN)基础最近⼏天陆续补充了⼀些“线性回归”部分内容,这节继续机器学习基础部分,这节主要对CNN的基础进⾏整理,仅限于基础原理的了解,更复杂的内容和实践放在以后再进⾏总结。

卷积神经⽹络的基本原理 前⾯对全连接神经⽹络和深度学习进⾏了简要的介绍,这⼀节主要对卷积神经⽹络的基本原理进⾏学习和总结。

所谓卷积,就是通过⼀种数学变换的⽅式来对特征进⾏提取,通常⽤于图⽚识别中。

既然全连接的神经⽹络可以⽤于图⽚识别,那么为什么还要⽤卷积神经⽹络呢?(1)⾸先来看下⾯⼀张图⽚: 在这个图⽚当中,鸟嘴是⼀个很明显的特征,当我们做图像识别时,当识别到有“鸟嘴”这样的特征时,可以具有很⾼的确定性认为图⽚是⼀个鸟类。

那么,在提取特征的过程中,有时就没有必要去看完整张图⽚,只需要⼀⼩部分就能识别出⼀定具有代表的特征。

因此,使⽤卷积就可以使某⼀个特定的神经元(在这⾥,这个神经元可能就是⽤来识别“鸟嘴”的)仅仅处理带有该特征的部分图⽚就可以了,⽽不必去看整张图⽚。

那么这样就会使得这个神经元具有更少的参数(因为不⽤再跟图⽚的每⼀维输⼊都连接起来)。

(2)再来看下⾯⼀组图⽚:上⾯两张图⽚都是鸟类,⽽不同的是,两只鸟的“鸟嘴”的位置不同,但在普通的神经⽹络中,需要有两个神经元,⼀个去识别左上⾓的“鸟嘴”,另⼀个去识别中间的“鸟嘴”: 但其实这两个“鸟嘴”的形状是⼀样的,这样相当于上⾯两个神经元是在做同⼀件事情。

⽽在卷积神经⽹络中,这两个神经元可以共⽤⼀套参数,⽤来做同⼀件事情。

(3)对样本进⾏⼦采样,往往不会影响图⽚的识别。

如下⾯⼀张图: 假设把⼀张图⽚当做⼀个矩阵的话,取矩阵的奇数⾏和奇数列,可看做是对图⽚的⼀种缩放,⽽这种缩放往往不会影响识别效果。

卷积神经⽹络中就可以对图⽚进⾏缩放,是图⽚变⼩,从⽽减少模型的参数。

卷积神经⽹络的基本结构如图所⽰: 从右到左,输⼊⼀张图⽚→卷积层→max pooling(池化层)→卷积层→max pooling(池化层)→......→展开→全连接神经⽹络→输出。

十种深度学习算法要点及代码解析

十种深度学习算法要点及代码解析一、卷积神经网络(CNN)1.1算法原理:卷积神经网络(CNN)是一种深度神经网络,通过一系列卷积层和池化层实现特征提取和信息处理,可以有效的处理图像、语音、文字等多种复杂数据,相比传统的神经网络,其特征更加准确、泛化能力更强,训练更快;1.2基本结构:CNN通常由输入层、卷积层、激活层、池化层、全连接层(FC)组成;1.3应用场景:CNN应用最广泛的场景是机器视觉,对图像进行分类、识别和特征提取,特别是在人脸识别、图像分类等领域;(1)构建卷积神经网络先导入必要的库:from keras.models import Sequential #导入序列模型from yers import Conv2D, MaxPooling2D #导入卷积层和池化层from yers import Activation, Dropout, Flatten, Dense #导入激活函数、Dropout层、Flatten层、全连接层#构建模型#实例化一个Sequential模型model = Sequential#第1层卷积model.add(Conv2D(32, (3, 3), input_shape = (32, 32, 3))) model.add(Activation('relu'))#第2层卷积model.add(Conv2D(32, (3, 3)))model.add(Activation('relu'))#第3层池化model.add(MaxPooling2D(pool_size = (2, 2)))#第4层Dropoutmodel.add(Dropout(0.25))#第5层Flatten层model.add(Flatten()#第6层全连接model.add(Dense(128))model.add(Activation('relu'))#第7层Dropout层model.add(Dropout(0.5))#第8层全连接model.add(Dense(10))model.add(Activation('softmax'))。

res2net代码解析

res2net代码解析一、介绍r e s2ne t(Re si du al-Re so lu ti on Ne two r k)是一种提升图像识别性能的卷积神经网络结构。

它利用了多尺度特征之间的相互依赖关系,通过增加分辨率分支和多尺度特征融合模块,有效提高了网络的特征表达能力。

二、网络结构r e s2ne t的主要特点在于引入了分辨率分支和多尺度特征融合模块。

下面将详细介绍这两个重要的组成部分。

2.1分辨率分支r e s2ne t通过在主干网络的每个模块中增加一个分辨率分支,实现了多尺度特征的提取。

具体而言,分辨率分支由两个卷积层组成,分别用于提取低分辨率和高分辨率特征。

这种设置可以捕捉到更丰富的图像细节和上下文信息。

2.2多尺度特征融合模块为了充分利用不同分辨率特征的信息,re s2n et引入了多尺度特征融合模块。

该模块通过将多个分辨率特征叠加在一起,并通过卷积操作进行特征融合,从而生成新的特征表示。

这样做有助于提高网络对不同尺度目标的感知能力。

三、代码实现下面给出了r es2n et代码的基本实现步骤,供大家参考。

```p yt ho ni m po rt to rc hi m po rt to rc h.nn asn nc l as sR es2N et(n n.M o du le):d e f__i ni t__(se lf,n um_c la ss es):s u pe r(Re s2Ne t,sel f).__in it__()网络结构定义代码...d e ff or wa rd(s el f,x):前向传播代码...r e tu rn xm o de l=Re s2Ne t(num_cl as se s=100)```需要注意的是,这只是r es2n et代码的基本实现框架,具体细节实现需要根据具体任务进行调整。

四、应用领域r e s2ne t在图像识别领域取得了很多突破性的成果。

卷积神经网络全面解析之代码详解

卷积神经网络全面解析之代码详解本文介绍多层感知机算法,特别是详细解读其代码实现,基于python theano,代码来自:Convolutional Neural Networks (LeNet)。

一、CNN卷积神经网络原理简介要讲明白卷积神经网络,估计得长篇大论,网上有很多博文已经写得很好了,所以本文就不重复了,如果你了解CNN,那可以往下看,本文主要是详细地解读CNN的实现代码。

CNN的最大特点就是稀疏连接(局部感受)和权值共享,如下面两图所示,左为稀疏连接,右为权值共享。

稀疏连接和权值共享可以减少所要训练的参数,减少计算复杂度。

至于CNN的结构,以经典的LeNet5来说明:这个图真是无处不在,一谈CNN,必说LeNet5,这图来自于这篇论文:Gradient-Based Learning Applied to Document Recognition,论文很长,第7页那里开始讲LeNet5这个结构,建议看看那部分。

我这里简单说一下,LeNet5这张图从左到右,先是input,这是输入层,即输入的图片。

input-layer到C1这部分就是一个卷积层(convolution运算),C1到S2是一个子采样层(pooling运算),关于卷积和子采样的具体过程可以参考下图:然后,S2到C3又是卷积,C3到S4又是子采样,可以发现,卷积和子采样都是成对出现的,卷积后面一般跟着子采样。

S4到C5之间是全连接的,这就相当于一个MLP的隐含层了(如果你不清楚MLP,参考《DeepLearning tutorial(3)MLP多层感知机原理简介+代码详解》)。

C5到F6同样是全连接,也是相当于一个MLP的隐含层。

最后从F6到输出output,其实就是一个分类器,这一层就叫分类层。

ok,CNN的基本结构大概就是这样,由输入、卷积层、子采样层、全连接层、分类层、输出这些基本“构件”组成,一般根据具体的应用或者问题,去确定要多少卷积层和子采样层、采用什么分类器。

cnn是什么意思

cnn是什么意思CNN是什么意思?——深入解析卷积神经网络引言:在当今互联网高速发展的时代,人工智能技术已经成为各行各业的热门话题,它以其强大的数据处理能力和智能决策能力,正逐渐改变着我们生活的方方面面。

而在人工智能领域中,卷积神经网络(Convolutional Neural Network,简称CNN)作为一种深度学习模型,占据着重要的地位。

本文将详细介绍CNN是什么意思,以及其基本原理、工作原理和应用场景等内容。

一、基本概念卷积神经网络(CNN)是一种人工神经网络,通过模拟人脑中神经元之间的连接关系,实现对图像、音频等非结构化数据的处理和分析。

相对于传统的全连接神经网络,CNN具有处理图像任务的优势,能够提取图像中的局部特征,并通过层层处理得到更高层次的抽象特征。

二、基本原理1. 卷积层卷积层是CNN的核心组成部分,它通过滑动窗口的方式,对输入数据进行卷积运算,从而提取特征。

在卷积运算过程中,使用一组称为卷积核或过滤器的小矩阵,通过对输入数据进行滑动和相乘累加的操作,得到卷积特征图。

2. 池化层池化层是CNN中的另一个重要组成部分,它通过降采样的方式,减少特征图的尺寸和参数数量,从而提高模型的鲁棒性和计算效率。

常见的池化方式有最大池化和平均池化,它们分别选取特征图中最大值和平均值作为输出。

3. 激活函数激活函数是CNN中用于引入非线性的一环,它对卷积层输出的结果进行非线性变换,增加网络的表达能力。

常用的激活函数有ReLU、Sigmoid和Tanh等,它们分别在不同场景下表现出不同的性能。

三、工作原理CNN的工作原理可以简单概括为:输入数据经过一系列的卷积层、池化层和全连接层的处理,最终得到输出结果。

具体流程如下:1. 输入层:接收原始数据,通常是图像或音频。

2. 卷积层:提取输入数据的局部特征。

3. 激活函数:引入非线性变换,增加网络的表达能力。

4. 池化层:减少特征图的尺寸和参数数量。

5. 全连接层:将池化层输出的特征进行分类或预测。

convtasnet代码讲解

Convtasnet代码讲解1. 引言Convtasnet是一个用于语音分离的深度学习模型,它基于卷积神经网络(CNN)和转置卷积(Transposed Convolution)的结构。

该模型在语音分离任务上取得了显著的成果,被广泛应用于音频处理领域。

本文将对Convtasnet的代码进行讲解,以便读者能够深入理解该模型的实现细节。

2. 模型结构Convtasnet的核心结构由卷积神经网络和Transformer模块组成。

在代码实现中,卷积神经网络用于提取语音特征,而Transformer模块用于对特征进行编码和解码。

模型还包括了损失函数以及优化器等组件。

在接下来的讲解中,我们将逐步介绍这些组件的具体实现。

3. 卷积神经网络在Convtasnet中,卷积神经网络被用来提取语音特征。

具体来说,模型采用了一维卷积(1D Convolution)来对语音信号进行卷积操作,从而捕获语音中的时域特征。

在代码中,卷积层的参数设置和卷积核的设计都对模型的性能有着重要影响,我们将详细讨论这些实现细节。

4. Transformer模块Transformer模块在Convtasnet中用于对特征进行编码和解码,它由多个自注意力层(Self-Attention Layer)和前馈神经网络(Feed-Forward Neural Network)组成。

在代码中,我们将讨论如何实现这些组件,并且介绍它们在语音分离任务中的作用。

5. 损失函数为了训练Convtasnet模型,我们需要定义合适的损失函数。

常用的语音分离损失函数包括均方误差(Mean Squared Error)和混合度谱损失(Mixed-SNR Loss)。

在代码实现中,我们将详细介绍这些损失函数的实现方式,并分析它们对模型训练的影响。

6. 优化器优化器在深度学习模型的训练中起着至关重要的作用。

在Convtasnet 的代码实现中,我们将讨论常用的优化器(如Adam、SGD等)的选择和参数调整策略,以及它们在训练过程中的效果。

卷积的几种代码方式

在深度学习和计算机视觉领域,卷积操作通常可以通过多种编程语言和深度学习框架来实现。

以下是使用Python和几种流行的深度学习库来实现卷积的例子。

1. **Python 纯代码**这是最基础的方式,使用Python的NumPy库来实现卷积操作。

```pythonimport numpy as npdef conv2d(image, kernel):# 假设 image 和 kernel 是 numpy 数组# 获取图像和卷积核的尺寸image_h, image_w = image.shapekernel_h, kernel_w = kernel.shape# 计算卷积结果的大小output_h = image_h - kernel_h + 1output_w = image_w - kernel_w + 1# 初始化输出结果output = np.zeros((output_h, output_w))# 进行卷积操作for i in range(output_h):for j in range(output_w):output[i, j] = np.sum(image[i:i+kernel_h, j:j+kernel_w] * kernel)return output```2. **TensorFlow**TensorFlow是一个流行的深度学习库,它内置了卷积操作。

```pythonimport tensorflow as tf# 假设 image 和 kernel 是 TensorFlow tensors# 获取图像和卷积核的尺寸image_shape = image.shapekernel_shape = kernel.shape# 计算卷积结果的大小output_shape = (image_shape[0] - kernel_shape[0] + 1, image_shape[1] - kernel_shape[1] + 1)# 进行卷积操作output = tf.nn.conv2d(image, kernel, strides=[1, 1, 1, 1], padding='VALID')```3. **PyTorch**PyTorch是另一个流行的深度学习库,它也内置了卷积操作。

使用TensorFlow构建卷积神经网络CNN

• 三种常见的激活函数:sigmod、tanh、RELU

• 全连接层 • 两层之间所有的神经元都有权重连接,通常全连接层在卷积神经

网络的尾部。

Cifar-10数据集

• Cifar-10数据集一共包含了60000张32*32大小的图片,这些图片被 分为以下十类,每一个类别包含6000张图片,所有的60000张图 片分为50000张训练图片和10000测试图片。

使用Tensorflow构建卷积神经 网络CNN

人工智能、机器学习和深度学习

卷积神经网络

• 卷积神经网络(Convolutional Neural Networks)是仿照生物视觉 识别系统构建的一种高效识别算法,目前主要应用于图像处理。

• 神经元是卷积神经网络中最基本的单位。

• 将多个神经元组合起来,并具有分层结构就构成了神经网络。

• 输入图片大小WxW,卷积核大小FxF, 步长S,填充值P

• 卷积层输出大小N=(W-F+2P)/S + 1

• 池化层:池化层夹在连续的卷积层之间,用于压缩数据和参数的 数量,减少过拟合。

• 池化层使用的方法有最大池化和平均池化,实际上使用较多的是 最大池化。

• 激活函数

• 在卷积神经网络中,我们对于图像的处理使用的卷积,对每一个 像素点赋予一个权重,卷积的操作是线性的,而对于我们的样本 而言,并不一定是线性可分的,仅仅有线性变换对于复杂问题的 建模是不够的,因此要在卷积神经网络中添加非线性的变化,激 活函数存在的目的就是进行非线性变化。有了激活函数,神经网 络的表达能力就能够更加强大(不再是线性组合,而是几乎可以 逼近任意函数)。

Tensorflow

• TensorFlow 是一个采用数据流图的形式,用于数值计算的开源软 件库。节点在图中表示数学操作,图中的线则表示在节点间相互 联系的多维数据数组,即张量。Tensorflow可以在多种平台上展 开计算,例如台式计算机中的一个或多个CPU(或GPU),服务 器,移动设备等等。TensorFlow 主要用于机器学习和深度神经网 络方面的研究,但这个系统的通用性使其也可广泛用于其他计算 领域。

卷积神经网络(CNN,ConvNet)及其原理详解

卷积神经网络(CNN,ConvNet)及其原理详解卷积神经网络(CNN,有时被称为ConvNet)是很吸引人的。

在短时间内,它们变成了一种颠覆性的技术,打破了从文本、视频到语音等多个领域所有最先进的算法,远远超出了其最初在图像处理的应用范围。

CNN 由许多神经网络层组成。

卷积和池化这两种不同类型的层通常是交替的。

网络中每个滤波器的深度从左到右增加。

最后通常由一个或多个全连接的层组成:图1 卷积神经网络的一个例子Convnets 背后有三个关键动机:局部感受野、共享权重和池化。

让我们一起看一下。

局部感受野如果想保留图像中的空间信息,那么用像素矩阵表示每个图像是很方便的。

然后,编码局部结构的简单方法是将相邻输入神经元的子矩阵连接成属于下一层的单隐藏层神经元。

这个单隐藏层神经元代表一个局部感受野。

请注意,此操作名为“卷积”,此类网络也因此而得名。

当然,可以通过重叠的子矩阵来编码更多的信息。

例如,假设每个子矩阵的大小是5×5,并且将这些子矩阵应用到28×28 像素的MNIST 图像。

然后,就能够在下一隐藏层中生成23×23 的局部感受野。

事实上,在触及图像的边界之前,只需要滑动子矩阵23 个位置。

定义从一层到另一层的特征图。

当然,可以有多个独立从每个隐藏层学习的特征映射。

例如,可以从28×28 输入神经元开始处理MNIST 图像,然后(还是以5×5 的步幅)在下一个隐藏层中得到每个大小为23×23 的神经元的k 个特征图。

共享权重和偏置假设想要从原始像素表示中获得移除与输入图像中位置信息无关的相同特征的能力。

一个简单的直觉就是对隐藏层中的所有神经元使用相同的权重和偏置。

通过这种方式,每层将从图像中学习到独立于位置信息的潜在特征。

理解卷积的一个简单方法是考虑作用于矩阵的滑动窗函数。

在下面的例子中,给定输入矩阵I 和核K,得到卷积输出。

将3×3 核K(有时称为滤波器或特征检测器)与输入矩阵逐元素地相乘以得到输出卷积矩阵中的一个元素。

CNN卷积神经网络详解

CNN卷积神经⽹络详解分割线---------------------------------- 这⾥更新过⼀次,在朋友的提醒下,我发现这份代码不是很容易懂。

我使⽤了Pytorch给的官⽅demo重新实现了LeNet,并做出了详细解释,如果理解下⾯代码有问题,可以先看我的这篇⽂章,它能够帮助你更好的理解这篇⽂章中的代码,⽂章地址->:分割线----------------------------------前⾔ 在学计算机视觉的这段时间⾥整理了不少的笔记,想着就把这些笔记再重新整理出来,然后写成Blog和⼤家⼀起分享。

⽬前的计划如下(以下⽹络全部使⽤Pytorch搭建):专题⼀:计算机视觉基础介绍CNN⽹络(计算机视觉的基础)浅谈VGG⽹络,介绍ResNet⽹络(⽹络特点是越来越深)介绍GoogLeNet⽹络(⽹络特点是越来越宽)介绍DenseNet⽹络(⼀个看似⼗分NB但是却实际上⽤得不多的⽹络)整理期间还会分享⼀些⾃⼰正在参加的⽐赛的Baseline专题⼆:GAN⽹络搭建普通的GAN⽹络卷积GAN条件GAN模式崩溃的问题及⽹络优化 以上会有相关代码实践,代码是基于Pytorch框架。

话不多说,我们先进⾏专题⼀的第⼀部分介绍,卷积神经⽹络。

⼀、CNN解决了什么问题? 在CNN出现之前,对于图像的处理⼀直都是⼀个很⼤的问题,⼀⽅⾯因为图像处理的数据量太⼤,⽐如⼀张512 x 512的灰度图,它的输⼊参数就已经达到了252144个,更别说1024x1024x3之类的彩⾊图,这也导致了它的处理成本⼗分昂贵且效率极低。

另⼀⽅⾯,图像在数字化的过程中很难保证原有的特征,这也导致了图像处理的准确率不⾼。

⽽CNN⽹络能够很好的解决以上两个问题。

对于第⼀个问题,CNN⽹络它能够很好的将复杂的问题简单化,将⼤量的参数降维成少量的参数再做处理。

也就是说,在⼤部分的场景下,我们使⽤降维不会影响结果。

⽐如在⽇常⽣活中,我们⽤⼀张1024x1024x3表⽰鸟的彩⾊图和⼀张100x100x3表⽰鸟的彩⾊图,我们基本上都能够⽤⾁眼辨别出这是⼀只鸟⽽不是⼀只狗。

卷积神经网络CNN代码解析matlab

卷积神经网络CNN代码解析 deepLearnToolbox-master是一个深度学习matlab包,里面含有很多机器学习算法,如卷积神经网络CNN,深度信念网络DBN,自动编码AutoEncoder 堆栈SAE,卷积CAE的作者是 Rasmus Berg Palm代码下载:这里我们介绍deepLearnToolbox-master中的CNN部分; DeepLearnToolbox-master中CNN内的函数:调用关系为:该模型使用了mnist的数字作为训练样本,作为cnn的一个使用样例,每个样本特征为一个2828=的向量;网络结构为:让我们来看看各个函数:一、Test_example_CNN:Test_example_CNN:1设置CNN的基本参数规格,如卷积、降采样层的数量,卷积核的大小、降采样的降幅2 cnnsetup函数初始化卷积核、偏置等3 cnntrain函数训练cnn,把训练数据分成batch,然后调用cnnff 完成训练的前向过程,cnnbp计算并传递神经网络的error,并计算梯度权重的修改量cnnapplygrads 把计算出来的梯度加到原始模型上去4 cnntest 函数,测试当前模型的准确率该模型采用的数据为,含有70000个手写数字样本其中60000作为训练样本,10000作为测试样本; 把数据转成相应的格式,并归一化;设置网络结构及训练参数初始化网络,对数据进行批训练,验证模型准确率绘制均方误差曲线二、该函数你用于初始化CNN的参数;设置各层的mapsize大小,初始化卷积层的卷积核、bias尾部单层感知机的参数设置bias统一设置为0权重设置为:-1~1之间的随机数/sqrt6/输入神经元数量+输出神经元数量对于卷积核权重,输入输出为fan_in, fan_outfan_out = {l}.outputmaps {l}.kernelsize ^ 2;%卷积核初始化,1层卷积为16个卷积核,2层卷积一共612=72个卷积核;对于每个卷积输出featuremap,%fan_in = 表示该层的一个输出map,所对应的所有卷积核,包含的神经元的总数;125,625fan_in = numInputmaps {l}.kernelsize ^ 2;fin =125 or 625fout=1625 or 61225{l}.k{i}{j} = rand{l}.kernelsize - 2 sqrt6 / fan_in + fan_out;1 卷积降采样的参数初始化2尾部单层感知机的参数权重和偏量设置:三、该函数用于训练CNN;生成随机序列,每次选取一个batch50个样本进行训练;批训练:计算50个随机样本的梯度,求和之后一次性更新到模型权重中;在批训练过程中调用:完成前向过程完成误差传导和梯度计算过程把计算出来的梯度加到原始模型上去四、1、取得CNN的输入2、两次卷积核降采样层处理3、尾部单层感知机的数据处理,需要把subFeatureMap2连接成为一个4412=192的向量,但是由于采用了50样本批训练的方法,subFeatureMap2被拼合成为一个19250的特征向量fv;Fv作为单层感知机的输入,全连接的方式得到输出层五、该函数实现2部分功能,计算并传递误差,计算梯度1、计算误差和LossFunction2、计算尾部单层感知机的误差3、把单层感知机的输入层featureVector的误差矩阵,恢复为subFeatureMap2的44二维矩阵形式插播一张图片:4、误差在特征提取网络卷积降采样层的传播如果本层是卷积层,它的误差是从后一层降采样层传过来,误差传播实际上是用降采样的反向过程,也就是降采样层的误差复制为22=4份;卷积层的输入是经过sigmoid处理的,所以,从降采样层扩充来的误差要经过sigmoid求导处理;如果本层是降采样层,他的误差是从后一层卷积层传过来,误差传播实际是用卷积的反向过程,也就是卷积层的误差,反卷积卷积核转180度卷积层的误差,原理参看插图;5、计算特征抽取层和尾部单层感知机的梯度五、该函数完成权重修改,更新模型的功能1更新特征抽取层的权重 weight+bias2 更新末尾单层感知机的权重 weight+bias 六、验证测试样本的准确率。

深度学习——带你通俗理解卷积神经网络(CNN)

深度学习——带你通俗理解卷积神经⽹络(CNN)卷积神经⽹络(CNN)基础知识⽂章⽬录1.前⾔ 如果说深度神经⽹络模型中的“明星”是谁?那么⾮卷积神经⽹络莫属。

下⾯给⼤家简单介绍⼀下CNN的基础知识。

其中CNN基础主要涉及卷积层、池化层、全连接层在卷积神经⽹络扮演的⾓⾊、实现的具体的功能和⼯作原理。

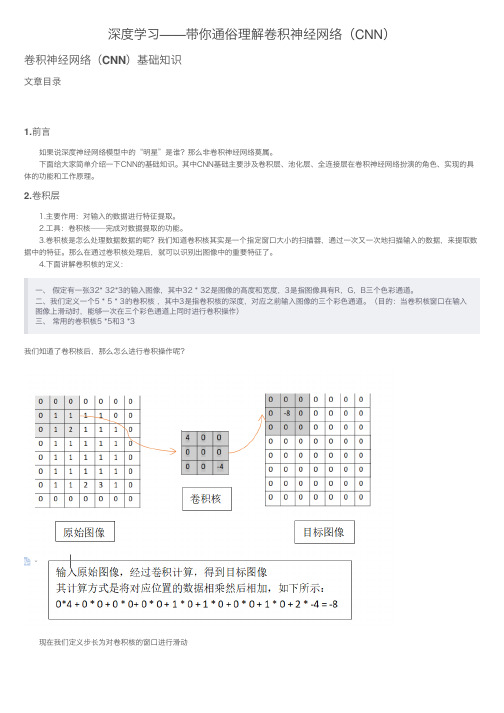

2.卷积层 1.主要作⽤:对输⼊的数据进⾏特征提取。

2.⼯具:卷积核——完成对数据提取的功能。

3.卷积核是怎么处理数据数据的呢?我们知道卷积核其实是⼀个指定窗⼝⼤⼩的扫描器,通过⼀次⼜⼀次地扫描输⼊的数据,来提取数据中的特征。

那么在通过卷积核处理后,就可以识别出图像中的重要特征了。

4.下⾯讲解卷积核的定义:⼀、 假定有⼀张32* 32*3的输⼊图像,其中32 * 32是图像的⾼度和宽度,3是指图像具有R,G,B三个⾊彩通道。

⼆、我们定义⼀个5 * 5 * 3的卷积核 ,其中3是指卷积核的深度,对应之前输⼊图像的三个彩⾊通道。

(⽬的:当卷积核窗⼝在输⼊图像上滑动时,能够⼀次在三个彩⾊通道上同时进⾏卷积操作)三、 常⽤的卷积核5 *5和3 *3我们知道了卷积核后,那么怎么进⾏卷积操作呢? 现在我们定义步长为对卷积核的窗⼝进⾏滑动 下图为⼀个步长为2的卷积核经过⼀次滑动窗⼝位置变化情况 仔细观察不难发现,在上⾯的输⼊图像的最外界多了⼀圈全为0的像素,这其实就是⼀种⽤于提升卷积效果的边界像素扩充的⽅法共有两种⽅式进⾏填充Same和Valid1.Same在输⼊图像的最外界加上指定层数的值全为0的像素边界:为了让输⼊图像的全部像素能被滑动窗⼝捕捉。

2.Valid直接对输⼊图像进⾏卷积,不对输⼊图像进⾏任何的前期处理和图像填充。

缺点就是会导致部分像素点不嫩被滑动窗⼝捕捉。

通过对卷积过程的计算,可以得出卷积通⽤公式⽤于计算输⼊图像经过⼀轮卷积操作后的输出图像的宽度和⾼度的参数 其中W,H分别代表图像的宽度和⾼度的值;下标input代表输⼊图像的相关参数;下标output表⽰输出图像的相关参数,filter代表卷积核的相关参数,S代表卷积的步长,P(padding)代表在图像边缘增加的边界像素层数。

简述卷积神经网络(CNN)和循环神经网络(RNN)的原理及应用场景

简述卷积神经网络(CNN)和循环神经网络(RNN)的原理及应用场景卷积神经网络(CNN)和循环神经网络(RNN)是当前深度学习领域中最热门的两个神经网络架构。

本论文将从两个方面分别介绍CNN和RNN的原理及应用场景。

一、卷积神经网络(CNN)1. 原理卷积神经网络是一种使用卷积操作的深度神经网络,其网络结构主要由卷积层、池化层和全连接层构成。

其中,卷积层和池化层主要用于提取图像的特征信息,而全连接层则用于进行分类或回归等任务。

具体而言,卷积层利用卷积核对输入数据进行卷积计算,以提取输入数据中的关键信息。

池化层则用于缩小特征图的空间大小,减少模型参数数量,提高模型的泛化能力。

全连接层将卷积层和池化层的输出进行flatten操作后,再进行全连接计算,以得出最终的分类或回归结果。

2. 应用场景卷积神经网络在图像识别、目标检测、人脸识别、自然语言处理等领域有着广泛的应用。

其中,图像识别是其主要应用场景之一。

例如,利用卷积神经网络可以对图像进行分类、分割、检测等任务。

此外,卷积神经网络还可以用于文本特征提取、语音识别等任务。

二、循环神经网络(RNN)1. 原理循环神经网络是一种具有记忆功能的神经网络,其主要特点是能够处理序列数据。

循环神经网络通过循环连接将上一时刻的输出作为本时刻的输入,以便学习上下文信息。

其网络结构主要由输入层、隐藏层和输出层构成。

其中,隐藏层包含循环单元,用于存储前面输入的信息。

具体而言,循环神经网络通过隐藏层单元的记忆功能,能够将上下文信息融合到当前的计算中,从而在序列数据的预测和生成任务上取得优异的效果。

2. 应用场景循环神经网络主要应用于序列任务,如文本生成、语音识别、机器翻译、时间序列预测等。

例如,在机器翻译中,可以将源语言序列作为输入序列,目标语言序列作为输出序列,利用循环神经网络进行学习和预测,从而实现机器翻译的自动化。

结论本论文从原理和应用场景两个方面介绍了卷积神经网络和循环神经网络。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

deepLearnToolbox-master是一个深度学习matlab包,里面含有很多机器学习算法,如卷积神经网络CNN,深度信念网络DBN,自动编码AutoEncoder(堆栈SAE,卷积CAE)的作者是Rasmus Berg Palm)代码下载:rasmusbergpalm/DeepLearnToolbox

这里我们介绍deepLearnToolbox-master中的CNN部分。

DeepLearnToolbox-master中CNN内的函数:

调用关系为:

该模型使用了mnist的数字作为训练样本,作为cnn的一个使用样例,

每个样本特征为一个28*28=的向量。

网络结构为:

让我们来看看各个函数:

一、Test_example_CNN: (1)

三、 (2)

四、 (2)

五、 (2)

五、 (2)

六、 (3)

一、Test_example_CNN:

Test_example_CNN:

1设置CNN的基本参数规格,如卷积、降采样层的数量,卷积核的大小、降采样的降幅

2cnnsetup函数初始化卷积核、偏置等

3cnntrain函数训练cnn,把训练数据分成batch,然后调用

cnnff完成训练的前向过程,

cnnbp计算并传递神经网络的error,并计算梯度(权重的修改量)

cnnapplygrads把计算出来的梯度加到原始模型上去

4cnntest函数,测试当前模型的准确率

该模型采用的数据为,

含有70000个手写数字样本其中60000作为训练样本,10000作为测试样本。

把数据转成相应的格式,并归一化。

设置网络结构及训练参数

初始化网络,对数据进行批训练,验证模型准确率

绘制均方误差曲线

二、

该函数你用于初始化CNN的参数。

设置各层的mapsize大小,

初始化卷积层的卷积核、bias

尾部单层感知机的参数设置

*

bias统一设置为0

权重设置为:-1~1之间的随机数/sqrt(6/(输入神经元数量+输出神经元数量))

对于卷积核权重,输入输出为fan_in, fan_out

fan_out = {l}.outputmaps * {l}.kernelsize ^ 2;fin =1*25 or 6*25

fout=1*6*25 or 6*12*25

{l}.k{i}{j} = (rand{l}.kernelsize) - * 2 * sqrt(6 / (fan_in + fan_out));

1卷积降采样的参数初始化

2尾部单层感知机的参数(权重和偏量)设置:

三、

该函数用于训练CNN。

生成随机序列,每次选取一个batch(50)个样本进行训练。

批训练:计算50个随机样本的梯度,求和之后一次性更新到模型权重中。

在批训练过程中调用:

完成前向过程

完成误差传导和梯度计算过程

把计算出来的梯度加到原始模型上去

四、

1、取得CNN的输入

2、两次卷积核降采样层处理

3、尾部单层感知机的数据处理,需要把subFeatureMap2连接成为一个(4*4)*12=192的向量,但是由于采用了50样本批训练的方法,subFeatureMap2被拼合成为一个192*50的特征向量fv;

Fv作为单层感知机的输入,全连接的方式得到输出层

五、

该函数实现2部分功能,计算并传递误差,计算梯度

1、计算误差和LossFunction

2、计算尾部单层感知机的误差

3、把单层感知机的输入层featureVector的误差矩阵,恢复为subFeatureMap2的4*4二维矩阵形式插播一张图片:

4、误差在特征提取网络【卷积降采样层】的传播

如果本层是卷积层,它的误差是从后一层(降采样层)传过来,误差传播实际上是用降采样的反向过程,也就是降采样层的误差复制为2*2=4份。

卷积层的输入是经过sigmoid处理的,所以,从降采样层扩充来的误差要经过sigmoid求导处理。

如果本层是降采样层,他的误差是从后一层(卷积层)传过来,误差传播实际是用卷积的反向过程,也就是卷积层的误差,反卷积(卷积核转180度)卷积层的误差,原理参看插图。

5、计算特征抽取层和尾部单层感知机的梯度

五、

该函数完成权重修改,更新模型的功能

1更新特征抽取层的权重weight+bias

验证测试样本的准确率。