卷积神经网络全面解析之代码注释

卷积神经网络算法分析及图像处理示例

卷积神经网络算法分析及图像处理示例卷积神经网络(Convolutional Neural Network, CNN)是一种广泛应用于图像处理、语音识别等领域的深度神经网络,在计算机视觉中被广泛应用。

它的特殊之处在于,它的网络结构与人类的视觉神经结构有异曲同工之妙,能够有效提取图片中的图像特征。

下面将介绍我们是如何应用卷积神经网络对图像进行处理的,并对算法进行分析。

首先来看卷积神经网络的基本算法思想。

卷积神经网络是由卷积层、池化层、全连接层等基本组件构成的,其中卷积层是卷积神经网络的核心,因为它负责特征提取。

这么说可能还不是很清楚,下面就来详细分析一下卷积神经网络的算法。

卷积神经网络的算法分析主要分为两个方面:卷积层的算法和反向传播算法。

1. 卷积层的算法卷积神经网络的卷积层基本操作是使用固定大小的窗口在输入特征图(inputfeature map)的每个位置上对应进行卷积,然后将这些卷积结果组合成输出特征图(output feature map)。

一个卷积滤波器(卷积核)从输入特征图的左上角开始移动,每次向右移动一个像素,然后再向下移动一个像素。

卷积核内的值与输入特征值相乘之和(即内积)即为卷积结果,而这个卷积结果则成为输出特征值。

在卷积过程中,卷积核通常是可以学习的,也就是说,网络会自适应地训练卷积核以自动提取有用的特征。

这个训练过程是通过反向传播实现的。

2. 反向传播算法反向传播算法是卷积神经网络使用的一种优化算法,用于计算网络的误差梯度,以便对网络进行调整。

反向传播算法主要分为两个步骤:前向传播和反向传播。

前向传播是卷积神经网络中的重要环节,通过这一步骤可以得到每个节点的输出(forward pass)。

它通过不断迭代多次前向传播来计算最终输出。

反向传播是指统计误差并利用误差信息来训练网络(backward pass)。

它通过计算误差的反向传播,逐层更新每个节点的权重来训练网络,完成优化操作。

odenet代码解读

Odenet 是一种用于汽车驾驶环境的深度学习网络模型,主要用于处理和识别车辆周围的环境信息,例如车辆、行人、交通标志等。

Odenet 模型是基于卷积神经网络(CNN)的,它可以在复杂的环境中提取有用的特征并做出分类。

一般来说,Odenet 模型的代码包含以下几个部分:

1. 数据预处理:这部分代码主要负责对输入的图像数据进行处理,例如归一化、裁剪、缩放等。

2. 网络结构定义:这部分代码定义了Odenet 模型的网络结构,包括卷积层、池化层、全连接层等。

3. 损失函数和优化器定义:这部分代码定义了模型的损失函数和优化器,例如交叉熵损失函数、随机梯度下降优化器等。

4. 模型训练:这部分代码主要负责训练模型,包括前向传播、损失计算、反向传播、参数更新等。

5. 模型评估:这部分代码主要负责评估模型的性能,包括计算模型的准确率、召回率、F1 分数等。

6. 模型部署:这部分代码主要负责将训练好的模型部署到实际应用中,例如车辆周围环境的识别等。

卷积神经网络之LeNet

卷积神经⽹络之LeNet开局⼀张图,内容全靠编。

上图引⽤⾃ . ⽬前常⽤的卷积神经⽹络深度学习现在是百花齐放,各种⽹络结构层出不穷,计划梳理下各个常⽤的卷积神经⽹络结构。

⽬前先梳理下⽤于图像分类的卷积神经⽹络LeNetAlexNetVGGGoogLeNetResNet本⽂是关于卷积神经⽹络的开⼭之作LeNet的,之前想着论⽂较早,⼀直没有细读,仔细看了⼀遍收获满满啊。

本⽂有以下内容:LeNet ⽹络结构LeNet 论⽂LeNet keras实现,并应⽤CIFAR10进⾏测试LeNet的贡献LeNet-5可谓是第⼀个卷积神经⽹络,并且在⼿写数字识别上取得了很好的效果。

对于图像像素作为神经⽹络的输⼊数据⾯临的⼀些问题:1. 图像数据量较⼤,单独像素独⽴输⼊神经元中,需要很⼤的⽹络结构,训练参数过多2. 图像的形变,形变引起的图像特征位置变化的问题3. 图像的局部相关性。

其提出了卷积神经⽹络的概念,并应⽤局部感受野权值共享下采样(池化)来解决上述问题。

LeNet⽹络结构1998年的诞⽣的LeNet(LeCun et al. )可谓是现在各种卷积神经⽹络的始祖了,其⽹络结构虽然只有5层,却包含了卷积神经⽹络的基本组件(卷积层,池化层,全连接层)输⼊层 INPUT输⼊32×32×1的图像第⼀个卷积层 CONV1使⽤6个尺⼨为5×5的滤波器,在卷积的过程中不做边缘填充,步长为stride=1。

单个核的卷积输出⼤⼩为(32−5+1)×(32−5+1)=28×28。

由于有6个卷积核,所以整个卷积层输出得到为Feature Map为 28×28×6。

该层的参数滤波器的核: (5×5+1)×6=156,每个滤波器除了5×5的核以外,还有⼀个偏置。

神经元的个数:28×28×6。

在卷积层中,卷积核每移动⼀步产⽣⼀个神经元的输出,也就相当于⼀个神经元。

conv参数

conv参数Conv参数详解卷积神经网络(Convolutional Neural Network,简称CNN)是深度学习中广泛应用于图像处理的一种神经网络。

在CNN中,卷积层是最重要的一层,而卷积层的核心就是卷积操作。

在进行卷积操作时,需要设置一些参数,这些参数被称为Conv参数。

本文将对Conv参数进行详细解释。

1. 卷积核大小(kernel_size)卷积核大小指的是卷积核的宽度和高度。

在进行卷积操作时,将卷积核从左到右、从上到下地滑动,在每个位置上与输入数据进行点乘并相加得到输出特征图。

卷积核大小会影响输出特征图的大小和形状。

2. 步长(stride)步长指的是每次滑动卷积核的距离。

如果步长为1,则每次滑动一个像素;如果步长为2,则每次滑动两个像素。

步长越大,则输出特征图的尺寸越小。

3. 零填充(padding)零填充指的是在输入数据周围添加一圈0来扩大输入数据的大小。

零填充可以使得输出特征图与输入数据大小相同或者更大,并且可以减少边缘像素的信息丢失。

4. 输入通道数(in_channels)输入通道数指的是输入数据的通道数。

对于彩色图像而言,其通道数为3,分别代表红、绿、蓝三个颜色通道。

对于黑白图像而言,其通道数为1。

5. 输出通道数(out_channels)输出通道数指的是输出特征图的通道数。

在卷积层中,每个卷积核都会生成一个输出特征图,因此输出特征图的数量等于卷积核数量,也就是输出通道数。

6. 激活函数(activation)激活函数指的是在卷积操作后对输出进行非线性变换的函数。

常用的激活函数包括ReLU、sigmoid和tanh等。

7. 权重初始化方式(weight_init)权重初始化方式指的是对卷积核权重进行初始化的方法。

常用的权重初始化方法包括随机初始化、Xavier初始化和He初始化等。

8. 偏置项(bias)偏置项指的是在卷积操作后加上一个常量值来平移输出特征图。

偏置项可以增加模型拟合能力,并且可以使得模型更加灵活。

神经网络算法的代码实现详解

神经网络算法的代码实现详解神经网络算法是一种模拟人脑神经系统的计算模型,它通过构建多层神经元网络来实现对数据的学习与预测。

本文将对神经网络算法的代码实现进行详细解析,通过Python语言实现。

1.数据准备首先,我们需要准备训练数据和测试数据。

训练数据是用来训练神经网络的样本,通常包含一组输入数据和对应的输出数据。

测试数据则是用来测试训练后的神经网络模型的准确性。

2.构建神经网络结构接下来,我们需要构建神经网络的结构。

神经网络通常由多层神经元组成,每层神经元与上一层的神经元全连接。

我们可以使用Python的Numpy库来创建神经网络的结构,其中的矩阵运算能够高效地实现神经网络算法。

3.定义激活函数神经网络中,每个神经元都需要一个激活函数来对输入数据进行处理,并输出非线性的结果。

常用的激活函数有sigmoid函数、ReLU 函数等。

我们可以在构建神经网络结构时定义激活函数。

4.前向传播前向传播是指从输入层开始,逐层计算神经元的输出,直到输出层为止。

这一过程可以通过矩阵运算实现,其中每一层的输出都是上一层输出与权重矩阵的乘积再经过激活函数处理得到。

最终,输出层的输出即为神经网络的预测结果。

5.反向传播反向传播是指根据预测结果,逐层更新权重矩阵,以使得预测结果与实际结果尽可能接近。

反向传播算法通过计算误差项,逆向更新权重矩阵。

误差项的计算根据损失函数的不同而有所差异,常用的损失函数有均方误差、交叉熵等。

6.更新权重矩阵根据反向传播算法计算得到的误差项,我们可以更新每一层的权重矩阵。

更新的方法一般是使用梯度下降算法,通过计算每个权重的梯度值以及学习率,来逐步调整权重的取值。

7.训练神经网络模型在完成以上步骤后,我们可以开始训练神经网络模型。

训练过程即是重复进行前向传播和反向传播,以不断更新权重矩阵。

通过多次迭代,使得神经网络模型的预测结果逼近真实结果。

8.测试神经网络模型在训练完成后,我们需要使用测试数据对神经网络模型进行测试,以评估其性能。

深度学习CNN卷积神经网络入门PPT课件

softmax

softmax直白来说就是将原来输出是3,1,-3通过softmax函数一作用,就映射成为 (0,1)的值,而这些值的累和为1

VGG刺猬特征图可视化

第一层卷积核学 到的图片特征

VGG刺猬特征图可视化

第一层特征图的细节比较清晰和输入图片较为相似,提取出了输入 图片的边缘。

VGG刺猬特征图可视化

结束语

当你尽了自己的最大努力时,失败也是伟大的, 所以不要放弃,坚持就是正确的。

When You Do Your Best, Failure Is Great, So Don'T Give Up, Stick To The End

感谢聆听

不足之处请大家批评指导

Please Criticize And Guide The Shortcomings

参数数目计算

C1有156个参数:(5*5+1)*6=156

S2有12个参数:因为S2中每个map中的每个点都与C1的四个点相连接进行池化,一般做完 池化操作比如取最大或平均,还要乘以一个数,再加一个bias,再非线性变换

C3有1516个参数:C3也是通过5*5的卷积核由14*14的map得到10*10的map,不过这里连接 方式有点复杂,共有(5*5*3+1)*6+(5*5*4+1)*9+(5*5*6+1)*1=1516个参数。

逻辑回归

过拟合与欠拟合

基础知识

过拟合与欠拟合

正则化

λ=1

λ=0

λ=100

过拟合与欠拟合解决方案

解决欠拟合(高偏差)的方法 1.增加神经网络的隐藏层数和隐藏单元数等 2.增加更多的特征 3.调整参数和超参数 超参数包括: 神经网络中:学习率、学习衰减率、隐藏层数、隐藏层的单元数、batch_size、正则化参数λ等 4.降低正则化约束

resnet unet++代码

深度学习模型在计算机视觉领域有着广泛的应用,其中ResNet和UNet++是两种常用的神经网络模型。

它们在图像分类、目标检测、分割等任务中都取得了很好的效果。

在本文中,我们将重点介绍ResNet和UNet++的原理以及它们的代码实现。

一、ResNet原理ResNet是由微软亚洲研究院提出的一种深度残差网络。

传统的深度神经网络在网络层数增加时,容易出现梯度消失或梯度爆炸的问题,导致训练困难。

ResNet通过引入残差块(Residual Block),可以解决这一问题。

残差块的结构是将输入直接与输出相加,这样可以更好地保留原始输入的信息,同时使得网络更容易训练。

总体来说,ResNet 的核心思想是“学习残差”,即学习网络输出与目标的残差,而不是直接学习目标。

二、ResNet代码实现1. 引入相关库我们需要引入相关的Python库,如tensorflow或PyTorch等。

2. 定义残差块在代码中,我们需要定义残差块的结构,包括卷积层、批量归一化层和激活函数等。

3. 构建ResNet网络接下来,我们可以根据具体的任务需求,构建一个完整的ResNet网络,包括多个残差块、池化层和全连接层等。

4. 编写训练代码我们可以编写训练代码,包括数据加载、损失函数定义、优化器选择和模型训练等步骤。

三、UNet++原理UNet++是对经典的UNet模型的改进版本,主要解决了UNet模型在处理多尺度信息时的不足。

UNet++通过引入密集连接和多尺度特征融合的机制,使得网络能够更好地捕获图像中的细节信息,从而在图像分割任务中取得更好的性能。

四、UNet++代码实现1. 定义多尺度特征融合模块在代码中,我们需要定义一个多尺度特征融合模块,用于将不同层级的特征图进行融合。

2. 构建UNet++网络接下来,我们可以根据具体的任务需求,构建一个完整的UNet++网络,包括编码器、解码器和多尺度特征融合模块等。

3. 编写训练代码我们可以编写训练代码,包括数据加载、损失函数定义、优化器选择和模型训练等步骤。

【机器学习基础】卷积神经网络(CNN)基础

【机器学习基础】卷积神经⽹络(CNN)基础最近⼏天陆续补充了⼀些“线性回归”部分内容,这节继续机器学习基础部分,这节主要对CNN的基础进⾏整理,仅限于基础原理的了解,更复杂的内容和实践放在以后再进⾏总结。

卷积神经⽹络的基本原理 前⾯对全连接神经⽹络和深度学习进⾏了简要的介绍,这⼀节主要对卷积神经⽹络的基本原理进⾏学习和总结。

所谓卷积,就是通过⼀种数学变换的⽅式来对特征进⾏提取,通常⽤于图⽚识别中。

既然全连接的神经⽹络可以⽤于图⽚识别,那么为什么还要⽤卷积神经⽹络呢?(1)⾸先来看下⾯⼀张图⽚: 在这个图⽚当中,鸟嘴是⼀个很明显的特征,当我们做图像识别时,当识别到有“鸟嘴”这样的特征时,可以具有很⾼的确定性认为图⽚是⼀个鸟类。

那么,在提取特征的过程中,有时就没有必要去看完整张图⽚,只需要⼀⼩部分就能识别出⼀定具有代表的特征。

因此,使⽤卷积就可以使某⼀个特定的神经元(在这⾥,这个神经元可能就是⽤来识别“鸟嘴”的)仅仅处理带有该特征的部分图⽚就可以了,⽽不必去看整张图⽚。

那么这样就会使得这个神经元具有更少的参数(因为不⽤再跟图⽚的每⼀维输⼊都连接起来)。

(2)再来看下⾯⼀组图⽚:上⾯两张图⽚都是鸟类,⽽不同的是,两只鸟的“鸟嘴”的位置不同,但在普通的神经⽹络中,需要有两个神经元,⼀个去识别左上⾓的“鸟嘴”,另⼀个去识别中间的“鸟嘴”: 但其实这两个“鸟嘴”的形状是⼀样的,这样相当于上⾯两个神经元是在做同⼀件事情。

⽽在卷积神经⽹络中,这两个神经元可以共⽤⼀套参数,⽤来做同⼀件事情。

(3)对样本进⾏⼦采样,往往不会影响图⽚的识别。

如下⾯⼀张图: 假设把⼀张图⽚当做⼀个矩阵的话,取矩阵的奇数⾏和奇数列,可看做是对图⽚的⼀种缩放,⽽这种缩放往往不会影响识别效果。

卷积神经⽹络中就可以对图⽚进⾏缩放,是图⽚变⼩,从⽽减少模型的参数。

卷积神经⽹络的基本结构如图所⽰: 从右到左,输⼊⼀张图⽚→卷积层→max pooling(池化层)→卷积层→max pooling(池化层)→......→展开→全连接神经⽹络→输出。

十种深度学习算法要点及代码解析

十种深度学习算法要点及代码解析一、卷积神经网络(CNN)1.1算法原理:卷积神经网络(CNN)是一种深度神经网络,通过一系列卷积层和池化层实现特征提取和信息处理,可以有效的处理图像、语音、文字等多种复杂数据,相比传统的神经网络,其特征更加准确、泛化能力更强,训练更快;1.2基本结构:CNN通常由输入层、卷积层、激活层、池化层、全连接层(FC)组成;1.3应用场景:CNN应用最广泛的场景是机器视觉,对图像进行分类、识别和特征提取,特别是在人脸识别、图像分类等领域;(1)构建卷积神经网络先导入必要的库:from keras.models import Sequential #导入序列模型from yers import Conv2D, MaxPooling2D #导入卷积层和池化层from yers import Activation, Dropout, Flatten, Dense #导入激活函数、Dropout层、Flatten层、全连接层#构建模型#实例化一个Sequential模型model = Sequential#第1层卷积model.add(Conv2D(32, (3, 3), input_shape = (32, 32, 3))) model.add(Activation('relu'))#第2层卷积model.add(Conv2D(32, (3, 3)))model.add(Activation('relu'))#第3层池化model.add(MaxPooling2D(pool_size = (2, 2)))#第4层Dropoutmodel.add(Dropout(0.25))#第5层Flatten层model.add(Flatten()#第6层全连接model.add(Dense(128))model.add(Activation('relu'))#第7层Dropout层model.add(Dropout(0.5))#第8层全连接model.add(Dense(10))model.add(Activation('softmax'))。

卷积神经网络全面解析之代码详解

卷积神经网络全面解析之代码详解本文介绍多层感知机算法,特别是详细解读其代码实现,基于python theano,代码来自:Convolutional Neural Networks (LeNet)。

一、CNN卷积神经网络原理简介要讲明白卷积神经网络,估计得长篇大论,网上有很多博文已经写得很好了,所以本文就不重复了,如果你了解CNN,那可以往下看,本文主要是详细地解读CNN的实现代码。

CNN的最大特点就是稀疏连接(局部感受)和权值共享,如下面两图所示,左为稀疏连接,右为权值共享。

稀疏连接和权值共享可以减少所要训练的参数,减少计算复杂度。

至于CNN的结构,以经典的LeNet5来说明:这个图真是无处不在,一谈CNN,必说LeNet5,这图来自于这篇论文:Gradient-Based Learning Applied to Document Recognition,论文很长,第7页那里开始讲LeNet5这个结构,建议看看那部分。

我这里简单说一下,LeNet5这张图从左到右,先是input,这是输入层,即输入的图片。

input-layer到C1这部分就是一个卷积层(convolution运算),C1到S2是一个子采样层(pooling运算),关于卷积和子采样的具体过程可以参考下图:然后,S2到C3又是卷积,C3到S4又是子采样,可以发现,卷积和子采样都是成对出现的,卷积后面一般跟着子采样。

S4到C5之间是全连接的,这就相当于一个MLP的隐含层了(如果你不清楚MLP,参考《DeepLearning tutorial(3)MLP多层感知机原理简介+代码详解》)。

C5到F6同样是全连接,也是相当于一个MLP的隐含层。

最后从F6到输出output,其实就是一个分类器,这一层就叫分类层。

ok,CNN的基本结构大概就是这样,由输入、卷积层、子采样层、全连接层、分类层、输出这些基本“构件”组成,一般根据具体的应用或者问题,去确定要多少卷积层和子采样层、采用什么分类器。

使用卷积神经网络进行序列标注的技巧和注意事项

使用卷积神经网络进行序列标注的技巧和注意事项序列标注是自然语言处理中的一项重要任务,它涉及到对文本中的每个单词或字符进行分类或标注。

近年来,深度学习技术的快速发展为序列标注任务带来了新的突破,其中卷积神经网络(Convolutional Neural Network,CNN)被广泛应用于序列标注任务中。

本文将介绍使用卷积神经网络进行序列标注的技巧和注意事项。

一、数据预处理在使用卷积神经网络进行序列标注之前,首先需要对数据进行预处理。

常见的预处理步骤包括分词、词性标注、去除停用词等。

此外,还需要将文本转换成适合卷积神经网络输入的格式。

一种常见的方式是使用词嵌入(Word Embedding)技术将文本表示为稠密向量,例如Word2Vec、GloVe等。

这样可以将文本表示为一个二维矩阵,其中每一行表示一个词或字符的词向量。

二、卷积神经网络模型设计在设计卷积神经网络模型时,需要考虑输入数据的特点和任务的要求。

对于序列标注任务,一般使用卷积神经网络的一维卷积层来处理文本序列。

一维卷积层的输入是一个二维矩阵,其中每一行表示一个词或字符的词向量。

卷积层的输出是一个三维张量,其中每个通道对应一个特征图。

可以通过调整卷积核的大小、数量和步长来控制特征图的大小和数量。

在卷积层之后,可以添加池化层来减少特征图的维度。

常见的池化方式有最大池化和平均池化。

最大池化将每个特征图中的最大值作为输出,而平均池化将每个特征图中的平均值作为输出。

池化层的作用是提取最重要的特征并减少计算量。

三、注意事项在使用卷积神经网络进行序列标注时,还需要注意一些问题。

首先是模型的选择和调参。

由于卷积神经网络有很多变种,选择合适的模型对于任务的性能至关重要。

此外,还需要调整模型的超参数,如学习率、批大小、卷积核的大小、数量和步长等。

其次是数据集的划分和评估。

为了准确评估模型的性能,需要将数据集划分为训练集、验证集和测试集。

训练集用于模型的训练,验证集用于模型的调参,测试集用于评估模型的性能。

convtasnet代码讲解

Convtasnet代码讲解1. 引言Convtasnet是一个用于语音分离的深度学习模型,它基于卷积神经网络(CNN)和转置卷积(Transposed Convolution)的结构。

该模型在语音分离任务上取得了显著的成果,被广泛应用于音频处理领域。

本文将对Convtasnet的代码进行讲解,以便读者能够深入理解该模型的实现细节。

2. 模型结构Convtasnet的核心结构由卷积神经网络和Transformer模块组成。

在代码实现中,卷积神经网络用于提取语音特征,而Transformer模块用于对特征进行编码和解码。

模型还包括了损失函数以及优化器等组件。

在接下来的讲解中,我们将逐步介绍这些组件的具体实现。

3. 卷积神经网络在Convtasnet中,卷积神经网络被用来提取语音特征。

具体来说,模型采用了一维卷积(1D Convolution)来对语音信号进行卷积操作,从而捕获语音中的时域特征。

在代码中,卷积层的参数设置和卷积核的设计都对模型的性能有着重要影响,我们将详细讨论这些实现细节。

4. Transformer模块Transformer模块在Convtasnet中用于对特征进行编码和解码,它由多个自注意力层(Self-Attention Layer)和前馈神经网络(Feed-Forward Neural Network)组成。

在代码中,我们将讨论如何实现这些组件,并且介绍它们在语音分离任务中的作用。

5. 损失函数为了训练Convtasnet模型,我们需要定义合适的损失函数。

常用的语音分离损失函数包括均方误差(Mean Squared Error)和混合度谱损失(Mixed-SNR Loss)。

在代码实现中,我们将详细介绍这些损失函数的实现方式,并分析它们对模型训练的影响。

6. 优化器优化器在深度学习模型的训练中起着至关重要的作用。

在Convtasnet 的代码实现中,我们将讨论常用的优化器(如Adam、SGD等)的选择和参数调整策略,以及它们在训练过程中的效果。

3DU-Net卷积神经网络

3DU-Net卷积神经⽹络3D U-Net这篇论⽂的诞⽣主要是为了处理⼀些块状图(volumetric images),基本的原理跟U-Net其实并⽆⼤差,因为3D U-Net就是⽤3D 卷积操作替换了2D的,不过在这篇博⽂中我会按照论⽂的结构⼤概介绍⼀下整体的原理及结构运⽤。

当然在原本的论⽂中,论⽂作者为了证实框架的可执⾏性及实验的最终结果,是设⽴了两组不同的实验的,⼀个是半⾃动设置(即:⼈为地利⽤算法对3D图像中地某些切⽚(slices)进⾏标注然后再放⼊模型中去跑程序),⽽另外⼀种情况则是作者假设有代表性地,稀疏地标注训练集是存在地,直接将数据输⼊模型进⾏end-to-end地训练,这部分地处理我将不详细描述,有兴趣的朋友或者⼩伙伴请点击下⾯论⽂链接进⾏下载阅读理解,在博⽂中将主要讲述3D U-Net的结构及特征。

1. 介绍(Introduction)⽣物医学影像(biomedical images)很多时候都是块状的,也就是说是由很多个切⽚构成⼀整张图的存在。

如果是⽤2D的图像处理模型去处理3D本⾝不是不可以,但是会存在⼀个问题,就是不得不将⽣物医学影像的图⽚⼀个slice⼀个slice成组的(包含训练数据和标注好的数据)的送进去设计的模型进⾏训练,在这种情况下会存在⼀个效率问题,因⽽很多时候处理块状图的时候会让任感到不适,并且数据预处理的⽅式也相对⽐较繁琐(tedious)。

所以,论⽂的作者就提出来了3D -Net模型,模型不仅解决了效率的问题,并且对于块状图的切割只要求数据中部分切⽚被标注即可(可参考下图说明)。

2. 模型结构(Network Architecture)整个3D U-Net的模型是基于之前U-Net(2D)创建⽽来,同样包含了⼀个encoder部分和⼀个decoder部分,encoder部分是⽤来分析整张图⽚并且进⾏特征提取与分析,⽽与之相对应的decoder部分是⽣成⼀张分割好的块状图。

卷积神经网络(CNN,ConvNet)及其原理详解

卷积神经网络(CNN,ConvNet)及其原理详解卷积神经网络(CNN,有时被称为ConvNet)是很吸引人的。

在短时间内,它们变成了一种颠覆性的技术,打破了从文本、视频到语音等多个领域所有最先进的算法,远远超出了其最初在图像处理的应用范围。

CNN 由许多神经网络层组成。

卷积和池化这两种不同类型的层通常是交替的。

网络中每个滤波器的深度从左到右增加。

最后通常由一个或多个全连接的层组成:图1 卷积神经网络的一个例子Convnets 背后有三个关键动机:局部感受野、共享权重和池化。

让我们一起看一下。

局部感受野如果想保留图像中的空间信息,那么用像素矩阵表示每个图像是很方便的。

然后,编码局部结构的简单方法是将相邻输入神经元的子矩阵连接成属于下一层的单隐藏层神经元。

这个单隐藏层神经元代表一个局部感受野。

请注意,此操作名为“卷积”,此类网络也因此而得名。

当然,可以通过重叠的子矩阵来编码更多的信息。

例如,假设每个子矩阵的大小是5×5,并且将这些子矩阵应用到28×28 像素的MNIST 图像。

然后,就能够在下一隐藏层中生成23×23 的局部感受野。

事实上,在触及图像的边界之前,只需要滑动子矩阵23 个位置。

定义从一层到另一层的特征图。

当然,可以有多个独立从每个隐藏层学习的特征映射。

例如,可以从28×28 输入神经元开始处理MNIST 图像,然后(还是以5×5 的步幅)在下一个隐藏层中得到每个大小为23×23 的神经元的k 个特征图。

共享权重和偏置假设想要从原始像素表示中获得移除与输入图像中位置信息无关的相同特征的能力。

一个简单的直觉就是对隐藏层中的所有神经元使用相同的权重和偏置。

通过这种方式,每层将从图像中学习到独立于位置信息的潜在特征。

理解卷积的一个简单方法是考虑作用于矩阵的滑动窗函数。

在下面的例子中,给定输入矩阵I 和核K,得到卷积输出。

将3×3 核K(有时称为滤波器或特征检测器)与输入矩阵逐元素地相乘以得到输出卷积矩阵中的一个元素。

CNN卷积神经网络详解

CNN卷积神经⽹络详解分割线---------------------------------- 这⾥更新过⼀次,在朋友的提醒下,我发现这份代码不是很容易懂。

我使⽤了Pytorch给的官⽅demo重新实现了LeNet,并做出了详细解释,如果理解下⾯代码有问题,可以先看我的这篇⽂章,它能够帮助你更好的理解这篇⽂章中的代码,⽂章地址->:分割线----------------------------------前⾔ 在学计算机视觉的这段时间⾥整理了不少的笔记,想着就把这些笔记再重新整理出来,然后写成Blog和⼤家⼀起分享。

⽬前的计划如下(以下⽹络全部使⽤Pytorch搭建):专题⼀:计算机视觉基础介绍CNN⽹络(计算机视觉的基础)浅谈VGG⽹络,介绍ResNet⽹络(⽹络特点是越来越深)介绍GoogLeNet⽹络(⽹络特点是越来越宽)介绍DenseNet⽹络(⼀个看似⼗分NB但是却实际上⽤得不多的⽹络)整理期间还会分享⼀些⾃⼰正在参加的⽐赛的Baseline专题⼆:GAN⽹络搭建普通的GAN⽹络卷积GAN条件GAN模式崩溃的问题及⽹络优化 以上会有相关代码实践,代码是基于Pytorch框架。

话不多说,我们先进⾏专题⼀的第⼀部分介绍,卷积神经⽹络。

⼀、CNN解决了什么问题? 在CNN出现之前,对于图像的处理⼀直都是⼀个很⼤的问题,⼀⽅⾯因为图像处理的数据量太⼤,⽐如⼀张512 x 512的灰度图,它的输⼊参数就已经达到了252144个,更别说1024x1024x3之类的彩⾊图,这也导致了它的处理成本⼗分昂贵且效率极低。

另⼀⽅⾯,图像在数字化的过程中很难保证原有的特征,这也导致了图像处理的准确率不⾼。

⽽CNN⽹络能够很好的解决以上两个问题。

对于第⼀个问题,CNN⽹络它能够很好的将复杂的问题简单化,将⼤量的参数降维成少量的参数再做处理。

也就是说,在⼤部分的场景下,我们使⽤降维不会影响结果。

⽐如在⽇常⽣活中,我们⽤⼀张1024x1024x3表⽰鸟的彩⾊图和⼀张100x100x3表⽰鸟的彩⾊图,我们基本上都能够⽤⾁眼辨别出这是⼀只鸟⽽不是⼀只狗。

卷积神经网络CNN代码解析matlab

卷积神经网络CNN代码解析 deepLearnToolbox-master是一个深度学习matlab包,里面含有很多机器学习算法,如卷积神经网络CNN,深度信念网络DBN,自动编码AutoEncoder 堆栈SAE,卷积CAE的作者是 Rasmus Berg Palm代码下载:这里我们介绍deepLearnToolbox-master中的CNN部分; DeepLearnToolbox-master中CNN内的函数:调用关系为:该模型使用了mnist的数字作为训练样本,作为cnn的一个使用样例,每个样本特征为一个2828=的向量;网络结构为:让我们来看看各个函数:一、Test_example_CNN:Test_example_CNN:1设置CNN的基本参数规格,如卷积、降采样层的数量,卷积核的大小、降采样的降幅2 cnnsetup函数初始化卷积核、偏置等3 cnntrain函数训练cnn,把训练数据分成batch,然后调用cnnff 完成训练的前向过程,cnnbp计算并传递神经网络的error,并计算梯度权重的修改量cnnapplygrads 把计算出来的梯度加到原始模型上去4 cnntest 函数,测试当前模型的准确率该模型采用的数据为,含有70000个手写数字样本其中60000作为训练样本,10000作为测试样本; 把数据转成相应的格式,并归一化;设置网络结构及训练参数初始化网络,对数据进行批训练,验证模型准确率绘制均方误差曲线二、该函数你用于初始化CNN的参数;设置各层的mapsize大小,初始化卷积层的卷积核、bias尾部单层感知机的参数设置bias统一设置为0权重设置为:-1~1之间的随机数/sqrt6/输入神经元数量+输出神经元数量对于卷积核权重,输入输出为fan_in, fan_outfan_out = {l}.outputmaps {l}.kernelsize ^ 2;%卷积核初始化,1层卷积为16个卷积核,2层卷积一共612=72个卷积核;对于每个卷积输出featuremap,%fan_in = 表示该层的一个输出map,所对应的所有卷积核,包含的神经元的总数;125,625fan_in = numInputmaps {l}.kernelsize ^ 2;fin =125 or 625fout=1625 or 61225{l}.k{i}{j} = rand{l}.kernelsize - 2 sqrt6 / fan_in + fan_out;1 卷积降采样的参数初始化2尾部单层感知机的参数权重和偏量设置:三、该函数用于训练CNN;生成随机序列,每次选取一个batch50个样本进行训练;批训练:计算50个随机样本的梯度,求和之后一次性更新到模型权重中;在批训练过程中调用:完成前向过程完成误差传导和梯度计算过程把计算出来的梯度加到原始模型上去四、1、取得CNN的输入2、两次卷积核降采样层处理3、尾部单层感知机的数据处理,需要把subFeatureMap2连接成为一个4412=192的向量,但是由于采用了50样本批训练的方法,subFeatureMap2被拼合成为一个19250的特征向量fv;Fv作为单层感知机的输入,全连接的方式得到输出层五、该函数实现2部分功能,计算并传递误差,计算梯度1、计算误差和LossFunction2、计算尾部单层感知机的误差3、把单层感知机的输入层featureVector的误差矩阵,恢复为subFeatureMap2的44二维矩阵形式插播一张图片:4、误差在特征提取网络卷积降采样层的传播如果本层是卷积层,它的误差是从后一层降采样层传过来,误差传播实际上是用降采样的反向过程,也就是降采样层的误差复制为22=4份;卷积层的输入是经过sigmoid处理的,所以,从降采样层扩充来的误差要经过sigmoid求导处理;如果本层是降采样层,他的误差是从后一层卷积层传过来,误差传播实际是用卷积的反向过程,也就是卷积层的误差,反卷积卷积核转180度卷积层的误差,原理参看插图;5、计算特征抽取层和尾部单层感知机的梯度五、该函数完成权重修改,更新模型的功能1更新特征抽取层的权重 weight+bias2 更新末尾单层感知机的权重 weight+bias 六、验证测试样本的准确率。

通俗理解卷积神经网络

通俗理解卷积神经⽹络1 前⾔2012年我在北京组织过8期machine learning读书会,那时“”⾮常⽕,很多⼈都对其抱有巨⼤的热情。

当我2013年再次来到北京时,有⼀个词似乎⽐“机器学习”更⽕,那就是“深度学习”。

本博客内写过⼀些机器学习相关的⽂章,但上⼀篇技术⽂章“LDA主题模型”还是写于2014年11⽉份,毕竟⾃2015年开始创业做在线教育后,太多的杂事、琐碎事,让我⼀直想再写点技术性⽂章但每每恨时间抽不开。

然由于公司在不断开机器学习、深度学习等相关的在线课程,⽿濡⽬染中,总会顺带学习学习。

我虽不参与讲任何课程(公司的所有在线课程都是由⽬前讲师团队的17位讲师讲),但依然可以⽤最最⼩⽩的⽅式把⼀些初看复杂的东西抽丝剥茧的通俗写出来。

这算重写技术博客的价值所在。

在dl中,有⼀个很重要的概念,就是卷积神经⽹络CNN,基本是⼊门dl必须搞懂的东西。

本⽂基本根据斯坦福的机器学习公开课、cs231n、与七⽉在线寒⽼师讲的5⽉dl班第4次课CNN与常⽤框架视频所写,是⼀篇课程笔记。

本只是想把重点放在其卷积计算具体是怎么计算怎么操作的,但后⾯不断补充,故写成了关于卷积神经⽹络的通俗导论性的⽂章。

有何问题,欢迎不吝指正。

2 ⼈⼯神经⽹络2.1 神经元神经⽹络由⼤量的节点(或称“神经元”、“单元”)和相互连接⽽成。

每个神经元接受输⼊的线性组合,进⾏⾮线性变换(亦称激活函数activation function)后输出。

每两个节点之间的连接代表加权值,称之为权重(weight)。

不同的权重和激活函数,则会导致神经⽹络不同的输出。

举个⼿写识别的例⼦,给定⼀个未知数字,让神经⽹络识别是什么数字。

此时的神经⽹络的输⼊由⼀组被输⼊图像的像素所激活的输⼊神经元所定义。

在通过激活函数进⾏⾮线性变换后,神经元被激活然后被传递到其他神经元。

重复这⼀过程,直到最后⼀个输出神经元被激活。

从⽽识别当前数字是什么字。

神经⽹络的每个神经元/单元如下类似wx + b的形式,其中a1~an为输⼊向量,当然,也常⽤x1~xn表⽰输⼊w1~wn为权重b为偏置biasf 为激活函数t 为输出如果只是上⾯这样⼀说,估计以前没接触过的⼗有⼋九⼜必定迷糊了。

深度学习——带你通俗理解卷积神经网络(CNN)

深度学习——带你通俗理解卷积神经⽹络(CNN)卷积神经⽹络(CNN)基础知识⽂章⽬录1.前⾔ 如果说深度神经⽹络模型中的“明星”是谁?那么⾮卷积神经⽹络莫属。

下⾯给⼤家简单介绍⼀下CNN的基础知识。

其中CNN基础主要涉及卷积层、池化层、全连接层在卷积神经⽹络扮演的⾓⾊、实现的具体的功能和⼯作原理。

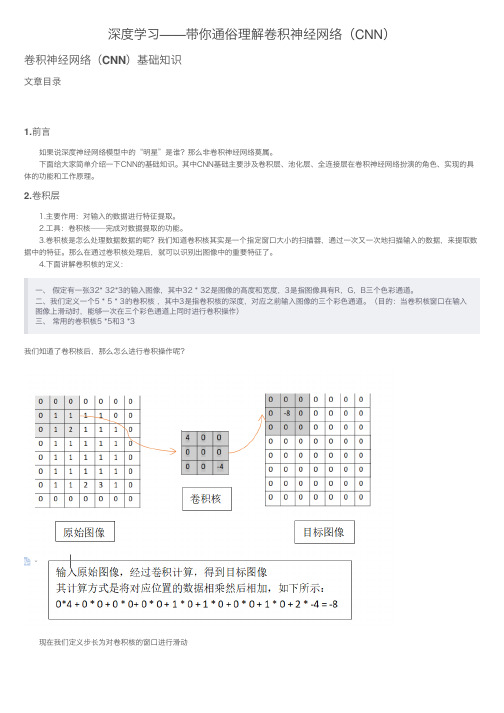

2.卷积层 1.主要作⽤:对输⼊的数据进⾏特征提取。

2.⼯具:卷积核——完成对数据提取的功能。

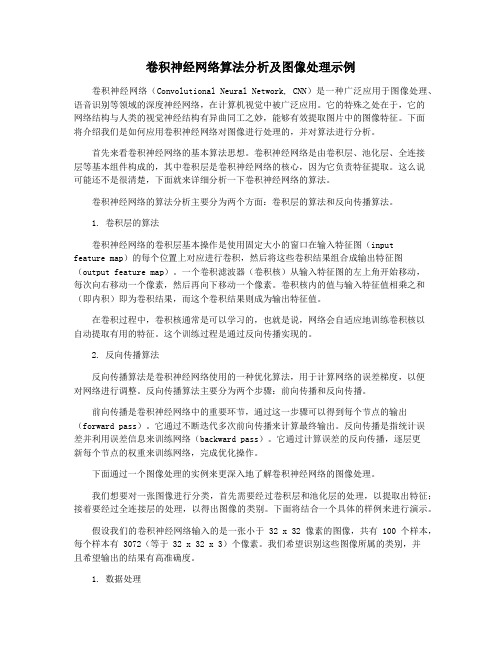

3.卷积核是怎么处理数据数据的呢?我们知道卷积核其实是⼀个指定窗⼝⼤⼩的扫描器,通过⼀次⼜⼀次地扫描输⼊的数据,来提取数据中的特征。

那么在通过卷积核处理后,就可以识别出图像中的重要特征了。

4.下⾯讲解卷积核的定义:⼀、 假定有⼀张32* 32*3的输⼊图像,其中32 * 32是图像的⾼度和宽度,3是指图像具有R,G,B三个⾊彩通道。

⼆、我们定义⼀个5 * 5 * 3的卷积核 ,其中3是指卷积核的深度,对应之前输⼊图像的三个彩⾊通道。

(⽬的:当卷积核窗⼝在输⼊图像上滑动时,能够⼀次在三个彩⾊通道上同时进⾏卷积操作)三、 常⽤的卷积核5 *5和3 *3我们知道了卷积核后,那么怎么进⾏卷积操作呢? 现在我们定义步长为对卷积核的窗⼝进⾏滑动 下图为⼀个步长为2的卷积核经过⼀次滑动窗⼝位置变化情况 仔细观察不难发现,在上⾯的输⼊图像的最外界多了⼀圈全为0的像素,这其实就是⼀种⽤于提升卷积效果的边界像素扩充的⽅法共有两种⽅式进⾏填充Same和Valid1.Same在输⼊图像的最外界加上指定层数的值全为0的像素边界:为了让输⼊图像的全部像素能被滑动窗⼝捕捉。

2.Valid直接对输⼊图像进⾏卷积,不对输⼊图像进⾏任何的前期处理和图像填充。

缺点就是会导致部分像素点不嫩被滑动窗⼝捕捉。

通过对卷积过程的计算,可以得出卷积通⽤公式⽤于计算输⼊图像经过⼀轮卷积操作后的输出图像的宽度和⾼度的参数 其中W,H分别代表图像的宽度和⾼度的值;下标input代表输⼊图像的相关参数;下标output表⽰输出图像的相关参数,filter代表卷积核的相关参数,S代表卷积的步长,P(padding)代表在图像边缘增加的边界像素层数。

[数据分析] 推荐 :用Python实现神经网络(附完整代码)!

![[数据分析] 推荐 :用Python实现神经网络(附完整代码)!](https://img.taocdn.com/s3/m/8c8a5b6a52ea551810a687fd.png)

在学习神经网络之前,我们需要对神经网络底层先做一个基本的了解。

我们将在本节介绍感知机、反向传播算法以及多种梯度下降法以给大家一个全面的认识。

一、感知机数字感知机的本质是从数据集中选取一个样本(example),并将其展示给算法,然后让算法判断“是”或“不是”。

一般而言,把单个特征表示为xi,其中i是整数。

所有特征的集合表示为,表示一个向量:,类似地,每个特征的权重表示为其中对应于与该权重关联的特征的下标,所有权重可统一表示为一个向量:这里有一个缺少的部分是是否激活神经元的阈值。

一旦加权和超过某个阈值,感知机就输出1,否则输出0。

我们可以使用一个简单的阶跃函数(在图5-2中标记为“激活函数”)来表示这个阈值。

一般而言我们还需要给上面的阈值表达式添加一个偏置项以确保神经元对全0的输入具有弹性,否则网络在输入全为0的情况下输出仍然为0。

注:所有神经网络的基本单位都是神经元,基本感知机是广义神经元的一个特例,从现在开始,我们将感知机称为一个神经元。

二、反向传播算法2.1 代价函数很多数据值之间的关系不是线性的,也没有好的线性回归或线性方程能够描述这些关系。

许多数据集不能用直线或平面来线性分割。

比如下图中左图为线性可分的数据,而右图为线性不可分的数据:在这个线性可分数据集上对两类点做切分得到的误差可以收敛于0,而对于线性不可分的数据点集,我们无法做出一条直线使得两类点被完美分开,因此我们任意做一条分割线,可以认为在这里误差不为0,因此我们需要一个衡量误差的函数,通常称之为代价函数:而我们训练神经网络(感知机)的目标是最小化所有输入样本数据的代价函数2.2 反向传播权重通过下一层的权重()和()来影响误差,因此我们需要一种方法来计算对误差的贡献,这个方法就是反向传播。

下图中展示的是一个全连接网络,图中没有展示出所有的连接,在全连接网络中,每个输入元素都与下一层的各个神经元相连,每个连接都有相应的权重。

因此,在一个以四维向量为输入、有5个神经元的全连接神经网络中,一共有20个权重(5个神经元各连接4个权重)。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

卷积神经网络全面解析之代码注释自己平时看了一些论文,但老感觉看完过后就会慢慢的淡忘,某一天重新拾起来的时候又好像没有看过一样。

所以想习惯地把一些感觉有用的论文中的知识点总结整理一下,一方面在整理过程中,自己的理解也会更深,另一方面也方便未来自己的勘察。

更好的还可以放到博客上面与大家交流。

因为基础有限,所以对论文的一些理解可能不太正确,还望大家不吝指正交流.下面是自己对代码的注释:cnnexamples.m[plain]view plain copy1.clear all; close all; clc;2.addpath('../data');3.addpath('../util');4.load mnist_uint8;5.6.train_x = double(reshape(train_x',28,28,60000))/255;7.test_x = double(reshape(test_x',28,28,10000))/255;8.train_y = double(train_y');9.test_y = double(test_y');10.11.%% ex112.%will run 1 epoch in about 200 second and get around 11% error.13.%With 100 epochs you'll get around 1.2% error14.15.c yers = {16. struct('type', 'i') %input layer17. struct('type', 'c', 'outputmaps', 6, 'kernelsize', 5) %convolution layer18. struct('type', 's', 'scale', 2) %sub sampling layer19. struct('type', 'c', 'outputmaps', 12, 'kernelsize', 5) %convolution layer20. struct('type', 's', 'scale', 2) %subsampling layer21.};22.23.%这里把cnn的设置给cnnsetup,它会据此构建一个完整的CNN网络,并返回24.c nn = cnnsetup(cnn, train_x, train_y);25.26.%学习率27.o pts.alpha = 1;28.%每次挑出一个batchsize的batch来训练,也就是每用batchsize个样本就调整一次权值,而不是29.%把所有样本都输入了,计算所有样本的误差了才调整一次权值30.o pts.batchsize = 50;31.%训练次数,用同样的样本集。

我训练的时候:32.% 1的时候 11.41% error33.% 5的时候 4.2% error34.% 10的时候 2.73% error35.o pts.numepochs = 10;36.37.%然后开始把训练样本给它,开始训练这个CNN网络38.c nn = cnntrain(cnn, train_x, train_y, opts);39.40.%然后就用测试样本来测试41.[er, bad] = cnntest(cnn, test_x, test_y);42.43.%plot mean squared error44.p lot(cnn.rL);45.%show test error46.d isp([num2str(er*100) '% error']);cnnsetup.m[plain]view plain copy1.function net = cnnsetup(net, x, y)2. inputmaps = 1;3. % B=squeeze(A) 返回和矩阵A相同元素但所有单一维都移除的矩阵B,单一维是满足size(A,dim)=1的维。

4. % train_x中图像的存放方式是三维的reshape(train_x',28,28,60000),前面两维表示图像的行与列,5. % 第三维就表示有多少个图像。

这样squeeze(x(:, :, 1))就相当于取第一个图像样本后,再把第三维6. % 移除,就变成了28x28的矩阵,也就是得到一幅图像,再size一下就得到了训练样本图像的行数与列数了7. mapsize = size(squeeze(x(:, :, 1)));8.9. % 下面通过传入net这个结构体来逐层构建CNN网络10. % n = numel(A)返回数组A中元素个数11. % yers中有五个struct类型的元素,实际上就表示CNN共有五层,这里范围的是512. for l = 1 : numel(yers) % layer13. if strcmp(yers{l}.type, 's') % 如果这层是子采样层14. % subsampling层的mapsize,最开始mapsize是每张图的大小28*2815. % 这里除以scale=2,就是pooling之后图的大小,pooling域之间没有重叠,所以pooling后的图像为14*1416. % 注意这里的右边的mapsize保存的都是上一层每张特征map的大小,它会随着循环进行不断更新17. mapsize = floor(mapsize / yers{l}.scale);18. for j = 1 : inputmaps % inputmap就是上一层有多少张特征图19. yers{l}.b{j} = 0; % 将偏置初始化为020. end21. end22. if strcmp(yers{l}.type, 'c') % 如果这层是卷积层23. % 旧的mapsize保存的是上一层的特征map的大小,那么如果卷积核的移动步长是1,那用24. % kernelsize*kernelsize大小的卷积核卷积上一层的特征map后,得到的新的map的大小就是下面这样25. mapsize = mapsize - yers{l}.kernelsize + 1;26. % 该层需要学习的参数个数。

每张特征map是一个(后层特征图数量)*(用来卷积的patch图的大小)27. % 因为是通过用一个核窗口在上一个特征map层中移动(核窗口每次移动1个像素),遍历上一个特征map28. % 层的每个神经元。

核窗口由kernelsize*kernelsize个元素组成,每个元素是一个独立的权值,所以29. % 就有kernelsize*kernelsize个需要学习的权值,再加一个偏置值。

另外,由于是权值共享,也就是30. % 说同一个特征map层是用同一个具有相同权值元素的kernelsize*kernelsize的核窗口去感受输入上一31. % 个特征map层的每个神经元得到的,所以同一个特征map,它的权值是一样的,共享的,权值只取决于32. % 核窗口。

然后,不同的特征map提取输入上一个特征map层不同的特征,所以采用的核窗口不一样,也33. % 就是权值不一样,所以outputmaps个特征map就有(kernelsize*kernelsize+1)* outputmaps那么多的权值了34. % 但这里fan_out只保存卷积核的权值W,偏置b在下面独立保存35. fan_out = yers{l}.outputmaps * yers{l}.kernelsize ^ 2;36. for j = 1 : yers{l}.outputmaps % output map37. % fan_out保存的是对于上一层的一张特征map,我在这一层需要对这一张特征map提取outputmaps种特征,38. % 提取每种特征用到的卷积核不同,所以fan_out保存的是这一层输出新的特征需要学习的参数个数39. % 而,fan_in保存的是,我在这一层,要连接到上一层中所有的特征map,然后用fan_out保存的提取特征40. % 的权值来提取他们的特征。

也即是对于每一个当前层特征图,有多少个参数链到前层41. fan_in = inputmaps * yers{l}.kernelsize ^ 2;42. for i = 1 : inputmaps % input map43. % 随机初始化权值,也就是共有outputmaps个卷积核,对上层的每个特征map,都需要用这么多个卷积核44. % 去卷积提取特征。

45. % rand(n)是产生n×n的 0-1之间均匀取值的数值的矩阵,再减去0.5就相当于产生-0.5到0.5之间的随机数46. % 再 *2 就放大到 [-1, 1]。

然后再乘以后面那一数,why?47. % 反正就是将卷积核每个元素初始化为[-sqrt(6 / (fan_in + fan_out)), sqrt(6 / (fan_in + fan_out))] 48. % 之间的随机数。

因为这里是权值共享的,也就是对于一张特征map,所有感受野位置的卷积核都是一样的49. % 所以只需要保存的是 inputmaps * outputmaps 个卷积核。

50. yers{l}.k{i}{j} = (rand(yers{l}.kernelsize) - 0.5) * 2 * sqrt(6 / (fan_in + fan_out));51. end52. yers{l}.b{j} = 0; % 将偏置初始化为053. end54. % 只有在卷积层的时候才会改变特征map的个数,pooling的时候不会改变个数。

这层输出的特征map个数就是55. % 输入到下一层的特征map个数56. inputmaps = yers{l}.outputmaps;57. end58. end。