技术盛宴丨机框式核心交换机硬件架构演进

华为主存储技术激荡二十年

2010年 自研V7000上市

2010年 24亿美元收购3Par

2001年 开始OEM EMC中端 存储系统CLARiiON 系列产品

2007年 Dell 2007年收购 Equallogic

2011年 戴尔将以总价值 9.6亿美元收购 Compellent

3

系统架构技术演进

1990

总线式架构

基于总线互连的Scaleup多控架构,升级换代的 方式就是采用更强的CPU、 接口卡、内存、协议

1995年 HDS发布首款存储 Lightning 7700

2000年 2006年 HDS Lightning Fujitsu ETERNUS 9900基于第一代Hi- 8000 Star光纤交换架构 存储系统

1,000,000$/套

2

高端存储技术下移,中端存储兴起

97年后中端存储开始追随 高端存储技术向前发展, 中端存储继承了数据保护、 数据管理等软件特性,而 在系统架构、扩展性、关 键业务保障性、交付形态 等方面采用了另一种方式

聚焦Open System环境

技术屏蔽IBM,HP,价格打击EMC,HDS

强化国产高端形象和品牌,跟随策略,扬长避短

*我们将于2013年12月30号使用OceanStor 18500/18800替换HVS85T/88T

13

目录

1 2 3

高端存储演进 中端存储演进 低端存储简介 应用案例

4

14

中端存储演进历史

主存储技术激荡二十年

目录

1 2 3

高端存储演进 中端存储演进 低端存储简介 应用案例

4

1

高端存储出现

1956年 世界第一台磁盘存储 系统IBM 305 RAMAC,容量5MB, 性能10K/s 磁盘介质取代打孔卡

交换机的硬件结构PPT教学课件

测 振 极 过馈混

编

试 铃 性 压点合

译

开 关Biblioteka 开 关倒 换保 护

电 桥

电 路

w

码 器

开电

关路

监视电路

2020/12/10

7

2020/12/10

8

模拟用户线电路(ALC)

(1)馈电(B,Battery feed)交换机通过用户线 向共电式话机直流馈电。我国规定馈电电压为-48V, 容差为(+6,-4)V,在摘机时,馈电电流为18—50mA。

2020/12/10

10

模拟用户线电路(ALC)

(5)编解码(C,Codec)。利用编码器和解码器 及其相应的滤波器,完成模拟话音信号的A/D,D/A变 换及其所需的防混叠失真、滤除50Hz电源干扰和平滑 滤波等功能,以与程控数字交换机的数字交换网络接 口。目前该功能几乎全部由PCM编解码器/滤波器专用 集成电路来实现。

2020/12/10

4

2 程控交换机的用户线电路

(SLIC , Subscriber Line Interface Circuit)。 作用:实现各种类型的用户线与交换网络之间的连接。

程控数字交换机主要有以下3种用户线形式: (1)与模拟话机或传真机连接的模拟用户接口电路。 (2)与数字话机或计算机数据终端设备连接的数字用户

2020/12/10

11

模拟用户线电路(ALC)

(6)混合(H,Hybrid)。进行模拟用户线的2线 与编解码所需的4线之间的转换。该功能可由混 合线圈或专用集成电路实现。

(7)测试(T,Test)。提供测试端口,通过测试 继电器或电子开关、交换机测试程序,对用户电 路进行自动测试,其结果可在交换系统维护终端 上加以显示。

交换机配置教程

交换机配置教程目录一、基础概念 (2)1.1 什么是交换机 (2)1.2 交换机的功能 (3)二、交换机基本操作 (4)2.1 连接电源 (5)2.2 登录交换机 (6)2.3 查看和修改配置 (7)三、交换机基本配置 (8)四、交换机高级配置 (9)五、交换机故障排查与维护 (10)5.1 常见故障排查方法 (11)5.2 系统升级与备份 (12)六、交换机配置实例 (14)6.1 企业办公网络配置示例 (15)6.2 校园网配置示例 (16)6.3 企业数据中心配置示例 (17)七、交换机命令行界面 (18)八、交换机配置文件管理 (19)8.1 配置文件的作用 (21)8.2 配置文件的创建与导入 (22)8.3 配置文件的备份与恢复 (24)九、交换机与网络操作系统的集成 (24)十、交换机安全性配置 (26)10.1 交换机安全管理 (27)10.2 交换机端口安全 (28)10.3 交换机访问控制列表 (29)十一、交换机性能优化 (31)11.1 交换机端口流量控制 (33)11.2 交换机背压控制 (34)11.3 交换机缓存优化 (35)十二、交换机应用场景 (37)12.1 企业办公网络 (38)12.2 企业数据中心 (40)12.3 无线网络 (42)十三、总结与展望 (43)13.1 交换机配置教程总结 (44)13.2 未来交换机技术发展趋势 (44)一、基础概念交换机是一种网络设备,主要用于在局域网(LAN)中实现数据的转发和通信。

它的主要功能是接收来自一个端口的数据包,然后根据目标MAC地址将数据包转发到另一个端口,从而实现不同设备之间的通信。

交换机的工作原理类似于电话交换机,通过识别源MAC地址和目标MAC地址来决定数据包的转发路径。

交换机通常有两种工作模式:访问控制列表(ACL)模式和广播模式。

在ACL模式下,交换机会根据预先设定的规则对数据包进行过滤,只有符合规则的数据包才会被转发。

技术盛宴丨大型数据中心网络路由协议选择

为了满足数据中心虚拟机(Vm)、容器(Docker)之间大二层通信的需求,数据中心网络发展历程中出现了众多依托网络设备硬件实现的互联组网技术——例如借鉴路由协议实现的大二层组网技术:多链接透明互联(TRILL)、最短路径桥接(SPB);虚实结合的Overlay技术:可扩展虚拟局域网(VXLAN)、使用通用路由封装的网络虚拟化(NVGRE)等等。

但由于技术的复杂性、设备能力的参差不齐,这些技术均没有在网络设备上得到大规模应用。

到今天,我们看到数据中心(IDC)网络返璞归真,与业务解耦,简单、可靠成为核心诉求,数据中心只需要提供简单、可靠的三层Underlay组网,二层Overlay网络更多依赖主机侧软件或智能网卡实现。

那么问题来了,如何为数据中心三层组网选择合适的路由协议?本文聚焦于大型数据中心场景,力图给出确切的答案。

IDC网络架构演进经济基础决定上层建筑。

同样的,数据中心(物理)网络架构很大程度上决定了路由协议的规划。

关于架构的设计,推荐阅读《技术盛宴| 互联网数据中心网络25G组网架构设计》。

本文对IDC网络架构仅做简要介绍,目的在于理清基础架构与路由协议选择的关系。

传统数据中心网络架构图1:传统数据中心网络架构(内部,不含网关区)图1展示的是传统数据中心的网络架构:传统IDC承载的大多是数据中心提供对外访问的业务;流量分布符合80/20模型,且以南北向为主,东西向流量小;网络架构设计采用核心-汇聚-接入三级结构,汇聚往下采用大二层组网,汇聚及核心横向采用厂商私有虚拟化技术,保证可靠性;流量瓶颈在出口,IDC内部可以维持高收敛比(10:1甚至更大)。

近年来,随着云计算、大数据等业务的兴起,分布式计算、分布式存储等技术开始在IDC内部大规模部署。

从网络视角看,IDC内部的东西向流量急剧上升,流量的80/20模型转变成以东西向流量为主。

此时,传统网络架构开始力所不逮,显现出诸多弊端:扩展能力差:网络规模受限于核心交换机端口数量,无法平滑Scale-out(横向扩展);收敛比过高:为南北向流量设计的流量模型,收敛模型呈三角型,越往上性能越低,东西向带宽严重不足;单控制面运维复杂:汇聚及核心的可靠性依赖于厂商的横向虚拟化技术,虚拟化技术的单控制面存在明显弊端,很难做到不中断业务升级版本(ISSU ,In-Service Software Upgrade)。

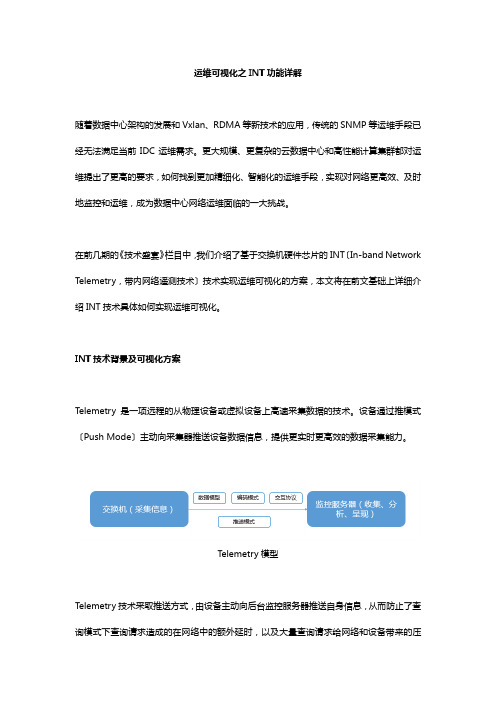

技术盛宴-运维可视化之INT功能详解

运维可视化之INT功能详解随着数据中心架构的发展和Vxlan、RDMA等新技术的应用,传统的SNMP等运维手段已经无法满足当前IDC运维需求。

更大规模、更复杂的云数据中心和高性能计算集群都对运维提出了更高的要求,如何找到更加精细化、智能化的运维手段,实现对网络更高效、及时地监控和运维,成为数据中心网络运维面临的一大挑战。

在前几期的《技术盛宴》栏目中,我们介绍了基于交换机硬件芯片的INT〔In-band Network Telemetry,带内网络遥测技术〕技术实现运维可视化的方案,本文将在前文基础上详细介绍INT技术具体如何实现运维可视化。

INT技术背景及可视化方案Telemetry是一项远程的从物理设备或虚拟设备上高速采集数据的技术。

设备通过推模式〔Push Mode〕主动向采集器推送设备数据信息,提供更实时更高效的数据采集能力。

Telemetry模型Telemetry技术采取推送方式,由设备主动向后台监控服务器推送自身信息,从而防止了查询模式下查询请求造成的在网络中的额外延时,以及大量查询请求给网络和设备带来的压力。

与传统的SNMP、CLI、SYSLOG等方式相比,Telemetry可以实现亚秒级监控精度。

理论上,通过Telemetry技术可以获取设备所有信息。

INT技术是由Barefoot、Arista、Dell、Intel和VMware在Telemetry的基础上共同提出的一种新的Telemetry模型。

INT技术是通过在数据层面收集和报告网络的状态来实现对网络状态的监控,这个过程不需要控制层面的参与。

INT架构模型中的术语:INT header:任何包含INT信息的packet header;INT Source:在报文中嵌入INT header的设备;INT Instruction:收集数据信息的定义;INT Metadata:监控对象信息,即在每台设备上收集的数据信息;INT Transit Hop:加入本设备节点INT Metadata信息的设备;INT Sink:拆除INT header报文头,并收集上送INT Metadata信息的设备。

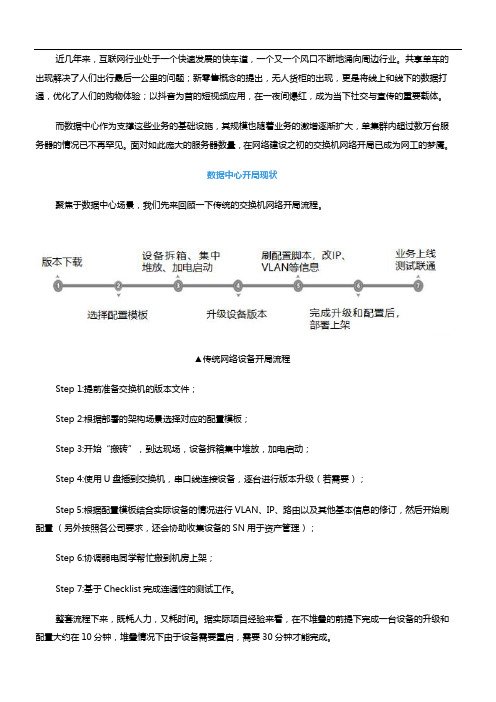

技术盛宴丨数据中心自动化运维技术探索之交换机零配置上线

近几年来,互联网行业处于一个快速发展的快车道,一个又一个风口不断地涌向周边行业。

共享单车的出现解决了人们出行最后一公里的问题;新零售概念的提出,无人货柜的出现,更是将线上和线下的数据打通,优化了人们的购物体验;以抖音为首的短视频应用,在一夜间爆红,成为当下社交与宣传的重要载体。

而数据中心作为支撑这些业务的基础设施,其规模也随着业务的激增逐渐扩大,单集群内超过数万台服务器的情况已不再罕见。

面对如此庞大的服务器数量,在网络建设之初的交换机网络开局已成为网工的梦魇。

数据中心开局现状聚焦于数据中心场景,我们先来回顾一下传统的交换机网络开局流程。

▲传统网络设备开局流程Step 1:提前准备交换机的版本文件;Step 2:根据部署的架构场景选择对应的配置模板;Step 3:开始“搬砖”,到达现场,设备拆箱集中堆放,加电启动;Step 4:使用U盘插到交换机,串口线连接设备,逐台进行版本升级(若需要);Step 5:根据配置模板结合实际设备的情况进行VLAN、IP、路由以及其他基本信息的修订,然后开始刷配置(另外按照各公司要求,还会协助收集设备的SN用于资产管理);Step 6:协调弱电同学帮忙搬到机房上架;Step 7:基于Checklist完成连通性的测试工作。

整套流程下来,既耗人力,又耗时间。

据实际项目经验来看,在不堆叠的前提下完成一台设备的升级和配置大约在10分钟,堆叠情况下由于设备需要重启,需要30分钟才能完成。

总结来看,对于支撑数万台服务器集群的数据中心网络场景,如果按照这种传统的开局模式来部署,会存在以下几点不足:• 效率低下:靠手工方式进行设备的版本升级、刷脚本,效率非常低;• 出错率高:重复性的工作会导致网工疲于思考,稍有不慎出现失误,需要额外的时间用于排查错误更正,产生一定的时间损耗。

对此,各厂家做了许多的探索,比如零配置上线技术。

数据中心自动化开局随着数据中心规模的不断增大,标准化的建设方式已经成为主流。

技术盛宴丨新一代IP承载核心技术SRv6的转发原理-—一文带你了解网络新贵

分段路由(SR,Segment Routing)是一种源路由技术,具有集中控制、中间网络无状态、可扩展性好等优点,SR更是面向软件定义网络(SDN,Software Defined Network)架构设计的协议,融合了设备自主转发和集中编程控制的优势,能够更好地实现应用驱动的网络。

关于SR技术的优势、技术演进等在上一篇技术文章《一文读懂网络界新贵Segment Routing技术化繁为简的奥秘》里有详细介绍,本文将接着SR技术演进的话题,介绍SR 的另一种标签寻址技术IPv6分段路由(SRv6,Segment Routing IPv6)。

一、从“大道至简”到“极简”——SRv6“大道至简”的控制平面SRv6控制层面与SR-MPLS一样,控制面基于传统支持IPv6的路由协议(OSPFv3/ISISv6/BGP4+)进行能力扩展,取代独立的LDP、RSVP实现整体架构的简化。

同时,SRv6相比SR-MPLS更加简化,无需通告IPv6前缀外的其他信息,因为前缀本身就是分段标识符(SID,Segment Identifier)。

当SRv6的控制面配合集中的SDN控制器,SRv6 SID的分配和相关指令下发均交给控制器下发,面向业务和应用进一步实现简化,只需要在边缘设备为应用指定路径,中间设备无需维护路径和应用的状态,使得网络边缘更智能、核心更简单,极大地简化了网络设计和管理。

“极简”的数据平面SR技术为数据平面设计了两种实现方式,一种是复用MPLS数据平面的SR-MPLS,另一种是SRv6。

SRv6使用IPv6数据平面,基于IPv6路由扩展头进行扩展,这部分扩展没有破坏标准的IPv6报头,而且,只有SRv6节点需要针对扩展头进行额外的处理,对于其他普通IPv6节点没有任何影响,这让SRv6可与现有IPv6网络无缝兼容,更让转发层面达到纯IPv6的极简转发。

为方便大家更直观地了解到SRv6数据面的“极简”,我们拿SRv6与SR-MPLS的帧结构做下对比,看看在帧结构上做了哪些改变。

技术盛宴丨IPv6系列安全篇:园区网IPv6的接入安全策略

园区网技术发展了这么多年,想必大家对于IPv4场景下的接入安全问题已经烂熟于心。

随着IPv6技术的发展和推广,未来园区网架构向IPv6演进已经成为不可阻挡的趋势,而我们对于IPv6架构下的接入安全问题了解多少?比如,终端可以获取到正确的IPv6地址吗?拿到地址就可以正确封装报文信息吗?报文封装正确就可以转发正常吗?等等。

在IPv6环境下接入层还有哪些安全问题?我们又该如何解决?上一篇文章(IPv6系列安全篇——SAVI技术解析)为大家介绍了SAVI(Source Address Validation Improvements,源址合法性检验) 的技术原理,本文将聚焦IPv6在园区网有线部署的场景,阐述如何应用SAVI技术解决接入安全问题。

IPv6园区网接入安全问题众所周知,终端正常访问资源的前提是需要有一个可用的IP地址,那么如何获取正确的地址是我们要讨论的一个问题。

其次,为了正常访问网络资源进行流量转发,还需要正确解析对端的MAC地址或者网关的MAC地址(跨网段时),这样才能进行一个报文的完整封装。

在IPv4的场景中是通过ARP协议来解析地址,对应到IPv6场景是通过ND协议中的NS/NA报文交互来解析。

除此之外,为了给所有终端分配地址资源,地址源可谓是“尽心竭力”,因此它的资源是有限的,也需要额外关注。

看似平淡无奇的过程中暗藏着很多安全问题,下面我们来详细分析一下这些问题是如何发生,以及有何威胁。

地址获取欺骗在IPv6的场景中,地址获取的方式有多种:1、DHCPv6:通过DHCPv6协议实现地址的获取,整个流程和IPv4下的DHCP协议类似,但协议报文有部分差异,具体可以参考DHCPv6的报文详解。

2、SLAAC(Stateless Address Auto Configuration,无状态地址自动配置):根据网关设备通告RA (Router Advertisement,路由器通告)报文中携带的网络前缀生成网络ID,根据EUI-64算法生成接口ID,通过两者结合生成一个IPv6地址。

交换机演变及特点

华为交换机的演变过程及特点华为交换机诞生至今先后开发了A型机、C型机、B型机三种个基本模块,管理平台经历了从8模、16模、32模和128模几代,每一代设备改进的主要围绕设备容量、设备功能、组网能力的不断优化而进行,同时产品的品质、稳定性得到不断提升。

下面就介绍目前网上常见的各种模块和机型:第一节、A型机A型机既可作独立局,也可作RSMⅡA 、挂在B形机或C型机下面,作为SM ⅡA通过E16板挂在32模或128模下面。

容量:单模块不大于2048用户线240DT。

当用户容量超过此容量时需改为B模块。

特点:A型机作独立局的情况现目前比较少,其特点是主控板用CC04MPU0,运行B软件时还可用CC06MPU0,终端系统配PCI卡(含在计算机中),通过加载电缆与主机相联,配有时钟板CLK和SEL板,TCI板,其网板目前用CC07NET(历史上还曾用过CC03NET板、CC05NET板,它们均不兼容,扩容时应特别注意),中继框存在CTB、ATB两种母板情况,配置情况各不相同,NOD板数量则应根据具体情况计算得出,版本目前为CC02NOD1板(历史上还曾用过CC03NOD等,CC02NOD1板兼容以前的版本),A型机通过RUB方式还可带远端RSA 。

机柜和配线:A型机目前所用的机柜主要为1.8米A型机柜,新A型机柜,B型机柜(历史上还曾用过C型机柜,2米老式A机柜),其插框均不兼容,扩容时应特别重视。

配线(HW、NOD电缆)历史上共存在三种:512配线、1024配线、2048配线,95年10月以前发货存在上述三种配线,95年10月以后发货仅有1024,2048两种配线, RSA机柜类型与此类似。

板件拉手条目前存在白色拉手条(F 型),灰色拉手条(D型),历史上以前发货的蓝色,蓝灰色等拉手条均统一到灰色拉手条上,RSMⅡA情况在硬件上与独立局基本相同,不同的是它一定配NO.7板中继电缆:中继配线一般为240DT,中继电缆接头均为BNC,RSA电缆接头也为BNC头。

交换设备运行与维护控制机框

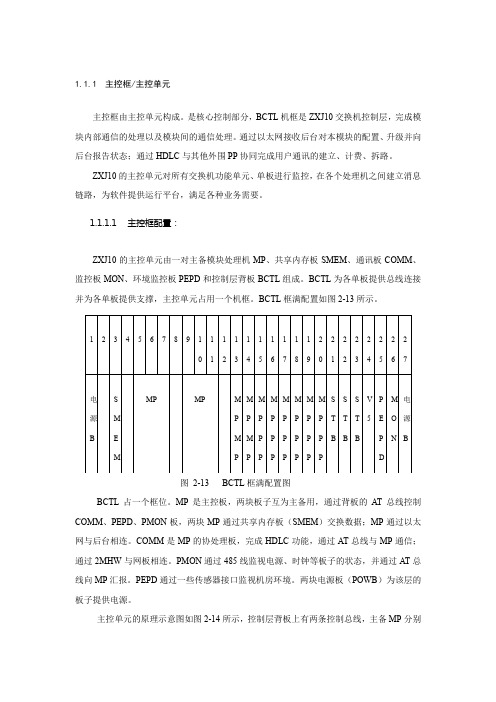

1.1.1主控框/主控单元主控框由主控单元构成。

是核心控制部分,BCTL机框是ZXJ10交换机控制层,完成模块内部通信的处理以及模块间的通信处理。

通过以太网接收后台对本模块的配置、升级并向后台报告状态;通过HDLC与其他外围PP协同完成用户通讯的建立、计费、拆路。

ZXJ10的主控单元对所有交换机功能单元、单板进行监控,在各个处理机之间建立消息链路,为软件提供运行平台,满足各种业务需要。

1.1.1.1主控框配置:ZXJ10的主控单元由一对主备模块处理机MP、共享内存板SMEM、通讯板COMM、监控板MON、环境监控板PEPD和控制层背板BCTL组成。

BCTL为各单板提供总线连接并为各单板提供支撑,主控单元占用一个机框。

BCTL框满配置如图2-13所示。

图2-13 BCTL框满配置图BCTL占一个框位。

MP是主控板,两块板子互为主备用,通过背板的AT总线控制COMM、PEPD、PMON板,两块MP通过共享内存板(SMEM)交换数据;MP通过以太网与后台相连。

COMM是MP的协处理板,完成HDLC功能,通过AT总线与MP通信;通过2MHW与网板相连。

PMON通过485线监视电源、时钟等板子的状态,并通过AT总线向MP汇报。

PEPD通过一些传感器接口监视机房环境。

两块电源板(POWB)为该层的板子提供电源。

主控单元的原理示意图如图2-14所示,控制层背板上有两条控制总线,主备MP分别与其中一条控制总线连接,而COMM板、PEPD板和MON板同时挂在两条控制总线上。

COMM板、PEPD板和MON板上都带有8K字节的双口RAM,各单板通过双口RAM和控制总线实现与MP的通信。

图2-14 主控单元的原理示意图(1)主控板(MP板)1)功能模块处理机MP是交换机各模块的核心部件,它相当于一个功能强大且低功耗的计算机,位于ZXJ10(V10.0)交换机的控制层,该层有主备两个MP,互为热备份。

目前常用的MP 硬件版本有MP B0111、MP B9908、MP B9903。

GEPON-技术简介PPT课件

数据网

局端

ONU

语音/视频/数据

GEPON组成及功能

OLT

❖ 向ONU以广播方式发送数据 ❖ 发起并控制测距过程,并记录测距信息 ❖ 为ONU分配带宽,即控制ONU发送数据的起始时

间和发送窗口大小

ODN

❖ 由无源光分路器和光纤构成

ONU

❖ 选择接收OLT发送的广播数据 ❖ 响应OLT发出的测距命令,并作相应的调整 ❖ 对用户的数据进行缓存,并在OLT分配的发送窗口中向

ODN OLT 单芯光纤 分路器

ONU

(FTTB)

(FTTH)

目录

GEPON技术原理 产品介绍 解决方案

B-STAR FBB-GEPON系统组成

FE

FE

FBB-ONU101

Internet上网

IPTV

FE

➢增强型光线路终端设备FBBEOLT5810系列

➢光网络单元设备FBBONU100系列

➢GEPON接入网管理系统

最少光纤量

最大传输距离 N个用最户少故障,无源分光

…………

1根光纤 1个局端光口 故障点少 有QoS

简化网络结构,降低运维成本

MC+LAN网络结构

3层交换机 2层交换机双芯光纤

IP

城域机房

GEPON网络结构

3层交换机

IP 城域机房

小区中心机房 小区2级机房 楼道交换机

:光电收发器

成本比较区间

:L2SW交换机

写在最后

成功的基础在于好的学习习惯

The foundation of success lies in good habits

24

谢谢聆听

·学习就是为了达到一定目的而努力去干, 是为一个目标去 战胜各种困难的过程,这个过程会充满压力、痛苦和挫折

5G架构的演进

5G架构的演进作者:高世强来源:《电子技术与软件工程》2018年第19期摘要基站架构和5G传输演进的研究和发展,使得基站架构和形态的变化历程开始成为基带单元和射频单元的硬件架构,在探讨基站架构的未来演进趋势,重点阐述面向5G基站架构和完善流程方面,人们发现了一些新的挑战。

无线业务的宽带化和多样化发展趋势,使得移动网络架构开始进入了新的发展历程,而网络的容量和性能持续提升,使得5G网络的发展越来越不断的丰富和变化。

【关键词】5G 架构演进基站设备是由基带单元和射频单元所共同组成的,基带单元,提供了基础的协议和处理方式,在基站系统的管理功能管控之下,射频单元负责射频信号的收发和处理,随着网络制式的发展,基站架构经历了从基带射频及中基带射频分离到多模一体化的演变路径,这种演变路径展现了新时代发展的系统化和框架化的特点,其集成度越来越高。

1 5G架构选项1.1 5G架构选择的基础选择合理的5G架构可以有效的提升组网的灵活度,降低工程复杂度,基于基带射频分离架构的分布式基站逐渐成熟的特点,设备设施自然而然的分化为BBU与RRU,BBU放置在机房,RRU上塔,BBU和RRU之间通过光纤连接。

期待的视频分离,随着LTE在引入使得运营商面临着多制式网络共存的情况,射频馈线损耗降低,才能够提升视频覆盖效率,而多模基站改变制式一整套基站设备的特点和模式,采用多模BBU与多模RRU的分布式架构,多模BBU在同一套硬件平台上同时支持多种接入技术,支持多制式共机框或共板卡,多模RRU则可在连续的瞬时工作带宽内通过软件配置同时支持多制式,完成对多制式射频信号的收发处理。

1.2 5G架构演进的必要性现有网络架构有其劣势,而这也正是5G网络架构演进的必然基础,新的特性需要使用新的版本,这是毋庸置疑的,在容量扩展方面,应该考虑到其扩展的必要性,如果其位置相对非常固定,不能进行动态迁移,那么可能会浪费电量的资源扩容。

也会变得比较复杂,因此为了支持新的功能,不断引入新电网的新组织网关和模块。

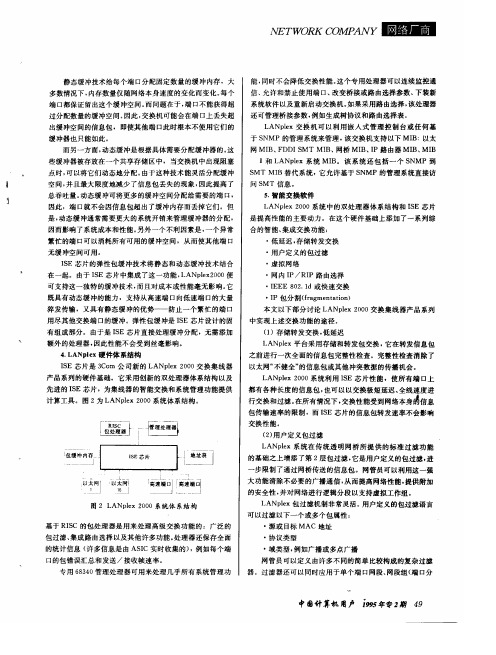

3Com LANplex 2000体系结构——新一代名高性能交换集线器的基础

x

m

公 司 的可 堆栈 iL

n

w s

t c i

h 侧系列

I S) ( E

2

,

xs E E

芯片交换 性能

.

这是

3 Co

m

公司 的

L AN

n e l

2 00

产 品 系 列 的基

Z。 。。

I s 8 1

芯片技术传送包的速度能够超过交换机支持的所有

础 本文不仅讨论 了这种体系结构在新的

公 司最新 一代

。

交换非转换的

F D D I 网段 )

,

F D D I 和 以 太 网流时可获 得这一速率 〔 所有 以

交换集线器所其有的先进系统体系结构的 网管员撰写的

AN p .

e x

太 网通信 童交换 到 以 太 网网段 通过交换机交换

)

,

所有

F D DI 通信t

交 换到

钾能交换集线 .

(A s I

,

L A N p le x

交换

个 网 络连 接 时的 最大包 传输 速 率 个信 息包

(p s P )

,

最大 传 输率 为每 秒

集线器产品中的实施 同时也论述 了这些产 品的一些先进的交 换功能 本文是专为那些有兴趣深人 了解

L L

.

5 654 69

每个 网络接 口 以 容许的最小包长度

,

3C

m o

I 线器将先进的定制 A s

C

。

月 初次 面 市

该集

信量并处 理所有通 过集线器的通信 J S E 芯片包含 2 0 多万 个门

和 超过

芯片 和 革新的双处理器系统体系结

小度写范文【交换机酝酿全面升级】交换机模板

【交换机酝酿全面升级】交换机数据中心内的交换机正在悄悄发生变革。

用不了几年,传统的交换机就会被更低延时、更大吞吐量、更灵活的新一代交换设备所取代。

数据中心中的交换设备正在发生变革,用不了几年,传统的交换设备就会被速度更快、更灵活的交换设备所取代。

推动这一变革的动力来自以下三个方面:服务器虚拟化、光纤存储与IP交换设备的直连,以及企业云计算,因为这三者都需要更快的传输速度、更高的传输能力。

其实,更快和更大吞吐量一直是交换设备所追求的目标,但与过去不同的是,现在仅仅靠提高接口的吞吐能力已经不够了,还需要更低的延时、取消生成树以及支持新的存储协议――没有这些改变,构建更灵活、更低成本的数据中心的梦想将化为泡影。

未来,数据中心内的网络将融合为统一的交换结构,好消息是这种转化不可能在几个月内完成,也许需要几年时间,因此还有时间可以为这一变化进行规划。

虚拟化带来的麻烦服务器虚拟化能够极大地提高服务器的利用率、节约服务器的购置成本和管理成本,这是人所共知的事情,但服务器虚拟化也为眼下的数据中心交换环境带来了很大麻烦。

第一个麻烦就是每个物理服务器都有很多虚拟机,而每个虚拟机又都有自己的MAC地址,这就让数据包的发送变得很复杂,特别是两个虚拟机相互通信时。

解决这个问题最容易的办法是在虚拟机里配置一个软交换机(Soft-switch),现在每个虚拟机供应商都能提供这样的产品。

设置了软交换机的服务器对网络交换机来说它只有一个MAC地址,而对服务器内的虚拟机来说,它又起着交换机的作用。

不过,这里存在几个问题: 软交换机需要执行各种安全策略,也需要有访问控制列表(ACL),以保证各个VLAN的安全。

例如,如果安全策略不允许被破坏的虚拟机与同一个服务器上其他虚拟机通信,那么,一旦某个虚拟机被破坏,它就不应该再与其他虚拟机进行通信。

当然,如果软交换机位于不同物理服务器上,网络会保证这些安全策略得到遵守。

一个解决办法是由负责维护服务器和软交换机的人来确保所有的网络控制都得到执行。

核心交换机架构演进

核⼼交换机架构演进应⽤永远是技术发展的原动⼒。

在⽬前⽇益复杂的业务应⽤⾯前,⽹络设备的技术架构成为⼀个设备适⽤范围的关键因素,不同的应⽤环境需要不同的⽹络设备。

⽐如NGN的应⽤需要基于SoftSwitch技术架构的设备,⽐如纵向⽹就需要关注路由器,园区⽹重点则是交换机等等,这都说明,⼀种技术架构的出现必然是为解决某种应⽤⽽服务的。

那么,在当前⽹络⼤融合的趋势下,核⼼交换机需要⼀种什么样的架构呢? 交换架构的演进 随着Internet⽤户的增加和带宽的扩⼤,交换机的结构也在不断的发展,从推出的时间看,交换架构主要经历了总线型和CrossBar两个阶段。

但由于以太⽹技术的发展⽇进千⾥,因此这两种架构的交换机⽬前都活跃在市场上。

总线型交换架构 基于总线结构的交换机⼀般分为共享总线和共享内存型总线两⼤类。

共享内存结构的交换机使⽤⼤量的⾼速RAM来存储输⼊数据,同时依赖中⼼交换引擎来提供全端⼝的⾼性能连接,由核⼼引擎检查每个输⼊包以决定路由。

这类交换机设计上⽐较容易实现,但在交换容量扩展到⼀定程度时,内存操作会产⽣延迟;另外,在这种设计中,由于总线互连的问题增加冗余交换,引擎相对⽐较复杂。

所以这种交换机如果提供双引擎的话,要做到⾮常稳定相对⽐较困难。

所以我们可以看到,早期在市场上推出的核⼼交换机往往都是单引擎,尤其是随着交换机端⼝的增加,由于需要内存容量更⼤,速度也更快,中央内存的价格变得很⾼。

交换引擎会成为性能实现的瓶颈。

CrossBar+共享内存架构 CrossBar(即CrossPoint)被称为交叉开关矩阵或纵横式交换矩阵。

它能很好的弥补共享内存模式的⼀些不⾜。

⾸先,CrossBar实现相对简单。

共享交换架构中的线路卡到交换结构的物理连接简化为点到点连接,实现起来更加⽅便,从⽽更容易保证⼤容量交换机的稳定性; 其次,CrossBar内部⽆阻塞。

只要同时闭合多个交叉节点(crosspoint),多个不同的端⼝就可以同时传输数据。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

随着互联网业务的高速发展,对构建互联网基础架构的网络设备提出了更高要求,例如容量、性能、扩展性以及QoS等诸多关键特性,而这往往是由其所采用的硬件架构决定的。

以框式核心交换机为例,先后出现了多种硬件架构,而现在最为常用的有三种:Full-Mesh交换架构、Crossbar矩阵交换架构和基于Cell的CLOS 交换架构。

本文将通过对这三种硬件架构、报文转发流程等原理的分析,全面剖析三种架构的优劣势。

名词解释

Full-Mesh

架构说明

▲图1:Full-Mesh架构图

如图1所示,所有业务线卡通过背板走线连接到其它线卡,因为Full-Mesh不需要外部的交换芯片,而是任意两个节点间都有直接连接,故得名全连接。

由于各线卡需要Full-Mesh互联,一个节点数为N的Full-Mesh,连接总数为[N×(N-1)]÷2,所以随着节点数量增加连接总数也急剧上升,因而可扩展性较差,仅适用于槽位数量较少的核心设备。

报文转发流程

1、报文从线卡进入,跨卡报文送到与目的线卡连接的背板通路;

2、报文到达目的线卡。

Crossbar

架构说明

▲图2:Crossbar架构图

如图2所示,业务线卡通过背板走线连接到Crossbar芯片上,Crossbar芯片集成在主控引擎上。

▲图3:Crossbar芯片架构

Crossbar芯片架构如图3所示,每一条输入链路和输出链路都有一个CrossPoint,在CrossPoint处有一个半导体开关连接输入线路和输出线路,当来自某个端口的输入线路需要交换到另一个端口的输出点时,在CPU或交换矩阵的控制下,将交叉点的开关连接,数据就被发到另一个接口。

简单地说,Crossbar 架构是一种两级架构,它是一个开关矩阵,每一个CrossPoint都是一个开关,交

换机通过控制开关来完成输入到特定输出的转发。

如果交换具有N个输入和N个输出,那么该Crossbar Switch就是一个带有N*(N-1)≈N²个CrossPoint点的矩阵,可见,随着端口数量的增加,交叉点开关的数量呈几何级数增长。

对于Crossbar芯片的电路集成水平、矩阵控制开关的制造难度、制造成本都会呈几何级数增长。

所以,采用一块Crossbar交换背板的交换机,所能连接的端口数量也是有限的。

报文转发流程

• 无缓存Crossbar

每个交叉点没有缓存,业务调度采用集中调度的方式,对输入输出进行统一调度,报文转发流程如下:

1、报文从线卡进入,线卡先向Arbiter请求发送;

2、Arbiter根据输出端口队列拥塞情况,决定是否允许线卡发送报文到输出端口;

3、报文通过Crossbar转发到目的线卡输出端口。

由于是集中调度,所以仲裁器的调度算法复杂度很高,扩展性较差,系统容量大时仲裁器容易形成瓶颈,难以做到精确调度。

• 缓存式Crossbar

最早的缓存式Crossbar只有交叉节点带缓存,而输入端是无缓存的,被称为”bus matrix”,后来,CICQ 的概念被引入,即在输入端用大的Input Buffer,在中间节点用小的CrossPoint Buffer。

这种结构采用分布式调度的方式进行业务调度,即输入和输出端都有各自的调度器,报文转发流程如下:

1、报文从线卡进入,输入端口通过特定的调度算法(如RR算法)独立地选择有效的VOQ;

2、将VOQ队列头部分组发送到相应的交叉点缓存;

3、输出端口通过特定的算法在非空的交叉点缓存中选择进行服务。

由于输入和输出的调度策略相互独立,所以很难确保交换系统在每个时隙整体上达到理想匹配状态,并且调度算法复杂度和交换系统规模有关,限制了其扩展性。

CLOS

架构说明

▲图4:CLOS架构图

如图4所示,每块业务线卡和所有交换网板相连,交换芯片集成在交换网板上,实现了交换网板和主控引擎硬件分离。

CLOS架构是一种多级架构,每个入口级开关和每个中间级开关之间只有一个连接,并且,每个中间级开关正好连接到每个出口级开关,这种架构的优点是可以通过多个小型Crossbar 开关来实现大量输入和输出端口之间的连接,CrossPoint数量级别低于Crossbar架构的N的2次方,降低了芯片实现难度。

报文转发流程

•基于Cell的动态负载

1、入方向线卡将数据包切分为N个cell,其中:N=下一跳可用线路数量;

2、交换网板采用动态路由方式,即根据下一级各链路的实际可用交换能力,动态选路和负载均衡,通过多条路径将分片发送到出方向线卡;

3、出方向线卡重组报文。

动态负载关键点在于能负载分担地均衡利用所有可达路径,由此实现了无阻塞交换。

CLOS架构交换机的分类

• 非正交背板设计

▲图5:非正交背板

如图5所示,业务线卡与交换网板互相平行,板卡之间通过背板走线连接。

背板走线会带来信号干扰,背板设计也限制了带宽的升级,同时,背板上PCB的走线要求很高,从背板开孔就成了奢望,这直接导致纯前后的直通风道设计瓶颈一直无法突破。

• 正交背板设计

▲图6:正交背板

如图6所示,交换机线卡与交换网板分别与背板对接。

同非正交背板设计一样,背板带宽限制了带宽的升级,同时也增加了散热的难度。

• 正交零背板设计

▲图7:正交零背板

如图7所示,业务线卡与交换网板互相垂直,背板走线为零,甚至无中板。

正交设计能减少背板走线带来的高速信号衰减,提高了硬件的可靠性,无背板设计能够解除背板对容量提升的限制,当需要更大带宽的时候,只需要更换相应板卡即可,大大缩短业务升级周期,并且因为没有了背板的限制,交换机直通风道散热问题迎刃而解,匹配数据中心机房空气流的走向,形成了贯穿前后板卡的高速、通畅的气流。

总结

下表将对以上三种架构做出总结:

对于高端机架式交换机,以Crossbar交换架构和CLOS交换架构为主。

其中CLOS交换架构是当前大容量数据中心核心交换机的理想架构。

我们RG-N18000-X系列交换机基于无阻塞的CLOS架构,并且采用“零背板”技术,在提供高效、稳定交换服务的同时,可实现未来10年网络可持续平滑升级。