基于网络百科全书的中文关联语义知识获取

中文维基百科分类提取(jwpl)--构建知识图谱数据获取

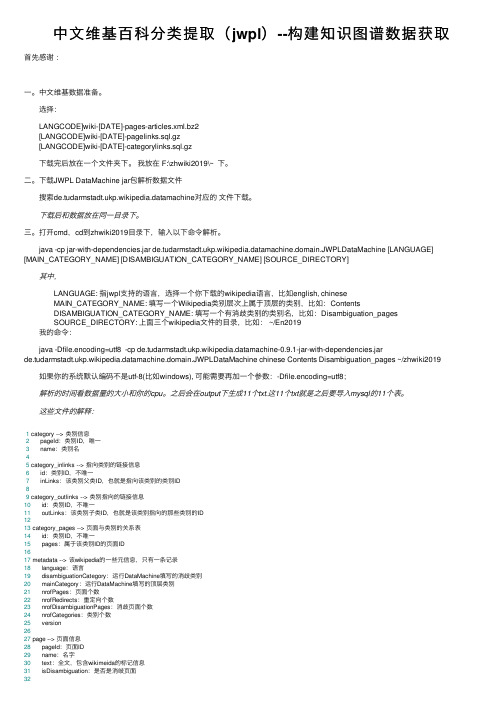

中⽂维基百科分类提取(jwpl)--构建知识图谱数据获取⾸先感谢:⼀。

中⽂维基数据准备。

选择: LANGCODE]wiki-[DATE]-pages-articles.xml.bz2 [LANGCODE]wiki-[DATE]-pagelinks.sql.gz [LANGCODE]wiki-[DATE]-categorylinks.sql.gz 下载完后放在⼀个⽂件夹下。

我放在 F:\zhwiki2019\~ 下。

⼆。

下载JWPL DataMachine jar包解析数据⽂件 搜索p.wikipedia.datamachine对应的⽂件下载。

下载后和数据放在同⼀⽬录下。

三。

打开cmd,cd到zhwiki2019⽬录下,输⼊以下命令解析。

java -cp jar-with-dependencies.jar p.wikipedia.datamachine.domain.JWPLDataMachine [LANGUAGE] [MAIN_CATEGORY_NAME] [DISAMBIGUATION_CATEGORY_NAME] [SOURCE_DIRECTORY] 其中, LANGUAGE: 指jwpl⽀持的语⾔,选择⼀个你下载的wikipedia语⾔,⽐如english, chinese MAIN_CATEGORY_NAME: 填写⼀个Wikipedia类别层次上属于顶层的类别,⽐如:Contents DISAMBIGUATION_CATEGORY_NAME: 填写⼀个有消歧类别的类别名,⽐如:Disambiguation_pages SOURCE_DIRECTORY: 上⾯三个wikipedia⽂件的⽬录,⽐如: ~/En2019 我的命令: java -Dfile.encoding=utf8 -cp p.wikipedia.datamachine-0.9.1-jar-with-dependencies.jarp.wikipedia.datamachine.domain.JWPLDataMachine chinese Contents Disambiguation_pages ~/zhwiki2019 如果你的系统默认编码不是utf-8(⽐如windows), 可能需要再加⼀个参数:-Dfile.encoding=utf8; 解析的时间看数据量的⼤⼩和你的cpu。

基于互联网的汉语认知属性获取及分析

· 136 ·

语言文字应用

2012 年 8 月 第3 期

语言文字应用 Applied Linguistics

Aug. ,2012 No. 3

基于互联网的汉语认知属性 获取及分析*

李 斌1 陈家骏2 陈小荷1

( 1. 南京师范大学文学院 江苏 南京 210097; 2. 南京大学计算机软件新技术国家重点实验室 江苏 南京 210093)

2012 年第 3 期

( 2000) 在语料库上利用潜在语义分析技术( LSA) ,寻找和名词密切相关的形容词,作为名 词的显著特征。Veale( 2007) 利用英语的明喻格式“A is as B as C”,从搜索引擎谷歌上抓取 了大量的“目标域( 名词) —属性值( 形容词) ”对。杨芸( 2008 ) 利用词语相关度计算,从本 地语料库获取了和名词相关的属性形容词,贾玉祥( 2009 ) 则用明喻格喻句的理解。这些研究极大地推 进了隐喻中明喻研究的进展,但美中不足的是,在数据采集上忽视了频率信息和理论分析。

Keywords: cognitive property; metaphor; salience; cognitive computation

一引言

词语的认知属性是指,在特定的语言中,语言使用者对词语代表的概念或实体的认知体验 凝结到词义中的各种属性。例如汉语里“猪”这个词,除了语文词典所描写的“眼睛小,耳朵 大,身体肥”之外,其认知属性还有“懒”“笨”“丑”等等。表面上看,后面三个属性不过是“猪” 的常见特性而已,但这样的语言知识却很难在现有的语文词典和电子资源中找到。传统的词 汇语义学,一般将这种意义作为附加在概念义或基本义之上的附加义或陪义( 张志毅,2001: 44; 张慧晶,2003) ,并没有重视系统性的描写。认知语言学则不区分概念义和附加义,在隐喻 研究的框架下,将“肥”和“笨”都作为“猪”的“显著特征”( Giora,97; Veale,2007) 。显著特征 可以用作隐喻的喻底,比如“他真是头猪”的意思是他像猪一样笨或像猪一样懒,等等。所谓 “显著”是认知上显著,“特征”则表示事物的特殊之处,表现为属性和属性值的特异性( 陈小 荷,2005) 。从理论上看,“显著特征”并没有得到良好的界定。为了凸出认知体验性和属性 ( 值) ,并涵盖更多的词语属性,在本文中,我们将“显著特征”一般化为“认知属性”,以便进行 阐述和分析。

使用网络搜索引擎计算汉语词汇的语义相似度

使用网络搜索引擎计算汉语词汇的语义相似度高国强;黄吕威;陈丰钰【摘要】Similarity computation of Chinese words is a key problem in Chinese information processing. It measures semantic similarity between Chinese words using the information returned by web search engines. First,implement a model named WebPMI which computes similarity using page counts,and then,describe another model named CODC which analyzes semantic similarity using text snippets. Final-ly,present the algorithm based on the two models. Experimental results show that this algorithm outperforms all the existing web-based semantic similarity measures for Chinese,and is close to the traditional semantic similarity measures using lexicon.%汉字词语的语义相似度计算是中文信息处理中的一个关键问题。

文中利用网络搜索引擎提供的信息来计算汉语词对的语义相似性。

首先通过程序访问搜索引擎,获取汉字词汇的搜索结果数,并依此实现了相似度计算模型WebPMI;然后描述了根据查询返回的文本片段进行语义相关性分析的模型CODC;最后,结合这个两个模型,给出了文中算法的伪代码。

基于语义网的知识表示与检索技术研究

基于语义网的知识表示与检索技术研究随着互联网技术的发展,我们可以获取的信息变得越来越多,信息的搜索和处理也变得越来越复杂。

为了更好地管理这些海量信息,语义网应运而生。

语义网是一个具有良好语义理解能力的分布式网络,能够有效地支持数据共享、语义交互和协作等方面的工作。

同时,基于语义网的知识表示与检索技术也越来越受到人们的关注。

在本文中,我们将探讨语义网的基本概念、知识表示和检索技术以及未来发展方向。

一、语义网的基本概念语义网由万维网的发明者蒂姆·伯纳斯-李提出,它把互联网上的信息资源与语义相关的知识联系在一起。

语义网是基于RDF(Resource Description Framework)语言的。

RDF语言是一种用于描述信息的标准语言,它可以描述万维网上的资源和它们之间的关系。

基于RDF语言,我们可以对网页上的文本、图像、音频等信息进行描述,进而实现对这些信息的检索和管理。

语义网的基本概念包括三部分:资源、属性和值。

资源是语义网上最基本的概念,用来描述万维网上的信息资源,它可以是文本、图像、视频、网页等等。

属性描述了资源的相关信息,它用于描述某个资源的某个方面,如长度、作者、出版日期等。

值是属性的取值,表示资源某一属性的具体内容。

二、知识表示知识表示是指将事物的知识以机器可以处理的形式表示出来。

在语义网中,知识表示的核心是对资源进行描述。

在RDF语言中,知识的表示通常采用三元组(subject,predicate,object)来进行描述。

其中,主语表示资源,谓语表示属性,宾语表示属性取值。

例如,对于一篇文章来说,可以描述为:主题(主语)是“语义网的基本概念”,作者(谓语)是“作者”,名字(宾语)是“小明”。

基于语义网的知识表示还可以采用OWL(Web Ontology Language)语言进行表示。

OWL是一种用于描述知识和类别关系的语言,它可以描述类别之间的继承关系,以及类别之间的属性和关系等信息。

基于知识图谱的网络用语语义分析研究

基于知识图谱的网络用语语义分析研究基于知识图谱的网络用语语义分析研究摘要:随着互联网的迅猛发展,网络用语作为一种重要的沟通方式,已经成为社交媒体和网络社区中的独特语言形式。

然而,由于网络用语的变化快速且复杂,其存在大量的新词汇、俚语和含义的多样性,使得传统的自然语言处理技术无法有效应对。

本文基于知识图谱的网络用语语义分析研究,旨在利用知识图谱的优势,对网络用语的语义进行深入分析与挖掘,以提高网络用语的理解和应用效果。

1. 引言随着社交媒体和网络社区的兴起,网络用语在人们的日常交流中扮演着越来越重要的角色。

网络用语作为一种特殊的语言形式,具有快速变化和多样化的特点,往往包含着丰富的情感和文化内涵。

然而,由于网络用语的语义多样性和常见问题,传统的自然语言处理技术很难准确理解和处理网络用语。

为了解决这一问题,本文将基于知识图谱的方法来进行网络用语的语义分析研究。

2. 知识图谱介绍知识图谱是一种将数据组织成图结构的技术,用于表示实体之间的关系和属性。

它由实体、关系和属性三部分组成,可以用来表示丰富的知识和语义关联。

知识图谱的特点是信息结构化、语义明确和关系丰富,可以提供对复杂数据的准确理解和分析。

因此,利用知识图谱进行网络用语的语义分析,可以克服传统自然语言处理技术的局限性,提高网络用语的理解和应用效果。

3. 网络用语语义分析的挑战网络用语语义分析面临着许多挑战,包括词义消歧、新词识别、俚语理解和情感情绪分析等问题。

首先,网络用语中存在大量的新词汇和俚语,传统的词典和语料库很难准确理解其含义。

其次,网络用语的词义经常发生变化,同一个词在不同上下文中可能具有不同的含义。

此外,网络用语通常包含大量的表情符号和缩略语,需要结合上下文进行正确理解。

最后,网络用语往往充满了强烈的情感和文化内涵,需要进行情感情绪分析以准确理解其意义。

4. 基于知识图谱的网络用语语义分析方法本文提出了一种基于知识图谱的网络用语语义分析方法,包括数据预处理、实体识别与关系抽取、语义关联建模和情感情绪分析等步骤。

基于知识图谱的语义搜索引擎研究

基于知识图谱的语义搜索引擎研究随着互联网技术的不断发展,搜索引擎已成为人们获取信息的主要途径。

但是,传统的基于关键词的搜索方式已经无法满足人们日益增长的信息需求。

在这个背景下,基于知识图谱的语义搜索引擎逐渐出现并受到了广泛关注。

本文将围绕该主题进行探讨。

一、知识图谱的概念及发展知识图谱源于谷歌的“知识图谱”项目,它是一种用于表示语义化信息的结构化数据。

在知识图谱中,通过对现实世界中实体、关系、属性的描述,形成了一个从更广泛、抽象的层面上描述现实世界的机器可读的知识库。

知识图谱的发展可以追溯到20世纪60年代的人工智能研究中,它是一种通过将人类知识和机器逻辑结合起来来实现更智能化的处理能力的方式。

在过去的几年中,谷歌、微软、IBM等公司先后推出自己的知识图谱,同时一些知识图谱相关的技术公司也兴起。

这些公司主要通过利用结构化数据的方式,来更好地帮助客户研究和分析他们所涉及的领域,例如物联网、医疗保健等领域。

近年来,随着人工智能技术的快速发展,基于知识图谱的应用也越来越广泛,其中一些最为有影响力的应用如智能语音助手和智能问答系统就是基于知识图谱。

二、传统搜索引擎的局限性将搜索引擎应用于寻找信息时,最重要的是关键词。

搜索引擎系统会根据搜索关键词在数据库中匹配结果,并展示在用户页面中。

然而,单一的关键词语可能携带着不丰富的信息,且存在歧义性问题。

例如,在搜索关键词“苹果”时,系统很难判断是指水果还是科技公司。

而在涉及到复杂的问题时,搜索引擎系统还需要理解内容上下文,并分析相关的语义、逻辑和常识,进而给出更准确的结果,而这种理解是传统搜索引擎所缺乏的。

因此,传统搜索引擎的局限性在如何理解应用领域的知识和怎样对结果进行语义表示这两个方面体现得最为明显。

三、基于知识图谱的语义搜索引擎早期的基于知识图谱的搜索引擎主要是针对谷歌的知识图谱进行了应用。

通过结合这些应用,用户可以使搜索引擎系统更好地理解他们的搜索需求。

基于语义网络的知识图谱构建及应用研究

基于语义网络的知识图谱构建及应用研究近年来,随着人工智能技术的快速发展,知识图谱(Knowledge Graph)作为一种新的知识表示方式,越来越受到广泛关注。

它是图论和语义网络理论的结合体,把人类知识以图谱的形式进行结构化表示,为人工智能系统提供更加丰富、精准的语义信息,从而实现更加智能化的应用。

本文将从语义网络的概念入手,介绍基于语义网络的知识图谱构建及应用研究。

一、语义网络的概念语义网络是一种表示语言的计算机技术,主要用于处理和表示语义信息。

它是由节点和边构成的有向图,节点表示事物,边表示节点之间的关系。

语义网络最早由心理学家Collins和Quillian在1969年提出,在他们的实验中,被试需要通过回答问题的方式来验证人们所拥有的知识结构,并从中获得相关结论。

这一实验为后来的知识表示模型提供了重要的思路。

语义网络在自然语言处理、人工智能以及策略规划等领域中都有广泛的应用。

例如,在自然语言处理中,语义网络可以将自然语言文本转化为可供计算机处理的结构化表示;在人工智能领域,语义网络可以作为知识表示和推理的基础;在策略规划中,语义网络可以用于表示问题空间和解空间,达到确定最佳解决方案的目的。

二、知识图谱的构建知识图谱是一种语义网络,它以实体和关系为基本元素,将不同类型的数据(结构化和非结构化)进行系统化的整合,从而实现了语义级别上的联接。

知识图谱在很多实际应用中都有广泛的应用,例如:百度搜索引擎、谷歌知识图谱、苹果Siri语音助手等。

知识图谱的构建主要分为以下几个步骤:1.数据来源的确定。

知识图谱的构建需要数据来源,其中包括结构化数据(如维基百科、人口普查、学术论文等)、非结构化数据(如社交媒体、新闻报道等)、半结构化数据等。

2.实体和关系的定义。

实体是知识图谱中的基本元素,他可以是一个物体、一个事件或一段时期。

因此,我们需要确定实体的种类和特征,并对其进行分类和抽象。

关系是实体之间的连接,描述实体之间的语义关系,例如:人-就职于->公司公司-位于->地点地点-属于->区域3.数据提取和预处理。

基于语义网的知识检索技术研究

基于语义网的知识检索技术研究随着互联网的发展,人们获取信息的途径也变得更为多样化。

搜索引擎的出现,使得人们可以在海量的信息中快速地找到所需的内容。

然而,仅仅通过关键词搜索,难以满足人们获取信息的需求。

而基于语义网的知识检索技术,则可以更为准确地获取所需信息。

语义网是当前互联网发展的重要趋势之一,它是建立在万维网之上的一种全球性、联结性的知识共享网络,从而使语义化的信息能够在互联网上存储、共享、查询和利用。

与传统的互联网不同,语义网要求信息不仅能够被机器读取,还要能够被机器理解。

基于此,语义网技术的应用主要包括 RDF(Resource Description Framework)、OWL(Web Ontology Language)、SPARQL(SPARQL Protocol and RDF Query Language)等技术。

目前,基于语义网的知识检索技术正在不断地完善和发展,主要体现在以下几个方面:一、基于语义表示的信息检索传统的信息检索是基于文本的keyword检索,而基于语义表示的信息检索则可以更为准确地搜索到相关信息。

它不仅能够根据用户输入的关键词搜索到相关的信息,而且可以根据用户所提供的信息分类、关系等维度进行分析,从而返回更加准确的结果。

例如,用户通过搜索引擎输入“医生”,搜索引擎不仅可以返回与“医生”相关的文章、图片等,还可以根据用户提供的信息筛选出关于哪个地区的医生,哪个科室的医生等相关信息。

这在医疗领域非常实用,用户可以通过输入症状等信息,搜索引擎可以根据病情、药品、医生等一系列信息进行分析,返回更加准确的结果,为病人提供更好的医疗服务。

二、基于知识图谱的信息检索知识图谱是一种基于图形结构的知识表示方式,能够将不同领域中的知识进行集成,建立起一个强大的知识库。

基于知识图谱的信息检索,则是将用户的查询请求映射到知识图谱上,在图谱中查找相关的实体,再根据实体之间的关系返回用户所需的信息。

基于语义网的知识图谱构建和应用

基于语义网的知识图谱构建和应用随着互联网的不断发展,信息爆炸的时代已经到来。

在这个时代,人们需要一种更加智能和高效的方式来获取和管理信息。

而知识图谱就是一种能够解决这个问题的工具。

一、知识图谱的定义知识图谱是一种基于语义网的结构化数据模型,它能够将人类知识体系中的实体、属性和关系以图形的形式展示出来。

它不仅仅是一个简单的概念图,而是涵盖了大量的结构化和半结构化数据。

它的目的是将信息变成知识,并且能够让计算机更好地理解和利用这些知识。

二、知识图谱的构建方式知识图谱的构建方式有很多,但是基于语义网的知识图谱是目前应用最广泛的。

基于语义网的知识图谱主要包含以下几个步骤:1、实体提取:从文本中提取出实体,并将它们归类成为事物的类型,例如人、地点、机构等等。

2、关系提取:从文本中提取出实体之间的各种关系,例如合作关系、资助关系等等。

3、实体消歧:将同名异义的实体进行消歧,保证知识图谱的准确性。

4、实体链接:将提取出的实体链接到已有的知识库中,例如维基百科、Freebase等等。

5、知识融合:将不同来源的知识进行整合,尽可能地增加知识图谱的完整性和准确性。

三、知识图谱的应用知识图谱的应用场景非常广泛,下面列举一些主要的应用场景:1、个性化推荐:通过对用户的偏好和历史操作进行数据分析,从而为用户推荐个性化的内容。

2、搜索引擎优化:通过对企业或个人进行知识图谱的构建,能够提高搜索引擎在该领域内的排名。

3、智能问答系统:通过对知识图谱进行语义分析,能够帮助用户更快速地找到答案。

4、风险防控:通过对关键词进行监测和分析,能够及早发现潜在的风险和威胁。

5、智能客服:通过对用户提问的语义进行分析,能够更好地为用户提供服务。

四、知识图谱的发展趋势目前,知识图谱的应用已日益广泛,同时也面临着一些挑战,例如如何保证数据的完整性和准确性。

未来,知识图谱的发展趋势将主要集中在以下几个方面:1、数据开放:开放数据能够降低知识图谱的构建难度,同时也能够提高知识图谱的完整性。

基于语义分析的网络信息抓取与知识提取

基于语义分析的网络信息抓取与知识提取网络信息抓取与知识提取是当今互联网时代的重要任务之一。

随着信息爆炸式增长,人们急需从大量的文本信息中提取有用的知识和信息,以辅助决策、推理和研究等活动。

基于语义分析的方法成为了解决这一问题的重要手段之一。

本文将介绍基于语义分析的网络信息抓取与知识提取的原理、应用以及存在的挑战和解决方案。

首先,我们来了解一下基于语义分析的网络信息抓取的原理。

语义分析是指对文本进行深层次理解和解析,找出其中的实体、关系和属性等重要信息。

传统的文本分析方法主要基于关键词匹配和统计方法,容易受到歧义、多义性等问题的干扰。

而基于语义分析的方法则能够实现更精确的信息抓取和提取。

它利用自然语言处理和机器学习等技术,对文本进行词义消歧、语法分析和语义推理等处理,从而识别出文本中的实体,建立实体之间的关系,并提取出实体的属性和特征。

基于语义分析的信息抓取有许多应用。

首先,它可以用于搜索引擎的优化。

传统的搜索引擎主要基于关键词匹配,容易受到关键词多义性和噪声干扰的影响。

而基于语义分析的搜索引擎可以更好地理解用户的查询意图,提供更准确、有用的搜索结果。

其次,基于语义分析的信息抓取可以应用于情感分析和舆情监测。

通过分析大量的网络文本,可以了解用户对产品、服务以及事件的评价和情感倾向,帮助企业和政府做出更好的决策。

此外,基于语义分析的信息抓取还可以应用于智能问答系统、知识图谱构建等领域,为人们提供更智能化和个性化的信息服务。

然而,基于语义分析的信息抓取仍然面临着一些挑战。

首先,语义分析是一个复杂的任务,需要充分考虑语言的多义性、词序和上下文等多个因素。

这使得准确识别实体和建立实体关系变得困难。

其次,因为互联网上的文本数量庞大,信息抓取的规模巨大。

如何高效地处理这些文本,并保证处理的准确性和稳定性,也是一个亟待解决的问题。

此外,随着互联网技术的不断发展,信息抓取和提取的技术也在不断演进,如何保持技术的先进性和适应性也是一个挑战。

一种基于百度百科的文本语义主题抽取方法

一种基于百度百科的文本语义主题抽取方法专利名称:一种基于百度百科的文本语义主题抽取方法技术领域:本发明涉及一种基于百度百科的文本语义主题抽取方法。

背景技术:网络已经进入了 Web2.0的时代,即以用户为主导、由用户提供和分享资源的网络应用迅速发展,每天都会出现海量的新信息,如何获取其中真正所需的内容却是一大难题。

网络上的文本资源组合灵活、不规范、数据量大、容易创作与发布,话题涉及社会的方方面面。

对这些数据进行主题跟踪发现、分类、情感判断将有着广泛的应用和前景,如社会舆情监控、情感分析、商业调查等。

处理这些数据需要应用文本挖掘技术,涉及文本相似度计算、聚类、分类等方面。

这些传统方法大多是针对文本信息表述规则,包含了大量的信息内容的文本。

然而,网络文本包含许多不规则的简写方式,例如‘发改委’和‘发展改革委员会’,若用传统的数据挖掘相似度算法,计算结果为0,因为二者没有词汇交集,但实际上二者在语义上相同。

另外,词汇的语义与其所处环境有关,比如‘苹果4代’与‘4袋苹果’,两个短语中都有的‘苹果’ 一词,传统算法计算结果相似度为0. 67,但二者风马牛不相及。

面对这些问题,传统的文本挖掘方法显然不能令人满意。

特别在中文领域,情况更为复杂,不仅要解决文本挖掘的基本问题,还需先对文本做准确的分词。

现有的中文分词工具对长文本的分词取得不错的效果。

但在短文本分词方面还有待改进,例如‘有木有银请我7饭’(有没有人请我吃饭),通过ICTCLAS分词结果处理的分词结果是‘有木有银请我7饭’,与实际意思相差很大,对进一步所要做的语义挖掘很不利。

要解决这些困局,需要一个能涵盖社会各领域的知识库,不仅能提供全面、准确、复杂的知识关系,还要能及时跟进社会热点与网络流行动态。

在中文知识信息领域,相比于传统的各种知识库,百度百科是一部内容开放、自由的网络百科全书,其旨在创造一个涵盖各领域知识的中文信息收集平台,并与百度搜索、百度知道结合,从不同的层次上满足用户对信息的需求。

面向中文网络百科的本体学习与知识获取研究

面向中文网络百科的本体学习与知识获取研究对大数据进行研究和分析,将大数据转化为信息和知识对于知识工程和信息网络安全领域都具有重要的科学价值和实际意义。

本体知识库是自动问答、决策支持、语义搜索等应用的基础,然而本体知识库的构建费时耗力。

中文网络百科是通过广大网络用户协作方式创建的网络大数据,是群体智慧的产物,其潜在用户数约占世界人口的四分之一,为大规模、协作式本体学习与知识获取提供了比较理想的资源和环境。

本文针对中文网络百科进行分析,研究适用于中文网络百科特点的本体学习与知识获取方法,为从中文网络百科大数据中挖掘海量概念和关系提供理论依据和算法。

主要研究内容分为四个部分:(1)分类关系与实例关系获取:通过对开放分类进行共现分析和语义分析获取开放分类间的上下位关系,并将其转化为开放分类概念层次结构。

针对概念层次结构数量较多问题,提出概念层次结构聚类方法,将具有语义相似性的层次结构聚合。

利用开放分类概念层次结构计算开放分类之间的相似度,在此基础上计算开放分类的权重,根据开放分类的权重获取百科条目与开放分类之间的实例关系,建立海量分类词汇表。

在互动百科数据集上进行实验表明,与代表性方法相比,本文提出的本体学习方法在性能上有明显提高。

(2)属性关系获取:将属性值看做命名实体,从百科文本集中挖掘频繁k元模式,通过对k元模式进行关联分析获取候选属性词语,再借助语义资源去除重复的候选属性词语,为类别建立统一的属性列表。

针对每个类别属性,采用bootstrapping方法获取属性触发词,根据触发词从文本集中挖掘属性值抽取模式,并基于层次聚类过滤低频、不可信的模式。

在互动百科文本集上进行实验表明,与人工定义的类别属性相比,本文获取类别属性数量较多,且更能体现类别的特征;与代表性方法相比本文提出的属性值获取方法在性能上有所提高。

(3)实体关系获取:利用百科结构化信息和百科文本集自动获取关系抽取的训练数据。

从训练数据和语义资源中挖掘关系词语,通过关系词语过滤对训练数据进行优化,并使用n元模式特征建立分类器,对测试数据进行标注,获取关系实例。

基于百科语料的中英文双语词典提取

第35卷第1期2021年1月Vol.35,No.1Jan.,2021中文信息学报JOURNAL OF CHINESE INFORMATION PROCESSING文章编号:1003-0077(2021)01-0025-09基于百科语料的中英文双语词典提取王星I,单力秋I,侯磊于济凡234,陈吉】,陶明阳(1.辽宁工程技术大学电子与信息T.程学院,辽宁葫芦岛125105;2.清华大学计算机科学与技术系.北京100084;3.清华大学人工智能研究院知识智能研究中心.北京100084;4.清华大学北京信息科学与技术国家研究中心,北京100084)摘要:双语词典是跨语言自然语言处理中一项非常重要的资源。

目前提取双语词典的方法主要是基于平行语料库和基于可比语料库.但是这两种方法在提取新词或者某些技术术语时都存在双■语资源匮乏的问题。

相比之下,基于部分双.语语料的方法由于利用的是新阿或者百科知识,故可以很好地解决这个问题.然而目前基于部分双语语料的方法主要集中在对文本内容的提取上,缺乏对文本内容以外部分的提取。

针对此不足,该文以中英文两种语言为例.提出了一种基于百科语料时中英文双语词典的提取方法。

该方法是在对文本内容提取的基础上结合在线百科的结构特点.分别用五种不同的方法对百科语料进行提取,综合查重后得到的双语信息数量为969308条。

与以往的基于部分双语语料的双语词典的提取方法相比.该方法在在线百科语料上的提取数量提高了170.75%。

关键词:双语词典提取;跨语言自然语言处理;部分双语语料中图分类号:TP391文献标识码:AChinese English Bilingual Dictionary Extraction Based on Encyclopedia CorpusWANG Xing',SHAN Liqiu1,HOU Lei"",YU Jifan23'4,CHEN Ji1,TAO Mingyang'(1.School of Electronic and Information Engineering,Liaoning Technical University♦Huludao,Liaoning125105,China;2.Department of Computer Science and Technology.Tsinghua University,B&jing100084,China;3.Knowledge Intelligence Research Center,Institute for Artificial Intelligence,Tsinghua University,B&jing100084,China;4.Beijing National Research Center for Information Science and Tech n o l ogy,Tsin g hua University,Beijing100084*China)Abstract:Bilingual dictionary is a very important resource in natural language processing.In contrast to the classical methods of extracting bilingual dictionaries from parallel corpora or comparable corpora,the method based on partial bilingual corpus can avoid the limit of bilingual corpus by employing news or encyclopedia knowledge.This paper proposes a method of bilingual dictionary extraction by employing the structural characteristics of online encyclopedia.In addition to the text contents,this method designs five processes to extract encyclopedia corpus and a-chieves total969308piece of information with pared with the previous extraction methods,the number of bilingual information extracted from the online encyclopedia by this method is increased by170.75%.Keywords:bilingual dictionary extraction;cross language natural language processing;part of bilingual corpus0引言间的交流日趋频繁,这使得跨语言自然语言处理显得愈发的有价值。

基于语义网的中文百科知识组织与集成

基于语义网的中文百科知识组织与集成付宇新;王鑫;冯志勇;吕雪栋【期刊名称】《计算机工程与应用》【年(卷),期】2015(000)014【摘要】It identifies important structural features from immense knowledgeable data in three largest Chinese encyclope-dias(Baidu Encyclopedia, Hudong Encyclopedia, Chinese Wikipedia)and generates RDF triples, then integrates the in-formation data and sets into a distributed large-scale RDF data storage system, and constructs the RDF dataset of Chinese Encyclopedia Knowledge Base that fits with the requirements of Linked Data. The main work includes, configuring the web crawler to crawl the html pages from Baidu Encyclopedia and Hudong Encyclopedia, parsing the content of the infor-mation box to generate RDF triples, downloading Chinese triples data from DBpedia, integrating the data sets into the dis-tributed large-scale RDF data storage system Jingwei, designing the display of dynamic inserting and triple pattern query pages, it also verifies the validity of the method through prototype system experiments.%通过从3个最大的中文百科全书(百度百科、互动百科、中文维基百科)所包含的大规模知识数据中识别重要的结构化特征生成RDF三元组,并将这些信息数据整合加入分布式大规模RDF数据存储系统,从而构成符合Linked Data要求的中文百科知识库RDF数据集。

ibot 原理

ibot 原理iBot原理解析iBot是一种智能机器人,它可以通过自主学习和逻辑推理的方式来理解和回答人类提出的问题。

iBot的原理基于人工智能和自然语言处理技术,通过大量的训练数据和算法模型,使其能够模拟人类的思维和语言能力。

iBot的工作原理可以分为以下几个步骤:1. 文本理解:iBot首先通过自然语言处理技术对输入的问题进行分析和理解。

它会对句子进行分词、词性标注和句法分析,以便更好地理解句子的语义和结构。

2. 知识获取:iBot通过连接到互联网上的知识库和数据库,获取丰富的知识和信息。

这些知识可以包括百科全书、新闻文章、论文等各种文本资源。

iBot会根据问题的内容和上下文,从这些资源中提取相关的信息。

3. 问题推理:iBot在获取到问题的相关信息后,会进行逻辑推理和问题分析。

它会根据问题的语义和结构,运用逻辑规则和推理算法,来推导出问题的答案。

iBot可以处理复杂的问题,包括推理和假设等。

4. 答案生成:iBot在推理出问题的答案后,会将答案转化为自然语言,并输出给用户。

它可以通过文本、语音或图像等方式进行回答。

iBot的答案可以是直接的事实性回答,也可以是基于推理的间接回答。

iBot的原理基于人工智能技术的发展。

它借鉴了机器学习和深度学习的方法,通过模拟神经网络的结构和学习算法,来实现对问题的理解和回答。

iBot会根据大量的训练数据进行模型训练和参数优化,以提高其准确性和性能。

iBot的原理不仅仅局限于问答系统,它也可以应用于其他领域,如智能助理、机器翻译、智能客服等。

通过不断的学习和迭代,iBot 可以不断提升自身的能力和智慧,成为人们日常生活和工作中的重要伙伴。

总结起来,iBot的原理基于人工智能和自然语言处理技术,通过文本理解、知识获取、问题推理和答案生成等步骤,使其能够理解和回答人类提出的问题。

iBot的应用潜力巨大,将为人们带来更多便利和智慧。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

的贡献度来刻画。贡献度也表达了语义指纹中的一个词语与语义标签(也是一个词语)的关联度。 表2中给出了两个语义标签以及其语义指纹,表中的数字(0到1之间)表示了词语对语义 指纹的贡献度,数值越大表明越相关。由于苹果这个语义标签所指代的概念有多个,因此我们根 据它所指代的不同概念分成了两行展示。

一2-表1.中文维基百科、百科和互动百科的主要差别词条数 是否有消歧义页 有 无 有 页面以繁体,简体编写 许多文章的原始版本是繁体编写,959,284 4,357,226

互动百科的每个具有特定含义的词条都对应一个解释页面。解释页面中包含有词条名、摘要、 目录、正文、开放分类、用户添加的相关词条和其他信息。正文是对该词条的解释,其中的内容 与该词条紧密相关。~个词条可以属于多个开放分类,用户可以为一个词条添加多个相关词条。

因此,本文旨在研究通过建立一种形式化的表示关联语义知识的方法来模拟人类习得知识

的过程。本文通过词汇之间的关联关系来形式化地描述这种关联语义知识,将概念作为语义知识 的一个基本单元,用语义标签来指代,用语义指纹来刻画其语义。通过语义标签和语义指纹来表 示自然语言中的关联语义知识,其具体形式为:

语义标签:语义指纹;

Abstract:This proposes

a

paper

to

uses

semantic label and semantic fingerprint

to

represent the related

semantic knowledge and

represents

a

method

a

obtain related semantic knowledge from

or

an online encyclopedia.Semantic label natLl/吐language.Semandc

concept,

which can be

word

phrase,and is

a

basic semantic unit in

fingerprint is

consisted ofⅡ1e

其中,语义标签代表一个概念,对应于语言中的词或短语,它是自然语言中表达某个语义 知识的基本单元。但是语义标签并不完全等同于语义知识单元或概念,有时一个词在不同的语境 中有完全不同的语义,对应于两个不同的知识单元,这样两个知识单元可能共用一个标签,也即 一个语义标签可能指代多个语义知识单元,例如词语“苹果”在不同的语境中可能对应一种水果 或一个公司,也即语义标签“苹果”指代了多个语义知识单元,在这种隋况下,语义标签所指代 的语义知识则由该语义标签和其语义指纹共同确定。

通过该词条解释正文里提到的词语、用户添加的该词条相关词条的超链接,可以链接到互动百科

中其他词条的解释页面。

2关联语义知识的形式化表示

美国心理学家哈里・洛拉尼在他的书中提到【l】:“如果要记住任何新信息,就必须使这条信息 与你已经知道或记住的信息联系起来。联系,与记忆紧密相关,指的就是将两种或两种以上的事

l引言

万维网的发展使得人类拥有的文本信息资源越来越多,人们迫切需要机器能自动地从海量文 本中获取目标信息。自然语言处理领域的一些子任务,诸如文本分类、信息检索、自动文摘和自 动问答等都足通过计算机来解决人们对特定文本信息的需求。由于互联网上文本信息大都足以人 类的自然语言出现,而人类的语言中蕴含着丰富的语义知识,因此,为了增加机器理解自然语言

苹果【水果】 苹果【公司】

(个人电脑O.798)』电脑0.791),(-T-㈣0.748),(iPhone0.676),(乔布斯0.502).…

University,Wuhan,China

Monitoring and Research Center,Wuhan,China

Information Technology

Oil

Education,Huazhong Normal

University,Wuhan,China

yangliu721@yahoo.com.ell tthe@mail.CCnu.edu.cn tuxinhui@163.com

用互联网的人都可以在遵循一定规范的情况下在网络百科全书中创建和编辑词条,因此网络百科

全书词条的数目远远超过传统依靠少数人力或部分专家构建的知识库中的词条数。另外,网络媒 体和各种网络通讯工具的发展,使得新事物和新词的传播速度以及其为人们所接纳的速度也随之 加快,网络百科全书的人人可编辑性保证了其会及时收录社会发展过程中不断出现的新事物和新 词。进一步地,网络百科全书中的一个词条往往是由多个用户共同编辑、修改而成,因此该词条 的综合信息从一定程度上反映的是多个用户的对词条理解,也即群体智能。基于以上发现,本文 旨在研究从网络百科全书中获取语义知识。 互联网上中文网网络百科全书中,每一个词条都对应有词条解释页面。但是,许多词语在不同 的语境中会有不同的含义,比如苹果,可能表示一种水果或者一个叫苹果的公司。中文维基百科 和互动百科为这些多义词建立了相应的消歧义页面,即在这个页面中列出该多义词所有可能的含 义,用户根据自己的需要点击相应含义的超链接即可进入特定含义下的词条解释页面。也就是说,

tuxinhui@163.com

摘要:本文提出了—种用语义标签、语义指纹来表示关联语义知识的形式化方法,其中语义标签指代语义中的一

个知识单元(也即概念),语义指纹是对语义标签所指代概念的描述,由语义标签的相关词语及其关联度共同组

成。本文提出了—种从网络百科全书获取中文关联语义知识的方法,通过该方法获得语义标签的相关词群,利用 网络百科全书中的内部链接和开放分类信息计算每个相关词语与语义标签的关联度。通过与入的判断进行比较, 说明了本文提出的计算语义标签与相关词语关联度的方法的有效性。 关键字:百科全书,语义知识,语义关联度i语义标签,语义指纹

following pairs:semantic related term,its

semantic relatedness.We obtain the semantic related terms ofeach semantic label and operl category information in the encyclopedia. comptaing method is effective.

Obta i

n

i ng Re I ated

Semant i C Know I edge Encyc I oped i a

from On I i

Re

Liu Yan91’2 Tmgting Hel’2 Xinhui Tu3

1 Department ofComputer Science and Technology,Huazhong Normal 2 Network Media Branch ofNationa/Language Resources 3 Engineering&Research Center for

基于网络百科全书的中文关联语义知识获取奉

杨柳12,何婷婷”,涂新辉3

1华中师范大学计算机科学系武汉430049 2国家语言资源监测与研究中心网络媒体分中心武汉430049 3国家数字化学习工程技术研究中心武汉430079

yangliu721@yahooห้องสมุดไป่ตู้com.cn tthe@mail.ccnLLeducn

and compute the semantic relatedness by analy五ng the inner hyperlinks By

comparing

our

remits with human judgments,we prove that

our relatedness

Keywords:encyclopedia;semantic knowledge;semantic relatedness;semantic label;semantic fingerprint

一l・

的能力,在自然语言处理过程中适度地引入语义知识便十分必要。 人类语言的复杂|生,使得语义知识的内涵十分丰富,词法、句法、概念的分类结构、词语之 间的相似度、词语之间的相关度等都可以属于语义知识的范畴。中文语义知识的来源有两种,一 种是人工构建的知识库,如Hownetl,另一种则是大规模的真实文本,包括互联网上的海量文本、 各种离线文本集合(如各种规模的语料库识库Hownet是通过义原、概念以及义原和概念之间的关系来反映中文语义知 识。这种人工构建的知识库一般是由语言学家或领域专家标定而成,知识库的质量很高;但是人 工标注耗时耗力,且语言的发展过程中新词新义不断出现,人工构建的知识库很难及时收录各种 新词新义。大规模的文本集合是人类自然语言的真实写照,能反映语言中丰富的语义知识,尤其 是词语之间的共现规律能在一定程度上反映词语之间的语义关联度。但是互联网上的文本大都是 以无结构的形式出现,这给机器自动获取语义知识带来了一定的困难。 网络百科全书是目前存在于互联网上的一种人人可编辑的在线百科全书,它通过分类体系和 各种超级链接将大量的概念组织起来,使得概念与概念之间具有一定的关联性,这种关联是语义 知识中的—个重要范畴,也是本文研究的内容。网络百科全书有以下显著特点:任何一个可以使

物捆绑在一起,或者在它们之间建立起关系。”同理,人们遇到一个新概念(知识)时,往往是

将存储在人脑中已有的概念与新碰到的概念建立起一定的联系,从而达到理解和记忆新概念的目 的。这种概念与概念之间的关系,是语义知识中很重要的一部分。例如,当我们遇到一个概念“基 因”(假设我们事先对这个概念的内涵并不了解),同时看到对“基因”的解释语句“基因是指携 带有遗传信息的DNA序列,是控制性状的基本遗传单位”时,我们必定在脑海中建立起了“基 因一遗传信息”,“基因.DNA”,“基因.遗传单位”等等这样的关系对。人类习得新的知识必定是 建立在以往知识经验的基础上,并将新知识与过往经验建立起一定的关联。