谷歌自动驾驶测试报告(2015年12月)

综述无人驾驶汽车的主要功能

综述无人驾驶汽车的主要功能摘要:随着技术模式的不断更迭与改进,无人驾驶已成为世界各国竞相投入开发的新技术。

原因在于无人驾驶技术涉及多项领域,其中包括无人控制,人工智能,计算机视觉等高新技术,还与互联网紧密结合。

将无人驾驶技术做好做强,掌握的不仅是一门精尖技术,更是对本国科技水平的一次整合与提升。

本文简要介绍了无人驾驶汽车的一些主要功能及实现方法,对无人驾驶的一些问题进行了思考,简述了无人驾驶技术的一些优势和不足。

关键词:无人驾驶、路线规划、车内信息采集、车外信息采集1. 引言无人驾驶汽车在20世纪已经有了数十年的历史,在21世纪呈现出了实用趋势,国内外几家公司也在快速推进无人驾驶汽车实用化。

当前,人们对无人驾驶汽车的需求不断提高,无人驾驶技术也日益成熟。

因此开展对无人驾驶方面的研究具有重要的意义。

2. 无人驾驶技术的简介2.1 无人驾驶汽车的发展情况无人驾驶这一概念最先由英、德、美等发达国家在上世纪七八十年代提出。

发展至今,国外的许多公司都取得了不错的成绩。

如谷歌,其在2014年12月中下旬,就首次展示了无人驾驶原型车成品,该车可全功能运行。

2015年5月8日在美国内华达州允许测试3个月后,谷歌的无人驾驶汽车就取得了合法牌照。

在我国,无人驾驶技术日臻成熟。

在1992年国防科技大学成功研制出中国第一辆真正意义上的无人驾驶汽车。

现今,百度与北汽合作打造的无人驾驶汽车已经试运营,并且达到L3级别。

未来,我国将推进立法,使无人驾驶汽车真正合法化。

美国汽车工程师学会(SAE)对自动驾驶有明确的分级并已经被 NHTSA 确定为标准,从辅助驾驶到完全不需要人干预的自动驾驶有明确界定[1]。

根据NHTSA对无人驾驶汽车的分级,无人驾驶汽车分为L0、L1、L2、L3、L4五个等级,如表1。

美国摩根斯丹利研究报告中指出在2025 年自动驾驶技术在美国的潜在经济影响为 2000 亿到 1.9万亿美元左右。

[2]2.2 无人汽车的组成部分无人汽车的组成部分主要有:GPS、测距雷达、激光发射器、中央处理器、视频采集器。

清华姚班VS浙大竺院谁是中国最牛AI创业班

|FEATURES清华姚班VS浙大竺院谁是中国最牛AI创业班?育和孵化下,其人才隐藏着惊人的造富实力。

而这背后除了聪明人的聚群效应,了中国已经进入技术造富时代。

程华秋子/文特写|FEATURES机器视觉、AI芯片、机器人、生命科技……越来越多科幻的名词,出现在我们的生活中。

与之相随的,是一系列科技独角兽的崛起。

中国的创业与创富,由此转向完全不同的硬核轨迹。

专业知识,成为创富的撒手锏和护城河。

名校理工科精英,是当仁不让的先行者。

中国名校理工科教育领域,清华姚班、浙大竺院在生源上堪称“制霸”全国。

如今这一波科技创富潮中,两个中国最牛学院是否也是一骑绝尘?二者之中,谁最能打?清华姚班:一群天才聚集在一起创业是怎样的?清华大学流传一句话,“半国英才聚清华,清华一半英才在姚班”。

人们俗称的姚班,正式名称是清华学堂计算机科学实验班,隶属清华大学交叉信息研究院,由唯一一位华人图灵奖得主、中国科学院院士姚期智教授于2005年创办。

姚班的学生大牛如云,基本上都是数学、物理及信息学奥赛的金牌选手,各省高考前三甲,其生源主要来自保送、自主招生。

以2018级50位姚班学霸为例,保送和自招占44人,高考裸考6人。

其中,数学奥赛选手13人(3人国家队),信息奥赛选手26人(3人国家队、2人省理科状元)。

2019年姚班录取的55人中,有3省理科状元,以及24名奥赛金牌得主,他们大多年少成名;其中被录取的唯一一位理科女状元,高考裸分达到711。

成立以来,姚班已培养出375名本科生,平均每届30人左右。

近年姚班的生源有扩张趋势,其录取人数2012年为34人,2018、2019年分别达到了50和55人。

2019年,全国高考人数达到1031万人,清华大学的录取人数为3400余人,其中理工科考生占77.3%,文史类考生占8.9%。

按当年姚班录取55人计算,其在全国的录取比例达到0.05,也就是百万分之五,说他们是国内金字塔尖的人才一点也不为过。

无人驾驶概况及技术简析可编辑全文

,然后对这些区域 提取特征,最后使 用训练的分类器进 行分类

基于深度学习目 框提取速度

标检测的热潮

CVPR 2014 R-CNN

NIPS 2015 Faster R-CNN

CVPR 2016 YOLO

SSD

SSD300: 74.3% mAP

63.4% mAP 46fps

DPM(HOG+SVM) 66% mAP 0.02fps

2011 年 , 柏 林 自 由 大 学 顺 利 完成拥堵交通流、交通信号灯 及环岛通行等诸多项目。

2015年,google无人车完 成美国加州公路测试。

21世纪

2007

2011

2015

2003

2003 , 清 华 大 学 研 制 成 功 THMR-V 型 无 人 驾驶车辆。

2009

2009年,Google已完成多款 无人驾驶样车,以及近100万 公里的实际道路测试。

1月

7月

2016 年 1 月 , 初 创 公 司 Nauto 使 用行车记录仪实 现ADAS功能。

2016年9月,Uber 在匹兹堡市向公 众开放无人驾驶 汽车出行服务。

2016年12月, Chris Urmson成 立了自己的自动 驾驶创业公司。

2017年1月,Quanergy 公司的Solid State LiDAR S3获得了汽车无 人类的最高奖项。

25

2.2 关键技术:目标感知 基于深度学习的视觉和LiDAR数据融合方法

1) 显著提高识别分类精度以及收敛速度; 2) 采用车载NVIDIA TX1(15W)运算可达120帧/秒; 3) 物体识别率提高将近5%

26

2.2 关键技术:目标感知

27

无人驾驶汽车论文【范本模板】

无人驾驶汽车院别:**学院专业:自动化学号:******** 姓名:*********摘要:无人驾驶汽车通过传感器装置和计算机来实现无人驾驶,这一技术正渐渐地在生活中的到应用,并在生活中发挥着巨大的作用,有着广泛的发展前景.2009年11月,在国外某社交网站上的一段视频,引起广泛关注。

视频的上传者本·蔡特林在美国旧金山和帕洛阿尔托之间的280号高速公路行驶时,发现旁边有一辆“怪异"的丰田普锐斯轿车,在它的车顶,装着一个类似于扰流板的装置,蔡特林最初以为这是用来测试风速的,其实这就是谷歌所研发的无人驾驶汽车系统,在当时,这还是一个秘密进行中的项目。

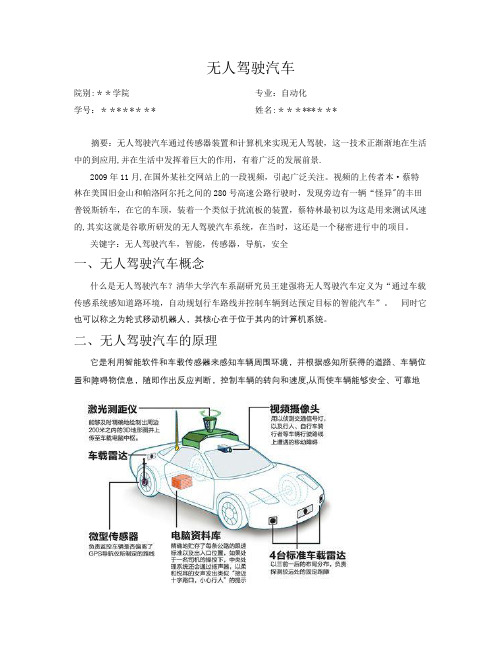

关键字:无人驾驶汽车,智能,传感器,导航,安全一、无人驾驶汽车概念什么是无人驾驶汽车?清华大学汽车系副研究员王建强将无人驾驶汽车定义为“通过车载传感系统感知道路环境,自动规划行车路线并控制车辆到达预定目标的智能汽车”。

同时它也可以称之为轮式移动机器人,其核心在于位于其内的计算机系统。

二、无人驾驶汽车的原理它是利用智能软件和车载传感器来感知车辆周围环境,并根据感知所获得的道路、车辆位置和障碍物信息,随即作出反应判断,控制车辆的转向和速度,从而使车辆能够安全、可靠地在道路上行驶。

比如,车体多个部位装有激光感应器,用于确定车身与障碍物的距离;有效地避开障碍物。

车载电脑可以经由后视镜附近的摄像头识别交通信号、交通标志并分析路况。

无人驾驶车的运动控制包括感知、动作、行为3个部分。

感知主要是通过车的“眼睛”认知周围环境,实现对环境的精确建模,如结构化环境中的车道线的检测、半结构环境中的边缘检测等;动作是指车的“大脑”在收到感知信息时作出的规划、控制与决策;而行为则是无人驾驶汽车在规划、控制与决策下产生的外在响应,体现了无人车的自主性能。

无人驾驶车是集视觉计算、模式识别和控制等众多技术于一体、具有人工智能功能的汽车。

它有车载麦克风、声波定位仪、红外线传感器、罗盘、激光扫描仪和微波雷达等多种传感器,这些装置相当于无人驾驶车辆的“眼耳”,用来感知车辆周围环境,并将感知所获得的道路、车辆位置、障碍物信息等,传输给无人驾驶车辆的“大脑”-—安装在车辆内部的高性能计算机进行分析和计算,以控制车辆的转向和速度,从而使车辆在遵守交通规则的前提下能够安全、可靠地在道路上自主行驶.当然,不同公司生产的无人驾驶汽车其原理都不太一样。

无人驾驶或将是智能汽车发展终极阶段

无人驾驶或将是智能汽车发展终极阶段茫茫多的国家已经在研究无人驾驶这项技术了,相关测试品也陆续出世,一般人我不告诉他。

无人驾驶是智能汽车发展的终极阶段,是将驾驶员抽离人- 车-路系统模型,是对汽车工业的革命性变革。

实际上,无人驾驶这一话题是全球性的。

综合BBC 等多家媒体信息,美国当地时间1 月14 日,美国运输部(DOT)部长安东尼-福克斯代表美国政府宣布在未来十年在无人驾驶领域投资40 亿美元的扶持政策。

同时,美国交通部辖下的国家公路交通安全管理局(NHTSA)宣布在两年内豁免整个行业2500 辆汽车遵循现行相关交通安全规定,也就是允许这部分车辆在没有配备司机的情况下上路测试。

美国运输部长安东尼-福克斯表示,该计划旨在帮助制造商、科技公司在未来十年中开发出更加安全、智能化的车辆。

这也是现任总统奥巴马的计划,让美国在未来的运输中能够占领先机。

据日本共同社报道,联合国谈判相关人士表示,关于全球汽车厂商推进研发的自动驾驶系统,制定汽车国际规则的联合国机构已开始制定安全法规,预计日本和德国将提出方案,关于高速公路的行驶法规最早将在2017 年3 月获得通过。

成员国将遵照国际法规完善国内法。

谷歌在无人驾驶方面早有耕耘。

据Wired 报道,谷歌最新提供给DMV(美国机动车辆管理局)的报告显示,2014 年9 月以来,谷歌无人驾驶汽车已经行驶了680 万公里,谷歌无人驾驶汽车总共主动脱离无人驾驶状态272 次。

官方详细数据还指出,最有可能发展成事故的13 次情况中,有8 次发生在2014 年,剩下5 次发生在2015 年。

而2014 年和2015 年无人驾驶汽车的行驶里程分别是8.5 万公里和59.5 万公里,表现提升的服务还是相当大的。

谷歌提出,无人驾驶汽车的自动驾驶时间百分比一直在稳定增加。

自动驾驶技术测试与验证项目计划书

自动驾驶技术测试与验证项目计划书一、项目背景随着科技的飞速发展,自动驾驶技术已成为汽车行业的热门研究领域。

自动驾驶技术有望提高交通安全、减少交通拥堵,并为人们的出行带来更大的便利。

然而,要实现可靠和安全的自动驾驶,严格的测试与验证是必不可少的。

本项目旨在建立一套全面、科学的自动驾驶技术测试与验证体系,确保自动驾驶车辆在各种复杂环境下的性能和安全性。

二、项目目标1、开发一套完整的自动驾驶技术测试流程和方法,涵盖功能测试、性能测试、安全测试等多个方面。

2、构建真实场景的测试环境,包括城市道路、高速公路、乡村道路等不同类型的道路条件。

3、对自动驾驶系统进行大规模的实际道路测试,收集数据并分析,以评估其可靠性和安全性。

4、建立严格的安全评估标准和指标体系,确保自动驾驶技术符合相关法规和标准。

三、项目团队1、项目负责人:负责人姓名,负责项目的整体规划、协调和决策。

2、技术专家:包括传感器专家、算法工程师、车辆动力学专家等,负责解决技术难题和优化测试方案。

3、测试工程师:负责具体的测试执行和数据采集工作。

4、数据分析人员:对测试数据进行处理和分析,为评估提供支持。

5、安全评估专家:制定安全评估标准和流程,确保测试符合安全要求。

四、项目进度安排1、第一阶段(第 1-3 个月)完成项目团队组建和培训。

调研和分析现有的自动驾驶测试方法和标准。

制定初步的测试计划和流程。

2、第二阶段(第 4-6 个月)设计和搭建测试环境,包括道路设施、模拟场景等。

确定测试车辆和传感器配置。

开发测试数据采集和分析系统。

3、第三阶段(第 7-9 个月)进行小规模的预测试,验证测试流程和方法的可行性。

根据预测试结果,优化测试方案。

开始大规模的实际道路测试。

4、第四阶段(第 10-12 个月)持续进行实际道路测试,收集大量数据。

对数据进行深入分析,评估自动驾驶系统的性能和安全性。

撰写测试报告,总结测试结果。

5、第五阶段(第 13-15 个月)根据测试报告,提出改进建议和措施。

人工智能自动驾驶汽车安全分析报告评估人工智能自动驾驶汽车的传感器精度和紧急刹车系统性能

人工智能自动驾驶汽车安全分析报告评估人工智能自动驾驶汽车的传感器精度和紧急刹车系统性能人工智能自动驾驶汽车安全分析报告1. 引言人工智能自动驾驶汽车正逐渐成为交通行业的重要发展方向。

然而,对于这种新型交通工具的安全性能进行准确评估和分析是至关重要的。

本报告将着重评估人工智能自动驾驶汽车的传感器精度和紧急刹车系统性能,旨在为该领域相关研究和发展提供参考。

2. 传感器精度评估2.1 传感器种类人工智能自动驾驶汽车的传感器主要包括摄像头、雷达和激光雷达等。

这些传感器通过不同的方式感知车辆周围的环境并获取相关数据。

2.2 传感器精度测试方法评估传感器的精度需要进行一系列实地测试和模拟实验。

其中包括:(1)辅助设备校准:确保传感器的安装和校准符合标准要求;(2)实地测试:通过在实际道路环境中模拟各种交通情况,评估传感器对于车辆、行人和障碍物的感知准确度;(3)数据分析:对传感器获取的数据进行深入分析,评估传感器的准确性和稳定性。

2.3 评估指标对于传感器的精度评估,我们可以考虑以下指标:(1)位置识别准确性:评估传感器对于车辆和障碍物位置的识别准确度;(2)速度测量准确性:评估传感器对车辆速度的测量准确度;(3)目标分类准确性:评估传感器对不同类型目标的分类准确度。

3. 紧急刹车系统性能评估3.1 紧急刹车系统原理人工智能自动驾驶汽车的紧急刹车系统通过识别潜在的碰撞危险并自动采取刹车措施来保障车辆和乘客的安全。

3.2 紧急刹车系统性能测试方法评估紧急刹车系统的性能需要进行以下测试:(1)实地测试:在不同道路条件下,模拟潜在危险并测试紧急刹车系统的反应时间和刹车效果;(2)模拟实验:通过计算机模拟传感器数据和实际道路条件,评估紧急刹车系统的性能。

3.3 评估指标对于紧急刹车系统性能的评估,我们可以考虑以下指标:(1)刹车距离:测量车辆在遇到紧急情况时,紧急刹车系统所需的刹车距离;(2)反应时间:评估系统检测到危险并采取刹车措施之间的时间间隔。

汽车自动驾驶专题报告

汽车自动驾驶专题报告1、自动驾驶三大系统:感知、决策、执行驾驶技术的发展是将人类驾车替换为机器驾车的过程,因此可以拿人类驾车作类比,自动驾驶技术分为感知决策和执行三大核心环节。

感知指对于环境的场景理解能力。

例如障碍物的类型、道路标志及标线、行车车辆的检测、交通信息等数据的分类。

目前存在两种主流技术路线,一种是以特斯拉为代表的以摄像头为主导的纯视觉方案;另外一种是以谷歌、百度为代表的多传感器融合方案。

根据融合阶段不同分为前融合和后融合。

前融合指的是把所有传感器的数据作为整体进行识别,后融合指的是将不同传感器识别后的结果进行整合。

决策是依据驾驶场景、驾驶需求进行任务决策,规划出车辆的路径和对应的车身控制信号。

分为任务决策、轨迹规划、跟踪控制和执行控制四个阶段。

在决策的过程中需要综合考虑安全性、舒适性和到达速度。

执行指的是将控制信号发送给执行器,执行器执行的过程。

执行器有转向、油门、刹车、灯光档位等。

由于电动汽车执行器执行较线性,便于控制,因此比燃油车更适合作为自动驾驶汽车使用。

为了实现更精确的执行能力,线控转向、线控刹车、线控油门等技术不断发展。

2、自动驾驶分级2.1L1-L2为驾驶辅助,L3-L5为自动驾驶国家标准GB/40429-2021和SAEJ3016明确定义了汽车自动驾驶分级,将驾驶自动化分为0级至5级。

其中定义等级的原则是1)自动化驾驶系统能够执行动态驾驶任务的程度。

2)驾驶员的角色分配。

3)有无允许规范限制。

国标规定L1和L2级自动化系统命名为“驾驶辅助系统”、L3-L5命名为“自动驾驶系统”。

具体来看:L0驾驶自动化—应急辅助(EmergencyAssistance):该级别的辅助驾驶系统,可以感知环境、并提供信息或者短暂介入车辆运动控制,但是不能持续执行车辆控制。

L1驾驶自动化—部分驾驶辅助(Partialdriverassistance):该级别的辅助驾驶系统可以持续提供横向或纵向运动控制。

自动驾驶教学实践报告(3篇)

第1篇一、前言随着科技的飞速发展,自动驾驶技术逐渐成为汽车行业的研究热点。

我国政府高度重视自动驾驶技术的发展,将其列为国家战略新兴产业。

为培养自动驾驶领域的人才,提升我国在自动驾驶领域的竞争力,我国多所高校和研究机构纷纷开设自动驾驶相关课程。

本报告以某高校自动驾驶教学实践为例,总结教学经验,分析存在的问题,并提出改进措施。

二、教学实践概述1. 课程设置本课程旨在培养学生掌握自动驾驶相关理论知识,提高实践操作能力。

课程设置包括以下几个方面:(1)自动驾驶概述:介绍自动驾驶技术的发展历程、技术原理、应用场景等。

(2)传感器技术:讲解激光雷达、摄像头、毫米波雷达等传感器的工作原理及在自动驾驶中的应用。

(3)感知与定位:分析目标检测、场景理解、定位与地图构建等关键技术。

(4)决策与规划:探讨决策算法、路径规划、行为规划等核心问题。

(5)控制与执行:介绍车辆控制、动力系统控制、执行机构控制等关键技术。

(6)系统集成与测试:讲解自动驾驶系统的集成、测试与验证方法。

2. 教学方法(1)理论教学:采用课堂讲授、案例分析、小组讨论等形式,使学生掌握自动驾驶相关理论知识。

(2)实践教学:通过实验、实习、项目实践等方式,提高学生的实践操作能力。

(3)课程设计:要求学生独立完成自动驾驶系统的设计与实现,培养学生的创新能力和团队协作能力。

三、教学实践成果1. 学生掌握自动驾驶相关理论知识,了解自动驾驶技术的发展趋势。

2. 学生具备自动驾驶系统的感知、决策、控制等关键技术能力。

3. 学生能够独立完成自动驾驶系统的设计与实现,具备一定的创新能力。

4. 学生在国内外各类自动驾驶竞赛中取得优异成绩,提升了学校的知名度和影响力。

四、存在的问题及改进措施1. 存在问题(1)师资力量不足:自动驾驶技术发展迅速,部分教师缺乏实践经验。

(2)实验设备不足:实验设备更新换代快,部分实验设备难以满足教学需求。

(3)课程体系不完善:课程设置不够系统,部分课程内容与实际应用脱节。

自动驾驶技术测试与应用项目可行性分析报告

自动驾驶技术测试与应用项目可行性分析报告一、引言在科技飞速发展的今天,自动驾驶技术犹如一颗璀璨的新星,吸引着无数人的目光。

想象一下,未来的道路上,车辆能够自动行驶,人们可以在车内安心地休息、工作或者娱乐,这是多么令人期待的场景啊!但在这美好的愿景实现之前,我们需要对自动驾驶技术的测试与应用项目进行深入的可行性分析。

二、自动驾驶技术概述自动驾驶技术,简单来说,就是让汽车在没有人类驾驶员直接操作的情况下,能够自主感知周围环境、做出决策并控制车辆行驶。

这可不是一件简单的事儿,它涉及到众多先进的技术,比如传感器技术、计算机视觉、人工智能算法等等。

就拿传感器来说吧,车上得装一堆“眼睛”,像激光雷达、摄像头、毫米波雷达啥的,来感知周围的车辆、行人、道路标识等等。

这些传感器收集到的信息,会被传送到车载电脑里,然后通过复杂的算法进行处理和分析,最后做出驾驶决策,比如加速、减速、转弯等等。

三、市场需求分析(一)出行需求的增长随着人们生活水平的提高,出行需求不断增加。

尤其是在大城市,交通拥堵成了家常便饭。

自动驾驶技术如果能够得到广泛应用,有望提高交通效率,减少拥堵。

我就有过这样的经历,有一次在早高峰出门,被堵在路上动弹不得。

看着旁边一辆辆车里的司机们一脸无奈,我就在想,如果车能自己开,合理规划路线,避开拥堵路段,那该多好啊!(二)消费者对安全性和舒适性的追求自动驾驶技术有望降低人为因素导致的交通事故,提高出行的安全性。

同时,也能让乘客在车内更加舒适地享受出行时光。

(三)物流行业的需求在物流领域,自动驾驶卡车可以实现不间断运输,提高物流效率,降低成本。

四、技术可行性分析(一)传感器技术的发展目前,各种传感器的精度和可靠性不断提高,能够更准确地感知周围环境。

(二)人工智能算法的进步深度学习等算法的应用,让车辆能够更好地理解和应对复杂的路况。

(三)通信技术的支持5G 网络的普及,为车辆之间、车辆与基础设施之间的高速通信提供了保障。

无人驾驶的测试和验证

无人驾驶的测试和验证一、引言与背景无人驾驶作为智能交通系统的重要组成部分,其起源可以追溯到20世纪70年代。

随着计算机技术、传感器技术、人工智能等领域的快速发展,无人驾驶汽车逐渐从概念走向现实。

近年来,谷歌、特斯拉等科技巨头以及各大汽车制造商的加入,使得无人驾驶技术得到了前所未有的关注和投入。

研究无人驾驶具有重要的现实意义和深远的社会影响。

首先,无人驾驶可以有效减少交通事故,提高道路通行效率,缓解交通拥堵。

据数据显示,90%以上的交通事故都是由人为因素造成的,无人驾驶技术有望从根本上解决这个问题。

其次,无人驾驶有助于实现能源节约和环境保护,减少碳排放。

此外,无人驾驶还可以为弱势群体提供便捷、安全的出行服务,如老年人、残疾人和儿童。

从经济角度来看,无人驾驶技术的发展将带来产业链的重构,创造大量新的就业机会,同时推动相关产业如保险、房地产、物流等领域的变革。

从科技角度来看,无人驾驶技术的突破将推动人工智能、大数据、物联网等关键技术的发展,进而推动整个社会的科技进步。

二、行业/领域的核心概念与分类核心概念无人驾驶是指利用计算机、传感器、控制系统等设备,使汽车在没有人类司机的情况下自主完成驾驶任务。

其核心目标是实现车辆的安全、高效、舒适行驶。

分类与特征1.根据传感器类型,无人驾驶车辆可以分为:–仅使用摄像头:主要依靠计算机视觉技术进行感知,如谷歌无人驾驶汽车。

–使用摄像头和雷达:结合两种传感器的优势,提高感知准确性,如特斯拉自动驾驶系统。

–使用摄像头、雷达和激光雷达:全方位感知周围环境,如百度Apollo平台。

2.根据驾驶场景,无人驾驶车辆可以分为:–封闭场地无人驾驶:如工厂、机场、港口等特定场景。

–公开道路无人驾驶:在普通公路、高速公路等公开道路上行驶。

3.根据自动驾驶级别,无人驾驶车辆可以分为:–辅助驾驶:主要用于提高驾驶员的驾驶体验,如自适应巡航、车道保持辅助等。

–部分自动驾驶:在特定场景下,车辆可以自主完成部分驾驶任务,如停车、变道等。

无人驾驶国外调研报告

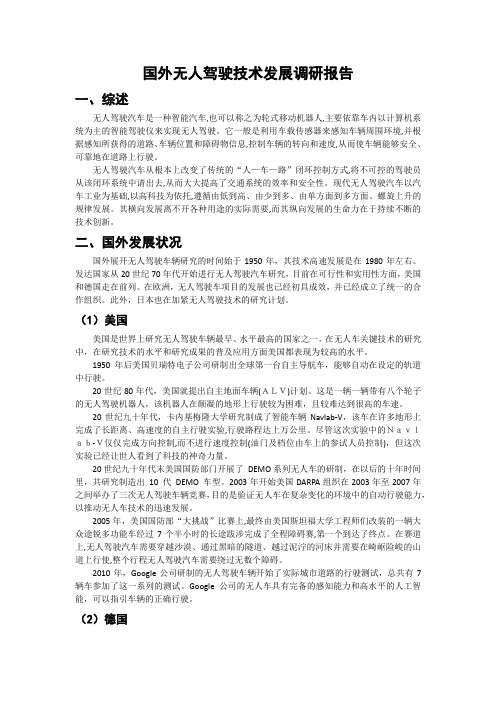

国外无人驾驶技术发展调研报告一、综述无人驾驶汽车是一种智能汽车,也可以称之为轮式移动机器人,主要依靠车内以计算机系统为主的智能驾驶仪来实现无人驾驶。

它一般是利用车载传感器来感知车辆周围环境,并根据感知所获得的道路、车辆位置和障碍物信息,控制车辆的转向和速度,从而使车辆能够安全、可靠地在道路上行驶。

无人驾驶汽车从根本上改变了传统的“人—车—路”闭环控制方式,将不可控的驾驶员从该闭环系统中请出去,从而大大提高了交通系统的效率和安全性。

现代无人驾驶汽车以汽车工业为基础,以高科技为依托,遵循由低到高、由少到多、由单方面到多方面、螺旋上升的规律发展。

其横向发展离不开各种用途的实际需要,而其纵向发展的生命力在于持续不断的技术创新。

二、国外发展状况国外展开无人驾驶车辆研究的时间始于1950年,其技术高速发展是在1980年左右。

发达国家从20世纪70年代开始进行无人驾驶汽车研究,目前在可行性和实用性方面,美国和德国走在前列。

在欧洲,无人驾驶车项目的发展也已经初具成效,并已经成立了统一的合作组织。

此外,日本也在加紧无人驾驶技术的研究计划。

(1)美国美国是世界上研究无人驾驶车辆最早、水平最高的国家之一。

在无人车关键技术的研究中,在研究技术的水平和研究成果的普及应用方面美国都表现为较高的水平。

1950年后美国贝瑞特电子公司研制出全球第一台自主导航车,能够自动在设定的轨道中行驶。

20世纪80年代,美国就提出自主地面车辆(ALV)计划。

这是一辆一辆带有八个轮子的无人驾驶机器人,该机器人在颠凝的地形上行驶较为困难,且较难达到很高的车速。

20世纪九十年代,卡内基梅隆大学研究制成了智能车辆Navlab-V,该车在许多地形上完成了长距离、高速度的自主行驶实验,行驶路程达上万公里。

尽管这次实验中的Navlab-V仅仅完成方向控制,而不进行速度控制(油门及档位由车上的参试人员控制),但这次实验已经让世人看到了科技的神奇力量。

20世纪九十年代末美国国防部门开展了DEMO系列无人车的研制,在以后的十年时间里,共研究制造出10 代DEMO 车型。

自动驾驶汽车

死亡事故

2016年6月30日,美国特斯拉汽车公司证实,一辆该公司生产的S型电动轿车在自动驾驶模式下发生撞车事故, 导致司机身亡。美国负责监管公路交通安全的机构正在对事故车辆的自动驾驶系统展开调查。这是美国首例涉及 汽车自动驾驶功能的交通死亡事故。

事故于2016年5月7日发生在美国佛罗里达州,导致涉事S型电动轿车车主、一名40岁美国男子身亡。特斯拉 在官方博客中说,公司在事发后立即向美国国家高速公路交通安全管理局作了报告。

文件明确了自动驾驶汽车申请临时上路行驶的相关条件。

第一,申请上路测试人需是在中国境内注册的独立法人单位,因进行自动驾驶相关科研、定型试验,可申请 临时上路行驶。测试车辆必须符合《机动车运行安全技术条件》(GB7258)标准。测试车辆具备自动、人工两种 驾驶模式,并可随时切换;测试车辆必须安装相应监管装置,能监测驾驶行为和车辆位置。

第二,测试车辆上路前必须先在封闭测试场内按相关标准进行测试和考核,考核结果经专家评审,通过后才 允许上路测试。

研发历史

2009年,曝光了自动驾驶汽车的雏形图片。

2009年曝光的自动驾驶汽车雏形2010年10月9日,谷歌公司在官方博客中宣布,正在开发自动驾驶汽车,目 标是通过改变汽车的基本使用方式,协助预防交通事故,将人们从大量的驾车时间中解放出来,并减少碳排 放。

nuTonomy发布自动驾驶数据集nuScenes

nuTonomy发布自动驾驶数据集nuScenes数据集是机器学习算法的命脉——从某种意义上讲,数据集对于自动驾驶等人工智能应用领域,最重要的是它们的质量最高。

同时,数据集也衍生出自动驾驶行业新的商业模式。

nuTonomy今天发布了一个名为nuScenes的自动驾驶数据集,它声称其规模和精确度超过了KITTI、百度的ApolloScape和Udacity自动驾驶汽车数据集等公共数据集。

数据集下载链接:https://d3u7q4379vrm7e.cloudfront/downloadScale为nuScenes提供了数据注释,公司首席执行官表示,这是有史以来发布的最健壮的开放源码,基于多传感器自动驾驶数据集。

NuTonomy编辑了1000多个场景,其中包含140万幅图像、40万次激光雷达扫描(判断物体之间距离)和110万个三维边界框(用RGB相机、雷达和激光雷达组合检测的物体)。

它们已经通过Scale的传感器融合注释API进行了细致的标签,该API利用人工智能和人类团队进行数据注释,并且从本周开始面向行业开源。

近年来,越来越多的公司在加入这个行列。

比如,早些时候全球红外系统供应商Flir发布了基于热成像仪拍摄的1万多张带标注图片。

Mapillary公司发布了25000张街道级别的图像,以及加州大学伯克利分校上传了10万张基于RGB相机拍摄的视频序列。

之所以被称之为比之前其他公司和机构发布的数据集更为全面,是因为此次数据搜集使用了6个摄像头、1个激光雷达、5个毫米波雷达、GPS及惯导系统,包括对于自动驾驶系统有挑战性的复杂道路、天气条件等。

车辆传感器设置使用两辆具有相同传感器布局的雷诺Zoe汽车在波士顿和新加坡开车,收集数据。

有关传感器的位置,请参阅上图。

传感器发布数据如下:1x旋转激光雷达:5倍长距离雷达传感器:相机方向和重叠请参阅下图:20Hz捕获频率32个频道360°水平视场,+ 10°至-30°垂直视场80m-100m范围,可用返回70米,精度±2厘米每秒高达~139百万点用于77GHz13Hz捕获频率使用调频连续波在一个周期内独立测量距离和速度距离最远250米速度精度为±0.1 km / hsan6x相机:12Hz捕获频率1 / 1.8英寸CMOS传感器,1600x1200分辨率Bayer8格式,每像素1字节编码1600x900 ROI从原始分辨率中裁剪,以减少处理和传输带宽曝光时间限制为最大20 ms的自动曝光图像被解压缩为BGR格式并压缩为JPEG传感器校准要获得高质量的多传感器数据集,必须校准每个传感器的外在和内在因素。

无人驾驶车辆

环境感知技术

A

Key point

定位与导航技术

B

C

控制技术

3.1环境感知技术

1

• 视觉技术

2

• 激光雷达技术

3

• 毫米波雷达技术

4

• 超声波技术

1

• 视觉技术

机器视觉采用摄影机和电脑代替人眼的方式,对目标进行识别、 跟踪和测量。在无人车辆上,通过机器视觉应用,可解释交通信号、 交通图案、道路标识等环境语言。与其它传感器相比,机器视觉具 有检测信息大、价格相对低廉等优点;但在复杂环境下,要将探测 的目标与背景提取出来,具有图像计算量大、算法不易实现等缺点。 机器视觉又分为单目视觉、全景视觉和立体视觉。

谷歌无人驾驶车

2.2国内现状

我国在军用无人车辆方面的研发尚处起步阶段。 2015 年,中国兵器工业集团北方车辆研究所成 立的地面无人平台研发中心,展示了其最新研 制的军用无人车,其采用6×6分布式轮毂电机 驱动形式,可实现零半径速差转向。据报道, 该车具有单兵跟踪的能力,可携带物资随队行 军,此外该车辆还可搭载专门的探测设备,以 辅助士兵完成侦察等任务。

4

• 超声波技术

超声波指的是工作频率在20KHz以上的机械波,它具有穿透性 强、衰减小、反射能力强等特点。超声波测距原理是利用测量超声 波发射脉冲和接收脉冲的时间差, 再结合超声波在空气中传输的速 度来计算距离。现阶段广泛应用于倒车雷达系统中的便是超声波测 距,且现在国内外市场上大量存在的泊车辅助系统大都采用超声波 测距系统。

激光雷达测距

3

• 毫米波雷达技术

毫米波雷达工作在毫米波波段,其频域为30GHz~300GHz之间,波长 介于厘米波和光波之间,兼有微波制导和光电制导的优点。毫米波导引头 体积小、质量轻、空间分辨率高;穿透雾、烟、灰尘的能力强,具有全天 候(大雨天除外)、全天时的特点。然而,雨雾对毫米波的影响非常大,吸 收强度大。在雨雾天气,毫米波雷达的性能将会大大下降。 目前,毫米波雷达主要应用于有人车辆的碰撞预警和防撞等主动安全 应用,在无人车辆领域的 应用相对激光雷达较少;毫米波雷达可以探测一 定区域内的所有目标,但是其方向性较激光雷达差,且测量精度也不如激 光雷达;另外,相对于一般的二维激光雷达,其成本高昂。这些因素虽然 限制了毫米波雷达在无人车辆上的应用,但许多国内外无人车辆,仍然会 安装一个毫米波雷达用于探测车辆正前方的障碍。

Waymo自动驾驶汽车在公共道路上的测试里程已达到了800万英里

不完全竞争市场的结构和行为模式不完全竞争市场,指的是市场中存在一些垄断力量或者卖方和买方之间存在信息不对称的情况,导致市场价格不完全由供求关系决定,产生一定的变化和扭曲。

在这种市场结构下,企业的行为模式也会受到影响,适应市场环境进行相应的调整。

本文将探讨不完全竞争市场的结构和企业的行为模式。

一、不完全竞争市场的结构不完全竞争市场的结构通常可以归为两种类型:垄断市场和寡头垄断市场。

在垄断市场中,市场上只有一个卖方或者只有几个卖方,他们可以通过操纵价格或者控制供给来获取更高的利润。

而在寡头垄断市场中,市场上存在几个相对较大的卖方,他们通过相互之间的竞争和协作来控制市场的价格和供给。

二、垄断市场的行为模式在垄断市场中,垄断者通常具有较高的市场份额和市场影响力,他们可以通过一系列的行为模式来维持自己的垄断地位。

首先,垄断者可以通过设立障碍来限制其他企业的进入,例如获取专利或者建立品牌效应。

其次,垄断者可以通过提高产品的差异化来增加消费者对其产品的需求,从而将市场需求转化为自己的市场份额。

最后,垄断者可以通过控制供给和调整价格来调整市场供求关系,以获取更高的利润。

三、寡头垄断市场的行为模式在寡头垄断市场中,寡头垄断者之间的竞争和合作对市场结构和行为模式产生重要影响。

首先,寡头垄断者之间可以通过价格协调来达到共同的利益,例如通过协商确定价格范围或者通过监测市场行情来调整价格。

其次,寡头垄断者之间也存在竞争,他们会通过创新、降低成本和提高产品品质来争夺市场份额。

最后,在寡头垄断市场中,企业之间的广告宣传和营销活动也会相对激烈,以提高产品的知名度和竞争力。

四、不完全竞争市场的政府调控在不完全竞争市场中,政府的角色和调控也起到了重要的作用。

政府可以通过反垄断法来限制垄断者的行为,保护市场的竞争秩序。

政府还可以通过监管和政策引导来调整市场结构和行为模式,以促进市场的公平竞争和消费者利益的最大化。

五、不完全竞争市场对社会经济的影响不完全竞争市场的存在可能会导致资源配置效率的降低和市场的不公平。

无人驾驶汽车道路测试报告

无人驾驶汽车道路测试报告第1章引言 (3)1.1 研究背景与意义 (3)1.2 国内外研究现状 (3)1.3 报告结构安排 (3)第2章无人驾驶汽车技术概述 (3)2.1 无人驾驶汽车发展历程 (3)2.2 核心技术与架构 (4)2.3 我国相关政策与法规 (4)第3章测试车辆与设备 (5)3.1 测试车辆概述 (5)3.1.1 车辆品牌与型号 (5)3.1.2 车辆配置 (5)3.1.3 车辆功能 (5)3.2 测试设备与传感器 (5)3.2.1 设备概述 (5)3.2.2 传感器 (5)3.3 数据采集与处理系统 (6)3.3.1 数据采集 (6)3.3.2 数据处理 (6)3.3.3 数据存储与传输 (6)第4章道路测试环境 (6)4.1 测试道路概述 (6)4.2 道路条件分析 (6)4.2.1 城市道路 (6)4.2.2 郊区道路 (6)4.2.3 高速公路 (6)4.2.4 山区道路 (7)4.3 测试场景设置 (7)4.3.1 城市道路测试场景 (7)4.3.2 郊区道路测试场景 (7)4.3.3 高速公路测试场景 (7)4.3.4 山区道路测试场景 (7)第5章道路识别与感知 (7)5.1 道路识别算法 (7)5.1.1 数据集准备 (7)5.1.2 算法训练与优化 (7)5.2 道路特征提取 (8)5.2.1 颜色特征 (8)5.2.2 结构特征 (8)5.2.3 纹理特征 (8)5.3 感知结果分析 (8)5.3.1 道路识别准确率 (8)5.3.2 道路特征贡献分析 (8)5.3.3 实际道路测试 (8)第6章车辆控制策略 (9)6.1 控制策略概述 (9)6.2 车辆跟随控制 (9)6.2.1 跟随控制策略 (9)6.2.2 跟随控制参数设置 (9)6.3 换道与超车控制 (9)6.3.1 换道控制策略 (9)6.3.2 超车控制策略 (9)6.3.3 换道与超车控制参数设置 (9)第7章决策与规划 (10)7.1 决策与规划算法 (10)7.1.1 决策算法 (10)7.1.2 规划算法 (10)7.2 遇障处理策略 (10)7.2.1 障碍物检测 (11)7.2.2 遇障处理方法 (11)7.3 行人及其他交通参与者交互策略 (11)7.3.1 行人交互策略 (11)7.3.2 其他交通参与者交互策略 (11)第8章安全性与风险评估 (11)8.1 安全性评价指标 (12)8.2 风险评估方法 (12)8.3 测试结果分析 (12)第9章测试数据与分析 (13)9.1 数据预处理与清洗 (13)9.1.1 数据清洗 (13)9.1.2 数据预处理 (13)9.2 测试数据统计分析 (13)9.2.1 描述性统计分析 (13)9.2.2 相关性分析 (13)9.2.3 假设检验 (14)9.3 测试结果可视化展示 (14)9.3.1 折线图 (14)9.3.2 散点图 (14)9.3.3 饼图 (14)9.3.4 地图 (14)第十章结论与展望 (14)10.1 测试成果总结 (14)10.2 不足与改进方向 (14)10.3 未来发展趋势与应用前景 (15)第1章引言1.1 研究背景与意义科技的飞速发展,无人驾驶汽车技术逐渐成为全球关注的热点。

安徽省六安市2024高三冲刺(高考数学)苏教版真题(拓展卷)完整试卷

安徽省六安市2024高三冲刺(高考数学)苏教版真题(拓展卷)完整试卷一、单选题:本题共8小题,每小题5分,共40分 (共8题)第(1)题已知P,Q为抛物线x2=2y上两点,点P,Q的横坐标分别为4,2,过P,Q分别作抛物线的切线,两切线交于点A,则点A的纵坐标为A.1B.3C.4D.8第(2)题已知复数,则的共轭复数()A.B.C.D.第(3)题设函数,若将的图象向左平移个单位长度后在上有且仅有两个零点,则的取值范围是()A.B.C.D.第(4)题某大型电子商务平台每年都会举行“双11”商业促销狂欢活动,现统计了该平台从2010年到2018年共9年“双11”当天的销售额(单位:亿元)并作出散点图,将销售额y看成以年份序号x(2010年作为第1年)的函数.运用excel软件,分别选择回归直线和三次多项式回归曲线进行拟合,效果如下图,则下列说法错误的是()A.销售额y与年份序号x呈正相关关系B.根据三次多项式函数可以预测2019年“双11”当天的销售额约为2684.54亿元C.三次多项式回归曲线的拟合效果好于回归直线的拟合效果D.销售额y与年份序号x线性相关不显著第(5)题某几何体的三视图如图,则该几何体的表面中最大面的面积为()A.B.C.3D.第(6)题已知,,,,若存在,,使得,则实数a的取值范围为 A.B.C.D.第(7)题2名男同学和1名女同学随机排成一行照相,则2名男同学不相邻的概率为()A.B.C.D.第(8)题已知函数f(x)=log2x-2log2(x+c),其中c>0.若对于任意的x∈(0,+∞),都有f(x)≤1,则c的取值范围是( )A.B.C.D.二、多选题:本题共3小题,每小题6分,共18分 (共3题)第(1)题如图,正方体的棱长为3,点、、分别在棱、、上,满足,,记平面与平面的交线为,则()A.存在使得平面截正方体所得截面图形为四边形B.当时,三棱锥的外接球表面积为C.当时,三棱锥体积为D.当时;与平面所成的角的正弦值为第(2)题已知点是圆上任意一点,点是直线与轴的交点,为坐标原点,则()A.以线段为直径的圆周长最小值为B.面积的最大值为C.以线段为直径的圆不可能过坐标原点D.的最大值为25第(3)题在棱长为2的正方体中,,分别为,的中点,则()A.异面直线与所成角的余弦值为B.点为正方形内一点,当平面时,的最大值为C.过点,,的平面截正方体所得的截面周长为D.当三棱锥的所有顶点都在球的表面上时,球的表面积为三、填空题:本题共3小题,每小题5分,共15分 (共3题)第(1)题铁矿石A和B的含铁率a ,冶炼每万吨铁矿石的的排放量b及每万吨铁矿石的价格c如下表:a B(万吨)C(百万元)A50%13B70%0.56某冶炼厂至少要生产1.9(万吨)铁,若要求的排放量不超过2(万吨)则购买铁矿石的最少费用为______(万元)第(2)题平面区域,则的面积为___________.第(3)题对平面直角坐标系中的两组点,如果存在一条直线使这两组点分别位于该直线的两侧,则称该直线为“分类直线”.对于一条分类直线,记所有的点到的距离的最小值为,约定:越大,分类直线的分类效果越好.某学校高三(2)班的7位同学在2020年期间网购文具的费用(单位:百元)和网购图书的费用(单位:百元)的情况如图所示,现将,,和为第Ⅰ组点.将,和归为第Ⅱ点.在上述约定下,可得这两组点的分类效果最好的分类直线,记为.给出下列四个结论:①直线比直线的分类效果好;②分类直线的斜率为2;③该班另一位同学小明的网购文具与网购图书的费用均为300元,则小明的这两项网购花销的费用所对应的点与第Ⅱ组点位于的同侧;④如果从第Ⅰ组点中去掉点,第Ⅱ组点保持不变,则分类效果最好的分类直线不是.其中所有正确结论的序号是___________.四、解答题:本题共5小题,每小题15分,最后一题17分,共77分 (共5题)第(1)题已知圆,点,P是圆M上的动点,线段PN的中垂线与直线PM交于点Q,点Q的轨迹为曲线C.(1)求曲线C的方程;(2),点E、F(不在曲线C上)是直线上关于x轴对称的两点,直线、与曲线C分别交于点A、B(不与、重合),证明:直线AB过定点.第(2)题近年来,汽车自动驾驶技术高速发展,日趋成熟.自动驾驶是依靠人工智能、视觉计算、雷达、监控装置和全球定位系统协同合作,让自动驾驶系统可以在没有人类主动的操作下,自动安全地操作机动车辆的技术,其安全性备受人们的关注.2015年起,美国加州机动车管理局要求获得自动驾驶道路测试资质的公司每年1月1日之前上交一份自动驾驶年度报告,总结道路测试总里程数,以及过程中所经历的所有自动驾驶脱离事件,脱离事件是指在自动驾驶系统遇到无法处理的情况时,由驾驶员人工干预的事件.每次脱离平均行驶里程(MPD值,Miles per Disengagement),代表自动驾驶汽车每行驶多少里程才需要人工干预一次,它由一家公司报告的总里程数除以总脱离次数得到,这是衡量一辆自动驾驶汽车“驾驶水平”的重要指标之一.下图是今年发布的《加州2023年自动驾驶脱离报告》中选取了10家公司的数据.公司所属国家测试总里程(英里)脱离次数MPD值百度中国108300618050谷歌Waymo美国145413*********通用Cruise美国8310406812221比亚迪中国32054310684小马智行中国174845276475Nuro美国68762342022Zoox美国67015421595小米中国1227281534苹果美国754464117奔驰德国142382054 6.9(1)从表中随机抽取一家中国公司和一家美国公司,求抽到的中国公司比抽到的美国公司MDP值高的概率;(2)从表中的10家公司随机抽取3家,求至少有2家MPD值大于10000的概率;(3)有人认为根据《加州2023年自动驾驶脱离报告》的数据,可以说明百度公司的自动驾驶技术已经全面超越谷歌公司.你是否同意此观点?并说明你的理由.第(3)题“友谊杯”围棋擂台赛采取淘汰制,现有名选手报名参加比赛(含甲、乙两名选手),规则如下:第一轮将所有报名选手任意两两配对对弈,输者淘汰出局,然后将剩下的名胜者再任意两两配对对弈,同样输者淘汰出局……如此下去,直至第轮比赛决出一名冠军.假定每名选手在各轮比赛中获胜的概率均为0.5.(1)当时,求甲、乙两人相遇对弈的概率;(2)当时,求甲、乙两人相遇对弈的概率;(3)已知当擂台赛报名选手人数分别为时,甲、乙两人相遇对弈的次数依次是,记,若随机变量服从两点分布,且,,求.第(4)题设正项等比数列的公比为,且,.令,记为数列的前项积,为数列的前项和.(1)若,,求的通项公式;(2)若为等差数列,且,求.第(5)题已知椭圆的左右顶点分别为和,离心率为,且经过点,过点作垂直轴于点.在轴上存在一点(异于),使得.(1)求椭圆的标准方程;(2)过点作一条垂直于轴的直线,在上任取一点,直线和直线分别交椭圆于两点,证明:直线经过定点.。

自动驾驶系统实习报告

一、实习背景随着科技的飞速发展,自动驾驶技术已成为汽车行业的重要发展方向。

我国政府高度重视自动驾驶技术的发展,并在政策、资金等方面给予了大力支持。

为了更好地了解自动驾驶技术,提高自己的专业素养,我于2021年7月至9月在某知名汽车公司进行了为期两个月的自动驾驶系统实习。

二、实习目的1. 了解自动驾驶技术的基本原理和发展现状;2. 掌握自动驾驶系统的硬件和软件架构;3. 熟悉自动驾驶系统的测试方法和流程;4. 提高自己的动手能力和团队协作能力。

三、实习内容1. 自动驾驶技术概述在实习期间,我首先了解了自动驾驶技术的基本原理和发展现状。

自动驾驶技术是指通过搭载多种传感器、控制器和执行器,使汽车能够实现自主感知、决策和执行,从而实现无人驾驶。

目前,自动驾驶技术主要分为以下几个等级:(1)L0:无自动化,全部由人类驾驶员操作;(2)L1:部分自动化,如自适应巡航控制(ACC);(3)L2:有条件自动化,如自动泊车、车道保持辅助等;(4)L3:有条件自动化,如自动驾驶辅助系统(ADAS);(5)L4:高度自动化,如自动驾驶出租车;(6)L5:完全自动化,无需人类干预。

2. 自动驾驶系统硬件架构自动驾驶系统硬件主要包括传感器、控制器和执行器。

传感器负责收集周围环境信息,控制器负责处理和分析传感器数据,执行器负责执行控制指令。

(1)传感器:常见的传感器有雷达、激光雷达、摄像头、超声波传感器等。

这些传感器可以实现对周围环境的全面感知。

(2)控制器:控制器主要负责处理和分析传感器数据,实现对汽车的自主控制。

常见的控制器有CPU、GPU、FPGA等。

(3)执行器:执行器负责执行控制指令,如电机、液压系统、制动系统等。

3. 自动驾驶系统软件架构自动驾驶系统软件主要包括感知、决策和执行三个模块。

(1)感知:感知模块负责收集和处理传感器数据,实现对周围环境的感知。

常见的感知算法有目标检测、语义分割、跟踪等。

(2)决策:决策模块负责根据感知模块提供的信息,生成控制指令。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Google Self-Driving Car Testing Reporton Disengagements of Autonomous ModeDecember 2015IntroductionIn accordance with regulations issued by the the California Department of Motor Vehicles (DMV), Google Auto LLC (“Google”) submits this report of disengagements from autonomous mode that have occurred when operating its self-driving cars (SDCs) on public roads in California. In accordance with the DMV rule , this report covers the period from the date of issuance of Google’s1Manufacturer’s Testing Permit (September 24, 2014) through November 30, 2015.As of the end of November, Google had operated its self-driving cars in autonomous mode for more than 1.3 million miles. Of those miles, 424,331 occurred on public roads in California during the period covered by this report -- with the vast majority on surface streets in the typical suburban city environment of Mountain View, CA and neighboring communities. We’re self-driving 30,000-40,000 miles or more per month, which is equal to two to four years of typical US adult driving.The setting in which our SDCs and our drivers operate most frequently is important. M astering autonomous driving on city streets -- rather than freeways, interstates or highways -- requires us to navigate complex road environments such as m ulti-lane intersectionsor unprotected left-hand turns, a larger variety of road users including cyclists and pedestrians, and more unpredictable behavior from other road users. This differs from the driving undertaken by an average American driver who will spend a larger proportion of their driving miles on less complex roads such as freeways. N ot surprisingly, 89 percent of our reportable disengagements have occurred in this complex street environment (see Table 6 below).Disengagements are a critical part of the testing process that allows our engineers to expand the software’s capabilities and identify areas of improvement. Our objective is not to minimize disengagements; rather, it is to gather, while operating safely, as much data as possible to enable us to improve our self-driving system. Therefore, we set disengagement thresholds conservatively, and each is carefully recorded. We have an evaluation process in which we identify disengagements that may signal any safety issues, and we resolve them by refining our software, firmware, or hardware and incorporating those changes across our entire fleet.As we continue to develop our technology, the rate of safety significant disengagements has fallen even as we drive more autonomous miles on public roads.Disengagements Covered by This ReportThe DMV rule defines disengagements as deactivations of the autonomous mode in two situations: (1) “when a failure of the autonomous technology is detected,” or (2) “when the safe operation of the vehicle requires that the autonomous vehicle test driver disengage the autonomous mode and take immediate manual control of the vehicle.” In adopting this definition, the DMV noted:1 S ection 227.46 of Article 3.7 (Autonomous Vehicles) of Title 13, Division 1, Chapter 1, California Code of Regulations“This clarification is necessary to ensure that manufacturers are not reporting each common or routine disengagement.”2As part of testing, our cars switch in and out of autonomous mode many times a day. These disengagements number in the many thousands on an annual basis though the vast majority are considered routine and not related to safety. Safety is our highest priority and Google test drivers are trained to take manual control in a multitude of situations, not only when safe operation “requires” that they do so. Our drivers err on the side of caution and take manual control if they have any doubt about the safety of continuing in autonomous mode (for example, due to the behavior of the SDC or any other vehicle, pedestrian, or cyclist nearby), or in situations where other concerns may warrant manual control, such as improving ride comfort or smoothing traffic flow. Similarly, the SDC’s computer hands over control to the driver in many situations that do not involve a “failure of the autonomous technology” and do not require an immediate takeover of control by the driver. We explain more in each relevant section below.Failure of the Autonomous Technology DetectedIn events where the software has detected a technology “failure” -- i.e. an issue with the autonomous technology that may affect the safe operation of the vehicle -- the SDC will immediately hand over control to the driver; we categorize these as “immediate manual control” disengagements. In these cases, the test driver is given a distinct audio and visual signal, indicating that immediate takeover is required.3“Immediate manual control” disengage thresholds are set conservatively. Our objective is not to minimize disengages; rather, it is to gather as much data as possible to enable us to improve our self-driving system. Our self-driving system runs thousands of checks on itself every second. Immediate manual control disengages are triggered primarily when we detect a communication failure between the primary and secondary (back-up) self-driving systems (for example, a broken wire); when we detect anomalies in sensor readings related to our acceleration or position in the world (accelerometers or GPS); or when we detect anomalies in the monitoring of key functions like steering and braking.During the reporting period, Google’s fleet of SDCs experienced 272 such disengagements. Our test drivers are trained and prepared for these events and the average driver response time of all measurable events was 0.84 seconds.As we continue to develop and refine the self-driving software, we are seeing fewer disengagements of this type despite a growing number of miles driven each month (Table 1). The number of autonomous miles we are driving between immediate manual control disengagements is increasing steadily over time. The rate of this type of disengagement has dropped significantly from 785 miles per disengagement in the fourth quarter of 2014 to 5318 miles per disengagement in the fourth quarter of 2015. Figure 1 illustrates this improvement.2 DMV’s Final Statement of Reasons at page 2.3 D uring this testing phase of the software, our SDC hands over control to test drivers on many other occasions that are not “failures” of the autonomous technology. As we calibrate our software and hardware, we closely monitor its performance and alert our drivers and engineers to any minor anomalies.Table 1: Disengagements related to detection of a failure of the autonomous technologyMonthNumberDisengagesAutonomous mileson public roads2014/09 0 4207.22014/10 14 23971.12014/11 14 15836.62014/12 40 9413.12015/01 48 18192.12015/02 12 18745.12015/03 26 22204.22015/04 47 31927.32015/05 9 38016.82015/06 7 42046.62015/07 19 34805.12015/08 4 38219.82015/09 15 36326.62015/10 11 47143.52015/11 6 43275.9Total 272 424331Figure 1: Autonomous miles driven per disengagement related to detection of a failure of the autonomous technologyDisengagements Where Safe Operation of the Vehicle Requires Control by the DriverOur test drivers play a critical role in refining our technology and ensuring the safe operation of the vehicles while we are in this development phase. They are directed to take control of the vehicle as often as they feel is necessary and for a variety of reasons relating to the comfort of the ride, the safety of the vehicle, or the erratic or unpredictable behavior of other road users.Each time a test driver takes manual control of the vehicle, our system automatically records the circumstances leading up to the disengagement from autonomous mode and flags them for review by the software team. This information, along with feedback given by the test driver, is used to evaluate the software for any potential safety issues or areas of improvement, such as making our self-driving car drive more smoothly.To help evaluate the significance of driver disengagements, we employ a powerful simulator program -- developed in-house by our engineers -- that allows the team to “replay” each incident and predict the behavior of the self-driving car (had the driver not taken control of it) as well as the behavior and positions of other road users in the vicinity (such as pedestrians, cyclists, and other vehicles). The simulator can also create thousands of variations on that core event so we can evaluatewhat would have happened under slightly different circumstances, such as our vehicle and other road users moving at different times, speeds, and angles.Through this process we can determine the events that have safety significance and should receive prompt and thorough attention from our engineers in resolving them. In the reporting period, there were 69 events across our fleet in which safe operation of the vehicle required disengagement by the driver.Each of these events is carefully studied to root out the underlying issue or family of issues, and our software is then refined. The revised software is tested extensively, in simulation, on closed courses and on public roads with our test drivers. Even with the vast majority of our autonomous miles being driven in complex city street environments, we only record a few safe operation disengagements each month (Table 2) .Table 2: Driver-initiated disengagements related to safe operation of the vehicleMonthNumberDisengagesAutonomous mileson public roads2014/09 2 4207.22014/10 5 23971.12014/11 7 15836.62014/12 3 9413.12015/01 5 18192.12015/02 2 18745.12015/03 4 22204.22015/04 4 31927.32015/05 4 38016.82015/06 4 42046.62015/07 10 34805.12015/08 3 38219.82015/09 1 36326.62015/10 5 47143.52015/11 10 43275.9Total69 424331Figure 2, below, displays how the number of autonomous miles driven between such disengagements has changed over the calendar quarters covered in the report. The low absolute number of events makes a trend hard to discern because an aberrational month can skew the data.Figure 2: Autonomous miles driven per driver-initiated disengagement related to safe operationof the vehicleOf the 69 reportable safe operation events, 13 were “simulated contacts” -- events in which, upon replaying the event in our simulator, we determined that the test driver prevented our vehicle from making contact with another object. The remaining 56 of the 69 events were safety-significant because, under simulation, we identified some aspect of the SDC’s behavior that could be a potential cause of contacts in other environments or situations if not addressed. This includes proper perception of traffic lights, yielding properly to pedestrians and cyclists, and violations of traffic laws. To be clear, however, these 56 events during the reporting period would very likely not have resulted in a real-world contact if the test driver had not taken over.In 10 of the 13 simulated contact events, the SDC’s predicted behavior would have, in simulation, caused contact (though 2 of these involved simulated contact with traffic cones). In 3 of the 13 occasions, a driver in another vehicle made a move that would have, in simulation, caused a contact with our car (e.g., in one case the other vehicle was driving the wrong way down the road in the SDC’s path); in these cases, we believe a human driver could have taken a reasonable action to avoid the contact but the simulation indicated the SDC would not have taken that action.These events are rare and our engineers carefully study these simulated contacts and refine the software to ensure the self-driving car performs safely. A software “fix” is tested against many miles of simulated driving, then tested on the road, and, after careful review and validation, rolled out to the entire fleet. The rate of these simulated contact disengagements is declining even as autonomous miles driven increase. Because the simulated contact events are so few in number, they do not lend themselves well to trend analysis, but, we are generally driving more autonomous miles between these events. From April 2015 to November 2015, our cars self-drove more than 230,000 miles without a single such event.Table 3: Disengagements related to simulated contacts of the autonomous technologyMonthNumberDisengagesAutonomous mileson public roads2014/09 0 4207.22014/10 2 23971.12014/11 4 15836.62014/12 2 9413.12015/01 1 18192.12015/02 0 18745.12015/03 1 22204.22015/04 1 31927.32015/05 0 38016.82015/06 0 42046.62015/07 0 34805.12015/08 0 38219.82015/09 0 36326.62015/10 0 47143.52015/11 2 43275.9Total 13 424331Summary of All Reportable DisengagementsTable 4 summarizesa ll disengagements required to be reported to the DMV, i.e., both those where a failure of the autonomous technology was detected and those involving drivers taking control when required for safe operation. A brief description of each reportable disengagement is shown in Appendix A.Table 4: All Reportable DisengagementsMonthNumberDisengagesAutonomous mileson public roads2014/09 2 4207.22014/10 19 23971.12014/11 21 15836.62014/12 43 9413.12015/01 53 18192.12015/02 14 18745.12015/03 30 22204.22015/04 51 31927.32015/05 13 38016.82015/06 11 42046.62015/07 29 34805.12015/08 7 38219.82015/09 16 36326.62015/10 16 47143.52015/11 16 43275.9Total 341 424331 Figure 3, below, shows the relationship between all reportable disengagements and the number of autonomous miles driven.Figure 3: Autonomous miles driven per reportable disengagementTable 5 below provides the breakdown of disengagements by cause. Note that, while we have used, where applicable, the causes mentioned in the DMV rule (weather conditions, road surface conditions, construction, emergencies, accidents or collisions), those causes were infrequent in our experience. Far more frequent were the additional causes we have labeled as unwanted maneuver, perception discrepancy, software discrepancy, hardware discrepancy, incorrect behavior prediction, or other road users behaving recklessly.4Table 5: Disengagements by Cause4 O ur cause descriptions reflect the categories of disengagements that our experience has taught us are the most useful for analyzing any underlying issue. “Recklessly behaving road user” indicates that our driver disengaged from autonomous mode to respond to reckless behavior by another driver, cyclist, or pedestrian. “Hardware discrepancy” indicates that a hardware element is not performing as expected. “Unwanted maneuver of the vehicle” involves the SDC moving in a way that is undesirable (e.g., coming uncomfortably close to a parked car). “Perception discrepancy” refers to a situation in which the SDC’s sensors are not correctly perceiving an object (e.g., perceiving overhanging branches as an obstacle). “Incorrect behavior prediction of other traffic participants” involves not correctly predicting the behavior of another road user (e.g., incorrectly predicting that pedestrians on the sidewalk will jaywalk). “Software discrepancy” covers situations involving apparent software inadequacies that do not readily fall into other categories (e.g., map or calibration issues).Cause Sep2014Oct2014Nov2014Dec2014Jan2015Feb2015Mar2015Apr2015May2015Jun2015Jul2015Aug2015Sep2015Oct2015Nov2015Totaldisengage forweatherconditionsduring testing 0 0 0 0 1 5 0 6 0 0 0 0 0 0 1 13 disengage for arecklesslybehaving roaduser 1 0 1 1 1 3 3 7 0 0 0 2 1 0 3 23 disengage forhardwarediscrepancy 0 1 0 0 2 1 0 1 0 5 8 1 8 8 4 39 disengage forunwantedmaneuver ofthe vehicle 0 3 6 14 15 1 3 2 1 0 3 2 0 3 2 55 disengage for aperceptiondiscrepancy 1 2 3 18 19 2 20 30 4 4 8 0 4 3 1 119 disengage forincorrectbehaviorprediction ofother trafficparticipants 0 2 2 0 1 0 2 0 0 0 0 0 0 1 0 8 disengage for asoftwarediscrepancy 0 11 9 9 14 2 1 5 8 2 9 2 3 1 4 80 disengage forconstructionzone duringtesting 0 0 0 1 0 0 1 0 0 0 1 0 0 0 0 3 disengage foremergencyvehicle duringtesting 0 0 0 0 0 0 0 0 0 0 0 0 0 0 1 1 Total 2 19 21 43 53 14 30 51 13 11 29 7 16 16 16 341Table 6 provides information on the location of disengagements covered in this report.Table 6: Disengagements by LocationLocation Sep2014Oct2014Nov2014Dec2014Jan2015Feb2015Mar2015Apr2015May2015Jun2015Jul2015Aug2015Sep2015Oct2015Nov2015TotalInterstate 0 0 0 0 0 0 0 0 0 0 1 0 0 0 0 1 Freeway 0 0 0 0 0 0 0 0 1 0 3 0 0 0 0 4 Highway 0 1 2 0 1 1 4 2 3 2 2 2 5 4 3 32 Street 2 18 19 43 52 13 26 49 9 9 23 5 11 12 13 304 Total 2 19 21 43 53 14 30 51 13 11 29 7 16 16 16 341In its listing of possible disengagement causes, the DMV rule asks each manufacturer to state “whether the disengagement was the result of a planned test of the autonomous vehicle.” All thedisengagements reported here occurred during planned testing of the SDCs. However, if the rule isseeking information on whether the disengagement occurred during planned testing of thedisengagement function itself, we do not test that function on public roads. Instead, we test thefunction in our own facilities during vehicle preparation.Miles Driven by Autonomous VehiclesAppendix Bs hows the total number of miles each autonomous vehicle was tested in autonomous mode on public roads each month. The total miles driven on public roads in Californiaby Google’s fleet during the period, broken down by autonomous and manual modes, is shown inFigure 4.FIgure 4: Miles driven on public roads in California.Time Elapsed Between Technology Failure and Driver Assumption of ControlThe DMV rule requires that our report include in our summary of disengagements the “period of time elapsed from when the autonomous vehicle test driver was alerted of the technology failure and the driver assumed manual control of the vehicle.” This requirement is relevant only to the “technology failure” category of disengagements when the vehicle hands over control to the driver for immediate action. Appendix A shows this elapsed time for each disengagement where the data are available. In the vast majority of cases, the driver took control in one second or less after the immediate manual control message was received. The average time of all measurable events was 0.84 seconds.Appendix ASummary of Each Reportable DisengagementDate Location Type Time to manual CauseSep 2014 Street Safe Operation - Disengage for a perception discrepancy Sep 2014 Street Safe Operation - Disengage for a recklessly behaving agent Oct 2014 Street Safe Operation - Disengage for a perception discrepancy Oct 2014 Street Failure Detection 0.7s Disengage for hardware discrepancyOct 2014 Street Safe Operation - Disengage for incorrect behavior prediction of other traffic participantsOct 2014 Street Failure Detection 0.8s Disengage for unwanted maneuver of the vehicle Oct 2014 Street Failure Detection 0.8s Disengage for unwanted maneuver of the vehicle Oct 2014 Street Failure Detection 0.9s Disengage for a software discrepancyOct 2014 Street Safe Operation - Disengage for a perception discrepancyOct 2014 Highway Failure Detection 0.6s Disengage for a software discrepancyOct 2014 Street Failure Detection 0.9s Disengage for a software discrepancyOct 2014 Street Failure Detection 0.9s Disengage for a software discrepancyOct 2014 Street Failure Detection 1.0s Disengage for a software discrepancyOct 2014 Street Failure Detection 0.6s Disengage for a software discrepancyOct 2014 Street Failure Detection 0.9s Disengage for a software discrepancyOct 2014 Street Failure Detection 0.6s Disengage for a software discrepancyOct 2014 Street Failure Detection 0.6s Disengage for a software discrepancyOct 2014 Street Safe Operation - Disengage for unwanted maneuver of the vehicleOct 2014 Street Safe Operation - Disengage for incorrect behavior prediction of other traffic participantsOct 2014 Street Failure Detection 0.7s Disengage for a software discrepancy Oct 2014 Street Failure Detection * Disengage for a software discrepancy Nov 2014 Street Failure Detection 0.5s Disengage for a software discrepancy Nov 2014 Highway Failure Detection 0.8s Disengage for a software discrepancy Nov 2014 Street Failure Detection 0.7s Disengage for a software discrepancy Nov 2014 Street Failure Detection 0.2s Disengage for a software discrepancy Nov 2014 Street Failure Detection 0.7s Disengage for a software discrepancyNov 2014 Street Safe Operation - Disengage for a perception discrepancyNov 2014 Street Failure Detection 0.2s Disengage for incorrect behavior prediction of other traffic participantsNov 2014 Street Failure Detection 0.8s Disengage for a software discrepancyNov 2014 Street Failure Detection 0.6s Disengage for a software discrepancyNov 2014 Street Safe Operation - Disengage for unwanted maneuver of the vehicleNov 2014 Street Failure Detection * Disengage for incorrect behavior prediction of other traffic participantsNov 2014 Street Safe Operation - Disengage for a recklessly behaving agentNov 2014 Street Failure Detection 0.7s Disengage for unwanted maneuver of the vehicle Nov 2014 Street Safe Operation - Disengage for unwanted maneuver of the vehicle Nov 2014 Street Safe Operation - Disengage for a perception discrepancyNov 2014 Street Failure Detection 0.2s Disengage for unwanted maneuver of the vehicle Nov 2014 Highway Failure Detection 1.1s Disengage for a software discrepancyNov 2014 Street Safe Operation - Disengage for a perception discrepancyNov 2014 Street Failure Detection 2.2s Disengage for unwanted maneuver of the vehicle Nov 2014 Street Safe Operation - Disengage for unwanted maneuver of the vehicle Nov 2014 Street Failure Detection 2.2s Disengage for a software discrepancyDec 2014 Street Failure Detection 0.2s Disengage for a software discrepancyDec 2014 Street Safe Operation - Disengage for unwanted maneuver of the vehicle Dec 2014 Street Failure Detection * Disengage for a software discrepancyDec 2014 Street Failure Detection 1.8s Disengage for unwanted maneuver of the vehicle Dec 2014 Street Failure Detection 0.7s Disengage for unwanted maneuver of the vehicle Dec 2014 Street Failure Detection 0.8s Disengage for unwanted maneuver of the vehicle Dec 2014 Street Failure Detection * Disengage for unwanted maneuver of the vehicle Dec 2014 Street Failure Detection 0.3s Disengage for a perception discrepancyDec 2014 Street Failure Detection 1.2s Disengage for unwanted maneuver of the vehicle Dec 2014 Street Failure Detection 0.8s Disengage for unwanted maneuver of the vehicle Dec 2014 Street Failure Detection 0.3s Disengage for unwanted maneuver of the vehicle Dec 2014 Street Failure Detection 1.1s Disengage for a perception discrepancyDec 2014 Street Failure Detection 1.7s Disengage for a perception discrepancyDec 2014 Street Failure Detection 1.1s Disengage for unwanted maneuver of the vehicle Dec 2014 Street Failure Detection * Disengage for a perception discrepancyDec 2014 Street Failure Detection * Disengage for a perception discrepancyDec 2014 Street Failure Detection 0.3s Disengage for a software discrepancyDec 2014 Street Failure Detection 1.0s Disengage for a perception discrepancyDec 2014 Street Failure Detection * Disengage for a perception discrepancyDec 2014 Street Failure Detection 0.7s Disengage for unwanted maneuver of the vehicle Dec 2014 Street Failure Detection 0.6s Disengage for a perception discrepancyDec 2014 Street Failure Detection * Disengage for a perception discrepancyDec 2014 Street Failure Detection 1.3s Disengage for a perception discrepancyDec 2014 Street Failure Detection 0.4s Disengage for a software discrepancyDec 2014 Street Failure Detection 0.2s Disengage for unwanted maneuver of the vehicle Dec 2014 Street Failure Detection 2.0s Disengage for a perception discrepancyDec 2014 Street Failure Detection 0.8s Disengage for unwanted maneuver of the vehicle Dec 2014 Street Failure Detection 0.8s Disengage for a software discrepancyDec 2014 Street Failure Detection 1.6s Disengage for a software discrepancyDec 2014 Street Failure Detection 0.8s Disengage for a perception discrepancyDec 2014 Street Failure Detection 0.3s Disengage for a software discrepancyDec 2014 Street Failure Detection 1.7s Disengage for unwanted maneuver of the vehicle Dec 2014 Street Failure Detection 0.3s Disengage for unwanted maneuver of the vehicle Dec 2014 Street Failure Detection 0.4s Disengage for a recklessly behaving agentDec 2014 Street Failure Detection 0.2s Disengage for a perception discrepancyDec 2014 Street Failure Detection 1.2s Disengage for a software discrepancyDec 2014 Street Failure Detection * Disengage for a perception discrepancyDec 2014 Street Safe Operation - Disengage for construction zone during testing Dec 2014 Street Safe Operation - Disengage for a perception discrepancyDec 2014 Street Failure Detection 0.6s Disengage for a perception discrepancyDec 2014 Street Failure Detection * Disengage for a perception discrepancyDec 2014 Street Failure Detection 1.3s Disengage for a perception discrepancyJan 2015 Street Failure Detection 1.9s Disengage for unwanted maneuver of the vehicle Jan 2015 Street Failure Detection * Disengage for a perception discrepancyJan 2015 Street Failure Detection 0.2s Disengage for a perception discrepancyJan 2015 Street Failure Detection * Disengage for a perception discrepancyJan 2015 Street Failure Detection 0.2s Disengage for a perception discrepancyJan 2015 Street Failure Detection 0.5s Disengage for a software discrepancyJan 2015 Street Failure Detection 0.3s Disengage for unwanted maneuver of the vehicle Jan 2015 Street Failure Detection 0.3s Disengage for a perception discrepancyJan 2015 Street Failure Detection 0.8s Disengage for a software discrepancyJan 2015 Street Failure Detection 0.3s Disengage for unwanted maneuver of the vehicle Jan 2015 Street Failure Detection 0.8s Disengage for a perception discrepancyJan 2015 Street Failure Detection 0.5s Disengage for unwanted maneuver of the vehicle Jan 2015 Street Failure Detection 0.7s Disengage for a perception discrepancyJan 2015 Street Failure Detection * Disengage for adverse road surface conditions such as road holes or bumpsJan 2015 Street Failure Detection 0.4s Disengage for unwanted maneuver of the vehicle Jan 2015 Street Failure Detection 0.3s Disengage for a perception discrepancyJan 2015 Street Failure Detection 0.7s Disengage for unwanted maneuver of the vehicle Jan 2015 Street Failure Detection * Disengage for a software discrepancyJan 2015 Street Failure Detection 0.3s Disengage for a perception discrepancyJan 2015 Street Failure Detection 1.0s Disengage for a software discrepancyJan 2015 Street Failure Detection 0.4s Disengage for unwanted maneuver of the vehicle Jan 2015 Street Failure Detection 1.4s Disengage for a perception discrepancyJan 2015 Street Failure Detection 1.9s Disengage for a perception discrepancyJan 2015 Street Failure Detection 0.3s Disengage for unwanted maneuver of the vehicle Jan 2015 Street Failure Detection 0.2s Disengage for a software discrepancyJan 2015 Street Failure Detection 0.2s Disengage for a software discrepancyJan 2015 Street Failure Detection 1.0s Disengage for a software discrepancyJan 2015 Street Failure Detection 2.0s Disengage for a software discrepancyJan 2015 Street Failure Detection 0.2s Disengage for unwanted maneuver of the vehicle Jan 2015 Street Failure Detection 0.8s Disengage for a perception discrepancyJan 2015 Highway Safe Operation - Disengage for a recklessly behaving agentJan 2015 Street Failure Detection 0.2s Disengage for a perception discrepancyJan 2015 Street Safe Operation - Disengage for incorrect behavior prediction of other traffic participantsJan 2015 Street Failure Detection 0.3s Disengage for a software discrepancyJan 2015 Street Failure Detection 1.4s Disengage for unwanted maneuver of the vehicle Jan 2015 Street Failure Detection 1.3s Disengage for unwanted maneuver of the vehicle Jan 2015 Street Failure Detection 0.9s Disengage for unwanted maneuver of the vehicle Jan 2015 Street Failure Detection * Disengage for unwanted maneuver of the vehicle Jan 2015 Street Failure Detection * Disengage for a perception discrepancyJan 2015 Street Failure Detection 0.6s Disengage for a software discrepancy。