朴素贝叶斯分类器设计方案v1.0

朴素贝叶斯分类器的超参数调优方法(十)

朴素贝叶斯分类器的超参数调优方法朴素贝叶斯分类器是一种基于贝叶斯定理的机器学习算法,它在文本分类、垃圾邮件过滤、情感分析等领域有着广泛的应用。

尽管朴素贝叶斯分类器具有简单、高效的特点,但是在实际应用中,对其超参数的调优仍然是一个重要的课题。

本文将介绍一些常见的朴素贝叶斯分类器超参数调优方法,以及它们的优缺点。

1. 数据预处理在进行朴素贝叶斯分类器的超参数调优之前,首先需要进行数据预处理。

数据预处理包括数据清洗、特征提取、特征选择等步骤。

在数据清洗方面,需要处理缺失值、异常值等问题,以确保数据的质量。

在特征提取和选择方面,可以采用词袋模型、TF-IDF等技术,以提取有效的特征并降低特征的维度。

2. 贝叶斯估计朴素贝叶斯分类器的核心是基于贝叶斯定理进行分类。

在贝叶斯估计中,存在一个重要的超参数——平滑参数。

平滑参数的选择对分类器的性能有着重要的影响。

常见的平滑参数包括拉普拉斯平滑、Lidstone平滑等。

在实际应用中,可以通过交叉验证等方法选择最优的平滑参数。

3. 特征选择朴素贝叶斯分类器在特征选择方面有着其独特的优势。

在进行特征选择时,可以采用互信息、卡方检验等方法,以选择对分类器性能有着重要影响的特征。

此外,还可以采用特征组合、特征降维等方法,以提高分类器的效果。

4. 样本平衡在实际应用中,样本不均衡是一个常见的问题。

对于不均衡样本,朴素贝叶斯分类器的性能会受到影响。

因此,在进行超参数调优时,需要考虑样本平衡的问题。

可以采用过采样、欠采样等方法,以提高分类器对不均衡样本的适应能力。

5. 多分类问题朴素贝叶斯分类器通常用于二分类问题,但在一些实际应用中,需要处理多分类问题。

对于多分类问题,需要对朴素贝叶斯分类器进行相应的调优。

可以采用一对一、一对多等方法,以解决多分类问题。

6. 结合其他算法朴素贝叶斯分类器可以与其他算法进行结合,以提高分类器的性能。

例如,可以将朴素贝叶斯分类器与支持向量机、决策树等算法进行融合,以提高分类器的泛化能力。

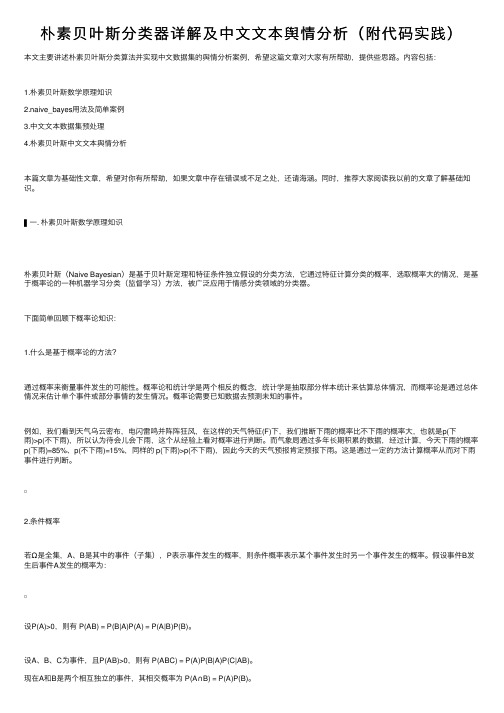

朴素贝叶斯分类器详解及中文文本舆情分析(附代码实践)

朴素贝叶斯分类器详解及中⽂⽂本舆情分析(附代码实践)本⽂主要讲述朴素贝叶斯分类算法并实现中⽂数据集的舆情分析案例,希望这篇⽂章对⼤家有所帮助,提供些思路。

内容包括:1.朴素贝叶斯数学原理知识2.naive_bayes⽤法及简单案例3.中⽂⽂本数据集预处理4.朴素贝叶斯中⽂⽂本舆情分析本篇⽂章为基础性⽂章,希望对你有所帮助,如果⽂章中存在错误或不⾜之处,还请海涵。

同时,推荐⼤家阅读我以前的⽂章了解基础知识。

▌⼀. 朴素贝叶斯数学原理知识朴素贝叶斯(Naive Bayesian)是基于贝叶斯定理和特征条件独⽴假设的分类⽅法,它通过特征计算分类的概率,选取概率⼤的情况,是基于概率论的⼀种机器学习分类(监督学习)⽅法,被⼴泛应⽤于情感分类领域的分类器。

下⾯简单回顾下概率论知识:1.什么是基于概率论的⽅法?通过概率来衡量事件发⽣的可能性。

概率论和统计学是两个相反的概念,统计学是抽取部分样本统计来估算总体情况,⽽概率论是通过总体情况来估计单个事件或部分事情的发⽣情况。

概率论需要已知数据去预测未知的事件。

例如,我们看到天⽓乌云密布,电闪雷鸣并阵阵狂风,在这样的天⽓特征(F)下,我们推断下⾬的概率⽐不下⾬的概率⼤,也就是p(下⾬)>p(不下⾬),所以认为待会⼉会下⾬,这个从经验上看对概率进⾏判断。

⽽⽓象局通过多年长期积累的数据,经过计算,今天下⾬的概率p(下⾬)=85%、p(不下⾬)=15%,同样的 p(下⾬)>p(不下⾬),因此今天的天⽓预报肯定预报下⾬。

这是通过⼀定的⽅法计算概率从⽽对下⾬事件进⾏判断。

2.条件概率若Ω是全集,A、B是其中的事件(⼦集),P表⽰事件发⽣的概率,则条件概率表⽰某个事件发⽣时另⼀个事件发⽣的概率。

假设事件B发⽣后事件A发⽣的概率为:设P(A)>0,则有 P(AB) = P(B|A)P(A) = P(A|B)P(B)。

设A、B、C为事件,且P(AB)>0,则有 P(ABC) = P(A)P(B|A)P(C|AB)。

朴素贝叶斯分类算法的设计与分析

朴素贝叶斯分类算法的设计与分析朴素贝叶斯分类算法是一种常用于文本分类的算法,其核心思想是基于贝叶斯公式和特征条件独立假设,利用已有的样本数据集建立模型,进而对新样本进行分类。

1. 特征提取在分类之前,需要将文本数据转化为可计算的特征向量。

常见的特征提取方法包括词袋模型、TF-IDF等。

其中,词袋模型将一篇文本表示为一个词集合,即将文本中出现的所有单词组合成一个无序的集合;而TF-IDF则是根据某个词在文本中的出现频率和在整个文本集合中的逆文档频率来计算每个词的权重。

2. 模型训练在训练阶段,需要利用带有标签的样本数据集来构建分类器。

一般地,用$D={(x_1,y_1),(x_2,y_2),...,(x_n,y_n)}$表示训练样本集合,其中$x_i$表示文本的特征向量,$y_i$表示该文本所属的类别。

可以利用训练集中出现次数计算每个类别的先验概率$P(y)$,以及对于每个类别$y$,特征向量$x$在该类别下的条件概率$P(x|y)$。

具体而言,对于一个特征向量$x$和类别$y$,其条件概率可以用以下公式来计算:$P(x|y)=P(x_1,x_2,...,x_n|y)=P(x_1|y)*P(x_2|y)*...*P(x_n|y)$其中,特征条件独立假设是指假设在每个类别下,特征之间相互独立。

这个假设在实际情况中并不总是成立,但是由于其简化了模型的复杂度,并且在很多情况下可以得到不错的结果,因此被广泛应用。

3. 模型预测当拥有了训练好的模型之后,就可以对新的文本进行分类。

具体而言,对于一个特定的文本$x$,其所属类别$y$可以用以下公式来计算:$P(y|x) = \frac{P(y)*P(x|y)}{\sum_{y^\prime}P(y^\prime)*P(x|y^\prime)}$其中,分母是归一化项,其目的是保证概率的总和为1。

在实际应用中,通常只需要比较不同类别$y$的后验概率$P(y|x)$,将概率最大的类别作为该文本的分类结果即可。

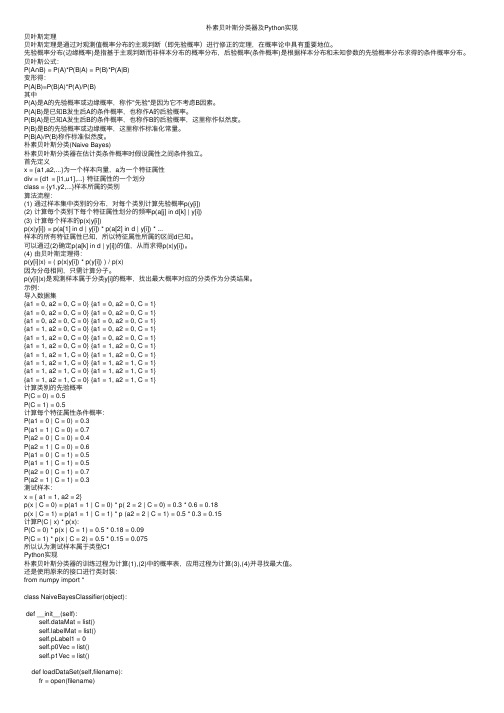

朴素贝叶斯分类器及Python实现

朴素贝叶斯分类器及Python实现贝叶斯定理贝叶斯定理是通过对观测值概率分布的主观判断(即先验概率)进⾏修正的定理,在概率论中具有重要地位。

先验概率分布(边缘概率)是指基于主观判断⽽⾮样本分布的概率分布,后验概率(条件概率)是根据样本分布和未知参数的先验概率分布求得的条件概率分布。

贝叶斯公式:P(A∩B) = P(A)*P(B|A) = P(B)*P(A|B)变形得:P(A|B)=P(B|A)*P(A)/P(B)其中P(A)是A的先验概率或边缘概率,称作"先验"是因为它不考虑B因素。

P(A|B)是已知B发⽣后A的条件概率,也称作A的后验概率。

P(B|A)是已知A发⽣后B的条件概率,也称作B的后验概率,这⾥称作似然度。

P(B)是B的先验概率或边缘概率,这⾥称作标准化常量。

P(B|A)/P(B)称作标准似然度。

朴素贝叶斯分类(Naive Bayes)朴素贝叶斯分类器在估计类条件概率时假设属性之间条件独⽴。

⾸先定义x = {a1,a2,...}为⼀个样本向量,a为⼀个特征属性div = {d1 = [l1,u1],...} 特征属性的⼀个划分class = {y1,y2,...}样本所属的类别算法流程:(1) 通过样本集中类别的分布,对每个类别计算先验概率p(y[i])(2) 计算每个类别下每个特征属性划分的频率p(a[j] in d[k] | y[i])(3) 计算每个样本的p(x|y[i])p(x|y[i]) = p(a[1] in d | y[i]) * p(a[2] in d | y[i]) * ...样本的所有特征属性已知,所以特征属性所属的区间d已知。

可以通过(2)确定p(a[k] in d | y[i])的值,从⽽求得p(x|y[i])。

(4) 由贝叶斯定理得:p(y[i]|x) = ( p(x|y[i]) * p(y[i]) ) / p(x)因为分母相同,只需计算分⼦。

朴素贝叶斯分类器

朴素贝叶斯分类方法1朴素贝叶斯分类方法概述朴素贝叶斯分类方法是在严谨的数学理论作支撑和假设分类项的各个属性相互独立的情况下基于贝叶斯定理而得出的一类分简单常用类方法。

假设一个属性对给定类的影响独立于其他属性,当条件独立性假设成立时,朴素贝叶斯分类算法具有最小的误分类率。

2数学知识准备2.1概率空间定义如果是上的一个实值函数,即对每一个,有一个实函数与之对应,并且满足一下三点:非负性规范性可列可加性若是R中的两两不相容的事件,则称是上的一个概率测度, 称为事件A的概率,三元组称为概率空间。

2.2条件概率定义设为一概率空间,,且则称为已知A发生时B的条件概率。

2.3 全概率公式定义设两两不相容,且,则对任何事件。

2.4 贝叶斯公式定义设两两不相容,则对于任何满足的B,,有:3朴素贝叶斯分类方法流程:3.1第一阶段——准备阶段:该阶段为朴素贝叶斯分类做必要的准备。

主要是依据具体情况确定特征属性,并且对特征属性进行适当划分。

然后就是对一部分待分类项进行人工划分,以确定训练样本。

这一阶段的输入是所有的待分类项,输出时特征属性和训练样本。

分类器的质量很大程度上依赖于特征属性及其划分以及训练样本的质量。

3.2第二阶段——分类器训练阶段:主要工作是计算每个类别在训练样本中出现频率以及每个特征属性划分对每个类别的条件概率估计。

输入是特征属性和训练样本,输出是分类器。

3.3第三阶段——应用阶段:这个阶段的任务是使用分类器对待分类项进行分类,其输入是分类器和待分类项,输出是待分类项与类别的映射关系。

这一阶段也是机械性阶段,由程序完成。

4朴素贝叶斯分类方法详细操作过程:4.1朴素贝叶斯分类或简单贝叶斯分类的工作过程(1)每个数据样本用一个n 维特征向量{}12,,...n X x x x =表示,分别描述对n 个属性A 1,A 2,…A n 样本的n 个度量。

(2)假定有m 个类C 1,C 2,…C m 。

给定一个未知的数据样本X (即没有类标号),分类法将预测X 属于具有最高后验概率(条件X 下)的类。

朴素贝叶斯分类器

朴素贝叶斯分类器Naive Bayesian ClassifierC语言实现信息电气工程学院计算本1102班20112212465马振磊1.贝叶斯公式通过贝叶斯公式,我们可以的知在属性F1-Fn成立的情况下,该样本属于分类C的概率。

而概率越大,说明样本属于分类C的可能性越大。

若某样本可以分为2种分类A,B。

要比较P(A | F1,F2......) 与P(B | F1,F2......)的大小只需比较,P(A)P(F1,F2......| A) ,与P(B)P(F1,F2......| B) 。

因为两式分母一致。

而P(A)P(F1,F2......| A)可以采用缩放为P(A)P(F1|A)P(F2|A).......(Fn|A)因此,在分类时,只需比较每个属性在分类下的概率累乘,再乘该分类的概率即可。

分类属性outlook 属性temperature 属性humidity 属性wind no sunny hot high weakno sunny hot high strongyes overcast hot high weakyes rain mild high weakyes rain cool normal weakno rain cool normal strongyes overcast cool normal strongno sunny mild high weakyes sunny cool normal weakyes rain mild normal weakyes sunny mild normal strongyes overcast mild high strongyes overcast hot normal weakno rain mild high strong以上是根据天气的4种属性,某人外出活动的记录。

若要根据以上信息判断(Outlook = sunny,Temprature = cool,Humidity = high,Wind = strong)所属分类。

朴素贝叶斯分类算法演示

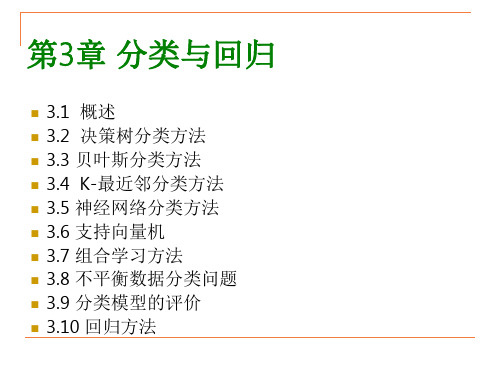

基本概念

与ID3分类算法相关的基本概念包括:

信息熵 信息增益

信息熵

熵(entropy,也称信息熵)用来度量一个属性的信 息量。

假定S为训练集,S的目标属性C具有m个可能的类标 号值,C={C1,C2,…,Cm},假定训练集S中,Ci在所 有样本中出现的频率为 (i=1,2,3,…,m),则该训练集S 所包含的信息熵定义为:

Single Married Single Married

125K 100K 70K 120K

婚姻状态

Single, Divorced Married NO > 80K YES

Divorced 95K Married 60K

年收入

< 80K NO

Divorced 220K Single Married Single 85K 75K 90K

分类与回归的区别

分类和回归都有预测的功能,但是:

分类预测的输出为离散或标称的属性; 回归预测的输出为连续属性值;

分类与回归的例子:

预测未来某银行客户会流失或不流失,这是分类任务; 预测某商场未来一年的总营业额,这是回归任务。

分类的步骤

分类的过程描述如下:

1)首先将数据集划分为2部分:训练集和测试集。 2) 第一步:对训练集学习,构建分类模型。

回归分析

回归分析可以对预测变量和响应变量之间的 联系建模。

在数据挖掘环境下,预测变量是描述样本的感兴 趣的属性,一般预测变量的值是已知的,响应变 量的值是我们要预测的。当响应变量和所有预测 变量都是连续值时,回归分析是一个好的选择。

朴素贝叶斯分类器算法

朴素贝叶斯分类器是一种基于贝叶斯定理和特征条件独立性假设的概率分类算法。

它在文本分类、垃圾邮件过滤等领域得到广泛应用。

下面是朴素贝叶斯分类器的基本算法步骤:

数据准备:收集并准备带有标记的训练数据集,包括已知类别的样本以及对应的特征向量。

特征提取:从每个样本中提取出特征,这些特征可以是文本中的单词、词频、关键词等信息,也可以是其他类型的特征。

模型训练:根据训练数据集,计算每个类别的先验概率(即每个类别出现的概率)和每个特征在不同类别下的条件概率。

模型构建:根据训练数据计算得到的先验概率和条件概率构建朴素贝叶斯模型。

测试样本分类:对于未知类别的测试样本,通过计算后验概率来确定其属于哪个类别。

后验概率由贝叶斯定理计算得到,选择具有最大后验概率的类别作为测试样本的分类结果。

评估模型性能:将测试样本的分类结果与真实标签进行比较,计算分类器的准确率、精确率、召回率等指标来评估模型的性能。

需要注意的是,朴素贝叶斯分类器基于特征条件独立性假设,即假设每个特征与其他特征相互独立。

这在某些情况下可能不成立,但朴素贝叶斯分类器仍然可以在实践中表现出良好的性能。

同时,对于连续型特征,通常需要进行概率密度函数估计,如高斯分布等。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1.数据库基本表格设计

针对贝叶斯分类器所需数据结构设计以下4个表格

新闻类别表:

包括以下3个字段:ID(int),类别编号(int),类别名称(string)

ID

categorynum

category

1

19005

哲学

上表就记录了一条记录,哲学类的编号为19005。

一条记录代表一个新闻类别。不同记录,新闻类别应该保持不同。只有出现新的新闻类别的时候,这个表格才会增加一条记录。

4.增量学习

这里不讨论增加的样本包含新的标签,或者属于新的新闻类别。

当数据样本增加的时候,可以修正统计参数表中对应的参数,分以下几种情况:

1.新增样本中,类别是C1,同样这个样本中出现的标签编号在样本空间中同类别中也出现过。

首先修改,categorynum是C1的所有行的total++.

然后修改这个样本所属类别的出现的概率,P(C1)对应的number++,更新计算概率probability.

一条记录代表一个标签。不同记录,标签名应该保持不同。只有出现新的标签的时候,这个表格才会增加一条记录。

实际应用中,标签库的规模应该会在百万级别的范围之内。因此,ID可以直接采用数据库里自增长的int字段即可。标签编号根据设计的编号规则采用合适的数据字段,比如用纯数字编号,就可采用int存储。标签名采用string类别字段。

样本标签向量:

X = (10,30,57,98,104,25,1980,996,5668,87)

我们定义A = {10,30,57,98,104,25,1980,996,5668,87}。用~A表示所有标签减去A中的剩下的标签集合。

我们计算这个样本属于C1这个类别的概率P0。

P0=logP(C1) + +

统计指定类别中某个标签出现的概率:在样本数据表中,这个类别出现的次数Nc在上面已经统计出来了。只需要统计指定标签出现的次数,根据样本数据表的第3列和第4列统计出指定类别指定标签出现的次数Nc,i。最后概率就是(Nc,i+ 1)/(Nc+ 2)。

3.测试过程

针对每一个测试样本,利用贝叶斯定理计算出这个样本属于类别库里每一个类别的概率值,最后找到最大的那个,就是该样本所属的类别。

5.新增标签

标签新增加一个,那么在标签库表中增加一条记录。

增加含有这个标签的样本放到样本数据表里。

根据新增加的样本类别,按照增量学习中第2种情况计算。

6.新增类别

新闻类别增加一个,那么新闻类别表增加一条记录。

增加这类新闻的训练样本到样本数据表里。

统计参数表中:

1.由于类别增加,更新所有的类出现概率值。样本总数更新,类别总数更新。因此,其它类的出现概率要更新。

如果标签编号为-1.那么这行数据就代表样本空间中,这个类别出现的概率。number就是这个类别出现的次数,total就是总样本数量。

probability= (number + 1)/(total + N)。N代表样本空间中样本类别的种数。即新闻类别表的记录条数。

2.训练过程

标签编号表和类别编号表的存储略过。

1

19

19005

0.0103

30

3000

2

-1

19005

0.05996

3000

50000

如果标签编号不是负数。这条记录表示标签编号为19的这个标签,在类别编号为19005的这个类别中出现的概率为probability。number是标签在这个类别里出现的次数,total就是类别出现的次数。

probability= (number + 1)/(total + 2)(1,2是拉普拉斯修正数)

实际应用中,新闻类别总数数量级应该是很小的(100这个级别)。因此,ID可以直接采用数据库里自增长的int字段即可。类别编号和类别名称可以采用国家标准,采用对应的字段类型。

标签库表:

包括以下3个字段:ID(int),标签编号(int),标签名(string)

ID

labelnum

label

1

19

蜜蜂

蜜蜂这个标签的编号为19

其中P(C1)是类别C1在样本空间中的出现概率。这个值在统计参数表里一定存在的。

是在样本空间中类别C1中标签编号是a出现的概率。这些值在统计参数表如果存在就取出来直接用,如果这个值没有出现,说明样本中,C1类的样本标签编号是a的都没有出现,因此出现的概率就是1– (Nc+ 1)/(Nc+ 2)。

是在样本空间中类别C1中标签编号是a不出现的概率。这些值在统计参数表如果存在,存储的是出现的概率,1-取出来的值就就不出现的概率。如果这个值没有出现,说明样本中,C1类的样本标签编号是a的都没有出现,因此出概率就是(Nc+ 1)/(Nc+ 2)。

2.针对这个新出现的类别,统计样本中这类样本出现的所有标签的概率。以新纪录添加到统计数据表中。

在统计指定类别中,某个标签出现的次数时,就可以根据第三列和第四列统计出来对应的次数。

Hale Waihona Puke 统计参数表:包括以下6个字段:

ID(int),标签编号(int),类别编号(int),概率(float),个数(int),总个数(int)

ID

labelnum

categorynum

probability

number

total

19005

9

1

1230

19005

10

1

679

19005

如果一个样本提取10个关键词,那么表示这一个样本,就需要10条记录,例如上表。其中,样本号和类别编号一样,表示这个样本属于哪一种类,只是这10个关键词的标签编号不同。第一条记录的含义就是,在19005类别中,标签编号为2的标签出现了一次。

如果每一个文本都提取10个关键词,那么在样本库里统计每一个类别的个数时,就统计第四列出现了多少次这个类别编号,然后除以10,就是这个类别出现的次数。考虑到后面可能每一个文本提取的关键词个数发生改变了,那么上述方法就不行了。因此设计记录样本编号。这样统计某个类别出现的次数时,就可以再加上第二列排重即可。

样本数据表:

包括以下4个字段:ID(int),样本号(int),标签编号(int),类别编号(string)

ID

sampleId

labelnum

categorynum

1

1

2

19005

2

1

7

19005

3

1

19

19005

4

1

25

19005

5

1

30

19005

6

1

100

19005

7

1

350

19005

8

1

3790-

样本存储过程:

根据提取每个样本的10个标签,找到这10个标签对应的标签编号,以及这个样本所属类别的编号。把这10条数据存储到样本数据表中。注意,这10个数据的样本编号都一样。

训练过程:

贝叶斯分类器的训练过程,就是在样本中,统计各个种类出现的概率以及标签在类别中出现的概率。

统计类别出现的概率:首先统计出样本所有的类别个数Nk在样本数据表中,统计出样本个数N,找到对应类别以及样本编号不一样的个数,即是这个类别出现的次数Nc。最后概率就是(Nc+1)/(N+Nk).

最后更新这个样本中出现的标签编号对应记录中的number++,更新计算概率probability。

2.新增样本中,类别是C1,但是这个样本里出现了以前C1类中从未出现过的标签编号。

重复上一种情况的操作。

针对这个类里新出现的标签编号。新加一条记录。Number= 1.Total是这个类别出现的总次数。更新计算概率。