Hadoop2.0介绍

Hadoop概述和2.0生态组件简介

Hadoop概述及生态组件简介Hadoop是Apache软件基金会的顶级开源项目,是一套靠得住的,可扩展的,支持散布式计算的开源软件,由原雅虎公司Doug Cutting依照Google 发布的学术论文(Google File System、MapReduce、BigTable)而创建的开源项目。

Doug Cutting被称为Hadoop之父。

而Hadoop是一个虚构的名字,Doug Cutting说明Hadoop的得名:“那个名字是我小孩给一个棕黄色的大象玩具命名的。

我的命名标准确实是简短、容易发音和拼写,没有太多的意义,而且可不能被用于别处,小小孩恰正是这方面的高手”。

因此Hadoop 的logo确实是一只奔跑的棕黄色小象。

Hadoop是一个基础框架,许诺用简单的编程模型在运算机集群对大型数据集进行散布式处置。

它的设计规模从单一效劳器到数千台机械,每一个都提供本地计算和存储,框架本身提供运算机集群高可用的效劳而不是依托硬件来提供高可用性。

用户能够在不了解散布式底层细节的情形下,轻松地在Hadoop上开发和运行处置海量数据的应用程序,低本钱、高靠得住、高扩展、高有效、高容错等特性让Hadoop成为最流行的大数据分析系统。

Hadoop的特点Hadoop是一个能够对大量数据进行散布式处置的软件框架,它是以一种靠得住、高效、可伸缩的方式进行数据处置。

高靠得住性:Hadoop按位存储和处置数据的能力值得人们信任。

高扩展性:Hadoop是在可用的运算机集群间分派数据并完成计算任务的,这些集群能够方便地扩展到数以千计的节点中。

高效性:Hadoop能够在节点之间动态地移动数据,并保证各个节点的动态平稳,因此处置速度超级快。

高容错性:Hadoop能够自动保留数据的多个副本,而且能够自动将失败的任务从头分派。

低本钱:Hadoop 依托于社区效劳,它的本钱比较低。

Hadoop版本演进当前Hadoop已进展到第二代版本,最新稳固版本是。

Hadoop - 介绍

Clint

NameNode

Second NameNode

Namespace backup

Heartbeats,balancing,replication etc

DataNode

Data serving

DataNode

DataNode

DataNode

DataNode

Google 云计算

MapReduce BigTable Chubby

GFS

Hadoop可以做什么?

案例1:我想知道过去100年中每年的最高温 度分别是多少?

这是一个非常典型的代表,该问题里边包含了大量的信息数据。

针对于气象数据来说,全球会有非常多的数据采集点,每个采 集点在24小时中会以不同的频率进行采样,并且以每年持续365 天这样的过程,一直要收集 100年的数据信息。然后在这 100年 的所有数据中,抽取出每年最高的温度值,最终生成结果。该 过程会伴随着大量的数据分析工作,并且会有大量的半结构化 数据作为基础研究对象。如果使用高配大型主机( Unix环境) 计算,完成时间是以几十分钟或小时为单位的数量级,而通过 Hadoop完成,在合理的节点和架构下,只需要“秒”级。

HIVE

ODBC Command Line JDBC Thrift Server Metastore Driver (Compiler,Optimizer,Executor ) Hive 包括

元数据存储(Metastore) 驱动(Driver)

查询编译器(Query Compiler)

1. HDFS(Hadoop分布式文件系统)

HDFS:源自于Google的GFS论文,发表于2003年10月, HDFS是GFS克隆版。是Hadoop体系中数据存储管理的 基础。它是一个高度容错的系统,能检测和应对硬件 故障,用于在低成本的通用硬件上运行。HDFS简化 了文件的一致性模型,通过流式数据访问,提供高吞 吐量应用程序数据访问功能,适合带有大型数据集的 应用程序。 Client:切分文件;访问HDFS;与NameNode交互, 获取文件位置信息;与DataNode交互,读取和写入数 据。 NameNode:Master节点,在hadoop1.X中只有一个, 管理HDFS的名称空间和数据块映射信息,配置副本 策略,处理客户端请求。 DataNode:Slave节点,存储实际的数据,汇报存储信 息给NameNode。 Secondary NameNode:辅助NameNode,分担其工作 量;定期合并fsimage和fsedits,推送给NameNode;紧 急情况下,可辅助恢复NameNode,但Secondary NameNode并非NameNode的热备。

hadoop2.0安装

Hadoop2.0配置SSH安装在线安装ssh #sudo apt-get install openssh-serveropenssh-client手工安装ssh存储ssh密码#ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa#cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys#sudo chmod go-w $HOME $HOME/.ssh#sudo chmod 600 $HOME/.ssh/authorized_keys#sudo chown `whoami` $HOME/.ssh/authorized_keys测试连接本地服务,无密码登陆,则说明ssh服务安装配置正确#ssh localhost#exit安装JDK安装必须1.6或者1.6以上版本。

#sudo mkdir /usr/java#cd /usr/java#sudo wget/otn-pub/java/jdk/6u31-b04/jdk-6u31-linux-i586.bin #sudo chmod o+w jdk-6u31-linux-i586.bin#sudo chmod +x jdk-6u31-linux-i586.bin#sudo ./jdk-6u31-linux-i586.bin修改环境变量/etc/profile文件中增加如下代码export JA V A_HOME=/usr/java/jdk1.6.0_24export PATH=$PATH:/usr/java/jdk1.6.0_24/binexport CLASSPA TH=/usr/java/jdk1.6.0_24/lib/dt.jar:/usr/java/jdk1.6.0_24/lib/tools.jar#source /etc/profile测试# java -version显示java版本,则证明安装配置正确安装hadoop选择一个linux系统,下载并解压hadoop2.0.x并解压到/home/hadoop-2.0.0-alpha。

yarn资源管理机制

yarn资源管理机制

YARN(Yet Another Resource Negotiator)是Hadoop 2.0中引入的集群资源管理系统。

它负责为运算程序提供服务器运算资源,相当于一个分布式的操作系统平台,而MapReduce等运算程序则相当于运行于操作系统之上的应用程序。

YARN资源管理机制的特点包括:

1.抽象资源:YARN会对集群中各类资源进行抽象,然后根据各种应

用程序或服务的要求,按照一定的调度策略将资源分配给它们使用。

2.隔离机制:资源管理采用一定的隔离机制防止应用程序或服务之

间因为抢占资源而互相干扰。

3.三种调度器:YARN自身自带了三种调度器,包括FIFO Scheduler、

Capacity Scheduler(Yahoo!)和Fair Scheduler(Facebook)。

4.统一资源管理:用户可以将各种服务框架部署在YARN上,由YARN

进行统一地管理和资源分配。

以上是YARN资源管理机制的一些重要特点,但请注意,YARN的使用和配置可能会随着版本更新和具体应用场景的变化而有所不同。

Hadoop2.0系统中的资源分配与动态监控实践

201数据库技术Database Technology电子技术与软件工程Electronic Technology & Software Engineering1 引言信息化社会中的信息爆炸引发了数据量的大幅增长。

传统数据处理器已经很难快速高效地在经济实用的条件下完成数据实时运算。

服务器联同协作成为大规模数据处理的发展方向。

在此背景之下,大数据运算平台应运而生,其中以Apache 基金会旗下的Hadoop 项目最为知名。

得益于其开源特性,Hadoop 被许多大学、研究所与商业公司广泛采用,在大数据领域已经成为广为接受的基准平台。

与此同时,为了方便使用者更简便快捷的在Hadoop 平台上实现分布式运算,许多分布式运算框架被研发与发行,其中Spark 以其突出的基于内存存取的高性能运算,自推出之时,便成为了学术界与工业界重要的关注与应用对象。

然而,大规模数据集所带来的问题并不止于数据量的大幅增长,数据结构的复杂性与差异性导致各个数据之间运算量差异亦十分明显。

直接的结果就是导致了Spark 工作集的多样化。

不同种类的Spark 工作,其生存周期与资源消耗各不相同。

当大量多种类Spark 工作同时出现在同一个Hadoop 平台上时,运算资源的不当分配极易导致大量微型工作被阻塞,等待资源,直至超时。

当数据量极大,例如运算峰值阶段的平台资源紧张时期,各个Spark 工作会因为资源争抢,导致相互阻塞,数据运算因为各个Spark 工作均无法取得足够资源而停顿,致使整个Hadoop 平台产生系统死锁,工作流停顿。

问题产生的根源是Spark 工作多样性与单一的资源分配规则之间的矛盾。

故而,在Hadoop 平台搭配Spark 框架支持大规模数据运算的实践中,Spark 工作集应该被系统化分类,采用不同的分配原则,避免数据流高峰时刻因资源争抢而导致的相互阻塞。

此外,Hadoop 平台资源高利用率阶段出现性能下降是正常的反应,与工作流完全阻塞相比,两者在短时间内会呈现相同现象,而长时间的人工观测在此情境下并不经济可取。

HADOOP 1.0与2.0区别

HADOOP2.0较1.0版本的进步1.1从Hadoop整体框架来说,Hadoop1.0即第一代Hadoop,由分布式存储系统HDFS和分布式计算框架MapReduce组成,其中HDFS由一个NameNode和多个DateNode组成,MapReduce由一个JobTracker 和多个TaskTracker组成。

Hadoop2.0即第二代Hadoop为克服Hadoop1.0中的不足:针对Hadoop1.0单NameNode制约HDFS的扩展性问题,提出HDFS Federation,它让多个NameNode分管不同的目录进而实现访问隔离和横向扩展,同时彻底解决了NameNode单点故障问题,单点故障是通过主备NameNode切换实现的,这是一种古老的解决服务单点故障的方案,主备NameNode之间通过一个共享存储同步元数据信息,因此共享存储系统的选择称为关键而Hadoop则提供了NFS、QJM和Bookeeper三种可选的共享存储系统,HDFS Federation实现的,它允许一个HDFS集群中存在多个NameNode,每个NameNode分管一部分目录,而不同NameNode之间彼此独立,共享所有DataNode的存储资源,注意,NameNode Federation中的每个NameNode仍存在单点问题,需为每个NameNode提供一个backup以解决单点故障问题;针对Hadoop1.0中的MapReduce在扩展性和多框架支持等方面的不足,它将JobTracker中的资源管理和作业控制分开,分别由ResourceManager(负责所有应用程序的资源分配)和ApplicationMaster(负责管理一个应用程序)实现,即引入了资源管理框架Yarn。

1.2从MapReduce计算框架来讲MapReduce1.0计算框架主要由三部分组成:编程模型、数据处理引擎和运行时环境。

它的基本编程模型是将问题抽象成Map和Reduce两个阶段,其中Map阶段将输入的数据解析成key/value,迭代调用map()函数处理后,再以key/value 的形式输出到本地目录,Reduce阶段将key相同的value进行规约处理,并将最终结果写到HDFS上;它的数据处理引擎由MapTask和ReduceTask组成,分别负责Map阶段逻辑和Reduce阶段的逻辑处理;它的运行时环境由一个JobTracker和若干个TaskTracker两类服务组成,其中JobTracker负责资源管理和所有作业的控制,TaskTracker负责接收来自JobTracker的命令并执行它。

大数据处理之 Hadoop 原理与应用介绍

Input

Input Data:

A DD BB A BB A

Map Task Map

Map

0,A 1,DD

A,1 DD,1

Reduce Task

Shuffle & Sort

Reduce

map, sort, combiner, partition, spill, merge

copy partition data A,[1, 1, 1]

1、问题:

有如下数据,字段内容分别为:url,catePath0,catePath1,catePath2,unitparams

https:///confluence 0 1 8 {"store":{"fruit":[{"weight":1,"type":"apple"},{"weight":9,"type":"pear"}],"bicycle":{"price":19.951,"color":"red1"}},"email":" amy@only_for_json_udf_","owner":"amy1"} /leejun2005/blog/83058 0 1 23 {"store":{"fruit":[{"weight":1,"type":"apple"},{"weight":2,"type":"pear"}],"bicycle":{"price":19.951,"color":"red1"}},"email":"

Hadoop与Spark简介 课件

JobTracker

JobTracker负责资源监控和作业调度 JobTracker 监控所有TaskTracker与Job的状况,

一旦失败,就将任务转移到其他节点 JobTracker 跟踪任务执行进度、资源使用量等,

CONTENTS

03 HDFS简介 Introduction of HDFS

04 Spark概述 Overview of Spark

2 MapReduce简介

2.1 分布式并行编程

摩尔定律

CPU性能大约每隔18个月翻一番 从2005年开始摩尔定律逐渐失效 ,需要处理的数据量快速增加,人们开始借助于分布式

Kafka Spark

一种高吞吐量的分布式发布订阅消息系 统,可以处理消费者规模的网站中的所

有动作流数据

类似于Hadoop MapReduce的通用并 行框架

01 Hadoop概述 Overview of Hadoop

Hadoop与Spark简介

02 MapReduce简介 Introduction of MapReduce

多个溢写文件归并成一个或多个大文件,文件 中的键值对是排序的

当数据很少时,不需要溢写到磁盘,直接在缓 存中归并,然后输出给Reduce

2 MapReduce简介

2.4 实例1 -- WordCount

算法思想

程序 输入

输出

WordCount

一个包含大量单词的文本文件

文件中每个单词及其出现次数(频数 ),并按照单词字母顺序排序,每个 单词和其频数占一行,单词和频数之

周期性地通过“心跳”将本节点上资源的使用情 况和任务进度汇报给JobTracker,同时接收 JobTracker 命令并执行相应操作

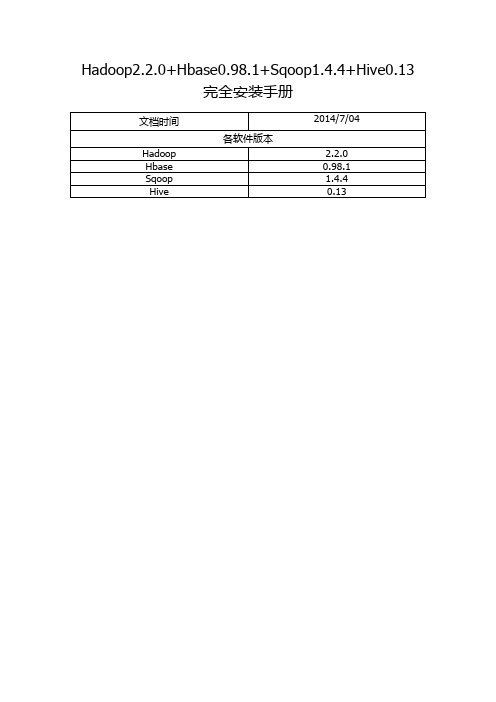

Hadoop2.2.0+Hbase0.98.1+Sqoop1.4.4+Hive0.13完全安装手册

Hadoop2.2.0+Hbase0.98.1+Sqoop1.4.4+Hive0.13完全安装手册前言: (3)一. Hadoop安装(伪分布式) (4)1. 操作系统 (4)2. 安装JDK (4)1> 下载并解压JDK (4)2> 配置环境变量 (4)3> 检测JDK环境 (5)3. 安装SSH (5)1> 检验ssh是否已经安装 (5)2> 安装ssh (5)3> 配置ssh免密码登录 (5)4. 安装Hadoop (6)1> 下载并解压 (6)2> 配置环境变量 (6)3> 配置Hadoop (6)4> 启动并验证 (8)前言:网络上充斥着大量Hadoop1的教程,版本老旧,Hadoop2的中文资料相对较少,本教程的宗旨在于从Hadoop2出发,结合作者在实际工作中的经验,提供一套最新版本的Hadoop2相关教程。

为什么是Hadoop2.2.0,而不是Hadoop2.4.0本文写作时,Hadoop的最新版本已经是2.4.0,但是最新版本的Hbase0.98.1仅支持到Hadoop2.2.0,且Hadoop2.2.0已经相对稳定,所以我们依然采用2.2.0版本。

一. Hadoop安装(伪分布式)1. 操作系统Hadoop一定要运行在Linux系统环境下,网上有windows下模拟linux环境部署的教程,放弃这个吧,莫名其妙的问题多如牛毛。

2. 安装JDK1> 下载并解压JDK我的目录为:/home/apple/jdk1.82> 配置环境变量打开/etc/profile,添加以下内容:export JAVA_HOME=/home/apple/jdk1.8export PATH=$PATH:$JAVA_HOME/binexport CLASSPATH=.:$JAVA_HOME/lib/tools.jar:$JAVA_HOME/lib/dt.jar执行source /etc/profile ,使更改后的profile生效。

海量数据处理技术——Hadoop介绍

海量数据处理技术——Hadoop介绍如今,在数字化时代,数据已经成为企业和组织中最重要的资产之一,因为巨大量的数据给企业和组织带来了更多的挑战,比如如何存储、管理和分析数据。

随着数据越来越庞大,传统方法已经无法胜任。

这正是Hadoop出现的原因——Hadoop是一个开源的、可扩展的海量数据处理工具。

本文将介绍什么是Hadoop、它的架构和基本概念、以及使用的应用场景。

一、什么是HadoopHadoop是一种基于Java的开源框架,它可以将大量数据分布式分割存储在许多不同的服务器中,并能够对这些数据进行处理。

Hadoop最初是由Apache软件基金会开发的,旨在解决海量数据存储和处理的难题。

Hadoop采用了一种分布式存储和处理模式,能够高效地处理PB级别甚至EB级别的数据,使得企业和组织能够在这些大量数据中更快地发现价值,并利用它带来的价值。

二、 Hadoop架构和基本概念Hadoop架构由两个核心组成部分构成:分布式文件系统Hadoop Distributed File System(HDFS)和MapReduce的执行框架。

1. HDFSHDFS以可扩展性为前提,其存储处理是在上面构建的,它在集群内将数据分成块(Block),每个块的大小通常为64MB或128MB,然后将这些块存储在相应的数据节点上。

HDFS架构包含两类节点:一个是namenode,另一个是datanode。

namenode是文件系统的管理节点,负责存储所有文件和块的元数据,这些元数据不包括实际数据本身。

datanode是存储节点,负责存储实际的数据块,并向namenode报告其状态。

2. MapReduceMapReduce是一个处理数据的编程模型,它基于两个核心操作:map和reduce。

Map负责将输入数据划分为一些独立的小片段,再把每个小片段映射为一个元组作为输出。

Reduce将Map输出的元组进行合并和过滤,生成最终输出。

hadoop介绍讲解

hadoop介绍讲解Hadoop是一个由Apache软件基金会开发的开源分布式系统。

它的目标是处理大规模数据集。

Hadoop可以更好地利用一组连接的计算机和硬件来存储和处理海量数据集。

Hadoop主要由Hadoop分布式文件系统(HDFS)和MapReduce两部分组成。

以下是hadoop的详细介绍。

1. Hadoop分布式文件系统(HDFS)HDFS是Hadoop的分布式文件系统。

HDFS将大量数据分成小块并在多个机器上进行存储,从而使数据更容易地管理和处理。

HDFS适合在大规模集群上存储和处理数据。

它被设计为高可靠性,高可用性,并且容错性强。

2. MapReduceMapReduce是Hadoop中的计算框架。

它分为两个阶段:Map和Reduce。

Map阶段将数据分为不同的片段,并将这些片段映射到不同的机器上进行并行处理,Reduce阶段将结果从Map阶段中得到,并将其组合在一起生成最终的结果。

MapReduce框架根据数据的并行处理进行拆分,而输出结果则由Reduce阶段组装而成。

3. Hadoop生态系统Hadoop是一个开放的生态系统,其包含了许多与其相关的项目。

这些项目包括Hive,Pig,Spark等等。

Hive是一个SQL on Hadoop工具,用于将SQL语句转换为MapReduce作业。

Pig是另一个SQL on Hadoop工具,它是一个基于Pig Latin脚本语言的高级并行运算系统,可以用于处理大量数据。

Spark是一个快速通用的大数据处理引擎,它减少了MapReduce 的延迟并提供了更高的数据处理效率。

4. Hadoop的优点Hadoop是一个灵活的、可扩展的与成本优势的平台,它可以高效地处理大规模的数据集。

同时,它的开放式和Modular的体系结构使得其在大数据环境下无论是对数据的处理还是与其他开发者的协作都非常便利。

5. 总结Hadoop是一个很好的大数据处理工具,并且在行业中得到了广泛的应用。

第2章-Hadoop初体验

6、Pig Pig是一种数据流语言和运行环境,用于检索非常大的数据集。 Pig为大型数据集的处理提供了一个更高层次的抽象。与 MapReduce相比,Pig提供了更丰富的数据结构,还提供了一 套更强大的数据变换操作。Pig Latin语言的编译器会把类SQL 的数据分析请求转换为一系列经过优化处理的MapReduce运算。 Pig为复杂的海量数据并行计算提供了一个简单的操作和编程的 接口。

9、Sqoop Sqoop是Apache 旗下一款适用于Hadoop和关系型数据库服务 器之间传送数据的开源工具。通过Sqoop,可以方便地将数据 从MySQL,Oracle等关系数据库中导入到Hadoop的 HDFS、 Hive、HBase 等数据存储系统,也可以将数据从Hadoop的文 件系统中导出到mysql等关系数据库中,使得Hadoop和传统关 系数据库之间的数据迁移变得非常方便。

来增加其存储能力。

5、Hive(数据仓库) Hive是基于Hadoop的一个数据仓库工具,并提供简单的类 SQL的HiveQL 语言实现查询功能,可以将类SQL语句转换为 MapReduce任务进行运行。 其优点是学习成本低,可以通过 类SQL语句快速实现简单的MapReduce统计,不必开发专门的 MapReduce应用,减少开发人员的学习成本,主要适ut Mahout 是 Apache软件基金会旗下的一个开源项目,是 Hadoop系统基于MapReduce开发的数据挖掘/机器学习库,提 供一些可扩展的数据挖掘/机器学习领域经典算法的实现,旨在 帮助开发人员更加方便快捷地创建智能应用程序。Mahout实现 了大部分常用的数据挖掘算法,包括聚类、分类、推荐、频繁

3、 Hadoop优势 (3)高效性。 Hadoop以并行的方式工作,通过大规模的并行处理来加快 数据的处理速度,并保证各个节点的动态平衡,因此保证 了集群的整体处理速度。

描述hdfs ha架构组成组件及具体功能

描述hdfs ha架构组成组件及具体功能HDFS HA架构组成HDFS是Hadoop分布式文件系统的简称,它是一个可扩展的、高可靠性的分布式文件系统。

在Hadoop 2.0版本中,引入了HDFS HA (High Availability)架构,使得HDFS具备了更高的可用性和容错性。

HDFS HA架构由以下几个组成部分:1. NameNode:NameNode是整个集群中最重要的节点之一,它负责管理整个文件系统的命名空间和数据块映射信息。

在HA架构中,NameNode被划分为两个部分:Active NameNode和Standby NameNode。

2. JournalNodes:JournalNodes是一个独立于NameNode之外的组件,它负责存储NameNode操作日志。

JournalNodes可以采用共享存储或者网络共享存储来实现数据持久化。

3. ZooKeeper:ZooKeeper是一个开源的分布式协作服务框架,在HA架构中用于协调Active NameNode和Standby NameNode之间的状态转移。

4. DataNodes:DataNodes是集群中具体存储数据块的节点。

在HA 架构中,DataNodes不需要做任何改变。

具体功能1. Active NameNodeActive NameNode是整个集群中唯一一个处于活动状态的NameNode。

它负责处理客户端请求、管理元数据、以及控制数据块的读写。

Active NameNode会将元数据和操作日志发送到JournalNodes进行持久化,以保证在发生故障时可以快速恢复。

2. Standby NameNodeStandby NameNode是一个处于备用状态的NameNode,它与Active NameNode保持同步。

Standby NameNode通过ZooKeeper来监测Active NameNode的状态,如果Active NameNode出现故障,则Standby NameNode会立即接管Active NameNode的工作,并成为新的Active NameNode。

云计算课堂讨论题

2018.5。

171、如何理解分布式系统中的CAP定理?(一致性、可用性、分区容错性)CAP原则又称CAP定理,指的是在一个分布式系统中,Consistency(一致性)、Availability (可用性)、Partition tolerance(分区容错性),三者不可得兼。

一致性(C):在分布式系统中的所有数据备份,在同一时刻是否同样的值。

(等同于所有节点访问同一份最新的数据副本),换句话就是说,任何时刻,所用的应用程序都能访问得到相同的数据.可用性(A):在集群中一部分节点故障后,集群整体是否还能响应客户端的读写请求。

(对数据更新具备高可用性),换句话就是说,任何时候,任何应用程序都可以读写数据。

分区容错性(P):以实际效果而言,分区相当于对通信的时限要求。

系统如果不能在时限内达成数据一致性,就意味着发生了分区的情况,必须就当前操作在C和A之间做出选择,换句话说,系统可以跨网络分区线性的伸缩和扩展。

2、云计算平台(系统)的核心技术是虚拟化技术、服务计算(功能服务化、按需服务、按需收费)、分布式技术(分布式存储、分布式计算一分而治之)。

如何理解?虚拟化是云计算最重要的核心技术之一,它为云计算服务提供基础架构层面的支撑,是ICT 服务快速走向云计算的最主要驱动力.从技术上讲,虚拟化是一种在软件中仿真计算机硬件,以虚拟资源为用户提供服务的计算形式。

旨在合理调配计算机资源,使其更高效地提供服务。

它把应用系统各硬件间的物理划分打破,从而实现架构的动态化,实现物理资源的集中管理和使用。

虚拟化的最大好处是增强系统的弹性和灵活性,降低成本、改进服务、提高资源利用效率。

服务计算(Service Computing)泛指以服务及其组合为基础构造应用这一新开发范型相关的方法、技术、规范、理论和支撑环境分布式网络存储系统采用可扩展的系统结构,利用多台存储服务器分担存储负荷,利用位置服务器定位存储信息,它不但提高了系统的可靠性、可用性和存取效率,还易于扩展。

第6章 Hadoop2.0新特性

☞点击查看本节相关知识点

✎ 章节概要

在第1章介绍Hadoop版本时,介绍过在Hadoop最初诞生时,在 架构设计和应用性能方面存在很多不尽人意的地方,在后续发展过程中 逐渐得到了改进和完善。相比Hadoop1.0版本,Hadoop2.0的优化改 良主要体现在两个方面:一方面是Hadoop自身核心组件架构设计的改 进,另一方面是Hadoop集群性能的改进,通过这些优化和提升, Hadoop可以支持更多的应用场景,提高资源利用率。

第6章 Hadoop2.0新特性

· Hadoop2.0改进与提升 · HDFS的高可用 · Yarn资源管理框架

✎ ✎ 学习目标

1 了解YARN的体系结

构和工作流程

理解HDFS的高可用 2

架构

掌握

掌握Hadoop HA集群

的搭建方式

3

✎ 目录

Hadoop2.0改进与提升

YARN资源管理框架

☞点击查看本节相关知识点

✎ 6.3 HDFS的高可用

启动测试Hadoop高可用集群

3. 配置Hadoop高可用集群

修改core-site.xml文件,配置HDFS端口、指定Hadoop的临时目录和

1 Zookeeper集群地址。

修改hdfs-site.xml文件,配置NameNode端口和通信方式,并指定元

2 数据存放位置及开启失败自动切换服务,配置隔离机制方法。

✎ 6.2 YARN资源管理框架

YARN体系结构

体系结构图

✎ 6.2 YARN资源管理框架

YARN体系结构

1 . ResourceManager

ResourceManager是一个全局的资源管理系统,它负责的是整个Yarn 集群资源的监控、分配和管理工作。

Hadoop大数据技术基础与应用 教案

第1章Hadoop技术概述1.Hadoop2.0包含哪些核心组件?MapReduce、HDFS、YARN2.Hadoop包含哪些优势?方便、弹性、健壮、简单3.Hadoop有哪些应用领域?运营商、电子商务、在线旅游、欺诈检测、医疗保健、能源开采、金融、直播、在线教育等等4.Hadoop有几种运行模式?单机模式、伪分布模式、完全分布式模式5.Hadoop伪分布集群包含哪些守护进程?DataNode、NodeManager、ResourceManager、SecondaryNameNode、NameNode 第2章Hadoop分布式文件系统(HDFS)1.简述HDFS的设计理念?HDFS的设计理念来源于非常朴素的思想:即当数据文件的大小超过单台计算机的存储能力时,就有必要将数据文件切分并存储到由若干台计算机组成的集群中,这些计算机通过网络进行连接,而HDFS 作为一个抽象层架构在集群网络之上,对外提供统一的文件管理功能,对于用户来说就感觉像在操作一台计算机一样,根本感受不到HDFS 底层的多台计算机,而且HDFS还能够很好地容忍节点故障且不丢失任何数据。

2.简述FSImage和Edit Log的合并过程?FSImage和EditLog合并的详细步骤如下所示。

(1)SecondaryNameNode(即从元数据节点)引导NameNode(即元数据节点)滚动更新EditLog,并开始将新的EditLog写进edits.new。

(2)SecondaryNameNode将NameNode的FSImage(fsimage)和EditLog(edits)复制到本地的检查点目录。

(3)SecondaryNameNode将FSImage(fsimage)导入内存,并回放EditLog(edits),将其合并到FSImage(fsimage.ckpt),并将新的FSImage(fsimage.ckpt)压缩后写入磁盘。

《Hadoop系统搭建及项目实践》课后习题答案

项目1 Hadoop基础知识1.Hadoop是由哪个项目发展来的?答:2002年,开源组织Apache成立开源搜索引擎项目Nutch,但在Nutch开发过程中,始终无法有效地将计算任务分配到多台计算机上。

2004年前后,Google陆续发表三大论文GFS、MapReduce和BigTable。

于是Apache在其Nutch里借鉴了GFS和MapReduce思想,实现了Nutch版的NDFS和MapReduce。

但Nutch项目侧重搜索,而NDFS和MapReduce则更像是分布式基础架构,因此,2006年,开发人员将NDFS和MapReduce移出Nutch,形成独立项目,称为Hadoop。

2.Hadoop主要有哪些版本?答:目前Hadoop的发行版除了Apache的开源版本之外,还有华为发行版、Intel发行版、Cloudera发行版(CDH)、Hortonworks发行版(HDP)、MapR等,所有这些发行版均是基于Apache Hadoop衍生出来的。

Apache Hadoop版本分为两代,第一代Hadoop称为Hadoop 1.0,第二代Hadoop称为Hadoop 2.0。

第一代Hadoop包含三个大版本,分别是0.20.x,0.21.x和0.22.x,其中,0.20.x 最后演化成1.0.x,变成了稳定版,而0.21.x和0.22.x增加了NameNode HA等新的重大特性。

第二代Hadoop包含两个版本,分别是0.23.x和2.x,它们完全不同于Hadoop 1.0,是一套全新的架构,均包含HDFS Federation和YARN两个系统,相比于0.23.x,2.x增加了NameNodeHA和Wire-compatibility两个重大特性。

3.简要描述Hadoop的体系结构,分析1.x与2.x版本间的区别。

答:Hadoop 2.x相比Hadoop 1.x最大的变化是增加了YARN组件,YARN是一个资源管理和任务调度的框架,主要包含三大模块:ResourceManager(RM)、NodeManager(NM)和ApplicationMaster(AM)。

hadoop版本差异详解.docx

Hadoop版本的关键特性调研报高 Apache HadoopApache版本衍化Apache Hadoop版本分为两代,我们将第一代Hadoop称为Hadoop 1.0,第二代Hadoop 称为Hadoop 2.0。

第一代Hadoop包含三个大版本,分别是0.20.x,0.21.x和0.22.x,其中,0.20.x最后演化成1.0.x,变成了稳定版,而0.21.x和0.22.x则NameNode HA 等新的重大特性。

第二代Hadoop包含两个版本,分别是0.23.x和2.x,它们完全不同于Hadoop 1.0,是一套全新的架构,均包含HDFS Federation和YARN两个系统,相比于0.23.x,2.x增加了NameNode HA和Wire-compatibility两个重大特性。

经过上面的大体解释,大家可能明白了Hadoop以重大特性区分各个版本的,总结起来,用于区分Hadoop版本的特性有以下几个:(1)Append 支持文件追加功能,如果想使用HBase,需要这个特性。

(2)RAID 在保证数据可靠的前提下,通过引入校验码较少数据块数目.(3)Symlink支持HDFS文件(4)Security Hadoop安全。

需要注意的是,Hadoop 2.0主要由Yahoo独立出来的hortonworks公司主持开发。

2013年10月,Hadoop 2.0发布。

关键特性包括:a)YARNYARN是“Yet Another Resource Negotiator”的简称,它是Hadoop 2.0引入的一个全新的通用资源管理系统,可在其之上运行各种应用程序和框架,比如MapReduce、Tez、Storm等,它的引入使得各种应用运行在一个集群中成为可能。

YARN是在MRv1基础上衍化而来的,是MapReduce发展到一定程度的必然产物,它的出现使得Hadoop计算类应用进入平台化时代,我的博客中包含大量介绍YARN的文章,有兴趣的读者可阅读:/category/mapreduce-nextgen/b)HDFS单点故障得以解决Hadoop 2.2.0同时解决了NameNode单点故障问题和存受限问题,其中,单点故障是通过主备NameNode切换实现的,这是一种古老的解决服务单点故障的方案,主备NameNode之间通过一个共享存储同步元数据信息,因此共享存储系统的选择称为关键,而Hadoop则提供了NFS、QJM和Bookeeper三种可选的共享存储系统,具体可阅读我的这篇文章:Hadoop 2.0单点故障问题方案总结。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

28. }

Hadoop2.0 新特性: YARN上运行的软件

Applications Run Natively In Hadoop

Batch

InterActive

(MapReduce) (Tez)

OnLine

Streaming

Graph

(HBase) (Storm, S4,…) (Giraph)

IN-Memory HPC MPI (Spark) (OpenMPI)

Hadoop2.0 新特性: YARN-架构及组件

• ResourceManager

– 处理客户端请求

YARN 是Hadoop 2.0 中的资源管理系统, 它是一个通用的资源管理模块,可为各 类应用程序进行资源管理和调度。

– 启动/监控ApplicationMaster

– 监控NodeManager

Next-Gen DataProccess Platform-Hadoop2.0介绍

Single Use System

Batch Apps

Hadoop 1.0

MapReduce(v1)

(cluster resource management & data processing)

HDFS

(redundant, reliable storage)

所有的元数据信息的读取和操作都需要与NameNode进行 通信,如客户端的addBlock、getBlockLocations,DataNode的 blockRecieved、blockReport等操作,在集群规模变大后, NameNode 会成为性能瓶颈

Hadoop2.0 新特性: NameNode Federation

• 扩展性

– 集群最大节点数–4000

当 map-reduce job 非常多的时候,会造成很大的 内存开销,潜在来说,也增加了 JobTracker fail 的风险,这也是业界普遍总结出老 Hadoop 的 Map-Reduce 只能支持 4000 节点主机的上限。

– 最大并发任务数–40000

• 可以根据实际需要和CPU性能将每个物理CPU划分成若干个

虚拟CPU。管理员可为每个节点单独配置可用的虚拟CPU个 15. // Priority for worker containers - priorities are intra-application

16. Priority priority = Records.newRecord(Priority.class);

• 防止脑裂(brain-split):主备切换时由于切换不彻底等原因导 致Slave误以为出现两个active master,通常采用Fencing机制:

-共享存储fencing,确保只有一个NN可以写入edits -客户端fencing,确保只有一个NN可以响应客户端的请求 - DN fencing,确保只有一个NN可以向DN下发删除等命令

数,用户程序也可指定每个任务需要的虚拟CPU个数 17. priority.setPriority(0);

18.

Setup requirements for worker containers

19. // Resource requirements for worker containers

• 可为每个节点单独配置可用内存,采用线程监控的方案控 20. Resource capability = Records.newRecord(Resource.class);

Apache Hadoop 2.0

下一代数据处理框架介绍

主要内容

• Hadoop 1.0 的局限性 • Hadoop 2.0 新特性介绍 • Hadoop现状及最新进展

Hadoop1.0的局限- HDFS

※资源隔离 ※元数据扩展性 ※访问效率 ※数据丢失

Hadoop1.0的局限-MapReduce

Hadoop 2.0 Federation实现方式

26.

ContainerRequest containerAsk = new ContainerRequest(capability, null, null,

prio•riMtye);sos等资源管理软件

Make resource requests to ResourceManager

27.

rmClient.addContainerRequest(containerAsk);

Hadoop2.0 新特性: NameNode HA

Hadoop 1.0 HA实现方式及缺陷:

– Secondary NameNode:阶段性合并edits和fsimage以缩短集群启动 时间,不是HA ,无法立刻接管失效的NN及保证数据完整性

– Backup NameNode (HADOOP-4539):它在内存中复制了NN的当 前状态,算是Warm Standby,但无法保证数据完整性

21. capability.setMemory(128);

22. capability.setVirtualCores(1);

23. 24.

制//内Ma存ke 使cont用ain,er 发requ现est任s t务o Re超sou过rce约Mana定ger的资源量会将其杀死

25. for (int i = 0; i < n; ++i) {

– 手动把name.dir指向NFS:这是安全的Cold Standby,可以保证元 数据不丢失,但集群的恢复则完全靠手动

– Facebook AvatarNode:Hot Standby,无法自动切换,需要管理 员手动把对外提供服务的虚拟IP映射到Standby NN

– 其它依赖外部的HA机制,譬如DRBD,Linux HA,VMware的 FT等等

Hadoop2.0 新特性: NameNode HA

Hadoop 2.0 HA实现方式:

Others: QJM:HDFS HA using the Quorum Journal Manager to share edit logs between the Active and Standby NameNodes YARN-MRv2作业处理流程

Hadoop2.0 新特性: YARN-MRv2作业处理流程

步骤1 用户向YARN 中提交应用程序, 其中包括ApplicationMaster 程序、启动ApplicationMaster 的命令、用户程序等。 步骤2 ResourceManager 为该应用程序分配第一个Container, 并与对应的NodeManager 通信,要 求它在这个Container 中启动应用程序的ApplicationMaster。 步骤3 ApplicationMaster 首先向ResourceManager 注册, 这样用户可以直接通过ResourceManage 查看应用程序的运行状态,然后它将为各个任务申请资源,并监控它的运行状态,直到运行结 束,即重复步骤4~7。 步骤4 ApplicationMaster 采用轮询的方式通过RPC 协议向ResourceManager 申请和领取资源。 步骤5 一旦ApplicationMaster 申请到资源后,便与对应的NodeManager 通信,要求它启动任务。 步骤6 NodeManager 为任务设置好运行环境(包括环境变量、JAR 包、二进制程序 等)后,将任务启动命令写到一个脚本中,并通过运行该脚本启动任务。 步骤7 各个任务通过某个RPC 协议向ApplicationMaster 汇报自己的状态和进度,以让 ApplicationMaster 随时掌握各个任务的运行状态,从而可以在任务失败时重新启动任务。在应用 程序运行过程中,用户可随时通过RPC 向ApplicationMaster 查询应用程序的当 前运行状态。 步骤8 应用程序运行完成后,ApplicationMaster 向ResourceManager 注销并关闭自己。

Other (Search) (Weave…)

YARN (Cluster Resource Management)

HDFS2 (Redundant, Reliable Storage)

运行在YARN上带来的好处 :

– 一个集群部署多个版本 – 计算资源按需伸缩 – 不同负载应用混搭,集群利用率高 – 共享底层存储,避免数据跨集群迁移

Hadoop2.0 新特性: YARN-产生背景

• 直接源于MRv1在几个方面的无能

– 扩展性差,JobTracker成为瓶颈 – 可靠性差,NameNode单点故障 – 扩展性差,难以支持MR之外的计算 – 资源利用率低

• 多计算框架各自为战,数据共享困难

– MR:离线计算框架 – Storm:实时计算框架 – Spark:内存计算框架

HDFS2

(redundant, reliable storage)

Hadoop 2.0新特性:

– 由HDFS、MapReduce和YARN三个分支构成 – HDFS:支持NN Federation、HA – MapReduce:运行在YARN上的MR,编程模型不变 – YARN:资源管理系统 –…

Hadoop2.0 新特性: NameNode Federation

Hadoop 1.0版本容量及性能缺陷:

– 单NameNode容量限制: 按常规的估算公式1百万个块需要1G内存,1亿个文件

NameNode进程可能需要上百G内存保存元数据信息,受制于 Java内存管理能力限制,上百G内存保基本上达到上限 – 单NameNode性能限制:

• 可用性

– JobTracker负载较重

– 存在单点故障, 一旦故障,

所有执行的任务的全部失败

• 批处理模式,时效性低

– 仅仅使用MapReduce一种计算方式