视觉里程计原理(一)特征提取(SURF算法)

surf特征提取

surf特征提取Surf(SpeededUpRobustFeatures)特征提取技术是一种广泛应用的机器视觉技术,旨在检测与识别图像中的特征点。

Surf特征提取技术是一种极为有效的特征提取方法,可以从图像中提取大量重要信息。

Surf特征提取技术基于Rotation Invariance Feature Transform(RIFT)技术,它被认为是一种强大的方法,可以克服传统技术(如SIFT)中存在的局限性,如旋转不变性。

Surf特征提取技术可以被认为是一种模型保持技术,它采用两个基础技术:尺度不变性技术(SIFT)和旋转不变性技术。

SIFT和RIFT的基本原理是使用流行的尺度空间理论(Multi-Scale Space Theory)来找到图像中的特征。

在检测到特征之后,它们将用作特征描述符。

简而言之,特征描述符是由一系列特征来描述一幅图像中的某一特定区域。

Surf特征提取技术可以非常有效地检测出图像中的特征点,这些特征点可以用来分析图像中的模式。

它的强大之处在于可以分析出图像中模式的特征,同时忽略其他非结构化的信息。

Surf特征提取技术的一个重要优势是可以同时处理多张图像,从而加快处理速度。

而另一个重要的优势是可以忽略图像中的噪点,这可以有效地检测出图像中的重要特征。

Surf特征提取技术主要应用于计算机视觉领域,如图像匹配和图像识别。

首先,它可以用来检测图像中的特征点,这些特征点可以用来定位图像中的目标内容,例如脸部和轮廓等。

其次,它可以用来检测图像中的不同类型的边缘和聚类,这有助于图像识别系统对图像内容进行识别。

Surf特征提取技术的一个重要的缺点是不能很好地处理运动物体。

当处理运动物体时,Surf特征提取技术不能很好地检测出运动部分的变化,这会导致其结果的偏差。

此外,该技术的可扩展性和可伸缩性也被认为是一个比较大的问题,其计算复杂度也较高,这对于处理大型图像集来说可能是一个问题。

Surf特征提取技术是一种广泛应用的技术,它为计算机视觉领域提供了许多重要的功能。

视觉里程计

视觉里程计来源 | ADAS视觉里程计(Visual Odometry)在机器人学与计算机视觉领域,视觉里程计是一个通过分析相关图像序列,来确定机器人位置和朝向的过程。

在导航系统中,里程计(odometry)是一种利用致动器的移动数据来估算机器人位置随时间改变量的方法。

例如,测量轮子转动的旋转编码器设备。

里程计总是会遇到精度问题,例如轮子的打滑就会导致产生机器人移动的距离与轮子的旋转圈数不一致的问题。

当机器人在不光滑的表面运动时,误差是由多种因素混合产生的。

由于误差随时间的累积,导致了里程计的读数随着时间的增加,而变得越来越不可靠。

视觉里程计是一种利用连续的图像序列来估计机器人移动距离的方法。

视觉里程计增强了机器人在任何表面以任何方式移动时的导航精度。

视觉里程计算法:大多数现有的视觉里程计算法都是基于以下几个步骤:1、图像获取:单目照相机、双目照相机或者全向照相机;2、图像校正:使用一些图像处理技术来去除透镜畸变;3、特征检测:确定感兴趣的描述符,在帧与帧之间匹配特征并构建光流场;(1)、使用相关性来度量两幅图像间的一致性,并不进行长时间的特征跟踪;(2)、特征提取、匹配(Lucas–Kanade method);(3)、构建光流场;4、检查光流场向量是否存在潜在的跟踪误差,移除外点;5、由光流场估计照相机的运动;(1)、可选方法1:使用卡尔曼滤波进行状态估计;(2)、可选方法2:查找特征的几何与3D属性,以最小化基于相邻两帧之间的重投影误差的罚函数值。

这可以通过数学上的最小化方法或随机采样方法来完成;6、周期性的重定位跟踪点;我选择的视觉里程计算法是:“ sift特征匹配点——基本矩阵——R和T”。

第一步:由特征点计算基本矩阵F。

一般而言,sift点是存在误匹配的情况,因此,采用ransac鲁棒方法计算基本矩阵F。

这个过程已经实现,但是还有一个小问题:同样的一组sift点,进行两次基本矩阵计算,得到的基本矩阵差异很大,因此,我在ransac方法的基础上,根据得到的inliers点,采用常规的8点基本矩阵计算方法,这样得到的基本矩阵能保持不变第二步:由基本矩阵计算R和T方法1:奇异值分解E = KK'*F*KK; %%这是真实的本质矩阵E[U,S,V] = svd(E); %奇异值分解。

SURF算法

SURF算法⼀、原理:Sift算法的优点是特征稳定,对旋转、尺度变换、亮度保持不变性,对视⾓变换、噪声也有⼀定程度的稳定性;缺点是实时性不⾼,并且对于边缘光滑⽬标的特征点提取能⼒较弱。

Surf(Speeded Up Robust Features)改进了特征的提取和描述⽅式,⽤⼀种更为⾼效的⽅式完成特征的提取和描述。

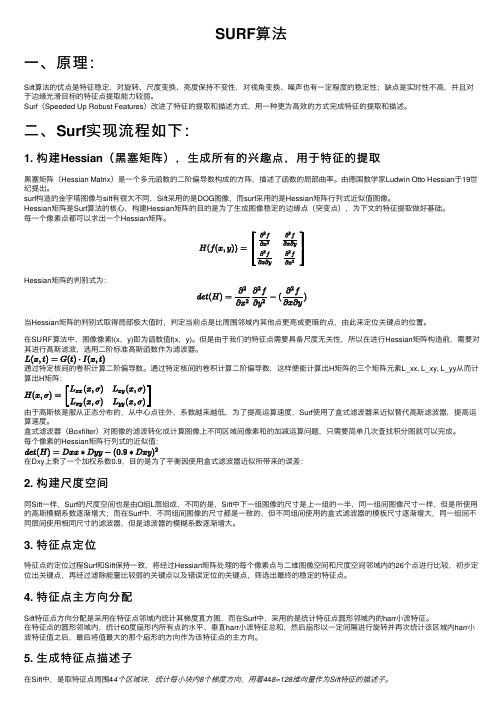

⼆、Surf实现流程如下:1. 构建Hessian(⿊塞矩阵),⽣成所有的兴趣点,⽤于特征的提取⿊塞矩阵(Hessian Matrix)是⼀个多元函数的⼆阶偏导数构成的⽅阵,描述了函数的局部曲率。

由德国数学家Ludwin Otto Hessian于19世纪提出。

surf构造的⾦字塔图像与sift有很⼤不同,Sift采⽤的是DOG图像,⽽surf采⽤的是Hessian矩阵⾏列式近似值图像。

Hessian矩阵是Surf算法的核⼼,构建Hessian矩阵的⽬的是为了⽣成图像稳定的边缘点(突变点),为下⽂的特征提取做好基础。

每⼀个像素点都可以求出⼀个Hessian矩阵。

Hessian矩阵的判别式为:当Hessian矩阵的判别式取得局部极⼤值时,判定当前点是⽐周围邻域内其他点更亮或更暗的点,由此来定位关键点的位置。

在SURF算法中,图像像素l(x,y)即为函数值f(x,y)。

但是由于我们的特征点需要具备尺度⽆关性,所以在进⾏Hessian矩阵构造前,需要对其进⾏⾼斯滤波,选⽤⼆阶标准⾼斯函数作为滤波器。

H矩阵的三个矩阵元素L_xx, L_xy, L_yy从⽽计算出H矩阵:Surf使⽤了盒式滤波器来近似替代⾼斯滤波器,提⾼运算速度。

盒式滤波器(Boxfilter)对图像的滤波转化成计算图像上不同区域间像素和的加减运算问题,只需要简单⼏次查找积分图就可以完成。

每个像素的Hessian矩阵⾏列式的近似值:2. 构建尺度空间同Sift⼀样,Surf的尺度空间也是由O组L层组成,不同的是,Sift中下⼀组图像的尺⼨是上⼀组的⼀半,同⼀组间图像尺⼨⼀样,但是所使⽤的⾼斯模糊系数逐渐增⼤;⽽在Surf中,不同组间图像的尺⼨都是⼀致的,但不同组间使⽤的盒式滤波器的模板尺⼨逐渐增⼤,同⼀组间不同层间使⽤相同尺⼨的滤波器,但是滤波器的模糊系数逐渐增⼤。

surf特征点检测原理

surf特征点检测原理一、引言surf特征点检测是一种在计算机视觉领域被广泛应用的算法,用于图像特征提取和匹配。

本文将介绍surf特征点检测的原理及其相关概念,以帮助读者更好地理解该算法的工作原理。

二、SURF特征点检测的概述SURF(Speeded Up Robust Features)是一种基于尺度空间理论的图像特征描述算法。

它的主要思想是通过检测和描述图像中的局部特征点,从而实现图像的匹配与识别。

SURF算法具有计算速度快、尺度不变性强等优点,因此得到了广泛的应用。

三、尺度空间理论尺度空间理论是SURF算法的基础。

它认为图像中的物体在不同尺度下都会呈现出不同的外观,因此在进行特征点检测时,需要考虑不同尺度下的图像特征。

SURF算法通过构建一个尺度空间金字塔来实现不同尺度下的特征点检测。

四、Hessian矩阵的计算SURF算法使用Hessian矩阵来检测图像中的局部极值点。

Hessian 矩阵描述了图像中的灰度变化情况,通过计算图像的二阶导数来得到Hessian矩阵。

在SURF算法中,为了加速计算速度,Hessian 矩阵的计算采用了一种近似方法。

五、关键点的定位在得到Hessian矩阵后,SURF算法通过计算特征点的行列方向和尺度来实现关键点的定位。

其中,行列方向表示特征点在图像中的位置,尺度表示特征点的大小。

SURF算法还引入了一种基于盒子滤波器的方法,用于对关键点进行定位。

六、关键点的描述关键点的描述是SURF算法的核心内容之一。

SURF算法采用了一种称为Haar小波的特征描述子,用于描述关键点的局部特征。

Haar小波通过计算图像中的水平和垂直边缘来描述图像的纹理特征。

SURF算法通过对Haar小波的积分图像进行快速计算,实现了关键点的快速描述。

七、关键点的匹配关键点的匹配是SURF算法的最后一步。

在进行关键点匹配时,SURF算法采用了一种称为海森距离的相似性度量。

海森距离可以有效地判断两个关键点之间的相似度,从而实现关键点的匹配。

计算机视觉技术的基本原理与方法

计算机视觉技术的基本原理与方法计算机视觉技术是人工智能领域的重要分支,它的目标是使计算机能够通过对图像、视频等视觉信息的理解和处理,来感知和理解世界。

计算机视觉技术已经在各个领域得到广泛应用,包括医疗影像诊断、无人驾驶、人脸识别等。

基本原理:计算机视觉技术的基本原理是通过让计算机学习和模拟人类的视觉系统,使其能够理解和解释图像和视频中的内容。

人类视觉系统会将感兴趣的视觉特征提取出来,然后进行分类和识别。

计算机视觉技术也是基于这个思想。

它通过使用算法和数学模型来对图像进行特征提取和表示,然后使用机器学习算法来进行分类和识别。

计算机视觉技术的方法:1. 特征提取特征提取是计算机视觉技术中最关键的步骤之一。

它通过对图像进行预处理和分析,将图像中的信息提取为一些有意义的特征。

常用的特征包括颜色特征、纹理特征、边缘特征等。

特征提取方法有很多种,包括像素级特征提取、基于滤波器的特征提取、基于模型的特征提取等。

2. 图像分类图像分类是计算机视觉技术的一个重要应用。

它将图像分为不同的类别,通常使用机器学习算法来进行分类。

常用的机器学习算法包括支持向量机、随机森林、神经网络等。

在进行图像分类之前,需要先进行特征提取,然后使用机器学习算法来训练分类器。

3. 目标检测目标检测是计算机视觉技术中的另一个重要应用。

它的目标是在图像或视频中检测出特定的目标物体。

常用的目标检测算法包括滑动窗口法、深度学习算法等。

目标检测需要先进行特征提取,然后使用算法来进行检测。

4. 图像分割图像分割是将图像分成若干个具有相似性质的区域的过程。

常用的图像分割算法包括基于阈值的分割、基于边缘的分割、基于区域的分割等。

图像分割可以用于图像编辑、目标跟踪等领域。

5. 三维重建三维重建是计算机视觉技术的另一项重要应用。

它的目标是从多个视角的图像中重建出三维场景的几何结构。

常用的三维重建方法包括立体视觉技术、结构光技术等。

三维重建可以应用于虚拟现实、增强现实等领域。

surf算法学习心得(一)——算法原理

surf算法学习心得(一)——算法原理surf算法详解SURF学习笔记Speed-Up Robust Features(SURF)SURF 是一种尺度,旋转不变的detector和descriptor.最大的特点是快!在快的基础上保证性能(repeatability,distinctiveness 和robustness)。

SURF采用有效策略的主要有:1)积分图(用于对图像卷积)2)detector是基于Hessian矩阵,descriptor是基于分布的下面是SURF算法的具体实现:1.兴趣点检测SURF 对于兴趣点的检测是基于最基本的Hessian近似矩阵。

1.1积分图像(由于不会在这里编辑公式,直接截图了)PS:这里加一点自己的一点个人理解:关于矩形区域内像素点的求和应该是一种简单重复性运算,采用这种思路总体上提高了效率。

为什么这么说呢?假设一幅图片共有n个像素点,则计算n 个位置的积分图总共的加法运算有n-1次(注意:可不是次哦,要充分利用递推思想),将这些结果保存在一个跟原图对应的矩阵M中。

当需要计算图像中某个矩形区域内的所有像素之和是直接像查表一样,调出A,B,C,D四点的积分图值,简单的加减法(注意只需要三次哦)即可得到结果。

反之,如果采用naive的方式直接在原图像中的某个矩形区域内求和,你想想,总共可能的矩形组合有多少?!!且对于一幅图像n那是相当大啊,所以2那可是天文数字,而且这里面绝大部分的矩形有重叠,重叠意味着什么?在算求和的时候有重复性的工作,其实我们是可以有效的利用已经计算过的信息的。

这就是积分图法的内在思想:它实际上是先计算n个互不重叠(专业点说是不相交)的矩形区域内的像素点求和,充分利用这些值(已有值)计算未知值,有点类似递推的味道...这就完全避免了重复求和运算。

1.2 用于检测兴趣点的Hessian矩阵作者Herbert Bay利用Hessian矩阵来检测兴趣点,具体是用Hessian矩阵行列式的最大值标记斑状结构(blob-like structure)的位置。

找特征点的算法SIFT和SURF算法

找特征点的算法SIFT和SURF算法SIFT算法和SURF算法是用于图像特征点的检测与描述的两种经典算法。

它们在图像处理、计算机视觉和模式识别等领域得到广泛应用。

下面将分别介绍SIFT算法和SURF算法,并对其原理和应用进行详细阐述。

一、SIFT算法(Scale-Invariant Feature Transform)SIFT算法是由Lowe于1999年提出的一种用于图像特征点检测与描述的算法。

它通过分析图像的局部特征来提取与尺度无关的特征点,具有尺度不变性、旋转不变性和仿射不变性等优点。

1.特征点检测SIFT算法首先通过高斯差分金字塔来检测图像中的特征点。

高斯差分金字塔是由一系列模糊后再进行差分操作得到的,通过不同尺度的高斯核函数对图像进行卷积,然后对结果进行差分运算,得到图像的拉普拉斯金字塔。

在拉普拉斯金字塔上,通过寻找局部最大值和最小值来确定特征点的位置。

2.特征点描述在确定特征点的位置后,SIFT算法使用梯度直方图表示特征点的局部特征。

首先,计算特征点周围邻域内每个像素点的梯度幅值和方向,然后将邻域分为若干个子区域,并统计每个子区域内的梯度幅值和方向的分布,最后将这些统计结果组合成一个向量作为特征点的描述子。

3.特征点匹配SIFT算法通过计算特征点描述子之间的欧式距离来进行特征点的匹配。

欧式距离越小表示两个特征点越相似,因此选择距离最近的两个特征点作为匹配对。

二、SURF算法(Speeded Up Robust Features)SURF算法是由Bay等人于2024年提出的一种在SIFT算法的基础上进行改进的图像特征点检测与描述算法。

它通过加速特征点的计算速度和增强特征点的稳定性来提高算法的实时性和鲁棒性。

1.特征点检测SURF算法使用Hessian矩阵来检测图像中的特征点。

Hessian矩阵是图像的二阶导数矩阵,通过计算Hessian矩阵的行列式和迹来确定图像的局部最大值和最小值,从而找到特征点的位置。

机器视觉技术的使用方法与特征提取算法探索

机器视觉技术的使用方法与特征提取算法探索机器视觉技术是一种能够让计算机“看”和“理解”图像和视频的领域,它的应用非常广泛,包括人脸识别、物体检测、图像分类等等。

在机器视觉技术中,特征提取算法是至关重要的一环,它能够从图像或视频数据中提取出重要的特征信息,为后续的任务提供基础。

使用机器视觉技术的方法可以分为以下几步:第一步是数据采集。

对于许多机器视觉任务来说,关键的第一步就是获取高质量的数据。

这包括摄像头拍摄的图像或视频数据,以及相应的标注信息。

数据的质量和多样性对于训练和测试模型的性能至关重要。

第二步是数据预处理。

在进行特征提取之前,常常需要对数据进行一些预处理。

这可能包括图像的缩放、剪裁、去噪等操作,以确保数据的一致性和可用性。

此外,还可以利用图像增强技术来改善图像的质量,例如调整对比度、亮度等。

第三步是特征提取。

在机器视觉中,特征提取是非常重要的一步,它可以从图像或视频数据中抽取出最具代表性的特征。

常见的特征提取算法有SIFT、SURF、HOG等。

这些算法能够从图像中提取出局部特征或全局特征,用于表示图像的内容。

SIFT(尺度不变特征转换)是一种局部特征提取算法,它能够在不同尺度和旋转下提取出关键点和描述子。

SURF(加速稳健特征)是SIFT的一种改进算法,具有更快的计算速度和更好的鲁棒性。

HOG (方向梯度直方图)是一种用于物体检测的特征描述子,它通过计算图像中各个区域的梯度方向来表示图像的纹理特征。

根据不同的任务需求,选择适合的特征提取算法是非常重要的。

一般来说,SIFT和SURF适用于局部特征匹配或配准,而HOG则适用于物体检测和行人识别等任务。

此外,还有其他一些特征提取算法,如LBP(局部二值模式)、Color Histogram等,可以根据具体的任务需求进行选择。

第四步是特征表示与分类。

在完成特征提取之后,需要将提取出的特征进行适当的表示和分类。

常用的方法包括使用聚类算法将相似的特征聚类在一起,或者使用分类算法将特征分为不同的类别。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

MPIG Seminar0045

Feature Extraction

陈伟杰

Machine Perception and Interaction Group (MPIG)

cwj@

Feature Extraction

Refined based on the book:

Mastering OpenCV with Practical Computer Vision

Projects_full.pdf

and

Bay H, Tuytelaars T, Van Gool L. Surf: Speeded up robust features [M]. Computer vision–ECCV 2006. Springer. 2006: 404-417.

or F for [R|t]Drawing path

The main steps of Visual Odometry

images parameters

Feature Extraction

Feature

matching

Compute E

First

Feature Extraction What feature is?

Characteristics can be easily identified in images

Edges Corners Blobs

lines points

Harris SIFT SURF Commonly used algorithm:

•Corner extractor

•Fast operation •Poor resolution •Not applicable when scale

changes •Blobs extractor

•Slow operation

•Good resolution

•Scale invariance

•Upgrade from

SIFT

•Speed up

•More robust

SURF(Speed Up Robust Feature) opencv2/nonfree/features2d.hpp

SurfFeatureDetectordetector()

SurfDescriptorExtractor

SURF(Speed Up Robust Feature)

Integral image

ii x,y = i=0i≤x j=0

j≤y

I(i,j)

(x,y)

A

C

B D

123

4

ii 1= A ii 2= A + B

D =ii 1+ii 4−ii 2−ii 3

SURF(Speed Up Robust Feature)

Hessian matrix

H x,σ=L xx(x,σ)L xy(x,σ) L xy(x,σ)L yy(x,σ)

L x,σ=Gσ∗I(x,y)Gσ=ð2g(σ)

ðx2g(σ) is Gaussian function andσis variance

It’s the image conversion like frequency domain transform

Approximation of Hessian matrix

Det

H

approx

=D xx D yy−0.9D xy2

L yy L xy

D yy D

xy

We can use integral image to compute easily now

H x,σ=

L xx(x,σ)L xy(x,σ)

L xy(x,σ)L yy(x,σ) Filter template

SURF(Speed Up Robust Feature)

scale space (image pyramid)

SIFT SURF Change size of filter only Easier and faster

Positioning feature points

3×3 window

“x”is extreme point when it’s the

max or the min of 26 points around

Setting a threshold value t

if x>t, x is feature point

The larger t is, the less points will be

SURF feature descriptor

Main direction

Statistics harr wavelet feature around the feature point with the range of 60°in a circle of radius6s(s is the scale of the feature point)

The max value is main direction

SURF feature descriptor

main direction

feature point 20s Every descriptor has

4*4*4=64 dimensional vector

Mat img1 = imread( "chapel00.png");

Mat img2 = imread("chapel01.png");

int minHessian = 400;

SurfFeatureDetector detector( minHessian );std::vector<KeyPoint> keypoints1, keypoints2;detector.detect(img1, keypoints1);

detector.detect(img2, keypoints2);

// computing descriptors

SurfDescriptorExtractor extractor;

Mat descriptors1, descriptors2;

pute(img1, keypoints1, descriptors1);

pute(img2, keypoints2, descriptors2);CODE

//--Draw keypoints Mat img_keypoints_1; Mat img_keypoints_2;drawKeypoints( img1, keypoints1, img_keypoints_1, Scalar::all(-1), DrawMatchesFlags::DEFAULT );drawKeypoints( img2, keypoints2, img_keypoints_2, Scalar::all(-1), DrawMatchesFlags::DEFAULT );//--Show detected (drawn) keypoints imshow("Keypoints 1", img_keypoints_1 );imshow("Keypoints 2", img_keypoints_2 );waitKey(0);return 0;

800 400

200 minHessian。