双线负载均衡、设备冗余地方案设计设计

负载均衡 解决方案

负载均衡解决方案

《负载均衡解决方案》

负载均衡是指将网络流量或者负载分布到多个服务器或者硬件上,以确保每个服务器都能够有效地处理流量。

负载均衡解决方案旨在提高性能、可扩展性和可靠性,同时降低成本和资源浪费。

为了实现有效的负载均衡,组织需要考虑多种解决方案。

其中之一是硬件负载均衡器。

硬件负载均衡器是一种专用的设备,用于管理网络流量,并将其分发到多个服务器上。

这种解决方案通常是昂贵的,但它们提供了高性能和可靠性。

另一种解决方案是软件负载均衡器。

软件负载均衡器是通过软件实现的负载均衡解决方案,通常以应用程序的形式提供。

这种解决方案通常比硬件负载均衡器便宜,并且可以灵活地适应不同的需求。

此外,云服务提供商通常也提供负载均衡解决方案。

例如,亚马逊AWS和微软Azure都提供了负载均衡服务,使用户能够轻松地实现负载均衡,而无需购买昂贵的硬件或者配置复杂的软件。

总的来说,负载均衡解决方案是组织确保其网络和服务器能够高效运行的关键组成部分。

通过仔细选择合适的解决方案,并且灵活地适应需求,组织可以提高其网络的性能、可靠性和可扩展性,从而为用户提供更好的体验。

基于双线路接入的网关冗余和负载均衡设计与实现

基于双线路接入的网关冗余和负载均衡设计与实现[摘要] 各个企业为了保证企业网络的可用性和连续性,都使用了双链路的接入方式。

本文介绍在双链路接入的情况下,如何利用HSRP和DHCP技术做网关冗余和负载均衡,并详细介绍了具体的技术实现细节。

[关键字] HSRP协议DHCP协议网关冗余负载均衡[Abstract] In order to ensure all business availability and continuity of the corporate network, they always use the double-link access. This article describes the case of dual-link access, how to use HSRP and DHCP technology to do the gateway redundancy and load balancing, and details the specific technical implementation details.[Keywords] HSRP Protocol DHCP protocol load balancing Gateway Redundancy1.引言随着企业信息化、数字化建设的推进,越来越多的企业为了保证企业网络的高可用性和高连续性,大多数企业选用了双链路接入的方式,即采用多ISP接入或者是通一个ISP的双链路接入方式来保证服务的持续性,但是大多数仍旧采用了冷备份的方式。

这样做的结果:一是闲置了设备,二是遇到设备故障不能快速、自动启用备份设备,三是不能起到负载均衡的作用。

本文介绍了如何在双链路接入的情况下,如何利用HSRP协议实现双网关冗余和负载均衡以及如何利用三层交换设备动态的给用户分配IP地址,省去了静态IP分配的麻烦。

2.HSRP概述HSRP 是Cisco 的专有协议。

F5多出口链路负载均衡解决方案

F5 Networks多出口链路负载均衡解决方案建议目录一.多出口链路负载均衡需求分析 (3)二.多出口链路负载均衡解决方案概述 (4)2.1多出口链路负载均衡网络拓朴设计 (4)2.2方案描述 (5)2.3方案优点 (7)2.3.1 拓扑结构方面 (7)2.3.2安全机制方面 (7)三.技术实现 (8)3.1F5多出口链路负载均衡(产品选型:B IGIP LC) (8)3.2O UTBOUND流量负载均衡实现原理 (10)3.3I NBOUND流量负载均衡实现原理 (11)3.4在链路负载均衡环境中的DNS设计和域名解析方式 (13)3.4.1 Root DNS(注册DNS)直接与F5多链路负载均衡器配合 (13)3.4.2 Root DNS(注册DNS)通过第三方DNS Server与F5多链路负载均衡器配合(我们建议这种方式) (14)3.5F5设备双机冗余----毫秒级切换原理 (16)3.6S TATEFUL F AIL O VER 技术(与F5设备双机冗余有关) (17)四.产品介绍 (18)4.1F5B IGIP (18)一.多出口链路负载均衡需求分析为了保证XXXX出口链路的高可用性和访问效率,计划拥有两条线路:一条中国网通链路,一条中国电信链路。

F5公司的多链路负载均衡设备(Bigip)能够提供独具特色的解决方案,不但能够充分利用这两条链路(双向流量按照预设的算法分担到不同的链路上,一旦一条链路不通的情况下,能够无缝切换到另外一条可用链路上);而且可以根据对不同链路的侦测结果,将最快速的链路提供给外部用户进行响应,从而解决目前广泛存在的多个ISP之间的互联互通问题。

具体解决方案特色如下:➢提供网至internet流量的负载均衡(Outbound)➢实现从Internet对服务器访问流量的负载均衡(Inbound)➢支持自动检测和屏蔽故障Internet链路➢支持多种静态和动态算法智能均衡多个ISP链路的流量➢支持多出口链路动态冗余,流量比率和切换➢支持多种DNS解析和规划方式,适合各种用户网络环境➢支持Layer2-7交换和流量管理控制功能➢完全支持各种应用服务器负载均衡,防火墙负载均衡➢多层安全增强防护,抵挡黑客攻击➢业界领先的双机冗余切换机制,能够做到毫秒级切换➢详细的链路监控报表,提供给网络管理员直观详细的图形界面➢对于用户完全透明➢对所有应用无缝支持➢业界优异的硬件平台和性能➢稳定,安全的设备运行记录二.多出口链路负载均衡解决方案概述2.1 多出口链路负载均衡网络拓朴设计下面是专门为XXXX设计的多出口链路负载均衡网络拓扑图(单机版)。

双线负载均衡设置完整版

双线负载均衡设置完整版在我们遇到双线网络的时候,该如何进行负载均衡的设置呢?这个问题我们将通过一个实际的案例帮助大家介绍,那么我们还是先从例子的实际情况出发,根据问题的所在进行方案的研究,之后通过前面文章的基础介绍,在此我们就直接引入双线负载均衡的配置问题了。

该公司有两条专线,一条联通的2M 租线,另一条互联通的512K 租线;有一台Linux 做的WEB服务器,该WEB服务器有一张网卡,接到中心交换机3560上。公司希望,当两条线路都正常时,客户能够通过任何一条专线访问公司的WEB服务器,实现双线负载均衡;而且,当任何一条线路出现故障时,用户仍然可以访问WEB服务器。分析:为了实现两条线路正常时的双线负载均衡,可以通过配置DNS轮询实现。而为了实现容错,我们需要实现从哪条线路进来的请求,其响应也从该线路出去,这是解决问题的关键所在。因为,如果从一条线路进去的请求,其响应从另外一条线路出来的话,那么TCP的三次握手不可能完成,TCP连接不可能建立起来(因为两条线路上都有防火墙)。而且,即使不考虑防火墙的状态检测机制,假设两条线路都正常时TCP连接能够建立起来,但是,一旦其中一条线路挂了,那么连接也不可能建立得起来,容错机制也不能实现。DNS轮询,比较简单,我们不做深入的讨论。由于该公司的域名是在域名供应商那里注册的,所有只需要在域名供应商的网站上做适当配置:将该公司的WEB服务器域名 分别映射到IP地址 x.x.x.x(联通IP) 和 y.y.y.y(互联通IP)就完事了。当用户浏览的时候,浏览器会智能地在这两个IP之间作出选择。下面我们讨论怎样实现双线负载均衡。

从哪条线路进来的请求,其响应也从该线路出去。我们可以这样来做:双线负载均衡第一步:在联通线路的防火墙上,将联通给我们的IP地址x.x.x.x 的80端口映射到内网地址192.168.168.1的80端口:iptables -t nat -A PREROUTING -p tcp -s 0/0 -d x.x.x.x/32 \--dport 80 -j DNAT --to-destination 192.168.168.1iptables -t nat -A POSTROUTING -p tcp -s 192.168.168.1/32 -d 0/0 \--sport 80 -j SNAT --to-source x.x.x.x双线负载均衡第二步:在互联通线路的防火墙上,将互联通给我们的IP地址y.y.y.y 的80端口映射到内网地址 192.168.1.2的80端口:iptables -t nat -A PREROUTING -p tcp -s 0/0 -d y.y.y.y/32 \--dport 80 -j DNAT --to-destination 192.168.168.2iptables -t nat -A POSTROUTING -p tcp -s 192.168.168.2/32 -d 0/0 \--sport 80 -j SNAT --to-source y.y.y.y双线负载均衡第三步:在WEB服务器上,为网卡eth0绑定两个IP地址:192.168.168.1,192.168.168.2:[root@web network-scripts]# cat ifcfg-eth0DEVICE=eth0HWADDR=00:0C:76:23:23:9AIPADDR=192.168.168.1NETMASK=255.255.255.0ONBOOT=yesTYPE=Ethernet[root@web network-scripts]# cat ifcfg-eth0:0DEVICE=eth0:0HWADDR=00:0C:76:23:23:9AIPADDR=192.168.168.2NETMASK=255.255.255.0ONBOOT=yesTYPE=Ethernet双线负载均衡第四步:在WEB服务器上配置策略路由:将来自联通线路的,发给192.168.168.1的请求的响应包,发送给192.168.168.11,然后通过联通的线路,返回给用户;将来自互连通线路的,发给192.168.168.2的请求的响应包,发给192.168.168.12,然后通过互联通的线路返回给用户.这样,就可以实现从哪条线路进来的请求,其响应也从该线路出去。具体配置如下:[root@web ~]# ip route add table 1 default via 192.168.168.11[root@web ~]# ip route add table 2 default via 192.168. 168.12[root@web ~]# ip rule add from 192.168.168.1 table 1[root@web ~]# ip rule add from 192.168.168.2 table 2[root@web ~]# sh ip rule<--- IOS^-^/sbin/ip: /sbin/ip: cannot execute binary file [root@web ~]# ip rule list0:from all lookup local32764:from 192.168.168.2 lookup 232765:from 192.168.168.1 lookup 132766:from all lookup main32767:from all lookup default[root@web ~]# ip route list table 1default via 192.168.168.11 dev eth0[root@web ~]# ip route list table 2default via 192.168.168.12 dev eth0。

负载均衡方案设计

负载均衡有两方面的含义:首先,大量的并发访问或数据流量分担到多台节点设备上分别处理,减少用户等待响应的时间;其次,单个重负载的运算分担到多台节点设备上做并行处理,每个节点设备处理结束后,将结果汇总,返回给用户,系统处理能力得到大幅度提高。

算法提供多个WAN ports可作多种负载平衡算法则,企业可依需求自行设定负载平衡规则,而网络存取可参照所设定的规则,执行网络流量负载平衡导引。

算法则有:◎依序Round Robin◎比重Weighted Round Robin◎流量比例Traffic◎使用者端User◎应用别Application◎联机数量Session◎服务别Service◎自动分配Auto ModeInbound Load Balancing内建Inbound Load Balance 功能,可让企业透过多条ISP线路,提供给浏览者更实时、快速与稳定不断线的因特网在线服务;Inbound负载平衡算法包括:Round Robin/ Weighted Round Robin/Auto Back Up;功能内建DNS服务器,可维护多个网域(domain),每个网域又可以新增多笔纪(A/CNAME/MX),达到Inbound oad Sharing的功能。

■Server Load BalancingAboCom服务器负载均衡提供了服务级(端口)负载均衡及备援机制。

主要用于合理分配企业对外服务器的访问请求,使得各服务器之间相互进行负载和备援。

AboCom服务器负载与服务器群集差异:一旦有服务器故障,群集技术只对服务器的硬件是否正常工作进行检查;AboCom服务器负载则对应用服务端口进行检查,一旦服务器的该应用服务端口异常则自动将访问请求转移到正常的服务器进行响应。

■VPN Trunk 负载均衡支持同时在多条线路上建立VPN连接,并对其多条VPN线路进行负载。

不仅提高了企业总部与分支机构的VPN访问速度,也解决了因某条ISP线路断线造成无法访问的问题。

网络冗余方案

网络冗余方案第1篇网络冗余方案一、方案背景随着信息化建设的不断深入,网络系统已成为企业、机构运营的重要基础设施。

网络系统的稳定性和可靠性对业务连续性至关重要。

为防范网络故障带来的业务中断风险,提高网络系统的高可用性和稳定性,本方案提出了一套全面、高效的网络冗余策略。

二、方案目标1. 确保网络系统的高可用性,降低单点故障风险;2. 提高网络系统在面临故障时的自愈能力;3. 保障关键业务的稳定运行,减少网络故障对业务的影响;4. 合法合规,遵循我国相关法律法规和标准。

三、方案内容1. 网络架构冗余(1)核心层冗余采用双核心交换机架构,通过虚拟路由冗余协议(VRRP)实现双机热备。

双核心交换机之间采用光纤互连,确保数据传输的高速和稳定性。

(2)汇聚层冗余汇聚层交换机采用双机热备方式,通过堆叠技术实现设备间的冗余。

汇聚层与核心层之间采用多链路捆绑,提高链路带宽和可靠性。

(3)接入层冗余接入层交换机采用双电源供电,确保设备在电源故障时仍能正常运行。

接入层与汇聚层之间采用双链路连接,提高接入层的可靠性。

2. 设备冗余(1)交换机冗余关键设备如核心交换机、汇聚层交换机采用双机热备方式,确保在设备故障时能够快速切换,降低故障影响。

(2)路由器冗余采用双路由器架构,通过路由器之间的热备协议(如HSRP、VRRP等)实现冗余。

在主备路由器之间进行路由信息同步,确保数据传输的连续性。

(3)电源冗余关键设备采用双电源供电,确保在一路电源故障时,另一路电源能够正常供电,保证设备的稳定运行。

3. 链路冗余(1)互联网出口冗余采用多运营商接入,实现互联网出口的冗余。

通过智能DNS解析,将用户请求分配到不同的运营商出口,提高访问速度和可靠性。

(2)内网链路冗余关键业务服务器采用多链路接入,通过链路聚合技术实现内网链路的冗余。

在链路故障时,其他链路能够自动接管,确保业务不受影响。

4. 数据冗余(1)存储冗余采用磁盘阵列存储关键数据,通过RAID技术实现数据冗余。

路由器的双WAN口负载均衡技术

路由器的双WAN口负载均衡技术在现代网络中,随着互联网的快速发展,越来越多的用户对网络连接速度和稳定性有着更高的要求。

路由器作为连接计算机与网络的桥梁,起着至关重要的作用。

为了满足用户对网络的需求,路由器厂商不断推出新技术,其中双WAN口负载均衡技术成为了一个备受关注的话题。

一、双WAN口负载均衡技术的定义双WAN口负载均衡技术是指通过同时连接两个或多个宽带接入线路,将网络流量进行均衡分配的一种技术。

通过将数据流量分散到不同的网络线路上,从而提高网络连接的带宽利用率和传输速度,同时增加网络的可靠性和稳定性。

二、双WAN口负载均衡技术的原理双WAN口负载均衡技术的实现原理主要包括以下几个方面:1. 数据流量的分流:路由器通过运用负载均衡算法,将传入的数据流量分流到不同的宽带线路上。

常见的负载均衡算法有基于轮询、基于权重、基于最小连接数量等。

算法的选择要基于实际网络环境和对网络连接的需求。

2. 数据流量的计算与监控:路由器会根据每条线路的情况,综合考虑带宽利用率、延迟、丢包率等指标,进行数据流量的动态分配。

同时,路由器还会通过监控网络连接的质量,及时切换到可用的线路上,以保证网络的稳定性。

3. 单会话的优化:由于部分应用程序对于单个会话的要求更加严格,路由器会通过一些技术手段,如会话绑定或基于源地址的哈希算法,保证单个会话的数据流量只通过一个指定的宽带线路传输,以避免数据的乱序和重传。

三、双WAN口负载均衡技术的优势双WAN口负载均衡技术相比于传统的单WAN口路由器,具有以下几个优势:1. 带宽利用率提升:通过同时利用多条宽带线路,可以将网络流量分散到不同线路上,从而提高整体的带宽利用率。

特别是在大流量网络环境下,双WAN口负载均衡技术能够明显提升网络的吞吐量。

2. 传输速度提升:通过同时使用多条线路进行数据传输,双WAN口负载均衡技术可以有效地提高数据传输的速度。

特别是在进行大文件传输、视频流媒体等高带宽应用时,用户可以明显感受到速度的提升。

负载均衡的实施方案

负载均衡的实施方案在当今互联网应用日益复杂的环境下,负载均衡技术显得尤为重要。

负载均衡的实施方案涉及到网络架构、硬件设备和软件系统等多个方面,下面将从这些方面进行详细介绍。

首先,对于网络架构的设计,负载均衡的实施方案需要考虑到整个网络环境的特点,包括网络拓扑结构、数据中心的布局、网络设备的分布等。

在设计网络架构时,需要充分考虑到负载均衡设备的位置,以及负载均衡策略的制定,确保负载均衡能够有效地分担流量,提高系统的整体性能。

其次,硬件设备的选择也是负载均衡实施方案中的关键环节。

在选择硬件设备时,需要考虑到网络规模、预期的负载水平以及系统的可扩展性等因素。

常见的负载均衡硬件设备包括交换机、路由器、负载均衡器等,而现在也有许多厂商提供了基于软件的负载均衡解决方案,如Nginx、HAProxy等。

在选择硬件设备时,需要综合考虑其性能、稳定性、成本以及厂商的技术支持等因素。

另外,软件系统的配置和优化也是负载均衡实施方案中不可忽视的一部分。

负载均衡软件的配置需要根据实际的业务需求来进行,包括负载均衡算法的选择、会话保持的设置、健康检查的策略等。

此外,对于负载均衡软件的优化也是至关重要的,通过调整参数、升级版本、优化代码等手段,可以进一步提升系统的性能和稳定性。

最后,负载均衡的实施方案还需要考虑到监控和故障处理等方面。

监控系统可以实时地监测负载均衡设备和后端服务器的运行状态,及时发现并解决潜在的问题。

而对于故障处理,需要建立完善的应急预案,确保在发生故障时能够快速、有效地恢复系统的正常运行。

总的来说,负载均衡的实施方案涉及到网络架构、硬件设备和软件系统等多个方面,需要综合考虑各种因素,确保系统能够稳定、高效地运行。

只有在全面而系统的规划和实施下,才能够充分发挥负载均衡技术的优势,为用户提供更加稳定、快速的网络服务。

负载均衡设计方案

负载均衡设计方案负载均衡是指将网络流量合理分配到多个服务器上,使得每个服务器负载均匀,提高系统的可用性和性能。

以下是一个负载均衡的设计方案:1. 确定负载均衡的算法:负载均衡的算法有很多种,常见的有轮询、最少连接、IP哈希等。

根据系统的需求和规模,选择适合的负载均衡算法。

2. 引入负载均衡设备:在系统架构中引入负载均衡设备,如硬件负载均衡器或软件负载均衡器。

负载均衡设备可以根据负载均衡算法将流量分发到后端服务器。

3. 添加后端服务器:根据系统的性能需求和负载均衡设备的性能,确定后端服务器的数量。

后端服务器可以是物理服务器、虚拟机或者容器。

确保每个后端服务器都具有相同的应用程序和数据副本。

4. 监控后端服务器:使用监控工具监控每个后端服务器的性能指标,如CPU使用率、内存使用率、网络流量等。

通过这些指标可以及时发现负载过高或发生故障的服务器。

5. 动态调整负载均衡策略:根据监控数据和负载均衡算法,动态调整负载均衡策略。

例如,当某个后端服务器负载过高时,可以将部分流量转发到其他服务器上,以减轻其负载。

6. 安全策略:在负载均衡设备上设置安全策略,如访问控制列表(ACL)、防火墙等,以保护系统免受攻击。

7. 故障恢复:当某个后端服务器发生故障时,负载均衡设备可以自动将流量转发到其他正常的服务器上,以保证系统的可用性。

8. 水平扩展:根据系统的负载情况,根据预测的流量增长趋势,可以动态增加后端服务器的数量,以满足系统的性能需求。

综上所述,一个负载均衡的设计方案包括确定负载均衡的算法,引入负载均衡设备,添加后端服务器,监控后端服务器,动态调整负载均衡策略,设置安全策略,故障恢复以及水平扩展。

通过合理的设计和配置,可以提高系统的性能和可用性,提升用户体验。

双WAN口接入 负载均衡和流量分配最优化

双WAN口接入负载均衡和流量分配最优化飞鱼星新推出的VOLANS-4150+ 宽带路由器提供了双W AN口功能,该功能是专为满足企业、小区、网吧等大中型局域网共享上网需求而设计的,它提供了一套完整的INTERNET冲浪以及资源共享的解决方案。

VOLANS-4150+ 配备了两个W AN口及四个LAN口,通过双W AN口方式支持双线路接入,通过捆绑不同ISP的宽带线路,能够真正的做到负载均衡和流量分配最优化,尤其对于同时拥有网通、电信双光纤的客户是一个极佳的选择!它的强大功能主要有以下几点:一、断网自动切换,灾难性自救功能下面以乐山网吧一例,来看看它的强大功能:为配合乐山电信给网吧配备的一条光纤一条ADSL的方案,飞鱼星4150可以实现线路备份的功能。

当电信的光纤出现问题断了,路由器在3秒之内自动切换到ADSL上,光纤恢复后3秒内在自动切换回光纤,网吧用户几乎感觉不到断网,电信提供的ADSL作到了自动备份,不需要人为去改动,方便维护。

如图所示:灾难性自救,保证线路稳定(图1)使用双WAN口路由器可以申请两条线路,这两条线路还可以是不同运营商的,例如一条中国电信的ADSL,一条网通的10M以太网,就能在某个ISP、某条电缆、某个Modem出现故障时,把数据流量重新分配到没有故障的口上,整个网络不会中断。

而且不同的ISP服务商所提供的服务也有着区别,在网通和电信之间有着不同的游戏服务器。

对于网吧来说,大多数游戏服务器都在网通的主干网上,而大多数的下载主要落在电信主干网上,所以申请双线路是网吧的重要选择。

比如,在网通主干网上的游戏有奇迹、天堂、决战、石器时代等多款热门游戏,还有网通马上要运营的韩国大型游戏等。

中国网通今年已将网游作为重点发展项目,这些因素对于网通线路接入网吧客户群有很大帮助。

其次,网通干网质量高、服务好也是吸引网吧客户的有利因素。

在网吧上网,网速成为顾客最为关心的一个问题。

大量的下载集中在电信的线路上,导致网络游戏运行不畅,严重的影响了网吧的生意,双鱼星的双线互通就很好的解决了这个问题。

网络负载均衡设计方案

网络负载均衡设计方案背景介绍:在现代互联网环境下,大量数据传输和流量处理成为了网络架构的重要组成部分。

为了提高网络性能和可靠性,网络负载均衡(Load Balancing)技术得到了广泛应用。

本文将为您介绍网络负载均衡的概念、原理,并提出一种可行的网络负载均衡设计方案。

一、网络负载均衡的概念和原理1.1 概念网络负载均衡是一种通过对网络流量进行分发和管理的技术,将大量请求均匀分配到多个服务器上,以提高系统的性能、可靠性和可扩展性。

通过负载均衡,可以充分利用服务器资源,提供更快的响应时间和更高的服务可用性,同时减轻单个服务器的压力。

1.2 原理网络负载均衡的实现依赖于以下三个主要原理:- 分发:将请求分发到多个服务器上,确保每个服务器处理的请求数相对均衡。

- 监测:实时监测服务器的负载情况,根据各个服务器的性能决策将请求发送至合适的服务器。

- 故障处理:当某个服务器发生故障时,能够自动将请求转发至其他正常工作的服务器。

二、基于软件的为了满足不同应用场景下的网络负载均衡需求,我们提出了一种基于软件的网络负载均衡设计方案。

2.1 方案概述该方案通过在网络架构中引入软件负载均衡器,实现对流量的智能分发和管理。

我们选用了常见的开源软件负载均衡器Nginx作为核心组件,其具备高性能、灵活性和可扩展性等优点。

2.2 架构设计本方案的架构如下图所示:[图1:基于软件的网络负载均衡方案架构图]在该架构中,负载均衡器位于服务器集群和外部网络之间,负责接收来自外部网络的请求,并将其分发至后端的多个服务器。

负载均衡器通过内置的算法根据服务器的负载情况,将请求发送至最适合的服务器。

2.3 主要功能和特点我们的网络负载均衡设计方案具备以下主要功能和特点:- 接收和分发请求:负载均衡器可以接收来自外部网络的请求,并将其均衡分发至后端的服务器。

- 动态调整:负载均衡器能够实时监测服务器的负载情况,并根据负载情况动态调整请求的分发策略。

F5负载均衡的双机冗余配置与全冗余解析

F5负载均衡的双机冗余配置与全冗余解析F5负载均衡的双机冗余实现与RadWare是不同的,RadWare是采用VRRP协议实现的,F5主要是通过串口心跳和网络心跳来实现双机冗余的。

下面让我们对此做一下认识和了解,仅此交流。

一、串口心跳双机冗余方式两台F5 BIGIP之间通过串口用它自带的串口线揽(这个串口线较短)相连。

每台F5 BIGIP通过串口心跳线监控对端设备的状态。

在串口心跳线的结构中,双机切换流程如下:1、Active 设备负责在心跳线上产生一个高电平2、Backup设备监听对端的高电平3、当Backup设备监听到对端没有高电平时,将自己转换为Active设备4、Backup设备对外发送ARP广播,将所有的VS和浮动IP对外广播,表明这些地址在自己这端,引发网络流量切换。

在BIGIP的串口心跳线中,主要通过电平方式来通知对端和监控对端状态,在串口心跳线中没有任何的数据信号传输。

这种方式也是F5推荐的冗余方式。

二、网络心跳双机冗余方式由于F5的串口线长度有限(50英尺),当两台F5 BIGIP物理位置相距较远的时候,就不方便连接了。

除了串口心跳外,两台F5 BIGIP之间还可以通过网络线连接来实现心跳信号的传递。

切换触发信号通过网络通知对端设备,同时每台F5 BIGIP通过网络连线来监控对端设备的状态。

两台f5 BIGIP之间通过TCP的1028端口进行心跳信号传递。

切换的过程如下:1、Acitve设备负责产生心跳信号2、Backup设备监听Active设备的心跳信号3、当Backup设备在一定时间内没有接收到心跳信号时,则将自己切换为Active4、Backup设备对外发送ARP广播,将所有的VS和浮动IP对外广播,表明这些地址在自己这端,引发网络流量切换。

在配置Network FailSafe的时候,将指定一个VLAN来进行心跳信号传输。

这个VLAN通常为两台BIGIP之间的一个独立连接VLAN 或者Internal VLAN。

局域网组建中的网络设备冗余与负载均衡策略

局域网组建中的网络设备冗余与负载均衡策略在局域网组建中,网络设备的冗余和负载均衡策略是至关重要的。

网络设备冗余指的是在网络中使用多个设备来备份和替代主要设备的方法,以提高网络的可用性和容错性。

而负载均衡则是将网络流量分配到不同的设备上,以避免某一设备过载而导致性能下降。

一、网络设备冗余网络设备冗余是保证网络可靠性的重要手段之一。

常见的网络设备冗余策略包括硬件冗余和软件冗余。

1. 硬件冗余硬件冗余是指通过使用多个相同或相似的硬件设备来提高系统的可靠性。

常见的硬件冗余技术有备份冗余和热备插槽。

备份冗余是指在网络中使用备用设备来备份主要设备,以保证在主设备故障时能够无缝切换到备用设备。

备份冗余可以采用主备关系或者主-主关系,前者指备用设备处于待命状态,只有主设备故障时才接管工作;后者指主备设备同时工作,可以实现双机热备。

热备插槽是指将备用设备插入到已运行的设备中,当主设备故障时,备用设备可以立即接管工作,减少网络中断的时间。

2. 软件冗余软件冗余是通过在网络设备中实施冗余软件来提高系统的可靠性。

常见的软件冗余技术有软件备份和虚拟化技术。

软件备份是指在主设备和备用设备中运行相同的软件,并实时同步数据和配置信息。

当主设备故障时,备用设备可以立即接管工作,并保持原有的网络状态。

虚拟化技术是将多个逻辑设备虚拟化为一个物理设备,从而提高系统的可伸缩性和容错性。

当有设备故障时,其他虚拟设备可以自动接管其工作,无需人工干预。

二、负载均衡策略负载均衡是指将网络流量均衡地分配到不同的设备上,以避免某一设备负载过重而导致性能下降。

常见的负载均衡策略有基于DNS的负载均衡、基于设备的负载均衡和基于内容的负载均衡。

1. 基于DNS的负载均衡基于DNS的负载均衡是通过DNS服务器将客户请求引导到不同的服务器上,从而实现负载均衡。

DNS服务器会返回多个服务器的IP地址,客户端会根据一定的策略选择其中一个IP地址进行连接。

常见的DNS负载均衡策略有轮询、加权轮询和最少连接。

企业internet接入全冗余解决方案

企业internet接入全冗余解决方案随着互联网的发展和普及,internet应用在企业中占据的位置也越来越明显,企业开始更多地使用互联网来交付其关键业务应用,企业生产力的保证越来越多的依赖于企业IT架构的高可靠运行,尤其是企业数据中心关键业务应用的高可用性,所以企业对于internet链接的可靠性、稳定性和各项性能的要求也越来越高。

同时越来越关注如何在最大节省IT成本的情况下维持关键应用7×24小时工作,保证业务的连续性。

为了解决这些问题,许多企业开始租用两条或者更多的isp 线路进行internet接入。

那么如何对多条链路进行有效的负载均衡和冗余备份就是一个需要迫切解决的问题。

标签:internet;稳定性;可靠性;冗余备份傳统的单条链路解决方案已经无法适用于今天的网络环境,而多宿主的边界网关协议(BGP)管理非常复杂并需要网络具有自治系统(AS)号,这对于一个企业来说,建设和管理成本都极为不划算,所以通过采用边界网关协议(BGP)来管理路由和流量存在很大的局限性。

针对于目前中国网络的环境,也为了解决绝大多数企业对于互联网应用稳定的需求,我们需要使用链路负载均衡来完善我们的接入。

1负载均衡工作原理负载均衡设备一般设置在防火墙和internet接入之间,它时刻监视链路,通过一系列透明的状态和性能检测,分析每条链路的状态,接着按照一套规定的算法,将流量导入最优链路。

算法考虑了多种多样的网络因数,如,链路是否正常(可用性)、带宽和资费、到达目的站点的跳数、时延、当前负载情况(字节数、流量、连接数、用户数)和丢包率等。

并结合采用平均、权重/比率、轮询和预测等方法进行优化计算,这样就可以将流量在多条链路平均分配,有效的提高了带宽的利用率,同时流量总是通过最优链路传输,大大的提高了网络效率。

2负载均衡的结构化部署简单的介绍完负载均衡的工作原理后,我们就应该知道负载均衡设备需要被部署在网络结构的接入部分如图1所示当部署了负载均衡设备后我们的接入网就算进行了冗余备份,负载均衡设备会在单独线路出现问题时主动切换至另一条线路保证企业内部网络用户对internet访问的连续性。

负载均衡解决方案设计设计

负载均衡解决方案设计设计负载均衡(Load Balancing) 解决方案设计对于大型分布式应用程序和高流量网站来说是非常重要的。

这种解决方案能够确保所有的应用程序资源得到充分利用和分配。

它也能够确保网络交通负载均衡和故障转移能够顺畅完成。

在本文中,我们将探讨负载均衡解决方案设计的一些关键技术和策略。

负载均衡的类型首先,让我们来探讨几种负载均衡的类型。

根据应用程序的需求,我们可以选择以下类型的负载均衡:1. 基于硬件的负载均衡:在硬件负载均衡中,我们可以在前端将流量路由到不同的服务器上,其中负载均衡设备充当中介路由器。

这种类型的解决方案提供了稳定的性能,并且能够在服务器发生故障的情况下提供快速的故障转移。

2. 基于软件的负载均衡:在软件负载均衡中,我们可以使用特定的软件平台来进行负载均衡。

这种解决方案虽然比硬件负载均衡经济实惠,但是在处理高流量应用、高带宽网站等要求较高的应用时,性能可能有所损失。

3. DNS负载均衡:DNS负载均衡是一种基于DNS 域名解析管理的负载均衡方法。

当用户在浏览器中输入URL 时,DNS服务器将返回一个可用的IP 地址。

这种方法可以在多个服务器之间分散流量,但是可能会在故障转移方面面临一些挑战。

负载均衡元素负载均衡解决方案通常包含以下重要元素:1. 前端服务器:这是请求发送者与负载均衡设备之间的中介,在这个元素中,请求接收到负载均衡设备后会被转发到后端的服务器。

2. 负载均衡设备:这个设备可以确保在多个服务器上分配流量,它可以根据不同的负载均衡算法来选择最佳的服务器。

3. 后端服务器:这是实际处理请求的服务器,通常有多个,它们被负载均衡设备监测和管理。

4. 网络连接:网络连接是连接前端服务器、负载均衡设备和后端服务器的关键元素,一个稳定的网络连接可以确保流量有效地分配和处理。

负载均衡的策略在设计负载均衡解决方案时,选择适当的负载均衡策略非常重要。

以下是几种常用的策略:1. 轮流分配:这种策略会使负载均衡设备按顺序将请求发送到可用的服务器上。

负载均衡的实施方案

负载均衡的实施方案负载均衡是指在多台服务器之间分发工作负载,以确保每台服务器都能够有效地处理请求。

在大型网站和应用程序中,负载均衡是至关重要的,它可以提高系统的可靠性、可扩展性和性能。

下面我们将介绍一些负载均衡的实施方案。

首先,我们可以考虑使用硬件负载均衡器。

硬件负载均衡器是一种专门设计用于负载均衡的物理设备,它可以根据预先设定的算法将请求分发到多台服务器上。

硬件负载均衡器通常具有较高的性能和稳定性,能够有效地处理大量的请求流量。

此外,硬件负载均衡器还可以提供一些高级功能,如会话保持和健康检查,以进一步提高系统的可靠性和性能。

其次,我们可以考虑使用软件负载均衡器。

软件负载均衡器是一种运行在普通服务器上的软件程序,它可以通过网络将请求分发到多台服务器上。

与硬件负载均衡器相比,软件负载均衡器通常具有更低的成本,并且可以在普通服务器上灵活部署。

常见的软件负载均衡器包括Nginx、HAProxy等,它们都具有良好的性能和稳定性,可以满足大部分负载均衡的需求。

另外,我们还可以考虑使用DNS负载均衡。

DNS负载均衡是一种通过DNS服务器将请求分发到多台服务器上的方式。

当客户端发起请求时,DNS服务器会根据预先设置的策略返回一个服务器的IP地址,从而实现负载均衡。

DNS负载均衡具有较低的成本和简单的部署方式,但是由于DNS服务器的缓存机制和TTL设置,可能会导致负载分发不均匀的问题。

最后,我们还可以考虑使用内容分发网络(CDN)来实现负载均衡。

CDN是一种通过在全球各地部署节点服务器来缓存和分发静态资源的技术,它可以有效地减轻源服务器的负载压力,并加速用户对内容的访问速度。

在使用CDN时,我们可以将动态内容和静态内容分开处理,动态内容由源服务器处理,静态内容由CDN节点服务器处理,从而实现负载均衡。

综上所述,负载均衡是保证系统可靠性、可扩展性和性能的重要手段,选择合适的负载均衡实施方案对于系统的稳定运行至关重要。

双机热备+负载均衡 线上方案.doc

双机热备+负载均衡线上方案双机热备+负载均衡线上方案(Heartbeat+DRBD+NFS+Keepalived+Lnmp)gotop对于网站服务器来说,可靠性之重要不用我多说,但要想做到可靠性一般需要昂贵的设备,这里最主要是就是数据同步用的共享磁盘了,磁盘柜+磁盘一共下来是20多万,这对于追求最高性价比的双机负载热备方案来说是极其不靠谱的,尤其是中小型企业,私有企业,一般经理是不会考虑这么高的成本的。

我们通常做都是四台服务器+一个磁盘柜子+千兆交换机,那么这个成本下来将近30万了,而且这个方案有个弊端就是存储依然存在单点故障,除非使用双控制+双电源+双主板设计的磁盘柜,但这种成本实在太高。

那是否有更为廉价的双机方案呢,很明显开源软件帮我们解决了成本问题!!!用Heartbeat+DRBD+NFS+Keepalived+Lnmp 等开源软件实现双机负载热备架构只需要两台服务器+一台全千兆交换机,这个成本是极其低廉的,我们做运维了就是要用技术来压榨硬件性能,用最低的成本实现最高的效能,不然天天谈论的性能优化有何用?堆叠硬件不是更好?那不是我们的目的,下面我们来看看这两台服务器的双机热备+负载均衡是如何实现并且稳定运行的。

这个方案是我给一个论坛做的,论坛15分钟在线8000人,以前放在IIS里面,并发连接6000-7000左右,我给设计的双机热备方案如下图:图一2011-10-1211:43:32上传下载附件(62.41KB)注意:第三台服务器可要可不要,我这里他由于成本问题,并没有采用第三台服务器,而是一共只有两台系统环境配置一,硬件配置:节点一(centosa):做主负载点,和主数据库压力负载点,必须高性能高稳定高I/O配置如下:CPU:双CPU(4核+4核)5405级别内存:8G组三通道DDR3ECC内存硬盘:1块1TB普通硬盘+2块300GSAS15K(15000转)硬盘网卡:2块千兆网卡节点二(centosb):做分担负载和备服务器,稳定第一CPU:双CPU(4核+4核)5405内存:8G组三通道DDR3ECC内存硬盘:1块1TB普通硬盘+3块300GSAS15K(15000转)硬盘网卡:2块千兆网卡注意:网卡极力建议用四块,这个架构对网络I/O要求极高,我这里只有两块,没办法,机房做不到,如果你是百兆交换机,拜托,你一定要用四块网卡二,操作系统配置1),所有服务器的操作系统版本:操作系统版本:CentOS5.764位操作系统官方下载地址:/centos/5/isos/x86_64/2),每台服务器的安装要求:节点一:分区:一共三块硬盘,不用组RAID第一块硬盘:系统占用一块,分区情况如下:/boot200MB/40GBswap交换分区8GB/data第一块硬盘的所有剩余空间第二块硬盘:不要分区,留给我自己分区第三块硬盘:不要分区,留给我自己分区系统安装安装规范最小化安装,字符界面安装去掉所有组件,只需要一个内核节点二:分区:一共三块硬盘,不用组RAID第一块硬盘:系统占用一块,分区情况如下:/boot500MB/40GBswap交换分区16GB/data第一块硬盘的所有剩余空间第二块硬盘:不要分区,留给我自己分区第三块硬盘:不要分区,留给我自己分区系统安装要求最小化安装,字符界面安装去掉所有组件,只需要一个内核三,交换机配置:注意:有条件最好用两台交换机,内网一台,外网一台如果只有一台交换机,划分两个VLAN,一个外网使用,一个内网使用四,目录规划用途/usr/local/src/lnmp:用来存放源码工具等等/data:用来存放所有数据和NFS以及DRBD的挂载/data/shell:用来存放所有管理脚本/data/mysql:用来挂载DRBD的mysql资源,以供mysql存放数据库/data/wwwnfs:用来挂载DRBD生成的www资源,以供两个节点挂载到各个节点的/data/www目录,以供论坛等程序数据使用/data/www:用来挂载NFS资源,用来存放论坛(网站)等程序数据双机热备+负载均衡具体配置一,先建立用户和目录吧:useradd-s/sbin/nologinwwwuseradd-s/sbin/nologinmysqlmkdir-p/dat a/mysqlmkdir-p/data/wwwmkdir-p/data/wwwnfsmkdir-p/data/shell 二,架构详解如果用LVS做均衡器拓扑图如下:图二2011-10-1212:18:52上传下载附件(158.59KB)如果用Nginx做均衡器拓扑图如下:图三2011-10-1212:27:51上传下载附件(184.31KB)我们这里用NGINX做均衡器,因此我用图三来拓扑,来讲讲这个拓扑的工作原理内网:1,DRBD网络存储创建出两个资源,一个mysql给mysql数据库同步用,一个www给web(论坛)数据NFS共享挂载用,虚拟出两个虚拟IP,一个是192.168.1.100,用来连接数据库,一个是192.168.1.200,用来给节点挂载NFS注意:NFS底下挂载了三次:DRBD挂载一次,文件系统挂载一次,客户端挂载一次2,Heartbeat来实现DRBD 的HA,同时虚拟出两个内网IP,并管理NFS,MySQL的启动和关闭外网:1,两个节点都用Nginx做均衡器,通过内网调度负载两个节点,实现内部均衡2,DNS配置双IP对应一个域名的方式来实现DNS轮询,实现外网均衡3,Keepalived使用双主(master)配置虚拟出两个虚拟IP:节点一12.12.12.100和节点二12.12.12.200,同时共外网访问,两个节点互为主从关系,当某个节点挂掉的时候,另外一个节点将同时是两个资源的master,同时拥有两个虚拟IP,实现资源转移我们知道DNS的缺点就是生效慢,分配资源不合理,理论上有可能把所有的请求都发送给同一节点,导致均衡不合理导致所有资源不可用,这里我们由于有了NGINX内部负载,就不怕DNS轮询不均衡了,因为NGINX 内部有严谨的调度方式,不管那台请求有多少,在内部都能实现理想的调度,这样就能把DNS负载均衡和NGINX完美结合,是硬件资源得到合理的利用,然后利用keepalive保证了每个节点的可靠性,几乎完美!三,LNMP架构配置两台服务器的一样配置这个我请看我发的这个帖子:注意一:这里MYSQL都不要初始化,不要启动!后面有专门的配置的注意二:nginx所有端口都改成8080,因为一会还要安装nginx来做均衡器并对外提供服务,所以不要用默认的80四,安装配置NFS兵马未动粮草先行,NFS是网站存放数据实现数据同步的基础,我们先安装上吧1,安装:服务器端要安装:nfs-utils:NFS主程序portmap:RPC 主程序客户端要安装:nfs-utils:NFS主程序portmap:RPC主程序由于我们这里一共只用了两台服务器,所以,这里客户端和服务器段是同一台机器,这点要注意了两个节点同时安装:1.yum-yinstallportmapnfs-utils复制代码2,配置:生存共享目录vi/etc/exports输入:1./data/wwwnfs192.168.1.0/24(rw,sync,anonuid=501,anongid=501)复制代码注意:/data/wwwnfs:就是给两个节点挂载的目录,所有网站程序都放在这里,实现论坛程序等数据的共享(同步)anonuid=501,anongid=501:这个表示客户端上任何用户进入到挂载目录都以uid=501和gid=501身份,我这里这个代表的是www用户3,启动:serviceportmapstartservicenfsstart切忌,必须先启动portmapchkconfig--level0123456nfsoffchkconfig--level0123456port mapon注意:portmap服务器必须常驻,且不收heartbeat管理;而nfs这必须要用heartbeat来管理他的启动和关闭,所以这里要关闭nfs开机自动启动同时要启动锁机制,因为同时有两个节点要使用同一份数据,所以需要有总裁,这个尤其是在NFS给mysql 用的时候是必须要用的,对于论坛或网站,要看情况,如果存在对同一文件同时修改的时候必须要启动NFS锁机制,如果没有这种情况,那么建议不要启动,启动了会降低NFS的性能:/sbin/rpc.lockdecho“/sbin/rpc.lockd“/etc/rc.local4,建立NFS的管理脚本有人奇怪了,nfs用RPM安装的,应该直接用servicenfsstart/stop即可啊,维护还要建立脚本呢,这里由于NFS 的启动关闭权要交给heartbeat处理,而默认/etc/init.d/nfs这个启动脚本在heartbeat处理的时候有问题,所以这里自己建立了一个vinfs输入:1.#!/bin/bash2.3.NFSD=/etc/rc.d/init.d/nfs4.NFSDPID=`/sbin/pidofn fsd`5.case$1in6.start)7.$NFS Dstart;8.;;9.stop)10.$NFSDstop;11.if[“$NFSDPID“!=““];then12.forNFSPIDin$NFSDPID13.do/bin/kill-9$ NFSPID;14.done15.fi16.;;17.*)18.echo“Syntaxincorrect.Youneedon eof{start|stop}“19.;;20.esac复制代码wq保存退出chmod+xnfsOK,NFS服务器端配置完毕。

双机解决方案范文

双机解决方案范文双机解决方案可分为两种类型:高可用性(HA)和负载平衡(LB)。

高可用性方案旨在确保在一个计算机或网络设备发生故障时,系统仍然可用。

负载平衡方案旨在将工作任务均匀地分配给多台计算机,以提高整体性能和可伸缩性。

在高可用性方案中,通常使用硬件或软件冗余来实现系统的冗余和容错能力。

硬件冗余包括使用多个独立的计算机系统、多个存储设备、多个网络设备和多个电源来提供系统。

软件冗余则是通过使用备份服务器、镜像磁盘或实时数据复制等技术来确保数据的备份和可用性。

一种常见的高可用性方案是使用双机热备。

这种方案中,两台计算机通过共享存储设备和网络连接连接在一起。

其中一台计算机(主服务器)处理所有的工作任务,而另一台计算机(备份服务器)则处于待命状态。

如果主服务器发生故障,备份服务器会立即接替其工作,并且系统的服务不会中断。

在负载平衡方案中,系统将工作任务平均分配给多台计算机,以提高整体的性能和可靠性。

负载平衡可以通过多种方式实现,包括基于硬件的负载平衡器、软件负载平衡器和DNS负载平衡。

硬件负载平衡器通常位于服务器和网络之间,通过监视和分配传入的请求来实现负载平衡。

软件负载平衡器是一种以软件形式实现的负载平衡器,通常运行在每台服务器上,通过监视和分配传入的请求来实现负载平衡。

DNS负载平衡是通过将请求分发到多个服务器的不同IP地址来实现负载平衡。

双机解决方案还可以与其他技术和方法结合使用,以提供更高级的功能和性能,例如故障转移、数据同步和自动扩展。

故障转移是指将工作任务从一个计算机系统或网络设备转移到另一个计算机系统或网络设备的过程。

这种过程可以手动完成,也可以通过自动故障转移软件来自动化。

数据同步是指将数据从一台计算机系统或网络设备复制到另一台计算机系统或网络设备的过程。

这可以通过实时数据复制、定期数据备份或增量备份等技术来实现。

自动扩展是指根据当前负载情况自动添加或删除计算机系统或网络设备的过程,以提供所需的计算和存储资源。

双线负载均衡、设备冗余地方案设计设计

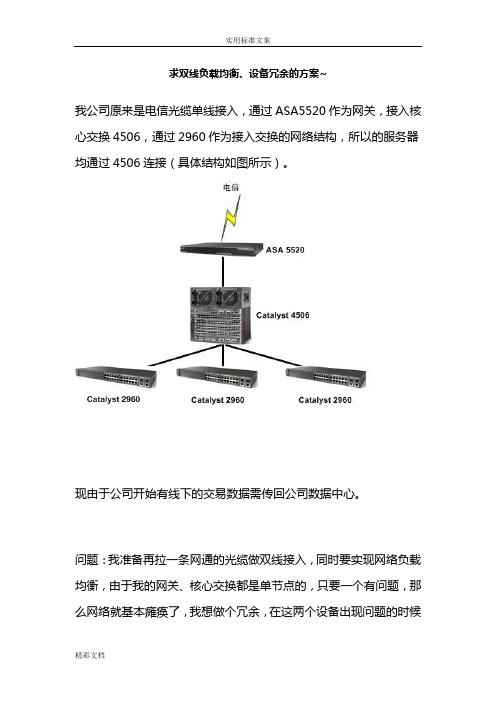

求双线负载均衡、设备冗余的方案~

我公司原来是电信光缆单线接入,通过ASA5520作为网关,接入核心交换4506,通过2960作为接入交换的网络结构,所以的服务器均通过4506连接(具体结构如图所示)。

现由于公司开始有线下的交易数据需传回公司数据中心。

问题:我准备再拉一条网通的光缆做双线接入,同时要实现网络负载均衡,由于我的网关、核心交换都是单节点的,只要一个有问题,那么网络就基本瘫痪了,我想做个冗余,在这两个设备出现问题的时候

能自动切换到备用设备上继续工作,请问该如何实施呢?需要添置什么设备?请问有实施方案推荐给我学习学习吗?

由于我是新手,请各位不吝指教。

看了各位的回答,很精彩也很感谢!下面我把一个厂商出的方案的拓扑给发上来,其中的上网行为管理设备和VPN设备是我公司要求的,因为我希望对内网的上网行为进行管控,以及让线下的客户通过VPN接入,请大家给给点建议!!!

方案1:

方案2:

双设备。

核心交换机采用HSRP负载分担,,,ASA采用FAILOVER技术。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

求双线负载均衡、设备冗余的方案~

我公司原来是电信光缆单线接入,通过ASA5520作为网关,接入核心交换4506,通过2960作为接入交换的网络结构,所以的服务器均通过4506连接(具体结构如图所示)。

现由于公司开始有线下的交易数据需传回公司数据中心。

问题:我准备再拉一条网通的光缆做双线接入,同时要实现网络负载均衡,由于我的网关、核心交换都是单节点的,只要一个有问题,那么网络就基本瘫痪了,我想做个冗余,在这两个设备出现问题的时候

能自动切换到备用设备上继续工作,请问该如何实施呢?需要添置什么设备?请问有实施方案推荐给我学习学习吗?

由于我是新手,请各位不吝指教。

看了各位的回答,很精彩也很感谢!下面我把一个厂商出的方案的拓扑给发上来,其中的上网行为管理设备和VPN设备是我公司要求的,因为我希望对内网的上网行为进行管控,以及让线下的客户通过VPN接入,请大家给给点建议!!!

方案1:

方案2:

双设备。

核心交换机采用HSRP负载分担,,,ASA采用FAILOVER技术。