matlab30个案例分析案例14-SVM神经网络的回归预测分析

在Matlab中实现神经网络的方法与实例

在Matlab中实现神经网络的方法与实例神经网络是一种模拟人类大脑神经系统的计算模型,它能够通过学习数据的模式和关联性来解决各种问题。

在计算机科学和人工智能领域,神经网络被广泛应用于图像识别、自然语言处理、预测等任务。

而Matlab作为一种功能强大的科学计算软件,提供了一套完善的工具箱,可以方便地实现神经网络的建模和训练。

本文将介绍在Matlab中实现神经网络的方法与实例。

首先,我们会简要介绍神经网络的基本原理和结构,然后详细讲解在Matlab中如何创建并训练神经网络模型,最后通过几个实例展示神经网络在不同领域的应用。

一、神经网络的原理和结构神经网络模型由神经元和它们之间的连接构成。

每个神经元接收输入信号,并通过权重和偏置进行加权计算,然后使用激活函数对结果进行非线性变换。

这样,神经网络就能够模拟复杂的非线性关系。

常见的神经网络结构包括前馈神经网络(Feedforward Neural Network)和循环神经网络(Recurrent Neural Network)。

前馈神经网络是最基本的结构,信号只能向前传递,输出不对网络进行反馈;而循环神经网络具有反馈连接,可以对自身的输出进行再处理,适用于序列数据的建模。

神经网络的训练是通过最小化损失函数来优化模型的参数。

常用的训练算法包括梯度下降法和反向传播算法。

其中,梯度下降法通过计算损失函数对参数的梯度来更新参数;反向传播算法是梯度下降法在神经网络中的具体应用,通过反向计算梯度来更新网络的权重和偏置。

二、在Matlab中创建神经网络模型在Matlab中,可以通过Neural Network Toolbox来创建和训练神经网络模型。

首先,我们需要定义神经网络的结构,包括输入层、隐藏层和输出层的神经元数量,以及每个神经元之间的连接权重。

例如,我们可以创建一个三层的前馈神经网络模型:```matlabnet = feedforwardnet([10 8]);```其中,`[10 8]`表示隐藏层的神经元数量分别为10和8。

MATLAB智能算法30个重点学习的案例解析总结模板计划模板终极版本带目录.doc

MATLAB 智能算法30 个案例分析(终极版)1 基于遗传算法的TSP算法(王辉)基于遗传算法和非线性规划的函数寻优算法(史峰)基于遗传算法的 BP神经网络优化算法(王辉)设菲尔德大学的 MATLAB遗传算法工具箱(王辉)基于遗传算法的 LQR控制优化算法(胡斐)遗传算法工具箱详解及应用(胡斐)多种群遗传算法的函数优化算法(王辉)基于量子遗传算法的函数寻优算法(王辉)多目标 Pareto 最优解搜索算法(胡斐)基于多目标 Pareto 的二维背包搜索算法(史峰)基于免疫算法的柔性车间调度算法(史峰)基于免疫算法的运输中心规划算法(史峰)基于粒子群算法的函数寻优算法(史峰)基于粒子群算法的 PID 控制优化算法(史峰)基于混合粒子群算法的 TSP寻优算法(史峰)基于动态粒子群算法的动态环境寻优算法(史峰)粒子群算法工具箱(史峰)基于鱼群算法的函数寻优算法(王辉)基于模拟退火算法的 TSP算法(王辉)基于遗传模拟退火算法的聚类算法(王辉)基于模拟退火算法的 HEV能量管理策略参数优化(胡斐)22 蚁群算法的优化计算——旅行商问题(TSP)优化(郁磊)基于蚁群算法的二维路径规划算法(史峰)基于蚁群算法的三维路径规划算法(史峰)有导师学习神经网络的回归拟合——基于近红外光谱的汽油辛烷值预测(郁磊)有导师学习神经网络的分类——鸢尾花种类识别(郁磊)无导师学习神经网络的分类——矿井突水水源判别(郁磊)支持向量机的分类——基于乳腺组织电阻抗特性的乳腺癌诊断(郁磊)支持向量机的回归拟合——混凝土抗压强度预测(郁磊)极限学习机的回归拟合及分类——对比实验研究(郁磊)智能算法是我们在学习中经常遇到的算法,主要包括遗传算法,免疫算法,粒子群算法,神经网络等,智能算法对于很多人来说,既爱又恨,爱是因为熟练的掌握几种智能算法,能够很方便的解决我们的论坛问题,恨是因为智能算法感觉比较“玄乎” ,很难理解,更难用它来解决问题。

用MATLAB求解回归分析讲解共28页文档

谢谢你的阅读

❖ 知识就是财富 ❖ 丰富你的人生

71、既然我已经踏上这条道路,那么,任何东西都不应妨碍我沿着这条路走下去。——康德 72、家庭ห้องสมุดไป่ตู้为快乐的种子在外也不致成为障碍物但在旅行之际却是夜间的伴侣。——西塞罗 73、坚持意志伟大的事业需要始终不渝的精神。——伏尔泰 74、路漫漫其修道远,吾将上下而求索。——屈原 75、内外相应,言行相称。——韩非

用MATLAB求解回归分析讲 解

31、别人笑我太疯癫,我笑他人看不 穿。(名 言网) 32、我不想听失意者的哭泣,抱怨者 的牢骚 ,这是 羊群中 的瘟疫 ,我不 能被它 传染。 我要尽 量避免 绝望, 辛勤耕 耘,忍 受苦楚 。我一 试再试 ,争取 每天的 成功, 避免以 失败收 常在别 人停滞 不前时 ,我继 续拼搏 。

33、如果惧怕前面跌宕的山岩,生命 就永远 只能是 死水一 潭。 34、当你眼泪忍不住要流出来的时候 ,睁大 眼睛, 千万别 眨眼!你会看到 世界由 清晰变 模糊的 全过程 ,心会 在你泪 水落下 的那一 刻变得 清澈明 晰。盐 。注定 要融化 的,也 许是用 眼泪的 方式。

35、不要以为自己成功一次就可以了 ,也不 要以为 过去的 光荣可 以被永 远肯定 。

Matlab技术神经网络优化应用案例

Mat1ab技术神经网络优化应用案例随着人工智能和机器学习的快速发展,神经网络成为了解决复杂问题的重要工具。

而在神经网络中,优化算法则是提高网络性能和准确性的关键。

本文将以Mauab技术为基础,介绍神经网络优化的应用案例。

一、神经网络与优化算法神经网络是一种模仿人脑神经系统的计算模型,通过模拟神经元之间的连接和信息传递来实现人工智能。

而优化算法则是指通过调整网络中的权重和偏置等参数,使得网络的输出结果尽可能地接近期望值。

在神经网络的训练过程中,优化算法起到了至关重要的作用。

常见的优化算法包括梯度下降法、遗传算法、粒子群算法等。

而Mauab作为一种强大的数学工具和编程语言,为神经网络的优化提供了丰富的支持和工具。

二、基于MatIab的神经网络优化案例1.图像识别在图像识别领域,神经网络具有广泛的应用。

例如,我们可以利用神经网络识别手写数字。

首先,我们需要提供大量的手写数字样本作为训练集,然后使用MaUab中的神经网络工具箱搭建一个适当的神经网络结构。

接下来,我们可以使用优化算法对网络中的权重和偏置进行调优,以提高识别准确率。

通过迭代优化过程,不断调整网络参数,使得网络能够对手写数字进行准确的判断和识别。

2.金融市场预测神经网络在金融市场的预测也有广泛的应用。

以股票市场为例,我们可以利用神经网络来预测股票价格的变化趋势。

首先,我们需要收集一段时间内的历史股票价格数据,作为训练集。

然后,利用Mat1ab中的神经网络工具箱搭建一个能够接受历史数据并输出价格预测的神经网络结构。

接着,我们可以使用优化算法对网络参数进行调整,使得网络能够更好地拟合历史数据,并对未来的价格变化作出准确的预测。

3.机器人控制在机器人控制领域,神经网络可以用来优化机器人的运动过程。

例如,我们可以利用神经网络来控制机器人的路径规划和运动轨迹。

首先,我们需要将机器人的运动环境建模,并将其转化为输入-输出映射的训练数据。

接着,利用Mauab中的神经网络工具箱搭建一个能够接受环境输入并输出机器人运动指令的神经网络结构。

matlab神经网络43个案例分析

MATLAB神经网络43个案例分析简介神经网络(Neural Network)是一种模拟人类神经元行为的计算模型,它通过对大量输入数据进行训练,学习到输入和输出之间的复杂关系。

MATLAB是一个强大的数学计算工具,具有丰富的神经网络函数和工具箱,可以用于神经网络的设计、训练和应用。

本文将介绍43个使用MATLAB进行神经网络分析的案例,主要包括神经网络的基本概念、神经网络模型的建立、参数的调整和优化等方面。

二级标题1: 基本概念在开始具体的案例分析之前,首先理解神经网络的基本概念是非常重要的。

三级标题1: 神经元神经网络的基本单元是神经元(Neuron),它模拟了生物神经元的工作原理。

神经元接收多个输入信号,并通过一个激活函数产生输出信号。

常用的激活函数包括Sigmoid函数、ReLU函数等。

三级标题2: 神经网络的结构神经网络由多层神经元组成,通常包括输入层、隐藏层和输出层。

输入层接收外部输入,隐藏层用于处理中间信息,输出层产生最终的输出。

三级标题3: 前向传播和反向传播神经网络的训练过程主要包括前向传播和反向传播两个步骤。

前向传播是通过输入数据按照网络结构进行计算,得到输出结果。

反向传播是根据输出结果与真实结果之间的误差,通过调整网络参数来提高模型性能。

二级标题2: 案例分析三级标题4: 案例1: 图像分类本案例通过使用神经网络和MATLAB工具箱,对手写数字图像进行分类。

首先,将图像数据转化为向量形式,并通过网络进行训练。

然后,将训练好的网络用于分类未知图像,并评估分类性能。

三级标题5: 案例2: 时序预测本案例使用神经网络来预测时间序列数据。

通过对历史数据进行训练,建立时序模型,并利用该模型来预测未来的数据。

通过调整网络结构和参数,提高预测准确性。

三级标题6: 案例3: 异常检测本案例利用神经网络进行异常检测。

通过对正常数据进行训练,建立正常模型,并使用该模型检测异常数据。

通过调整网络的灵敏度和阈值,提高异常检测的性能。

matlab智能算法30个案例分析

matlab智能算法30个案例分析Matlab智能算法30个案例分析。

Matlab作为一种强大的数学软件,拥有丰富的算法库和强大的编程能力,能够实现各种复杂的智能算法。

本文将针对Matlab智能算法进行30个案例分析,帮助读者深入了解Matlab在智能算法领域的应用和实践。

1. 遗传算法。

遗传算法是一种模拟自然选择和遗传机制的优化算法,能够有效解决复杂的优化问题。

在Matlab中,可以利用遗传算法工具箱快速实现各种优化问题的求解,例如函数最小化、参数优化等。

2. 神经网络。

神经网络是一种模拟人脑神经元网络的计算模型,能够实现复杂的非线性映射和模式识别。

Matlab提供了丰富的神经网络工具箱,可以用于神经网络的建模、训练和应用,例如分类、回归、聚类等任务。

3. 模糊逻辑。

模糊逻辑是一种处理不确定性和模糊信息的逻辑推理方法,能够有效处理模糊规则和模糊数据。

Matlab中的模糊逻辑工具箱提供了丰富的模糊推理方法和工具,可以用于模糊控制、模糊识别等领域。

4. 粒子群算法。

粒子群算法是一种模拟鸟群觅食行为的优化算法,能够有效处理多维优化问题。

在Matlab中,可以利用粒子群算法工具箱快速实现各种优化问题的求解,例如函数最小化、参数优化等。

5. 蚁群算法。

蚁群算法是一种模拟蚂蚁觅食行为的优化算法,能够有效处理离散优化问题和组合优化问题。

Matlab中的蚁群算法工具箱提供了丰富的蚁群优化方法和工具,可以用于解决各种组合优化问题。

6. 遗传规划算法。

遗传规划算法是一种结合遗传算法和规划算法的优化方法,能够有效处理复杂的规划问题。

在Matlab中,可以利用遗传规划算法工具箱快速实现各种规划问题的求解,例如路径规划、资源分配等。

7. 人工免疫算法。

人工免疫算法是一种模拟免疫系统的优化算法,能够有效处理多峰优化问题和动态优化问题。

在Matlab中,可以利用人工免疫算法工具箱快速实现各种复杂的优化问题的求解。

8. 蜂群算法。

MATLAB_智能算法30个案例分析

MATLAB_智能算法30个案例分析1.线性回归:使用MATLAB的回归工具箱,对给定的数据集进行线性回归分析,获取拟合的直线方程。

2.逻辑回归:使用MATLAB的分类工具箱,对给定的数据集进行逻辑回归分析,建立分类模型。

3.K均值聚类:使用MATLAB的聚类工具箱,对给定的数据集进行K 均值聚类算法,将数据集分为多个簇。

4.支持向量机:使用MATLAB的SVM工具箱,对给定的数据集进行支持向量机算法,建立分类或回归模型。

5.决策树:使用MATLAB的分类工具箱,对给定的数据集进行决策树分析,建立决策模型。

6.随机森林:使用MATLAB的分类和回归工具箱,对给定的数据集进行随机森林算法,集成多个决策树模型。

7. AdaBoost:使用MATLAB的分类工具箱,对给定的数据集进行AdaBoost算法,提升分类性能。

8.遗传算法:使用MATLAB的全局优化工具箱,利用遗传算法进行优化问题的求解。

9.粒子群优化:使用MATLAB的全局优化工具箱,利用粒子群优化算法进行优化问题的求解。

10.模拟退火算法:使用MATLAB的全局优化工具箱,利用模拟退火算法进行优化问题的求解。

11.神经网络:使用MATLAB的神经网络工具箱,构建和训练多层感知机模型。

12.卷积神经网络:使用MATLAB的深度学习工具箱,构建和训练卷积神经网络模型。

13.循环神经网络:使用MATLAB的深度学习工具箱,构建和训练循环神经网络模型。

14.长短期记忆网络:使用MATLAB的深度学习工具箱,构建和训练长短期记忆网络模型。

15.GAN(生成对抗网络):使用MATLAB的深度学习工具箱,构建和训练生成对抗网络模型。

16.自编码器:使用MATLAB的深度学习工具箱,构建和训练自编码器模型。

17.强化学习:使用MATLAB的强化学习工具箱,构建和训练强化学习模型。

18.关联规则挖掘:使用MATLAB的数据挖掘工具箱,发现数据中的关联规则。

MATLAB_智能算法30个案例分析

MATLAB_智能算法30个案例分析MATLAB是一种强大的数值计算和编程工具,教育和科研领域中广泛应用于数据分析、机器学习和智能算法的研究。

在本文中,我们将介绍30个MATLAB智能算法的案例分析,并探讨其用途和优势。

分析的案例包括分类、回归、聚类、神经网络和遗传算法等不同类型的智能算法。

1. K均值聚类:利用MATLAB中的kmeans函数对一组数据进行聚类分析,得到不同的簇。

2. 随机森林:利用MATLAB中的TreeBagger函数构建一个随机森林分类器,并通过测试数据进行分类预测。

3. 人工神经网络:使用MATLAB中的feedforwardnet函数构建一个人工神经网络,并通过训练集进行预测。

4. 遗传算法:利用MATLAB中的ga函数对一个优化问题进行求解,找到最优解。

5. 支持向量机:使用MATLAB中的svmtrain和svmclassify函数构建一个支持向量机分类器,并进行分类预测。

6. 极限学习机:使用MATLAB中的elmtrain和elmpredict函数构建一个极限学习机分类器,并进行分类预测。

7. 逻辑回归:使用MATLAB中的mnrfit和mnrval函数构建一个逻辑回归模型,并进行预测。

8. 隐马尔可夫模型:使用MATLAB中的hmmtrain和hmmdecode函数构建一个隐马尔可夫模型,对一系列观测数据进行预测。

9. 神经进化算法:利用MATLAB中的ne_train函数构建一个基于神经进化算法的神经网络分类器,并进行分类预测。

10. 朴素贝叶斯分类器:使用MATLAB中的NaiveBayes对象构建一个朴素贝叶斯分类器,并进行分类预测。

11. 高斯过程回归:使用MATLAB中的fitrgp函数构建一个高斯过程回归模型,并进行回归预测。

12. 最小二乘支持向量机:使用MATLAB中的fitcsvm函数构建一个最小二乘支持向量机分类器,并进行分类预测。

13. 遗传网络:利用MATLAB中的ngenetic函数构建一个基于遗传算法和人工神经网络的分类器,并进行分类预测。

MATLAB智能算法30个案例分析

MATLAB智能算法30个案例分析1.线性回归:通过拟合数据,预测未知的连续变量。

2.逻辑回归:基于已知输入和输出数据,通过对数斯蒂格回归模型,进行二元分类。

3.决策树:通过对已知数据进行分类预测,构建一棵决策树模型。

4.随机森林:通过构建多个决策树模型,进行分类和回归分析。

5.支持向量机:通过找到一个最优超平面,对数据进行二元分类。

6.高斯混合模型:基于多个高斯分布,对数据进行聚类分析。

7.K均值聚类:通过对数据进行分组,找到数据的簇结构。

8.主成分分析:找到最具有代表性的主成分,实现数据的降维和可视化。

9.独立成分分析:在多变量数据中,找到相互独立的成分。

10.关联规则挖掘:通过分析大规模数据集,找到数据项之间的关联规则。

11.朴素贝叶斯分类器:基于贝叶斯理论,进行分类和预测。

12.遗传算法:通过模拟进化过程,找到最优解。

13.粒子群算法:通过模拟粒子在空间中的移动,优化问题的解。

14.蚁群算法:通过模拟蚂蚁在空间中的行为,解决优化问题。

15.神经网络:通过多层神经元之间的连接,进行模式识别和预测。

16.卷积神经网络:通过卷积层和池化层,进行图像分类和目标检测。

17.循环神经网络:通过循环连接,进行时间序列预测和自然语言处理。

18.支持张量分解的非负矩阵分解:通过分解张量,进行数据降维和特征提取。

19.马尔科夫链:通过状态转移概率,对随机过程进行建模和分析。

20.K最近邻算法:通过找到与未知样本最接近的训练样本,进行分类和回归分析。

21.高斯过程回归:利用高斯过程进行回归分析和置信区间估计。

22.隐马尔科夫模型:通过观测序列推断隐藏状态序列。

23.时序聚类:通过对时间序列数据进行聚类分析,找到相似的模式。

24.大规模机器学习:通过将数据划分为小批量,进行机器学习模型的训练。

25.非线性最小二乘:通过最小化非线性函数的残差平方和,拟合数据。

26.分类集成学习:通过结合多个分类器的预测结果,提高分类准确率。

matlab30个案例分析案例13-SVM神经网络中的参数优化

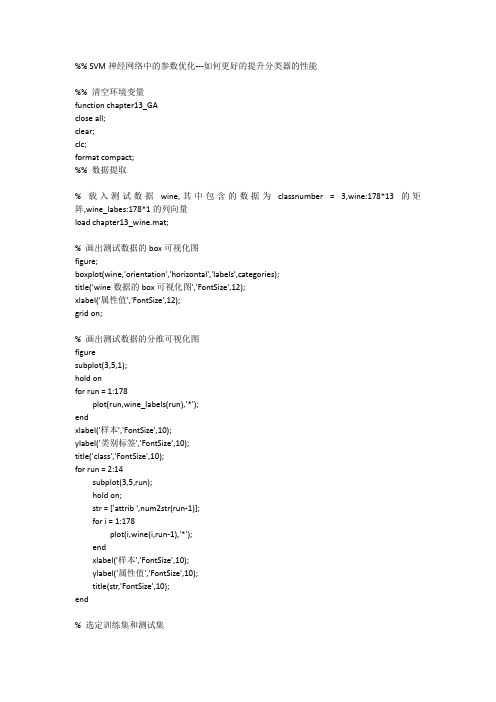

%% SVM神经网络中的参数优化---如何更好的提升分类器的性能%% 清空环境变量function chapter13_GAclose all;clear;clc;format compact;%% 数据提取% 载入测试数据wine,其中包含的数据为classnumber = 3,wine:178*13的矩阵,wine_labes:178*1的列向量load chapter13_wine.mat;% 画出测试数据的box可视化图figure;boxplot(wine,'orientation','horizontal','labels',categories);title('wine数据的box可视化图','FontSize',12);xlabel('属性值','FontSize',12);grid on;% 画出测试数据的分维可视化图figuresubplot(3,5,1);hold onfor run = 1:178plot(run,wine_labels(run),'*');endxlabel('样本','FontSize',10);ylabel('类别标签','FontSize',10);title('class','FontSize',10);for run = 2:14subplot(3,5,run);hold on;str = ['attrib ',num2str(run-1)];for i = 1:178plot(i,wine(i,run-1),'*');endxlabel('样本','FontSize',10);ylabel('属性值','FontSize',10);title(str,'FontSize',10);end% 选定训练集和测试集% 将第一类的1-30,第二类的60-95,第三类的131-153做为训练集train_wine = [wine(1:30,:);wine(60:95,:);wine(131:153,:)];% 相应的训练集的标签也要分离出来train_wine_labels = [wine_labels(1:30);wine_labels(60:95);wine_labels(131:153)];% 将第一类的31-59,第二类的96-130,第三类的154-178做为测试集test_wine = [wine(31:59,:);wine(96:130,:);wine(154:178,:)];% 相应的测试集的标签也要分离出来test_wine_labels = [wine_labels(31:59);wine_labels(96:130);wine_labels(154:178)];%% 数据预处理% 数据预处理,将训练集和测试集归一化到[0,1]区间[mtrain,ntrain] = size(train_wine);[mtest,ntest] = size(test_wine);dataset = [train_wine;test_wine];% mapminmax为MATLAB自带的归一化函数[dataset_scale,ps] = mapminmax(dataset',0,1);dataset_scale = dataset_scale';train_wine = dataset_scale(1:mtrain,:);test_wine = dataset_scale( (mtrain+1):(mtrain+mtest),: );%% 选择GA最佳的SVM参数c&g% GA的参数选项初始化ga_option.maxgen = 200;ga_option.sizepop = 20;ga_option.cbound = [0,100];ga_option.gbound = [0,100];ga_option.v = 5;ga_option.ggap = 0.9;[bestacc,bestc,bestg] = gaSVMcgForClass(train_wine_labels,train_wine,ga_option);% 打印选择结果disp('打印选择结果');str = sprintf( 'Best Cross Validation Accuracy = %g%% Best c = %g Best g = %g',bestacc,bestc,bestg);disp(str);%% 利用最佳的参数进行SVM网络训练cmd = ['-c ',num2str(bestc),' -g ',num2str(bestg)];model = svmtrain(train_wine_labels,train_wine,cmd);%% SVM网络预测[predict_label,accuracy] = svmpredict(test_wine_labels,test_wine,model);% 打印测试集分类准确率total = length(test_wine_labels);right = sum(predict_label == test_wine_labels);disp('打印测试集分类准确率');str = sprintf( 'Accuracy = %g%% (%d/%d)',accuracy(1),right,total);disp(str);%% 结果分析% 测试集的实际分类和预测分类图figure;hold on;plot(test_wine_labels,'o');plot(predict_label,'r*');xlabel('测试集样本','FontSize',12);ylabel('类别标签','FontSize',12);legend('实际测试集分类','预测测试集分类');title('测试集的实际分类和预测分类图','FontSize',12);grid on;snapnow;%% 子函数gaSVMcgForClass.mfunction [BestCVaccuracy,Bestc,Bestg,ga_option] = gaSVMcgForClass(train_label,train_data,ga_option)% gaSVMcgForClass%% by faruto%Email:patrick.lee@ QQ:516667408 /faruto BNU%last modified 2010.01.17%Super Moderator @ % 若转载请注明:% faruto and liyang , LIBSVM-farutoUltimateVersion% a toolbox with implements for support vector machines based on libsvm, 2009.% Software available at %% Chih-Chung Chang and Chih-Jen Lin, LIBSVM : a library for% support vector machines, 2001. Software available at% .tw/~cjlin/libsvm% 参数初始化if nargin == 2ga_option = struct('maxgen',200,'sizepop',20,'ggap',0.9,...'cbound',[0,100],'gbound',[0,1000],'v',5);end% maxgen:最大的进化代数,默认为200,一般取值范围为[100,500]% sizepop:种群最大数量,默认为20,一般取值范围为[20,100]% cbound = [cmin,cmax],参数c的变化范围,默认为(0,100]% gbound = [gmin,gmax],参数g的变化范围,默认为[0,1000]% v:SVM Cross Validation参数,默认为5%MAXGEN = ga_option.maxgen;NIND = ga_option.sizepop;NVAR = 2;PRECI = 20;GGAP = ga_option.ggap;trace = zeros(MAXGEN,2);FieldID = ...[rep([PRECI],[1,NVAR]);[ga_option.cbound(1),ga_option.gbound(1);ga_option.cbound(2),ga_opti on.gbound(2)]; ...[1,1;0,0;0,1;1,1]];Chrom = crtbp(NIND,NVAR*PRECI);gen = 1;v = ga_option.v;BestCVaccuracy = 0;Bestc = 0;Bestg = 0;%cg = bs2rv(Chrom,FieldID);for nind = 1:NINDcmd = ['-v ',num2str(v),' -c ',num2str(cg(nind,1)),' -g ',num2str(cg(nind,2))];ObjV(nind,1) = svmtrain(train_label,train_data,cmd);end[BestCVaccuracy,I] = max(ObjV);Bestc = cg(I,1);Bestg = cg(I,2);for gen = 1:MAXGENFitnV = ranking(-ObjV);SelCh = select('sus',Chrom,FitnV,GGAP);SelCh = recombin('xovsp',SelCh,0.7);SelCh = mut(SelCh);cg = bs2rv(SelCh,FieldID);for nind = 1:size(SelCh,1)cmd = ['-v ',num2str(v),' -c ',num2str(cg(nind,1)),' -g ',num2str(cg(nind,2))];ObjVSel(nind,1) = svmtrain(train_label,train_data,cmd);end[Chrom,ObjV] = reins(Chrom,SelCh,1,1,ObjV,ObjVSel);if max(ObjV) <= 50continue;end[NewBestCVaccuracy,I] = max(ObjV);cg_temp = bs2rv(Chrom,FieldID);temp_NewBestCVaccuracy = NewBestCVaccuracy;if NewBestCVaccuracy > BestCVaccuracyBestCVaccuracy = NewBestCVaccuracy;Bestc = cg_temp(I,1);Bestg = cg_temp(I,2);endif abs( NewBestCVaccuracy-BestCVaccuracy ) <= 10^(-2) && ...cg_temp(I,1) < BestcBestCVaccuracy = NewBestCVaccuracy;Bestc = cg_temp(I,1);Bestg = cg_temp(I,2);endtrace(gen,1) = max(ObjV);trace(gen,2) = sum(ObjV)/length(ObjV);end%figure;hold on;trace = round(trace*10000)/10000;plot(trace(1:gen,1),'r*-','LineWidth',1.5);plot(trace(1:gen,2),'o-','LineWidth',1.5);legend('最佳适应度','平均适应度',3);xlabel('进化代数','FontSize',12);ylabel('适应度','FontSize',12);axis([0 gen 0 100]);grid on;axis auto;line1 = '适应度曲线Accuracy[GAmethod]';line2 = ['(终止代数=', ...num2str(gen),',种群数量pop=', ...num2str(NIND),')'];line3 = ['Best c=',num2str(Bestc),' g=',num2str(Bestg), ...' CVAccuracy=',num2str(BestCVaccuracy),'%'];title({line1;line2;line3},'FontSize',12);。

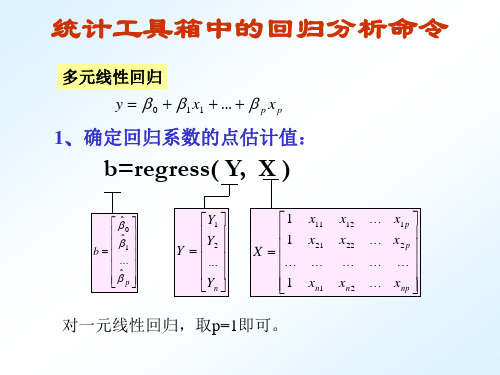

用MATLAB求解回归分析

1. 对回归模型建立M文件model.m如下: function yy=model(beta0,X) a=beta0(1); b=beta0(2); c=beta0(3); d=beta0(4); e=beta0(5); f=beta0(6); x1=X(:,1); x2=X(:,2); x3=X(:,3); x4=X(:,4); x5=X(:,5); x6=X(:,6); yy=a*x1+b*x2+c*x3+d*x4+e*x5+f*x6;

例 2 观测物体降落的距离 s 与时间 t 的关系,得到数据如下表, 求 s 关于 t 的回归方程 sˆ a bt ct 2 .

t (s)

1/30

2/30

3/30

4/30

5/30

6/30

7/30

s (cm) 11.86

15.67

20.60

26.69

33.71

41.93

51.13

t (s) s (cm)

回归系数 的初值

(2)非线性回归命令:nlintool(x,y,’model’, beta0,alpha)

2、预测和预测误差估计: [Y,DELTA]=nlpredci(’model’, x,beta,r,J)

求nlinfit 或nlintool所得的回归函数在x处的预测值Y及预测值的显 著性为1-alpha的置信区间Y DELTA.

80

70

50

65

90

100 110 60

收入 1000 600 1200 500 300 400 1300 1100 1300 300

价格 5

7

6

6

8

7

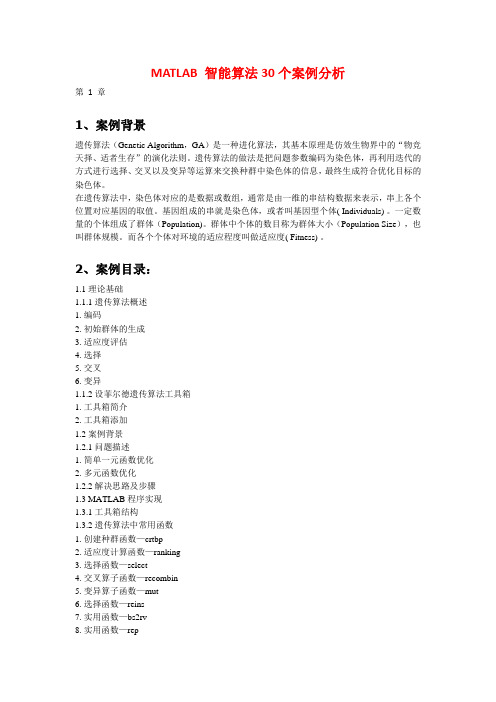

MATLAB智能算法30个案例分析

MATLAB 智能算法30个案例分析第1 章1、案例背景遗传算法(Genetic Algorithm,GA)是一种进化算法,其基本原理是仿效生物界中的“物竞天择、适者生存”的演化法则。

遗传算法的做法是把问题参数编码为染色体,再利用迭代的方式进行选择、交叉以及变异等运算来交换种群中染色体的信息,最终生成符合优化目标的染色体。

在遗传算法中,染色体对应的是数据或数组,通常是由一维的串结构数据来表示,串上各个位置对应基因的取值。

基因组成的串就是染色体,或者叫基因型个体( Individuals) 。

一定数量的个体组成了群体(Population)。

群体中个体的数目称为群体大小(Population Size),也叫群体规模。

而各个个体对环境的适应程度叫做适应度( Fitness) 。

2、案例目录:1.1 理论基础1.1.1 遗传算法概述1. 编码2. 初始群体的生成3. 适应度评估4. 选择5. 交叉6. 变异1.1.2 设菲尔德遗传算法工具箱1. 工具箱简介2. 工具箱添加1.2 案例背景1.2.1 问题描述1. 简单一元函数优化2. 多元函数优化1.2.2 解决思路及步骤1.3 MATLAB程序实现1.3.1 工具箱结构1.3.2 遗传算法中常用函数1. 创建种群函数—crtbp2. 适应度计算函数—ranking3. 选择函数—select4. 交叉算子函数—recombin5. 变异算子函数—mut6. 选择函数—reins7. 实用函数—bs2rv8. 实用函数—rep1.3.3 遗传算法工具箱应用举例1. 简单一元函数优化2. 多元函数优化1.4 延伸阅读1.5 参考文献3、主程序:1. 简单一元函数优化:clcclear allclose all%% 画出函数图figure(1);hold on;lb=1;ub=2; %函数自变量范围【1,2】ezplot('sin(10*pi*X)/X',[lb,ub]); %画出函数曲线xlabel('自变量/X')ylabel('函数值/Y')%% 定义遗传算法参数NIND=40; %个体数目MAXGEN=20; %最大遗传代数PRECI=20; %变量的二进制位数GGAP=0.95; %代沟px=0.7; %交叉概率pm=0.01; %变异概率trace=zeros(2,MAXGEN); %寻优结果的初始值FieldD=[PRECI;lb;ub;1;0;1;1]; %区域描述器Chrom=crtbp(NIND,PRECI); %初始种群%% 优化gen=0; %代计数器X=bs2rv(Chrom,FieldD); %计算初始种群的十进制转换ObjV=sin(10*pi*X)./X; %计算目标函数值while gen<MAXGENFitnV=ranking(ObjV); %分配适应度值SelCh=select('sus',Chrom,FitnV,GGAP); %选择SelCh=recombin('xovsp',SelCh,px); %重组SelCh=mut(SelCh,pm); %变异X=bs2rv(SelCh,FieldD); %子代个体的十进制转换ObjVSel=sin(10*pi*X)./X; %计算子代的目标函数值[Chrom,ObjV]=reins(Chrom,SelCh,1,1,ObjV,ObjVSel); %重插入子代到父代,得到新种群X=bs2rv(Chrom,FieldD);gen=gen+1; %代计数器增加%获取每代的最优解及其序号,Y为最优解,I为个体的序号[Y,I]=min(ObjV);trace(1,gen)=X(I); %记下每代的最优值trace(2,gen)=Y; %记下每代的最优值endplot(trace(1,:),trace(2,:),'bo'); %画出每代的最优点grid on;plot(X,ObjV,'b*'); %画出最后一代的种群hold off%% 画进化图figure(2);plot(1:MAXGEN,trace(2,:));grid onxlabel('遗传代数')ylabel('解的变化')title('进化过程')bestY=trace(2,end);bestX=trace(1,end);fprintf(['最优解:\nX=',num2str(bestX),'\nY=',num2str(bestY),'\n'])2. 多元函数优化clcclear allclose all%% 画出函数图figure(1);lbx=-2;ubx=2; %函数自变量x范围【-2,2】lby=-2;uby=2; %函数自变量y范围【-2,2】ezmesh('y*sin(2*pi*x)+x*cos(2*pi*y)',[lbx,ubx,lby,uby],50); %画出函数曲线hold on;%% 定义遗传算法参数NIND=40; %个体数目MAXGEN=50; %最大遗传代数PRECI=20; %变量的二进制位数GGAP=0.95; %代沟px=0.7; %交叉概率pm=0.01; %变异概率trace=zeros(3,MAXGEN); %寻优结果的初始值FieldD=[PRECI PRECI;lbx lby;ubx uby;1 1;0 0;1 1;1 1]; %区域描述器Chrom=crtbp(NIND,PRECI*2); %初始种群%% 优化gen=0; %代计数器XY=bs2rv(Chrom,FieldD); %计算初始种群的十进制转换X=XY(:,1);Y=XY(:,2);ObjV=Y.*sin(2*pi*X)+X.*cos(2*pi*Y); %计算目标函数值while gen<MAXGENFitnV=ranking(-ObjV); %分配适应度值SelCh=select('sus',Chrom,FitnV,GGAP); %选择SelCh=recombin('xovsp',SelCh,px); %重组SelCh=mut(SelCh,pm); %变异XY=bs2rv(SelCh,FieldD); %子代个体的十进制转换X=XY(:,1);Y=XY(:,2);ObjVSel=Y.*sin(2*pi*X)+X.*cos(2*pi*Y); %计算子代的目标函数值[Chrom,ObjV]=reins(Chrom,SelCh,1,1,ObjV,ObjVSel); %重插入子代到父代,得到新种群XY=bs2rv(Chrom,FieldD);gen=gen+1; %代计数器增加%获取每代的最优解及其序号,Y为最优解,I为个体的序号[Y,I]=max(ObjV);trace(1:2,gen)=XY(I,:); %记下每代的最优值trace(3,gen)=Y; %记下每代的最优值endplot3(trace(1,:),trace(2,:),trace(3,:),'bo'); %画出每代的最优点grid on;plot3(XY(:,1),XY(:,2),ObjV,'bo'); %画出最后一代的种群hold off%% 画进化图figure(2);plot(1:MAXGEN,trace(3,:));grid onxlabel('遗传代数')ylabel('解的变化')title('进化过程')bestZ=trace(3,end);bestX=trace(1,end);bestY=trace(2,end);fprintf(['最优解:\nX=',num2str(bestX),'\nY=',num2str(bestY),'\nZ=',num2str(bestZ), '\n']) 第2 章基于遗传算法和非线性规划的函数寻优算法1.1案例背景1.1.1 非线性规划方法非线性规划是20世纪50年代才开始形成的一门新兴学科。

在Matlab中进行回归分析和预测模型的技术

在Matlab中进行回归分析和预测模型的技术在当今数据驱动的社会中,回归分析和预测模型成为了数据科学领域中不可或缺的技术。

在这方面,Matlab作为一个功能强大且广泛应用的数学软件包,为进行回归分析和预测模型提供了丰富的工具和函数。

本文将探讨在Matlab中使用回归分析进行数据建模和预测的技术。

首先,回归分析是一种通过建立一个数学方程来描述变量之间关系的统计方法。

它常用于研究自变量(也称为预测变量)与因变量之间的关系。

在Matlab中,回归分析主要通过线性回归模型来实现。

线性回归模型假设因变量与自变量之间存在线性关系。

在Matlab中,可以使用regress函数来拟合线性回归模型。

该函数可以通过最小二乘法估计回归系数,使得预测变量与实际观测值之间的残差平方和最小化。

除了线性回归模型,Matlab还提供了其他类型的回归模型,如多项式回归模型、岭回归模型和弹性网络回归模型等。

多项式回归模型通过增加自变量的多项式项来处理非线性关系。

岭回归模型和弹性网络回归模型则通过引入正则化项来解决多重共线性问题,提高模型的鲁棒性和预测能力。

在进行回归分析时,特征工程是一个重要的环节。

特征工程涉及到对原始数据进行处理和转换,以提取对模型建立和预测有用的特征。

在Matlab中,可以利用数据预处理工具箱来进行特征工程。

数据预处理工具箱提供了一系列函数和工具来处理数据中的缺失值、异常值和重复值,进行特征选择和降维,并进行数据标准化和归一化等操作。

通过合理的特征工程,可以提高模型的性能和准确度。

除了回归分析,预测模型在许多实际应用中也起着重要的作用。

预测模型可以根据历史数据和趋势来预测未来的趋势和行为。

在Matlab中,可以利用时间序列分析和神经网络等方法进行预测建模。

时间序列分析是一种用于预测未来数值的统计方法,广泛应用于经济学、金融学和气象学等领域。

在Matlab中,时间序列分析主要通过自回归(AR)模型和移动平均(MA)模型来实现。

用MATLAB求解回归分析课件

用Matlab求解 回归分析课件

目 录

• 回归分析简介 • Matlab基础操作 • 线性回归分析 • 非线性回归分析 • 多元回归分析 • Matlab在回归分析中的应用实例

01

CATALOGUE

回归分析简介

回归分析的定义

回归分析是一种统计学方法,用于研 究自变量和因变量之间的相关关系, 并建立数学模型来预测因变量的值。

显著性检验

对回归模型的显著性进行检验,如F 检验、t检验等。

预测精度评估

使用均方误差、均方根误差等指标评 估模型的预测精度。

可解释性

评估模型的解释性,即模型是否易于 理解,自变量对因变量的影响是否合 理。

06

CATALOGUE

Matlab在回归分析中的应用实例

用Matlab进行线性回归分析的实例

迭代法

对于一些复杂的回归模型,可能 需要使用迭代法进行求解,如梯 度下降法、牛顿法等。

Matlab函数

在Matlab中,可以使用内建的回 归分析函数来求解多元回归模型 ,如 `fitlm`、`fitlm2` 等。

多元回归模型的评估

残差分析

对回归模型的残差进行分析,检查残 差是否满足正态分布、同方差等假设 。

要点一

总结词

要点二

详细描述

多元回归分析是处理多个自变量和因变量之间关系的回归 分析方法,通过Matlab可以方便地进行多元回归分析。

在Matlab中,可以使用`fitlm`函数对一组数据进行多元回 归分析。首先需要准备数据,然后使用`fitlm`函数拟合多 元线性模型,最后通过模型进行预测和评估。

THANKS

使用预测值与实际值之间的误差评估模型的预测 能力,如均方误差、平均绝对误差等指标。

matlab神经网络43个案例分析

matlab神经网络43个案例分析MATLAB神经网络是一种广泛使用的机器学习工具,可以应用于多种问题的解决。

下面为大家介绍43个用MATLAB神经网络解决的案例分析。

1. 基于神经网络的股票市场预测通过分析历史数据,建立神经网络模型,预测未来股票市场走势。

2. 神经网络分类器建模分析通过建立分类模型,对不同类型数据进行分类处理。

3. 基于神经网络的信用评估模型通过收集客户的基本信息和信用历史,建立神经网络模型,对客户的信用进行评估。

4. 神经网络医学图像分析通过医学图像数据,建立神经网络模型,进行疾病诊断与分析。

5. 基于神经网络的机器人动作控制通过神经网络,训练机器人进行动作控制,提高机器人的智能化水平。

6. 神经网络预测库存需求通过分析历史销售数据,建立神经网络模型,预测未来库存需求,提高企业的运作效率。

7. 基于神经网络的人脸识别通过收集人脸数据,建立神经网络模型,实现人脸识别功能。

8. 神经网络垃圾邮件过滤通过建立神经网络模型,对邮件进行分类,筛选出垃圾邮件。

9. 基于神经网络的语音识别通过收集语音数据,建立神经网络模型,实现语音识别功能。

10. 神经网络飞机失速预测通过分析飞机数据和空气动力学知识,建立神经网络模型,预测飞机发生失速的概率。

11. 基于神经网络的目标识别通过收集目标数据,建立神经网络模型,实现目标识别功能。

12. 神经网络电力负荷预测通过历史电力数据,建立神经网络模型,预测未来电力负荷。

13. 基于神经网络的网络入侵检测通过建立神经网络模型,检测网络攻击行为。

14. 神经网络手写数字识别通过收集手写数字数据,建立神经网络模型,实现手写数字识别功能。

15. 基于神经网络的情感分析通过对情感文本数据进行分析,建立神经网络模型,实现情感分析功能。

16. 神经网络自然语言处理通过对自然语言文本数据进行处理和分析,建立神经网络模型,实现自然语言处理功能。

17. 基于神经网络的物体识别通过收集物体数据,建立神经网络模型,实现物体识别功能。

在Matlab中使用神经网络进行预测

在Matlab中使用神经网络进行预测引言预测未来是人类长久以来的梦想。

随着计算机技术的不断发展,神经网络作为一种重要的预测工具被广泛应用。

Matlab作为一种功能强大的软件工具,提供了丰富的函数和工具箱,使得神经网络在Matlab中的应用变得更加简单和高效。

本文将介绍在Matlab中使用神经网络进行预测的方法与技巧。

一、神经网络基础1.1 神经元与权重神经网络是由神经元和连接它们的权重构成的。

神经元类似于人类大脑中的神经元,能够接受输入并产生输出。

权重则表示了神经元之间相互连接的强度。

1.2 激活函数激活函数在神经网络中起到了非常重要的作用。

它将神经元输入的加权和映射到合适的范围,通常是非线性的。

常见的激活函数有Sigmoid函数、ReLU函数等。

二、神经网络的训练与预测2.1 数据准备在进行神经网络预测之前,需要准备好训练数据和测试数据。

训练数据用于训练神经网络的权重,而测试数据用于评估神经网络在未知数据上的表现。

2.2 网络设计与构建根据预测问题的特点和要求,选择合适的神经网络结构。

在Matlab中,可以使用Neural Network Toolbox来构建神经网络。

根据问题的复杂程度,可以选择单层感知器、多层感知器等不同类型的神经网络。

2.3 训练过程在Matlab中,可以使用trainlm、trainbfg等函数来训练神经网络。

在进行训练之前,需要设置好训练参数,如学习率、最大迭代次数等。

通过反向传播算法,神经网络根据训练数据不断调整权重,以使得预测结果与实际结果之间的误差最小。

2.4 预测过程训练完成后,可以使用trained network来进行预测。

在Matlab中,可以使用仿真函数来对已经训练好的神经网络进行仿真。

将测试数据输入到神经网络中,即可得到预测结果。

三、神经网络预测问题案例3.1 股票价格预测股票价格的预测一直是投资者关注的重点。

利用神经网络可以分析历史交易数据,预测未来股价的趋势。

MATLAB回归分析

MATLAB回归分析回归分析是一种通过建立数学模型来研究变量之间的关系的统计方法。

在MATLAB中,我们可以使用回归分析工具箱来进行回归分析。

回归分析的目标是找到一个能够最好地描述自变量和因变量之间关系的数学模型。

在这篇文章中,我们将介绍回归分析的基本原理、MATLAB中的回归分析工具箱的使用以及如何解释回归分析的结果。

回归分析的基本原理回归分析建立在线性回归的基础上。

线性回归假设因变量与自变量之间存在一个线性关系。

回归分析通过找到最佳拟合线来描述这种关系。

最常用的回归方程是一元线性回归方程,它可以表示为:y=β0+β1x+ε,其中y是因变量,x是自变量,β0和β1是回归系数,ε是误差项。

- regress函数:用于计算多元线性回归模型,并返回回归系数、截距和残差。

例如,[B, BINT, R]=regress(y, X)用于计算因变量y和自变量矩阵X之间的回归模型。

- fitlm函数:用于拟合线性回归模型并返回拟合对象。

例如,mdl= fitlm(X, y)用于拟合因变量y和自变量矩阵X之间的线性回归模型,并返回mdl拟合对象。

- plot函数:用于绘制回归分析的结果。

例如,plot(mdl)用于绘制fitlm函数返回的拟合对象mdl的结果。

- coefCI函数:用于计算回归系数的置信区间。

例如,CI =coefCI(mdl)用于计算拟合对象mdl中回归系数的置信区间。

解释回归分析的结果回归分析的结果通常包括拟合曲线、回归系数以及模型的可靠性指标。

拟合曲线描述了自变量和因变量之间的关系。

回归系数可以用来解释自变量对因变量的影响。

模型的可靠性指标包括截距、回归系数的显著性检验以及相关系数等。

拟合曲线可以通过调用plot函数来绘制。

回归系数可以通过调用coef函数来获取。

对回归系数的显著性检验可以利用置信区间来判断,如果置信区间包含0,则说明回归系数不显著。

相关系数可以通过调用corrcoef函数来计算。

MATLAB智能算法30个案例分析

MATLAB智能算法30个案例分析以下是MATLAB智能算法30个案例的分析:1.遗传算法优化问题:利用遗传算法求解最佳解的问题。

可以用于求解复杂的优化问题,如旅行商问题等。

2.神经网络拟合问题:利用神经网络模型拟合给定的数据。

可以用于预测未知的数据或者进行模式分类等。

3.支持向量机分类问题:利用支持向量机模型进行分类任务。

可以用于医学图像处理、信号处理等领域。

4.贝叶斯网络学习问题:利用贝叶斯网络对大量数据进行学习和分析。

可以用于推断潜在关系、预测未来事件等。

5.粒子群算法逆向问题:利用粒子群算法解决逆向问题,如数据恢复、逆向工程等。

可以用于重建丢失的数据或者还原未知的模型参数。

6.模拟退火算法优化问题:利用模拟退火算法寻找最优解。

可以用于参数优化、组合优化等问题。

7.K均值聚类问题:利用K均值算法对数据进行聚类。

可以用于数据分析、图像处理等。

8.线性回归问题:利用线性回归模型预测目标变量。

可以用于价格预测、趋势分析等。

9.主成分分析问题:利用主成分分析模型对高维数据进行降维。

可以用于数据可视化和预处理。

10.深度学习图像分类问题:利用深度学习算法对图像进行分类。

可以用于图像识别和物体检测等。

11.强化学习问题:利用强化学习算法让智能体自主学习和改进策略。

可以用于自动驾驶、博弈等。

12.偏微分方程求解问题:利用数值方法求解偏微分方程。

可以用于模拟物理过程和工程问题。

13.隐马尔可夫模型序列分类问题:利用隐马尔可夫模型对序列进行分类。

可以用于语音识别、自然语言处理等。

14.遗传编程问题:利用遗传编程算法自动发现和改进算法。

可以用于算法设计和优化等。

15.高斯混合模型聚类问题:利用高斯混合模型对数据进行聚类。

可以用于人群分析和异常检测等。

16.马尔可夫链蒙特卡洛采样问题:利用马尔可夫链蒙特卡洛方法采样复杂分布。

可以用于概率推断和统计模拟等。

17.基因表达式数据分析问题:利用统计方法分析基因表达数据。

matlab30个案例分析案例14-SVM神经网络的回归预测分析

matlab30个案例分析案例14-SVM神经网络的回归预测分析%% SVM神经网络的回归预测分析---上证指数开盘指数预测%%% 清空环境变量function chapter14tic;close all;clear;clc;format compact;%% 数据的提取和预处理% 载入测试数据上证指数(1990.12.19-2009.08.19)% 数据是一个4579*6的double型的矩阵,每一行表示每一天的上证指数% 6列分别表示当天上证指数的开盘指数,指数最高值,指数最低值,收盘指数,当日交易量,当日交易额.load chapter14_sh.mat;% 提取数据[m,n] = size(sh);ts = sh(2:m,1);tsx = sh(1:m-1,:);% 画出原始上证指数的每日开盘数figure;plot(ts,'LineWidth',2);title('上证指数的每日开盘数(1990.12.20-2009.08.19)','FontSize',12);xlabel('交易日天数(1990.12.19-2009.08.19)','FontSize',12);ylabel('开盘数','FontSize',12);grid on;% 数据预处理,将原始数据进行归一化ts = ts';tsx = tsx';% mapminmax为matlab自带的映射函数% 对ts进行归一化[TS,TSps] = mapminmax(ts,1,2);% 画出原始上证指数的每日开盘数归一化后的图像figure;plot(TS,'LineWidth',2);title('原始上证指数的每日开盘数归一化后的图像','FontSize',12);xlabel('交易日天数(1990.12.19-2009.08.19)','FontSize',12);ylabel('归一化后的开盘数','FontSize',12);grid on;% 对TS进行转置,以符合libsvm工具箱的数据格式要求TS = TS';% mapminmax为matlab自带的映射函数% 对tsx进行归一化[TSX,TSXps] = mapminmax(tsx,1,2);% 对TSX进行转置,以符合libsvm工具箱的数据格式要求TSX = TSX';%% 选择回归预测分析最佳的SVM参数c&g% 首先进行粗略选择:[bestmse,bestc,bestg] = SVMcgForRegress(TS,TSX,-8,8,-8,8);% 打印粗略选择结果disp('打印粗略选择结果');str = sprintf( 'Best Cross Validation MSE = %g Best c = %g Best g = %g',bestmse,bestc,bestg); disp(str);% 根据粗略选择的结果图再进行精细选择:[bestmse,bestc,bestg] = SVMcgForRegress(TS,TSX,-4,4,-4,4,3,0.5,0.5,0.05);% 打印精细选择结果disp('打印精细选择结果');str = sprintf( 'Best Cross Validation MSE = %g Best c = %g Best g = %g',bestmse,bestc,bestg); disp(str);%% 利用回归预测分析最佳的参数进行SVM网络训练cmd = ['-c ', num2str(bestc), ' -g ', num2str(bestg) , ' -s 3 -p 0.01'];model = svmtrain(TS,TSX,cmd);%% SVM网络回归预测[predict,mse] = svmpredict(TS,TSX,model);predict = mapminmax('reverse',predict',TSps);predict = predict';% 打印回归结果str = sprintf( '均方误差MSE = %g 相关系数R = %g%%',mse(2),mse(3)*100);disp(str);%% 结果分析figure;hold on;plot(ts,'-o');plot(predict,'r-^');legend('原始数据','回归预测数据');hold off;title('原始数据和回归预测数据对比','FontSize',12);xlabel('交易日天数(1990.12.19-2009.08.19)','FontSize',12);ylabel('开盘数','FontSize',12);grid on;figure;error = predict - ts';plot(error,'rd');title('误差图(predicted data - original data)','FontSize',12);xlabel('交易日天数(1990.12.19-2009.08.19)','FontSize',12);ylabel('误差量','FontSize',12);grid on;figure;error = (predict - ts')./ts';plot(error,'rd');title('相对误差图(predicted data - original data)/original data','FontSize',12);xlabel('交易日天数(1990.12.19-2009.08.19)','FontSize',12);ylabel('相对误差量','FontSize',12);grid on;snapnow;toc;%% 子函数SVMcgForRegress.mfunction [mse,bestc,bestg] = SVMcgForRegress(train_label,train,cmin,cmax,gmin,gmax,v,cstep ,gstep,msestep)%SVMcg cross validation by faruto%% by faruto%Email:patrick.lee@/doc/2510837534.html, QQ:516667408 /doc/2510837534.html,/faruto BNU%last modified 2010.01.17%Super Moderator @ /doc/2510837534.html,% 若转载请注明:% faruto and liyang , LIBSVM-farutoUltimateVersion% a toolbox with implements for support vector machinesbased on libsvm, 2009.% Software available at /doc/2510837534.html,%% Chih-Chung Chang and Chih-Jen Lin, LIBSVM : a library for % support vector machines, 2001. Software available at% /doc/2510837534.html,.tw/~cjlin/libsvm % about the parameters of SVMcgif nargin < 10msestep = 0.06;endif nargin < 8cstep = 0.8;gstep = 0.8;endif nargin < 7v = 5;endif nargin < 5gmax = 8;gmin = -8;endif nargin < 3cmax = 8;cmin = -8;end% X:c Y:g cg:acc[X,Y] = meshgrid(cmin:cstep:cmax,gmin:gstep:gmax);[m,n] = size(X);cg = zeros(m,n);eps = 10^(-4);bestc = 0;bestg = 0;mse = Inf;basenum = 2;for i = 1:mfor j = 1:ncmd = ['-v ',num2str(v),' -c ',num2str( basenum^X(i,j) ),' -g ',num2str( basenum^Y(i,j) ),' -s 3 -p 0.1'];cg(i,j) = svmtrain(train_label, train, cmd);if cg(i,j) < msemse = cg(i,j);bestc = basenum^X(i,j);bestg = basenum^Y(i,j);endif abs( cg(i,j)-mse )<=eps && bestc > basenum^X(i,j)mse = cg(i,j);bestc = basenum^X(i,j);bestg = basenum^Y(i,j);endendend% to draw the acc with different c & g[cg,ps] = mapminmax(cg,0,1);figure;[C,h] = contour(X,Y,cg,0:msestep:0.5);clabel(C,h,'FontSize',10,'Color','r');xlabel('log2c','FontSize',12);ylabel('log2g','FontSize',12);firstline = 'SVR参数选择结果图(等高线图)[GridSearchMethod]';secondline = ['Best c=',num2str(bestc),' g=',num2str(bestg), ...' CVmse=',num2str(mse)];title({firstline;secondline},'Fontsize',12);grid on;figure;meshc(X,Y,cg);% mesh(X,Y,cg);% surf(X,Y,cg);axis([cmin,cmax,gmin,gmax,0,1]);xlabel('log2c','FontSize',12);ylabel('log2g','FontSize',12);zlabel('MSE','FontSize',12);firstline = 'SVR参数选择结果图(3D视图)[GridSearchMethod]'; secondline = ['Best c=',num2str(bestc),' g=',num2str(bestg), ...' CVmse=',num2str(mse)];title({firstline;secondline},'Fontsize',12);。

matlab中回归分析实例分析

1.研究科研人员的年工资与他的论文质量、工作年限、获得资助指标之间的关系.24位科研人员的调查数据(ex81.txt):设误差ε~(0,σ 2 ), 建立回归方程; 假定某位人员的观测值 , 预测年工资及置信度为95%的置信区间.程序为:A=load('ex81.txt')Y=A(:,1)X=A(1:24,2:4)xx=[ones(24,1) X]b = regress(Y,X)Y1=xx(:,1:4)*bx=[1 5.1 20 7.2]s=sum(x*b)调出Y 和X 后,运行可得:b =17.84691.10310.32151.2889010203(,,)(5.1,20,7.2)x x x =x =1.0000 5.1000 20.0000 7.2000s =39.1837所以,回归方程为:Y= 17.8469+1.1031X1+0.3215X2+1.2889X3+ε当 时,Y=39.18372、 54位肝病人术前数据与术后生存时间(ex82.txt,指标依次为凝血值,预后指数,酵素化验值,肝功能化验值,生存时间).(1) 若用线性回归模型拟合, 考察其各假设合理性;(2) 对生存是时间做对数变换,用线性回归模型拟合, 考察其各假设合理性;(3) 做变换 用线性回归模型拟合, 考察其各假设合理性; (4) 用变量的选择准则,选择最优回归方程010203(,,)(5.1,20,7.2)x x x =0.0710.07Y Z -=(5)用逐步回归法构建回归方程程序为:A=load('ex82.txt')Y=A(:,5)X=A(1:54,1:4)xx=[ones(54,1) X][b,bint,r,rint,stats]=regress(Y,xx) 运行结果为:b =-621.597633.16384.27194.125714.0916bint =-751.8189 -491.376219.0621 47.26563.1397 5.40403.0985 5.1530-11.0790 39.2622stats =1.0e+003 *0.0008 0.0628 0 3.7279由检验结果知,bi的置信区间分别为:[-751.8189 ,-491.3762][ 19.0621 47.2656][3.1397 5.4040][3.0985 5.1530][-11.0790 39.2622]R2 =8 f=0.0628 p=0 估计误差方差为3.7279所以可见这种拟合不合理。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

%% SVM神经网络的回归预测分析---上证指数开盘指数预测%%% 清空环境变量function chapter14tic;close all;clear;clc;format compact;%% 数据的提取和预处理% 载入测试数据上证指数(1990.12.19-2009.08.19)% 数据是一个4579*6的double型的矩阵,每一行表示每一天的上证指数% 6列分别表示当天上证指数的开盘指数,指数最高值,指数最低值,收盘指数,当日交易量,当日交易额.load chapter14_sh.mat;% 提取数据[m,n] = size(sh);ts = sh(2:m,1);tsx = sh(1:m-1,:);% 画出原始上证指数的每日开盘数figure;plot(ts,'LineWidth',2);title('上证指数的每日开盘数(1990.12.20-2009.08.19)','FontSize',12);xlabel('交易日天数(1990.12.19-2009.08.19)','FontSize',12);ylabel('开盘数','FontSize',12);grid on;% 数据预处理,将原始数据进行归一化ts = ts';tsx = tsx';% mapminmax为matlab自带的映射函数% 对ts进行归一化[TS,TSps] = mapminmax(ts,1,2);% 画出原始上证指数的每日开盘数归一化后的图像figure;plot(TS,'LineWidth',2);title('原始上证指数的每日开盘数归一化后的图像','FontSize',12);xlabel('交易日天数(1990.12.19-2009.08.19)','FontSize',12);ylabel('归一化后的开盘数','FontSize',12);grid on;% 对TS进行转置,以符合libsvm工具箱的数据格式要求TS = TS';% mapminmax为matlab自带的映射函数% 对tsx进行归一化[TSX,TSXps] = mapminmax(tsx,1,2);% 对TSX进行转置,以符合libsvm工具箱的数据格式要求TSX = TSX';%% 选择回归预测分析最佳的SVM参数c&g% 首先进行粗略选择:[bestmse,bestc,bestg] = SVMcgForRegress(TS,TSX,-8,8,-8,8);% 打印粗略选择结果disp('打印粗略选择结果');str = sprintf( 'Best Cross Validation MSE = %g Best c = %g Best g = %g',bestmse,bestc,bestg); disp(str);% 根据粗略选择的结果图再进行精细选择:[bestmse,bestc,bestg] = SVMcgForRegress(TS,TSX,-4,4,-4,4,3,0.5,0.5,0.05);% 打印精细选择结果disp('打印精细选择结果');str = sprintf( 'Best Cross Validation MSE = %g Best c = %g Best g = %g',bestmse,bestc,bestg); disp(str);%% 利用回归预测分析最佳的参数进行SVM网络训练cmd = ['-c ', num2str(bestc), ' -g ', num2str(bestg) , ' -s 3 -p 0.01'];model = svmtrain(TS,TSX,cmd);%% SVM网络回归预测[predict,mse] = svmpredict(TS,TSX,model);predict = mapminmax('reverse',predict',TSps);predict = predict';% 打印回归结果str = sprintf( '均方误差MSE = %g 相关系数R = %g%%',mse(2),mse(3)*100);disp(str);%% 结果分析figure;hold on;plot(ts,'-o');plot(predict,'r-^');legend('原始数据','回归预测数据');hold off;title('原始数据和回归预测数据对比','FontSize',12);xlabel('交易日天数(1990.12.19-2009.08.19)','FontSize',12);ylabel('开盘数','FontSize',12);grid on;figure;error = predict - ts';plot(error,'rd');title('误差图(predicted data - original data)','FontSize',12);xlabel('交易日天数(1990.12.19-2009.08.19)','FontSize',12);ylabel('误差量','FontSize',12);grid on;figure;error = (predict - ts')./ts';plot(error,'rd');title('相对误差图(predicted data - original data)/original data','FontSize',12);xlabel('交易日天数(1990.12.19-2009.08.19)','FontSize',12);ylabel('相对误差量','FontSize',12);grid on;snapnow;toc;%% 子函数SVMcgForRegress.mfunction [mse,bestc,bestg] = SVMcgForRegress(train_label,train,cmin,cmax,gmin,gmax,v,cstep,gstep,msestep)%SVMcg cross validation by faruto%% by faruto%Email:*************************:516667408/farutoBNU%last modified 2010.01.17%******************************.cn% 若转载请注明:% faruto and liyang , LIBSVM-farutoUltimateVersion% a toolbox with implements for support vector machines based on libsvm, 2009.% Software available at %% Chih-Chung Chang and Chih-Jen Lin, LIBSVM : a library for% support vector machines, 2001. Software available at% .tw/~cjlin/libsvm% about the parameters of SVMcgif nargin < 10msestep = 0.06;endif nargin < 8cstep = 0.8;gstep = 0.8;endif nargin < 7v = 5;endif nargin < 5gmax = 8;gmin = -8;endif nargin < 3cmax = 8;cmin = -8;end% X:c Y:g cg:acc[X,Y] = meshgrid(cmin:cstep:cmax,gmin:gstep:gmax);[m,n] = size(X);cg = zeros(m,n);eps = 10^(-4);bestc = 0;bestg = 0;mse = Inf;basenum = 2;for i = 1:mfor j = 1:ncmd = ['-v ',num2str(v),' -c ',num2str( basenum^X(i,j) ),' -g ',num2str( basenum^Y(i,j) ),' -s 3 -p 0.1'];cg(i,j) = svmtrain(train_label, train, cmd);if cg(i,j) < msemse = cg(i,j);bestc = basenum^X(i,j);bestg = basenum^Y(i,j);endif abs( cg(i,j)-mse )<=eps && bestc > basenum^X(i,j)mse = cg(i,j);bestc = basenum^X(i,j);bestg = basenum^Y(i,j);endendend% to draw the acc with different c & g[cg,ps] = mapminmax(cg,0,1);figure;[C,h] = contour(X,Y,cg,0:msestep:0.5);clabel(C,h,'FontSize',10,'Color','r');xlabel('log2c','FontSize',12);ylabel('log2g','FontSize',12);firstline = 'SVR参数选择结果图(等高线图)[GridSearchMethod]'; secondline = ['Best c=',num2str(bestc),' g=',num2str(bestg), ...' CVmse=',num2str(mse)];title({firstline;secondline},'Fontsize',12);grid on;figure;meshc(X,Y,cg);% mesh(X,Y,cg);% surf(X,Y,cg);axis([cmin,cmax,gmin,gmax,0,1]);xlabel('log2c','FontSize',12);ylabel('log2g','FontSize',12);zlabel('MSE','FontSize',12);firstline = 'SVR参数选择结果图(3D视图)[GridSearchMethod]'; secondline = ['Best c=',num2str(bestc),' g=',num2str(bestg), ...' CVmse=',num2str(mse)];title({firstline;secondline},'Fontsize',12);。