选取SVM中参数c和g的最佳值

SVM分类核函数及参数选择比较_奉国和

coef ) 。

2 参数选取方法

SVM 的参数选择问题,其实质就是一个优化问题。目前 SVM 参数选取方法主要有:经验选择法、实验试凑法、梯度下 降法、交叉验证法、Bayesian 法等。同时随着遗传算法、粒子群 优化、人工免疫等智能优化方法的成功,陆续有学者采用这些 方法来优化选择 SVM 参数。近几年,进化计算领域兴起了一 类新型优化算法,即分布估计算法,并迅速成为进化计算领域

(1)Polynomial 核函数:K(xxi) =[γ*(x·xi) + coef ]d ,其中 d 为多项式的阶,coef 为偏置系数。

(2)RBF 核函数:K(xxi) = exp(-γ* x - xi 2) ,其中 γ 为核

函数的宽度。 (3)Sigmoid核函数(两层神经网络):K(xxi) = tanh(γ(x·xi) +

1 支持向量机原理

支持向量机是基于结构风险最小化原理(Structural Risk

Mininization,SRM),为了控制泛化能力,需要控制两个因素, 即经验风险和置信范围值。传统的神经网络是基于经验风险 最小化原则,以训练误差最小化为优化目标,而支持向量机以 训练误差作为优化问题的约束条件,以置信范围最小化为优 化目标。它最终化为解决一个线性约束的凸二次规划(QP)求解 问题,所以支持向量机的解具有唯一性,也是全局最优的 。 [3-4] 应用核函数技术,将输入空间中的非线性问题,通过函数映射 到高维特征空间中,在高维空间中构造线性判别函数,常用的 核函数有如下三种。

svm参数

svm参数

SVM(支持向量机)参数是指在支持向量机算法中定义的超参数。

支持向量机是一种机器学习算法,用于分类和回归问题。

它通过将数据表示为N维空间中的点,然后找到最佳决策边界来将不同类型的点分开。

SVM参数包括:核函数、惩罚系数、正则化参数和精度等。

其中,核函数是一种对应点之间的映射,它在支持向量机算法中用于通过改变原始特征空间来提高模型性能。

核函数常见的类型有:线性核函数、多项式核函数和高斯核函数等。

核函数可以帮助支持向量机算法针对复杂的决策边界进行训练,从而提高模型的性能。

惩罚系数(C)是一种用于控制SVM算法的参数,用于控制算法的复杂度和正则化。

C参数越大,则SVM算法的复杂度越大。

惩罚系数用于控制SVM算法的方差,即模型的准确度和泛化能力之间的平衡。

正则化参数是一种用于控制SVM算法的参数,用于避免过拟合,从而使模型性能更高。

正则化参数越大,则模型更偏向于保守,从而更少受到过拟合的影响。

精度(epsilon)是SVM算法中的另一个参数,用于控制模型的精度。

精度越大,则模型性能越好,但是会增加训练时间。

总之,SVM参数是支持向量机算法中的一组重要参数,它们可以帮助控制模型的复杂度、正则化和精度,从而提高模型的性能。

envi svm 参数

envi svm 参数在ENVI中,SVM参数设置主要包括以下几个方面:1.核函数(Kernel):SVM通过核函数将输入数据从低维空间映射到高维空间,以便更好地进行线性或非线性分类。

常见的核函数有线性核函数、多项式核函数和径向基函数(RBF)等。

不同的核函数对应不同的特征映射方式,因此选择合适的核函数对分类结果至关重要。

2.C值:C值是SVM中一个重要的正则化参数,控制了错误样本对模型损失函数的惩罚程度。

较小的C值会使得模型更容忍误分类样本,并生成更大的决策边界;较大的C值则会强制模型更加关注每个样本的分类准确性。

根据具体问题的复杂程度和数据噪声情况,需要适当调整C值以平衡分类错误和过拟合之间的关系。

3.Gamma值:这个参数控制了样本错误与分类刚性延伸之间的平衡,默认值是100。

4.Pyramid Levels:设置分级处理等级,用于SVM训练和分类处理过程。

此外,在SVM参数设置面板中,还有以下选项:Kernel Type:下拉列表里选项有Linear,Polynomial,Radial Basis Function,以及Sigmoid。

如果选择Polynomial,还需要设置一个核心多项式的次数用于SVM。

如果选择Polynomial、Radial Basis Function、Sigmoid,需要设置Gamma in Kernel Function参数。

Support Vector Regression(SVR):支持向量回归,用于构建回归模型。

One-Class SVM(OCSVM):用于进行异常检测和一分类问题。

在使用这些参数时,可能需要根据具体的数据和问题来调整和优化参数设置,以获得最佳的分类效果。

支持向量机回归的参数选择方法

支持向量机回归的参数选择方法支持向量机(Support Vector Machine,简称SVM)是一种非常强大且广泛应用于机器学习领域的算法。

它不仅适用于分类问题,还可以用于回归任务。

本文将深入探讨支持向量机回归的参数选择方法,并分析其优势和应用场景。

SVM回归的目标是通过拟合一个最优的超平面来预测连续变量的输出。

与分类任务不同的是,SVM回归关注的是给定输入样本点的输出数值。

在SVM回归中,参数选择方法对模型性能的影响非常重要。

我们来讨论SVM回归的核函数选择。

核函数是SVM中的一个关键概念,它可以将输入样本从原始特征空间映射到高维特征空间。

常见的核函数包括线性核函数、多项式核函数和高斯核函数等。

针对回归任务,一般常用的是高斯核函数,它能更好地处理非线性关系。

接下来,我们讨论SVM回归的惩罚参数C选择。

惩罚参数C控制着模型对误差的容忍程度,其值的选择对模型的求解和泛化能力都会产生较大影响。

当C的值较小时,模型会容忍更多的误差,从而产生较宽泛的超平面;相反,当C的值较大时,模型会更严格地拟合训练样本,但可能会导致过拟合现象。

在参数选择过程中,需要权衡模型的拟合能力和泛化能力。

另外,核函数的超参数γ也是SVM回归中需要选择的重要参数。

γ决定了高斯核函数的带宽,即决定了样本点对决策边界的影响程度。

当γ较大时,样本点之间的距离对决策边界的影响减小,决策边界可能变得更加平滑;相反,当γ较小时,样本点之间的距离对决策边界的影响增大,决策边界可能更加对训练样本敏感。

在选择参数C和γ时,通常使用交叉验证的方法来评估模型的性能。

交叉验证将数据集划分为训练集和验证集,在不同的参数组合下训练模型,并在验证集上计算模型的性能指标,如均方误差(Mean Squared Error,简称MSE)。

根据验证集上的性能表现,选择使MSE最小的参数组合作为最终的模型参数。

支持向量机回归的参数选择方法涉及到核函数选择、惩罚参数C的确定和高斯核函数的超参数γ的选择。

基于SVM的股票指数预测

基于SVM的股票指数预测邹存利;张蕾;王玥;丛琳【摘要】随着中国经济的飞速发展,越来越多的人加入到股市这个大家庭中来。

由于股票市场具有高噪声、不确定等特性,使得股票的价格预测极为困难。

而较为准确的预测股票价格,有利于人们的投资。

本文选用国泰君安大智慧软件中2007年1月4日至2017年12月29日的沪深300指数中2676个交易日数据作为原始分析数据,通过建立支持向量机模型和ARMA模型进行分析并做出短期预测。

实验结果:采用支持向量机模型的预测数据与实际数据的拟合度较高,相对误差控制在4%左右;说明支持向量机模型可以对股票市场做出更准确的价格预测,可以为沪深股票市场股票价格走势的研究提供一些借鉴。

【期刊名称】《计算机科学与应用》【年(卷),期】2018(008)004【总页数】8页(P421-428)【关键词】沪深300指数;支持向量机;ARMA模型;股票预测;数据归一化【作者】邹存利;张蕾;王玥;丛琳【作者单位】[1]辽宁师范大学数学学院,辽宁大连;;[1]辽宁师范大学数学学院,辽宁大连;;[1]辽宁师范大学数学学院,辽宁大连;;[1]辽宁师范大学数学学院,辽宁大连;【正文语种】中文【中图分类】F21.引言股票市场瞬息万变,风险很高,而对股票指数的预测可以为我们从整体上把握股市的变动提供有效的信息。

沪深300指数是沪深证交所联合发布,以流动性和规模作为两大选样的根本标准,是一个能反映A股市场价格整体走势的指标。

所以对于沪深指数的预测具有十分重要的意义。

基于支持向量机的优良性能,考虑将其应用于股市指数的预测[5]。

支持向量机于1995年由Cortes和Vapnik等人正式发表,由于其在文本分类任务中显示出卓越性能,很快成为机器学习的主流技术,并直接掀起了“统计学习”在2000年前后的高潮。

Vapnik等人从六、七十年代开始致力于此方面研究,直到九十年代才使抽象的理论转化为通用的学习算法,其中核技巧才真正成为机器学习的通用基本技术。

基于SVM算法的局部放电模式识别

基于SVM算法的局部放电模式识别气体绝缘组合电器(Gas Insulated Switchgear)局部放电检测对于保证其安全可靠运行具有重要的意义。

为了对变压器故障进行有效诊断,试验设计了4种典型缺陷模型。

用超声波法提取局部放电信号,得到局放分布图谱,获得了局放特征参数。

根据所提取的特征参数的特点,通过支持向量机(SVM)分类算法对典型缺陷信号进行了模式识别。

标签:超声波法;特征参数;SVM算法;模式识别引言变压器作为电力系统中重要的电力设备,是输电网中重要的组成部分,及时的发现其内部故障,对于电网的安全供电,减少经济损失是至关重要的。

以前,主要是通过检测绝缘电阻、局部放电等来进行变压器内部的故障诊断情况,这种方法具有局限性,会受到周围环境的影响。

超声波法是一种较好的故障检测方法,能够及时准确的对变压器内部的故障进行监测。

用超声波法对变压器缺陷故障引起的局部放电进行检测,得到的信号图谱中含有丰富的局放信息,可以从中提取能充分反映局放信号特征的偏斜度Sk、陡峭度Ku、局部峰点数Pe、互相关系数Cc和放电量Q等特征参数。

对统计特征参数进行分析,能够较好的进行典型绝缘缺陷故障的诊断。

基于此,本文通过对变压器内部设置典型绝缘缺陷模型,对其故障进行局放试验,提取出能反映典型缺陷局放信号的特征参数。

用SVM算法对典型绝缘缺陷局放信号进行分类,结果表明:SVM分类算法对于GIS内典型缺陷类型具有较高的识别率。

1 SVM算法的原理1.1 分类器设计SVM是Vapnik提出的一种建立在统计学习基础上的非线性数据处理方法,其基于“结构风险最小化原理”的独特决策规则能较好的克服传统分类算法“维数灾”和“过拟合”等问题,并且具有很强的泛化能力,在处理二分类和多分类模式识别问题上有着优异表现,因而备受研究人员青睐,目前已开发出LIBSVM、LS-SVMLAB、OSU SVM等诸多软件包。

然而,SVM模型参数的选取没有既定的标准,需要很强的经验与技巧。

svm参数范围

svm参数范围支持向量机(Support Vector Machine,SVM)是一种在机器学习中常用的分类算法。

在使用SVM进行分类时,需要选择合适的参数。

本文将介绍SVM的参数范围,并解释其对分类结果的影响。

1. 核函数(Kernel Function):SVM通过核函数将数据从原始空间映射到一个高维特征空间,从而更容易进行分类。

常用的核函数有线性核函数、多项式核函数和高斯核函数等。

线性核函数适用于线性可分的数据,多项式核函数可以处理非线性数据,而高斯核函数可以处理任意类型的数据。

选择合适的核函数是SVM分类的关键之一。

2. 惩罚参数C(Penalty Parameter C):C控制着分类器对误分类样本的惩罚程度。

C越大,分类器对误分类样本的惩罚越重,容忍度越小,可能导致过拟合;C越小,分类器对误分类样本的惩罚越轻,容忍度越大,可能导致欠拟合。

因此,需要根据实际情况选择合适的C值,以达到较好的分类效果。

3. 松弛变量(Slack Variable):松弛变量允许在分类边界上存在一定的错误。

通过引入松弛变量,可以处理线性不可分的数据。

松弛变量的数量通过参数ε进行控制,ε越大,容忍度越大,允许更多的误分类样本;ε越小,容忍度越小,要求更少的误分类样本。

选择合适的松弛变量参数ε可以平衡分类精度和容忍度。

4. 核函数参数:对于使用核函数的SVM,还需要选择相应的核函数参数。

例如,多项式核函数需要选择多项式的阶数和常数项,高斯核函数需要选择核函数的带宽。

选择合适的核函数参数可以更好地适应数据的特点,提高分类器的性能。

5. 类别权重参数(Class Weight):在数据不平衡的情况下,某些类别样本的数量可能远远大于其他类别。

类别权重参数可以用来调整不同类别样本的重要性,从而更好地处理不平衡数据。

选择合适的类别权重参数可以提高对少数类别的分类准确率。

在选择SVM的参数时,可以通过网格搜索(Grid Search)等方法来寻找最优参数组合。

libsvm参数说明

libsvm参数说明摘要:1.介绍libsvm2.libsvm 的参数说明3.使用libsvm 的注意事项4.结束语正文:1.介绍libsvmLIBSVM(Library for Support Vector Machines)是一个开源的支持向量机(SVM)算法库,它可以帮助我们解决分类和回归问题。

SVM 算法是一种非常强大的机器学习算法,它可以在各种领域中得到广泛的应用,例如人脸检测、车牌识别等。

2.libsvm 的参数说明在使用libsvm 时,我们需要了解它的一些参数,以便更好地利用这个工具。

以下是一些常见的libsvm 参数及其说明:- -s:表示是否进行核函数的平滑处理。

默认值为1,表示不进行平滑处理。

- -t:表示是否启用时间限制。

默认值为0,表示不限制运行时间。

- -n:表示SVM 的核函数类型。

默认值为3,表示使用径向基函数(rbf)。

- -c:表示SVM 的成本参数C。

默认值为1.0,表示使用线性核函数。

- -g:表示SVM 的梯度裁剪参数。

默认值为0.1,表示启用梯度裁剪。

- -b:表示是否在输出结果中包含预测样本的类别。

默认值为0,表示不输出。

3.使用libsvm 的注意事项在使用libsvm 时,我们需要注意以下几点:- 安装libsvm 时,需要添加环境变量,以便正确地调用该库。

- 在使用libsvm 前,需要对数据进行预处理,例如缩放、归一化等。

- 选择合适的核函数和参数C 是提高SVM 算法性能的关键。

- 在训练模型时,可以采用交叉验证等方法来避免过拟合。

4.结束语总之,libsvm 是一个功能强大的支持向量机库,它可以帮助我们解决各种分类和回归问题。

在使用libsvm 时,我们需要了解其参数的含义,并根据实际需求进行相应的设置。

LIBSVM使用方法

LIBSVM使用方法1libsvm简介2libsvm使用方法libsvm就是以源代码和可执行文件两种方式得出的。

如果就是windows系列操作系统,可以轻易采用软件包提供更多的程序,也可以展开修正编程;如果就是unix类系统,必须自己编程,软件包中提供更多了编程格式文件,我们在sgi工作站(操作系统irix6.5)上,采用免费编译器gnuc++3.3编程通过。

2.1libsvm使用的一般步骤:1)2)3)4)5)6)按照libsvm软件包所建议的格式准备工作数据集;对数据展开直观的翻转操作方式;考量采用rbf核函数;使用交叉检验挑选最佳参数c与g;使用最佳参数c与g对整个训练集展开训练以获取积极支持向量机模型;利用以获取的模型展开测试与预测。

2.2libsvm使用的数据格式该软件采用的训练数据和检验数据文件格式如下:::...其中就是训练数据集的目标值,对于分类,它就是标识某类的整数(积极支持多个类);对于重回,就是任一实数。

就是以1已经开始的整数,可以就是不已连续的;为实数,也就是我们常说道的自变量。

检验数据文件中的label只用作排序准确度或误差,如果它就是未明的,只需用一个数核对这一栏,也可以空着不填上。

在程序包中,还包括存有一个训练数据实例:heart_scale,便利参照数据文件格式以及练采用软件。

可以撰写大程序,将自己常用的数据格式转换成这种格式。

2.3svmtrain和svmpredict的用法svmtrain(训练建模)的用法:svmtrain[options]training_set_file[model_file]options:需用的选项即为则表示的涵义如下-ssvm类型:svm设置类型(默认0)0--c-svc1--v-svc2–一类svm3--e-svr4--v-svr-t核函数类型:核函数设置类型(默认2)0–线性:u'v1–多项式:(r*u'v+coef0)^degree2–rbf函数:exp(-r|u-v|^2)3–sigmoid:tanh(r*u'v+coef0)-ddegree:核函数中的degree设置(预设3)-gr(gama):核函数中的?函数设置(默认1/k)-rcoef0:核函数中的coef0设置(预设0)-ccost:设置c-svc,?-svr和?-svr的参数(默认1)-nnu:设置?-svc,一类svm和?-svr的参数(预设0.5)-pe:设置?-svr中损失函数?的值(默认0.1)-mcachesize:设置cache内存大小,以mb为单位(预设40)-eε:设置允许的终止判据(默认0.001)-hshrinking:与否采用启发式,0或1(预设1)-wiweight:设置第几类的参数c为weight?c(c-svc中的c)(默认1)-vn:n-fold可视化检验模式其中-g选项中的k是指输入数据中的属性数。

灰 狼 优 化 算 法 ( G W O ) 原 理

GWO(灰狼优化)算法以优化SVM算法的参数c和g为例,对GWO算法MATLAB源码进行了逐行中文注解。

————————————————tic % 计时器%% 清空环境变量close allformat compact%% 数据提取% 载入测试数据wine,其中包含的数据为classnumber = 3,wine:178*13的矩阵,wine_labes:178*1的列向量load wine.mat% 选定训练集和测试集% 将第一类的1-30,第二类的60-95,第三类的131-153做为训练集train_wine = [wine(1:30,:);wine(60:95,:);wine(131:153,:)];% 相应的训练集的标签也要分离出来train_wine_labels = [wine_labels(1:30);wine_labels(60:95);wine_labels(131:153)] ;% 将第一类的31-59,第二类的96-130,第三类的154-178做为测试集test_wine = [wine(31:59,:);wine(96:130,:);wine(154:178,:)];% 相应的测试集的标签也要分离出来test_wine_labels = [wine_labels(31:59);wine_labels(96:130);wine_labels(154:178 )];%% 数据预处理% 数据预处理,将训练集和测试集归一化到[0,1]区间[mtrain,ntrain] = size(train_wine);[mtest,ntest] = size(test_wine);dataset = [train_wine;test_wine];% mapminmax为MATLAB自带的归一化函数[dataset_scale,ps] = mapminmax(dataset',0,1);dataset_scale = dataset_scale';train_wine = dataset_scale(1:mtrain,:);test_wine = dataset_scale( (mtrain+1):(mtrain+mtest),: );%% 利用灰狼算法选择最佳的SVM参数c和gSearchAgents_no=10; % 狼群数量,Number of search agents Max_iteration=10; % 最大迭代次数,Maximum numbef of iterationsdim=2; % 此例需要优化两个参数c和g,number of your variableslb=[0.01,0.01]; % 参数取值下界ub=[100,100]; % 参数取值上界% v = 5; % SVM Cross Validation参数,默认为5% initialize alpha, beta, and delta_posAlpha_pos=zeros(1,dim); % 初始化Alpha狼的位置Alpha_score=inf; % 初始化Alpha狼的目标函数值,change this to -inf for maximization problemsBeta_pos=zeros(1,dim); % 初始化Beta狼的位置Beta_score=inf; % 初始化Beta狼的目标函数值,change this to -inf for maximization problemsDelta_pos=zeros(1,dim); % 初始化Delta狼的位置Delta_score=inf; % 初始化Delta狼的目标函数值,change this to -inf for maximization problems%Initialize the positions of search agentsPositions=initialization(SearchAgents_no,dim,ub,lb);Convergence_curve=zeros(1,Max_iteration);l=0; % Loop counter循环计数器% Main loop主循环while lMax_iteration % 对迭代次数循环for i=1:size(Positions,1) % 遍历每个狼% Return back the search agents that go beyond the boundaries of the search space% 若搜索位置超过了搜索空间,需要重新回到搜索空间Flag4ub=Positions(i,:)ub;Flag4lb=Positions(i,:)lb;% 若狼的位置在最大值和最小值之间,则位置不需要调整,若超出最大值,最回到最大值边界;% 若超出最小值,最回答最小值边界Positions(i,:)=(Positions(i,:).*(~(Flag4ub+Flag4lb)))+ub.*F lag4ub+lb.*Flag4lb; % ~表示取反% 计算适应度函数值cmd = [' -c ',num2str(Positions(i,1)),' -g ',num2str(Positions(i,2))];model=svmtrain(train_wine_labels,train_wine,cmd); % SVM 模型训练[~,fitness]=svmpredict(test_wine_labels,test_wine,model); % SVM模型预测及其精度fitness=100-fitness(1); % 以错误率最小化为目标% Update Alpha, Beta, and Deltaif fitnessAlpha_score % 如果目标函数值小于Alpha狼的目标函数值Alpha_score=fitness; % 则将Alpha狼的目标函数值更新为最优目标函数值,Update alphaAlpha_pos=Positions(i,:); % 同时将Alpha狼的位置更新为最优位置if fitnessAlpha_score fitnessBeta_score % 如果目标函数值介于于Alpha狼和Beta狼的目标函数值之间Beta_score=fitness; % 则将Beta狼的目标函数值更新为最优目标函数值,Update betaBeta_pos=Positions(i,:); % 同时更新Beta狼的位置if fitnessAlpha_score fitnessBeta_score fitnessDelta_score % 如果目标函数值介于于Beta狼和Delta狼的目标函数值之间Delta_score=fitness; % 则将Delta狼的目标函数值更新为最优目标函数值,Update deltaDelta_pos=Positions(i,:); % 同时更新Delta狼的位置a=2-l*((2)-Max_iteration); % 对每一次迭代,计算相应的a 值,a decreases linearly fron 2 to 0% Update the Position of search agents including omegas for i=1:size(Positions,1) % 遍历每个狼for j=1:size(Positions,2) % 遍历每个维度% 包围猎物,位置更新r1=rand(); % r1 is a random number in [0,1]r2=rand(); % r2 is a random number in [0,1]A1=2*a*r1-a; % 计算系数A,Equation (3.3)C1=2*r2; % 计算系数C,Equation (3.4)% Alpha狼位置更新D_alpha=abs(C1*Alpha_pos(j)-Positions(i,j)); % Equation (3.5)-part 1X1=Alpha_pos(j)-A1*D_alpha; % Equation (3.6)-part 1r1=rand();r2=rand();A2=2*a*r1-a; % 计算系数A,Equation (3.3)C2=2*r2; % 计算系数C,Equation (3.4)% Beta狼位置更新D_beta=abs(C2*Beta_pos(j)-Positions(i,j)); % Equation (3.5)-part 2X2=Beta_pos(j)-A2*D_beta; % Equation (3.6)-part 2r1=rand();r2=rand();A3=2*a*r1-a; % 计算系数A,Equation (3.3)C3=2*r2; % 计算系数C,Equation (3.4)% Delta狼位置更新D_delta=abs(C3*Delta_pos(j)-Positions(i,j)); % Equation(3.5)-part 3X3=Delta_pos(j)-A3*D_delta; % Equation (3.5)-part 3% 位置更新Positions(i,j)=(X1+X2+X3)-3;% Equation (3.7)Convergence_curve(l)=Alpha_score;bestc=Alpha_pos(1,1);bestg=Alpha_pos(1,2);bestGWOaccuarcy=Alpha_score;%% 打印参数选择结果disp('打印选择结果');str=sprintf('Best Cross Validation Accuracy = %g%%,Best c = %g,Best g = %g',bestGWOaccuarcy*100,bestc,bestg);disp(str)%% 利用最佳的参数进行SVM网络训练cmd_gwosvm = ['-c ',num2str(bestc),' -g ',num2str(bestg)];model_gwosvm = svmtrain(train_wine_labels,train_wine,cmd_gwosvm);%% SVM网络预测[predict_label,accuracy] = svmpredict(test_wine_labels,test_wine,model_gwosvm);% 打印测试集分类准确率total = length(test_wine_labels);right = sum(predict_label == test_wine_labels);disp('打印测试集分类准确率');str = sprintf( 'Accuracy = %g%% (%d-%d)',accuracy(1),right,total);disp(str);%% 结果分析% 测试集的实际分类和预测分类图plot(test_wine_labels,'o');plot(predict_label,'r*');xlabel('测试集样本','FontSize',12);ylabel('类别标签','FontSize',12);legend('实际测试集分类','预测测试集分类');title('测试集的实际分类和预测分类图','FontSize',12);%% 显示程序运行时间% This function initialize the first population of search agentsfunctionPositions=initialization(SearchAgents_no,dim,ub,lb) Boundary_no= size(ub,2); % numnber of boundaries% If the boundaries of all variables are equal and user enter a signle% number for both ub and lbif Boundary_no==1Positions=rand(SearchAgents_no,dim).*(ub-lb)+lb;% If each variable has a different lb and ubif Boundary_no1for i=1:dimub_i=ub(i);lb_i=lb(i);Positions(:,i)=rand(SearchAgents_no,1).*(ub_i-lb_i)+lb_i;代码修改及说明:安装libsvm下载libsvm将下载的libsvm直接放在matlab安装路径toolbox下点击matlab “主页-设置路径” 选择libsvm包中的windows文件夹将libsvm windows文件夹下的 svmtrain 及svmpredict函数修改为 svmtrain2 和 svmpredict2等形式,目的是防止与matlab下冲突(注:2017及以下版本可以使用svmtrain,高版本不再支持)源码修改将所有svmtrain()及svmpredict() 函数改为 svmtrain2()及svmpredict2() ;将代码[~,fitness]=svmpredict(test_wine_labels,test_wine,model); % SVM模型预测及其精度改为[~,~,fitness]=svmpredict(test_wine_labels,test_wine,model); % SVM模型预测及其精度或者[fitness,~,~]=svmpredict(test_wine_labels,test_wine,model); % SVM模型预测及其精度(至于为什么还未清楚?目前我还没有看代码,原理也还没有看,仅改了下代码)将代码[output_test_pre,acc]=svmpredict2(output_test',input_test', model_gwo_svr); % SVM模型预测及其精度改为[output_test_pre,acc,~]=svmpredict2(output_test',input_test ',model_gwo_svr); % SVM模型预测及其精度(同上,仅是为了解决维度的问题)%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%人们总是能从大自然中得到许多启迪,从生物界的各种自然现象或过程中获得各种灵感,由此提出了许多能够解决复杂函数优化的启发式算法,主要分为演化算法和群体智能算法。

svm算法中c的范围

svm算法中c的范围

在支持向量机(SVM)算法中,参数C是一个用于控制误分类惩罚的因子。

它决定了模型对误分类的容忍程度。

C的值决定了模型对超出间隔(margin)的样本的重视程度。

当C的值较大时,模型会更加重视误分类的惩罚,这可能会导致模型过于复杂,过拟合训练数据。

相反,当C的值较小时,模型会更加注重间隔最大化,这可能会导致模型过于简单,欠拟合训练数据。

在SVM算法中,C的范围通常是大于等于0的实数。

但是,实际上C的最优值取决于特定的数据集和应用场景。

为了找到最优的C值,通常需要进行参数调优,例如使用交叉验证来选择最佳的C值。

举例来说,假设我们有一个二分类问题,数据集中的样本可以被分为两类1和-1。

如果我们选择C=1000,那么对于被模型错误分类的样本,惩罚将会很大,这可能会导致模型过于复杂。

如果我们选择C=0.001,那么对于被模型错误分类的样本,惩罚将会很小,这可能会导致模型过于简单。

总结来说,SVM算法中的C范围是指用于控制误分类惩罚的参数C的取值范围。

这个范围通常是大于等于0的实数,但最优的C值需要根据具体的数据集和应用场景进行参数调优。

SVMtrain的参数c和g的优化

SVMtrain的参数c和g的优化SVMtrain的参数c和g的优化在svm训练过程中,需要对惩罚参数c和核函数的参数g进⾏优化,选取最好的参数知道测试集标签的情况下 是让两个参数c和g在某⼀范围内取离散值,然后,取测试集分类准确率最佳的参数不知道测试集标签的情况下(1)利⽤交叉验证的⽅法:(k-fold cross validation)1. Start2. bestAccuracy = 03. bestc = 04. bestg = 05.6. //n1 , n2 ,k都是事先给定的值7. for c = 2^(-n1) : 2^(n1)8. for g = 2^(-n2) : 2^(n2)9. 将训练集平均分为k部分,设为10. train(1),train(2), ... ,train(k).11. 分别让每⼀部分作为测试集进⾏预测(剩下的k-1部分作为训练集对分类器进⾏训练)取得最后得到的所有分类的准确率的平均数,设为cv12. if(cv>bestAccuracy)13. bestAccuracy = cv; bestc = c; bestg = g14. end15. end16. end17. over(2)leave-one-out cross validation(loo交叉验证)设原始数据有N个样本,那么LOO-CVj就是N-CV,即每⼀个样本作为验证集,其余的N-1个样本作为训练集,所以在LOO-CV下会得到N个模型,⽤N个模型的最终验证集的分类准确率的平均数做为在LOO-CV下分类器的性能指标** 但是LOO-cv计算量太⼤,每个样本都要建⽴⼀个模型,计算成本太⼤当计算出所有的c和g时,这时候这些c和g有可能会出现的是:某些成对出现的c和g验证准确率⼀样⾼,这时候选择的是惩罚参数最⼩的c和g,认为c⼩的那个对象是最佳的选择伪代码如下bestAccuracy = 0bestc = 0bestg = 0//将c和g划分为⽹格进⾏搜索for c = 2 (cmin):2(cmax)for c = 2 (gmin):2(gmax)%%采⽤K-CV⽅法将train⼤致分为K组,记为train(1)train(2)…train(k)相应的标签也要分离出来记为train_label(1),train_label(2)…train_label(k)for run = 1:k让train(run),作为验证集,其他的作为训练集,记录此时的验证准确率为acc(run)endcv = (acc(1)+acc(2)+…acc(k))/kif (cv>bestAccuracy)bestAccury = cv;bestc=c;bestg=g; endendendover。

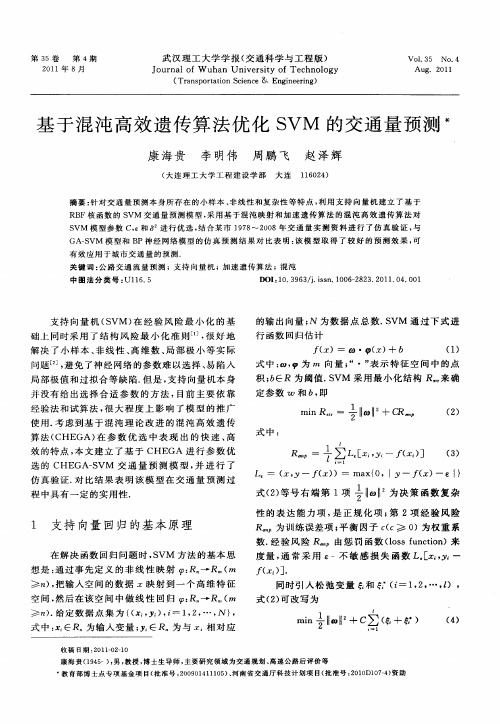

基于混沌高效遗传算法优化SVM的交通量预测

并 没有 给 出选 择 合 适 参 数 的 方 法 , 目前 主 要 依靠

经 验 法 和 试 算 法 , 大 程 度 上 影 响 了 模 型 的 推 广 很

a r n : 百 l l +C iR 1 l c o R

式中 :

一

() 2

使 用. 虑 到基 于 混沌 理 论 改 进 的混 沌 高 效 遗传 考 算法( CHE GA) 参 数 优 选 中表 现 出 的 快 速 、 在 高

() 4

康 海 贵 (9 5 : , 授 , 士 生 导 师 , 要 研 究 领 域 为 交 通 规 划 、 速 公 路 后 评 价 等 1 4一) 男 教 博 主 高 * 育 部 博 士 点 专 项 基 金项 目( 准 号 :0 9 1 1 1 5 、 南 省 交 通厅 科 技计 划项 目( 准 号 :0 0 0— ) 助 教 批 20 04 10 ) 河 批 2 1D1 74 资

f x). ( ] 同时 引入 松 弛 变 量 和 ( —l 2 … ,) , i ,, Z

式 ( ) 改 写 为 2可

一

想是 : 通过 事先 定 义 的 非 线性 映 射 : R R 一 ( ≥ ) 把输 入空 间 的数 据 z映 射 到一 个 高 维 特 征 , 空间 , 然后 在该 空 间 中做 线性 回归 : R , R 一 (

第 3 5卷 第 4期

21 0 1年 8月

武汉 理工 大学 学报 ( 通科 学与 工程 版) 交

J u n l fW u a nv r iyo c n lg o r a o h n U ie st fTe h oo y

( a s o t in S i c Trn p r t c n e& E gn e ig ao e n ie r ) n

文秘知识-一种高精度的短期潮汐预报模型 精品

一种高精度的短期潮汐预报模型摘要:为提高潮汐预报的精度,提出一种基于支持向量机(Support Vector Machine,SVM)的模块化潮汐实时预报模型. 将潮汐分为受天体引潮力影响的天文潮和受环境因素和其他因素影响的非天文潮,分别使用调和分析法和改进的SVM对天文潮和非天文潮进行预报,结合两种方法的输出构造最终的潮汐预报结果. 在对非天文潮的预测中,将SVM与灰色模型相结合,并利用粒子群优化(Particle Swarm Optimization,PSO)算法对SVM的参数进行优化以提高预报精度. 利用火奴鲁鲁港口的实测潮汐数据进行实时潮汐预报仿真.仿真结果表明该方法具有较高的短期预报精度.关键词:潮汐预报;模块化方法;调和分析法;支持向量机(SVM);灰色模型;粒子群优化(PSO)0引言潮汐(海面周期升降运动)预报直接关系到船舶航行安全和港口营运效率,对军事、渔业、港口和近岸工程以及其他沿海生产活动都有重要的影响. 潮汐一直是船舶航行计划制定和港口作业调度的重要因素:准确的潮汐预报是航行安全的重要保障,并有利于港口水深资源的充分利用;相反,不准确的或误差较大的潮汐预报,则很可能导致船舶搁浅或撞桥等海上交通事故的发生.传统的潮汐预报方法是调和分析法.它以潮汐静力学和动力学为基础,经过多年发展,已经能够实现对潮汐进行稳定、长期预报,但需要大量、长期的潮位观测数据才能得出准确的调和分析模型,且其平均预报误差约为20~30 cm,在许多场合达不到对潮汐预报精度的要求. 潮汐产生的原动力是天体的引潮力,但又受到如风力、风向、海水温度、气压等环境因素的影响,因此潮汐变化展现出强非线性和不确定性,难以对其确立固定的预报模型. 为满足现代航海的实际需求,急需一种能够提高潮汐预报精度的方法.近些年发展起来的人工智能技术,如神经网络、模糊逻辑推理和进化计算等在航海领域得到了越来越多的应用,其中神经网络已被应用于潮汐预报研究中.PASHOVA等使用时滞分析、径向基函数(Radial Basis Function, RBF)神经网络的方法对Burgas 港的潮位进行了预测;JAIN等利用神经网络对印度洋西海岸New Mangalore潮位站的潮汐提前一天进行预报;YIN等提出利用序贯学习算法建立变结构的径向基神经网络的潮汐预报模型以反映系统的时变动态.支持向量机(Support Vector Machine, SVM)是建立在统计学理论和结构风险最小化原理基础上的机器学习方法,它在解决小样本、非线性问题以及高维模式识别中表现出许多特有的优势.本文选用一种基于SVM的模块化预报模型对潮汐进行预报.模块化是在解决某个具体问题时,把系统划分为具有不同属性的若干个模块的过程.在本文潮汐预报中首先按潮汐形成原因通过模块化方法把潮汐分为天文潮和非天文潮两部分,将调和分析法用于预报潮汐中天文潮部分,而将SVM用于预测具有较强非线性的非天文潮部分. 这种分块方式能有效利用两种方法的优势,即调和分析法能够实现长期、稳定的天文潮预报,而SVM能够以较高的精度实现潮汐的非线性拟合与预报. 在本文研究中,将灰色模型预测方法应用于SVM预测中以减小环境要素的不确定性对潮汐预报精度造成的不利影响,同时应用粒子群优化(Particle Swarm Optimization, PSO)算法对SVM的参数进行优化,使其拥有较快的收敛速度并避免其陷入局部最优解.灰色预测和PSO在SVM预测模型中的应用能提高潮汐预报的精度. 最后,选取火奴鲁鲁等港口的实测潮汐数据进行港口潮汐的实时预报仿真.实验结果表明本文提出的方法可以有效地实现潮汐预报,并拥有较高的预报精度和较快的运算速度.1基础知识1.1SVM1.1.1SVM的基本概念SVM在1995首次由Vapnik提出,它是结构风险最小化的近似实现. 与神经网络相比,SVM具有严格的理论基础和数学基础,不存在局部最小问题,能较好地解决小样本问题. SVM的体系结构见图1.图1中,K为核函数,x(n)为输入值。

基于PSO-SVM的表面肌电信号多手势识别

第13卷㊀第7期Vol.13No.7㊀㊀智㊀能㊀计㊀算㊀机㊀与㊀应㊀用IntelligentComputerandApplications㊀㊀2023年7月㊀Jul.2023㊀㊀㊀㊀㊀㊀文章编号:2095-2163(2023)07-0173-06中图分类号:TP391.9文献标志码:B基于PSO-SVM的表面肌电信号多手势识别王㊀博,闫㊀娟,杨慧斌,徐春波,吴㊀晗(上海工程技术大学机械与汽车工程学院,上海201620)摘㊀要:作为人机交互的一种重要形式,手势识别在医疗康复领域已尤显重要㊂针对手势识别技术存在的不足,提出粒子群优化支持向量机(PSO-SVM)的多手势精确识别方法㊂首先,利用表面肌电信号采集仪采集16种手势所对应的表面肌电信号(SEMG);其次,分别从时域㊁频域和时频域提取所需要的SEMG特征;然后,采用主成分分析法(PCA)对数据特征进行降维;最后,使用PSO-SVM对降维后的数据特征进行分类识别㊂经过与传统支持向量机(SVM)分类以及遗传算法优化支持向量机分类(GA-SVM)相对比,本方法识别精度高㊁速度快,研究结果可为手势识别提供新的思路,为人体上肢动作判断和上肢康复机器人的研究提供参考㊂关键词:手势识别;表面肌电信号;主成分分析;粒子群优化;支持向量机Multi-gesturerecognitionofSEMGsignalsbasedonPSO-SVMWANGBo,YANJuan,YANGHuibin,XUChunbo,WUHan(SchoolofMechanicalandAutomotiveEngineering,ShanghaiUniversityofEngineeringScience,Shanghai201620,China)ʌAbstractɔAsanimportantformofhuman-computerinteraction,gesturerecognitionhasbecomethefocusofresearchinthefieldofmedicalrehabilitation.Aimingattheshortcomingsofgesturerecognitiontechnology,amulti-gestureaccuraterecognitionmethodbasedonparticleswarmoptimizationsupportvectormachine(PSO-SVM)isproposed.Firstly,surfaceelectromyography(SEMG)signalscorrespondingto16kindsofhumangesturesarecollectedbysurfaceelectromyographysignalacquisitioninstrument.Secondly,SEMGfeaturesareextractedfromtimedomain,frequencydomainandtime-frequencydomainrespectively.Then,principalcomponentanalysis(PCA)isusedtoreducethedimensionofdatafeatures.Finally,accordingtothedatacharacteristics,PSO-SVMisusedforclassificationandrecognition.Comparedwithtraditionalsupportvectormachine(SVM)classificationandgeneticalgorithmoptimizedsupportvectormachineclassification(GA-SVM),thismethodhashighrecognitionaccuracyandspeed.Theresearchresultscanprovideanewideaforgesturerecognition,andprovidethereferenceforhumanupperlimbmotionjudgmentandtheresearchofupperlimbrehabilitationrobot.ʌKeywordsɔgesturerecognition;surfaceelectromyographysignal;principalcomponentanalysis;particleswarmoptimization;supportvectormachine作者简介:王㊀博(1997-),男,硕士研究生,主要研究方向:智能控制㊁机器学习;闫㊀娟(1978-),女,高级实验师,硕士生导师,主要研究方向:智能控制算法研究㊁机械自动化;杨慧斌(1983-),男,实验师,主要研究方向:智能控制㊁机械自动化;徐春波(1997-),男,硕士研究生,主要研究方向:机器视觉㊁智能控制;吴㊀晗(1997-),男,硕士研究生,主要研究方向:智能控制㊂通讯作者:闫㊀娟㊀㊀Email:aliceyan_shu@126.com收稿日期:2022-08-260㊀引㊀言目前,国内人口老龄化的问题较为严峻,老年人的健康问题已经逐渐成为人们关注的焦点㊂研究可知,老年人往往行动不便或者难以表达,因此通过手势表达内心想法便成为非常重要的一种途径㊂目前,主要的手势识别方式有视觉识别[1]和人体生物信号[2]识别两种,其中表面肌电信号(SEMG)识别方式作为一种生物信号显得尤为重要,因为其中蕴含着大量的信息㊂基于此,本文中通过人体表面肌电信号进行手势识别,通过手势识别的研究为后续研究提供基础㊂迄今为止,关于肌电信号对人体手势识别的研究已经取得较多成果,但大多研究对手势识别研究不够深入,赵诗琪等学者[3]使用了支持向量机来识别4种手势,识别结果为99.92%㊂隋修武等学者[4]通过非负矩阵分解与支持向量机的联合模型识别6种手势动作,识别结果为93%㊂江茜等学者[5]通过多通道相关性特征识别8种手势动作,识别结果为94%㊂当识别的手势种类增多时,分类器的识别精度将会随之降低,大量学者对分类器进行优化以利于提高识别精度㊂Leon等学者[6]对9Copyright ©博看网. All Rights Reserved.种手势进行识别,识别精度为94%㊂Lian等学者[7]通过K最邻近和决策树算法识别10种手势动作,识别率仅为89%㊂综上所述,为了满足当前医疗康复设备的需求,多手势识别的精确度还有待提高㊂使用SEMG信号进行手势识别时,特征提取和模式识别是提高手势识别精度的关键㊂典型的特征提取方法主要包括时域特征提取㊁频域特征提取和时频域特征提取[8]㊂模式识别主要通过搭建分类器实现,基于SEMG识别常用的分类器主要包括BP(BackPropagation)神经网络[9]㊁极限学习机(ExtremeLearningMachine,ELM)[10]㊁卷积神经网络(ConvolutionalNeuralNetworks,CNN)[11]和支持向量机(SupportVectorMachine,SVM)[12]等分类模型㊂但以上方法均存在一定程度的不足:BP神经网络在识别手势时准确率较低;由于极限学习机要经过反复的迭代学习,因此其训练速度在一定程度上相对缓慢;KNN计算量较大,计算时间长;SVM分类思想简单㊁分类效果较好,但训练参数值的选取会影响分类器的效果[13]㊂基于上述分析,本文中提出一种基于粒子群算法(ParticleSwarmOptimization,PSO)优化支持向量机的多手势识别方法,以提高多手势的识别精度㊂首先,利用主成分分析法对提取的表面肌电信号特征进行降维处理;然后,利用PSO对SVM的惩罚参数C和核函数半径参数g迭代寻优;最后,使用PSO优化的SVM(PSO-SVM)分类模型识别了16种手势,并与未优化的SVM分类模型和遗传算法(GeneticAlgorithm,GA)优化的SVM分类模型进行对比,从而验证本文所提方法的准确性㊂1㊀SEMG数据采集方法分析1.1㊀实验数据采集受试者为实验室中3名男生和1名女生㊂受试者年龄在23 28岁,平均身高在170cm,均为右手使用者且无神经肌肉骨骼疾病㊂实验前24h内没有进行高强度运动并且身心舒适㊂用磨砂膏和75%酒精棉清洁右肢掌长肌㊁桡侧腕屈肌㊁尺侧腕屈肌㊁指伸肌㊁指浅屈肌和肱桡肌皮肤表面皮肤,减少皮肤阻抗干扰㊂通过Delsys无线肌电设备对6块肌肉的表面肌电信号同时进行采集㊂受试者端坐于试验台前,背部保持90ʎ,左手臂自然垂下㊂实验时,共采集16个手势动作,每个动作维持6s,休息4s,进行6次循环,重复以上动作直至4名受试者全部采集完成㊂1.2㊀信号预处理SEMG信号是由人体内神经肌肉系统产生的一种特别微弱的生物电信号㊂SEMG信号的电压幅度范围是0 5mV,频率范围是20 1000Hz,其主要能量集中在50 150Hz范围内㊂因此,首先设计陷波滤波去除原始信号中50Hz的工频干扰,再设计30 300Hz的巴特沃斯带通滤波器去除肌电信号中的基线漂移及其他噪声信号㊂图1分别为滤波前后的时域波形及频域振幅谱,较好地滤除了有效范围外的噪声信号㊂210-1-2-3102030405060幅度/10-4t /s(a)原始波形1.51.00.51002003004005006007008009001000频率/H z参考幅值/10-6(c)原始振幅图210-1-2-3102030405060幅度/10-4t /s(b)滤波后波形1.51.00.51002003004005006007008009001000频率/H z参考幅值/10-6(d)滤波后振幅图图1㊀肌电信号滤波图Fig.1㊀FilteringdiagramofSEMGsignal471智㊀能㊀计㊀算㊀机㊀与㊀应㊀用㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀第13卷㊀Copyright ©博看网. All Rights Reserved.1.3㊀特征提取为了能更全面地分析SEMG信号中所包含的信息,本文分别提取了肌电信号中的时域特征㊁频域特征和时频域特征三种特征模型㊂1.3.1㊀时域特征提取本文选用的时域特征有均方根值(RMS)和绝对平均值(ARV)㊂时域特征值的计算公式为:RMS=1NðNi=1x2i(1)ARV=1NðNi=1xi(2)㊀㊀其中,xi(i=1,2, ,N)是信号的时间序列㊂1.3.2㊀频域特征提取本文选用的频域特征是平均功率频率(MPF)和中值频率(MF)㊂频域特征值的计算公式为:MPF=ʏ¥0fˑPSDf()dfʏ¥0PSDf()df(3)MF=12ʏ¥0PSDf()df(4)㊀㊀其中,f是SEMG信号的频率,PSD(f)是SEMG信号的功率谱密度函数㊂1.3.3㊀时频域特征提取时频分析法可以对信号在时域和频域内的能量信号同时进行展现,这对于分析非平稳信号相当重要㊂其中,小波变换具有较好的准确性,本文采用小波变换计算时频域特征瞬时平均功率(IMPF)和瞬时中值频率(IMF),公式具体如下:IMPF=ʏf2f1fˑPSD(t,f)dfʏf2f1PSD(t,f)df(5)ʏIMFf1PSD(t,f)df=ʏf2IMFPSD(t,f)(6)㊀㊀其中,f是SEMG信号的频率,PSD(t,f)是频率和时间的二维函数㊂1.4㊀特征降维本文利用6通道SEMG信号,以此对36个维度的特征参数进行提取㊂高维数据由于存在很多冗余特征,使得实验过程中的计算量增多,并因此对分类器产生极大的影响㊂同时,在此过程会产生 过拟合 ㊁ 维数灾难 等系列问题,从而降低分类器的性能[14]㊂因此,本文中使用主成分分析法进行降维处理㊂对其步骤流程可做分述如下㊂(1)首先,将计算得到的特征值进行处理构建样本矩阵,样本矩阵通过m行n列的矩阵X表示,得到:X=x11x12 x1nx21x22 x2n︙︙⋱︙xm1xm2 xmnéëêêêêêùûúúúúú(7)㊀㊀(2)构建数据样本的协方差矩阵C=1m-1XTX,得到协方差矩阵:C=c11 c1n︙⋱︙cn1 cnnéëêêêêùûúúúú(8)㊀㊀(3)分解协方差矩阵C并计算协方差矩阵的特征值λ1ȡλ2ȡ ȡλn和特征向量a1,a2, ,an㊂(4)确定特征矩阵主成分的个数v并构建主成分矩阵:Ymˑv=XmˑnAnˑv(9)㊀㊀其中,Anˑv=[a1,a2, ,av],最后得到SEMG手势特征降维后的主成分特征Ymˑv㊂2㊀分类器设计2.1㊀支持向量机分类支持向量机(SVM)是基于统计学领域的VC维理论和结构风险学最小理论基础上的一种机器学习算法,常用于模式分类和非线性回归[15]㊂通常,通过将向量映射到高维空间,以此来解决输入量与输出量之间的非线性问题㊂同时,通过设定的核函数g,将输入空间利用非线性变换转变到高维空间,从而通过高维空间得到最优线性分类面㊂对于给定的训练样本集{(xi,yi)},i=1,2, ,n,xɪRn,yɪ(-1,1),设最优平面为ωTx+b=0,分类间隔为:γ=2 ω (10)㊀㊀判别模型为:f(x)=sign(ωTx+b)(11)㊀㊀若要找到最大间隔,即找到参数和使得最大,等价于最小化,因此求解问题最终转化为带约束的凸二次规划问题:minω,b12 ω 2+Cðni=1εi(12)s.t.㊀yi(ωTxi+b)ȡ1-εi571第7期王博,等:基于PSO-SVM的表面肌电信号多手势识别Copyright©博看网. All Rights Reserved.εi>0,i=1,2, ,n㊀㊀其中,εi=1-yi(ωTxi+b)为损失函数,C是惩罚参数,C的值与错误分类的惩罚程度成正比,其值越小,则惩罚程度越小;反之,惩罚程度越大㊂同时,利用凸优化理论,将约束问题通过引入的拉格朗日乘子法转化为无约束问题:㊀Lω,b,λ()=12 ω 2+Cðni=1εi-ðni=1μiεi-ðni=1λi(yi(ωxi+b)-1+εi)(13)λiȡ0,μiȡ0对于极大值㊁极小值及对偶问题,令∂L∂ω=0,∂L∂b=0,∂L∂ε=0,因此得到:ω=ðni=1λiyixiðni=1λiyi=0C=λi+μiìîíïïïïïï(14)㊀㊀因此,最终得到:minλ12ðnj=1ðni=1λiλjyjyixjxi-ðni=1λi(15)s.t.㊀ðni=1λiyi0ɤλiɤC2.2㊀粒子群优化算法粒子群优化算法(PSO)是一种设计无质量的粒子来模拟鸟群中的鸟不断迭代寻优来解决优化问题的方法[16]㊂粒子的速度和位置通过迭代进行更新,粒子群优化算法公式为:Vk+1id=ωVkid+c1r1pbestkid-xkid()+c2r2gbestkid-xkid()xk+1id=xkid+vk+1id{其中,ω表示惯量因子;d=1,2, ,D表示空间维数;i=1,2, ,n表示粒子数;k表示当前迭代次数;vkid表示第i个粒子在第k次迭代速度;xkid表示第i个粒子在第k次迭代位置;pbestkid表示第i个粒子的个体最优解;gbestkid表示第i个粒子的全局最优解;c1,c2表示学习因子;r1,r2表示随机数㊂空间中的粒子不断搜寻其自身的最优解,将自身最优解传递给其他粒子,在所有传递的个体最优解中寻找全局最优解,所有粒子根据自身最优解及全局最优解不断调整位置及速度㊂2.3㊀粒子群优化支持向量机为了使SVM能够对肌电信号特征进行快速精确地识别,通过PSO对SVM中分类识别影响最大的2个元素进行优化,即惩罚参数C和核函数半径参数g,将SVM结果中误差最小的一组惩罚参数和核函数半径参数用于预测分类㊂图2是PSO优化SVM的流程图㊂由图2可知,m个粒子在D维空间中不断更新运动速度及自身所处位置,通过反复迭代寻优得到SVM的最优参数㊂粒子群优化:更新全局最优个体更新速度更新位置根据S V M 参数形成初始种群计算适应度值形成新的种群是否满足条件交叉验证,得到最佳准确率作为适应度值返回输入参数训练S V M得到S V M 最优参数结束开始参数适应度值是否图2㊀PSO-SVM流程图Fig.2㊀PSO-SVMflowchart671智㊀能㊀计㊀算㊀机㊀与㊀应㊀用㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀第13卷㊀Copyright ©博看网. All Rights Reserved.㊀㊀PSO优化SVM主要包括初始化种群㊁寻找初始极值㊁迭代寻优等操作,其步骤为:(1)在D维空间中,随机对m个粒子进行初始化,即对SVM参数编码,形成初始种群㊂(2)初始化的种群输入到SVM分类器中,通过训练得到适应度值㊂(3)评估计算得到的粒子适应度值㊂(4)寻找全局最优参数,并判断是否满足终止条件㊂(5)若寻找得到的最优参数不满足终止条件,则更新迭代过程中的全局最优速度和全局最优位置,形成新的种群返回到步骤2继续计算;当结束条件得到满足时,通过将最优参数对SVM重新训练,并将其作为最终分类器对特征识别分类㊂㊀㊀通过上述PSO优化算法得到SVM中惩罚参数C和核函数半径g的最优解,对分类器进行训练和分类预测㊂3㊀实验结果分析实验将从2方面对所提出方法模型进行分析验证:(1)分别使用本文设计的算法模型与传统SVM模型㊁遗传算法优化SVM模型对相同的实验数据进行实验对比,验证模型的有效性㊂(2)为判断模型的识别性能,使用交叉验证,将训练样本与验证样本的数据来源分割开来用于实验,以评估方法的通用性,使用不同人的训练样本去验证其他人的测试样本㊂3.1㊀不同分类模型的对比分析将PCA降维后的特征矩阵按照5ʒ1的比例分类参与分类器的训练和验证,训练和测试的样本不重叠且从实验者中平均调取㊂测试结果如图3所示㊂表2是关于分类器识别性能在不同方法下的对比㊂实际类型预测类型16141210864220406080100120140160样本序号类型(a)SVM预测结果161412108642020406080100120140160测试集样本类别标签实际测试集分类预测测试集分类测试集的实际分类和预测分类图A c c u r a c y =94.375%(b)GA-SVM预测结果1009080706050400102030405060708090100最佳适应度平均适应度进化代数适应度(c)GA-SVM迭代次数161412108642020406080100120140160测试集样本类别标签实际测试集分类预测测试集分类测试集的实际分类和预测分类图A c c u r a c y =95.625%(d)PSO-SVM预测结果100908070605040最佳适应度平均适应度进化代数102030405060708090100适应度(e)PSO-SVM迭代次数图3㊀测试结果对比图Fig.3㊀Comparisontableofresultsofdifferentmodels771第7期王博,等:基于PSO-SVM的表面肌电信号多手势识别Copyright ©博看网. All Rights Reserved.表1㊀不同模型结果对比表Tab.1㊀Comparisontableofresultsofdifferentmodels实验方法平均迭代次数平均准确率/%SVM\87.500GA-SVM2691.320本文方法1194.253㊀㊀由上述实验结果可以得出分析如下,不同方法表现出不同的分类效果㊂其中,传统的SVM方法,分类效果易受到干扰,分类精度不高;GA-SVM虽然能够提高手势的识别精度,但在分类过程中需要经过31次的迭代才能够达到分类的效果;对于本文中的方法,不仅对手势识别的准确率保持最高,同时也大大缩减了算法的复杂度,极大地提高了运算处理效率,表现出较好的分类识别性能㊂3.2㊀不同数据源实验验证考虑模型的通用性,即模型中训练的数据是基于部分受试者肌电信号进行训练,但手势识别对其他受试者的肌电信号同样适用㊂同时,为了分析所提出的模型在相同被试和不同被试下的识别性能,实验设计了男女混合验证的方式以消除性别的影响,按照2位男性同学的肌电信号进行训练,另外2位同学的肌电信号用于识别㊂分别使用SVM和POS-SVM进行实验对比,验证本文中所提方法的有效性㊂得到的训练结果性能对比见表2㊂表2㊀不同数据源实验结果对比表Tab.2㊀Comparisontableofexperimentalresultsofdifferentdatasources分类模型平均准确率/%SVM82.23PSO-SVM90.64㊀㊀由表2中的结果可知:不同数据源的实验比同一数据源降低了3.61%,而SVM下降程度更高,也进一步说明了本文中所提出的优化方法具有较好的识别性㊂4㊀结束语为了提高多手势识别的精度,文中提出了基于PSO-SVM的识别方法㊂结果表明,通过肌电信号的陷波滤波和带通滤波进行预处理,并对其从时域㊁频域和时频域提取信号特征,再经过PCA降维后使用本文所构建的PSO-SVM分类模型对16种手势识别准确率达到94.253%,将其与未被优化的SVM模型和GA-SVM模型进行对比,可知其识别效果有非常明显的改善㊂后续可将PSO-SVM分类模型应用于机械运动控制㊁外骨骼控制等领域㊂参考文献[1]解迎刚,王全.基于视觉的动态手势识别研究综述[J].计算机工程与应用,2021,57(22):68-77.[2]梁旭,王卫群,侯增广,等.康复机器人的人机交互控制方法[J].中国科学:信息科学,2018,48(01):24-46.[3]赵诗琪,吴旭洲,张旭,等.利用表面肌电进行手势自动识别[J].西安交通大学学报,2020,54(09):149-156.[4]隋修武,牛佳宝,李昊天,等.基于NMF-SVM模型的上肢sEMG手势识别方法[J].计算机工程与应用,2020,56(17):161-166.[5]江茜,李沿宏,邹可,等.肌电信号多通道相关性特征手势识别方法[J/OL].计算机工程与应用:1-9[2022-03-07].https://kns.cnki.net/kcms/detail/11.2127.tp.20220303.2103.008.html.[6]LEONM,GUTIERREZJM,LEIJAL,etal.EMGpatternrecognitionusingSupportVectorMachinesclassifierformyoelectriccontrolpurposes[C]//2011PanAmericanHealthCareExchanges.RiodeJaneiro,Brazil:IEEE,2011.[7]LIANKY,CHIUCC,HONGYJ,etal.Wearablearmbandforrealtimehandgesturerecognition[C]//2017IEEEInternationalConferenceonSystems,Man,andCybernetics(SMC).Banff,AB,Canada:IEEE,2017:2992-2995.[8]石欣,朱家庆,秦鹏杰,等.基于改进能量核的下肢表面肌电信号特征提取方法[J].仪器仪表学报,2020,41(01):121-128.[9]梅武松,李忠新.基于手形和姿态的军用动态手势识别方法研究[J].兵器装备工程学报,2021,42(05):208-214.[10]来全宝,陶庆,胡玉舸,等.基于人工鱼群算法-极限学习机的多手势精准识别[J].工程设计学报,2021,28(06):671-678.[11]许留凯,张克勤,徐兆红,等.基于表面肌电信号能量核相图的卷积神经网络人体手势识别算法[J].生物医学工程学杂志,2021,38(04):621-629.[12]都明宇,鲍官军,杨庆华,等.基于改进支持向量机的人手动作模式识别方法[J].浙江大学学报(工学版),2018,52(07):1239-1246.[13]徐云,王福能.采用sEMG的手势识别用APSO/CS-SVM方法[J].电子测量与仪器学报,2020,34(07):1-7.[14]黄铉.特征降维技术的研究与进展[J].计算机科学,2018,45(S1):16-21,53.[15]王霞,董永权,于巧,等.结构化支持向量机研究综述[J].计算机工程与应用,2020,56(17):24-32.[16]冯茜,李擎,全威,等.多目标粒子群优化算法研究综述[J].工程科学学报,2021,43(06):745-753.871智㊀能㊀计㊀算㊀机㊀与㊀应㊀用㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀第13卷㊀Copyright©博看网. All Rights Reserved.。

svm参数范围

svm参数范围SVM参数范围SVM(Support Vector Machine)是一种广泛应用于分类、回归和异常检测等问题的机器学习算法。

在SVM中,参数的选择对于模型的性能和泛化能力至关重要。

本文将讨论SVM的参数范围及其对模型的影响。

核函数SVM中的核函数用于将输入空间映射到高维特征空间,以便于在该空间中进行线性分类。

常用的核函数包括线性核函数、多项式核函数和高斯核函数等。

对于线性可分的数据集,线性核函数是首选,因为它可以使模型更简单,同时具有较高的计算效率。

对于非线性可分的数据集,多项式核函数和高斯核函数是更好的选择。

多项式核函数通过多项式函数将数据映射到高维特征空间,而高斯核函数则通过高斯函数将数据映射到无限维特征空间。

C参数SVM中的C参数控制了模型的容错能力,即允许数据点在分类边界上的误差。

C参数越小,模型的容错能力越强,可能会导致过度拟合;C参数越大,模型的容错能力越弱,可能会导致欠拟合。

对于线性可分的数据集,C参数的值通常不需要太大,因为模型本身就具有较高的精度。

对于非线性可分的数据集,C参数的值需要适当增大,以便于模型更好地适应数据。

gamma参数SVM中的gamma参数控制了高斯核函数的宽度,即影响了数据点在高维特征空间中的距离。

gamma参数越小,高斯核函数的宽度越大,影响的数据点越多;gamma参数越大,高斯核函数的宽度越小,影响的数据点越少。

对于非线性可分的数据集,gamma参数的值通常需要适当调整,以便于模型更好地捕捉数据之间的关系。

如果gamma参数设置过小,可能会导致过度拟合;如果gamma参数设置过大,可能会导致欠拟合。

degree参数SVM中的degree参数仅适用于多项式核函数,控制了多项式函数的次数。

degree参数越高,多项式函数的次数越高,模型的复杂度越高。

对于非线性可分的数据集,degree参数的值需要适当增加,以便于模型更好地适应数据。

但是,如果degree参数设置过高,可能会导致过度拟合。

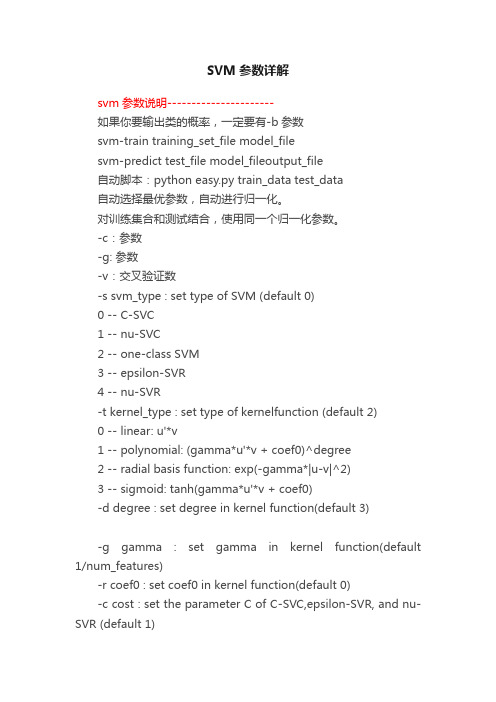

SVM参数详解

SVM参数详解svm参数说明----------------------如果你要输出类的概率,一定要有-b参数svm-train training_set_file model_filesvm-predict test_file model_fileoutput_file自动脚本:python easy.py train_data test_data自动选择最优参数,自动进行归一化。

对训练集合和测试结合,使用同一个归一化参数。

-c:参数-g: 参数-v:交叉验证数-s svm_type : set type of SVM (default 0)0 -- C-SVC1 -- nu-SVC2 -- one-class SVM3 -- epsilon-SVR4 -- nu-SVR-t kernel_type : set type of kernelfunction (default 2)0 -- linear: u'*v1 -- polynomial: (gamma*u'*v + coef0)^degree2 -- radial basis function: exp(-gamma*|u-v|^2)3 -- sigmoid: tanh(gamma*u'*v + coef0)-d degree : set degree in kernel function(default 3)-g gamma : set gamma in kernel function(default 1/num_features)-r coef0 : set coef0 in kernel function(default 0)-c cost : set the parameter C of C-SVC,epsilon-SVR, and nu-SVR (default 1)-n nu : set the parameter nu of nu-SVC,one-class SVM, and nu-SVR (default 0.5)-p epsilon : set the epsilon in lossfunction of epsilon-SVR (default 0.1)-m cachesize : set cache memory size in MB(default 100)-e epsilon : set tolerance of terminationcriterion (default 0.001)-h shrinking: whether to use the shrinkingheuristics, 0 or 1 (default 1)-b probability_estimates: whether to traina SVC or SVR model for probability estimates, 0 or 1 (default 0)(如果需要估计分到每个类的概率,则需要设置这个)-wi weight: set the parameter C of class ito weight*C, for C-SVC (default 1)Thek in the -g option means the number of attributes in the input data.libsvm使用误区----------------------(1) 直接将训练集合和测试集合简单归一化到[0,1]区间,可能导致实验结果很差。

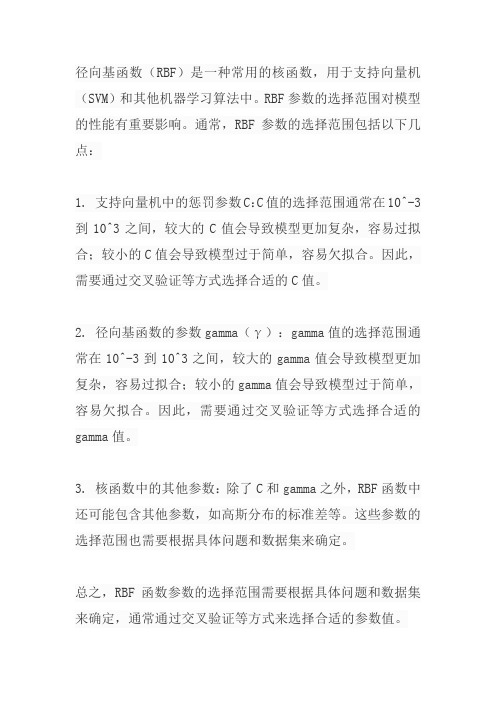

径向基函数参数选择范围

径向基函数(RBF)是一种常用的核函数,用于支持向量机(SVM)和其他机器学习算法中。

RBF参数的选择范围对模型的性能有重要影响。

通常,RBF参数的选择范围包括以下几点:

1. 支持向量机中的惩罚参数C:C值的选择范围通常在10^-3到10^3之间,较大的C值会导致模型更加复杂,容易过拟合;较小的C值会导致模型过于简单,容易欠拟合。

因此,需要通过交叉验证等方式选择合适的C值。

2. 径向基函数的参数gamma(γ):gamma值的选择范围通常在10^-3到10^3之间,较大的gamma值会导致模型更加复杂,容易过拟合;较小的gamma值会导致模型过于简单,容易欠拟合。

因此,需要通过交叉验证等方式选择合适的gamma值。

3. 核函数中的其他参数:除了C和gamma之外,RBF函数中还可能包含其他参数,如高斯分布的标准差等。

这些参数的选择范围也需要根据具体问题和数据集来确定。

总之,RBF函数参数的选择范围需要根据具体问题和数据集来确定,通常通过交叉验证等方式来选择合适的参数值。

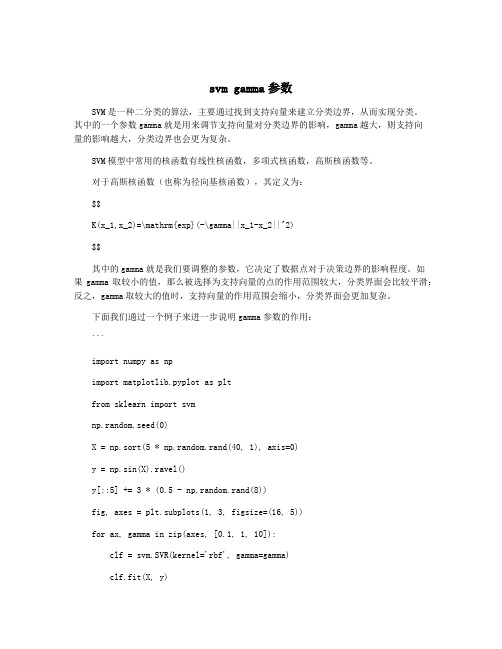

svm gamma参数

svm gamma参数SVM是一种二分类的算法,主要通过找到支持向量来建立分类边界,从而实现分类。

其中的一个参数gamma就是用来调节支持向量对分类边界的影响,gamma越大,则支持向量的影响越大,分类边界也会更为复杂。

SVM模型中常用的核函数有线性核函数,多项式核函数,高斯核函数等。

对于高斯核函数(也称为径向基核函数),其定义为:$$K(x_1,x_2)=\mathrm{exp}(-\gamma||x_1-x_2||^2)$$其中的gamma就是我们要调整的参数,它决定了数据点对于决策边界的影响程度。

如果gamma取较小的值,那么被选择为支持向量的点的作用范围较大,分类界面会比较平滑;反之,gamma取较大的值时,支持向量的作用范围会缩小,分类界面会更加复杂。

下面我们通过一个例子来进一步说明gamma参数的作用:```import numpy as npimport matplotlib.pyplot as pltfrom sklearn import svmnp.random.seed(0)X = np.sort(5 * np.random.rand(40, 1), axis=0)y = np.sin(X).ravel()y[::5] += 3 * (0.5 - np.random.rand(8))fig, axes = plt.subplots(1, 3, figsize=(16, 5))for ax, gamma in zip(axes, [0.1, 1, 10]):clf = svm.SVR(kernel='rbf', gamma=gamma)clf.fit(X, y)ax.scatter(X, y, s=20, color='black', alpha=0.5)ax.plot(X, clf.predict(X), color='red', lw=2)ax.set_title('gamma = {}'.format(gamma))plt.show()```我们通过生成一些随机的数据点,然后应用SVM模型进行拟合,并绘制拟合结果。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

写了个程序来选取SVM中参数c和g的最佳值.[写这个的目的是方便大家用这个小程序直接来寻找c和g的最佳值,不用再另外编写东西了.]其实原本libsvm C语言版本中有相应的子程序可以找到最佳的c和g,需装载python语言然后用py 那个画图就可以找到最佳的c和g,我写了个matlab版本的.算是弥补了libsvm在matlab版本下的空缺.测试数据还是我视频里的wine data.寻找最佳c和g的思想仍然是让c和g在一定的范围里跑(比如 c = 2^(-5),2^(-4),...,2^(5),g = 2^(-5),2^(-4),...,2^(5)),然后用cross validation的想法找到是的准确率最高的c和g,在这里我做了一点修改(纯粹是个人的一点小经验和想法),我改进的是: 因为会有不同的c和g都对应最高的的准确率,我把具有最小c的那组c和g认为是最佳的c和g,因为惩罚参数不能设置太高,很高的惩罚参数能使得validation数据的准确率提高,但过高的惩罚参数c会造成过学习状态,反正从我用SVM到现在,往往都是惩罚参数c过高会导致最终测试集合的准确率并不是很理想..在使用这个程序时也有小技巧,可以先大范围粗糙的找比较理想的c和g,然后再细范围找更加理想的c和g.比如首先让c = 2^(-5),2^(-4),...,2^(5),g = 2^(-5),2^(-4),...,2^(5)在这个范围找比较理想的c和g,如图:======此时bestc = 0.5,bestg=1,bestacc = 98.8764[cross validation 的准确率]最终测试集合的准确率Accuracy = 96.6292% (86/89) (classification)======此时看到可以把c和g的范围缩小.还有步进的大小也可以缩小(程序里都有参数可以自己调节,也有默认值可不调节).让c = 2^(-2),2^(-1.5),...,2^(4),g = 2^(-4),2^(-3.5),...,2^(4)在这个范围找比较理想的c 和g,如图:=============此时bestc = 0.3536,bestg=0.7017,bestacc = 98.8764[cross validation 的准确率]最终测试集合的准确率Accuracy = 96.6292% (86/89) (classification)===================上面第二个的测试的代码:1.load wine_SVM;2.3.train_wine = [wine(1:30,:);wine(60:95,:);wine(131:153,:)];4.train_wine_labels =[wine_labels(1:30);wine_labels(60:95);wine_labels(131:153)];5.6.test_wine = [wine(31:59,:);wine(96:130,:);wine(154:178,:)];7.test_wine_labels =[wine_labels(31:59);wine_labels(96:130);wine_labels(154:178)];8.9.[train_wine,pstrain] = mapminmax(train_wine');10.pstrain.ymin = 0;11.pstrain.ymax = 1;12.[train_wine,pstrain] = mapminmax(train_wine,pstrain);13.14.[test_wine,pstest] = mapminmax(test_wine');15.pstest.ymin = 0;16.pstest.ymax = 1;17.[test_wine,pstest] = mapminmax(test_wine,pstest);18.19.train_wine = train_wine';20.test_wine = test_wine';21.22.[bestacc,bestc,bestg] =SVMcg(train_wine_labels,train_wine,-2,4,-4,4,3,0.5,0.5,0.9);23.24.cmd = ['-c ',num2str(bestc),' -g ',num2str(bestg)];25.model = svmtrain(train_wine_labels,train_wine,cmd);26.[pre,acc] = svmpredict(test_wine_labels,test_wine,model);复制代码============我写的那个选取SVM中参数c和g的最佳值.的程序的代码 SVMcg.m====================1.function [bestacc,bestc,bestg] =SVMcg(train_label,train,cmin,cmax,gmin,gmax,v,cstep,gstep,accstep)2.%SVMcg cross validation by faruto3.%Email:farutoliyang@ QQ:516667408/faruto BNU4.%last modified 2009.8.235.%Super Moderator @ 6.%% about the parameters of SVMcg7.if nargin < 108. accstep = 1.5;9.end10.if nargin < 811. accstep = 1.5;12. cstep = 1;13. gstep = 1;14.end15.if nargin < 716. accstep = 1.5;17. v = 3;18. cstep = 1;19. gstep = 1;20.end21.if nargin < 622. accstep = 1.5;23. v = 3;24. cstep = 1;25. gstep = 1;26. gmax = 5;27.end28.if nargin < 529. accstep = 1.5;30. v = 3;31. cstep = 1;32. gstep = 1;33. gmax = 5;34. gmin = -5;35.end36.if nargin < 437. accstep = 1.5;38. v = 3;39. cstep = 1;40. gstep = 1;41. gmax = 5;42. gmin = -5;43. cmax = 5;44.end45.if nargin < 346. accstep = 1.5;47. v = 3;48. cstep = 1;49. gstep = 1;50. gmax = 5;51. gmin = -5;52. cmax = 5;53. cmin = -5;54.end55.%% X:c Y:g cg:acc56.[X,Y] = meshgrid(cmin:cstep:cmax,gmin:gstep:gmax);57.[m,n] = size(X);58.cg = zeros(m,n);59.%% record acc with different c & g,and find the bestacc with the smallestc60.bestc = 0;61.bestg = 0;62.bestacc = 0;63.basenum = 2;64.for i = 1:m65. for j = 1:n66. cmd = ['-v ',num2str(v),' -c ',num2str( basenum^X(i,j) ),' -g',num2str( basenum^Y(i,j) )];67. cg(i,j) = svmtrain(train_label, train, cmd);68.69. if cg(i,j) > bestacc70. bestacc = cg(i,j);71. bestc = basenum^X(i,j);72. bestg = basenum^Y(i,j);73. end74. if ( cg(i,j) == bestacc && bestc > basenum^X(i,j) )75. bestacc = cg(i,j);76. bestc = basenum^X(i,j);77. bestg = basenum^Y(i,j);78. end79.80. end81.end82.%% to draw the acc with different c & g83.[C,h] = contour(X,Y,cg,60:accstep:100);84.clabel(C,h,'FontSize',10,'Color','r');85.xlabel('log2c','FontSize',10);86.ylabel('log2g','FontSize',10);87.grid on;88.复制代码这样那个libsvm-matlab工具箱我就有了自己的一个升级版本的了.大家可以把这个SVMcg.m加进去一起用了...libsvm-mat-2.89-3[faruto version].rar(76.46 KB, 下载次数: 1582)里面有SVMcg.m使用说明.如下:[bestacc,bestc,bestg] =SVMcg(train_label,train,cmin,cmax,gmin,gmax,v,cstep,gstep,accstep)train_label:训练集标签.要求与libsvm工具箱中要求一致.train:训练集.要求与libsvm工具箱中要求一致.cmin:惩罚参数c的变化范围的最小值(取以2为底的对数后),即c_min = 2^(cmin).默认为-5cmax:惩罚参数c的变化范围的最大值(取以2为底的对数后),即c_max = 2^(cmax).默认为5gmin:参数g的变化范围的最小值(取以2为底的对数后),即g_min = 2^(gmin).默认为-5 gmax:参数g的变化范围的最小值(取以2为底的对数后),即g_min = 2^(gmax).默认为5 v:cross validation的参数,即给测试集分为几部分进行cross validation.默认为3cstep:参数c步进的大小.默认为1gstep:参数g步进的大小.默认为1accstep:最后显示准确率图时的步进大小. 默认为1.5[上面这些参数大家可以更改以期达到最佳效果,也可不改用默认值]。