AffinityPropagation算法介绍

expectation propagation算法基本原理

expectation propagation算法基本原理Expectation Propagation(EP)算法是一种贝叶斯推断方法,用于求解复杂高维概率模型的近似后验分布。

它是由Jordan 和Ghahramani于1994年提出的,主要用于处理具有隐变量或隐藏状态的概率模型。

EP算法的核心思想是通过迭代地更新每个变量的局部期望来逼近全局期望,从而得到一个近似的后验分布。

EP算法的基本步骤如下:1. 初始化:为每个隐变量分配一个先验分布,通常是一个高斯分布。

这些先验分布可以是任意的,但需要满足归一化条件。

2. 计算局部期望:对于每个隐变量,计算其局部期望,即在给定其他隐变量的情况下,该隐变量的期望值。

这可以通过边缘化其他隐变量的概率密度函数来实现。

3. 更新隐变量:根据计算出的局部期望,更新每个隐变量的值。

这可以通过采样或者直接替换实现。

4. 重复步骤2和3,直到收敛。

收敛的判断标准可以是局部期望的变化小于某个阈值,或者达到预设的最大迭代次数。

EP算法的关键在于如何计算局部期望。

对于具有离散隐变量的情况,可以直接通过边缘化概率密度函数来计算局部期望。

然而,对于具有连续隐变量的情况,边缘化操作变得非常困难,因为需要对概率密度函数进行积分。

为了解决这个问题,EP算法引入了一种称为“变分”的方法,将边缘化操作转化为优化问题。

具体来说,对于每个隐变量,定义一个关于其值的函数(称为因子),并最小化该因子与真实概率密度函数之间的差异。

这样,局部期望的计算就转化为优化因子的问题。

EP算法的优点在于它可以处理具有复杂结构和高维数据的概率模型,而不需要显式地计算边缘化操作。

此外,EP算法还具有良好的扩展性,可以应用于多个隐变量的情况。

然而,EP算法的缺点是计算复杂度较高,尤其是当隐变量的数量较多时。

此外,EP算法的收敛性也是一个值得关注的问题,因为它依赖于初始值的选择和迭代过程的稳定性。

尽管EP算法具有一定的局限性,但它在许多实际应用中取得了显著的成功。

机器学习:Python实现聚类算法(二)之AP算法

机器学习:Python实现聚类算法(⼆)之AP算法1.算法简介AP(Affinity Propagation)通常被翻译为近邻传播算法或者亲和⼒传播算法,是在2007年的Science杂志上提出的⼀种新的聚类算法。

AP 算法的基本思想是将全部数据点都当作潜在的聚类中⼼(称之为exemplar),然后数据点两两之间连线构成⼀个⽹络(相似度矩阵),再通过⽹络中各条边的消息(responsibility和availability)传递计算出各样本的聚类中⼼。

2.相关概念(假如有数据点i和数据点j)(图1)(图2)(图3)1)相似度:点j作为点i的聚类中⼼的能⼒,记为S(i,j)。

⼀般使⽤负的欧式距离,所以S(i,j)越⼤,表⽰两个点距离越近,相似度也就越⾼。

使⽤负的欧式距离,相似度是对称的,如果采⽤其他算法,相似度可能就不是对称的。

2)相似度矩阵:N个点之间两两计算相似度,这些相似度就组成了相似度矩阵。

如图1所⽰的黄⾊区域,就是⼀个5*5的相似度矩阵(N=5) 3) preference:指点i作为聚类中⼼的参考度(不能为0),取值为S对⾓线的值(图1红⾊标注部分),此值越⼤,最为聚类中⼼的可能性就越⼤。

但是对⾓线的值为0,所以需要重新设置对⾓线的值,既可以根据实际情况设置不同的值,也可以设置成同⼀值。

⼀般设置为S相似度值的中值。

(有的说设置成S的最⼩值产⽣的聚类最少,但是在下⾯的算法中设置成中值产⽣的聚类是最少的)4)Responsibility(吸引度):指点k适合作为数据点i的聚类中⼼的程度,记为r(i,k)。

如图2红⾊箭头所⽰,表⽰点i给点k发送信息,是⼀个点i 选点k的过程。

5)Availability(归属度):指点i选择点k作为其聚类中⼼的适合程度,记为a(i,k)。

如图3红⾊箭头所⽰,表⽰点k给点i发送信息,是⼀个点k 选diani的过程。

6)exemplar:指的是聚类中⼼。

7)r (i, k)加a (i, k)越⼤,则k点作为聚类中⼼的可能性就越⼤,并且i点⾪属于以k点为聚类中⼼的聚类的可能性也越⼤3.数学公式1)吸引度迭代公式:(公式⼀)说明1:R t+1(i,k)表⽰新的R(i,k),R t(i,k)表⽰旧的R(i,k),也许这样说更容易理解。

基于仿射传播的拉普拉斯判别投影及应用09-0804

基于仿射传播的拉普拉斯判别投影及应用摘要:提出了一种新的有监督降维算法:基于仿射传播的拉普拉斯判别投影(affinity propagation based laplacian discriminant projection, APLDP)。

APLDP算法将仿射传播引入到传统的线性判别分析中,结合拉普拉斯特征映射(laplacian eigenmap),通过有监督学习可得到一种有效的线性判别转换矩阵。

样本的类别结构信息保存在基于范例样本点的拉普拉斯矩阵中,并可以对所得到的判别投影子空间加以控制。

在多个数据集上的实验证明了该算法的有效性。

关键字:有监督学习;拉普拉斯映射;仿射传播;降维中图分类号:TP18 文献标识码:AAffinity Propagation based Laplacian DiscriminantProjection and Its ApplicationsAbstract: A new algorithm, affinity propagation based Laplacian Discriminant Projection (APLDP), is proposed in this paper for supervised dimensionality reduction. APLDP aims at learning a linear transformation which is an extension of Linear Discriminant Analysis combining with affinity propagation. After the transformation, the considered pair-wise samples within the same exemplar subset and the same class are as close as possible, while those exemplars between classes are as far as possible. The structural information of classes is contained in the exemplar based Laplacian matrices. Thus the discriminant projection subspace can be derived by controlling the structural evolution of Laplacian matrices. The performance on several data sets demonstrates the competence of the proposed algorithm.Key words: supervised learning; laplacian Eigenmap; affinity propagation; dimensionality reduction1 背景近年来,在模式识别、机器学习等领域,研究人员对降维(Dimensionality Reduction,或称维数约简)投入了极大的热情,新的方法也不断涌现。

APSCAN

APSCAN:A parameter free algorithm for clusteringAPSCAN:一种不受参数影响的聚类算法关键字:Clusteringalgorithm:聚类算法DBSCAN:基于密度的聚类算法Affinity propagation algorithm:邻近传播算法摘要:DBSCAN是一个基于密度的聚类算法,并且它在空间数据集中的有效性已经在现存的文献中得到了证明。

但是,DBSCAN算法存在两个明显的缺点:第一点:DBSCAN聚类算法的有效性取决于两个特定的参数。

一个参数是领域半径的最大值,另一个是在这样的领域内的最小数据点数。

事实上,这两个特定的参数唯一定义一个密度。

然而,如果没有充足的先验知识,这两个参数是很难确定下来的。

第二点:即便有了这两个参数,DBSCAN算法在那些有不同密度的数据集中的应用效果并不好。

以上的两个问题给DBSCAN算法在实际中的应用带来了困难。

为了系统的解决这两个问题,在这篇文章中,我们提出了一个全新的、不受参数影响的聚类算法,叫APSCAN。

首先,我们运用近邻传播算法来为数据集检测局部密度,并生成一个标准化的密度表。

然后,我们把第一对密度参数和标准化密度表中其他任何一对密度参数进行结合,并作为DDBSCAN(基于双密度的SCAN算法)的输入,来生成聚类的结果集。

通过这种方式,我们可以运用从标准化的密度表中得到的不同密度参数,来获得不同的聚类结果。

最后,通过运用不同的输入参数,DDBSCAN算法可以得到一些结果,我们可以为这些结果建立一个更新的规则,然后就能综合这些聚类的结果,得到一个最终的结果。

本文中提到的APSCAN算法有两大优点:第一,APSCAN算法不必像DBSCAN算法一样要预先确定那两个参数;第二,APSCAN算法不仅能对拥有不同密度的数据集进行聚类,而且能够对这样的数据集保持非线性的数据结构。

简介:聚类是强大的数据挖掘方法之一,并且能运用于很多地方,比如图像分割、信息恢复和网络数据挖掘。

affinity propagation算法Matlab代码实现

%APCLUSTER Affinity Propagation Clustering (Frey/Dueck, Science 2007) % [idx,netsim,dpsim,expref]=APCLUSTER(s,p) clusters data, using a set% of real-valued pairwise data point similarities as input. Clusters% are each represented by a cluster center data point (the "exemplar"). % The method is iterative and searches for clusters so as to maximize% an objective function, called net similarity.%% For N data points, there are potentially N^2-N pairwise similarities;% this can be input as an N-by-N matrix 's', where s(i,k) is the% similarity of point i to point k (s(i,k) needn抰equal s(k,i)). In% fact, only a smaller number of relevant similarities are needed; if% only M similarity values are known (M < N^2-N) they can be input as % an M-by-3 matrix with each row being an (i,j,s(i,j)) triple.%% APCLUSTER automatically determines the number of clusters based on % the input preference 'p', a real-valued N-vector. p(i) indicates the% preference that data point i be chosen as an exemplar. Often a good% choice is to set all preferences to median(s); the number of clusters% identified can be adjusted by changing this value accordingly. If 'p'% is a scalar, APCLUSTER assumes all preferences are that shared value. %% The clustering solution is returned in idx. idx(j) is the index of% the exemplar for data point j; idx(j)==j indicates data point j% is itself an exemplar. The sum of the similarities of the data points to % their exemplars is returned as dpsim, the sum of the preferences of% the identified exemplars is returned in expref and the net similarity% objective function returned is their sum, i.e. netsim=dpsim+expref.%% [ ... ]=apcluster(s,p,'NAME',VALUE,...) allows you to specify% optional parameter name/value pairs as follows:%% 'maxits' maximum number of iterations (default: 1000)% 'convits' if the estimated exemplars stay fixed for convits% iterations, APCLUSTER terminates early (default: 100)% 'dampfact' update equation damping level in [0.5, 1). Higher % values correspond to heavy damping, which may be needed % if oscillations occur. (default: 0.9)% 'plot' (no value needed) Plots netsim after each iteration% 'details' (no value needed) Outputs iteration-by-iteration% details (greater memory requirements)% 'nonoise' (no value needed) APCLUSTER adds a small amount of % noise to 's' to prevent degenerate cases; this disables that.%% Copyright (c) B.J. Frey & D. Dueck (2006). This software may be% freely used and distributed for non-commercial purposes.% (RUN APCLUSTER WITHOUT ARGUMENTS FOR DEMO CODE)function [idx,netsim,dpsim,expref]=apcluster(s,p,varargin);if nargin==0, % display demofprintf('Affinity Propagation (APCLUSTER) sample/demo code\n\n');fprintf('N=100; x=rand(N,2); % Create N, 2-D data points\n');fprintf('M=N*N-N; s=zeros(M,3); % Make ALL N^2-N similarities\n');fprintf('j=1;\n');fprintf('for i=1:N\n');fprintf(' for k=[1:i-1,i+1:N]\n');fprintf(' s(j,1)=i; s(j,2)=k; s(j,3)=-sum((x(i,:)-x(k,:)).^2);\n');fprintf(' j=j+1;\n');fprintf(' end;\n');fprintf('end;\n');fprintf('p=median(s(:,3)); % Set preference to median similarity\n');fprintf('[idx,netsim,dpsim,expref]=apcluster(s,p,''plot'');\n');fprintf('fprintf(''Number of clusters: %%d\\n'',length(unique(idx)));\n');fprintf('fprintf(''Fitness (net similarity): %%g\\n'',netsim);\n');fprintf('figure; % Make a figures showing the data and the clusters\n');fprintf('for i=unique(idx)''\n');fprintf(' ii=find(idx==i); h=plot(x(ii,1),x(ii,2),''o''); hold on;\n');fprintf(' col=rand(1,3); set(h,''Color'',col,''MarkerFaceColor'',col);\n');fprintf(' xi1=x(i,1)*ones(size(ii)); xi2=x(i,2)*ones(size(ii)); \n');fprintf(' line([x(ii,1),xi1]'',[x(ii,2),xi2]'',''Color'',col);\n');fprintf('end;\n');fprintf('axis equal tight;\n\n');return;end;start = clock;% Handle arguments to functionif nargin<2 error('Too few input arguments');elsemaxits=1000; convits=100; lam=0.9; plt=0; details=0; nonoise=0;i=1;while i<=length(varargin)if strcmp(varargin{i},'plot')plt=1; i=i+1;elseif strcmp(varargin{i},'details')details=1; i=i+1;elseif strcmp(varargin{i},'sparse')% [idx,netsim,dpsim,expref]=apcluster_sparse(s,p,varargin{:});fprintf('''sparse'' argument no longer supported; see website for additional software\n\n');return;elseif strcmp(varargin{i},'nonoise')nonoise=1; i=i+1;elseif strcmp(varargin{i},'maxits')maxits=varargin{i+1};i=i+2;if maxits<=0 error('maxits must be a positive integer'); end;elseif strcmp(varargin{i},'convits')convits=varargin{i+1};i=i+2;if convits<=0 error('convits must be a positive integer'); end;elseif strcmp(varargin{i},'dampfact')lam=varargin{i+1};i=i+2;if (lam<0.5)||(lam>=1)error('dampfact must be >= 0.5 and < 1');end;else i=i+1;end;end;end;if lam>0.9fprintf('\n*** Warning: Large damping factor in use. Turn on plotting\n');fprintf(' to monitor the net similarity. The algorithm will\n');fprintf(' change decisions slowly, so consider using a larger value\n');fprintf(' of convits.\n\n');end;% Check that standard arguments are consistent in sizeif length(size(s))~=2 error('s should be a 2D matrix');elseif length(size(p))>2 error('p should be a vector or a scalar');elseif size(s,2)==3tmp=max(max(s(:,1)),max(s(:,2)));if length(p)==1 N=tmp; else N=length(p); end;if tmp>Nerror('data point index exceeds number of data points');elseif min(min(s(:,1)),min(s(:,2)))<=0error('data point indices must be >= 1');end;elseif size(s,1)==size(s,2)N=size(s,1);if (length(p)~=N)&&(length(p)~=1)error('p should be scalar or a vector of size N');end;else error('s must have 3 columns or be square'); end;% Construct similarity matrixif N>3000fprintf('\n*** Warning: Large memory request. Consider activating\n');fprintf(' the sparse version of APCLUSTER.\n\n');end;if size(s,2)==3 && size(s,1)~=3,S=-Inf*ones(N,N,class(s));for j=1:size(s,1), S(s(j,1),s(j,2))=s(j,3); end;else S=s;end;if S==S', symmetric=true; else symmetric=false; end;realmin_=realmin(class(s)); realmax_=realmax(class(s));% In case user did not remove degeneracies from the input similarities,% avoid degenerate solutions by adding a small amount of noise to the% input similaritiesif ~nonoiserns=randn('state'); randn('state',0);S=S+(eps*S+realmin_*100).*rand(N,N);randn('state',rns);end;% Place preferences on the diagonal of Sif length(p)==1 for i=1:N S(i,i)=p; end;else for i=1:N S(i,i)=p(i); end;end;% Numerical stability -- replace -INF with -realmaxn=find(S<-realmax_); if ~isempty(n), warning('-INF similarities detected; changing to -REALMAX to ensure numerical stability'); S(n)=-realmax_; end; clear('n');if ~isempty(find(S>realmax_,1)), error('+INF similarities detected; change to a large positive value (but smaller than +REALMAX)'); end;% Allocate space for messages, etcdS=diag(S); A=zeros(N,N,class(s)); R=zeros(N,N,class(s)); t=1;if plt, netsim=zeros(1,maxits+1); end;if detailsidx=zeros(N,maxits+1);netsim=zeros(1,maxits+1);dpsim=zeros(1,maxits+1);expref=zeros(1,maxits+1);end;% Execute parallel affinity propagation updatese=zeros(N,convits); dn=0; i=0;if symmetric, ST=S; else ST=S'; end; % saves memory if it's symmetricwhile ~dni=i+1;% Compute responsibilitiesA=A'; R=R';for ii=1:N,old = R(:,ii);AS = A(:,ii) + ST(:,ii); [Y,I]=max(AS); AS(I)=-Inf;[Y2,I2]=max(AS);R(:,ii)=ST(:,ii)-Y;R(I,ii)=ST(I,ii)-Y2;R(:,ii)=(1-lam)*R(:,ii)+lam*old; % DampingR(R(:,ii)>realmax_,ii)=realmax_;end;A=A'; R=R';% Compute availabilitiesfor jj=1:N,old = A(:,jj);Rp = max(R(:,jj),0); Rp(jj)=R(jj,jj);A(:,jj) = sum(Rp)-Rp;dA = A(jj,jj); A(:,jj) = min(A(:,jj),0); A(jj,jj) = dA;A(:,jj) = (1-lam)*A(:,jj) + lam*old; % Dampingend;% Check for convergenceE=((diag(A)+diag(R))>0); e(:,mod(i-1,convits)+1)=E; K=sum(E);if i>=convits || i>=maxits,se=sum(e,2);unconverged=(sum((se==convits)+(se==0))~=N);if (~unconverged&&(K>0))||(i==maxits) dn=1; end;end;% Handle plotting and storage of details, if requestedif plt||detailsif K==0tmpnetsim=nan; tmpdpsim=nan; tmpexpref=nan; tmpidx=nan;elseI=find(E); notI=find(~E); [tmp c]=max(S(:,I),[],2); c(I)=1:K; tmpidx=I(c);tmpdpsim=sum(S(sub2ind([N N],notI,tmpidx(notI))));tmpexpref=sum(dS(I));tmpnetsim=tmpdpsim+tmpexpref;end;end;if detailsnetsim(i)=tmpnetsim; dpsim(i)=tmpdpsim; expref(i)=tmpexpref;idx(:,i)=tmpidx;end;if plt,netsim(i)=tmpnetsim;figure(234);plot(((netsim(1:i)/10)*100)/10,'r-'); xlim([0 i]); % plot barely-finite stuff as infinitexlabel('# Iterations');ylabel('Fitness (net similarity) of quantized intermediate solution');% drawnow;end;end; % iterationsI=find((diag(A)+diag(R))>0); K=length(I); % Identify exemplarsif K>0[tmp c]=max(S(:,I),[],2); c(I)=1:K; % Identify clusters% Refine the final set of exemplars and clusters and return resultsfor k=1:K ii=find(c==k); [y j]=max(sum(S(ii,ii),1)); I(k)=ii(j(1)); end; notI=reshape(setdiff(1:N,I),[],1);[tmp c]=max(S(:,I),[],2); c(I)=1:K; tmpidx=I(c);tmpdpsim=sum(S(sub2ind([N N],notI,tmpidx(notI))));tmpexpref=sum(dS(I));tmpnetsim=tmpdpsim+tmpexpref;elsetmpidx=nan*ones(N,1); tmpnetsim=nan; tmpexpref=nan;end;if detailsnetsim(i+1)=tmpnetsim; netsim=netsim(1:i+1);dpsim(i+1)=tmpdpsim; dpsim=dpsim(1:i+1);expref(i+1)=tmpexpref; expref=expref(1:i+1);idx(:,i+1)=tmpidx; idx=idx(:,1:i+1);elsenetsim=tmpnetsim; dpsim=tmpdpsim; expref=tmpexpref; idx=tmpidx;end;if plt||detailsfprintf('\nNumber of exemplars identified: %d (for %d data points)\n',K,N);fprintf('Net similarity: %g\n',tmpnetsim);fprintf(' Similarities of data points to exemplars: %g\n',dpsim(end));fprintf(' Preferences of selected exemplars: %g\n',tmpexpref);fprintf('Number of iterations: %d\n\n',i);fprintf('Elapsed time: %g sec\n',etime(clock,start));end;if unconvergedfprintf('\n*** Warning: Algorithm did not converge. Activate plotting\n');fprintf(' so that you can monitor the net similarity. Consider\n');fprintf(' increasing maxits and convits, and, if oscillations occur\n');fprintf(' also increasing dampfact.\n\n');end;。

各种聚类算法的比较

各种聚类算法的比较聚类算法是一种无监督学习方法,用于将样本划分为具有相似特征的不同组别。

在机器学习和数据挖掘中被广泛应用。

有许多不同的聚类算法可供选择,每个算法有其独特的优点和适用范围。

在本文中,我们将比较几种常用的聚类算法,以帮助选择最适合特定问题和数据集的算法。

1.K均值聚类算法:K均值算法是一种经典的聚类算法。

它将数据点分为K个不同的簇,使得同一簇内的数据点之间的距离尽可能小,不同簇之间的距离尽可能大。

该算法计算复杂度较低,适用于大数据集。

然而,该算法对初始聚类中心的选择非常敏感,并且只能处理数值型数据。

2.层次聚类算法:层次聚类算法通过计算数据点之间的相似性将它们逐步聚类成树状结构。

该算法不需要事先指定聚类个数,并且可以处理各种数据类型。

然而,该算法在处理大数据集时计算复杂度较高,并且结果的质量受到相似性度量的影响。

3.密度聚类算法:密度聚类算法使用数据点密度来识别簇。

该算法可以处理不规则形状的簇,并且对初始聚类中心的选择不敏感。

DBSCAN是一种常用的密度聚类算法。

然而,该算法对密度参数的选择敏感,并且在处理高维数据时效果可能不好。

4.基于模型的聚类算法:基于模型的聚类算法将数据点建模为一些概率分布的样本。

该算法可以处理不同形状和大小的簇,并且能够进行概率推断。

高斯混合模型(GMM)是一种常用的基于模型的聚类算法。

然而,该算法对模型的选择和参数估计比较困难。

5.谱聚类算法:谱聚类算法通过矩阵分解来对数据进行聚类。

该算法可以处理非线性可分的数据,并且不需要事先指定聚类个数。

然而,该算法在处理大数据集时计算开销较大,并且对相似度矩阵的构建方法敏感。

以上只是一些常见的聚类算法,实际上还有许多其他聚类算法可供选择,如affinity propagation、BIRCH、OPTICS等。

每种算法都有其独特的特点和适用范围。

在选择聚类算法时,需要考虑数据集的规模、维度、特征类型以及问题的特殊需求等因素。

自动聚类算法

自动聚类算法自动聚类算法是一种机器学习算法,它可以将数据集中的对象自动分类,以形成新的集合。

这些对象可以是文本、图像、音频、视频或其他类型的数据。

聚类是一种无监督学习技术,它不需要标记或先验信息,但仍然可以从数据中发现模式和结构。

在本文中,我们将介绍一些常用的自动聚类算法,并讨论它们的优点和缺点。

1. k-均值聚类算法k-均值聚类算法是一种基于迭代的算法,它将数据集分成k个不同的簇,使得每个簇中的数据点与该簇的质心之间的距离最小。

该算法需要指定k的值,即要分成的簇的数量。

一般来说,k的值通过试验和误差来确定。

该算法的优点在于计算简单、易于实现、速度快。

但它的缺点在于对异常值和噪声的鲁棒性较差,在数据分布不均匀的情况下效果不佳。

2. 层次聚类算法层次聚类算法是一种逐步加密数据点的算法,它将数据点逐步组合成簇并形成树状结构,称为“聚类树”。

该算法有两个主要类型:聚合层次聚类和分裂层次聚类。

聚合层次聚类从底向上构建聚类树,每个簇开始只有一个数据点,逐步合并到更大的簇,直到形成一个大的簇。

分裂层次聚类从顶向下构建聚类树,开始为一个包含所有数据点的大簇,逐步分裂成较小的簇。

该算法的优点在于不需要预先指定簇的数量,易于可视化以及能够处理异常值和噪声。

但其缺点在于计算复杂度高,速度较慢,对大型数据集不适用。

3. DBSCAN聚类算法DBSCAN聚类算法是一种基于密度的算法,可以对任意形状的簇进行聚类。

该算法通过寻找数据点的“核心点”以及它们周围的数据点来定义簇。

其中,“核心点”是指一个密度大于某一阈值的数据点,在其附近半径内的所有数据点都被认为是同一簇。

该算法的优点在于能够处理任意形状的簇,对噪声和异常值有较好的鲁棒性。

但其缺点在于对参数的依赖性较大,需要人为设定阈值,并且对数据分布不均匀的情况下效果不佳。

4. GMM聚类算法GMM聚类算法是一种基于概率模型的算法,它可以对数据分布于高斯分布的数据进行聚类。

GMM模型假设每个簇是一个高斯分布,并寻找最优参数来拟合数据集。

AFFINITYPROPAGATION算法介绍

{

(3)

由上面的公式可以看出,当 s(k, k)较大使得 r(k, k)较大时,a(i, k)也较大, 从而类代表 k 作为 最终聚类中心的可能性较大;同样,当越多的 s(k, k)较大时,越多的类代表倾向于成为最终 的聚类中心。因此,增大或减小 s(k, k)可以增加或减少 AP 输出的聚类数目。 Damping factor(阻尼系数):主要是起收敛作用的。AP 聚类算法迭代过程很容易产生震荡, 所以一般每次迭代都加上一个阻尼系数 ( [0.5,1)) :

m e d ia n ( s ) 2

median(s) 2×median(s)

表 1.不同的 preference 得到的聚类数目比较 由表 1,我们可以看出,当 preference 越大时,得到的聚类数目越多。 当取不同的 (阻尼系数)值时,迭代次数和迭代过程中数据的摆动都会有很大的不同,下 面同样是对同一组数据集(200 个数据点)进行计算,取有代表性的两个值(0.5 和 0.9)进行 比较结果如下:

心(该聚类中所有对象的均值) ;不断重复这一过程直到标准测度函

k

i 1 pCi

| pm

i

|2

(1)

其中,E 是数据集中所有对象的平方误差和,p 是空间中的点,表示给定对象,mi 是簇 Ci 的 均值(p 和 mi 都是多维的) 。换句话说,对于每个簇中的每个对象,求对象到其簇中心距离 的平方,然后求和。这个准则试图使生成的 k 个结果簇尽可能的紧凑和独立。 例 1:我们在二维空间中随机的生成 20 个数据点,将聚类数目指定为 5 个,并随机生成一 个聚类中心(用“×”来标注),根据对象与簇中心的距离,每个对象分属于最近的簇。初始 示例图如下:

AP 聚类算法

《Python数据分析与应用》教学课件第5章聚类分析

图 5<16 运行结果

553 算法实例

运行结果如图5-16所示。 由图5-16可以看出 ,300个数据点被 分成三类 ,聚类中心分别为( 3,3 )、

( -3 ,-3 )和( 3 ,-3 ) ,符合原始数

据的分布趋势 ,说明sklearn库中的近 邻传播算法 AffinityPropagation能够

按预期完成聚类功能。

5.1基本概NTENTS

DBSCAN聚类算法

5.4 谱聚类算法

5.5 近邻传播算法

学习目标

( 1 )了解聚类分析的定义 ,并了解几种聚类分析方法。

(2 )了解簇的定义及不同的簇类型。

( 3 )学习K means聚类算法、DBSCAN聚类算法、谱聚类 ( spectral clustering )算法和近邻传播( affinity propagation )算法。 ( 4 )通过算法的示例进一步理解算法的过程。 ( 5 )了解聚类分析的现状与前景。

5.5.3 算法实例

23. plt.plot(cluster_center [ 0 ] ,cluster_center [ 1 ] , o ,

markerfacecolor=col, \

24.

markeredgecolor= k , markersize=14)

25. for x in X [ class_members ] :

26.

plt.plot( [ cluster_center [ 0 ] , x [ 0 ] ] , [ cluster_center

[l],x[l] ] , col)

27.plt.title( Estimated number of clusters: %d % n_clustersJ

仿射传播AP

仿射传播AP(affinity propagation)是Frey 于2007年在Science 上首次提出的一种聚类算法,算法快速、有效,已经在人脸图像的聚类、“基因外显子”发现、搜索最优航线等方面得到了应用。

它可以找到样本集合中具有代表性的范例样本,并对原始数据集加以分割。

仿射传播算法的输入是成对样本点之间的测度(,)s n m ,定义为:2(,).n m s n m V C =--‖‖ 原始样本集中的所有数据点都可能是潜在的范例样本,因而所有的(,)s m m 初始化时都是相同的。

在聚类的过程中,有两个变量,吸引度(,)r n m 和归属度(,)a n m ,需要通过竞争机制加以更新。

更新规则为:..(,)(,)max {(,)(,)}m s t m mr n m s n m a n m s n m ''≠''=-+..(,)(,)max {(,)(,)}m s t m mr m m s m m a m m s m m ''≠''=-+ ..,(,)min{0,(,)max{0,(,)}}n s t n n m a n m r m m r n m ''≠'=+∑..(,)max{0,(,)}n s t n m a m m r n m ''≠'=∑通过以上更新规则,样本点之间进行信息的互换,最终使得所选择的能量函数达到极小。

仿射传播算法也可以通过设置固定的迭代次数或者是局部的变化程度加以终止。

仿射传播算祛与K 均值算法同属于K 中心聚类方法。

经典的K 均值算法对初始聚类中心的选择敏感且容易陷入局部极值,因此,需要在不同初始化下运行很多次,以寻找一个最好的聚类结果。

然而,这种策略也只有在小的类数和某次初始化靠近好的结果时才有效果。

AP 算法则克服了这些缺点,其迭代过程不断搜索合适的聚类中心,同时也使得聚类的适应度函数(目标函数)最大化。

ap聚类算法原理

ap聚类算法原理Ap聚类算法原理Ap聚类算法(Affinity Propagation Clustering Algorithm)是一种基于消息传递的聚类算法,它是由Brendan J. Frey和Delbert Dueck于2007年提出的。

该算法通过自适应性地选择样本点作为聚类中心,并利用消息传递的方式更新样本点之间的相似度矩阵,从而实现聚类的目的。

Ap聚类算法的基本原理是通过样本点之间的相似度来构建网络图,然后利用消息传递的方式在网络图上进行迭代更新,最终确定每个样本点的聚类归属。

具体而言,Ap聚类算法包含以下几个关键步骤:1. 相似度计算:首先,需要计算每对样本点之间的相似度。

相似度的计算可以根据具体问题采用不同的度量方法,如欧氏距离、余弦相似度等。

通过计算相似度矩阵,可以得到样本点之间的相似度关系。

2. 网络图构建:基于相似度矩阵,构建一个带权重的网络图。

在网络图中,每个样本点表示一个节点,相似度表示节点之间的边的权重。

网络图的构建过程中,需要选择一个合适的参数damping,用于控制节点之间消息的传递强度。

3. 消息传递:在网络图上进行消息传递的迭代过程。

首先,每个节点向其他节点发送一个“责任”消息,表示该节点希望成为其他节点的聚类中心。

然后,每个节点根据接收到的“责任”消息和自身的相似度,更新自己的“可用性”值,表示该节点作为聚类中心的适合程度。

接着,每个节点根据接收到的“可用性”值和自身的相似度,更新自己的“归属度”值,表示该节点作为某个聚类中心的合适程度。

最后,每个节点根据接收到的“归属度”值和自身的相似度,更新自己的“偏好度”值,表示该节点作为聚类中心的优先级。

4. 聚类结果确定:经过多轮的消息传递迭代后,每个节点的“偏好度”值会趋于稳定。

根据节点的“偏好度”值和相似度矩阵,可以确定每个样本点的聚类归属。

具体而言,对于每个节点,选择与其“归属度”最大的节点作为其聚类中心,从而确定每个样本点的聚类归属。

亲和传播聚类算法的流程图及具体步骤

亲和传播聚类算法的流程图及具体步骤下载温馨提示:该文档是我店铺精心编制而成,希望大家下载以后,能够帮助大家解决实际的问题。

文档下载后可定制随意修改,请根据实际需要进行相应的调整和使用,谢谢!并且,本店铺为大家提供各种各样类型的实用资料,如教育随笔、日记赏析、句子摘抄、古诗大全、经典美文、话题作文、工作总结、词语解析、文案摘录、其他资料等等,如想了解不同资料格式和写法,敬请关注!Download tips: This document is carefully compiled by theeditor.I hope that after you download them,they can help yousolve practical problems. The document can be customized andmodified after downloading,please adjust and use it according toactual needs, thank you!In addition, our shop provides you with various types ofpractical materials,such as educational essays, diaryappreciation,sentence excerpts,ancient poems,classic articles,topic composition,work summary,word parsing,copy excerpts,other materials and so on,want to know different data formats andwriting methods,please pay attention!亲和传播聚类算法的流程图与具体步骤解析亲和传播(Affinity Propagation)是一种非中心化的无参数聚类算法,它通过消息传递的方式在数据点之间进行交互,寻找“示例”数据点,即那些能代表一个簇的典型数据点。

基于改进AP聚类算法的人脸标注技术研究

基于改进AP聚类算法的人脸标注技术研究刘胜宇;刘家锋;黄庆成;唐降龙【摘要】利用网络新闻图像以及与图像相关的文字说明构造一个有人名标注的人脸库.人脸库中的人脸通过对新闻图像进行人脸检测得到,人名从与图像相关的文字说明中提取得到.通过一个聚类过程得到人脸与人名之间的对应关系,并通过一个合并聚类的过程可以识别出同一个人的不同名字.对AP聚类算法进行改进,实验表明相比于k-means与AP算法,改进的AP聚类算法能充分利用网络新闻图文互补的特性,从而得到更准确的人脸与人名对应关系.【期刊名称】《智能计算机与应用》【年(卷),期】2011(001)003【总页数】4页(P35-38)【关键词】网络新闻;人名;人脸图像;人脸标注【作者】刘胜宇;刘家锋;黄庆成;唐降龙【作者单位】哈尔滨工业大学计算机科学与技术学院,哈尔滨150001;哈尔滨工业大学计算机科学与技术学院,哈尔滨150001;哈尔滨工业大学计算机科学与技术学院,哈尔滨150001;哈尔滨工业大学计算机科学与技术学院,哈尔滨150001【正文语种】中文【中图分类】TP391.40 引言现实世界中存在许多图像与文本相关联的数据,网络新闻是一个很典型的例子。

在这种图文并茂的数据中,图像与相关联的文本是相互补充的,利用这种图文互补特性可以挖掘很多重要信息。

如果能将网络新闻图像中出现的人物用其名字进行标注,就可以将图像检索[1-2]问题转化为文本检索[3]问题,从而可以很好地解决人物检索这一问题。

采取手工标注的方法是有效的,但是多媒体和网络技术的迅速发展使得图像库越来越大,完全使用手工标注,工作量太大。

网络新闻数据如图1所示,图像右侧是与此图像关联的文字说明。

本文的基本任务是对新闻图像中出现的人脸用人名进行标注。

虽然人脸识别[4]的研究已经很成熟,但是很难对图1中的人脸进行识别。

因为图1中的人脸图像来源于网络,人脸的姿势、表情、光照等情况以及图像采集设备差别很大,比实验室条件下采集的图像数据要复杂很多。

各种聚类方法及举例

聚类,也被称为Clustering,是一种无监督学习方法,用于将数据集分割成不同的类或簇。

每个簇内的数据对象的相似性尽可能大,而不在同一个簇中的数据对象的差异性也尽可能地大。

以下是一些常见的聚类方法及其简要描述:1. K-Means: K-Means聚类算法是最常用的聚类方法之一,它将数据点分为K个簇,每个簇的中心点是其所有成员的平均值。

例如,可以使用K-Means对顾客按照购买行为进行分组。

2. Affinity Propagation: 这是一种基于图论的聚类算法,旨在识别数据中的"exemplars" (代表点)和"clusters" (簇)。

例如,可以使用Affinity Propagation来识别新闻文章中的主题。

3. Agglomerative Clustering (凝聚层次聚类): 这是一种自底向上的聚类算法,它将每个数据点视为一个初始簇,并将它们逐步合并成更大的簇,直到达到停止条件为止。

例如,可以使用Agglomerative Clustering来对基因进行分类。

4. Mean Shift Clustering: 此算法根据数据的密度来进行聚类。

例如,可以使用Mean Shift 对天气数据进行空间分区。

5. Bisecting K-Means: 它是K-Means的衍生算法,通过不断地将当前簇一分为二来找到更好的聚类效果。

例如,可以使用Bisecting K-Means对文档进行主题分类。

6. DBSCAN: DBSCAN是一个基于密度的聚类算法,它可以识别出任意形状的簇,并且可以处理噪声数据。

例如,可以使用DBSCAN对地理空间数据进行区域划分。

affinitypropagation参数

affinitypropagation参数

亲和传播(Affinity Propagation)是一种聚类算法,它基于数据点之间的相似度来寻找聚类中心。

以下是亲和传播算法的一些参数:

1. damping:阻尼参数,控制消息传递的收敛速度。

范围为[0.5, 1),默认值为0.5。

较小的值会减慢收敛速度,但可能会增加迭代次数。

2. max_iter:最大迭代次数。

默认值为200。

当算法迭代次数达到max_iter或收敛到指定的tolerance时,算法会停止。

3. convergence_iter:当算法连续多少次迭代未改善最佳的聚类结果时,算法将收敛。

默认值为15。

4. preference:数据点对自身作为聚类中心的偏好值。

较高的偏好值会导致更多的聚类中心,而较低的偏好值会导致较少的聚类中心。

默认值为None,表示不设置偏好值,算法会自动选择。

5. affinity:相似度度量的方法。

可以是预定义的字符串(如"euclidean"表示欧氏距离)或自定义的可调用对象。

默认值为"euclidean"。

6. verbose:是否打印详细输出。

默认值为False。

这些参数可以根据具体的数据集和需求进行调整。

在使用亲和传播算法时,根据数据的特点和目标,在调整参数时需要仔细考虑各个参数的影响,以获得最佳的聚类结果。

热点聚类算法

热点聚类算法热点聚类算法通常用于识别数据集中的热点区域或集群。

以下是一些常见的热点聚类算法:1. K均值聚类(K-Means):K均值聚类是一种常见的聚类算法,它将数据集划分为预定数量的簇,每个簇的中心代表簇的热点。

该算法适用于规模较大的数据集。

2. DBSCAN(Density-Based Spatial Clustering of Applications with Noise):DBSCAN 是一种基于密度的聚类算法,它能够识别数据中的簇以及离群点。

簇的密度较高的区域被认为是热点。

3. OPTICS(Ordering Points To Identify the Clustering Structure):OPTICS 是另一种密度聚类算法,它能够发现数据集中的簇以及簇之间的相对密度。

热点的识别基于数据点的相对密度。

4. Mean Shift:Mean Shift 是一种非参数化的聚类算法,它通过不断调整数据点的位置来寻找数据分布的高密度区域。

簇的中心被认为是热点。

5. Affinity Propagation:Affinity Propagation 是一种基于数据点之间的消息传递的聚类算法,它能够找到数据集中的簇,其中消息的传递反映了数据点之间的相似性。

6. OPTICS-HC(OPTICS with Hierarchical Clustering):OPTICS-HC 是在OPTICS算法基础上引入层次聚类的版本,它可以更好地识别层次结构和热点。

选择适当的热点聚类算法取决于数据的性质、规模和特定的应用场景。

在应用算法之前,最好先了解数据的特点,并根据具体需求选择适合的算法。

近邻传播算法在非监督图像聚类中的应用

Microcomputer Applica tions V ol.27,No.2,2011开发应用微型电脑应用2011年第27卷第2期3文章编号:1007-757X(2011)02-0034-03近邻传播算法在非监督图像聚类中的应用钱丽丽,施鹏飞摘要:近邻传递算法的快速、有效性体现在处理大的聚类问题上。

采用图像低层特征,包括颜色、纹理和边缘特征,使用近邻传播算法初次聚类,将聚类结果的中心作为k-means 的初始中心进行二次聚类。

实验表明,二次聚类的正确率比一次聚类提高了将近10%,达到了95%。

关键词:近邻传播算法;聚类;k-means中图分类号:TP391文献标志码:A0引言随着因特网的普及,数字图像等媒体数据库的规模急剧扩大,图像的应用和传播也越来越广泛。

图像已经成为描述和存储信息的常用载体,它已经渗透到人类生活的方方面面。

但图像信息自身的无序化也越来越突出,如何对日益庞大的图像库进行有效的组织、管理和检索成为一个富有挑战性而又亟待解决的问题。

图像聚类就是在给出的图像集中,根据图像的内容,在无先验知识的条件下,将人们感兴趣的图像按其不同的需求进行分类。

图像聚类在搜索引擎中也有很大应用,如文献[1]采用了高效而且通用的聚类算法,它将MSN 图像搜索引擎的返回结果进行聚类。

文献[2]提出了一种基于视觉,文本以及图像间链接信息的聚类方法。

本文基于图像低层视觉特征(颜色、纹理、边缘),采用二次聚类方法。

首先用近邻传播算法(Affinity PropagationAlgorithm )对图像进行初次聚类,然后计算各类聚类中心,作为k-means 聚类的初始中心,进行二次聚类。

1图像特征提取图像聚类两个本质的问题是图像内容表示和图像相似性度量。

其中,图像可视内容的表示是图像聚类的基础,图像内容表示的好坏直接决定了图像聚类的性能。

本文采用的图像内容描述子,包括纹理谱描述子、图像边缘描述子和图像颜色描述子[3]。

AP聚类算法

AP(Affinity Propagation)算法不需要事先指定聚类数目,相反它将所有的数据点都作为潜在的聚类中心,称之为exemplar。

以S矩阵的对角线上的数值s (k, k)作为k点能否成为聚类中心的评判标准,这意味着该值越大,这个点成为聚类中心的可能性也就越大,(Q:这个是怎么算的)。

这个值又称作参考度p ( preference) 。

聚类的数量受到参考度p的影响,如果认为每个数据点都有可能作为聚类中心,那么p就应取相同的值。

如果取输入的相似度的均值作为p 的值,得到聚类数量是中等的。

如果取最小值,得到类数较少的聚类。

AP算法中传递两种类型的消息, (responsiility)和(availability) 。

r(i,k)表示从点i发送到候选聚类中心k的数值消息,反映k点是否适合作为i点的聚类中心。

a(i,k)则从候选聚类中心k 发送到i的数值消息,反映i点是否选择k作为其聚类中心。

r (i, k)与a (i, k)越强,则k点作为聚类中心的可能性就越大,并且i点隶属于以k点为聚类中心的聚类的可能性也越大。

AP算法通过迭代过程不断更新每一个点的吸引度和归属度值,直到产生m个高质量的exemplar,同时将其余的数据点分配到相应的聚类中。

一开始就把所有数据点都看做可能的中心, 任意两个数据点i 和j之间存在两个信息量 a ( i ,j) 和r( i , j ), 前者表示i可以选择j作为其中心点的累积证据,后者表示j 可以作为i 中心点的累积证据; 每个点可以看做网络中的一个节点, 网络节点之间不断地传播前面的两个信息量, 直到一个好的聚类结果(各个类及其对应中心) 出现。

相似性传播聚类算法不要求指定聚类数和初始化中心,只需要输入数据点之间的相似性矩阵S 。

s( i , j) 表示i 归入以j为中心的类的可能性, 该值越大, i 越有可能归入该类中。

当i = j时, s( j , j ) 表示j作为类中心的可能性, 显然s( j , j ) 越大,j越有可能成为中心。

affinitypropagation 参数

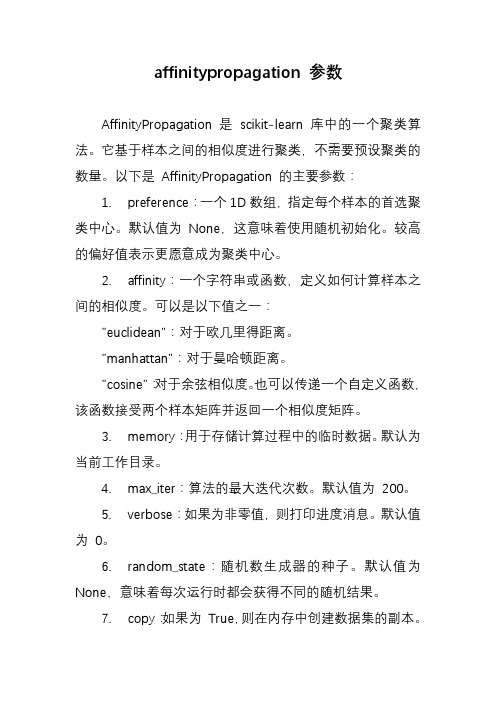

affinitypropagation 参数AffinityPropagation 是scikit-learn 库中的一个聚类算法。

它基于样本之间的相似度进行聚类,不需要预设聚类的数量。

以下是AffinityPropagation 的主要参数:1. preference:一个1D数组,指定每个样本的首选聚类中心。

默认值为None,这意味着使用随机初始化。

较高的偏好值表示更愿意成为聚类中心。

2. affinity:一个字符串或函数,定义如何计算样本之间的相似度。

可以是以下值之一:"euclidean":对于欧几里得距离。

"manhattan":对于曼哈顿距离。

"cosine":对于余弦相似度。

也可以传递一个自定义函数,该函数接受两个样本矩阵并返回一个相似度矩阵。

3. memory:用于存储计算过程中的临时数据。

默认为当前工作目录。

4. max_iter:算法的最大迭代次数。

默认值为200。

5. verbose:如果为非零值,则打印进度消息。

默认值为0。

6. random_state:随机数生成器的种子。

默认值为None,意味着每次运行时都会获得不同的随机结果。

7. copy:如果为True,则在内存中创建数据集的副本。

默认值为True。

当你使用AffinityPropagation 时,重要的是要根据数据集的特性选择适当的相似度度量方法(例如,欧几里得距离、曼哈顿距离或余弦相似度)。

另外,可以通过调整preference 参数来影响聚类的数量和质量。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

AffinityPropagation算法介绍

AP聚类算法

1。

分类和聚类1.1分类算法简介

分类是寻找一个模型(或函数)来描述和区分数据类或概念,以便用模型预测类来标记未知对象类分类算法或训练集中的数据输入由数据库记录一个接一个组成。

每个记录包含几个属性以形成一个特征向量。

训练集中的每个记录也有与之对应的特定类别标签。

这种标签是系统的输入,通常是一些过去的经验数据。

特定样本可以采取样本向量的形式:(v1,v2,...,越南);c)这里vi表示字段值,c表示类别

分类的目的是分析输入数据,并通过训练集中数据的特征(通常用谓词表示)找到每个类的准确描述或模型生成的类描述用于对未来的测试数据进行分类虽然这些未来测试数据的类别标签是未知的,但是我们仍然可以预测这些新数据所属的类别。

注意力是预测,而不是确定。

我们也可以对数据中的每个类有更好的理解也就是说,我们已经获得了这门课的知识。

以下是对分类过程的简要描述:

训练:训练集->特征选择->训练->分类器分类:新样本->特征选择->分类->决策

常用的分类算法包括:决策树,K-最近邻,SVM,VSM,贝叶斯,神经网络等

1.2聚类算法简介

聚类是指根据“物以类聚”的原则将没有类别的样本分组为不同组的过程。

这样一组数据对象被称为集群,并且描述了每个这样的集群。

与分类规则不同,在聚类之前,我们不知道我们将分成哪些组,我们将分成哪些组,也不知道我们将根据哪些空间区分规则来定义组。

其目的是使属于同一个聚类的样本彼此相似,而属于不同聚类的样本应该足够不相似。

聚类分析算法可分为:划分方法、分层方法、基于密度的方法、基于网格的方法和基于模型的方法经典的K均值和K中心都是除法。

1.3分类和聚类

聚类分析之间的区别也称为无监督学习或无监督学习。

聚类样本没有标记,需要通过聚类学习算法自动确定。

在分类中,我们知道目标数据库中存在哪些类,我们需要做的是标记每个记录属于哪些类。

集群学习是观察学习,而不是示例学习。

可以说,聚类分析可以用作分类分析的预处理步骤。

2。

k-means算法

k-means算法接受输入k;然后将N个数据对象分成K个聚类,得到的聚类满足以下要求:同一聚类中对象的相似度高;然而,不同聚类中对象的相似性很低。

聚类的相似性是对聚类中对象的平均值的度量,它可以被认为是聚类的中心或重心。

k均值算法的工作过程如下:首先,从n个数据对象中随机选取k个对象作为初始聚类中心;对于其余的其他对象,根据它们与这些聚类中心的相似性(距离),它们被分别分配给与它们最相似的聚类(由聚类中心表示)。

然后,计算每个获得的新聚类中的

个中心(聚类中所有对象的平均值)。

重复该过程,直到标准测量函

数开始收敛。

通常,均方差被用作标准测量函数。

其定义如下: ????|p?mi|2i?1p?Cik(1)

,其中E是数据集中所有对象的误差平方和,P是空间中的一个点,表示给定的对象,mi是聚类Ci的平均值(P和mi都是多维的)换句话说,对于每个集群中的每个对象,计算从对象到其集群中心的距离的平方,然后求和该准则试图使生成的K个结果簇尽可能紧凑和独立示例1:我们在二维空间中随机生成20个数据点,将聚类数指定为5,并随机生成一个聚类中心(标有“×”),根据对象与聚类中心的距离,每个对象属于最近的聚类初始示例图如下:

图1。

随机生成的数据点和初始聚类中心的示例图

接下来,更新聚类中心也就是说,根据集群中的当前对象重新计算每个集群的平均值。

使用这些新的聚类中心,对象被细分成具有最近聚类中心的聚类。

迭代上述过程,直到集群中对象的重新分布不再发生,并且该过程结束最终聚类结果示例图如下:

图2。

最终聚类结果示例图

从上图可以看出,最终聚类结果受初始聚类中心的影响很大,最终聚类质心点不一定在数据点上

K-均值算法试图确定最小化平方误差的K个分区当生成的簇是紧凑的并且簇之间明显分离时,其效果更好。

对于处理大数据集,该算法

是相对可伸缩和有效的,因为它的计算复杂度是O(nkt),其中n是对象的总数,k是聚类的数目,t是迭代的数目一般来说,k。