GBDT(梯度提升树) 原理小结

梯度提升法的原理及应用

梯度提升法的原理及应用1. 梯度提升法的背景梯度提升法(Gradient Boosting)是一种常用的集成学习算法,用于拟合回归问题或分类问题。

它是基于决策树的集成方法,通过序列化地训练一系列决策树模型,并通过梯度下降的方式进行优化,最终将多个模型的预测结果加权求和,得到最终的预测结果。

2. 梯度提升法的原理梯度提升法的原理可以分为以下几步:2.1 初始化模型首先,我们使用一个简单的模型作为初始模型,可以是一个简单的线性回归模型或常数。

2.2 计算损失函数的梯度接下来,我们计算当前模型预测结果与实际观测值之间的损失函数的梯度。

这一步是梯度提升法与其他集成学习方法的主要区别之一。

通过计算损失函数的梯度,我们可以得到模型预测结果的残差。

2.3 拟合残差将上一步计算得到的残差作为目标变量,使用一个新的模型来拟合这个残差。

通常情况下,我们使用决策树作为基本模型。

2.4 更新模型将新生成的模型添加到之前的模型中,并将其与之前的模型进行加权求和。

通过梯度下降的方式,更新模型的参数,使之逐步逼近最优解。

2.5 重复步骤2到步骤4重复进行步骤2到步骤4,直到达到设定的迭代次数或收敛准则。

2.6 得到最终预测结果将所有模型的预测结果加权求和,得到最终的预测结果。

3. 梯度提升法的应用梯度提升法在大量的实际问题中有着广泛的应用,特别是在回归问题和分类问题中。

3.1 回归问题在回归问题中,梯度提升法可以用于预测房价、股票价格等连续型目标变量。

通过序列化地训练一系列决策树模型,梯度提升法可以逐步逼近目标变量,得到更加准确的预测结果。

3.2 分类问题在分类问题中,梯度提升法可以用于预测用户的购买行为、信用评分等离散型目标变量。

通过训练一系列决策树模型,并通过梯度下降的方式进行优化,梯度提升法可以提高分类问题的准确度和稳定性。

3.3 特征选择梯度提升法可以通过特征的重要性评估来选择最重要的特征,有助于特征工程和模型优化。

极限梯度提升模型的训练-概述说明以及解释

极限梯度提升模型的训练-概述说明以及解释1.引言1.1 概述概述极限梯度提升模型(Extreme Gradient Boosting, XGBoost)是一种基于梯度提升决策树(Gradient Boosting Decision Tree, GBDT)算法的机器学习模型。

它在许多数据科学竞赛和实际应用中都表现出了出色的性能。

XGBoost模型的主要优势在于它具备高可扩展性、高效性和准确性。

通过在训练过程中采用了多种技术手段,XGBoost能够有效地处理高维特征和大规模数据集,并且在模型精度方面具有较强的竞争力。

本文将详细介绍极限梯度提升模型的训练方法和原理。

首先,我们将介绍梯度提升决策树算法的基本原理,包括梯度下降和决策树的概念。

然后,我们将阐述XGBoost模型的训练过程,包括损失函数的定义、模型的初始化和迭代优化算法。

最后,我们将探讨极限梯度提升模型在实际应用中的一些典型领域,如金融风控、推荐系统和医疗诊断等。

通过本文的阅读,读者将能够深入了解极限梯度提升模型的训练方法和原理,掌握XGBoost模型在实际应用中的优势和不足,并能够运用该模型解决实际问题。

希望本文能对机器学习和数据科学领域的研究者和从业者提供有益的参考和指导。

1.2 文章结构文章结构:本文主要包括引言、正文和结论三个部分。

引言部分主要是对本篇文章的概述,介绍了极限梯度提升模型的训练这一主题的背景和意义。

其中,概述部分会简要介绍极限梯度提升模型,包括其基本原理和训练过程。

文章结构部分将会列出本文的章节结构,并对各章节的内容进行简要说明。

正文部分主要分为三个章节:极限梯度提升模型的基本原理、极限梯度提升模型的训练过程和极限梯度提升模型的应用领域。

其中,极限梯度提升模型的基本原理章节将详细介绍该模型的基本概念、工作原理和数学原理等内容。

极限梯度提升模型的训练过程章节将详细说明该模型的训练方法和步骤,包括特征选择、参数设置、模型调优等方面的内容。

GBDT算法简述

GBDT算法简述提升决策树GBDT梯度提升决策树算法是近年来被提及较多的⼀个算法,这主要得益于其算法的性能,以及该算法在各类数据挖掘以及机器学习⽐赛中的卓越表现,有很多⼈对GBDT算法进⾏了开源代码的开发,⽐较⽕的是陈天奇的XGBoost和微软的LightGBM⼀、监督学习1、监督学习的主要任务监督学习是机器学习算法中重要的⼀种,对于监督学习,假设有m个训练样本:其中,,如分类问题;也可以为连续值,如回归问题。

在监督学习中利⽤训练样本训练出模型,该模型能够细线从样本特征。

为了能够对映射F进⾏求解,通常对模型设置损失函数,并求的损失函数最⼩的情况下的映射为最好的映射。

对于⼀个具体的问题,如线性回归问题,其映射函数的形式为:梯度下降法算法是求解最优化问题最简单、最直接的⽅法。

梯度下降法是⼀种迭代的优化算法,对于优化问题:其基本步骤为:1)随机选择⼀个初始点2)重复以下过程:决定下降的⽅向:选择步长更新:直到满⾜终⽌条件梯度下降法的具体过程如下图所⽰:2、在函数空间的优化以上是在指定的函数空间中对最优化函数进⾏搜索,那么,能否直接在函数空间中查找到最优的函数呢?根绝上述的梯度下降法的思路,对于模型的损失函数,为了⼆、Boosting1、集成⽅法之BoostingBoosting⽅法是集成学习中重要的⼀种⽅法,在集成学习⽅法中最主要的两种⽅法是Bagging和Boosting,在bagging中,通过对训练样本重新采样的⽅法得到不同的训练样本集,在这些新的训练样本集上分别训练学习器,最终合并每⼀个学习器的结果,作为最终的学习结果,Bagging⽅法的具体过程如下图所⽰:在Bagging⽅法中最重要的算法为随机森林RF算法。

由以上的图中可以看出,在Bagging⽅法中,b个学习器之间彼此是相互独⽴的,这样的特点使得Bagging⽅法更容易并⾏。

与bagging不同的是,在Boosting算法中,学习器之间是存在先后顺序的,同时,每⼀个样本是都有权重的,初始时,每⼀个样本的权重都是相等的,⾸先,第1个学习器对训练样本进⾏学习,当学习完成后,增⼤错误样本的权重,同时减⼩正确样本的权重,再利⽤第2个学习器对其进⾏学习,依次进⾏下去,最终得到b个学习器,最终,合并这b个学习器的结果,同时,与Bagging中不同的是,每个学习器的权重也不⼀样,Boosting⽅法的具体过程如下图所⽰:在Boosting⽅法中,最重要的⽅法包括:Adaboost和GBDT。

梯度提升决策树(GBDT)

梯度提升决策树(GBDT)

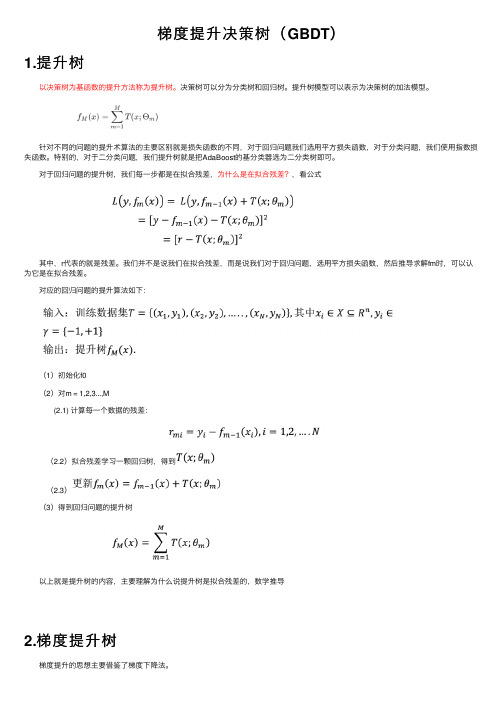

1.提升树

以决策树为基函数的提升⽅法称为提升树。

决策树可以分为分类树和回归树。

提升树模型可以表⽰为决策树的加法模型。

针对不同的问题的提升术算法的主要区别就是损失函数的不同,对于回归问题我们选⽤平⽅损失函数,对于分类问题,我们使⽤指数损失函数。

特别的,对于⼆分类问题,我们提升树就是把AdaBoost的基分类器选为⼆分类树即可。

对于回归问题的提升树,我们每⼀步都是在拟合残差,为什么是在拟合残差?,看公式

其中,r代表的就是残差。

我们并不是说我们在拟合残差,⽽是说我们对于回归问题,选⽤平⽅损失函数,然后推导求解fm时,可以认为它是在拟合残差。

对应的回归问题的提升算法如下:

(1)初始化f0

(2)对m = 1,2,3...,M

(2.1) 计算每⼀个数据的残差:

(2.2)拟合残差学习⼀颗回归树,得到

(2.3)

(3)得到回归问题的提升树

以上就是提升树的内容,主要理解为什么说提升树是拟合残差的,数学推导

2.梯度提升树

梯度提升的思想主要借鉴了梯度下降法。

十大经典预测算法(九)---GBDT

⼗⼤经典预测算法(九)---GBDT

GBDT⼜叫梯度提升决策树,它也属于Boosting框架。

GBDT核⼼原理如下:

如图所⽰,⽤GBDT预测年龄,第⼀轮,预测到年龄为20,它和真实值之间的残差为10,第⼆轮,GBDT开始预测上⼀轮的残差10,预测结果为6,这⼀轮的残差为4,第三轮,以年龄4为预测⽬标,预测来的值为3,和真实值之间相差1,最后以残差1为预测⽬标,预测结果为1,此时残差为0,预测结束,最后把之前模型预测的结果全部相加,就得到预测的真实值为30岁

所以,GBDT的核⼼原理是先⽤初始值预测⼀颗决策树,得到本轮的残差,即真实值减预测值,然后⽤残差作为下⼀轮决策树的预测对象,这时会再产⽣⼀个残差,再⽤这个残差作为下⼀轮的预测对象,以此循环迭代直到最后⼀轮的预测残差为0或⾮常⼩的时候就停⽌迭代,然后把所有轮的模型预测结果相加得到最终预测结果,GBDT核⼼原理如下图所⽰

GBDT和AdaBoost的异同

相似之处:

都是基于Boosting思想的融合算法

默认的基分类器都是决策树

AdaBoost其实是GBDT的⼀个特例

不同之处:

AdaBoost的基分类器可以选择更多的算法,⽽GBDT只能选决策树

GBDT的模型提升⽅法与AdaBoost不同,AdaBoost是通过不断加强对错判数据的权重学习来提升模型的预测效果,⽽GBDT则是通过不断降低模型误差来(学习残差)的思想来提升模型的预测效果。

GBDT!深入浅出详解梯度提升决策树

GBDT!深入浅出详解梯度提升决策树AI有道一个有情怀的公众号1Adaptive Boosted Decision TreeRandom Forest的算法流程我们之前已经详细介绍过,就是先通过bootstrapping“复制”原样本集D,得到新的样本集D’;然后对每个D’进行训练得到不同的decision tree和对应的gt;最后再将所有的gt通过uniform的形式组合起来,即以投票的方式得到G。

这里采用的Bagging的方式,也就是把每个gt的预测值直接相加。

现在,如果将Bagging替换成AdaBoost,处理方式有些不同。

首先每轮bootstrap得到的D’中每个样本会赋予不同的权重;然后在每个decision tree中,利用这些权重训练得到最好的gt;最后得出每个gt 所占的权重,线性组合得到G。

这种模型称为AdaBoost-D Tree。

但是在AdaBoost-DTree中需要注意的一点是每个样本的权重。

我们知道,在Adaptive Boosting中进行了bootstrap操作,u(t)表示D中每个样本在D’中出现的次数。

但是在决策树模型中,例如C&RT算法中并没有引入u(t)。

那么,如何在决策树中引入这些权重来得到不同的gt而又不改变原来的决策树算法呢?在Adaptive Boosting中,我们使用了weighted algorithm,形如:每个犯错误的样本点乘以相应的权重,求和再平均,最终得到了E。

如果在决策树中使用这种方法,将当前分支下犯错误的点赋予权重,每层分支都这样做,会比较复杂,不易求解。

为了简化运算,保持决策树算法本身的稳定性和封闭性,我们可以把决策树算法当成一个黑盒子,即不改变其结构,不对算法本身进行修改,而从数据来源D’上做一些处理。

按照这种思想,我们来看权重u实际上表示该样本在bootstrap中出现的次数,反映了它出现的概率。

那么可以根据u值,对原样本集D进行一次重新的随机sampling,也就是带权重的随机抽样。

gbdt原理

gbdt原理

梯度提升决策树(GBDT)是一种常用的监督学习算法,它是一种集成学习方法,通过集成多个决策树来构建强大的预测模型。

GBDT的原理如下:首先,我们定义一个损失函数,常用的有均方误差(MSE)、平均绝对误差(MAE)等。

然后,我们构建一个初始的决策树模型作为第一个基学习器。

接下来,我们根据定义的损失函数,计算当前模型的预测值与真实值之间的差异,这就是残差。

然后,我们使用这个残差作为新的标签,构建一个新的决策树模型,将其添加到集成模型中。

然后,我们通过迭代的方式,继续计算每个新模型的残差,并构建新的决策树模型,将其添加到集成模型中。

这样,我们不断地优化我们的模型,直到达到预设的迭代次数或停止条件。

最终,通过将每个决策树的预测结果进行累加,我们得到了最终的预测结果。

在预测过程中,GBDT使用加法模型的形式,将每个决策树的预测结果相加得到最终的预测值。

总结来说,GBDT通过迭代地构建决策树模型,并使用残差作为新的标签进行训练,不断优化模型的预测能力。

该算法具有很强的灵活性和鲁棒性,在很多实际问题中都有较好的表现。

GBDT算法原理深入解析

GBDT算法原理深入解析标签:机器学习集成学习GBM GBDT XGBoost梯度提升(Gradient boosting)是一种用于回归、分类和排序任务的机器学习技术,属于Boosting算法族的一部分。

Boosting是一族可将弱学习器提升为强学习器的算法,属于集成学习(ensemble learning)的范畴。

Boosting方法基于这样一种思想:对于一个复杂任务来说,将多个专家的判断进行适当的综合所得出的判断,要比其中任何一个专家单独的判断要好。

通俗地说,就是“三个臭皮匠顶个诸葛亮”的道理。

梯度提升同其他boosting方法一样,通过集成(ensemble)多个弱学习器,通常是决策树,来构建最终的预测模型。

Boosting、bagging和stacking是集成学习的三种主要方法。

不同于bagging方法,boosting方法通过分步迭代(stage-wise)的方式来构建模型,在迭代的每一步构建的弱学习器都是为了弥补已有模型的不足。

Boosting族算法的著名代表是AdaBoost,AdaBoost算法通过给已有模型预测错误的样本更高的权重,使得先前的学习器做错的训练样本在后续受到更多的关注的方式来弥补已有模型的不足。

与AdaBoost算法不同,梯度提升方法在迭代的每一步构建一个能够沿着梯度最陡的方向降低损失(steepest-descent)的学习器来弥补已有模型的不足。

经典的AdaBoost算法只能处理采用指数损失函数的二分类学习任务,而梯度提升方法通过设置不同的可微损失函数可以处理各类学习任务(多分类、回归、Ranking等),应用范围大大扩展。

另一方面,AdaBoost算法对异常点(outlier)比较敏感,而梯度提升算法通过引入bagging思想、加入正则项等方法能够有效地抵御训练数据中的噪音,具有更好的健壮性。

这也是为什么梯度提升算法(尤其是采用决策树作为弱学习器的GBDT算法)如此流行的原因,有种观点认为GBDT是性能最好的机器学习算法,这当然有点过于激进又固步自封的味道,但通常各类机器学习算法比赛的赢家们都非常青睐GBDT算法,由此可见该算法的实力不可小觑。

GBDT算法原理深入解析

GBDT算法原理深入解析标签:机器学习集成学习GBM GBDT XGBoost梯度提升(Gradient boosting)是一种用于回归、分类和排序任务的机器学习技术,属于Boosting算法族的一部分。

Boosting是一族可将弱学习器提升为强学习器的算法,属于集成学习(ensemble learning)的范畴。

Boosting方法基于这样一种思想:对于一个复杂任务来说,将多个专家的判断进行适当的综合所得出的判断,要比其中任何一个专家单独的判断要好。

通俗地说,就是“三个臭皮匠顶个诸葛亮”的道理。

梯度提升同其他boosting方法一样,通过集成(ensemble)多个弱学习器,通常是决策树,来构建最终的预测模型。

Boosting、bagging和stacking是集成学习的三种主要方法。

不同于bagging方法,boosting方法通过分步迭代(stage-wise)的方式来构建模型,在迭代的每一步构建的弱学习器都是为了弥补已有模型的不足。

Boosting族算法的著名代表是AdaBoost,AdaBoost算法通过给已有模型预测错误的样本更高的权重,使得先前的学习器做错的训练样本在后续受到更多的关注的方式来弥补已有模型的不足。

与AdaBoost算法不同,梯度提升方法在迭代的每一步构建一个能够沿着梯度最陡的方向降低损失(steepest-descent)的学习器来弥补已有模型的不足。

经典的AdaBoost算法只能处理采用指数损失函数的二分类学习任务,而梯度提升方法通过设置不同的可微损失函数可以处理各类学习任务(多分类、回归、Ranking等),应用范围大大扩展。

另一方面,AdaBoost算法对异常点(outlier)比较敏感,而梯度提升算法通过引入bagging思想、加入正则项等方法能够有效地抵御训练数据中的噪音,具有更好的健壮性。

这也是为什么梯度提升算法(尤其是采用决策树作为弱学习器的GBDT算法)如此流行的原因,有种观点认为GBDT是性能最好的机器学习算法,这当然有点过于激进又固步自封的味道,但通常各类机器学习算法比赛的赢家们都非常青睐GBDT算法,由此可见该算法的实力不可小觑。

gbdt原理

gbdt原理GBDT(Gradient Boosting Decision Tree)是一种集成学习算法,它通过多棵决策树的集成来提高预测准确性。

在GBDT中,每棵树都是基于上一棵树的残差进行训练的,这使得GBDT能够不断迭代地提高模型的预测能力。

本文将详细介绍GBDT的原理及其在机器学习中的应用。

首先,GBDT的核心思想是将多棵决策树进行集成。

在训练过程中,每棵树都试图学习上一棵树的残差,以此来不断改进模型的预测能力。

这种残差学习的方式使得GBDT能够有效地拟合复杂的非线性关系,从而提高模型的泛化能力。

其次,GBDT在训练过程中采用了梯度提升(Gradient Boosting)的方法。

具体来说,每一棵树的训练都是通过最小化损失函数来实现的。

在每一轮迭代中,GBDT都会计算出当前模型对训练样本的残差,然后用一个新的决策树来拟合这些残差,从而不断改进模型的预测能力。

此外,GBDT还采用了加法模型的思想。

在GBDT中,模型的预测结果是多棵树的预测结果的累加。

这种累加的方式使得GBDT能够灵活地拟合不同的数据分布,从而提高模型的适应能力。

在实际应用中,GBDT已经被广泛应用于各种机器学习任务中。

例如,在推荐系统中,GBDT可以用于预测用户对商品的喜好程度;在金融风控领域,GBDT可以用于预测客户的信用风险等。

由于GBDT 具有较强的泛化能力和适应能力,因此在实际应用中取得了很好的效果。

总的来说,GBDT作为一种集成学习算法,通过多棵决策树的集成来提高模型的预测能力。

它采用了梯度提升的方法,通过不断迭代地改进模型来提高预测准确性。

在实际应用中,GBDT已经取得了很好的效果,并被广泛应用于各种机器学习任务中。

希望本文能够帮助读者更好地理解GBDT的原理及其在机器学习中的应用。

GBT (3)

GBTGBT(Gradient Boosting Trees)是一种集成学习模型,它通过使用多个决策树来建立一个强大的预测模型。

在GBT中,每个决策树都是基于之前决策树的错误来构建的,这样可以逐步改进模型。

GBT广泛应用于回归和分类问题,并在许多机器学习竞赛中取得了优秀的成绩。

GBT的原理Gradient Boosting Trees由两个核心概念组成:梯度提升和决策树。

梯度提升梯度提升是GBT的核心,它通过迭代地拟合一个回归模型来改进预测结果。

每次迭代都会计算出模型的残差,然后使用残差作为目标来训练下一个模型。

最后,将所有的模型加起来,得到最终的预测结果。

决策树决策树是一种将输入特征空间划分为不同区域并对每个区域进行预测的模型。

GBT使用决策树作为基本的学习器,每个决策树都会根据之前决策树的错误来进行调整。

GBT中的决策树通常是二叉树,每个节点都有一个分裂规则,用于将输入样本划分到不同的子节点中。

GBT的训练过程通常包括以下几个步骤: 1. 初始化模型,将所有的预测值设为常数; 2. 计算模型的残差; 3. 使用残差来训练一个新的决策树模型; 4. 更新模型的预测值,将新的决策树模型的预测结果加到原来的预测值上; 5. 重复步骤2-4,直到满足停止条件。

GBT的优点GBT具有以下几个优点: - 高准确性:GBT能够处理复杂的非线性关系,因此通常能够获得较高的预测准确性。

- 可解释性强:由于GBT是由多个决策树组成的,每棵树都可以解释为特征的重要性,因此模型具有较强的可解释性。

- 鲁棒性强:梯度提升的过程通过不断减小残差来改进模型,因此对于异常值和噪声数据具有较强的鲁棒性。

GBT的应用GBT在实际应用中有广泛的应用,主要包括以下几个方面:- 回归问题:GBT可以用于预测数值型的输出变量,例如预测股票的价格、预测房价等。

- 分类问题:GBT也可以用于分类问题,例如预测某个用户是否会购买某个产品、预测电子邮件是否为垃圾邮件等。

GBDT:梯度提升决策树

综述GBDT(Gradient Boosting Decision Tree) 又叫 MART(Multiple Additive Regression Tree),是一种迭代的决策树算法,该算法由多棵决策树组成,所有树的结论累加起来做最终答案。

它在被提出之初就和SVM一起被认为是泛化能力较强的算法。

GBDT中的树是回归树(不是分类树),GBDT用来做回归预测,调整后也可以用于分类。

GBDT的思想使其具有天然优势可以发现多种有区分性的特征以及特征组合。

业界中,Facebook使用其来自动发现有效的特征、特征组合,来作为LR模型中的特征,以提高 CTR预估(Click-Through Rate Prediction)的准确性(详见参考文献5、6);GBDT在淘宝的搜索及预测业务上也发挥了重要作用(详见参考文献7)。

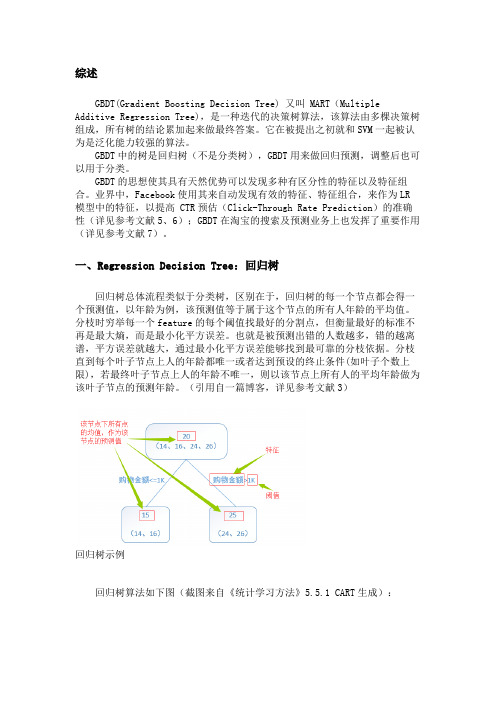

一、Regression Decision Tree:回归树回归树总体流程类似于分类树,区别在于,回归树的每一个节点都会得一个预测值,以年龄为例,该预测值等于属于这个节点的所有人年龄的平均值。

分枝时穷举每一个feature的每个阈值找最好的分割点,但衡量最好的标准不再是最大熵,而是最小化平方误差。

也就是被预测出错的人数越多,错的越离谱,平方误差就越大,通过最小化平方误差能够找到最可靠的分枝依据。

分枝直到每个叶子节点上人的年龄都唯一或者达到预设的终止条件(如叶子个数上限),若最终叶子节点上人的年龄不唯一,则以该节点上所有人的平均年龄做为该叶子节点的预测年龄。

(引用自一篇博客,详见参考文献3)回归树示例回归树算法如下图(截图来自《统计学习方法》5.5.1 CART生成):回归树生成算法二、Boosting Decision Tree:提升树算法提升树是迭代多棵回归树来共同决策。

当采用平方误差损失函数时,每一棵回归树学习的是之前所有树的结论和残差,拟合得到一个当前的残差回归树,残差的意义如公式:残差 = 真实值 - 预测值。

gbdt算法原理

gbdt算法原理

GBDT(梯度提升决策树)是一种迭代的决策树算法,是在传统的决策树学习算法的基础上进行加强的一种方法。

它是一种分类方法,利用弱学习训练生成强学习模型,可以将弱学习算法转化为强算法。

它包括训练和预测过程,用于解决回归问题和分类问题。

GBDT 将一个未知功能建模为一个梯度提升树。

在梯度提升的过程中,每个节点都是一个决策树,对整个训练样本集进行分析,然后决定是否应用当前决策树的节点拆分。

最终,当所有的决策树的节点都被拆分,训练样本集就被分解成由多个决策树组成的一个组合模型。

每棵树试图拟合剩余残差(残差指训练数据与组合模型之间的差值),以使框架残差逐步减少。

优化方式:GBDT 使用了最小均方差(Least Square)法作为它的损失函数。

弱分类器之间迭代中使用了梯度下降优化策略,使它们可以自行调整,使损失函数更小,最后得到最优结果。

组合:由于 GBDT 模型建立的每个树之间无关,因此可以使用 parallel training 来加快模型的训练速度。

GBDT 会根据上一棵树的训练结果,经进一步处理和优化,形成下一棵树,最后再进行组合。

应用:GBDT 非常适用于复杂的非线性数据,同时将几种不同的分类器进行组合,可以构建出一个非常强大而且稳健的分类器。

它被广泛用于推荐系统、特征客户群分类、对照群建模和网络搜索等多个领域。

梯度提升算法的原理和应用

梯度提升算法的原理和应用一、引言梯度提升算法(Gradient Boosting)是一种集成学习方法,通过将多个弱学习器(通常是决策树)组合起来,形成一个强学习器。

梯度提升算法以其高精度和良好的鲁棒性,在机器学习领域中得到广泛应用。

本文将介绍梯度提升算法的原理和一些常见的应用场景。

二、梯度提升算法原理梯度提升算法采用了迭代的方法,通过不断地学习和优化弱学习器,使整体模型不断逼近真实值或损失函数的最优解。

其原理主要包括以下几个步骤:1. 初始化弱学习器梯度提升算法首先需要初始化一个弱学习器,通常选择决策树作为弱学习器。

每个决策树只考虑一部分特征进行分裂,从而形成一个基本的分类器。

2. 计算残差在每一轮迭代中,梯度提升算法通过计算当前模型的预测值与真实值之间的残差,来更新残差的值。

残差是指当前模型的预测值与真实值之间的差异。

3. 计算损失函数的负梯度利用当前模型的残差,计算损失函数的负梯度,即负梯度损失。

负梯度损失表示了当前模型的预测值偏离真实值的方向,用于指导下一轮迭代中模型的更新方向。

4. 基于负梯度损失训练弱学习器根据计算得到的负梯度损失,对当前模型训练一个新的弱学习器。

通常采用梯度下降法来优化决策树,使其最小化损失函数。

5. 更新模型将新训练得到的弱学习器加入到模型中,通过加权平均的方式更新当前模型,使其逼近真实值或损失函数的最优解。

6. 重复迭代重复进行步骤2至步骤5,直到达到指定的迭代次数或达到指定的停止条件,得到最终的模型。

三、梯度提升算法的应用梯度提升算法在各个领域中都有广泛的应用,下面介绍其中一些常见的应用场景。

1. 回归问题梯度提升算法可以用于解决回归问题,如房价预测、股票价格预测等。

通过训练多个弱学习器,并将其进行加权平均,可以得到一个较为准确的回归模型。

2. 分类问题梯度提升算法也可应用于解决分类问题,如垃圾邮件过滤、图像识别等。

通过训练多个弱分类器,并基于加权平均的方式进行预测,可以得到一个具有较高精度的分类模型。

GBDT--原来是这么回事(附代码)

GBDT--原来是这么回事(附代码)1. 解释⼀下GBDT算法的过程GBDT(Gradient Boosting Decision Tree),全名叫梯度提升决策树,使⽤的是Boosting的思想。

1.1 Boosting思想Boosting⽅法训练基分类器时采⽤串⾏的⽅式,各个基分类器之间有依赖。

它的基本思路是将基分类器层层叠加,每⼀层在训练的时候,对前⼀层基分类器分错的样本,给予更⾼的权重。

测试时,根据各层分类器的结果的加权得到最终结果。

Bagging与Boosting的串⾏训练⽅式不同,Bagging⽅法在训练过程中,各基分类器之间⽆强依赖,可以进⾏并⾏训练。

1.2 GBDT原来是这么回事GBDT的原理很简单,就是所有弱分类器的结果相加等于预测值,然后下⼀个弱分类器去拟合误差函数对预测值的残差(这个残差就是预测值与真实值之间的误差)。

当然了,它⾥⾯的弱分类器的表现形式就是各棵树。

举⼀个⾮常简单的例⼦,⽐如我今年30岁了,但计算机或者模型GBDT并不知道我今年多少岁,那GBDT咋办呢?它会在第⼀个弱分类器(或第⼀棵树中)随便⽤⼀个年龄⽐如20岁来拟合,然后发现误差有10岁;接下来在第⼆棵树中,⽤6岁去拟合剩下的损失,发现差距还有4岁;接着在第三棵树中⽤3岁拟合剩下的差距,发现差距只有1岁了;最后在第四课树中⽤1岁拟合剩下的残差,完美。

最终,四棵树的结论加起来,就是真实年龄30岁(实际⼯程中,gbdt是计算负梯度,⽤负梯度近似残差)。

为何gbdt可以⽤⽤负梯度近似残差呢?回归任务下,GBDT 在每⼀轮的迭代时对每个样本都会有⼀个预测值,此时的损失函数为均⽅差损失函数,那此时的负梯度是这样计算的所以,当损失函数选⽤均⽅损失函数是时,每⼀次拟合的值就是(真实值 - 当前模型预测的值),即残差。

此时的变量是y',即“当前预测模型的值”,也就是对它求负梯度。

训练过程简单起见,假定训练集只有4个⼈:A,B,C,D,他们的年龄分别是14,16,24,26。

B K 树 算 法

GBDT梯度提升树算法及官方案例梯度提升树是一种决策树的集成算法。

它通过反复迭代训练决策树来最小化损失函数。

决策树类似,梯度提升树具有可处理类别特征、易扩展到多分类问题、不需特征缩放等性质。

Spark.ml通过使用现有decision tree工具来实现。

梯度提升树依次迭代训练一系列的决策树。

在一次迭代中,算法使用现有的集成来对每个训练实例的类别进行预测,然后将预测结果与真实的标签值进行比较。

通过重新标记,来赋予预测结果不好的实例更高的权重。

所以,在下次迭代中,决策树会对先前的错误进行修正。

对实例标签进行重新标记的机制由损失函数来指定。

每次迭代过程中,梯度迭代树在训练数据上进一步减少损失函数的值。

spark.ml为分类问题提供一种损失函数(Log Loss),为回归问题提供两种损失函数(平方误差与绝对误差)。

Spark.ml支持二分类以及回归的随机森林算法,适用于连续特征以及类别特征。

不支持多分类问题。

# -*- coding: utf-8 -*-Created on Wed May 9 09:53:30 2018@author: adminimport numpy as npimport matplotlib.pyplot as pltfrom sklearn import ensemblefrom sklearn import datasetsfrom sklearn.utils import shufflefrom sklearn.metrics import mean_squared_error################################################################ ############### Load databoston = datasets.load_boston()X, y = shuffle(boston.data, boston.target, random_state=13) X = X.astype(np.float32)offset = int(X.shape[0] * 0.9)X_train, y_train = X[:offset], y[:offset]X_test, y_test = X[offset:], y[offset:]################################################################ ############### Fit regression modelparams = {'n_estimators': 500, 'max_depth': 4, 'min_samples_split': 2,'learning_rate': 0.01, 'loss': 'ls'} #随便指定参数长度,也不用在传参的时候去特意定义一个数组传参clf = ensemble.GradientBoostingRegressor(**params)clf.fit(X_train, y_train)mse = mean_squared_error(y_test, clf.predict(X_test))print("MSE: %.4f" % mse)################################################################ ############### Plot training deviance# compute test set deviancetest_score = np.zeros((params['n_estimators'],), dtype=np.float64)for i, y_pred in enumerate(clf.staged_predict(X_test)):test_score[i] = clf.loss_(y_test, y_pred)plt.figure(figsize=(12, 6))plt.subplot(1, 2, 1)plt.title('Deviance')plt.plot(np.arange(params['n_estimators']) + 1, clf.train_score_, 'b-',label='Training Set Deviance')plt.plot(np.arange(params['n_estimators']) + 1, test_score, 'r-',label='Test Set Deviance')plt.legend(loc='upper right')plt.xlabel('Boosting Iterations')plt.ylabel('Deviance')################################################################ ############### Plot feature importancefeature_importance = clf.feature_importances_# make importances relative to max importancefeature_importance = 100.0 * (feature_importance - feature_importance.max())sorted_idx = np.argsort(feature_importance)pos = np.arange(sorted_idx.shape[0]) + .5plt.subplot(1, 2, 2)plt.barh(pos, feature_importance[sorted_idx], align='center') plt.yticks(pos, boston.feature_names[sorted_idx])plt.xlabel('Relative Importance')plt.title('Variable Importance')plt.show()房产数据介绍:- CRIM? per capita crime rate by town?- ZN? proportion of residential land zoned for lots over 25,000 sq.ft.?- INDUS? proportion of non-retail business acres per town?- CHAS? CharlesRiver dummy variable (= 1 if tract bounds river; 0 otherwise)?- NOX? nitric oxides concentration (parts per 10 million)?- RM? average number of rooms per dwelling?- AGE? proportion of owner-occupied units built prior to 1940?- DIS? weighted distances to five Boston employment centres?- RAD? index of accessibility to radial highways?- TAX? full-value property-tax rate per $10,000?- PTRATIO? pupil-teacher ratio by town?- B? 1000(Bk - 0.63)^2 where Bk is the proportion of blacks by town?- LSTAT? % lower status of the population?- MEDV? Median value of owner-occupied homes in $1000' if( k[a] + k[b] + k[c] + k[d] == m)1. d(x,y) = 0 当且仅当 x=y? (Levenshtein距离为0 == 字符串相等)bool Place(int k, int i, int *x)plt.plot(np.arange(params['n_estimators']) + 1, clf.train_score_, 'b-',for i:=1 to n do inc(ans,a[i]);记 wi,j pi,j为m(i,j) ,则m(1,n)=w1,n p1,n=p1,n为所求的最优值。

GBDT算法的原理与应用

GBDT算法的原理与应用GBDT(Gradient Boosting Decision Tree)算法是一种基于树模型的迭代学习算法,它通过在多个决策树之间提升模型的表现。

该算法是通过在迭代中逐步减小误差而提高模型精度的。

和随机森林相比,GBDT 算法更加灵活、精度更高,且可以有效处理高维数据和非线性数据。

1. 基本原理GBDT算法基于回归树,通过将多个简单的回归树组合起来,形成一个复杂的模型。

在GBDT算法中,每个回归树的训练都是为了减小前一颗回归树残差的平方和。

首先,建立一个初始的回归树,然后计算该树的残差,在依次生成多颗回归树,每颗回归树都拟合上一颗回归树的残差,然后加起来形成一个新的整体模型。

GBDT 通过责任分配的方式来训练每个决策树,使用步长参数和迭代次数控制逼近过程的速度。

当达到指定的迭代次数或训练误差小于设定阈值时,结束模型训练,输出训练好的模型。

2. 应用场景GBDT算法在广泛的应用领域中均可派上用场。

例如,在金融领域中,它可以用来预测信用风险、股票市场走势、大宗商品价格等;在互联网领域中,它可以用于用户行为预测、广告点击率预测、搜索结果排序等;在医学领域,可以用于癌症早期诊断、药物研发等。

具体的应用场景还包括国际象棋精通度预测、疾病预测等。

3. 算法优化GBDT 算法在应对数据中的一些常见问题时,存在一些优化方法。

首先是在高维度数据中使用特征选择技术消除不必要的特征,提高训练效率和模型精度。

其次是通过缩小步长参数、增加决策树深度、调整正则化系数等优化方法,可以进一步提高模型的稳定性和泛化能力。

另外,采用随机渐进搜索或 Stochastic Gradient Boosting,可以加速模型训练。

最后再提一提,数据预处理(例如缺失值处理、数据归一化等)对模型训练也是有很大的帮助的。

4. 实战应用GBDT 算法在实际应用过程中,一般使用 Python、R 等主流编程语言进行开发和调试。

机器学习算法总结(四)——GBDT与XGBOOST

机器学习算法总结(四)——GBDT与XGBOOST Boosting⽅法实际上是采⽤加法模型与前向分布算法。

在上⼀篇提到的Adaboost算法也可以⽤加法模型和前向分布算法来表⽰。

以决策树为基学习器的提升⽅法称为提升树(Boosting Tree)。

对分类问题决策树是CART分类树,对回归问题决策树是CART回归树。

1、前向分布算法 引⼊加法模型 在给定了训练数据和损失函数L(y, f(x))的条件下,可以通过损失函数最⼩化来学习加法模型 然⽽对于这个问题是个很复杂的优化问题,⽽且要训练的参数⾮常的多,前向分布算法的提出就是为了解决模型的优化问题,其核⼼思想是因为加法模型是由多各模型相加在⼀起的,⽽且在Boosting中模型之间⼜是有先后顺序的,因此可以在执⾏每⼀步加法的时候对模型进⾏优化,那么每⼀步只需要学习⼀个模型和⼀个参数,通过这种⽅式来逐步逼近全局最优,每⼀步优化的损失函数: 具体算法流程如下: 1)初始化f_0(x) = 0; 2)第m次迭代时,极⼩化损失函数 3)更新模型,则$f_m(x)$: 4)得到最终的加法模型 Adaboost算法也可以⽤前向分布算法来描述,在这⾥输⼊的数据集是带有权重分布的数据集,损失函数是指数损失函数。

2、GBDT算法 GBDT是梯度提升决策树(Gradient Boosting Decision Tree)的简称,GBDT可以说是最好的机器学习算法之⼀。

GBDT分类和回归时的基学习器都是CART回归树,因为是拟合残差的。

GBDT和Adaboost⼀样可以⽤前向分布算法来描述,不同之处在于Adaboost算法每次拟合基学习器时,输⼊的样本数据是不⼀样的(每⼀轮迭代时的样本权重不⼀致),因为Adaboost旨在重点关注上⼀轮分类错误的样本,GBDT算法在每⼀步迭代时是输出的值不⼀样,本轮要拟合的输出值是之前的加法模型的预测值和真实值的差值(模型的残差,也称为损失)。

gbdt原理

gbdt原理

梯度提升(Gradient Boosting,GBDT)是一种机器学习方法,

可用于分类和回归。

它是集成学习中的一种,因此结合了用于确定分

类和回归模型的多种基础学习器或算法,从而提高模型表现情况。

这

些基础学习器通常是决策树,因此GBDT也被称为梯度提升决策树或GBDT。

GBDT的模型是逐个学习器,它们一起工作以准确地预测输出结果。

每个基础学习器都是以一种特定顺序训练的,以帮助模型学习以前未

尝试的解决方案。

方法的一般过程是,第一个基础学习器被训练以尽

可能准确地拟合初始数据,以便捕捉主要的数据特征,然后以次要学

习器继续,以此类推。

每个学习器都提高了模型的准确性,而且由于它们基于梯度,所

以这些可改进量是基于梯度优化方法发现的。

梯度优化方法是对模型

的损失函数进行修正,以减少损失表现,从而改善模型的性能。

所以,GBDT模型相当于在训练之前使用梯度优化技术来拟合基础学习器,以

最小化误差。

总之,GBDT是一种高效的机器学习技术,已被广泛用于预测和分析,并可用于减少拟合数据和改善模型表现。

此外,由于它是逐步叠

加学习器来实现的,因此它可以轻松处理复杂的数据,并能有效地利

用已有的知识来进一步增强学习表现。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1) 初始化弱学习器: 2) 对迭代轮数t=1,2,...T有: a)对样本i=1,2,...m,计算负梯度

b)利用(xi,r ti)(i=1,2...m), 拟合一颗CART回归树,得到第t颗回归树,其对应的叶子节点区域为 Rtj,j=1.2...J 。其中J为回归树t的叶子节点的个数。

b)绝对损失,这个损失函数也很常见

对应负梯度误差为:

c)Huber损失,它是均方差和绝对损失的折衷产物,对于远离中心的异常点,采用绝对损 失,而中心附近的点采用均方差。这个界限一般用分位数点度量。损失函数如下:

对应的负梯度误差为:

d) 分位数损,需要我们在回归前指定。对应的负梯度误差为:

这里我们再对常用的GBDT损失函数做一个总结。 对于分类算法,其损失函数一般有对数损失函数和指数损失函数两种: a) 如果是指数损失函数,则损失函数表达式为

其负梯度计算和叶子节点的最佳残差拟合参见Adaboost原理篇。 b) 如果是对数损失函数,分为二元分类和多元分类两种,参见4.1节和4.2节。 对于回归算法,常用损失函数有如下4种: a)均方差,这个是最常见的回归损失函数了

如果我们加上了正则化项,则有:

v 的取值范围为0<v<1.对于同样的训练集学习效果,较小的v意味着我们需要更多的弱学习 器的迭代次数。通常我们用步长和迭代最大次数一起来决定算法的拟合效果。

第二种正则化的方式是通过子采样比例(subsample)。取值为(0,1]。注意这里的子采样和 随机森林不一样,随机森林使用的是放回抽样,而这里是不放回抽样。如果取值为1,则全部样本 都使用,等于没有使用子采样。如果取值小于1,则只有一部分样本会去做GBDT的决策树拟合。 选择小于1的比例可以减少方差,即防止过拟合,但是会增加样本拟合的偏差,因此取值不能太 低。推荐在[0.5, 0.8]之间。

GBDT也是集成学习Boosting家族的成员,但是却和传统的Adaboost有很大的不同。回顾下 Adaboost,我们是利用前一轮迭代弱学习器的误差率来更新训练集的权重,这样一轮轮的迭代 下去。GBDT也是迭代,使用了前向分布算法,但是弱学习器限定了只能使用CART回归树模型, 同时迭代思路和Adaboost也有所不同。

从而本轮最终得到的强学习器的表达式如下:

通过损失函数的负梯度来拟合,我们找到了一种通用的拟合损失误差的办法,这样无轮是分 类问题还是回归问题,我们通过其损失函数的负梯度的拟合,就可以用GBDT来解决我们的分类 回归问题。区别仅仅在于损失函数不同导致的负梯度不同而已。

好了,有了上面的思路,下面我们总结下GBDT的回归算法。为什么没有加上分类算法一 起?那是因为分类算法的输出是不连续的类别值,需要一些处理才能使用负梯度,我们在下一节 讲。

从上面的例子看这个思想还是蛮简单的,但是有个问题是这个损失的拟合不好度量,损失函 数各种各样,怎么找到一种通用的拟合方法呢?

在上一节中,我们介绍了GBDT的基本思路,但是没有解决损失函数拟合方法的问题。针对 这个问题,大牛Freidman提出了用损失函数的负梯度来拟合本轮损失的近似值,进而拟合一个 CART回归树。第t轮的第i个样本的损失函数的负梯度表示为:

多元GBDT要比二元GBDT复杂一些,对应的是多元逻辑回归和二元逻辑回归的复杂度差别。 假设类别数为K,则此时我们的对数似然损失函数为:

其中如果样本输出类别为k,则yk=1第k类的概率Pk(x)表达式为: 集合上两式,我们可以计算出第t 轮的i 个样本对应类别

集合上两式,我们可以计算出第t轮的i个样本对应类别 的负梯度误差为:

为了解决这个问题,主要有两个方法,一个是用指数损失函数,此时GBDT退化为Adaboost 算法。另一种方法是用类似于逻辑回归的对数似然损失函数的方法。也就是说,我们用的是类别 的预测概率值和真实概率值的差来拟合损失。本文仅讨论用对数似然损失函数的GBDT分类。而 对于对数似然损失函数,我们又有二元分类和多元分类的区别。

c) 对叶子区域j =1,2,..J,计算最佳拟合值

d) 更新强学习器

3) 得到强学习器f(x)的表达式

这里我们再看看GBDT分类算法,GBDT的分类算法从思想上和GBDT的回归算法没有区别, 但是由于样本输出不是连续的值,而是离散的类别,导致我们无法直接从输出类别去拟合类别输 出的误差。

观察上式可以看出,其实这里的 误差就是样本i对应类别

观察上式可以看出,其实这里的误差就是样本i对应类别 的真实概率和t-1轮预测概率的差值。

的真实概率和t-1 对于生成的决策树,我们各个叶子节点的最佳残差拟合值为:

由于上式比较难优化,我们一般使用近似值代替:

除了负梯度计算和叶子节点的最佳残差拟合的线性搜索,多元GBDT分类和二元GBDT分类以 及GBDT回归算法过程相同。

利用(xi,rti)(i=1,2,...m),我们可以拟合一颗CART回归树,得到了第t颗回归树,其对应的叶节 点区域Rtj,j=1,2,...,J。其中J为叶子节点的个数。

针对每一个叶子节点里的样本,我们求出使损失函数最小,也就是拟合叶子节点最好的的输 出值ctj如下:

这样我们就得到了本轮的决策树拟合函数如下:

对于二元GBDT,如果用类似于逻辑回归的对数似然损失函数,则损失函数为:

其中y {-1,1} 则此时的负梯度误差为:

对于生成的决策树,我们各个叶子节点的最佳残差拟合值为:

由于上式比较难优化,我们一般使用近似值代替

除了负梯度计算和叶子节点的最佳残差拟合的线性搜索,二元GBDT分类和GBDT回归算法过 程相同。

在GBDT的迭代中,假设我们前一轮迭代得到的强学习器是ft-1(x)损失函数是L(y,ft-1(x)) 我 们本轮迭代的目标是找到一个CART回归树模型的弱学习器ht(x),让本轮的损失L(t,ft-1(x)+ht(x)) 最小。也就是说,本轮迭代找到决策树,要让样本的损失尽量变得更小。

GBDT的思想可以用一个通俗的例子解释,假如有个人30岁,我们首先用20岁去拟合,发现 损失有10岁,这时我们用6岁去拟合剩下的损失,发现差距还有4岁,第三轮我们用3岁拟合剩下 的差距,差距就只有一岁了。如果我们的迭代轮数还没有完,可以继续迭代下面,每一轮迭代, 拟合的岁数误差都会减小。

GBDT主要的优点有:

1) 可以灵活处理各种类型的数据,包括连续值和离散值。

2) 在相对少的调参时间情况下,预测的准确率也可以比较高。这个是相对SVM来说的。

3)使用一些健壮的损失函数,对异常值的鲁棒性非常强。比如 Huber损失函数和Quantile 损失函数。

GBDT的主要缺点有:

1)由于弱学习器之间存在依赖关系,难以并行训练数据。不过可以通过自采样的SGBT来达到 部分并行。

使用了子采样的GBDT有时也称作随机梯度提升树(Stochastic Gradient Boosting Tree, SGBT)。由于使用了子采样,程序可以通过采样分发到不同的任务去做boosting的迭代过程,最 后形成新树,从而减少弱学习器难以并行学习的弱点。

第三种是对于弱学习器即CART回归树进行正则化剪枝。在决策树原理篇里我们已经讲过,这 里就不重复了。

(文章参考自刘建平机器学习)

共轭梯度法

欧几里得距离

神经网络浅讲

径向基函数神经网络

imagenet

GBDT(梯度提升树) 原理小结

在之前博客中,我们对Boosting家族的Adaboost算法做了总结,本文就对Boosting家族中 另一个重要的算法梯度提升树(Gradient Boosting Decison Tree, 以下简称GBDT)做一个总结。 GBDT有很多简称,有GBT(Gradient Boosting Tree), GTB(Gradient Tree Boosting ), GBRT(Gradient Boosting Regression Tree), MART(Multiple Additive Regression Tree),其实都是指的同一种算法,本文统一简称GBDT。GBDT在BAT大厂中也有广 泛的应用,假如要选择3个最重要的机器学习算法的话,个人认为GBDT应该占一席之地。

GBDT终于讲完了,GDBT本身并不复杂,不过要吃透的话需要对集成学习的原理,决策树原 理和各种损失函树有一定的了解。由于GBDT的卓越性能,只要是研究机器学习都应该掌握这个 算法,包括背后的原理和应用调参方法。目前GBDT的算法比较好的库是xgboost。当然scikitlearn也可以。

最后总结下GBDT的优缺点。

为分位数,需要我们在回归前指定。对应的负梯度误差为:

对于Huber损失和分位数损失,主要用于健壮回归,也就是减少异常点对损失函数的影响。 和Adaboost一样,我们也需要对GBDT进行正则化,防止过拟合。GBDT的正则化主要有三 种方式。 第一种是和Adaboost类似的正则化项,即步长(learning rate)。定义为V,对于前面的弱学 习器的迭代