hive常用语句

hive数据库查询表大小的sql语句

hive数据库查询表大小的sql语句Hive数据库是一个基于Hadoop的数据仓库,它以SQL语言为基础,可以方便地进行大规模数据的处理和分析。

在使用Hive数据库时,经常需要查询表的大小来了解表的数据占用情况。

本文将介绍几种查询表大小的SQL语句。

Step 1:使用DESCRIBE EXTENDED命令DESCRIBE EXTENDED命令是Hive中常用的查询表结构的命令。

其包含了表的详细信息,包括表的大小。

具体操作步骤如下:1. 打开Hive终端,并连接到相应的数据库。

2. 输入DESCRIBE EXTENDED表名,例如:DESCRIBE EXTENDED myTable; 。

3. 在查询结果中找到表大小相关的信息,一般为Total Size。

该方法的优点是简单易行,只需一条SQL语句即可查询到表的大小。

但缺点是查询结果包含了大量的表信息,需要耗费一定的时间和网络带宽。

此外,如果表的大小特别大,DESCRIBE EXTENDED命令可能导致Hive Server挂起。

Step 2:使用hdfs dfs -du命令Hadoop分布式文件系统(HDFS)是Hive数据库的底层存储系统。

因此,使用hdfs dfs -du命令查询表的大小,可以得到更准确的结果。

具体操作步骤如下:1. 打开Hadoop Shell终端,并连接到NameNode。

2. 输入hdfs dfs -du/user/hive/warehouse/db_name.db/myTable/命令,其中db_name和myTable分别为数据库名和表名。

3. 查询结果中,第一列为表的总大小,第二列为所有分区的大小之和。

通常,我们只关注第一列结果即可。

该方法的优点是查询结果准确,并且速度较快。

缺点是需要打开Hadoop Shell,操作较为繁琐。

Step 3:使用SHOW TABLE EXTENDED命令SHOW TABLE EXTENDED命令可以查询表的扩展属性,包括表的大小信息。

hive常用的的函数

hive常用的的函数Hive提供了一种简单的SQL查询语言称为HiveQL,它允许数据工程师、数据分析师和应用程序开发人员查询和管理大规模数据。

以下是Hive中常用的一些函数:1. 字符串函数:`length(string)`: 返回字符串的长度。

`concat(string1, string2, ...)`: 连接两个或多个字符串。

`substr(string, start, length)`: 返回字符串的子串。

`trim(string)`: 去除字符串两端的空格。

`ltrim(string)`: 去除字符串左端的空格。

`rtrim(string)`: 去除字符串右端的空格。

2. 数值函数:`abs(bigint)`: 返回整数的绝对值。

`ceil(double)`: 返回大于或等于给定数字的最小整数。

`floor(double)`: 返回小于或等于给定数字的最大整数。

`round(double, ndigits)`: 返回四舍五入的值,其中ndigits是精度。

`mod(int, int)`: 返回第一个参数除以第二个参数的余数。

3. 日期函数:`current_date()`: 返回当前日期。

`from_unixtime(unix_timestamp[, format])`: 将UNIX时间戳转换为指定格式的日期时间。

`unix_timestamp()`: 将当前日期和时间转换为UNIX时间戳(以秒为单位)。

`date_format(date, format)` or `date_format(timestamp, format)`: 将日期/时间值格式化为指定的字符串格式。

4. 聚合函数:`count(), count(column)`: 计算行数或非NULL值的数量。

`sum(column)`: 计算列的总和。

`avg(column)`: 计算列的平均值。

`min(column)`: 返回列中的最小值。

hive cast as用法

hive cast as用法Hive Cast As用法简介Hive Cast As是Hive中的一个关键字,用于将字段的数据类型进行转换。

它可以将某个字段从一种数据类型转换为另一种数据类型,以满足不同的业务需求。

用法一:将字符型字段转换为数字型字段SELECT CAST(column_name AS data_type) FROM table_na me;该用法可以将字符型字段转换为数字型字段。

其中,column_name 代表要转换的字段名称,data_type代表目标数据类型。

例如,假设有一个表student,其中有一个字段age为字符串类型(varchar),我们想要将其转换为整型(int),可以使用以下语句:SELECT CAST(age AS int) FROM student;用法二:将数字型字段转换为字符型字段SELECT CAST(column_name AS data_type) FROM table_na me;该用法可以将数字型字段转换为字符型字段。

其中,column_name 代表要转换的字段名称,data_type代表目标数据类型。

例如,假设有一个表sales,其中有一个字段amount为浮点型(float),我们想要将其转换为字符串型(string),可以使用以下语句:SELECT CAST(amount AS string) FROM sales;用法三:将日期型字段转换为字符串类型SELECT CAST(column_name AS string) FROM table_name;该用法可以将日期型字段转换为字符型字段。

其中,column_name 代表要转换的字段名称。

例如,假设有一个表orders,其中有一个字段order_date为日期类型(date),我们想要将其转换为字符串类型(string),可以使用以下语句:SELECT CAST(order_date AS string) FROM orders;用法四:将字符型字段转换为日期类型SELECT CAST(column_name AS date) FROM table_name;该用法可以将字符型字段转换为日期型字段。

hive空间函数

Hive是基于Hadoop的数据仓库工具,支持SQL语句和类SQL语句,提供了一些空间函数,用于处理空间数据。

以下是常用的Hive空间函数:

1. ST_Area:计算几何图形的面积。

2. ST_Boundary:返回几何图形的边界。

3. ST_Centroid:计算几何图形的重心。

4. ST_ConvexHull:计算几何图形的凸壳。

5. ST_Contains:判断一个几何图形是否包含另一个几何图形。

6. ST_Crosses:判断两个几何图形是否交叉。

7. ST_Disjoint:判断两个几何图形是否不相交。

8. ST_Envelope:返回几何图形的最小外接矩形。

9. ST_Equals:判断两个几何图形是否相等。

10. ST_Intersects:判断两个几何图形是否交叉。

11. ST_PointOnSurface:返回几何图形表面上的一个点。

12. ST_SymDifference:返回两个几何图形的对称差集。

13. ST_Union:返回多个几何图形的并集。

14. ST_Within:判断一个几何图形是否在另一个几何图形内部。

15. ST_X:返回几何图形的x坐标。

16. ST_Y:返回几何图形的y坐标。

这些空间函数在处理空间数据时非常有用,例如可以用于计算地理区域的面积、周长、重心等信息,判断两个地理位置之间的距离、相交关系等。

hive insert用法

hive insert用法摘要:一、Hive简介1.Hive是什么2.Hive的作用二、Hive的Insert操作1.Insert into语句2.Overwrite和Append选项3.路径和目录三、Hive Insert示例1.插入单行数据2.插入多行数据3.插入数据到已有表四、Hive Insert注意事项1.数据类型匹配2.表结构检查3.权限检查正文:Hive是一个基于Hadoop的数据仓库工具,它可以用来存储、查询和分析大规模的结构化数据。

Hive支持多种数据存储格式,如Parquet、Avro、SequenceFile等,并提供了一系列的操作符和函数,以方便用户进行数据处理和分析。

Hive的Insert操作是用于向Hive表中插入数据的。

它有两种形式:Insert into语句和Insert overwrite语句。

Insert into语句用于向已有表插入数据,而Insert overwrite语句用于覆盖已有表中的数据。

在实际应用中,根据需求选择合适的插入方式。

在使用Hive Insert操作时,需要注意以下几点:1.数据类型匹配:插入的数据需与表结构中对应列的数据类型匹配,否则插入操作将失败。

2.表结构检查:在插入数据前,请确保表结构与数据一致。

如有差异,可以使用Alter Table语句进行调整。

3.权限检查:确保执行Insert操作的用户具有向目标表插入数据的权限。

以下是一个Hive Insert的示例:```-- 插入单行数据INSERT INTO table_name (column1, column2)VALUES ("value1", "value2");-- 插入多行数据INSERT INTO table_name (column1, column2)SELECT "value1", "value2";-- 插入数据到已有表INSERT OVERWRITE table_name (column1, column2)SELECT "value1", "value2";```总之,Hive的Insert操作是数据仓库处理中常用的操作之一。

hivesql常用set

hivesql常⽤setset hive.execution.engine = tez; --"mr", "tez", "spark"set =root.hello;set tez.grouping.min-size=556000000;set tez.grouping.max-size=3221225472;set hive.tez.auto.reducer.parallelism=true;set mapreduce.map.cpu.vcores=6;set mapreduce.map.memory.mb=3072;set mapreduce.map.java.opts=-Xmx2400m -Dfile.encoding=UTF-8;set mapreduce.reduce.cpu.vcores=6;set mapreduce.reduce.memory.mb=6144;set mapreduce.reduce.java.opts=-Xmx4900m -Dfile.encoding=UTF-8;set hive.exec.max.created.files=900000;set =root.ESS-GODDOG-OFFLINE;set =t_dm_relation_graph;set hive.exec.dynamic.partition=true;set hive.exec.dynamic.partition.mode=nonstrict;set hive.exec.max.dynamic.partitions=3000;set hive.exec.max.dynamic.partitions.pernode=1000;set hive.fetch.task.conversion=more;set hive.exec.parallel=true;set hive.exec.parallel.thread.number=2048;set mapreduce.job.jvm.numtasks=-1;set hive.exec.reducers.bytes.per.reducer=500000000;--set mapred.reduce.tasks=1024;set hive.auto.convert.join=true;set hive.map.aggr=true;set hive.groupby.skewindata=true;set mapred.max.split.size=256000000;set mapred.min.split.size.per.node=134217728;set mapred.min.split.size.per.rack=134217728;set hive.input.format=bineHiveInputFormat;set hive.merge.mapfiles=true;set hive.merge.mapredfiles=true;set hive.merge.size.per.task=256000000;set hive.merge.smallfiles.avgsize=16000000;set io.file.buffer.size=2097152;set mapreduce.task.io.sort.mb=300;set mapreduce.map.sort.spill.percent=0.8;set mapreduce.task.io.sort.factor=10;set mapreduce.reduce.shuffle.parallelcopies=8;set press.intermediate=true;set press=true;set press.codec=press.SnappyCodec;set mapreduce.reduce.merge.inmem.threshold=0;set mapreduce.reduce.input.buffer.percent=0.8;set press.output=true;set press.codec=press.SnappyCodec; set press.type=BLOCK;# 关闭local hadoopset hive.exec.mode.local.auto=false;set mapred.job.priority=HIGH;set pletedmaps=0.15Map端调优map数控制对于map运⾏时间过长或者map数据倾斜⽐较严重时可以通过设置切⽚⼤⼩实现对map数的控制,hive设置如下set mapred.max.split.size=100000000;set mapred.min.split.size.per.node=100000000;set mapred.min.split.size.per.rack=100000000;map⼩⽂件优化使⽤Combinefileinputformat,将多个⼩⽂件打包作为⼀个整体的inputsplit,减少map任务数set hive.input.format=bineHiveInputFormat;Map 内存控制ApplicationMaster执⾏在独⽴的jvm中以child process的⽅式执⾏ Mapper/Reducer task⼦任务继承ApplicationMaster的环境,⽤户可以通过mapreduce.{map|reduce}.java.opts 指定child-jvm参数set mapreduce.map.memory.mb=2048;set mapreduce.map.java.opts=-Xmx1536mMapJoin优化set hive.auto.convert.join= true;set hive.mapjoin.smalltable.filesize=25000000;select/*+ MAPJOIN(table_a)*/,a.*,b.*from table_a a join table_b b on a.id = b.idreduce端优化reduce数控制hive1.2.1⾃⼰如何确定reduce数: reduce个数的设定极⼤影响任务执⾏效率,不指定reduce个数的情况下,Hive会猜测确定⼀个reduce个数,基于以下两个设定:hive.exec.reducers.bytes.per.reducer(每个reduce任务处理的数据量,默认为256*1000*1000)。

hive 的用法

hive 的用法摘要:1.Hive 简介2.Hive 的基本用法3.Hive 的高级用法4.Hive 的应用场景5.总结正文:1.Hive 简介Hive 是基于Hadoop 的数据仓库工具,可以用来处理和分析大规模的结构化数据。

它允许用户使用类似于SQL 的查询语言(称为HiveQL 或QL)来查询、汇总和分析存储在Hadoop 分布式文件系统(HDFS) 上的数据。

Hive 的本质是一个数据仓库,可以将数据抽象成表,并通过SQL 查询进行操作。

2.Hive 的基本用法(1)连接Hive要使用Hive,首先需要连接到Hive。

可以通过命令行或IDE(如IntelliJ IDEA 或Eclipse)连接到Hive。

(2)创建表在Hive 中,表是由一组行组成,每行包含一组列。

可以使用CREATE TABLE 语句创建表,并指定表的列和数据类型。

(3)插入数据可以使用INSERT INTO 语句将数据插入到表中。

(4)查询数据可以使用SELECT 语句查询表中的数据。

(5)更新数据可以使用UPDATE 语句更新表中的数据。

(6)删除数据可以使用DELETE 语句删除表中的数据。

3.Hive 的高级用法(1)分区Hive 支持根据某一列或一组列对表进行分区,以提高查询效率。

(2)分桶Hive 支持根据某一列或一组列对表进行分桶,以提高数据处理的并发度。

(3)索引Hive 支持创建索引以加速查询速度。

4.Hive 的应用场景Hive 主要应用于大数据处理领域,如数据仓库建设、数据分析、报表生成等。

5.总结Hive 是一个功能强大的数据仓库工具,它允许用户通过类似于SQL 的查询语言(HiveQL 或QL)来查询、汇总和分析存储在Hadoop 分布式文件系统(HDFS) 上的数据。

hive sql if 语句

hive sql if 语句

HiveSQL中的If语句是一种条件语句,用于根据给定的条件执行不同的操作。

它的语法类似于其他编程语言中的If语句,可以使用以下格式:

IF (condition) THEN statement1 ELSE statement2 END IF;

其中,condition是要评估的表达式,如果它为真,则执行statement1,否则执行statement2。

在Hive SQL中,If语句可以与其他函数和操作符结合使用,以执行更复杂的逻辑。

例如,可以使用If语句在表中插入数据时进行验证,或者在查询中筛选特定的数据。

需要注意的是,在Hive SQL中,If语句只能在SELECT、INSERT和UPDATE语句中使用,而不能在CREATE、DROP和ALTER语句中使用。

总之,Hive SQL中的If语句是一种非常有用的工具,可以帮助开发人员在数据处理过程中进行条件判断和流程控制。

- 1 -。

hive 分页sql语句

hive 分页sql语句

Hive是一个基于Hadoop的数据仓库工具,它提供了类似SQL 的查询语言HiveQL来进行数据查询和分析。

在Hive中,我们可以使用类似于SQL的语法来进行分页查询。

要在Hive中进行分页查询,我们可以使用LIMIT和OFFSET子句来实现。

下面是一个示例:

sql.

SELECT FROM table_name LIMIT 10 OFFSET 20;

在这个示例中,我们从名为table_name的表中选择数据,然后使用LIMIT子句指定每页返回的行数为10,使用OFFSET子句指定偏移量为20,这意味着我们将从第21行开始返回10行数据,这就是分页查询的效果。

另外,Hive也支持使用LIMIT子句来进行简单的分页查询,例如:

sql.

SELECT FROM table_name LIMIT 10;

这将返回table_name表中的前10行数据。

除了使用LIMIT和OFFSET之外,Hive还支持使用窗口函数来

进行分页查询,例如使用ROW_NUMBER()函数和OVER()子句来实现分

页查询,这种方法在处理复杂的分页需求时非常有用。

总之,在Hive中进行分页查询可以通过使用LIMIT和OFFSET

子句或窗口函数来实现,具体的选择取决于查询的复杂程度和需求。

希望这些信息能够帮助到你。

hive 常用正则

hive 常用正则Hive是一个基于Hadoop的数据仓库工具,它提供了一个SQL-like查询语言,使得用户可以使用类SQL的语法来查询和分析大数据。

在Hive中,正则表达式是非常常用的工具,它可以帮助用户快速地处理和分析数据。

本文将介绍Hive中常用的正则表达式。

一、正则表达式的基本语法正则表达式是一种用来描述字符串模式的语言,它可以通过一些特定的符号来表示字符的匹配规则。

在Hive中,正则表达式包含了一些特殊字符和元字符,它们可以用来表示一些常见的字符或字符集合。

下面是一些常见的正则表达式语法:1. 字面值:表示一个具体的字符。

例如,正则表达式“hello”表示匹配一个字符串“hello”。

2. 字符集合:表示一组字符中的任意一个字符。

例如,正则表达式“[abc]”表示匹配一个字符“a”、“b”或“c”。

3. 范围:表示一组连续的字符中的任意一个字符。

例如,正则表达式“[a-z]”表示匹配一个小写字母。

4. 量词:表示一个字符或字符集合的出现次数。

例如,正则表达式“a{3}”表示匹配三个连续的字符“a”。

5. 通配符:表示任意一个字符。

例如,正则表达式“.”表示匹配任意一个字符。

二、常用的正则表达式函数在Hive中,常用的正则表达式函数包括REGEXP、RLIKE、REGEXP_REPLACE、REGEXP_EXTRACT等。

下面是这些函数的具体用法: 1. REGEXP函数REGEXP函数用来判断一个字符串是否匹配一个正则表达式。

它的语法如下:SELECT column1 FROM table1 WHERE column2 REGEXP 'pattern';其中,column2是要匹配的字符串,pattern是正则表达式。

例如,我们可以使用REGEXP函数来匹配所有以“a”开头的字符串:SELECT * FROM table1 WHERE column2 REGEXP '^a';2. RLIKE函数RLIKE函数和REGEXP函数类似,用来判断一个字符串是否匹配一个正则表达式。

hive的truncate语句

hive的truncate语句Hive是一种基于Hadoop的分布式数据仓库系统,主要用于在大规模数据集上进行数据仓库和分析查询操作。

在Hive中,truncate是一个用于删除表数据的重要操作。

本文将对Hive的truncate语句进行详细介绍。

一、什么是truncate语句truncate是一种删除操作,用于删除表中的所有数据。

与delete语句不同,truncate语句删除数据的速度更快,因为它是通过删除表的所有数据来实现删除操作的。

二、Hive中的truncate语句在Hive中,truncate语句用于删除表中的所有数据,并保留表的结构。

Hive支持两种truncate语句:TRUNCATE TABLE和TRUNCATE TABLE PARTITION。

1. TRUNCATE TABLE语句TRUNCATE TABLE是一种删除表中所有数据的命令,它的语法如下:```sqlTRUNCATE TABLE table_name;```其中table_name是要被清空数据的Hive表名。

执行TRUNCATE TABLE语句后,Hive将清空表中的所有数据,并保留表的结构。

与delete语句不同,truncate语句删除数据的速度更快,因为它是通过删除表的所有数据来实现删除操作的。

2. TRUNCATE TABLE PARTITION语句在Hive中,TRUNCATE TABLE PARTITION语句用于删除指定分区中的所有数据。

语法如下:```sqlTRUNCATE TABLE table_name PARTITION(partition_column=value, ...);```其中,table_name是要被清空数据的表名;partition_column 是分区列名,value是与分区列关联的值。

执行TRUNCATE TABLE PARTITION语句后,Hive将清空指定分区中的所有数据,并保留表的结构。

hive sql 语法

hive sql 语法一、Hive SQL简介Hive是一个基于Hadoop的数据仓库工具,它允许用户使用SQL语言来查询存储在Hadoop集群中的数据。

Hive SQL语法与传统的SQL语法非常类似,但也有一些特殊的语法和函数。

本文将详细介绍Hive SQL语法。

二、Hive SQL基础语法1. 创建表在Hive中创建表需要使用CREATE TABLE语句,其基本格式如下:CREATE TABLE table_name (column1_name data_type,column2_name data_type,...) [ROW FORMAT row_format][STORED AS file_format]其中,table_name表示要创建的表名;column1_name、column2_name等表示列名;data_type表示数据类型;row_format表示行格式;file_format表示文件格式。

例如:CREATE TABLE employee (id INT,name STRING,age INT) ROW FORMAT DELIMITED FIELDS TERMINATED BY ',' STORED AS TEXTFILE;上述代码创建了一个名为employee的表,包含三个列:id、name 和age。

行格式为分隔符为逗号(',')的文本格式,文件格式为TEXTFILE。

2. 插入数据在Hive中插入数据需要使用INSERT INTO语句,其基本格式如下:INSERT INTO table_name VALUES (value1, value2, ...);其中,table_name表示要插入数据的表名;value1、value2等表示要插入的值。

例如:INSERT INTO employee VALUES (1, 'Tom', 25);上述代码向employee表中插入了一条数据,id为1,name为'Tom',age为25。

2.Hive常见操作命令整理

2.Hive常见操作命令整理该笔记主要整理了《Hive编程指南》中⼀些常见的操作命令,⼤致如下(持续补充中):1. 查看/设置/修改变量2. 执⾏命令3. 搜索相关内容4. 查看库表信息5. 创建表6. 分区7. 修改表(重命名、修改列、删除列、增加列)8. 找到表位置并导出⾄本地9. 去空格10. case...when...then句式11. 操作符12. group by...having句式13. JOIN14. order by和sort by15. 抽样查询16. 视图17. 分桶表18. 函数19. with...as20. rank() over (partition by ... order by ... asc/desc)和row_number()21. 时间相关的函数(from_unixtime,unix_timestamp,date_add,months_between)22.substr()23.regexp_replace()和regexp_extract()24.动态分区25.nvl和grouping set26. concat_ws()、group_concat()和collect_list()teral view explode()1. 查看/设置/修改变量$ hive############# 查询环境变量############hive>set env:HOME;# 打印命名空间hivevar, hiveconf, system和env所有变量hive>set;# 还打印Hadoop所定义的所有属性hive>set -v;############# 设置hive变量############hive>set hivevar:foo=bar# 查看刚设置的变量hive>set foo;hive>set hivevar:foo;############# 修改属性变量############# hiveconf: Hive相关的配置属性# 不进⼊Hive进⾏配置属性修改hive --hiveocnf hive.cli.print.current.db=true# 进⼊hive进⾏配置修改hive>set hiveconf:hive.cli.print.current_db=true;2. 执⾏命令# 执⾏命令⽅式1:使⽤下⾯的 “⼀次使⽤”命令(-e是指⼀次执⾏,-S是指静默模式,在输出结果中不显⽰Ok和Time taken字段)hive -e -S "select * from mytable limit 3";# 执⾏命令⽅式2:调⽤Hive执⾏hql⽂件hive -f /path/query.hql# 执⾏命令⽅式3:在Hive shell内执⾏hql⽂件$ hivehive>source /path/query.hql3. 搜索相关内容# 模糊搜索set命令的输出结果中某个于warehouse相关的属性$ hive -S -e "set" | grep warehousehive.metastore.warehouse.dir=/user/hive/warehousehive.warehouse.subdir.inherit.perms=false4. 查看库表信息# 查看数据库,使⽤like是以ahf开头,以其他字符结尾(即.*)的数据库名show databases;show databases like 'ahf.*';# 查看表的详细表结构信息(formatted⽐extended输出内容更详细且可读性更⾼)describe mydb.table;describe formatted mydb.table;describe extended mydb.table;5. 创建表# 拷贝表结构,⽽不拷贝数据(⽤like)create table if not exists mydb.mytable like mydb.mytable2;# 拷贝表结构,且拷贝数据(⽤as)create table if not exists mydb.mytable asselect*from mydb.mytable2;# 直接创建表结构create table if not exists mydb.mytable(id string comment 'id',name string comment '姓名')partitioned by (class string)stored as orc;6. 分区# 建⽴分区create table(字段1 字段类型, 字段2 字段类型)paritioned by (字段名3 字段类型, 字段名4 字段类型);# 查看分区show partitions table_name;# 查看某个特定分区键的分区show partitions table_name partition(⼀个分区字段='该分区字段下的某个值');# 增加分区alter table log_message add partition(year=2012, month=1, day=2);# 删除分区alter table log_messages drop if exists partition(year=2012, month=1, day=2);7. 修改表(重命名、修改列、删除列、增加列)# 表重命名alter table log_messages rename to logmsgs;# 修改列信息, 在下⾯的例⼦中,# 我们将字段hms重命名为hour_minutes_seconds,修改其类型和注释,再转移到severity字段之后# 如果⽤户想将这个字段移动到第⼀个为位置,只需要使⽤first关键字替换after severityalter table log_messages change column hms hour_minutes_seconds intcomment 'the hours, minutes, and seconds parts of the timestamp'after severity;# 删除或替换列, 下⾯的例⼦移除了之前所有字段并重新指定了新的字段alter table log_messages replace columns(新字段1 int comment '...',新字段2 string comment '...');# 增加列alter table log_messages add columns(app_name string comment 'application name',session_id long comment 'the current session id');8. 找到表位置并导出⾄本地# 找到表位置describe formatted mydb.mytable;# 例如:Location:hdfs://alg-hdfs/warehouse/user/alvinai.mydb/mytable# 导出⽂件hadoop fs -cp [表来源][⽬标导出路径]9. 去空格# 去空格 ltrim去左空格,rtrim去右空格ltrim(string s)10. case...when...then句式select name,salary,case when salary <5000.0then'low'when salary >=5000.0and salary <70000.0then'middle'else'high'end as bracketfrom employees;11. 操作符# 常见的谓语操作符A<>B跟A!=B是⼀样的A<==>B是指任⼀为NULL,则结果为NULLA is null还有A is not nulla not betweenb and c, between是闭区间# LiKE和RELIKE谓语操作符A like B, A relike B前者是SQL,后者是JAVA的正则表达式A like B, ‘x%’表⽰A必须以字母x开头,‘%x’表⽰A必须以字母x结尾,‘%x%’表⽰A包含字母x,可以位于开头结尾或者字符串中间A relike B, .号表⽰任意字符,*表⽰重复左边的字符串零次到⽆数次,表达式(x|y)表⽰x或者y匹配例⼦:查找住址以Ave结尾的⼈select name, address from where employees where address like'Ave.';例⼦:查找地址以0开头的⼈select name, address from where employees where address like 'O%';# split操作符select split(row_key, '_')[0] as account_id12. group by...having句式# 如果想要对group by语句产⽣的分组进⾏条件过滤,可以⽤having例如:select year(ymd),avg(price_close) from stockswhere exchange ='NASDAQ'and symbol ='AAPL'group by year(ymd)having avg(price_close) >0.0;13. JOINHive连接有:inner join: 交集,就是join。

hive备份表的sql语句

在Hive中,备份表通常意味着创建一个表的复制品。

这可以通过几种不同的SQL语句来完成,具体取决于你的需求。

以下是一些常用的方法:1. 创建新表并复制数据你可以创建一个新表并将原表的数据复制到新表中。

CREATE TABLE backup_table AS SELECT * FROM original_table;2. 使用CREATE TABLE AS SELECT (CTAS)这种方法类似于上面的方法,但它允许你更灵活地定义备份表的结构。

CREATE TABLE backup_table ASSELECT column1, column2, ...FROM original_tableWHERE <conditions>;3. 使用INSERT INTO如果你已经创建了一个空表作为备份,你可以使用INSERT INTO语句将数据从原表复制到备份表。

CREATE TABLE backup_table LIKE original_table;INSERT INTO TABLE backup_table SELECT * FROM original_table;4. 使用SHOW CREATE TABLE和CREATE TABLE这种方法涉及两个步骤:首先,使用SHOW CREATE TABLE获取原表的DDL语句,然后稍微修改DDL语句来创建备份表。

SHOW CREATE TABLE original_table;获取DDL输出后,你可以修改表名并执行DDL语句来创建备份表。

5. 使用Hive的复制表命令Hive也提供了一个复制表的命令,可以直接复制表结构和数据。

hadoop fs -cp -r /user/hive/warehouse/original_db.db/original_table /user/hive /warehouse/backup_db.db/backup_table请根据你的具体需求和环境选择合适的方法。

hive left outer join用法

hive left outer join用法Hive Left Outer Join 用法左外连接是Hive中常用的连接操作之一,它可用于根据两个或多个数据表之间的关联关系来合并数据。

下面是一些关于Hive左外连接用法的详细讲解。

1. 什么是左外连接?左外连接(Left Outer Join)是一种连接操作,它返回左表中所有的行以及与右表中满足连接条件的匹配行。

如果右表中没有匹配的行,则返回NULL值。

2. 使用语法Hive中左外连接的语法如下:SELECT <columns>FROM <left_table>LEFT OUTER JOIN <right_table>ON <join_condition>;其中,<columns>表示所选取的列,<left_table>表示左表,<right_table>表示右表,<join_condition>表示连接条件。

3. 示例下面通过一个示例来演示Hive左外连接的具体用法。

假设我们有两个表:orders和customers,orders表包含订单号和客户ID,customers表包含客户ID和客户名称。

首先,我们创建并插入数据到orders表和customers表中:CREATE TABLE orders (order_id INT,customer_id INT);INSERT INTO orders VALUES(1, 101),(2, 102),(3, 103);CREATE TABLE customers (customer_id INT,customer_name STRING);INSERT INTO customers VALUES(101, 'Alice'),(103, 'Bob');接下来,我们使用左外连接来获取订单表和客户表的联合结果:SELECT _id, _id, _nameFROM orders oLEFT OUTER JOIN customers cON _id = _id;执行以上语句后,将返回以下结果:order_id | customer_id | customer_name--1 | 101 | Alice2 | 102 | NULL3 | 103 | Bob可以看到,在左外连接的结果中,所有左表orders的行都被包含在内,而右表customers中没有与订单2关联的客户信息,所以customer_name列的值为NULL。

hive中groupby的用法

hive中groupby的用法在Hive中,`GROUP BY`用于将数据按照一个或多个列进行分组。

`GROUP BY`用于与聚合函数(如`COUNT`,`SUM`,`AVG`等)一起使用,常用于对数据进行统计和汇总。

下面是`GROUP BY`的基本语法:```SELECT column1, column2, aggregate_function(column3) FROM tableGROUP BY column1, column2;```- `column1, column2`:要按照哪些列进行分组- `aggregate_function(column3)`:对哪些列进行聚合函数的计算以下是一个详细的示例,演示如何在Hive中使用`GROUP BY`:假设我们有一个名为`orders`的表,包含以下列:`order_id, customer_id, order_date, order_total`。

首先,我们可以使用以下语句来计算每个客户的订单总数:```sqlSELECT customer_id, COUNT(order_id) as order_count FROM ordersGROUP BY customer_id;```输出将显示每个客户的ID和他们的订单数量。

我们还可以使用`GROUP BY`来计算每个客户的订单总额:```sqlSELECT customer_id, SUM(order_total) as total_amount FROM ordersGROUP BY customer_id;```这将给出每个客户的ID以及他们的订单总额。

`GROUP BY`还可以用于多个列的组合。

例如,我们可以使用以下语句计算每个客户每年的订单总额:```sqlSELECT customer_id, YEAR(order_date) as order_year,SUM(order_total) as total_amountFROM ordersGROUP BY customer_id, YEAR(order_date);```这将按客户ID和订单年份对数据进行分组,并计算每个组的订单总额。

hive sql语法 insert语法

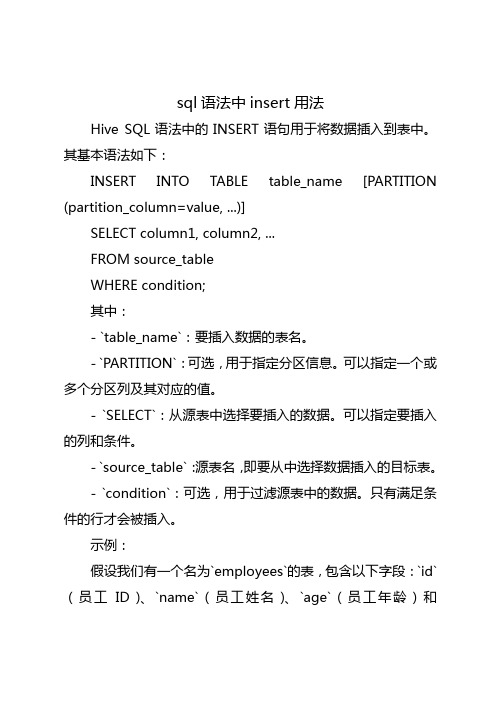

sql语法中insert用法

Hive SQL语法中的INSERT语句用于将数据插入到表中。

其基本语法如下:

INSERT INTO TABLE table_name [PARTITION (partition_column=value, ...)]

SELECT column1, column2, ...

FROM source_table

WHERE condition;

其中:

- `table_name`:要插入数据的表名。

- `PARTITION`:可选,用于指定分区信息。

可以指定一个或多个分区列及其对应的值。

- `SELECT`:从源表中选择要插入的数据。

可以指定要插入的列和条件。

- `source_table`:源表名,即要从中选择数据插入的目标表。

- `condition`:可选,用于过滤源表中的数据。

只有满足条件的行才会被插入。

示例:

假设我们有一个名为`employees`的表,包含以下字段:`id`(员工ID)、`name`(员工姓名)、`age`(员工年龄)和

`department`(所属部门)。

现在我们想要将年龄大于30的员工信息插入到另一个名为`old_employees`的表中。

可以使用以下INSERT语句实现:

INSERT INTO TABLE old_employees

SELECT id, name, age, department

FROM employees

WHERE age > 30;。

hive values语法

hive values语法Hive Values语法:从数据仓库中提取有价值的信息在大数据时代,数据仓库的建设和管理变得越来越重要。

而Hive作为一种基于Hadoop的数据仓库基础设施,为我们提供了一种方便、高效的数据查询和分析方式。

在Hive中,Values语法是一种非常有用的查询方法,可以帮助我们从数据仓库中提取有价值的信息。

Values语法可以用于将固定的值或表达式作为查询结果返回。

它的基本语法如下:```sqlSELECT value1 [, value2, ...]```其中,value1、value2等表示要返回的值或表达式。

下面我们将介绍一些常见的使用场景,以便更好地理解和运用Hive Values语法。

1. 列出指定的值在某些情况下,我们可能需要列出一组指定的值。

例如,我们想要列出一个部门中的所有员工姓名,可以使用以下语句:```sqlSELECT 'John', 'Mary', 'Tom' FROM employees;```这样就会返回一个结果集,包含了'John'、'Mary'和'Tom'这几个员工的姓名。

2. 返回常量值有时候,我们需要返回一些固定的常量值作为查询结果。

例如,我们想要查询某个员工的工作时长,但是不需要具体的数值,只需要返回一个固定的字符串"Full-time"。

可以使用以下语句:```sqlSELECT 'Full-time' FROM employees WHERE name = 'John';```这样就会返回一个结果集,其中只包含"Full-time"这个常量值。

3. 使用表达式Values语法还可以用于返回一些计算后的表达式。

例如,我们想要计算某个员工的工资水平,可以使用以下语句:```sqlSELECT salary * 12 AS annual_salary FROM employees WHERE name = 'John';```这样就会返回一个结果集,其中包含了该员工的年薪。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

显示命令 : show tables;

show databases;

show partitions;

show functions;

describbe extended table_name dot col_name;

location '<hdfs_location>';

复制一张表:create table new_table_name like old_table_name;

删除一张表:drop table table_name;

重新命名表:alter table old_table_name rename to new_table_name;

JOIN hive> FROM pokes t1 JOIN invites t2 ON (t1.bar = t2.bar) INSERT OVERWRITE TABLE events SELECT t1.bar, t1.foo, t2.foo;

hive的参数配置:

(1)开启Hive的本地模式:

hive> set hive.exec.mode.local.auto=true;(默认为false)

set mapred.reduce.tasks;

(2)hive.exec.parallel

•说明:是否并行提交任务

•默认值:false

(3)hive.merge.mapredfiles

上传数据:load data inpath '/usr/hadoop/zbb/*' overwrite into table thive;

将查询结果保存到本地: insert overwrite local directory 'a.txt' select * from employees;

启动HWI的命令: nohup hive --service hwi &

启动Hive :nohup hive –service hiveserver &

web的启动 :hive –service hwi

创建一张表:create [external] table table_name

•默认值: 在作业结束的时候是否合并小文件

•说明: false

(4)在hive shell下使用,如下:

#####) hive>add jar /lib/RowNumber.jar; (可以省略了!!!)

hive>set hive.exec.mode.local.auto=true;

修改表美容:alter table table_name change [cloumn]

col_old_name col_new_name column_type

[comment col_comment][first|after column_name]

增/改表列: alter table table_name add | replace columns (col_name data_type[comment col_comment],...)

hive>create temporary function row_number as 'RowNumber';

[(col_name data_type[comment col_commment],...)]

[comment table_comment]

row format delimited fields terminated by '\t' stored as textfile

将一个表的统计结果插入另一个表中 hive> FROM invites a INSERT OVERWRITE TABLE events SELECT a.bar, count(1) WHERE a.foo > 0 GROUP BY a.bar;

hive> INSERT OVERWRITE TABLE events SELECT a.bar, count(1) FROM invites a WHERE a.foo > 0 GROUP BY a.bar;