OpenMP例程使用手册

openmp并行编程实例

openmp并行编程实例OpenMP并行编程实例引言:随着计算机硬件的发展,单个处理器的性能已经达到了瓶颈。

为了充分利用多核处理器的潜力,开发并行程序已经成为一种必要的技能。

OpenMP是一种简单易用的并行编程模型,它可以帮助开发人员轻松地将串行程序转化为并行程序。

本文将以几个实例来介绍OpenMP并行编程的基本概念和用法。

1. 实例1: 并行化for循环在很多科学和工程应用中,for循环是最常见的计算密集型任务。

通过使用OpenMP,我们可以很容易地将这些for循环并行化。

例如,下面的代码片段展示了如何使用OpenMP并行化一个简单的for循环:```cpp#include <omp.h>#include <stdio.h>int main() {int n = 100;int sum = 0;#pragma omp parallel for reduction(+:sum)for (int i = 0; i < n; i++) {}printf("Sum: %d\n", sum);return 0;}```在上面的代码中,我们使用了`#pragma omp parallel for`指令来告诉编译器将for循环并行化。

通过`reduction(+:sum)`,我们可以确保所有线程都可以正确地更新sum变量的值。

运行该程序,我们可以得到正确的和值。

2. 实例2: 并行化嵌套循环除了单个for循环,OpenMP还支持嵌套循环的并行化。

下面的代码展示了如何使用OpenMP并行化一个简单的嵌套循环:```cpp#include <omp.h>#include <stdio.h>int main() {int n = 100;int m = 100;#pragma omp parallel for collapse(2) reduction(+:sum)for (int i = 0; i < n; i++) {for (int j = 0; j < m; j++) {sum += i + j;}}printf("Sum: %d\n", sum);return 0;}```在上面的代码中,我们使用了`#pragma omp parallel for collapse(2)`指令来告诉编译器将嵌套循环并行化。

OpenMP程序演示

17

6.2.2 并行区域编程

循环并行化实际上是并行区域编程的一个特例, 本节介绍非循环的并行区域编程 并行区域简单说就是通过循环并行化编译指导语 句使得一段代码能够在多个线程内部同时执行。 并行区域编译指导语句的格式 #pragma omp parallel [clause[clause]…]

程序段2

程序段2运行结果

循环嵌套比较(程序段3、4)

int i;int j #pragma omp parallel for private(j) for(i=0; i<2; i++) for(j=6; j<10; j++) printf(“ i=%d j=%d\n”, i, j); 执行结果: i=0 j=6 i=1 j=6 i=0 j=7 i=1 j=7 i=0 j=8 i=1 j=8 i=1 j=9 i=0 j=9 int i;int j; for(i=0; i<2; i++) #pragma omp parallel for for(j=6; j<10; j++) printf("i=%d j=%d \n", i, j); 执行结果: i=0 j=6 i=0 j=8 i=0 j=9 i=0 j=7 i=1 j=6 i=1 j=8 i=1 j=7 i=1 j=9

2

OMP_NUM_THREADS=4

OMP_NUM_THREADS=2

设置环境OMP_NUM_THREADS的值

5

数据相关的概念

实例:

x[0] = 0; y[0] = 1; #pragma omp parallel for private(k) for (k = 1; k < 100; k++){ x[k] = y[k-1] + 1; //S1 y[k] = x[k-1] + 2; //S2 }

OpenMP编程指南

for,用于 for 循环之前,将循环分配到多个线程中并行执行,必须保证每次循环之 间无相关性。 parallel for, parallel 和 for 语句的结合,也是用在一个 for 循环之前,表示 for 循 环的代码将被多个线程并行执行。 sections,用在可能会被并行执行的代码段之前 parallel sections,parallel 和 sections 两个语句的结合 critical,用在一段代码临界区之前 single,用在一段只被单个线程执行的代码段之前,表示后面的代码段将被单线程执 行。 barrier,用于并行区内代码的线程同步,所有线程执行到 barrier 时要停止,直到所 有线程都执行到 barrier 时才继续往下执行。 atomic,用于指定一块内存区域被制动更新 master,用于指定一段代码块由主线程执行 ordered, 用于指定并行区域的循环按顺序执行 threadprivate, 用于指定一个变量是线程私有的。 OpenMP 除上述指令外,还有一些库函数,下面列出几个常用的库函数: omp_get_num_procs, 返回运行本线程的多处理机的处理器个数。 omp_get_num_threads, 返回当前并行区域中的活动线程个数。 omp_get_thread_num, 返回线程号 omp_set_num_threads, 设置并行执行代码时的线程个数 omp_init_lock, 初始化一个简单锁 omp_set_lock, 上锁操作 omp_unset_lock, 解锁操作,要和 omp_set_lock 函数配对使用。 omp_destroy_lock, omp_init_lock 函数的配对操作函数,关闭一个锁 OpenMP 的子句有以下一些 private, 指定每个线程都有它自己的变量私有副本。 firstprivate,指定每个线程都有它自己的变量私有副本,并且变量要被继承主线程中 的初值。 lastprivate, 主要是用来指定将线程中的私有变量的值在并行处理结束后复制回主线 程中的对应变量。 reduce,用来指定一个或多个变量是私有的,并且在并行处理结束后这些变量要执 行指定的运算。 nowait,忽略指定中暗含的等待 num_threads,指定线程的个数 schedule,指定如何调度 for 循环迭代 shared,指定一个或多个变量为多个线程间的共享变量 ordered,用来指定 for 循环的执行要按顺序执行 copyprivate,用于 single 指令中的指定变量为多个线程的共享变量 copyin,用来指定一个 threadprivate 的变量的值要用主线程的值进行初始化。 default,用来指定并行处理区域内的变量的使用方式,缺省是 shared

openmp用法

openmp用法OpenMP是一种支持共享内存多线程编程的标准API。

它提供了一种简单而有效的方法,用于在计算机系统中利用多核和多处理器资源。

本文将逐步介绍OpenMP的用法和基本概念,从简单的并行循环到复杂的并行任务。

让我们一步一步来学习OpenMP吧。

第一步:环境设置要开始使用OpenMP,我们首先需要一个支持OpenMP的编译器。

常见的编译器如GCC、Clang和Intel编译器都支持OpenMP。

我们需要确保在编译时启用OpenMP支持。

例如,在GCC中,可以使用以下命令来编译包含OpenMP指令的程序:gcc -fopenmp program.c -o program第二步:并行循环最简单的OpenMP并行化形式是并行循环。

在循环的前面加上`#pragma omp parallel for`指令,就可以让循环被多个线程并行执行。

例如,下面的代码演示了如何使用OpenMP并行化一个简单的for循环:c#include <stdio.h>#include <omp.h>int main() {int i;#pragma omp parallel forfor (i = 0; i < 10; i++) {printf("Thread d: d\n", omp_get_thread_num(), i);}return 0;}在上面的例子中,`#pragma omp parallel for`指令会告诉编译器将for 循环并行化。

`omp_get_thread_num()`函数可以获取当前线程的编号。

第三步:数据共享与私有变量在并行编程中,多个线程可能会同时访问和修改共享的数据。

为了避免数据竞争和不一致的结果,我们需要显式地指定哪些变量是共享的,哪些变量是私有的。

我们可以使用`shared`和`private`子句来指定。

`shared`子句指定某个变量为共享变量,对所有线程可见。

OpenMIPS教学版讲解

一 OpenMIPS项目简介

OpenMIPS_VHDL_study_v1.0 OpenMIPS_Verilog_study_v1.0 OpenMIPS_VHDL_practice_v1.0 OpenMIPS_Verilog_practice_v1.0

教学版(VHDL) 1.0 教学版(Verilog)1.0 实践版(VDHL) 1.0 实践版(Verilog)1.0

四 OpenMIPS教学版的文件组织

ห้องสมุดไป่ตู้

tool

包括一个小工具Bin2Mem.exe,该工具用来将GCC编译 得到的二进制文件进行格式变化得到inst_rom.data文件, 使用后者初始化OpenMIPS_min_sopc中的指令存储器 imem,以便进行测试

四 OpenMIPS教学版的文件组织

WB_CONMAX

s0 s1 s2 s3

SDRAM Controller

UART Controller

GPIO Controller

FLASH Controller

一 OpenMIPS项目简介

OpenMIPS是采用具有哈佛结构的32位标量处理器,兼容 MIPS32体系结构,这样可以使用现有的MIPS编译环境。

min_sopc 包括如下文件:

指令存储器imem.vhd 数据存储器dmem.vhd 以及一个用来测试OpenMIPS的最小SOPC的 顶层文件OpenMIPS_min_sopc.vhd

四 OpenMIPS教学版的文件组织

testbench

包括testbench测试文件OpenMIPS_min_sopc_tb.vhd

四 OpenMIPS教学版的文件组织

OpenMP并行编程简易教程

parallel for,parallel和for语句的结合,也是用在一个for循环之前,表示for循环的代码将被多个线程并行执行。

sections,用在可能会被并行执行的代码段之前

parallel sections,parallel和sections两个语句的rdered,用于指定并行区域的循环按顺序执行

threadprivate,用于指定一个变量是线程私有的。

OpenMP除上述指令外,还有一些库函数,下面列出几个常用的库函数:

omp_get_num_procs,返回运行本线程的多处理机的处理器个数。

omp_get_num_threads,返回当前并行区域中的活动线程个数。

例子2 RankNum.c

01 #include

02 #include

03 int main( int argc, char **argv)

04 {

05 int rank, size;

06 #pragma omp parallel private(rank)

07 {

08 rank= omp_get_thread_num();

例子1 helloworld.c

01 #include

02 int main( argc, argv)

03 int argc;

04 char **argv;

05 {

06 #pragma omp parallel

07 printf( "Hello world!\n" );

08 return 0;

09 }

void test()

{

openMP在CFD上的应用说明

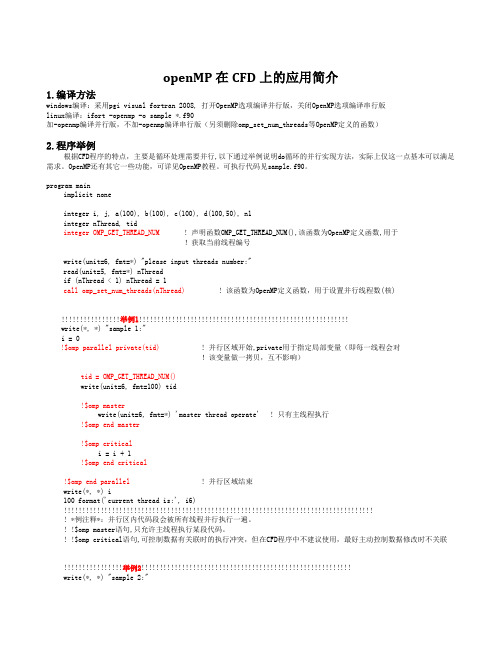

openMP在CFD上的应用简介1.编译方法windows编译:采用pgi visual fortran 2008, 打开OpenMP选项编译并行版,关闭OpenMP选项编译串行版linux编译:ifort -openmp -o sample *.f90加-openmp编译并行版,不加-openmp编译串行版(另须删除omp_set_num_threads等OpenMP定义的函数)2.程序举例根据CFD程序的特点,主要是循环处理需要并行,以下通过举例说明do循环的并行实现方法,实际上仅这一点基本可以满足需求。

OpenMP还有其它一些功能,可详见OpenMP教程。

可执行代码见sample.f90。

program mainimplicit noneinteger i, j, a(100), b(100), c(100), d(100,50), n1integer nThread, tidinteger OMP_GET_THREAD_NUM ! 声明函数OMP_GET_THREAD_NUM(),该函数为OpenMP定义函数,用于!获取当前线程编号write(unit=6, fmt=*) "please input threads number:"read(unit=5, fmt=*) nThreadif (nThread < 1) nThread = 1call omp_set_num_threads(nThread)! 该函数为OpenMP定义函数,用于设置并行线程数(核)!!!!!!!!!!!!!!!!举例1!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!write(*, *) "sample 1:"i = 0!$omp parallel private(tid)! 并行区域开始,private用于指定局部变量(即每一线程会对!该变量做一拷贝,互不影响)tid = OMP_GET_THREAD_NUM()write(unit=6, fmt=100) tid!$omp masterwrite(unit=6, fmt=*) 'master thread operate' ! 只有主线程执行!$omp end master!$omp criticali = i + 1!$omp end critical!$omp end parallel ! 并行区域结束write(*, *) i100 format('current thread is:', i6)!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!! *例注释*:并行区内代码段会被所有线程并行执行一遍。

OpenMP的用法

在双重循环中怎样写OpenMP?那要分析你的外循环跟内循环有没有彼此依赖的关系unsigned int nCore = GetComputeCore();unsigned int nStep = IMAGETILEYSIZE / nCore;#pragma omp parallel for private(Level0_x, Level0_y, ChangeLevel0_x, ChangeLevel0_y, InterX1, InterX2, InterY1, InterY2)for (int k = 0; k < nCore; k++){int begin = k * nStep;int end = (k + 1) * nStep;for (int YOff = begin; YOff < end; YOff++){for (int XOff = 0; XOff < IMAGETILEXSIZE; XOff++){Level0_x = pPixelXBuf[YOff][XOff];Level0_y = pPixelYBuf[YOff][XOff];ChangeLevel0_x = Level0_x - XMin;ChangeLevel0_y = Level0_y - YMin;//寻找坐标在Level1Buf中对应的4个像素值InterX1 = (int)(ChangeLevel0_x);InterX2 = (int)(ChangeLevel0_x + 1);InterY1 = (int)(ChangeLevel0_y);InterY2 = (int)(ChangeLevel0_y + 1);//双线性插值对Level0_Buf赋值ZoomInterpolation(Level0Buf, Level1Buf, ChangeLevel0_x, ChangeLevel0_y, SamplesPerPixel, nXSize,nYSize, InterX1, InterX2, InterY1, InterY2, XOff, YOff);}}}我也想应该这样,可是如果nCore=1的时候,外循环只循环一次,线程是怎么分配的呢。

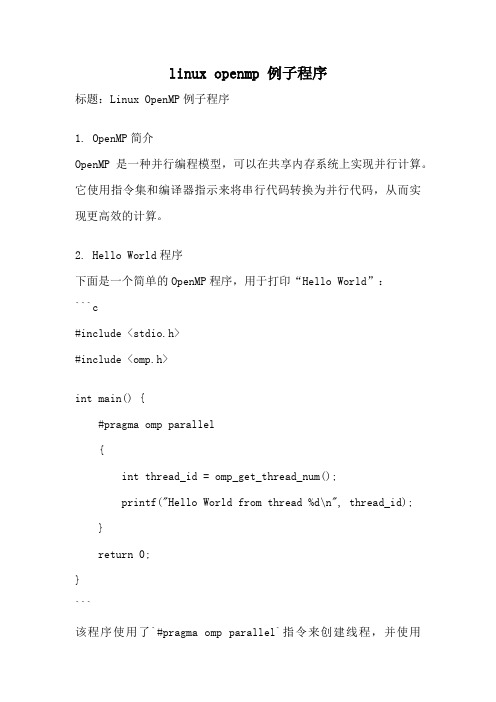

linux openmp 例子程序

linux openmp 例子程序标题:Linux OpenMP例子程序1. OpenMP简介OpenMP是一种并行编程模型,可以在共享内存系统上实现并行计算。

它使用指令集和编译器指示来将串行代码转换为并行代码,从而实现更高效的计算。

2. Hello World程序下面是一个简单的OpenMP程序,用于打印“Hello World”:```c#include <stdio.h>#include <omp.h>int main() {#pragma omp parallel{int thread_id = omp_get_thread_num();printf("Hello World from thread %d\n", thread_id);}return 0;}```该程序使用了`#pragma omp parallel`指令来创建线程,并使用`omp_get_thread_num()`函数获取线程ID。

3. 并行for循环OpenMP可以很方便地并行化for循环。

下面是一个计算数组元素和的例子:```c#include <stdio.h>#include <omp.h>int main() {int sum = 0;#pragma omp parallel for reduction(+:sum)for (int i = 0; i < 100; i++) {sum += i;}printf("Sum: %d\n", sum);return 0;}```在上述代码中,`#pragma omp parallel for`指令将for循环并行化,`reduction(+:sum)`指示OpenMP将每个线程的局部和累加到全局和`sum`中。

4. 并行化矩阵乘法OpenMP也可以用于并行化矩阵乘法。

下面是一个简单的矩阵乘法示例:```c#include <stdio.h>#include <omp.h>#define N 100void matrix_multiply(int A[N][N], int B[N][N], int C[N][N]) {#pragma omp parallel forfor (int i = 0; i < N; i++) {for (int j = 0; j < N; j++) {C[i][j] = 0;for (int k = 0; k < N; k++) {C[i][j] += A[i][k] * B[k][j];}}}}int main() {int A[N][N];int B[N][N];int C[N][N];// 初始化A和B矩阵matrix_multiply(A, B, C);// 打印结果return 0;}```在上述代码中,`#pragma omp parallel for`指令将外层循环并行化,从而加快矩阵乘法的计算速度。

openmp使用

OpenMP 的基本使用要在Visual C++ 2005 中使用OpenMP其实不难,只要将Project 的Propert ies中C/C++里Language的OpenMP Support开启(参数为/openmp),就可以让VC++2005 在编译时支持OpenMP 的语法了;而在编写使用OpenMP 的程序时,则需要先include OpenMP的头文件:omp.h。

而要将for 回圈平行化处理,该怎麼做呢?非常简单,只要在前面加上一行#pragma omp parallel for就够了!也可以实际用一段简单的程序,来弄清楚它的运作方式。

#include <STDIO.H>#include <STDLIB.H>void Test(int n) {for(int i = 0; i < 10000; ++i){//do nothing, just waste time}printf("%d, ", n);}int main(int argc, char* argv[]){for(int i = 0; i < 10; ++i)Test(i);system("pause");}上面的程序,在main() 是一个很简单的回圈,跑十次,每次都会调用Test()这个函数,并把是回圈的执行次数(i)传进Test() 并打印出来。

想当然,它的结果会是:0, 1, 2, 3, 4, 5, 6, 7, 8, 9,而如果想利用OpenMP把main() 里面的回圈平行化处理呢?只需要修改成下面的样子:#include <omp.h>#include <stdio.h>#include <stdlib.h>void Test (int n) {for(int i = 0; i < 10000; ++i) {//do nothing, just waste time}printf("%d, ", n);}int main(int argc, char* argv[]) {#pragma omp parallel forfor(int i = 0; i < 10; ++i)Test( i );system("pause");}够简单吧?重头到尾,只加了两行!而执行后,可以发现结果也变了!0, 5, 1, 6, 2, 7, 3, 8, 4, 9,可以从结果很明显的发现,他没有照着0到9的顺序跑了!而上面的顺序怎麼来的?其实很简单,OpenMP只是把回圈0 - 9 共十个步骤,拆成0 - 4, 5 - 9 两部份,丢给不同的执行绪去跑,所以数字才会出现这样交错性的输出~而要怎麼确定真的有跑多执行绪呢?如果本来有多处理器、多核心处理器或有Hyper Thread 的话,一个单执行绪程序,最多只会把一颗核心的使用量吃完;像比如说在Pentium 4 HT 上跑,单一执行绪的程序,在工作管理员中看到的CPU 使用率最多就是50%。

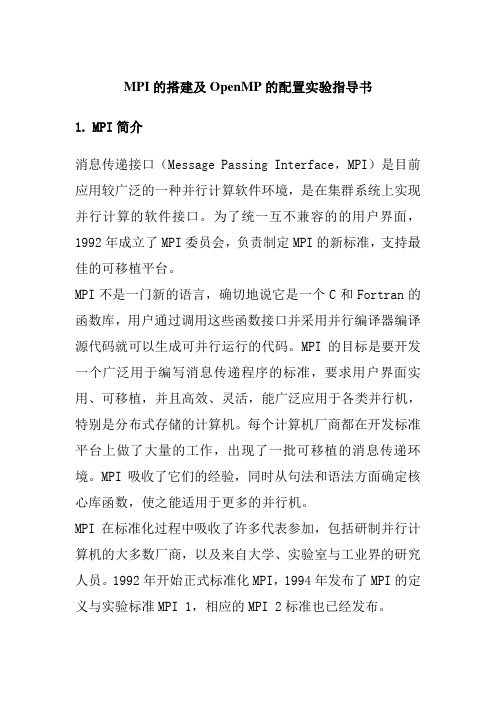

MPI的搭建及OpenMP的配置实验指导书

MPI的搭建及OpenMP的配置实验指导书1.MPI简介消息传递接口(Message Passing Interface,MPI)是目前应用较广泛的一种并行计算软件环境,是在集群系统上实现并行计算的软件接口。

为了统一互不兼容的的用户界面,1992年成立了MPI委员会,负责制定MPI的新标准,支持最佳的可移植平台。

MPI不是一门新的语言,确切地说它是一个C和Fortran的函数库,用户通过调用这些函数接口并采用并行编译器编译源代码就可以生成可并行运行的代码。

MPI的目标是要开发一个广泛用于编写消息传递程序的标准,要求用户界面实用、可移植,并且高效、灵活,能广泛应用于各类并行机,特别是分布式存储的计算机。

每个计算机厂商都在开发标准平台上做了大量的工作,出现了一批可移植的消息传递环境。

MPI吸收了它们的经验,同时从句法和语法方面确定核心库函数,使之能适用于更多的并行机。

MPI在标准化过程中吸收了许多代表参加,包括研制并行计算机的大多数厂商,以及来自大学、实验室与工业界的研究人员。

1992年开始正式标准化MPI,1994年发布了MPI的定义与实验标准MPI 1,相应的MPI 2标准也已经发布。

MPI吸取了众多消息传递系统的优点,具有很好的可以执行、易用性和完备的异步通信功能等。

MPI事实上只是一个消息传递标准,并不是软件实现并行执行的具体实现,目前比较著名的MPI具体实现有MPICH、LAM MPI等,其中MPICH是目前使用最广泛的免费MPI系统,MPICH2是MPI 2标准的一个具体实现,它具有较好的兼容性和可扩展性,目前在高性能计算集群上使用非常广泛。

MPICH2的使用也非常简单,用户只需在并行程序中包含MPICH的头文件,然后调用一些MPICH2函数接口将计算任务分发到其他计算节点即可,MPICH2为并行计算用户提供了100多个C和Fortran函数接口,表1-1列出了一些常用的MPICH2的C语言函数接口,用户可以像调用普通函数一样,只需要做少量的代码改动就可以实现程序的并行运行,MPICH并行代码结构如图1-1所示。

Oracle Solaris Studio 12.2 OpenMP API 用户指南说明书

Oracle®Solaris Studio12.2:OpenMP API 用户指南文件号码821–25072010年9月版权所有©2010,Oracle和/或其附属公司。

保留所有权利。

本软件和相关文档是根据许可证协议提供的,该许可证协议中规定了关于使用和公开本软件和相关文档的各种限制,并受知识产权法的保护。

除非在许可证协议中明确许可或适用法律明确授权,否则不得以任何形式、任何方式使用、拷贝、复制、翻译、广播、修改、授权、传播、分发、展示、执行、发布或显示本软件和相关文档的任何部分。

除非法律要求实现互操作,否则严禁对本软件进行逆向工程设计、反汇编或反编译。

此文档所含信息可能随时被修改,恕不另行通知,我们不保证该信息没有错误。

如果贵方发现任何问题,请书面通知我们。

如果将本软件或相关文档交付给美国政府,或者交付给以美国政府名义获得许可证的任何机构,必须符合以下规定:ERNMENT RIGHTS Programs,software,databases,and related documentation and technical data delivered to ernment customers are "commercial computer software"or"commercial technical data"pursuant to the applicable Federal Acquisition Regulation and agency-specific supplemental regulations.As such,the use,duplication,disclosure,modification,and adaptation shall be subject to the restrictions and license terms set forth in the applicable Government contract,and,to the extent applicable by the terms of the Government contract,the additional rights set forth in FAR52.227-19,Commercial Computer Software License(December2007).Oracle America,Inc.,500Oracle Parkway,Redwood City,CA94065.本软件或硬件是为了在各种信息管理应用领域内的一般使用而开发的。

openmp手册

machine-name% machine-name# $ #

受支持的平台

此 Sun Studio 发 行 版 本 支 持 使 用 如 下 SPARC® 和 x86 系 列 处 理 器 架 构 的 系 统: UltraSPARC®、 ARC64、 AMD64、 Pentium 和 Xeon EM64T。可从以下位置获得硬件兼 容 性 列 表,在 列 表 中 可 以 查 看 您 正 在 使 用 的 Solaris 操 作 系 统 版 本 所 支 持 的 系 统: /bigadmin/hcl。这些文档中给出了平台类型间所有实现的 区别。 在本文档中,术语 “x86”指采用兼容 AMD64 或 Intel Xeon/Pentium 产品系列处理器的 64 位和 32 位系统。有关受支持的系统,请参阅硬件兼容性列表。

1–8

1.8

同步构造 1.8.1 1.8.2 1.8.3 1.8.4 1.8.5 1.8.6

MASTER 构造

CRITICAL 构造 BARRIER 构造 ATOMIC 构造 FLUSH 构造

ORDERED 构造 1–13

1.9

RIVATE 指令 1–14 1–14

版权所有 © 2005 Sun Microsystems, Inc., 4150 Network Circle, Santa Clara, California 95054, U.S.A. 保留所有权利。 美国政府权利 - 商业软件。政府用户应遵循 Sun Microsystems, Inc. 的标准许可协议,以及 FAR (Federal Acquisition Regulations,即 “联邦 政府采购法规” )的适用条款及其补充条款。使用须遵守许可证条款。 本发行可包含第三方开发的材料。 本产品的某些部分可能是从 Berkeley BSD 系统衍生出来的,并获得了加利福尼亚大学的许可。 UNIX 是由 X/Open Company, Ltd. 在美国和其 他国家/地区独家许可的注册商标。 Sun、Sun Microsystems、Sun 徽标、Java 和 JavaHelp 是 Sun Microsystems, Inc. 在美国和其他国家/地区的商标或注册商标。所有的 SPARC 商 标均需获得授权才能使用,它们是 SPARC International, Inc. 在美国和其他国家/地区的商标或注册商标。标有 SPARC 商标的产品均基于由 Sun Microsystems, Inc. 开发的体系结构。 本产品受美国出口管制法律控制,并可能受其他国家/地区的进出口法律的制约。严禁将本产品直接或间接地用于核设施、导弹、生化武器或海 上核设施,也不能直接或间接地出口给核设施、导弹、生化武器或海上核设施的最终用户。严禁出口或转口到美国禁运的国家/地区以及美国禁 止出口清单中所包含的实体,包括但不限于被禁止的个人以及特别指定的国家/地区的公民。 本文档按 “原样”提供,对于所有明示或默示的条件、陈述和担保,包括对适销性、适用性或非侵权性的默示保证,均不承担任何责任,除非 此免责声明的适用范围在法律上无效。

openmp手册

openmp手册OpenMP手册本文档旨在为使用OpenMP(Open Multi-Processing)编程模型的开发人员提供详细的参考指南和使用范例。

OpenMP是一套用于共享内存并行编程的API(Application Programming Interface)。

它允许程序员利用多线程并行化程序,以便在多个处理器上执行计算任务,以提高性能。

1、简介1.1 OpenMP的背景1.2 OpenMP的概述1.3 OpenMP的优势1.4 OpenMP的特性2、OpenMP基础指令2.1 并行区域(Parallel Regions)2.2 线程同步(Thread Synchronization)2.3 数据范围(Data Scoping)2.4 工作分配(Work Sharing)2.5 循环指令(Loop Directive)2.6 条件指令(Conditional Directive)2.7 函数指令(Function Directive)2.8并行性管理(Parallelism Management)3、OpenMP环境设置3.1 编译器支持3.2 编译选项3.3 运行时库3.4 环境变量4、OpenMP任务(Task)4.1 任务创建与同步4.2 任务调度4.3 任务优先级4.4 任务捕获变量5、OpenMP并行循环5.1 并行循环概述5.2 循环调度5.3 循环依赖5.4 循环优化6、OpenMP同步6.1 同步指令6.2 互斥锁6.3 条件变量6.4 同步的最佳实践7、OpenMP并行化任务图7.1 并行化任务图的概念 7.2 创建和管理任务图 7.3 数据依赖性和同步7.4 任务图调度8、OpenMP并行化内存管理 8.1 共享内存的访问模型 8.2 数据共享与私有化 8.3 内存一致性8.4 直接存储器访问模型9、OpenMP性能分析与优化9.1 性能分析工具9.2 优化技术9.3 并行编程陷阱9.4 调试OpenMP程序附件:附件一、OpenMP示例代码附件二、OpenMP编程规范附件三、OpenMP常见问题解答法律名词及注释:1、API(Application Programming Interface):应用程序编程接口,定义了软件组件之间的通信协议和接口规范。

2024版并行程序设计导论之OpenMP编程指南

OpenMP编程指南•OpenMP 概述•OpenMP 基本原理•OpenMP 编程实践•并行算法设计与优化•多线程并发控制及同步机制•内存访问优化与缓存一致性维护•性能评价与调试技巧分享目录01 OpenMP概述并行计算与OpenMP并行计算定义并行计算是指同时使用多种计算资源解决计算问题的过程,其主要目的是快速解决大型且复杂的计算问题。

OpenMP简介OpenMP是一种用于共享内存并行编程的API,在C/C和Fortran中广泛使用。

它提供了一种简单、灵活的线程并行编程模型,支持多平台和多编译器。

OpenMP与并行计算关系OpenMP通过提供一套编程接口和运行时库,使得程序员能够方便地使用多线程进行并行计算,从而加速程序的执行速度。

OpenMP历史与发展OpenMP起源OpenMP起源于1997年,由一组计算机硬件和软件厂商共同发起,旨在创建一个开放的、标准的并行编程模型。

OpenMP版本演进自1998年发布第一个版本以来,OpenMP不断发展和完善,增加了对任务并行、加速器支持、原子操作、线程同步等功能的支持。

OpenMP现状与未来目前,OpenMP已成为并行编程领域的事实标准之一,广泛应用于科学计算、工程仿真、数据分析等领域。

未来,随着硬件技术的不断发展和应用需求的不断提高,OpenMP将继续发展并完善。

OpenMP 在科学计算领域有着广泛的应用,如天气预报、气候模拟、油藏模拟等。

科学计算在工程仿真领域,OpenMP 可用于加速有限元分析、流体动力学仿真等计算过程。

工程仿真在数据分析领域,OpenMP 可用于加速数据挖掘、机器学习等算法的执行速度。

数据分析此外,OpenMP 还可应用于图像处理、密码学、生物信息学等领域。

其他领域OpenMP 应用领域02 OpenMP基本原理共享内存模型OpenMP基于共享内存模型,多个线程可以访问和修改同一块内存空间,需要解决数据一致性和同步问题。

分布式内存模型与MPI等基于分布式内存的并行计算模型不同,OpenMP不需要显式地进行数据分发和收集。

OpenMP (5)

5.5.2 符号表OMPi对符号表的高层管理是使用symtab结构体,其中symtabl->table是一个数组,记录了STSIZE个符号表项。

Symbol.h文件部分代码如下,首先是符号表的大小:…1. #define STSIZE 1031 /* Prime */ 符号表大小然后是关于符号的名字空间问题。

可以看出符号分成几种名字空间,namespace有IDNAME 标识符、TYPENAME类型名、SUNAME结构和联合体名、ENUMNAME枚举名等6种。

2. typedef enum { IDNAME = 1, TYPENAME, SUNAME, ENUMNAME, LABELNAME, FUNCNAME }3. namespace; 名字空间再接着是符号表项指针和符号表项,符号表项是符号表的元素,它对符号symble进行了封装,不同的名字空间的符号借助于成员space来标示。

所有的符号都在符号表里。

一个符号使用符号项来记录,下面是符号项stentry_的定义。

4. typedef struct stentry_ *stentry;5. struct stentry_ { symbol key; /* The symbol */ 指向符号6. void *vval; /* General, to put anything */7. int ival; /* For int values (common case) */8. astspec spec; /* The specifier */9. astdecl decl; /* The bare declarator */10. astdecl idecl; /* initdeclarator (includes decl) */11. namespace space; /* 1 table for all spaces */12. int isarray; /* Non-scalar */13. int isthrpriv; /* 1 if it is a threadprivate var */14. int scopelevel; /* The scope it was declared in */15. stentry bucketnext; /* for the bucket */16. stentry stacknext; /* for the scope stack */17. };符号表项里面的spec、decl和idecl分别指向某个变量符号的类型、声明和带初始化声名的AST节点,用于后面代码变换时克隆变量相关的代码。

openMP

openMP语法[编辑]directive[编辑]其中,directive共11个:•atomic 内存位置将会原子更新(Specifies that a memory location that will be updated atomically.)•barrier 线程在此等待,直到所有的线程都运行到此barrier。

用来同步所有线程。

•critical 其后的代码块为临界区,任意时刻只能被一个线程运行。

•flush 所有线程对所有共享对象具有相同的内存视图(view of memory)•for 用在for循环之前,把for循环并行化由多个线程执行。

循环变量只能是整型•master 指定由主线程来运行接下来的程序。

•ordered 指定在接下来的代码块中,被并行化的 for循环将依序运行(sequential loop)•parallel 代表接下来的代码块将被多个线程并行各执行一遍。

•sections 将接下来的代码块包含将被并行执行的section块。

•single 之后的程序将只会在一个线程(未必是主线程)中被执行,不会被并行执行。

•threadprivate 指定一个变量是线程局部存储(thread local storage)clause[编辑]共计13个clause:•copyin 让threadprivate的变量的值和主线程的值相同。

•copyprivate 不同线程中的变量在所有线程中共享。

•default Specifies the behavior of unscoped variables in aparallel region.•firstprivate 对于线程局部存储的变量,其初值是进入并行区之前的值。

•if 判断条件,可用来决定是否要并行化。

•lastprivate 在一个循环并行执行结束后,指定变量的值为循环体在顺序最后一次执行时获取的值,或者#pragma sections在中,按文本顺序最后一个section中执行获取的值。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

OpenMP例程使用手册

目录

1 OpenMP简介 (2)

2 OpenMP例程编译 (2)

2.1安装gawk (2)

2.2编译例程 (2)

2.3拷贝例程到开发板 (3)

3例程测试 (5)

3.1 dspheap (5)

3.2 vecadd (6)

3.3 vecadd_complex (6)

3.4 其他例程测试说明 (7)

更多帮助.................................................................................................... 错误!未定义书签。

公司官网: 销售邮箱:sales@ 公司总机:020-8998-6280 1/7技术论坛: 技术邮箱:support@ 技术热线:020-3893-9734

1 OpenMP简介

OpenMP用于共享内存并行系统的多处理器程序设计的一套指导性的编译处理方案(Compiler Directive)。

它是为在多处理机上编写并行程序而设计的一个应用编程接口。

它包括一套编译指导语句和一个用来支持它的函数库。

OpenMP提供的这种对于并行描述的高层抽象降低了并行编程的难度和复杂度,这样程序员可以把更多的精力投入到并行算法本身,而非其具体实现细节。

对基于数据分集的多线程程序设计,OpenMP是一个很好的选择。

同时,使用OpenMP也提供了更强的灵活性,可以较容易的适应不同的并行系统配置。

线程粒度和负载平衡等是传统多线程程序设计中的难题,但在OpenMP中,OpenMP库从程序员手中接管了部分这两方面的工作。

但是,作为高层抽象,OpenMP并不适合需要复杂的线程间同步和互斥的场合。

OpenMP的另一个缺点是不能在非共享内存系统(如计算机集群)上使用。

在这样的系统上,MPI使用较多。

2 OpenMP例程编译

2.1安装gawk

此工具为编译的必要工具,在Ubuntu下安装:

Host#sudoapt-get install gawk

图1

2.2编译例程

请先安装ti-processor-sdk-linux-am57xx-evm-03.01.00.06,安装步骤请参照《相关软件

安装》文档,安装之后进入SDK根目录,执行编译命令:

Host#make openmpacc-examples

图2

编译成功后,会在SDK根目录“example-applications/openmpacc-examples-1.4.0.2/”目录下生成可执行文件。

2.3拷贝例程到开发板

源码路径:光盘资料/demo/OpenMP/bin/openmp.tar.gz

本文已经提供编译好的OpenMP例程,将它拷贝Ubuntu解压并拷贝到开发板文件系统上即可执行,或者自行拷贝上一步骤编译的文件也可以。

解压openmp.tar.gz:

Host#tar axvfopenmp.tar.gz

图3

使用SSH拷贝到开发板,注意,需先要在开发板系统上ping一下Ubuntu的IP,再进行拷贝:

Target#ifconfig //查询Ubuntu IP

图4

Target#ping 192.168.1.54 //在开发板上pingUbuntuIP

图5

在Ubuntu上拷贝解压出来的OpenMP文件夹到开发板

Host#scp -r openmproot@192.168.1.45:/home/root //192.168.1.45为开发板IP

图6

即可在开发板上看到拷贝过去的OpenMP文件:

图7

3 例程测试

3.1dspheap

程序功能:

此例程演示如何在OpenMP目标区域内,在DSP上创建和使用堆。

有DSP内置函数来创建在MSMC,DDR和本地内存区域中操作用户定义的堆。

这些堆是永久的,只要它们的底层内存被分配。

在这个例子中,从连续的共享内存区域创建缓冲区,提供底层内存存储。

堆是活跃的和持久的从它们被初始化直到缓冲区被解除分配。

运行测试:

进入“/openmp/dspheap/”目录,运行程序:

Target# ./dspheap

图8

3.2vecadd

程序功能:

利用OpenMP进行两个元素个数为8K的一维向量的并行相加。

运行测试:

进入“/openmp/vecadd/”目录,运行程序:

Target# ./vecadd

图9

3.3vecadd_complex

程序功能:

利用OpenMP进行两个元素个数为8K的复数向量的并行相加。

运行测试:

进入“/openmp/vecadd_complex/”目录,运行程序:

Target# ./vecadd_complex

图10

3.4其他例程测试说明

其他程序测试方法跟以上一样,具体程序功能可以查看源码.C文件的注释,路径在SDK根目录“/example-applications/openmpacc-examples-1.4.0.2/”目录下。