第10章 决策树模型

农业病虫害预测与防控智能化系统

农业病虫害预测与防控智能化系统第1章绪论 (3)1.1 农业病虫害预测与防控的意义 (3)1.1.1 保证粮食安全 (4)1.1.2 提高农产品质量 (4)1.1.3 促进农业可持续发展 (4)1.2 智能化系统在农业病虫害预测与防控中的应用 (4)1.2.1 数据采集与分析 (4)1.2.2 病虫害预测模型构建 (4)1.2.3 防控策略优化 (4)1.2.4 农业生产管理决策支持 (4)第2章农业病虫害基本知识 (5)2.1 病虫害分类与发生规律 (5)2.1.1 真菌性病害 (5)2.1.2 细菌性病害 (5)2.1.3 病毒性疾病 (5)2.1.4 害虫侵害 (5)2.1.5 线虫病害 (5)2.1.6 非生物因素引起的病虫害 (5)2.2 病虫害影响因素分析 (5)2.2.1 气候因素 (6)2.2.2 土壤因素 (6)2.2.3 农业生产措施 (6)2.2.4 生态环境 (6)2.3 病虫害监测与预警技术 (6)2.3.1 病虫害调查与监测 (6)2.3.2 遥感技术 (6)2.3.3 气象预报技术 (6)2.3.4 模型预测技术 (6)2.3.5 预警系统 (6)第3章数据采集与处理技术 (7)3.1 农业病虫害数据采集方法 (7)3.1.1 传统数据采集方法 (7)3.1.2 现代遥感技术 (7)3.1.3 传感器技术 (7)3.2 数据预处理技术 (7)3.2.1 数据清洗 (7)3.2.2 数据标准化与归一化 (7)3.2.3 数据整合与融合 (7)3.3 数据分析与挖掘方法 (7)3.3.1 描述性统计分析 (7)3.3.2 机器学习与模式识别 (8)3.3.4 深度学习技术 (8)第4章病虫害预测模型构建 (8)4.1 统计预测模型 (8)4.1.1 时间序列分析模型 (8)4.1.2 线性回归模型 (8)4.1.3 逻辑回归模型 (8)4.2 机器学习预测模型 (8)4.2.1 决策树模型 (8)4.2.2 随机森林模型 (9)4.2.3 支持向量机模型 (9)4.3 深度学习预测模型 (9)4.3.1 卷积神经网络模型 (9)4.3.2 循环神经网络模型 (9)4.3.3 深度信念网络模型 (9)4.3.4 对抗网络模型 (9)4.3.5 融合模型 (9)第5章病虫害防控策略制定 (9)5.1 防控策略概述 (9)5.2 防控措施优化方法 (10)5.2.1 预防措施 (10)5.2.2 治理措施 (10)5.2.3 监测措施 (10)5.3 防控效果评估 (10)第6章智能化系统设计与实现 (11)6.1 系统架构设计 (11)6.1.1 整体架构 (11)6.1.2 数据层 (11)6.1.3 服务层 (11)6.1.4 应用层 (11)6.2 系统功能模块设计 (11)6.2.1 数据处理模块 (11)6.2.2 模型预测模块 (11)6.2.3 防控策略模块 (11)6.3 系统开发与实现 (12)6.3.1 开发环境 (12)6.3.2 系统实现 (12)6.3.3 系统部署 (12)第7章智能识别与诊断技术 (12)7.1 图像处理与特征提取 (12)7.1.1 图像预处理 (12)7.1.2 特征提取 (12)7.2 深度学习在病虫害识别中的应用 (13)7.2.1 卷积神经网络(CNN) (13)7.3 病虫害诊断方法研究 (13)7.3.1 支持向量机(SVM) (13)7.3.2 集成学习 (13)7.3.3 深度学习方法 (13)第8章预测与防控系统应用案例 (14)8.1 案例一:水稻病虫害预测与防控 (14)8.1.1 案例背景 (14)8.1.2 系统应用 (14)8.1.3 应用效果 (14)8.2 案例二:小麦病虫害预测与防控 (14)8.2.1 案例背景 (14)8.2.2 系统应用 (14)8.2.3 应用效果 (14)8.3 案例三:果树病虫害预测与防控 (14)8.3.1 案例背景 (14)8.3.2 系统应用 (15)8.3.3 应用效果 (15)第9章农业病虫害防控政策与措施 (15)9.1 我国病虫害防控政策概述 (15)9.1.1 政策背景 (15)9.1.2 政策目标 (15)9.1.3 政策措施 (15)9.2 农业病虫害防控措施实践 (15)9.2.1 监测预警体系构建 (15)9.2.2 绿色防控技术应用 (16)9.2.3 农药、化肥减量使用 (16)9.3 防控政策与措施优化建议 (16)9.3.1 政策优化 (16)9.3.2 措施优化 (16)9.3.3 社会共治 (16)第10章智能化系统在农业病虫害防控中的前景与挑战 (16)10.1 农业病虫害防控智能化发展趋势 (16)10.2 面临的挑战与问题 (17)10.3 未来研究方向与展望 (17)第1章绪论1.1 农业病虫害预测与防控的意义农业病虫害预测与防控是保障粮食安全和农产品质量的重要环节。

第10章 决策树

的算法,其剪枝的方法也不尽相同。常用的剪枝方法有预剪枝和后剪枝两种。例如CHILD和C5.0采用预剪枝,CART则采用后

剪枝。

(1)预剪枝:是指在构建决策树之前,先指定好生长停止准则(例如指定某个评估参数的阈值),此做法适合应用于大规模

和CART几乎同时被提出,但都采用类似的方法从训练样本中学习决策树。

决策树算法

算法描述

ID3算法

其核心是在决策树的各级分裂节点上,使用信息增益作为分裂变量的选择标准,来帮助确定生成每个节点时所

应采用的合适自变量

C4.5算法

C4.5决策树算法相对于ID3算法的重要改进是使用信息增益率来选择节点属性。C4.5算法可以克服ID3算法存在

示自变量A的信息熵。

C5.0算法是由计算机科学家J.Ross Quinlan为改进他之前的算法C4.5开发的新版本。该算法增强了对大量数据的处理能力,

并加入了Boosting以提高模型准确率。尽管Quinlan将C5.0算法销售给商业用户,但是该算法的一个单线程版本的源代码

是公开的,因此可以编写成程序,R中就有相应的包实现C5.0算法。

用log函数。可见,发生的概率p越大,其不确定性越低。

考虑到信源的所有可能发生的事件,假设其概率为{1 , 2 , … , },则可以计算其平均值(数学期望),该值被称为信息熵或者经验熵。假设S是s

个数据样本的集合,假定离散变量有m个不同的水平: ( = 1,2, … , ),假设 是类 中的样本数。对一个给定的样本,它总的信息熵为:

CART算法正好适用于连续型特征。CART算法使用二元切分法来处理连续型变量。而使用二元切分法则易于对树构建过程进行调整。

机器学习基础智慧树知到答案章节测试2023年太原理工大学

第一章测试1.样本是连续型数据且有标签,我们采用()进行机器学习。

A:嵌入算法B:聚类算法C:分类算法D:回归算法答案:D2.在机器学习中,样本常被分成()。

A:训练集B:其它选项都有C:测试集D:评估集答案:B3.机器学习算法需要显示编程,具备归纳、总结等自学习能力。

()A:错B:对答案:A4.机器学习和人工智能、深度学习是一个概念,都是指机器模仿人类推理、学习能力。

()A:错B:对答案:A5.特征工程非常重要,在采用机器学习算法前,首先需要利用特征工程确定样本属性。

()A:错B:对答案:B第二章测试1.K近邻算法认为距离越近的相似度越高。

()A:对B:错答案:A2.K近邻算法中数据可以不做归一化,因为是否归一化对结果影响不大。

()A:错B:对答案:A3.K近邻算法中采用不同的距离公式对于结果没有影响。

()A:错答案:A4.在上面图中,K=5,绿色样本的类别是()。

A:红色三角形B:蓝色正方形C:不能确定D:绿色圆形答案:B5.在K近邻算法中,K的选择是()?A:越大越好B:与样本有关C:其它都不正确D:越小越好答案:B第三章测试1.下列()中两个变量之间的关系是线性的。

A:猫的皮毛颜色和体重B:人的工作环境和健康状况C:重力和质量D:女儿的身高和父亲的体重答案:C2.下列说法不正确的是()。

A:线性回归模型也可以解决线性不可分的情况B:回归用于预测输入变量和输出变量之间的关系C:回归就是数据拟合D:回归分析就是研究两个事物的相关性答案:C3.从某大学随机选择8名女大学生,其身高x(cm)和体重y(kg)的回归方程是y=0.849x-85.712,则身高172cm的女大学生,预测体重为()。

A:60.316kgB:大于60.316kgC:小于60.316kgD:其它都不正确答案:Asso中采用的是L2正则化。

()A:错B:对答案:A5.线性回归中加入正则化可以降低过拟合。

()A:错答案:B第四章测试1.以下说法正确的是()。

决策树模型算法

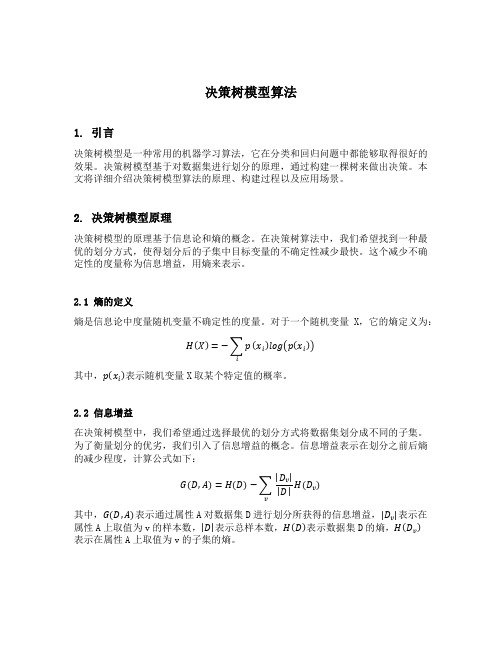

决策树模型算法1. 引言决策树模型是一种常用的机器学习算法,它在分类和回归问题中都能够取得很好的效果。

决策树模型基于对数据集进行划分的原理,通过构建一棵树来做出决策。

本文将详细介绍决策树模型算法的原理、构建过程以及应用场景。

2. 决策树模型原理决策树模型的原理基于信息论和熵的概念。

在决策树算法中,我们希望找到一种最优的划分方式,使得划分后的子集中目标变量的不确定性减少最快。

这个减少不确定性的度量称为信息增益,用熵来表示。

2.1 熵的定义熵是信息论中度量随机变量不确定性的度量。

对于一个随机变量X,它的熵定义为:H(X)=−∑pi(x i)log(p(x i))其中,p(x i)表示随机变量X取某个特定值的概率。

2.2 信息增益在决策树模型中,我们希望通过选择最优的划分方式将数据集划分成不同的子集。

为了衡量划分的优劣,我们引入了信息增益的概念。

信息增益表示在划分之前后熵的减少程度,计算公式如下:G(D,A)=H(D)−∑|D v| |D|vH(D v)其中,G(D,A)表示通过属性A对数据集D进行划分所获得的信息增益,|D v|表示在属性A上取值为v的样本数,|D|表示总样本数,H(D)表示数据集D的熵,H(D v)表示在属性A上取值为v的子集的熵。

2.3 构建决策树决策树的构建是一个递归的过程。

在每个节点上,我们选择使得信息增益最大的特征作为划分标准,将数据集划分成不同的子集。

然后,对于每个子集,我们继续递归地构建下一级节点,直到满足终止条件为止。

3. 决策树模型算法步骤决策树模型算法的步骤主要包括:特征选择、决策树构建和决策树剪枝。

3.1 特征选择特征选择是决策树模型算法的关键步骤。

我们需要选择最优的特征作为划分标准。

常用的特征选择方法有信息增益、增益率和基尼系数等。

3.2 决策树构建决策树的构建是一个递归的过程。

我们从根节点开始依次划分数据集,直到满足终止条件。

在每个节点上,我们选择使得信息增益最大的特征进行划分。

决策树(完整)

无缺失值样本中在属性 上取值 的样本所占比例

ቤተ መጻሕፍቲ ባይዱ

谢谢大家!

举例:求解划分根结点的最优划分属性

根结点的信息熵:

用“色泽”将根结点划分后获得3个分支结点的信息熵分别为:

属性“色泽”的信息增益为:

若把“编号”也作为一个候选划分属性,则属性“编号”的信息增益为:

根结点的信息熵仍为:

用“编号”将根结点划分后获得17个分支结点的信息熵均为:

则“编号”的信息增益为:

三种度量结点“纯度”的指标:信息增益增益率基尼指数

1. 信息增益

香农提出了“信息熵”的概念,解决了对信息的量化度量问题。香农用“信息熵”的概念来描述信源的不确定性。

信息熵

信息增益

一般而言,信息增益越大,则意味着使用属性a来进行划分所获得的“纯度提升”越大。决策树算法第8行选择属性

著名的ID3决策树算法

远大于其他候选属性信息增益准则对可取值数目较多的属性有所偏好

2. 增益率

增益率准则对可取值数目较少的属性有所偏好著名的C4.5决策树算法综合了信息增益准则和信息率准则的特点:先从候选划分属性中找出信息增益高于平均水平的属性,再从中选择增益率最高的。

3. 基尼指数

基尼值

基尼指数

著名的CART决策树算法

过拟合:学习器学习能力过于强大,把训练样本自身的一些特点当作了所有潜在样本都会具有的一般性质,导致泛化性能下降。欠拟合:学习器学习能力低下,对训练样本的一般性质尚未学好。

过拟合无法彻底避免,只能做到“缓解”。

不足:基于“贪心”本质禁止某些分支展开,带来了欠拟合的风险

预剪枝使得决策树的很多分支都没有“展开”优点:降低过拟合的风险减少了训练时间开销和测试时间开销

决策树

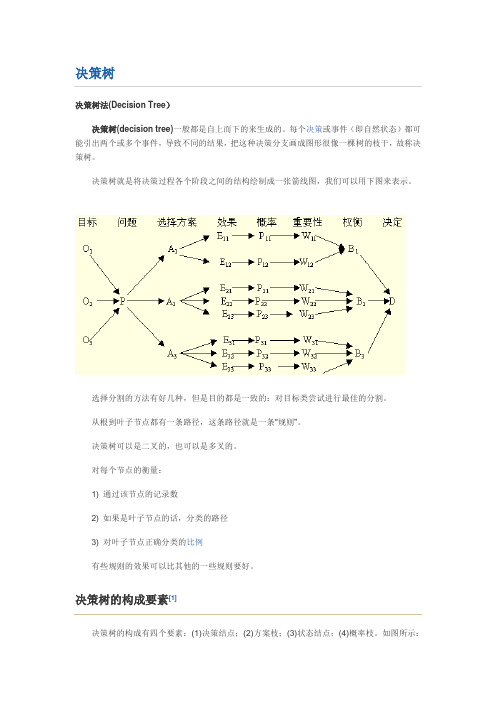

决策树决策树法(Decision Tree)决策树(decision tree)一般都是自上而下的来生成的。

每个决策或事件(即自然状态)都可能引出两个或多个事件,导致不同的结果,把这种决策分支画成图形很像一棵树的枝干,故称决策树。

决策树就是将决策过程各个阶段之间的结构绘制成一张箭线图,我们可以用下图来表示。

选择分割的方法有好几种,但是目的都是一致的:对目标类尝试进行最佳的分割。

从根到叶子节点都有一条路径,这条路径就是一条“规则”。

决策树可以是二叉的,也可以是多叉的。

对每个节点的衡量:1) 通过该节点的记录数2) 如果是叶子节点的话,分类的路径3) 对叶子节点正确分类的比例有些规则的效果可以比其他的一些规则要好。

决策树的构成要素[1]决策树的构成有四个要素:(1)决策结点;(2)方案枝;(3)状态结点;(4)概率枝。

如图所示:总之,决策树一般由方块结点、圆形结点、方案枝、概率枝等组成,方块结点称为决策结点,由结点引出若干条细支,每条细支代表一个方案,称为方案枝;圆形结点称为状态结点,由状态结点引出若干条细支,表示不同的自然状态,称为概率枝。

每条概率枝代表一种自然状态。

在每条细枝上标明客观状态的内容和其出现概率。

在概率枝的最末稍标明该方案在该自然状态下所达到的结果(收益值或损失值)。

这样树形图由左向右,由简到繁展开,组成一个树状网络图。

决策树对于常规统计方法的优缺点优点:1)可以生成可以理解的规则;2)计算量相对来说不是很大;3) 可以处理连续和种类字段;4) 决策树可以清晰的显示哪些字段比较重要。

缺点:1) 对连续性的字段比较难预测;2) 对有时间顺序的数据,需要很多预处理的工作;3) 当类别太多时,错误可能就会增加的比较快;4) 一般的算法分类的时候,只是根据一个字段来分类。

决策树的适用范围[1]科学的决策是现代管理者的一项重要职责。

我们在企业管理实践中,常遇到的情景是:若干个可行性方案制订出来了,分析一下企业内、外部环境,大部分条件是己知的,但还存在一定的不确定因素。

决策树模型的使用教程(十)

决策树模型的使用教程在机器学习领域,决策树模型是一种常用的预测模型,它可以用于分类和回归分析。

本文将详细介绍决策树模型的原理和使用方法,帮助读者了解如何利用决策树模型解决实际问题。

原理介绍决策树模型是一种基于树状结构的预测模型,通过一系列的决策节点和叶子节点来进行数据分类或回归分析。

在决策树的构建过程中,算法会选择最佳的特征进行分割,使得分割后的子集尽可能地纯净。

纯净度可以通过不同的指标来衡量,比如信息增益、基尼系数等。

决策树模型的优点在于易于理解和解释,同时能够处理非线性关系和交互作用。

然而,决策树模型也存在一些缺点,比如容易过拟合、对噪声敏感等。

使用方法要使用决策树模型进行预测,首先需要准备数据集。

数据集应包括特征变量和目标变量,特征变量是用来进行预测的输入变量,目标变量是需要预测的输出变量。

然后,可以使用Python中的scikit-learn库来构建决策树模型。

首先,需要导入所需的库和数据集:```pythonimport numpy as npimport pandas as pdfrom _selection import train_test_splitfromimport DecisionTreeClassifierfromimport accuracy_score```然后,加载数据集并划分训练集和测试集:```pythondata = _csv('')X = ('target', axis=1)y = data['target']X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=, random_state=42)```接着,使用训练集来构建决策树模型:```pythonmodel = DecisionTreeClassifier()(X_train, y_train)```最后,使用测试集来评估模型的性能:```pythony_pred = (X_test)accuracy = accuracy_score(y_test, y_pred)print('Accuracy:', accuracy)```通过以上步骤,就可以使用决策树模型进行预测并评估模型的性能了。

大数据分析在金融风控中的应用手册

大数据分析在金融风控中的应用手册第1章:概述 (3)1.1 金融风控背景 (3)1.2 大数据分析简介 (3)1.3 大数据在金融风控中的应用价值 (3)第2章:数据采集与处理 (3)2.1 数据来源 (3)2.2 数据预处理 (3)2.3 数据质量评估 (3)第3章:数据挖掘技术 (3)3.1 传统数据挖掘方法 (4)3.2 深度学习在金融风控中的应用 (4)3.3 强化学习在金融风控中的应用 (4)第4章:信用评分模型 (4)4.1 逻辑回归模型 (4)4.2 决策树模型 (4)4.3 随机森林模型 (4)第5章:反欺诈模型 (4)5.1 基于规则的欺诈检测 (4)5.2 基于机器学习的欺诈检测 (4)5.3 实时反欺诈系统 (4)第6章:风险监测与预警 (4)6.1 风险指标体系 (4)6.2 风险监测方法 (4)6.3 预警系统构建 (4)第7章:风险度量与评估 (4)7.1 风险价值(VaR) (4)7.2 预期损失(EL) (4)7.3 条件风险价值(CVaR) (4)第8章:信贷审批与风险控制 (4)8.1 信贷审批流程优化 (4)8.2 风险控制策略 (4)8.3 信贷组合管理 (4)第9章:投资决策与风险管理 (4)9.1 资产配置 (4)9.2 投资组合优化 (4)9.3 风险预算 (4)第10章:大数据技术在保险风控中的应用 (4)10.1 保险风险评估 (4)10.2 保险欺诈检测 (5)10.3 保险理赔优化 (5)第11章:大数据技术在证券市场风控中的应用 (5)11.2 量化交易策略 (5)11.3 市场异常检测 (5)第12章:大数据风控未来发展趋势与挑战 (5)12.1 技术发展趋势 (5)12.2 数据安全与隐私保护 (5)12.3 监管政策与合规要求 (5)第1章:概述 (5)1.1 金融风控背景 (5)1.2 大数据分析简介 (5)1.3 大数据在金融风控中的应用价值 (6)第二章:数据采集与处理 (6)2.1 数据来源 (6)2.2 数据预处理 (7)2.3 数据质量评估 (7)第三章:数据挖掘技术 (7)3.1 传统数据挖掘方法 (7)3.2 深度学习在金融风控中的应用 (8)3.3 强化学习在金融风控中的应用 (8)第四章:信用评分模型 (9)4.1 逻辑回归模型 (9)4.2 决策树模型 (9)4.3 随机森林模型 (10)第五章:反欺诈模型 (10)5.1 基于规则的欺诈检测 (10)5.1.1 规则制定 (10)5.1.2 规则执行 (11)5.2 基于机器学习的欺诈检测 (11)5.2.1 特征工程 (11)5.2.2 模型训练与评估 (11)5.2.3 模型部署与应用 (11)5.3 实时反欺诈系统 (12)第6章:风险监测与预警 (12)6.1 风险指标体系 (12)6.1.1 风险指标选取原则 (12)6.1.2 风险指标分类 (12)6.1.3 风险指标体系构建 (12)6.2 风险监测方法 (12)6.2.1 数据挖掘方法 (12)6.2.2 指标监测方法 (13)6.2.3 实时监测方法 (13)6.3 预警系统构建 (13)6.3.1 预警系统架构 (13)6.3.2 预警阈值设定 (13)6.3.4 预警信息发布与响应 (13)6.3.5 预警系统评估与优化 (13)第7章:风险度量与评估 (13)7.1 风险价值(VaR) (14)7.2 预期损失(EL) (14)7.3 条件风险价值(CVaR) (14)第8章:信贷审批与风险控制 (14)8.1 信贷审批流程优化 (15)8.2 风险控制策略 (15)8.3 信贷组合管理 (15)第9章:投资决策与风险管理 (16)9.1 资产配置 (16)9.2 投资组合优化 (16)9.3 风险预算 (17)第10章:大数据技术在保险风控中的应用 (17)10.1 保险风险评估 (17)10.2 保险欺诈检测 (18)10.3 保险理赔优化 (18)第11章:大数据技术在证券市场风控中的应用 (19)11.1 股票市场风险监测 (19)11.2 量化交易策略 (19)11.3 市场异常检测 (20)第12章:大数据风控未来发展趋势与挑战 (20)12.1 技术发展趋势 (20)12.2 数据安全与隐私保护 (21)12.3 监管政策与合规要求 (21)第1章:概述1.1 金融风控背景1.2 大数据分析简介1.3 大数据在金融风控中的应用价值第2章:数据采集与处理2.1 数据来源2.2 数据预处理2.3 数据质量评估第3章:数据挖掘技术3.1 传统数据挖掘方法3.2 深度学习在金融风控中的应用3.3 强化学习在金融风控中的应用第4章:信用评分模型4.1 逻辑回归模型4.2 决策树模型4.3 随机森林模型第5章:反欺诈模型5.1 基于规则的欺诈检测5.2 基于机器学习的欺诈检测5.3 实时反欺诈系统第6章:风险监测与预警6.1 风险指标体系6.2 风险监测方法6.3 预警系统构建第7章:风险度量与评估7.1 风险价值(VaR)7.2 预期损失(EL)7.3 条件风险价值(CVaR)第8章:信贷审批与风险控制8.1 信贷审批流程优化8.2 风险控制策略8.3 信贷组合管理第9章:投资决策与风险管理9.1 资产配置9.2 投资组合优化9.3 风险预算第10章:大数据技术在保险风控中的应用10.1 保险风险评估10.2 保险欺诈检测10.3 保险理赔优化第11章:大数据技术在证券市场风控中的应用11.1 股票市场风险监测11.2 量化交易策略11.3 市场异常检测第12章:大数据风控未来发展趋势与挑战12.1 技术发展趋势12.2 数据安全与隐私保护12.3 监管政策与合规要求第1章:概述在当今经济全球化、金融创新不断加速的背景下,金融风控作为金融行业的核心环节,对于维护金融市场的稳定、保护投资者利益具有的作用。

决策树模型参数及其解释

决策树模型参数及其解释决策树模型是一种常用的机器学习算法,它通过构建一棵树状的决策流程来进行分类或回归任务。

决策树模型有一些重要的参数,下面我将逐个解释它们。

1. criterion(划分标准),决策树在每个节点上选择最佳划分的标准。

常见的划分标准有基尼系数(gini)和信息增益(entropy)。

基尼系数衡量了节点的不纯度,信息增益则衡量了节点的信息不确定性。

2. max_depth(最大深度),决策树的最大深度限制。

深度是指从根节点到叶节点的最长路径长度。

设置最大深度可以避免过拟合,但也可能导致欠拟合。

通常需要通过交叉验证来选择最优的最大深度。

3. min_samples_split(节点划分的最小样本数),决策树在进行节点划分时所需的最小样本数。

如果某个节点的样本数小于该值,则不再进行划分。

这个参数可以控制决策树的复杂度,避免过拟合。

4. min_samples_leaf(叶节点的最小样本数),决策树的叶节点上所需的最小样本数。

如果某个叶节点的样本数小于该值,则该节点会被剪枝。

这个参数可以控制决策树的复杂度,避免过拟合。

5. max_features(最大特征数),在进行节点划分时考虑的最大特征数。

可以是一个固定的整数值,也可以是一个比例。

这个参数可以控制决策树的复杂度,避免过拟合。

6. splitter(节点划分策略),决策树节点划分的策略,可以是"best"或"random"。

"best"表示选择最佳划分,"random"表示随机选择划分。

默认为"best",一般情况下不需要修改。

这些参数可以根据具体问题和数据集的特点进行调整,以获得更好的模型性能。

需要注意的是,参数的选择需要综合考虑模型的准确性和复杂度,避免过拟合或欠拟合的问题。

可以使用交叉验证等技术来选择最优的参数组合。

决策树模型在临床研究数据分析中的应用

·临床研究规范·决策树模型在临床研究数据分析中的应用沈范玲子1王瑞平1,2(1. 上海中医药大学公共健康学院上海 201203;2. 上海市皮肤病医院临床研究与创新转化中心上海 200443)摘要决策树模型是一种有监督的机器学习方法,分类规则通常采取IF-THEN形式,分析结果常以树形图呈现,具有可解释性强、易于理解的优势,在灾害预测、环境监测、临床诊疗决策等领域均有广泛的应用。

本文从决策树模型概念入手,介绍了决策树模型的一般构建步骤、分类与回归树(classification and regression tree, CART)决策树模型在临床研究数据分析中的应用,并应用SPSS软件示例CART决策树模型的构建过程和实现方法,以期为临床研究者采用决策树模型进行数据分析提供参考。

关键词决策树临床研究 CART算法 SPSS软件中图分类号:G304; R-3 文献标志码:C 文章编号:1006-1533(2024)05-0014-05引用本文沈范玲子, 王瑞平. 决策树模型在临床研究数据分析中的应用[J]. 上海医药, 2024, 45(5): 14-18.Application of decision tree modeling in clinical research data analysisSHEN Fanlingzi1, WANG Ruiping1,2(1. School of Public Health, Shanghai University of Traditional Chinese Medicine, Shanghai 201203, China;2. Clinical Research & Innovation Center, Shanghai Skin Disease Hospital, Shanghai 200443, China)ABSTRACT Decision tree model is a supervised machine learning method and its classification rules usually take the form of IF-THEN, the analysis results are often presented in the form of tree diagrams, with the advantages of solid interpretability and ease understanding, and it has been widely used in the fields of disaster prediction, environmental monitoring, clinical diagnosis and treatment decision-making. This article starts from the concept of decision tree model, introduces the general construction steps of decision tree model, the application of classification and regression tree (CART) decision tree model in the analysis of clinical research data, and the construction process and realization method of CART decision tree model using the SPSS software example, so as to provide a better solution for clinical researchers to use decision tree model for data analysis.KEY WORDS decision trees; clinical research; CART algorithm; SPSS software临床医学研究中,在探讨多个自变量和因变量之间关系时,常采用多元线性回归、logistic回归、Cox回归分析、广义线性模型等经典统计分析方法。

第10章 公共政策分析《公共政策学》PPT课件

第一节 公共政策分析概述 第二节 公共政策分析的步骤与方法 第三节 公共政策分析模型 第四节 我国公共政策分析的发展

第一节 公共政策分析概述

一、公共政策分析概念与意义 (一)公共政策分析的涵义 公共政策分析就是依据一定的政策理论、知识,运

用各种分析方法和技术,帮助决策者发现和解决公 共政策问题,以作出正确、合理的决策,避免出现 重大的决策失误的过程。

我国学者张金马所说,“公共政策分析中成本—效 益分析就是针对各种备选方案的成本和它们达到特 定目标的有效性程度(即效益)进行比较。如果政 策成本与效益的货币价值可计算出来,那么最符合 需要的最有效的政策方案(包括非行动)就是那个可 提供最大纯效益(全部效益减去全部成本)的方案。”

一般说来,公共政策分析中成本—效益分析包括以 下三个步骤:

2.在公共政策信息转换分析模型中非常强调信息的作 用。在公共政策分析中,以下五种信息不容忽视。 (1)政策问题信息; (2)政策未来信息; (3)政策行动信息; (4)政策结果信息; (5)政策体系信息。

此外,公共政策信息转换分析模式还非常注重各种 政策信息之间的相互转化关系。

四、公共政策成本—效益分析模型

一、公共政策系统分析模型

(一)含义:公共政策系统分析,就是指根据公共政 策的系统特征,从公共政策的有机整体出发,着重 分析研究公共政策整体与部分、整体与层次、整体 与结构、整体与政策环境的相互作用和相互联系, 以求得优化的整体政策目标效应。

(二)根据系统的本质及其特征,可以将公共政策系 统分析的内容相对地划分为: 1.整体分析 2.环境分析 3.结构分析 4.层次分析 5.动态过程分析 6.反馈分析

三、公共政策世界大战之 后美国。

公共政策分析被普遍接受且得到迅速发展,是在20 世纪70年代至80年代。

Chap10_决策规则

由决策树直接生成推理规则集的具体操作

在流管理器Model选项卡中,鼠标右击C5.0模型结果,选择弹出菜 单中的Add to Stream项,将模型结果添加到数据流中。 鼠标右击数据流中的模型节点,选择弹出菜单中的Edit选项,选 择窗口主菜单Generate项下的Rule Set项,生成规则集 鼠标双击规则集节点,可浏览由决策树生成的规则集。

采用PRISM算法生成规则集

规则集生成时不对变量的重要性进行测度 利用PRISM算法得到的规则集与直接来自决策树的规则集存在一定 差异 规则集中的规则是经过精简处理的,正确率并非100%。括号中给 出的规则置信度是经过拉普拉斯调整后的结果

采用PRISM算法生成规则集的具体操作

选择Rule Set项 在流管理器的Model选项卡中,鼠标右击C5.0moxing,选择弹出菜 单的Browse项,浏览规则集

10.2 规则集的生成算法

生成规则集的一般算法是PRISM,该算法是一种覆盖算法,所生成的规则 在训练样本集上是100%正确的。 算法的基本思路:首先确定输出变量中的一个类别,称之为期望类别,然 后完成以下步骤: 在当前样本范围内(开始时为全部观测),寻找一条能最大限度覆盖 属于该类别样本的推理规则 在样本容量为M的样本范围内,按照正确覆盖率最大的原则确定附加 条件,得到一个再小些的样本范围。 从当前样本集中剔除已经被正确覆盖的样本,并检查剩余样本中是否 还有属于期望类别的样本。如果有则回到第一步,否则结束。

10.3 规则集的精简

精简过程基于测试样本集 对每条推理规则,找出它覆盖的测试集中的所有观测,暂时去掉 其中的一个逻辑与条件,计算正确覆盖率和误差率。如果误差率 低于原规则的误差率,则去掉相应的逻辑与条件。 继续暂时剔除其他的逻辑与条件,直到提出后的规则误差率高于 提出前的逻辑与条件。 查看已有被精简的推理规则是否有重复的规则,有则剔除。

自动训练(决策树)模型

⾃动训练(决策树)模型项⽬上要求给出⼀个可配置的类⾃动化的流程,下⾯根据⾃⼰的思考给出⾃动训练模型的部分。

决策树模型关键参数有两个:树深度和树棵数(模型训练中称为迭代次数,下称迭代次数)树深度树的深度如何决定,个⼈觉得:每棵树最好都能⽤到所有的特征,所以树深度跟特征数相关,对特征个数对2求对数,然后上取整即可# 通过特征个数计算决策树深度# 计算逻辑:把所有的特征都放到决策树的叶⼦节点⾄少需要深度为多少的⼆叉树tree_depth = math.ceil(math.log(num_of_features,2))下⾯做了⼀个验证这样选择树深度合理的实验特征个数:6,正样本:2903,计算得到树深度为3,最⼤迭代次数(看下⾯)为47先看树深度为2,3,4的评分结果:y是评分结果,t是train_fbeta,e是eval_fbeta树深度为2:树深度为3树深度为4:这个实验也证明这样选择树深度是⽐较合理的:树深度过⼩,模型不容易收敛,需要更⼤的迭代次数;树深度过⼤,模型容易过拟合,甚⾄可能在迭代次数为⼀的时候就已经过拟合。

对⽐树深度为2,3,4的结果,可以发现树深度为3的时候⽐较合理,没有⼀开始就过拟合,也不需要太⼤的迭代次数再能收敛。

迭代次数相对树深度来说,迭代次数不好确定,是本⽂的重点,下⾯详细给出⾃⼰的做法上下限下限⽐较容易,⾄少也得⽣成⼀⼀棵决策树,下限可以定为1,当然,如果你知道更⾼的下限,那就更好不过了上限可以根据经验来,详细见下⾯的注释。

# 通过样本数和特征数(树深度)计算最⼤的迭代次数# 计算逻辑是:每个特征需要多少个样本来⽀撑(这个需要根据样本本⾝和实践经验得到)# 这⾥我们使⽤正样本的数量来计算,根据经验,每个特征我们假设需要10个样本⽀撑(这个值可以根据不同的样本来选择)# 样本越多,样本越密集,每个特征需要⽀撑的样本数增加sustain_num = 10max_num_rounds= pos_num/(num_of_features*sustain_num)模型好坏模型本⾝好坏这⾥只研究⼆分类问题,对于给定的样本,模型的好坏还是有⽐较成熟的标准去判断,⽐较精度和召回率,fbeta值等等⼀般来说精度和召回率是此起彼伏的关系,所以⼀般⽤他们的加权值fbeta来衡量from sklearn import metrics# ⼆分类问题的fbeta,在这⾥作为衡量训练模型好坏的标准,⽽不是直接⽤精度和召回率def getFbeta(train_y,predict):# print set(train_y),set(predict)return metrics.fbeta_score(train_y, predict, 0.5,labels=[0,1])模型鲁棒性⼀般随着迭代次数的增加,模型趋向过拟合,也就是模型本⾝会过分拟合训练数据,导致可能在其他的样本集表现失常,从⽽使得模型鲁棒性差。

指导团队决策的决策树模型

指导团队决策的决策树模型1. 引言随着企业规模的不断扩大和竞争的加剧,团队决策变得越来越重要。

为了有效地指导团队决策并确保决策的可靠性和一致性,决策树模型被引入到团队决策中。

决策树模型是一种基于图的决策工具,通过生成分支和节点,帮助团队在复杂的决策情境中做出准确的决策。

2. 决策树模型的基本原理决策树模型基于一系列问题或决策来构建决策树,并通过树的分支来指导团队的决策过程。

决策树模型的基本原理包括:2.1 节点与分支决策树模型由节点和分支组成。

节点代表一个决策或问题,而分支代表团队决策的不同选项。

决策树模型根据问题的类型,可以分为三种节点类型:•根节点:起始节点,代表团队需要做出的第一个决策。

•中间节点:代表在决策过程中的中间步骤。

•叶节点:最终的决策结果。

2.2 决策树的生成决策树的生成是通过对问题空间的划分来实现的。

根据决策树模型的基本原理,一个决策树的生成可以通过以下步骤完成:1.选择一个合适的特征作为根节点。

2.对于每个根节点的取值,生成一个分支。

3.对每个分支进行递归的生成过程,直到生成叶节点。

2.3 决策树的评估与剪枝决策树的评估是指通过对决策树的各个分支进行评估,选择最佳的分支作为团队的决策。

决策树的剪枝是为了减少决策树的复杂性和提高准确性,通过删除一些不重要的分支来实现。

3. 决策树模型的应用决策树模型在团队决策中有广泛的应用,以下是一些常见的应用场景:3.1 项目管理决策在项目管理决策中,决策树模型可以根据不同的项目特征和需求,帮助团队选择最佳的项目方案、资源分配方案和进度安排方案。

3.2 人力资源决策在人力资源决策中,决策树模型可以根据员工的能力、经验、培训需求等因素,帮助团队进行招聘、晋升和绩效评估等决策。

3.3 营销策略决策在营销策略决策中,决策树模型可以根据市场需求、竞争情况和产品特征等因素,帮助团队选择最佳的市场定位、促销策略和产品定价等决策。

3.4 风险管理决策在风险管理决策中,决策树模型可以根据风险的概率和影响程度,帮助团队选择最佳的风险管理方案、应对措施和保险策略等决策。

第10章决策树模型

第10章决策树模型决策树模型是一种基于树形结构的分类与回归方法,常用于解决分类与回归问题。

决策树模型的主要目标是通过学习从输入变量到输出变量的映射规则,即从特征集合到目标变量的映射。

它通过一系列的判断和决策来实现对数据的分类或回归。

本章将介绍决策树模型的原理、构建过程以及常用的决策树算法。

决策树模型的思想是将决策过程建模成一个树形结构,每个内部节点表示一个判断条件,每个叶节点表示一个分类或回归结果。

决策树的构建过程包括特征选择、划分节点和剪枝三个方面。

特征选择决定了每个节点的判断条件,常用的特征选择准则有信息增益、信息增益比和基尼系数等。

划分节点是根据特征的取值将数据集划分成不同的子集,直到达到叶节点为止。

剪枝是为了避免过拟合,通过降低决策树的复杂度来提高模型的泛化性能。

常用的决策树算法有ID3、C4.5和CART三种。

ID3算法是最早的决策树算法,以信息增益作为特征选择准则。

C4.5算法在ID3算法的基础上进行了改进,以信息增益比作为特征选择准则,并且支持对连续型特征的处理。

CART算法是一种二叉决策树算法,以基尼系数作为特征选择准则,既可以进行分类问题,也可以进行回归问题。

决策树模型具有很多优点。

首先,决策树是一种易于理解和解释的模型,可以直观地表示分类规则。

其次,决策树可以处理多类型的特征、可以处理缺失值、可以自动进行特征选择和特征间的交互作用。

最后,决策树模型具有较好的泛化性能,并且在处理大数据集时具有较高的计算效率。

然而,决策树模型也存在一些缺点。

首先,决策树模型容易产生过拟合问题,特别是当训练集中的噪声较多时。

其次,决策树的构建过程是一个贪心算法,容易陷入局部最优解。

最后,决策树模型对于特征空间的划分相对粗糙,无法处理连续性特征变量。

为了克服决策树模型的缺点,研究人员提出了一些改进方法。

例如,集成学习方法通过组合多个决策树模型来提高泛化性能。

随机森林和梯度提升树是两个常用的集成学习方法。

数据挖掘与商务智能总结

第一章绪论什么是数据挖掘,什么是商业智能从大型数据库中提取有趣的(非平凡的、蕴涵的、先前未知的且是潜在有用的)信息或模式。

商业智能是要在必须的时间段内,把正确有用的信息传递给适当的决策者,以便为有效决策提供信息支持。

分类算法的评价标准召回率recall =系统检索到的相关文件数/相关文件总数准确率precision(查准率)= 系统检索到的相关文件数/系统返回的文件总数第二章数据仓库什么是数据仓库是运用新信息科技所提供的大量数据存储、分析能力,将以往无法深入整理分析的客户数据建立成为一个强大的顾客关系管理系统,以协助企业制定精准的运营决策。

数据仓库的基本特征1面向主题2整合性 3长期性 4稳定性第三章数据挖掘简介数据挖掘的一般功能1分类2估计3 预测4关联分类5聚类数据挖掘的完整步骤1理解数据与数据所代表的含义2获取相关知识与技术3整合与检查数据4取出错误或不一致的数据5建模与假设6数据挖掘运行7测试与验证所挖掘的数据8解释与使用数据数据挖掘建模的标准CRISP-CM跨行业数据挖掘的标准化过程第四章数据挖掘中的主要方法基于SQL Server 2005 SSAS的十种数据挖掘算法是什么1.决策树2.聚类3.Bayes分类4.有序规则5. 关联规则6.神经网络7.线性回归8. Logistic回归9. 时间序列10. 文本挖掘第五章数据挖掘与相关领域的关系数据挖掘与机器学习、统计分析之间的区别与联系(再看看书整理下)32页处理大量实际数据更具优势,并且使用数据挖掘工具无需具备专业的统计学背景。

数据分析的需求和趋势已经被许多大型数据库所实现,并且可以进行企业级别的数据挖掘应用。

相对于重视理论和方法的统计学而言,数据挖掘更强调应用,毕竟数据挖掘目的是方便企业用户的使用。

第六章SQL Server 2005中的商业智能商业智能(BI)的核心技术是什么数据仓库和数据挖掘第七章SQL Server 2005中的数据挖掘Microsoft SQL Server Management Studio提供了两个用于管理数据库项目(如脚本、查询、数据连接和文件)的容器是什么?1项目 2解决方案第八章SQL Server 2005的分析服务什么是UDM?统一维度模型第九章SQL Server 2005的报表服务什么是报表服务,其功能是一个基于服务器的完整平台,可创建、管理和交付传统报表和交互式报表。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

12

10.1 基本概念

• 决策树是同时提供分类与预测的常用方法。 • 决策树的数据分析方法是一种树形结构来表现数 据各变量影响程度的预测模型,利用树上各级结 点的分支自动确认和评估各个类别。

• 决策树能从一个或多个预测变量中,针对类别因 变量的选项,预测出个例的趋势变化关系等。也 可以由结果来反推原因。

• 如果不同分类的比例相差较大,以至于影响到分类数,那 么,可依据样本中的分类比例来估计先验概率

• 如果针对基本比例有着经验判断,便可以给予不同的基本 比例,并可将其归类为先验概率 • 如果设置相同的错误分类成本,并且不以分类的个体比例 作为权数,那么错误分类率是相同的

9

10.4 计算方法—选择分裂(分层)技术

7

10.4 计算方法—制定预测精确度的标准

• 决策树是要建立预测正确率最高的分类规则

• 预测精度的定义,一般包含了成本的概念• 来自本指的是个例被混合分类时的比例

8

10.4 计算方法—先验概率

• 如果研究中,各分类包含的个例数的比例相等或相近,或 各类中的个例数目相等或相近,就可以选择“相同先验概 率”

• 分层技术比较如表10-2所示

10

10.4 计算方法—定义停止分层的时点

• 在决策树模块中,提供两个选项可以控制停止分 裂(分层)的时间点: • (1)取小n(最终节点中所包含的个例数) • (2)设置对象的片段

11

10.4 计算方法—选择适当大小的决策树

• 在一般化的分割过程中,需要确定决策树的适当 规模 • 决策树模块可提供几种不同的选取适当大小的策 略,可择一或同时使用。如表10-3所示

5

10.2 决策树模型的建立

• 针对分类预测变量,计算以单变量分裂为基础的 二元决策树 • 针对顺序预测变量,计算以单变量分裂为基础的 二元决策树(至少为顺序尺度类型的变量) • 混合两类方式的预测变量计算以单变量分裂为基 础的二元决策树

6

10.3 决策树与判别函数的比较

• 决策树与判别函数的比较如表10-1所示

• 常用决策树的方法有CHAID以及CART

• CHAID(卡方自动交互检测法)决策树只限于处 理分类变量,如果是连续变量必须采用区段的方 式,先转换数据成为类别变量,才可以使用。

4

10.1 基本概念

• CHAID决策树的基本步骤如下: (1)对每个变量都计算其所有可能的分割点,并找出一 个最佳分割点。 (2)比较各预测变量在“最佳分割方式”下的组间方差, 然后找出一个组间方差最大的变量,即为最佳的预测变量。 (3)用最佳预测变量的最佳分割方式把原始数据分成两 组。 (4)将分割后的每一组作为样本,重复前述分割步骤。 (5)重复分割,直到所有变量都被用完为止。

2

10.1 基本概念

• 决策树是同时提供分类与预测的常用方法。通 过一系列的选择将数据分类,可由落入相同结 点的路径上的规则集来推测相同的结果。 • 决策树主要功能是由已知分类的个体来建立决 策树和相对应的决策规则。 • 与神经网络不同,决策树产生的决策规则可用 文字或数字来表达。

3

10.1 基本概念