基于Google与KL距离的概念相关度算法

KL散度,相似度计算以及相似度重要性

KL散度,相似度计算以及相似度重要性简介在推荐系统⾥,有些场景下是需要推荐相似商品,从⽽可以更好的挖掘⽤户⾏为并且提升⽤户体验。

这些情况下需要⼀些公式计算商品的相似度。

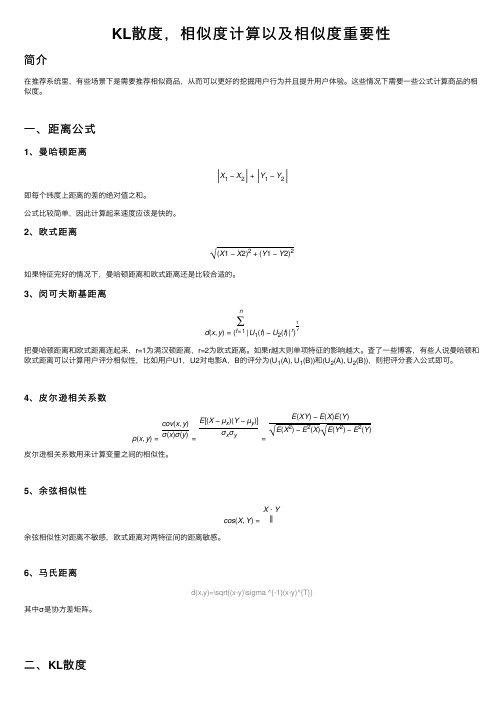

⼀、距离公式1、曼哈顿距离X1−X2+Y1−Y2即每个纬度上距离的差的绝对值之和。

公式⽐较简单,因此计算起来速度应该是快的。

2、欧式距离√(X1−X2)2+(Y1−Y2)2如果特征完好的情况下,曼哈顿距离和欧式距离还是⽐较合适的。

3、闵可夫斯基距离d(x,y)=(n ∑f=1|U1(f)−U2(f)|r)1 r把曼哈顿距离和欧式距离连起来,r=1为满汉顿距离,r=2为欧式距离。

如果r越⼤则单项特征的影响越⼤。

查了⼀些博客,有些⼈说曼哈顿和欧式距离可以计算⽤户评分相似性,⽐如⽤户U1,U2对电影A,B的评分为(U1(A), U1(B))和(U2(A), U2(B)),则把评分套⼊公式即可。

4、⽪尔逊相关系数ρ(x,y)=cov(x,y)σ(x)σ(y)=E[(X−µx)(Y−µy)]σxσy=E(XY)−E(X)E(Y)√E(X2)−E2(X)√E(Y2)−E2(Y)⽪尔逊相关系数⽤来计算变量之间的相似性。

5、余弦相似性cos(X,Y)=X⋅Y ‖余弦相似性对距离不敏感,欧式距离对两特征间的距离敏感。

6、马⽒距离d(x,y)=\sqrt{(x-y)\sigma ^{-1}(x-y)^{T}}其中σ是协⽅差矩阵。

⼆、KL散度||||1、量化两种分布P和Q可以使⽤KL散度来度量。

K-L散度能帮我们度量⼀个分布来近似另⼀个分布所使⽤的损失信息2、公式以及推导信息熵H=-\sum_{i=1}^{N}p(x_{i})\cdot log\ p(x_i)KL散度D_{KL}(p||q)=\sum_{i=1}^{N}p(x_{i})\cdot (log\ p(x_{i})-log\ q(x_{i}))根据上⾯公式可得,KL散度是近似分布和原始分布对数差的期望值另⼀种表⽰⽅法D_{KL}(p||q)=\sum_{i=1}^{N}p(x_{i})\cdot log\frac{p(x_{i})}{q(x_{i})}KL散度并⾮对称Dkl (Observed || Binomial) != Dkl (Binomial || Observed)三、相似度重要性加⼊相似度重要性的策略,这些策略的本质是⼀样的,当只有少量评分⽤于计算时,就会降低相似度重要性的权重1、公式\omega _{uv}=\frac{min(\left | I_{uv} \right |,\gamma )}{\gamma}*\gamma_{uv}Iuv为u和v⽤户共同评分的商品数,当I⼩⾬给定的参数r时,他们的相似度w会收到与I成⽐例的惩罚2、当能够根据常量的收缩权重的时候,可以使⽤公式\omega _{uv}=\frac{\left | \mu _{ij} \right |}{\left | \mu _{ij} \right |+\beta }\ast \omega _{ij} Loading [MathJax]/jax/element/mml/optable/GeneralPunctuation.js。

简述基于距离的分类算法

简述基于距离的分类算法一、引言基于距离的分类算法是机器学习中常用的一种分类方法,它通过计算不同样本之间的距离来确定样本之间的相似度,从而将它们分为不同的类别。

本文将从以下几个方面对基于距离的分类算法进行详细介绍。

二、基本概念1. 距离度量:在基于距离的分类算法中,需要定义不同样本之间的距离度量方法。

常用的方法有欧氏距离、曼哈顿距离、切比雪夫距离等。

2. 样本空间:指所有样本组成的空间,每个样本都可以看作该空间中一个点。

3. 样本特征:指每个样本所具有的特征或属性,如身高、体重等。

三、KNN算法KNN(K-Nearest Neighbor)算法是基于距离度量来进行分类和回归分析的一种非参数性统计方法。

它通过计算未知样本与已知样本之间的距离来找到最近邻居,并将未知样本归入与其最近邻居相同的类别中。

KNN算法具有简单易懂、效果好等优点,在实际应用中得到了广泛的应用。

四、K-means算法K-means算法是一种基于距离度量的聚类算法,它将样本空间划分为k个簇,每个簇包含距离最近的k个样本。

在算法开始时,需要随机选择k个样本作为初始中心点,然后计算所有样本与这些中心点之间的距离,并将每个样本归入距离最近的簇中。

接着重新计算每个簇的中心点,并重复以上步骤直到达到收敛条件。

K-means算法具有较高的效率和准确性,在数据挖掘和图像处理等领域得到了广泛应用。

五、DBSCAN算法DBSCAN(Density-Based Spatial Clustering of Applications with Noise)是一种基于密度的聚类算法。

它通过计算每个样本周围其他样本的密度来确定该样本所属于的簇,并将密度较小的点归为噪声点。

在DBSCAN算法中,需要定义两个参数:邻域半径和最小密度。

邻域半径表示一个点周围所包含其他点的最大距离,而最小密度表示一个簇所包含点数目的下限值。

DBSCAN算法具有处理复杂数据集、不受初始化影响等优点,在图像处理和数据挖掘等领域得到了广泛应用。

基于词关联度的语义相关度算法研究

Microcomputer Applications Vol. 27, No.3, 2011文章编号:100 7-757X(2011)03-0045-03开发应用微型电脑应用2011 年第 27 卷第 3 期基于词关联度的语义相关度算法研究张增杰,李晓城,刘鑫,夏勇明,钱松荣摘 要:如今网页排名算法很多,基本上可以分为两类:基于超链接和基于内容。

比较成熟的算法主要有 PageRank、HITS、 LSI 等。

本文基于向量空间模型以及信息论,提出一个与文章内容相关的语义相关度算法模型。

该模型将文章语义抽象为词 频表,并通过机器学习构建词语之间的关联度表,以此词关联度为基础,计算文章之间的相关度。

实验结果表明,文中提出 的相关度算法可以有效的根据文章之间语义相关度大小来进行排名。

关键 词: 词关 联度 ,语 义, 相关 度, 向量 模型 ,信 息量 ,概 率模 型 中图 法分 类号 :TP311 文献标志码:A 查询者。

PageRank 是由斯坦福大学的两位教授 Lary Page 和 Sergey 网页排名是 web 搜索中非常重要的一环。

现今社会发展 的一个重要方面就是信息技术的突飞猛进, 伴随而来的是信 息容量的爆炸式发展。

信息的种类也是纷繁复杂,书籍、论 文、 博客、论坛等各种应用极大的丰富了现代人的生活。

然 而, 日益成为一个非常有价值的研究问题是, 如何高效获取 这些有价值的、 符合我们需要的信息。

解开这个纷繁头绪的, 便是搜索引擎,它为我们提供了获取信息的接入点。

搜索引 擎收集网页的信息,建立索引库, 在用户输入查询的关键词 时,返回与关键词相关的信息。

返回的信息如何能够更好的 反映用户的需求,这就涉及到网页排名的问题。

现在对网页排名的算法有很多的研究,例如 P agerank、 HITS、LSI 等等。

总的来说,网页排名算法可以分为两类: 基于内容和非基于内容的, 这两者的主要区别是排名是否能 反 映网页文章的语义内容。

基于跨模态检索的效率优化算法

基于跨模态检索的效率优化算法徐明亮; 余肖生【期刊名称】《《计算机技术与发展》》【年(卷),期】2019(029)011【总页数】4页(P67-70)【关键词】跨模态检索; 语义鸿沟; 典型相关分析; 主成分分析; 子空间投影【作者】徐明亮; 余肖生【作者单位】三峡大学计算机与信息学院湖北宜昌 443002【正文语种】中文【中图分类】TP3010 引言随着互联网技术的不断发展变化,人们越来越注重于信息的交互。

人们对于信息的需求已从最初的单一新闻上的文字发展到后来的图片、视频、声音等。

在各种网络平台上,这些不同类型的数据相互交织,互为补充,且存在一定的关联。

同一信息可能以不同类型的数据呈现。

为了从不同类型的数据中同时找到表示同一信息的数据,跨模态信息检索技术应运而生。

传统的信息检索主要针对同类型的数据提取特征向量,对其进行相似度度量,根据相似度的排名来实现单模态的信息检索。

而跨模态信息检索则是建立不同模态的隐式关系模型,让不同模态能在同一空间下像单模态度量一样进行相似度度量,从而完成不同模态间的相互检索。

不同类型的模态数据,由于提取的特征向量的方式不同,导致在同一空间投影和匹配时工作量巨大。

针对传统的跨模态检索算法在处理高维度计算量巨大的问题,文中提出了一种跨模态信息检索的优化方法。

实验表明与原有算法相比,该方法在保证查准率基本不变的情况下,可以大幅减少原有算法的计算量,提高检索效率。

1 相关研究跨模态信息检索主要包括三个步骤:一是提取不同模态的特征信息来构建特征子空间;二是采用某种算法判断不同模态间特征子空间数据的关联性;三是在特征子空间下进行相似度度量,得出相应结果。

1.1 模态信息特征表达为了提取不同类型数据信息,需对原始数据进行特征提取,取出原有数据特征向量。

根据图像的特征表示,图像类型的特征可分为全局特征和局部特征两大类。

对全局特征而言,常用的提取结果主要有颜色直方图和纹理灰度矩阵;对局部特征,常用的处理结果主要有尺度不变特征,方向梯度直方图等。

K-L距离(相对熵)

KL距离,是Kullback-Leibler差异(Kullback-Leibler Divergence)的简称,也叫做相对熵(Relative Entropy)。

它衡量的是相同事件空间里的两个概率分布的差异情况。

其物理意义是:在相同事件空间里,概率分布P(x)的事件空间,若用概率分布Q(x)编码时,平均每个基本事件(符号)编码长度增加了多少比特。

我们用D(P||Q)表示KL距离,计算公式如下:当两个概率分布完全相同时,即P(x)=Q(X),其相对熵为0 。

我们知道,概率分布P(X)的信息熵为:其表示,概率分布P(x)编码时,平均每个基本事件(符号)至少需要多少比特编码。

通过信息熵的学习,我们知道不存在其他比按照本身概率分布更好的编码方式了,所以D(P||Q)始终大于等于0的。

虽然KL被称为距离,但是其不满足距离定义的三个条件:1)非负性;2)对称性(不满足);3)三角不等式(不满足)。

我们以一个例子来说明,KL距离的含义。

假如一个字符发射器,随机发出0和1两种字符,真实发出概率分布为A,但实际不知道A的具体分布。

现在通过观察,得到概率分布B与C。

各个分布的具体情况如下:A(0)=1/2,A(1)=1/2B(0)=1/4,B(1)=3/4C(0)=1/8,C(1)=7/8那么,我们可以计算出得到如下:也即,这两种方式来进行编码,其结果都使得平均编码长度增加了。

我们也可以看出,按照概率分布B进行编码,要比按照C进行编码,平均每个符号增加的比特数目少。

从分布上也可以看出,实际上B要比C更接近实际分布。

如果实际分布为C,而我们用A分布来编码这个字符发射器的每个字符,那么同样我们可以得到如下:再次,我们进一步验证了这样的结论:对一个信息源编码,按照其本身的概率分布进行编码,每个字符的平均比特数目最少。

这就是信息熵的概念,衡量了信息源本身的不确定性。

另外,可以看出KL距离不满足对称性,即D(P||Q)不一定等于D(Q||P)。

常见的距离算法和相似度(相关系数)计算方法

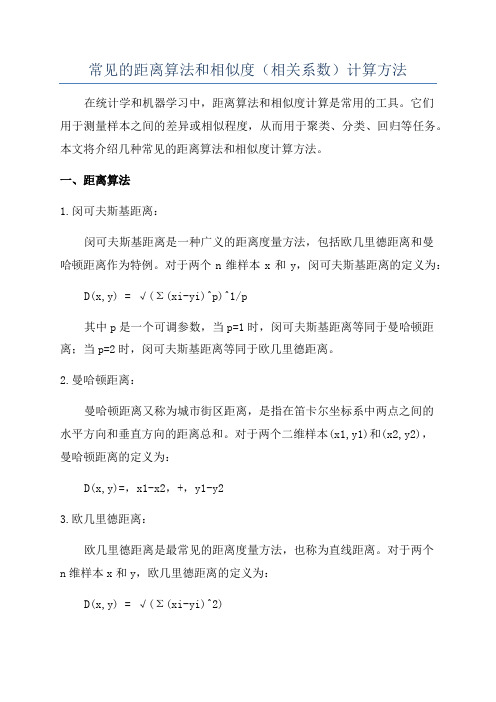

常见的距离算法和相似度(相关系数)计算方法在统计学和机器学习中,距离算法和相似度计算是常用的工具。

它们用于测量样本之间的差异或相似程度,从而用于聚类、分类、回归等任务。

本文将介绍几种常见的距离算法和相似度计算方法。

一、距离算法1.闵可夫斯基距离:闵可夫斯基距离是一种广义的距离度量方法,包括欧几里德距离和曼哈顿距离作为特例。

对于两个n维样本x和y,闵可夫斯基距离的定义为:D(x,y) = √(Σ(xi-yi)^p)^1/p其中p是一个可调参数,当p=1时,闵可夫斯基距离等同于曼哈顿距离;当p=2时,闵可夫斯基距离等同于欧几里德距离。

2.曼哈顿距离:曼哈顿距离又称为城市街区距离,是指在笛卡尔坐标系中两点之间的水平方向和垂直方向的距离总和。

对于两个二维样本(x1,y1)和(x2,y2),曼哈顿距离的定义为:D(x,y)=,x1-x2,+,y1-y23.欧几里德距离:欧几里德距离是最常见的距离度量方法,也称为直线距离。

对于两个n维样本x和y,欧几里德距离的定义为:D(x,y) = √(Σ(xi-yi)^2)4.切比雪夫距离:切比雪夫距离是指两个样本在每个维度上差值的最大绝对值。

对于两个n维样本x和y,切比雪夫距离的定义为:D(x,y) = max(,xi-yi,)5.杰卡德距离:杰卡德距离主要用于比较两个集合的相似度,特别适用于处理二元变量或稀疏数据。

对于两个集合A和B,杰卡德距离的定义为:D(A,B)=1-,A∩B,/,A∪B1.皮尔逊相关系数:皮尔逊相关系数是一种常用的方法,用于测量两个变量之间的线性关系程度。

对于两个n维向量x和y,皮尔逊相关系数的定义为:ρ(x,y) = Σ((xi-μx)(yi-μy))/(√(Σ(xi-μx)^2)√(Σ(yi-μy)^2))其中,μx和μy分别是向量x和y的均值。

2.余弦相似度:余弦相似度是一种常用的方法,用于测量两个向量之间的夹角余弦值。

对于两个n维向量x和y,余弦相似度的定义为:cosθ = (x·y)/(∥x∥∥y∥)其中,·表示向量的点积,∥x∥和∥y∥表示向量的模。

KL散度相似度计算以及相似度重要性

KL散度相似度计算以及相似度重要性KL散度(Kullback-Leibler divergence)是一种用来衡量两个概率分布之间差异性的指标。

在信息论和统计学中,KL散度被广泛应用于各种问题,例如模式识别、机器学习、信息检索等。

KL散度衡量的是两个概率分布P和Q之间的差异程度,记作Dkl(P,Q),其中P表示真实分布,Q表示近似分布。

KL散度的计算公式如下:Dkl(P,Q) = ΣP(i) * log(P(i)/Q(i))其中P(i)和Q(i)分别表示两个分布在第i个事件上的概率。

KL散度具有以下性质:1. 非负性:Dkl(P,Q) >= 0,当且仅当P和Q完全相同时取等号。

2. 不对称性:Dkl(P,Q) ≠ Dkl(Q,P),即KL散度的结果与P和Q 的顺序有关。

3.非度量性:KL散度并不满足三角不等式。

KL散度通常用于评估两个概率分布之间的差异程度,可以通过最小化KL散度的方法寻找近似分布。

在机器学习中,KL散度经常用于训练生成模型(如变分自编码器)和判别模型(如深度生成对抗网络),以及进行模型选择和参数估计等任务。

相似度计算是指衡量两个对象之间的相似程度的方法。

在数据挖掘和机器学习领域,相似度计算是一项重要的任务,常用于聚类、推荐系统、图像处理等应用中。

相似度计算的方法有很多种,常见的方法包括余弦相似度、欧氏距离、曼哈顿距离等。

以下是几种常用的相似度计算方法:1. 余弦相似度(Cosine Similarity):计算两个向量之间的余弦夹角,用来衡量它们在方向上的相似程度。

余弦相似度的范围在-1到1之间,值越接近1表示相似度越高。

2. 欧氏距离(Euclidean Distance):计算两个向量之间的欧氏距离,即各个维度差值的平方和的平方根。

欧氏距离越小表示相似度越高。

3. 曼哈顿距离(Manhattan Distance):计算两个向量之间的曼哈顿距离,即各个维度差值的绝对值之和。

结合编辑距离和Google距离的语义标注方法

外 , 网页进 行语义标 注后 , 用标注结果 对本体进行 有效扩 充, 对 利 使本体 更趋 于领域 化。 实验 结果表 明该 方法是

行之 有效 的。

关键 词 :语 义 网 ; 体 ; 义标 注 ; 辑 距 离 ;G o l 离 本 语 编 og e距

中圈分 类号 :T 3 1 P 9

核 心 的组 成 部 分 。Sue 等 人 在进 行 深 入 研究 之 后 , 出 了 t r d 给 本 体 的定 义 : 体 是 共 享 概 念 模 型 的 明确 的 形 式 化 规 范 说 明 。 本 这包 含 四层 含 义 , 概 念 模 型 (ocpulao ) 明 确 (x |— 即 cn taztn 、 i i epi c

色, 使其 可理解 We b上的信 息, We 使 b应用具有一定 的智能 ,

从而实现信息的 自动化 和智 能化处理 。在语义 网上 , 信息

通过 本 体 以 及与 本 体 一致 的元 数 据 以结 构 化 的 形式 描 述 , 定 并

在 B re .e 等人” 提 出的语 义 网模 型中 , enr Le s 本体层是 最

张玉 芳 , 东 梅 , 艾 黄 涛 , 忠 阳 熊

( 重庆大 学 计算机 学院 ,重庆 4 04 ) 0 0 4

摘 要 :提 出 了一种在领域 本体指导 下对网 页进 行语 义标 注 的方 法。该方 法利用编 辑距 离和 G ol 离从词 oge距

语 的语法和语 义两方 面综合 度量词 汇与本体概念之 间 的语 义相关度 , 从而在 网页与本体之 间建 立映射 关 系。此

o n o ain t k heo oo y g e ty c v rt o an k wld e T x e me a e u ts wsta hs meh d i i— fa n tto o ma e t ntlg r al o e he d m i no e g . he e p r ntlr s l ho h tt i t o ssg i nfc nl fe t e i a t ef ci . i y v K e r s: s ma i e y wo d e nt W b;o tlg c no o y; s ma tc a noain;e i dsa c e n i n t t o dt itn e;Go ge dit n e o l sa c

融合KL散度和移地距离的高斯混合模型相似性度量方法

融合KL散度和移地距离的高斯混合模型相似性度量方法余艳【摘要】为提高高斯混合模型(GMM)间相似性度量方法的计算效率和准确性,通过对称化KL散度(KLD)并结合移地距离(EMD)提出一种新的相似性度量方法.首先计算待比较的两个高斯混合模型内各高斯成分间的KL散度,对称化处理后用于构造地面距离矩阵;然后用线性规划方法求解两个高斯混合模型间的移地距离作为高斯混合模型间的相似性度量.实验结果表明,将该相似性度量方法应用于彩色图像检索,相对于传统方法能够提高检索的时间效率和准确性.【期刊名称】《计算机应用》【年(卷),期】2014(034)003【总页数】5页(P828-832)【关键词】图像检索;高斯混合模型;KL散度;移地距离;颜色空间分布【作者】余艳【作者单位】武汉科技大学理学院,武汉430065;华中科技大学计算机科学与技术学院,武汉430074【正文语种】中文【中图分类】TP391.413随着网络和计算机技术的发展,多媒体信息日益膨胀,基于人工标注的多媒体信息管理方法逐渐不能满足人们的需求,基于内容的多媒体信息检索则成为研究热点。

在基于内容的多媒体信息检索系统中,两个关键工作是多媒体信息的特征表达和特征间的相似性度量[1]。

高斯混合模型(Gaussian Mixture Model, GMM)是常用的多媒体信息表达方法,文献[1-5]使用GMM表达图像特征实现图像分类和图像检索;文献[6-8]使用GMM表达音频特征实现声音检索和音乐标注。

在使用GMM表达多媒体信息时,常用的相似性度量方法为KL散度(Kullback-Leibler Divergence, KLD)[9-10]。

使用KLD度量GMM间的相似性,由于没有闭合形式的求解表达式通常使用蒙特卡罗模拟法求解KLD,但蒙特卡罗模拟算法需要大量采样,因此该方法时间效率较低。

为解决GMM间KLD计算的时间效率问题,文献[1]提出了两种KLD的近似求解方法:基于匹配的KLD近似算法和基于无迹变换的KLD近似算法。

机器学习白皮书系列之二:无监督学习的方法介绍及金融领域应用实例

┃研究报告┃2017-11-27金融工程┃专题报告报告要点⏹无监督学习方法简介本篇报告将进行无监督学习方法的介绍。

无监督学习方法包括分布估计、因子分析、主成分分析、聚类分析、关联规则和Google PageRank算法等,本文主要就常用方法分成两类:聚类和降维进行介绍。

⏹降维方法的应用实践中,将降维思想运用得炉火纯青的是Barra风险模型。

个股和个券都有几十、上百个指标可以辅助分析其收益风险特征,通过降维的方式,Barra提取出若干具有代表性的风险因子,找出了资产背后共同驱动因素,使用这些风险因子即可方便的进行绩效归因、组合风险控制等。

降维的具体方法包括因子分析和主成分分析等。

本文通过因子分析和主成分分析两种方法,结合常见的股票基本面、财务数据、技术指标等,构建选股策略。

与基准相比,策略都能获取一定的超额收益,说明了通过降维提取主要特征能够起到一定的提纯和增强作用。

⏹聚类方法的应用聚类分析方法基于相似性概念将数据集再划分,形成较小的组,追求组别间差异尽量大而组内的差异尽量小。

根据样本数据特征和预期达到的效果,聚类可选择的方式非常多。

本文详细介绍了K-Means聚类分析的原理,并且对于几种常见的聚类分析算法:沃德层次聚类、综合层次聚类算法、聚集聚类算法、基于密度的聚类算法、AP聚类算法、谱聚类算法、小批量法等也一一进行简介。

在具体应用上,聚类分析可以用做选股前的预处理,通过重要特征将个股分类之后在每个类别中分别进行选股,效果会优于在全样本内选股。

此外,聚类分析的可视化也是重要的应用方式之一,通过热图或最小生成树的方式可以直观的描述资产间的相关性,帮助实现投资组合的风险分散。

⏹无监督学习方法的总结无监督学习相较于上篇的监督学习算法更偏向于数据分析和特征提取,在机器学习中属于算法比较简单基础的类型,因此很多时候容易被忽略,但是不得不强调监督学习及我们系列的下篇将会介绍的深度学习算法如若想要达到较好的效果都离不开对于原始数据分析和处理工作,提升算法的复杂度对于效果的边际提升效应会受到使用的数据本身的局限。

基于KL散度的ALS推荐算法

基于KL散度的ALS推荐算法作者:***来源:《电脑知识与技术》2022年第12期摘要:針对传统协同过滤推荐算法在稀疏数据上推荐准确度低的问题,提出一种基于KL 散度的ALS推荐算法KL-ALS。

传统ALS算法计算物品相似度时只考虑了用户之间的共同评分项,得到的相似性与真实值会有一定的误差,而采用KL散度计算物品相似度时,对用户评论的数量不做任何限制,不依赖于用户共同评分项。

KL-ALS算法首先将ALS算法计算物品相似度和KL散度计算的物品相似度按照一定权重混合,产生总体相似度,进而采用ALS算法训练模型,能够更加准确地度量物品间的相似度,改善推荐效果。

实验选取亚马逊智能产品评论数据集,与传统的基于ALS的协同过滤推荐算法和基于物品的协同过滤推荐算法(Item-CF)进行对比,实验结果表明KL-ALS推荐算法能有效提高推荐的准确度和性能。

关键词:KL散度;ALS算法;推荐算法;相似度;协同过滤中图分类号:TP399 文献标识码:A文章编号:1009-3044(2022)12-0004-03开放科学(资源服务)标识码(OSID):近几年来,网络中的数据呈现爆炸性增长的趋势,人们渐渐由信息缺乏时期进入了信息超载时期,存储、分析、处理这些数据往往需要利用大数据技术。

对于平台来说,如何使自己的产品信息在大量的信息中凸显出来,被用户所关注,正变成一个日益重要的问题。

而推荐系统[1]可以很好地解决这个问题,它可以将平台海量数据加以处理利用,以便用于预测用户的兴趣。

1 相关研究推荐系统通过分析数据源中用户对不同物品的评价和历史偏好之间的联系规律[2],帮助用户从网络中的大量信息中搜索现在和将来可能会喜欢的信息资源,从而进一步向用户提供相应的推荐服务。

而推荐算法是推荐系统中的核心部分,目前常用的推荐算法按照数据源不同可以分为基于人口统计学的推荐算法、基于内容的推荐算法和协同过滤推荐算法[3]。

基于人口统计学的推荐算法主要根据用户的身份信息的相似性进行推荐,例如:性别、年龄、职业等信息,这种推荐较为粗糙,精确度一般不高。

基于Google与KL距离的概念相关度算法

假设,通过测定两个词语在网络文本中的共发频率来测量词语之间的距离。

度量方式简单,容易推广,但假设过于简单,无法准确符合人类的认知。

Jianping Fan 等将Google 距离的思想用在图像标签上,提出了一种结合图像标签共现概率与W ordNet 的概念相关性度量方法,这种方法具有和Google 距离类似的度量方式简单,容易推广的特点,且图像标签的引入使算法考虑了图像的内容,但该算法的主要问题是标签不准确和数量少,难以得到准确的距离度量。

本文提出一种新的概念相关性度量算法,其基本思路是结合Google 与KL 距离作为概念文本相关性度量标准,解决了W ordNet 的词汇量和难以扩展问题。

2 概念相关性度量算法2.1 基于Google 距离的概念相关性度量Google 距离【3】通过测定两个词语在网络文本中的共现频率来测量词语之间的距离。

设要计算两个概念1C 和2C 的相Google 距离是基于W eb 词汇共现概率计算的,与W ordNet 的作用类似,可反映概念间的语义相关性,后面的实验也证明了用Google 距离测量的语义相关性和W ordNet 是基本吻合的。

由于W eb 具有词汇量大且能实时更新的特点,因此将Google 距离作为概念间语义相关性的测度可以有效地弥补W ordNet 在词汇量上的限制。

但是,与W ordNet 类似,Google 距离也存在由于特殊概念关系 (如同义、近义、一词多义)导致的相似性度量与图像内容不符的问题。

而且,W eb 上信息的杂乱性也会对相关性度量造成一定干扰。

为了提高基金项目:国家自然科学基金资助项目(61075014, 60875016);教育部博士点基金资助项目(20096102110025)作者简介:连 宇(1985-),男,硕士研究生,主研方向:图像处理,模式识别;彭进业,教授、博士生导师;谢红梅,副教授;冯晓毅,教授、博士生导师收稿日期:2010-0-0 E-mail :dongzhou399@网络出版时间:2011-2-12 14:01网络出版地址:/kcms/detail/31.1289.tp.20110212.1401.012.html2 计 算 机 工 程 2011年3月5日 概念相似性度量的有效性,有必要结合视觉信息来计算概念间相关性以弥补Google 距离所具有的这些缺点。

基于Google与KL距离的概念相关度算法

基于Google与KL距离的概念相关度算法连宇;彭进业;谢红梅;冯晓毅【期刊名称】《计算机工程》【年(卷),期】2011(037)019【摘要】WordNet在计算概念相关度时存在词汇量小、难以及时扩展更新以及同义、近义、一词多义等问题.为此,提出一种结合文本信息和图像视觉信息的概念相关度方法.利用Google距离和KL距离分别计算基于词语同现频率的概念相关度和基于视觉特征的概念相关度,并结合两者得到概念的总体相关度.实验结果验证了该方法的有效性.%For WordNet has its limitation of the vocabulary and promptly expansion, the problem of the synonym, near-synonym and polysemy, this paper proposes a new concept similarity measurement algorithm, which combines text and image vision information. Google distance is used to calculate the semantic distance between the concepts based on co-occurrence of the words. And the visual similarity is calculated. The whole similarity between the concepts is measured by combining them. Experimental results verify the validity of this algorithm.【总页数】3页(P291-292,封3)【作者】连宇;彭进业;谢红梅;冯晓毅【作者单位】西北工业大学电子信息学院,西安710129;西北工业大学电子信息学院,西安710129;西北工业大学电子信息学院,西安710129;西北工业大学电子信息学院,西安710129【正文语种】中文【中图分类】TP301.6【相关文献】1.基于KL距离的异类传感器动态数据关联算法 [J], 吕丽平;白鑫;张玉宏2.基于KL距离的KPCA人脸识别算法 [J], 王春芳;高煜妤3.基于KL散度和近邻点间距离的球面嵌入算法 [J], 张变兰;路永钢;张海涛4.基于KL距离的交互式动态影响图近似算法 [J], 田乐;罗键;曹浪财;陈志平5.基于双向KL距离聚类算法的变压器状态异常检测 [J], 林越;刘廷章;黄莉荣;奚晓晔;潘建因版权原因,仅展示原文概要,查看原文内容请购买。

kl距离公式

kl距离公式KL距离公式是一种用于度量两个概率分布之间的差异程度的方法。

KL距离公式来源于信息论,被广泛应用于机器学习和数据挖掘领域。

KL距离公式的全称是Kullback-Leibler距离公式,又称为相对熵。

它由Kullback和Leibler在20世纪50年代提出,用于度量两个概率分布P和Q之间的差异程度。

KL距离公式的计算方法如下:KL(P||Q) = Σ(P(x) * log(P(x)/Q(x)))其中,P(x)和Q(x)分别表示两个概率分布P和Q在样本点x上的概率值。

log表示以2为底的对数。

Σ表示对所有样本点x求和。

KL距离公式的计算结果是一个非负的值,当且仅当P和Q完全相同的时候,KL距离等于0。

当P和Q之间的差异越大时,KL距离的值越大。

KL距离公式的应用非常广泛。

在机器学习领域,KL距离常用于度量两个概率分布之间的相似度或差异度。

例如,在聚类算法中,可以使用KL距离来度量不同样本之间的相似度,从而将相似的样本聚集在一起。

在图像处理领域,KL距离可以用于图像检索和图像分类等任务中。

KL距离还有一些重要的性质和应用。

首先,KL距离是非对称的,即KL(P||Q) ≠ KL(Q||P)。

这意味着P和Q之间的差异程度可能与Q和P之间的差异程度不同。

其次,KL距离是一种度量,它满足三角不等式,即KL(P||Q) + KL(Q||R) ≥ KL(P||R)。

这意味着KL距离可以用于构建距离度量空间,从而可以应用于各种机器学习算法中。

总结起来,KL距离公式是一种用于度量两个概率分布之间差异程度的方法。

它在机器学习和数据挖掘领域具有重要的应用价值。

通过计算KL距离,我们可以量化不同概率分布之间的差异,从而为各种机器学习任务提供支持。

kl邻近算法 -回复

kl邻近算法-回复“kl邻近算法”是一种基于信息论的非监督学习算法,它被广泛应用于模式识别、数据聚类和异常检测等领域。

本文将详细介绍kl邻近算法的原理、应用和优缺点等内容,并逐步回答相关问题。

第一步:kl邻近算法简介(150-250字)kl邻近算法是一种非常有实用价值的聚类算法,它基于信息论的原理,通过计算两个概率分布之间的KL距离来度量它们之间的差异。

kl邻近算法的核心思想是,相似的样本数据具有相似的概率分布。

算法首先将输入的样本数据表示为一个概率分布,然后对这些分布进行聚类,寻找具有相似概率分布的样本集合。

第二步:kl邻近算法的原理(300-500字)kl邻近算法的原理可以分为两个阶段:概率分布表示和聚类分析。

1. 概率分布表示:kl邻近算法将样本数据表示为概率分布。

对于一个样本集合,可以用每个样本的特征向量作为输入数据。

然后,根据特定的概率分布模型(如高斯分布)对样本的概率分布进行估计。

这种表示方式可以更好地描述样本之间的相似性,同时也便于进行概率分析。

2. 聚类分析:kl邻近算法通过计算两个概率分布之间的KL距离来度量它们之间的差异。

KL距离是一种用于衡量两个概率分布之间差异的指标,它被广泛用于信息论和统计学中。

kl邻近算法通过计算每对概率分布之间的KL距离,可以得到一个距离矩阵。

然后,算法根据距离矩阵来进行样本聚类,将具有相似概率分布的样本分到同一个簇中。

第三步:kl邻近算法的应用(500-750字)kl邻近算法在许多领域都有着广泛的应用,下面介绍它在模式识别、数据聚类和异常检测等方面的具体应用。

1. 模式识别:kl邻近算法可以用于模式识别任务,例如图像分类和人脸识别。

在这些任务中,算法可以通过比较样本之间的概率分布来判断它们的相似度。

将相似的样本聚类在一起,可以更好地进行模式分类和识别。

2. 数据聚类:kl邻近算法是一种非监督学习算法,适用于无标签的数据聚类任务。

算法通过计算概率分布之间的KL距离,将具有相似概率分布的样本聚类在一起。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

假设,通过测定两个词语在网络文本中的共发频率来测量词语之间的距离。

度量方式简单,容易推广,但假设过于简单,无法准确符合人类的认知。

Jianping Fan 等将Google 距离的思想用在图像标签上,提出了一种结合图像标签共现概率与W ordNet 的概念相关性度量方法,这种方法具有和Google 距离类似的度量方式简单,容易推广的特点,且图像标签的引入使算法考虑了图像的内容,但该算法的主要问题是标签不准确和数量少,难以得到准确的距离度量。

本文提出一种新的概念相关性度量算法,其基本思路是结合Google 与KL 距离作为概念文本相关性度量标准,解决了W ordNet 的词汇量和难以扩展问题。

2 概念相关性度量算法

2.1 基于Google 距离的概念相关性度量

Google 距离【3】通过测定两个词语在网络文本中的共现频率来测量词语之间的距离。

设要计算两个概念1C 和2C 的相Google 距离是基于W eb 词汇共现概率计算的,与W ordNet 的作用类似,可反映概念间的语义相关性,后面的实验也证明了用Google 距离测量的语义相关性和W ordNet 是基本吻合的。

由于W eb 具有词汇量大且能实时更新的特点,因此将Google 距离作为概念间语义相关性的测度可以有效地弥补W ordNet 在词汇量上的限制。

但是,与W ordNet 类似,Google 距离也存在由于特殊概念关系 (如同义、近义、一词多义)导致的相似性度量与图像内容不符的问题。

而且,W eb 上信息的杂乱性也会对相关性度量造成一定干扰。

为了提高

基金项目:国家自然科学基金资助项目(61075014, 60875016);教育部博士点基金资助项目(20096102110025)

作者简介:连 宇(1985-),男,硕士研究生,主研方向:图像处理,模式识别;彭进业,教授、博士生导师;谢红梅,副教授;冯晓毅,教授、博士生导师

收稿日期:2010-0-0 E-mail :dongzhou399@

网络出版时间:2011-2-12 14:01

网络出版地址:/kcms/detail/31.1289.tp.20110212.1401.012.html

2 计 算 机 工 程 2011年3月5日 概念相似性度量的有效性,有必要结合视觉信息来计算概念间相关性以弥补Google 距离所具有的这些缺点。

2.2 基于KL 距离的概念相关性度量

视觉语言建模【4】基于统计学和概率论理论对视觉语言进行建模,通过对相邻图像块特征之间的空间依赖性进行分析,捕获视觉语言中的规律和特性,包括图像分割、特征提取、Hash 码转化和视觉语言模型训练四个步骤。

对两个概念分别进行建模后,再计算其KL 距离。

KL 距离是基于图像内容计算得到的,能反映两个概念对应图像内容之间的相关程度。

概念间视觉相似度算法流程可描述为如图1所示。

Hash

Hash

KL

视觉相关度算法流程在视觉语言模型训练中设定了以下假设【4】:视觉单词仅与其左边和上边的单词相关联。

在视觉语言文档中,单词是以Hash 码矩阵的形式存在的,三个单词形成一个三元模型

1,,1,,i j i j ij w w w −−〈〉。

视觉单词矩阵如图2所示。

00010203101112132021222330313233 w w w w w w w w w w w w w w w w ⎡⎤⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎣

⎦ 图2 视觉单词矩阵

三元模型的训练过程用下式表示:

1,,11,,11,,1()(,,)()

i j i j ij ij i j i j i j i j Count w w w C p w w w C Count w w C −−−−−−=

(3)

在训练过程中,难免会出现因数据稀疏引起的零概率问题。

为了解决此问题,采用回退(back-off)和打折

(discounting)相结合的数据平滑【5】方法处理。

2.2.5 KL 距离

KL 距离定义如下【6】:

1

2

1

2

2

1

12()

()

(,)()lg

()lg

()

()

C C KL C C l

l

C C P l P l

D C C P l P l P l P l =+∑∑ (4)

这里1

()C P l 和2

()C P l 对应的是在两个分布下第l 个三元模型的概率密度。

2.3 概念相关度

根据所得到的Google 距离与KL 距离,我们定义概念相关度12(,)Sim C C 为:

(,)

(,)

D

C C D

C C 图3 算法流程表1为部分概念列表。

irport

ast

hway

ark

b irds

do g

mou ntain

s ky

b mw

flo wer nig htfall

t rees

c ity

fo otball

oce an

…

对应每个概念词从MIT 的LabelMe 图像数据库

(/)中选取200幅典型代表性图像作为提取视觉信息的样本库。

下面对上述三类概念词汇分别进行实验,以验证本文算法的有效性。

3.2 普通概念词汇的比较实验

对选取的50对普通概念词汇,分别采用W&P 算法与本文算法计算概念1和概念2之间的相关性并比较它们的接近

程度。

Wu&Plamer 算法是基于W ordNet 路径的典型的概念相似度测量方法,被广大学者广泛采用,其相似度归一化为0到1之间,方便我们用于比较实验。

限于篇幅,选取部分数据罗列,如表2所示。

概念1 概念2 W&P 算法 本文算法 bird woodland 0.4706 0.4578 coast forest 0.6154 0.6223 mountain shore 0.7692 0.7367 forest park 0.6667 0.5899 …

…

…

…

我们通过相关系数r 来比较两种算法的接近程度。

如式(6)所示:

图4 特殊关系概念的相似度比较

我们定义一个相关性结果与主观判断结果的兼容率

Compat 为:

11(1)N

i i i i

Sim Subject Compat N Subject =−=−∑ (7)

其中,N 为所选概念对数目,i 表示概念对的序号,i Sim 与

i Subject 分别为所选算法与主观判断所得到的概念相关度。

根据式(7)与所得数据,我们得到Wu&Plamer 相似度与主观判断的兼容率为59.54%,而本文算法与主观判断的兼容率为87.37%。

可见,本文算法度量特殊关系概念的相关度与主观判断的结果较为吻合,较Wu&Plamer 结果更为客观。

3.4 非W ordNet 概念词汇的相关性度量

将20对非W ordNet 概念添加到实验所用的概念库中,利用本文算法进行概念相关度计算,同时对其进行主观打分。

部分实验结果如表3所示。

表中bmw 、nba 等是互联网中经常出现但在W ordNet 中不存在的概念。

Sim 表示采用本文算法所得到的相关度,Subject 表示主观判断的均值。

概念1 概念2 度 分 bmw car 0.6835 0.7230 Compat 为词汇的度量Personalized

large-scale Circuits and IEEE

2007, international New

data for the

language model component of a speech recognizer[J]. IEEE Transactions on Acoustics, Speech and Signal Processing, 1987, 35(3):400-401.

[6] Wu Suyan, Guo Qiao. Kullback-Leibler distance based concepts

mapping between web ontologies[J]. Journal of Southeast University, 2007, 123(3):385-388.。