大数据导论思维第11章 分布式图计算框架SPARK GRAPHX

大数据知识点总结

大数据知识点总结原始数据要经过一连串收集、提取、清洗、整理等等的预处理过程,才能形成高质量的数据;按照自己的需要,比如要对数据贴标签分类,或者预测,或者想要从大量复杂的数据中提取有价值的且不易发现的信息,下面由为您整理出的大数据知识点总结内容,一起来看看吧。

1、Hadoop是一个由Apache基金会所开发的分布式系统基础架构。

用户可以在不了解分布式底层细节的情况下,开发分布式程序。

充分利用集群的威力进行高速运算和存储。

2、Hadoop实现了一个分布式文件系统(Hadoop Distributed File System),简称HDFS。

HDFS有高容错性的特点,并且设计用来部署在低廉的(low-cost)硬件上;而且它提供高吞吐量(high throughput)来访问应用程序的数据,适合那些有着超大数据集(large data set)的应用程序。

HDFS放宽了(relax)POSIX的要求,可以以流的形式访问(streaming access)文件系统中的数据。

3、Hadoop的框架最核心的设计就是:HDFS和MapReduce。

HDFS为海量的数据提供了存储,则MapReduce为海量的数据提供了计算。

4、Hadoop它主要有以下几个优点:(a)高可靠性。

Hadoop按位存储和处理数据的能力值得人们信赖。

(b)高扩展性。

Hadoop是在可用的计算机集簇间分配数据并完成计算任务的,这些集簇可以方便地扩展到数以千计的节点中。

(c)高效性。

Hadoop能够在节点之间动态地移动数据,并保证各个节点的动态平衡,因此处理速度非常快。

(d)高容错性。

Hadoop能够自动保存数据的多个副本,并且能够自动将失败的任务重新分配。

(e)低成本。

与一体机、商用数据仓库以及QlikView、Yonghong Z-Suite等数据集市相比,hadoop是开源的,项目的软件成本因此会大大降低。

5、HDFS对外部客户机而言,HDFS就像一个传统的分级文件系统。

Spark图计算GraphX介绍及实例

Spark图计算GraphX介绍及实例1、GraphX介绍1.1 GraphX应⽤背景Spark GraphX是⼀个分布式图处理框架,它是基于Spark平台提供对图计算和图挖掘简洁易⽤的⽽丰富的接⼝,极⼤的⽅便了对分布式图处理的需求。

众所周知·,社交⽹络中⼈与⼈之间有很多关系链,例如Twitter、Facebook、微博和微信等,这些都是⼤数据产⽣的地⽅都需要图计算,现在的图处理基本都是分布式的图处理,⽽并⾮单机处理。

Spark GraphX由于底层是基于Spark来处理的,所以天然就是⼀个分布式的图处理系统。

图的分布式或者并⾏处理其实是把图拆分成很多的⼦图,然后分别对这些⼦图进⾏计算,计算的时候可以分别迭代进⾏分阶段的计算,即对图进⾏并⾏计算。

下⾯我们看⼀下图计算的简单⽰例:从图中我们可以看出:拿到Wikipedia的⽂档以后,可以变成Link Table形式的视图,然后基于Link Table形式的视图可以分析成Hyperlinks超链接,最后我们可以使⽤PageRank去分析得出Top Communities。

在下⾯路径中的Editor Graph到Community,这个过程可以称之为Triangle Computation,这是计算三⾓形的⼀个算法,基于此会发现⼀个社区。

从上⾯的分析中我们可以发现图计算有很多的做法和算法,同时也发现图和表格可以做互相的转换。

1.2 GraphX的框架设计GraphX时,点分割和GAS都已成熟,在设计和编码中针对它们进⾏了优化,并在功能和性能之间寻找最佳的平衡点。

如同Spark本⾝,每个⼦模块都有⼀个核⼼抽象。

GraphX的核⼼抽象是Resilient Distributed Property Graph,⼀种点和边都带属性的有向多重图。

它扩展了Spark RDD的抽象,有Table和Graph两种视图,⽽只需要⼀份物理存储。

两种视图都有⾃⼰独有的操作符,从⽽获得了灵活操作和执⾏效率。

学会使用ApacheSpark进行大数据分析和处理的基本操作

学会使用ApacheSpark进行大数据分析和处理的基本操作Apache Spark是一个快速、通用、可扩展的大数据处理引擎,被广泛应用于大数据分析和处理中。

学会使用Apache Spark进行大数据分析和处理的基本操作,对于数据科学家和大数据工程师来说至关重要。

本文将介绍Apache Spark的基本概念和操作,包括数据加载、转换、过滤、聚合以及输出等,以帮助读者快速上手使用Apache Spark进行大数据分析和处理。

第一章:Apache Spark简介与安装Apache Spark是一款开源的大数据处理框架,提供了高效的分布式计算能力,可以处理大规模的数据集。

在使用Apache Spark 之前,我们需要先安装Spark并配置好相应的环境。

具体的安装过程可以在Apache Spark官方网站上找到,并根据操作系统类型和版本进行安装、设置和配置。

第二章:数据加载与存储在使用Apache Spark进行大数据分析和处理之前,我们需要先将数据加载到Spark中。

Spark支持多种数据源和格式,如文本文件、CSV文件、JSON文件、数据库等。

可以使用Spark的API或工具(如spark-submit或spark-shell)来加载和读取数据。

除了加载数据,我们还可以将结果保存到各种外部存储介质中,如HDFS、S3或关系型数据库等。

第三章:数据转换与过滤在数据分析和处理过程中,常常需要对数据进行转换和过滤以满足需求。

Apache Spark提供了丰富的转换和过滤操作,如映射、过滤、排序、去重等。

通过这些操作,我们可以对数据集进行加工和处理,以便于后续的分析和挖掘。

第四章:数据聚合与计算数据聚合是大数据处理中常见的操作之一,Apache Spark提供了多种聚合和计算函数,如求和、平均值、最大值、最小值、统计等。

通过这些函数,我们可以对数据集进行统计和计算,以获取更有价值的信息。

此外,Spark还支持自定义聚合函数和窗口函数,可以满足更加复杂的需求。

云计算与大数据技术知到章节答案智慧树2023年北京联合大学

云计算与大数据技术知到章节测试答案智慧树2023年最新北京联合大学绪论单元测试1.下列哪些应用属于大数据技术的应用()。

参考答案:音视频网站上通过分析注册用户的浏览习惯,为用户推送感兴趣的音视频。

;手机银行或网上银行在用户画像基础上,对用户群进行定位,挖掘潜在金融服务需求。

;政务领域中的智慧城市建设,如智慧交通、智慧医疗、智慧教育等。

;电商网站上对注册用户浏览信息记录、分析、挖掘,为用户推送感兴趣的商品。

2.日常我们用到的云服务器、钉钉办公软件、百度网盘等应用都是云计算服务厂商提供的云计算服务。

()参考答案:对第一章测试1.云计算的服务模式包括()。

参考答案:平台即服务;软件即服务;基础设施即服务2.云计算的劣势有()。

参考答案:风险被集中;数据泄密的环节增多;严重依赖网络3.云计算部署模型有()。

参考答案:公有云;私有云;混合云4.云计算是把有形的产品(网络设备、服务器、存储设备、各种软件等)转化为服务产品(IaaS,PaaS,SaaS),并通过网络让人们远程在线使用。

()参考答案:对5.云计算是一种计算模式,能够提供随时随地、便捷的、随需应变的网络接入,访问可配置的计算资源共享池。

()参考答案:对第二章测试1.虚拟化技术主要用于云计算物理资源的池化,物理资源不包括()。

参考答案:操作系统2.虚拟技术特性有()。

参考答案:隔离;封装;分区;相对于硬件独立3.虚拟化的益处包括()。

参考答案:实现节能减排;实现动态负载均衡;实现资源最优利用;通过系统自愈功能提升可靠性4.个人PC上使用比较多的虚拟化工具有()。

参考答案:Virtual Box;VMware Workstation5.虚拟化是一项技术,而云是一种环境或服务。

()参考答案:对6.虚拟化的主要功能是把单个资源抽象成多个给用户使用,而云计算则是帮助不同部门或公司访问一个自动置备的资源池。

()参考答案:对第三章测试1.开放系统的存储类型分为内置存储和外挂存储,其中外挂存储可分为()。

Spark大数据处理框架入门与实践

Spark大数据处理框架入门与实践概述Spark是现今最流行的大数据处理框架之一,它可以处理多种类型的数据,包括结构化数据、半结构化数据、非结构化数据、日志数据等。

本文将介绍Spark的基本概念与使用方法,并通过实际案例帮助读者快速掌握Spark大数据处理框架。

Spark的基本概念Spark是一种基于内存的分布式计算框架,可以将数据分布在多个节点上进行计算,从而提高计算效率。

Spark的核心理念是弹性分布式数据集(Resilient Distributed Dataset,简称RDD),它是一种分布式的元素集合,通过分布式群集实现高效计算。

RDD 分为两种类型:Spark的高级API中,基于RDD构建的应用程序称为Spark Core。

Spark的优势Speed:Spark使用内存计算,因此速度要比Hadoop快。

Ease of Use:Spark的API非常友好,许多用户花费很短的时间在上手Spark上。

Unified Engine:Spark的统一计算引擎可以处理多个任务,包括批量处理、流处理等。

Real-time stream processing:Spark有流计算框架Spark Streaming,可以进行流处理。

安装Spark安装Java环境下载Spark启动SparkSpark的实践在下面的实践中,我们将从实际的案例开始使用Spark构建项目。

案例描述我们将使用Spark来分析一份数据,该数据是储格拉斯选举数据,包括每个区域的投票情况和每个候选人得票情况。

步骤1:数据探索我们先下载数据并使用Spark来分析。

下载数据分析数据在Spark中,数据可以从多种来源读取,例如HDFS、S3、HTTP等。

对于我们的数据,我们可以使用以下代码从文件中读取。

在将数据读取到Spark中之后,我们可以使用一些API来处理数据。

下面是一些示例代码,用于清理数据并返回有关储格拉斯选举的一些统计信息。

步骤2:数据处理在数据探索之后,我们需要进一步处理数据。

Spark介绍

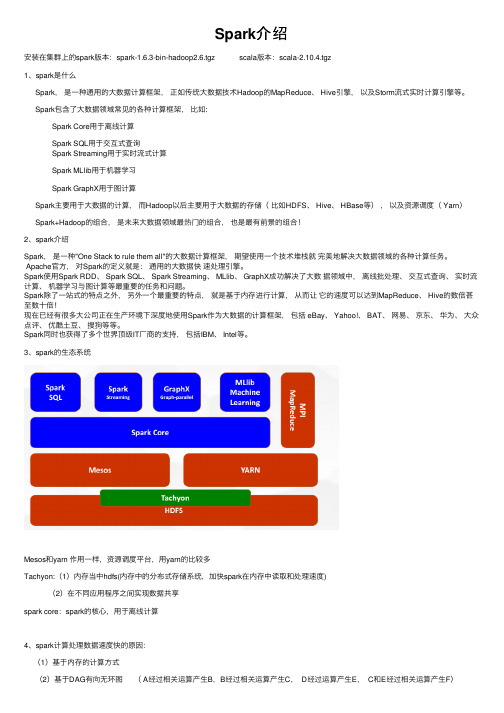

Spark介绍安装在集群上的spark版本:spark-1.6.3-bin-hadoop2.6.tgz scala版本:scala-2.10.4.tgz1、spark是什么Spark,是⼀种通⽤的⼤数据计算框架,正如传统⼤数据技术Hadoop的MapReduce、 Hive引擎,以及Storm流式实时计算引擎等。

Spark包含了⼤数据领域常见的各种计算框架,⽐如:Spark Core⽤于离线计算Spark SQL⽤于交互式查询Spark Streaming⽤于实时流式计算Spark MLlib⽤于机器学习Spark GraphX⽤于图计算Spark主要⽤于⼤数据的计算,⽽Hadoop以后主要⽤于⼤数据的存储(⽐如HDFS、 Hive、 HBase等),以及资源调度( Yarn)Spark+Hadoop的组合,是未来⼤数据领域最热门的组合,也是最有前景的组合!2、spark介绍Spark,是⼀种"One Stack to rule them all"的⼤数据计算框架,期望使⽤⼀个技术堆栈就完美地解决⼤数据领域的各种计算任务。

Apache官⽅,对Spark的定义就是:通⽤的⼤数据快速处理引擎。

Spark使⽤Spark RDD、 Spark SQL、 Spark Streaming、 MLlib、 GraphX成功解决了⼤数据领域中,离线批处理、交互式查询、实时流计算、机器学习与图计算等最重要的任务和问题。

Spark除了⼀站式的特点之外,另外⼀个最重要的特点,就是基于内存进⾏计算,从⽽让它的速度可以达到MapReduce、 Hive的数倍甚⾄数⼗倍!现在已经有很多⼤公司正在⽣产环境下深度地使⽤Spark作为⼤数据的计算框架,包括 eBay、 Yahoo!、 BAT、⽹易、京东、华为、⼤众点评、优酷⼟⾖、搜狗等等。

Spark同时也获得了多个世界顶级IT⼚商的⽀持,包括IBM、 Intel等。

大数据试题及答案

大数据试题及答案大数据试题及答案第一章:概述⑴什么是大数据?大数据是指规模巨大、复杂多样的数据集合,无法通过传统的数据处理工具进行处理与分析。

⑵大数据的特点有哪些?- 体量大:大数据的规模通常以TB、PB、EB等级进行衡量。

- 多样性:大数据包含结构化数据、半结构化数据和非结构化数据。

- 时效性:大数据的产生和更新速度很快。

- 高速性:大数据的处理需要高速的数据存储和计算能力。

⑶大数据的应用领域有哪些?- 金融行业:大数据可以用于风险控制、反欺诈、客户细分等。

- 零售行业:大数据可以用于商品推荐、库存管理、营销策略等。

- 医疗行业:大数据可以用于疾病诊断、药物研发、患者管理等。

第二章:大数据技术⑴大数据的存储技术- 分布式文件系统:HDFS、Ceph等。

- NoSQL数据库:Redis、MongoDB等。

- 列存储数据库:HBase、Cassandra等。

⑵大数据的计算技术- 分布式计算框架:MapReduce、Spark、Flink等。

- 流式计算框架:Storm、Kafka等。

- 图计算框架:GraphX、Giraph等。

⑶大数据的处理技术- 数据清洗与预处理:数据过滤、去重、缺失值处理等。

- 数据挖掘与分析:关联规则挖掘、聚类分析、预测建模等。

- 可视化与报表:数据可视化工具、报表工具等。

第三章:大数据分析⑴数据采集与清洗- 数据采集:从各种数据源中提取数据,如数据库、日志文件、网络爬虫等。

- 数据清洗:对采集到的数据进行去噪、去重、格式化等处理。

⑵数据存储与管理- 数据存储:将清洗后的数据存储到相应的存储系统中,如HDFS、数据库等。

- 数据管理:对存储的数据进行分类、索引、备份等管理。

⑶数据分析与挖掘- 数据预处理:对存储的数据进行特征选择、降维、标准化等处理。

- 数据建模:通过机器学习算法构建预测模型或分类模型。

- 数据评估:对建模结果进行评估和优化。

第四章:大数据应用案例⑴网络广告推荐系统⑵金融风控系统⑶物流运输优化系统第五章:附件本文档所涉及的附件包括示例代码、数据集、技术文档等,请参考附件部分的内容。

Spark大数据技术原理与实践

HDFS

HDFS

read iter. 1 write

Input

HDFS read

Input

DataSharinginSpark

太慢,冗余读写、序列化、磁盘IO

HDFS

HDFS

read iter. 2 write

.. .

query 1

result 1

query 2

result 2

query 3 .. .

result 3

10-100x快于网络和磁盘

iter. 1

iter. 2

.. .

Input

one-time processing

Input

Distributed memory

query 1 query 2 query 3

.. .

Spark 核心概念-- RDDs

7

• 弹性分布式数据集(ResilientDistributed Datasets)

重复使用。

– A distributed memory abstraction that letsprogrammers perform

in-memory computations on large clusters – 只读的,可分区的分布式数据集 – 只能直接通过操作符来创建和处理 – 支持容错处理

• R D D 操作:

据栈的基础组件;

• 做什么

– 数据处理( Data Processing): 可以用来快速处理数 据,兼具容错性和可扩展性。

– 迭代计算( Iterative Computation):支持迭代计算, 有效应对多步的数据处理逻辑。

– 数据挖掘( Data Mining):在海量数据基础上进行复 杂的挖掘分析,可支持各种数据挖掘和机器学习算法。

Spark的应用与实现

Spark的应用与实现Spark的应用与实现Spark是一个开源的通用的大数据处理框架,如果用三个词来形容它,那么就是快、强大和灵活。

Spark支持多种语言,包括Java、Scala、Python等。

作为Hadoop生态系统中的一部分,Spark可以与Hadoop、Hive、HBase等其他技术进行整合,实现更加多样化的数据处理解决方案。

Spark的应用Spark在大数据处理中有非常广泛的应用,可以适用于数据分析、机器学习、图形计算等多个领域。

本节中将简单介绍一下Spark在这些领域的主要应用。

1.数据分析Spark可以运行在一个分布式的集群环境中,通过RDD(弹性分布式数据集)来支持数据处理。

用户可以通过Spark SQL进行数据分析,使用Spark底层的计算引擎可以极大地提高处理大数据时的性能和效率。

在数据仓库的构建方面,Spark也有很强的优势,它可以连接各种存储系统,如Hadoop HDFS、Hive、Cassandra等。

2.机器学习Spark支持运行在机器学习算法之上的库,如MLlib(机器学习库)等。

在Spark中,MLlib支持多种机器学习模型,如分类、回归、聚类和协同过滤等。

它还支持从多种数据源(如HDFS、Hive、Cassandra 等)中读取数据,从而便于机器学习的建模和优化。

3.图形计算Spark也可以支持图计算框架GraphX。

通过GraphX,用户可以使用Spark来分析网络数据和图像数据。

图计算特别适合于分布式图分析、推荐算法和社交媒体分析等场景。

Spark可以对图进行并行处理,并发聚合,支持节点、边上的属性计算。

Spark的实现Spark的实现基本上可以分为四个主要模块:Spark Core、Spark SQL、MLlib和GraphX。

下面将对这几个模块进行简要介绍。

1. Spark CoreSpark Core是Spark的核心,提供了分布式任务调度、内存计算等基本的功能。

大数据导论思维第10章 大数据实时流计算 Spark Streaming

后还可以将处理结果存储到文件系统,数据库和现场仪表盘。

Spark Streaming 数据流:

Kafka

Flume HDFS/S3 Kinesis

Spark Streaming

HDFS Databases Dashboards

概述

Spark Streaming 工作原理: ① 接收实时的输入数据流 ② 根据一定的时间间隔(比如1秒钟)拆分成一批批的数据 ③ 然后通过Spark引擎处理这些批数据 ④ 最终得到处理后的一批批结果数据

resourcBiblioteka sstatic scheduling of continuous operators to nodes can cause bottlenecks

dynamic scheduling of tasks ensures even distribution of load

动态负载均衡

Spark系统将数据划分为小批量,允许对资源进行细粒度分配。 例如: 当输入数据流需要由一个键值来分区处理。

Input data Stream

Spark Streaming

Batches of Input data

Spark Engine

Batches of Processed data

概述

Spark Streaming支持一个高层的抽象,叫做离散流(Discretized Stream)或者DStream,它代表连续的数据流。 在内部,DStream是由一系列RDD组成。对应的批数据,在Spark内核 对应一个RDD 实例。因此,对应流数据的DStream可以看成是一组 RDD,即RDD的一个序列。

基于Spark的大数据分布式计算框架研究

基于Spark的大数据分布式计算框架研究在当今信息时代,随着网络科技和技术的发展,数据的规模逐渐呈指数级增长。

所以,如何快速高效地处理这些海量数据成为了一个亟待解决的问题。

而大数据分布式计算框架就是解决这一问题的最佳方案之一。

其中,Spark就是大数据分布式计算中备受关注的一个框架,本篇文章就将对Spark进行研究探讨。

一、Spark框架概述Spark是一个大数据分布式计算框架,它支持速度快、易于使用的API,并具有适用于内存和磁盘上的计算模式。

Spark的核心思想是将数据集合分为若干小块(分区),将这些数据分别分布到不同的计算节点上进行处理,最后将结果合并得到最终的结果。

其内部实现采用了内存计算和读取磁盘的策略,使得Spark具有了较高的运算速度。

另外,Spark的API接口非常丰富,同时也兼容Java、Scala、Python等各种编程语言,更为方便应用于不同的业务场景。

二、Spark的核心组件Spark主要包含了以下四个核心组件:1. Spark CoreSpark Core是Spark的核心组件,它提供RDD(Resilient Distributed Datasets,具有弹性的分布式数据集)的API接口,实现了快速分布式计算和物化计算功能。

Spark Core的RDD可以缓存到内存中,因此读取速度远高于Hadoop中的MapReduce。

2. Spark SQLSpark SQL是一种基于SQL的查询引擎,针对结构化数据进行SQL查询和化简,并支持使用SQL语句连接多个数据源。

除了基于SQL的查询外,Spark SQL还提供了许多有用的操作,如withColumnRenamed、groupBy和agg等函数。

3. Spark StreamingSpark Streaming是一种分布式计算模型,支持实时处理数据流。

它采用微小批处理(Micro-batch Processing)技术,将数据分为小批次处理,从而保证了高吞吐量和可扩展性。

大数据存储与处理的技术与方案

大数据存储与处理的技术与方案随着大数据时代的到来,大数据存储与处理的技术与方案变得越来越重要。

在海量数据增长的背景下,如何高效地存储和处理大数据成为了许多组织和企业所关注的焦点。

本文将探讨大数据存储与处理的技术与方案,介绍其原理和应用。

一、大数据存储技术1. 分布式文件系统(DFS)分布式文件系统是一种用于管理和存储大规模数据的系统。

它将数据分散存储在多个计算机节点上,实现了数据的分散和冗余,提高了数据的可靠性和可用性。

常见的分布式文件系统包括Hadoop HDFS和Ceph。

Hadoop HDFS是目前最常用的分布式文件系统之一。

它基于Google的GFS (Google File System)设计,具有高可靠性和扩展性。

Hadoop HDFS将数据划分成块并存储在不同的计算机上,通过数据冗余和备份来提高系统的容错性。

Ceph是另一个开源的分布式文件系统,它采用对象存储的方式存储数据。

Ceph提供了高可靠性和可扩展性,并支持动态数据迁移和数据副本的自动修复等特性。

2. NoSQL数据库NoSQL(Not Only SQL)数据库是一种非关系型数据库,适用于大规模数据的存储和处理。

相比于传统的关系型数据库,NoSQL数据库具有更好的扩展性和性能。

常见的NoSQL数据库包括MongoDB、Cassandra和Redis等。

MongoDB是一种面向文档的数据库,适用于半结构化数据的存储和查询。

Cassandra是一种分布式、高可用性的列式数据库,适合处理大规模的数据和高并发的访问。

Redis是一种内存数据库,支持多种数据结构和高效的存储与查询。

3. 数据仓库数据仓库是一种用于集中存储和管理数据的系统。

它可以将来自不同数据源的数据整合起来,提供一致的查询接口和分析功能。

常见的数据仓库包括传统的关系型数据库(如Oracle、SQL Server)和列式数据库(如Vertica、Greenplum)。

关系型数据库适用于事务处理和数据的实时查询,而列式数据库则更适用于大规模数据的分析和报表查询。

大数据技术中的Hadoop与Spark框架深入剖析

大数据技术中的Hadoop与Spark框架深入剖析大数据技术是当今信息技术领域的热门话题,随着大数据的迅速发展,大数据技术的应用也逐渐成为了企业发展的重要组成部分。

在大数据处理中,Hadoop与Spark是两个非常重要的框架,它们分别有着不同的特点和优势。

本文将深入剖析Hadoop与Spark框架,分析它们的原理与优势,帮助读者更好地了解大数据处理技术。

一、Hadoop框架1. Hadoop的概述Hadoop是由Apache基金会开发的一个开源分布式计算框架,它主要用于存储和处理大规模数据。

Hadoop框架由Hadoop分布式文件系统(HDFS)和MapReduce计算框架组成,它可以在廉价的硬件上运行,可以处理大规模数据,并可靠地运行在集群中。

Hadoop的出现,极大地推动了大数据处理技术的发展。

2. Hadoop的原理与架构Hadoop的原理是基于分布式存储和计算,其中HDFS是其核心组件之一。

它采用主从架构,包括一个NameNode(管理存储的元数据)和多个DataNode(实际存储数据),数据会被分成块并分布在不同的DataNode上,保证了数据的可靠性和容错性。

而MapReduce是Hadoop 的计算框架,通过将大规模的数据分成小块,分发给计算节点,再将结果合并的方式来进行大规模数据的并行处理。

Hadoop的架构设计保证了它可以高效地处理大规模数据。

3. Hadoop的优势Hadoop有着以下几点优势:(1)高可靠性:Hadoop通过数据的冗余备份和容错性设计,保证了其在节点宕机或者数据损坏的情况下能够继续正常工作;(2)高扩展性:Hadoop使用分布式计算和存储,能够很容易地扩展到上百台机器,以满足不断增长的数据处理需求;(3)高性能:Hadoop的分布式计算模型保证了它可以高效地并行处理大规模数据,具有较高的处理性能。

二、Spark框架1. Spark的概述Spark是由加州大学伯克利分校研究中心开发的一个快速、通用、可扩展的大数据处理引擎,它提供了一种通用的基于内存的计算模型,可以方便地处理大规模数据。

10第八章-02-GraphFrames简介

GraphFrames库

基于Spark平台的并行图计算库

将Spark中的Graph算法统一到 DataFrame接口的Graph操作接口

项目托管在Github上,它基于DataFrame构建

GraphFram es

受益于aFrame的高性能和可拓展性, 具有很大优势!

GraphFrames库

使用GraphFrames库

或者使用SparkConf的spark.jars.packages属性指定依赖包:

from pyspark import SparkConf conf = SparkConf().set('spark.jars.packages' ,'graphframes:graphframes:0.5.0-spark2.1-s_2.11')

graphframes图计算spark大数据技术与应用第八章课前回顾图的重要概念3图的分类content01图的重要概念02graphframes简介03graphframe编程模型04graphframes实现的算法02graphframes简介基于dataframe的graphframes图计算框架01pregelgoogle内部的分布式图计算框架030204giraph运行在hadoop之上的类pregel图计算框架powergraph一个支持异步执行方式利用共享内存的并行图计算框架graphxspark平台下面向大规模图计算的组件graphframes库基于spark平台的并行图计算库graphframes将spark中的graph算法统一到dataframe接口的graph操作接口项目托管在github上它基于dataframe构建受益于dataframe的高性能和可拓展性具有很大优势

Spark(十七)图计算GraphX

Spark(⼗七)图计算GraphX⼀、图概念术语1.1 基本概念图是由顶点集合(vertex)及顶点间的关系集合(边edge)组成的⼀种数据结构。

这⾥的图并⾮指代数中的图。

图可以对事物以及事物之间的关系建模,图可以⽤来表⽰⾃然发⽣的连接数据,如:社交⽹络、互联⽹web页⾯常⽤的应⽤有:在地图应⽤中找到最短路径、基于与他⼈的相似度图,推荐产品、服务、⼈际关系或媒体1.2 术语1.2.1顶点和边⼀般关系图中,事物为顶点,关系为边1.2.2有向图和⽆向图在有向图中,⼀条边的两个顶点⼀般扮演者不同的⾓⾊,⽐如⽗⼦关系、页⾯A连接向页⾯B;在⼀个⽆向图中,边没有⽅向,即关系都是对等的,⽐如qq中的好友。

GraphX中有⼀个重要概念,所有的边都有⼀个⽅向,那么图就是有向图,如果忽略边的⽅向,就是⽆向图。

1.2.3有环图和⽆环图有环图是包含循环的,⼀系列顶点连接成⼀个环。

⽆环图没有环。

在有环图中,如果不关⼼终⽌条件,算法可能永远在环上执⾏,⽆法退出。

1.2.4度、出边、⼊边、出度、⼊度度表⽰⼀个顶点的所有边的数量出边是指从当前顶点指向其他顶点的边⼊边表⽰其他顶点指向当前顶点的边出度是⼀个顶点出边的数量⼊度是⼀个顶点⼊边的数量1.2.5超步图进⾏迭代计算时,每⼀轮的迭代叫做⼀个超步⼆、图处理技术图处理技术包括图数据库、图数据查询、图数据分析和图数据可视化。

2.1 图数据库Neo4j、Titan、OrientDB、DEX和InfiniteGraph等基于遍历算法的、实时的图数据库;2.2 图数据查询对图数据库中的内容进⾏查询2.3 图数据分析Google Pregel、Spark GraphX、GraphLab等图计算软件。

传统的数据分析⽅法侧重于事物本⾝,即实体,例如银⾏交易、资产注册等等。

⽽图数据不仅关注事物,还关注事物之间的联系。

例如,如果在通话记录中发现张三曾打电话给李四,就可以将张三和李四关联起来,这种关联关系提供了与两者相关的有价值的信息,这样的信息是不可能仅从两者单纯的个体数据中获取的。

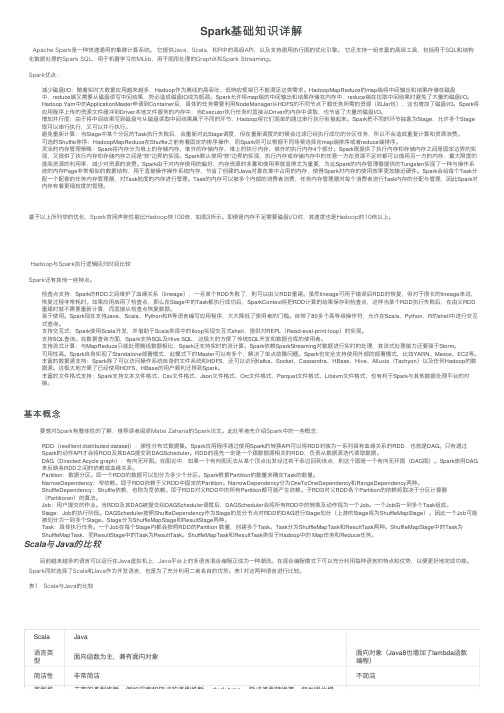

Spark基础知识详解

Spark基础知识详解Apache Spark是⼀种快速通⽤的集群计算系统。

它提供Java,Scala,和R中的⾼级API,以及⽀持通⽤执⾏图的优化引擎。

它还⽀持⼀组丰富的⾼级⼯具,包括⽤于SQL和结构化数据处理的Spark SQL,⽤于机器学习的MLlib,⽤于图形处理的GraphX和Spark Streaming。

Spark优点:减少磁盘I/O:随着实时⼤数据应⽤越来越多,Hadoop作为离线的⾼吞吐、低响应框架已不能满⾜这类需求。

HadoopMapReduce的map端将中间输出和结果存储在磁盘中,reduce端⼜需要从磁盘读写中间结果,势必造成磁盘IO成为瓶颈。

Spark允许将map端的中间输出和结果存储在内存中,reduce端在拉取中间结果时避免了⼤量的磁盘I/O。

Hadoop Yarn中的ApplicationMaster申请到Container后,具体的任务需要利⽤NodeManager从HDFS的不同节点下载任务所需的资源(如Jar包),这也增加了磁盘I/O。

Spark将应⽤程序上传的资源⽂件缓冲到Driver本地⽂件服务的内存中,当Executor执⾏任务时直接从Driver的内存中读取,也节省了⼤量的磁盘I/O。

增加并⾏度:由于将中间结果写到磁盘与从磁盘读取中间结果属于不同的环节,Hadoop将它们简单的通过串⾏执⾏衔接起来。

Spark把不同的环节抽象为Stage,允许多个Stage 既可以串⾏执⾏,⼜可以并⾏执⾏。

避免重新计算:当Stage中某个分区的Task执⾏失败后,会重新对此Stage调度,但在重新调度的时候会过滤已经执⾏成功的分区任务,所以不会造成重复计算和资源浪费。

可选的Shuffle排序:HadoopMapReduce在Shuffle之前有着固定的排序操作,⽽Spark则可以根据不同场景选择在map端排序或者reduce端排序。

灵活的内存管理策略:Spark将内存分为堆上的存储内存、堆外的存储内存、堆上的执⾏内存、堆外的执⾏内存4个部分。

Spark在大数据处理领域的应用

Spark在大数据处理领域的应用随着数字化时代的到来,数据的规模越来越庞大。

而大数据处理成为了一个极为重要的领域,因为只有对这些数据进行有效的分析,才能发掘出其中的价值。

然而,对大数据进行处理并非易事,传统的数据处理方式往往面临各种困难。

为了解决这些困难,一种名为“Spark”的技术应运而生。

Spark是一个开源的分布式计算框架,能够高效地处理大规模数据。

它在数据处理方面有很多优势,例如高速处理速度、易于使用的API等。

本文将详细介绍Spark在大数据处理领域的应用。

一、Spark基础1. Spark的历史Spark最初由加州大学伯克利分校的AMPLab实验室开发,于2010年首次亮相。

在2013年,Spark成为了Apache软件基金会的顶级项目,并在随后的几年中不断完善和更新。

今天,它已经成为了世界上最流行的大数据处理框架之一。

2. Spark的核心组件Spark由以下四个核心组件组成:a. Spark SQL: Spark SQL是一个基于SQL的接口,它允许开发人员使用传统的SQL查询语言来访问Spark数据。

Spark SQL还提供了一个名为DataFrame的高级数据结构,它可以轻松处理结构化数据。

b. Spark Streaming: Spark Streaming是一种流式处理框架,能够实时地处理来自多个数据源的数据。

c. Spark MLlib: Spark MLlib是一个机器学习库,提供了大量的机器学习算法和工具,包括分类、回归和聚类等。

d. Spark GraphX: Spark GraphX是一个图形计算框架,能够用于处理图形数据。

二、Spark在大数据处理中的优势1. 处理速度快Spark的处理速度非常快,这得益于它的内存计算框架。

与Hadoop不同,Spark可以将数据存储在内存中,而不是在磁盘上,这样可以大大提高数据处理速度。

此外,Spark还能通过分布式计算,让计算任务尽可能地并行执行,从而进一步提高处理速度。

graphx的实现结构

graphx的实现结构GraphX是一个基于Apache Spark的图处理框架,旨在提供高效、易用的图计算能力。

GraphX与其他大数据图处理框架不同的是,它将图数据结构和图计算操作融合在一起,通过数据抽象和优化技术,实现了高性能的图计算。

GraphX的实现结构主要包括图数据模型和图计算接口两个方面。

其中,图数据模型部分包括图的构建、存储和操作等功能;图计算接口部分提供了一系列的图计算算法和操作方法。

下面将对GraphX的实现结构进行详细介绍。

1.图数据模型GraphX使用分布式内存图模型来存储和管理图数据。

图数据模型主要由顶点(Vertex)和边(Edge)组成,每个顶点和边都可以带有属性数据。

在GraphX中,顶点和边的属性数据可以是任意的数据类型,可以是基本数据类型,也可以是自定义的复杂数据类型。

GraphX通过使用属性图(Property Graph)来表示图数据,在属性图中,每个顶点和边都有一个唯一的标识符,可以通过标识符来访问和操作顶点和边。

在GraphX中,图数据被分布式存储在Spark集群的内存中,图数据可通过不同的方式进行构建。

例如,可以通过从文件加载数据、通过Spark SQL查询结果生成图数据以及通过程序构建图数据等方式来构建图数据。

构建图数据后,可以对图数据进行查询、过滤、修改等操作。

2.图计算接口GraphX提供了丰富的图计算接口,包括基本图算法、路径查找、图转换、图合并等。

这些接口可以用于解决各种图计算问题,如社交网络分析、推荐系统、网络流量分析等。

基本图算法接口包括图的顶点和边的属性操作、顶点和边的过滤、顶点和边的连接等。

这些基本的图算法操作可以用于计算图的属性、度分布、连通性等基本指标。

除了基本图算法,GraphX还提供了一些高级的图算法接口,包括PageRank算法、连通分量算法、最短路径算法等。

这些高级图算法可以用于解决更复杂的图计算问题。

在图计算接口中,GraphX还提供了图的转换和合并等功能。

大数据分析导论(2024)

THANKS

感谢观看

REPORTING

2024/1/28

27

6

PART 02

大数据分析技术

REPORTING

2024/1/28

7

数据挖掘技术

数据预处理

包括数据清洗、数据集成、数 据变换和数据规约等步骤,旨 在提高数据质量和减少数据维

度。

2024/1/28

关联规则挖掘

通过寻找数据项之间的有趣关 联,揭示隐藏在数据中的模式 或规律。

分类与预测

利用已知类别的样本建立分类 模型,预测新样本的类别或属 性值。

医疗资源优化

利用大数据分析技术,对医疗资源的分布、需求和利用情况进行实时监测和分析,优化医疗资源的配置和管 理,提高医疗服务的效率和质量。

药物研发和临床试验

通过分析海量的医学文献、基因数据、临床试验结果等信息,加速药物研发的过程,提高药物研发的成功率 和安全性。

22

PART 06

大数据挑战与未来趋势

市场趋势预测

通过分析历史销售数据、用户评 价等信息,预测市场趋势和消费 者需求变化,为商家制定销售策 略和库存管理提供依据。

2024/1/28

20

金融领域应用案例

2024/1/28

信贷风险评估

利用大数据分析技术,对借款人的历史信用记录、财务状 况、社交网络等信息进行深度挖掘和分析,评估借款人的 信贷风险,提高信贷决策的准确性和效率。

股票市场分析

通过分析历史股票价格、交易量、新闻事件等信息,预测 股票市场的走势和波动情况,为投资者提供投资决策支持 。

反欺诈检测

利用大数据分析和机器学习技术,实时监测金融交易中的 异常行为和模式,及时发现和防范金融欺诈行为。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

CONTENTS

目录

PART 01 分布式图计算 PART 02 Spark Graphx简介 PART 03 Graphx实现 PART 04 Graphx实例

PART 05 Spark Graphx的优势 PART 06 作业

PART 01 分布式图计算

分布式图计算

数据并行与图并行计算 1.数据并行系统,像 MapReduce和Spark等计算 框架,主要用于对数据集进行 各种运算,在数据内部之间关 联度不高的计算场景下能够进 行很高效的处理。 2.图并行计算对存在较高关联 度的数据处理非常合适

指定不同的划分策略

Spark GraphX简介

GraphX的设计要点

Property Graph

3

rxin stu.

Advisor

5

franklin, prof.

Colleague Collab.

PART 02 Spark GraphX简介

Spark GraphX是一个分布式图处理框架, 它是基于Spark平台提供对图计算和图挖掘 简洁易用的而丰富的接口,极大的方便了对 分布式图处理的需求

Spark GraphX简介

GraphX的应用背景

在社交网络中人与人之间存在

有很多关系链,例如微博、微 信、QQ、Twitter、Facebook、

Table View

GraphX Unified Representation

Graph View

Spark GraphX简介

GraphX的框架

算法

PageRank

SVDPlusPlus

TriangleCount

ConnectedCom ponents

操作

GraphOps

Pregel Graph

GraphImpl

Pregel框架以顶点为中心,对边进行切割,将图数据分成若干个分区,

每一个分区包含一组顶点以及由这组顶点为源顶点构成的边,并不断在

顶点上进行算法迭代和数据同步

B P2 A

A 连接B P1

C 连接D

P1 C

D P3

B 连接C

P2

D 连接B

P3

分布式图计算

Pregel计算过程

读取输入数据,初始化图数据,

GAS模型是以节点为中心的图计算编程模型,某个顶点可能被部署到多台

机器上,其中一台机器上的为主顶点(Master),其余机器上的为镜像

顶点(Mirror),与主顶点的数据保持同步,将边唯一部署在某一台机器

上

B

A

B

P1

A

C

P1

P2

D

B P2

C P3

D

C

D P3

分布式图计算

GAS模型计算阶段划分 ➢ 收集阶段:工作顶点的边,可以是出边或入边,也可以同时包含入边

实现 PartitionStrategy

VertexRDD

MessageToPartition VertexPartition

EdgeRDD Edge

EdgePartition

RDD{EdgeTripl et}

EdgeTriplet

RoutingTablePartit ReplicatedVertexVi

就是一个分布式的图处理系统。

Hyperlinks

PageRank

Top 20 Page Title PR.

Top Communities

Com. PR.

Editor Graph

Community Detection

User Community

User Com.

Spark GraphX简介

GraphX的框架 GraphX的核心抽象是Resilient Distributed Property Graph,一种点 和边都带属性的有向多重图。它扩展了Spark RDD的抽象,具有Table 和Graph两种视图,而只需要一份物理存储

分布式图计算

图存储模式 1.边分割:每个顶点都存储一次,但有的边会被打断分到两台机器上。 2.点分割:每条边只存储一次,都只会出现在一台机器上。邻居多的点 会被复制到多台机器上

A

B2

A

B

A

1

1

C

C

ห้องสมุดไป่ตู้D3

C

D

C

B2 D3

A

1

B

C

D

3

A

B

C

B

C

D

(a)Edge-Cut

(b)Vertex-Cut

分布式图计算

A 3

在图数据上运行一系列的超步

运算直至整个计算结束,输出

结果。当一个节点结束计算之

6

后,该节点停止运行,如果有

新任务分配,则又重新开始运

6

行,然后再次停止。当所有节

点全部停止运行,并且没有新

任务分配的时候,整个算法停

6

止

B

C

6

2

6

2

6

6

6

6

D

1

超步0

6

超步1

6

超步2

6

超步3

分布式图计算

GAS模型:邻居更新模型

图计算模式

1.图计算框架基本上都遵循BSP(Bulk Synchronous Parallell)计算模式。

2.在BSP中,一次计算过程由一系列全局超步组成

3.超步分为三个阶段:

处理 器

➢ 本地执行阶段 ➢ 全局通信阶段

局部 计算

➢ 栅栏同步阶段

通讯

栅栏 同步

分布式图计算

Pregel模型:像顶点一样思考

Link Table Title Link

Linkedin等,这些都是大数据

产生的地方,都需要图计算。

Raw Wikipedia

因为图的结构复杂、数据量大, </>

只有分布式的图处理才能胜任。 XML

Editor Table

Editor Title

由 于 Spark GraphX 底 层 是 基

于 Spark 来 处 理 的 , 所 以 天 然

ion

ew

Spark GraphX简介

GraphX的设计要点 ➢ 1.对GraphX视图的所有操作,最终都会转换成其关联的Table视图的

RDD操作来完成 ➢ 2.两种视图底层共用的物理数据,由RDD[VertexPartition]和

RDD[EdgePartition]这两个RDD组成 ➢ 3.图的分布式存储采用点分割模式,而且使用partitionBy方法,由用户

和出边,从邻接顶点和自身收集数据,并对收集的数据使用用户定义 的函数进行运算。这一阶段对顶点和边都是只读的。 ➢ 执行阶段:镜像顶点将收集阶段的计算结果发送给主顶点,主顶点对 从各个镜像顶点收集的数据进行聚集运算,并利用聚集结果和上一步 的顶点数据,按照用户定义的更新函数进行计算,更新主顶点的数据, 并同步给镜像顶点。在执行阶段中,工作顶点可修改,边不可修改。 ➢ 分发阶段:工作顶点更新完成之后,更新边上的数据,通知对其有依 赖的邻接边更新状态。在分发阶段,工作顶点只读,边上数据可写。