信息论试卷题目及答案

信息论试卷含答案资料讲解

《信息论基础》参考答案一、填空题(共15分,每空1分)1、信源编码的主要目的是提高有效性,信道编码的主要目的是提高可靠性。

2、信源的剩余度主要来自两个方面,一是信源符号间的相关性,二是信源符号的统计不均匀性。

3、三进制信源的最小熵为0,最大熵为32log bit/符号。

4、无失真信源编码的平均码长最小理论极限制为信源熵(或H(S)/logr= H r (S))。

5、当R=C 或(信道剩余度为0)时,信源与信道达到匹配。

6、根据信道特性是否随时间变化,信道可以分为恒参信道和随参信道。

7、根据是否允许失真,信源编码可分为无失真信源编码和限失真信源编码。

8、若连续信源输出信号的平均功率为2σ,则输出信号幅度的概率密度是高斯分布或正态分布或()222x f x σ-=时,信源具有最大熵,其值为值21log 22e πσ。

9、在下面空格中选择填入数学符号“,,,=≥≤〉”或“〈”(1)当X 和Y 相互独立时,H (XY )=H(X)+H(X/Y)=H(Y)+H(X)。

(2)()()1222H X X H X =≥()()12333H X X X H X = (3)假设信道输入用X 表示,信道输出用Y 表示。

在无噪有损信道中,H(X/Y)> 0, H(Y/X)=0,I(X;Y)<H(X)。

二、(6分)若连续信源输出的幅度被限定在【2,6】区域内,当输出信号的概率密度是均匀分布时,计算该信源的相对熵,并说明该信源的绝对熵为多少。

()1,2640,x f x ⎧≤≤⎪=⎨⎪⎩Q 其它()()()62log f x f x dx ∴=-⎰相对熵h x=2bit/自由度该信源的绝对熵为无穷大。

三、(16分)已知信源1234560.20.20.20.20.10.1S s s s s s s P ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦(1)用霍夫曼编码法编成二进制变长码;(6分) (2)计算平均码长L ;(4分)(3)计算编码信息率R ';(2分)(4)计算编码后信息传输率R ;(2分) (5)计算编码效率η。

信息论基础理论与应用考试题及答案

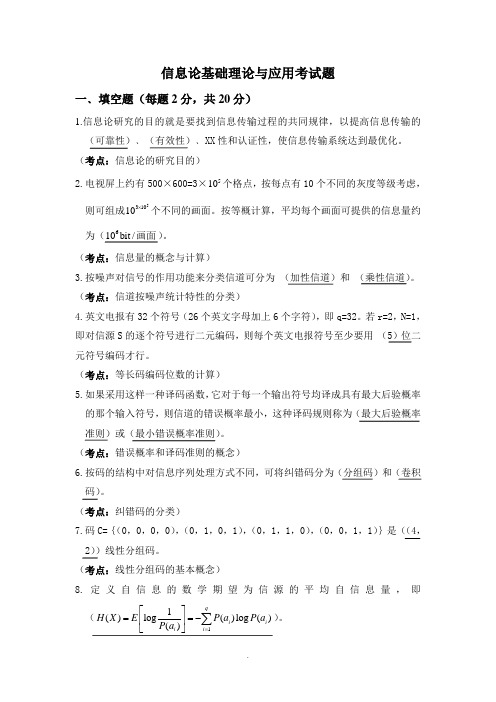

信息论基础理论与应用考试题一﹑填空题(每题2分,共20分)1.信息论研究的目的就是要找到信息传输过程的共同规律,以提高信息传输的 (可靠性)﹑(有效性)﹑XX 性和认证性,使信息传输系统达到最优化。

(考点:信息论的研究目的)2.电视屏上约有500×600=3×510个格点,按每点有10个不同的灰度等级考虑,则可组成531010⨯个不同的画面。

按等概计算,平均每个画面可提供的信息量约为(610bit /画面)。

(考点:信息量的概念与计算)3.按噪声对信号的作用功能来分类信道可分为 (加性信道)和 (乘性信道)。

(考点:信道按噪声统计特性的分类)4.英文电报有32个符号(26个英文字母加上6个字符),即q=32。

若r=2,N=1,即对信源S 的逐个符号进行二元编码,则每个英文电报符号至少要用 (5)位二元符号编码才行。

(考点:等长码编码位数的计算)5.如果采用这样一种译码函数,它对于每一个输出符号均译成具有最大后验概率的那个输入符号,则信道的错误概率最小,这种译码规则称为(最大后验概率准则)或(最小错误概率准则)。

(考点:错误概率和译码准则的概念)6.按码的结构中对信息序列处理方式不同,可将纠错码分为(分组码)和(卷积码)。

(考点:纠错码的分类)7.码C={(0,0,0,0),(0,1,0,1),(0,1,1,0),(0,0,1,1)}是((4,2))线性分组码。

(考点:线性分组码的基本概念)8.定义自信息的数学期望为信源的平均自信息量,即(11()log ()log ()()q i i i i H X E P a P a P a =⎡⎤==-⎢⎥⎣⎦∑)。

(考点:平均信息量的定义)9.对于一个(n,k)分组码,其最小距离为d,那么,若能纠正t个随机错误,同时能检测e(e≥t)个随机错误,则要求(d≥t+e+1)。

(考点:线性分组码的纠检错能力概念)10.和离散信道一样,对于固定的连续信道和波形信道都有一个最大的信息传输速率,称之为(信道容量)。

最新《信息论》试题及答案

期终练习一、某地区的人群中,10%是胖子,80%不胖不瘦,10%是瘦子。

已知胖子得高血压的概率是15%,不胖不瘦者得高血压的概率是10%,瘦子得高血压的概率是5%,则“该地区的某一位高血压者是胖子”这句话包含了多少信息量。

解:设事件A :某人是胖子; B :某人是不胖不瘦 C :某人是瘦子 D :某人是高血压者根据题意,可知:P (A )=0.1 P (B )=0.8 P (C )=0.1 P (D|A )=0.15 P (D|B )=0.1 P (D|C )=0.05而“该地区的某一位高血压者是胖子” 这一消息表明在D 事件发生的条件下,A 事件的发生,故其概率为P (A|D )根据贝叶斯定律,可得:P (D )=P (A )* P (D|A )+P (B )* P (D|B )+P (C )* P (D|C )=0.1 P (A|D )=P (AD )/P (D )=P (D|A )*P (A )/ P (D )=0.15*0.1/0.1=0.15 故得知“该地区的某一位高血压者是胖子”这一消息获得的多少信息量为: I (A|D ) = - logP (A|D )=log (0.15)≈2.73 (bit ) 二、设有一个马尔可夫信源,它的状态集为{S 1,S 2,S 3},符号集为{a 1,a 2,a 3},以及在某状态下发出符号集的概率是(|)k i p a s (i ,k=1,2,3),如图所示(1)求图中马尔可夫信源的状态极限概率并找出符号的极限概率(2)计算信源处在某一状态下输出符号的条件熵H(X|S=j) (j=s 1,s 2,s 3) (3)求出马尔可夫信源熵H ∞解:(1)该信源达到平稳后,有以下关系成立:13212312123()()31()()()4211()()()42()()()1Q E Q E Q E Q E Q E Q E Q E Q E Q E Q E Q E =⎧⎪⎪=+⎪⎨⎪=+⎪⎪++=⎩可得1232()73()72()7Q E Q E Q E ⎧=⎪⎪⎪=⎨⎪⎪=⎪⎩3111322133313()()(|)72()()(|)73()()(|)7i i i i i i i i i p a Q E p a E p a Q E p a E p a Q E p a E =========∑∑∑(2)311113222133331(|)(|)log (|) 1.5bit/(|)(|)log (|)1bit/(|)(|)log (|)0bit/k k k kk k k k k H X S p a S p a S H X S p aS p a S H X S p a S p a S ====-==-==-=∑∑∑(符号)(符号)(符号)(3)31()(|)2/7*3/23/7*12/7*06/7iii H Q E H X E ∞==⨯=++=∑(比特/符号)三、二元对称信道的传递矩阵为0.60.40.40.6⎡⎤⎢⎥⎣⎦(1)若P(0)=3/4,P(1)=1/4,求H (X ),H (X|Y )和I (X ;Y )(2)求该信道的信道容量及其最大信道容量对应的最佳输入分布 解:⑴()H X =21()log ()iii p x p x ==-∑=0.75log 750.25log 25--≈0.811(比特/符号)1111212()()(|)()(|)p y p x p y x p x p y x =+=0.75*0.6+0.25*0.4=0.55 2121222()()(|)()(|)p y p x p y x p x p y x =+=0.75*0.4+0.25*0.6=0.45()0.55log0.550.45log0.45H Y =--=≈0.992(比特/符号)122(|)()(|)()(|)0.75(0.6,0.4)0.25(0.4,0.6)(0.6log 0.60.4log 0.4)0.971/H Y X p x H Y x p x H Y x H H =+=⨯+⨯=-+≈(比特符号)(|)()()()(|)()H X Y H XY H Y H X H Y X H Y =-=+-≈0.811+0.971-0.992=0.79 (比特/符号)I (X ;Y )=H (X )-H (X =0.811-0.79=0.021(比特/符号)(2)此信道为二元对称信道,所以信道容量为C=1-H(p)=1-H(0.6)=1-0.971=0.029(比特/符号) 当输入等概分布时达到信道容量四、求信道22042240p p p p εεεεεε⎡⎤-- ⎢⎥-- ⎢⎥⎣⎦的信道容量,其中1p p =-。

《信息论》期末考试试题( 卷)标准答案

2.(共 10 分)有两枚硬币,第一枚是正常的硬币,它的一面是国徽,另一面是 面值;第二枚是不正常的硬币,它的两面都是面值。现随机地抽取一枚硬币,进 行 2 次抛掷试验,观察硬币朝上的一面,其结果为:面值、面值。

1)求该试验结果与事件“取出的是第一枚硬币”之间的互信息;(4 分)

=

E( XS + αS 2 ) σ SσU

=

αQ σ SσU

I (U ; S) = H (U ) + H (S ) − H (US )

=

1 2

log

2πe σ

2 U

+

1 2

log

2πeσ

2 S

+

log 2πeσUσ S

1− ρ2

=

1 2

log

σ

σ σ2 2

SU

σ2 2

US

− (αQ)

2

=

1 log P + α 2Q

2 1 d = 1 0 7)若失真矩阵为 3 1 ,输入等概,则 Dmin = 2/3 , Dmax = 2/3 。

三、简答题(6 分)

1.仙农第二定理指出了“高效率、高可靠性”的信道编码存在性,

1)“高效率”的含义是什么?

(1 分)

2)“高可靠性” 的含义是什么?

(1 分)

3)存在这种信道编码的必要条件是什么?

1− ρ2

=

1 log

σ

2 U

σ

2 Y

2

σ

2 U

σ

2 Y

−

(P

+ αQ)2

=

1 log

(P + Q + N )(P + α 2Q)

信息论试卷及解答

=

log 2 −

1+ε 2 2

log(1+ ε

2)

− εε

log ε

−ε

log ε

I (X

; Y1Y2

)

=

H

(X

)

+

H (Y1Y2

)

−

H ( XY1Y2

)

=

log

2

−

1+ε 2

2

log(1 +

ε

2

)

−

ε

(2

−

ε

) log ε

其中ε = 1 − ε

5

五、(22 分)一离散无记忆信道如图 3 所示:

1/2

01

10

0

0

εε 2

P y1 y2 (01)=

εε 2

εε 2

P y1 y2 (10)=

εε 2

11

0

ε2 2

P y1 y2 (11)=

ε2 2

∴ H (XY1Y2 ) = log 2 − ε 2 log ε − εε log εε − ε 2 log ε = log 2 + H (ε ) ;

H (Y1Y2 )

信息量为:

I(z

=

1/

x

=

0)

=

− log2

2 9

=

2.170

比特

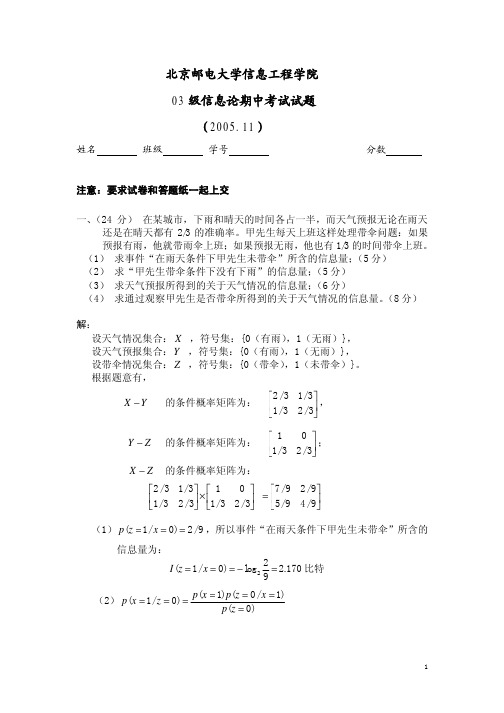

(2) p(x = 1/ z = 0) = p(x = 1) p(z = 0 / x = 1) p(z = 0)

1

=

p( x = 1) p(z = 0 / x = 1)

p(x = 0) p(z = 0 / x = 0) + p(x = 1) p(z = 0 / x = 1)

信息论典型试题及答案

第五章

5.1将下表所列的信源进行六种不同的二进制编码。

(1)求这些码中哪些是惟一可译码。

(2)哪些码是非延长码

(3)对所有惟一可译码求出其平均码长 。

消息

C1

C2

C3

C4

C5

C6

1/2

000

0

0

0

0

0

1/4

001

01

10

10

10

100

1/16

010

011

110

110

1100

101

27.能够描述无失真信源编码定理

例1:.黑白气象传真图的消息只有黑色和白色两种,求:

1)黑色出现的概率为0.3,白色出现的概率为0.7。给出这个只有两个符号的信源X的数学模型。假设图上黑白消息出现前后没有关联,求熵H(X);

2)假设黑白消息出现前后有关联,其依赖关系为:P(白/白)=0.9,P(黑/白)=0.1,P(白/黑)=0.2,P(黑/黑)=0.8,求其熵H2(X);

10.互信息的性质是什么?

11.熵的表达式、单位、含义是什么?

12.单符号离散信源最大熵是多少?信源概率如何分布时能达到?

13.熵的性质是什么?

14.联合熵、条件熵和熵的关系。

15.平均互信息的定义是什么?平均互信息的表达式怎么推导?

16.平均互信息的含义?

17.信道疑义度、损失熵和噪声熵的含义?

18.平均互信息的性质?(能够证明,并说明每个性质的含义)

解:

由题意可知该二元信道的转移概率矩阵为:

为一个BSC信道

所以由BSC信道的信道容量计算公式得到:

3.14电视图像编码中,若每帧为500行,每行划分为600个像素,每个像素采用8电平量化,且每秒传送30帧图像。试求所需的信息速率(bit/s)。

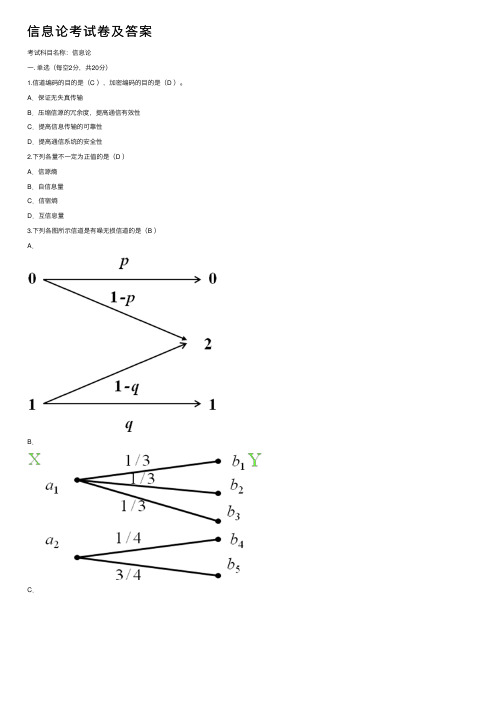

信息论考试卷及答案

信息论考试卷及答案考试科⽬名称:信息论⼀. 单选(每空2分,共20分)1.信道编码的⽬的是(C ),加密编码的⽬的是(D )。

A.保证⽆失真传输B.压缩信源的冗余度,提⾼通信有效性C.提⾼信息传输的可靠性D.提⾼通信系统的安全性2.下列各量不⼀定为正值的是(D )A.信源熵B.⾃信息量C.信宿熵D.互信息量3.下列各图所⽰信道是有噪⽆损信道的是(B )A.B.C.D.4.下表中符合等长编码的是( A )5.联合熵H(XY)与熵H(X)及条件熵H(X/Y)之间存在关系正确的是(A )A.H(XY)=H(X)+H(Y/X)B.H(XY)=H(X)+H(X/Y)C.H(XY)=H(Y)+H(X)D.若X和Y相互独⽴,H(Y)=H(YX)6.⼀个n位的⼆进制数,该数的每⼀位可从等概率出现的⼆进制码元(0,1)中任取⼀个,这个n位的⼆进制数的⾃信息量为(C )A.n2B.1 bitC.n bitnD.27.已知发送26个英⽂字母和空格,其最⼤信源熵为H0 = log27 = 4.76⽐特/符号;在字母发送概率不等时,其信源熵为H1 = 4.03⽐特/符号;考虑字母之间相关性时,其信源熵为H2 = 3.32⽐特/符号;以此类推,极限熵H=1.5⽐特/符号。

问若⽤⼀般传送⽅式,冗余度为( B )∞A.0.32B.0.68C .0.63D .0.378. 某对称离散信道的信道矩阵为,信道容量为( B )A .)61,61,31,31(24log H C -= B .)61,61,31,31(4log H C -= C .)61,61,31,31(2log H C -= D .)61,31(2log H C -= 9. 下⾯不属于最佳变长编码的是( D )A .⾹农编码和哈夫曼编码B .费诺编码和哈夫曼编码C .费诺编码和⾹农编码D .算术编码和游程编码⼆. 综合(共80分)1. (10分)试写出信源编码的分类,并叙述各种分类编码的概念和特性。

信息论复习题期末答案

信息论复习题期末答案1. 信息论的创始人是谁?答案:信息论的创始人是克劳德·香农。

2. 信息熵的概念是什么?答案:信息熵是衡量信息量的一个指标,它描述了信息的不确定性或随机性。

在信息论中,熵越高,信息的不确定性越大。

3. 请简述信源编码定理。

答案:信源编码定理指出,对于一个具有确定概率分布的离散无记忆信源,存在一种编码方式,使得信源的平均编码长度接近信源熵的值,且当信源长度趋于无穷大时,编码长度与信源熵之间的差距趋于零。

4. 什么是信道容量?答案:信道容量是指在特定的通信信道中,能够以任意小的错误概率传输信息的最大速率。

它是信道的最大信息传输率,通常用比特每秒(bps)来表示。

5. 香农公式是如何定义信道容量的?答案:香农公式定义信道容量为信道输入和输出之间的互信息量的最大值,可以表示为C = B log2(1 + S/N),其中C是信道容量,B是信道带宽,S是信号功率,N是噪声功率。

6. 差错控制编码的目的是什么?答案:差错控制编码的目的是为了检测和纠正在数据传输过程中可能发生的错误,以提高数据传输的可靠性。

7. 什么是线性码?答案:线性码是一种特殊的编码方式,其中任意两个合法编码的线性组合仍然是一个合法编码。

线性码通常可以用生成矩阵和校验矩阵来表示。

8. 卷积码和块码有什么区别?答案:卷积码和块码都是差错控制编码的类型,但它们的主要区别在于编码的结构和处理方式。

卷积码是连续的,其编码过程是按时间序列进行的,而块码是离散的,其编码过程是针对数据块进行的。

9. 什么是信道编码定理?答案:信道编码定理指出,对于任何给定的信道和任何小于信道容量的错误概率,都存在一种编码方式,可以使得错误概率趋近于零。

10. 请解释什么是信道编码的译码算法。

答案:信道编码的译码算法是一种用于从接收到的编码信号中恢复原始信息的方法。

常见的译码算法包括维特比算法、最大似然译码和最小均方误差译码等。

这些算法旨在最小化译码错误的概率。

信息论典型试题及答案

3.1设有一个信源,它产生0,1序列的信息。它在任意时间而且不论以前发生过什么符号,均按P(0) = 0.4,P(1) = 0.6的概率发出符号。

(1)试问这个信源是否是平稳的?

(2)试计算H(X2),H(X3/X1X2)及H∞;

(3)试计算H(X4)并写出X4信源中可能有的所有符号。

解:

(1)这个信源是平稳无记忆信源。因为有这些词语:“它在任意时间而且不论以前发生过什么符号……”

(1)计算接收端的平均不确定性;

(2)计算由于噪声产生的不确定性H(Y/X);

解:(1)

(2)

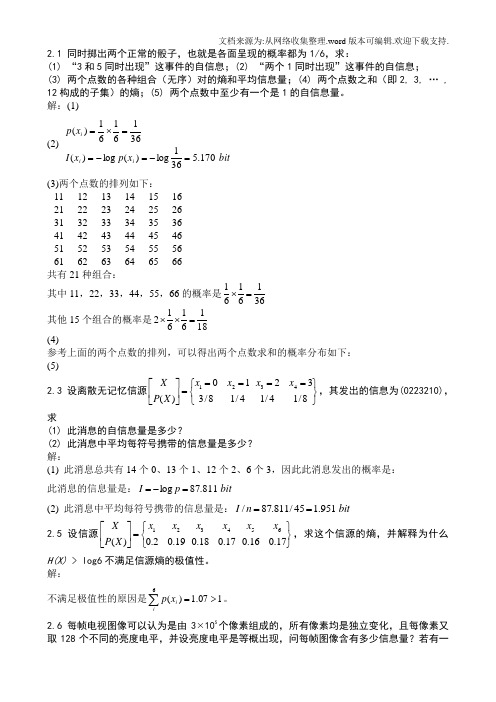

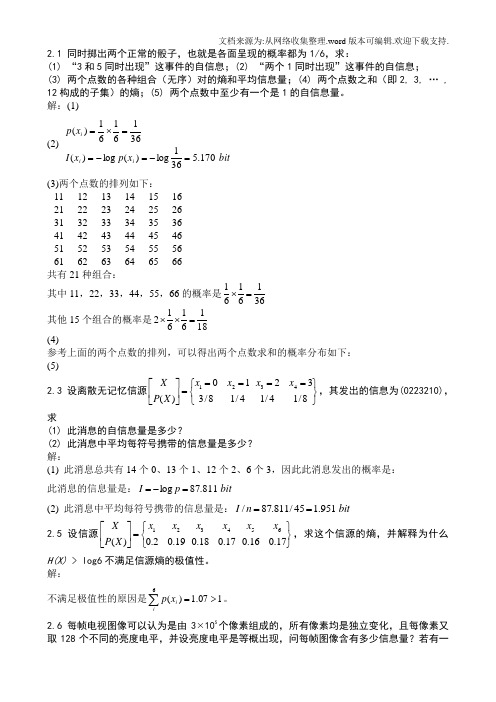

(3)两个点数的排列如下:

11

12

13

14

15

16

21

22

23

24

25

26

31

32

33

34

35

36

41

42

43

44

45

46

51

52

53

54

55

56

61

62

63

64

65

66

共有21种组合:

其中11,22,33,44,55,66的概率是

其他15个组合的概率是

(4)

参考上面的两个点数的排列,可以得出两个点数求和的概 Nhomakorabea分布如下:

解:

(1)

(2)黑白气象传真图的消息前后有关联时,由其前后的依赖关系可知,黑色白色同时出现的联合概率为:

则信源的联合熵为:

H(X1X2)=1.426bit/symbol

H2(X)=1/2*H(X1X2)=0.713 bit/symbol

(3)上述两种信源的剩余度分别为:

《信息论》期末考试B卷答案

北方民族大学试卷课程代码: 01100622 课程:信息理论及编码B 卷答案:号学说明:此卷为《信息理论及编码》B 卷答案一、概念简答题(每小题6分,共30分)1、比较平均自信息(信源熵)与平均互信息的异同。

题试试考末期期学季 秋 年学- —80名姓班级业专程工息信院学程工息信气电线 - q- 答:平均自信息为 H X - -7 p q log p q ,表示信源的平均不确定度,也表示平-i 4-均每个信源消息所提供的信息量。

........................... (3分)平均互信息I X;Y P xy logX,Y。

表示从Y 获得的关于每个 X 的平均信息量,也表示发X 前后Y 的平均不确定性减少的量,还表示通信前后整个系统不确定性减少的量。

(3分)2、简述香农第一定理。

- 答:对于离散信源 S 进行r 元编码,只要其满足L N_匕^, ..................................... (3分)-N log r- 当N 足够长,总可以实现无失真编码。

............................. (3分) 密3、简述唯一可译变长码的判断方法?- 答:将码C 中所有可能的尾随后缀组成一个集合F ,当且仅当集合 F 中没有包含任一码字-时,码C 为唯一可译变长码。

构成集合 F 的方法: ............. (2分) 首先,观察码C 中最短的码字是否是其他码字的前缀。

若是,将其所有可能的尾随后缀排 列出。

而这些尾随后缀又可能是某些码字的前缀, 再将由这些尾随后缀产生的新的尾随后缀列出。

依此下去,直至没有一个尾随后缀是码字的前缀或没有新的尾随后缀产生为止。

.............(2分)接着,按照上述步骤将次短的码字直至所有码字可能产生的尾随后缀全部列出, 得到尾随后缀集合F 。

............. (2分) 4、简述最大离散熵定理。

信息论考题及答案

一、(25分)如果X 和Y 相互独立,证明X 和Y 的熵满足可加性,即 H(Y)H(X)Y)H(X,+= 证明:设P(x,y)=P(x)P(y),则有1H(X,Y)()()logP()()11()()log()()log ()()11()log()log ()()()()xyxyxy xy P x P y x P y P x P y P x P y P x P y P x P y P x P y H X H Y ==+=+=+∑∑∑∑∑二、(50分)联合总体X ,Y 具有如下联合分布。

XY分别计算(1) 联合熵H(X,Y)是多少? (2)边缘熵H(X)和H(Y)是多少?(3)对于每一个y 值,条件熵H(X ︱y)是多少? (4)条件熵H(X ︱Y)是多少? (5)X 和Y 之间的互信息是多少? 解答:(1) H(X,Y)=3.375(2) H(X)=2, H(Y)=1.75(3) H(X|y=1)=2,H(X|y=1)=1.875,H(X|y=1)=1.875, H(X|y=4)=0.5(4)H(X|Y)=1.1264(5)I(X;Y)=H(X)-H(X|Y)=2-1.1264=0.8736 三、(25分)考虑一个差错概率为f=0.15的二进制对称信道。

输入总体为x Ω:{0P =0.9,1p =0.1},假设观察到y=1,请计算(1|1)P x y ==? 解:(1|1)P x y ===(1|1)(1)(1|)()xP y x P x P y x P x ===∑==9.015.01.085.01.085.0⨯+⨯⨯=22.0085.0=0.39一、(25分)如果X 和Y 相互独立,证明X 和Y 的熵满足可加性,即 H(Y)H(X)Y)H(X,+=二、(50分)联合总体X ,Y 具有如下联合分布。

XY分别计算(1) 联合熵H(X,Y)是多少? (2)边缘熵H(X)和H(Y)是多少?(3)对于每一个y 值,条件熵H(X ︱y)是多少? (4)条件熵H(X ︱Y)是多少? (5)X 和Y 之间的互信息是多少?三、(25分)考虑一个差错概率为f=0.15的二进制对称信道。

信息论基础及答案

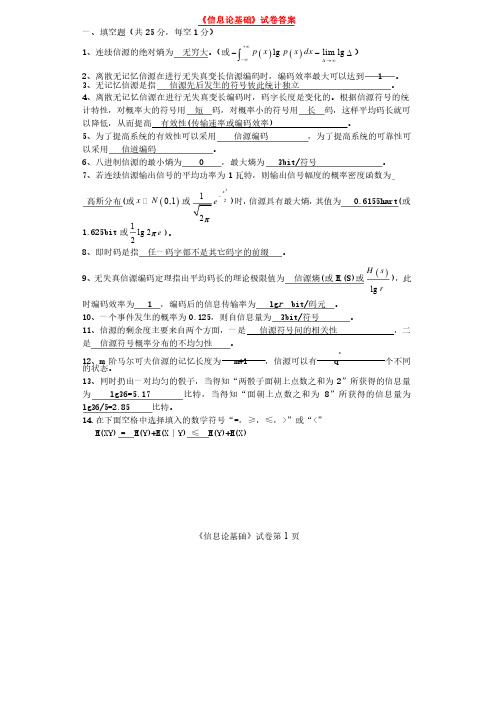

《信息论基础》试卷第1页《信息论基础》试卷答案一、填空题(共25分,每空1分)1、连续信源的绝对熵为无穷大。

(或()()lg lim lg p x p x dx +¥-¥D ®¥--D ò)2、离散无记忆信源在进行无失真变长信源编码时,编码效率最大可以达到、离散无记忆信源在进行无失真变长信源编码时,编码效率最大可以达到 1 1 1 。

3、无记忆信源是指信源先后发生的符号彼此统计独立。

4、离散无记忆信源在进行无失真变长编码时,码字长度是变化的。

根据信源符号的统计特性,对概率大的符号用短码,对概率小的符号用长码,这样平均码长就可以降低,从而提高有效性有效性((传输速率或编码效率传输速率或编码效率) ) ) 。

5、为了提高系统的有效性可以采用信源编码,为了提高系统的可靠性可以采用信道编码。

6、八进制信源的最小熵为、八进制信源的最小熵为 0 0 0 ,最大熵为,最大熵为,最大熵为 3bit/ 3bit/ 3bit/符号符号。

7、若连续信源输出信号的平均功率为1瓦特,则输出信号幅度的概率密度函数为高斯分布高斯分布((或()0,1x N 或2212x ep-)时,信源具有最大熵,其值为其值为 0.6155hart( 0.6155hart( 0.6155hart(或或1.625bit 或1lg 22e p )。

8、即时码是指任一码字都不是其它码字的前缀。

9、无失真信源编码定理指出平均码长的理论极限值为信源熵信源熵((或H r (S)(S)或或()lg H s r),此时编码效率为时编码效率为 1 1 1 ,编码后的信息传输率为,编码后的信息传输率为,编码后的信息传输率为 lg lg r bit/ bit/码元码元。

1010、一个事件发生的概率为、一个事件发生的概率为0.1250.125,则自信息量为,则自信息量为,则自信息量为 3bit/ 3bit/ 3bit/符号符号。

信息论 试卷与答案

答:最大离散熵定理为:离散无记忆信源,等概率分布时熵最大。

最大熵值为

。

3.解释信息传输率、信道容量、最佳输入分布的概念,说明平均互信息与信源的 概率分布、信道的传递概率间分别是什么关系?

答:信息传输率 R 指信道中平均每个符号所能传送的信息量。信道容量是一个信道所能达到 的最大信息传输率。信息传输率达到信道容量时所对应的输入概率分布称为最佳输入概率分 布。

一、概念简答题(每题 5 分,共 40 分)

1.什么是平均自信息量与平均互信息,比较一下这两个概念的异同?

答:平均自信息为 表示信源的平均不确定度,也表示平均每个信源消息所提供的信息量。

平均互信息

表示从 Y 获得的关于每个 X 的平均信息量,也表示发 X 前后 Y 的平均不确定性减少的量,还 表示通信前后整个系统不确定性减少的量。

概念简答题(每题 5 分,共 40 分) 1. 2. 3.答:信息传输率 R 指信道中平均每个符号所能传送的信息量。信道容量是一个信道所能达到的最大信息 传输率。信息传输率达到信道容量时所对应的输入概率分布称为最佳输入概率分布。

平均互信息是信源概率分布的∩型凸函数,是信道传递概率的 U 型凸函数。 4. 5 6 7.答:当 R<C 时,只要码长足够长,一定能找到一种编码方法和译码规则,使译码错误概率无穷小。 8. 二、综合题(每题 10 分,共 60 分)

8.什么是保真度准则?对二元信源 求 a>0 时率失真函数的 和 ?

答:1)保真度准则为:平均失真度不大于允许的失真度。

,其失真矩阵

,

2)因为失真矩阵中每行都有一个 0,所以有 。

二、综合题(每题 10 分,共 60 分) 1.黑白气象传真图的消息只有黑色和白色两种,求:

08信息论基础试卷级答案

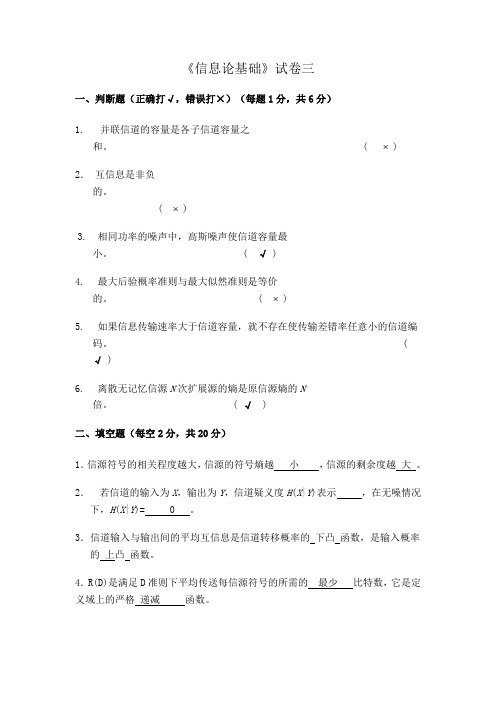

《信息论基础》试卷三一、判断题(正确打√,错误打×)(每题1分,共6分)1.并联信道的容量是各子信道容量之和。

( ⨯ )2.互信息是非负的。

( ⨯ )3.相同功率的噪声中,高斯噪声使信道容量最小。

( √ )4.最大后验概率准则与最大似然准则是等价的。

( ⨯ )5.如果信息传输速率大于信道容量,就不存在使传输差错率任意小的信道编码。

( √ )6.离散无记忆信源N次扩展源的熵是原信源熵的N倍。

( √ )二、填空题(每空2分,共20分)1.信源符号的相关程度越大,信源的符号熵越小,信源的剩余度越大。

2.若信道的输入为X,输出为Y,信道疑义度H(X|Y)表示,在无噪情况下,H(X|Y)= 0 。

3.信道输入与输出间的平均互信息是信道转移概率的下凸函数,是输入概率的上凸函数。

4.R(D)是满足D准则下平均传送每信源符号的所需的最少比特数,它是定义域上的严格递减函数。

6. AWGN 信道下实现可靠通信的信噪比下界为 -1.59 dB ,此时对应的频谱利用率为.0 。

三、计算题(共74分)1.(16分)设信源X 的符号集为{0,1,2},其概率分布为1014P P==,122P =,每信源符号通过两个信道同时传输,输出分别为Y ,Z ,两信道转移概率如图所示:XY1201XZ121求(1)H (Y ),H (Z ); (各2分共4分) (2)H (XY ),H (XZ ),H (XYZ ); (各2分共6分) (3)I (X;Y ),I (X;Z ), I (Y;Z ); (各2分共6分)2. (共18分)一个离散无记忆信源发出M 个等概率消息,每个消息编成长度为n 的码字通过一个离散无记忆二元对称信道传输。

设信道的输入为X ,输出为 Y , 错误率为0.1;n 长编码序列的每一个符号按达到信道容量的概率选择,共选择M 个码字,n 选得足够大。

1) 求该信道的信道容量;(5分)2) 当传输速率达到容量时,确定M 与n 的关系。

信息论考试卷与答案..

考试科目名称:信息论一. 单选(每空2分,共20分)1.一个m位的二进制数的自信息量为(A )A.m bitB.1 bitC.m2mD.22.信源编码的目的是(A )A.提高通信有效性B.提高信息传输的可靠性C.提高通信系统的安全性D.压缩信源的冗余度3.下面属于最佳变长编码的是(C )A.算术编码和游程编码B.香农编码和游程编码C.哈夫曼编码和费诺编码D.预测编码和香农编码4.表中符合即时码的是(A )和(D )5.下列各量可能为负值的是(B )A.自信息量B.互信息量C.信息熵D.平均互信息量6.联合熵H(XY)与熵H(X)及条件熵H(X/Y)之间存在关系错误的是(D )A.H(XY)=H(X)+H(Y/X)B.若X和Y相互独立,H(Y)=H(Y/X)C.H(XY)=H(Y)+H(X/Y)D.H(XY)=H(X)+H(X/Y)7.已知发送26个英文字母(包括空格),其最大信源熵(发送概率相等)为H0 = log27 = 4.76比特/符号;在字母发送概率不等时,其信源熵为H1 = 4.03比特/符号;考虑字母之间相关性时,其信源熵为H2 = 3.32=1.4比特/符号。

问若用一般传送比特/符号;以此类推,极限熵H∞方式,冗余度γ为( B )A.0.58B.0.71C.0.65D.0.298. 某信道传递矩阵为,其信道容量为( D )A .)41log 4143log 43()81,81,41,21(4log ++-=H C B .)41log 4343log 41()81,81,41,21(2log +--=H C C .)41log 4143log 43()81,81,41,21(4log +--=H CD .)41log 4143log 43()81,81,41,21(2log +--=H C9. 下列各图所示信道是对称信道的是( C )A .B .C .⎥⎥⎥⎦⎤⎢⎢⎢⎣⎡=8181214181814121PD.二. 综合(共80分)1.(10分)试画出通信系统的模型,并叙述各部分的定义和作用。

信息论期末考试试题 答案

安徽大学2011—2012学年第1学期 《信息论》考试试卷参考答案(AB 合卷)一、 填空题 1、()(;)log()()p xy I x y p x p y =;2、事物运动状态或存在方式的不确定性的描述;3、(|)log(|)(|)p xy z p x z p y z ;4、信源 编码器 信道 译码器 信宿;5、保密性 认证性;6、0.72;7、 , ;8、(;)C I X Y - ;9、4.6 ; 10、0H ≥1H ≥4H ≥6H ≥∞H ; 11、()()1log log N L H S H S r N r N≤<+; 12、()f x 在q F 上不可约; 13、()g x |1n x -; 14、2F 、22F 、32F 、42F 、62F 、122F ; 15、8,4.二、判断题1、╳2、√3、√4、╳5、╳6、√7、√8、╳9、 ╳三、计算题 1、解:1111()log log 12222H X =--=1()log24H Y =-= 1()log 38H Z =-=当Z Y X ,,为统计独立时:()()()()1236H XYZ H X H Y H Z =++=++=2、解:二次扩展信源为2111213212223313233,,,,,,,,411111111,,,,,,,,9999363693636x x x x x x x x x x x x x x x x x x X P ⎡⎤⎡⎤=⎢⎥⎢⎥⎢⎥⎣⎦⎣⎦信源熵:22HX H X =()()22112log 2log )3366=-+⨯(=2log3-2/3比特/二符号 3、解:1)信道到矩阵为1/31/61/31/61/61/31/61/3P ⎛⎫= ⎪⎝⎭,故此信道为对称信道1111log 4(,,,)3636C H =-5l o g 33=-(比特/符号)相应的最佳输入概率分布为等概率分布。

(2)信道到矩阵为1/21/31/61/61/21/31/31/61/2P ⎛⎫ ⎪= ⎪ ⎪⎝⎭,故此信道为对称信道111l o g 3(,,)236C H =-12log 323=- (比特/符号) 相应的最佳输入概率分布为等概率分布。

《信息论》试题(精华)及答案(精华版)

期终练习,10%就是胖子 ,80%不胖不瘦 ,10%就是瘦子;已知胖子得高血压的概率 一,某地区的人群中 就是 15% ,不胖不瘦者得高血压的概率就是 10%,瘦子得高血压的概率就是 5% ,就“该地区的 某一位高血压者就是胖子”这句话包含了多少信息量;解: 设大事 A: 某人就是胖子 ; B: 某人就是不胖不瘦 C:某人就是瘦子D: 某人就是高血压者依据题意 ,可知 :P(A)=0 , 1 P(B)=0 , 8 P(C)=0 ,1P(D|A)=0 , 15 P(D|B)=0 , 1 P(D|C)=0 , 05而“该地区的某一位高血压者就是胖子” 这一消息说明在 D 大事发生的条件下 ,A 大事 的发生 ,故其概率为 依据贝叶斯定律 P(A|D),可得 :P(D) = P(A)* P(D|A) + P(B)* P(D|B) +P(C)* P(D|C) = 0, 1P(A|D) = P(AD)/P(D) = P(D|A)*P(A)/ P(D) = 0, 15*0 , 1/0, 1= 0,15故得知“该地区的某一位高血压者就是胖子”这一消息获得的多少信息量为 I(A|D) = - logP(A|D)=log(0 ,15) ≈ 2, 73 (bit): 二,设有一个马尔可夫信源 ,它的状态集为 {S 1,S 2,S 3}, 符号集为 {a 1,a 2,a 3 }, 以及在某状态下发出 p (a k | s i ) (i,k=1,2,3), 如下列图符号集的概率就是 (1) 求图中马尔可夫信源的状态极限概率并找出符号的极限概率(2) 运算信源处在某一状态下输出符号的条件熵 H(X|S=j) (j=s 1,s 2,s 3)(3) 求出马尔可夫信源熵 H解 :(1) 该信源达到平稳后 , 有以下关系成立 :Q( E 1 ) Q(E 3 ) 273727Q(E 1 )3 4 1 4 1 2 1 2 Q( E 2 ) Q(E 1 ) Q( E 2 )Q(E )可得 2 Q( E 3 ) Q(E 1 ) Q( E 2 )Q(E ) 3Q( E 1 ) Q(E 2 ) Q(E 3 ) 133 72 73 7 p(a 1)Q(E i ) p( a 1 |E i ) i 13 p(a 2 )Q(E i ) p(a 2 |E i ) i 1 3p(a ) Q(E ) p(a |E ) 3 i 3 i i 13 p(a k |S 1 ) log p(a k | S 1) 1.(5 bit/ 符号)H ( X | S 1 ) k 13(1 bit/ 符号)(2) H ( X | S 2 ) p(a k |S 2 ) log p(a k | S 2 ) k 13p(a k |S 3 ) log p(a k | S 3 ) 0(bit/ 符号)H ( X | S 3 ) k 13(3) H Q(E i ) H (X | E i ) 2 / 7*3/ 2 3/ 7*1 2 / 7*0 6 / 7 (比特 /符号 )i 1三,二元对称信道的传递矩阵为 (1) 如 P(0)=3/4,P(1)=1/4, 求 H(X),H(X|Y) 与 I(X;Y)(2) 求该信道的信道容量及其最大信道容量对应的正确输入分布2解: ⑴ H ( X ) = p(x i )log p( x i ) 75 25 0, 811(比特 /符号 )= i 1p( y 1 ) p( x 1 ) p( y 1 | x 1 ) p( x 2 ) p( y 1 | x 2 ) =0,75*0 ,6+0 , 25*0 , 4=0 , 55 p( y 2 ) p( x 1 ) p( y 2 | x 1 ) p( x 2 ) p( y 2 | x 2 ) 0, 75*0 , 4+0 , 25*0 , 6=0, 45 H (Y) 0, 992(比特 /符号 )H (Y | X ) p( x)H (Y | x 1) p(x 2 ) H (Y | x 2 ) H (0.6,0.4) H (0.4,0.6) 0.4)7(1 比特 / 符号)H ( X | Y ) H ( XY ) H (Y) H ( X ) H (Y | X ) H (Y)0, 811+0, 971-0 , 992=0, 79 (比特 /符号 )I(X;Y)=H(X)-H(X|Y) =0, 811-0, 79=0, 021(比特 /符号 )(2) 此信道为二元对称信道 ,所以信道容量为C=1-H(p)=1-H(0 , 6)=1-0 , 971=0, 029( 比特 /符号 )当输入等概分布时达到信道容量p p 22pp2244,其中p 1 p ;四,求信道的信道容量0 44 0p p 22pp22解: 这就是一个准对称信道,可把信道矩阵分为: ,N1 M 1 1 4 , N 2 4 , M 422C log r H ( p 2, p 2 ,0,4 ) Nk log Mkk 1log 2 H ( p 2 , p 2 ,0,4 )(1 4 )log(1 44)4log 4(比特/ 符号)故1H ( p 2 , p 2 ,4 ) (1 4 )log(1 4 ) log 4 当输入等概分布时达到信道容量;1XP( x) x1x2x3x4x5x6五,信源(1) 利用霍夫曼码编成二元变长的惟一可译码,并求其L,并求其L(2) 利用费诺码编成二元变长的惟一可译码(3) 利用香农码编成二元变长的惟一可译码(1) 香农编码:,并求其信源符号x 1x 2x 3x 4x 5x 6概率P(x i)0,40,20,20,10,050,05码长233455累积概率0,40,60,80,90,95码字0001110011001110011110l i PL =0 ,4×2+0,2×3+0,2×3+0,1×4+0,05×5+0,05×5=2,9(码元/信源符号)η=H(X)/( L logr)=2 ,222/2,9=0 ,7662(2) 霍夫曼编码:L =0 ,4×2+0,2×2×2+0 ,1×3+0,05×4×2=2,3(码元/信源符号)η=H(X)/( L logr)=0 ,9964(3)费诺编码:L =0 ,4×2+0,2×2×2+0 ,1×3+0,05×4×2=2,3(码元/信源符号)η=H(X)/( L logr)= 0 ,99641 21312161613121613六,设有一离散信道,传递矩阵为设P(x1 )= P(x 2)=1/4,P(x 3)=1/2,试分别按最小错误概率准就与最大似然译码准就确定译码规章并相应的运算机平均错误概率的大小;解:(1) 按最大似然译码准就,F(y1)=x1 F(y2)=x2 F(y3)=x3P(E)=1/2(1/3+1/6)+1/4 ×2×(1/3+1/6)=1/2(2) 联合概率矩阵为,就按最小错误概率准1 8 1 24 1 61121811212411214F(y1)=x3 F(y2)=x2 F(y3)=x3 P(E)= 1/8+1/24+2/12 +1/24+1/12=11/240,131,13213UP(u)八,一个三元对称信源0 1 1 1 0 1 11接收符号为 V = {0,1,2}, 其失真矩阵为 (1)求 D max 与 D min 及信源的 R(D) 函数;(2)求出达到 R(D ) 的正向试验信道的传递概率1 r2 3解 :(1) D max = min P ( u ) d(u ,v) 1 V U 3D min = P ( u ) min d (u , v) 0 j i 1由于就是三元对称信源 ,又就是等概分布 ,所以依据 r 元离散对称信源可得 R(D) =log3 - Dlog2 -H(D) = log3 - D - H(D) 0<=D<=2/3= 0 D>2/3(2)满意 R(D) 函数的信道其反向传递概率为1 D (i j )P(u i | v j ) D2 (i j )13以及有 P(v j )= 依据依据贝叶斯定律 ,可得该信道的正向传递概率为 :1 D2 D (i j )P( v j | u i ) (i j )九,设二元码为 C=[11100,01001,10010,00111](1) 求此码的最小距离 d min ;(2) 采纳最小距离译码准就 ,试问接收序列 10000,01100 与 00100 应译成什么码字?(3) 此码能订正几位码元的错误?解:(1) 码距如左图11100 01001 10010 001111110001001 10010 00111 33 4 43 3故 d min = 3(2) 码距如右图故 10000 译为 译为 11100,00100 译为 11100 或 0011110010,01100 d min 2 e 1,知此码能订正一位码元的错误;(3) 依据。

信息论测试题与答案

信息论测试题与答案⼀、设X、Y是两个相互统计独⽴的⼆元随机变量,其取-1 或1 的概率相等。

定义另⼀个⼆元随机变量Z,取Z=YX(⼀般乘积)。

试计算:1.H(Y)、H(Z);2.H (YZ);3.I (X;Y)、I (Y;Z);⼆、如图所⽰为⼀个三状态马尔科夫信源的转移概率矩阵1. 绘制状态转移图;2. 求该马尔科夫信源的稳态分布;3. 求极限熵;三、在⼲扰离散对称信道上传输符号 1 和0,已知P(0)=1/4,P(1)=3/4, 试求:1. 信道转移概率矩阵P2. 信道疑义度3. 信道容量以及其输⼊概率分布四、某信道的转移矩阵0.6 0.3 0.1 0P ,求信道容量,最佳输⼊概率分布。

0.3 0.6 0 0.1五、求下列各离散信道的容量(其条件概率P(Y/X) 如下:)六、求以下各信道矩阵代表的信道的容量答案⼀、设X、Y是两个相互统计独⽴的⼆元随机变量,其取-1或1的概率相等。

定义另⼀个⼆元随机变量Z,取Z=YX(⼀般乘积)。

试计算:1.H(Y)、H(Z);2.H(XY)、H(YZ);3.I(X;Y)、I(Y;Z);解:1.21111()=-()()=1bit/符号H Y P y logP y log logi i2222i1Z=YX ⽽且X 和Y 相互独⽴P(Z1=1)=P(Y=1)P(X1)P(Y1)P(X1)= 11111 22222P(Z2=-1)=P(Y=1)P(X1)P(Y1)P(X1)= 11111 222222故H(Z)= P(z)log P(z)=1bit/ 符号iii12.从上式可以看出:Y 与X 的联合概率分布为:P(Y,Z) Y=1 Y=-1Z=1 0.25 0.25Z=-1 0.25 0.25H(YZ)=H(X)+H(Y)=1+1=2bit/ 符号2. X 与Y 相互独⽴,故H(X|Y)=H(X)=1bit/ 符号I (X;Y)=H(X)-H(X|Y)=1-1=0bit/ 符号I(Y;Z)=H(Y)-H(Y|Z)=H(Y)-[H(YZ)-H(Z)]=0 bit/ 符号⼆、如图所⽰为⼀个三状态马尔科夫信源的转移概率矩阵3. 绘制状态转移图; 2. 求该马尔科夫信源的稳态分布; 3. 求极限熵;解:1. 状态转移图如右图32. 由公式p(E j ) P(E i ) P(E j | E i ) ,可得其三个状态的稳态概率为:i 11 1 1P(E ) P(E ) P(E ) P(E )1 12 32 2 41 1P(E ) P(E ) P(E )2 2 32 21 1P(E ) P(E ) P(E )3 1 32 4P(E ) P(E ) P(E ) 11 2 3 P(E )1P(E )2P(E )33727273. 其极限熵:33 1 1 2 1 1 2 1 1 1H = - |E = 0 + 0 +P(E)H(X )H(,,)H(,,)H(,,)i i7 2 2 7 2 2 7 4 2 4 i 13 2 2 8= 1+ 1+ 1.5= bit/7 7 7 7符号三、在⼲扰离散对称信道上传输符号 1 和0,已知P(0)=1/4,P(1)=3/4, 试求:2. 信道转移概率矩阵P 2. 信道疑义度3. 信道容量以及其输⼊概率分布4.4.0.7110.9解:1. 该转移概率矩阵为P= 0.90.1 0.10.92. 根据P(XY)=P(Y|X)P(X),可得联合概率P(XY)Y YX=0 9/40 1/40X=1 3/40 27/40P(Y=i) 12/40 28/40由P(X|Y)=P(X|Y)/P(Y) 可得P(X|Y) Y=0 Y=1X=0 3/4 1/28X=1 1/4 27/28H(X|Y)=- i j (i j)符号P(x y ) log P x |y =0.09+0.12+0.15+0.035=0.4bit/ i ,j 3. 该信道是对称信道,其容量为:C=logs-H=log2-H (0.9,0.1 )=1-0.469=0.531bit/ 符号这时,输⼊符号服从等概率分布,即XP(X ) 0 11 12 2四、某信道的转移矩阵3.0.3 0.1 0P ,求信道容量,最佳输⼊概率分布。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

中国海洋大学2008—2009学年第一学期

一、填空题(每空2分,共20分)

1、1948年,美国数学家 香农 发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。

2、信源编码的目的是提高通信的有效性。

信道编码的最终目的是提高信号传输的可靠性。

3、离散平稳无记忆信源X 的N 次扩展信源的熵等于离散信源X 的熵的N 倍。

4、对于香农编码、费诺编码和哈夫曼编码,编码方法惟一的是香农编码。

5、信道输入与输出间的平均互信息是信道转移概率的 下凸 函数,是输入概率的 上凸 函数。

6、信道矩阵⎥⎦⎤⎢⎣⎡10002/12/1代表的信道的信道容量C=符号/1bit ,达到信道容量的条件是输入符号等概分布。

7、 设某二进制码{00011,10110,01101,11000,10010,10001},则码的最小距离是2 ,假设码字等概分布,则该码的码率为 0.517比特/符号 ,这时若通过二元对称信道接收码字为01100和00110时,应译为01101 , 10110 。

二、判断题(每题2分,共10分)

1、必然事件和不可能事件的自信息量都是0 。

(错)

2、最大后验概率准则与最大似然准则是等价的。

(错)

3、如果信息传输速率大于信道容量,就不存在使传输差错率任意小的信道编码。

(对)

4、连续信源和离散信源的熵都具有非负性。

(错)

5、相同功率的噪声中,高斯噪声使信道容量最小。

(对) 三、简答题(第1、2题各6分,第三题10分,共22分)

1、简述最大离散熵定理。

对于一个有m 个符号的离散信源,其最大熵是什么? 答:最大离散熵定理为:离散无记忆信源,等概率分布时熵最大。

(3分) 最大熵值为

m

H 2max log = (3分)

2、对于任意概率事件集X 、Y 、Z ,证明下述三角不等式成立()()()Z X H Z Y H X H ≥+ 证:因为)|()|(Y X H YZ X H ≤ ,(3分) 所以:

)

|()|()|()

|,()

|()|()|()|(Z Y H XZ Y H Z Y H Z Y X I YZ X H Z X H Y X H Z X H ≤-==-≤-(3分)

所以原命题得证。

3、什么是保真度准则?对二元信源()⎥⎦⎤⎢⎣⎡-=⎥⎦⎤⎢⎣⎡ωω110u p u ,其失真矩阵⎥

⎦⎤

⎢⎣⎡=00ααD ,求0>α时率失真函数的min D 和max D ?

答:1)保真度准则为:平均失真度不大于允许的失真度。

(3分)

2)因为失真矩阵中每行都有一个0,所以有0min =D (2分),

而(){}()⎪⎩

⎪⎨⎧<

≥-=-=21

211,1min max

ωωαωαωωααωD 。

(5分)

四、计算题(第1、2、3题每题15分,第4题10分,共55分)

1、黑白气象传真图的消息只有黑色和白色两种,求:(1)黑色出现的概率为0.3,白色出现的概率为0.7。

给出这个只有两个符号的信源X 的数学模型,假设图上黑白消息出现前后没有关联,求熵

()X H ;(2)假设黑白消息出现前后有关联,其依赖关系为:P(白/白)=0.9,P(黑/白)=0.1,P(白/

黑)=0.2,P(黑/黑)=0.8,求其熵()X H 2。

答:(1)信源模型为()⎥⎦⎤

⎢⎣⎡===⎥

⎦⎤⎢⎣⎡7.03

.021白黑x x x p X (5分) ()()()符号/881.07.0log 7.03.0log 3.0log 2

1bit x p x p X H i i i =--=-=∑=(5分)

(2)由()()()()()⎪⎩⎪⎨⎧

=+=∑=1

21

2

1

x P x P x x P x P x P j j i j i (2,1=i )(3分) 可得()()()()()()()()⎪⎩⎪⎨⎧=++=+=1

9.02.01.08.021212211x P x P x P x P x P x P x P x P 得⎪⎪⎩

⎪⎪⎨⎧====32)(3

1)(11白黑x P x P (3分)

则()()()

[][]符号

/5533.09.0log 9.01.0log 1.032

1.0log 1.08.0log 8.031log )(2212

1

2bit x x P x x P x P X H i j i j i j i =⨯+⨯⨯-⨯+⨯⨯-=-=∑∑== (4分)

2、设有一离散信道,其信道矩阵为⎥

⎦

⎤

⎢⎣⎡=7.01.02.02.01.07.0p ,求(1)最佳概率分布?(2)当()7.01=x P ,()3.02=x P 时,求平均互信息()Y X I ;和信道疑义度()Y X H /;(3)输入为等概分布时,试写出一译码

规则,使平均译码错误率E p 最小,并求此E p 。

答:(1)是准对称信道,因此其最佳输入概率分布为()()5.021==x p x p (2分) (2)由已知的输入概率空间和信道转移概率,可求得输出概率

()()()∑==2

1i i j i j x y p x p y p (2分)

()()()55.02.03.07.07.021

11=⨯+⨯==∑=i i i x y p x p y p

()()()1

.01.03.01.07.02

122=⨯+⨯==∑=i i i x y p x p y p

()()()35

.07.03.02.07.02

1

33=⨯+⨯==∑=i i i x y p x p y p

(2分)

()()()

符号/3367.135.0log 35.01.0log 1.055.0log 55.0log 3

1

bit y p y p Y H j j j =⨯-⨯-⨯-=-=∑=(2分)

()()()()

()

()符号

/1569.17.0log 7.01.0log 1.02.0log 2.03.02.0log 2.01.0log 1.07.0log 7.07.0log 3

1

2

1

bit x y p x y p x p X Y H j i i i i i i =⨯+⨯+⨯⨯-⨯+⨯+⨯⨯-=-=∑∑==(2分)

平均互信息()()()符号/1798.01569.13367.1;bit X Y H Y H Y X I =-=-=(2分)

()()()符号/8813.07.0log 7.03.0log 3.0log 2

1bit x p x p X H i i i =⨯-⨯-=-=∑=(2分)

信道疑义度()()()符号/7015.01798.08813.0;bit Y X I X H Y X H =-=-=(2分) (3)此时可用最大似然译码准则,译码规则为

()11x y F =,()212x x y F 或=,()23x y F = (2分)

平均译码错误率

()[]

()()25.02.01.02.02

1

18,=++⨯==

=∑-a X Y i j j E a b p r y e p E p (2分) 3、(共20分)某离散无记忆信源符号集为 ,所对应的概率分别为:0.4,0.2,0.1,0.1,

0.07,0.05,0.05,0.02,0.01,码符号集为{0,1,2,3}。

1) 求信源的熵H (X )及信源剩余度 ;(2+2=4分)

信源的熵:

(2分)信源剩余度:(2分)

2)对其进行四元Huffman编码;(5分)

,其中,若取,可得大于9但与9最接近的正整数10,因此在Huffman 编码是加入一个零概率符号。

编码为332;编码为331;编码为330;编码为32;编码为31;编码为30;编码为2;

编码为1;编码为0

3)求平均码长,编码效率及编码器输出的信息传输率(码率)R。

平均码长:

码元/信息符号(2分)编码效率:0.9194(2分)

信息传输速率: 1.8388比特/符号(2分)

4、已知加性高斯白噪声(AWGN,Add itiveWhite Gaussian Noise)信道,信号的带宽范围为300~3400Hz,信号与噪声功率比为26 dB,(1)计算该信道的最大信息传输速率;(2)若信号与噪声功率比降到10dB,且保持信道最大信息传输速率不变,则信道带宽应该变为多少?

解:(1)计算该信道的最大信息传输速率;(5分)

W=3400-300=3100Hz

SNR=26dB=398

(2)若信号与噪声功率比降到10dB,且保持信道最大信息传输速率不变,则信道带宽应该变为多少?(5分)

SNR=10dB=10。