回归分析讲义

回归分析实例PPT课件

线性回归分析的应用

预测

使用线性回归模型来预测因变 量的值,基于给定的自变量值

。

解释变量关系

通过线性回归分析来了解自变 量与因变量之间的数量关系和 影响程度。

控制变量效应

在实验或调查中,控制自变量 的影响,以观察因变量的变化 情况。

模型的建立和检验

模型的建立

首先需要收集数据,并进行数据 清洗和预处理,然后选择合适的 自变量和因变量,建立逻辑回归

模型。

模型的检验

通过多种检验方法对模型进行评 估,包括参数估计、假设检验、 模型诊断等,以确保模型的准确

性和可靠性。

模型的优化

根据检验结果对模型进行调整和 优化,包括参数调整、变量筛选

详细描述

收集产品在过去一段时间的销售数据,包括销售额、销售量等,作为自变量, 将未来某一段时间的产品销量作为因变量,建立回归模型。通过模型预测未来 产品销量,为企业制定生产和销售计划提供依据。

实例三:疾病风险预测

总结词

基于个人健康数据和疾病历史,建立回归模型预测疾病风险。

详细描述

收集个人的健康数据和疾病历史,包括血压、血糖、胆固醇等生理指标以及家族 病史等信息,作为自变量,将未来患某种疾病的风险作为因变量,建立回归模型 。通过模型预测个人患某种疾病的风险,为预防和早期干预提供参考。

线性关系的假设

自变量x与因变量y之间存在线性关系, 即随着x的增加(或减少),y也相应 地增加(或减少)。

模型的建立和检验

01

02

03

数据收集与整理

收集相关数据,并进行必 要的整理和清洗,以确保 数据的质量和可靠性。

《回归分析》PPT课件

多元共线性

即数学上的线性相依,指在回归模型中 预测变量本身间有很高的相关。

有很多评价指标,如容差(容忍度)、 VIF,特征值

特征值若小于0.01,预测变量间可能存在多元共线性;

方差比例:若有两个或多个自变量在一个特征值上高于0.8 或 0.7以上,表示 可能存在多元共线性

整理成表格

表1 福利措施、同侪关系、适应学习对组织效能的影响

Beta

t

福利 0.180 5.513*

措施

**

同侪 0.264 8.166*

关系

**

适应 0.369 12.558

学习

***

R=0.73 R2=0.5 F=464.

阶层回归

如第一层自变量为福利措施 第二层为同辈关系 第三层为适应学习

学习完毕请自行删除

什么是回归分析

用一定的数学模型来表述变量相关关系 的方法。

一元线性回归

最简单的回归是只涉及一个因变量和一个自变量一元 线性回归,此时的表达式为:

y= 0+ 1 x+ y为因变量,x为自变量或预测变量, 0为截距即当

x=0时y的值, 1为斜率即1个单位的x变化对应 1个单 位y的变化。 是误差,服从N(0, σ2)的正态分布,不 同观察值之间是相互。

练习

“组织效能.sav”

15回归系数及检验组织效能0180福利措施0264同侪关系0369适应学习在回归分析中若自变量间中高相关则某些与因变量有关系的变量会被排除在回归模型之外容差及方差膨胀系数vif检验多元回归分析的共线性问题

《回归分析》PPT课件

本课件PPT仅供学习使用 本课件PPT仅供学习使用 本课件PPT仅供学习使用

回归分析专题教育课件

学习目的 掌握简朴线性回归模型基本原理。 掌握最小平措施。 掌握测定系数。 了解模型假定。 掌握明显性检验 学会用回归方程进行估计和预测。 了解残差分析。

1

习题

1. P370-1 2. P372-7 3. P380-18

4. P380-20 5. P388-28 6. P393-35

2

案例讨论: 1.这个案例都告诉了我们哪些信息? 2.经过阅读这个案例你受到哪些启发?

3

根据一种变量(或更多变量)来估计 某一变量旳措施,统计上称为回归分析 (Regression analysis)。

回归分析中,待估计旳变量称为因变 量(Dependent variables),用y表达;用来 估计因变量旳变量称为自变量 (Independent variables),用x表达。

yˆ b0 b1 x (12.4)

yˆ :y 旳估计值

b0 :0 旳估计值

b1 : 1 旳估计值

18

19

第二节 最小平措施

最小平措施(Least squares method), 也称最小二乘法,是将回归模型旳方差之 和最小化,以得到一系列方程,从这些方 程中解出模型中需要旳参数旳一种措施。

落在拒绝域。所以,总体斜率 1 0 旳假

设被拒绝,阐明X与Y之间线性关系是明显

旳。

即 12 条 航 线 上 , 波 音 737 飞 机 在 飞 行

500公里和其他条件相同情况下,其乘客数

量与飞行成本之间旳线性关系是明显旳。

57

单个回归系数旳明显性检验旳几点阐明

为何要检验回归系数是否等于0?

假如总体中旳回归系数等于零,阐明相应旳自变 量对y缺乏解释能力,在这种情况下我们可能需 要中回归方程中去掉这个自变量。

数理统计CH回归分析课件

2024/10/4

21

回归最小二乘估计

(2)最小二乘思想

n

n

| i |

2 i

i 1

i 1

残差计算:

yi a bxi i

i yi a bxi

➢用残差(误差)平 方和代表试验点与 回归直线旳总距离

2024/10/4

➢回归方程旳最小二乘

估计可归结为求解下

面旳优化模型:

n

Min a,b

n i 1

yi

a

bxi

2

n i 1

b

yi a bxi

2

n

2 yi a bxi xi i 1

2024/10/4

24

回归最小二乘估计

(3)回归最小二乘估计

x

1 n

n i 1

xi

y

1 n

n i 1

yi

Q 0 a aˆ,b bˆ a

n

即 2 yi aˆ bˆxi 0 i 1

2024/10/4

40

回归明显性检验

(3)模型和假设

线性回归模型 线性有关假设

➢由线性回归模型可推论:

E yi E a bxi i a bxi

Var yi Var a bxi i Var i 2

2024/10/4

10

7.2 一元线性回归

(1)案例和问题

x称作自变量 y称作响应变量

案例:某特种钢抗拉强度试 抗拉强度试验成果 验,控制某稀有金属含量x

x(%) y(MPa) 测得不同抗拉强度y,试验

2.07 128 成果如表所示。

3.10 194 4.14 273 5.17 372 6.20 454

yi

应用统计方法第四章-回归分析PPT课件

• 回归分析概述 • 线性回归分析 • 非线性回归分析 • 多元回归分析 • 回归分析的注意事项

01

回归分析概述

回归分析的定义

回归分析是一种统计学方法,用于研 究自变量和因变量之间的相关关系, 并建立数学模型来描述这种关系。

它通过分析因变量对自变量的依赖程 度,来预测因变量的未来值或解释因 变量的变异。

影响

共线性会导致回归系数不 稳定,降低模型的预测精 度和可靠性。

解决方法

通过剔除不必要的自变量、 使用主成分分析等方法来 降低共线性的影响。

05

回归分析的注意事项

数据质量与预处理数据完整性源自确保数据集中的所有必要 信息都已收集,没有遗漏 或缺失值。

数据准确性

核实数据的准确性,并处 理任何错误或异常值。

回归分析的分类

线性回归分析

研究自变量和因变量之间线性关系的回归分析。

多元回归分析

研究多个自变量与一个因变量之间关系的回归分析。

ABCD

非线性回归分析

研究自变量和因变量之间非线性关系的回归分析,如多 项式回归、指数回归、对数回归等。

一元回归分析

研究一个自变量与一个因变量之间关系的回归分析。

回归分析的应用场景

02

线性回归分析

线性回归模型

线性回归模型

描述因变量与自变量之间线性关系的 数学模型。

模型形式

(Y = beta_0 + beta_1X_1 + beta_2X_2 + ldots + beta_pX_p + epsilon)

最小二乘法估计

最小二乘法

01

通过最小化预测值与实际值之间的残差平方和来估计回归参数

《回归分析三》课件

03 诊断工具

如残差图、杠杆值、DW检验等,用于进一步诊 断模型的潜在问题。

模型的预测与评估

1 2

预测

基于已知的自变量x值,使用回归模型预测因变 量y的值。

预测精度评估

通过计算预测值与实际值之间的均方误差(MSE )或均方根误差(RMSE)来评估预测精度。

半参数回归在处理复 杂数据和解释性建模 方面具有广泛应用, 如生物医学、环境科 学和经济学等领域。

THANKS

感谢观看

3

模型评估

将模型应用于新数据或实际情境中,以评估模型 的实用性和预测能力。

03

多元线性回归分析

多元线性回归模型

多元线性回归模型

模型形式

假设条件

描述因变量与多个自变量之间 的关系,通过最小二乘法估计 参数。

$Y = beta_0 + beta_1X_1 + beta_2X_2 + ... + beta_pX_p + epsilon$,其中$Y$是因变 量,$X_1, X_2, ..., X_p$是自 变量,$beta_0, beta_1, ..., beta_p$是待估计的参数, $epsilon$是误差项。

分位数回归在金融、医学、环境科学 等领域有广泛应用。

半参数回归分析

半参数回归是一种非 完全参数化的回归分 析方法,它结合了参 数回归和非参数回归 的优点。

半参数回归模型既包 含参数部分,也包含 非参数部分,能够更 好地拟合数据的复杂 性和不确定性。

常见的半参数回归模 型包括部分线性模型 、可加模型和单指标 模型等。

01 预测模型

通过回归分析建立预测模 型,预测未来的趋势和结 果。

《回归分析 》课件

通过t检验或z检验等方法,检验模型中各个参数的显著性,以确定 哪些参数对模型有显著影响。

拟合优度检验

通过残差分析、R方值等方法,检验模型的拟合优度,以评估模型是 否能够很好地描述数据。

非线性回归模型的预测

预测的重要性

非线性回归模型的预测可以帮助我们了解未来趋势和进行 决策。

预测的步骤

线性回归模型是一种预测模型,用于描述因变 量和自变量之间的线性关系。

线性回归模型的公式

Y = β0 + β1X1 + β2X2 + ... + βpXp + ε

线性回归模型的适用范围

适用于因变量和自变量之间存在线性关系的情况。

线性回归模型的参数估计

最小二乘法

最小二乘法是一种常用的参数估计方法,通过最小化预测值与实 际值之间的平方误差来估计参数。

最大似然估计法

最大似然估计法是一种基于概率的参数估计方法,通过最大化似 然函数来估计参数。

梯度下降法

梯度下降法是一种迭代优化算法,通过不断迭代更新参数来最小 化损失函数。

线性回归模型的假设检验

线性假设检验

检验自变量与因变量之间是否存在线性关系 。

参数显著性检验

检验模型中的每个参数是否显著不为零。

残差分析

岭回归和套索回归

使用岭回归和套索回归等方法来处理多重共线性问题。

THANKS

感谢观看

04

回归分析的应用场景

经济学

研究经济指标之间的关系,如GDP与消费、 投资之间的关系。

市场营销

预测产品销量、客户行为等,帮助制定营销 策略。

生物统计学

研究生物学特征与疾病、健康状况之间的关 系。

中级经济师—经济基础 第二十六章 回归分析-课件新

二、最小二乘法

(一)最小二乘法 ★

最小二乘法就是使得因变量的观测值yi与估计值yෝ i之间的离 差(又称残差)平方和最小来估计参数β0和β1 的方法。

y

yi

yi - yෝ i

ෝy i = β 0 +β 1X

yi

值yෝ i

0

x1

xi

x

20

小试一下

【单选题】最小二乘法就是使得因变量的( β0和β1的方法。 A.平均值与估计值之间的离差平方和 B.观测值与真值之间的离差平方和

小试一下 【单选题】在一元线性回归模型Y=β0 +β1X+ε中, ε反映的是 ( )。 A.X和Y的线性关系对Y的影响 B.由自变量X的变化引起的因变量Y的变化 C.X和Y的线性关系对X的影响 D.除X和Y的线性关系之外的随机因素对Y的影响

14

小试一下 【答案】D 【解析】误差项ε是个随机变量,表示除线性关系之外的随机因素 对Y的影响,它是不能由X和Y的线性关系所解释的Y的变异性。

《经济基础知识》中级

1

目录 CONTENT

第一部分:经济学基础 第二部分:财政 第三部分:货币与金融

第四部分:统计 第五部分:会计 第六部分:法律

2

第四部分 统计

3

23.统计与数据科学 24.描述统计

25.抽样调查

目录内容

26.回归分析 27.时间序列分析

4

第二十六章 回归分析

5

本章教材结构

一般情况下,在使用估计的回归方程之前,需要对模型进行检

验:

①结合经济理论和经验分析回归系数的经济含义是否合理; ②分析估计的模型对数据的拟合效果如何; ③对模型进行假设检验。

24

6回归分析-简单难度-讲义

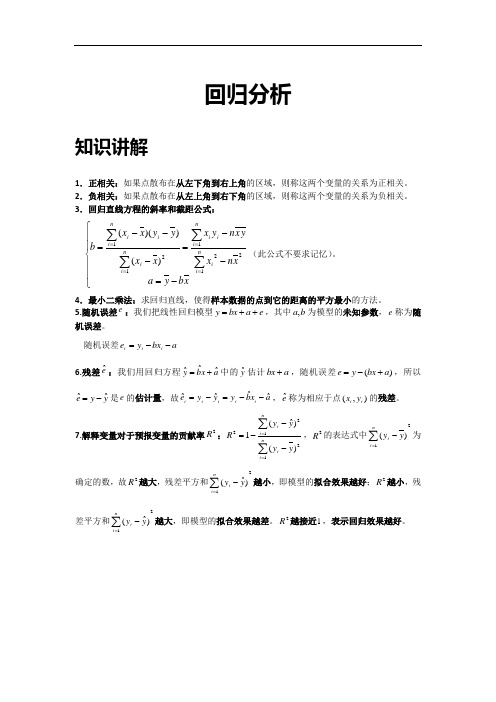

回归分析知识讲解1.正相关:如果点散布在从左下角到右上角的区域,则称这两个变量的关系为正相关。

2.负相关:如果点散布在从左上角到右下角的区域,则称这两个变量的关系为负相关。

3.回归直线方程的斜率和截距公式:⎪⎪⎩⎪⎪⎨⎧-=--=---=∑∑∑∑====xb y a xn x yx n yx x x y y x xb ni i ni ii ni i i ni i1221121)()()((此公式不要求记忆)。

4.最小二乘法:求回归直线,使得样本数据的点到它的距离的平方最小的方法。

5.随机误差e :我们把线性回归模型e a bx y ++=,其中b a ,为模型的未知参数,e 称为随机误差。

随机误差a bx y e i i i --=6.残差eˆ:我们用回归方程a x b y ˆˆˆ+=中的y ˆ估计a bx +,随机误差)(a bx y e +-=,所以y y e ˆˆ-=是e 的估计量,故a x b y y y e ii i i i ˆˆˆˆ--=-=,e ˆ称为相应于点),(i i y x 的残差。

7.解释变量对于预报变量的贡献率2R :∑∑==---=ni ini iy yyy R 12122)()ˆ(1,2R 的表达式中21)(∑=-ni i y y 为确定的数,故2R 越大,残差平方和21)ˆ(∑=-ni i yy 越小,即模型的拟合效果越好;2R 越小,残差平方和21)ˆ(∑=-ni i yy 越大,即模型的拟合效果越差。

2R 越接近1,表示回归效果越好。

典例精讲一.选择题(共12小题)1.(2018春•禅城区校级期末)在线性回归模型中,分别选择了4个不同的模型,它们的相关指数R2依次为0.36、0.95、0.74、0.81,其中回归效果最好的模型的相关指数R2为()A.0.95B.0.81C.0.74D.0.362.(2017秋•黄陵县校级月考)一项研究要确定是否能够根据施肥量预测作物的产量.这里的被解释变量是()A.作物的产量B.施肥量C.试验者D.降雨量或其他解释产量的变量3.(2017秋•荆州区校级月考)已知变量x和y的统计数据如表x681012y2356根据上表可得回归直线方程y^=0.7x+a,据此可以预测,当x=14时,y=()A.7.2B.7.5C.7.8D.8.14.(2017春•临夏市校级月考)设有一个回归方程y∧=﹣6.5x+6,变量x每增加一个单位时,变量y∧平均()A.增加6.5个单位B.增加6个单位C.减少6.5个单位D.减少6个单位5.(2017春•伊春区校级期末)某商店统计了最近6个月某商品的进份x与售价y(单位:元)的对应数据如表:x3528912y46391214假设得到的关于x和y之间的回归直线方程是y∧=bx+a,那么该直线必过的定点是()A.(8,6)B.(5,7)C.(8,6.5)D.(6.5,8)6.(2017春•商丘期末)对两个变量x和y进行回归分析,得到一组样本数据:(x1,y1),(x2,y2),…(x n,y n),则下列说法中不正确的是()A.由样本数据得到的回归方程∧y=b∧x+a∧必过样本中心(x−,y−)B.残差平方和越小的模型,拟合的效果越好C.若变量y和x之间的相关系数为r=﹣0.9362,则变量和之间具有线性相关关系D.用相关指数R2来刻画回归效果,R2越小,说明模型的拟合效果越好7.(2017春•三元区校级期中)a,b,c,d四个人各自对两个变量x,y进行相关性的测试试验,并用回归分析方法分别求得相关指数R2与残差平方和m(如表),则这四位同学中,()同学的试验结果体现两个变量x,y有更强的相关性.a b c dr0.800.760.670.82m10011312199 A.a B.b C.c D.d8.(2017春•中原区校级期中)下列可以用来分析身高和体重之间的关系的是( ) A .残差分析 B .回归分析 C .等高条形图 D .独立性检验9.(2017春•乾安县校级月考)对两个变量进行回归分析,则下列说法中不正确的是( )A .有样本数据得到的回归方程y ∧=b ∧x +a ∧必经过样本中心(x ,y ) B .残差平方和越大,模型的拟合效果越好C .用R 2来刻画回归效果,R 2越大,说明模型的拟合效果越好D .若散点图中的样本呈条状分布,则变量y 和x 之间具有线性相关关系10.(2017春•赣州期中)两个变量y 与x 的回归模型中,分别选择了4个不同模型,它们对应的回归系数r 如下,其中变量之间线性相关程度最高的模型是( )A .模型1对应的r 为﹣0.98B .模型2对应的r 为0.80C .模型3对应的r 为0.50D .模型4对应的r 为﹣0.2511.(2016秋•武昌区校级期末)对于给定的样本点所建立的模型A 和模型B ,它们的残差平方和分别是a 1,a 2,R 2的值分别为b 1,b 2,下列说法正确的是( )A .若a 1<a 2,则b 1<b 2,A 的拟合效果更好B .若a 1<a 2,则b 1<b 2,B 的拟合效果更好C .若a 1<a 2,则b 1>b 2,A 的拟合效果更好D .若a 1<a 2,则b 1>b 2,B 的拟合效果更好12.(2017•泸州模拟)某研究机构对儿童记忆能力x和识图能力y进行统计分析,得到如下数据:记忆能力x46810识图能力y3568由表中数据,求得线性回归方程为y^=45x+a^,若某儿童的记忆能力为12时,则他的识图能力为()A.9.2B.9.5C.9.8D.10二.填空题(共5小题)13.(2009春•通州区期末)某兴趣小组随机抽取了50个家庭的年可支收入x(单位:元)与年家庭消费y(单位:元)的数据,发现x和y之间具有较强的线性相关关系,回归系数约为0.5,回归街区约为380,据此可以估计某家庭年可支配收入15000元,改家庭年消费大约元.14.若施化肥量x与小麦产量y之间的回归方程为y^=250+4x(单位:kg),当施化肥量为50kg时,预计小麦产量为kg.15.(2017秋•扶余县校级期末)对于回归直线方程y^=4.75x+257,当x=28时,y 的估计值为.16.(2017春•青山区校级期末)两个相关变量的关系如下表x1236y 2 7﹣n 12 19+n利用最小二乘法得到线性回归方程为y =bx +a ,已知a ﹣b=2,则3a +b= .17.(2016秋•新余期末)一组数据中,经计算x =10,y =4,回归直线的斜率为0.6,则利用回归直线方程估计当x=12时,y= .三.解答题(共3小题)18.(2013春•蓟县期中)某种产品的广告费用支出x (万元)与销售额y (万元)之间有如下的对应数据: x 2 4 5 6 8 y3040605070(1)画出散点图; (2)求回归直线方程;(3)据此估计广告费用为9万元时,销售收入y 的值.参考公式:回归直线的方程y =bx +a ,其中b=∑n i=1(x 1−x)(y i −y)=∑ni=1x i y i −nxy∑i=1x i 2−nx2,a=y ﹣b x .19.我国1993年至2002年的国内生产总值(GDP )的数据如下:年份 GDP/亿元 1993 34634.4 1994 46759.4 1995 58478.1 199667884.61997 74462.6 1998 78345.2 1999 82067.5 2000 89468.1 2001 97314.8 2002104790.6(1)作GDP 和年份的散点图,根据该图猜想它们之间的关系是什么. (2)建立年份为解释变量,GDP 为预报变量的回归模型,并计算残差. (3)根据你得到的模型,预报2003年的GDP ,看看你的预报与实际GDP (117251.9亿元).(4)你认为这个模型能较好的刻画GDP 和年份关系吗?请说明理由.20.改革开放以来,我国高等教育事业有了突飞猛进的发展,有人记录了某村2001到2005年五年间每年考入大学的人数,为了方便计算,2001年编号为1,2002年编号为2,…,2005年编号为5,数据如下: 年份(x ) 1 2 3 4 5 人数(y )3581113求y 关于x 的回归方程y ^=b ^x +a ^所表示的直线必经的点.。

回归分析演讲PPT

13

经济预测与决策方法讲义

1.2 一元线性回归预测法—模型构建

回归预测模型 回归分析是对具有相关关系的变量之间的数量变化规律进

变量 yˆi 相应增加(减少)多少。 ➢ b 0 时, x 与 y 正相关,当 b 0 时, x 与 y 负相关。

16

经济预测与决策方法讲义

1.2 一元线性回归预测法—参数估计

估计模型的回归系数方法有很多,最广泛的是最小二乘法;

中心思想:通过数学模型,配合一条较为理想的趋势线;

(1) 原数列的预测值与模型估计值的离差平方和最小;

当显著性水平 0.05时,试估计 2004 年

其国内生产总值的预测区间。

20

年份

1986 1987 1988 1989 1990 1991 1992 1993 1994 1995 1996 1997 1998 1999 2000 2001 2002 2003

固定资产投 资完成额 x 241.23 317.12 371.87 320.23 356.3 439.98 711.7 1144.2 1331.13 1680.17 1949.53 2203.09 2535.5 2744.65 2995.43 3304.96 3849.24 5335.8

➢ 因变量 y 就是我们的预测对象;服从 y N(a bx, 2) ➢ 常数 a, b 是待定的参数。

15

经济预测与决策方法讲义

1.2 一元线性回归预测法—模型构建 设

回归分析法PPT课件

线性回归模型的参数估计

最小二乘法

通过最小化误差平方和的方法来估计 模型参数。

最大似然估计

通过最大化似然函数的方法来估计模 型参数。

参数估计的步骤

包括数据收集、模型设定、参数初值、 迭代计算等步骤。

参数估计的注意事项

包括异常值处理、多重共线性、自变 量间的交互作用等。

线性回归模型的假设检验

假设检验的基本原理

回归分析法的历史与发展

总结词

回归分析法自19世纪末诞生以来,经历 了多个发展阶段,不断完善和改进。

VS

详细描述

19世纪末,英国统计学家Francis Galton 在研究遗传学时提出了回归分析法的概念 。后来,统计学家R.A. Fisher对其进行了 改进和发展,提出了线性回归分析和方差 分析的方法。随着计算机技术的发展,回 归分析法的应用越来越广泛,并出现了多 种新的回归模型和技术,如多元回归、岭 回归、套索回归等。

回归分析法的应用场景

总结词

回归分析法广泛应用于各个领域,如经济学、金融学、生物学、医学等。

详细描述

在经济学中,回归分析法用于研究影响经济发展的各种因素,如GDP、消费、投资等;在金融学中,回归分析法 用于股票价格、收益率等金融变量的预测;在生物学和医学中,回归分析法用于研究疾病发生、药物疗效等因素 与结果之间的关系。

梯度下降法

基于目标函数对参数的偏导数, 通过不断更新参数值来最小化目 标函数,实现参数的迭代优化。

非线性回归模型的假设检验

1 2

模型检验

对非线性回归模型的适用性和有效性进行检验, 包括残差分析、正态性检验、异方差性检验等。

参数检验

通过t检验、z检验等方法对非线性回归模型的参 数进行假设检验,以验证参数的显著性和可信度。

回归分析学习课件PPT课件

为了找到最优的参数组合,可以使用网格搜索方 法对参数空间进行穷举或随机搜索,通过比较不 同参数组合下的预测性能来选择最优的参数。

非线性回归模型的假设检验与评估

假设检验

与线性回归模型类似,非线性回归模型也需要进行假设检验,以检验模型是否满足某些统计假 设,如误差项的独立性、同方差性等。

整估计。

最大似然法

03

基于似然函数的最大值来估计参数,能够同时估计参数和模型

选择。

多元回归模型的假设检验与评估

线性假设检验

检验回归模型的线性关系 是否成立,通常使用F检 验或t检验。

异方差性检验

检验回归模型残差的异方 差性,常用的方法有图检 验、White检验和 Goldfeld-Quandt检验。

多重共线性检验

检验回归模型中自变量之 间的多重共线性问题,常 用的方法有VIF、条件指数 等。

模型评估指标

包括R方、调整R方、AIC、 BIC等指标,用于评估模 型的拟合优度和预测能力。

05

回归分析的实践应用

案例一:股票价格预测

总结词

通过历史数据建立回归模型,预测未来股票 价格走势。

详细描述

利用股票市场的历史数据,如开盘价、收盘价、成 交量等,通过回归分析方法建立模型,预测未来股 票价格的走势。

描述因变量与自变量之间的非线性关系,通过变 换或使用其他方法来适应非线性关系。

03 混合效应回归模型

同时考虑固定效应和随机效应,适用于面板数据 或重复测量数据。

多元回归模型的参数估计

最小二乘法

01

通过最小化残差平方和来估计参数,是最常用的参数估计方法。

加权最小二乘法

02

适用于异方差性数据,通过给不同观测值赋予不同的权重来调

《回归分析)》课件

收集和整理相关数据,并进行数据清洗和变量转换,为模型建立做准备。

2

模型的建立和检验

选择适当的回归模型,进行参数估计和模型检验,确保模型的准确性和可靠性。

3

模型的应用和解释

利用已建立的模型进行预测和解释因变量的变化,探索自变量对因变量的影响。

回归因变量之间的关系。

非线性回归分析

使用非线性模型来描述自变 量和因变量之间的关系。

多元回归分析

考虑多个自变量对因变量的 影响,并建立多元回归模型。

回归分析的评价指标

• 实际因子与预测因子之间的相关系数 • 平均绝对误差 • 可决系数

回归分析的应用

经济学领域

回归分析可用于预测经济因素 之间的关系,如GDP与失业率的 关系。

社会学领域

回归分析可用于研究社会现象 和行为之间的关系,如教育水 平与收入的关系。

工程学领域

回归分析可用于工程问题的预 测和优化,如建筑材料的强度 与耐久性的关系。

回归分析的限制条件

• 不同因素的关系并非线性 • 自变量之间的相关性 • 数据量的大小和均匀性

总结和展望

回归分析是一种强大的工具,能够帮助我们理解变量之间的关系,并进行预 测和解释。未来,随着数据科学的发展,回归分析在各个领域的应用将会更 加广泛。

《回归分析)》PPT课件

回归分析是一种用于研究变量之间关系的统计方法。本课程将介绍回归分析 的定义、步骤、类型、评价指标以及应用领域,并探讨其限制条件。

什么是回归分析

回归分析是一种统计方法,用于研究自变量和因变量之间的关系。通过建立 数学模型,预测和解释因变量的变化。

回归分析的步骤

1

数据的收集和处理

Spss线性回归分析讲稿ppt课件

察其与因变量之间是否具有线性关系。然后,

将自变量进行组合,生成若干自变量的子集,再

针对每一个自变量的子集生成回归分析报告。

比较调整后的R2值,挑选最优的自变量子集,

生成回归分析模型。

火灾袭来时要迅速疏散逃生,不可蜂 拥而出 或留恋 财物, 要当机 立断, 披上浸 湿的衣 服或裹 上湿毛 毯、湿 被褥勇 敢地冲 出去

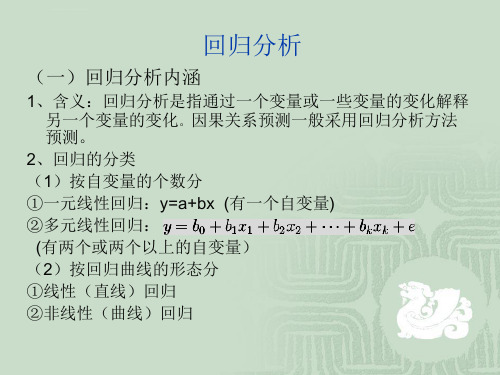

①一元线性回归:y=a+bx (有一个自变量)

②多元线性回归:

(有两个或两个以上的自变量)

(2)按回归曲线的形态分

①线性(直线)回归

②非线性(曲线)回归

火灾袭来时要迅速疏散逃生,不可蜂 拥而出 或留恋 财物, 要当机 立断, 披上浸 湿的衣 服或裹 上湿毛 毯、湿 被褥勇 敢地冲 出去

回归分析

(二)回归分析的主要内容

即销售量的95%以上的变动都可以被该模型所解释,拟和优度较高。

表3

火灾袭来时要迅速疏散逃生,不可蜂 拥而出 或留恋 财物, 要当机 立断, 披上浸 湿的衣 服或裹 上湿毛 毯、湿 被褥勇 敢地冲 出去

一元线性回归分析

表4给出了回归模型的方差分析表,可以看到,F统计量为

734.627,对应的p值为0,所以,拒绝模型整体不显著的

图1

奖金-销售量表

火灾袭来时要迅速疏散逃生,不可蜂 拥而出 或留恋 财物, 要当机 立断, 披上浸 湿的衣 服或裹 上湿毛 毯、湿 被褥勇 敢地冲 出去

一元线性回归

以奖金-销售量表图1做回归分析

2、绘制散点图

打开数据文件,选择【图形】-【旧对话框】-【散点/点状】

图2

火灾袭来时要迅速疏散逃生,不可蜂 拥而出 或留恋 财物, 要当机 立断, 披上浸 湿的衣 服或裹 上湿毛 毯、湿 被褥勇 敢地冲 出去

回归分析讲义范文

回归分析讲义范文回归分析是一种统计方法,用于研究两个或更多变量之间的关系。

它是一种预测性建模方法,可以用来预测因变量的值,基于独立变量的值。

回归分析广泛应用于经济学、金融学、社会科学和自然科学等领域。

回归分析的基本思想是建立一个数学模型,通过寻找最佳拟合线来描述自变量和因变量之间的关系。

最常用的回归模型是线性回归模型,其中自变量和因变量之间的关系可以用一条直线表示。

但是,回归分析也可以应用于非线性关系,如二次、指数和对数关系等。

线性回归模型的一般形式是:Y=β0+β1X1+β2X2+...+βnXn+ε其中Y是因变量,X1,X2,...,Xn是自变量,β0,β1,...,βn是模型的参数,ε是误差项。

回归分析的目标是估计模型的参数,以最小化观测值与拟合值之间的残差平方和。

通常使用最小二乘法来估计参数。

最小二乘法通过最小化残差平方和来确定最佳拟合线。

除了估计模型的参数,回归分析还提供了一些统计指标来评估模型的拟合程度和预测能力。

其中最常见的指标是决定系数(R-squared),它表示模型解释了因变量的变异性的比例。

R-squared的取值范围是0到1,值越接近1表示模型拟合得越好。

此外,回归分析还可以用来评估自变量的影响大小和统计显著性。

通过估计参数的标准误差和计算置信区间,可以确定自变量的影响是否显著。

回归分析的前提是自变量和因变量之间存在关系。

如果变量之间没有明显的关系,回归模型将不具备解释能力。

此外,回归分析还要求数据满足一些假设,如线性关系、多元正态分布和同方差性。

回归分析有许多扩展和改进的方法。

常见的包括多元回归分析、逐步回归、岭回归和逻辑回归等。

多元回归分析用于研究多个自变量对因变量的影响,逐步回归用于选择最佳自变量子集,岭回归用于解决多重共线性问题,逻辑回归用于二元因变量或多元因变量。

总之,回归分析是一种重要的统计方法,可以用于研究变量之间的关系和预测因变量的值。

通过建立数学模型、估计参数和评估拟合程度,回归分析可以为决策提供有用的信息和洞察力。

spss第五讲回归分析PPT课件

2、用于判断误差的假定是否成立 3、检测有影响的观测值

34

残差图

(形态及判别)

残

差

0

残

残

差

差

0

0

x

(a)满意模式

x

(b)非常数方差

x

(c)模型不合适

35

二、检验正态性 标准化残差(standardized residual)

2. E(y0) 在1-置信水平下的置信区间为

yˆ0 t 2 (n 2)se

1

n

x0 x 2

n

xi x 2

i 1

式中:se为估计标准误差

29

个别值的预测区间

1. 利用估计的回归方程,对于自变量 x 的一个给定值 x0 ,求出因变量 y 的一个个别值的估计区间,这一

区间称为预测区间(prediction interval) 2. y0在1-置信水平下的预测区间为

一、变差 1、因变量 y 的取值是不同的,y 取值的这种波动称为变

差。变差来源于两个方面

由于自变量 x 的取值不同造成的 除 x 以外的其他因素(如x对y的非线性影响、测量误差等)

的影响

2、对一个具体的观测值来说,变差的大小可以通过该 实际观测值与其均值之差y y 来表示

16

误差分解图

y

(xi , yi )

32

一、检验方差齐性

残差(residual)

1、因变量的观测值与根据估计的回归方程求 出的预测值之差,用e表示

ei yi yˆi

2、反映了用估计的回归方程去预测而引起的 误差

3、可用于确定有关误差项的假定是否成立 4、用于检测有影响的观测值

北大暑期课程《回归分析》(Linear-Regression-Analysis)讲义PKU5

Class 5: ANOVA (Analysis of Variance) andF-testsI.What is ANOVAWhat is ANOVA? ANOVA is the short name for the Analysis of Variance. The essence ofANOVA is to decompose the total variance of the dependent variable into two additivecomponents, one for the structural part, and the other for the stochastic part, of a regression. Today we are going to examine the easiest case.II.ANOVA: An Introduction Let the model beεβ+= X y .Assuming x i is a column vector (of length p) of independent variable values for the i th'observation,i i i εβ+='x y .Then is the predicted value. sum of squares total:[]∑-=2Y y SST i[]∑-+-=2'x b 'x y Y b i i i[][][][]∑∑∑-+-+-=Y -b 'x b 'x y 2Y b 'x b 'x y 22i i i i i i[][]∑∑-+=22Y b 'x e i ibecause .This is always true by OLS. = SSE + SSRImportant: the total variance of the dependent variable is decomposed into two additive parts: SSE, which is due to errors, and SSR, which is due to regression. Geometric interpretation: [blackboard ]Decomposition of VarianceIf we treat X as a random variable, we can decompose total variance to the between-group portion and the within-group portion in any population:()()()i i i x y εβV 'V V +=Prove:()()i i i x y εβ+='V V()()()i i i i x x εβεβ,'Cov 2V 'V ++=()()iix εβV 'V +=(by the assumption that ()0 ,'Cov =εβk x , for all possible k.)The ANOVA table is to estimate the three quantities of equation (1) from the sample.As the sample size gets larger and larger, the ANOVA table will approach the equation closer and closer.In a sample, decomposition of estimated variance is not strictly true. We thus need toseparately decompose sums of squares and degrees of freedom. Is ANOVA a misnomer?III.ANOVA in MatrixI will try to give a simplied representation of ANOVA as follows:[]∑-=2Y y SST i ()∑-+=i i y Y 2Y y 22∑∑∑-+=i i y Y 2Y y 22∑-+=222Y n 2Y n y i (because ∑=Y n y i )∑-=22Y n y i2Y n y 'y -=y J 'y n /1y 'y -= (in your textbook, monster look)SSE = e'e[]∑-=2Y b 'x SSR i()()[]∑-+=Y b 'x 2Y b 'x 22i i()[]()∑∑-+=b 'x Y 2Y n b 'x 22i i()[]()∑∑--+=i i ie y Y 2Y n b 'x 22()[]∑-+=222Y n 2Y n b 'x i(because ∑∑==0e ,Y n y i i , as always)()[]∑-=22Yn b 'x i2Y n Xb X'b'-=y J 'y n /1y X'b'-= (in your textbook, monster look)IV.ANOVA TableLet us use a real example. Assume that we have a regression estimated to be y = - 1.70 + 0.840 xANOVA TableSOURCE SS DF MS F with Regression 6.44 1 6.44 6.44/0.19=33.89 1, 18Error 3.40 18 0.19 Total 9.8419We know , , , , . If we know that DF for SST=19, what is n?n= 205.220/50Y ==84.95.25.22084.134Y n y SST 22=⨯⨯-=-=∑i()[]∑-+=0.1250.84x 1.7-SSR 2i[]∑-⨯⨯⨯-⨯+⨯=0.125x 84.07.12x 84.084.07.17.12i i= 20⨯1.7⨯1.7+0.84⨯0.84⨯509.12-2⨯1.7⨯0.84⨯100- 125.0 = 6.44SSE = SST-SSR=9.84-6.44=3.40DF (Degrees of freedom): demonstration. Note: discounting the intercept when calculating SST. MS = SS/DFp = 0.000 [ask students].What does the p-value say?V.F-TestsF-tests are more general than t-tests, t-tests can be seen as a special case of F-tests.If you have difficulty with F-tests, please ask your GSIs to review F-tests in the lab. F-tests takes the form of a fraction of two MS's.MSR/MSE F ,=df2df1An F statistic has two degrees of freedom associated with it: the degree of freedom inthe numerator, and the degree of freedom in the denominator.An F statistic is usually larger than 1. The interpretation of an F statistics is thatwhether the explained variance by the alternative hypothesis is due to chance. In other words, the null hypothesis is that the explained variance is due to chance, or all the coefficients are zero.The larger an F-statistic, the more likely that the null hypothesis is not true. There is atable in the back of your book from which you can find exact probability values.In our example, the F is 34, which is highly significant. VI.R2R 2 = SSR / SSTThe proportion of variance explained by the model. In our example, R-sq = 65.4%VII.What happens if we increase more independent variables. 1.SST stays the same. 2.SSR always increases. 3.SSE always decreases. 4.R2 always increases. 5.MSR usually increases. 6.MSE usually decreases.7.F-test usually increases.Exceptions to 5 and 7: irrelevant variables may not explain the variance but take up degrees of freedom. We really need to look at the results.VIII.Important: General Ways of Hypothesis Testing with F-Statistics.All tests in linear regression can be performed with F-test statistics. The trick is to run"nested models."Two models are nested if the independent variables in one model are a subset or linearcombinations of a subset (子集)of the independent variables in the other model.That is to say. If model A has independent variables (1, , ), and model B has independent variables (1, , , ), A and B are nested. A is called the restricted model; B is called less restricted or unrestricted model. We call A restricted because A implies that . This is a restriction.Another example: C has independent variable (1, , + ), D has (1, + ). C and A are not nested.C and B are nested.One restriction in C: . C andD are nested.One restriction in D: . D and A are not nested.D and B are nested: two restriction in D: 32ββ=; 0=1β.We can always test hypotheses implied in the restricted models. Steps: run tworegression for each hypothesis, one for the restricted model and one for the unrestricted model. The SST should be the same across the two models. What is different is SSE and SSR. That is, what is different is R2. Let()()df df SSE ,df df SSE u u r r ==;df df ()()0u r u r r u n p n p p p -=---=-<Use the following formulas:()()()()(),SSE SSE /df SSE df SSE F SSE /df r u r u dfr dfu dfu u u---=or()()()()(),SSR SSR /df SSR df SSR F SSE /df u r u r dfr dfu dfu u u---=(proof: use SST = SSE+SSR)Note, df(SSE r )-df(SSE u ) = df(SSR u )-df(SSR r ) =df ∆,is the number of constraints (not number of parameters) implied by the restricted modelor()()()22,2R R /df F 1R /dfur dfr dfu dfuuu--∆=- Note thatdf 1df ,2F t =That is, for 1df tests, you can either do an F-test or a t-test. They yield the same result. Another way to look at it is that the t-test is a special case of the F test, with the numerator DF being 1.IX.Assumptions of F-testsWhat assumptions do we need to make an ANOVA table work?Not much an assumption. All we need is the assumption that (X'X) is not singular, so that the least square estimate b exists.The assumption of =0 is needed if you want the ANOVA table to be an unbiased estimate of the true ANOVA (equation 1) in the population. Reason: we want b to be an unbiased estimator of , and the covariance between b and to disappear.For reasons I discussed earlier, the assumptions of homoscedasticity and non-serial correlation are necessary for the estimation of .The normality assumption that (i is distributed in a normal distribution is needed for small samples.X.The Concept of IncrementEvery time you put one more independent variable into your model, you get an increase in . We sometime called the increase "incremental ." What is means is that more variance is explained, or SSR is increased, SSE is reduced. What you should understand is that the incremental attributed to a variable is always smaller than the when other variables are absent.XI.Consequences of Omitting Relevant Independent VariablesSay the true model is the following:0112233i i i i i y x x x ββββε=++++.But for some reason we only collect or consider data on . Therefore, we omit in the regression. That is, we omit in our model. We briefly discussed this problem before. The short story is that we are likely to have a bias due to the omission of a relevant variable in the model. This is so even though our primary interest is to estimate the effect of or on y. Why? We will have a formal presentation of this problem.XII.Measures of Goodness-of-FitThere are different ways to assess the goodness-of-fit of a model.A. R2R2 is a heuristic measure for the overall goodness-of-fit. It does not have an associated test statistic.R 2 measures the proportion of the variance in the dependent variable that is “explained” by the model: R 2 =SSESSR SSRSST SSR +=B.Model F-testThe model F-test tests the joint hypotheses that all the model coefficients except for the constant term are zero.Degrees of freedoms associated with the model F-test: Numerator: p-1Denominator: n-p.C.t-tests for individual parametersA t-test for an individual parameter tests the hypothesis that a particular coefficient is equal to a particular number (commonly zero).tk = (bk- (k0)/SEk, where SEkis the (k, k) element of MSE(X ’X)-1, with degree of freedom=n-p. D.Incremental R2Relative to a restricted model, the gain in R 2 for the unrestricted model: ∆R 2= R u 2- R r 2E.F-tests for Nested ModelIt is the most general form of F-tests and t-tests.()()()()(),SSE SSE /df SSE df SSE F SSE /df r u r dfu dfr u dfu u u---=It is equal to a t-test if the unrestricted and restricted models differ only by one single parameter.It is equal to the model F-test if we set the restricted model to the constant-only model.[Ask students] What are SST, SSE, and SSR, and their associated degrees of freedom, for the constant-only model?Numerical ExampleA sociological study is interested in understanding the social determinants of mathematical achievement among high school students. You are now asked to answer a series of questions. The data are real but have been tailored for educational purposes. The total number of observations is 400. The variables are defined as: y: math scorex1: father's education x2: mother's educationx3: family's socioeconomic status x4: number of siblings x5: class rankx6: parents' total education (note: x6 = x1 + x2) For the following regression models, we know: Table 1 SST SSR SSE DF R 2 (1) y on (1 x1 x2 x3 x4) 34863 4201 (2) y on (1 x6 x3 x4) 34863 396 .1065 (3) y on (1 x6 x3 x4 x5) 34863 10426 24437 395 .2991 (4) x5 on (1 x6 x3 x4) 269753 396 .02101.Please fill the missing cells in Table 1.2.Test the hypothesis that the effects of father's education (x1) and mother's education (x2) on math score are the same after controlling for x3 and x4.3.Test the hypothesis that x6, x3 and x4 in Model (2) all have a zero effect on y.4.Can we add x6 to Model (1)? Briefly explain your answer.5.Test the hypothesis that the effect of class rank (x5) on math score is zero after controlling for x6, x3, and x4.Answer: 1. SST SSR SSE DF R 2 (1) y on (1 x1 x2 x3 x4) 34863 4201 30662 395 .1205 (2) y on (1 x6 x3 x4) 34863 3713 31150 396 .1065 (3) y on (1 x6 x3 x4 x5) 34863 10426 24437 395 .2991 (4) x5 on (1 x6 x3 x4) 275539 5786 269753 396 .0210Note that the SST for Model (4) is different from those for Models (1) through (3). 2.Restricted model is 01123344()y b b x x b x b x e =+++++Unrestricted model is ''''''011223344y b b x b x b x b x e =+++++(31150 - 30662)/1F 1,395 = -------------------- = 488/77.63 = 6.29 30662 / 395 3.3713 / 3F 3,396 = --------------- = 1237.67 / 78.66 = 15.73 31150 / 3964.No. x6 is a linear combination of x1 and x2. X'X is singular.5.(31150 - 24437)/1F 1,395 = -------------------- = 6713 / 61.87 = 108.50 24437/395t = 10.42t ===。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

回

一元线性回归分析 线性回归分析

归

多元线性回归分析

分 析

非线性回归分析

2020/9/19

9

一元线性回归:

例1 测16名成年女子的身高与腿长所得数据如下:

身 高1 4 31 4 51 4 61 4 71 4 91 5 01 5 31 5 41 5 51 5 61 5 71 5 81 5 91 6 01 6

2020/9/19

10

散点图

2020/9/19

腿长

102

100

98

96

94

92

90

88

86

84

140

150

身高

160

11 170

一元线性回归spss:

2020/9/19

12

2020/9/19

13

Estim:a默te认的输出项。 j、S输 j和出 其与 相伴概率值等。

Modfeilt:默认的输 .输出出项(调整), 判回 定归 系方 数程的。 标准误 Rsquarcehdan: ge方程引入或个 者自 踢变 出量 一以后。 的变化量 C2a02s0e/9/w 19 disieagnoss:输 tic出标准化残差 3的绝样对本值点的相1关 4 信息

2020/9/19

7

回归分析的基本思想

变量之间的关系

确定性关系 相 关关系

Sr2

身高和体重

确定性关系 相关关系

相关关系的特征是:变量之间的关系很难用一 种精确的方法表示出来.

回归分析——处理变量之间的相关关系的一 种数学方法,它是最常用的数理统计方法.

2020/9/19

8

起源:英国统计学家F.GALTON和K.PEARSON研究 身高问题时总结出来的。

腿 长8 8 8 5 8 8 9 1 9 2 9 3 9 3 9 5 9 6 9 8 9 7 9 6 9 8 9 91 0

以身高x为横坐标,以腿长y为纵坐标将这些数据点(xI,yi) 在平面直角坐标系上标出.

102

解答

100

98

y01x

96

94

92

90

88

86

84

140

145

150

155

160

165

2020/9/19

15

0.05:F统计量的相S伴 ig概 0.0率 , 5 应该引入回归方程; 0.1:F统计量的相S伴 ig概 0.1, 率应该从回归; 方程剔除

2020/9/19Leabharlann 162020/9/19

17

2020/9/19

18

显示:相R= 关 0.9系 9, 5R 数 2= 0.91, 3 经调R2整 = 0.9的 0, 6 估计标准 1.82误 。 49差 表明身高与 存腿 在长 线之 性间 相关

以身高x为横坐标,以腿长y为纵坐标将这些数据点(xI,yi) 在平面直角坐标系上标出.

102

解答

100

98

y01x

96

94

92

90

88

86

84

140

145

150

155

160

165

2020/9/19

3

散点图

多元线性回归:

20000

10000

人 均 GNP

0

70

60 50

2020/9服/1产9 比

40

13212.76

52.16

38.2 44.37

12099.78 8830.92

452.78 43.32

一元非线性回归:

高教入学率

60

50

40

30

20

10

0

-10

-10000

0

人 均 GDP

10000

20000

30000

40000

2020/9/19

5

11

10.5

10

9.5

9

8.5

8

7.5

7

6.5

6

30

0

10

20

30 40 50 60

高教入学

70

服务业产值

高校入学率 人均GNP

比

0.97

348.42

25.01

2.21

375.46

31.16

4.19

603.14

35.44

6.3

698.42

35.68

8.74

666.86

39.45

10.48

1501.88

43.92

12.36

1851.18

47.18

14.55

参 数 a和 b .采 用 的 方 法 是 通 过 变 量 代 换 把 非 线 性 回 归 化 成 线 性 回 归 , 即 采 用

非 线 性 回 归 线 性 化 的 方 法 .

2020/9/19

6

通常选择的六类曲线如下:

( 1 ) 双 曲 线 1 a b y x

( 2 ) 幂 函 数 曲 线 y = a x b , 其 中 x > 0 , a > 0

数学建模与数学实验

回归分析

2020/9/19

1

目的

1、了解回归分析基本内容。 2、掌握用数学软件求解回归分析问题。

一元线性回归:

例1 测16名成年女子的身高与腿长所得数据如下:

身 高1 4 31 4 51 4 61 4 71 4 91 5 01 5 31 5 41 5 51 5 61 5 71 5 81 5 91 6 01 6 21 6 4 腿 长8 8 8 5 8 8 9 1 9 2 9 3 9 3 9 5 9 6 9 8 9 7 9 6 9 8 9 91 0 01 0 2

1811.18

45.85

16.25

2099.16

46.3

19.05

3709.54

44.45

21.46

3592.09

36.98

23.59

4940.4

49.4

25.64

5899.97

51.89

27.59

9742.41

54.04

29.55

8462.23

52.88

31.55

14371.63

54.88

34.94

2020/9/19

19

表中显示方方 差和 来、 源自 、由 平 F度 比、 以均 及方 显、 著性

F的值 13为 .652, 0 其相伴 0.0概 0, 0率 即为 检验 H0: 假回 设归 “ j= 系 0”数

成立的概 0.0率 0, 0等 从于 而应 H0, 该说 拒明 绝回归效果显

2

4

6

8

10

12

14

16

散 点 图

此即非线性回归或曲线回归 问题(需要配曲线) 配曲线的一般方法是:

先 对 两 个 变 量 x 和 y作 n 次 试 验 观 察 得 (x i,y i)i ,1 ,2 ,.n .画 .出 ,散 点 图 ,

根 据 散 点 图 确 定 须 配 曲 线 的 类 型 .然 后 由 n 对 试 验 数 据 确 定 每 一 类 曲 线 的 未 知

( 3 ) 指 数 曲 线 y = a e b 其 中 参 数 a > 0 x .

( 4) 倒 指 数 曲 线 y=aeb/x 其 中 a>0,

( 5 ) 对 数 曲 线 y = a + b l o g x , x > 0 ( 6 ) S 型 曲 线 y 1

a b x e

也可根据专业知识直接确定类型,进而估计参数即可(logstic) 当然,多项式形式是一个通用的选择,但可能精度不高。