消息传递并行编程环境MPI

消息传递编程接口MPI

并行矩阵乘法

并行矩阵乘法是MPI的重要应用之一, 通过将矩阵划分为多个块,并在不同的 处理器上并行计算这些块之间的乘积, 最终得到完整的矩阵乘积。

MPI提供了各种函数,如`MPI_Matmul`, 用于在进程之间传递矩阵数据并进行乘法运 算。

并行矩阵乘法在高性能计算、机器 学习等领域有广泛应用,能够显著 提高计算速度和效率。

错误处理和调试

错误检测和处理

MPI提供了错误检测机制,允许程序员在运行时检测和 处理错误。例如,当发送进程尝试发送消息给不存在的 接收进程时,MPI会返回一个错误码,提示发送进程操 作失败。

调试工具

为了帮助程序员调试并行程序,MPI提供了一系列的调 试工具和技术。这些工具可以帮助程序员跟踪程序的执 行过程、检查变量的状态以及诊断潜在的错误来源。通 过使用这些工具,程序员可以提高程序的可靠性和可维 护性。

03 MPI编程模型

点对点通信

进程间一对一通信

MPI提供了点对点通信方式,允许两个进程 之间直接发送和接收消息。这种方式适用于 一对一的通信场景,如进程间数据交换或同 步。

通信模式

点对点通信支持同步和异步模式。在同步模 式下,发送进程会等待消息被接收后才继续 执行;在异步模式下,发送进程发送消息后 可以继续执行其他任务,不需要等待接收进

并行排序

01

02

03

并行排序是MPI的另一个常见应用, 通过将待排序数据划分为多个子集, 并在不同的处理器上并行进行排序, 最终合并得到完全排序的结果。

MPI提供了各种函数,如`MPI_Sort`, 用于在进程之间传递数据并进行排序操 作。

并行排序在处理大规模数据集时具有 显著优势,能够显著提高排序速度和 效率。

MPI并行程序设计

MPI并行程序设计MPI并行程序设计引言MPI(Message Passing Interface)是一种常用的并行计算编程模型,用于在分布式计算环境中实现并行程序设计。

MPI提供了在多个进程之间进行通信和同步的机制,使得程序能够充分利用集群或超级计算机的并行性能。

本文将介绍MPI的基本概念和使用方法,并帮助读者了解如何进行MPI并行程序设计。

MPI基本概念MPI的核心思想是将计算任务划分为多个子任务,并将这些子任务分发给不同的进程进行并行计算。

MPI使用消息传递的方式来实现进程之间的通信和同步。

以下是一些MPI的基本概念:进程通信在MPI中,每个并行计算的进程都有一个唯一的标识符,称为进程号(rank)。

进程之间可以使用通信操作进行消息传递,包括发送消息(send)、接收消息(receive)和同步(synchronize)等操作。

点对点通信点对点通信是指在两个进程之间进行消息传递,包括发送方和接收方。

发送方使用`MPI_Send`函数发送消息,接收方使用`MPI_Recv`函数接收消息。

广播通信广播通信是指一个进程向所有其他进程发送消息的操作。

发送方使用`MPI_Bcast`函数广播消息,接收方使用`MPI_Recv`函数接收消息。

归约操作归约操作是指将一组数值合并为一个数值的操作,如求和、求最大值等。

MPI提供了多种归约操作,包括`MPI_Reduce`和`MPI_Allreduce`。

并行计算模式MPI支持多种并行计算模式,包括主从模式、对等模式等。

在主从模式中,一个进程作为主进程,负责分发任务和收集结果;其余进程作为从进程,负责执行分配的子任务。

在对等模式中,所有进程都具有相同的任务和贡献。

MPI程序设计步骤编写MPI并行程序的一般步骤如下:1. 初始化MPI环境:使用`MPI_Init`函数初始化MPI环境,并获取进程数量和进程编号等信息。

2. 分配任务:根据进程编号和任务数量,将总计算任务划分为子任务,并分发给各个进程。

并行计算环境介绍

并行计算环境介绍计算机系04 级研究生 武志鹏1 MPI简介目前两种最重要的并行编程模型是数据并行和消息传递。

数据并 行编程模型的编程级别比较高,编程相对简单,但它仅适用于数据并 行问题;消息传递编程模型的编程级别相对较低,但消息传递编程模 型可以有更广泛的应用范围。

MPI就是一种消息传递编程模型,并成为这种编程模型的代表和 事实上的标准。

1.1什么是 MPI对MPI的定义是多种多样的,但不外乎下面三个方面:(1) MPI是一个库,而不是一门语言;(2) MPI是一种标准或规范的代表,而不特指某一个对它的实现;(3) MPI是一种消息传递编程模型,MPI虽然很庞大,但是它的最终目的是服务于进程间通信这一目标的。

1.2 MPI的历史MPI的标准化开始于1992年4月在威吉尼亚的威廉姆斯堡召开的分 布存储环境中消息传递标准的讨论会,由Dongarra,Hempel,Hey和 Walker建议的初始草案,于1992年11月推出并在1993年2月完成了修订版,这就是MPI 1.0。

1995年6月推出了MPI的新版本MPI1.1,对原来的MPI作了进一步 的修改完善和扩充。

在1997年7月在对原来的MPI作了重大扩充的基础上又推出了MPI 的扩充部分MPI2,而把原来的MPI各种版本称为MPI1。

MPI2的扩 充很多但主要是三个方面:并行I/O、远程存储访问和动态进程管理。

1.3 MPI的语言绑定在MPI1中明确提出了MPI和FORTRAN 77与C语言的绑定,并且 给出了通用接口和针对FORTRAN 77与C的专用接口说明。

在MPI2中除了和原来的FORTRAN 77和C语言实现绑定之外,进一步与 Fortran90和C++结合起来。

1.4 MPI的实现版本MPICH是一种最重要的MPI实现, 它是与MPI-1规范同步发展的版 本,每当MPI推出新的版本,就会有相应的MPICH的实现版本,另外 它还支持部分MPI-2的特征。

Python高性能计算的MPI编程模型与实践

Python高性能计算的MPI编程模型与实践Python是一种简单易学、功能强大的编程语言,因其广泛丰富的库和包,被广泛应用于各个领域。

然而,对于高性能计算而言,Python 的解释性语言特点会限制程序运行速度。

为了克服这一问题,MPI编程模型被引入,以实现高效的并行计算。

本文将介绍Python高性能计算的MPI编程模型,并探讨其实践应用。

一、MPI编程模型简介MPI(Message Passing Interface)是一种消息传递编程接口,用于实现并行计算。

MPI模型基于进程间消息传递的通信机制,使得多个进程能够相互通信和协同工作。

MPI编程模型通常采用了master-slave 架构,其中一个或多个进程作为主节点(master),负责协调其他进程(slave)的工作。

MPI编程模型的核心在于消息传递。

进程之间通过发送和接收消息来实现通信,进而实现划分任务和并行计算的目标。

MPI提供了一系列的通信操作,如发送(send)、接收(recv)、广播(broadcast)和归约(reduce)等。

通过这些操作,进程可以在不同节点间传递数据和协调计算。

二、Python中的MPI实现在Python中,有多个MPI库可供选择,如mpi4py、pyMPI等。

其中,mpi4py是当前最常用且功能较为完善的库。

mpi4py是一个开源的Python库,提供了许多MPI接口函数的Python封装。

通过mpi4py,我们可以在Python环境下使用MPI编程模型,实现高性能计算。

mpi4py库提供了多种通信操作的函数,如send、recv、bcast等,支持多种数据类型的传递和通信模式的选择。

下面是一个简单的mpi4py示例代码:```pythonfrom mpi4py import MPIcomm = M_WORLDrank = comm.Get_rank()if rank == 0:data = 10comm.send(data, dest=1)elif rank == 1:data = comm.recv(source=0)print("Received data:", data)```在以上代码中,首先导入了mpi4py库,并创建了一个通信组(comm)。

基于MPI的并行程序设计

基于MPI的并行程序设计MPI(Message Passing Interface)是一种用于并行计算的消息传递编程接口。

它提供了一组用于在多个进程之间传递消息的函数,使得在并行计算中能够更加高效地利用计算资源。

本文将介绍MPI的基本原理和并行程序设计的一些基本概念。

MPI的基本原理是基于消息传递的,并行计算模型。

在MPI中,计算节点被组织成一个逻辑拓扑结构,每个节点都可以通过消息传递的方式与其他节点进行通信。

这种消息传递方式可以通过网络或者高速互连的硬件来实现,使得多个节点之间可以并行地进行计算。

并行程序设计的关键是分割问题和分配任务。

在MPI中,通常将任务分割成若干个较小的子任务,然后将这些子任务分配给不同的计算节点进行并行计算。

每个计算节点独立地计算自己的子任务,并通过消息传递与其他节点进行通信,最终将计算结果汇总起来。

并行程序设计的另一个重要概念是同步和异步操作。

同步操作是指在发送或接收消息时,发送进程或接收进程需要等待对应的操作完成后才能继续执行。

而异步操作则是指发送和接收消息的操作不会阻塞进程的执行,进程可以继续执行其他的计算操作。

MPI提供了一系列的同步和异步通信操作,例如MPI_Isend和MPI_Irecv函数,用于实现非阻塞的消息传递。

在并行程序设计中,性能优化是一个重要的课题。

为了提高并行计算的效率,可以采用一些优化技术,例如流水线计算、任务分发和负载均衡。

流水线计算是指将计算任务划分为若干个阶段,并将每个阶段分配给不同的计算节点进行并行计算。

任务分发是指将计算任务动态地分配给空闲的计算节点,以实现任务的并行处理。

负载均衡是指将计算任务均匀地分配给不同的计算节点,以避免一些节点的计算负载过重。

总的来说,MPI是一种基于消息传递的并行编程接口,提供了一系列的通信原语,用于在计算节点之间进行消息传递。

通过合理地分割问题、分配任务和优化计算过程,可以实现高效的并行程序设计。

在当前的多核计算环境中,MPI仍然是一种重要的并行编程模型,在科学计算、大规模数据分析等领域有着广泛的应用。

基于MPI并行编程环境简述

基于MPI并行编程环境简述MPI并行编程环境是一种并行编程解决方案,它被广泛应用于高性能计算领域。

本文将对MPI并行编程环境做一个简单的介绍,包括MPI的概念、MPI的基本编程模式、MPI的特点和应用场景等方面。

最后还将介绍一些MPI编程中要注意的问题。

一、MPI的概念MPI是Message Passing Interface的缩写,意思是“消息传递接口”,它是一种并行计算环境的标准化接口,并且被广泛应用于高性能计算领域。

MPI允许程序员编写MPI应用程序来在多个进程之间传递消息,并对应用程序进行并行化处理。

MPI定义了一套通信协议,使得单个进程可以通过网络连接与其他进程进行通信。

MPI支持多种编程语言,包括C、C++、Fortran等。

MPI的实现通常包括一个标准库和一个运行时系统,它们提供了一系列函数和工具,用于支持消息传递协议和进程管理。

二、MPI的基本编程模式MPI的基本编程模式是消息传递模型,它通过传递消息实现进程之间的通信和同步。

MPI提供了一套通信协议,包括点对点通信和集合通信两种方式,以及同步通信和异步通信两种方式。

在点对点通信中,发送方将消息传递给接收方;在集合通信中,一组进程相互交换数据。

同步通信要求发送方等待接收方的响应,而异步通信则可以在发送消息之后立即返回并继续执行。

三、MPI的特点MPI具有以下几个特点:1. 并行性:MPI可以同时在多个进程之间完成任务,并能够将运算分解成多个独立的计算单元来并行执行。

2. 可移植性:MPI的标准化接口使得程序员可以跨平台编写MPI应用程序,而无需考虑底层计算机架构和操作系统的区别。

3. 可扩展性:MPI支持将计算任务分配到大规模的计算资源上,能够有效地扩展计算能力。

4. 通信效率高:MPI的通信协议具有高效的性能,支持传输大量的数据,因此可以在高速网络上实现高速通信。

四、MPI的应用场景MPI主要应用于高性能计算领域,可以用于大规模数值模拟、数据挖掘、机器学习等任务。

MPI并行程序设计

➢ 启动MPI环境,标志并行代码的开始。 ➢ 并行代码之前,第一个mpi函数(除

MPI_Initialize()源自)。 ➢ 要求main必须带参数运行,否则出错。

9

MPI结束-MPI_Finalize

1

消息传递并行程序设计

➢ 并行计算粒度大,特别适合于大规模可 扩展并行算法: 由于消息传递程序设计要求用户很好地分解问 题,组织不同进程间的数据交换,并行计算粒 度大,特别适合于大规模可扩展并行算法。

➢ 消息传递是当前并行计算领域的一个非常重要 的并行程序设计方式。

2

什么是MPI?

➢ MPI(Massage Passing Interface):是消息传递函数 库的标准规范,由MPI论坛开发,支持Fortran和C。 一种新的库描述,不是一种语言。共有上百个函数调 用接口,在Fortran和C语言中可以直接对这些函数进 行调用。从语法上,它遵守所有对库函数/过程的调 用规则,与一般的函数/过程没有区别。 MPI是一种标准或规范的代表,而不是特指某一个对 它的具体实现。一个正确的MPI程序,可不加修改在 所有的并行机上运行。 MPI是一种消息传递编程模型,并成为这种编程模型 的代表和事实上的标准。最终目标是服务于进程间通 信。

5

为什么要用MPI?—优点

➢ MPI是被正式的详细说明的:它已经成为一个标 准。消息传递标准的定义能提供给生产商清晰定 义的程序库,以便他们能有效地实现这些库或在 某些情况下为库程序提供硬件支持,因此加强了 扩展性。

➢ MPI有完备的异步通信:使得send,receive能与 计算重叠。

intel mpi原理

intel mpi原理Intel MPI是一种基于消息传递接口(Message Passing Interface,MPI)的编程库,用于在Intel架构上实现并行计算。

它提供了一套高性能的通信和同步机制,使得并行应用程序能够在多个处理器之间进行消息传递,并实现并行计算的任务划分和负载均衡。

本文将介绍Intel MPI的原理和工作机制。

Intel MPI的原理基于MPI标准,该标准定义了一系列的函数和语义规范,用于在分布式内存系统中进行并行计算的消息传递。

MPI 标准的目标是提供一种统一的编程接口,使得不同的并行计算环境能够实现互操作性。

Intel MPI作为一种基于MPI标准的实现,提供了对Intel架构的优化和支持,以提供更高的性能和可扩展性。

Intel MPI的工作机制主要包括进程通信、进程管理和任务调度三个方面。

进程通信是Intel MPI的核心功能之一。

在并行计算中,不同的进程之间需要进行消息传递,以实现数据的交换和协同计算。

Intel MPI通过提供一系列的通信函数,如发送(send)、接收(receive)和同步(synchronize)等,来支持进程之间的消息传递。

这些通信函数可以根据应用程序的需要进行灵活的调用,以实现不同的通信模式,如点对点通信、广播通信和规约通信等。

此外,Intel MPI 还提供了高效的通信协议和算法,如基于RDMA(Remote DirectMemory Access)的通信方式,以提高通信性能和可扩展性。

进程管理是Intel MPI的另一个重要功能。

在并行计算中,需要对多个进程进行管理和调度,以实现任务的分配和负载均衡。

Intel MPI通过提供一系列的进程管理函数,如进程创建(create)、进程销毁(destroy)和进程同步(synchronize)等,来支持进程的管理和协同。

这些函数可以根据应用程序的需要进行灵活的调用,以实现不同的进程管理策略,如静态进程划分和动态进程迁移等。

消息传递编程接口MPI

3.1.2 MPI定义

(2) MPI是一种标准或规范的代表,而不特指 是一种标准或规范的代表, 是一种标准或规范的代表 某一个对它的具体实现。 某一个对它的具体实现。 迄今为止,所有的并行计算机制造商都提 供对MPI的支持,可以在网上免费得到MPI在 不同并行计算机上的实现,一个正确的MPI程 序,可以不加修改地在所有的并行机上运行。

3.1.2 MPI定义

关于MPI三个不同侧面的定义 三个不同侧面的定义 关于 对MPI的定义是多种多样的,但不外乎下面 三个方面,它们限定了MPI的内涵和外延。 (1)MPI是一个库,而不是一门语言。 是一个库, 是一个库 而不是一门语言。 许多人认为MPI就是一种并行语言,这是不 准确的。但是按照并行语言的分类,可以把 FORTRAN+MPI或C+MPI,看作是一种在原来串 行语言基础之上扩展后得到的并行语言。MPI库 可以被FORTRAN77/C/Fortran90/C++调用,从 语法上说,它遵守所有对库函数/过程的调用规 则,和一般的函数/过程没有什么区别。 6

4

3.1.1 MPI简介

Message-Passing Interface (MPI) MPI这个标准具备了公共软件包和厂家专用软件包的

优点。 这个标准能用于大多数并行计算机、机群系统和异构 网络环境,能达到较高的数据传输速率。 这个标准支持 C 语言和 FORTRAN 语言: C + MPI 是在C语言基础上扩展得到的并行程序语 言 FORTRAN + MPI 是在FORTRAN语言基础上扩展 5 得到的并行程序语言

14

3.3 MPI程序的总体结构和MPI 的数据类型

15

3.3.1 MPI程序的总体结构

第四讲消息传递编程接口MPI

该函数返回指定通信器所包含的进程数

MPI_SEND 点对点通信

MPI_SEND(buf,count,datatype,dest,tag,comm)

参数

IN buf

所发送消息的首地址

IN count 将发送的数据的个数

IN datatype 发送数据的数据类型

IN dest

接收消息的进程的标识号

在四个结点上,开 4 个进程的运行结果 Hello, I am Proc. 1 of 4 on c1 Hello, I am Proc. 0 of 4 on c2 Hello, I am Proc. 2 of 4 on c4 Hello, I am Proc. 3 of 4 on c3

MPI 程序执行过程

MPI 编程的一些惯例

由于 C 语言的函数调用机制是值传递,所以 MPI 的所有 C 函数中的输出参数用的都是指针

MPI 是按进程组(Process Group) 方式工作: 所有 MPI 程序在开始时均被认为是在通信器 MPI_COMM_WORLD 所拥有的进程组中工作, 之后用户可以根据自己的需要,建立其它的进程组

MPI 数据类型: 原始数据类型 和 自定义数据类型

MPI 原始数据类型

FORTRAN 77 数据类型

MPI datatype

MPI_INTEGER MPI_REAL MPI_DOUBLE_PRECISION MPI_COMPLEX MPI_DOUBLE_COMPLEX MPI_LOGICAL MPI_CHARACTER MPI_BYTE MPI_PACKED

call MPI_GET_PROCESSOR_NAME(proc_name, namelen, ierr) write(*,10) myid, numprocs, proc_name 10 FORMAT('Hello, I am Proc. ',I2,' of ',I1,' on ', 20A)

Python高性能并行计算之mpi4py

Python高性能并行计算之mpi4pympi4py是Python中的一个消息传递接口(MPI)的实现。

MPI是一种并行计算的标准,用于在多个计算节点之间进行通信和协调。

mpi4py允许开发者使用Python语言进行高性能并行计算,利用多台计算机上的多个处理器进行任务分配和执行。

MPI的并行计算模型基于消息传递,它允许不同计算节点之间通过发送和接收消息来交换数据和同步计算。

MPI提供了一套丰富的编程接口,包括进程管理、通信和同步操作等功能,可以满足各种类型的并行计算需求。

mpi4py是Python语言对MPI标准的实现,它包含了一系列的模块和类,用于管理MPI的进程和通信操作。

开发者可以创建MPI进程,发送和接收消息,进行同步操作,以及执行各种MPI操作。

mpi4py允许开发者通过简单的Python语法来编写并行计算程序。

开发者可以使用Python的标准语法来定义任务和数据,并使用mpi4py提供的函数和类来进行进程管理和通信操作。

mpi4py提供了一系列的函数和类,用于创建和管理MPI进程,发送和接收消息,以及进行同步操作。

使用mpi4py进行并行计算可以带来很多好处。

首先,mpi4py充分利用了多个计算节点上的多个处理器,可以显著提高计算速度和效率。

其次,mpi4py提供了丰富的并行计算功能和工具,可以简化程序的编写和调试过程。

最后,mpi4py是一个开源项目,拥有庞大的社区和用户群体,可以获取大量的支持和资源。

然而,使用mpi4py进行并行计算也存在一些挑战和限制。

首先,mpi4py需要在多个计算节点上安装和配置MPI软件,需要一定的专业知识和技能。

其次,mpi4py是一个底层的接口,需要开发者具有一定的并行计算经验和编程能力,否则可能会导致程序的性能和正确性问题。

另外,mpi4py并不适用于所有类型的并行计算应用,例如图形处理和深度学习等计算密集型任务。

总结来说,mpi4py是Python中高性能并行计算的一个重要工具,它基于MPI标准,提供了丰富的并行计算功能和接口。

mpi

Message Passing Interface—消息传递接口

与OpenMP并行程序不同,MPI是一 种基于信息传递的并行编程技术。消息传 递接口是一种编程接口标准,而不是一种 具体的编程语言。简而言之,MPI标准定义 了一组具有可移植性的编程接口。

1.MPi组成

• 数据类型

定义了精确的数据类型参数而不使用字节计数,以数据类型为单位指定 消息的长度; 对于C和Fortran,MPI均预定义了一组数据类型和一些附加的数据类型; 可以发送 或接收连续的数据,还可以处理不连续的数据;中的一个通信域定义了一组进程和一个通信的上下文,虚拟处理 器拓扑、属性等内容。它以对象形式存在,作为通信操作的附加参数。 MPI预定义的通信域:mpi comm world(包含所有进程)、 mpi comm self(只包含各个进程自己的进程组)

• MPI调用接口—6个基本调用

1.mpi init()初始化MPI执行环境,建立多个MPI进程之间的联系,为 后续通信做准备 2.mpi finalize 结束MPI执行环境 3.mpi comm rank用来标识各个MPI进程的,给出调用该函数的进程的 进程号,返回整型的错误值 两个参数:MPI_Comm类型的通信域,标识参与计算的MPI进程组; &rank返回调用进程中的标识号 4.mpi comm size用来标识相应进程组中有多少个进程

• 组通信—一个特定组内所有进程都参加全局的数据处理和通信操作

功能:通信—组内数据的传输 同步—所有进程在特定的点上取得一致 计算—对给定的数据完成一定的操作 类型:1)数据移动 广播(mpi bcast) 收集(mpi gather) 散射(mpi scater) 组收集(mpi all gather)全交换(all to all) 2)聚集 规约(mpi reduce)将组内所有的进程输入 缓冲区中的数据按 定操作OP进行运算,并将起始结果返回到root进程的接收缓冲区 扫描(mpi scan)要求每一个进程对排在它前面的进程进行规约 操作,结果存入自身的输出缓冲区 3)同步 路障(mpi barrier)实现通信域内所有进程互相同步,它们将处 于等待状态,直到所有进程执行它们各自的MPI-BARRIER调用

c++的mpi编程

c++的mpi编程C++的MPI编程是一种用于实现并行计算的方法。

MPI(Message Passing Interface)是一种通信协议,它允许在分布式计算系统中进行高效的消息传递。

在C++中使用MPI编程,可以充分利用多核处理器和集群计算机等并行资源。

以下是C++ MPI编程的基本步骤:1. 配置MPI环境:首先,需要在操作系统上安装MPI库。

安装完成后,可以通过编译器参数或环境变量指定MPI库的路径。

2. 编写程序:编写一个C++程序,使用MPI库提供的函数进行通信和同步。

常见的MPI函数包括发送和接收消息的函数(如MPI_Send 和MPI_Recv),以及用于进程间通信的函数(如MPI_Comm_size和MPI_Comm_rank)。

3. 分配计算资源:在程序中,使用MPI_Comm_size函数获取进程数量,然后根据问题规模和计算资源分配任务。

可以使用MPI_Comm_rank函数获取当前进程的编号。

4. 初始化MPI:在程序开始时,使用MPI_Init函数初始化MPI库。

在程序结束时,使用MPI_Finalize函数关闭MPI库。

5. 编写主函数:在主函数中,使用MPI函数进行进程间通信和数据交换。

例如,可以使用MPI_Send和MPI_Recv函数实现数据的发送和接收。

6. 编写并行区域:在并行区域中,使用MPI_Barrier函数同步进程。

这样可以确保所有进程在执行并行区域之前达到相同的进度。

7. 结束MPI:在程序结束时,使用MPI_Finalize函数关闭MPI库。

以下是一个简单的C++ MPI编程示例:```cpp#include <iostream>#include <mpi.h>int main(int argc, char *argv[]) {// 初始化MPI库MPI_Init(&argc, &argv);// 获取进程数量和当前进程编号int size, rank;MPI_Comm_size(MPI_COMM_WORLD, &size);MPI_Comm_rank(MPI_COMM_WORLD, &rank);// 输出进程信息std::cout << "Hello, I am process " << rank << " of " << size << "." << std::endl;// 结束MPI库MPI_Finalize();return 0;}```这个示例程序将输出各个进程的编号和总进程数。

MPI的名词解释

MPI的名词解释MPI,全称为Message Passing Interface(消息传递接口),是一种基于消息传递机制的并行计算通信标准。

它由一系列函数和语法规则组成,用于在并行计算环境中实现进程间的通信与同步操作。

MPI的出现极大地推动了并行计算的发展,并成为当前科学计算领域中最为重要和广泛使用的编程模型之一。

一、MPI的产生与发展MPI最早由美国国家科学基金会(NSF)于20世纪80年代中期提出,并由一支由美国国家研究委员会(NRC)支持的工作组进行研发。

该工作组的目标是构建一个可跨不同型号和架构的计算机系统进行通信的标准接口。

经过多年的努力,MPI于1994年正式发布第一个版本,至今经过多次修订和升级,已经成为最新一代的MPI标准。

二、MPI的特点与优势1. 灵活性:MPI提供了一种抽象的通信模型,允许开发者在不同的并行计算平台上进行通信操作。

这使得并行计算应用能够灵活地适应不同的硬件和软件环境。

2. 高性能:MPI以高效的消息传递机制为基础,充分利用并行计算系统的硬件资源,实现高效的进程间通信和数据交互。

这使得MPI成为大规模科学计算和仿真模拟的重要工具。

3. 可扩展性:MPI适用于从单机多核到分布式集群的各种规模的并行系统。

无论是小型集群还是大型超级计算机,MPI都能够灵活地管理进程间通信,实现可扩展的分布式计算和通信。

4. 可移植性:MPI是一个标准化的接口,各个计算平台上的MPI实现都遵循相同的接口规范。

开发者可以编写与具体平台无关的MPI程序,实现代码的重用和平台的移植。

5. 易用性:MPI提供了一系列简单易用的函数调用和语法规则,方便开发者进行进程间通信的编程。

开发者无需关注底层通信的细节,只需调用相应的MPI函数即可完成通信操作。

三、MPI的基本概念与操作1. 进程:MPI程序由多个并行执行的进程组成,每个进程都有一个唯一的标识符(MPI Rank)。

进程通过发送和接收消息进行通信和同步操作。

高性能计算中的MPI并行编程方法

高性能计算中的MPI并行编程方法随着科技的快速发展,计算机的性能和运算速度也越来越快。

然而,在面对海量数据和复杂运算时,单台计算机的性能已经无法满足需求。

因此,高性能计算(High Performance Computing, HPC)逐渐成为科学研究和工程领域中必不可少的一部分。

在HPC领域中,MPI并行编程是一种被广泛使用的技术,能够有效地提高计算机的并行性和计算速度。

MPI并行编程是什么?MPI(Message Passing Interface)是一种并行编程的通信库。

在MPI中,所有进程之间都是通过发送和接收消息来通信的。

MPI并行编程在计算机集群(Cluster)中应用广泛,因为计算机集群中的计算节点是分布在不同的物理服务器上,MPI并行编程可以将这些节点组合成一个逻辑上的整体,有效地提高了计算机的并行性。

MPI并行编程的优点MPI并行编程有如下优点:1.能够实现海量数据和复杂运算的高效处理,提高了计算速度。

2.可靠性高,因为MPI并行编程中所有进程之间都是通过发送和接收消息来通信的,不依赖于共享内存,可以有效避免内存泄漏等问题。

3.良好的可移植性,MPI API已经被很多计算机系统所支持,使得代码在不同的平台上也可以运行。

MPI并行编程的应用领域MPI并行编程被广泛应用于高性能计算领域,包括海洋模拟、气象预报、金融计算、生物医学等多个领域。

在气象预报中,MPI并行计算可以对气象数据进行分布式处理,快速生成气象预报模型,为人们提供准确的天气信息。

在金融领域,MPI并行编程可以进行股票行情分析、期货合约计算等任务,为投资者提供科学的决策支持。

在生物医学领域,MPI并行编程可以进行基因序列比对、药物分子模拟等任务,为科学家们提供准确的实验数据。

MPI并行编程的实现方法MPI通信和计算模型是一种消息传递模型,MPI中进程之间的通信主要与其它进程的交互有关。

在MPI并行编程中,进程的编写过程可以被分为以下几个步骤:1.初始化MPI环境在编写MPI程序时,必须首先调用MPI环境的初始化函数,建立进程之间的通讯。

MPI并行编程

chainrtm*aargincv(,[] ) { chainrtm*aargincv(,[] )

#include "mpi.h" #include <stdio.h> main( int argc,

char *argv[] ) {

MPI_Init( &argc, &argv ); printf( "Hello, world!\n" ); MPI_Finalize(); }

2021/7/1

#include "mpi.h" #inc#liundcelu<dsetd"miop.hi.>h"

• MPI 1.2 (1997) • …. • MPI 2.2 (2009-09)

2021/7/1

6

MPI是一个库,而不是一门语言

• 这个标准支持 C 语言和 FORTRAN 语言 • MPI库可以被FORTRAN77/C/Fortran90/C++调

用 • 它遵守所有对库函数/过程的调用规则,和

/*进程数,该变量为各处理器中的同名变量, 存储是分布的 */

/*我的进程ID,存储也是分布的

*/

MPI_Status status;

/*消息接收状态变量,存储也是分布的

*/

char message[100];

一般的函数/过程没有什么区别

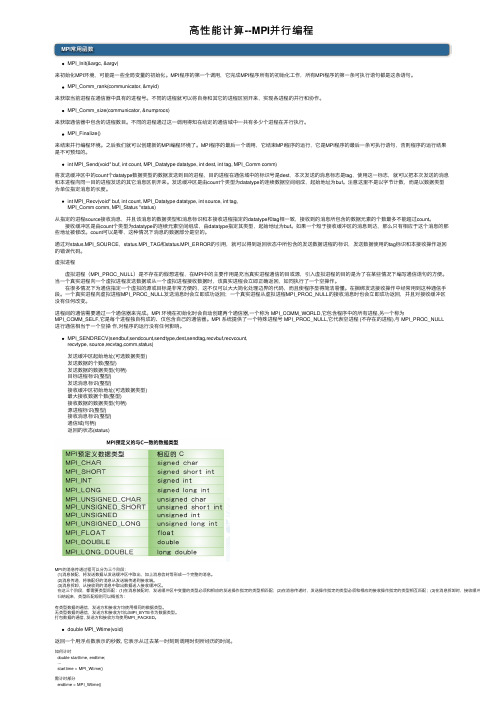

高性能计算--MPI并行编程

⾼性能计算--MPI并⾏编程MPI常⽤函数MPI_Init(&argc, &argv)来初始化MPI环境,可能是⼀些全局变量的初始化。

MPI程序的第⼀个调⽤,它完成MPI程序所有的初始化⼯作,所有MPI程序的第⼀条可执⾏语句都是这条语句。

MPI_Comm_rank(communicator, &myid)来获取当前进程在通信器中具有的进程号。

不同的进程就可以将⾃⾝和其它的进程区别开来,实现各进程的并⾏和协作。

MPI_Comm_size(communicator, &numprocs)来获取通信器中包含的进程数⽬。

不同的进程通过这⼀调⽤得知在给定的通信域中⼀共有多少个进程在并⾏执⾏。

MPI_Finalize()来结束并⾏编程环境。

之后我们就可以创建新的MPI编程环境了。

MPI程序的最后⼀个调⽤,它结束MPI程序的运⾏,它是MPI程序的最后⼀条可执⾏语句,否则程序的运⾏结果是不可预知的。

int MPI_Send(void* buf, int count, MPI_Datatype datatype, int dest, int tag, MPI_Comm comm)将发送缓冲区中的count个datatype数据类型的数据发送到⽬的进程,⽬的进程在通信域中的标识号是dest,本次发送的消息标志是tag,使⽤这⼀标志,就可以把本次发送的消息和本进程向同⼀⽬的进程发送的其它消息区别开来。

发送缓冲区是由count个类型为datatype的连续数据空间组成,起始地址为buf。

注意这⾥不是以字节计数,⽽是以数据类型为单位指定消息的长度。

int MPI_Recv(void* buf, int count, MPI_Datatype datatype, int source, int tag,MPI_Comm comm, MPI_Status *status)从指定的进程source接收消息,并且该消息的数据类型和消息标识和本接收进程指定的datatype和tag相⼀致,接收到的消息所包含的数据元素的个数最多不能超过count。

MPI编程简介

Hello (Fortran语言)

program main include „mpif.h‟ integer ierr call MPI_INIT( ierr ) print *, 'Hello, world!' call MPI_FINALIZE( ierr ) end

C和Fortran中MPI函数约定

Greeting执行过程

进程 0 rank=0

. . . Recv() . . .

进程 1 rank=1

. . . Send() . . .

进程 2 rank=2

. . . Send() . . .

进程 3 rank=3

. . . Send() . . .

解剖greeting程序

• 头文件:mpi.h/mpif.h • int MPI_Init(int *argc, char ***argv) • 通信组/通信子: MPI_COMM_WORLD

}

更新的Hello World(Fortran)

program main include „mpif.h‟ integer ierr, myid, numprocs call MPI_INIT( ierr ) call MPI_COMM_RANK( MPI_COMM_WORLD, myid, ierr ) call MPI_COMM_SIZE( MPI_COMM_WORLD, numprocs, ierr ) print *, „I am', myid, „of', numprocs call MPI_FINAo hello1 hello1.c • mpirun -np 4 hello1

结果: I am 0 I am 1 I am 2 I am 3

mpi原理

mpi原理MPI原理MPI(Message Passing Interface)是一种用于编写并行程序的标准接口,它是一种基于消息传递的编程模型。

MPI的设计目标是提供一种可移植性强、高效、灵活的并行计算模型,以满足科学计算领域对并行计算的需求。

MPI的基本原理是通过消息传递来实现进程间的通信和同步。

在MPI中,程序由多个并发运行的进程组成,每个进程都有自己的地址空间,它们通过发送和接收消息来进行通信。

进程可以通过发送消息将数据传递给其他进程,也可以通过接收消息从其他进程接收数据。

MPI提供了丰富的通信操作,如点对点通信和集体通信,使得进程之间可以方便地进行数据交换和协调。

MPI的通信操作是基于消息的,即进程之间通过发送和接收消息来进行通信。

发送消息时,进程将需要发送的数据放入消息中,并指定消息的目标进程。

接收消息时,进程会等待特定的消息到达,并将消息中的数据提取出来。

MPI提供了不同类型的消息传递操作,如阻塞发送和接收、非阻塞发送和接收等,以满足不同情况下的通信需求。

MPI还提供了一些同步操作,如同步发送和接收、同步广播等。

同步操作可以保证进程之间的通信按照特定的顺序进行,避免出现数据竞争和不一致的情况。

同步操作在并行程序中起到了重要的作用,可以保证数据的正确性和一致性。

MPI的优点在于其可移植性和灵活性。

MPI可以在不同的并行计算环境中使用,如多核CPU、GPU集群等。

而且,MPI提供了丰富的通信和同步操作,可以满足不同并行程序的需求。

此外,MPI还提供了一些辅助函数和工具,用于方便地调试和优化并行程序。

然而,MPI编程也存在一些挑战和限制。

首先,MPI编程需要开发人员具备并行编程的知识和经验,对于初学者来说有一定的学习曲线。

其次,由于MPI是基于消息传递的,进程之间的通信开销较大,特别是在大规模并行计算中。

因此,在设计并行算法时需要注意减少通信次数和数据传输量,以提高程序的性能。

MPI是一种强大而灵活的并行编程接口,它通过消息传递来实现进程间的通信和同步。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

国家973项目高性能计算环境支持讲座MPI与PETSc莫则尧(北京应用物理与计算数学研究所)个人介绍莫则尧,男,汉族,1971年7月生,副研究员:●1992年国防科技大学应用数学专业本科毕业;●1997年国防科技大学计算机应用专业并行算法方向博士毕业;●1999年北京应用物理与计算数学数学博士后流动站出站,并留所工作;●主要从事大规模科学与工程并行计算研究。

消息传递并行编程环境MPI一、进程与消息传递二、MPI环境的应用现状三、MPI并行程序设计入门(程序例1)四、初步的MPI消息传递函数五、作业一六、先进的MPI函数七、MPI并行程序示例2(求解- u=f);八、MPI环境的发展九、作业二一、进程与消息传递1.单个进程(process )●同时包含它的执行环境(内存、寄存器、程序计数器等),是操作系统中独立存在的可执行的基本程序单位;● 通俗理解:串行应用程序编译形成的可执行代码,分为“指令”和“数据”两个部分,并在程序执行时“独立地申请和占有”内存空间,且所有计算均局限于该内存空间。

2.单机内多个进程:● 多个进程可以同时存在于单机内同一操作系统:由操作系统负责调度分时共享处理机资源(CPU 、内存、存储、外设等);● 进程间相互独立(内存空间不相交):在操作系统调度下各自独立地运行,例如多个串行应用程序在同一台计算机中运行;● 进程间可以相互交换信息:例如数据交换、同步等待,内存些信息在进程间的相互交换,是实现进程间通信的唯一方式;●最基本的消息传递操作:发送消息(send)、接受消息(receive)、进程同步(barrier)、规约(reduction);●消息传递的实现:共享内存或信号量,用户不必关心;3.包含于通过网络联接的不同计算机的多个进程:●进程独立存在:进程位于不同的计算机,由各自独立的操作系统调度,享有独立的CPU和内存资源;●进程间相互信息交换:消息传递;●消息传递的实现:基于网络socket机制,用户不必关心;4.消息传递库函数:●应用程序接口(API):提供给应用程序(FORTRAN、C、C++语言)的可直接调用的完成进程间消息传递的某项特定功能的函数;●消息传递库:所有定义的消息传递函数编译形成的软件库,调用其内部函数的应用程序,通过与之联接,即可成为可并行执行的程序;●目前流行的消息传递函数库:PVM 3.3.11、MPICH1.2、LAMMPI 6.4等;5.标准消息传递界面(MPI:Message Passing Interface):●MPI标准:根据应用程序对消息传递功能的需求,全球工业、应用和研究部门联合推出标准的消息传递界面函数,不考虑其具体实现,以保证并行应用程序的可移植性;●MPI的具体实现:消息传递库函数,目前有影响的为MPICH和LAMMPI,我们注重MPICH系列;6.基于消息传递的并行程序执行模式:●SPMD模式:单程序多数据流可执行代码●MPMD模式:多程序多数据流,除初始启动多个可执行代码,其余与SPMD模式一致;7.共享存储与分布式存储:●属于并行机体系结构的范畴,与消息传递并行程序设计平台无关;分布式存储共享存储●消息传递是相对于进程间通信方式而言的,与具体并行机存储模式无关,任何支持进程间通信的并行机,均可支持消息传递并行程序设计;●几乎所有共享和分布存储并行计算环境均支持进程间的消息传递通信;二、MPI环境的应用现状●MPI(消息传递界面)是全球工业、政府和科研部门联合推出的适合进程间进行标准消息传递的并行程序设计平台,最初版MPI 1.0本于1994年6月推出,目前最新的为MPI 2.0版,于1998年年低推出;●MPI的具体实现:MPICH和LAMMPI,目前均已实现MPI 1.2版,适用于任何并行计算平台;部分并行机已实现MPI 2.0版;●MPI是目前应用最广的并行程序设计平台,几乎被所有并行计算环境(共享和分布式存储并行机、MPP、机群系统等)和流行的多进程操作系统(UNIX、Windows NT)所支持,基于它开发的应用程序具有最佳的可移植性;●目前高效率的超大规模并行计算(1000个处理器)最可信赖的平台;●工业、科学与工程计算部门的大量科研和工程软件(气象、石油、地震、空气动力学、核等)目前已经移植到MPI平台,发挥了重要作用;●目前,MPI相对于PVM:优点:功能强大,性能高,适应面广,使用方便,可扩展性好;缺点:进程数不能动态改变;三、MPI并行程序设计入门1.MPI序),进行通信;2.MPI程序:●SPMD执行模式:一个程序同时启动多份,形成多个独立的进程,在不同的处理机上运行,拥有独立的内存空间,进程间通信通过调用MPI函数来实现;●每个进程开始执行时,将获得一个唯一的序号(rank)。

例如启动P个进程,序号依次为0,1,…,P-1;●MPI程序例1:进程0发送一个整数给进程1;进程1将该数加1,传递给进程2;进程2再将该数加1,再传递给进程3;依次类推,最后,进程P-1将该数传递给进程0,由进程0负责广播该数给所有进程,并打印输出。

program example1include “mpif.h”!! MPI系统头文件integer status(MPI_STATUS_SIZE),my_rank,p,source,dest,tag,ierr,datacc-------进入MPI系统call MPI_Init(ierr)call MPI_Comm_rank(MPI_COMM_WORLD,my_rank,ierr)call MPI_Comm_size(MPI_COMM_WORLD,p,ierr)cc-------数据交换data=0tag = 5source= my_rank-1if(source.eq.-1) source=p-1dest =my_rank+1if(dest.eq.p) dest=0if(my_rank.eq.0) thencall MPI_Send(data,1,MPI_INTEGER,dest,tag,MPI_COMM_WORLD,ierr)call MPI_Recv(data,1,MPI_INTEGER,source,tag,MPI_COMM_WORLD,status,ierr) elsecall MPI_Recv(data,1,MPI_INTEGER,source,tag,MPI_COMM_WORLD,status,ierr)data=data+1call MPI_Send(data,1,MPI_INTEGER,dest,tag,MPI_COMM_WORLD,ierr) endifcc-------广播数据call MPI_Bcast(data,1,MPI_INTEGER,0,MPI_COMM_WORLD,ierr)cc------打印输出if(my_rank.eq.0) thenif(data.eq.p-1) thenprint *,”Successful, data=”,dataelseprint *,”Failure, data=”,dataendifendifccall MPI_Finalize(ierr)end●编译命令: mpif77 -o exam.e example.f●运行命令: mpirun –np 4 exam.e●运行效果:MPI系统选择相同或不同的4个处理机,在每个处理机上运行程序代码exam.e。

my_rank=0 myrank=1 myrank=2 my_rank=3 Comm_size() p=4 p=4 p=4 p=4tag=5,data=0 tag=5,data=0 tag=5,data=0 tag=5,data=0source=3 source=0 source=1 source=2dest=1 dest=2 dest=3 dest=0数据交换send() recv() recv() recv()recv() data=data+1空send()闲data=data+1等send()待data=data+1消息传递send() Broadcast() send() recv() recv() recv()Finalize()3.MPI重要概念●进程序号(rank);各进程通过函数MPI_Comm_rank()获取各自的序号;●消息号:消息的标号;●通信器(Communicator):1)理解为一类进程的集合,且在该集合内,进程间可以相互通信;类比:邮局、电话局、国际网;2)任何MPI通信函数均必须在某个通信器内发生;3) MPI系统提供省缺的通信器MPI_COMM_WORLD,所有启动的MPI进程通过调用函数MPI_Init()包含在该通信器内;4)各进程通过函数MPI_Comm_size()获取通信器包含的(初始启动)的MPI进程个数;●消息:分为数据(data)和包装(envelope)两个部分,其中,包装由接收进程序号、发送进程序号、消息标号和通信器四部分组成,数据包含用户将要传递的内容;●进程组:一类进程的集合,在它的基础上,可以定义新的通信器;●基本数据类型:对应于FORTRAN和C语言的内部数据类型(INTEGER,REAL,DOUBLE PRECISION,COMPLEX,LOGICAL,CHARACTER),MPI系统提供已定义好的对应数据类型(MPI_INTEGER,MPI_REAL,MPI_DOUBLE_PRECISION,MPI_COMPLEX,MPI_LOGICAL,MPI_CHARACTER);●自定义数据类型:基于基本数据类型,用户自己定义的数据类型(后面介绍);●MPI对象: MPI系统内部定义的数据结构,包括数据类型、进程组、通信器等,它们对用户不透明,在FORTRAN 语言中,所有MPI对象均必须说明为“整型变量INTEGER”;●MPI联接器(handle):联接MPI对象和用户的桥梁,用户可以通过它访问和参与相应MPI对象的具体操作;例如,MPI系统内部提供的通信器MPI_COMM_WORLD;在FORTRAN语言中,所有MPI联接器均必须说明为“整型变量INTEGER”;●进程拓扑结构:进程组内部进程之间的一种相互连接结构,如3⨯3 网格,将在后面介绍。

3 ⨯ 3 网格拓扑结构●静态进程个数:进程数由命令“mpirun –np xxx”初始确定为xxx个,程序执行过程中不能动态改变进程的个数;●消息缓存区:应用程序产生的消息包含的数据所处的内存空间;●标准输入:所有进程的标准输入read(*,*)均省缺为当前终端屏幕,且只能由0号进程执行该操作,其他进程需要这些输入参数,只能由0号进程执行数据广播操作;●标准输出:所有进程可以独立执行标准输出write(*,*),但其省缺为当前终端屏幕;4.MPI函数格式:●FORTAN语言中,最后一个参数为该函数调用是否成功的标志:0表示成功,其它表示各种可能的错误;●C语言中,该标志又函数参数返回;C :ierr=MPI_Comm_rank(myrank)F : MPI_Comm_rank(myrank,ierr)5. MPI函数的使用查询:●由函数名查询:man 函数名(MPI_Xxxx), 注意大小写,例如man MPI_Comm_rank, man MPI_Send, man MPI_recv.6.MPI函数的学习与使用:●注重MPI函数的各类功能,由应用程序的通信需求出发,寻找匹配的函数类型,在查找具体函数名,采用man命令可以查询该函数的具体参数含义和使用方法。