ovirt上主机的网卡绑定

基于virtio的网卡使用

基于virtio的网卡使用0.1版Contents《改版履歴》 (2)1.概要 (3)2. 使用virtio的前提 (3)2.1 前端驱动 (3)2.2 后端驱动 (4)2.3 使用QEMU创建virtio网卡 (4)3 virtio网卡的使用场景 (5)3.1 Guest虚拟机与Host机通讯 (5)3.2 Guest虚拟机通过Host与外部网络通讯 (6)3.3 Guest虚拟机与Guest虚拟机通讯 (9)4.4 使用virtio的效果分析 (10)1. 概要在QEMU中,默认使用的网卡配置为virtio网卡。

virtio本身是一个framework,使用QEMU加上KVM来进行虚拟I/O,概而言之,virtio 是半虚拟化hypervisor 中位于设备之上的抽象层。

而virtio网卡则是挂载在virtio模拟的pci总线上的一个虚拟网卡。

在虚拟机开发中一般推荐使用virtio网卡,因为virtio网卡是在虚拟化中速度最快、功能最全面的虚拟网卡。

2. 使用virtio的前提使用virtio需要Guest虚拟机的kernel和Host机的kernel包含相应的驱动,virtio驱动包含前段和后端,也就是说需要在Host的Kernel中添加Back-end的驱动,并在Guest的kernel中添加Front-end的驱动。

2.1 前端驱动Guest机使用的kernel在编译时(make menuconfig)需要添加如下选项:[*] Virtualization ---><*> PCI driver for virtio devicesDevice Drivers --->[*] Network device support ---><*> Virtio network driverDevice Drivers --->[*] Block devices ---><*> Virtio block driver第一个选项是在内核中添加virtio PCI驱动,第二个选项时再内核中添加virtio网卡驱动,第三个选项时为了支持virtio的块设备驱动,如virtio硬盘等。

linux下个网卡如何绑定多个IP和多个网卡用一个ip的设置

个网卡绑定多个IP和多个网卡用一个ip的设置

常用到的是“一个网卡绑定多个IP”

一个网卡绑定多个IP

linux的网络设备配置文件存放在/etc/sysconfig/network-scripts里面,

对于以太网的第一个网络设备,配置文件名一般为ifcfg-eth0。

如果需要为第一个网络设备多绑定一个IP地址,只需要在

/etc/sysconfig/network-scripts目录里面创建一个名为ifcfg-eth0:0的文件,

内容样例为:

DEVICE="eth0:0"

IPADDR="211.100.10.119"

NETMASK="255.255.255.0"

ONBOOT="yes"

其中的DEVICE为设备的名称,

IPADDR为此设备的IP地址,

NETMASK为子网掩码

ONBOOT 表示在系统启动时自动启动。

如果需要再绑定多一个IP地址,

只需要把文件名和文件内的DEVICE中的eth0:x加一即可。

LINUX最多可以支持255个IP别名

多个网卡绑定一个IP

网卡绑定一个ip详见《北京华唐宽带测速系统环境搭建手册》

现在两块网卡已经象一块一样工作了,这样可以提高集群节点间的数据传输。

你最好把这几句写成一个脚本,再由/etc/rc.d/rc.local调用,以便一开机就生效。

bonding对于服务器来是个比较好的选择,在没有千兆网卡时,用两三块100兆网卡作bonding,可大大提高服务器到交换机之间的带宽。

但是需要在交换机上设置连接bonding 网卡的两个口子映射为同一个虚拟接口。

linux双网卡绑定配置,验证及测试

shwang 西安 linux+c E-mail:fenghuaster@ QQ:271904106

内容概要

什么是双网卡绑定 检查kernel是否支持绑定 检查 是否支持绑定 绑定配置 绑定后的验证 测试带宽

什么是双网卡绑定

双网卡绑定实现就是使用两块网卡虚拟成为一块网卡, 双网卡绑定实现就是使用两块网卡虚拟成为一块网卡, 这个聚合起来的设备看起来是一个单独的以太网接口设备。 这个聚合起来的设备看起来是一个单独的以太网接口设备。 通俗讲就是两块网卡具有相同的IP IP地址而并行链接聚合成 通俗讲就是两块网卡具有相同的IP地址而并行链接聚合成 一个逻辑链路工作。 一个逻辑链路工作。 Linux下双网卡绑定技术实现负载均衡和失效保护。 Linux下双网卡绑定技术实现负载均衡和失效保护。 下双网卡绑定技术实现负载均衡和失效保护

检查kernel是否支持绑定 是否支持绑定 检查

cat /boot/config-2.6.18-*** |grep –i bongding 如果有: 如果有: CONFIG_BONDING=m 表示支持。 表示支持。 否则需要编译内核使她支持bonding后,才可以做双网卡绑定 否则需要编译内核使她支持 后

配置绑定

1.新建/etc/sysconfig/network-scripts/ifcfg-bond0文件。 1.新建/etc/sysconfig/network-scripts/ifcfg-bond0文件。 新建/etc/sysconfig/network 文件 DEVICE=bond0 ONBOOT=yes BOOTPROTO=static PADDR=192.168.9.202 NETMASK=255.255.255.0 GATEWAY=192.168.9.1 USERCTL=no

Linux下双网卡绑定bond0

Linux下双网卡绑定bond0一:原理:linux操作系统下双网卡绑定有七种模式。

现在一般的企业都会使用双网卡接入,这样既能添加网络带宽,同时又能做相应的冗余,可以说是好处多多。

而一般企业都会使用linux操作系统下自带的网卡绑定模式,当然现在网卡产商也会出一些针对w indows操作系统网卡管理软件来做网卡绑定(windows操作系统没有网卡绑定功能需要第三方支持)。

进入正题,linux有七种网卡绑定模式:0. round robin,1.ac tive-backup,2.load balancing (xor), 3.fault-tolerance (broadcast),cp,5.transmit load balancing,6.adaptive load balancing。

二:案例一:mode=1(active-backup):一个网卡处于活动状态,一个处于备份状态,所有流量都在主链路上处理。

当活动网卡down掉时,启用备份的网卡。

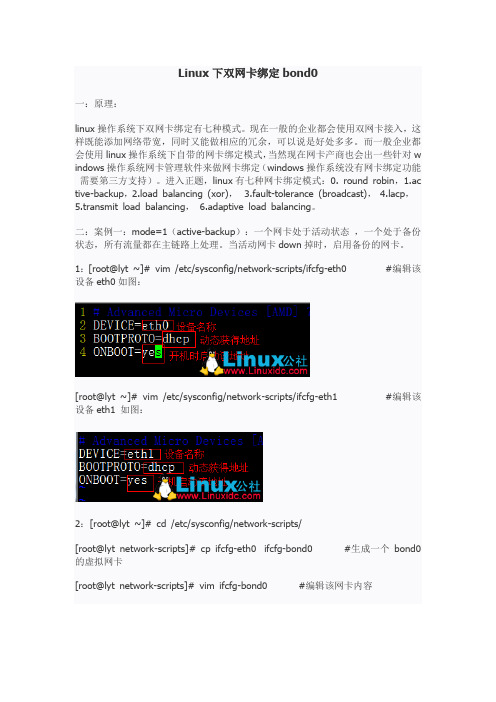

1:[root@lyt ~]# vim /etc/sysconfig/network-scripts/ifcfg-eth0 #编辑该设备eth0如图:[root@lyt ~]# vim /etc/sysconfig/network-scripts/ifcfg-eth1 #编辑该设备eth1 如图:2:[root@lyt ~]# cd /etc/sysconfig/network-scripts/[root@lyt network-scripts]# cp ifcfg-eth0 ifcfg-bond0 #生成一个bond0的虚拟网卡[root@lyt network-scripts]# vim ifcfg-bond0 #编辑该网卡内容3:[root@lyt network-scripts]# vim /etc/modprobe.conf #编辑该配置文件下图中1表示系统在启动时加载bonding模块,对外虚拟网络接口设备为bond0;miimon=100表示系统每100ms监测一次链路连接状态,如果有一条线路不通就转入另一条线路;mode=1表示fault-tolerance (active-backup)提供冗余功能,工作方式是主备的工作方式,也就是说默认情况下只有一块网卡工作,另一块做备份。

Linux双网卡绑定和解除

Linux双⽹卡绑定和解除⼀、传统的bond模式⽹卡绑定⼀定要在服务管理中关闭NetworkManager服务并禁⽤⾃动启动,因为centos中NetworkManager服务与network服务冲突,默认是由NetworkManager接管⽹络服务,所以传统⽅式重启会出现启动失败,错误⽇志⼀般如下所⽰,管理员就得回到机房接显⽰器配置⽹络连接。

以绑定eth0和eth1为例1.通过vim设置eth0的IP地址和eth1的IP地址。

[root@x101 network-scripts]# vim ifcfg-eth0DEVICE=eth0ONBOOT=yesBOOTPROTO=noneTYPE=EthernetMASTER=bond0 //将⽹卡指向bond0SLAVE=yesUSERCTL=[yes|no](⾮root⽤户是否可以控制该设备)[root@x101 network-scripts]# vim ifcfg-eth1DEVICE=eth1ONBOOT=yesNETBOOT=yesBOOTPROTO=noneTYPE=EthernetMASTER=bond0 //将⽹卡指向bond0SLAVE=yesUSERCTL=[yes|no](⾮root⽤户是否可以控制该设备)2.新建 /etc/sysconfig/network-scripts/ifcfg-bond0绑定配置⽂件[root@x101 network-scripts]# cat ifcfg-bond0DEVICE=bond0ONBOOT=yesNETBOOT=yesBOOTPROTO=noneTYPE=EthernetIPADDR=192.168.0.106PREFIX=24DNS=192.168.0.1NM_CONTROLLED=no[root@x101 network-scripts]#5.创建⽹卡绑定的驱动⽂件/etc/modprobe.d/⾃定义.conf,使得绑定后的⽹卡bond0能够⽀持绑定技术(bonding),同时定义⽹卡以mode6模式进⾏绑定,且出故障时⾃动切换时间为100毫秒ms,添加alias bond0 bondingoptions bond0 mode=6 miimon=100 max_bonds=2miimon是指多久时间要检查⽹路⼀次,单位是ms(毫秒)。

ovirt上主机的网卡绑定分析

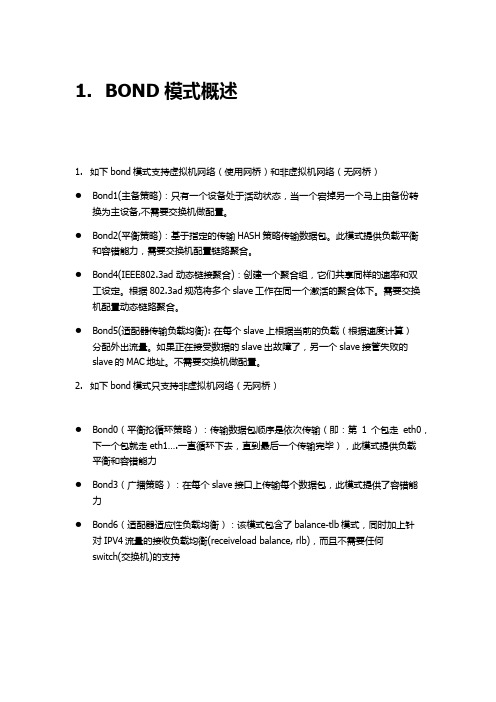

1.BOND模式概述1.如下bond模式支持虚拟机网络(使用网桥)和非虚拟机网络(无网桥)●Bond1(主备策略):只有一个设备处于活动状态,当一个宕掉另一个马上由备份转换为主设备,不需要交换机做配置。

●Bond2(平衡策略):基于指定的传输HASH策略传输数据包。

此模式提供负载平衡和容错能力,需要交换机配置链路聚合。

●Bond4(IEEE802.3ad 动态链接聚合):创建一个聚合组,它们共享同样的速率和双工设定。

根据802.3ad规范将多个slave工作在同一个激活的聚合体下。

需要交换机配置动态链路聚合。

●Bond5(适配器传输负载均衡): 在每个slave上根据当前的负载(根据速度计算)分配外出流量。

如果正在接受数据的slave出故障了,另一个slave接管失败的slave的MAC地址。

不需要交换机做配置。

2.如下bond模式只支持非虚拟机网络(无网桥)●Bond0(平衡抡循环策略):传输数据包顺序是依次传输(即:第1个包走eth0,下一个包就走eth1….一直循环下去,直到最后一个传输完毕),此模式提供负载平衡和容错能力●Bond3(广播策略):在每个slave接口上传输每个数据包,此模式提供了容错能力●Bond6(适配器适应性负载均衡):该模式包含了balance-tlb模式,同时加上针对IPV4流量的接收负载均衡(receiveload balance, rlb),而且不需要任何switch(交换机)的支持2.BOND配置2.1Bond0配置1.在设置主机网络中绑定两个网卡并配置bond模式为自定义,自定义模式为“mode=0 miimon=100”2.把逻辑网络附加到bond,并配置IP地址3.在交换机进行配置,如下为华为交换机的配置,主要为创建链路聚合组并把两个接口加入到聚合组。

#interface Eth-Trunk1port hybrid pvid vlan 14port hybrid untagged vlan 14#interface GigabitEthernet0/0/30undo negotiation autoeth-trunk 1#interface GigabitEthernet0/0/31undo negotiation autoeth-trunk 1#2.2Bond1配置1.在设置主机网络中绑定两个网卡并选择bonding模式为mode12.把逻辑网络附加到bond,并配置逻辑网络的IP3.交换机不需要做配置,不过需要让em2和em3对应的交换机网口属于相同的vlan2.3Bond2配置1.在设置主机网络中绑定两个网卡并选择bonding模式为mode22.把逻辑网络附加到bond,并配置逻辑网络的IP3.然后需要在交换机配置静态端口聚合,如下为华为交换机配置interface Eth-Trunk1port hybrid pvid vlan 14port hybrid untagged vlan 14#interface GigabitEthernet0/0/30undo negotiation autoeth-trunk 1#interface GigabitEthernet0/0/31undo negotiation autoeth-trunk 1#2.4Bond3配置1.在设置主机网络中绑定两个网卡并配置bond模式为自定义,自定义模式为“mode=3 miimon=100”2.把逻辑网络附加到bond,并配置IP地址3.交换机不需要做配置,不过需要让em2和em3对应的交换机网口属于相同的vlan。

VirtualBox配置虚拟网卡(桥接),实现主机-虚拟机网络互通(图文教程)

VirtualBox配置虚拟⽹卡(桥接),实现主机-虚拟机⽹络互通(图⽂教程)⽹上搜出来的⽐较乱,讲的不明不⽩,因此根据⾃⼰弄过⼀次,确认可⾏的⽅式,做个备份,⽅便⽇后查阅。

环境:在Oracle VM VirtualBox中安装的Ubuntu,具体版本名是:ubuntu-14.10-server-amd64Step1:VirtualBox在虚拟机关机状态下,如图进⾏设置:Step 2:虚拟机开机,输⼊命令:sudo ifconfig或者sudo ifconfig -a查看当前⽹卡配置查看当前ip地址Step3:输⼊命令:vim /etc/network/interfaces打开⽹卡配置⽂件,添加eth1,保存修改。

修改后的⽂件内容,如下:# This file describes the network interfaces available on your system# and how to activate them. For more information, see interfaces(5).# The loopback network interfaceauto loiface lo inet loopback# The primary network interfaceauto eth0iface eth0 inet dhcpauto eth1iface eth1 inet static#本机当前ip地址,通过Step2中ifconfig查询出来的即可address 192.168.56.11netmask 255.255.255.0Step4:重启虚拟机(必要时重启主机电脑),命令ifconfig查看当前⽹卡设置。

能看到eth1,并且有值,即可。

Step5:1) Windows的cmd中,命令:ipconfig查看当前ip2) ubuntu中,输⼊命令:ping 192.168.56.1,Enter,显⽰如下:虚拟机访问主机ip,通过了。

Linux系统配置双网卡绑定bond0

Linux系统配置双⽹卡绑定bond01、bonding简述双⽹卡配置设置虚拟为⼀个⽹卡实现⽹卡的冗余,其中⼀个⽹卡坏掉后⽹络通信仍可正常使⽤,实现⽹卡层⾯的负载均衡和⾼可⽤性。

现在⼀般的企业都会使⽤双⽹卡接⼊,这样既能添加⽹络带宽,同时⼜能做相应的冗余,可以说是好处多多。

⽽⼀般企业都会使⽤linux操作系统下⾃带的⽹卡绑定模式,当然现在⽹卡产商也会出⼀些针对windows操作系统⽹卡管理软件来做⽹卡绑定(windows操作系统没有⽹卡绑定功能需要第三⽅⽀持)。

1.1 bonding原理⽹卡⼯作在混杂(promisc)模式,接收到达⽹卡的所有数据包,tcpdump⼯作⽤的也是混杂模式(promisc),将两块⽹卡的MAC地址修改为相同接收特定MAC的数据帧,然后把相应的数据帧传送给bond驱动程序进⾏处理。

1.2 Bonding模式(bonding mode)轮询策略(round robin),mode=0,按照设备顺序依次传输数据包,提供负载均衡和容错能⼒主备策略(active-backup),mode=1,只有主⽹卡处于⼯作状态,备⽹卡处于备⽤状态,主⽹卡坏掉后备⽹卡开始⼯作,提供容错能⼒异或策略(load balancing (xor)),mode=2,根据源MAC地址和⽬的MAC地址进⾏异或计算的结果来选择传输设备,提供负载均衡和容错能⼒⼴播策略(fault-tolerance (broadcast)),mode=3,将所有数据包传输给所有接⼝通过全部设备来传输所有数据,⼀个报⽂会复制两份通过bond下的两个⽹卡分别发送出去,提供⾼容错能⼒动态链接聚合(lacp),mode=4,按照802.3ad协议的聚合⾃动配置来共享相同的传输速度,⽹卡带宽最⾼可以翻倍,链路聚合控制协议(LACP)⾃动通知交换机聚合哪些端⼝,需要交换机⽀持 802.3ad协议,提供容错能⼒输出负载均衡模式(transmit load balancing),mode=5,输出负载均衡模式,只有输出实现负载均衡,输⼊数据时则只选定其中⼀块⽹卡接收,需要⽹卡和驱动⽀持ethtool命令输⼊/输出负载均衡模式(adaptive load balancing),mode=6,输⼊和输出都实现负载均衡,需要⽹卡和驱动⽀持ethtool命令2、⽹卡配置⽂件的配置2.1 配置环境 环境:系统CentOS 6.7 + 虚拟机 VMware 12 ⾄少两块物理⽹卡(VMware上添加eth0,eth1) 2.2 需要添加或修改的配置⽂件有5个(mode=1) 这5个配置⽂件是: /etc/sysconfig/network-scripts/ifcfg-eth{0,1} /etc/sysconfig/network-scripts/ifcfg-bond0 /etc/modprobe.d/dist.conf /etc/rc.local2.2.1 /etc/sysconfig/network-scripts/ifcfg-{eth0,eth1,bonding0}修改或添加提⽰:先备份好eth0和eth1,再修改这⼏个⽂件以下是修改好的三个⽹卡配置⽂件的参数[root@ant network-scripts]# vimdiff ifcfg-eth0 ifcfg-eth1 ifcfg-bond02.2.2 修改/etc/modprobe.d/dist.conf⽂件在此⽂件中添加以下内容:alias bond0 bonding,表⽰系统在启动时加载bonding模块,对外虚拟⽹络接⼝设备为 bond0miimon=100,表⽰系统每100ms监测⼀次链路连接状态,如果有⼀条线路不通就转⼊另⼀条线mode=1,表⽰绑定模式为1primary=eth0,系统⾸先eth0作为bond0接⼝与外界信息的传输接⼝2.2.3 修改配置⽂件/etc/rc.local在此⽂件中添加以下内容:modprobe bonding miimon=100 mode=12.2.4 重启⽹络(service network restart),并查看三个接⼝的mac地址使⽤ifconfig命令显⽰,bond0,eth1,eth2物理地址相同,提⽰三个⽹卡均通过⼀个ip主机端⼝与外界通信但是,我们可以看到,在mode=1的情况下,当前bond0采⽤eth0通信,实际的物理⽹卡地址见下图:3、验证⽹络的连通性没有丢包,⽹络连通性可。

开源虚拟化管理平台Ovirt简介和配置环境搭建

开源虚拟化管理平台Ovirt简介和配置环境搭建一Ovirt简介Ovirt是什么?Ovirt是一个开源的虚拟化管理平台,是redhat 虚拟化管理平台RHEV的开源版本。

Ovirt的构架是什么样的?Ovirt由两部分组成,客户端ovirt-node 类似于vmware esxi,是由fedaro 16订制而成。

也可以在linux系统上安装vdsm服务而得到一个ovirt客户端。

管理端overt-engine 类似于 vmware vcenter,但是是基于web页面的。

Ovirt能做什么,不能做什么?Ovirt现在已有的功能:1. 对宿主机节点的管理,支持基于数据中心,集群的管理,比较有特色的一个功能是可以管理ilo idarc等硬件管理卡;2. 对虚拟机的管理,可以完成虚拟机的创建、快照、删除、基于模版的克隆等常见操作;3. 迁移,在线及离线迁移虚拟机;4. 高可用,当一台宿主机宕机,在另外一台宿主机上自动开启虚机;5. 宿主机、虚拟机性能查看及统计;6. 支持nfs,iscsi,fc等存储方式;7. 支持多端口的网口绑定;8. 提供一个命令行,可以完成图形界面的大部分功能;9. 活动目录集成;10. 提供python api接口,可以api编程;11. 没有授权限制;和vmware相比,目前没有的功能:1. 稳定目前较差,经常出现崩溃,连接出现问题;2. 易用性较差,设计不人性化;3. 没有cpu 内存很精细的调节限制功能;4. 没有FT(Fault Tolerance)功能;5. 宿主机、虚拟机性能查看及统计功能很简单,远没有vmware丰富;6. 不支持分布式交换机;二 Ovirt测试环境的搭建本次测试环境:硬件环境Ovirt Node 1 Dell r610CPU E5645 2颗(2.4G 6核)内存 48G硬盘 300G*2 raid 1Ovirt Node 2 HP 380G7CPU E5620 2颗(2.4G 4核)内存 8G硬盘 146G*4 raid 10Ovirt engine vmware虚拟机CPU 2颗2.4G内存 4G硬盘 255G软件环境Ovirt Node 1 安装f16 更新最新软件包,然后安装vdsm软件包Ovirt Node 2 安装f16订制的ovirt-node-image 2.2.2版本Ovirt engine 安装f16更新最新软件包,然后安装ovirt engine软件包Ovirt配置注意事项:因为ovirt的程序调用是用全局域名FQDN,因此应该保证每台测试机器的机器名能被解析,需要配置dns,或者确保/etc/hosts文件内容一致。

linux双网卡绑定的方法和步骤

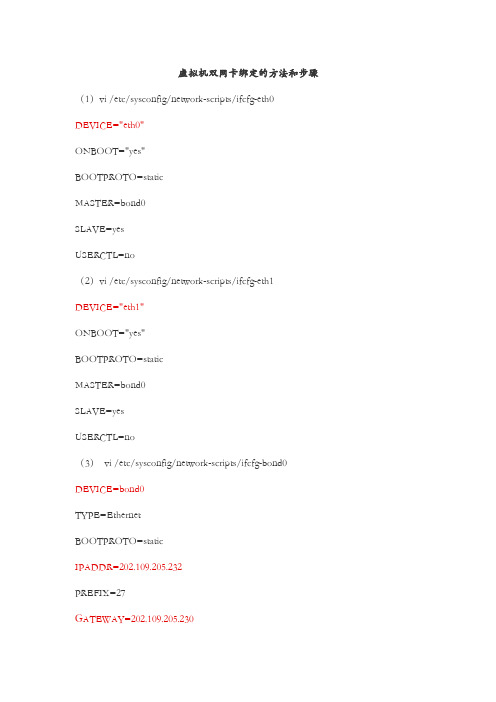

虚拟机双网卡绑定的方法和步骤(1)vi /etc/sysconfig/network-scripts/ifcfg-eth0 DEVICE="eth0"ONBOOT="yes"BOOTPROTO=staticMASTER=bond0SLAVE=yesUSERCTL=no(2)vi /etc/sysconfig/network-scripts/ifcfg-eth1 DEVICE="eth1"ONBOOT="yes"BOOTPROTO=staticMASTER=bond0SLAVE=yesUSERCTL=no(3)vi /etc/sysconfig/network-scripts/ifcfg-bond0 DEVICE=bond0TYPE=EthernetBOOTPROTO=staticIPADDR=202.109.205.232PREFIX=27GATEWAY=202.109.205.230注:(2)、(3)的配置内容一样,就是"DEVICE"不一样,修改成对应的文件名即可。

(4)中的"IPADDR"根据对应服务器的IP来填写即可。

(4)vi /etc/modprobe.d/bond0.confalias bond0 bondingoptions bond0 miimon=100 mode=1(5)确定前面的四个文件的配置无误(编辑完内容后认真核对一遍或用cat命令检查一遍)后,重启网卡:"service network restart"(6)"ifconfig"===>>查看具体情况(7)用绑定后的IP新建会话并连接,连接后,打入命令:"sync"==>与磁盘同步(确保将修改的内容存到磁盘中)==>多执行几次!!(8)打入"reboot"命令重启服务器。

Linux网卡绑定

Linux网卡绑定Centeros7下面的网卡绑定有2种方式,一种是team,一种是bond实现方式有三种,1、第一种,命令行方式,执行脚本Bond命令行实现方式nmcli connection add type bond con-name bond0 ifname bond0 mode active-backup ipv4.method manual ipv4.addresses 10.68.15.56/24 ipv4.dns 114.114.114.144 ipv4.gateway 10.68.15.254 #将ip地址,网关修改为目标网络规划的ip地址nmcli connection add con-name bond-slave0 type bond-slave ifname eno3 master bond0#实体网卡对应绑定nmcli connection add con-name bond-slave1 type bond-slave ifname eno4 master bond0#实体网卡对应绑定nmcli connection up bond-slave0 #启用实体网卡对应的虚拟网卡nmcli connection up bond-slave1#启用实体网卡对应的虚拟网卡nmcli connection up bond0 #启动绑定2、team命令行实现方式nmcli connection add type team con-name team0 ifname agg-eth0 config '{"runner":{"name":"activebackup"}}' #创建team 口, con-name team0 , con-name team0nmcli con add type team con-name CNAME ifname INAME [config JSON] #创建连接nmcli connection modify team0 ipv4.addresses "192.168.1.250/24" #给team0 配置IP Gateway DNSnmcli connection modify team0 ipv4.gateway "192.168.1.1"nmcli connection modify team0 ipv4.dns "192.168.1.1"nmcli connection modify team0 ipv4.method manualnmcli connection add type team-slave con-name team0-port1 ifname ens37master team0 #将 ens37 ens38 加入team0,nmcli connection add type team-slave con-name team0-port2 ifname ens38 master team0nmcli connection up team0 #激活 team0 team0-port1 team0-port2nmcli connection up team0-port1nmcli connection up team0-port2虽然team和bond都可以实现网卡绑定,但是bond仅支持双网口,team组最多支持8个网口3、半图形界面工具nmtui在终端键入nmtui后,弹出半图形化管理方式选择编辑连接,弹出下面的界面,然后点添加选择绑定,或者组队然后在弹出界面设置bond,或者team第三种完全图形化界面命令行输入 nm-connection-editor 弹出网络管理界面点击加号,选择连接类型然后弹出选择ADD,添加网卡同样添加另一块网卡。

Linux双网卡绑定

Linux双网卡绑定1、在terminal中进行操作2、停止网络服务[root@TXJH-BILL ~]# service network stopShutting down loopback interface: [ OK ]3、进入到网络配置文件目录[root@TXJH-BILL ~]# cd /etc/sysconfig/network-scripts/[root@TXJH-BILL network-scripts]# lsifcfg-eth0 ifdown-ipsec ifup ifup-isdn ifup-wirelessifcfg-eth1 ifdown-ipv6 ifup-aliases ifup-plip init.ipv6-globalifcfg-eth2 ifdown-isdn ifup-bnep ifup-plusb net.hotplugifcfg-eth3 ifdown-post ifup-eth ifup-post network-functionsifcfg-lo ifdown-ppp ifup-ib ifup-ppp network-functions-ipv6ifdown ifdown-routes ifup-ippp ifup-routesifdown-bnep ifdown-sit ifup-ipsec ifup-sitifdown-eth ifdown-sl ifup-ipv6 ifup-slifdown-ippp ifdown-tunnel ifup-ipx ifup-tunnel4、新建一个关于bond口的文件并进行编辑。

(此处由于bond口文件配置和物理网口配置文件相似,所以复制了一份物理网口的配置文件并重命名)[root@TXJH-BILL network-scripts]# cp ifcfg-eth0 ifcfg-bond05、编辑ifcfg-bond0配置文件[root@TXJH-BILL network-scripts]# vi ifcfg-bond0DEVICE=bond0BOOTPROTO=staticONBOOT=yesTYPE=EthernetIPADDR=172.16.1.9NETMASK=255.255.255.0BONDING_OPTS="primary=eth0 mode=1 miimon=200"~~6、编辑物理网口配置文件eth0和eth1[root@TXJH-BILL network-scripts]# vi ifcfg-eth0 /eth1# Intel Corporation I350 Gigabit Network ConnectionDEVICE=eth0 /eth1BOOTPROTO=noneHWADDR=B8:CA:3A:5D:B1:18ONBOOT=yesMASTER=bond0SLAVE=yes~~7、编辑modprobe.conf文件[root@TXJH-BILL network-scripts]# vi /etc/modprobe.confalias eth0 igbalias eth1 igbalias eth2 igbalias eth3 igbalias scsi_hostadapter megaraid_sasalias scsi_hostadapter1 ahcialias scsi_hostadapter2 usb-storagealias bond0 bonding~~8、重新启动网络服务[root@TXJH-BILL network-scripts]# service network startBringing up loopback interface: [ OK ] Bringing up interface bond0: [ OK ]。

基于virtio的网卡使用

基于virtio的网卡使用基于virtio的网卡使用0.1版Contents《改版履歴》....................... 错误!未定义书签。

1.概要 (5)2. 使用virtio的前提 (6)2.1 前端驱动 (6)2.2 后端驱动 (8)2.3 使用QEMU创建virtio网卡 (9)3 virtio网卡的使用场景 (10)3.1 Guest虚拟机与Host机通讯 (11)3.2 Guest虚拟机通过Host与外部网络通讯 (14)3.3 Guest虚拟机与Guest虚拟机通讯 (20)4.4 使用virtio的效果分析 (23)1. 概要在QEMU中,默认使用的网卡配置为virtio 网卡。

virtio本身是一个framework,使用QEMU加上KVM来进行虚拟I/O,概而言之,virtio 是半虚拟化hypervisor 中位于设备之上的抽象层。

而virtio网卡则是挂载在virtio模拟的pci 总线上的一个虚拟网卡。

在虚拟机开发中一般推荐使用virtio网卡,因为virtio网卡是在虚拟化中速度最快、功能最全面的虚拟网卡。

2. 使用virtio的前提使用virtio需要Guest虚拟机的kernel和Host机的kernel包含相应的驱动,virtio驱动包含前段和后端,也就是说需要在Host的Kernel 中添加Back-end的驱动,并在Guest的kernel 中添加Front-end的驱动。

2.1 前端驱动Guest机使用的kernel在编译时(make menuconfig)需要添加如下选项:[*] Virtualization ---><*> PCI driver for virtiodevicesDevice Drivers --->[*] Network device support ---><*> Virtio network driverDevice Drivers --->[*] Block devices ---><*> Virtio block driver第一个选项是在内核中添加virtio PCI驱动,第二个选项时再内核中添加virtio网卡驱动,第三个选项时为了支持virtio的块设备驱动,如virtio硬盘等。

Linux学习之CentOS(29)--Linux网卡高级命令、IP别名及多网卡绑定

Linux学习之CentOS(二十九)--Linux网卡高级命令、IP别名及多网卡绑定您可以通过点击右下角的按钮来对文章内容作出评价, 也可以通过左下方的关注按钮来关注我的博客的最新动态。

如果文章内容对您有帮助, 不要忘记点击右下角的推荐按钮来支持一下哦如果您对文章内容有任何疑问, 可以通过评论或发邮件的方式联系我: 501395377@ /lzp501395377@如果需要转载,请注明出处,谢谢!!本篇随笔将详细讲解Linux系统的网卡高级命令、IP别名以及Linux下多网卡绑定的知识一、网卡高级命令在之前的一篇随笔里Linux学习之CentOS(九)--Linux系统的网络环境配置,详细讲解了Linux系统下的网络环境配置等知识,我们了解了一些关于网络配置的一些基本命令。

在这里将补充一些Linux系统下有关网卡的一些高级命令。

①mii-tool命令mii-tool命令我们可以用来查看网卡状态信息,包括了以太网连接是否正常,使用的是哪种型号的网卡等等[root@xiaoluo ~]# mii-tool eth0eth0: no autonegotiation, 100baseTx-FD, link ok我们从输出的信息可以看到,当前以太网连接正常,以太网的速率是100M每秒,通过这个命令我们可以看到网卡底层的一些信息,当有时我们在上层通过ping、traceroute等命令进行网络排错时,如果发现网络还是不能连接畅通,这时就可以使用这个命令来查看是否是以太网连接出问题了②ethtool命令通过mii-tool命令可以查看网卡的一些底层信息,但是如果我们想要查看网卡的更详细信息,就可以使用ethtool 这个命令,它可以将网卡的所有信息都详细列出来[root@xiaoluo ~]# ethtool eth0Settings for eth0:Supported ports: [ TP ]Supported link modes: 10baseT/Half 10baseT/Full100baseT/Half 100baseT/Full1000baseT/FullSupported pause frame use: NoSupports auto-negotiation: YesAdvertised link modes: 10baseT/Half 10baseT/Full100baseT/Half 100baseT/Full1000baseT/FullAdvertised pause frame use: NoAdvertised auto-negotiation: YesSpeed: 1000Mb/sDuplex: FullPort: Twisted PairPHYAD: 0Transceiver: internalAuto-negotiation: onMDI-X: UnknownSupports Wake-on: umbgWake-on: dCurrent message level: 0x00000007 (7)drv probe linkLink detected: yes包括网卡支持的链接速率、双工模式等等信息都能查看到如果说我们想要查看网卡的驱动信息,可以在 ethtool 命令后加上 -i 参数,就能显示网卡的驱动信息了[root@xiaoluo ~]# ethtool -i eth0driver: e1000version: 7.3.21-k8-NAPIfirmware-version:bus-info: 0000:00:03.0supports-statistics: yessupports-test: yessupports-eeprom-access: yessupports-register-dump: yessupports-priv-flags: no如果说我们还需要查看网卡当前底层工作状态信息,可以在命令后加上 -S 参数[root@xiaoluo ~]# ethtool -S eth0NIC statistics:rx_packets: 3255tx_packets: 898rx_bytes: 477575tx_bytes: 2228309rx_broadcast: 2190tx_broadcast: 198rx_multicast: 0tx_multicast: 6rx_errors: 0tx_errors: 0tx_dropped: 0multicast: 0collisions: 0rx_length_errors: 0rx_over_errors: 0rx_crc_errors: 0rx_frame_errors: 0rx_no_buffer_count: 0rx_missed_errors: 0tx_aborted_errors: 0tx_carrier_errors: 0tx_fifo_errors: 0tx_heartbeat_errors: 0tx_window_errors: 0tx_abort_late_coll: 0tx_deferred_ok: 0tx_single_coll_ok: 0tx_multi_coll_ok: 0tx_timeout_count: 0tx_restart_queue: 0rx_long_length_errors: 0rx_short_length_errors: 0 rx_align_errors: 0tx_tcp_seg_good: 263tx_tcp_seg_failed: 0rx_flow_control_xon: 0rx_flow_control_xoff: 0tx_flow_control_xon: 0tx_flow_control_xoff: 0rx_long_byte_count: 477575 rx_csum_offload_good: 0rx_csum_offload_errors: 0 alloc_rx_buff_failed: 0tx_smbus: 0rx_smbus: 0dropped_smbus: 0包括网卡发送了多少数据包、接受了多少数据包等信息都能看到。

LINUX 6.0双网卡绑定

双网卡绑定linux下双网卡绑定环境:rhel 6.01.新建/etc/sysconfig/network-scripts/ifcfg-bond0文件DEVICE=bond0ONBOOT=yesBOOTPROTO=staticIPADDR=192.168.0.23NETMASK=255.255.255.224GATEWAY=192.168.128.233USERCTL=no这里要主意,不要指定单个网卡的IP地址、子网掩码或网卡ID。

将上述信息指定到虚拟适配器(bonding)中即可。

2.更改/etc/sysconfig/network-scripts/ifcfg-eth0网卡属性DEVICE=eth0ONBOOT=yesBOOTPROTO=noneMASTER=bond0USERCTL=no3.更改/etc/sysconfig/network-scripts/ifcfg-eth1网卡的属性DEVICE=eth1ONBOOT=yesBOOTPROTO=noneMASTER=bond0USERCTL=no文章出处:DIY部落4#vi/etc/modules.d/dist.conf或vi/etc/modprobe.d/dist.conf编辑/etc/modules.d/dist.conf文件,加入如下一行内容,以使系统在启动时加载bonding模块,对外虚拟网络接口设备为bond0加入下列两行alias bond0bondingoptions bond0miimon=100mode=1说明:miimon是用来进行链路监测的。

比如:miimon=100,那么系统每100ms监测一次链路连接状态,如果有一条线路不通就转入另一条线路;mode的值表示工作模式,他共有0,1,2,3四种模式,常用的为0,1两种。

mode=0表示load balancing(round-robin)为负载均衡方式,两块网卡都工作。

linux双网卡绑定配置

“?REDHAT linux双网卡绑定配置(v 130214)版本说明目录版本说明 (2)1、配置驱动模块 (4)2、建立bonding网卡配置 (4)3、修改被绑定网卡的配置 (6)4、修改/etc/sysconfig/network-scripts/ifcfg-eth1 (6)5、导入bonding驱动: (6)6、重启网络 (7)1、配置驱动模块修改文件/etc/modprobe.conf,找到:alias eth0 8139cpalias eth1 8139cp注意:8139cp为网卡型号。

在此内容后加入:######## Bonding ##########alias bond0 bondingoptions bonding max_bonds=1或######## Bonding ##########alias bond0 bondingoptions bond0 miimon=100 mode=12、建立bonding网卡配置新建文件/etc/sysconfig/network-scripts/ifcfg-bond0,输入以下内容:DEVICE=bond0ONBOOT=yesBOOTPROTO=staticIPADDR=192.168.100.21NETMASK=255.255.255.0USERCTL=noBONDING_OPTS="mode=1 miimon=100 primary=eth0"BONDING_OPTS参数解释此参数用于指定网卡绑定时的属性,以下是对常用参数进行的解释:miimon参数:指定网卡故障时的切换时间间隔以ms为单位。

primary参数:指定默认的主网卡设备。

mode参数:0-轮询模式,所绑定的网卡会针对访问以轮询算法进行平分。

1-高可用模式,运行时只使用一个网卡,其余网卡作为备份,在负载不超过单块网卡带宽或压力时建议使用。

2-基于HASH算法的负载均衡模式,网卡的分流按照xmit_hash_policy的TCP协议层设置来进行HASH 计算分流,使各种不同处理来源的访问都尽量在同一个网卡上进行处理。

Linux+Oracle 10g RAC双网卡绑定和解除绑定的实现

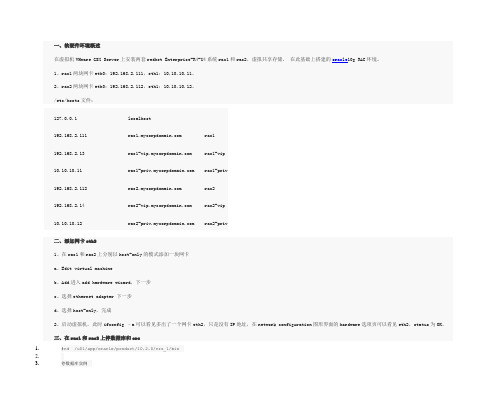

一、软硬件环境概述在虚拟机VMware GSX Server上安装两套redhet Enterprise-R4-U4系统rac1和rac2,虚拟共享存储,在此基础上搭建的oracle10g RAC环境。

1、rac1两块网卡eth0:192.168.2.111,eth1:10.10.10.11。

2、rac2两块网卡eth0:192.168.2.112,eth1:10.10.10.12。

/etc/hosts文件:127.0.0.1localhost192.168.2.111 rac1 rac1-vip rac1-priv rac2 rac2-vip rac2-priv二、添加网卡eth21、在rac1和rac2上分别以host-only的模式添加一块网卡a、Edit virtual machineb、Add进入add hardware wizard,下一步c、选择ethernet adapter 下一步d、选择host-only,完成2、启动虚拟机,此时ifconfig –a可以看见多出了一个网卡eth2,只是没有IP地址,在network configuration图形界面的hardware选项页可以看见eth2,status为OK。

三、在rac1和rac2上停数据库和crs1.#cd /u01/app/oracle/product/10.2.0/crs_1/bin2.3.停数据库实例4.5.#./srvctl stop instance –d devdb –i ora.devdb.devd1.inst6.7.#./srvctl stop instance –d devdb –i ora.devdb.devd2.inst8.9.停数据库10.11.#./srvctl stop database –d devdb12.13.停ASM实例14.15.#./srvctl stop asm –n rac116.17.#./srvctl stop asm –n rac218.19.停vip,gsd,listener,ons20.21.#./srvctl stop nodeapps –n rac122.23.#./srvctl stop nodeapps –n rac2四、更改网卡配置绑定网卡更改eth0和eth2的配置文件,将eth0和eth2绑定为一块虚拟网卡bond0.1、首先在/etc/sysconfig/network-scripts/下创建虚拟网卡bond0的配置文件ifcfg-bond0 1.#cd /etc/sysconfig/network-scripts/2.3.#vi ifcfg-bond04.5.DEVICE=bond06.7.BOOTPROTO=none8.9.BROADCAST=192.168.2。

Linux下多网卡绑定bond及模式介绍

Linux下多⽹卡绑定bond及模式介绍【介绍】⽹卡bond⼀般主要⽤于⽹络吞吐量很⼤,以及对于⽹络稳定性要求较⾼的场景。

主要是通过将多个物理⽹卡绑定到⼀个逻辑⽹卡上,实现了本地⽹卡的冗余,带宽扩容以及负载均衡。

Linux下⼀共有七种⽹卡bond⽅式,实现以上某个或某⼏个具体功能。

最常见的三种模式是bond0,bond1,bond6.【bond0】平衡轮循环策略,有⾃动备援,不过需要"Switch"⽀援及设定。

balance-rr(Round-robin policy)⽅式:传输数据包的顺序是依次传输(即:第⼀个包⾛eth0,第⼆个包就⾛eth1……,⼀直到所有的数据包传输完成)。

优点:提供负载均衡和容错能⼒。

缺点:同⼀个链接或者会话的数据包从不同的接⼝发出的话,中间会经过不同的链路,在客户端可能会出现数据包⽆法有序到达的情况,⽽⽆序到达的数据包将会被要求重新发送,⽹络吞吐量反⽽会下降。

【bond1】主-备份策略active-backup(Active -backup policy)⽅式:只有⼀个设备处于活动状态,⼀个宕掉之后另⼀个马上切换为主设备。

mac地址为外部可见,从外⾯看,bond的mac地址是唯⼀的,switch不会发⽣混乱。

优点:提⾼了⽹络连接的可靠性。

缺点:此模式只提供容错能⼒,资源利⽤性较低,只有⼀个接⼝处于active状态,在有N个⽹络接⼝bond 的状态下,利⽤率只有1/N。

【bond2】平衡策略balance-xor(XOR policy)⽅式:基于特性的Hash算法传输数据包。

缺省的策略为:(源MAC地址 XOR ⽬标MAC地址) % slave数量。

# XRO为异或运算,值不同时结果为1,相同为0可以通过xmit_hash_policy选项设置传输策略。

特点:提供负载均衡和容错能⼒。

【bond3】⼴播策略broadcast⽅式:在每个slave接⼝上传输每⼀个数据包。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1.BOND模式概述

1.如下bond模式支持虚拟机网络(使用网桥)和非虚拟机网络(无网桥)

●Bond1(主备策略):只有一个设备处于活动状态,当一个宕掉另一个马上由备份转

换为主设备,不需要交换机做配置。

●Bond2(平衡策略):基于指定的传输HASH策略传输数据包。

此模式提供负载平衡

和容错能力,需要交换机配置链路聚合。

●Bond4(IEEE802.3ad 动态链接聚合):创建一个聚合组,它们共享同样的速率和双

工设定。

根据802.3ad规范将多个slave工作在同一个激活的聚合体下。

需要交换机配置动态链路聚合。

●Bond5(适配器传输负载均衡): 在每个slave上根据当前的负载(根据速度计算)

分配外出流量。

如果正在接受数据的slave出故障了,另一个slave接管失败的

slave的MAC地址。

不需要交换机做配置。

2.如下bond模式只支持非虚拟机网络(无网桥)

●Bond0(平衡抡循环策略):传输数据包顺序是依次传输(即:第1个包走eth0,

下一个包就走eth1….一直循环下去,直到最后一个传输完毕),此模式提供负载平衡和容错能力

●Bond3(广播策略):在每个slave接口上传输每个数据包,此模式提供了容错能

力

●Bond6(适配器适应性负载均衡):该模式包含了balance-tlb模式,同时加上针

对IPV4流量的接收负载均衡(receiveload balance, rlb),而且不需要任何

switch(交换机)的支持

2.BOND配置

2.1Bond0配置

1.在设置主机网络中绑定两个网卡并配置bond模式为自定义,自定义模式为

“mode=0 miimon=100”

2.把逻辑网络附加到bond,并配置IP地址

3.在交换机进行配置,如下为华为交换机的配置,主要为创建链路聚合组并把两个接

口加入到聚合组。

#

interface Eth-Trunk1

port hybrid pvid vlan 14

port hybrid untagged vlan 14

#

interface GigabitEthernet0/0/30

undo negotiation auto

eth-trunk 1

#

interface GigabitEthernet0/0/31

undo negotiation auto

eth-trunk 1

#

2.2Bond1配置

1.在设置主机网络中绑定两个网卡并选择bonding模式为mode1

2.把逻辑网络附加到bond,并配置逻辑网络的IP

3.交换机不需要做配置,不过需要让em2和em3对应的交换机网口属于相同的vlan

2.3Bond2配置

1.在设置主机网络中绑定两个网卡并选择bonding模式为mode2

2.把逻辑网络附加到bond,并配置逻辑网络的IP

3.然后需要在交换机配置静态端口聚合,如下为华为交换机配置

interface Eth-Trunk1

port hybrid pvid vlan 14

port hybrid untagged vlan 14

#

interface GigabitEthernet0/0/30

undo negotiation auto

eth-trunk 1

#

interface GigabitEthernet0/0/31

undo negotiation auto

eth-trunk 1

#

2.4Bond3配置

1.在设置主机网络中绑定两个网卡并配置bond模式为自定义,自定义模式为

“mode=3 miimon=100”

2.把逻辑网络附加到bond,并配置IP地址

3.交换机不需要做配置,不过需要让em2和em3对应的交换机网口属于相同的vlan。

2.5Bond4配置

1.在设置主机网络中绑定两个网卡并选择bonding模式为mode4

2.把逻辑网络附加到bond,并配置逻辑网络的IP

3.然后需要在交换机配置动态链路聚合,如下为华为交换机配置#

lacp priority 100

#

interface Eth-Trunk1

port hybrid pvid vlan 14

undo port hybrid vlan 1

port hybrid untagged vlan 14

mode lacp

max bandwidth-affected-linknumber 2

#

interface GigabitEthernet0/0/30

undo negotiation auto

eth-trunk 1

lacp priority 100

#

interface GigabitEthernet0/0/31

undo negotiation auto

eth-trunk 1

lacp priority 100

2.6Bond5配置

1.在设置主机网络中绑定两个网卡并选择bonding模式为mode5

2.把逻辑网络附加到bond,并配置逻辑网络的IP

3.交换机不需要做配置,不过需要让em2和em3对应的交换机网口属于相同的vlan

2.7Bond6配置

1.在设置主机网络中绑定两个网卡并配置bond模式为自定义,自定义模式为

“mode=6 miimon=100”

2.把逻辑网络附加到bond,并配置IP地址

4.交换机不需要做配置,不过需要让em2和em3对应的交换机网口属于相同的vlan。

3.验证结果

如下为验证的结果,仅供参考

1.支持虚拟机的网络为通过在虚拟机中使用iperf发送流量进行测试,测试结果如下

●bond1:流量在活动网卡上,如果禁用活动网卡,流量切换到备用网卡,切换过程中

网络存在短时间中断,启用刚才禁用的网卡后,流量不会切换到该网卡

●bond2:需要交换机配置链路聚合,禁用其中一块网卡后,流量切换到另一块网卡,

切换过程有少量丢包,把禁用的网卡启用后,流量恢复到之前的网卡,在该过程中存在少量丢包。

流量分布为1:3

●bond4:需要交换机配置。

禁用其中一块网卡后,流量切换到另一块网卡,切换过程

有少量丢包,把禁用的网卡启用后,流量恢复到之前的网卡,在该过程中流量基本不会受到影响。

流量分布为1:3

●bond5:

接收流量:数据在一个网卡传输,禁用正在传输数据的网卡后,流量切换到另一块的网卡,切换过程中有少量丢包,把禁用的网卡启用后,网络会出现10秒以上的中断

发送流量:

流量在两个网卡上切换,禁用正在传输数据的网卡后,流量切换到另一块网卡,切换过程

有少量丢包,把禁用的网卡启用后,网络会出现10秒以上的中断

2.不支持虚拟机的网络为通过虚拟机迁移迁移进行测试,测试结果如下

●bond0:发送的流量在两个网卡,接收的流量大部分时间在一个网卡,后续需要确认

原因。

●bond3:两个网卡上都有相同的流量,bond的流量为两个流量的总大小,禁用一个

网卡,流量不会出现中断

●bond6:

接受流量:流量在两个网卡上切换,禁用正在传输数据的网卡后,流量切换到另一块的网卡,切换过程中有少量丢包,把禁用的网卡启用后,网络也会出现短暂中断

发送流量:

流量在两个网卡上切换,禁用正在传输数据的网卡后,流量切换到另一块网卡,切换过程有少量丢包,把禁用的网卡启用后,网络会出现短暂中断。