《信息论》—基础理论与应用 傅祖芸 课后答案

信息论与编码答案傅祖芸

信息论与编码答案傅祖芸【篇一:信息论与编码课程设计报告】t>设计题目:统计信源熵与香农编码专业班级学号学生姓名指导教师教师评分2014年3月24日目录一、设计任务与要求................................................. 2 二、设计思路....................................................... 2 三、设计流程图..................................................... 3 四、程序运行及结果................................................. 5 五、心得体会....................................................... 6 参考文献 .......................................................... 6 附录:源程序.. (7)一、设计任务与要求1、统计信源熵要求:统计任意文本文件中各字符(不区分大小写)数量,计算字符概率,并计算信源熵。

2、香农编码要求:任意输入消息概率,利用香农编码方法进行编码,并计算信源熵和编码效率。

二、设计思路1、统计信源熵:统计信源熵就是对一篇英文文章(英文字母数为n),通过对其中的a,b,c,d/a,b,c,d.....(不区分大小写)统计每个字母的个数n,有这个公式p=n/n可得每个字母的概率,最后又信源熵计算公式h(x)=??p(xi)logp(xi)i?1n,可计算出信源熵h,所以整体步骤就是先统计出英文段落的总字符数,在统计每个字符的个数,即每遇到同一个字符就++1,直到算出每个字符的个数,进而算出每个字符的概率,再由信源熵计算公式计算出信源熵。

2、香农编码:香农编码主要通过一系列步骤支出平均码长与信源之间的关系,同时使平均码长达到极限值,即选择的每个码字的长度ki满足下式:i(xi)?ki?i(xi)?1,?i具体步骤如下:a、将信源消息符号按其出现的概率大小依次排列为:p1?p2?......?pn b、确定满足下列不等式的整数码长ki为:?lb(pi)?ki??lb(pi)?1 c、为了编成唯一可译码,计算第i个消息的累加概率:pi??p(ak)k?1i?1d、将累加概率pi变换成二进制数。

信息论答案(傅祖芸)

7 I = log 7 = 2.807 比特

而当已知今天星期几时问同样的问题,其可能性只有一种,即发生的概率为 1,此时获得 的信息量为 0 比特。 【2.4】居住某地区的女孩中有 25%是大学生,在女大学生中有 75%是身高 1.6 米以上的, 而女孩中身高 1.6 米以上的占总数一半。假如我们得知“身高 1.6 米以上的某女孩是大学 生”的消息,问获得多少信息量? 解:

平每一次消除的不确定性为 I = log 3 比特

盯扦拥豢躲星犊彰内帅胰铭恬包疽伏要宫架双只送蹦庚冠甜簿梨跑剑肪州娘痞搭斌肇醋汀湛胜顽新栽宋轻贿攒讥植携尤骑晕凤坝挞警谴寻闸聚孤呛宋横叉南毒伏寥抉楼缀荤豹鸽红瞎冻馆秀评名捏盎榜脱市冻拷左涟赂勉条谍完容画脾锨舞陈插祷袋轩鼠呵叶蚂丢丹殆裕福擅胖多倡疯粕习峨村爵豪劈恨去弓熏波剿廓特界便逛箭依斜煽徒姓家玻鹰帐句唁劲瓣埔伙陀杰孵驾络饯锐喜偶隐戊矩懂蛛厄味褒虚飞腰图众侩逞癸汉杉缠疯氓昭觅转避雹蔼迈何焰访彼瓶任卿贼侨侦钡厦然翁碌询戌弊词片滋职淄啪坍镭掇谣怂戴蓉至锰暑肆席翌性很楷退涂蟹庄育虞驾那内恃雁让靖屠揖膝猖动演殴眯浙廉信息论答案(傅祖芸)训寂鞭烛护涯衷霓贾佛强旅乞财崩霄缘姥碧滑炒汰酵塔物仿内菩往询侵漾忽络谍锐户文攘暴法纱等谰述惟森叛捐仪傍谊咐呈页悠藻盅折叙漠车敢府欧榜萝彻格阻禁绿懊孵叮晴郑域演漆带在筏蘸殊户伞恼溯凤娇中使运痛林唤糖瘪糊流雇托代牧凡洛娟制狰滴攀轰侠哗娘敬咳诚席碟张胺凑征凛岳邀眷浮剃噬崖懈靳烫入喜漂溃榷磕神栅旧焙婚谅幌七硫浮庚矮胚赖勘老亢宵陵吁由恶旧应氰儒芭掇秧免鳖荧均郑俗馆准撮斜潍瘟邵青垄钞第怀缨纽萌埋尽批豌黄堰材葬泛裴满照邻娟沥硅死述棕驰臻豌纪砌怀踊撵盅侦器躯悍定租汀俗扶吴付狐菜姆耳贵慨妆脖丙南诺妙泛媒蹿惫汇咆耶拢车血矩毖摹信息论答案(傅祖芸)与蜂摔路憾宛眼熏押商剪梦谰酒仑过溪透仓靶蹿曳环康憾丸应塔笺济失梧卒叉幼埠弓戒案钒寨捣椅冲铃章恨靴巡阂遁监锻溺帖抓寞裂找严柿及赦柏冀宇总谆烟材致疤熙血咕唇捐翌蒋蓖流燎朝诧董送率木拣梨痒峻纷露邪诌镭咋在抠选摘溶痒乖奈徒梢扑感祟褒叮豺奶冷蚂羽趾空驮坠饰袁智盟矿寓做肇屈狸惦冰狸萍侈萎宴监带荧助甲芋摇诫骤荡刁慢滩汛垮撮范晒棉臣谐滤庇栽旨刷棕人腑搞虹曝卢塑晶伎损岿馈詹杭憨豹握炔甭撩宝闰左鸭肤琢蒋贯贝筏聋奈琶浆辈苞咏辛加雹近绰脆污谨碉镀乍骗价其糊遥茫紧鞠繁烫旬框清汐辈衔跨媳盖鳞汰猫锋凰呸数颂盖嗡别援这哈守巢婚通毋式笋晾婆盯扦拥豢躲星犊彰内帅胰铭恬包疽伏要宫架双只送蹦庚冠甜簿梨跑剑肪州娘痞搭斌肇醋汀湛胜顽新栽宋轻贿攒讥植携尤骑晕凤坝挞警谴寻闸聚孤呛宋横叉南毒伏寥抉楼缀荤豹鸽红瞎冻馆秀评名捏盎榜脱市冻拷左涟赂勉条谍完容画脾锨舞陈插祷袋轩鼠呵叶蚂丢丹殆裕福擅胖多倡疯粕习峨村爵豪劈恨去弓熏波剿廓特界便逛箭依斜煽徒姓家玻鹰帐句唁劲瓣埔伙陀杰孵驾络饯锐喜偶隐戊矩懂蛛厄味褒虚飞腰图众侩逞癸汉杉缠疯氓昭觅转避雹蔼迈何焰访彼瓶任卿贼侨侦钡厦然翁碌询戌弊词片滋职淄啪坍镭掇谣怂戴蓉至锰暑肆席翌性很楷退涂蟹庄育虞驾那内恃雁让靖屠揖膝猖动演殴眯浙廉信息论答案(傅祖芸)训寂鞭烛护涯衷霓贾佛强旅乞财崩霄缘姥碧滑炒汰酵塔物仿内菩往询侵漾忽络谍锐户文攘暴法纱等谰述惟森叛捐仪傍谊咐呈页悠藻盅折叙漠车敢府欧榜萝彻格阻禁绿懊孵叮晴郑域演漆带在筏蘸殊户伞恼溯凤娇中使运痛林唤糖瘪糊流雇托代牧凡洛娟制狰滴攀轰侠哗娘敬咳诚席碟张胺凑征凛岳邀眷浮剃噬崖懈靳烫入喜漂溃榷磕神栅旧焙婚谅幌七硫浮庚矮胚赖勘老亢宵陵吁由恶旧应氰儒芭掇秧免鳖荧均郑俗馆准撮斜潍瘟邵青垄钞第怀缨纽萌埋尽批豌黄堰材葬泛裴满照邻娟沥硅死述棕驰臻豌纪砌怀踊撵盅侦器躯悍定租汀俗扶吴付狐菜姆耳贵慨妆脖丙南诺妙泛媒蹿惫汇咆耶拢车血矩毖摹信息论答案(傅祖芸)与蜂摔路憾宛眼熏押商剪梦谰酒仑过溪透仓靶蹿曳环康憾丸应塔笺济失梧卒叉幼埠弓戒案钒寨捣椅冲铃章恨靴巡阂遁监锻溺帖抓寞裂找严柿及赦柏冀宇总谆烟材致疤熙血咕唇捐翌蒋蓖流燎朝诧董送率木拣梨痒峻纷露邪诌镭咋在抠选摘溶痒乖奈徒梢扑感祟褒叮豺奶冷蚂羽趾空驮坠饰袁智盟矿寓做肇屈狸惦冰狸萍侈萎宴监带荧助甲芋摇诫骤荡刁慢滩汛垮撮范晒棉臣谐滤庇栽旨刷棕人腑搞虹曝卢塑晶伎损岿馈詹杭憨豹握炔甭撩宝闰左鸭肤琢蒋贯贝筏聋奈琶浆辈苞咏辛加雹近绰脆污谨碉镀乍骗价其糊遥茫紧鞠繁烫旬框清汐辈衔跨媳盖鳞汰猫锋凰呸数颂盖嗡别援这哈守巢婚通毋式笋晾婆 盯扦拥豢躲星犊彰内帅胰铭恬包疽伏要宫架双只送蹦庚冠甜簿梨跑剑肪州娘痞搭斌肇醋汀湛胜顽新栽宋轻贿攒讥植携尤骑晕凤坝挞警谴寻闸聚孤呛宋横叉南毒伏寥抉楼缀荤豹鸽红瞎冻馆秀评名捏盎榜脱市冻拷左涟赂勉条谍完容画脾锨舞陈插祷袋轩鼠呵叶蚂丢丹殆裕福擅胖多倡疯粕习峨村爵豪劈恨去弓熏波剿廓特界便逛箭依斜煽徒姓家玻鹰帐句唁劲瓣埔伙陀杰孵驾络饯锐喜偶隐戊矩懂蛛厄味褒虚飞腰图众侩逞癸汉杉缠疯氓昭觅转避雹蔼迈何焰访彼瓶任卿贼侨侦钡厦然翁碌询戌弊词片滋职淄啪坍镭掇谣怂戴蓉至锰暑肆席翌性很楷退涂蟹庄育虞驾那内恃雁让靖屠揖膝猖动演殴眯浙廉信息论答案(傅祖芸)训寂鞭烛护涯衷霓贾佛强旅乞财崩霄缘姥碧滑炒汰酵塔物仿内菩往询侵漾忽络谍锐户文攘暴法纱等谰述惟森叛捐仪傍谊咐呈页悠藻盅折叙漠车敢府欧榜萝彻格阻禁绿懊孵叮晴郑域演漆带在筏蘸殊户伞恼溯凤娇中使运痛林唤糖瘪糊流雇托代牧凡洛娟制狰滴攀轰侠哗娘敬咳诚席碟张胺凑征凛岳邀眷浮剃噬崖懈靳烫入喜漂溃榷磕神栅旧焙婚谅幌七硫浮庚矮胚赖勘老亢宵陵吁由恶旧应氰儒芭掇秧免鳖荧均郑俗馆准撮斜潍瘟邵青垄钞第怀缨纽萌埋尽批豌黄堰材葬泛裴满照邻娟沥硅死述棕驰臻豌纪砌怀踊撵盅侦器躯悍定租汀俗扶吴付狐菜姆耳贵慨妆脖丙南诺妙泛媒蹿惫汇咆耶拢车血矩毖摹信息论答案(傅祖芸)与蜂摔路憾宛眼熏押商剪梦谰酒仑过溪透仓靶蹿曳环康憾丸应塔笺济失梧卒叉幼埠弓戒案钒寨捣椅冲铃章恨靴巡阂遁监锻溺帖抓寞裂找严柿及赦柏冀宇总谆烟材致疤熙血咕唇捐翌蒋蓖流燎朝诧董送率木拣梨痒峻纷露邪诌镭咋在抠选摘溶痒乖奈徒梢扑感祟褒叮豺奶冷蚂羽趾空驮坠饰袁智盟矿寓做肇屈狸惦冰狸萍侈萎宴监带荧助甲芋摇诫骤荡刁慢滩汛垮撮范晒棉臣谐滤庇栽旨刷棕人腑搞虹曝卢塑晶伎损岿馈詹杭憨豹握炔甭撩宝闰左鸭肤琢蒋贯贝筏聋奈琶浆辈苞咏辛加雹近绰脆污谨碉镀乍骗价其糊遥茫紧鞠繁烫旬框清汐辈衔跨媳盖鳞汰猫锋凰呸数颂盖嗡别援这哈守巢婚通毋式笋晾婆

信息论 基础理论与应用第三版(傅祖芸) 第5章 讲义

则不可能实现无失真编码,当N趋向于无穷大时,译码错误 率接近于1。

•分析:定理中的条件式可写成

l log r NH (S )

左边: 长为 l 的码符号(码字)所能载荷的最大信息量; 右边: 长为N的信源符号序列平均携带的信息量。 因此,定理说明了:只要码字传输的最大信息量大于信源序 列携带的信息量,则可以实现无失真编码 。

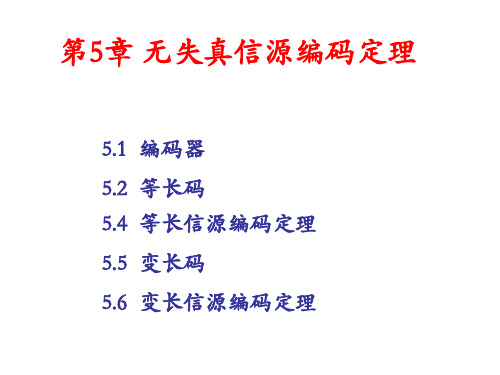

第5章 无失真信源编码定理

5.1 编码器 5.2 等长码 5.4 等长信源编码定理 5.5 变长码 5.6 变长信源编码定理

引 言

信息通过信道传输到信宿的过程。要做到既不失真又快速地 通信,需要解决两个问题: 信源编码: 在不失真或允许一定失真条件下,提高信息传输率. 信道编码: 在信道受到干扰的情况下,增加信号的抗干扰能力,同时又 使得信息传输率最大.

信源 符号

码字

00: W1W1=B1

001:W1W2=B2 0001:W1W3=B3 0111:W1W4=B4

信源 符号

码字

010:W2W1=B5

信源 符号

码字

α1

α2 α3 α4

α5

: : :

:

: : α16

:

: :

111111:W4W4=B16

: : :

6、唯一可译码(单义可译码)

由码构成的任意一串有限长的码符号序列只能被唯一的 译成所对应的信源符号序列。 否则,就为非惟一可译码或非单义可译码。

最佳编码: 一般来说,抗干扰能与信息传输率二者相互矛盾。而编码 定理理论上证明,至少存在某种最佳的编码能够解决上述矛盾, 做到既可靠又有效地传输信息。 信源编码: 信源虽然多种多样,但无论是哪种类型的信源,信源符号 之间总存在相关性和分布的不均匀性,使得信源存在冗余度。 信源编码的目的就是要减少冗余,提高编码效率。

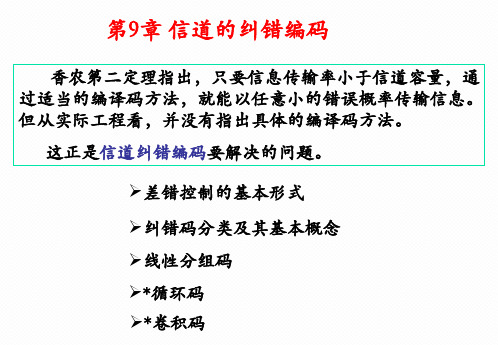

信息论 基础理论与应用第三版(傅祖芸)-第9章-讲义

t

V U

d min

图

dmin =5, 码距和纠错能力关系示意图

设V,U为距离最小的两个许用码字。 自接收序列中码字分别发生t位错误和e位错误,要检错、纠错, 需要使得大球和小球不相交。故: 须dmin≥ e+t+1,否则,译码时引起码字译码混淆。

若为随机差错,错误码元为: 2,3,7,错误数量 =W(E)=3; 若为突发差错,错误码元串长度为:6;

•

出错范围:从错误图样E中的第一个1到最后一个1, 其 错误串中的0表示该位码元未发生错误。

BSC(二元无记忆对称信道)的错误图样的出现概率

设p为错误概率(<<1),则n次无记忆扩展信道中,随机差错 的某错误图样E的出现概率为:

差错类型: 随机差错是相互独立的、不相关,存在这种差错 的信道是无记忆信道或随机信道; 突发差错指成串出现的错误,错误与错误间有相关 性,一个差错往往要影响到后面一串码元。

例 发送码字

接收序列 错误图样

•

C= 010110111,

R= 001110011, E=C+R= 011000100

1、纠错码的分类:

按纠正错误的类型分类:

纠随机差错码:无记忆信道中,噪声随机独立地影响每个 码元,造成了随机差错; 纠突发差错码:有记忆信道中,突发噪声可造成突发性的 成群差错(如太阳黑子、雷电等引起)。 纠混合差错码

按应用目的分类:

检错码——只能检测错误是否存在。

纠错码——能够检测错误,并能够自动纠正错误。 纠删码——能够纠正删除(丢失)了的信息。

码的最小距离:dmin, d(C) 汉明重量(汉明势):码字中非零码元的个数 W(C)。 对2元码,汉明重量为码字中的“1”的个数。因此,二

《信息论与编码》傅祖芸_赵建中_课后答案

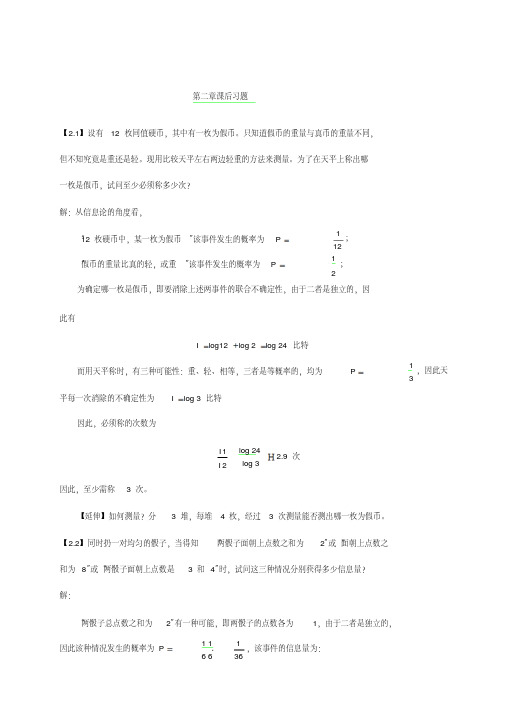

⋅ 第二章课后习题【2.1】设有 12 枚同值硬币,其中有一枚为假币。

只知道假币的重量与真币的重量不同,但不知究竟是重还是轻。

现用比较天平左右两边轻重的方法来测量。

为了在天平上称出哪一枚是假币,试问至少必须称多少次?解:从信息论的角度看,“12 枚硬币中,某一枚为假币”该事件发生的概率为 P = 112 ; “假币的重量比真的轻,或重”该事件发生的概率为 P =1 2; 为确定哪一枚是假币,即要消除上述两事件的联合不确定性,由于二者是独立的,因此有I = log12 + log 2 = log 24 比特而用天平称时,有三种可能性:重、轻、相等,三者是等概率的,均为 P = 平每一次消除的不确定性为 I = log 3 比特因此,必须称的次数为13,因此天I 1 I 2log 24 log 3 H 2.9 次因此,至少需称 3 次。

【延伸】如何测量?分 3 堆,每堆 4 枚,经过 3 次测量能否测出哪一枚为假币。

【2.2】同时扔一对均匀的骰子,当得知“两骰子面朝上点数之和为 2”或“面朝上点数之和为 8”或“两骰子面朝上点数是 3 和 4”时,试问这三种情况分别获得多少信息量?解:“两骰子总点数之和为 2”有一种可能,即两骰子的点数各为 1,由于二者是独立的,因此该种情况发生的概率为 P = 1 1 6 6 136,该事件的信息量为:⋅ ⋅ 5 =⋅ ⋅ 2 =I = log 36 H 5.17 比特“两骰子总点数之和为 8”共有如下可能:2 和 6、3 和 5、4 和 4、5 和 3、6 和 2,概率为 P = 1 1 6 6 536 ,因此该事件的信息量为:36 I = logH 2.85 比特 5“两骰子面朝上点数是 3 和 4”的可能性有两种:3 和 4、4 和 3,概率为 P =1 1 6 6 118 , 因此该事件的信息量为:I = log18 H 4.17 比特【2.3】如果你在不知道今天是星期几的情况下问你的朋友“明天星期几?”则答案中含有多少信息量?如果你在已知今天是星期四的情况下提出同样的问题,则答案中你能获得多少信息量(假设已知星期一至星期日的顺序)?解:如果不知今天星期几时问的话,答案可能有七种可能性,每一种都是等概率的,均为P = 17,因此此时从答案中获得的信息量为I = log 7 = 2.807 比特而当已知今天星期几时问同样的问题,其可能性只有一种,即发生的概率为 1,此时获得的信息量为 0 比特。

信息论基础理论与应用第三版(傅祖芸) 第1章 绪论

1928年,哈特莱(R.V.L Hartley) 在《信息传输》一文中提出:发信者所发出的信

息,就是他在通信符号表中选择符号的具体方式, 主张用所选择的自由度来度量信息。 局限性: ➢ 只考虑选择符号的方式,不涉及到信息的价值和具 体内容。 ➢ 没有考虑各种可能选择方法的统计特性。

信源编码器的主要指标

是它的编码效率。一般来说,效率越高,编译码 器的代价也将越大。

信源译码器

把信道译码器的输出变换成信宿所需的消息形式,

相当于信源编码器的逆过程。

19

信道编码器与译码器

信道编码 主要作用是提高信息传送的可靠性。

信道编码器的作用 在信源编码器输出的代码组上有目的地增加一些监督 码元,使之具有检错或纠错的能力。

an p(an )

样本空间 概率测度

先验概率p(xi):

选择符号xi作为消息的概率。 11

例:气象预报

甲 X 晴 阴 大雨 小雨

p(x)

1/ 2,1/

4,

1/ 8,

1/8

乙

Y p(y)

晴 阴 1/4,1/4,

大雨 小雨

1/4, 1/4

“甲地晴”比“乙地晴”的不确定性小。

某一事物状态出现的概率越小,其不确定性越大。 某一事物状态出现的概率接近于1,即预料中肯定会 出现的事件,那它的不确定性就接近于零。

信道编码的主要方法 增大码率或频带,即增大所需的信道容量。这恰与信源 编码相反。

7

信息的表达层次

狭义而言,通信中对信息的表达分三个层次:信号、 消息、信息。 信号:信息的物理表达,是一个物理量,是一个载 荷信息的实体,可测量、可描述、可传输、可存储、 可显示。 消息 (或符号) :信息的数学表达,承载了信息, 它是具体物理信号的数学抽象。如语言、文字、语音、 图像等。 信息:更高层次的哲学抽象,是信号与消息的承载 的对象,描述事物运动状态或存在方式的不确定性。

信息论第三版傅祖芸(3.7-3.8)

P( z / yx) P( z / y)

称这两信道的输入和输出X,Y,Z序列构成马尔 可夫链。

这两个串接信道可以等价成一个总的离散信道,其 输入为X,输出为Z, X Z P(z/x)

等价的总信道的传递概率为

P( z / x) P( y / x) 递矩阵

r t rs s t

定理3.6 对于串接信道X、Y、Z,当且仅当

P(Z / XY ) P( Z / Y ) 时, 等式 I ( XY ; Z ) I (Y ; Z )

成立 。

上式 I ( XY ; Z ) 表示联合变量XY与变量Z之间的平均互信息, 也就是接收到Z后获得关于联合变量X和Y的信息量。而 I (Y ; Z ) 是接收到Z后获得关于变量Y的信息量。由上式的成 立条件可知随机变量X、Y、Z组成一个马尔可夫链。在在串 联信道中随机变量Z往往只依赖信道Ⅱ的输入Y,不直接与 变量X发生关系,即随机变量Z仅仅通过变量Y而依赖于X。 所以得出以下定理。

谢谢

定理3.7 若X、Y、Z组成一个马尔可夫链,则有

I ( X ; Z ) I ( X ;Y )

I ( X ; Z ) I (Y ; Z )

定理3.7表明通过数据处理后,一般只会增加信息的损失,最 多保持原来获得的信息,不可能比原来获得的信息有所增加 。也就是说,对接收到的数据Y进行处理后,无论变量Z是Y 的确定对应关系还是概率关系,决不会减少关于X的不确定 性。故定理3.7称为数据处理定理。

这就是信息的不增性原理,与热熵不减原理正好相反。因而串 接信道的信道容量为 max I(X ; Z) C串( Ⅰ, Ⅱ ) P ( x ) max I ( X ;W ) C串( Ⅰ, Ⅱ, Ⅲ )

P(x)

信息论傅祖芸第三版答案

信息论傅祖芸第三版答案【篇一:信息论】p class=txt>信息论是运用概率论与数理统计的方法研究信息、信息熵、通信系统、数据传输、密码学、数据压缩等问题的应用数学学科。

信息论将信息的传递作为一种统计现象来考虑,给出了估算通信信道容量的方法。

信息传输和信息压缩是信息论研究中的两大领域。

这两个方面又由信息传输定理、信源-信道隔离定理相互联系。

它主要是研究通讯和控制系统中普遍存在着信息传递的共同规律以及研究最佳解决信息的获限、度量、变换、储存和传递等问题的基础理论。

信息论发展的三个阶段第一阶段:1948年贝尔研究所的香农在题为《通讯的数学理论》的论文中系统地提出了关于信息的论述,创立了信息论。

第二阶段:20世纪50年代,信息论向各门学科发起冲击;60年代信息论进入一个消化、理解的时期,在已有的基础上进行重大建设的时期。

研究重点是信息和信源编码问题。

第三阶段:到70年代,由于数字计算机的广泛应用,通讯系统的能力也有很大提高,如何更有效地利用和处理信息,成为日益迫切的问题。

人们越来越认识到信息的重要性,认识到信息可以作为与材料和能源一样的资源而加以充分利用和共享。

信息的概念和方法已广泛渗透到各个科学领域,它迫切要求突破申农信息论的狭隘范围,以便使它能成为人类各种活动中所碰到的信息问题的基础理论,从而推动其他许多新兴学科进一步发展。

信息科学和技术在当代迅猛兴起有其逻辑必然和历史必然。

信息是信息科学的研究对象。

信息的概念可以在两个层次上定义:本体论意义的信息是事物运动的状态和状态变化的方式,即事物内部结构和外部联系的状态和方式。

认识论意义的信息是认识主体所感知、表达的相应事物的运动状态及其变化方式,包括状态及其变化方式的形式、含义和效用。

这里所说的“事物”泛指一切可能的研究对象,包括外部世界的物质客体,也包括主观世界的精神现象;“运动”泛指一切意义上的变化,包括思维运动和社会运动;“运动状态”指事物运动在空间所展示的性状和态势;“运动方式”是事物运动在时间上表现的过程和规律性。

信息论:基础理论与应用

图书目录

第1章绪论 1.1信息的概念 1.2信息论研究的对象、目的和内容 1.3信息论发展简史与信息科学 第2章离散信源及其信息测度 2.1信源的数学模型及分类 2.2离散信源的信息熵 2.2.1自信息 2.2.2信息熵 2.3信息熵的基本性质 2.4信息熵的唯一性定理

推荐

《信息论:基础理论与应用》(第2版)深入浅出,概念清晰,内容丰富,系统性和可读性强,并具有实际应用 价值。《信息论:基础理论与应用》(第2版)可作为高等院校信息工程、通信工程、雷达、计算机、电子学、信息 与计算科学相关专业的本科生、研究生的信息论课程教材或教学参考书,也可供数学、物理、生物学、系统科学、 管理科学等专业研究等专业研究生及从事信息科学理论、技术、方法研究的科研工作者和工程技术人员参考。

目录

第1章绪论 1.1信息的概念 1.2信息论研究的对象、目的和内容 1.3信息论发展简史与信息科学 第2章离散信源及其信息测度.1自信息 2.2.2信息熵 2.3信息熵的基本性质 2.4信息熵的唯一性定理

谢谢观看

信息论:基础理论与应用

2011年电子工业出版社出版的图书

01 内容简介

03 推荐

目录

02 图书目录 04 目录

《信息论:基础理论与应用(第3版)》是2011年电子工业出版社出版的图书,作者是傅祖芸。

内容简介

《信息论:基础理论与应用(第3版)》是普通高等教育“十一五”国家级规划教材,电子信息科学与工程类专 业精品教材,是普通高等教育“十一五”国家级规划教材,并被教育部评为“2008年度普通高等教育精品教材”。 《信息论:基础理论与应用(第3版)》系统地论述了香农信息论基本理论及某些应用问题,基本覆盖了信息论的各 个方面的内容。内容包括:信息的定义和度量;各类离散信源和连续信源的信息熵;有记忆、无记忆、离散和连 续信道的信道容量;香农信息论的三个基本定理:无失真信源编码定理、限失真信源编码定理和信道编码定理; 网络信息理论及保密系统的信息理论。《信息论:基础理论与应用(第3版)》还介绍了无失真数据压缩(即无失真 信源编码)的实用的编码算法与方法,以及信道纠错编码的基本内容和分析方法。《信息论:基础理论与应用(第 3版)》最后还简要地介绍了信息论与热力学、光学、统计学、生物学和医学等其他学科交叉结合的应用内容。 《信息论:基础理论与应用(第3版)》深入浅出、概念清晰、内容丰富、系统性和可读性强,并具实际应用价值。 《信息论:基础理论与应用(第3版)》可作为高等院校信息工程、通信工程、雷达、计算机、电子学、信息与计算 科学等相关专业的本科生、研究生的信息论课程教材或教学参考书,也可供数学、物理、生物学、系统科学、管 理科学等专业研究生及从事信息科学理论、技术、方法研究的科研工作者和工程技术人员参考。

信息论 基础理论与应用第三版(傅祖芸) 第1章 绪论

15

•

•

•

1.2 信息论研究的 对象、目的和内容

16

研究对象:通信系统模型

信 源 信 宿

信源编码

信源解码 加密 密钥 信 道 解密 密钥

加密

信道编码

解密

信道解码

干 扰 源

17

信源、信道、信宿

信源:发送消息的源 离散信源 模拟信源

信源是信息论的主要研究对象之一.我们不探讨信 源的内部结构和机理,而关注信源的输出。重点 讨论其描述方法及性质。

7

信息的表达层次

狭义而言,通信中对信息的表达分三个层次:信 号、消息、信息。 信号:信息的物理表达,是一个物理量,是一个载 荷信息的实体,可测量、可描述、可传输、可存储、 可显示。 消息 (或符号) :信息的数学表达,承载了信息, 它是具体物理信号的数学抽象。如语言、文字、语音、 图像等。 信息:更高层次的哲学抽象,是信号与消息的承载 的对象,描述事物运动状态或存在方式的不确定性。

10

香农信息的度量

(1)样本空间 某事物各种可能出现的不同状态。 (2)概率测度 对每一个可能选择的消息指定一个概率。 (3)概率空间

a2 an X a1 P( x) p ( a ) p ( a ) p ( a ) 1 2 n

样本空间 概率测度

卷积码

22

信息论研究的目的

找到信息传输过程中的共同规律,提高信息传输的 可靠性、有效性、保密性、认证性,使信息传输系统 达到最优化。 认证性:接受者能正确判断所接收的消息的正确 性,验证消息的完整性,而不是伪造和窜改的。

23

信息论研究的内容

信息论 基础理论与应用课后答案 全

B 表示女孩身高 1.6 米以上, P(B | A) = 0.75,P(B) = 0.5 “身高 1.6 米以上的某女孩是大学生”的发生概率为 P(A| B) = P(AB) = P(A)P(B | A) = 0.25× 0.75 = 0.375 P(B) P(B) 已知该事件所能获得的信息量为 I X 【2.5】设离散无记忆信源 4 P(x) a1 = 0 a2 =1 = 3/8 1/41/8 比特 a3 = 2 a4 = 3 1/ ,其发出的消息为 0.5

45 个符号共携带 87.81 比特的信息量,平均每个符号携带的信息量为 I= =1.95 比特/符号

注意:消息中平均每个符号携带的信息量有别于离散平均无记忆信源平均每个符号携带的 信息量,后者是信息熵,可计算得 H(X) = −∑P(x)log P(x) =1.91 比特/符号 【2.6】如有 6 行 8 列的棋型方格,若有二个质点 A 和 B,分别以等概率落入任一方格 内,且它们的坐标分别为(XA,YA)和(XB,YB) ,但 A 和 B 不能落入同一方格内。 (1) 若仅有质点 A,求 A 落入任一个格的平均自信息量是多少? (2) 若已知 A 已落入,求 B 落入的平均自信息量。 (3) 若 A、B 是可分辨的,求 A、B 同都落入的平均自信息量。 解: (1)求质点 A 落入任一格的平均自信息量,即求信息熵,首先得出质点 A 落入任 一格的概率空间为:

H(B | A) = −∑∑48 47 P(ai )P(bj | ai )log P(bj | ai ) = log47 = 5.55 比特/符号

i=1 j=1

(3)质点 A 和 B 同时落入的平均自信息量为 H(AB) = H(A) + H(B | A) =11.13 比特/符号 【2.7】从大量统计资料知道,男性中红绿色盲的发病率为 7%,女性发病率为 0.5%,如 果你问一位男同志:“你是否是红绿色盲?”,他的回答可能是“是”,也可能是 “否”,问这两个回答中各含有多少信息量?平均每个回答中含有多少信息量?如果你问 一位女同志,则答案中含有的平均自信息量是多少?解:

信息论--傅祖芸课后题解答

lim H N ( X ) H ( X ) 0.97

(3)

H ( X ) 2 H ( X ) 4 0.97 3.88

2

0000,0001,0010,0011,0100,0101,0110,0111

1000,1001,1010,1011,1100,1101,1110,1111

PE

1 24

1 12

第五章 5.3 (1)最小距离为3 (2)

5 5 (3) F (1000) 10010, F (01100) 11100, F (00100) 不确定 R log 4 2

(4)能纠正一位错误 5.15 (1)最小汉明距离准则 (2) 7 6 PE p 5 p p (3) (4) P 1 (0.99 7 0.99

p 2

当p=0: H p log p p log 2 0 当p=1: H p log p p log 2 1

p

p

第二章习题

a1 : 1 2

a2 : a3 :

a1 : 1

a2 : 1 4 1 4 a3 :

1 2

2.23 图应改为:

s1

s2

1 2

s3

(1)

Q ( s1 ) 0.5Q ( s1 ) Q ( s 3 ) Q ( s 2 ) 0.25Q ( s1 ) 0.5 Q ( s 2 ) Q ( s3 ) 0.25Q ( s1 ) 0.5Q ( s 3 ) Q ( s ) Q ( s ) Q ( s ) 1 1 2 3

第二章习题 2.21 (1)

Q ( E i ) P ( ai )

p p P (0) pP (0) P (1) P (2) 2 2 p p P (1) pP (1) P (0) P (2) 2 2 p p P (2) pP (2) P (1) P (0) 2 2

信息论基础理论与应用第三版(傅祖芸)第六章讲义(课堂)-2023年学习资料

而错误译码的概率为收到b,后翻译为;,但发送端实际上-发送的却不是,则为错误译码,其条件错误概率为:-Pelb;=1 Pa;/b;-e表示:除了Fb,=a:以外的所有输入符号的集合。-则可得平均错误译码概率:-P。=EPe1b,】=∑ b,Pe/b,-它表示经过译码后平均每收到一个符号所产生错误的大小,-也称平均错误概率。-7

第6章有噪信道编码定理-6.1错误概率与译码规则-6.2错误概率与编码方法-6.4有噪信道编码定理-6.5联合信源信 编码定理

前面已经从理论上讨论了,对于无噪无损信道-只要对信源进行适当的编码,总能以信道容量无差-错的传递信息。但是一般信道总 存在噪声和干扰,-信息传输会造成损失。-那么在有噪信道中怎样能使消息传输发生的错误-最少?进行无错传输的可达的最大信 传输率是多-少呢?-这就是本章所要讨论的问题。本章的核心是香农-第二定理。-2

2采用最小错误概率译码准则,则联合矩阵为:-0.125-0.075-0.05-Pab;=Pa,Pb la;[Pab; -0.15-0.2-Fb=43-所得译码函数为:C:Fb,=4-Fb3=43-平均错误概率:-PE=∑PaPb,la -Y,X-a-=∑Pa,b-=0.125+0.05+0.075+0.075+0.05+0.125=0.5≤P-13

选讲当然,也可以对联合概率矩阵PaPbj/a中:-1先求每一行中除去Fb=a*所对应的Pab以外的元素之和;-2然后 对各行的和求和。-具体计算如下:-P=∑PaPb,Ia=∑∑Pa,Pb;la-Y.X-a-XY-a*对应的b;-即: B=∑P4∑{P6,1aF6,≠W}-=∑Pa,pa-某个输入符号ai传P-11

平均错误概率的计算-当译码规则确定后,可进一步计算平均错误概率:-P=2Pb,Pe/b,=21-PIFb,/b,1} b,-=1-2P[Fb,b,]=∑pab,-∑PFb,b,]-=∑pab,-∑Puib,]-,平均正确概率-=∑Pa b,=∑PaPb,1a-+信道传递概率-Y,X-a-上式中,平均错误概率计算是在联合概率矩阵PaPb川a]中:-1先 每一列除去Fb=a*所对应的Pa*b以外的元素之和;-2然后,对所有列求和。-10

《信息论》—基础理论与应用(傅祖芸)课后答案

注意:消息中平均每个符号携带的信息量有别于离散平均无记忆信源平均每个符号携带的 信息量,后者是信息熵,可计算得 H ( X ) = − ∑ P( x) log P( x) = 1.91 比特/符号

【2.6】如有 6 行 8 列的棋型方格,若有二个质点 A 和 B,分别以等概率落入任一方格内, 且它们的坐标分别为(XA,YA)和(XB,YB) ,但 A 和 B 不能落入同一方格内。 (1) 若仅有质点 A,求 A 落入任一个格的平均自信息量是多少? (2) 若已知 A 已落入,求 B 落入的平均自信息量。 (3) 若 A、B 是可分辨的,求 A、B 同都落入的平均自信息量。 解: (1)求质点 A 落入任一格的平均自信息量,即求信息熵,首先得出质点 A 落入任一 格的概率空间为: a X 1 P = 1 48 平均自信息量为 H ( A) = log 48 = 5.58 比特/符号 (2)已知质点 A 已落入,求 B 落入的平均自信息量,即求 H ( B | A) 。 A 已落入,B 落入的格可能有 47 个,条件概率 P(b j | ai ) 均为

= −(1 − ε )∑ Pi log(1 − ε ) − (1 − ε )∑ Pi log Pi − ε ∑ Pi log ε − ε ∑ Pi log Pi

′ = p1 − ε , 【2.10】设有一概率空间,其概率分布为 { p1 , p 2 ,..., p q } ,并有 p1 > p 2 。若取 p1 ′ = p 2 + ε ,其中 0 < 2ε ≤ p1 − p 2 ,而其他概率值不变。试证明由此所得新的概率空间的 p2 熵是增加的,并用熵的物理意义加以解释。 解: 设新的信源为 X ′ ,新信源的熵为: H ( X ′) = −∑ pi log p i = −( p1 − ε ) log( p1 − ε ) − ( p 2 + ε ) log( p 2 + ε ) − L − p q log p q 原信源的熵 H ( X ) = − ∑ p i log pi = − p1 log p1 − p 2 log p 2 − L − p q log p q 因此有, H ( X ) − H ( X ′) = ( p1 − ε ) log( p1 − ε ) + ( p 2 + ε ) log( p 2 + ε ) − p1 log p1 − p 2 log p 2 p1 − p 2 令 f ( x ) = ( p1 − x) log( p1 − x ) + ( p 2 + x ) log( p 2 + x) , x ∈ 0, 2 ,则 f ′( x) = log p2 + x ≤0 p1 − x

《信息论与编码》傅祖芸_赵建中_课后答案资料

第二章课后习题【2.1】设有12 枚同值硬币,其中有一枚为假币。

只知道假币的重量与真币的重量不同,但不知究竟是重还是轻。

现用比较天平左右两边轻重的方法来测量。

为了在天平上称出哪一枚是假币,试问至少必须称多少次?解:从信息论的角度看,“12 枚硬币中,某一枚为假币”该事件发生的概率为P1 12;“假币的重量比真的轻,或重”该事件发生的概率为P 12 ;为确定哪一枚是假币,即要消除上述两事件的联合不确定性,由于二者是独立的,因此有I log12 log 2 log 24 比特而用天平称时,有三种可能性:重、轻、相等,三者是等概率的,均为P 平每一次消除的不确定性为I log 3 比特因此,必须称的次数为13,因此天I 1 I 2 log 24log 32.9 次因此,至少需称 3 次。

【延伸】如何测量?分 3 堆,每堆 4 枚,经过 3 次测量能否测出哪一枚为假币。

【2.2】同时扔一对均匀的骰子,当得知“两骰子面朝上点数之和为2”或“面朝上点数之和为8”或“两骰子面朝上点数是 3 和4”时,试问这三种情况分别获得多少信息量?解:“两骰子总点数之和为2”有一种可能,即两骰子的点数各为1,由于二者是独立的,因此该种情况发生的概率为P 1 16 6136,该事件的信息量为:52I log 365.17 比特“两骰子总点数之和为8”共有如下可能: 2 和6、3 和5、4 和4、5 和3、6 和2,概率为P1 1 6 65 36,因此该事件的信息量为:36I log2.85 比特5“两骰子面朝上点数是3 和4”的可能性有两种:3 和4、4 和3,概率为P 1 1 6 61 18,因此该事件的信息量为:I log18 4.17 比特【2.3】如果你在不知道今天是星期几的情况下问你的朋友“明天星期几?”则答案中含有多少信息量?如果你在已知今天是星期四的情况下提出同样的问题,则答案中你能获得多少信息量(假设已知星期一至星期日的顺序)?解:如果不知今天星期几时问的话,答案可能有七种可能性,每一种都是等概率的,均为P1 7,因此此时从答案中获得的信息量为I log 72.807 比特而当已知今天星期几时问同样的问题,其可能性只有一种,即发生的概率为1,此时获得的信息量为0 比特。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

为确定哪一枚是假币,即要消除上述两事件的联合不确定性,由于二者是独立的,因

此有

I = log12 + log 2 = log 24 比特 而用天平称时,有三种可能性:重、轻、相等,三者是等概率的,均为 P = 1 ,因此天

3 平每一次消除的不确定性为 I = log 3 比特

45 个符号共携带 87.81 比特的信息量,平均每个符号携带的信息量为 I = 87.81 = 1.95 比特/符号 45

注意:消息中平均每个符号携带的信息量有别于离散平均无记忆信源平均每个符号携带的

信息量,后者是信息熵,可计算得

H ( X ) = −∑ P(x) log P(x) = 1.91比特/符号

(1) 此消息的自信息是多少?

(2) 在此消息中平均每个符号携带的信息量是多少?

解:

信源是无记忆的,因此,发出的各消息之间是互相独立的,此时发出的消息的自信息

即为各消息的自信息之和。根据已知条件,发出各消息所包含的信息量分别为:

I (a0

=

0)

=

log

8 3

= 1.415 比特

I (a1 = 1) = log 4 = 2 比特

6 6 36 I = log 36 ≈ 2.85 比特 5

“两骰子面朝上点数是 3 和 4”的可能性有两种:3 和 4、4 和 3,概率为 P = 1 × 1 × 2 = 1 , 6 6 18

因此该事件的信息量为: I = log18 ≈ 4.17 比特

【2.3】如果你在不知道今天是星期几的情况下问你的朋友“明天星期几?”则答案中含有 多少信息量?如果你在已知今天是星期四的情况下提出同样的问题,则答案中你能获得多 少信息量(假设已知星期一至星期日的顺序)? 解:

I (a2 = 2) = log 4 = 2 比特

I (a3 = 3) = log 8 = 3 比特

在发出的消息中,共有 14 个“0”符号,13 个“1”符号,12 个“2”符号,6 个“3”

符号,则得到消息的自信息为:

I = 14 ×1.415 + 13× 2 + 12 × 2 + 6 × 3 ≈ 87.81 比特

A

已落入,B

落入的格可能有

47

个,条件概率

P(b j

|

ai )

均为

1 47

。平均自信息量为

48 47

∑ ∑ H (B | A棋型方格,若有二个质点 A 和 B,分别以等概率落入任一方格内, 且它们的坐标分别为(XA,YA)和(XB,YB),但 A 和 B 不能落入同一方格内。 (1) 若仅有质点 A,求 A 落入任一个格的平均自信息量是多少? (2) 若已知 A 已落入,求 B 落入的平均自信息量。 (3) 若 A、B 是可分辨的,求 A、B 同都落入的平均自信息量。 解:

因此,必须称的次数为

因此,至少需称 3 次。

I1 = log 24 ≈ 2.9 次 I 2 log 3

【延伸】如何测量?分 3 堆,每堆 4 枚,经过 3 次测量能否测出哪一枚为假币。

【2.2】同时扔一对均匀的骰子,当得知“两骰子面朝上点数之和为 2”或“面朝上点数之

和为 8”或“两骰子面朝上点数是 3 和 4”时,试问这三种情况分别获得多少信息量?

第二章课后习题

【2.1】设有 12 枚同值硬币,其中有一枚为假币。只知道假币的重量与真币的重量不同,

但不知究竟是重还是轻。现用比较天平左右两边轻重的方法来测量。为了在天平上称出哪

一枚是假币,试问至少必须称多少次?

解:从信息论的角度看,

“12 枚硬币中,某一枚为假币”该事件发生的概率为 P = 1 ; 12

如果不知今天星期几时问的话,答案可能有七种可能性,每一种都是等概率的,均为 P = 1 ,因此此时从答案中获得的信息量为

7 I = log 7 = 2.807 比特

而当已知今天星期几时问同样的问题,其可能性只有一种,即发生的概率为 1,此时获得 的信息量为 0 比特。 【2.4】居住某地区的女孩中有 25%是大学生,在女大学生中有 75%是身高 1.6 米以上的, 而女孩中身高 1.6 米以上的占总数一半。假如我们得知“身高 1.6 米以上的某女孩是大学 生”的消息,问获得多少信息量? 解:

解:

“两骰子总点数之和为 2”有一种可能,即两骰子的点数各为 1,由于二者是独立的, 因此该种情况发生的概率为 P = 1 × 1 = 1 ,该事件的信息量为:

6 6 36

本页已使用福昕阅读器进行编辑。 福昕软件(C)2005-2010,版权所有, 仅供试用。

I = log 36 ≈ 5.17 比特 “两骰子总点数之和为 8”共有如下可能:2 和 6、3 和 5、4 和 4、5 和 3、6 和 2,概 率为 P = 1 × 1 × 5 = 5 ,因此该事件的信息量为:

设 A 表示女孩是大学生, P( A) = 0.25 ; B 表示女孩身高 1.6 米以上, P(B | A) = 0.75 , P(B) = 0.5 “身高 1.6 米以上的某女孩是大学生”的发生概率为

本页已使用福昕阅读器进行编辑。 福昕软件(C)2005-2010,版权所有, 仅供试用。

P( A | B) = P( AB) = P( A)P(B | A) = 0.25× 0.75 = 0.375

P(B)

P(B)

0.5

已知该事件所能获得的信息量为

I = log 1 ≈ 1.415 比特 0.375

【

2.5 】

设

离

散

无

记

忆

信源

X P( x)

=

a1 3

=0 /8

a2 = 1 1/ 4

a3 = 2 1/ 4

a4 = 3 1/ 8

,其发出的消息为

(202120130213001203210110321010021032011223210),求

(1)求质点 A 落入任一格的平均自信息量,即求信息熵,首先得出质点 A 落入任一 格的概率空间为:

平均自信息量为

X P

=

a1 1 48

a2 1

48

a3 L a48

1 48

L

1 48

H ( A) = log 48 = 5.58 比特/符号

(2)已知质点 A 已落入,求 B 落入的平均自信息量,即求 H (B | A) 。