中科大研究生高级数据库实验报告,用LRU算法实现buffermanager,模拟数据库对记录的处理过程

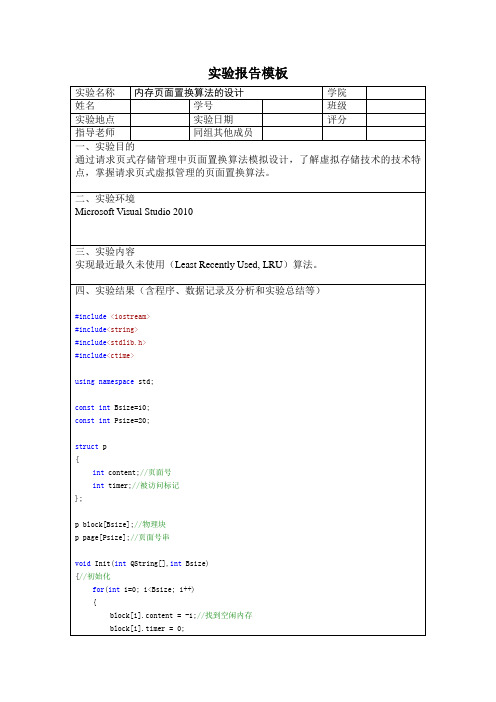

LRU页面置换算法的设计实验报告

return-1;

}

intfindReplace(intBsize)

{//查找应予置换的页面

intpos = 0;

for(inti=0; i<Bsize; i++)

if(block[i].timer >= block[pos].timer)

for(i=0;i<20;i++)

{

QString[i] = rand()%10 ;

}

cout<<"页面号引用串: ";

for(i=0;i<20;i++)

{

cout<<QString[i]<<" ";

}

cout<<endl<<"------------------------------------------------------"<<endl;

四、实验结果(含程序、数据记录及分析和实验总结等)

#include<iostream>

#include<string>

#include<stdlib.h>

#include<ctime>

usingnamespacestd;

constintBsize=10;

constintPsize=20;

structp

Bsize = 3;

Init(QString,Bsize);

cout<<"LRU算法结果如下:<<endl;

LRU缓存淘汰算法实现及应用场景解析

LRU缓存淘汰算法实现及应用场景解析LRU缓存淘汰算法是一种常见的缓存淘汰策略,LRU全称为Least Recently Used,即最近最少使用。

LRU算法的思想是根据数据项的访问时间进行淘汰,最近访问的数据项会被保留,而较少被访问的数据项会被淘汰。

实现LRU缓存淘汰算法有多种方式,下面介绍一种基于哈希表和双向链表的实现方法。

1.数据结构:2.缓存访问操作:当访问一个数据项时,首先在哈希表中查找该数据项是否已存在。

如果存在,将该数据项从双向链表中删除,并将其移动到链表头部。

如果不存在,根据缓存的容量判断是否需要淘汰数据项,如果容量已满,则淘汰链表尾部的数据项。

然后将新的数据项添加到双向链表的头部,并在哈希表中插入该数据项。

3.淘汰策略:当缓存容量已满时,需要选择一个数据项进行淘汰。

由于LRU算法要淘汰最近最少使用的数据项,所以选择双向链表的尾部节点作为被淘汰的节点。

1.数据库查询缓存:在数据库查询过程中,为了提高查询性能,常常使用缓存来缓存查询的结果。

LRU缓存淘汰算法可以用于在缓存容量达到上限时淘汰最近不常访问的查询结果。

2.网页缓存:在web服务器中,为了提高网页的访问速度,通常会使用缓存来缓存网页。

LRU缓存淘汰算法可以用于在缓存容量限制下淘汰最近不常被访问的网页。

3.图片缓存:在移动应用或网页中,图片是非常常见的资源。

为了减少网络请求,常常会使用缓存来缓存图片。

LRU缓存淘汰算法可以用于在缓存容量限制下淘汰最近不常被访问的图片。

4.CPU缓存淘汰:在计算机体系结构中,CPU缓存是提高计算机性能的关键因素之一、由于CPU缓存容量有限,LRU缓存淘汰算法可以用于在缓存容量限制下淘汰最近不常被访问的数据。

总之,LRU缓存淘汰算法是一种简单而高效的缓存淘汰策略。

它基于数据项的访问时间来进行淘汰,能够较好地保留最近常被访问的数据,适用于多种不同的应用场景。

在实际开发中,可以根据具体的需求和性能要求选择合适的缓存淘汰策略。

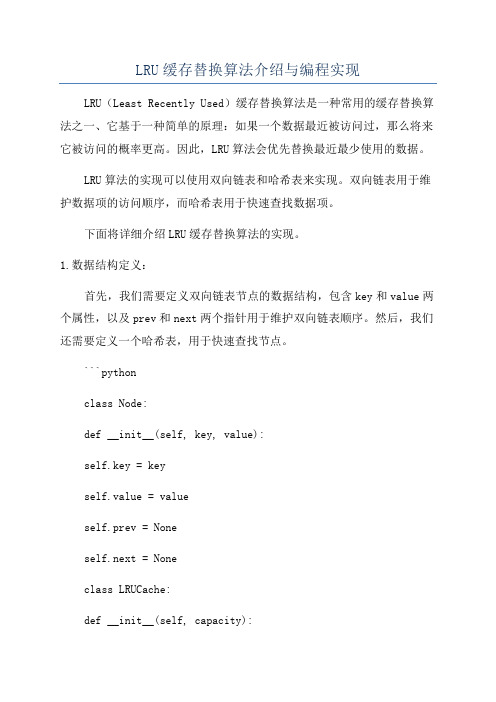

LRU缓存替换算法介绍与编程实现

LRU缓存替换算法介绍与编程实现LRU(Least Recently Used)缓存替换算法是一种常用的缓存替换算法之一、它基于一种简单的原理:如果一个数据最近被访问过,那么将来它被访问的概率更高。

因此,LRU算法会优先替换最近最少使用的数据。

LRU算法的实现可以使用双向链表和哈希表来实现。

双向链表用于维护数据项的访问顺序,而哈希表用于快速查找数据项。

下面将详细介绍LRU缓存替换算法的实现。

1.数据结构定义:首先,我们需要定义双向链表节点的数据结构,包含key和value两个属性,以及prev和next两个指针用于维护双向链表顺序。

然后,我们还需要定义一个哈希表,用于快速查找节点。

```pythonclass Node:def __init__(self, key, value):self.key = keyself.value = valueself.prev = Noneself.next = Noneclass LRUCache:def __init__(self, capacity):self.capacity = capacityself.hashmap = {}self.head = Node(0, 0) # 头节点self.tail = Node(0, 0) # 尾节点self.head.next = self.tail # 初始化双向链表self.tail.prev = self.head```2. get操作:当调用get(key)方法时,我们首先需要判断key是否存在于哈希表中。

如果存在,说明数据已经被访问过,我们需要将该节点移到链表头部,并返回对应的值。

如果不存在,说明数据不存在缓存中,我们直接返回-1 ```pythondef get(self, key):if key in self.hashmap:node = self.hashmap[key]self._remove(node)self._add(node)return node.valueelse:return -1def _remove(self, node):node.prev.next = node.nextnode.next.prev = node.prevdef _add(self, node):node.prev = self.headnode.next = self.head.nextself.head.next.prev = nodeself.head.next = node```3. put操作:当调用put(key, value)方法时,我们首先需要判断key是否存在于哈希表中。

lru算法实验报告

lru算法实验报告LRU算法实验报告摘要:本实验旨在通过实验和数据分析,验证LRU(Least Recently Used)算法在缓存替换策略中的有效性和性能表现。

通过模拟不同的缓存大小和访问模式,我们对LRU算法进行了测试,并分析了其命中率、缺失率以及性能表现。

1. 算法介绍LRU算法是一种常用的缓存替换策略,它根据数据的最近访问时间来进行替换决策。

当缓存空间不足时,LRU算法会淘汰最长时间未被访问的数据,以保证缓存中的数据是最近被使用的。

LRU算法的实现通常使用链表或者哈希表来记录数据的访问顺序,并且在每次访问数据时更新其在链表或哈希表中的位置。

2. 实验设计为了验证LRU算法的有效性和性能表现,我们设计了以下实验:- 实验一:不同缓存大小下的LRU算法性能对比- 实验二:不同访问模式下的LRU算法性能对比在实验一中,我们分别使用LRU算法对不同大小的缓存进行测试,并记录其命中率和缺失率。

在实验二中,我们模拟了随机访问、顺序访问和局部性访问等不同访问模式,并对比LRU算法的性能表现。

3. 实验结果实验结果显示,随着缓存大小的增加,LRU算法的命中率呈现出逐渐增加的趋势,而缺失率则相应减少。

在不同的访问模式下,LRU算法的性能表现也有所差异,其中局部性访问模式下LRU算法表现最佳,而随机访问模式下表现最差。

4. 结论与讨论通过实验结果的分析,我们得出结论:LRU算法在缓存替换策略中具有较好的性能表现,尤其适用于局部性访问模式。

然而,随着数据规模的增大和访问模式的复杂化,LRU算法的性能也会受到一定的影响。

因此,在实际应用中,我们需要根据具体情况选择合适的缓存替换策略,或者结合其他算法进行优化。

总之,本实验验证了LRU算法在缓存替换策略中的有效性和性能表现,为进一步研究和应用LRU算法提供了参考和借鉴。

同时,我们也意识到LRU算法在特定情况下可能存在一定的局限性,需要进一步优化和改进。

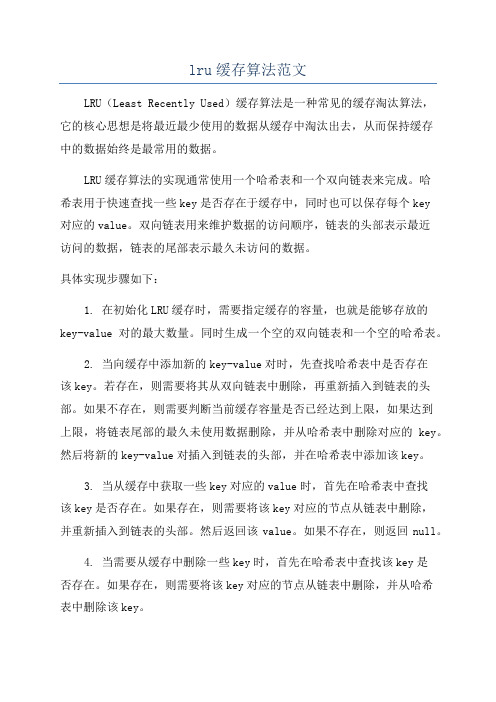

lru缓存算法范文

lru缓存算法范文LRU(Least Recently Used)缓存算法是一种常见的缓存淘汰算法,它的核心思想是将最近最少使用的数据从缓存中淘汰出去,从而保持缓存中的数据始终是最常用的数据。

LRU缓存算法的实现通常使用一个哈希表和一个双向链表来完成。

哈希表用于快速查找一些key是否存在于缓存中,同时也可以保存每个key对应的value。

双向链表用来维护数据的访问顺序,链表的头部表示最近访问的数据,链表的尾部表示最久未访问的数据。

具体实现步骤如下:1. 在初始化LRU缓存时,需要指定缓存的容量,也就是能够存放的key-value对的最大数量。

同时生成一个空的双向链表和一个空的哈希表。

2. 当向缓存中添加新的key-value对时,先查找哈希表中是否存在该key。

若存在,则需要将其从双向链表中删除,再重新插入到链表的头部。

如果不存在,则需要判断当前缓存容量是否已经达到上限,如果达到上限,将链表尾部的最久未使用数据删除,并从哈希表中删除对应的key。

然后将新的key-value对插入到链表的头部,并在哈希表中添加该key。

3. 当从缓存中获取一些key对应的value时,首先在哈希表中查找该key是否存在。

如果存在,则需要将该key对应的节点从链表中删除,并重新插入到链表的头部。

然后返回该value。

如果不存在,则返回null。

4. 当需要从缓存中删除一些key时,首先在哈希表中查找该key是否存在。

如果存在,则需要将该key对应的节点从链表中删除,并从哈希表中删除该key。

LRU缓存算法的时间复杂度为O(1),因为所有操作都可以在常数时间内完成。

同时,通过利用哈希表和双向链表,能够快速查找和插入数据,保证了LRU算法的高效性。

总结起来,LRU缓存算法通过维护一个访问顺序链表,将新访问的数据插入到链表的头部,同时将最久未访问的数据从链表尾部删除,从而保持链表的头部数据始终是最近访问的数据。

这样能够有效地提高缓存的命中率,减少缓存淘汰带来的性能损耗。

lru算法及例题讲解

lru算法及例题讲解

摘要:

1.LRU算法简介

2.LRU算法原理

3.LRU算法应用

4.例题讲解

5.总结与拓展

正文:

一、LRU算法简介

最近最少使用(Least Recently Used,简称LRU)算法是一种缓存置换策略,用于决定在内存有限的情况下,如何淘汰已失效的缓存数据。

LRU算法基于一个假设:最近访问过的数据很可能会在不久的将来再次被访问。

因此,当内存有限且需要腾出空间时,优先淘汰最近访问过的数据。

二、LRU算法原理

LRU算法通过维护一个访问顺序来实现。

当一个数据被访问时,将其放入一个队列(或栈)中,并按照访问顺序进行排序。

当需要淘汰缓存时,从队尾(或栈顶)移除最近访问过的数据。

三、LRU算法应用

LRU算法广泛应用于计算机科学领域,如操作系统、浏览器缓存、数据库等领域。

通过使用LRU算法,可以有效提高缓存利用率,提高系统性能。

四、例题讲解

题目:一个含有n个元素的缓存,采用LRU算法进行缓存置换,求第k个访问的元素在缓存中的位置。

解题思路:

1.初始化一个长度为n的数组,表示每个元素在缓存中的位置。

2.模拟访问过程,每次访问一个元素,按照LRU算法进行置换,并记录访问顺序。

3.当访问第k个元素时,找到其在访问顺序中的位置,即为在缓存中的位置。

五、总结与拓展

LRU算法作为一种高效的缓存置换策略,在实际应用中具有重要意义。

了解LRU算法的原理和应用,可以帮助我们更好地解决实际问题。

LRU算法实现策略概述

LRU算法实现策略概述LRU(Least Recently Used)算法是一种用于缓存替换的常见策略。

在计算机科学中,缓存是指将数据存储在更快的媒介中,以提高数据访问速度。

LRU算法通过淘汰最近最少使用的数据,以保持缓存的最新和最热数据。

实现LRU算法的关键在于如何判断数据是否被访问过以及如何确定最近最少使用的数据。

以下是一种常见的实现策略概述。

一、LRU缓存数据结构为了实现LRU算法,我们首先需要设计一个数据结构用于保存缓存数据。

一种常见的设计是使用双向链表和哈希表的结合。

双向链表用于按顺序保存数据的访问顺序,最近访问的数据在链表的头部,最久未访问的数据在链表的尾部。

哈希表用于快速查找数据在链表中的位置。

二、缓存数据访问操作1. 数据访问时的缓存命中:当访问一个数据时,首先在哈希表中查找数据是否存在。

- 若数据不存在,表示缓存未命中,需要将数据从磁盘或其他慢速存储中读取,并将数据添加到缓存中。

- 若数据存在,在双向链表中找到数据对应的节点,并将该节点移动到链表的头部,表示该数据最近被访问过。

2. 缓存数据淘汰:当缓存已满时,需要选择最近最少使用的数据进行替换。

- 直接选择链表尾部的数据淘汰是一种简单的策略,但在实际应用中可能不够高效。

因此,结合哈希表,可以快速查找链表尾部数据对应的节点,并将其淘汰。

三、LRU算法的优化LRU算法的实现可以进一步优化,以提高性能和效率。

以下是两种常见的优化策略:1. 使用伪最近使用算法:在实际应用中,我们可以通过记录数据的访问时间戳来近似判断数据的访问顺序。

当缓存满时,将最老的数据淘汰。

2. 使用多级缓存:为了提高访问速度,可以将缓存分为多级,每一级缓存的大小和替换策略可以不同。

常用的分级缓存包括L1缓存、L2缓存等。

四、LRU算法的应用LRU算法广泛应用于各种缓存系统中,如操作系统的页缓存、数据库的查询缓存、Web服务器的页面缓存等。

通过保持最热数据在缓存中,可以有效提高系统的访问速度和性能。

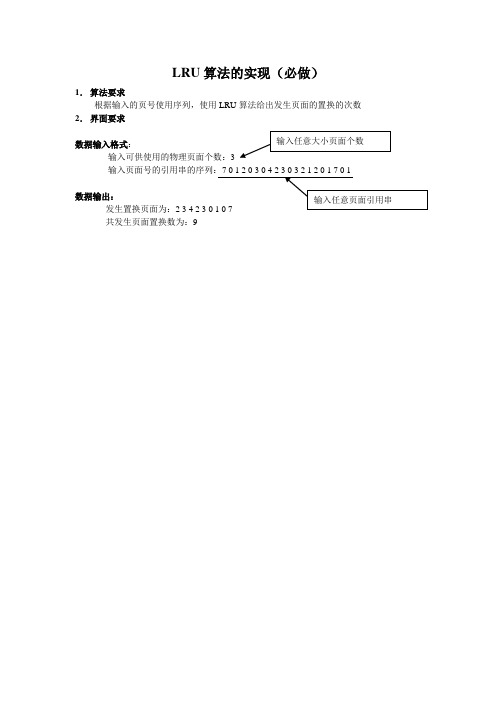

LRU算法实现

LRU算法的实现(必做)1.算法要求根据输入的页号使用序列,使用LRU算法给出发生页面的置换的次数2.界面要求输入可供使用的物理页面个数:3数据输出:发生置换页面为:共发生页面置换数为:9分页存储管理(选做)1. 作业描述对指定长度的内存区域使用分页进行存储管理,能够将用户进程中的内容使用分页机制进行存储,能够在内存区域不足时,使用LRU 算法,将制定的页面置换到外部存储空间中,如果访问的内容不在内存中,则要将外部存储空间中的相应内容调入到主存中。

2. 关键数据结构使用数组memory[…]来表示可用的物理内存页面,storage[…]来表示外存中存储的相应内容。

如memory[5]={1.1, 1.2, 2.2, 3.2, 1.4} 表示目前内存中存放着进程1中的第1、2和4部分的内容,进程2中的第2部分内容和进程3中第2部分的内容,同理storage[10]={1.3, 2.1, 2.3, 2.4, 2.5, 3.1 ,3.3, 3.4, 3.5, 4.1}在实现中要求数组storage 的长度为memory 长度的两倍.3. 界面要求数据输入:内存memory 中页面的个数:5内存中每个页面的大小:4操作(i 读入/o输入进程内容:2 184 13 15N //按‘N ’表示输入结束打印出memory 和storage 中相应的数据内容:memory[5]={1.1, 1.2, 2.2, 3.2, 1.4}storage[10]={1.3, 2.1, 2.3, 2.4, 2.5, 3.1 ,3.3, 3.4, 3.5, 4.1} i 读入/o 输出): o: 1 13 //表示1进程中的第13地址中的内容 输出这个地址所在页面信息: memory 5 //表示在memory 中的第5个页面中 操作(i 读入/o 输出): o//表示1进程中的第8地址中的内容//表示在storage 中的第1个页面中<-> memory 3 //storage 1和memory 3中的内容发生置换//表示要访问的内容在memory 3 中。

LRU缓存淘汰算法实现及应用场景解析

LRU缓存淘汰算法实现及应用场景解析LRU(Least Recently Used)缓存淘汰算法是一种常用的缓存管理策略,它的核心思想是根据数据的使用情况来决定缓存中的数据是否保留。

在LRU算法中,最近被访问的数据将被优先保留,而最近没有被使用到的数据则会被淘汰掉。

一、LRU缓存淘汰算法的实现实现LRU缓存淘汰算法有多种方式,常见的包括使用链表和哈希表的结合实现。

1. 链表实现首先,我们可以使用一个双向链表来存储缓存的数据。

链表的头部表示最近访问的数据,而链表的尾部则表示最久未访问的数据。

每当有新的数据被访问时,我们将其从链表中删除,并将其移动到链表头部。

当链表满了之后,我们就淘汰链表尾部的数据。

2. 哈希表实现为了快速判断某个数据是否在缓存中,我们可以使用一个哈希表来存储每个数据和对应的链表指针。

这样,当需要访问某个数据时,我们可以通过哈希表快速找到对应的链表节点,并将其移动到链表头部。

综合上述两种实现方式,我们可以得到一个高效的LRU缓存淘汰算法的实现。

二、LRU缓存淘汰算法的应用场景1. 网络请求缓存在网络请求中,有些请求的响应结果是可以被缓存的。

使用LRU缓存淘汰算法可以有效地管理这些缓存数据,使得热门的请求结果可以被快速访问到,从而提高系统的响应速度。

2. 数据库查询缓存在数据库查询中,有些查询结果是重复被使用的,这时候可以使用LRU缓存淘汰算法来缓存这些查询结果。

当下次有相同的查询请求时,可以直接从缓存中获取结果,避免了重复的数据库查询操作,提升了查询性能。

3. 操作系统页面置换在操作系统中,为了管理内存的使用,需要进行页面置换。

LRU缓存淘汰算法可以用来决定哪些页面需要被淘汰,从而更好地利用有限的内存资源。

4. 路由器缓存在路由器中,常常需要缓存一些常用的数据包,以减少网络流量的消耗。

使用LRU缓存淘汰算法可以保持最常用的数据包在缓存中,提高路由器的转发性能。

总结:LRU缓存淘汰算法是一种常用的缓存管理策略,通过根据数据的使用情况来决定数据是否保留,能够有效地提高缓存的命中率。

常用缓存淘汰算法(LFULRUARCFIFOMRU)介绍和实现

常用缓存淘汰算法(LFULRUARCFIFOMRU)介绍和实现缓存淘汰算法是指在缓存空间满时,选择哪些缓存数据应该被替换出去,以便为新的数据腾出空间。

常用的缓存淘汰算法包括LFU、LRU、ARC、FIFO和MRU。

下面将依次对这些算法进行介绍和实现。

1. LFU(Least Frequently Used,最近不经常使用):LFU算法是根据数据的历史访问频率进行淘汰的。

算法记录每个数据项被访问的次数,当缓存空间满时,选择访问次数最少的数据进行替换。

2. LRU(Least Recently Used,最近最少使用):LRU算法是根据数据的最近访问顺序进行淘汰的。

算法记录每个数据项被访问的时间戳,当缓存空间满时,选择最早被访问的数据进行替换。

3. ARC(Adaptive Replacement Cache,自适应替换缓存):ARC算法是结合了LFU和LRU的优点,根据最近访问的数据来进行替换。

算法维护两个LRU队列,一个用于访问频繁的数据,另一个用于访问冷门的数据。

当缓存空间满时,根据访问频率决定是替换访问频繁队列中的数据还是替换访问冷门队列中的数据。

4. FIFO(First In First Out,先进先出):FIFO算法是按照数据进入缓存的先后顺序进行淘汰的。

算法维护一个队列,存储数据进入缓存的顺序。

当缓存空间满时,选择最先进入缓存的数据进行替换。

5. MRU(Most Recently Used,最近被使用):MRU算法是根据数据的最近访问顺序进行淘汰的。

与LRU相反,MRU算法选择最近被访问的数据进行替换,即选择最近使用的数据。

以下是对每个算法的具体实现。

LFU算法实现:LFU算法需要维护一个数据项的访问次数统计表,并按照访问次数进行排序。

当缓存空间满时,替换访问次数最少的数据项。

LRU算法实现:LRU算法需要维护一个数据项的访问时间戳,并按照时间戳进行排序。

当缓存空间满时,替换最早被访问的数据项。

页面调度算法实验报告

页面调度算法实验报告引言页面调度算法是操作系统中的重要概念之一,主要用于管理操作系统中的虚拟内存。

虚拟内存是指通过硬盘空间来扩展系统的可用内存空间,将一部分数据放在内存中,将另一部分数据放在硬盘上。

为了高效地管理虚拟内存,需要使用合适的页面调度算法。

在本次实验中,我们将实现三种页面调度算法:先进先出(FIFO),最近最久未使用(LRU),和时钟(Clock)算法。

通过对这些算法的实现和比较,我们将能够更好地理解页面调度算法的原理和效果。

算法介绍1. 先进先出(FIFO)算法:该算法是最简单的页面调度算法之一。

它按照页面进入内存的先后顺序决定删除哪个页面,即最早进入内存的页面被删除。

该算法不考虑页面的使用频率和重要性。

2. 最近最久未使用(LRU)算法:该算法是一种根据页面的使用历史来进行页面调度的算法。

它假设最近一段时间内最久未使用的页面很可能在未来也不会被使用,因此将这些页面优先删除。

3. 时钟(Clock)算法:该算法是一种综合了FIFO算法和LRU算法的页面调度算法。

它使用一个环形链表来存储页面,并使用一个指针指向当前时钟。

当发生页面调度时,指针按照顺时针方向移动,并检查每个页面的访问位。

如果访问位为0,则说明该页面最近未被使用,可以删除;如果访问位为1,则将访问位置为0,表示该页面最近被使用。

实验设计本次实验中,我们将使用python语言实现上述三种页面调度算法,并通过相同的测试数据对它们进行性能比较。

环境配置在开始实验之前,需要安装Python 3.0及以上版本,并确保环境配置正确。

测试数据我们将使用一个虚拟内存大小为4个页面的系统来测试算法的性能。

假设系统会访问一个包含10个页面的访问序列。

访问序列:1, 2, 3, 4, 5, 1, 2, 6, 7, 8实验步骤1. 实现FIFO算法,并对测试数据进行页面调度。

2. 实现LRU算法,并对测试数据进行页面调度。

3. 实现时钟算法,并对测试数据进行页面调度。

LRU算法实现方法及参数调优策略

LRU算法实现方法及参数调优策略LRU (Least Recently Used)算法是一种常用的页面置换算法,被广泛应用于操作系统的内存管理中。

LRU算法根据页面的使用历史,将最久未被访问的页面替换出内存。

本文将介绍LRU算法的实现方法,并探讨如何通过参数调优来提升其性能。

一、LRU算法实现方法LRU算法的核心思想是根据页面的访问历史进行页面置换,具体的实现方法如下:1. 使用双向链表:建立一个带有头尾指针的双向链表,链表的节点表示页面。

最近访问的页面位于链表的头部,最久未被访问的页面位于链表的尾部。

2. 使用哈希表:对每个页面建立哈希表,以便快速查找页面在链表中的位置。

3. 页面访问时的操作:当一个页面被访问时,分为以下情况:- 若页面在链表中不存在,则将其插入链表头部。

- 若页面在链表中已存在,则将其从原位置删除,并插入到链表头部。

4. 替换页面:当内存已满,需要替换页面时,将链表尾部的页面删除即可。

二、参数调优策略为了进一步提升LRU算法的性能,我们可以通过调优一些参数来达到优化的目的。

下面是一些常用的参数调优策略:1. 缓存大小的设置:缓存大小是指可以存储在内存中的页面数量。

通常来说,缓存越大,缺页率越低,程序性能越好。

但是,过大的缓存大小也会占用更多的内存资源,需要权衡考虑。

2. 缓存淘汰策略:除了LRU算法,还有其他的缓存淘汰策略,如FIFO算法和LFU算法。

FIFO算法简单地按照页面到达的顺序进行页面替换,而LFU算法根据页面的使用频率进行页面替换。

根据不同的应用场景选择合适的缓存淘汰策略。

3. 硬件支持:在一些高性能系统中,可以使用硬件支持来加速LRU 算法的实现。

例如,在现代的处理器中,可以使用相关指令或硬件数据结构来提高对LRU链表的操作效率。

4. 缓存预加载:根据应用的特性,可以在系统启动或初始化阶段将一些常用的页面预先加载到缓存中,以减少缺页率和提高系统性能。

5. 自适应调整:根据实际应用的场景和需求,可以根据运行时的统计信息和监控数据进行动态调整,以适应不同的负载情况和访问模式。

lru页面置换算法实验c语言总结

LRU页面置换算法实验C语言总结1.引言在计算机科学中,页面置换算法是解决主存容量有限的情况下,如何有效地管理页面(或称为内存块)的一种重要方法。

L RU(L ea st Re ce nt ly Us e d)页面置换算法是其中一种经典的策略,通过淘汰最久未使用的页面来提高内存的利用率。

本文将总结使用C语言实现L RU页面置换算法的相关实验。

2.算法原理L R U页面置换算法的核心思想是:最近被访问的页面可能在未来继续被访问,而最久未被使用的页面可能在未来也不再被访问。

基于这一思想,L R U算法维护一个页面访问的时间顺序链表,每次发生页面置换时,选择链表头部(即最久未使用)的页面进行淘汰。

3.实验设计本次实验旨在使用C语言实现LR U页面置换算法,并通过模拟页面访问的过程来验证算法的正确性。

具体设计如下:3.1数据结构为了实现LR U算法,我们需要定义几个关键的数据结构:3.1.1页面节点结构t y pe de fs tr uc tP age{i n tp ag eI D;//页面I Ds t ru ct Pa ge*n ex t;//下一个节点指针s t ru ct Pa ge*p re v;//上一个节点指针}P ag e;3.1.2内存块结构t y pe de fs tr uc tM emo r y{i n tc ap ac it y;//内存块容量i n ts iz e;//当前存储的页面数量P a ge*h ea d;//内存块链表头指针P a ge*t ai l;//内存块链表尾指针}M em or y;3.2实验步骤本次实验主要包括以下几个步骤:3.2.1初始化内存块根据实际需求,设置内存块的容量,并初始化链表头指针和尾指针。

3.2.2页面置换每次发生页面访问时,检查访问的页面是否已经在内存块中。

如果在,将该页面移动到链表尾部;如果不在,执行页面置换。

3.2.3页面淘汰当内存块已满时,选择链表头部的页面进行淘汰,将新访问的页面加入链表尾部。

页面置换算法实验报告实验心得

页面置换算法实验报告实验心得

本次实验是关于页面置换算法的实验,页面置换算法是操作系统中一个非常重要的算法,用于管理内存中的页面。

在本次实验中,我们学习了三种页面置换算法:FIFO、LRU和OPT。

FIFO算法是最简单的页面置换算法,它按照页面进入内存的顺序来选择要被替换的页面。

但是FIFO算法存在一个问题,就是它无法考虑页面是否频繁使用,因此可能会大量使用不常用的页面,而且在内存不足时,会频繁地将常用的页面替换出去。

LRU算法是一种比较高效的页面置换算法,它按照页面最近的使用时间来选择要被替换的页面。

LRU算法考虑了页面的使用频率,能够保证常用的页面不会被替换出去,因此在内存不足时,LRU算法的性能比FIFO算法要好。

OPT算法是一种理论上最优的页面置换算法,它根据未来最长时间内不再使用的页面来选择要被替换的页面。

但是实际上,由于难以预测未来的页面使用情况,因此实际上很难实现OPT算法。

在实验中,我们使用了Python编程语言来模拟这三种页面置换算法,并对算法的性能进行了测试。

通过实验,我对页面置换算法有了更深入的了解,也提升了自己的编程能力。

lru算法实验报告

实验二模拟LRU页面置换算法一、实验目的1)用C或C++模拟LRU页面置换算法2)掌握LRU页面置换算法的调度过程二、实验内容设计一个虚拟存储系统,编写程序模拟LUR页面置换算法,通过程序输出淘汰的页面并计算出命中率:示列:随机输入页面访问串:7 0 1 2 0 3 0 4 2 3 0 3 2 1 2 0 1随机输入内存驻留集大小:3 (驻留集初始状态为空)三、实验要求要求访问页面号、驻留集都是随机输入,驻留集初始状态下为空。

实验代码:#include<iostream>using namespace std;int judge(int q[],int rear,int front,int num){for(int i = rear; i < front; i++){if(q[i] == num){return i;}}return -1;}void f(int q[],int rear,int t){for(int i = t; i > rear; i--){q[i] = q[i-1];}}void show(int q[],int rear,int front){for(int i = rear; i <= front; i++)cout << q[i] << " ";cout << endl;}void deal(int a[],int n,int m){int rear = 0;int front = -1;int q[m];int temp = 0;int count = 0;for(int i = 0; i < n; i++){int t = judge(q,rear,front,a[i]);q[++front]=a[i];if(temp < m){if(t != -1){f(q,rear,t);cout << a[i] << "命中" << endl; rear++;count++;}else{temp++;}}else{if(t != -1){f(q,rear,t);cout << a[i] << "命中" << endl; rear++;count++;}else{cout << q[rear] << "淘汰" << endl;rear++;}}}cout << "命中率为:" << count << "/" << n;}int main(){int n;int m;cout << "请输入要访问的页面序列个数:";cin >> n ;cout << "请输入驻留值的大小:";cin >> m;int a[n];cout << "请输入要访问的" << n << "个页面序列" << endl; for(int i = 0; i < n;i++){cin >> a[i];}deal(a,n,m);}运行结果:。

内存页面置换算法实验报告

竭诚为您提供优质文档/双击可除内存页面置换算法实验报告篇一:内存页面置换算法的设计实验报告内存页面置换算法的设计一、实验题目:实现最近最久未使用(LRu)置换算法二、实验目的:LInux中,为了提高内存利用率,提供了内外存进程对换机制,内存空间的分配和回收均以页为单位进行,一个进程只需将其一部分调入内存便可运行,还支持请求调页的存储管理方式。

本实习要求通过请求页式存储管理中页面置换算法模拟设计,了解虚拟存储技术的特点,掌握请求页式存储管理的页面置换算法。

三、实验原理:最近最久未使用(LRu)置换算法原理就是:当需要淘汰某页面时,选择当前一段时间内最久未使用过的页先淘汰,即淘汰距当前最远的上次使用的页。

例如:分配给该进程的页块数为3,一个20位长的页面访问序列为:12560,36536,56042,70435,则缺页次数和缺页率按下图给出:2.假定分配给该进程的页块数为3,页面访问序列长度为20。

本实验可以采用数组结构实现,首先随机产生页面序列,当发生请求调页时,若内存已满,则需要利用LRu算法,将当前一段时间内最久未使用过的页替换出去。

模拟程序的算法如下图:四、数据结构:数组五、程序代码:package页面置换;publicclassLRu{staticintblocknum=3;//页面数staticintlistnum=20;//序列页数staticintpageorder[]={7,0,1,2,0,3,0,4,2,3,0,3,2,1,2,0,1,7,0,1};的访问页面序列staticinttime[]=newint[blocknum];用的//随机生成//记录最近使staticintpageFrame[][]=newint[listnum][blocknum];//模拟页面置换staticintcount=0;//记录缺页数booleanfound;publicstaticvoidshow(){for(inti=0;isystem.out.print(pageorder[i]+"");system.out.println("");for(inti=0;i system.out.print("--");system.out.println("");for(intj=0;j for(inti=0;iif(pageFrame[i][j]==-1)system.out.print(+"");elsesystem.out.print(pageFrame[i][j]+"");}system.out.println("");}system.out.println("缺页数:"+count);}publicstaticvoidinit(){for(inti=0;i for(intj=0;jpageFrame[i][j]=-1;}}count=1;}publicstaticvoidLeastused(){init();pageFrame[0][0]=pageorder[0];inttemp,flag=0;time[0]=0;inti,j,k;for(i=1;i for(j=0;jif(pageorder[i]==pageFrame[flag][j]){//(与前一行的每一块比较)time[j]=i;break;}}if(j!=blocknum)//若该页面已经在内存中就跳出此次for循环进入下一个页面continue;for(k=0;k if(pageFrame[flag][k]==-1)break;elsepageFrame[i][k]=pageFrame[flag][k];}for(j=0;j if(pageFrame[i][j]==-1){//是否还有可用的块空间来分配给页面pageFrame[i][j]=pageorder[i];time[j]=i;count++;flag=i;break;}}if(j!=blocknum)//说明已经有空间放置该页面则已经分配好,跳出此次for循环continue;temp=0;for(j=0;j //很久不被访问的页面,即time值最小的那一个if(time[temp]>time[j])temp=j;}pageFrame[i][temp]=pageorder[i];time[temp]=i;count++;flag=i;}}}publicstaticvoidmain(string[]args){Leastused ();show();}六、运行结果:七、实验心得:这次的实验是内存页面的置换,相较上次的内存分配管理在算法实现上简单一些,但是代码不足在于使用到了较多的static全局变量使得整个代码质量不是很好,而且也只是简单的根据算法设计来模拟实现整个过程。

Python中的LRU缓存实现方法

Python中的LRU缓存实现方法缓存是计算机系统中重要的组成部分,特别是在Web应用中,缓存可以提高数据访问速度、降低系统负载和减少网络请求。

LRU (Least Recently Used)算法常用于解决缓存置换问题。

本文将从介绍LRU算法的实现方法和Python缓存模块的应用,探讨LRU缓存的原理、实现、性能优化和应用案例。

一、LRU缓存的原理LRU缓存置换算法是一种内存管理策略,适用于具有限定缓存容量的系统,例如Web浏览器。

LRU缓存的基本思想是:当缓存满时,将最近最少使用的条目置换出去。

LRU算法记录每个缓存条目最近一次被访问的时间,根据访问时间先后顺序进行置换。

在LRU缓存中,有两种数据结构需要实现:哈希表和双向链表。

哈希表用于查找缓存条目,双向链表用于维护最近访问顺序。

当一个缓存条目被维护到链表的头部时,表示最近访问过,而当一个缓存条目需要置换时,链表尾部的条目即为需要置换的条目。

二、LRU缓存的实现方法Python中有多种LRU缓存实现方法,例如自己实现、使用标准模块functools提供的lru_cache装饰器和导入第三方缓存模块如“cachetools”。

下面分别介绍这三种方法的实现流程。

1.自己实现LRU缓存自己实现LRU缓存需要了解LRU算法的原理,并熟悉Python的哈希表和双向链表的实现方法。

实现具体过程如下:(1)创建双向链表和哈希表。

使用Python的字典数据结构创建哈希表,使用类实现双向链表。

(2)每次缓存的读写操作都需要更新哈希表和双向链表。

若读取缓存值,则将对应的条目移动到链表头部;若写入新的缓存值,则插入新条目到链表头部,并检查容量是否超出限制,若超出则将链表尾的条目移出,并在哈希表中删除相应条目。

2.使用lru_cache装饰器Python标准模块functools提供了lru_cache装饰器,该方法可以实现简易的LRU缓存。

实现过程如下:(1)装饰想要缓存的函数,lru_cache接受一个maxsize参数,指定最大缓存数量。

LRU实验报告

实验报告学生姓名:学号:指导教师:一、实验室名称:二、实验项目名称:内存页面置换算法的设计改进三、实验原理:在内存运行过程中,若其所要访问的页面不在内存而需要把他们调入内存,但内存已经没有空闲空间时,为了保证该进程能正常运行,系统必须从内存中调出一页程序或数据送磁盘的对换区中。

但应将那个页面调出,需根据一定的算法来确定。

通常,把选择换出页面的算法成为页面置换算法。

置换算法的好坏,将直接影响到系统的性能。

一个好的页面置换算法,应具有较低的页面更换频率。

从理论上讲,应将那些以后不再会访问的页面置换出,或者把那些在较长时间内不会在访问的页面调出。

目前存在着许多种置换算法(如FIFO,OPT,LRU),他们都试图更接近理论上的目标。

四、实验目的:改进实现实验一中的LRU算法,要求页块数和输入序列由用户确定。

五、实验内容:内容:实现教材4.7节中所描述的最近最久未使用(LRU)置换算法要求:假设系统采用固定分配局部置换策略,某进程的总页面数为8(分别以数字0-7来代表);运行时,输入分配给该进程的页块数(如:3)和一个20位长的页面访问序列(如:12560,36536,56042,70435),输出缺页次数和缺页率。

六、实验器材(设备、元器件):1.基本环境要求①宽敞整洁专用实验室②必备的基本实验工具2.最低设备要求①计算机CPU不小于800MHZ;②计算机内存不小于128M;3.软硬件要求①实验平台Visual c++ 6.0七、实验步骤:代码如下:#include<stdio.h>#include<iostream>#define num 20#define max 65535typedef struct PB{int page;//当前页面号int seq_num;//对于页面最近一次被访问的序列号int fg;}Pb;int k;int seek(int seq[],int i,Pb a[],int k);int test1(int seq_i,int Pn,Pb a[]);int test2(Pb a[],int Pn);int LRU(int seq[],int i,int Pn,Pb pb[]);//页块中的页面的最近最久未使用位置int seek(int seq[],int i,Pb a[],int k){int flag=0;for(int j=i-1;j>=0;j--){if(a[k].page==seq[j]){flag=1;return j;break;}}if(flag==0)return -1;}//检测当前页面在不在内存中,如果在内存中,返回所在页块号;如果不在,返回-1int test1(int seq_i,int Pn,Pb a[]){int flag=0;for(int j=0;j<Pn;j++){if(a[j].page==seq_i){flag=1;return j;break;}}if(flag==0)return -1;}//检测有没有空页块,如果有空页块,返回页块号;如果没有,返回-1int test2(Pb a[],int Pn){int flag=0;for(int j=0;j<Pn;j++){if(a[j].page==-1){flag=1;return j;break;}}if(flag==0)return -1;}int LRU(int seq[],int i,int Pn,Pb pb[]) {int temp[20];int j;for(k=0;k<Pn;k++){temp[k]=seek(seq,i,pb,k);pb[k].fg=seek(seq,i,pb,k);}for(k=1;k<Pn;k++){int lastX=1;int tem;for(j=0;j<Pn-k;j++){if(temp[j]>temp[j+1]){tem=temp[j];temp[j]=temp[j+1];temp[j+1]=tem;lastX=0;}}if(lastX==1) break;}for(k=0;k<Pn;k++){if(pb[k].fg==temp[0]){printf("%d ",pb[k].page);return k;break;}}}void PCB(){Pb pb[10];//最多只允许0-9共10个页块号int Pn;int an=0;int seq[100];int i;float ar;printf("请输入页块数Pn:\n");scanf("%d",&Pn);printf("请输入%d位长的页面访问序列seq[%d]:\n",num,num);for(i=0;i<num;i++){scanf("%d",&seq[i]);}for(i=0;i<10;i++){pb[i].page=-1;pb[i].seq_num=-1;pb[i].fg=max;}printf("淘汰页面号依次为:\n");for(i=0;i<num;i++){//做20次int a,b;a=test1(seq[i],Pn,pb);b=test2(pb,Pn);if(a==-1){//不在内存中if(b!=-1){//没满pb[b].page=seq[i];pb[b].seq_num=i;an++;}else{//满了k=LRU(seq,i,Pn,pb);pb[k].page=seq[i];pb[k].seq_num=i;an++;}}}ar=(float)an/(float)num;printf("\n缺页次数为:%d\n缺页率为%f\n",an,ar); }void main(){PCB();}实例1实例2八、实验数据及结果分析:页块数可变,LRU算法结果正确。

lru算法

LRU算法1. 简介LRU(Least Recently Used,最近最少使用)算法是一种常用的缓存淘汰算法。

该算法根据数据的访问顺序来进行缓存淘汰,优先淘汰最近最少使用的数据,以保证缓存中始终保存着最常用的数据。

2. 算法原理LRU算法的原理很简单,在数据插入或访问时,首先查看缓存中是否存在该数据,如果存在,则将该数据移动到链表的头部;如果不存在,则将该数据插入到链表的头部。

当缓存达到容量上限时,需要淘汰最近最少使用的数据,即将链表尾部的数据删除。

基本的数据结构是双向链表,链表的头部存储的是最近访问的数据,链表的尾部存储的是最久未访问的数据。

3. 算法实现下面是一个简单的实现LRU算法的伪代码:class LRUCache:def__init__(self, capacity: int):self.capacity = capacityself.cache = {}self.count =0self.head = DoubleNode(0, 0)self.tail = DoubleNode(0, 0)self.head.next =self.tailself.tail.prev =self.headdef get(self, key: int) -> int:if key in self.cache:node =self.cache[key]self._remove(node)self._add(node)return node.valreturn-1def put(self, key: int, value: int) ->None: if key in self.cache:node =self.cache[key]self._remove(node)self.count -=1node = DoubleNode(key, value)self.cache[key] = nodeself._add(node)self.count +=1if self.count >self.capacity:node =self.tail.prevself._remove(node)self.count -=1def _add(self, node: DoubleNode) ->None:next_node =self.head.nextself.head.next = nodenode.prev =self.headnode.next = next_nodenext_node.prev = nodedef _remove(self, node: DoubleNode) ->None:prev_node = node.prevnext_node = node.nextprev_node.next = next_nodenext_node.prev = prev_nodeclass DoubleNode:def__init__(self, key: int, val: int):self.key = keyself.val = valself.prev =Noneself.next =None4. 使用示例cache = LRUCache(2) # 创建一个容量为2的缓存cache.put(1, 1) # 缓存中插入数据 (1,1)cache.put(2, 2) # 缓存中插入数据 (2,2)cache.get(1) # 返回 1cache.put(3, 3) # 缓存中插入数据 (3,3),因为缓存容量已满,所以需要淘汰 (2,2)cache.get(2) # 返回 -1,因为该数据已被淘汰cache.put(4, 4) # 缓存中插入数据 (4,4),因为缓存容量已满,所以需要淘汰 (1,1)cache.get(1) # 返回 -1,因为该数据已被淘汰cache.get(3) # 返回 3cache.get(4) # 返回 45. 算法分析•时间复杂度:LRU算法的时间复杂度是O(1),由于使用哈希表存储数据和双向链表维护数据顺序,所以对于插入、查找、删除等操作都是常数时间复杂度。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

数据库实现技术实验报告

SC11011042吴**源代码获取请联系:email:wude_yun@

wdyun@

一、实验目的

为了了解数据库buffer管理器的工作原理,对数据库底层结构有更进一步的了解,我们将实现一个简单的存储和缓冲管理器。

该实验涉及的存储和缓冲管理器,缓冲技术,散列技术,文件存储结构,磁盘空间和缓冲模块的接口功能。

二、实验环境

硬件平台:LENOVO ThinkPad E425

软件平台:开发系统:win7

开发工具:eclipse

开发语言:java

JDK版本jdk1.6

三、实验内容

1、相关数据结构描述

BCB类

1)1)BCB

BCB类的属性如下所示:

public class BCB{

private int page_id;//文件号

private int frame_id;//存放文件号的buffer地址的下标

private int latch;//锁

private int count;//计数器

private int dirty;//是否脏,修改过

private BCB next;//下一个bcb链

……

}

BCB类主要是实现快速的查找功能,既查找给定的文件号是否在缓存中。

查找给定的文件号是否在缓存中,一种比较简单的方法是遍历整个buffer,但是这样势必浪费时间。

因为整个记录的数目为50万条,buffer空间为1024。

那么对所有的记录查找是否在buffer中就需要50万×1024≈5亿次。

如果用BCB数组(类似一个十字链表的结构)Hash划分对每个文件号查找平均次数1(假设是平均划分,即使不是平均划分其平均查找次数远远小于1024

次),对所有的记录的查找只要5万次,明显要快。

BCB类具体包含的属性及方法的UML如图1所示。

图1BCB的UML结构

2)BufferManager与LRU类

BufferManager类的属性如下所示:

public class BufferManager{

public static final int DEFBUFSIZE=1024;

private int[]ftop;//对应buffer的号中存放frame_id

private BCB[]ptof;//Hash Table

private LRU lru;//lru类管理替换规则

private int freeBuffer;//用于表示空闲的buffer的下标

public BufferManager(){

super();

this.ftop=new int[this.DEFBUFSIZE];

this.ptof=new BCB[this.DEFBUFSIZE];

this.initialFtop();

this.intialPtof();

lru.intial();

}

……

}

其中LRU类为实现当buffer满了时,使用LRU算法替换buffer。

LRU类的属性如下所示:

public class LRU{

private Note head;

class Note{

private int bufNumber;//buffer的下标

private Note next;//后驱

private Note front;//前驱

}

public Note intial(){

//只申请1个空间

head=new Note();

head.front=head;

head.next=head;

return head;

}

……

}

LRU类包含一个head引用(类似c语言的指针)指示LRU链表的头,表示当前刚刚使用过的buffer地址。

Note类是LRU的内部类,其实就相当于实现c语言的结构体,用于表示LRU链表的内部节点,将链表表示成一个双向循环链表。

用双向循环链表实现LRU算法的好处是算法实现很简单。

head引用所指向的节点是当前刚刚使用的节点,head的next 指向的节点是将要替换的节点。

LRU类包含一个初始化函数intial()初始化LRU类,LRU类只有一个节点。

这里需要指出不一次性生成1024个节点(或者说是buffersize大小的节点数)好处在于当buffer 未满时,如果page_id在buffer中既已命中,这时需要调整更新LRU链表,将命中的存有page_id的buffer调到head指向的节点的前面,调换两个节点的次序即可;否则如果生成1024个节点,由于此时buffer未满,则肯定有空的LRU节点,因此将命中的存有page_id的buffer 调到head指向的节点的前面,势必要调整整个链表。

BufferManager与LRU类及其之间的关系的UML如图2所示。

图2BufferManager与LRU类及其之间的关系的UML

DataStorageManager类

3)3)DataStorageManager

DataStorageManager类的属性如下所示:

public class DataStorageManager{

private BufferManager buffer;

private int ioCount;//io次数

private int hitCount;//lru命中次数

……

}

DataStorageManager类主要要是实现读取文件记录实现整个buffer管理。

包含一个BufferManager类的成员变量buffer用于实现缓存的管理,ioCount表示整个I/O的次数,hitCount记录命中次数。

DataStorageManager类的UML与其他类之间的关系如图3所示。

图3DataStorageManager类的UML与其他类之间的关系

2、算法描述及流程图

先依次读入所给测试文档里面的数据,然后按行依次处理每个命令,循环执行如下:判断是文件号是否已存在于缓存中,是则在ptob数组中修改该页对应的BCB参数,并同时找出该页在双向链表head中的位置,插到首位。

读下一条记录。

若不存在I/O次数加1。

并判断buffer是否已满,如果未满,在双向链表head首部插入新节点,并同时在ftop数组添加该页映射;如果满用LRU算法选择一个替换的buffer地址(将head移到下一个节点),在ftop数组中找到替换的oldpage_id,删除ptob数组中旧的oldpage_id节点,在ftop数组添加该页映射。

最后将该页相关信息插入ptob数组中(不管是buffer否满)。

并读下一条记录。

算法流程图如图3所示。

四、实验结果

更改buffer的大小,观察结果

1)当buffersize=1024时的结果为,如图4所示:

共用时间:1.447秒,LRU命中次数:169565,总共I/O次数:575225,命中率:33.913%

图4buffersize=1024时的结果

2)当buffersize=2048时的结果为,如图5所示:

共用时间:1.638秒,LRU命中次数:209569,总共I/O次数:535221,命中率:41.9138%

图5buffersize=2048时的结果

3)当buffersize=10000时的结果为,如图6所示:

共用时间:7.114秒,LRU命中次数:325557,总共I/O次数:419233,命中率:65.1114%

图6buffersize=10000时的结果

结论:随着buffersize的增加命中次数不断增大,I/O次数不断减小,命中率也不断增大。

五、实验总结

本次实验最难的地方是对整个程序流程的把握,其次是各个数据结构(类)之间的关系如何组织。

LRU双向循环链表的使用大大简化了LRU替换算法的实现,Java语言没有指针使得编程变得相对简单。

通过本次实验,我对于数据库的buffer管理器的工作原理有了更进一步的了解,对于整个数据缓存技术也有了清晰的认识,收获颇多。