Google分布式数据库简介.

gfs名词解释

gfs名词解释

GFS指Google文件系统(Google File System),是由Google

开发的一个分布式文件系统,旨在为大规模数据密集型应用程序提供高性能、可扩展和可靠的存储解决方案。

以下是GFS的几个重要概念: 1. Master节点:GFS中的Master节点是整个系统的控制中心,负责对元数据进行管理和协调数据访问请求。

2. Chunk节点:GFS中的Chunk节点是存储实际数据的地方,它们保存多个数据块的备份副本。

3. Chunk大小:GFS将文件划分成固定大小的数据块(通常为64MB),以便更好地适应大型数据集和高并发访问需求。

4. 快照:GFS支持快照功能,可以以只读方式获取历史版本的文件或目录状态。

5. 冗余备份:GFS将每个数据块复制到多个Chunk节点上,以确保数据的可靠性和可用性。

6. 数据流传输:GFS采用数据流传输技术,通过优化数据传输来提高性能和效率。

总之,GFS是一种高性能、可扩展和可靠的分布式文件系统,具有很强的容错能力和快速访问数据的能力,广泛应用于云计算、科学研究和大规模数据处理等领域。

bigtable数据库简介

BigTable数据库概况摘要Bigtable是一个分布式的结构化数据存储系统,它被设计用来处理海量数据,通常是分布在数千台普通服务器上的PB级的数据。

Google的很多项目使用Bigt able存储数据,包括Web索引、Google Earth、GoogleFinance。

这些应用对Bigtable提出的要求差异非常大,无论是在数据量上(从URL 到网页到卫星图像)还是在响应速度上(从后端的批量处理到实时数据服务)。

尽管应用需求差异很大,但是,针对Google的这些产品,Bigtable还是成功的提供了一个灵活的、高性能的解决方案。

本论文描述了Bigtable的特点、发展史、目前应用现状、数据库存储技术、存储架构及查询、更新技术。

1 介绍BigTable是非关系的数据库,是一个稀疏的、分布式的、持久化存储的多维度排序Map。

Bigtable的设计目的是可靠的处理PB级别的数据,并且能够部署到上千台机器上。

Bigtable已经实现了下面的几个目标:适用性广泛、可扩展、高性能和高可用性,且已经在超过60个Google的产品和项目上得到了应用,包括Goog le Analytics、Google Finance、Orkut、Personalized Search、Writely和Google Earth。

这些产品对Bigtable提出了迥异的需求,有的需要高吞吐量的批处理,有的则需要及时响应,快速返回数据给最终用户。

它们使用的Bigtable集群的配置也有很大的差异,有的集群只有几台服务器,而有的则需要上千台服务器、存储几百TB的数据。

在很多方面,Bigtable和数据库很类似。

它使用了很多数据库的实现策略。

并行数据库和内存数据库已经具备可扩展性和高性能,但是Bigtable提供了一个和这些系统完全不同的接口。

Bigtable不支持完整的关系数据模型。

与之相反,Bigtable为客户提供了简单的数据模型,利用这个模型,客户可以动态控制数据的分布和格式,用户也可以自己推测底层存储数据的位置相关性。

分布式数据库简介

分布式数据库的目标:

4.逐步扩展处理能力和系统规模。当一个单位规

模扩大要增加新的部门(如银行系统增加新的分行,工厂 增加新的科室、车间)时,分布式数据库系统的结构为扩 展系统的处理能力提供了较好的途径:在分布式数据库 系统中增加一个新的结点.这样做比在集中式系统中扩 大系统规模要方便、灵活、经济得多.

分布式数据库的目标:

3.充分利用数据库资源,提高现有集中式数据库的 利用率。当在一个大企业或大部门中已建成了若干个数据

库之后,为了利用相互的资源,为了开发全局应用,就要研 制分布式数据库系统.这种情况可称为自底向上的建立分布 式系统.这种方法虽然也要对各现存的局部数据库系统做某 些改动、重构,但比起把这些数据库集中起来重建一个集中 式数据库,则无论从经济上还是从组织上考虑,分布式数据 库均是较好的选择.

到最大,这使得各处理机之间的相互干扰降到最低。负 载在各处理机之间分担,可以避免临界瓶颈。

4、方便进行全局应用。当现有机构中已存在几个数

据库系统,而且实现全局应用的必要性增加时,就可以 由这些数据库自下而上构成分布式数据库系统。

5、系统的可靠性高。相等规模的分布式数据库系统

在出现故障的几率上不会比集中式数据库系统低,但由 于其故障的影响仅限于局部数据应用,因此就整个系统 来讲它的可靠性是比较高的。

分布式数据库的特点:

四、全局的一致性、可串行性和可恢复性

分布式数据库中各局部数据库应满足集中式数据库 的一致性、可串行性和可恢复性.除此以外还应保 证数据库的全局一致性、并行操作的可串行性和系 统的全局可恢复性.这是因为全局应用要涉及两个 以上结点的数据.因此在分布式数据库系统中一个 业务可能由不同场地上的 多个操作组成.

分布式数据库的目标:

分布式数据库复习要点

分布式数据库复习要点第一章1、分布式数据库的定义(P4)物理上分散而逻辑上集中的系统,它使用计算机网络将地理位置分散而管理和控制又需要不同程度集中的多个逻辑单位(通常是集中式数据库系统)连接起来,共同组成一个统一的数据库系统。

分布式数据库系统可以看成是计算机网络和数据库系统的有机结合。

2、分布式数据库的两种分类方法(P7)●按局部DBMS的数据模型分同构型DDBS:各个站点上数据库使用同一数据模型同构同质型-数据模型相同,且是同一种DBMS(同一厂家)同构异质型-数据模型相同,不是同一种DBMS异构型DDBS :各站点上数据库的数据模型类型不同全局控制集中型DDBS:全局控制机制和全局数据词典位于中心站点全局控制分散型DDBS:全局控制机制和全局数据词典分散在网络的各个站点上。

全局控制可变型DDBS:也称主从型DDBS。

分成两组站点,一组包含全局控制机制和全局控制词典,另外一组不包含。

3、分布式数据库的组成成分(两部分)(P9)●数据:分布式数据库的主体,包括局部数据和全局数据。

●数据目录:数据结构的定义、全局数据的分片、分布、授权、事务恢复等描述,包括局部和全局数据目录。

4、分布式数据库的数据分片的定义和类型(3种)(P10)数据分片:又称数据分割、数据分段,局部数据库是由全局数据库分割而成。

三种类型:●水平分片:按特定条件把全局关系的所有元组划分成若干个互不相交的子集,对全局关系施加选择运算。

●垂直分片:把全局关系的属性集分成若干个子集,对全局关系施加投影运算。

●混合分片:以上两种方法的混合。

5、分布式数据库的分布策略(4条)(P11)数据分布:根据某种策略把数据分片所得的逻辑片断分散地存储在各个站点上.●集中式:所有数据都安排在同一站点上●分割式:所有数据只有一份,被分割成若干个逻辑片段,每个片段被放置在特定的站点●复制式:所有数据有多个副本,每个站点都有一个完整的数据副本●混合式:分割式和复制式的混合6、分布式数据库的模式结构(P13)分四层:●全局外层:全局外模式---全局应用的用户视图。

谷歌BigTable数据库

谷歌BigTable数据库Bigtable包括了三个主要的组件:链接到客户程序中的库、一个Master服务器和多个Tablet服务器。

针对系统工作负载的变化情况,BigTable可以动态的向集群中添加(或者删除)Tablet服务器。

Master服务器主要负责以下工作:为Tablet服务器分配Tablets、检测新加入的或者过期失效的Table服务器、对Tablet服务器进行负载均衡、以及对保存在GFS上的文件进行垃圾收集。

除此之外,它还处理对模式的相关修改操作,例如建立表和列族。

每个Tablet服务器都管理一个Tablet的集合(通常每个服务器有大约数十个至上千个Tablet)。

每个Tablet服务器负责处理它所加载的Tablet的读写操作,以及在Tablets过大时,对其进行分割。

和很多Single-Master类型的分布式存储系统【17.21】类似,客户端读取的数据都不经过Master服务器:客户程序直接和Tablet服务器通信进行读写操作。

由于BigTable的客户程序不必通过Master服务器来获取Tablet的位臵信息,因此,大多数客户程序甚至完全不需要和Master服务器通信。

在实际应用中,Master服务器的负载是很轻的。

一个BigTable集群存储了很多表,每个表包含了一个Tablet的集合,而每个Tablet包含了某个范围内的行的所有相关数据。

初始状态下,一个表只有一个Tablet。

随着表中数据的增长,它被自动分割成多个Tablet,缺省情况下,每个Tablet的尺寸大约是100MB到200MB。

我们使用一个三层的、类似B+树[10]的结构存储Tablet的位臵信息(如图4)。

第一层是一个存储在Chubby中的文件,它包含了Root Tablet的位臵信息。

Root Tablet包含了一个特殊的METADATA表里所有的Tablet 的位臵信息。

METADATA表的每个Tablet包含了一个用户Tablet的集合。

分布式数据库的概念

分布式数据库的概念

分布式数据库是指将数据存储在多个不同的地理位置上,并通过网络连接这些位置上的数据节点,以实现数据的分布式存储和处理。

在分布式数据库中,数据被分割成多个部分,并存储在不同的节点上。

这些节点可以分布在不同的服务器、数据中心或云平台上。

每个节点都具有自己的处理器、内存和存储设备,可以独立地执行数据操作和处理。

分布式数据库的主要优点包括:

1. 可伸缩性:分布式数据库可以通过增加节点数量来提高系统的存储和处理能力,从而满足不断增长的数据量和业务需求。

2. 高可用性:分布式数据库可以通过冗余存储和自动故障转移等技术来提高系统的可用性,减少单点故障对系统的影响。

3. 性能提升:分布式数据库可以通过将数据分布在多个节点上,提高数据的查询和处理速度,从而提高系统的性能。

4. 数据安全:分布式数据库可以通过数据加密、备份和恢复等技术来提高数据的安全性,保护数据免受攻击和丢失。

分布式数据库的实现需要考虑数据的分布、一致性、容错性、性能优化等多个方面。

同时,分布式数据库的管理和维护也需要专业的技术知识和经验。

总之,分布式数据库是一种高效、可靠、安全的数据库管理系统,适用于大规模数据存储和处理的应用场景。

大数据存储方式概述

大数据存储方式概述在当今信息时代,大数据已经成为各行各业的重要组成部分。

随着数据量的不断增长,如何高效地存储大数据成为了一个重要课题。

本文将从不同的角度对大数据存储方式进行概述,帮助读者更好地了解大数据存储的基本原理和方法。

一、分布式文件系统存储方式1.1 Hadoop分布式文件系统(HDFS)HDFS是Apache Hadoop项目的核心组件,采用分布式存储的方式,将大文件切分成多个块存储在不同的节点上,保证数据的可靠性和高可用性。

1.2 Google文件系统(GFS)GFS是Google开发的分布式文件系统,具有高容错性和高扩展性的特点,适用于大规模的数据存储和处理。

1.3 Amazon S3Amazon S3是亚马逊提供的对象存储服务,通过简单的API接口可以实现大规模数据的存储和访问,适用于云计算环境下的大数据存储。

二、分布式数据库存储方式2.1 HBaseHBase是基于Hadoop的分布式数据库,采用列式存储的方式,适用于实时读写大规模数据的场景,具有高性能和可伸缩性。

2.2 CassandraCassandra是一个高可用的分布式数据库系统,采用分区存储和副本复制的方式,适用于分布式数据存储和处理。

2.3 MongoDBMongoDB是一个NoSQL数据库,采用文档存储的方式,适用于存储半结构化和非结构化数据,具有灵活的数据模型和高性能的特点。

三、内存数据库存储方式3.1 RedisRedis是一个高性能的内存数据库,采用键值对存储的方式,适用于缓存和实时数据处理的场景,具有快速的读写速度和持久化功能。

3.2 MemcachedMemcached是一个分布式内存对象缓存系统,适用于存储热点数据和加速数据访问,具有简单的设计和高性能的特点。

3.3 AerospikeAerospike是一个高性能的NoSQL数据库,采用内存和闪存混合存储的方式,适用于实时数据处理和高并发访问的场景,具有可扩展性和可靠性。

Google全球级分布式数据库Spanner

Colossus系统架构

Colossus(GFS II)

GFS将整个系统的节点分为三种角色:GFS Master (总控服务器),GFS Chunkserver(数据块服务器, 简称CS)以及GFS Client(客户端)。 GFS文件被划分为固定大小的数据块(Chunk),由 Master在创建时分配一个64位全局唯一的Chunk句柄。 CS以普通的Linux文件的形式将Chunk存储在磁盘中。 为了保证可靠性,Chunk在不同的机器中复制多份,默 认为三份。 Master中维护了系统的元数据,包括文件及Chunk名字 空间,GFS文件到Chunk之间的映射,Chunk位置信息。 它也负责整个系统的全局控制,如Chunk租约管理,垃 圾回收无用Chunk,Chunk复制等等。Master会定期与 CS通过心跳的方式交换信息。

Colossus(GFS II) [kəˈl ɒsəs]

Colossus是第二代GFS,对应开源世界的新 HDFS。Google文件系统GFS是构建在廉价的 服务器之上的大型分布式系统。它将服务器故 障视为正常现象,通过软件的方式自动容错, 在保证系统可靠性和可用性的同时,大大减少 了系统的成本。 GFS是Google云存储的基石,其它存储系统, 如Google Bigtable,Google Megastore, Google Percolator [p:klet(r)]均直接或者间接 地构建在GFS之上。另外,Google大规模批处 理系统MapReduce也需要利用GFS作为海量数 据的输入输出。

Spanner背景

Spanner 是Google的全球级的分布式数 据库 (Globally-Distributed Database) 。 Spanner的扩展性达到了令人咋舌的全球 级,可以扩展到数百万的机器,数已百计 的数据中心,上万亿的行。更给力的是, 除了夸张的扩展性之外,它还能同时通过 同步复制和多版本来满足外部一致性,可 用性也是很好的。冲破CAP的枷锁,在三 者之间完美平衡。

Google的十个核心技术

Google的十个核心技术曾任职于IBM中国研究院,从事与云计算相关研究的CSDN博客专家吴朱华曾写过一篇文章《探索Google App Engine背后的奥秘(1)--Google的核心技术》,对Google的核心技术和其整体架构进行详细的分析,现转载于此,供大家学习。

本篇将主要介绍Google的十个核心技术,而且可以分为四大类:1.分布式基础设施:GFS,Chubby和Protocol Buffer。

2.分布式大规模数据处理:MapReduce和Sawzall。

3.分布式数据库技术:BigTable和数据库Sharding。

4.数据中心优化技术:数据中心高温化,12V电池和服务器整合。

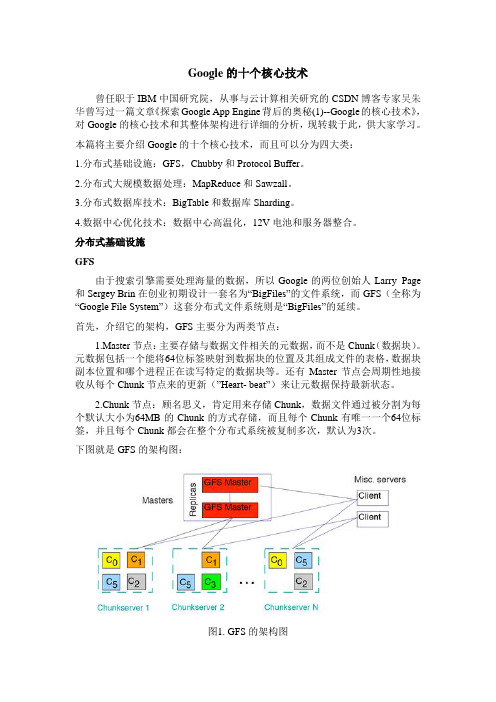

分布式基础设施GFS由于搜索引擎需要处理海量的数据,所以Google的两位创始人Larry Page 和Sergey Brin在创业初期设计一套名为“BigFiles”的文件系统,而GFS(全称为“Google File System”)这套分布式文件系统则是“BigFiles”的延续。

首先,介绍它的架构,GFS主要分为两类节点:1.Master节点:主要存储与数据文件相关的元数据,而不是Chunk(数据块)。

元数据包括一个能将64位标签映射到数据块的位置及其组成文件的表格,数据块副本位置和哪个进程正在读写特定的数据块等。

还有Master节点会周期性地接收从每个Chunk节点来的更新(”Heart- beat”)来让元数据保持最新状态。

2.Chunk节点:顾名思义,肯定用来存储Chunk,数据文件通过被分割为每个默认大小为64MB的Chunk的方式存储,而且每个Chunk有唯一一个64位标签,并且每个Chunk都会在整个分布式系统被复制多次,默认为3次。

下图就是GFS的架构图:图1. GFS的架构图接着,在设计上,GFS主要有八个特点:1.大文件和大数据块:数据文件的大小普遍在GB级别,而且其每个数据块默认大小为64MB,这样做的好处是减少了元数据的大小,能使Master节点能够非常方便地将元数据放置在内存中以提升访问效率。

分布式数据库原理、架构与实践 pdf

分布式数据库原理、架构与实践 pdf1 分布式数据库的定义和特点分布式数据库是指把数据分散存储于多个计算机节点上,数据节点之间可以互相通信和协作,以便快速响应用户请求并提高数据安全性和可用性。

分布式数据库有以下几个特点:- 可扩展性:可以添加或删除节点以应对数据量增大或缩小的需求;- 数据安全性:通过多副本存储和备份策略可以防止数据丢失或损坏;- 高可用性:节点之间互相备份和协作可以确保系统的高可用性;- 高并发处理能力:多个节点可以同时处理用户请求,提高系统的并发处理能力;- 易于维护:可以通过集中和分布式管理方法来优化系统的维护效率。

2 分布式数据库的架构和组成部分分布式数据库架构包括以下三个部分:- 分布式数据存储:将数据存储在多个节点上以提高数据安全性和可用性;- 分布式数据处理:将请求分配到多个节点以提高系统的并发处理能力;- 分布式数据管理:集中或分散管理节点,以提高系统维护效率。

分布式数据库的组成部分包括以下内容:- 数据节点:存储分布式数据库的数据,可以分为主节点和备份节点;- 数据存储引擎:管理数据存储和查询请求的软件;- 数据通信机制:节点之间通信的软件或协议,如TCP/IP协议;- 数据路由器:将请求路由到指定的数据节点;- 分布式锁管理器:管理分布式锁,防止同时修改或删除同一份数据;- 监控系统和日志:用于管理集中或分布式的数据库系统,并记录操作日志。

3 分布式数据库的实践应用分布式数据库已经成为大型互联网公司和金融行业等领域的重要技术,以下是几个分布式数据库的实践案例:- Google Spanner:是Google自主研发的分布式数据库,可以同时保证数据的强一致性和高可用性,被广泛用于Google的内部应用;- MyCat:是中国自主研发的开源分布式数据库中间件,可以提供MySQL、MariaDB等数据库的访问和高可用性等功能;- Hadoop Distributed File System(HDFS):是Apache Hadoop 生态系统的重要组成部分,是一个分布式文件系统,可以提高数据的可靠性和扩展性;- Amazon DynamoDB:是Amazon Web Services的一种NoSQL数据库,可以提供高可用性、强一致性和分布式数据存储和处理等功能。

leveldb 分布式

LevelDB 分布式LevelDB 是一款由 Google 开发的开源键值存储数据库,它以其高性能、可靠性和可扩展性而闻名。

LevelDB 采用 LSM 树(Log-Structured Merge Tree)作为其存储结构,这使得它能够在高负载下保持良好的性能。

此外,LevelDB 还支持分布式部署,这使得它能够扩展到更大的数据集和更高的吞吐量。

LevelDB 分布式架构LevelDB 分布式架构由多个节点组成,每个节点都维护一个独立的LevelDB 实例。

这些节点通过网络相互连接,并通过一致性协议来保证数据的一致性。

常用的分布式一致性协议包括 Paxos、Raft 和Zookeeper。

LevelDB 分布式部署LevelDB 分布式部署可以采用多种方式,常见的部署方式包括:主从复制:这种部署方式中,只有一个节点作为主节点,其他节点作为从节点。

主节点负责处理所有写请求,并将数据复制到从节点。

从节点负责处理所有读请求,并从主节点获取最新的数据。

多主复制:这种部署方式中,所有的节点都是主节点,每个节点都负责处理自己的写请求。

当某个节点收到写请求时,它会将数据复制到其他节点。

所有的节点都会维护一个最新的数据副本。

无主复制:这种部署方式中,没有主节点,所有的节点都是对等的。

每个节点都负责处理自己的写请求,并将数据复制到其他节点。

所有的节点都会维护一个最新的数据副本。

LevelDB 分布式特性LevelDB 分布式部署具有以下特性:高可用性:如果某个节点发生故障,其他节点仍然可以继续提供服务,不会影响数据的可用性。

可扩展性:LevelDB 分布式部署可以轻松地扩展到更大的数据集和更高的吞吐量。

一致性:LevelDB 分布式部署通过一致性协议来保证数据的一致性,即使在网络故障或节点故障的情况下,数据也不会丢失或损坏。

LevelDB 分布式应用场景LevelDB 分布式部署可以用于多种应用场景,常见的应用场景包括:Web 缓存:LevelDB 分布式部署可以作为 Web 缓存,用来缓存经常访问的数据,从而提高 Web 应用的性能。

分布式数据库发展综述

I G I T C W产业 观察Industry Observation172DIGITCW2023.101 分布式数据库概述分布式数据库的特点主要包括以下几点。

(1)透明性:分布式数据库的透明性包括分片透明、复制透明、位置透明和逻辑透明等,其中分片透明是透明性的最高层次,逻辑透明层次最低。

具体来说,透明性是指用户在使用过程中,不必关心数据在数据库管理系统内部是如何分片的,不必知道数据都分别存放在哪个节点以及各个网络节点是怎样完成数据复制的,用户只需在使用时完成自己的相关操作即可。

(2)高可靠性:分布式数据库会对数据采取多次备份存储形成多副本来提高数据的可靠性。

当某个节点出现故障时,其他节点可快速替代故障节点继续工作,避免出现数据丢失现象。

(3)易扩展性:当数据库现有容量和性能告急时,分布式数据库可采取添加新节点和服务器的方法来实现扩展,相比于集中式数据库的难扩展性可以更好地满足用户不断增长的需求。

如图1所示。

2 分布式数据库的发展历程21世纪以前,关系型商业数据库可以满足大部分用户应用场景,但随着互联网应用的到来,数据呈现大容量、多样性、流动性等特点,采取集中式架构的传分布式数据库发展综述苏彦志,陈 广,蒋越维(中国移动通信集团河北有限公司,河北 石家庄 050000)摘要:分布式数据库作为信息时代重要的数据管理工具,为处理分布式事务、海量数据存储、高并发任务发挥着重要的作用。

文章介绍了分布式数据库发展历程、国内外发展现状、发展面临的问题以及未来发展前景和展望。

关键词:分布式数据库;发展现状;发展前景doi:10.3969/J.ISSN.1672-7274.2023.10.056中图分类号:TP 311.13 文献标志码:A 文章编码:1672-7274(2023)10-0172-03Overview of the Development of Distributed DatabaseSU Yanzhi, CHEN Guang, JIANG Yuewei(China Mobile Group Hebei Co., Ltd., Shijiazhuang 050000, China)Abstract: As an important data management tool in the information age, distributed data plays an important role in processing Distributed transaction, massive data storage, and high concurrency tasks. This article introduces the development history of distributed databases, the current development status at home and abroad, the problems faced in development, and the future development prospects and prospects.Key words: distributed database; development status; development prospects作者简介:苏彦志(1982-),男,汉族,河北石家庄人,本科,研究方向为大型IT 基础设施发展与演进。

Google-Spanner中文版

Google Spanner (中文版)摘要:Spanner是谷歌公司研发的、可扩展的、多版本、全球分布式、同步复制数据库。

它是第一个把数据分布在全球范围内的系统,并且支持外部一致性的分布式事务。

本文描述了Spanner的架构、特性、不同设计决策的背后机理和一个新的时间API,这个API可以暴露时钟的不确定性。

这个API及其实现,对于支持外部一致性和许多强大特性而言,是非常重要的,这些强大特性包括:非阻塞的读、不采用锁机制的只读事务、原子模式变更。

中文关键词:谷歌,分布式数据库英文关键词: Google, Spanner, Bigtable, Distributed Database全文目录结构1. 介绍2. 实现2.1 Spanserver软件栈2.2 目录和放置2.3 数据模型3. TrueTime4. 并发控制4.1 时间戳管理4.2 细节5. 实验分析5.1 微测试基准5.2 可用性5.3 TrueTime5.4 F16. 相关工作7. 未来的工作8. 总结致谢参考文献1 介绍Spanner是一个可扩展的、全球分布式的数据库,是在谷歌公司设计、开发和部署的。

在最高抽象层面,Spanner就是一个数据库,把数据分片存储在许多Paxos[21]状态机上,这些机器位于遍布全球的数据中心内。

复制技术可以用来服务于全球可用性和地理局部性。

客户端会自动在副本之间进行失败恢复。

随着数据的变化和服务器的变化,Spanner会自动把数据进行重新分片,从而有效应对负载变化和处理失败。

Spanner被设计成可以扩展到几百万个机器节点,跨越成百上千个数据中心,具备几万亿数据库行的规模。

应用可以借助于Spanner来实现高可用性,通过在一个洲的内部和跨越不同的洲之间复制数据,保证即使面对大范围的自然灾害时数据依然可用。

我们最初的客户是F1[35],一个谷歌广告后台的重新编程实现。

F1使用了跨越美国的5个副本。

绝大多数其他应用很可能会在属于同一个地理范围内的3-5个数据中心内放置数据副本,采用相对独立的失败模式。

Google云计算

五、Google云计算服务

三者服务关系

三者服务之间没有必然的联系,只是三种不同的服务模式, 都是基于互联网,按需按时付费,就像水电、煤气一样,不能说 有什么联系,又不能说完全没有联系。 但是在实际的商业模式中,Paas的发展确实促进了SaaS的 发展,因为提供了开发平台后,SaaS的开发难度降低了。 从用户体验角度而言,他们之间的关系是独立的,因为他 们面对的是不同的用户。 从技术角度而言,他们并不是简单的继承关系,因为SaaS 可以是基于PaaS或者直接部署于IaaS之上,其次PaaS可以构建 与IaaS之上,也可以直接构建在物理资源之上。

五、Google云计算服务

一点点常识和一些简单的正确电脑操作练习可以将这类安 全性失误的影响降至最低,避免将你的机密资料放在云端上,如 果你真的放了,例如利用网上银行时,避免在网吧、学校或图书 馆内的公用电脑上进行,也别太随便给出自己真正的联络资料, 避免每个帐号都使用同一个密码,就算只更改一个字母也好。 就算一家公司运营正常,还是可能会选择关闭某项服务, 例如Google最近就宣布要关闭提供记事功能的Google Notebook 服务,不过网络的适应性是很强的,提供类似服务的Evernote马 上就接着发布一项可从Google将你的资料移植的工具。

五、Google云计算服务

SaaS全拼是Software-as-a-service ,国内通常叫做软件运 营服务模式,简称为软营模式,提供的是软件服务,例如 office365等,通过互联网就直接能使用这个软件应用,不需要本 地安装。 用户只需要接上网络,并通过浏览器,就能直接使用在云 端上运行应用,而不需要考虑类似安装等琐事,并且免去初期高 昂的软硬件投入。SaaS主要面对的是普通用户。 主要的产品: salesforce sales cloud,Google Apps,Zimbra,Zoho和IBM Lotus Live等,也包括像网页番茄类似的软件。

BigTable简介

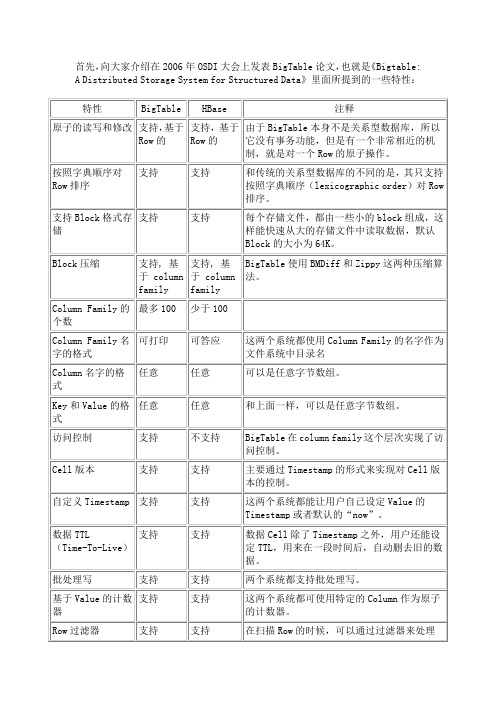

首先,向大家介绍在2006年OSDI大会上发表BigTable论文,也就是《Bigtable: A Distributed Storage System for Structured Data》里面所提到的一些特性:I.新特性在2009的LADIS大会上,Google院士jeff dean有一个非常精彩的Talk,称为“Design Lessons and Advice from Building Large Scale Distributed Systems”,在这次Talk中他提到了很多BigTable的新特性:表2. 在LADIS 2009大会上的Talk中提到的特性No CommentsPosted in PaaS相关技术, YunTable开发日记, 《云计算核心技术剖析》, 云计算II.Bigtable:一个分布式的结构化数据存储系统15 Jul为了方便部分博友和我自己,我特地将BigTable的中文版论文转载到人云亦云,原文地址在Google Labs,译者为alex。

III.摘要Bigtable是一个分布式的结构化数据存储系统,它被设计用来处理海量数据:通常是分布在数千台普通服务器上的PB级的数据。

Google 的很多项目使用Bigtable存储数据,包括Web索引、Google Earth、Google Finance。

这些应用对Bigtable提出的要求差异非常大,无论是在数据量上(从URL到网页到卫星图像)还是在响应速度上(从后端的批量处理到实时数据服务)。

尽管应用需求差异很大,但是,针对Google的这些产品,Bigtable还是成功的提供了一个灵活的、高性能的解决方案。

本论文描述了Bigtable提供的简单的数据模型,利用这个模型,用户可以动态的控制数据的分布和格式;我们还将描述Bigtable 的设计和实现。

IV. 1 介绍在过去两年半时间里,我们设计、实现并部署了一个分布式的结构化数据存储系统—在Google,我们称之为Bigtable。

解决海量数据的新思路——分布式数据库

解决海量数据的新思路——分布式数据库目前,分布式的概念越来越流行,但是在数据库领域里,分布式的应用相对较少。

在参阅了Google的Map/Reduce概念后,我构思了一种分布式数据库的架构,并实现了其雏形,现在将其基本思路写出来,希望能起到抛砖引玉的作用。

我工作时间不长,其中错误,不完善之处还请大家多多指出,谢谢。

设计这个分布式数据库的目的在于快速的处理海量数据。

基本思路其实很简单,将数据分布到多个数据节点中,在执行SQL语句时,分析SQL语句的语义,对一个或多个数据库进行操作。

这样就可以使查询的压力分散到每一个节点上面,面对海量数据时的处理时间大大缩短。

先拿几个简单的SQL语句做分析,看看在分布式的环境下和平常有何不同。

假设我们现在有两个数据节点A和B,表名为Table,其中ID为1~100的数据保存在节点A,ID为101~200的数据保存在节点B。

以下的SQL语句都是同时对2个数据库执行。

Select * from Table where ID=1这样A数据库将返回ID为1的数据,数据库B返回为空。

这时简单的合并A和B的数据,就可以得到正确的结果。

Select top 10 * from Table这时A数据库将返回10条数据,B数据库返回10条数据,这时如果合并A和B,将返回20条结果。

这时必须移除多余的10条数据才是正确的结果。

Select * from Table order by ID这时A,B数据库将返回所有的数据,但是要使得数据符合order by的条件,很显然应该进行一次排序操作。

Select top 10 * from Table order by ID这时A,B数据库都返回10条数据,经过合并后,还要经过排序,移除的操作,才能确保结果正确。

SQL语句中需要处理的关键字还有max,min,count,sum,avg等,这里就不写出来了。

经过这几个例子我们可以看到,其实只要经过一些处理,分别对不同数据节点上的查询,可以转化成对单一数据库查询等效的结果。

Big Table

Big Table 演讲概述一、简介2006年的OSDI有两篇google的论文,分别是BigTable和Chubby。

Chubby 是一个分布式锁服务,基于Paxos算法;BigTable是一个用于管理结构化数据的分布式存储系统,构建在GFS、Chubby、SSTable等google技术之上。

相当多的google应用使用了BigTable,比如Google Earth和Google Analytics,因此它和GFS、MapReduce并称为谷歌技术"三宝"。

Bigtable是一个为管理大规模结构化数据而设计的分布式存储系统,可以扩展到PB级数据和上千台服务器。

很多google的项目使用Bigtable存储数据,这些应用对Bigtable提出了不同的挑战,比如数据规模的要求、延迟的要求。

Bigtable 能满足这些多变的要求,为这些产品成功地提供了灵活、高性能的存储解决方案。

Bigtable看起来像一个数据库,采用了很多数据库的实现策略。

但是Bigtable 并不支持完整的关系型数据模型;而是为客户端提供了一种简单的数据模型,客户端可以动态地控制数据的布局和格式,并且利用底层数据存储的局部性特征。

Bigtable将数据统统看成无意义的字节串,客户端需要将结构化和非结构化数据串行化再存入Bigtable。

下文对BigTable的数据模型和基本工作原理进行介绍,而各种优化技术(如压缩、Bloom Filter等)不在讨论范围。

二、BigTable的数据模型Bigtable不是关系型数据库,但是却沿用了很多关系型数据库的术语,像table (表)、row(行)、column(列)等。

这容易让读者误入歧途,将其与关系型数据库的概念对应起来,从而难以理解论文。

Understanding HBase and BigTable 是篇很优秀的文章,可以帮助读者从关系型数据模型的思维定势中走出来。

分布式数据库HBase

(row:string, column:string, time:int64)→string

《大数据技术及应用》

信息科学与技术学院

16

数据模型

行

Bigtable的行关键字可以是任意的字符串,但是大小不能超过64KB。 Bigtable和传统的关系型数据库有很大不同,它不支持一般意义上的事务, 但能保证对于行的读写操作具有原子性(Atomic) 表中数据都是根据行关键字进行排序的,排序使用的是词典序。 一个典型实例,其中n.www就是一个行关键字。不直接存储网 页地址而将其倒排是Bigtable的一个巧妙设计。带来两个好处 :

“内容: ” “锚点:” “锚点:my..look.ca”

“n.www”

“<html>…” t3 “<html>…” t5 “<html>…” t6

“CNN”

t9

“”

t8

《大数据技术及应用》

信息科学与技术学院

19

数据模型

时间戳

为了简化不同版本的数据管理,Bigtable目前提供了两种设置:

• 通过单个master来协调数据访问、元数据存储

– 结构简单,容易保持元数据一致性

• 无缓存

《大数据技术及应用》

信息科学与技术学院

10

10

GFS将容错的任务交给文件系统完成,利用软件的方法解决系

GFS架构是怎样的? 统可靠性问题,使存储的成本成倍下降。

GFS将服务器故障视为正常现象,并采用多种方法,从多个角 度,使用不同的容错措施,确保数据存储的安全、保证提供不 间断的数据存储服务。

同一地址域的网页会被存储在表中的连续位置,有利于用户查找和分析 倒排便于数据压缩,可以大幅提高压缩率

freebase介绍

freebase介绍Freebase是一种基于知识图谱的开放式数据库,由Google于2007年推出。

它旨在整合世界各种不同的数据源,并将其组织成结构化的信息,以便人们可以更轻松地访问和使用这些数据。

Freebase的最大特点就是它的知识图谱结构。

知识图谱是一种将现实世界中的实体和概念之间的关系组织起来的方式,可以帮助人们更好地理解和利用这些关系。

在Freebase中,实体和概念以节点的形式存在,它们之间的关系以边的形式表示。

通过这种方式,Freebase可以将不同的实体和概念连接起来,形成一个巨大的知识网络。

Freebase的另一个重要特点是它的开放性和可扩展性。

任何人都可以向Freebase贡献数据,并且可以在数据库中创建新的实体和概念。

这使得Freebase成为一个非常丰富和多样化的数据库,其中包含了各种各样的知识,涵盖了从人物和地点到书籍和电影等各个领域。

使用Freebase可以带来许多好处。

首先,它可以帮助人们更快速地获取所需的信息。

通过Freebase,人们可以找到关于特定实体或概念的详细信息,包括其属性、关系和相关的其他实体。

这使得人们可以更好地了解和研究不同的领域。

Freebase还可以用于数据分析和挖掘。

由于Freebase中的数据都是以结构化的方式存储的,因此可以方便地进行各种分析和挖掘操作。

人们可以通过查询和分析Freebase中的数据,发现其中的模式和规律,从而帮助他们做出更明智的决策。

由于Freebase是一个开放的数据库,它还可以与其他系统和工具进行集成。

通过API接口,人们可以将Freebase中的数据与其他应用程序进行交互,从而实现更多的功能和应用。

然而,尽管Freebase的优点和潜力巨大,但它也存在一些挑战和限制。

首先,由于数据是由用户贡献的,因此可能存在一些不准确或不完整的信息。

其次,由于Freebase是一个开放的数据库,因此可能存在一些安全和隐私方面的问题。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Google Spanner简介Spanner 是Google的全球级的分布式数据库 (Globally-Distributed Database) 。

Spanner的扩展性达到了令人咋舌的全球级,可以扩展到数百万的机器,数已百计的数据中心,上万亿的行。

更给力的是,除了夸张的扩展性之外,他还能同时通过同步复制和多版本来满足外部一致性,可用性也是很好的。

冲破CAP的枷锁,在三者之间完美平衡。

Spanner是个可扩展,多版本,全球分布式还支持同步复制的数据库。

他是Google的第一个可以全球扩展并且支持外部一致的事务。

Spanner能做到这些,离不开一个用GPS和原子钟实现的时间API。

这个API能将数据中心之间的时间同步精确到10ms以内。

因此有几个给力的功能:无锁读事务,原子schema修改,读历史数据无block。

EMC中国研究院实时紧盯业界动态,Google最近发布的一篇论文《Spanner: Google’s Globally-Distributed Database》, 笔者非常感兴趣,对Spanner进行了一些调研,并在这里分享。

由于Spanner 并不是开源产品,笔者的知识主要来源于Google的公开资料,通过现有公开资料仅仅只能窥得Spanner 的沧海一粟,Spanner背后还依赖有大量Google的专有技术。

下文主要是Spanner的背景,设计和并发控制。

Spanner背景要搞清楚Spanner原理,先得了解Spanner在Google的定位。

从上图可以看到。

Spanner位于F1和GFS之间,承上启下。

所以先提一提F1和GFS。

F1和众多互联网公司一样,在早期Google大量使用了Mysql。

Mysql是单机的,可以用Master-Slave来容错,分区来扩展。

但是需要大量的手工运维工作,有很多的限制。

因此Google开发了一个可容错可扩展的RDBMS——F1。

和一般的分布式数据库不同,F1对应RDMS应有的功能,毫不妥协。

起初F1是基于Mysql的,不过会逐渐迁移到Spanner。

F1有如下特点:· 7×24高可用。

哪怕某一个数据中心停止运转,仍然可用。

·可以同时提供强一致性和弱一致。

·可扩展·支持SQL·事务提交延迟50-100ms,读延迟5-10ms,高吞吐众所周知Google BigTable是重要的NoSql产品,提供很好的扩展性,开源世界有HBase与之对应。

为什么Google还需要F1,而不是都使用 BigTable呢?因为BigTable提供的最终一致性,一些需要事务级别的应用无法使用。

同时BigTable还是NoSql,而大量的应用场景需要有关系模型。

就像现在大量的互联网企业都使用Mysql而不愿意使用HBase,因此Google才有这个可扩展数据库的F1。

而Spanner就是 F1的至关重要的底层存储技术。

Colossus(GFS II)Colossus也是一个不得不提起的技术。

他是第二代GFS,对应开源世界的新HDFS。

GFS是著名的分布式文件系统。

初代GFS是为批处理设计的。

对于大文件很友好,吞吐量很大,但是延迟较高。

所以使用他的系统不得不对GFS做各种优化,才能获得良好的性能。

那为什么 Google没有考虑到这些问题,设计出更完美的GFS ?因为那个时候是2001年,Hadoop出生是在2007年。

如果Hadoop是世界领先水平的话,GFS比世界领先水平还领先了6年。

同样的 Spanner出生大概是2009年,现在我们看到了论文,估计Spanner在Google已经很完善,同时Google内部已经有更先进的替代技术在酝酿了。

笔者预测,最早在2015年才会出现Spanner和F1的山寨开源产品。

Colossus是第二代GFS。

Colossus是Google重要的基础设施,因为他可以满足主流应用对FS的要求。

Colossus的重要改进有:·优雅Master容错处理 (不再有2s的停止服务时间)· Chunk大小只有1MB (对小文件很友好)· Master可以存储更多的Metadata(当Chunk从64MB变为1MB后,Metadata会扩大64倍,但是Google也解决了)Colossus可以自动分区Metadata。

使用Reed-Solomon算法来复制,可以将原先的3份减小到1.5份,提高写的性能,降低延迟。

客户端来复制数据。

具体细节笔者也猜不出。

与BigTable, Megastore对比Spanner主要致力于跨数据中心的数据复制上,同时也能提供数据库功能。

在Google类似的系统有BigTable和Megastore。

和这两者相比,Spanner又有什么优势呢。

BigTable在Google得到了广泛的使用,但是他不能提供较为复杂的Schema,还有在跨数据中心环境下的强一致性。

Megastore 有类RDBMS的数据模型,同时也支持同步复制,但是他的吞吐量太差,不能适应应用要求。

Spanner不再是类似BigTable的版本化 key-value存储,而是一个“临时多版本”的数据库。

何为“临时多版本”,数据是存储在一个版本化的关系表里面,存储的时间数据会根据其提交的时间打上时间戳,应用可以访问到较老的版本,另外老的版本也会被垃圾回收掉。

Google官方认为 Spanner是下一代BigTable,也是Megastore的继任者。

Google Spanner设计功能从高层看Spanner是通过Paxos状态机将分区好的数据分布在全球的。

数据复制全球化的,用户可以指定数据复制的份数和存储的地点。

Spanner可以在集群或者数据发生变化的时候将数据迁移到合适的地点,做负载均衡。

用户可以指定将数据分布在多个数据中心,不过更多的数据中心将造成更多的延迟。

用户需要在可靠性和延迟之间做权衡,一般来说复制1,2个数据中心足以保证可靠性。

作为一个全球化分布式系统,Spanner提供一些有趣的特性。

·应用可以细粒度的指定数据分布的位置。

精确的指定数据离用户有多远,可以有效的控制读延迟(读延迟取决于最近的拷贝)。

指定数据拷贝之间有多远,可以控制写的延迟(写延迟取决于最远的拷贝)。

还要数据的复制份数,可以控制数据的可靠性和读性能。

(多写几份,可以抵御更大的事故)· Spanner还有两个一般分布式数据库不具备的特性:读写的外部一致性,基于时间戳的全局的读一致。

这两个特性可以让Spanner支持一致的备份,一致的MapReduce,还有原子的Schema修改。

这写特性都得益有Spanner有一个全球时间同步机制,可以在数据提交的时候给出一个时间戳。

因为时间是系列化的,所以才有外部一致性。

这个很容易理解,如果有两个提交,一个在T1,一个在T2。

那有更晚的时间戳那个提交是正确的。

这个全球时间同步机制是用一个具有GPS和原子钟的TrueTime API提供了。

这个TrueTime API能够将不同数据中心的时间偏差缩短在10ms内。

这个API可以提供一个精确的时间,同时给出误差范围。

Google已经有了一个TrueTime API的实现。

笔者觉得这个TrueTimeAPI 非常有意义,如果能单独开源这部分的话,很多数据库如MongoDB都可以从中受益。

体系结构Spanner由于是全球化的,所以有两个其他分布式数据库没有的概念。

·Universe。

一个Spanner部署实例称之为一个Universe。

目前全世界有3个。

一个开发,一个测试,一个线上。

因为一个Universe就能覆盖全球,不需要多个。

· Zones. 每个Zone相当于一个数据中心,一个Zone内部物理上必须在一起。

而一个数据中心可能有多个Zone。

可以在运行时添加移除Zone。

一个Zone可以理解为一个BigTable部署实例。

如图所示。

一个Spanner有上面一些组件。

实际的组件肯定不止这些,比如TrueTime API Server。

如果仅仅知道这些知识,来构建Spanner是远远不够的。

但Google都略去了。

那笔者就简要介绍一下。

· Universemaster: 监控这个universe里zone级别的状态信息· Placement driver:提供跨区数据迁移时管理功能· Zonemaster:相当于BigTable的Master。

管理Spanserver上的数据。

·Location proxy:存储数据的Location信息。

客户端要先访问他才知道数据在那个Spanserver上。

· Spanserver:相当于BigTable的ThunkServer。

用于存储数据。

可以看出来这里每个组件都很有料,但是Google的论文里只具体介绍了Spanserver的设计,笔者也只能介绍到这里。

下面详细阐述Spanserver的设计。

Spanserver本章详细介绍Spanserver的设计实现。

Spanserver的设计和BigTable非常的相似。

参照下图从下往上看。

每个数据中心会运行一套Colossus (GFS II) 。

每个机器有100-1000个tablet。

Tablet概念上将相当于数据库一张表里的一些行,物理上是数据文件。

打个比方,一张1000行的表,有10个tablet,第1-100行是一个tablet,第101-200是一个tablet。

但和BigTable不同的是BigTable里面的 tablet存储的是Key-Value都是string,Spanner存储的Key多了一个时间戳:(Key: string, timestamp: int64) ->string。

因此spanner天生就支持多版本,tablet在文件系统中是一个B-tree-like的文件和一个write-ahead日志。

每个Tablet上会有一个Paxos状态机。

Paxos是一个分布式一致性协议。

Table的元数据和log都存储在上面。

Paxos会选出一个 replica做leader,这个leader的寿命默认是10s,10s后重选。

Leader就相当于复制数据的master,其他replica的数据都是从他那里复制的。

读请求可以走任意的replica,但是写请求只有去leader。

这些replica统称为一个paxos group。

每个leader replica的spanserver上会实现一个lock table还管理并发。

Lock table记录了两阶段提交需要的锁信息。