Linux内核分-(详细)收发数据包的调用

数据包处理过程

数据包处理过程来⾃链接:这篇⽂档是基于 x86 体系结构和转发 IP 分组的。

数据包在 Linux 内核链路层路径2 接收分组2.1 接收中断如果⽹卡收到⼀个和⾃⼰ MAC 地址匹配或链路层⼴播的以太⽹帧,它就会产⽣⼀个中断。

此⽹卡的驱动程序会处理此中断:从 DMA/PIO 或其他得到分组数据,写到内存⾥去;接着,会分配⼀个新的套接字缓冲区 skb ,并调⽤与协议⽆关的、⽹络设备均⽀持的通⽤⽹络接收处理函数netif_rx(skb) 。

netif_rx() 函数让内核准备进⼀步处理 skb 。

然后, skb 会进⼊到达队列以便 CPU 处理(对于多核 CPU ⽽⾔,每个 CPU 维护⼀个队列)。

如果 FIFO队列已满,就会丢弃此分组。

在 skb 排队后,调⽤ __cpu_raise_softirq() 标记 NET_RX_SOFTIRQ 软中断,等待 CPU 执⾏。

⾄此, netif_rx() 函数调⽤结束,返回调⽤者状况信息(成功还是失败等)。

此时,中断上下⽂进程完成任务,数据分组继续被上层协议栈处理。

2.2 softirq 和 bottom half内核 2.4 以后,整个协议栈不再使⽤ bottom half (下半⽂,没找到好的翻译),⽽是被软中断 softirq 取代。

软中断 softirq 优势明显,可以同时在多个 CPU 上执⾏;⽽ bottom half ⼀次只能在⼀个 CPU 上执⾏,即在多个 CPU执⾏时严格保持串⾏。

中断服务程序往往都是在 CPU 关中断的条件下执⾏的,以避免中断嵌套⽽使控制复杂化。

但是 CPU 关中断的时间不能太长,否则容易丢失中断信号。

为此, Linux 将中断服务程序⼀分为⼆,各称作“ Top Half ”和“ Bottom Half ”。

前者通常对时间要求较为严格,必须在中断请求发⽣后⽴即或⾄少在⼀定的时间限制内完成。

因此为了保证这种处理能原⼦地完成, Top Half 通常是在 CPU 关中断的条件下执⾏的。

linux网络基础知识

Linux网络基础知识TCP/IP通讯协议采用了4层的层级结构,每一层都呼叫它的下一层所提供的网络来完成自己的需求。

这4层分别为:应用层:应用程序间沟通的层,如简单电子邮件传输(SMTP)、文件传输协议(FTP)、网络远程访问协议(Telnet)等。

传输层:在此层中,它提供了节点间的数据传送服务,如传输控制协议(TCP)、用户数据报协议(UDP)等,TCP和UDP给数据包加入传输数据并把它传输到下一层中,这一层负责传送数据,并且确定数据已被送达并接收。

网络层:负责提供基本的数据封包传送功能,让每一块数据包都能够到达目的主机(但不检查是否被正确接收),如网际协议(IP)。

网络接口层(网络接口层例如以太网设备驱动程序):对实际的网络媒体的管理,定义如何使用实际网络(如Ethernet、Serial Line等)来传送数据。

网络接口层在发送端将上层的IP数据报封装成帧后发送到网络上;数据帧通过网络到达接收端时,该结点的网络接口层对数据帧拆封,并检查帧中包含的MAC地址。

如果该地址就是本机的MAC地址或者是广播地址,则上传到网络层,否则丢弃该帧。

网络接口层可细分为数据链路层和物理层,数据链路层实际上就是网卡的驱动程序,物理层实际上就是布线、光纤、网卡和其它用来把两台网络通信设备连接在一起的东西。

链路层,有时也称作数据链路层或网络接口层,通常包括操作系统中的设备驱动程序和计算机中对应的网络接口卡。

它们一起处理与电缆(或其他任何传输媒介)的物理接口细节。

网卡驱动程序主要实现发送数据帧与接受数据帧的功能,发送数据帧采用内核函数hard_start_xmit();接收数据帧采用内核函数netif_rx();网卡驱动程序主要是分配设置及注册net_dev结构体;数据帧的载体采用sk-buff结构体。

用浏览网页为例:发送方:1.输入网址:,按了回车键,电脑使用应用层用IE浏览器将数据从80端口发出,给了下一层协议——传输层。

linux 开发板之间数据传输方式

linux 开发板之间数据传输方式

Linux开发板之间的数据传输方式有多种,以下是一些常见的方式:1.网络传输:通过网线或Wi-Fi连接,使用TCP/IP协议栈进行数据传

输。

这种方式适合大量数据的快速传输,但需要稳定的网络环境。

2.串口传输:通过串口连接,使用串口通信协议(如RS-232、RS-485

等)进行数据传输。

这种方式适合短距离、低速的数据传输,常用于设备之间的调试和通信。

B传输:通过USB接口连接,使用USB协议进行数据传输。

这种

方式速度较快,适用于大量数据的传输,但需要开发板支持USB接口。

4.SD卡/eMMC传输:将数据存储到SD卡或eMMC等存储介质中,

然后通过插槽或接口连接到另一块开发板进行数据传输。

这种方式适合大量数据的存储和传输,但需要开发板支持相应的存储接口。

5.I2C/SPI传输:通过I2C或SPI等总线协议进行数据传输。

这种方式

适用于短距离、低速的数据传输,常用于设备之间的通信和控制。

具体选择哪种传输方式,需要根据应用场景、传输距离、传输速率、设备接口等因素综合考虑。

Linux内核中系统调用详解

Linux内核中系统调用详解什么是系统调用?(Linux)内核中设置了一组用于实现各种系统功能的子程序,称为系统调用。

用户可以通过系统调用命令在自己的应用程序中调用它们。

从某种角度来看,系统调用和普通的函数调用非常相似。

区别仅仅在于,系统调用由(操作系统)核心提供,运行于核心态;而普通的函数调用由函数库或用户自己提供,运行于用户态。

随Linux核心还提供了一些(C语言)函数库,这些库对系统调用进行了一些包装和扩展,因为这些库函数与系统调用的关系非常紧密,所以习惯上把这些函数也称为系统调用。

为什么要用系统调用?实际上,很多已经被我们习以为常的C语言标准函数,在Linux 平台上的实现都是靠系统调用完成的,所以如果想对系统底层的原理作深入的了解,掌握各种系统调用是初步的要求。

进一步,若想成为一名Linux下(编程)高手,也就是我们常说的Hacker,其标志之一也是能对各种系统调用有透彻的了解。

即使除去上面的原因,在平常的编程中你也会发现,在很多情况下,系统调用是实现你的想法的简洁有效的途径,所以有可能的话应该尽量多掌握一些系统调用,这会对你的程序设计过程带来意想不到的帮助。

系统调用是怎么工作的?一般的,进程是不能访问内核的。

它不能访问内核所占内存空间也不能调用内核函数。

(CPU)(硬件)决定了这些(这就是为什么它被称作"保护模式")。

系统调用是这些规则的一个例外。

其原理是进程先用适当的值填充(寄存器),然后调用一个特殊的指令,这个指令会跳到一个事先定义的内核中的一个位置(当然,这个位置是用户进程可读但是不可写的)。

在(Intel)CPU中,这个由中断0x80实现。

硬件知道一旦你跳到这个位置,你就不是在限制模式下运行的用户,而是作为操作系统的内核--所以你就可以为所欲为。

进程可以跳转到的内核位置叫做sysem_call。

这个过程检查系统调用号,这个号码告诉内核进程请求哪种服务。

然后,它查看系统调用表(sys_call_table)找到所调用的内核函数入口地址。

Linux内核参数说明

Linux内核参数说明转载⾃:https:///tolimit/p/5065761.html 因个⼈能⼒有限,不能保证所有描述都正确,还请⼤家集思⼴益,有错误的地⽅欢迎⼤家留⾔指正,同时也欢迎⼤家留⾔对未标注项进⾏补偿,谢谢。

内核参数列表kernel.acct acct功能⽤于系统记录进程信息,正常结束的进程都会在该⽂件尾添加对应的信息。

异常结束是指重启或其它致命的系统问题,不能够记录永不停⽌的进程。

该设置需要配置三个值,分别是:1.如果⽂件系统可⽤空间低于这个百分⽐值,则停⽌记录进程信息。

2.如果⽂件系统可⽤空间⾼于这个百分⽐值,则开始记录进程信息。

3.检查上⾯两个值的频率(以秒为单位)。

kernel.auto_msgmni 系统⾃动设置同时运⾏的消息队列个数。

0:不⾃动1:⾃动kernel.blk_iopollkernel.cad_pid接收Ctrl-alt-del操作的INT信号的进程的PIDkernel.cap_last_cap系统capabilities最⾼⽀持的权限等级。

详见:/iamfy/archive/2012/09/20/2694977.html pat-logkernel.core_pattern设置core⽂件保存位置或⽂件名,只有⽂件名时,则保存在应⽤程序运⾏的⽬录下kernel.core_pipe_limit 定义了可以有多少个并发的崩溃程序可以通过管道模式传递给指定的core信息收集程序。

如果超过了指定数,则后续的程序将不会处理,只在内核⽇志中做记录。

0是个特殊的值,当设置为0时,不限制并⾏捕捉崩溃的进程,但不会等待⽤户程序搜集完毕⽅才回收/proc/pid⽬录(就是说,崩溃程序的相关信息可能随时被回收,搜集的信息可能不全)。

kernel.core_uses_pid Core⽂件的⽂件名是否添加应⽤程序pid做为扩展0:不添加1:添加kernel.ctrl-alt-del 该值控制系统在接收到 ctrl+alt+delete 按键组合时如何反应:1:不捕获ctrl-alt-del,将系统类似于直接关闭电源0:捕获ctrl-alt-del,并将此信号传⾄cad_pid保存的PID号进程进⾏处理kernel.dmesg_restrict 限制哪些⽤户可以查看syslog⽇志0:不限制1:只有特权⽤户能够查看kernel.domainname⽹络域名(重启失效)kernel.ftrace_dump_on_oops 确定是否将ftrace的缓冲区的信息打印出来,是通过printk来打印的0:不打印1:在系统oops时,⾃动dump堆栈信息到输出终端kernel.hostname主机名(重启失效)kernel.hotplug该⽂件给出了当前系统⽀持热插拔(hotplug)时接收热插拔事件的程序的名字(包括路径)。

linux ops调用流程

linux ops调用流程

Linuxops调用流程是Linux内核中常见的一种操作方式,它是

由一组特定的函数组成的。

这些函数可以被设备驱动程序使用,以便在用户空间和内核空间之间进行数据传输。

整个调用流程可以分为以下几个步骤:

1. 调用open函数:当用户程序打开设备文件时,系统会调用设备驱动程序中的open函数。

这个函数会初始化设备并返回文件描述符。

2. 调用read函数:当用户程序从设备文件中读取数据时,系统会调用设备驱动程序中的read函数。

这个函数会将设备中的数据读

取到内核空间中,并将其返回到用户空间。

3. 调用write函数:当用户程序向设备文件中写入数据时,系

统会调用设备驱动程序中的write函数。

这个函数会将用户空间中的数据传输到内核空间中,并最终将其写入设备。

4. 调用ioctl函数:当需要进行设备的控制操作时,系统会调

用设备驱动程序中的ioctl函数。

这个函数可以进行一些特殊的控制操作,例如设置设备的参数等。

5. 调用close函数:当用户程序关闭设备文件时,系统会调用

设备驱动程序中的close函数。

这个函数会释放设备资源并关闭设备。

总的来说,Linux ops调用流程是一个在内核空间和用户空间之间进行数据传输的重要过程。

通过了解调用流程,我们可以更好地理解Linux内核的运作机制,并且可以更加高效地编写设备驱动程序。

Linux终端命令的进程通信和数据传输

Linux终端命令的进程通信和数据传输Linux终端命令是开发人员和系统管理员在Linux操作系统上进行各种操作的基础工具。

在Linux中,进程通信和数据传输是关键的功能之一,它允许不同的进程之间相互交换信息和共享资源。

本文将介绍Linux终端命令中的进程通信和数据传输的几种方法。

一、管道(pipe)管道是Linux终端命令中最简单和最常用的进程通信方式之一。

它实际上是一个特殊的文件,用于将一个命令的输出连接到另一个命令的输入。

管道使用竖线符号(|)来表示,例如:```command1 | command2```这将把command1的输出作为command2的输入。

通过管道,可以在不创建临时文件的情况下将多个命令串联起来,实现数据的流动和传输。

二、命名管道(named pipes)命名管道是一种特殊的文件类型,用于在不相关的进程之间进行通信。

与简单管道不同,命名管道可以通过文件系统中的路径进行引用,允许任意数量的进程进行读写操作。

命名管道使用mkfifo命令进行创建,例如:```mkfifo mypipe```创建后,可以通过文件读写的方式进行进程间通信,示例:```echo "Message" > mypipecat mypipe```第一条命令将一条消息写入命名管道,第二条命令将读取并显示该消息。

三、信号(signal)信号是一种Linux终端命令中用于进程间通信的异步通知机制。

当一个进程需要通知另一个进程发生了某个事件时,可以发送一个信号。

接收信号的进程可以根据信号的类型和处理方式来做出相应的响应。

常见的信号包括中断信号(SIGINT)和终止信号(SIGTERM)。

通过kill命令可以向指定进程发送信号,例如:```kill -SIGINT PID```这将中断具有PID标识符的进程。

四、共享内存(shared memory)共享内存是一种高效的进程间通信机制,允许不同的进程访问同一块物理内存。

Linux下IP――分片与重组――详解

Linux下IP――分片与重组――详解原理介绍为一个数据包片再次分片为数据包分片和为数据包片再次分片之间的细微差别就在于网关处理MF比特的不同。

但一个网关为原来为分片的数据包分片时,除了末尾的数据包片,它将其余所有分片上的MF比特都置为一,最后一片为0。

然而,当网关为一个非末尾的数据包片再次分片时,它会把生成的所有子分片中的MF比特全部设置为1,因为所有这些子分片都不可能是整个数据包的末尾的数据包片。

对于分片,需要拷贝IP首部和选项,以及数据。

而选项的拷贝要注意:根据协议标准,某些选项只应当出现在的一个数据包片中,而其他一些则必须出现在所有的数据包中。

数据包重组数据结构为了使数据包的重组效率更高,用于保存数据包的数据结构必须能够做到:为构成某一个特定数据包的一组数据包片快速定位;在一组数据包片中快速插入新的数据包片;有效地判断一个完整的数据包是否已经全部抵达;具有数据包片超时机制(ip_expire),并且,如果在重组完成之前定时器溢出,则删除数据包片。

互斥操作重组程序代码使用了一个互斥信号量。

Ipfrag_lock在链表中加入一个数据包片查找方式:链表的线性查找溢出时的丢弃分片列表空间以全满的情况下:丢弃对应的数据包的所有分片。

Ip_evictor测试是否组成一个完整的数据包ip_frag_queue判断IP_MF位是否为0!将数据包片组装成完整的数据包LAST_IN,ip_frag_reasm数据包片链表的维护管理为了使丢失数据包片的数据包不再浪费存储资源,并防止因为标示符字段的重新使用而给IP带来混乱,但已经不可能再受到剩余数据包片时,IP必须定期检查数据包片列表。

Ipq_unlinkIpq_putIpq_killIpqhashfnLinux下的实现IP分片如何提高分片处理的效率ip_fragment(非UDP使用)典型调用者ip_sendàip_fragment(skb, ip_finish_output);一般从转发来ip_queue_xmit2àip_fragment(skb, skb->dst->output)一般从TCP来因为IP报太大而将其分片以适合于一个帧的传输。

linux内核收包流程

linux内核收包流程Linux内核是开源的,它的内核源代码可以被任何人查看、修改和分发。

内核是操作系统的核心,它负责管理和协调系统硬件和软件资源,为应用程序提供一致的接口。

在Linux内核中,收包是指当接收到网络数据包时,内核如何处理和分发这些数据包。

下面将详细介绍Linux内核收包的流程。

首先,当数据包到达网卡时,网卡会将这个数据包拷贝到内核的内存中。

然后,内核会通过网络设备驱动程序检查这个数据包的合法性,包括检查以太网帧头、校验和等。

如果数据包合法,那么内核会将其拷贝到内核的套接字缓冲区中。

接下来,内核会分析数据包的目标IP地址,以确定数据包是发给本地还是需要转发到其他主机。

如果目标IP地址是本地主机,那么内核会查找与目标IP地址对应的本地套接字,并将数据包传递给该套接字。

如果目标IP地址是其他主机,那么内核会将数据包传递给路由子系统进行进一步的处理。

在路由子系统中,内核会根据路由表来确定下一跳的IP地址,并将数据包传递给相应的网络设备驱动程序。

网络设备驱动程序将数据包发送到下一跳主机。

如果目标主机和当前主机在同一局域网中,那么内核会使用ARP协议获取对应目标IP地址的MAC地址,然后通过以太网帧发送数据包。

当数据包到达目标主机后,目标主机的网卡会将数据包拷贝到内存中。

然后,内核会根据数据包的协议字段来识别上层协议类型,如TCP、UDP或ICMP等。

然后,将数据包传递给相应的协议处理函数进行处理。

协议处理函数会对数据包进行相应的处理,如IP协议处理函数会进行IP分片重组、IP头校验等操作;TCP协议处理函数会对TCP连接进行状态管理、流量调整等操作;UDP协议处理函数会进行端口匹配和应用程序通信等操作。

最后,协议处理函数会将处理后的数据包传递给相应的套接字,并唤醒等待在该套接字上的应用程序。

应用程序可以通过调用系统调用来读取数据包或向其发送数据包。

总结起来,Linux内核收包的流程主要包括:数据包到达网卡、网卡拷贝数据包到内存、检查数据包合法性、目标IP地址分析、传递给本地套接字或路由子系统、路由子系统发送数据包到下一跳、目标主机网卡拷贝数据包到内存、协议处理函数对数据包进行处理、将处理后的数据包传递给套接字、应用程序读取或发送数据包。

Linux操作系统修改内核参数的三种方法详细说明

Linux操作系统修改内核参数的三种方法详细说明linux内核的参数设置怎么弄呢,Linux 操作系统修改内核参数有以下三种方式:修改 /etc/sysctl.conf 文件;在文件中加入配置项,格式为 key = value,保存修改后的文件,执行命令 sysctl -p 加载新配置。

使用 sysctl 命令临时修改;如:sysctl -w net.ipv4.tcp_mem = “379008 505344 758016”直接修改/proc/sys/ 目录中的文件。

如:echo “379008 505344 758016” 》 /proc/sys/net/ipv4/tcp_mem 注意:第一种方式在重启操作系统后自动永久生效;第二种和第三种方式在重启后失效。

内核参数kernel.core_uses_pi d = 1core_uses_pid 可以控制 core 文件的文件名中是否添加 pid 作为扩展名。

设置为1,表示添加 pid 作为扩展名,生成的 core 文件格式为core.xxx;设置为0(默认),表示生成的 core 文件统一命名为 core。

kernel.core_pat te rn = corecore_pattern 可以控制 core 文件的保存位置和文件格式。

如:kernel.core_pattern = “/corefile/core-%e-%p-%t”,表示将core 文件统一生成到 /corefile 目录下,产生的文件名为 core-命令名-pid-时间戳。

以下是参数列表:%p - insert pid into filename 添加 pid%u - insert current uid into filename 添加当前 uid%g - insert current gid into filename 添加当前 gid%s - insert signal that caused the coredump into the filename 添加导致产生 core 的信号%t - insert UNIX ti me that the coredump occurred into filename 添加 core 文件生成时的 unix 时间%h - insert hostname where the coredump happened into filename 添加主机名%e - insert coredumping executable name into filename 添加命令名kernel.msgmax = 8192进程间的消息传递是在内核的内存中进行的。

linux动态库调用方法

linux动态库调用方法Linux动态库调用方法动态库是一种程序库,它在程序运行时才会被加载和链接,相对于静态库来说,动态库更加灵活和高效。

在Linux系统中,动态库的调用方法有多种,本文将介绍其中的一些常用方法。

1. 静态调用静态调用是指在编译链接阶段将动态库的代码完全复制到可执行文件中,使得可执行文件不再依赖于动态库。

在Linux系统中,静态调用需要使用静态库文件(以.a为后缀),可以通过在编译命令中添加-l参数来指定静态库文件的路径。

例如:```gcc main.c -L/path/to/lib -lmylib -o main```其中,/path/to/lib是动态库所在的路径,mylib是动态库的名称,main是生成的可执行文件名。

2. 动态调用动态调用是指在程序运行时动态加载和链接动态库。

在Linux系统中,动态调用需要使用动态库文件(以.so为后缀),可以通过以下几种方法进行动态调用。

(1)dlopen/dlsymdlopen和dlsym是Linux系统提供的动态库加载和符号查找函数。

dlopen函数用于加载动态库,dlsym函数用于查找动态库中的符号。

可以通过以下代码进行调用:```c#include <dlfcn.h>void* handle = dlopen("/path/to/libmylib.so", RTLD_LAZY);if (handle == NULL) {printf("Failed to load library: %s\n", dlerror());return -1;}void (*function)() = dlsym(handle, "my_function");if (function == NULL) {printf("Failed to find symbol: %s\n", dlerror());dlclose(handle);return -1;}function();dlclose(handle);```其中,/path/to/libmylib.so是动态库所在的路径,my_function 是动态库中的函数名。

linux收发包流程

Linux收发包流程概述

Linux收发包流程如下:

1. 应用程序通过套接字接口发送数据包,该数据包先要在网络协议栈中从上到下进行逐层处理,最终再送到网卡发送出去。

2. 网卡向CPU发起硬件中断,当CPU收到硬件中断请求后,根据中断表,调用已经注册的中断处理函数。

3. 中断处理函数会从用户态陷入到内核态中的Socket层,内核会申请一个内核态的sk_buff内存,将用户待发送的数据拷贝到sk_buff 内存,并将其加入到发送缓冲区。

4. 网络协议栈从Socket发送缓冲区中取出sk_buff,并按照TCP/IP协议栈从上到下逐层处理。

5. 传输层如果使用的是TCP传输协议发送数据,那么先拷贝一个新的sk_buff副本,接着,对sk_buff填充TCP头。

6. 然后交给网络层,在网络层里会做这些工作:选取路由(确认下一跳的IP)、填充IP头、netfilter过滤、对超过MTU大小的数据包进行分片。

处理完这些工作后会交给网络接口层处理。

7. 网络接口层负责物理地址寻址,找下一跳的MAC地址,添加帧头和帧尾,放到发包队列中。

8. 这一切完成后,会有软中断通知驱动程序:发包队列中有新的网络帧需要发送。

9. 驱动程序通过DMA ,从发包队列中读出网络帧,并通过物理网卡把它发送出去。

这就是Linux的收发包流程,仅供参考,建议查阅专业书籍或咨询专业人士获取更准确的信息。

linux 函数调用关系

linux 函数调用关系Linux函数调用关系Linux是一个开源的操作系统内核,其中包含了大量的函数用于实现不同的功能。

这些函数之间存在着复杂的调用关系,通过相互调用来完成各种任务。

本文将以Linux函数调用关系为主题,从整体上介绍Linux函数的调用方式和关系。

在Linux中,函数的调用关系可以分为以下几种情况:库函数调用、系统调用和内核函数调用。

1. 库函数调用库函数是一组预定义的函数,提供了各种常用的功能,如字符串操作、数学计算、文件操作等。

库函数通常以库的形式提供给用户,用户可以通过调用这些函数来实现相应的功能。

库函数调用的关系比较简单,函数之间的调用关系是线性的,即一个函数调用另一个函数,然后再返回到原来的函数。

2. 系统调用系统调用是用户程序与操作系统内核之间的接口,用于请求操作系统提供各种服务,如进程管理、文件管理、设备管理等。

系统调用是通过软中断的方式实现的,用户程序通过调用特定的系统调用函数来发起系统调用。

当用户程序调用系统调用函数时,控制权转移到内核态,操作系统内核根据系统调用号来确定用户请求的服务,并执行相应的操作。

系统调用函数的返回值通常用来表示操作的结果。

3. 内核函数调用内核函数是在操作系统内核内部实现的函数,用于处理系统的各种任务。

内核函数通常由系统调用函数调用,用于实现具体的系统服务。

内核函数之间的调用关系比较复杂,涉及到多个子系统和模块之间的相互调用。

内核函数的调用关系通常采用树状结构,即一个函数可以调用多个子函数,而子函数又可以调用其他函数。

在Linux中,函数的调用关系是通过函数指针来实现的。

函数指针是一个指向函数的指针变量,可以将函数作为参数传递给其他函数,也可以将函数作为返回值返回给调用者。

通过函数指针,可以在运行时动态地确定需要调用的函数,从而实现函数的灵活调用。

总结起来,Linux函数的调用关系可以分为库函数调用、系统调用和内核函数调用三种情况。

这些函数之间存在着复杂的调用关系,通过相互调用来完成各种任务。

linux报文的接收与发送

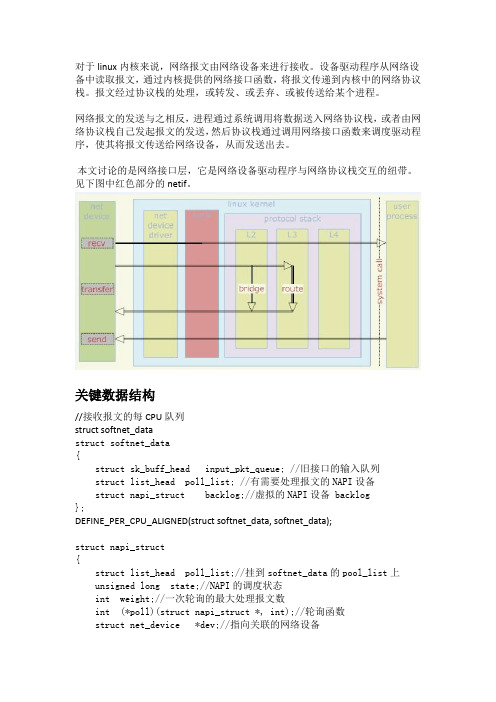

对于linux内核来说,网络报文由网络设备来进行接收。

设备驱动程序从网络设备中读取报文,通过内核提供的网络接口函数,将报文传递到内核中的网络协议栈。

报文经过协议栈的处理,或转发、或丢弃、或被传送给某个进程。

网络报文的发送与之相反,进程通过系统调用将数据送入网络协议栈,或者由网络协议栈自己发起报文的发送,然后协议栈通过调用网络接口函数来调度驱动程序,使其将报文传送给网络设备,从而发送出去。

本文讨论的是网络接口层,它是网络设备驱动程序与网络协议栈交互的纽带。

见下图中红色部分的netif。

关键数据结构//接收报文的每CPU队列struct softnet_datastruct softnet_data{struct sk_buff_head input_pkt_queue; //旧接口的输入队列struct list_head poll_list; //有需要处理报文的NAPI设备struct napi_struct backlog;//虚拟的NAPI设备 backlog};DEFINE_PER_CPU_ALIGNED(struct softnet_data, softnet_data);struct napi_struct{struct list_head poll_list;//挂到softnet_data的pool_list上unsigned long state;//NAPI的调度状态int weight;//一次轮询的最大处理报文数int (*poll)(struct napi_struct *, int);//轮询函数struct net_device *dev;//指向关联的网络设备struct list_head dev_list;//对应的网络设备上关联的NAPI链表节点 /*其他字段是gso功能用,这里先不讨论*/};网络设备的初始化这里会注册TX/RX软中断对应的回调函数static int __init net_dev_init(void){……open_softirq(NET_TX_SOFTIRQ, net_tx_action);open_softirq(NET_RX_SOFTIRQ, net_rx_action);……}}报文的接收网络报文的接收源自网络设备。

linunx pcie发送数据调用的函数

linunx pcie发送数据调用的函数【Linux PCIE发送数据调用的函数】当在Linux系统中使用PCIe总线发送数据时,可以使用一些特定的函数来实现这一功能。

PCIE发送数据的关键是通过驱动程序对PCIE设备进行访问和控制。

在编写驱动程序时,我们可以使用以下函数来进行数据发送操作:1. pci_request_regions:这个函数用于向操作系统请求PCI设备的资源,包括IO端口和内存地址。

将该函数与之后的pci_iomap函数结合使用,可以分配并映射PCI 设备的内存资源,为数据传输做准备。

2. pci_iomap:该函数用于将分配的内存资源映射到用户空间的内存地址空间,以便用户可以直接访问PCI设备的内存区域。

用户程序可以通过访问这些内存地址来发送数据到PCI设备。

3. memcpy_toio:这个函数用于将数据从内核空间复制到IO内存空间。

调用该函数可以将用户空间的数据复制到PCI设备的内存地址,实现数据发送的功能。

4. writel:该函数用于向PCI设备的寄存器中写入数据。

通过调用该函数,可以向PCI设备的控制寄存器中写入特定的命令和参数,控制设备的操作。

综合上述函数,我们可以编写一个函数,将数据从用户空间发送到PCIe 设备。

以下是一个示例:#include <linux/pci.h>#include <asm/io.h>void send_data_to_pcie(struct pci_dev *pdev, void *data, size_t size) {请求PCI设备的资源if (pci_request_regions(pdev, "driver_name") != 0) {printk("Fail to request regions\n");return;}映射设备的内存资源void __iomem *mem_base = pci_iomap(pdev, 0,pci_resource_len(pdev, 0));if (!mem_base) {printk("Fail to iomap\n");pci_release_regions(pdev);return;}将数据从内核空间复制到IO内存空间memcpy_toio(mem_base, data, size);向寄存器中写入命令和参数,实现数据发送writel(reg_value, mem_base + reg_offset);解除内存映射iounmap(mem_base);释放PCI设备的资源pci_release_regions(pdev);}上述代码示例展示了一个基本的数据发送函数。

Linux下一种高性能数据包收发机制与实现

Linux下一种高性能数据包收发机制与实现刘松涛;管鲍【摘要】The traditional Linux mainly sends and receives data packet in kernel space, so it has a memory copy process to protocol stack running in user space. This paper presents a mechanism of sending and receiving packet based on Datapath Acceleration Architecture, realizing the zero memory copy. Introduces each module of DPAA and the use schemes of USDPAA, analyses and realizes the design of USDPAA user space and kernel space. After testing, it is effective to sending and receiving data packet in user state.%传统上Linux主要在内核空间收发数据包,对于运行于用户空间的协议栈存在一次内存拷贝过程,文章提出基于数据通道加速架构(Datapath Acceleration Architecture,DPAA)的用户态收发包机制,实现内存零拷贝,介绍了DPAA各模块和USDPAA的使用方案,对USDPAA内核空间和用户空间的设计进行了分析和实现.经过测试,能够在用户态有效的收发数据包.【期刊名称】《价值工程》【年(卷),期】2012(031)015【总页数】2页(P187-188)【关键词】数据包;数据通道加速架构;内存拷贝【作者】刘松涛;管鲍【作者单位】武汉邮电科学研究院,武汉430074;武汉邮电科学研究院,武汉430074【正文语种】中文【中图分类】TP3920 引言传统的Linux在处理数据包时,主要采用在内核态收发包的模式,然后交给内核协议栈处理。

linux应用层调用内核接口函数的实现方法

在Linux操作系统中,应用层调用内核接口函数主要有以下几种方法:

1. 系统调用(System Call):系统调用是应用程序请求内核服务的一种方式,它是应用程序与操作系统内核之间通信的桥梁。

通过系统调用,应用程序可以访问内核提供的各种服务,例如文件操作、进程控制、网络通信等。

2. 库函数(Library Function):库函数是应用程序可以直接调用的函数,这些函数通常是由C标准库提供的。

库函数在实现时通常会使用系统调用来与内核交互,因此实际上是通过库函数间接地调用了内核接口函数。

3. 设备驱动程序(Device Driver):设备驱动程序是内核的一部分,它负责管理硬件设备。

应用程序可以通过设备驱动程序来访问硬件设备,实现与硬件的交互。

设备驱动程序通常通过系统调用来与应用程序通信。

4. 套接字(Socket):套接字是一种通信机制,用于应用程序之间的通信。

通过套接字,应用程序可以与其他应用程序或远程主机进行通信。

套接字在实现时通常会使用系统调用来与内核通信,因此也可以视为一种间接调用内核接口函数的方式。

无论哪种方法,都需要使用系统调用接口来实现应用程序与内核之间的通信。

系统调用接口提供了一组函数,例如`syscall()`、`access()`、

`mmap()`等,应用程序可以通过这些函数来发起系统调用,请求内核服务。

在内核中,相应的服务会被实现为内核函数,这些函数可以访问内核的数据结构和资源,以完成相应的操作。

linux bridge收包流程

linux bridge收包流程如下:

1. 当网卡收到一个数据包时,它会将数据包发送到__netif_receive_skb_core函数。

2. 在该函数中,会剥离VLAN标签(如果有的话),并找到对应的vlan子接口(如果有的话)。

3. 如果skb->dev是bridge成员口,那么数据包将会被传递到bridge成员口的接收处理函数。

4. 在bridge的接收处理函数中,首先会判断目的mac地址是否是特殊地址(如stp等),如果是,则转入本地处理。

5. 然后获取skb->dev指向的数据struct net_bridge_port *p。

6. 如果p->state == BR_STATE_FORWARDING,先执行ebtables-broute表规则,再执行下面BR_STATE_LEARNING相关部分。

7. 如果p->state == BR_STATE_LEARNING,先执行NF_BR_PRE_ROUTING链规则,之后进入br_handle_frame_finish。

8. 最后,在br_handle_frame_finish函数中,根据目的mac地址寻找出口。

以上就是linux bridge的收包流程,更多细节可以咨询专业人士或查阅相关文献。

Linux系统调用

Linux系统调⽤所谓系统调⽤是指操作系统提供给⽤户程序调⽤的⼀组“特殊”接⼝,⽤户程序可以通过这组“特殊”接⼝来获得操作系统内核提供的服务。

例如⽤户可以通过进程控制相关的系统调⽤来创建进程、实现进程调度、进程管理等。

在这⾥,为什么⽤户程序不能直接访问系统内核提供的服务呢?这是由于在 Linux 中,为了更好地保护内核空间,将程序的运⾏空间分为内核空间和⽤户空间(也就是常称的内核态和⽤户态),它们分别运⾏在不同的级别上,在逻辑上是相互隔离的。

因此,⽤户进程在通常情况下不允许访问内核数据,也⽆法使⽤内核函数,它们只能在⽤户空间操作⽤户数据,调⽤⽤户空间的函数。

但是,在有些情况下,⽤户空间的进程需要获得⼀定的系统服务(调⽤内核空间程序),这时操作系统就必须利⽤系统提供给⽤户的“特殊接⼝”——系统调⽤规定⽤户进程进⼊内核空间的具体位置。

进⾏系统调⽤时,程序运⾏空间需要从⽤户空间进⼊内核空间,处理完后再返回到⽤户空间。

Linux 系统调⽤部分是⾮常精简的系统调⽤(只有 250 个左右),它继承了 UNIX 系统调⽤中最基本和最有⽤的部分。

这些系统调⽤按照功能逻辑⼤致可分为进程控制、进程间通信、⽂件系统控制、系统控制、存储管理、⽹络管理、socket 控制、⽤户管理等⼏类。

在 Linux 中对⽬录和设备的操作都等同于⽂件的操作,因此,⼤⼤简化了系统对不同设备的处理,提⾼了效率。

Linux 中的⽂件主要分为 4种:普通⽂件、⽬录⽂件、链接⽂件和设备⽂件。

那么,内核如何区分和引⽤特定的⽂件呢?这⾥⽤到的就是⼀个重要的概念——⽂件描述符。

对于 Linux ⽽⾔,所有对设备和⽂件的操作都使⽤⽂件描述符来进⾏的。

⽂件描述符是⼀个⾮负的整数,它是⼀个索引值,并指向内核中每个进程打开⽂件的记录表。

当打开⼀个现存⽂件或创建⼀个新⽂件时,内核就向进程返回⼀个⽂件描述符;当需要读写⽂件时,也需要把⽂件描述符作为参数传递给相应的函数。

linux收包路径

linux收包路径

Linux收包路径主要涉及网络协议栈、驱动程序和内核线程等多个方面。

以下是详细的步骤:

1. 外部数据通过网线、路由器、网关等到达本地Linux机器的网卡设备上。

2. 网卡将数据DMA(Direct Memory Access)写到内存的RingBuffer中。

当RingBuffer满时,如果还有新的数据包到达,则会被丢弃。

3. 网卡向CPU发出一个硬中断,通知CPU处理数据。

4. CPU收到中断请求后,调用驱动注册的中断处理函数。

该函数发出软中断请求后,释放CPU资源,等待其他中断。

5. Linux内核的ksoftirqd内核线程检测到软中断请求到达,调用驱动注册的poll函数开始轮询收包。

驱动的igb_pool函数把数据从RingBuffer中取出,送到协议栈注册的ip_rcv函数中。

6. Linux内核的网络协议栈根据包的协议进行处理(TCP/UDP)。

7. 协议层开始处理网络数据帧,处理完的数据被放到用户进程socket的接收队列中。

8. 用户进程(如recv)被唤醒收包。

此外,网卡的多队列模式也是现代网卡的一个重要特性。

可以通过ethtool 命令查看当前网卡支持的最大队列数,并使用ethtool命令增大当前网卡的队列数。

每个硬中断都在一个特定的CPU上处理,因此可以通过调整硬中断的CPU 亲和性,将硬中断分配到指定的CPU上。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Linux内核分析- 网络[一]:收发数据包的调用分类:内核协议栈2010-12-01 15:08 7355人阅读评论(7) 收藏举报linux内核网络structlistaction内核版本:Linux-2.6.34网卡驱动:B4401什么是NAPINAPI是linux一套最新的处理网口数据的API,linux 2.5引入的,所以很多驱动并不支持这种操作方式。

简单来说,NAPI是综合中断方式与轮询方式的技术。

数据量很低与很高时,NAPI 可以发挥中断方式与轮询方式的优点,性能较好。

如果数据量不稳定,且说高不高说低不低,则NAPI会在两种方式切换上消耗不少时间,效率反而较低一些。

下面会用到netdev_priv()这个函数,这里先讲解下,每个网卡驱动都有自己的私有的数据,来维持网络的正常运行,而这部分私有数据放在网络设备数据后面(内存概念上),这个函数就是通过dev来取得这部分私有数据,注间这部分私有数据不在dev结构体中,而是紧接在dev内存空间后。

static inline void *netdev_priv(const struct net_device *dev){return (char *)dev + ALIGN(sizeof(struct net_device), NETDEV_ALIGN);}弄清这个函数还得先清楚dev这个结构的分配alloc_netdev() -> alloc_netdev_mq()struct net_device *alloc_netdev_mq(int sizeof_priv, const char *name,void (*setup)(struct net_device *), unsigned int queue_count){……alloc_size = sizeof(struct net_device);if (sizeof_priv) {/* ensure 32-byte alignment of private area */alloc_size = ALIGN(alloc_size, NETDEV_ALIGN);alloc_size += sizeof_priv;}/* ensure 32-byte alignment of whole construct */alloc_size += NETDEV_ALIGN - 1;p = kzalloc(alloc_size, GFP_KERNEL);if (!p) {printk(KERN_ERR "alloc_netdev: Unable to allocate device./n");return NULL;}……….}可以看到,dev在分配时,即在它的后面分配了private的空间,需要注意的是,这两部分都是32字节对齐的,如下图所示,padding是加入的的补齐字节:举个例子,假设sizeof(net_device)大小为31B,private大小45B,则实际分配空间如图所示:b44_interrupt():当有数据包收发或发生错误时,会产生硬件中断,该函数被触发struct b44 *bp = netdev_priv(dev);取出网卡驱动的私有数据private,该部分数据位于dev数据后面istat = br32(bp, B44_ISTAT);imask = br32(bp, B44_IMASK);读出当前中断状态和中断屏蔽字if (istat) {……if (napi_schedule_prep(&bp->napi)) {bp->istat = istat;__b44_disable_ints(bp);__napi_schedule(&bp->napi);}设置NAPI为SCHED状态,记录当前中断状态,关闭中断,执行调度void __napi_schedule(struct napi_struct *n){unsigned long flags;local_irq_save(flags);list_add_tail(&n->poll_list, &__get_cpu_var(softnet_data).poll_list);__raise_softirq_irqoff(NET_RX_SOFTIRQ);local_irq_restore(flags);}__get_cpu_var():得到当前CPU的偏移量,与多CPU有关将napi的poll_list加入到softnet_data队列尾部,然后引起软中断NET_RX_SOFTIRQ。

似乎还没有真正的收发函数出现,别急;关于软中断的机制请参考资料,在net_dev_init()[dev.c]中,注册了两个软中断处理函数,所以引起软中断后,最终调用了net_rx_action()。

open_softirq(NET_TX_SOFTIRQ, net_tx_action);open_softirq(NET_RX_SOFTIRQ, net_rx_action);下面来看下net_rx_action()函数实现:static void net_rx_action(struct softirq_action *h){struct list_head *list = &__get_cpu_var(softnet_data).poll_list; // [1]……n = list_first_entry(list, struct napi_struct, poll_list); // [2]……work = 0;if (test_bit(NAPI_STATE_SCHED, &n->state)) {work = n->poll(n, weight); // [3]trace_napi_poll(n);}……}__get_cpu_var是不是很熟悉,在b44_interrupt()中才向它的poll_list中加入了一个napi_struct;代码[2]很简单了,从poll_list的头中取出一个napi_struct,然后执行代码[3],调用poll()函数;注意到这里在interrupt时,会向poll_list尾部加入一个napi_struct,并引起软中断,在软中断处理函数中,会从poll_list头部移除一个napi_struct,进行处理,理论上说,硬件中断加入的数据在其引起的软中断中被处理。

poll函数实际指向的是b44_poll(),这是显而易见的,但具体怎样调用的呢?在网卡驱动初始化函数b44_init_one()有这样一行代码:netif_napi_add(dev, &bp->napi, b44_poll, 64);而netif_napi_add()中初始化napi并将其加入dev的队列,napi->poll = poll;这行代码就是b44_poll赋给napi_poll,所以在NET_RX_SOFTIRQ软中断处理函数net_rx_action()中执行的b44_poll()。

怎么到这里都还没有收发数据包的函数呢!b44_poll()就是轮询中断向量,查找出引起本次操作的中断;static int b44_poll(struct napi_struct *napi, int budget){……if (bp->istat & (ISTAT_TX | ISTAT_TO))b44_tx(bp);……if (bp->istat & ISTAT_RX)work_done += b44_rx(bp, budget);if (bp->istat & ISTAT_ERRORS)……}可以看到,查询了四种中断:ISTAT_TX、ISTAT_TO、ISTAT_RX、ISTAT_ERRORS#define ISTAT_TO 0x00000080 /* General Purpose Timeout */#define ISTAT_RX 0x00010000 /* RX Interrupt */#define ISTAT_TX 0x01000000 /* TX Interrupt */#define ISTAT_ERRORS (ISTAT_DSCE|ISTAT_DATAE|ISTAT_DPE|ISTAT_RDU|ISTAT_RFO|ISTAT_TFU) 如果是TX中断,则调用b44_tx发送数据包;如果是RX中断,则调用b44_rx接收数据包。

至此,从网卡驱动收发数据包的调用就是如此了。

最后,给个总结性的图:Linux内核分析- 网络[二]:网卡驱动接收报文分类:内核协议栈2011-03-30 11:34 5520人阅读评论(1) 收藏举报linux内核网络struct descriptorheader纠结了好多天,终于弄懂了B440X的处理。

上篇讲到通过中断,最终网卡调用了b44_rx()来接收报文对这个函数中的一些参数,可以这样理解:bp->rx_cons –处理器处理到的缓冲区号bp->rx_pending –分配的缓冲区个数bp->rx_prod –当前缓冲区的最后一个缓冲号这里要参数B440X的手册了解下寄存器的作用:#define B44_DMARX_ADDR 0x0214UL /* DMA RX Descriptor Ring Address */#define B44_DMARX_PTR 0x0218UL /* DMA RX Last Posted Descriptor */#define B44_DMARX_STAT 0x021CUL /* DMA RX Current Active Desc. + Status */仅b44_rx()来说,B44_DMARX_ADDR储存了环形缓冲的基地址,B44_DMARX_PTR存储了环形缓冲最后一个缓冲区号,这两个寄存器都由处理来设置;B44_DMARX_STAT储存了状态及网卡当前处理到的缓冲区号,这个寄存器只能由网卡来设置。

网卡中DMA也很重要:在网卡初始化阶段,b44_open() -> b44_alloc_consistent()bp->rx_buffers = kzalloc(size, gfp); // size = B44_RX_RING_SIZE * sizeof(struct ring_info)bp->rx_ring = ssb_dma_alloc_consistent(bp->sdev, size, &bp->rx_ring_dma, gfp);// size = DMA_TABLE_BYTESrx_ring是DMA映射的虚拟地址,rx_rind_dma是DMA映射的总线地址,这个地址将会写入B44_DMARX_ADDR寄存器,作为环形缓冲的基地址。