图像融合代码 matlab演示教学

MATLAB图像融合

一、实验原理本实验对源图像分别进行Harr 小波变换,建立图像的小波塔形分解,然后对分解层进行融合,处理各分解层上的不同频域分量可以采用不同的融合算子进行融合处理,本实验采用统一的算法处理,得到融合后的小波金字塔,对融合后的小波金字塔进行小波逆变换,得到的重构图像为拼接图像1、 Harr 小波变换Harr 小波分解步骤:步骤一:输入信号n S 有2n 个样本,步骤二:将信号分成1,2,2,,02n n l n l a S b S l -===,一共12n -对,然后对每一对变换,获得均值1n S -和差值1n d -。

,21,212n l n ln S S S +-+=,1,,21,2n l n l n l d S S -+=-反变换可以无损地从1n S -和1n d -中恢复出原信号,1n S -作为信号的全局信息(低频成分),1n d -作为信号的细节信息(高频成分),全局信息和原信号比较相似(局部一致性),细节信息(差值比较小)可以很高效的进行表示。

步骤三:对1n S -实施同样的变换(求均值和差值),获得均值2n S -和差值2n d -,它们两各有22n -个样本值。

步骤四:重复上面的变换步骤,直到0S 中仅有一个元素为止。

2、图像拼接算法本实验采用小波分解的图像处理方法,首先对图形进小波变换,然后采用分层比较法,对两幅图的一级分解的LL 层进行比较,从而获得准确的位置匹配,然后各层进行相应的位置衔接,得到拼接图像的一级小波分解图像,最后对分解图像进行重构,得到拼接后的图像。

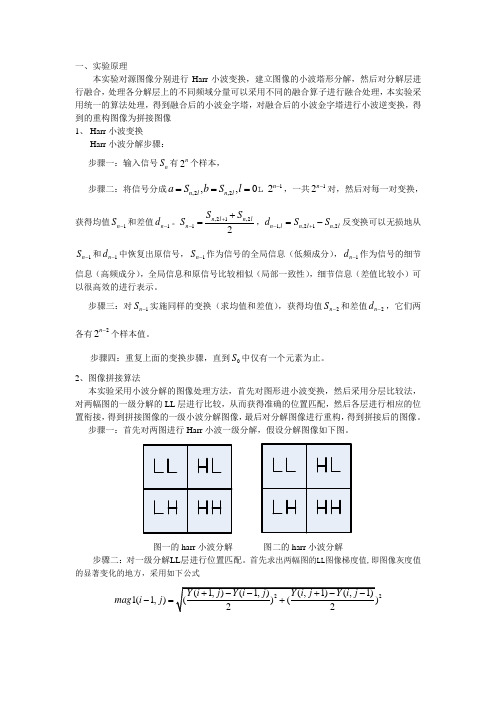

步骤一:首先对两图进行Harr 小波一级分解,假设分解图像如下图。

图一的harr 小波分解 图二的harr 小波分解步骤二:对一级分解LL 层进行位置匹配。

首先求出两幅图的LL 图像梯度值,即图像灰度值的显著变化的地方,采用如下公式21(1,)mag i j -=22(1,)mag i j -= 1mag 2mag 分别为图一、图二的LL 图像梯度值矩阵,然后求出相应的列梯度最大值,并赋给列梯度最大值向量1mtdd 、2mtdd ,为得到能反映实际特征的容易分析的图像,对1mtdd 、2mtdd 进行去噪。

MATLAB技术图像拼接实例

MATLAB技术图像拼接实例图像拼接是一种将多幅图像拼接在一起,形成一幅完整图像的技术。

它在计算机视觉、医学影像处理、地理信息系统等领域中有着广泛的应用。

在本文中,我们将通过一个实例来介绍如何使用MATLAB进行图像拼接。

首先,让我们先了解一下图像拼接的原理。

图像拼接主要分为两个步骤:特征提取和图像融合。

特征提取是指从每幅图像中提取出可以唯一标识该图像的特征点,常用的方法有SIFT、SURF和ORB等。

图像融合是指将提取出的特征点进行匹配,并利用匹配结果将多幅图像拼接到一起,常用的方法有RANSAC算法和Harris角点算法等。

接下来,我们以拼接两幅图像为例进行讲解。

假设我们有两幅图像A和B,我们将通过图像拼接将它们拼接在一起。

首先,我们需要在MATLAB中导入两幅图像。

可以使用imread()函数将图像文件导入到MATLAB中,通过imshow()函数将图像显示出来。

为了方便后续处理,我们可以将图像转换为灰度图像,可以使用rgb2gray()函数实现。

接下来,我们需要提取图像中的特征点。

这里我们可以使用SIFT算法,可以使用vl_sift()函数提取图像的SIFT特征点。

首先,需要将图像转换为单通道图像,可以使用mat2gray()函数实现。

然后,通过vl_sift()函数提取特征点的坐标和描述符。

特征点的坐标表示了特征点在图像中的位置,而描述符表示了特征点的特征信息。

提取完特征点后,我们需要将两幅图像的特征点进行匹配。

这里我们可以使用RANSAC算法,可以使用ransac()函数进行特征点匹配。

RANSAC算法是一种迭代算法,它通过随机选择一组特征点进行匹配,并计算出匹配结果的模型参数,然后通过模型参数,计算其他特征点的匹配误差。

通过多次迭代,得到最佳的匹配结果。

匹配完成后,我们可以通过Harris角点算法,对图像进行对齐。

Harris角点算法是一种基于图像灰度变化的角点检测算法,它通过计算图像每个像素点的Harris响应函数,来判断该点是否为角点。

小波变换-图像融合matlab代码

%对图像进行放大算子的运算

PIC3 = conv2(conv2(Y, 2*fw, 'valid'),2*fw','valid');

%第i1级图像重构;

PIC1 = PIC3 + L{i};

%选取图像范围

PIC1 = PIC1(1:k1(i),1:k2(i));

% %end;

% %end;

% %%

% %for k=1:256,

% % p1(k)=p1(k)/(d);

% % p2(k)=p2(k)/(d);

% %end;

%

% %for i=1:256

% % for j=1:256

% % p3(i,j) =p3(i,j)/(d);

%图像隔行隔列插值扩展恢复到原尺寸图像

[c d] = size(Y4);

Y6 = zeros(2*c, 2*d);

Y6(1:2:2*c,1:2:2*d) = Y4;

Y7 = zeros(2*c, 2*d);

%PIC2 = X2;

X1 = PIC1;

X2 = PIC2;

%定义滤波窗口;

fw = 1/16.*[1 4 6 4 1];

z =3;

L = cell(1,z);

L1 = cell(1,z);

for i = 1:z % N1

G3 = conv2(conv2(Y3, fw, 'valid'),fw', 'valid');

%将图像进行隔行隔列减半

[a b] = size(G2);

Y4 = G2(1:2:a, 1:2:b);

使用Matlab进行图像配准与图像融合的实践方法

使用Matlab进行图像配准与图像融合的实践方法引言:图像配准和图像融合是数字图像处理中的两个核心技术。

图像配准是将两幅或多幅图像进行几何变换,使它们在空间上对应一致。

而图像融合是将多幅图像进行融合处理,得到一幅更具信息量和视觉效果的图像。

本文将介绍使用Matlab进行图像配准与图像融合的实践方法,包括基本概念、算法原理和具体实现步骤。

一、图像配准方法介绍1.1 特征点匹配法特征点匹配法是一种常用的图像配准方法。

其基本原理是通过检测图像中的关键点,并将其描述为特征向量,然后通过比较特征向量之间的相似性来进行特征点匹配,最终实现图像的配准。

1.2 直方图匹配法直方图匹配法是一种基于图像的颜色直方图进行匹配的图像配准方法。

其基本原理是通过统计图像中各颜色水平的频率分布,然后对两幅图像的颜色分布进行比较和调整,从而实现图像的配准。

1.3 尺度空间配准法尺度空间配准法是一种基于尺度空间理论的图像配准方法。

其基本原理是通过对图像进行空间和尺度域的变换和处理,使得图像在不同尺度下都具有相似的特征分布和结构,从而实现图像的配准。

二、图像融合方法介绍2.1 加权融合法加权融合法是一种简单而有效的图像融合方法。

其基本原理是对多幅图像进行加权求和,其中每幅图像的权重可以根据其质量或重要性进行设定,从而实现图像的融合。

2.2 小波变换法小波变换法是一种基于小波理论的图像融合方法。

其基本原理是通过对图像进行小波变换,并利用小波变换系数来进行图像的分析和重建,从而实现图像的融合。

2.3 像素级融合法像素级融合法是一种基于像素级的图像融合方法。

其基本原理是通过对多幅图像的像素进行逐一操作和融合,从而实现图像的融合。

常用的像素级融合方法包括平均像素法、最大像素法和最小像素法等。

三、Matlab实现图像配准与图像融合的步骤3.1 图像配准的实现步骤图像配准的实现步骤包括图像预处理、特征提取、特征匹配和几何变换等。

首先,对图像进行预处理,包括去噪、平滑、增强等操作,以提高图像质量。

在Matlab中进行图像融合与图像叠加的方法与技巧

在Matlab中进行图像融合与图像叠加的方法与技巧引言:随着数字图像处理和计算机视觉领域的发展,图像融合和图像叠加变得越来越重要。

图像融合是指将多幅图像合成为一幅具有更清晰、更丰富信息的图像,而图像叠加则是在保留所叠加图像的原始信息的同时,使图像更加丰富和易于理解。

Matlab作为一种强大的科学计算工具,提供了丰富的图像处理函数和工具箱,可以很方便地进行图像融合与图像叠加。

一、图像融合的方法与技巧1. 融合算法图像融合的基本方法有加权平均法、空间域融合法、频域融合法、小波融合法等。

加权平均法是最简单的方法,通过计算图像像素的平均值来融合。

空间域融合法是通过对直接融合的图像进行空间域操作来提取融合结果。

频域融合法则是通过将图像转换到频域,然后进行频域操作来实现融合。

小波融合法是基于小波变换的方法,利用小波分析的多尺度分解能力对图像进行分析和融合。

根据具体需求和图像的特点,选择合适的融合算法是非常重要的。

2. 图像预处理在进行图像融合之前,通常需要进行图像预处理,以提高融合结果的质量。

常用的图像预处理方法包括灰度拉伸、直方图均衡化、滤波等。

灰度拉伸是通过对图像的像素值进行线性变换,将图像像素值的范围拉伸到合适的范围内,从而增加图像的对比度。

直方图均衡化则是将图像的像素值在灰度直方图上均匀分布,以增强图像的细节。

滤波是通过对图像进行滤波操作,如低通滤波、高通滤波等,以去除图像中的噪声和不需要的细节。

3. 图像融合的策略图像融合的策略可以根据具体需求来选择。

常见的策略包括全局融合和局部融合。

全局融合是将所有图像的信息进行融合,得到整体的融合结果。

而局部融合则是将不同图像的不同区域进行融合,以保留更多的细节和纹理。

根据具体应用和需求,选择合适的融合策略可以使融合结果更加符合实际需求。

4. 参数设置与调整在进行图像融合过程中,不同的算法和方法有各自的参数,根据不同的图像和具体应用,需要适时地进行参数的设置和调整。

图像处理matlab及图像融合图像镶嵌图像拼接

图像处理matlab及图像融合图像镶嵌图像拼接在实际的对图像处理过程中,由于我们读出的图像是unit8型,⽽在MATLAB的矩阵运算中要求所有的运算变量为double型(双精度型)。

因此读出的图像数据不能直接进⾏相加求平均,因此必须使⽤⼀个函数将图像数据转换成双精度型数据。

MATLAB中提供了这样的函数:im2double函数,其语法格式为:I2 = im2double(I1)其中I1是输⼊的图像数据,它可能是unit8或unit16型数据,通过函数的变化输出I2为⼀个double型数据,这样两图像数据就可以⽅便的进⾏相加等代数运算.要把double的图像(范围是0到1)再次转化为256灰度值的,可以这样Igrey= uint8(I2*255)图像类型转换函数:dither() 通过颜⾊抖动,把真彩图像转换成索引图像或灰度图象转换成⼆值图像gray2ind() 将灰度图像(或⼆值图像)转换成索引图像grayslice() 通过设定的阈值将灰度图象转换成索引图像im2bw() 通过设定亮度阈值将灰度、真彩、索引图象转换成⼆值图像ind2gray() 将索引图象转换成灰度图象ind2rgb() 将索引图象转换成真彩⾊图像mat2gray() 将⼀个数据矩阵转换成⼀幅灰度图象rgb2gray() 将真彩转换成灰度图象rgb2ind() 将真彩转换成索引图象图像类型与类型间的转换1。

索引图像:包括⼀个数据矩阵X和⼀个⾊图阵MAP。

矩阵元素值指向MAP中的特定颜⾊向量。

2。

灰度图像:数据矩阵I,I中的数据代表了颜⾊灰度值。

矩阵中的元素可以是double类型、8位或16位⽆符号的整数类型。

3。

RGB图像:即真彩图像。

矩阵中每个元素为⼀个数组,数组的元素定义了像素的红、绿、蓝颜⾊值。

RGB数组可以是double类型、8位或16位⽆符号的整数类型。

4。

⼆值图像:⼀个数据阵列,每个象素只能取0或1。

矩阵的基本运算⾏列式求值:det(A)矩阵加减:+、-矩阵相乘:*矩阵左除:A/B %相当于inv(A)*B矩阵右除:A\B %相当于A*inv(B)矩阵的幂:^矩阵转置:'矩阵求共轭(实部相同,虚部相反):conj(X)矩阵求逆:inv(X)级数的求和与收敛symsum(fun,var,a,b):其中fun是通项表达式,var为求和变量,a为求和起点,b为求和终点例如:I为1/[n*(2n+1)]从1到正⽆穷的和,求Isyms n;f1=1/(n*(2*n+1));I=symsum(f1,n,1,inf)计算结果为:I =2-2*log(2)空间曲⾯mesh()函数语法:mesh(Z):mesh(X,Y,Z,C):其中C是⽤来定义相应点颜⾊等属性的数组例:求x^2+y^2=z的空间曲⾯x=-4:4;y=x;[X,Y]=meshgrid(x,y);%⽣成x,y坐标Z=X.^2+Y.^2;mesh(X,Y,Z)曲⾯图[x,y]=meshgrid(xa,ya) 当xa,ya分别为m维和n维⾏向量,得到x和y均为n⾏m列矩阵。

Matlab中的图像融合和多模态图像分析技术

Matlab中的图像融合和多模态图像分析技术图像处理是一项非常重要的技术,在许多领域都有广泛的应用,如医学影像分析、计算机视觉、遥感图像处理等。

在图像处理中,图像融合和多模态图像分析技术是两个非常重要的方面。

本文将介绍在Matlab中实现图像融合和多模态图像分析的方法和技术。

一、图像融合技术图像融合是指将多个不同模态或不同源的图像融合为一个具有更丰富信息的图像。

在图像融合技术中,常用的方法有像素级融合和特征级融合。

1.1 像素级融合像素级融合是指将多幅图像的像素按照一定的规则进行融合。

在Matlab中,可以使用imfuse函数来实现像素级融合。

该函数可以通过设置不同的融合模式来实现不同的效果,如加权平均、最大值、最小值等。

通过调整各个模态的权重,可以获得不同的融合效果。

1.2 特征级融合特征级融合是指将多幅图像的特征进行融合。

在Matlab中,可以使用特征提取和特征匹配的方法来实现特征级融合。

首先,使用不同的特征提取方法,如SIFT、SURF等,提取多幅图像的特征点。

然后,使用特征匹配的方法,如RANSAC算法,将多幅图像的特征点进行匹配和融合。

最后,根据匹配结果,可以生成一幅具有更丰富信息的图像。

二、多模态图像分析技术多模态图像分析是指对多模态图像进行分析和处理,以获得更全面和准确的信息。

在Matlab中,可以使用多种方法和技术来实现多模态图像分析。

2.1 图像配准图像配准是多模态图像分析的基础,它是将多幅图像进行准确的空间或特征对齐。

在Matlab中,可以使用imregister函数来实现图像配准。

该函数可以通过设置不同的配准方法和参数,如相位相关、归一化互相关等,来实现不同的配准效果。

2.2 图像分割图像分割是将图像中的目标或区域进行划分和提取的过程。

在多模态图像分析中,图像分割可以用来提取不同模态之间的特征。

在Matlab中,可以使用多种图像分割算法,如阈值分割、区域生长、边缘检测等,来实现图像分割。

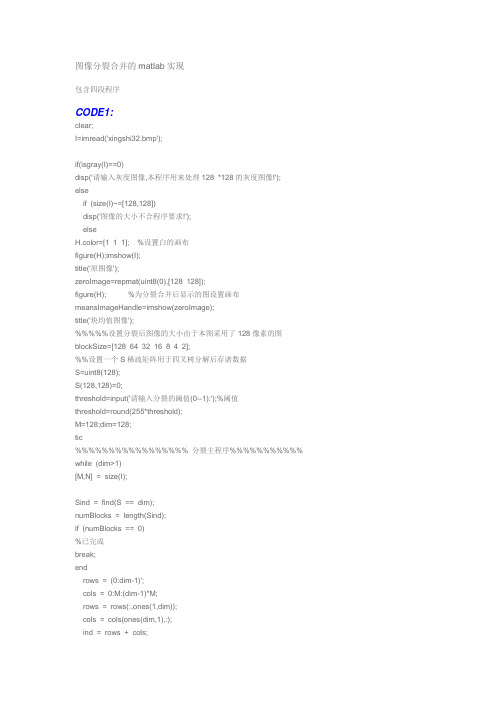

图像分裂合并的matlab实现

图像分裂合并的matlab实现包含四段程序CODE1:clear;I=imread('xingshi32.bmp');if(isgray(I)==0)disp('请输入灰度图像,本程序用来处理128 *128的灰度图像!');elseif (size(I)~=[128,128])disp('图像的大小不合程序要求!');elseH.color=[1 1 1]; %设置白的画布figure(H);imshow(I);title('原图像');zeroImage=repmat(uint8(0),[128 128]);figure(H); %为分裂合并后显示的图设置画布meansImageHandle=imshow(zeroImage);title('块均值图像');%%%%%设置分裂后图像的大小由于本图采用了128像素的图blockSize=[128 64 32 16 8 4 2];%%设置一个S稀疏矩阵用于四叉树分解后存诸数据S=uint8(128);S(128,128)=0;threshold=input('请输入分裂的阈值(0--1):');%阈值threshold=round(255*threshold);M=128;dim=128;tic%%%%%%%%%%%%%%%%% 分裂主程序%%%%%%%%%%% while (dim>1)[M,N] = size(I);Sind = find(S == dim);numBlocks = length(Sind);if (numBlocks == 0)%已完成break;endrows = (0:dim-1)';cols = 0:M:(dim-1)*M;rows = rows(:,ones(1,dim));cols = cols(ones(dim,1),:);ind = rows + cols;ind = ind(:);tmp = repmat(Sind', length(ind), 1);ind = ind(:, ones(1,numBlocks));ind = ind + tmp;blockValues= I(ind);blockValues = reshape(blockValues, [dim dim numBlocks]);if(isempty(Sind))%已完成break;end[i,j]=find(S);set(meansImageHandle,'CData',ComputeMeans(I,S));maxValues=max(max(blockValues,[],1),[],2);minValues=min(min(blockValues,[],1),[],2);doSplit=(double(maxValues)-double(minValues))>threshold;dim=dim/2;Sind=Sind(doSplit);Sind=[Sind;Sind+dim;(Sind+M*dim);(Sind+(M+1)*dim)];S(Sind)=dim;end[i,j]=find(S); % 用来寻找四叉机分解结果中大小为S的块的位置set(meansImageHandle,'CData',ComputeMeans(I,S)); % 显示分解结果块均值图像Numberofbloks=length(i); %计算块数%sizev=size(v);endendtocCODE2:function means = ComputeMeans(I, S)% 用来计算给定图像和稀疏矩阵的块均值% I: 为给定的图像% S: 为稀疏矩阵means = I;for dim = [128 64 32 16 8 4 2 1];values = getblk(I, S, dim);if (~isempty(values))%%%%%以下的句子是将小块的平均值来代替原图像中相应的块处的像素%%%% if (min(min(values))>=60)means = setblk(means, S, dim, 0); %用于合并时的阈值else%means = setblk(means, S, dim, sum(sum(values,1),2) ./ dim^2+std2(values));%means = setblk(means, S, dim, sum(sum(values,1),2) ./ dim^2);%means = setblk(means, S, dim, mean2(values));means = setblk(means, S, dim, max(max(values,1),2));endendendCODE3:function [val,r,c] = getblk(A,S,dim)% I:为待处理的图像% S:为四叉树分解后返回的稀疏矩阵包含四叉树结构% Val是dim * dim*k数组, 包含图像I的四叉树分解中的每个dim *dim 块% k是四叉树分解的dim *dim块的数量% 如果没有指定大小的块那么返回一个空矩阵[M,N] = size(A);Sind = find(S == dim);numBlocks = length(Sind);if (numBlocks == 0) % 没有找到任何模块val = zeros(dim,dim,0); % 返回空矩阵r = zeros(0,1);c = zeros(0,1);return;end% 为dim *dom的块计算索引%%%%%%%%%%%%%%%%%rows = (0:dim-1)';cols = 0:M:(dim-1)*M;rows = rows(:,ones(1,dim));cols = cols(ones(dim,1),:);ind = rows + cols;ind = ind(:);% 计算索引矩阵tmp = repmat(Sind', length(ind), 1);ind = ind(:, ones(1,numBlocks));ind = ind + tmp;val = A(ind);val = reshape(val, [dim dim numBlocks]);CODE4:function B = setblk(A,S,dim,val)% I 为待处理的图像% S:为四叉树分解后的稀疏矩阵包含四叉树结构% Val:是dim * dim *k数组% K :是四叉树分解的dim * dim 大小块的个数% setblk : 用val中相应的dim * dim块的值取代图像A 的四叉树分解中的每个% dim *dim 块[M,N] = size(A);blocks = find(S == dim)';numBlocks = length(blocks);if (~isequal([size(val,1) size(val,2) size(val,3)], [dim dim numBlocks]))if (prod(size(val)) == numBlocks)val = repmat(val(:)',[dim^2 1]);endendval = val(:);% 为每一个块算出一个索引rows = (0:dim-1)';cols = 0:M:(dim-1)*M;rows = rows(:,ones(1,dim));cols = cols(ones(dim,1),:);ind = rows + cols;ind = ind(:);% 依照索引进行替换%%%%%blocks = blocks(ones(length(ind),1),:);ind = ind(:, ones(1,numBlocks));ind = ind + blocks;B = A;B(ind) = val;。