大数据之hadoop分布式集群参数配置

Hadoop集群配置与数据处理入门

Hadoop集群配置与数据处理入门1. 引言Hadoop是一个开源的分布式计算框架,被广泛应用于大规模数据处理和存储。

在本文中,我们将介绍Hadoop集群的配置和数据处理的基本概念与入门知识。

2. Hadoop集群配置2.1 硬件要求架设Hadoop集群需要一定的硬件资源支持。

通常,集群中包含主节点和若干个从节点。

主节点负责整个集群的管理,而从节点负责执行具体的计算任务。

在硬件要求方面,主节点需要具备较高的计算能力和存储空间。

从节点需要具备较低的计算能力和存储空间,但数量较多。

此外,网络带宽也是一个关键因素。

较高的网络带宽可以加快数据的传输速度,提升集群的效率。

2.2 软件要求Hadoop运行在Java虚拟机上,所以首先需要确保每台主机都安装了适当版本的Java。

其次,需要安装Hadoop分发版本,如Apache Hadoop或Cloudera等。

针对集群管理,可以选择安装Hadoop的主节点管理工具,如Apache Ambari或Cloudera Manager。

这些工具可以帮助用户轻松管理集群的配置和状态。

2.3 配置文件Hadoop集群部署需要配置多个文件。

其中,最重要的是核心配置文件core-site.xml、hdfs-site.xml和yarn-site.xml。

core-site.xml配置Hadoop的核心参数,如文件系统和输入输出配置等;hdfs-site.xml用于配置Hadoop分布式文件系统;yarn-site.xml配置Hadoop资源管理器和任务调度器相关的参数。

3. 数据处理入门3.1 数据存储与处理Hadoop的核心之一是分布式文件系统(HDFS),它是Hadoop集群的文件系统,能够在集群中存储海量数据。

用户可以通过Hadoop的命令行工具或API进行文件的读取、写入和删除操作。

3.2 数据处理模型MapReduce是Hadoop的编程模型。

它将大规模的数据集拆分成小的数据块,并分配给集群中的多个计算节点进行并行处理。

hadoop完全分布式配置过程详解

hadoop完全分布式配置过程详解Hadoop全分布搭建⼀.今⽇任务hadoop完全分布式系统搭建⼆.任务内容1.准备软件hadoop-2.6.0-cdh5.7.0.tar.gzjdk-8u161-linux-x64.tar.gzCentos-6.5VirtualBox-5.2.18-124319-Win.exe1. 配置过程第⼀步:配置免密登录1. 新建虚拟机,设置静态ip地址,主机名master,ip以及主机名映射1. 配置免密登陆1. 启动ssh服务Service sshd start1. 配置免密登录,更新公钥第⼆步:复制虚拟机,更改ip主机名和ip映射,分别配置56.2 主机名master,56.3 主机名 slaver1,56.4 主机名slaver2第三步:上传jdk和hadoop到 hadoop⽤户⽬录使⽤sftp上传jdk和hadoop的压缩包到hadoop⽤户⽬录下第四步:jdk和hadoop配置1. 解压⽂件1. 配置环境变量1. 配置hadoop⽂件1. core-site.xml2.hdfs-site.Xml1. mapred-site.xml1. Yarn-site.xml1. Slaver1. 将jdk和hadoop⽂件分发到slaver1 和slaver21. 在master格式化hdfs的namenode 并且启动hdfs,使⽤jps验证启动三.遇到问题1.复制虚拟机后需要⼀个个更改ip包括映射等2.配置好之后启动 slaver1 和slaver2 均没有Java环境,但是jdk已配好四.处理⽅式Slaver1 和slaver2 配置成功环境变量但是启动时提⽰没有java环境的问题,解决⽅式是在master配置好之后,启动时显⽰6个进程,表⽰master主机hadoop⽂件已经全部配置,然后使⽤远程将 master配置好的 hadoop⽂件分发到slaver1和slaver2总结:1. 此处配置主机名和ip映射时,直接将所有的全部配置,以便复制虚拟机时不需要继续修改2. 配置java环境时,确保系统本⾝没有已经安装好的jdk安装包,有则删除3. 配置好环境变量,需要使⽤ source使其⽣效4. 分发⽂件时,最好是将master配置好的hadoop⽂件分发过去,避免出现其他问题5. 启动成功后,master有5个进程,slaver都只有2个进程。

hadoop集群配置

集群上部署HADOOP,构建HDFS(1)分布式计算开源框架Hadoop入门实践其实参看Hadoop官方文档已经能够很容易配置分布式框架运行环境了,不过这里既然写了就再多写一点,同时有一些细节需要注意的也说明一下,其实也就是这些细节会让人摸索半天。

Hadoop可以单机跑,也可以配置集群跑,单机跑就不需要多说了,只需要按照Demo的运行说明直接执行命令即可。

这里主要重点说一下集群配置运行的过程。

1环境7台普通的机器,操作系统都是Linux。

内存和CPU就不说了,反正Hadoop一大特点就是机器在多不在精。

JDK必须是1.5以上的,这个切记。

7台机器的机器名务必不同,后续会谈到机器名对于MapReduce有很大的影响。

2部署考虑正如上面我描述的,对于Hadoop的集群来说,可以分成两大类角色:Master和Slave,前者主要配置NameNode和JobTracker的角色,负责总管分布式数据和分解任务的执行,后者配置DataNode和TaskTracker的角色,负责分布式数据存储以及任务的执行。

本来我打算看看一台机器是否可以配置成Master,同时也作为Slave使用,不过发现在NameNode初始化的过程中以及TaskTracker执行过程中机器名配置好像有冲突(NameNode和TaskTracker对于Hosts的配置有些冲突,究竟是把机器名对应IP放在配置前面还是把Localhost对应IP放在前面有点问题,不过可能也是我自己的问题吧,这个大家可以根据实施情况给我反馈)。

最后反正决定一台Master,六台Slave,后续复杂的应用开发和测试结果的比对会增加机器配置。

3实施步骤1.在所有的机器上都建立相同的目录,也可以就建立相同的用户,以该用户的home路径来做hadoop的安装路径。

例如我在所有的机器上都建立了/home/wenchu。

2.下载Hadoop,先解压到Master上。

这里我是下载的0.17.1的版本。

hadoop集群安装配置的主要操作步骤-概述说明以及解释

hadoop集群安装配置的主要操作步骤-概述说明以及解释1.引言1.1 概述Hadoop是一个开源的分布式计算框架,主要用于处理和存储大规模数据集。

它提供了高度可靠性、容错性和可扩展性的特性,因此被广泛应用于大数据处理领域。

本文旨在介绍Hadoop集群安装配置的主要操作步骤。

在开始具体的操作步骤之前,我们先对Hadoop集群的概念进行简要说明。

Hadoop集群由一组互联的计算机节点组成,其中包含了主节点和多个从节点。

主节点负责调度任务并管理整个集群的资源分配,而从节点则负责实际的数据存储和计算任务执行。

这种分布式的架构使得Hadoop可以高效地处理大规模数据,并实现数据的并行计算。

为了搭建一个Hadoop集群,我们需要进行一系列的安装和配置操作。

主要的操作步骤包括以下几个方面:1. 硬件准备:在开始之前,需要确保所有的计算机节点都满足Hadoop的硬件要求,并配置好网络连接。

2. 软件安装:首先,我们需要下载Hadoop的安装包,并解压到指定的目录。

然后,我们需要安装Java开发环境,因为Hadoop是基于Java 开发的。

3. 配置主节点:在主节点上,我们需要编辑Hadoop的配置文件,包括核心配置文件、HDFS配置文件和YARN配置文件等。

这些配置文件会影响到集群的整体运行方式和资源分配策略。

4. 配置从节点:与配置主节点类似,我们也需要在每个从节点上进行相应的配置。

从节点的配置主要包括核心配置和数据节点配置。

5. 启动集群:在所有节点的配置完成后,我们可以通过启动Hadoop 集群来进行测试和验证。

启动过程中,我们需要确保各个节点之间的通信正常,并且集群的各个组件都能够正常启动和工作。

通过完成以上这些操作步骤,我们就可以成功搭建一个Hadoop集群,并开始进行大数据的处理和分析工作了。

当然,在实际应用中,还会存在更多的细节和需要注意的地方,我们需要根据具体的场景和需求进行相应的调整和扩展。

Hadoop集群配置心得(低配置集群+自动同步配置)

Hadoop集群配置⼼得(低配置集群+⾃动同步配置)本⽂为本⼈原创,⾸发到炼数成⾦。

情况是这样的,我没有⼀个⾮常强劲的电脑来搞出⼀个性能⾮常NB的服务器集群,相信很多⼈也跟我差不多,所以现在把我的低配置集群经验拿出来写⼀下好了。

我的配备:1)五六年前的赛扬单核处理器2G内存笔记本 2)公司给配的ThinkpadT420,i5双核处理器4G内存(可⽤内存只有3.4G,是因为装的是32位系统的缘故吧。

)就算是⽤公司配置的电脑,做出来三台1G内存的虚拟机也显然是不现实的。

企业笔记本运⾏的软件多啊,什么都不做空余内存也才不到3G。

所以呢,我的想法就是:⽤我⾃⼰的笔记本(简称PC1)做Master节点,⽤来跑Jobtracker,Namenode 和SecondaryNamenode;⽤公司的笔记本跑两个虚拟机(简称VM1和VM2),⽤来做Slave节点,跑Tasktracker和Datanode。

这么做的话,就需要让PC1,VM1和VM2处于同⼀个⽹段⾥,保证他们之间可以互相连通。

⽹络环境:我的两台电脑都是通过⼀个⽆线路由上⽹。

构建跟外部的电脑同⼀⽹段的虚拟机配置过程:准备⼯作:构建⼀个集群,⾸先前提条件是每台服务器都要有⼀个固定的IP地址,然后才可能进⾏后续的操作。

所以呢,先把我的两台笔记本电脑全部设置成固定IP(注意,如果像我⼀样使⽤⽆线路由上⽹,那就要把⽆线⽹卡的IP设置成固定IP)。

⽤来做Master节点的PC1:192.168.33.150,⽤来跑虚拟机的宿主笔记本:192.168.33.157。

⽬标:VM1和VM2的IP地址分别设置成192.168.33.151和152。

步骤:1)新建VM1虚拟机。

2)打开VM1的⽹卡设置界⾯,连接⽅式选Bridge。

(桥接)关于桥接的具体信息,可以百度⼀下。

我们需要知道的,就是⽤桥接的⽅式,可以让虚拟机通过本机的⽹关来上⽹,所以就可以跟本机处于同⼀个⽹段,互相之间可以进⾏通信。

大数据--Hadoop集群环境搭建

⼤数据--Hadoop集群环境搭建⾸先我们来认识⼀下HDFS, HDFS(Hadoop Distributed File System )Hadoop分布式⽂件系统。

它其实是将⼀个⼤⽂件分成若⼲块保存在不同服务器的多个节点中。

通过联⽹让⽤户感觉像是在本地⼀样查看⽂件,为了降低⽂件丢失造成的错误,它会为每个⼩⽂件复制多个副本(默认为三个),以此来实现多机器上的多⽤户分享⽂件和存储空间。

Hadoop主要包含三个模块:HDFS模块:HDFS负责⼤数据的存储,通过将⼤⽂件分块后进⾏分布式存储⽅式,突破了服务器硬盘⼤⼩的限制,解决了单台机器⽆法存储⼤⽂件的问题,HDFS是个相对独⽴的模块,可以为YARN提供服务,也可以为HBase等其他模块提供服务。

YARN模块:YARN是⼀个通⽤的资源协同和任务调度框架,是为了解决Hadoop中MapReduce⾥NameNode负载太⼤和其他问题⽽创建的⼀个框架。

YARN是个通⽤框架,不⽌可以运⾏MapReduce,还可以运⾏Spark、Storm等其他计算框架。

MapReduce模块:MapReduce是⼀个计算框架,它给出了⼀种数据处理的⽅式,即通过Map阶段、Reduce阶段来分布式地流式处理数据。

它只适⽤于⼤数据的离线处理,对实时性要求很⾼的应⽤不适⽤。

多相关信息可以参考博客:。

本节将会介绍Hadoop集群的配置,⽬标主机我们可以选择虚拟机中的多台主机或者多台阿⾥云服务器。

注意:以下所有操作都是在root⽤户下执⾏的,因此基本不会出现权限错误问题。

⼀、Vmware安装VMware虚拟机有三种⽹络模式,分别是Bridged(桥接模式)、NAT(⽹络地址转换模式)、Host-only(主机模式):桥接:选择桥接模式的话虚拟机和宿主机在⽹络上就是平级的关系,相当于连接在同⼀交换机上;NAT:NAT模式就是虚拟机要联⽹得先通过宿主机才能和外⾯进⾏通信;仅主机:虚拟机与宿主机直接连起来。

HADOOP大数据平台配置方法(懒人版)

HADOOP大数据平台配置方法(完全分布式,懒人版)一、规划1、本系统包括主节点1个,从节点3个,用Vmware虚拟机实现;2、主节点hostname设为hadoop,IP地址设为192.168.137.100;3、从节点hostname分别设为slave01、slave02,slave03,IP地址设为192.168.137.201、192.168.137.202、192.168137.203。

今后如要扩充节点,依此类推;基本原理:master及slave机器的配置基本上是一样的,所以我们的操作方式就是先配置好一台机器,然后克隆3台机器出来。

这样可以节省大量的部署时间,降低出错的概率。

安装配置第一台机器的时候,一定要仔细,否则一台机器错了所有的机器都错了。

二、前期准备1、在Vmware中安装一台CentOS虚拟机;2、设置主机名(假设叫hadoop)、IP地址,修改hosts文件;3、关闭防火墙;4、删除原有的JRE,安装JDK,设置环境变量;5、设置主节点到从节点的免密码登录(此处先不做,放在第七步做);三、安装Hadoop在hadoop机上以root身份登录系统,按以下步骤安装hadoop:1、将hadoop-1.0.4.tar.gz复制到/usr 目录;2、用cd /usr命令进入/usr目录,用tar –zxvf hadoop-1.0.4.tar.gz进行解压,得到一个hadoop-1.0.4目录;3、为简单起见,用mv hadoop-1.0.4 hadoop命令将hadoop-1.0.4文件夹改名为hadoop;4、用mkdir /usr/hadoop/tmp命令,在hadoop文件夹下面建立一个tmp目录;5、用vi /etc/profile 修改profile文件,在文件最后添加以下内容:export HADOOP_HOME=/usr/hadoopexport PATH=$PATH:$HADOOP_HOME/bin6、用source /usr/profile命令使profile 立即生效;四、配置HadoopHadoop配置文件存放在/usr/hadoop/conf目录下,本次有4个文件需要修改。

Hadoop集群配置(最全面总结)

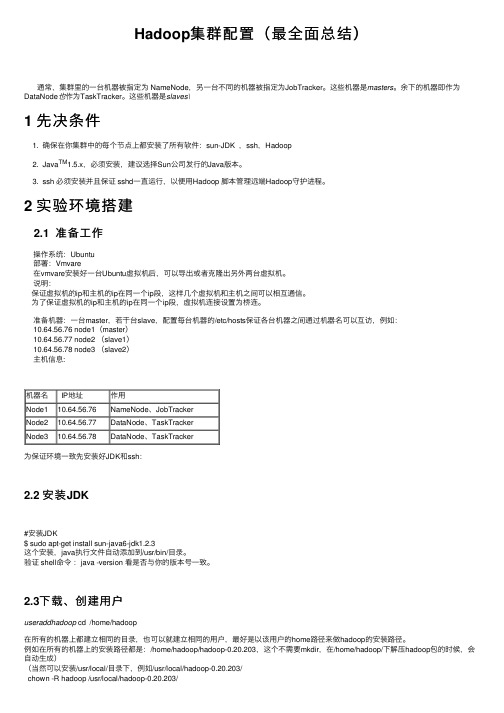

Hadoop集群配置(最全⾯总结)通常,集群⾥的⼀台机器被指定为 NameNode,另⼀台不同的机器被指定为JobTracker。

这些机器是masters。

余下的机器即作为DataNode也作为TaskTracker。

这些机器是slaves\1 先决条件1. 确保在你集群中的每个节点上都安装了所有软件:sun-JDK ,ssh,Hadoop2. Java TM1.5.x,必须安装,建议选择Sun公司发⾏的Java版本。

3. ssh 必须安装并且保证 sshd⼀直运⾏,以便⽤Hadoop 脚本管理远端Hadoop守护进程。

2 实验环境搭建2.1 准备⼯作操作系统:Ubuntu部署:Vmvare在vmvare安装好⼀台Ubuntu虚拟机后,可以导出或者克隆出另外两台虚拟机。

说明:保证虚拟机的ip和主机的ip在同⼀个ip段,这样⼏个虚拟机和主机之间可以相互通信。

为了保证虚拟机的ip和主机的ip在同⼀个ip段,虚拟机连接设置为桥连。

准备机器:⼀台master,若⼲台slave,配置每台机器的/etc/hosts保证各台机器之间通过机器名可以互访,例如:10.64.56.76 node1(master)10.64.56.77 node2 (slave1)10.64.56.78 node3 (slave2)主机信息:机器名 IP地址作⽤Node110.64.56.76NameNode、JobTrackerNode210.64.56.77DataNode、TaskTrackerNode310.64.56.78DataNode、TaskTracker为保证环境⼀致先安装好JDK和ssh:2.2 安装JDK#安装JDK$ sudo apt-get install sun-java6-jdk1.2.3这个安装,java执⾏⽂件⾃动添加到/usr/bin/⽬录。

验证 shell命令:java -version 看是否与你的版本号⼀致。

hadoop2.7.7分布式集群安装与配置

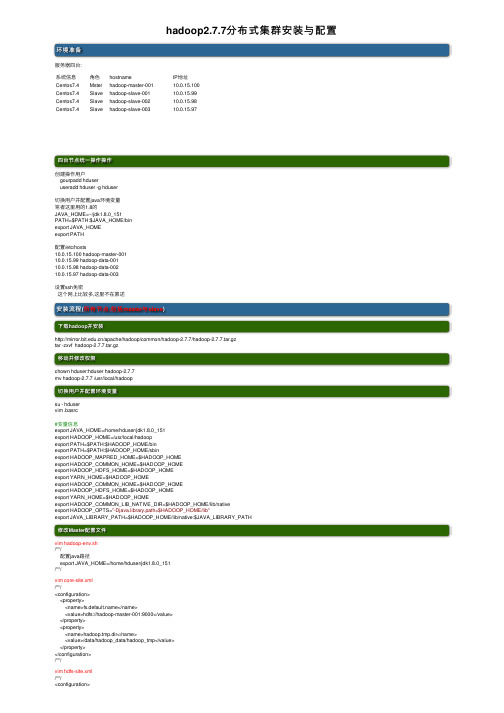

hadoop2.7.7分布式集群安装与配置环境准备服务器四台:系统信息⾓⾊hostname IP地址Centos7.4Mster hadoop-master-00110.0.15.100Centos7.4Slave hadoop-slave-00110.0.15.99Centos7.4Slave hadoop-slave-00210.0.15.98Centos7.4Slave hadoop-slave-00310.0.15.97四台节点统⼀操作操作创建操作⽤户gourpadd hduseruseradd hduser -g hduser切换⽤户并配置java环境变量笔者这⾥⽤的1.8的JAVA_HOME=~/jdk1.8.0_151PATH=$PATH:$JAVA_HOME/binexport JAVA_HOMEexport PATH配置/etc/hosts10.0.15.100 hadoop-master-00110.0.15.99 hadoop-data-00110.0.15.98 hadoop-data-00210.0.15.97 hadoop-data-003设置ssh免密这个⽹上⽐较多,这⾥不在累述安装流程(所有节点,包括master 与slave)下载hadoop 并安装/apache/hadoop/common/hadoop-2.7.7/hadoop-2.7.7.tar.gztar -zxvf hadoop-2.7.7.tar.gz移动并修改权限chown hduser:hduser hadoop-2.7.7mv hadoop-2.7.7 /usr/local/hadoop切换⽤户并配置环境变量su - hduservim .basrc#变量信息export JAVA_HOME=/home/hduser/jdk1.8.0_151export HADOOP_HOME=/usr/local/hadoopexport PATH=$PATH:$HADOOP_HOME/binexport PATH=$PATH:$HADOOP_HOME/sbinexport HADOOP_MAPRED_HOME=$HADOOP_HOMEexport HADOOP_COMMON_HOME=$HADOOP_HOMEexport HADOOP_HDFS_HOME=$HADOOP_HOMEexport YARN_HOME=$HADOOP_HOMEexport HADOOP_COMMON_HOME=$HADOOP_HOMEexport HADOOP_HDFS_HOME=$HADOOP_HOMEexport YARN_HOME=$HADOOP_HOMEexport HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/nativeexport HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib"export JAVA_LIBRARY_PATH=$HADOOP_HOME/lib/native:$JAVA_LIBRARY_PATH修改Master配置⽂件vim hadoop-env.sh/**/配置java路径export JAVA_HOME=/home/hduser/jdk1.8.0_151/**/vim core-site.xml/**/<configuration><property><name></name><value>hdfs://hadoop-master-001:9000</value></property><property><name>hadoop.tmp.dir</name><value>/data/hadoop_data/hadoop_tmp</value></property></configuration>/**/vim hdfs-site.xml/**/<configuration><property><name>dfs.replication</name><value>3</value></property><property><name>.dir</name><value>file:/data/hadoop_data/hdfs/namenode</value> #创建真实的路径⽤来存放名称节点 </property><property><name>dfs.datanode.data.dir</name><value>file:/data/hadoop_data/hdfs/datanode</value> #创建真实的路径⽤了存放数据</property></configuration>/**/vim mapred-site.xml/**/<configuration><property><name></name><value>yarn</value></property></configuration>/**/vim yarn-site.xml/**/<configuration><property><name>yarn.resourcemanager.hostname</name><value>hadoop-master-001</value></property><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><property><name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name><value>org.apache.hadoop.mapred.ShuffleHandler</value></property><property><name>yarn.resourcemanager.address</name><value>hadoop-master-001:8050</value></property><property><name>yarn.resourcemanager.scheduler.address</name><value>hadoop-master-001:8030</value></property><property><name>yarn.resourcemanager.resource-tracker.address</name><value>hadoop-master-001:8025</value></property>#使⽤hadoop yarn运⾏pyspark时,不添加下⾯两个参数会报错<property><name>yarn.nodemanager.pmem-check-enabled</name><value>false</value></property><property><name>yarn.nodemanager.vmem-check-enabled</name><value>false</value></property></configuration>/**/修改Slave配置⽂件vim hadoop-env.sh/**/配置java路径export JAVA_HOME=/home/hduser/jdk1.8.0_151/**/vim core-site.xml/**/<configuration><property><name></name><value>hdfs://hadoop-master-001:9000</value></property><property><name>hadoop.tmp.dir</name><value>/data/hadoop_data/hadoop_tmp</value></property></configuration>/**/vim hdfs-site.xml/**/<configuration><property><name>dfs.replication</name><value>3</value></property><property><name>dfs.datanode.data.dir</name><value>file:/home/data/hadoop_data/hdfs/datanode</value></property></configuration>/**/vim mapred-site.xml/**/<configuration><property><name>mapred.job.tracker</name><value>hadoop-master-001:54311</value></property></configuration>/**/vim yarn-site.xml/**/<configuration><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><property><name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name><value>org.apache.hadoop.mapred.ShuffleHandler</value></property><property><name>yarn.resourcemanager.address</name><value>hadoop-master-001:8050</value></property><property><name>yarn.resourcemanager.scheduler.address</name><value>hadoop-master-001:8030</value></property><property><name>yarn.resourcemanager.resource-tracker.address</name><value>hadoop-master-001:8025</value></property>#使⽤hadoop yarn运⾏pyspark时,不添加下⾯两个参数会报错<property><name>yarn.nodemanager.pmem-check-enabled</name><value>false</value></property><property><name>yarn.nodemanager.vmem-check-enabled</name><value>false</value></property></configuration>/**/其他操作(所有节点,包括master与slave)#执⾏hadoop 命令报WARNING解决办法vim log4j.properties添加如下⾏.apache.hadoop.util.NativeCodeLoader=ERROR启动操作安装并配置完成后返回master节点格式化namenodecd /data/hadoop_data/hdfs/namenodehadoop namenode -format在master节点执⾏命令start-all.sh //启动stop-all.sh //关闭异常处理hadoop数据节点查看hdfs⽂件时:ls: No Route to Host from hadoop-data-002/10.0.15.98 to hadoop-master-001:9000 failed on socket timeout exception: .NoRouteToHostException: 没有到主机的路由; For more details see: http:解决⽅式数据节点telnet namenode的9000端⼝正常原因/etc/hosts中主机名与ip地址不符或者端⼝未开放防⽕墙引起效果图扩展连接。

hadoop0.20.2集群配置

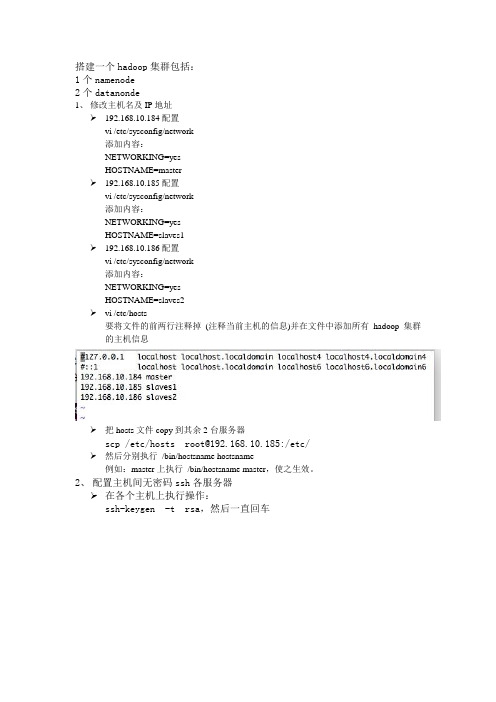

搭建一个hadoop集群包括:1个namenode2个datanonde1、修改主机名及IP地址192.168.10.184配置vi /etc/sysconfig/network添加内容:NETWORKING=yesHOSTNAME=master192.168.10.185配置vi /etc/sysconfig/network添加内容:NETWORKING=yesHOSTNAME=slaves1192.168.10.186配置vi /etc/sysconfig/network添加内容:NETWORKING=yesHOSTNAME=slaves2vi /etc/hosts要将文件的前两行注释掉(注释当前主机的信息)并在文件中添加所有hadoop集群的主机信息把hosts文件copy到其余2台服务器scp /etc/hosts root@192.168.10.185:/etc/然后分别执行/bin/hostsname hostsname例如:master上执行/bin/hostsname master,使之生效。

2、配置主机间无密码ssh各服务器在各个主机上执行操作:ssh-keygen -t rsa,然后一直回车在/root/.ssh/目录下生成了两个文件 id_rsa 和 id_rsa.pubcp id_rsa.pub authorized_keys修改authorized_keys的权限为600chmod 600 ~/.ssh/authorized_keys先将所有authorized_keys合并cat ~/.ssh/authorized_keys | ssh root@192.168.10.167 'cat >> ~/ .ssh/authorized_keys'合并结果如下图:然后复制分发到其他服务器(若没有.ssh文件夹需要自行创建)scp authorized_keys root@192.168.10.185:/root/.ssh/ 验证能否无密码ssh,在master服务器上执行操作:注意:第一次可能会提示输入yes or no,之后就可以直接ssh到其他主机上去了。

Hadoop2.7.3完全分布式集群搭建_光环大数据培训

Hadoop2.7.3完全分布式集群搭建_光环大数据培训光环大数据培训认为,集群如下:192.168.188.111 master192.168.188.112 slave1192.168.188.113 slave2一、环境配置1.修改hosts和hostname以master为例:修改hosts[[email protected] ~]# vim /etc/hosts192.168.188.111 master192.168.188.112 slave1192.168.188.113 slave2修改hostname[[email protected] ~]# vim /etc/hostname同样地,在slave1和slave2做相同的hostname操作,分别命名为slave1和slave2.然后分别把slave1和slave2的hosts文件更改为和master一样。

2.配免密登录次文章重点不在配免密登录,所有略,可以看其他博客。

3.配置环境变量[[email protected] ~]# vim /etc/profile#javaexport JAVA_HOME=/root/package/jdk1.8.0_121export PATH=$PATH:$JAVA_ HOME/bin#sparkexport SPARK_HOME=/root/package/spark-2.1.0-bin-hadoop2.7e xport PATH=$PATH:$SPARK_HOME/bin#ANACONDAexport ANACONDA=/root/anaconda2 export PATH=$PATH:$ANACONDA/bin#HADOOPexport HADOOP_HOME=/root/package/h adoop-2.7.3export HADOOP_MAPRED_HOME=$HADOOP_HOMEexport HADOOP_COMMON_HO ME=$HADOOP_HOMEexport HADOOP_HDFS_HOME=$HADOOP_HOMEexport YARN_HOME=$HAD OOP_HOMEexport HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/nativeexpor t PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/binexport HADOOP_INSTALL=$HA DOOP_HOME输入source /etc/profile 使配置文件生效。

Hadoop分布式文件系统的配置与使用教程

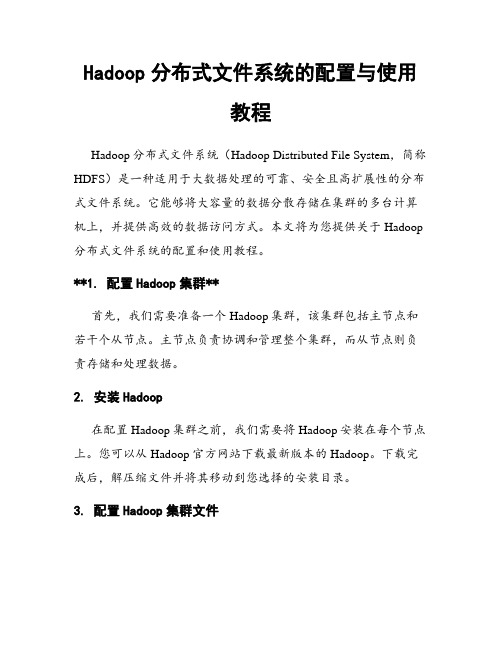

Hadoop分布式文件系统的配置与使用教程Hadoop分布式文件系统(Hadoop Distributed File System,简称HDFS)是一种适用于大数据处理的可靠、安全且高扩展性的分布式文件系统。

它能够将大容量的数据分散存储在集群的多台计算机上,并提供高效的数据访问方式。

本文将为您提供关于Hadoop 分布式文件系统的配置和使用教程。

**1. 配置Hadoop集群**首先,我们需要准备一个Hadoop集群,该集群包括主节点和若干个从节点。

主节点负责协调和管理整个集群,而从节点则负责存储和处理数据。

2. 安装Hadoop在配置Hadoop集群之前,我们需要将Hadoop安装在每个节点上。

您可以从Hadoop官方网站下载最新版本的Hadoop。

下载完成后,解压缩文件并将其移动到您选择的安装目录。

3. 配置Hadoop集群文件在配置Hadoop集群之前,您需要对一些配置文件进行修改。

这些配置文件位于Hadoop的安装目录中的“etc/hadoop”文件夹中。

以下是一些需要注意的主要配置文件:- core-site.xml: 设置Hadoop核心属性,如HDFS的命名节点和文件系统的URI。

- hdfs-site.xml: 配置HDFS的属性,如数据块大小、副本数量等。

- mapred-site.xml:配置Hadoop MapReduce属性,如MapReduce框架的任务分配方式等。

- yarn-site.xml:配置Hadoop资源管理器(YARN)属性,如内存和CPU分配等。

配置完成后,将这些文件复制到Hadoop集群的每个节点。

4. 格式化文件系统在配置完成后,我们需要格式化HDFS文件系统以准备存储数据。

在主节点上, 打开终端并使用以下命令格式化文件系统:```hadoop namenode -format```5. 启动Hadoop集群在所有节点上启动Hadoop集群。

首先进入Hadoop的安装目录并输入以下命令:```start-dfs.sh```这个命令将启动HDFS服务。

最新Hadoop集群部署(最全面)

Hadoop 集群配置(最全面)您的评价: 收藏该经验通常,集群里的一台机器被指定为NameNode,另一台不同的机器被指定为JobTracker。

这些机器是masters。

余下的机器即作为DataNode 也作为TaskTracker。

这些机器是slaves\官方地址:(/common/docs/r0.19.2/cn/cluster_setup.html)1 先决条件1.确保在你集群中的每个节点上都安装了所有必需软件:sun-JDK ,ssh,Hadoop2.Java TM1.5.x,必须安装,建议选择Sun公司发行的Java版本。

3.ssh必须安装并且保证sshd一直运行,以便用Hadoop 脚本管理远端Hadoop守护进程。

2 实验环境搭建2.1 准备工作操作系统:Ubuntu部署:Vmvare在vmvare安装好一台Ubuntu虚拟机后,可以导出或者克隆出另外两台虚拟机。

准备机器:一台master,若干台slave,配置每台机器的/etc/hosts 保证各台机器之间通过机器名可以互访,例如:10.64.56.76 node1(master)10.64.56.77 node2 (slave1)10.64.56.78 node3 (slave2)主机信息:机器名IP地址作用Node1 10.64.56.76 NameNode、JobTrackerNode2 10.64.56.77 DataNode、TaskTrackerNode3 10.64.56.78 DataNode、TaskTracker为保证环境一致先安装好JDK和ssh:2.2 安装JDK#安装JDK$ sudo apt-get install sun-java6-jdk1.2.3这个安装,java执行文件自动添加到/usr/bin/目录。

验证 shell命令:java -version 看是否与你的版本号一致。

2.3下载、创建用户在所有的机器上都建立相同的目录,也可以就建立相同的用户,以该用户的home 路径来做hadoop的安装路径。

Hadoop大数据开发基础教案Hadoop集群的搭建及配置教案

Hadoop大数据开发基础教案-Hadoop集群的搭建及配置教案教案章节一:Hadoop简介1.1 课程目标:了解Hadoop的发展历程及其在大数据领域的应用理解Hadoop的核心组件及其工作原理1.2 教学内容:Hadoop的发展历程Hadoop的核心组件(HDFS、MapReduce、YARN)Hadoop的应用场景1.3 教学方法:讲解与案例分析相结合互动提问,巩固知识点教案章节二:Hadoop环境搭建2.1 课程目标:学会使用VMware搭建Hadoop虚拟集群掌握Hadoop各节点的配置方法2.2 教学内容:VMware的安装与使用Hadoop节点的规划与创建Hadoop配置文件(hdfs-site.xml、core-site.xml、yarn-site.xml)的编写与配置2.3 教学方法:演示与实践相结合手把手教学,确保学生掌握每个步骤教案章节三:HDFS文件系统3.1 课程目标:理解HDFS的设计理念及其优势掌握HDFS的搭建与配置方法3.2 教学内容:HDFS的设计理念及其优势HDFS的架构与工作原理HDFS的搭建与配置方法3.3 教学方法:讲解与案例分析相结合互动提问,巩固知识点教案章节四:MapReduce编程模型4.1 课程目标:理解MapReduce的设计理念及其优势学会使用MapReduce解决大数据问题4.2 教学内容:MapReduce的设计理念及其优势MapReduce的编程模型(Map、Shuffle、Reduce)MapReduce的实例分析4.3 教学方法:互动提问,巩固知识点教案章节五:YARN资源管理器5.1 课程目标:理解YARN的设计理念及其优势掌握YARN的搭建与配置方法5.2 教学内容:YARN的设计理念及其优势YARN的架构与工作原理YARN的搭建与配置方法5.3 教学方法:讲解与案例分析相结合互动提问,巩固知识点教案章节六:Hadoop生态系统组件6.1 课程目标:理解Hadoop生态系统的概念及其重要性熟悉Hadoop生态系统中的常用组件6.2 教学内容:Hadoop生态系统的概念及其重要性Hadoop生态系统中的常用组件(如Hive, HBase, ZooKeeper等)各组件的作用及相互之间的关系6.3 教学方法:互动提问,巩固知识点教案章节七:Hadoop集群的调优与优化7.1 课程目标:学会对Hadoop集群进行调优与优化掌握Hadoop集群性能监控的方法7.2 教学内容:Hadoop集群调优与优化原则参数调整与优化方法(如内存、CPU、磁盘I/O等)Hadoop集群性能监控工具(如JMX、Nagios等)7.3 教学方法:讲解与案例分析相结合互动提问,巩固知识点教案章节八:Hadoop安全与权限管理8.1 课程目标:理解Hadoop安全的重要性学会对Hadoop集群进行安全配置与权限管理8.2 教学内容:Hadoop安全概述Hadoop的认证与授权机制Hadoop安全配置与权限管理方法8.3 教学方法:互动提问,巩固知识点教案章节九:Hadoop实战项目案例分析9.1 课程目标:学会运用Hadoop解决实际问题掌握Hadoop项目开发流程与技巧9.2 教学内容:真实Hadoop项目案例介绍与分析Hadoop项目开发流程(需求分析、设计、开发、测试、部署等)Hadoop项目开发技巧与最佳实践9.3 教学方法:案例分析与讨论团队协作,完成项目任务教案章节十:Hadoop的未来与发展趋势10.1 课程目标:了解Hadoop的发展现状及其在行业中的应用掌握Hadoop的未来发展趋势10.2 教学内容:Hadoop的发展现状及其在行业中的应用Hadoop的未来发展趋势(如Big Data生态系统的演进、与大数据的结合等)10.3 教学方法:讲解与案例分析相结合互动提问,巩固知识点重点和难点解析:一、Hadoop生态系统的概念及其重要性重点:理解Hadoop生态系统的概念,掌握生态系统的组成及相互之间的关系。

Hadoop集群的搭建和配置

Hadoop集群的搭建和配置Hadoop是一种分布式计算框架,它可以解决大数据处理和分析的问题。

Hadoop由Apache软件基金会开发和维护,它支持可扩展性、容错性、高可用性的分布式计算,并且可以运行在廉价的硬件设备上。

Hadoop集群的搭建和配置需要多个步骤,包括安装Java环境、安装Hadoop软件、配置Hadoop集群、启动Hadoop集群。

以下是这些步骤的详细说明。

第一步:安装Java环境Hadoop运行在Java虚拟机上,所以首先需要安装Java环境。

在Linux系统下,可以使用以下命令安装Java环境。

sudo apt-get install openjdk-8-jdk在其他操作系统下,安装Java环境的方式可能有所不同,请查阅相应的文档。

第二步:安装Hadoop软件Hadoop可以从Apache官方网站上下载最新版本的软件。

下载后,解压缩到指定的目录下即可。

解压缩后的目录结构如下:bin/:包含了Hadoop的可执行文件conf/:包含了Hadoop的配置文件lib/:包含了Hadoop的类库文件sbin/:包含了Hadoop的系统管理命令share/doc/:包含了Hadoop的文档第三步:配置Hadoop集群配置Hadoop集群需要编辑Hadoop的配置文件。

其中最重要的是hadoop-env.sh、core-site.xml、hdfs-site.xml和mapred-site.xml。

hadoop-env.sh:这个文件定义了Hadoop集群的环境变量。

用户需要设置JAVA_HOME、HADOOP_HOME等环境变量的值。

core-site.xml:这个文件定义了Hadoop文件系统的访问方式。

用户需要设置、hadoop.tmp.dir等参数的值。

hdfs-site.xml:这个文件定义了Hadoop分布式文件系统的配置信息。

用户需要设置.dir、dfs.data.dir等参数的值。

CDH5.1.0hadoop-2.3.( 2+3 )0完全分布式集群配置及HA配置

Hadoop-2.3.0-cdh5.1.0完全分布式集群配置及HA配置(冰峰)方式: 2个master + 3个slave hadoop-2.3.0-cdh5.1.0完全分布式集群配置HA配置重点说明:为了部署HA集群,应该准备以下事情:* NameNode服务器:运行NameNode的服务器应该有相同的硬件配置。

* JournalNode服务器:运行的JournalNode进程非常轻量,可以部署在其他的服务器上。

注意:必须允许至少3个节点。

当然可以运行更多,但是必须是奇数个,如3、5、7、9个等等。

当运行N个节点时,系统可以容忍至少(N-1)/2个节点失败而不影响正常运行。

一、安装前准备:操作系统:CentOS 6.5 64位操作系统环境:jdk1.7.0_45以上,本次采用jdk-7u72-linux-x64.tar.gzmaster1 192.168.100.151 namenode 节点master2 192.168.100.152 namenode 节点slave1 192.168.100.153 datanode 节点slave2 192.168.100.154 datanode 节点slave3: 192.168.100.155 datanode 节点注:Hadoop2.0以上采用的是jdk环境是1.7,Linux自带的jdk卸载掉,重新安装下载地址:/technetwork/java/javase/downloads/index.html软件版本:hadoop-2.3.0-cdh5.1.0.tar.gz, zookeeper-3.4.5-cdh5.1.0.tar.gz下载地址:/cdh5/cdh/5/开始安装:二、jdk安装1、检查是否自带jdkrpm -qa | grep jdkjava-1.6.0-openjdk-1.6.0.0-1.45.1.11.1.el6.i6862、卸载自带jdkyum -y remove java-1.6.0-openjdk-1.6.0.0-1.45.1.11.1.el6.i686安装jdk-7u72-linux-x64.tar.gz在usr/目录下创建文件夹java,在java文件夹下运行tar –zxvf jdk-7u72-linux-x64.tar.gz解压到java目录下[root@master01 java]# lsjdk1.7.0_72三、配置环境变量远行vi /etc/profile# /etc/profile# System wide environment and startup programs, for login setup# Functions and aliases go in /etc/bashrcexport JA VA_HOME=/usr/local/java/jdk1.7.0_65export JRE_HOME=/usr/local/java/jdk1.7.0_65/jreexport CLASSPATH=/usr/local/java/jdk1.7.0_65/libexport PATH=$JA V A_HOME/bin: $PA TH保存修改,运行source /etc/profile 重新加载环境变量运行java -version[root@master01 java]# java -versionjava version "1.7.0_72"Java(TM) SE Runtime Environment (build 1.7.0_72-b13)Java HotSpot(TM) 64-Bit Server VM (build 24.55-b03, mixed mode)Jdk配置成功四、系统配置预先准备5台机器,并配置IP,以下是我对这5台机器的角色分配。

标准hadoop集群配置

标准hadoop集群配置Hadoop是一个开源的分布式存储和计算框架,由Apache基金会开发。

它提供了一个可靠的、高性能的数据处理平台,可以在大规模的集群上进行数据存储和处理。

在实际应用中,搭建一个标准的Hadoop集群是非常重要的,本文将介绍如何进行标准的Hadoop集群配置。

1. 硬件要求。

在搭建Hadoop集群之前,首先需要考虑集群的硬件配置。

通常情况下,Hadoop集群包括主节点(NameNode、JobTracker)和从节点(DataNode、TaskTracker)。

对于主节点,建议配置至少16GB的内存和4核以上的CPU;对于从节点,建议配置至少8GB的内存和2核以上的CPU。

此外,建议使用至少3台服务器来搭建Hadoop集群,以确保高可用性和容错性。

2. 操作系统要求。

Hadoop可以在各种操作系统上运行,包括Linux、Windows和Mac OS。

然而,由于Hadoop是基于Java开发的,因此建议选择Linux作为Hadoop集群的操作系统。

在实际应用中,通常选择CentOS或者Ubuntu作为操作系统。

3. 网络配置。

在搭建Hadoop集群时,网络配置非常重要。

首先需要确保集群中的所有节点能够相互通信,建议使用静态IP地址来配置集群节点。

此外,还需要配置每台服务器的主机名和域名解析,以确保节点之间的通信畅通。

4. Hadoop安装和配置。

在硬件、操作系统和网络配置完成之后,接下来就是安装和配置Hadoop。

首先需要下载Hadoop的安装包,并解压到指定的目录。

然后,根据官方文档的指导,配置Hadoop的各项参数,包括HDFS、MapReduce、YARN等。

在配置完成后,需要对Hadoop集群进行测试,确保各项功能正常运行。

5. 高可用性和容错性配置。

为了确保Hadoop集群的高可用性和容错性,需要对Hadoop集群进行一些额外的配置。

例如,可以配置NameNode的热备份(Secondary NameNode)来确保NameNode的高可用性;可以配置JobTracker的热备份(JobTracker HA)来确保JobTracker的高可用性;可以配置DataNode和TaskTracker的故障转移(Failover)来确保从节点的容错性。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

hadoop分布式集群参数配置(一)

------master节点hadoop配置

上篇文章中我们已经将master节点的网络IP、hostname文件、hosts文件配置完成,接下来还有hadoop相关配置文件需要修改。

1、hdfs-site.xml

在hadoop的配置文件中与HDFS(hadoop分布式文件系统)相关的是hdfs-core.xml文件。

在伪分布集群中只有一个节点,因此此节点即要有NameNode 功能也要有DataNode功能。

在工作环境中这两个是不会在一个节点上的,在我们的多节点分布式集群中master只运行NameNode因此需在hdfs-site.xml文件中删除DataNode相关配置。

打开虚拟机在终端中输入cd hadoop/etc/hadoop 命令进入hadoop配置文件目录。

终端输入命令vim hdfs-site.xml进入vim编辑界面,按下图步骤删除原来伪分布集群配置的DataNode相关配置,并将数据冗余数量设置为2。

输入i进入编辑模式,编辑后的文件内容如下所示。

最后退出编辑模式,保存并退出。

2、core-site.xml

在core-site.xml中指定一个节点运行hdfs服务。

在之前伪分布集群中只有一个节点,因此我们使用的是localhost,如今在集群中有三个节点,我们约定使用master。

在终端中输入vim core-site.xml按下图操作修改配置文件。

修改后内容如下所示

记得退出并保存。

3、yarn-site.xml

在yarn-site.xml 里可以修改与资源管理模块YARN相关的一些配置。

终端中输入vim yarn-site.xml进行以下更改,将资源调度管理任务放置于master节点上

最终修改后的文件内容如下图所示。

4、mapred-site.xml

进行以下更改,主要添加mapreduce运行历史记录监控端口和网页端口。

同样,在终端输入vim mapred-site.xml开始编辑配置文件,配置内容如下所示

最后保存并退出。

5、slaves

slaves文件指明哪些节点运行DateNode进程,这里我们的集群中运行DataNode进程的节点有slave1、slave2。

因此需将这两节点保存到slaves文件中。

在终端中输入vim slaves命令编辑文件,编辑后的文件内容如下图所示。

最后保存slaves文件并退出编辑。

到这里master节点上的hadoop相关配置已经完成了。

接下来我们要通过克隆master及slave1虚拟机来扩展集群。

6、生成slave1节点

通过克隆master 生成slave1节点的过程与之前克隆伪分布节点的操作是一致的这里不再赘述,唯一区别是在执行到下图步骤时注意将虚拟机名称设置为slave1并选择正确的存储位置方便管理。

还有一点,被克隆的虚拟机一定要关机状态才可以被克隆。

slave1节点与master节点在hostname、IP地址、Hadoop配置这几个方面是有些差异的,在复制好slave1节点之后需进行配置。

6.1 配置IP地址

在前面文章中提到过slave1节点IP地址应设置为固定的值:192.168.79.12。

详细的配置方法步骤已经在配置master节点时介绍过,配置slave1节点时可以参考一下。

修改完成后的配置结果如下图所示,点击save保存即可。

6.2、修改hostname

保存并退出

6.3、修改Hadoop配置项

hdfs-site.xml

保存并退出之后重启slave1节点查看配置是否生效。

7、生成slave2节点

Slave2与slave1在Hadoop相关配置内容上是一致的,因此通过克隆slave1节点来生成slave2可以减少一些操作步骤。

克隆slave1节点时的操作步骤同样参考之前文章内容,区别是执行到下图步骤时记得更改虚拟机名称为slave2并更改存储目录(存储目录自己定义)。

7.1、配置IP地址

克隆完成后打开slave2虚拟机并配置其IP地址。

配置过程与之前配置master 节点IP过程一致,只是IP地址需改为192.168.79.13结果如下图所示,点击save

保存即可。

更改Hostname,在终端中输入sudo vim /etc/hostname并回车执行,根据提示输入密码

输入i编辑hostname文件,文件内容如下所示为slave2,然后保存退出。

重启虚拟机测试配置是否生效,重启命令为sudo reboot

slave2重新启动后打开终端,输入命令ifconfig查看IP设置及虚拟机名,如下图所示配置已经生效。

到这里我们的hadoop集群安装配置完成。

接下来的文章我会给大家介绍一下hadoop集群如如何启动。