数据挖掘中ID3算法实现

id3算法计算过程

id3算法计算过程ID3(Iterative Dichotomiser 3)算法是一种用于决策树分类的算法,它是基于信息论的一个概念,旨在通过选择最佳的属性来划分数据集,从而最小化不确定性。

ID3算法通过计算信息增益来选择最佳的属性,信息增益是用来衡量在给定属性下分类的不确定性减少的程度。

ID3算法的计算过程可以概括为以下几个步骤:1.输入数据集:首先需要将训练数据集输入到算法中。

数据集通常是由输入特征和对应的分类标签组成。

2.计算初始不确定性:通过计算数据集的初始不确定性来确定分类的基准。

这可以通过计算数据集中各个类别出现的频率来实现。

例如,如果训练数据集中有100个样本,其中60个属于类别A,40个属于类别B,则初始不确定性可以用公式H(D) = -p(A)log(p(A)) -p(B)log(p(B))来计算,其中p(A) = 60/100 = 0.6,p(B) = 0.4。

3.计算每个属性的信息增益:对于每个属性,需要计算它对分类的信息增益。

信息增益可以通过计算属性的条件熵来实现。

条件熵是指在某个属性已知的情况下,对于每个可能的属性值计算的熵,并对所有可能属性值的熵进行加权求和。

例如,对于一个属性A,它有三个可能的取值a1,a2和a3,在给定属性A的情况下,可以计算针对每个属性值的条件熵H(D|A=a1),H(D|A=a2)和H(D|A=a3),然后以属性值的出现频率加权求和。

属性的信息增益可以通过属性的条件熵与初始不确定性之差来计算。

例如,属性A的信息增益可以用公式IG(A) =H(D) - H(D|A)来计算。

4.选择信息增益最大的属性:选择信息增益最大的属性作为当前节点的划分属性。

信息增益最大意味着将这个属性作为划分属性所带来的不确定性减少最大。

5.递归构建决策树:通过选择信息增益最大的属性来划分数据集,并根据属性值创建子节点。

然后以这些子节点作为新的数据集,递归地重复上述步骤,直到满足停止条件。

id3算法代码

id3算法代码ID3算法简介ID3算法是一种常用的决策树算法,它通过对数据集的属性进行分析,选择最优属性作为节点,生成决策树模型。

ID3算法是基于信息熵的思想,通过计算每个属性对样本集合的信息增益来选择最优划分属性。

ID3算法步骤1. 计算数据集的熵首先需要计算数据集的熵,熵越大表示样本集合越混乱。

假设有n个类别,则数据集D的熵可以表示为:$$ Ent(D) = -\sum_{i=1}^{n}p_i\log_2p_i $$其中$p_i$表示第i个类别在数据集D中出现的概率。

2. 计算每个属性对样本集合的信息增益接下来需要计算每个属性对样本集合的信息增益。

假设有m个属性,则第j个属性$A_j$对数据集D的信息增益可以表示为:$$ Gain(D, A_j) = Ent(D) - \sum_{i=1}^{v}\frac{|D_i|}{|D|}Ent(D_i) $$其中$v$表示第j个属性可能取值的数量,$D_i$表示在第j个属性上取值为$i$时所包含的样本子集。

3. 选择最优划分属性从所有可用属性中选择最优划分属性作为当前节点。

选择最优划分属性的方法是计算所有属性的信息增益,选择信息增益最大的属性作为当前节点。

4. 递归生成决策树使用选择的最优划分属性将数据集划分成若干子集,对每个子集递归生成子树。

ID3算法代码实现下面是Python语言实现ID3算法的代码:```pythonimport mathimport pandas as pd# 计算熵def calc_entropy(data):n = len(data)label_counts = {}for row in data:label = row[-1]if label not in label_counts:label_counts[label] = 0label_counts[label] += 1entropy = 0.0for key in label_counts:prob = float(label_counts[key]) / n entropy -= prob * math.log(prob, 2) return entropy# 划分数据集def split_data(data, axis, value):sub_data = []for row in data:if row[axis] == value:sub_row = row[:axis]sub_row.extend(row[axis+1:])sub_data.append(sub_row)return sub_data# 计算信息增益def calc_info_gain(data, base_entropy, axis):values = set([row[axis] for row in data])new_entropy = 0.0for value in values:sub_data = split_data(data, axis, value)prob = len(sub_data) / float(len(data))new_entropy += prob * calc_entropy(sub_data) info_gain = base_entropy - new_entropyreturn info_gain# 选择最优划分属性def choose_best_feature(data):num_features = len(data[0]) - 1base_entropy = calc_entropy(data)best_info_gain = 0.0best_feature = -1for i in range(num_features):info_gain = calc_info_gain(data, base_entropy, i)if info_gain > best_info_gain:best_info_gain = info_gainbest_feature = ireturn best_feature# 多数表决函数,用于确定叶子节点的类别def majority_vote(class_list):class_count = {}for vote in class_list:if vote not in class_count:class_count[vote] = 0class_count[vote] += 1sorted_class_count = sorted(class_count.items(), key=lambda x:x[1], reverse=True)return sorted_class_count[0][0]# 创建决策树def create_tree(data, labels):class_list = [row[-1] for row in data]if class_list.count(class_list[0]) == len(class_list):return class_list[0]if len(data[0]) == 1:return majority_vote(class_list)best_feature_idx = choose_best_feature(data)best_feature_label = labels[best_feature_idx]tree_node = {best_feature_label: {}}del(labels[best_feature_idx])feature_values = [row[best_feature_idx] for row in data] unique_values = set(feature_values)for value in unique_values:sub_labels = labels[:]sub_data = split_data(data, best_feature_idx, value) tree_node[best_feature_label][value] =create_tree(sub_data, sub_labels)return tree_node# 预测函数def predict(tree, labels, data):first_str = list(tree.keys())[0]second_dict = tree[first_str]feat_index = labels.index(first_str)key = data[feat_index]value_of_feat = second_dict[key]if isinstance(value_of_feat, dict):class_label = predict(value_of_feat, labels, data) else:class_label = value_of_featreturn class_label# 测试函数def test():# 读取数据集df = pd.read_csv('iris.csv')data = df.values.tolist()# 划分训练集和测试集train_data = []test_data = []for i in range(len(data)):if i % 5 == 0:test_data.append(data[i])else:train_data.append(data[i])# 创建决策树labels = df.columns.tolist()[:-1]tree = create_tree(train_data, labels)# 测试决策树模型的准确率correct_count = 0for row in test_data:true_label = row[-1]pred_label = predict(tree, labels, row[:-1])if true_label == pred_label:correct_count += 1accuracy = float(correct_count) / len(test_data)if __name__ == '__main__':test()```代码解释以上代码实现了ID3算法的主要功能。

id3算法计算过程

id3算法计算过程ID3(Iterative Dichotomiser 3)是一种用于构建决策树的机器学习算法。

它根据信息增益来选择最优的特征,同时通过递归地分割和划分数据集来构建决策树。

下面将详细介绍ID3算法的计算过程。

1. 计算熵(Entropy):熵是衡量数据集的无序程度的指标。

对于给定的数据集D,其熵的计算公式如下:其中,p(i)表示数据集中属于类别i的样本在数据集中出现的概率。

2. 计算信息增益(Information Gain):信息增益是用于选择最优特征的指标。

对于给定的数据集D和特征A,其信息增益的计算公式如下:其中,H(D)表示数据集D的熵,D_v表示特征A在取值v上的样本子集,D_v,表示D_v的样本数,D,表示数据集D的样本数。

3.选择最优特征:针对给定的数据集D和特征集合A,计算每个特征的信息增益,选择信息增益最大的特征作为当前节点的划分特征。

4.划分数据集:根据最优特征的取值,将数据集D划分为不同的子集,每个子集对应于最优特征的一个取值。

5.递归构建决策树:对于每个子集,如果子集中的样本属于同一类别,则将该子集转换为叶节点,并标记为该类别。

否则,对该子集进行递归构建决策树的步骤。

6.剪枝处理:在构建决策树的过程中,可能会出现过拟合的情况。

为了避免过拟合,可以采用剪枝处理,即通过减小决策树的规模来降低过拟合的风险。

7.算法结束:当所有特征都被使用或者数据集已经完全划分时,算法结束,得到了一棵决策树。

ID3算法的主要优点是简单且易于理解,但也存在以下一些局限性:-ID3算法倾向于选择具有较多取值的特征作为划分特征,这可能导致决策树的过拟合问题。

-ID3算法无法处理连续型特征,只能处理离散型特征。

-ID3算法对于缺失值敏感,缺失值可能会导致信息增益的计算不准确。

为了克服这些局限,后续出现了C4.5和CART算法,它们在ID3算法的基础上做了一些改进和优化。

ID3决策树算法实现(Python版)

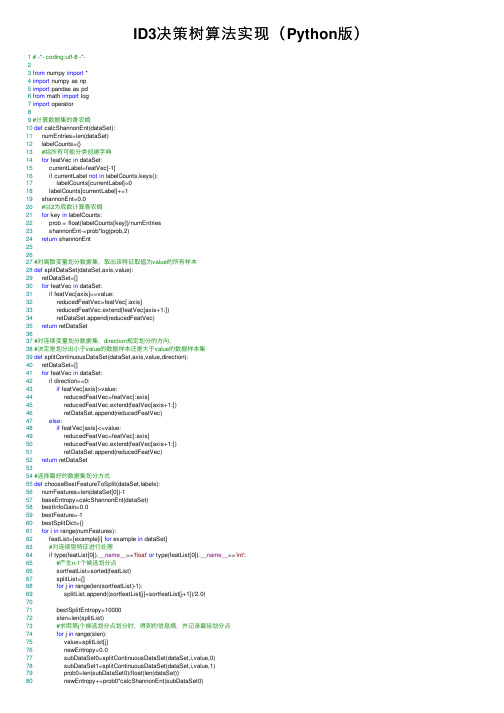

ID3决策树算法实现(Python版) 1# -*- coding:utf-8 -*-23from numpy import *4import numpy as np5import pandas as pd6from math import log7import operator89#计算数据集的⾹农熵10def calcShannonEnt(dataSet):11 numEntries=len(dataSet)12 labelCounts={}13#给所有可能分类创建字典14for featVec in dataSet:15 currentLabel=featVec[-1]16if currentLabel not in labelCounts.keys():17 labelCounts[currentLabel]=018 labelCounts[currentLabel]+=119 shannonEnt=0.020#以2为底数计算⾹农熵21for key in labelCounts:22 prob = float(labelCounts[key])/numEntries23 shannonEnt-=prob*log(prob,2)24return shannonEnt252627#对离散变量划分数据集,取出该特征取值为value的所有样本28def splitDataSet(dataSet,axis,value):29 retDataSet=[]30for featVec in dataSet:31if featVec[axis]==value:32 reducedFeatVec=featVec[:axis]33 reducedFeatVec.extend(featVec[axis+1:])34 retDataSet.append(reducedFeatVec)35return retDataSet3637#对连续变量划分数据集,direction规定划分的⽅向,38#决定是划分出⼩于value的数据样本还是⼤于value的数据样本集39def splitContinuousDataSet(dataSet,axis,value,direction):40 retDataSet=[]41for featVec in dataSet:42if direction==0:43if featVec[axis]>value:44 reducedFeatVec=featVec[:axis]45 reducedFeatVec.extend(featVec[axis+1:])46 retDataSet.append(reducedFeatVec)47else:48if featVec[axis]<=value:49 reducedFeatVec=featVec[:axis]50 reducedFeatVec.extend(featVec[axis+1:])51 retDataSet.append(reducedFeatVec)52return retDataSet5354#选择最好的数据集划分⽅式55def chooseBestFeatureToSplit(dataSet,labels):56 numFeatures=len(dataSet[0])-157 baseEntropy=calcShannonEnt(dataSet)58 bestInfoGain=0.059 bestFeature=-160 bestSplitDict={}61for i in range(numFeatures):62 featList=[example[i] for example in dataSet]63#对连续型特征进⾏处理64if type(featList[0]).__name__=='float'or type(featList[0]).__name__=='int':65#产⽣n-1个候选划分点66 sortfeatList=sorted(featList)67 splitList=[]68for j in range(len(sortfeatList)-1):69 splitList.append((sortfeatList[j]+sortfeatList[j+1])/2.0)7071 bestSplitEntropy=1000072 slen=len(splitList)73#求⽤第j个候选划分点划分时,得到的信息熵,并记录最佳划分点74for j in range(slen):75 value=splitList[j]76 newEntropy=0.077 subDataSet0=splitContinuousDataSet(dataSet,i,value,0)78 subDataSet1=splitContinuousDataSet(dataSet,i,value,1)79 prob0=len(subDataSet0)/float(len(dataSet))80 newEntropy+=prob0*calcShannonEnt(subDataSet0)81 prob1=len(subDataSet1)/float(len(dataSet))82 newEntropy+=prob1*calcShannonEnt(subDataSet1)83if newEntropy<bestSplitEntropy:84 bestSplitEntropy=newEntropy85 bestSplit=j86#⽤字典记录当前特征的最佳划分点87 bestSplitDict[labels[i]]=splitList[bestSplit]88 infoGain=baseEntropy-bestSplitEntropy89#对离散型特征进⾏处理90else:91 uniqueVals=set(featList)92 newEntropy=0.093#计算该特征下每种划分的信息熵94for value in uniqueVals:95 subDataSet=splitDataSet(dataSet,i,value)96 prob=len(subDataSet)/float(len(dataSet))97 newEntropy+=prob*calcShannonEnt(subDataSet)98 infoGain=baseEntropy-newEntropy99if infoGain>bestInfoGain:100 bestInfoGain=infoGain101 bestFeature=i102#若当前节点的最佳划分特征为连续特征,则将其以之前记录的划分点为界进⾏⼆值化处理103#即是否⼩于等于bestSplitValue104if type(dataSet[0][bestFeature]).__name__=='float'or type(dataSet[0][bestFeature]).__name__=='int': 105 bestSplitValue=bestSplitDict[labels[bestFeature]]106 labels[bestFeature]=labels[bestFeature]+'<='+str(bestSplitValue)107for i in range(shape(dataSet)[0]):108if dataSet[i][bestFeature]<=bestSplitValue:109 dataSet[i][bestFeature]=1110else:111 dataSet[i][bestFeature]=0112return bestFeature113114#特征若已经划分完,节点下的样本还没有统⼀取值,则需要进⾏投票115def majorityCnt(classList):116 classCount={}117for vote in classList:118if vote not in classCount.keys():119 classCount[vote]=0120 classCount[vote]+=1121return max(classCount)122123#主程序,递归产⽣决策树124def createTree(dataSet,labels,data_full,labels_full):125 classList=[example[-1] for example in dataSet]126if classList.count(classList[0])==len(classList):127return classList[0]128if len(dataSet[0])==1:129return majorityCnt(classList)130 bestFeat=chooseBestFeatureToSplit(dataSet,labels)131 bestFeatLabel=labels[bestFeat]132 myTree={bestFeatLabel:{}}133 featValues=[example[bestFeat] for example in dataSet]134 uniqueVals=set(featValues)135if type(dataSet[0][bestFeat]).__name__=='str':136 currentlabel=labels_full.index(labels[bestFeat])137 featValuesFull=[example[currentlabel] for example in data_full]138 uniqueValsFull=set(featValuesFull)139del(labels[bestFeat])140#针对bestFeat的每个取值,划分出⼀个⼦树。

(完整版)ID3算法

(2)用信息增益作为属性选择量存在一个假设, 即训 练例子集中的正, 反例的比例应与实际问题领域里正、 反例比例相同。一般情况不能保证相同, 这样计算训练 集的信息增益就有偏差。

(3)ID3在建树时, 每个节点仅含一个属性, 是一种单 变元的算法, 属性间的相关性强调不够。虽然它将多个 属性用一棵树连在一起, 但联系还是松散的。

该算法的计算时间是例子个数、属性个数、结点个数 之积的线性函数。对有4761个关于苯的质谱例子作了试验。 其中正例2361个, 反例2400个, 每个例子由500个属性描述, 每个属性取值数目为6, 得到一棵1514个结点的决策树。对 正、反例各100个测试例作了测试, 正例判对82个, 反例判对 80个, 总预测正确率81%, 效果是令人满意的。

J.R.Quinlan的工作主要是引进了信息论中的信息增益, 他将其称为信息增益(information gain), 作为属性 判别能力的度量, 设计了构造决策树的递归算法。

下面通过一个例子, 说明ID3算法的基本思想。

5

一、ID3基本思想

对于气候分类问题,属性为: 天气(A1) 取值为: 晴,多云,雨 气温(A2) 取值为: 冷 ,适中,热 湿度(A3) 取值为: 高 ,正常 风 (A4) 取值为: 有风, 无风

16

Gain(S, A1) Entropy(S) v晴,多云,雨

Sv S

Entropy(Sv )

Entropy(S

)

5 14

Entropy(S晴

)

4 14

Entropy(S多云

)

5 14

Entropy(S雨

)

而

Entropy(S晴 )

2 5

log

ID3算法的实现过程

ID3算法的实现过程ID3算法是一种用于数据挖掘和机器学习的算法,其本质是基于决策树的思想实现。

ID3算法常常被用来解决分类问题,如将一组数据通过某种属性分为不同类别。

下面我们将介绍ID3算法的实现过程。

1. 确定根节点在进行ID3算法之前,需要先确定根节点。

根节点通常是指整个数据集中出现频率最高的属性。

例如,如果我们有一组数据集包括性别、年龄、工资和教育水平等属性,我们需要选择出现频率最高的属性作为根节点属性。

2. 计算信息熵信息熵是很重要的一个概念,它用于衡量在一个集合中出现不同数据的概率。

在ID3算法中,我们需要计算每一个属性的信息熵,以便选择最佳的属性作为子节点。

信息熵的计算公式如下:$Entropy(S) = -p_1log_2(p_1) -p_2log_2(p_2) -···-pnlog_2(p_n)$其中,$S$表示数据集,$p_i$表示数据集中属于类别$i$的概率。

3. 计算信息增益信息增益是基于信息熵计算的。

信息增益计算方法如下:$Gain(S,A) = Entropy(S) -\sum_{t=1}^{v}\frac{S_t}{S}Entropy(S_t)$其中,$S$表示数据集,$A$表示属性,$S_t$表示属性$A$对应的值为$t$的子集,$v$表示属性$A$可以取的不同值的数量。

在计算信息增益时,我们可以选择属性$A$的增益最大的值作为子节点。

这个属性就可以作为决策树的下一层节点。

4. 递归构建子树通过属性的信息增益,我们已经确定了子节点,那么我们需要继续递归构建子树,不断重复上述过程,直到构建完整的决策树。

5. 剪枝在构建完整的决策树后,我们需要对其进行剪枝。

决策树的剪枝通常是指去除不必要的节点,以减小决策树的复杂度。

剪枝通常是通过交叉验证实现的,即将原始数据集分为训练集和测试集两个部分,利用测试集计算误差率,通过比较决策树剪枝前后的误差率,选择效果更好的决策树。

数据挖掘决策树ID3算法优化

数据挖掘决策树ID3算法优化数据挖掘决策树ID3算法是一种非常经典的基于信息增益的算法,用于解决分类问题。

虽然ID3算法具有简单、易于理解的优点,但也存在一些问题,如对于连续特征的处理不方便,对于缺失值的处理较为困难等。

本文将对ID3算法进行优化,以提高算法的鲁棒性和性能。

首先,ID3算法对连续特征的处理相对困难。

在ID3算法中,采用的是信息增益作为选择划分特征的依据,而对于连续型特征,信息增益的计算存在困难。

为了解决这个问题,可以引入基于连续数据的离散化技术。

离散化是将连续型特征转化为有限个离散值的过程。

常用的离散化方法包括等宽法和等频法。

等宽法是将连续型特征的取值范围平均分成K个区间,然后将特征的取值映射到相应的区间。

等频法是将连续型特征的值从小到大排序后,分成K个大小相等的区间。

离散化后,就可以像处理离散型特征一样来计算信息增益了。

其次,ID3算法对缺失值的处理不方便。

在现实的数据集中,经常会存在缺失值。

ID3算法中将缺失值视为一种特殊的取值,这会影响到信息增益的计算。

为了解决这个问题,可以考虑使用缺失值的众数或平均值来进行填充。

另外,在计算信息增益时,还可以加入缺失值的分支,并计算其对信息增益的贡献。

这样可以提高ID3算法对于缺失值的处理能力。

此外,由于ID3算法是自顶向下的贪心算法,容易陷入局部最优。

为了提高决策树的泛化能力,可以采用剪枝技术。

剪枝是通过去掉一些子树来减小决策树的复杂度,提高决策树的泛化能力。

常用的剪枝方法有预剪枝和后剪枝。

预剪枝是在构建决策树过程中,在每个节点处先进行一次估计,如果剪枝后的决策树性能不会比原树差,则进行剪枝操作。

后剪枝是在构建决策树结束后,通过遍历决策树的所有子树,将子树进行剪枝。

剪枝时使用交叉验证的方法,通过估计剪枝后的决策树在独立测试集上的性能来判断是否进行剪枝操作。

最后,对于处理大规模数据集时,ID3算法的性能较差。

ID3算法的时间复杂度为O(N^2),其中N是训练样本的数量。

实验二--分类挖掘算法(ID3)

实验二分类挖掘算法(ID3)一、实验目的1、理解分类2、掌握分类挖掘算法ID33、为改进ID3打下基础二、实验内容1、选定一个数据集(可以参考教学中使用的数据集)2、选择合适的实现环境和工具实现算法ID33、给出分类规则三、实验原理决策树是一种最常见的分类算法,它包含有很多不同的变种,ID3算法是其中最简单的一种。

ID3算法中最主要的部分就是信息熵和信息增益的计算。

信息熵的计算公式如下。

信息增益的计算公式为:其中P(ui)为类别ui在样本S中出现的概率,A是样本的属性,Value(A)是属性A所有取值的集合,v是A得其中一个属性值。

Sv是S中A的值为v的样例集合。

ID3算法的流程就是在属性集A中寻找信息增益值最大的属性,作为根节点,按照根节点属性的取值将样本集合分成几个子集,将此属性从属性集中去掉,在每个子集中选择信息增益值最大的属性,作为当前子集的根节点,上层集合的根节点的子节点,如此循环递归,如果得到的子集中所有的样本属于一个类别,则递归停止。

四、实验要求1、数据集具有一定的代表性,可以使用数据库技术管理2、实现界面友好3、提交实验报告:实验题目、目的、数据集描述、实验环境、过程、结果和分析等。

五、实验步骤1、所采用的数据集,如图1所示:2、具体步骤构造决策树的方法是采用自上而下的递归构造,其思路是:1)以代表训练样本的单个结点开始建树(步骤1)。

2)如果样本都在同一类,则该结点成为树叶,并用该类标记(步骤2和3)。

3)否则,算法使用称为信息增益的机遇熵的度量为启发信息,选择能最好地将样本分类的属性(步骤6)。

该属性成为该结点的“测试”或“判定”属性(步骤7)。

值得注意的是,在这类算法中,所有的属性都是分类的,即取离散值的。

连续值的属性必须离散化。

4)对测试属性的每个已知的值,创建一个分支,并据此划分样本(步骤8~10)。

5)算法使用同样的过程,递归地形成每个划分上的样本决策树。

一旦一个属性出现在一个结点上,就不必考虑该结点的任何后代(步骤13)。

id3 使用手册

id3 使用手册

ID3(Iterative Dichotomiser 3)是一种决策树算法。

它是机器学习中的一种分类算法,主要用于数据挖掘和知识发现。

ID3算法采用信息增益来选择属性进行分裂,生成决策树,

以解决分类问题。

1.ID3算法的基本流程如下:

2.计算每个属性的信息增益;

3.选择信息增益最大的属性进行分裂;

4.递归地构建子树,直到满足停止条件。

以下是ID3算法的详细步骤:

1.初始化根节点;

2.如果样本都属于同一类别,则该节点为叶节点,返回

该类别;

3.如果属性集为空,则该节点为叶节点,返回样本中最

常见的类别;

4.计算每个属性的信息增益;

5.选择信息增益最大的属性进行分裂;

6.对选定的属性进行值的划分,为每个值创建一个子节点;

7.递归地构建子树,直到满足停止条件。

ID3算法的优点是简单、易于理解和实现,同时能够处

理连续属性和缺失值。

但是,它也存在一些缺点,例如对数

据集的大小和属性值的分布敏感,容易出现过拟合和欠拟合等问题。

在使用ID3算法时,需要注意以下几点:

1.数据集需要足够大,才能保证算法的准确性;

2.属性值需要均匀分布,避免出现极端情况;

3.需要考虑处理连续属性和缺失值的情况;

4.需要调整停止条件和剪枝策略,以避免过拟合和欠拟合等问题。

总之,ID3算法是一种经典的决策树算法,它能够帮助我们进行数据分类和知识发现。

在使用ID3算法时,需要注意一些细节问题,以保证算法的准确性和效率。

id3算法的执行过程

id3算法的执行过程

ID3算法是一种用于决策树学习的算法,它的执行过程包括以下几个步骤:

1. 输入数据集:将训练样本集输入到算法中。

2. 选择最优特征:通过计算各个特征的信息增益或信息增益比,选择一个最优特征作为当前节点的分裂特征。

3. 根据最优特征创建节点:根据选择的最优特征,创建一个节点,并将数据集按照该特征的不同取值划分成多个子数据集。

4. 递归调用:对于每个子数据集,重复步骤2和步骤3,直到满足终止条件。

5. 设置节点类别:如果子数据集中的样本属于同一类别,则将当前节点设置为叶子节点,并将该类别作为叶子节点的类别。

6. 返回决策树:重复步骤2到步骤5,直到所有特征都被使用或达到终止条件。

最终得到一棵完整的决策树。

ID3算法的核心思想是通过选择最优特征将数据集分成更加纯净的子数据集,从而构建一棵具有较高分类能力的决策树。

机器学习决策树算法ID3

机器学习决策树算法ID3决策树是一种重要的机器学习算法,它能够处理分类和回归的问题,并且易于理解和解释。

其中,ID3(Iterative Dichotomiser 3)算法是决策树学习中最简单和最流行的一种算法,本文将介绍ID3算法的基本原理和实现过程。

什么是决策树决策树是一种树形结构,其中每个内部节点表示一个属性上的判断,每个叶子节点表示一种分类结果。

决策树的生成分为两个步骤:构建和剪枝。

构建过程是将数据集通过分裂形成一颗完整的决策树;剪枝过程是通过去除不必要的分支来提高模型的泛化能力。

ID3算法的基本原理ID3算法是一种贪心算法,也就是说,在每一次分裂时,它都会选择当前最优的特征进行分裂。

其基本思想是:通过计算某个特征的信息增益来确定每个节点的最优分割策略。

信息增益是指在选择某个特征进行分割后,熵的减少量。

熵的计算公式如下:$$ H(D) = -\\sum_{k=1}^{|y|}p_klog_2p_k $$其中,|y|表示类别的数量,p k表示第k个类别在所有样本中出现的概率。

信息增益的计算公式如下:$$ Gain(D,F) = H(D) - \\sum_{v\\in V(F)}\\frac{|D_v|}{|D|}H(D_v) $$其中,F表示属性,V(F)表示属性F的取值集合。

D v表示选择属性F取值为v时的样本集。

在计算信息增益时,需要选择具有最大信息增益的属性作为分裂属性。

ID3算法的实现过程ID3算法的实现过程可以分为以下几个步骤:1.选择分裂属性:选择信息增益最大的属性作为分裂属性;2.构建节点:将节点标记为分裂属性;3.分裂样本:按照分裂属性将样本集分裂为若干子集;4.递归继续分裂:对于每个子集,递归地执行步骤1到步骤3,直到构建完整个决策树。

具体实现时,可以使用递归函数来实现决策树的构建。

代码如下所示:```python def create_tree(dataset, labels):。

数据挖掘决策树ID3分类算法

数据挖掘ID3分类算法实验目的:学习分类算法的决策树算法,算法的过程数据处理,并用JAVA语言调试出来实验原理:检测所有属性,选择信息增量最大的属性产生决策树的节点,由该属性的不同取值建立分支,再对各分支的子集递归调用该方法建立决策树的节点的分支,直到所有的子集仅包含同一个类型的数据位置,最后得到一颗决策树,用来对新的样本进行分类,实验过程:计算步骤:1.信息嫡决策树算法是非常常用的分类算法,是逼近离散目标函数的方法,学习得到的函数以决策树的形式表示。

其基本思路是不断选取产生信息增益最大的属性来划分样例集和,构造决策树。

信息增益定义为结点与其子结点的信息熵之差。

信息熵是香农提出的,用于描述信息不纯度(不稳定性),其计算公式是Pi为子集合中不同性(而二元分类即正样例和负样例)的样例的比例。

这样信息收益可以定义为样本按照某属性划分时造成熵减少的期望,可以区分训练样本中正负样本的能力,其计算公司是conduct的分布为:9个样本的类标号取值为yes,5个样本的类标号取值为no,c1=yes在的样本s中出现的概率为9/14,c2=no出现的概率为5/14,所以s的嫡为:Entropy(S)=Entropy(9/14,5/14)=-9/14l㏒2(9/14)-5/14㏒2(5/14)=0.94 2.信息增益用credit-rating的属性来划分s,属性credit-rating有两个可能的取值[FAIR,excellent],讲s划分为2个子集{s1,s2},S1为有8个样本,s2为excellent有6个样本,分别计算子集s1,s2的嫡子集s1:credit-rating=yes有六个样本,=no有二个样本Entropy(s1)=-3/4log2(3/4)-1/4log2(1/4)=0.811子集s2:credit-rating=yes有3个样本,credit=no有三个样本Entropy(s2)=-1利用属性credit-rating划分的s后的嫡是Entropy(s)=|s1/s|entropy(s1)+|s2/s|entropy(s2)=0.891Gain(S,credit-rating)=Entropy(S)-Entropy(s)=0.94-0.891=0.0493.构建决策树的过程数据集conduct有属性{age,income,student,credit-rating},每个属性的取值分别是age={youth,middle-aged,senior,},income=(high,medium,low),student={no,yes},credit-rating={fair,excellent},过程:1.计算所有属性划分数据集s所得的信息增益值,寻找最大属性作为根节点Entropy-age(s)==|s1|/|s|Entropy(s1)+|s2|/|s|Entropy(S2)+|s3|=0.694Gain(S,age)=Entropy(s)-Entropy(age) s=0.94-0.694=0.246同理Entropy-income(s)=0.911Gain(s,income)=Entropy(s)-Entropy(income)=0.94-0.911=0.029Entropy-student(s)=0.788Gain(s,student)=Entropy(s)=Entropy(student)=0.94-0.788=0.152Gain(s,credit-rating)=0.049从上面的计算结果可以看出age属性具有最高信息增益值,被选为跟节点的决策属性2.以age作为根节点,并以age的可能取值建立分支。

数据挖掘ID3算法决策树

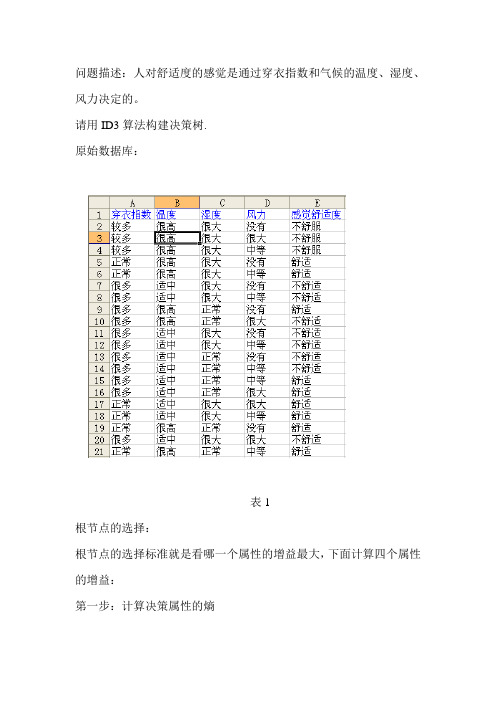

问题描述:人对舒适度的感觉是通过穿衣指数和气候的温度、湿度、风力决定的。

请用ID3算法构建决策树.原始数据库:表1根节点的选择:根节点的选择标准就是看哪一个属性的增益最大,下面计算四个属性的增益:第一步:计算决策属性的熵表2根据感觉舒适度的类别属性划分D为相互独立的类,决策属性感觉舒适度有20个记录,其中9个记录是舒适,11个记录是不舒适,分别为p1,p2.其概率分布为p={9/20,11/20},使用公式计算熵得:Info(感觉舒适度)= -(9/20)*log2(9/20)-(11/20)*log2(11/20)=0.993位第二步:计算条件属性的熵样本集共有4个条件属性,分别为:穿衣指数,温度,湿度,风力,使用公式计算各条件属性的熵。

1.穿衣指数的熵:按穿衣指数将D划分为D1(正常),D2(较多),D3(很多)三个集合D=D1∪D2∪D3,P的概率分布为:P={6/20,3/20,11/20}表3(1)用公式计算属性值的熵对于集合D1(正常)有舒适一个类别,其概率分布为P={6/6},Info(D1)= -(6/6)*log2(6/6)=0.0;对于集合D2(较多)有不舒适一个类别,其概率分布为P={ 3/3 },Info(D2)= -(3/3)*log2(3/3) =0.0;对于集合D3(很多)有舒适和不舒适两个类别,其概率分布为P={3/11,8/11},Info(D3)= -(3/11)*log2(3/11)-(8/11)*log2(8/11)=0.772位(2)用公式计算属性的熵(三个子集的加权平均值)Info(穿衣指数) =6/20*Info(D1)+3/20*Info(D2)+11/20*Info(D3)=6/20*0.0+3/20*0.0+11/20*0.772 =0.42462,温度的熵:按温度将D划分为D1(适中),D2(很高)两个集合D=D1∪D2,P的概率分布为:P={11/20,9/20}表4(1)用公式计算属性值的熵对于集合D1(适中)有两个类别舒适,不舒适,其概率分布为P={4/11,7/11}, Info(D1)= -(4/11)log2(4/11)-(7/11)log2(7/11)=0.9457;对于集合D2(很高)有两个类别舒适,不舒适,其概率分布为P={5/9,4/9}, Info(D2)= -(5/9)log2(5/9)-(4/9)log2(4/9)=0.9911;(2)用公式计算属性的熵(两个子集的加权平均值)Info(D,温度)=11/20*Info(D1)+9/20*Info(D2) =11/20*0.9457+9/20*0.9911 =0.9661位3.湿度的熵:按湿度将D划分为D1(正常),D2(很大)两个集合D=D1∪D2,P的概率分布为:P={8/20,12/20}表5(1)用公式计算属性值的熵对于集合D1(高)有两个类别舒适,不舒适,其概率分布为P={5/8,3/8},Info(D1)= -(5/8)log2(5/8)-(3/8)log2(3/8)=0.9544对于集合D2(正常)有两个类别舒适,不舒适,其概率分布为P={4/12,8/12}, Info(D2)= -(4/12)log2(4/12)-(8/12)log2(8/12)=0.9183(2)用公式计算属性的熵(两个子集的加权平均值)Info(D,湿度)=8/20*Info(D1)+12/20*Info(D2)=8/20*0.9544+12/20*0.9183 =0.93274.3.风力的熵:按风力将D划分为D1(中等),D2(没有),D3(很大)三个集合D=D1∪D2∪D3,P的概率分布为:P={8/20,7/20,5/20}表6(1)用公式计算属性值的熵对于集合D1(中等)有两个类别舒适,不舒适,其概率分布为P={4/8,4/8},Info(D1)=-(4/8)log2(4/8)-(4/8)log2(4/8)=1;对于集合D2(没有)有一个类别舒适,不舒适,其概率分布为P={3/7,4/7},Info(D2)=-(3/7)log2(3/7)-(4/7)log2(4/7)=0.9848;对于集合D3(很大)有一个类别舒适,不舒适,其概率分布为P={2/5,3/5},Info(D3)=-(2/5)log2(2/5)-(3/5)log2(3/5)=0.9710;(2)用公式计算属性的熵(三个子集的加权平均值)Info(D,风力)=8/20*Info(D1)+7/20*Info(D2) +5/20*Info(D3)=8/20*1+7/20*0.9848+5/20*0.9710 =0.9874第三步:计算条件属性的增益使用公式计算条件属性的增益为:Gain(穿衣指数)=Info(感觉舒适度)-Info(D,穿衣指数)= 0.993-0.4246=0.5684Gain(温度)=Info(感觉舒适度)-Info(D,温度)= 0.993-0.9661=0.0269Gain(湿度)=Info感觉舒适度)-Info(D,湿度)= 0.993-0.9327=0.0603Gain(风力)=Info感觉舒适度)-Info(D,风力)= 0.993-0.9874=0.0056结论:条件属性穿衣指数有最大的增益,所以它用于决策树的根节点正常很多 较多表7穿衣指数(正常)的分支根节点的选择:第一步:计算决策属性的熵根据感觉舒适度类别属性划分D 为相互独立的类,决策属性感觉舒适度有6个记录,全部为舒适.其概率分布为p={1},使用公式计算熵得: Info(感觉舒适度)= -(6/6)log2(6/6) =0第二步:计算条件属性的熵样本集共有3个条件属性,分别为:温度,湿度,风力,使用公式计算各条件属性的熵。

ID3算法原理及应用

I D3算法原理及应用-CAL-FENGHAI.-(YICAI)-Company One1ID3算法的应用研究摘要决策树算法是数据挖掘领域的核心分类算法之一,其中ID3算法是最为经典的决策树算法。

ID3算法理论清晰、使用简单、学习能力较强,且构造的决策树平均深度较小,分类速度较快,特别适合处理大规模的学习问题,目前已得到广泛应用。

本文对ID3算法进行了详细的描述,介绍了其算法的基本原理、发展近况、及其具体运用。

引言分类技术是一种根据输入数据集建立分类模型的系统方法。

分类技术一般是用一种学习算法确定分类模型,该模型可以很好地拟合输入数据中类标号和属性集之间的联系。

依据学习算法可以建立能够准确地预测未知样本类标号的模型。

分类方法的实例包括:决策树分类法、基于规则的分类法、神经网络、支持向量级、朴素贝叶斯分类方法等。

相对于其他几种算法而言,ID3算法理论清晰,算法简单,是很有实用价值的实例学习算法,计算时间是例子个数、特征属性个数、节点个数属性之积的线性函数,总预测准确率较高,针对属性选择问题,是决策树学习方法中最具影响和最为典型的算法。

因此本文将详细介绍该算法。

算法基本原理在ID3决策树归纳方法中,通常是使用信息增益方法来帮助确定生成每个节点时所应采用的合适属性。

这样就可以选择具有最高信息增益(熵减少的程度最大)的属性最为当前节点的测试属性,以便对之后划分的训练样本子集进行分类所需要的信息最小,也就是说,利用该属性进行当前(节点所含)样本集合划分,将会使得所产生的样本子集中的“不同类别的混合程度”降为最低。

因此,采用这样一种信息论方法将有效减少对象分来所需要的次数,从而确保所产生的决策树最为简单。

设E = F1 ×F2 ×…×Fn 是n 维有穷向量空间,其中j F 是有穷离散符号集, E 中的元素e = <1V ,2V ,…,n V >叫做例子,其中j V ∈j F , j = 1 ,2 , …, n 。

数据挖掘-决策树ID3分类算法的C++实现

数据挖掘-决策树ID3分类算法的C++实现数据挖掘课上⾯⽼师介绍了下决策树ID3算法,我抽空余时间把这个算法⽤C++实现了⼀遍。

决策树算法是⾮常常⽤的分类算法,是逼近离散⽬标函数的⽅法,学习得到的函数以决策树的形式表⽰。

其基本思路是不断选取产⽣信息增益最⼤的属性来划分样例集和,构造决策树。

信息增益定义为结点与其⼦结点的信息熵之差。

信息熵是⾹农提出的,⽤于描述信息不纯度(不稳定性),其计算公式是Pi为⼦集合中不同性(⽽⼆元分类即正样例和负样例)的样例的⽐例。

这样信息收益可以定义为样本按照某属性划分时造成熵减少的期望,可以区分训练样本中正负样本的能⼒,其计算公司是我实现该算法针对的样例集合如下该表记录了在不同⽓候条件下是否去打球的情况,要求根据该表⽤程序输出决策树C++代码如下,程序中有详细注释#include <iostream>#include <string>#include <vector>#include <map>#include <algorithm>#include <cmath>using namespace std;#define MAXLEN 6//输⼊每⾏的数据个数//多叉树的实现//1 ⼴义表//2 ⽗指针表⽰法,适于经常找⽗结点的应⽤//3 ⼦⼥链表⽰法,适于经常找⼦结点的应⽤//4 左长⼦,右兄弟表⽰法,实现⽐较⿇烦//5 每个结点的所有孩⼦⽤vector保存//教训:数据结构的设计很重要,本算法采⽤5⽐较合适,同时//注意维护剩余样例和剩余属性信息,建树时横向遍历考循环属性的值,//纵向遍历靠递归调⽤vector <vector <string> > state;//实例集vector <string> item(MAXLEN);//对应⼀⾏实例集vector <string> attribute_row;//保存⾸⾏即属性⾏数据string end("end");//输⼊结束string yes("yes");string no("no");string blank("");map<string,vector < string > > map_attribute_values;//存储属性对应的所有的值int tree_size = 0;struct Node{//决策树节点string attribute;//属性值string arrived_value;//到达的属性值vector<Node *> childs;//所有的孩⼦Node(){attribute = blank;arrived_value = blank;}};Node * root;//根据数据实例计算属性与值组成的mapvoid ComputeMapFrom2DVector(){unsigned int i,j,k;bool exited = false;vector<string> values;for(i = 1; i < MAXLEN-1; i++){//按照列遍历for (j = 1; j < state.size(); j++){for (k = 0; k < values.size(); k++){if(!values[k].compare(state[j][i])) exited = true;}if(!exited){values.push_back(state[j][i]);//注意Vector的插⼊都是从前⾯插⼊的,注意更新it,始终指向vector头}exited = false;}map_attribute_values[state[0][i]] = values;values.erase(values.begin(), values.end());}}//根据具体属性和值来计算熵double ComputeEntropy(vector <vector <string> > remain_state, string attribute, string value,bool ifparent){ vector<int> count (2,0);unsigned int i,j;bool done_flag = false;//哨兵值for(j = 1; j < MAXLEN; j++){if(done_flag) break;if(!attribute_row[j].compare(attribute)){for(i = 1; i < remain_state.size(); i++){if((!ifparent&&!remain_state[i][j].compare(value)) || ifparent){//ifparent记录是否算⽗节点if(!remain_state[i][MAXLEN - 1].compare(yes)){count[0]++;}else count[1]++;}}done_flag = true;}}if(count[0] == 0 || count[1] == 0 ) return 0;//全部是正实例或者负实例//具体计算熵根据[+count[0],-count[1]],log2为底通过换底公式换成⾃然数底数double sum = count[0] + count[1];double entropy = -count[0]/sum*log(count[0]/sum)/log(2.0) - count[1]/sum*log(count[1]/sum)/log(2.0);return entropy;}//计算按照属性attribute划分当前剩余实例的信息增益double ComputeGain(vector <vector <string> > remain_state, string attribute){unsigned int j,k,m;//⾸先求不做划分时的熵double parent_entropy = ComputeEntropy(remain_state, attribute, blank, true);double children_entropy = 0;//然后求做划分后各个值的熵vector<string> values = map_attribute_values[attribute];vector<double> ratio;vector<int> count_values;int tempint;for(m = 0; m < values.size(); m++){tempint = 0;for(k = 1; k < MAXLEN - 1; k++){if(!attribute_row[k].compare(attribute)){for(j = 1; j < remain_state.size(); j++){if(!remain_state[j][k].compare(values[m])){tempint++;}}}}count_values.push_back(tempint);}for(j = 0; j < values.size(); j++){ratio.push_back((double)count_values[j] / (double)(remain_state.size()-1));}double temp_entropy;for(j = 0; j < values.size(); j++){temp_entropy = ComputeEntropy(remain_state, attribute, values[j], false);children_entropy += ratio[j] * temp_entropy;}return (parent_entropy - children_entropy);}int FindAttriNumByName(string attri){for(int i = 0; i < MAXLEN; i++){if(!state[0][i].compare(attri)) return i;}cerr<<"can't find the numth of attribute"<<endl;return 0;}//找出样例中占多数的正/负性string MostCommonLabel(vector <vector <string> > remain_state){int p = 0, n = 0;for(unsigned i = 0; i < remain_state.size(); i++){if(!remain_state[i][MAXLEN-1].compare(yes)) p++;else n++;}if(p >= n) return yes;else return no;}//判断样例是否正负性都为labelbool AllTheSameLabel(vector <vector <string> > remain_state, string label){int count = 0;for(unsigned int i = 0; i < remain_state.size(); i++){if(!remain_state[i][MAXLEN-1].compare(label)) count++;}if(count == remain_state.size()-1) return true;else return false;}//计算信息增益,DFS构建决策树//current_node为当前的节点//remain_state为剩余待分类的样例//remian_attribute为剩余还没有考虑的属性//返回根结点指针Node * BulidDecisionTreeDFS(Node * p, vector <vector <string> > remain_state, vector <string> remain_attribute){ //if(remain_state.size() > 0){//printv(remain_state);//}if (p == NULL)p = new Node();//先看搜索到树叶的情况if (AllTheSameLabel(remain_state, yes)){p->attribute = yes;return p;}if (AllTheSameLabel(remain_state, no)){p->attribute = no;return p;}if(remain_attribute.size() == 0){//所有的属性均已经考虑完了,还没有分尽string label = MostCommonLabel(remain_state);p->attribute = label;return p;}double max_gain = 0, temp_gain;vector <string>::iterator max_it = remain_attribute.begin();vector <string>::iterator it1;for(it1 = remain_attribute.begin(); it1 < remain_attribute.end(); it1++){temp_gain = ComputeGain(remain_state, (*it1));if(temp_gain > max_gain) {max_gain = temp_gain;max_it = it1;}}//下⾯根据max_it指向的属性来划分当前样例,更新样例集和属性集vector <string> new_attribute;vector <vector <string> > new_state;for(vector <string>::iterator it2 = remain_attribute.begin(); it2 < remain_attribute.end(); it2++){if((*it2).compare(*max_it)) new_attribute.push_back(*it2);}//确定了最佳划分属性,注意保存p->attribute = *max_it;vector <string> values = map_attribute_values[*max_it];int attribue_num = FindAttriNumByName(*max_it);new_state.push_back(attribute_row);for(vector <string>::iterator it3 = values.begin(); it3 < values.end(); it3++){for(unsigned int i = 1; i < remain_state.size(); i++){if(!remain_state[i][attribue_num].compare(*it3)){new_state.push_back(remain_state[i]);}}Node * new_node = new Node();new_node->arrived_value = *it3;if(new_state.size() == 0){//表⽰当前没有这个分⽀的样例,当前的new_node为叶⼦节点new_node->attribute = MostCommonLabel(remain_state);}elseBulidDecisionTreeDFS(new_node, new_state, new_attribute);//递归函数返回时即回溯时需要1 将新结点加⼊⽗节点孩⼦容器 2清除new_state容器p->childs.push_back(new_node);new_state.erase(new_state.begin()+1,new_state.end());//注意先清空new_state中的前⼀个取值的样例,准备遍历下⼀个取值样例 }return p;}void Input(){string s;while(cin>>s,pare(end) != 0){//-1为输⼊结束item[0] = s;for(int i = 1;i < MAXLEN; i++){cin>>item[i];}state.push_back(item);//注意⾸⾏信息也输⼊进去,即属性}for(int j = 0; j < MAXLEN; j++){attribute_row.push_back(state[0][j]);}}void PrintTree(Node *p, int depth){for (int i = 0; i < depth; i++) cout << '\t';//按照树的深度先输出tabif(!p->arrived_value.empty()){cout<<p->arrived_value<<endl;for (int i = 0; i < depth+1; i++) cout << '\t';//按照树的深度先输出tab}cout<<p->attribute<<endl;for (vector<Node*>::iterator it = p->childs.begin(); it != p->childs.end(); it++){PrintTree(*it, depth + 1);PrintTree(*it, depth + 1);}}void FreeTree(Node *p){if (p == NULL)return;for (vector<Node*>::iterator it = p->childs.begin(); it != p->childs.end(); it++){ FreeTree(*it);}delete p;tree_size++;}int main(){Input();vector <string> remain_attribute;string outlook("Outlook");string Temperature("Temperature");string Humidity("Humidity");string Wind("Wind");remain_attribute.push_back(outlook);remain_attribute.push_back(Temperature);remain_attribute.push_back(Humidity);remain_attribute.push_back(Wind);vector <vector <string> > remain_state;for(unsigned int i = 0; i < state.size(); i++){remain_state.push_back(state[i]);}ComputeMapFrom2DVector();root = BulidDecisionTreeDFS(root,remain_state,remain_attribute);cout<<"the decision tree is :"<<endl;PrintTree(root,0);FreeTree(root);cout<<endl;cout<<"tree_size:"<<tree_size<<endl;return 0;}输⼊的训练数据如下Day Outlook Temperature Humidity Wind PlayTennis1 Sunny Hot High Weak no2 Sunny Hot High Strong no3 Overcast Hot High Weak yes4 Rainy Mild High Weak yes5 Rainy Cool Normal Weak yes6 Rainy Cool Normal Strong no7 Overcast Cool Normal Strong yes8 Sunny Mild High Weak no9 Sunny Cool Normal Weak yes10 Rainy Mild Normal Weak yes11 Sunny Mild Normal Strong yes12 Overcast Mild High Strong yes13 Overcast Hot Normal Weak yes14 Rainy Mild High Strong noend程序输出决策树如下可以⽤图形表⽰为有了决策树后,就可以根据⽓候条件做预测了例如如果⽓候数据是{S unny,Cool,Normal,Strong} ,根据决策树到左侧的yes叶节点,可以判定会去游泳。

数据挖掘中ID3算法实现

数据挖掘中ID3算法实现ID3算法是一种常用的决策树算法,它通过对数据集进行属性划分,建立一个由树结构表示的决策模型。

ID3算法的核心是通过信息增益来选择最佳的划分属性。

下面我们将详细介绍ID3算法的实现步骤。

1.准备数据集2.计算信息熵在信息论中,熵是对信息不确定性的度量。

在ID3算法中,我们需要计算数据集的信息熵,以此来确定最佳的划分属性。

信息熵的计算公式如下:其中,P(i)是样本中类别i的概率。

3.计算属性的信息增益属性的信息增益是用来度量将数据集划分成不同属性值时的信息增益量。

属性的信息增益越大,表示该属性对最终分类的贡献越大。

属性的信息增益的计算公式如下:其中,H(D)是数据集的信息熵,H(D,A)是在属性A已知的条件下,数据集D的条件熵。

4.选择最佳的划分属性根据上一步计算得到的属性的信息增益,我们可以选择信息增益最大的属性作为最佳的划分属性。

5.构建决策树根据最佳的划分属性,将数据集划分成若干子集,并为每个子集递归地重复上述过程。

直到所有的子集都属于同一类别或者子集为空时,停止划分。

6.决策预测最终,我们可以利用构建好的决策树对新样本进行分类预测。

通过遍历决策树的路径,将新样本划分到对应的叶节点,即可得到预测的类别。

需要注意的是,ID3算法在处理连续值属性和缺失值时存在一些问题。

为了解决这些问题,可以使用其他改进的决策树算法,如C4.5算法和CART算法。

以上就是ID3算法的实现步骤。

通过对数据集进行属性划分,建立决策树模型,我们可以利用这个模型对新样本进行分类预测。

ID3算法是一种简单而有效的数据挖掘算法,在实践中被广泛应用。

python实现ID3决策树算法

python实现ID3决策树算法决策树之ID3算法及其Python实现,具体内容如下主要内容决策树背景知识决策树⼀般构建过程ID3算法分裂属性的选择ID3算法流程及其优缺点分析ID3算法Python代码实现1. 决策树背景知识 决策树是数据挖掘中最重要且最常⽤的⽅法之⼀,主要应⽤于数据挖掘中的分类和预测。

决策树是知识的⼀种呈现⽅式,决策树中从顶点到每个结点的路径都是⼀条分类规则。

决策树算法最先基于信息论发展起来,经过⼏⼗年发展,⽬前常⽤的算法有:ID3、C4.5、CART算法等。

2. 决策树⼀般构建过程 构建决策树是⼀个⾃顶向下的过程。

树的⽣长过程是⼀个不断把数据进⾏切分细分的过程,每⼀次切分都会产⽣⼀个数据⼦集对应的节点。

从包含所有数据的根节点开始,根据选取分裂属性的属性值把训练集划分成不同的数据⼦集,⽣成由每个训练数据⼦集对应新的⾮叶⼦节点。

对⽣成的⾮叶⼦节点再重复以上过程,直到满⾜特定的终⽌条件,停⽌对数据⼦集划分,⽣成数据⼦集对应的叶⼦节点,即所需类别。

测试集在决策树构建完成后检验其性能。

如果性能不达标,我们需要对决策树算法进⾏改善,直到达到预期的性能指标。

注:分裂属性的选取是决策树⽣产过程中的关键,它决定了⽣成的决策树的性能、结构。

分裂属性选择的评判标准是决策树算法之间的根本区别。

3. ID3算法分裂属性的选择——信息增益 属性的选择是决策树算法中的核⼼。

是对决策树的结构、性能起到决定性的作⽤。

ID3算法基于信息增益的分裂属性选择。

基于信息增益的属性选择是指以信息熵的下降速度作为选择属性的⽅法。

它以的信息论为基础,选择具有最⾼信息增益的属性作为当前节点的分裂属性。

选择该属性作为分裂属性后,使得分裂后的样本的信息量最⼤,不确定性最⼩,即熵最⼩。

信息增益的定义为变化前后熵的差值,⽽熵的定义为信息的期望值,因此在了解熵和信息增益之前,我们需要了解信息的定义。

信息:分类标签xi 在样本集 S 中出现的频率记为 p(xi),则 xi 的信息定义为:−log2p(xi) 。

数据挖掘ID3算法

第6章 决策树

决策树算法

决策树的用途

计 数 64 64 128 60 64 64 64 年龄 青 青 中 老 老 老 中 收入 高 高 高 中 低 低 低 学生 否 否 否 否 是 是 是 信誉 良 优 良 良 良 优 优 归类:买计算机? 不买 不买 买 买 买 不买 买

假定公司收集了左表数据,那么对 于任意给定的客人(测试样例), 你能帮助公司将这位客人归类吗? 即:你能预测这位客人是属于“买” 计算机的那一类,还是属于“不买” 计算机的那一类? 又:你需要多少有关这位客人的信 息才能回答这个问题?

第6章 决策树

关于分类问题

名称 人类 海龟 鸽子 鲸 体温 恒温 冷血 恒温 恒温 表皮覆 盖 毛发 鳞片 羽毛 毛发

决策树基本概念

胎生 是 否 否 是 水生动 物 否 半 否 是 飞行动 物 否 否 是 否 有腿 是 是 是 否 冬眠 否 否 否 否 类标号 哺乳动 物 爬行类 鸟类 哺乳类

X 分类与回归 分类目标属性y是离散的,回归目标属性y是连续的

良

良 良 优 优 良 优 优

不买

买 买 买 买 买 不买 买

第6章 决策树

决策树的用途

计 数 年龄 收入 学生 信誉

决策树算法

归类:买 计算机?

64

64 128 60

青

青 中 老

高

高 高 中

否

否 否 否

良

优 良 良

不买

不买 买 买

谁在买计算机?

年龄? 青 老

64

64 64 128 64 132 64 32 32

1、Hunt,Marin和Stone 于1966年研制的CLS学习系统,用于学习单个概 念。 2、1979年, J.R. Quinlan 给出ID3算法,并在1983年和1986年对ID3 进行 了总结和简化,使其成为决策树学习算法的典型。 3、Schlimmer 和Fisher 于1986年对ID3进行改造,在每个可能的决策树 节点创建缓冲区,使决策树可以递增式生成,得到ID4算法。 4、1988年,Utgoff 在ID4基础上提出了ID5学习算法,进一步提高了效 率。 1993年,Quinlan 进一步发展了ID3算法,改进成C4.5算法。 5、另一类决策树算法为CART,与C4.5不同的是,CART的决策树由二 元逻辑问题生成,每个树节点只有两个分枝,分别包括学习实例的正 例与反例。

id3算法的具体流程

id3算法的具体流程下载温馨提示:该文档是我店铺精心编制而成,希望大家下载以后,能够帮助大家解决实际的问题。

文档下载后可定制随意修改,请根据实际需要进行相应的调整和使用,谢谢!并且,本店铺为大家提供各种各样类型的实用资料,如教育随笔、日记赏析、句子摘抄、古诗大全、经典美文、话题作文、工作总结、词语解析、文案摘录、其他资料等等,如想了解不同资料格式和写法,敬请关注!Download tips: This document is carefully compiled by theeditor. I hope that after you download them,they can help yousolve practical problems. The document can be customized andmodified after downloading,please adjust and use it according toactual needs, thank you!In addition, our shop provides you with various types ofpractical materials,such as educational essays, diaryappreciation,sentence excerpts,ancient poems,classic articles,topic composition,work summary,word parsing,copy excerpts,other materials and so on,want to know different data formats andwriting methods,please pay attention!1. 数据预处理:收集数据集,包括特征和目标变量。

对数据进行清洗和预处理,例如处理缺失值、异常值等。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

% region - Decision region vector: [-x x -y y number_of_points]

delta_Ib = zeros(1, Ni);

P = zeros(length(Uc), Nbins);

for i = 1:Ni,

for j = 1:length(Uc),

for k = 1:Nbins,

indices = find((targets == Uc(j)) & (features(i,:) == k));

end

%END use_tree

function tree = make_tree(features, targets, inc_node, Nbins)

%Build a tree recursively

[Ni, L] = size(features);

Uc = unique(targets);

for i = 1:Ni,

Pnode(i) = length(find(targets == Uc(i))) / L;

end

Inode = -sum(Pnode.*log(Pnode)/log(2));

%For each dimension, compute the gain ratio impurity

if isfinite(tree.child(i)),

targets(in) = tree.child(i);

else

%No data was found in the training set for this bin, so choose it randomally

n = 1 + floor(rand(1)*length(Uc));

targets(in) = Uc(n);

end

end

end

break

end

[H, binned_xy] = high_histogram(flatxy, Nbins, region);

%Build the tree recursively

disp('Building tree')

tree = make_tree(binned_features, train_targets, inc_node, Nbins);

id3

function D = ID3(train_features, train_targets, params, region)

% Classify using Quinlan's ID3 algorithm

% Inputs:

% features - Train features

% targets - Train targets

%For the decision region

N = region(5);

mx = ones(N,1) * linspace (region(1),region(2),N);

my = linspace (region(3),region(4),N)' * ones(1,N);

for i = 1:Nbins,

tree.split_dim = 0;

indices = find(features == i);

if ~isempty(indices),

if (length(unique(targets(indices))) == 1),

tree.split_dim = dim;

dims = find(~ismember(1:Ni, dim));

for i = 1:Nbins,

indices = find(features(dim, :) == i);

tree.child(i) = make_tree(features(dims, indices), targets(indices), inc_node, Nbins);

P

end

Pk = sum(P);

P = P/L;

Pk = Pk/sum(Pk);

info = sum(-P.*log(eps+P)/log(2));

%When to stop: If the dimension is one or the number of examples is small

if ((Ni == 1) | (inc_node > L)),

%Compute the children non-recursively

%And classify according to it

for i = 1:Nbins,

in = indices(find(features(dim, indices) == i));

targets = targets + use_tree(features(dims, :), in, tree.child(i), Nbins, Uc);

%Make the decision region according to the tree

disp('Building decision surface using the tree')

targets = use_tree(binned_xy, 1:N^2, tree, Nbins, unique(train_targets));

flatxy = [mx(:), my(:)]';

%Preprocessing

[f, t, UW, m] = PCA(train_features, train_targets, Ni, region);

train_features = UW * (train_features - m*ones(1,M));;

D = reshape(targets,N,N);

%END

function targets = use_tree(features, indices, tree, Nbins, Uc)

%Classify recursively using a tree

targets = zeros(1, size(features,2));

if (size(features,1) == 1),

%Only one dimension left, so work on it

for i = 1:Nbins,

in = indices(find(features(indices) == i));

if ~isempty(in),

%This is not the last level of the tree, so:

%First, find the dimension we are to work on

dim = tree.split_dim;

dims= find(~ismember(1:size(features,1), dim));

tree.child(i) = Uc(T);

end

else

tree.child(i) = inf;

end

end

break

end

%Compute the node's I

delta_Ib(i) = (Inode-sum(Pk.*info))/-sum(Pk.*log(eps+Pk)/log(2));

end

%Find the dimension minimizing delta_Ib

[m, dim] = max(delta_Ib);

%Split along the 'dim' dimension

flatxy = UW * (flatxy - m*ones(1,N^2));;

%First, bin the data and the decision region data

[H, binned_features]= high_histogram(train_features, Nbins, region);

end

tree.child(i) = targets(indices(1));

else

H = hist(targets(indices), Uc);

[m, T] = max(H);

%

% Outputs

% D - Decision sufrace

[Ni, M] = size(train_features);

%Get parameters

[Nbins, inc_node] = process_params(params);

inc_node = inc_node*M/100;