利用sklearn做文本分类(特征提取、knnsvm聚类)

文本聚类过程

文本聚类过程文本聚类是一种将文本数据分组的技术,它可以将相似的文本归为一类,从而更好地理解和分析文本数据。

文本聚类过程包括以下几个步骤:1. 数据预处理在进行文本聚类之前,需要对文本数据进行预处理。

预处理包括去除停用词、词干提取、词向量化等步骤。

去除停用词是指去除一些常见的无意义词汇,如“的”、“是”等。

词干提取是指将单词的不同形态转化为其基本形式,如将“running”转化为“run”。

词向量化是指将文本数据转化为向量形式,以便于计算相似度。

2. 特征提取在进行文本聚类之前,需要将文本数据转化为特征向量。

常用的特征提取方法包括词袋模型、TF-IDF模型等。

词袋模型是指将文本数据转化为一个词汇表,然后统计每个单词在文本中出现的次数,将其转化为向量形式。

TF-IDF模型是指将每个单词的重要性加权,以便于更好地区分不同的文本。

3. 相似度计算在进行文本聚类之前,需要计算文本之间的相似度。

常用的相似度计算方法包括余弦相似度、欧几里得距离等。

余弦相似度是指将文本向量进行归一化,然后计算它们之间的夹角余弦值。

欧几里得距离是指计算文本向量之间的欧几里得距离。

4. 聚类算法在进行文本聚类之前,需要选择合适的聚类算法。

常用的聚类算法包括K-Means算法、层次聚类算法等。

K-Means算法是一种基于距离的聚类算法,它将文本数据分为K个簇,每个簇的中心点是该簇中所有文本向量的平均值。

层次聚类算法是一种基于相似度的聚类算法,它将文本数据分为一棵树形结构,每个节点代表一个簇,节点之间的距离表示簇之间的相似度。

5. 聚类评估在进行文本聚类之后,需要对聚类结果进行评估。

常用的聚类评估指标包括轮廓系数、互信息等。

轮廓系数是指将每个文本向量与其所属簇中其他文本向量的相似度与该文本向量与其他簇中文本向量的相似度进行比较,以评估聚类结果的质量。

互信息是指将聚类结果与真实标签进行比较,以评估聚类结果的准确性。

文本聚类是一种重要的文本分析技术,它可以帮助我们更好地理解和分析文本数据。

文心一言 文本分类

文心一言文本分类文心一言是一个开源的短文本分类数据集,用于进行文本分类任务。

它包含了一系列短文本和相应的标签,可用于训练和评估文本分类模型。

以下是使用 Python 进行文本分类的示例代码,使用了文心一言数据集和scikit-learn库:from sklearn.feature_extraction.text import TfidfVectorizerfrom sklearn.svm import SVCfrom sklearn.metrics import classification_reportfrom sklearn.model_selection import train_test_splitimport pandas as pd# 读取文心一言数据集data = pd.read_csv('文心一言.csv')# 将文本和标签分别存储在X和y中X = data['text']y = data['label']# 将文本转换为TF-IDF特征向量表示vectorizer = TfidfVectorizer()X_tfidf = vectorizer.fit_transform(X)# 划分训练集和测试集X_train, X_test, y_train, y_test = train_test_split(X_tfidf, y, test_size=0.2, random_state=42)# 训练支持向量机分类模型svm_model = SVC()svm_model.fit(X_train, y_train)# 在测试集上进行预测y_pred = svm_model.predict(X_test)# 输出分类报告print(classification_report(y_test, y_pred))这段代码首先使用pandas库读取文心一言数据集,并将文本和标签分别存储在X和y中。

利用SVM进行文本分类并研究特征选择对文本分类的影响

利用SVM进行文本分类并研究特征选择对文本分类的影响SVM(支持向量机)是一种常用于文本分类的机器学习算法。

它的主要思想是将文本数据映射到高维向量空间,并在此空间中构建一个超平面来实现分类。

特征选择是在特定的文本分类任务中选择最相关特征的过程。

本文将研究特征选择对SVM文本分类的影响。

一、SVM文本分类的基本步骤SVM文本分类的基本步骤包括数据预处理、特征提取、特征选择和模型训练四个主要阶段。

1.数据预处理:这一步骤包括去除文本中的停用词、标点符号等无用信息,同时进行词干化和词向量化处理,将文本转换为向量表示。

2.特征提取:常用的特征提取方法有词袋模型和TF-IDF模型。

词袋模型统计文档中每个词的出现频率,将其构成一个向量。

TF-IDF模型基于词袋模型,加入了对词频的权重调整,更准确地反映了词对文档的重要性。

3.特征选择:特征选择是从所有特征中选择最有用的特征,以提高分类器的性能。

常用的特征选择方法有信息增益、卡方检验和互信息等。

4.模型训练:最后,使用选择的特征和标注的训练集来训练SVM分类器,通过调整超参数,如正则化参数C和核函数类型等,来优化模型的性能。

特征选择在SVM文本分类中起着至关重要的作用,它能够减少特征维度,提高分类效果。

以下是特征选择对文本分类的影响:1.维度减少:文本数据往往具有高维度,而很多特征无关或冗余。

通过特征选择可以减少特征维度,消除冗余信息,提高计算效率。

2.加快训练速度:特征选择可以减少训练样本的数量,从而缩短SVM 模型的训练时间。

特征选择能够剔除一些对分类任务无关的特征,使得模型更快速地收敛。

3.提高分类性能:特征选择有助于找到与分类任务最相关的特征,去除冗余和噪声,从而提高分类器的泛化能力和分类性能。

4.解释性:选择最相关的特征可以增加对分类结果的可解释性。

通过特征选择,我们可以更好地理解哪些特征对分类有贡献,有助于进一步分析文本数据的规律和特点。

三、特征选择方法1.信息增益:信息增益是通过比较每个特征与分类结果之间的关联性来衡量特征的重要性。

文本类型数据的特征提取以及相似度计算

文本类型数据的特征提取以及相似度计算随着信息技术的发展,文本数据不断增长,如何从大量的文本数据中提取有用的信息成为一项重要任务。

而文本特征提取和相似度计算是解决这一问题的关键步骤。

一、文本特征提取特征提取是将文本数据转化为计算机可以处理的数值向量的过程。

常用的文本特征提取方法有:1.词袋模型(Bag-of-Words):将文本看作是由词汇组成的集合,构建一个词汇表,然后统计每个词汇在文本中的出现频率。

这种方法忽略了词汇的顺序和语法结构,只关注词汇的频率。

2.TF-IDF:TF-IDF(Term Frequency-Inverse Document Frequency)是一种衡量词汇在文本中重要性的方法。

它通过计算词频和逆文档频率的乘积来衡量词汇在文本中的重要程度。

3.Word2Vec:Word2Vec是一种基于神经网络的词嵌入模型,可以将词汇映射到一个低维向量空间中。

这种方法能够捕捉词汇之间的语义关系,同时保留了词汇的语法结构。

二、相似度计算相似度计算是衡量文本之间相似程度的方法。

常用的相似度计算方法有:1.余弦相似度:余弦相似度是通过计算两个向量之间的夹角余弦值来衡量它们的相似程度。

在文本特征提取中,可以将文本表示为向量,然后计算它们之间的余弦相似度。

2.编辑距离:编辑距离是衡量两个字符串之间相似程度的方法。

它通过计算将一个字符串转换为另一个字符串所需的最少编辑操作次数来衡量它们的相似程度。

3.基于语义的相似度:基于语义的相似度是通过计算两个文本之间的语义距离来衡量它们的相似程度。

常用的方法有基于词向量的相似度计算和基于语义网络的相似度计算。

三、应用场景文本特征提取和相似度计算在许多领域都有广泛的应用。

以下是一些常见的应用场景:1.文本分类:通过提取文本的特征,并计算不同文本之间的相似度,可以实现文本的自动分类。

例如,可以将新闻文章分类为政治、经济、体育等不同类别。

2.信息检索:通过计算查询文本和文档之间的相似度,可以实现信息的准确检索。

物联网-机器学习模型调优与优化考试

物联网-机器学习模型调优与优化考试(答案见尾页)一、选择题1. 在物联网应用中,机器学习模型的训练数据通常包括哪些方面?A. 输入特征和输出标签B. 输入特征和部分输出标签C. 部分输入特征和输出标签D. 全部输入特征和全部输出标签2. 以下哪种方法不属于常见的机器学习模型调参策略?A. 网格搜索B. 随机搜索C. 贝叶斯优化D. 遗传算法3. 在Python中,用于导入scikit-learn库的关键字是什么?A. importB. fromC. import scikit-learn as sklearnD. import sklearn4. 以下哪些算法可以用于处理分类问题?A. SVMB. KNNC. Decision TreeD. Random Forest5. 以下哪个指标可以用来评估模型的准确性?A. F1值B. ROC曲线C. 精确度6. 在Keras中,如何对模型进行编译?A. pile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])B. model.fit(X_train, y_train, epochs=10)C. model.evaluate(X_test, y_test)D. model.predict(X_new)7. 在Python中,用于创建字典的关键字是什么?A. dict()B. create()C. dict{}D. new8. 以下哪些技术可以帮助提高模型的泛化能力?A. 数据增强B. 集成学习C. 正则化D. Dropout9. 在Scikit-learn中,如何实现交叉验证?A. cross_val_scoreB. cross_validateC. cross_validationD. cross Validation10. 以下哪些算法属于监督学习算法?A. SVMB. KNNC. Decision TreeD. Random Forest11. 以下哪种方法不属于无监督学习算法?A. K-MeansB. PCAD. Random Forest12. 在Python中,用于导入Pandas库的关键字是什么?A. import pandas as pdB. import pandasC. pandasD. pandas []13. 以下哪些算法可以用于回归问题?A. SVMB. KNNC. Decision TreeD. Random Forest14. 以下哪个函数是用于生成随机训练样本的?A. train_test_splitB. random_stateC. seedD. train_test_split15. 以下哪种方法可以用于降低过拟合的风险?A. 增加训练集大小B. 使用正则化C. 减小网络深度或宽度D. 增加学习率16. 在Keras中,以下哪项不是常用的损失函数?A. binary_crossentropyB. mean_squared_errorC. categorical_crossentropyD. hinge17. 以下哪种模型适用于文本分类问题?B. KNNC. Decision TreesD. Neural Networks18. 在Python中,以下哪种方法用于创建决策树?A. decisionTreeClassifierB. treeC. DecisionTreeD. classify19. 在Scikit-learn中,以下哪种方法可以用于降维?A. PCAB. t-SNEC. autoencodersD. dimension reduction20. 以下哪些算法可以用于聚类?A. K-MeansB. DBSCANC. AgglomerativeClusteringD. HierarchicalClustering21. 以下哪种模型适用于时间序列预测问题?A. SVMsB. LSTMC. GRUD. Decision Trees22. 在Python中,以下哪种方法用于导入NumPy库?A. import numpy as npB. import numpyC. NumpyD. np23. 以下哪些算法可以用于降维?B. t-SNEC. autoencodersD. dimension reduction24. 以下哪种模型适用于图像分类问题?A. SVMsB. Convolutional Neural Networks (CNNs)C. Decision TreesD. Random Forests25. 在Keras中,以下哪种层可以用于实现卷积神经网络?A. DenseB. Conv2DC. MaxPooling2DD. Flatten26. 以下哪种方法可以用于生成特征向量?A. one-hot encodingB. PCAC. t-SNED. autoencoders27. 以下哪些算法可以用于特征提取?A. SVMsB. KNNC. Decision TreesD. Random Forests28. 在Scikit-learn中,以下哪种方法可以用于生成随机搜索空间?A. GridSearchCVB. RandomizedSearchCVC. BayesianOptimizationD. grid_search29. 以下哪种模型适用于多类别分类问题?B. Decision TreesC. Random ForestsD. Support Vector Machines with a softmax output layer30. 在Python中,以下哪种函数可以用于计算两个数组的相似度?A. cosine similarityB. euclidean distanceC. jaccard similarityD. mitochondrial similarity31. 以下哪种方法可以用于处理缺失值?A. 删除缺失值B. 填充缺失值C. 均值 imputationD. 中位数 imputation32. 以下哪种模型适用于文本分类问题?A. SVMsB. KNNC. Decision TreesD. Neural Networks33. 在Keras中,以下哪种方法可以用于调整模型参数?A. model.fit(X_train, y_train, epochs=10)B. pile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])C. model.predict(X_test)D. model.evaluate(X_test, y_test)34. 以下哪些指标可以用于评估模型的性能?A. accuracyB. precisionC. recallD. F1 score35. 在Scikit-learn中,以下哪种方法可以用于获取特征重要性?A. feature_importances_B. importance_values_C. feature_selectorD. feature_selection36. 以下哪些算法可以用于生成树的表示形式?A. NP树B. AVL树C. B+树D. 决策树37. 以下哪种模型适用于回归问题?A. SVMsB. KNNC. Decision TreesD. Random Forests38. 在Python中,以下哪种方法可以用于创建字典?A. dict()B. create()C. dict{}D. new39. 以下哪种方法可以用于生成二进制序列?A. str.zfill()B. str.bfill()C. str.rjust()D. str.center()40. 以下哪种算法可以用于降维?A. PCAB. t-SNEC. autoencodersD. dimension reduction二、问答题1. 什么是物联网?2. 什么是机器学习?3. 什么是物联网机器学习模型?4. 为什么需要对物联网机器学习模型进行调优和优化?5. 如何对物联网机器学习模型进行调优?6. 什么是超参数调优?在物联网机器学习中,如何进行超参数调优?7. 什么是模型集成?在物联网机器学习中,为什么要使用模型集成?8. 如何评估物联网机器学习模型的性能?参考答案选择题:1. A2. D3. C4. A、C、D5. D6. A7. A8. A、B、C、D9. B 10. A、C、D11. D 12. A 13. A、C、D 14. B 15. B 16. D 17. D 18. C 19. A 20. A、C、D21. B、C 22. A 23. A、C 24. B 25. B 26. C 27. B、C 28. B 29. D 30. A31. B、C 32. D 33. B 34. A、C、D 35. B 36. D 37. D 38. A 39. A 40. A问答题:1. 什么是物联网?物联网是指通过网络将物理设备、传感器、软件和人类智能连接起来进行信息交换和通信的技术。

机器学习--K近邻(KNN)算法的原理及优缺点

机器学习--K近邻(KNN)算法的原理及优缺点⼀、KNN算法原理 K近邻法(k-nearst neighbors,KNN)是⼀种很基本的机器学习⽅法。

它的基本思想是:在训练集中数据和标签已知的情况下,输⼊测试数据,将测试数据的特征与训练集中对应的特征进⾏相互⽐较,找到训练集中与之最为相似的前K个数据,则该测试数据对应的类别就是K个数据中出现次数最多的那个分类。

由于KNN⽅法主要靠周围有限的邻近的样本,⽽不是靠判别类域的⽅法来确定所属类别的,因此对于类域的交叉或重叠较多的待分样本集来说,KNN⽅法较其他⽅法更为适合。

KNN算法不仅可以⽤于分类,还可以⽤于回归。

通过找出⼀个样本的k个最近邻居,将这些邻居的属性的平均值赋给该样本,就可以得到该样本的属性。

更有⽤的⽅法是将不同距离的邻居对该样本产⽣的影响给予不同的权值(weight),如权值与距离成反⽐。

KNN算法的描述: (1)计算测试数据与各个训练数据之间的距离; (2)按照距离的递增关系进⾏排序; (3)选取距离最⼩的K个点; (4)确定前K个点所在类别的出现频率 (5)返回前K个点中出现频率最⾼的类别作为测试数据的预测分类。

算法流程: (1)准备数据,对数据进⾏预处理。

(2)选⽤合适的数据结构存储训练数据和测试元组。

(3)设定参数,如k。

(4)维护⼀个⼤⼩为k的的按距离由⼤到⼩的优先级队列,⽤于存储最近邻训练元组。

随机从训练元组中选取k个元组作为初始的最近邻元组,分别计算测试元组到这k个元组的距离,将训练元组标号和距离存⼊优先级队列。

(5)遍历训练元组集,计算当前训练元组与测试。

元组的距离,将所得距离L 与优先级队列中的最⼤距离Lmax。

(6)进⾏⽐较。

若L>=Lmax,则舍弃该元组,遍历下⼀个元组。

若L < Lmax,删除优先级队列中最⼤距离的元组,将当前训练元组存⼊优先级队列。

(7)遍历完毕,计算优先级队列中k 个元组的多数类,并将其作为测试元组的类别。

python 分类变量 聚类方法

Python分类变量聚类方法在数据分析和机器学习领域,我们经常需要处理各种不同类型的数据。

其中,分类变量是一种常见的数据类型,它包括了诸如性别、颜色、地区等离散的取值。

而对于含有分类变量的数据,我们通常需要采取特定的方法来进行聚类分析,以便更好地理解数据之间的关系和特点。

在Python语言中,有许多强大的库和工具可供我们使用,用于处理包含分类变量的数据,并进行聚类分析。

下面,我将介绍几种常用的Python分类变量聚类方法,并结合具体示例来说明它们的应用。

1. K-Modes算法K-Modes算法是一种基于众数的聚类算法,它专门用于处理包含分类变量的数据。

与K-Means算法不同的是,K-Modes算法不仅考虑数据点的数值距离,还考虑了分类变量之间的距离。

这使得K-Modes算法在处理混合数据时表现更加出色。

举个例子,假设我们有一个包含性别、喜好、地区等分类变量的顾客数据集,我们可以使用K-Modes算法对这些顾客进行聚类,以发现不同群体之间的特征和规律。

2. 二元变量的分组聚类对于只包含两种取值的分类变量,我们可以采用二元变量的分组聚类方法。

这种方法通过计算变量之间的相似度,将相似的变量划分到同一类别中。

在Python中,我们可以使用scikit-learn库中的聚类算法来实现这一过程。

举个例子,假设我们有一个包含红色、绿色和蓝色三种颜色的分类变量数据集,我们可以使用二元变量的分组聚类方法来将这些颜色进行聚类,以便找出彼此相似的颜色组合。

3. 结合数值变量的混合聚类在实际数据分析中,除了分类变量外,数据集通常还包含数值变量。

为了更全面地进行聚类分析,我们可以结合数值变量和分类变量,使用混合聚类方法来探索数据的特征。

举个例子,假设我们有一个包含芳龄、收入和地区等数值变量,以及性别、喜好等分类变量的顾客数据集,我们可以使用混合聚类方法对这些变量进行聚类,以揭示不同群体的特征和规律。

总结回顾在本文中,我们介绍了Python中常用的分类变量聚类方法,并结合具体示例进行了说明。

利用自然语言处理技术进行文本匹配的方法与技巧

自然语言处理技术(NLP)是一种人工智能技术,旨在使计算机能够理解、解释和处理人类语言。

文本匹配作为NLP领域的一个重要应用,常常被用于信息检索、文档对比、问答系统等领域。

在本文中,我们将讨论利用自然语言处理技术进行文本匹配的方法与技巧。

一、文本预处理文本预处理是文本匹配的第一步,它包括分词、去除停用词、词干化等操作。

分词是将文本切分为单词或短语的过程,常用的分词工具包括jieba、NLTK等。

去除停用词是指去除对文本匹配无意义的词,如“的”、“了”、“是”等。

词干化是将词语变为其词干或词根的过程,如将“running”变为“run”。

通过文本预处理,可以使文本更加规范化、准确化,有利于后续的文本匹配操作。

二、特征提取特征提取是文本匹配的关键步骤,它将文本转化为计算机可处理的特征表示。

常用的特征提取方法包括词袋模型、TF-IDF、Word2Vec等。

词袋模型将文本表示为词频向量,不考虑词语之间的顺序和语义关系。

TF-IDF(Term Frequency-Inverse Document Frequency)是一种用于评估词语在文本和语料库中重要程度的方法,它考虑了词语在文本中的频率和在语料库中的稀有程度。

Word2Vec是一种基于神经网络的词向量表示方法,它能够捕捉词语之间的语义关系。

通过特征提取,可以将文本转化为向量表示,为后续的文本匹配任务提供输入。

三、相似度计算相似度计算是文本匹配的核心内容,它用于衡量两个文本之间的相似程度。

常用的相似度计算方法包括余弦相似度、Jaccard相似度、编辑距离等。

余弦相似度是一种用于计算两个向量之间夹角的相似度指标,它常用于衡量文本语义的相似程度。

Jaccard相似度是一种用于计算两个集合之间相似度的指标,它常用于衡量文本词语的相似程度。

编辑距离是一种用于计算两个字符串之间差异的指标,它常用于衡量文本的拼写相似程度。

通过相似度计算,可以得到文本之间的相似度分数,为文本匹配的结果提供依据。

文本 特征 提取 算法

文本特征提取算法文本特征提取算法是自然语言处理领域的重要研究方向之一。

在文本处理过程中,为了将文本转化为可供机器学习或其他算法处理的特征表示,需要进行特征提取。

本文将介绍几种常用的文本特征提取算法,并分析它们的优缺点。

首先,常用的文本特征提取算法之一是词袋模型。

词袋模型将文本看作是由词汇表中的词组成的集合,忽略了词序和语法等信息。

它通过统计每个词在文本中出现的次数或频率来表示文本特征。

词袋模型简单且易于实现,但无法捕捉词语之间的关系,因此在处理语义信息时存在局限性。

其次,n-gram模型是一种常见的文本特征提取算法。

n-gram模型通过考虑相邻词之间的关系,将文本表示为n个连续词的序列。

常用的是2-gram和3-gram模型,即考虑相邻两个或三个词的组合。

n-gram模型可以在一定程度上捕捉词语之间的语义关联,但对于长文本和高维特征空间的数据处理效果较差。

此外,TF-IDF(Term Frequency-Inverse Document Frequency)是另一种常用的文本特征提取算法。

TF-IDF通过计算词频和逆文档频率来评估词语在文本中的重要性。

词频指的是某个词在文本中出现的次数,而逆文档频率则是所有文本中包含该词的文档数的倒数的对数。

TF-IDF可以较好地捕捉到词语的重要性和区分能力,常用于信息检索和文本分类等任务。

最后,基于词向量的文本特征提取算法也在近年来得到广泛应用。

词向量是将词语表示为实数向量的一种方法,可以通过训练神经网络模型或使用预训练的词向量模型来获取。

基于词向量的文本表示方法能够克服传统方法中的一些问题,如词语维度灾难和语义表示能力不足等。

综上所述,文本特征提取算法在自然语言处理中起着重要作用。

词袋模型、n-gram模型、TF-IDF和基于词向量的方法都有各自的特点和适用场景。

在实际应用中,根据具体任务和数据特点选择合适的算法是关键。

通过合理选择和结合多种特征提取算法,可以提取出更全面、准确的文本特征,为后续的文本处理和分析任务提供有力支持。

文本特征提取方法

文本特征提取方法文本特征提取是自然语言处理(Natural Language Processing, NLP)中的重要任务之一,其目的是从文本数据中提取有意义的信息,以便用于各种文本分析任务,如情感分析、文本分类、信息检索等。

下面我将介绍几种常用的文本特征提取方法。

1. 词频(Term Frequency, TF):将文本表示为每个单词在文档中出现的频率。

对于一个给定的文档,计算每个单词在文档中出现的次数,并将其归一化,得到每个单词的词频。

2. 逆文档频率(Inverse Document Frequency, IDF):衡量单词对于整个文本集合的重要性。

该方法通过计算一个单词在文档集合中出现的文档数量与总文档数的比值的倒数,来表示单词的重要程度。

3. 词袋模型(Bag-of-Words, BoW):将文本表示为单词的集合,忽略单词在文档中的顺序。

该方法通过统计每个单词在文档中出现的次数,将文本表示为一个向量。

4. n-gram 模型:通过考虑相邻单词的组合来建模文本。

n-gram 模型将文本表示为连续的 n 个单词的集合。

例如,2-gram 模型(也称为bigram 模型)将文本表示为相邻两个单词的组合。

n-gram 模型捕捉了单词之间的语义信息和上下文关系。

5.TF-IDF模型:是将词频和逆文档频率的方法结合起来,用于表示文本的重要度。

通过将词频乘以逆文档频率,得到一个单词的TF-IDF值,表示其在文档中的重要性。

6. 主题模型(Topic Model):通过概率模型将文本表示为一组主题(topic)的分布。

主题模型用于发现文本中的主题,并用于文本的表示和聚类。

7. 单词嵌入(Word Embedding):将单词映射到一个低维向量空间,以表示其语义信息。

单词嵌入方法如 Word2Vec 和 GloVe 通过学习上下文关系,将语义相近的单词映射到彼此相邻的向量。

8.文本结构特征:除了单词级别的特征,还可以考虑文本的结构信息。

2.2:监督学习的基本分类模型(KNN、决策树、朴素贝叶斯)

2.2:监督学习的基本分类模型(KNN、决策树、朴素贝叶斯)K近邻分类器(KNN)KNN:通过计算待分类数据点,与已有数据集中的所有数据点的距离。

取距离最⼩的前K个点,根据“少数服从多数“的原则,将这个数据点划分为出现次数最多的那个类别。

sklearn中的K近邻分类器在sklearn库中,可以使⽤sklearn.neighbors.KNeighborsClassifier创建⼀个K近邻分类器,主要参数有:• n_neighbors:⽤于指定分类器中K的⼤⼩(默认值为5,注意与kmeans的区别)• weights:设置选中的K个点对分类结果影响的权重(默认值为平均权重“uniform”,可以选择“distance”代表越近的点权重越⾼,或者传⼊⾃⼰编写的以距离为参数的权重计算函数)• algorithm:设置⽤于计算临近点的⽅法,因为当数据量很⼤的情况下计算当前点和所有点的距离再选出最近的k各点,这个计算量是很费时的,所以(选项中有ball_tree、kd_tree和brute,分别代表不同的寻找邻居的优化算法,默认值为auto,根据训练数据⾃动选择)K近邻分类器的使⽤创建⼀组数据 X 和它对应的标签 y:>>> X = [[0], [1], [2], [3]]>>> y = [0, 0, 1, 1]使⽤ import 语句导⼊ K 近邻分类器:>>> from sklearn.neighbors import KNeighborsClassifier参数 n_neighbors 设置为 3,即使⽤最近的3个邻居作为分类的依据,其他参数保持默认值,并将创建好的实例赋给变量 neigh。

>>> neigh = KNeighborsClassifier(n_neighbors=3)调⽤ fit() 函数,将训练数据 X 和标签 y 送⼊分类器进⾏学习。

scikit-learn使用手册

scikit-learn使用手册Scikit-learn是一个功能强大的Python机器学习库,提供了各种各样的机器学习算法和工具,以帮助开发者构建高效准确的机器学习模型。

本使用手册将介绍Scikit-learn的基本功能和用法,以帮助读者快速上手并充分利用这个库。

一、安装与环境配置Scikit-learn依赖于NumPy和SciPy库,在使用之前需要先安装这些依赖项。

在安装完成后,你可以通过以下命令来检查Scikit-learn是否正确安装:```pythonimport sklearnprint(sklearn.__version__)```二、数据预处理在开始使用Scikit-learn进行机器学习之前,我们通常需要对原始数据进行预处理。

这包括数据清洗、特征选择、特征缩放以及数据拆分等步骤。

1. 数据清洗数据清洗是指从原始数据中去除无效或不完整的样本。

Scikit-learn提供了多种处理缺失数据的方法,例如使用均值来填充缺失值,或者使用最近邻算法来估计缺失值。

2. 特征选择特征选择是指从原始数据中选择最相关的特征,并且去除冗余特征。

Scikit-learn提供了多种特征选择的方法,包括方差阈值、相关系数、主成分分析(PCA)等。

3. 特征缩放特征缩放是指对原始数据的特征进行归一化处理,以消除不同特征之间的量纲差异。

Scikit-learn提供了多种特征缩放的方法,例如标准化(Standardization)和归一化(Normalization)。

4. 数据拆分在机器学习中,我们通常将数据集划分为训练集和测试集。

Scikit-learn提供了便捷的方法用于数据集划分,例如train_test_split函数可以将数据集按指定比例划分为训练集和测试集。

三、机器学习算法Scikit-learn提供了多种机器学习算法,包括分类、回归、聚类、降维等。

下面将介绍其中一些常用的机器学习算法及其使用方法。

数据挖掘实训报告-

项目1:基于sklearn的数据分类挖掘一、项目任务①熟悉sklearn数据挖掘的基本功能。

②进行用朴素贝叶斯、KNN、决策树、SVM算法进行数据分类分析。

二、项目环境及条件三、实验数据Iris数据集Iris数据集是常用的分类实验数据集,由Fisher, 1936收集整理。

Iris也称鸢尾花卉数据集,是一类多重变量分析的数据集。

数据集包含150个数据集,分为3类,每类50个数据,每个数据包含4个属性。

可通过花萼长度,花萼宽度,花瓣长度,花瓣宽度4个属性预测鸢尾花卉属于(Setosa,Versicolour,Virginica)三个种类中的哪一类。

Digits数据集美国著名数据集NIST的子集,模式识别常用实验数据集,图像属于灰度图像。

分辨率为8x8四、项目内容及过程1.读取数据集从sklearn中读取iris和digits数据集并测试打印from sklearn import datasetsiris = ()digits = ()print 'iris:',,'\ndigits:',打印的数据集存在中,ndarray会自动省略较长矩阵的中间部分。

Iris数据集的样本数据为其花瓣的各项属性Digits数据集的样本数据为手写数字图像的像素值2.划分数据集引入sklearn的model_selection使用train_test_split划分digits数据集,训练集和测试集比例为8:2from import train_test_splitx_train,x_test,y_train,y_test=train_test_split,,test_size=print'x_train:',x_train,'\nx_test:',x_test,'\ny_train:',y_train,'\ny_test:',y_test3.使用KNN和SVM对digits测试集分类引用sklearn的和模块调用算法,使用classification_report查看预测结果的准确率和召回率from import classification_reportfrom sklearn import neighborsclf = ()(x_train,y_train)y_pred=(x_test)print classification_report(y_test, y_pred)from import SVCclf = SVC()(x_train,y_train)y_pred=(x_test)print classification_report(y_test, y_pred)KNN的预测结果:所有数字的预测正确率几乎达到了100%SVM的预测结果:对部分数字的预测误差较大,基本情况不如KNN考虑SVM分类器的特性,在分类前对特征值进行标准化后再分类:from sklearn import preprocessingmin_max_scaler = ()x_train = (x_train)x_test = (x_test)标准化数据后SVM的预测结果达到了KNN的准度:4.使用贝叶斯和决策树对iris数据集分类from import train_test_splitx_train,x_test,y_train,y_test=train_test_split,,test_size= from import classification_reportfrom sklearn import naive_bayesclf = ()(x_train,y_train)y_pred=(x_test)print classification_report(y_test, y_pred)from sklearn import treeclf = ()(x_train,y_train)y_pred=(x_test)print classification_report(y_test, y_pred)决策树和贝叶斯都有较好的分类效果五、实验结果分析为什么用svm和knn处理digits数据集,用tree和bayes处理iris数据集,这是一个经验问题。

人工智能自然语言技术练习(习题卷29)

人工智能自然语言技术练习(习题卷29)第1部分:单项选择题,共43题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]最大正向匹配法可以用于( )A)文本分类B)文本特征获取C)分词D)情感分析答案:C解析:2.[单选题]零均值归一化会将原始数据的标准差映射为多少?A)0B)1C)2D)3答案:B解析:3.[单选题]不是逻辑回归与朴素贝叶斯的区别是A)逻辑回归是生成模型B)朴素贝叶斯是判别模型C)朴素贝叶斯需要独立假设D)逻辑回归不需要特征之间的线性答案:D解析:4.[单选题]关于贝叶斯判别规则,下列选项中描述正确的是?A)就是判断自变量和因变量之间的关系B)把特征向量X落入某类集群wi的条件概率平P(wi/X)当成分类判别函数,把X落入某集群的条件概率最大的类为X的分类这种判别规则叫贝叶斯判别规则C)不确定D)就是通过选择最优的超平面去进行最好的分类超平面答案:B解析:5.[单选题]Adam算法的底层原理是A)强化了RMSprop算法B)强化了动量梯度算法C)同时使用Momentum和RMSprop算法D)没有核心答案:C解析:6.[单选题]不属于常用的正则表达式函数的是( )。

C)findallD)matplotlib函数答案:D解析:7.[单选题]BERT-BASE的参数量有多大A)1亿B)2亿C)3亿D)4亿答案:A解析:8.[单选题]relu是常用的激活函数,它可以将小于()的数输出为0A)-1B)0C)1D)x答案:B解析:9.[单选题]零均值归一化是怎么做的A)原始数据进行线性变换B)使 结果映射到[0, 1]的范围C)实现对原始数据的等比缩放D)将原始数据映射到均值为 0、标准差为1的分布上答案:D解析:10.[单选题]决策树可以从以下哪个包中导入A)sklearnB)numpyC)PandasD)matplotlib答案:A解析:11.[单选题]一个汉字在方阵中的坐标,称为该字的“()”。

Python之Sklearn使用入门教程

Python之Sklearn使⽤⼊门教程1.Sklearn简介Scikit-learn(sklearn)是机器学习中常⽤的第三⽅模块,对常⽤的机器学习⽅法进⾏了封装,包括回归(Regression)、降维(Dimensionality Reduction)、分类(Classfication)、聚类(Clustering)等⽅法。

当我们⾯临机器学习问题时,便可根据下图来选择相应的⽅法。

Sklearn具有以下特点:简单⾼效的数据挖掘和数据分析⼯具让每个⼈能够在复杂环境中重复使⽤建⽴NumPy、Scipy、MatPlotLib之上2.Sklearn安装Sklearn安装要求Python(>=2.7 or >=3.3)、NumPy (>= 1.8.2)、SciPy (>= 0.13.3)。

如果已经安装NumPy和SciPy,安装scikit-learn可以使⽤pip install -U scikit-learn。

3.Sklearn通⽤学习模式Sklearn中包含众多机器学习⽅法,但各种学习⽅法⼤致相同,我们在这⾥介绍Sklearn通⽤学习模式。

⾸先引⼊需要训练的数据,Sklearn⾃带部分数据集,也可以通过相应⽅法进⾏构造,4.Sklearn datasets中我们会介绍如何构造数据。

然后选择相应机器学习⽅法进⾏训练,训练过程中可以通过⼀些技巧调整参数,使得学习准确率更⾼。

模型训练完成之后便可预测新数据,然后我们还可以通过MatPlotLib等⽅法来直观的展⽰数据。

另外还可以将我们已训练好的Model进⾏保存,⽅便移动到其他平台,不必重新训练。

from sklearn import datasets#引⼊数据集,sklearn包含众多数据集from sklearn.model_selection import train_test_split#将数据分为测试集和训练集from sklearn.neighbors import KNeighborsClassifier#利⽤邻近点⽅式训练数据###引⼊数据###iris=datasets.load_iris()#引⼊iris鸢尾花数据,iris数据包含4个特征变量iris_X=iris.data#特征变量iris_y=iris.target#⽬标值X_train,X_test,y_train,y_test=train_test_split(iris_X,iris_y,test_size=0.3)#利⽤train_test_split进⾏将训练集和测试集进⾏分开,test_size占30%print(y_train)#我们看到训练数据的特征值分为3类'''[0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 00 0 0 0 0 0 0 0 0 0 0 0 0 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 11 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 12 2 2 2 2 2 2 2 2 2 22 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 2 22 2]'''###训练数据###knn=KNeighborsClassifier()#引⼊训练⽅法knn.fit(X_train,y_train)#进⾏填充测试数据进⾏训练###预测数据###print(knn.predict(X_test))#预测特征值'''[1 1 1 0 2 2 1 1 1 0 0 0 2 2 0 1 2 2 0 1 0 0 0 0 0 0 2 1 0 0 0 1 0 2 0 2 01 2 1 0 0 1 0 2]'''print(y_test)#真实特征值'''[1 1 1 0 1 2 1 1 1 0 0 0 2 2 0 1 2 2 0 1 0 0 0 0 0 0 2 1 0 0 0 1 0 2 0 2 01 2 1 0 0 1 0 2]'''4.Sklearn datasetsSklearn提供⼀些标准数据,我们不必再从其他⽹站寻找数据进⾏训练。

人工智能自然语言技术练习(习题卷7)

人工智能自然语言技术练习(习题卷7)说明:答案和解析在试卷最后第1部分:单项选择题,共45题,每题只有一个正确答案,多选或少选均不得分。

1.[单选题]所谓继承是指对事物的描述从()结点传递到具体结点A)抽象B)现实C)普通D)任意2.[单选题]决策树分类器可以对文本数据分类。

关于文本分类算法,下列说法错误的是( )A)文本预处理包括文本分词和去停用词等步骤B)数据集可以是公开数据集,也可以是通过网络爬虫爬取的文本数据C)不需要进行特征工程D)对数值化后的文本数据,可采用如SVM、RF等进行分类3.[单选题]随机森林和GBDT都属于集成学习,肯定有很多异同点,在以下描述中,正确的是?A)都是由多棵树组成,最终的结果都是由多棵树一起决定。

B)RF和GBDT在使用CART树时,只能做回归不能做分类。

C)RF和GBDT在使用CART树时,只能做分类不能做回归。

D)不确定4.[单选题]关于KNN和K-Means的相似点,下列说法正确的是A)都是有监督学习B)都属于聚类算法C)训练的数据都带有label标签D)都包含这样的过程,给定一个点,在数据集中找离它最近的点5.[单选题]可以使一个词有多个嵌入方式的模型是哪个A)GloVeB)Word2VecC)ELMoD)Nltk6.[单选题]以下四个算法当中,哪个算法和逻辑回归一样都可以做分类A)线性回归B)岭回归C)K-meansD)SVM7.[单选题]NLP中常用的语言模型是为了求得什么A)一句话或者一个词出现的概率C)一个稠密的向量矩阵D)不确定8.[单选题],Transformer是很常用的特征提取器,那么Transformer架构首先是由下列哪项引入的?A)GloVeB)BERTC)Open AI’s GPTD)ULMFit9.[单选题]贝叶斯是常用的理论基础,在贝叶斯可以是用的什么图进行表示的A)无向图B)有无向图C)有向图D)不确定10.[单选题]深度学习中最常使用的框架就是TensorFlow,该框架中的matmul方法的作用是什么A)相与B)乘积C)相除D)相加11.[单选题]在NLP任务当中机器翻译任务所使用的的模型属于什么模型A)基于统计的语言模型B)基于神经网络的语言模型C)预训练模型D)编解码模型12.[单选题]确定语料库类型的主要依据是A)它的研究目的和用途B)语料库的大小C)它所包含的语言种类的数目D)语料库的加工方式13.[单选题]LDA这个模型是在哪一年提出的?A)2000B)2001C)2002D)200314.[单选题]聚类肘部法的作用是:A)就是从K值和代价函数J的二维图中找出J下降变平滑的拐点对应的K值。

《自然语言处理技术与应用》课程标准

《自然语言处理技术与应用》课程标准一、课程概述(一)课程性质本课程是高等职业院校人工智能专业的专业核心课之一,是该专业的一门必修课,是一门理论和实践相结合的课程。

(二)课程任务本课程主要针对人工智能算法工程师、人工智能系统运维工程师、人工智能技术支持工程师、人工智能训练师、数据标注工程师等岗位开设,主要任务是培养学生在自然语言处理的需求分析、方案制定、文本数据处理、文本分类聚类算法选型、应用的能力。

(三)课程设计思路本课程以高等职业院校“人工智能技术应用”专业的学生就业为导向,将教学内容与工作岗位对专业人才的知识要求与技能要求结合起来,将项目实践提升到一个较重要的位置,按照“理论—项目构建—项目实施”的组织结构进行课程设计。

本课程共分5个项目,分别是基础NLP、文本分类与聚类、情感分析、中文命名实体识别、机器翻译,通过5个项目系统介绍了自然语言处理的实践技术。

课程在介绍自然语言处理技术应用后,重点阐述自然语言处理技术的项目开发,突出了自然语言处理技术在实际项目中的应用。

在内容的编排上淡化了学科性,避免介绍过多偏深的理论,而注重自然语言处理技术在具体运用中的要点、方法和技术操作,逐层分析和自然语言处理技术进行实际项目的开发。

(四)前后续课程二、课程目标(一)总体目标本课程要求学习了解自然语言处理技术,培养学生具备高职人工智能技术专业所需要的自然语言处理的基本知识和技能,熟悉并能使用人工智能相关技术进行自然语言处理的相关操作,具备对人工智能技术领域出现的新技术、新思想进一步学习的能力。

希望通过本课程的学习,加深对自然语言处理技术的理解,为进一步研究和从事人工智能技术实践提供良好的基础和参考。

(二)具体目标1.知识目标1)了解常见的中文分词方法2)了解TF—IDF算法思想3)了解独热编码、Distributed representation、word2Vec、doc2vec的原理4)了解分类、聚类的方法5)了解情感分析方法6)了解命名实体识别的定义及过程7)了解机器翻译方法2.能力目标1)具备文本处理、解析、向量化的能力2)具备划文本分类与聚类的能力3)具备情感分析的能力4)具备中文命名实体识别模型构建和训练的能力5)具备中英翻译模型构建和训练的能力6)具备使用yolov3定位图片中文字区域的能力7)具备使用mediapie手势检测功能的能力3.素质目标1)培养谦虚、好学、勤于思考、认真做事的良好习惯———严谨的开发流程和正确编程思路;2)培养团队协作能力———相互沟通、互相帮助、共同学习、共同达到目标;3)提升自我展示能力———讲述、说明、表述和回答问题;4)培养自我学习能力———利用书籍或网络上的资料帮助解决实际问题。

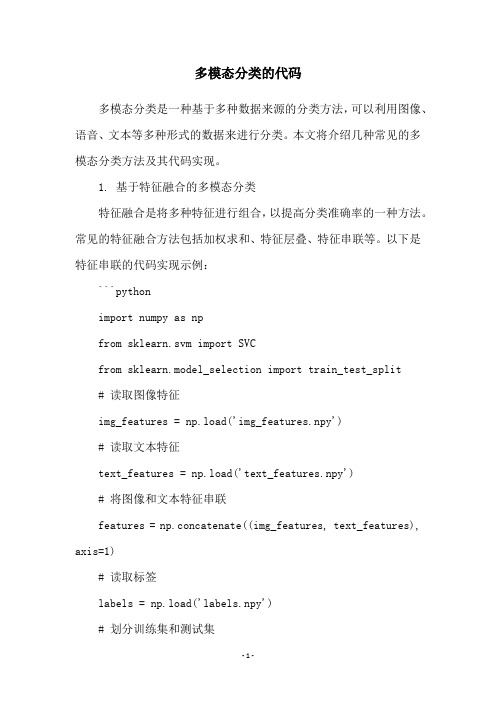

多模态分类的代码

多模态分类的代码多模态分类是一种基于多种数据来源的分类方法,可以利用图像、语音、文本等多种形式的数据来进行分类。

本文将介绍几种常见的多模态分类方法及其代码实现。

1. 基于特征融合的多模态分类特征融合是将多种特征进行组合,以提高分类准确率的一种方法。

常见的特征融合方法包括加权求和、特征层叠、特征串联等。

以下是特征串联的代码实现示例:```pythonimport numpy as npfrom sklearn.svm import SVCfrom sklearn.model_selection import train_test_split# 读取图像特征img_features = np.load('img_features.npy')# 读取文本特征text_features = np.load('text_features.npy')# 将图像和文本特征串联features = np.concatenate((img_features, text_features), axis=1)# 读取标签labels = np.load('labels.npy')# 划分训练集和测试集X_train, X_test, y_train, y_test =train_test_split(features, labels, test_size=0.2,random_state=42)# 训练SVM模型clf = SVC(kernel='linear')clf.fit(X_train, y_train)# 在测试集上进行预测y_pred = clf.predict(X_test)# 计算准确率acc = np.mean(y_pred == y_test)print('Accuracy: {:.2f}%'.format(acc * 100))```2. 基于模态融合的多模态分类模态融合是将多种模态的分类结果进行组合,以提高分类准确率的一种方法。

文本聚类方法

文本聚类方法文本聚类是一种将大量文本数据划分为若干个类别或群组的技术方法。

它可以帮助我们发现文本数据中的模式和隐藏的结构,从而更好地理解数据并进行进一步的分析和应用。

本文将介绍一些常用的文本聚类方法,包括传统方法和基于深度学习的方法。

传统的文本聚类方法主要有以下几种:1.基于词袋模型的聚类方法:这是最常见的文本聚类方法之一。

它将文本数据转化为词向量的表示,然后使用聚类算法,如K-means算法或层次聚类算法,将文本数据划分为不同的类别。

这种方法简单有效,但对于文本中的语义信息和上下文信息无视较多。

2.基于主题模型的聚类方法:主题模型是一种用于发现文本数据中隐藏主题的统计模型。

其中最著名的一种是LDA(Latent Dirichlet Allocation)模型。

基于主题模型的聚类方法将文本数据转化为主题分布的表示,然后使用聚类算法将文本数据划分为类别。

主题模型考虑了文本中词的分布和上下文关联,因此在一定程度上能更好地捕捉文本数据的语义信息。

3.基于谱聚类的聚类方法:谱聚类是一种通过图论的方法来进行聚类的技术。

将文本数据中的词或短语作为节点,考虑它们之间的相似度构建图,然后利用谱聚类算法将文本数据划分为不同的类别。

谱聚类在处理高维数据和复杂结构数据时具有很好的效果。

基于深度学习的文本聚类方法在最近几年得到了广泛的关注和应用。

这些方法利用深度神经网络来抽取文本数据中的语义信息,从而实现更准确和高效的文本聚类。

1.基于Word2Vec的文本聚类方法:Word2Vec是一种通过神经网络学习词的分布式表示的技术。

基于Word2Vec的文本聚类方法将文本数据中的词转化为词向量后,使用聚类算法将文本数据划分为不同的类别。

相比传统的基于词袋模型的方法,基于Word2Vec的方法能更好地捕捉词之间的语义关系。

2.基于卷积神经网络的文本聚类方法:卷积神经网络在图像处理中取得了很好的效果,而在处理文本数据中的局部结构时同样具有优势。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

利用sklearn做文本分类(特征提取、knnsvm聚类)数据挖掘入门与实战公众号:datadw分为以下几个过程:加载数据集提feature分类Naive BayesKNNSVM聚类20newsgroups官网/~jason/20Newsgroups/上给出了3个数据集,这里我们用最原始的20news-19997.tar.gz/~jason/20Newsgroups/20news-19997.ta r.gz1.加载数据集从20news-19997.tar.gz下载数据集,解压到scikit_learn_data文件夹下,加载数据,详见code注释。

[python]view plaincopy#first extract the 20 news_group dataset to/scikit_learn_datafromsklearn.datasets importfetch_20newsgroups#all categories#newsgroup_train = fetch_20newsgroups(subset='train') #part categoriescategories = ['comp.graphics','comp.os.ms-windows.misc','comp.sys.ibm.pc.hardware','comp.sys.mac.hardware','comp.windows.x'];newsgroup_train = fetch_20newsgroups(subset ='train',categories = categories);可以检验是否load好了:[python]view plaincopy#print category namesfrompprint importpprintpprint(list(newsgroup_train.target_names))结果:['comp.graphics','comp.os.ms-windows.misc','comp.sys.ibm.pc.hardware','comp.sys.mac.hardware','comp.windows.x']2. 提feature:刚才load进来的newsgroup_train就是一篇篇document,我们要从中提取feature,即词频啊神马的,用fit_transform Method 1. HashingVectorizer,规定feature个数[python]view plaincopy#newsgroup_train.data is the original documents, but we need to extract the#feature vectors inorder to model the text data fromsklearn.feature_extraction.text importHashingVectorizervectorizer = HashingVectorizer(stop_words ='english',non_negative = True,n_features = 10000)fea_train = vectorizer.fit_transform(newsgroup_train.data) fea_test = vectorizer.fit_transform(newsgroups_test.data);#return feature vector 'fea_train' [n_samples,n_features] print'Size of fea_train:'+ repr(fea_train.shape)print'Size of fea_train:'+ repr(fea_test.shape)#11314 documents, 130107 vectors for all categories print'The average feature sparsity is {0:.3f}%'.format(fea_train.nnz/float(fea_train.shape[0]*fea_train.shape[1])*1 00);结果:Size of fea_train:(2936, 10000)Size of fea_train:(1955, 10000)The average feature sparsity is 1.002%因为我们只取了10000个词,即10000维feature,稀疏度还不算低。

而实际上用TfidfVectorizer统计可得到上万维的feature,我统计的全部样本是13w多维,就是一个相当稀疏的矩阵了。

****************************************************************** ********************************************************上面代码注释说TF-IDF在train和test上提取的feature维度不同,那么怎么让它们相同呢?有两种方法:Method 2. CountVectorizer+TfidfTransformer让两个CountVectorizer共享vocabulary:[python]view plaincopy#----------------------------------------------------#method 1:CountVectorizer+TfidfTransformerprint'*************************nCountVectorizer+TfidfTransfor mern*************************'fromsklearn.feature_extraction.text importCountVectorizer,TfidfTransformercount_v1= CountVectorizer(stop_words = 'english', max_df = 0.5);counts_train =count_v1.fit_transform(newsgroup_train.data);print"the shape of train is "+repr(counts_train.shape)count_v2 =CountVectorizer(vocabulary=count_v1.vocabulary_); counts_test =count_v2.fit_transform(newsgroups_test.data);print"the shape of test is "+repr(counts_test.shape)tfidftransformer = TfidfTransformer();tfidf_train =tfidftransformer.fit(counts_train).transform(counts_train); tfidf_test =tfidftransformer.fit(counts_test).transform(counts_test);结果:*************************CountVectorizer+TfidfTransformer*************************the shape of train is (2936, 66433)the shape of test is (1955, 66433)Method 3. TfidfVectorizer让两个TfidfVectorizer共享vocabulary:[python]view plaincopy#method 2:TfidfVectorizerprint'*************************nTfidfVectorizern**************** *********'fromsklearn.feature_extraction.text importTfidfVectorizer tv = TfidfVectorizer(sublinear_tf = True,max_df = 0.5,stop_words = 'english');tfidf_train_2 = tv.fit_transform(newsgroup_train.data);tv2 = TfidfVectorizer(vocabulary = tv.vocabulary_);tfidf_test_2 = tv2.fit_transform(newsgroups_test.data); print"the shape of train is "+repr(tfidf_train_2.shape) print"the shape of test is "+repr(tfidf_test_2.shape) analyze = tv.build_analyzer()tv.get_feature_names()#statistical features/terms结果:*************************TfidfVectorizer*************************the shape of train is (2936, 66433)the shape of test is (1955, 66433)此外,还有sklearn里封装好的抓feature函数,fetch_20newsgroups_vectorizedMethod 4. fetch_20newsgroups_vectorized但是这种方法不能挑出几个类的feature,只能全部20个类的feature全部弄出来:[python]view plaincopyprint'*************************nfetch_20newsgroups_vectoriz edn*************************'fromsklearn.datasetsimportfetch_20newsgroups_vectorizedtfidf_train_3 = fetch_20newsgroups_vectorized(subset = 'train');tfidf_test_3 = fetch_20newsgroups_vectorized(subset = 'test');print"the shape of train is "+repr(tfidf_train_3.data.shape) print"the shape of test is "+repr(tfidf_test_3.data.shape)结果:*************************fetch_20newsgroups_vectorized*************************the shape of train is (11314, 130107)the shape of test is (7532, 130107)3. 分类3.1 Multinomial Naive Bayes Classifier[python]view plaincopy############################################## #########Multinomial Naive Bayes Classifierprint'*************************nNaiveBayesn*************************'fromsklearn.naive_bayes importMultinomialNB fromsklearn importmetricsnewsgroups_test = fetch_20newsgroups(subset = 'test', categories = categories);fea_test = vectorizer.fit_transform(newsgroups_test.data); #create the Multinomial Naive Bayesian Classifierclf = MultinomialNB(alpha = 0.01)clf.fit(fea_train,newsgroup_train.target);pred = clf.predict(fea_test);calculate_result(newsgroups_test.target,pred);#notice here we can see that f1_score is not equal to2*precision*recall/(precision+recall)#because the m_precision and m_recall we get is averaged, however, metrics.f1_score() calculates#weithed average, i.e., takes into the number of each class into consideration.注意我最后的3行注释,为什么f1≠2*(准确率*召回率)/(准确率+召回率)其中,函数calculate_result计算f1:[python]view plaincopydefcalculate_result(actual,pred):m_precision = metrics.precision_score(actual,pred);m_recall = metrics.recall_score(actual,pred);print'predict info:'print'precision:{0:.3f}'.format(m_precision)print'recall:{0:0.3f}'.format(m_recall);print'f1-score:{0:.3f}'.format(metrics.f1_score(actual,pred));3.2 KNN:[python]view plaincopy############################################## #########KNN Classifierfromsklearn.neighbors importKNeighborsClassifierprint'*************************nKNNn*************************'knnclf = KNeighborsClassifier()#default with k=5 knnclf.fit(fea_train,newsgroup_train.target)pred = knnclf.predict(fea_test);calculate_result(newsgroups_test.target,pred);3.3 SVM:[cpp]view plaincopy############################################## #########SVM Classifierfrom sklearn.svm import SVCprint '*************************nSVMn*************************' svclf = SVC(kernel = 'linear')#defaultwith 'rbf'svclf.fit(fea_train,newsgroup_train.target)pred = svclf.predict(fea_test);calculate_result(newsgroups_test.target,pred);结果:*************************Naive Bayes*************************predict info:precision:0.764recall:0.759f1-score:0.760*************************KNN*************************predict info:precision:0.642recall:0.635f1-score:0.636*************************SVM*************************predict info:precision:0.777recall:0.774f1-score:0.7744. 聚类[cpp]view plaincopy#######################################################KMeans Clusterfrom sklearn.cluster import KMeansprint'*************************nKMeansn*************************' pred = KMeans(n_clusters=5)pred.fit(fea_test)calculate_result(newsgroups_test.target,bels_);结果:*************************KMeans*************************predict info:precision:0.264recall:0.226f1-score:0.213本文全部代码回复“sk”获取。