基于Kafka和Spark的实时数据质量监控平台

机械设备大数据管理与分析平台的构建与应用研究

机械设备大数据管理与分析平台的构建与应用研究摘要:机械设备是工业生产中不可或缺的重要组成部分,然而,设备故障和管理不善会导致生产效率下降和成本增加。

因此,研究机械设备大数据管理与分析方法具有重要意义。

本文旨在研究机械设备大数据管理与分析平台的构建与应用。

通过对机械设备大数据管理与分析的重要性进行分析,提出了一种基于大数据技术的解决方案。

研究结果表明,应用大数据技术可以实现机械设备的远程监控、故障预测和维护优化,提高设备的可靠性和运行效率。

关键词:机械设备;大数据管理与分析;平台构建引言机械设备在各个领域中扮演着重要的角色,例如制造业、能源产业、交通运输等。

随着现代工业的快速发展,机械设备的数量和复杂性都在不断增加。

这些设备产生的数据量也随之增加,包括传感器数据、运行日志、故障记录等。

这些数据蕴含着宝贵的信息,可以用于设备状态监测、故障诊断、维修优化等方面。

然而,由于数据量庞大且多样化,传统的数据管理和分析方法已经无法满足对机械设备数据的有效利用。

因此,构建一个高效的机械设备大数据管理与分析平台对于实现设备的可靠运行、降低维护成本、提高生产效率具有重要意义。

一、机械设备大数据管理与分析的重要性(一)定义和特点机械设备大数据管理与分析是基于大数据和机器学习等技术手段,对机械设备运行过程中产生的海量数据进行采集、存储、处理和挖掘,以实现机械设备的故障诊断、性能预测和优化等目的。

其特点包括:数据量大、来源广泛、复杂多样、时效性强、价值密集。

(二)机械设备大数据管理与分析的目标机械设备大数据管理与分析的目标是实现对机械设备运行状态的全面监测和智能诊断,为设备维护、运营管理和决策提供数据支持。

具体包括以下几个方面:第一,实时监测:通过对机械设备运行状态的实时监测和数据采集,及时发现异常情况,避免因故障导致的生产中断和安全事故。

第二,故障诊断:通过对机械设备运行数据的分析和模型建立,实现对设备故障的快速诊断和定位,提高故障处理响应速度和效率。

业务监控系统方案

业务监控系统方案业务监控系统方案简介业务监控系统是一种用于监控企业业务运行状况和绩效的软件系统。

通过对关键业务指标的实时监控和分析,可以帮助企业发现问题、优化流程、提高效率。

本文将介绍一种基于云计算和大数据技术的业务监控系统方案。

系统架构业务监控系统的架构分为前端展示层、业务数据采集与处理层、数据存储与分析层和报警与预警层四个部分。

前端展示层前端展示层是用户直接接触的界面,通过网页或移动应用呈现各类业务指标和报表。

用户可以根据自己的需求定制监控图表和仪表盘,并实时查看数据和报警信息。

业务数据采集与处理层业务数据采集与处理层负责从各个数据源采集业务数据,并进行预处理和清洗。

它包括数据采集模块、数据转换与整合模块和数据质量控制模块。

数据采集模块通过接口或脚本方式,实时或定时从数据库、日志、消息队列等数据源中提取数据。

数据转换与整合模块负责将采集到的数据进行格式转换和整合,使其符合系统的数据模型。

数据质量控制模块会对数据进行清洗和校验,确保数据的准确性和完整性。

数据存储与分析层数据存储与分析层负责将处理后的数据持久化存储,并提供数据查询、统计和分析功能。

它包括实时数据库、历史数据仓库和数据分析模块。

实时数据库用于存储业务实时数据,以支持实时监控和实时报警。

历史数据仓库用于存储历史业务数据,以支持数据分析和生成报表。

数据分析模块可以对存储的数据进行多维分析和挖掘,提供对业务趋势、异常和规律的洞察。

报警与预警层报警与预警层负责根据业务指标的设定阈值,实时监控数据并触发相应的警报。

它包括报警规则管理模块和报警通知模块。

报警规则管理模块用于设定业务指标的阈值和报警策略。

报警通知模块根据设定的报警规则,通过邮件、短信、钉钉等方式及时将警报通知相关责任人,以便及时处理和解决问题。

技术选型根据业务监控系统的要求,我们建议采用以下技术进行系统开发和实施:- 前端展示层:采用HTML、CSS和JavaScript技术实现Web界面,可以使用Vue.js、React或Angular等流行的前端框架。

数据处理中的数据流和实时处理平台推荐(二)

数据处理中的数据流和实时处理平台推荐一、引言在当今数字化时代,数据已经成为了一种重要的资源。

无论是企业还是个人,都需要进行数据处理以提取有价值的信息并做出相应的决策。

在数据处理过程中,数据流和实时处理平台扮演着至关重要的角色。

本文将会讨论数据流和实时处理平台的概念,并针对这些平台提供一些推荐。

二、数据流平台的概念数据流平台是一种用于管理和处理数据流的应用程序。

数据流是指连续流动的数据,在处理过程中以连续的方式被提取、转换和加载。

数据流平台旨在提供一种有效的方式来处理这些数据,以便用户可以对其进行分析和运用。

常见的数据流平台包括Apache Kafka、Amazon Kinesis和Google Cloud Pub/Sub等。

这些平台能够处理大量的实时数据,并具有良好的可伸缩性和容错性。

三、数据流平台的推荐1. Apache KafkaApache Kafka是一个开源的分布式发布-订阅消息系统。

它具有高可用性、高吞吐量和低延迟的特点,适用于构建大规模的实时数据流平台。

Kafka的架构基于发布-订阅模式,消息通过一个或多个Topic进行传递,消费者可以根据自己的需求订阅感兴趣的Topic。

同时,由于Kafka支持分布式部署,可以很容易地水平扩展以应对不断增长的数据量。

2. Amazon KinesisAmazon Kinesis是亚马逊AWS云计算平台提供的一种实时大数据处理服务。

它能够接收和处理大规模的实时数据流,并将其转化为有用的信息。

Amazon Kinesis具有可靠性高、扩展性强的特点,适用于构建实时分析、实时监控和实时应用等场景。

3. Google Cloud Pub/SubGoogle Cloud Pub/Sub是谷歌云平台提供的一种高可用性、可扩展性强的消息传递服务。

它支持实时的发布-订阅模式,可以可靠地传递数据流和事件通知。

Google Cloud Pub/Sub提供了灵活的调度和消息传递机制,使用户能够轻松构建实时应用程序。

高效广告监测系统的构建与实现

高效广告监测系统的构建与实现一、引言广告投放在商业活动中扮演着非常重要的角色,而广告监测则成为了广告主必不可少的工具。

随着互联网的发展,广告投放面临着越来越多的挑战,如无效点击、流量欺诈等,同时广告主也越来越重视有效性监控的重要程度。

本文将介绍高效广告监测系统的构建和实现,通过对广告投放数据的采集和处理,实现对广告投放效果的监控和评估。

二、广告监测系统的需求分析为了构建高效广告监测系统,首先需要分析其具体的需求。

广告监测系统需要能够满足以下要求:1、数据采集:广告监测系统需要对广告投放数据进行采集,包括广告点击数、转化数、CTR等。

2、实时监控:广告监测系统需要能够实时监控广告投放效果,及时发现异常情况。

3、数据处理:广告监测系统需要对采集到的广告投放数据进行处理,生成可视化的数据报告和分析结果。

4、数据安全:广告投放数据属于商业机密,广告监测系统需要确保数据的安全和保密性。

5、数据可扩展性:随着广告投放数据的增加,广告监测系统需要具备良好的可扩展性,能够满足大规模数据处理的需求。

三、广告监测系统的架构设计基于以上需求,可以构建以下广告监测系统的架构:1、数据采集:采用Flume或Kafka等消息传输框架,对广告投放数据进行实时采集,并将数据传输到数据处理节点。

2、数据处理:利用Spark等分布式计算框架,对广告投放数据进行处理,并生成数据分析结果和报告。

3、数据可视化:采用Elasticsearch和Kibana等可视化工具,对数据分析结果进行可视化展示。

4、数据安全:采用权限控制机制和数据加密技术,确保广告投放数据的安全性和可靠性。

四、广告监测系统的实现1、数据采集采用Kafka作为消息传输框架,实时采集广告投放数据,并将数据传输到数据处理节点。

采用Kafka的好处是其分布式、高可用的特性,能够满足大规模数据采集的需求。

具体实现方法为,在广告投放平台上设置Kafka的Producer,将广告投放数据发送到Kafka Broker上,然后在数据处理节点上设置Kafka的Consumer,实时消费广告投放数据。

基于Spark的大数据分析与处理平台设计与实现

基于Spark的大数据分析与处理平台设计与实现一、引言随着互联网和物联网技术的快速发展,大数据已经成为当今社会中不可或缺的一部分。

大数据分析和处理已经成为各行各业的重要工具,帮助企业更好地理解市场趋势、优化运营效率、提升用户体验等。

在大数据处理领域,Apache Spark作为一种快速、通用、可扩展的大数据处理引擎,受到了广泛关注和应用。

二、Spark简介Apache Spark是一种基于内存计算的大数据并行计算框架,提供了丰富的API支持,包括Scala、Java、Python和R等语言。

Spark具有高容错性、高性能和易用性等特点,适用于各种大数据处理场景,如批处理、交互式查询、流式计算和机器学习等。

三、大数据分析与处理平台设计1. 架构设计在设计基于Spark的大数据分析与处理平台时,首先需要考虑整体架构设计。

典型的架构包括数据采集层、数据存储层、数据处理层和数据展示层。

其中,Spark通常被用于数据处理层,负责对海量数据进行分布式计算和分析。

2. 数据采集与清洗在构建大数据平台时,数据采集和清洗是至关重要的环节。

通过各种方式采集结构化和非结构化数据,并对数据进行清洗和预处理,以确保数据质量和准确性。

3. 数据存储与管理针对不同的业务需求,可以选择合适的数据存储方案,如HDFS、HBase、Cassandra等。

同时,需要考虑数据的备份、恢复和安全性等问题。

4. 数据处理与分析Spark提供了丰富的API和库,如Spark SQL、Spark Streaming、MLlib等,可以支持各种复杂的数据处理和分析任务。

通过编写Spark应用程序,可以实现对海量数据的实时处理和分析。

5. 数据展示与可视化为了更直观地展示分析结果,可以利用可视化工具如Tableau、Power BI等,将分析结果以图表或报表的形式展示给用户,帮助他们更好地理解数据。

四、平台实现步骤1. 环境搭建在搭建基于Spark的大数据平台之前,需要准备好相应的硬件设施和软件环境,包括服务器集群、操作系统、JDK、Hadoop等。

利用Spark进行实时大数据处理的最佳实践

利用Spark进行实时大数据处理的最佳实践在当今数字化时代,大数据处理已成为企业不可或缺的一环。

为了满足日益增长的数据处理需求,传统的批处理方式已无法满足实时性和性能的要求。

而Apache Spark作为一个快速、通用、容错且易用的大数据处理引擎,成为了处理实时大数据的最佳实践之一。

Spark提供了丰富的API和内置的组件,可以在实时大数据处理过程中实现高效的数据处理和分析。

以下是利用Spark进行实时大数据处理的最佳实践。

1. 选择合适的集群模式:Spark可以在多种集群模式下运行,包括单机模式、本地模式、独立模式和云模式。

根据数据量和需求,选择合适的集群模式可以提高实时大数据处理的效率和性能。

2. 使用Spark Streaming处理流式数据:Spark Streaming是Spark的一部分,支持从各种数据源(如Kafka、Flume和HDFS)实时接收数据并进行处理。

使用Spark Streaming可以实时处理数据流,并支持窗口和滑动窗口操作,以满足不同的实时数据分析需求。

3. 使用Spark SQL进行结构化数据处理:Spark SQL是Spark的SQL查询引擎,可以通过SQL语句处理结构化数据。

通过使用Spark SQL,可以方便地进行实时查询、过滤和转换操作,以满足实时大数据处理的需求。

4. 使用Spark MLlib进行机器学习:Spark MLlib是Spark的机器学习库,提供了各种机器学习算法和工具,可以在实时大数据处理中应用机器学习。

通过使用Spark MLlib,可以进行实时的数据挖掘和模型训练,帮助企业发现隐藏在大数据中的信息和模式。

5. 使用Spark GraphX进行图处理:Spark GraphX是Spark的图处理库,用于处理大规模的图数据。

通过使用Spark GraphX,可以进行实时的图分析和图计算,帮助企业发现图数据中的关联和模式。

6. 使用Spark Streaming和Spark SQL进行流与批处理的无缝集成:Spark提供了将流处理和批处理无缝集成的能力,可以在同一个应用程序中同时处理实时数据流和批处理数据。

基于Spark的实时数据分析与可视化平台开发

基于Spark的实时数据分析与可视化平台开发一、引言随着大数据时代的到来,数据分析和可视化变得越来越重要。

在这个信息爆炸的时代,如何从海量数据中提取有用信息,并以直观的方式展现给用户,成为了许多企业和组织面临的挑战。

基于Spark的实时数据分析与可视化平台的开发,可以帮助用户实时监控数据变化,及时做出决策,提高工作效率和决策准确性。

二、Spark简介Apache Spark是一个快速、通用、可扩展的大数据处理引擎,提供了高效的数据处理能力和丰富的API。

Spark支持多种编程语言,如Scala、Java、Python和R,同时具有内存计算和容错机制等优点,适合用于大规模数据处理和实时数据分析。

三、实时数据分析平台架构设计1. 数据采集在实时数据分析平台中,首先需要进行数据采集。

可以通过Flume、Kafka等工具将数据源头的数据实时传输到Spark集群中进行处理。

2. 数据处理Spark提供了丰富的API,如Spark SQL、Spark Streaming等,可以对实时流式数据进行处理和分析。

通过编写Spark应用程序,可以对数据进行清洗、转换、聚合等操作。

3. 数据存储处理后的数据可以存储到HDFS、HBase、Elasticsearch等存储系统中,以便后续查询和分析。

4. 可视化展示通过可视化工具(如Echarts、D3.js等),将处理后的数据以图表、报表等形式展示给用户。

用户可以通过交互式界面实时查看数据变化,并进行深入分析。

四、实时数据分析平台开发流程1. 环境搭建搭建Spark集群环境,并配置相关组件(如Hadoop、Zookeeper 等),保证平台正常运行。

2. 数据处理逻辑开发编写Spark应用程序,定义数据处理逻辑,包括数据清洗、转换、计算等操作。

3. 可视化界面开发设计并开发可视化界面,选择合适的图表类型展示数据,并添加交互功能,提升用户体验。

4. 平台测试与优化对平台进行全面测试,包括功能测试、性能测试等,根据测试结果进行优化和调整,确保平台稳定可靠。

基于Spark的实时大数据分析与预测

基于Spark的实时大数据分析与预测随着互联网的快速发展和技术的不断进步,我们生活中产生的数据量呈现爆炸式增长。

这些海量数据包含了大量有价值的信息,对企业和组织来说,更是宝贵的资源。

因此,如何高效地处理和分析大数据成为一项重要的任务。

为了满足大数据处理和分析的需求,Apache Spark作为一种快速、通用的大数据处理框架应运而生。

Spark是一个分布式计算系统,它提供了丰富的API和函数库,能够高效地处理和分析大规模数据。

同时,Spark还支持实时数据处理,这意味着我们可以立即获取数据,并进行实时的分析和预测。

那么基于Spark的实时大数据分析与预测是如何实现的呢?首先,我们需要将待分析的大数据导入Spark中。

Spark支持从多种数据源中读取数据,包括HDFS、Hive、Kafka等。

当然,我们也可以将数据从其他系统中导入到Spark,比如关系型数据库或实时流数据。

无论数据来自何方,Spark都能提供统一的接口来对数据进行处理,这一点非常方便。

一旦数据被导入到Spark中,我们就可以利用Spark提供的强大的函数库和API进行数据处理和分析。

Spark提供了丰富的内置函数,比如map、reduce、filter 等,可以帮助我们进行数据转换、聚合和筛选。

此外,Spark还提供了MLlib机器学习库,可以用于数据挖掘和预测分析。

MLlib包含了常见的机器学习算法,比如分类、回归、聚类和协同过滤等,能够满足各种预测需求。

当我们使用Spark进行数据分析时,我们可以利用其分布式计算的能力,通过并行处理来提高计算效率。

Spark将数据集划分为多个分区,每个分区在集群中的不同节点上并行处理,从而加速计算速度。

此外,Spark还支持将中间计算结果缓存在内存中,可以避免磁盘IO的开销,从而进一步提高性能。

在实时大数据分析中,Spark Streaming是一个非常重要的组件。

Spark Streaming可以接收实时输入的数据流,并将其划分为一系列小批量数据,然后使用Spark的批量处理功能对这些小批量数据进行分析。

基于Spark的实时大数据分析与预测在电商领域的应用

基于Spark的实时大数据分析与预测在电商领域的应用随着电子商务的快速发展,电商平台所产生的大数据量也愈发巨大。

为了更好地理解和挖掘这些数据,电商企业越来越倾向于采用实时大数据分析和预测技术。

这种技术能够帮助企业快速了解市场动态,优化产品策略,并实现更高的销售额和客户满意度。

Spark作为一个强大的实时数据处理平台,被广泛应用于电商领域的大数据分析与预测中。

它的高性能和丰富的功能使得它成为一个理想的选择。

下面将详细介绍基于Spark的实时大数据分析与预测在电商领域的应用。

首先,Spark可以实时处理大规模的数据流。

电商平台的交易数据源源不断地涌入,如订单数据、支付数据、用户行为数据等。

Spark Streaming技术可以实时接收、处理和分析这些数据,从而使得企业能够迅速响应市场变化,调整销售策略。

例如,在促销活动期间,企业可以根据用户实时的浏览和购买行为进行个性化推荐和定价策略调整,从而提高销售效益。

其次,Spark的机器学习库MLlib能够帮助电商企业进行智能化的预测分析。

通过训练模型,可以预测用户行为、销售趋势和市场需求等。

例如,基于Spark的实时大数据分析与预测模型可以根据用户过去的购买记录和浏览行为,预测他们的下一步购买意向,并提供个性化的推荐,从而提高用户购买的转化率。

此外,基于Spark的模型还可以预测未来的销售趋势,帮助企业合理安排库存,并优化供应链管理。

另外,Spark的图计算库GraphX可以用于构建用户网络和社交网络分析。

在电商领域中,用户之间的连接和影响力对于销售策略的制定具有重要的作用。

通过使用Spark的GraphX,企业可以根据用户之间的关系网络,识别出影响力较大的用户,然后针对这些用户制定更有针对性的营销策略,提高销售额和用户忠诚度。

同时,Spark还支持大规模的数据可视化和交互式查询。

Spark的SQL和SparkR库提供了强大的查询和分析功能,可以帮助用户从大规模的数据集中提取有价值的信息。

基于Spark Streaming的实时数据处理系统设计与实现

数据存储到了 Kafka 的 topic 中,需要创建一个消费者 消费采集到的数据。这里的消费者是通过 Spark Streaming 实 现的,通过 Spark Streaming 对采集到的数据进行计算校验。 首先需要将 Spark Streaming 与 Kafka 连接,才能读取到 topic 中的数据。因此需要配置 bootstrapserver、key.deserializer、 value.deserializer,设置 topic、groupid,kafkaoffset 的维护等级, 关闭自动提交。

2020 年 10 月 25 日 第 4 卷 第 20 期

DOI:10.19850/ki.2096-4706.2020.20.003

现代信息科技 Modern Information Technology

Oct.2020 Vol.4 No.20

基于 Spark Streaming 的实时数据处理系统 设计与实现

3 实时数据处理系统的设计与实现

通过上一节的分析,本文实现了一种实时数据处理系 统,通过 Flume 实时数据获取模块获取日志文件和数据库 中的实时新增数据,再将数据暂存到 Kafka 消息中间件,由 Spark Streaming 调用 Kafka 中的数据做实时处理,处理后的 结构存储到 HBase 中。其结构图如图 3 所示。

2 实时数据处理系统分析

一个实时数据处理过程包含了数据的接入、数据的传输、 数据的计算校验和数据的存储,其具体流程如图 1 所示。首 先需要有数据接入,有了数据之后需要将数据传输到相应位 置等待数据计算校验,经过计算校验之后的数据才能存储进 数据库。

数据接入

数据传输

数据计算校验

基于Spark的实时大数据处理与可视化分析系统设计

基于Spark的实时大数据处理与可视化分析系统设计随着大数据时代的到来,对大规模数据的实时处理与可视化分析需求日益增长。

基于Spark的实时大数据处理与可视化分析系统设计应运而生。

本文将从系统架构、功能实现、性能优化和应用场景等方面进行探讨。

一、系统架构基于Spark的实时大数据处理与可视化分析系统设计的架构主要包括以下几个组件:1.数据采集与存储模块:负责数据的采集和存储。

可以利用Flume、Kafka等工具进行数据的实时采集,将数据存储在分布式文件系统(如HDFS)或NoSQL数据库(如HBase)中。

2.数据处理模块:利用Spark Streaming进行数据的实时处理。

Spark Streaming支持批处理和流处理的混合模式,可以对实时数据进行持续的、可扩展的处理和分析。

3.数据可视化模块:利用可视化工具(如ECharts、D3.js)进行数据的可视化展示。

通过图表、地图等形式,将处理后的数据以直观易懂的方式展示出来,方便用户进行数据分析和决策。

4.系统管理与监控模块:负责系统的管理和监控。

可以通过配置管理工具(如Zookeeper)实现集群的配置和管理,利用监控工具(如Ganglia)对系统进行监控和性能调优。

二、功能实现基于Spark的实时大数据处理与可视化分析系统设计具备以下功能:1.数据实时采集和存储:可以实时采集和存储海量数据,同时支持数据的扩展性和容错性。

2.数据实时处理:能够对实时数据进行实时处理,包括数据清洗、转换、聚合和计算等操作,提供灵活的数据处理能力。

3.数据可视化展示:能够将处理后的数据以各种图表、地图等可视化形式展示出来,方便用户进行数据的可视化分析。

4.实时监控与报警:能够实时监控数据处理的状态和性能,并及时报警和处理异常情况,保证系统的稳定性和可靠性。

三、性能优化为提高基于Spark的实时大数据处理与可视化分析系统的性能,可以从以下几个方面进行优化:1.数据分区与并行处理:根据数据的特性进行合理的数据分区和任务调度,实现数据的并行处理,提高处理效率。

实时数据分析平台的设计与实现

实时数据分析平台的设计与实现随着数字化时代的到来,数据被视为公司最宝贵的资源之一。

数据分析平台的出现更是使其价值倍增,不仅为企业优化管理提供帮助,提高数据的使用效率和准确性,同时也带来了更多的商业机遇。

本文将介绍实时数据分析平台的设计与实现,以及其中需要注意的细节和技术。

一、实时数据分析平台的设计实时数据分析平台是一个功能非常强大的平台,它可以帮助企业快速找到其所需要的数据,根据统计的信息展开深入的分析,优化其业务流程,提高其战略决策的准确性。

1. 数据收集数据是任何分析平台的根基。

在实时数据分析平台中,收集数据的方式就显得尤为重要。

与传统的数据收集方式不同,实时数据分析平台收集数据的速度非常快,因此可以将收集数据的工作与应用程序的设计分离出来。

现有的数据收藏平台有Flume、Kafka等,它们是一些收集分布式数据的系统。

它们通过订阅主题,然后再将主题附加到相应的数据源中,以确保数据的实时性和准确性。

2. 数据存储数据的存储方式直接影响到数据的提取和分析。

实时数据分析平台收集到的数据都是非常庞大的,因此如何存储这些数据就显得至关重要。

NoSQL数据库是一种普遍使用的数据存储方式,它比传统的关系型数据库具有更好的扩展性和性能。

Hadoop、MongoDB等都是典型的NoSQL数据库,具有很好的横向伸缩性,可以通过不同的方法满足不同的数据需求。

3. 数据处理数据处理涉及到从数据源中提取有价值的信息和分析这些信息的过程。

因此,数据处理的流程实时数据分析平台中有着相当重要的地位,其算法必须能够从数据集中提取有用的信息。

数据处理的流程会因平台的需求、规模、算法和技术而大不相同。

一般来说,实时数据分析平台需要大量机器学习和深度学习算法,以分析大规模数据的关系,并预测可能的趋势和模式。

4. 数据可视化数据可视化是将大数据集中的信息转换成图形、表格、图表等视觉化元素,使用户能够直观地了解数据趋势和模式,进而做出相应的业务决策。

基于Spark平台的异常流量实时检测

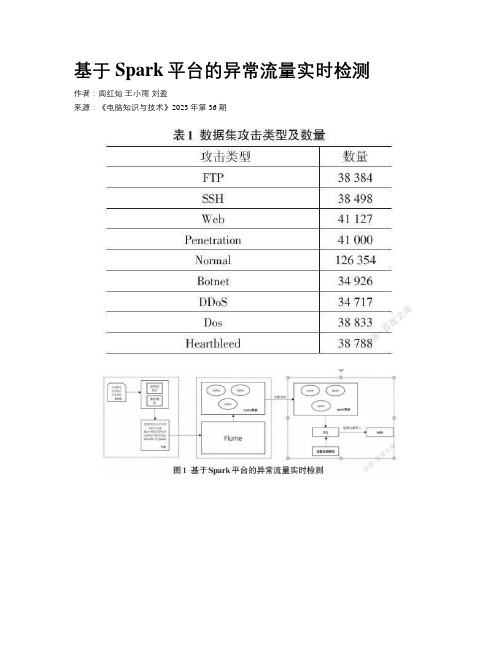

基于Spark平台的异常流量实时检测作者:阎红灿王小雨刘盈来源:《电脑知识与技术》2023年第36期摘要:传统的流量检测方法在大规模、大流量网络环境下不能满足对异常流量检测的准确性和实时性要求,基于此,该文构建了一个基于spark平台的分布式流量实时检测模型。

该模型使用LibPcap、Flume、SparkStreaming实现分布式流量采集、上传和实时计算,以满足大流量场景下实时性需求;通过CNN网络提取流量载荷内容特征和双向流量统计特征,基于Stacking算法进行模型融合,提高了检测准确性;使用CIC-IDS-2018数据集对该模型进行了测试。

实验结果表明,该模型能够满足大流量环境下异常流量检测的准确性和实时性要求。

关键词:SparkStreaming;分布式流量检测;CNN;Stacking;模型融合中图分类号:TP393 文献标识码:A文章编号:1009-3044(2023)36-0062-04开放科学(资源服务)标识码(OSID)0 引言随着网络技术的发展,针对互联网的攻击手段愈来多样化,其所带来的威胁也在不断提升,对流量进行异常检测也越显必要。

当前的入侵检测模型主要有基于统计分析的检测方法[1-3],对流量特征进行统计分析并建立特征库,通过对比特征库的方式来识别异常流量;基于分类的检测方法[4-7],通过训练分类器来识别正常和异常流量;基于聚类的检测方法[8-11],通过相似度和聚类将流量数据聚合成不同的类来达到流量检测的目的,属于无监督学习算法。

无论是基于统计、分类还是聚类的检测方法,都需要提取好流量的特征才能进行下一步工作,因此需要解决大量数据处理的问题。

作为一个分布式计算平台,Spark具有高性能、低延迟、可扩展等特性[12],非常适合处理大量流量数据,而且基于机器学习的流量检测方法具有准确率高、扩展性强等特点。

本文将二者结合起来,设计一个异常检测模型可满足海量流量环境下对准确率和实时性的要求。

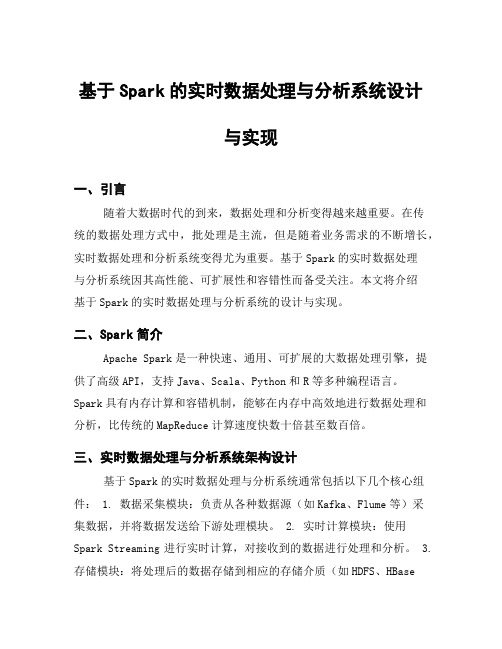

基于Spark的实时数据处理与分析系统设计与实现

基于Spark的实时数据处理与分析系统设计与实现一、引言随着大数据时代的到来,数据处理和分析变得越来越重要。

在传统的数据处理方式中,批处理是主流,但是随着业务需求的不断增长,实时数据处理和分析系统变得尤为重要。

基于Spark的实时数据处理与分析系统因其高性能、可扩展性和容错性而备受关注。

本文将介绍基于Spark的实时数据处理与分析系统的设计与实现。

二、Spark简介Apache Spark是一种快速、通用、可扩展的大数据处理引擎,提供了高级API,支持Java、Scala、Python和R等多种编程语言。

Spark具有内存计算和容错机制,能够在内存中高效地进行数据处理和分析,比传统的MapReduce计算速度快数十倍甚至数百倍。

三、实时数据处理与分析系统架构设计基于Spark的实时数据处理与分析系统通常包括以下几个核心组件: 1. 数据采集模块:负责从各种数据源(如Kafka、Flume等)采集数据,并将数据发送给下游处理模块。

2. 实时计算模块:使用Spark Streaming进行实时计算,对接收到的数据进行处理和分析。

3. 存储模块:将处理后的数据存储到相应的存储介质(如HDFS、HBase等)中,以便后续查询和分析。

4. 可视化模块:通过可视化工具(如Tableau、Superset等)展示处理后的数据结果,帮助用户更直观地理解数据。

四、系统设计与实现步骤1. 确定需求首先需要明确业务需求,确定需要处理和分析的数据类型、数据量以及实时性要求。

2. 架构设计根据需求设计系统架构,确定各个组件之间的交互方式和数据流向。

3. 环境搭建搭建Spark集群环境,并配置相关组件(如Kafka、HDFS等),保证系统正常运行。

4. 开发实时计算程序使用Spark Streaming编写实时计算程序,定义数据处理逻辑,并进行测试验证。

5. 数据存储与查询将处理后的数据存储到相应的数据库或文件系统中,并编写查询程序进行验证。

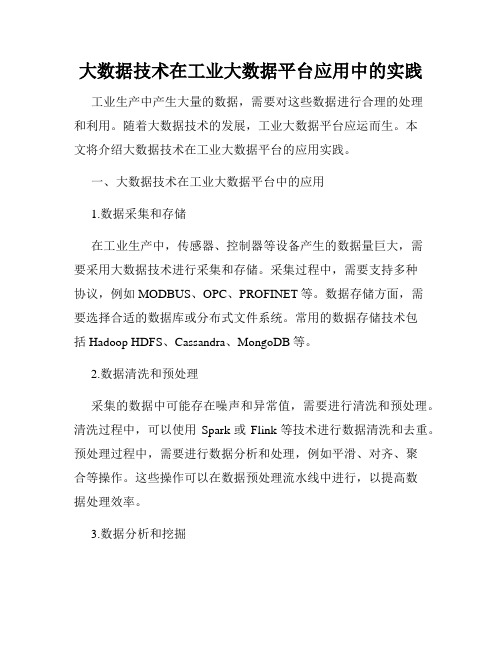

大数据技术在工业大数据平台应用中的实践

大数据技术在工业大数据平台应用中的实践工业生产中产生大量的数据,需要对这些数据进行合理的处理和利用。

随着大数据技术的发展,工业大数据平台应运而生。

本文将介绍大数据技术在工业大数据平台的应用实践。

一、大数据技术在工业大数据平台中的应用1.数据采集和存储在工业生产中,传感器、控制器等设备产生的数据量巨大,需要采用大数据技术进行采集和存储。

采集过程中,需要支持多种协议,例如MODBUS、OPC、PROFINET等。

数据存储方面,需要选择合适的数据库或分布式文件系统。

常用的数据存储技术包括Hadoop HDFS、Cassandra、MongoDB等。

2.数据清洗和预处理采集的数据中可能存在噪声和异常值,需要进行清洗和预处理。

清洗过程中,可以使用Spark或Flink等技术进行数据清洗和去重。

预处理过程中,需要进行数据分析和处理,例如平滑、对齐、聚合等操作。

这些操作可以在数据预处理流水线中进行,以提高数据处理效率。

3.数据分析和挖掘在工业生产中,需要对数据进行分析和挖掘,以便进行生产过程优化。

数据分析可以使用简单的统计方法,例如平均值、方差、标准差等。

数据挖掘可以使用决策树、神经网络、支持向量机等机器学习算法,进行分类、聚类、预测等操作。

这些操作可以使用Spark MLlib、TensorFlow等技术实现。

4.可视化和控制通过工业大数据平台,可以实现对生产过程的可视化和控制。

可视化可以使用D3、Echarts等工具进行数据展示和分析。

控制过程中,需要将数据采集和分析结果进行反馈,对生产过程进行控制和优化。

这些操作可以通过工业控制系统实现。

二、工业大数据平台的应用实践1.钢铁生产数据平台某钢铁企业建立了钢铁生产数据平台,对钢铁生产过程中产生的数据进行采集、存储、处理和分析。

该平台基于Hadoop和HBase实现了海量数据的存储和处理,同时通过Spark MLlib和TensorFlow等技术实现了数据分析和挖掘。

SparkStreaming的原理与实现

SparkStreaming的原理与实现随着大数据时代的来临,实时处理数据已经成为了一个非常重要的需求。

在这个背景下,SparkStreaming应运而生。

SparkStreaming是一个分布式流处理系统,通过对来自各种数据源的实时数据进行处理,可以实现各种实时应用程序的构建。

本文将从SparkStreaming的原理、实现、应用场景以及与其他流处理系统的对比等方面进行探讨,以期对该系统有更深入的理解。

一、SparkStreaming的原理SparkStreaming的核心是基于Spark引擎来处理实时数据流。

Spark本身是一个大规模分布式计算框架,它主要是针对离线批处理任务优化的。

为了应对实时数据流处理的需求,Spark引擎在进行批处理的同时,还可以进行数据流的处理。

SparkStreaming的实现原理可以简述为:SparkStreaming会将接收到的数据流按照一定时间窗口进行批量处理,转化成RDD (Resilient Distributed Dataset),然后对RDD进行计算。

为了实现流式处理,SparkStreaming采用微批处理的方式,即接收到的流数据被按照一定时间间隔分成一批,称之为DStream(Discretized Stream),每个DStream里包含了一个或多个RDD。

在SparkStreaming中,DStream是一种高级别的抽象,可以进行快速开发。

DStream是由数据流实时生成的RDD序列组成,底层实现是一个RDD的序列,因此操作DStream与操作RDD一样,可以应用原本针对批处理设计的大部分算子。

通过这种方式,就可以在原有Spark框架的基础上,实现流处理的功能,从而提供快速、高效、可扩展的实时数据处理能力。

二、SparkStreaming的实现1.数据源SparkStreaming可以支持各种数据源,包括Kafka、Flume、HDFS,还可以有自己的数据源。

史上最全的数据来源和数据分析平台

史上最全的数据来源和数据分析平台标题:史上最全的数据来源和数据分析平台引言概述:随着信息技术的不断发展,数据已经成为当今社会的重要资源之一。

数据来源和数据分析平台的选择对于企业和个人来说至关重要。

本文将介绍史上最全的数据来源和数据分析平台,匡助读者更好地了解并选择适合自己需求的平台。

一、数据来源平台1.1 数据库:数据库是存储数据的集合,提供了数据的组织、存储和管理功能。

常见的数据库包括MySQL、Oracle、SQL Server等。

1.2 互联网:互联网是一个巨大的数据来源平台,通过搜索引擎可以获取各种信息和数据。

1.3 传感器:随着物联网技术的发展,传感器可以实时采集各种数据,如温度、湿度、压力等。

二、数据分析平台2.1 Python:Python是一种流行的编程语言,具有丰富的数据分析库,如Pandas、NumPy、Matplotlib等,可以进行数据处理和可视化分析。

2.2 R语言:R语言是专门用于数据分析和统计建模的编程语言,拥有丰富的数据分析包和图形库,如ggplot2、dplyr等。

2.3 Tableau:Tableau是一款流行的数据可视化工具,可以将数据转化为易于理解的图表和仪表板,匡助用户更好地理解数据。

三、数据挖掘平台3.1 Weka:Weka是一款开源的数据挖掘软件,提供了丰富的数据挖掘算法和工具,可以匡助用户发现数据中隐藏的模式和规律。

3.2 RapidMiner:RapidMiner是一款易于使用的数据挖掘工具,提供了直观的用户界面和强大的数据挖掘功能,适合初学者和专业人士使用。

3.3 KNIME:KNIME是一款开源的数据分析和集成平台,可以通过可视化方式构建数据流程,实现数据挖掘和分析。

四、大数据平台4.1 Hadoop:Hadoop是一个开源的大数据处理框架,可以实现大规模数据的存储和处理,提供了分布式计算和存储功能。

4.2 Spark:Spark是一种快速、通用的大数据处理引擎,可以在内存中进行数据处理,提供了丰富的API和库。

基于Spark的大规模数据流处理与实时计算架构设计

基于Spark的大规模数据流处理与实时计算架构设计在当前信息爆炸的时代,大规模数据流的处理和实时计算已经成为许多企业和组织的重要需求。

为了满足这种需求,基于Spark的大规模数据流处理与实时计算架构设计成为了一种流行的选择。

本文将探讨基于Spark的大规模数据流处理与实时计算架构设计的几个重要方面。

首先,我们来介绍一下Spark。

Spark是一种开源的分布式计算框架,它提供了一个用于大规模数据处理的统一编程模型。

Spark通过将数据分为多个小块,并在集群中的多个节点上并发地进行处理,从而实现了高效的数据处理和并行计算。

Spark支持多种编程语言,如Java、Scala和Python,使得开发人员可以根据自己的喜好和熟练程度来选择。

在基于Spark的大规模数据流处理和实时计算架构设计中,一个关键的组件是流数据的源。

流数据源可以来自多个不同的地方,如传感器、网络日志、社交媒体等。

为了处理这些不断产生的数据流,我们需要将其接入到Spark中进行实时计算。

常用的数据源包括Kafka、Flume和RabbitMQ等,它们提供了稳定可靠的数据流处理能力。

接下来,我们需要设计适当的数据处理流程。

在基于Spark的架构中,数据处理流程可以通过DAG(有向无环图)来表示和管理。

DAG中的每个节点表示一个数据处理操作,如过滤、转换和聚合等。

Spark提供了丰富的高级API和内置函数,使得开发人员可以轻松地在数据处理流程中实现各种复杂的操作。

此外,Spark还支持自定义的分布式数据处理操作,以满足特定的业务需求。

在大规模数据流处理和实时计算中,容错性是一个重要的考虑因素。

由于数据流可能包含噪声和不完整性,我们需要确保系统能够正确地处理这些异常情况。

Spark提供了可靠的流处理机制,可以在故障发生时进行自动恢复和重试。

此外,Spark还支持事件时间处理,可以在数据流中按照时间戳进行有序处理,确保结果的准确性和一致性。

另一个重要的考虑因素是性能。

基于Spark的实时视频分析系统

E — ma i l : c s a @i s c a s . a c . c n

h t t p : / / ww w . c ・ S - a . o r g . c n

Te l : +8 6 . 1 0 . 6 2 6 6 1 0 41

基于 S p a r k的实时视频 分析 系统①

据视频 处理算法划分 为单机 处理与分布 式处理 . 并将视频 图像 处理 与数据分析耦合, 利用 K a f k a消息 队列与 S p a r k s t r e a mi n g完成对多路视 频输 出数据 的进 一步操作. 结 合分布式存储方 案, 并利用 O L A P框架 实现对海量数据 实时

多维 聚合分析与 高效实时查询 . 关键词 : S p a r k ; 视频分析 ; 数据 分析; 实时计算

引用格式: 郑健, 冯瑞. 基于S p a r k 的实时视频分析系统. 计算机系统应用, 2 0 1 7 , 2 6 ( 1 2 ) : 5 l _ 5 7 h t t p : / / w w w. c _ S - a : o r g . c n / l 0 0 3 - 3 2 5 4 / 6 1 1 2 . h t m l

郑 健 ,冯 瑞五

( 复旦大学 计算机科 学技术学院, 上海 2 0 1 2 0 3 ) 。 ( 复旦大学 上海 市智能信息处理重点实验室, 上海 2 0 1 2 0 3 ) 复旦大学 上海视频技术 与系 统工程研 究中心, 上海 2 0 1 2 0 3 )

摘

要: 视频监控技 术在交 通管理 、公共 安全 、智慧城市等 方面有着广泛 的应用前 景, 且 向着智能识 别、实 时处

Abs t r a c t : The vi d e o s u r v e i l l a n c e t e c h no l o g y h a s a wi d e a p pl i c a t i o n p r o s pe c t i n t r a ic f ma na g e me n t , p u bl i c s a f e t y , i nt e l l i g e n t c i t y, a nd i s d e ve l o pi n g t o wa r ds i n t e l l i g e n t r e c o g ni t i o n, r e a l — t i me p r o c e s s i n g, a nd l a r ge d a t a a na l ys i s . I n t h i s pa p e r , we pr o po s e a ne w s ys t e m f o r l a r g e — s c a l e r e a l - t i me vi d e o s ur v e i l l a nc e . The s y s t e m i s b a s e d o n S p a r k s t r e a mi n g, di s t r i b u t e d s t o r a g e a nd OLAP f r a me wo r k S O t h a t mu l t i - c h a n ne l v i d e o p r o c e s s i n g h a s o bv i o u s a d va n t a g e s i n s c a l a bi l i t y, f a u l t t o l e r a nc e a nd d a t a a na l ys i s o f t he mul t i — di me ns i on a l po l yme r . Ac c or di n g t o v i de o pr o c e s s i ng a l g o r i t hm,t h e p r o c e s s i n g mo d ul e i s d i v i d e d i n t o s i n g l e ma c h i n e p r o c e s s i n g a n d di s t ib r u t e d p r o c e s s i ng . The vi de o p r o c e s s i n g i s s e p ra a t e d f r o m t he d a t a a na l ys i s , a n d t h e f u r t h e r o pe r a t i o n o f t he mu l t i - c ha n ne l v i de o o u t pu t d a t a i s c o mp l e t e d b y us i n g Ka f k a me s s a g e q u e u e a n d S pa r k s t r e a mi n g . Co mb i n i n g t h e d i s t r i bu t e d s t o r a g e t e c h n o l o g y wi t h OLAP f r a me wo r k , t h e s ys t e m a c h i e v e s r e a l — t i me mu l t i — d i me ns i o n a l d a t a a n a l ys i s a n d hi g h - pe r f o r ma n c e r e a l — t i me q u e r y.

数据处理中的数据存储和数据管理平台推荐(三)

对于如今的大数据时代来说,数据处理是非常重要的一个环节。

在进行数据处理时,数据的存储和管理平台的选择至关重要。

本文将为大家推荐几个值得关注的数据存储和数据管理平台。

一、HadoopHadoop是目前最流行的大数据平台之一,它基于分布式计算的思想,能够快速高效地处理大规模数据。

Hadoop拥有强大的容错能力和高可用性,能够在硬件故障等情况下保持数据的安全和可靠性。

此外,Hadoop还提供了丰富的工具和技术,如Hive和Pig等,方便用户进行数据的查询和分析。

二、MongoDBMongoDB是一款开源的NoSQL数据库,它采用文档型存储方式,可以存储非结构化和半结构化的数据。

相比传统的关系型数据库,MongoDB具有更高的灵活性和可伸缩性。

它可以通过分片和副本集等方式来处理数据的存储和复制,确保数据的安全性和可用性。

此外,MongoDB还提供了强大的数据分析和聚合功能,方便用户进行数据的处理和分析。

三、SparkSpark是一个快速、通用、面向批处理和实时处理的大数据处理引擎。

它能够在内存中进行数据处理,大大减少了IO的开销,提高了处理速度。

Spark支持多种数据源,如Hadoop、Hive、HBase等,并且提供了强大的数据处理和机器学习库,如Spark SQL、Spark Streaming和MLlib等,方便用户进行各种复杂的数据处理和分析任务。

四、ElasticsearchElasticsearch是一个实时的分布式搜索和分析引擎,主要用于全文搜索和日志分析等场景。

它具有高可用性和可伸缩性,并且能够快速处理大量的数据。

Elasticsearch支持复杂的查询和聚合操作,并且能够提供高效的搜索结果。

此外,Elasticsearch还提供了Kibana 等工具,方便用户进行数据的可视化和监控。

五、KafkaKafka是一个分布式的流处理平台,主要用于处理实时数据流。

它能够高效地处理大规模的数据流,并且提供了可靠的数据传输和持久化。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Kafka上下游的数据质量保证

Kafka

HLC

Kafka

HLC

Kafka

HLC

100K QPS, 300 Gb per hour

LoDsattDaa=t=a M==onLeoyst Money

Destination Destination

工作原理简介

工作原理

3 个审计粒度 • 文件层级(file) • 批次层级(batch) • 记录层级 (record level)

• 基于历史数据,定义 “new value strangeness” • 在时刻t,我们收到一个新的值

• Add it to the history. For each item i in the history

s[i] = strangeness function of (value[i], history)

Batch Processing

快速增长的实时数据

1.3 million

EVENTS PER SECOND INGRESS AT PEAK

~1 trillion

EVENTS PER DAY PROCESSED AT PEAK

3.5 petabytes

PROCESSED PER DAY

100 thousand

• 监控streaming数据的完整性和时延 • 数据pipeline中,Multi-producer, multi-stage, multi-destination数据流 • In near real time • 提供诊断信息:哪个DC, 机器, event/file发生问题 • 超级稳定 99.9% 在线 • Scale out • 审计数据可信

• Let p[t] = (#{i: s[i] > s[t]}+ r*#{i: sБайду номын сангаасi]==s[t]})/N, where r is uniform in (0,1)

• Uniform r makes sure p is uniform

异常检测算法2

异常检测算法3

设计概述

数据监控系统设计目标

基于Kafka和Spark的实时数据质量监控平台

技术创新 变革未来

我们要解决什么问题

数据流

Devices

Services

Interactive analytics

Applications

Kafka as data bus

Scalable pub/sub for NRT data streams

Streaming Processing

UNIQUE DEVICES AND MACHINES

1,300

PRODUCTION KAFKA BROKERS

1 Sec

99th PERCENTILE LATENCY

Producer Producer Producer Producer Producer Producer Producer Producer Producer

Audit数据实际是数据的meta data, 可以用来做各种数据流量的异常检测和监控

异常检测算法1

Holt-Winters 算法

用来训练模型和预测 • 强健性上的改进

• 使用Median Absolute Deviation (MAD) 得到更好的估值 • 处理数据丢点和噪声 (例如数据平滑)

• 自动获取趋势和周期信息 • 允许用户人工标记和反馈来更好的处理趋势变化

Destination 1

数据时延的Kibana图表

数据完整性Kibana图表

3 lines • Green how many records produced • Blue: how many reached destination #1 • Green: how many reached destination #2

基于Power BI更丰富的图表

4 阶段实时数据处理pipeline的监控

发送Audit的代码

Create a client object

Lastly

client.SendBondObject(audit);

Prepare audit object

查询统计信息的APIs

基于Audit数据的异常检测

Metadata

{ “Action” : “Produced or Uploaded”, “ActionTimeStamp” : “action date and time (UTC)”, “Environment” : “environment (cluster) name”, “Machine” : “computer name”, “StreamID” : “type of data (sheeps, ducks, etc.)”, “SourceID” : “e.g. file name”, “BatchID” : “a hash of data in this batch”, “NumBytes” : “size in bytes”, “NumRecords” : “number of records in the batch”, “DestinationID” : “destination ID”

GLR (Generalized Likelihood Ratio)

• Floating Threshold GLR, 基于新的输入数据动态调整模型 • 对于噪声比较大的数据做去除异常点

异常检测算法2

• 基于Exchangeability Martingale时间序列的在线异常检测

• 分布是否发生变化?

}

Producer

Data Center

Producer

File 1:

RRRRReeeeecccccooooorrrrrddddd12345

Produced 2440 bytes 35 records Timestamp “File 1” BatchID=adbecf415263

工作原理 – 数据与审计流

Kafka + HLC under audit

Uploaded 24 bytes 3 records Timestamp BatchID Destination 1

Audit system Produced: file 1: 53 records Uploaded: file 1: 3 records