《计算机视觉》课程综合作业

计算机视觉作业

答:图象分割:把图像划分成区域,使得每一个区域对应一个候选的目标,这种划分称为图象分割.1.图像分割最简形式: 把灰度图(gray image)转换成二值图简单阈值化方法,自动阈值化方法:模态方法(mode),迭代式阈值选择法,自适应阈值化方法,变量阈值化方法,双阈值方法3、区域增长的双阈值算法的内容是什么?1、选择两个阈值T1和T2.2、把图像分割成三个区域:R1,包含所有灰度值低于阈值T1的像素;R2,包含所有灰度值位于阈值T1和T2之间的像素;R3,包含所有灰度值高于阈值T2的像素.3、查看分配给区域R2中的每一个像素.如果某一像素邻接区域R1,则把这一像素重新分配给R1.4、重复步骤3直到没有像素被重新分配.5、把区域R2剩下的所有像素重新分配给R3阵列表示,层级表示,基于特征的区域表示。

均值滤波和高斯滤波中值滤波器、边缘保持滤波器7、边缘检测算法有哪四个步骤?(1)滤波:边缘检测算法主要是基于图像强度的一阶和二阶导数,但导数的计算对噪声很敏感,因此必须使用滤波器来改善与噪声有关的边缘检测器的性能.需要指出,大多数滤波器在降低噪声的同时也导致了边缘强度的损失,因此,增强边缘和降低噪声之间需要折衷.(2)增强:增强边缘的基础是确定图像各点邻域强度的变化值.增强算法可以将邻域(或局部)强度值有显著变化的点突显出来.边缘增强一般是通过计算梯度幅值来完成的.(3)检测:在图像中有许多点的梯度幅值比较大,而这些点在特定的应用领域中并不都是边缘,所以应该用某种方法来确定哪些点是边缘点.最简单的边缘检测判据是梯度幅值阈值判据.(4)定位:如果某一应用场合要求确定边缘位置,则边缘的位置可在子像素分辨率上来估计,边缘的方位也可以被估计出来.8、请举出三种边缘检测器算子的卷积模板。

(1)Roberts算子(2)Sobel算子(3) Prewitt算子9、LoG边缘检测算法的基本特征是什么?基本特征:•平滑滤波器是高斯滤波器.•增强步骤采用二阶导数(二维拉普拉斯函数).•边缘检测判据是二阶导数零交叉点并对应一阶导数的较大峰值.•使用线性内插方法在子像素分辨率水平上估计边缘的位置10、什么是链码?链码是沿着轮廓记录边缘表的一种表示方法.链码规定了边缘表中每一个边缘点的轮廓方向,其中方向被量化为四个或八个方向中的一个.11、请说明轮廓表示的多直线段分裂方法的内容。

计算机视觉作业

计算机视觉作业(总10页) --本页仅作为文档封面,使用时请直接删除即可----内页可以根据需求调整合适字体及大小--不同尺度下LOG和CANNY边缘提取算子性能分析电子23李晓焕141.实验与结果分析在实验中使用了MATLAB 软件对三副图像进行了边缘检测(注:一开始使用的MATLAB R2010b软件在使用edge函数时出现闪退问题无法解决),分别是棋盘格、Lena 和自己选择的一幅自然场景图像(使用Photoshop软件将其转换成8bit灰度,256×256大小的Bmp格式图像)Nature 。

实验中选择的参数如下:对图像施加的高斯白噪声水平分别为σ=和σ=;选择的LOG边缘提取算子的参数分别为阈值=,σ=和阈值=,σ=;选择的Canny边缘提取算子的参数分别为阈值=[,],σ=和阈值=[,],σ=。

MATLAB程序代码示例如下:i=imread('d:\');j=imnoise(i,'gaussian',0,;k1=edge(j,'log',,;k2=edge(j,'canny',[,],;subplot(1,2,1);imshow(k1);title('log,th=,sigma=')subplot(1,2,2);imshow(k2);title('canny,th=[,],sigma=')对lena以及chess图像的边缘检测结果(1)噪声水平为σ=图1-1-1 原灰度图图1-1-2 加噪声图图1-1-3 log,th=,sigma= 图1-1-4 canny,th=[,],sigma=图1-1-5 log,th=,sigma= 图1-1-6 canny,th=[,],sigma=图1-2-1 原灰度图图1-2-2加噪声图图1-2-3 log,th=,sigma= 图1-2-4 canny,th=[,],sigma=图1-2-5 log,th=,sigma= 图1-2-6 canny,th=[,],sigma= (2)噪声水平为σ=图2-1-1 原灰度图图2-1-2加噪声图图2-1-3 log,th=,sigma= 图2-1-4 canny,th=[,],sigma=图2-1-5 log,th=,sigma= 图2-1-6 canny,th=[,],sigma=图2-2-1 原灰度图图2-2-2加噪声图图2-2-3 log,th=,sigma= 图2-2-4 canny,th=[,],sigma=图2-2-5 log,th=,sigma= 图2-2-6 canny,th=[,],sigma=实验中分别用两种算子在两种不同尺度下对图像进行边缘提取。

计算机视觉作业

后付年金的终值和现值 先付年金的终值和现值

一对一的验证过程

一对多的辨别过程

自动人脸识别系统

自动人脸识别系统

数据采集 子系统 人脸检测 子系统 人脸识别 子系统

识别结果: He is …!

• 所谓自动人脸识别系统,是指不需要人为干预,能够自动获 取人脸图像并且辨别出其身份的系统 • 一个自动人脸识别系统至少要包含三个部分,即数据采集子 系统、人脸检测子系统和人脸识别子系统

人脸识别的评价标准

定义11:登陆时间(Enrollment Time)从一幅人脸图像获取后,进 行人脸检测、定位和特征提取所花费的时间,此时间是数学统计平均 值,用毫秒(ms)表示。 定义12:比对时间(Matching Time)比较两张人脸特征所花费的时 间,此时间包含文件读写时间的数学统计平均值,用毫秒(ms)来 表示。或者是将一张人脸特征与一定数量的人脸特征进行比对所花费 的时间的总和,表示为毫秒/万人。 定义13:首选识别率(First Hit)匹配相似度最大的人脸是正确的人 的比率。即将识别结果按照匹配相似度从大到小排列,排在第一位的 人脸就是正确的被识别的人的比率。 定义14:累计识别率(Firs n Hit)正确的识别结果在前N个候选人中 的比率。即将识别结果按照匹配相似度从大到小排列,在前N个结果 中存在被识别的人的比率。

面部特征的模式识别与算法

线性判别分析(Fisher 线性判别) 支持向量机SVM 贝叶斯网络 隐马尔可夫模型及其基本问题 人工神经网络 模糊模式识别

人脸识别系统的设计与实现

人脸识别系统的总体设计 人脸识别系统的算法设计 人脸识别系统的实现

人脸识别系统的开发与实验工具

Intel® 开源计算机视觉库OpenCV简介

计算机视觉基础试题及答案精选全文完整版

可编辑修改精选全文完整版计算机视觉基础试题及答案第一部分:选择题1. 计算机视觉是指计算机具备的哪种能力?a) 看见和理解图像b) 感知周围环境c) 分析和识别物体d) 执行图像处理算法答案:a) 看见和理解图像2. 计算机视觉中常用的图像表示方法是什么?a) RGB表示b) HSL表示c) HSV表示d) CMYK表示答案:a) RGB表示3. 图像中的边缘是什么?a) 两个不同区域的分界线b) 图像中的明暗交界处c) 图像的主要特征点d) 图像中的高频部分答案:b) 图像中的明暗交界处4. 哪种算法常用于图像处理中的图像去噪?a) Sobel算子b) Canny边缘检测算法c) 高斯滤波器d) 傅里叶变换答案:c) 高斯滤波器5. 目标检测是计算机视觉中的一个重要任务,下列哪种方法常用于目标检测?a) 特征匹配b) 边缘检测c) 像素对比d) 颜色匹配答案:a) 特征匹配第二部分:填空题1. 图像的分辨率是指图像中的像素个数,通常用 _______ 表示。

答案:像素2. 计算机视觉中常用的图像特征描述算法是 _______。

答案:SIFT(尺度不变特征变换)3. 在图像处理中,将图像从RGB颜色空间转换到灰度颜色空间,常用的方法是 _______。

答案:加权平均法4. 机器学习中,常用的分类算法有决策树、支持向量机和_______。

答案:神经网络5. 图像分割是图像处理中的一个重要任务,常用的分割方法有阈值分割、区域生长和 _______。

答案:边缘检测第三部分:简答题1. 请简要说明计算机视觉在实际应用中的几个典型领域。

答案:计算机视觉在实际应用中广泛应用于人脸识别、车牌识别、视频监控、医学影像分析等领域。

在人脸识别中,计算机视觉可以通过检测脸部特征点来实现人脸识别;在视频监控中,计算机视觉可以实时分析视频图像,检测异常行为或目标物体;在医学影像分析中,计算机视觉可以辅助医生进行疾病诊断和治疗。

计算机视觉试题及答案精选全文完整版

可编辑修改精选全文完整版计算机视觉试题及答案第一部分:选择题1. 在计算机视觉中,图像处理主要通过哪些操作来提取有用的图像特征?a) 噪声抑制b) 边缘检测c) 特征提取d) 图像拼接答案:c2. 在计算机视觉中,常用的图像拼接算法是什么?a) 最近邻插值b) 双线性插值c) 双三次插值d) 原始图像拼接答案:b3. 在目标检测中,常用的算法是什么?a) Haar特征级联分类器b) SIFT算法c) SURF算法d) HOG特征描述子答案:a4. 在图像分割中,哪种算法可以将图像分割成不同的区域?a) K均值聚类算法b) Canny边缘检测算法c) 霍夫变换d) 卷积神经网络答案:a5. 在计算机视觉中,图像识别是通过什么来实现的?a) 特征匹配b) 图像分割c) 图像去噪d) 图像增强答案:a第二部分:填空题1. 图像的分辨率是指图像中的______。

答案:像素数量(或像素个数)2. 图像的直方图能够表示图像中不同______的分布情况。

答案:像素值(或亮度值)3. 图像处理中常用的边缘检测算子有______。

答案:Sobel、Prewitt、Laplacian等(可以列举多个)4. 在计算机视觉中,SURF算法中的SURF是什么的缩写?答案:加速稳健特征(Speeded-Up Robust Features)5. 在图像分割中,常用的阈值选择算法有______。

答案:Otsu、基于聚类的阈值选择等(可以列举多个)第三部分:问答题1. 请简述计算机视觉的定义及其应用领域。

答:计算机视觉是利用计算机对图像和视频进行理解和解释的研究领域。

它主要包括图像处理、图像分析、目标检测与跟踪、图像识别等技术。

应用领域包括机器人视觉、自动驾驶、安防监控、医学影像处理等。

2. 请简要描述图像处理中常用的滤波器有哪些,并说明其作用。

答:图像处理中常用的滤波器包括均值滤波器、中值滤波器、高斯滤波器等。

均值滤波器用于去除图像中的噪声,通过取邻域像素的平均值来减少噪声的影响;中值滤波器通过取邻域像素的中值来去除图像中的椒盐噪声;高斯滤波器通过对邻域像素进行加权平均来模糊图像,并且能够有效抑制高频噪声。

计算机视觉测试题目及答案

计算机视觉测试题目及答案在计算机视觉领域,测试题目是评估一个人对于图像处理、模式识别和计算机视觉理论的理解和应用能力的重要方法。

下面将给出一些常见的计算机视觉测试题目及其答案,希望能够帮助您更好地了解和掌握相关知识。

1. 图像处理题目:请简要说明什么是图像处理,并列举三种常见的图像处理操作。

答案:图像处理是指对于数字图像进行一系列的操作,以改善图像质量、提取图像特征或实现其他目标的过程。

常见的图像处理操作包括:灰度化、平滑滤波、边缘检测、直方图均衡化、二值化、图像加减运算、图像变换等。

2. 模式识别题目:请简要说明什么是模式识别,并列举三种常用的模式识别方法。

答案:模式识别是指通过对输入模式进行学习和分类,从而实现对未知模式的自动识别的过程。

常用的模式识别方法包括:最近邻算法(K-Nearest Neighbor,KNN)、支持向量机(Support Vector Machine,SVM)、人工神经网络(Artificial Neural Network,ANN)、决策树(Decision Tree)、隐马尔可夫模型(Hidden Markov Model,HMM)等。

3. 计算机视觉理论题目:请简要说明什么是计算机视觉,并介绍计算机视觉的应用领域。

答案:计算机视觉是指通过计算机模拟人类视觉系统的信息处理机制,实现对数字图像或视频的自动分析、理解和处理的学科。

计算机视觉的应用领域非常广泛,包括目标检测与跟踪、人脸识别、视频监控、机器人导航、医学影像分析、自动驾驶等。

4. 图像特征提取题目:请简要说明什么是图像特征提取,并列举三种常用的图像特征。

答案:图像特征提取是指通过对图像进行一系列数学或统计操作,提取出图像中携带有重要信息的特征表示的过程。

常用的图像特征包括:颜色直方图、纹理特征(如灰度共生矩阵)、形状特征(如边缘直方图、轮廓描述子)以及局部特征(如SIFT、SURF等)。

5. 图像分类题目:请简要说明什么是图像分类,并介绍图像分类的主要步骤。

《计算机视觉》题集

《计算机视觉》题集大题一:选择题1.下列哪项不属于计算机视觉的基本任务?A. 图像分类B. 目标检测C. 语音识别D. 语义分割2.在卷积神经网络(CNN)中,以下哪项操作不是卷积层的主要功能?A. 局部感知B. 权重共享C. 池化D. 特征提取3.下列哪个模型在图像分类任务中首次超过了人类的识别能力?A. AlexNetB. VGGNetC. ResNetD. GoogleNet4.以下哪个算法常用于图像中的特征点检测?A. SIFTB. K-meansC. SVMD. AdaBoost5.在目标检测任务中,IoU (Intersection over Union)主要用于衡量什么?A. 检测框与真实框的重叠程度B. 模型的检测速度C. 模型的准确率D. 模型的召回率6.下列哪项技术可以用于提高模型的泛化能力,减少过拟合?A. 数据增强B. 增加模型复杂度C. 减少训练数据量D. 使用更大的学习率7.在深度学习中,批归一化 (Batch Normalization)的主要作用是什么?A. 加速模型训练B. 提高模型精度C. 减少模型参数D. 防止梯度消失8.下列哪个激活函数常用于解决梯度消失问题?A. SigmoidB. TanhC. ReLUD. Softmax9.在进行图像语义分割时,常用的评估指标是?A. 准确率B. 召回率C. mIoU(mean Intersection over Union)D. F1分数10.下列哪个不是深度学习框架?A. TensorFlowB. PyTorchC. OpenCVD. Keras大题二:填空题1.计算机视觉中的“三大任务”包括图像分类、目标检测和______。

2.在深度学习模型中,为了防止梯度爆炸,常采用的技术是______。

3.在卷积神经网络中,池化层的主要作用是进行______。

4.YOLO算法是一种流行的______算法。

5.在进行图像增强时,常用的技术包括旋转、缩放、______和翻转等。

计算机视觉(作业)

视觉是各个应用领域,如制造业、检验、文档分析、医疗诊断,和军事等领域中各种智能/自主系统中不可分割的一部分。

由于它的重要性,一些先进国家,例如美国把对计算机视觉的研究列为对经济和科学有广泛影响的科学和工程中的重大基本问题,即所谓的重大挑战(grand challenge)。

"计算机视觉的挑战是要为计算机和机器人开发具有与人类水平相当的视觉能力。

机器视觉需要图象信号,纹理和颜色建模,几何处理和推理,以及物体建模。

一个有能力的视觉系统应该把所有这些处理都紧密地集成在一起。

作为一门学科,计算机视觉开始于60年代初,但在计算机视觉的基本研究中的许多重要进展是在80年代取得的。

现在计算机视觉已成为一门不同于人工智能、图象处理、模式识别等相关领域的成熟学科。

计算机视觉与人类视觉密切相关,对人类视觉有一个正确的认识将对计算机视觉的研究非常有益。

为此我们将先介绍人类视觉。

计算机视觉与人类视觉密切相关,对人类视觉有一个正确的认识将对计算机视觉的研究非常有益。

为此我们将先介绍人类视觉。

人类视觉感觉是人的大脑与周围世界联系的窗口,它的任务是识别周围的物体,并告诉这些物体之间的关系。

我们的思维活动是以我们对客观世界与环境的认识为基础的,而感觉则是客观世界与我们对环境的认识之间的桥梁,使我们的思维与周围世界建立某种对应关系。

视觉则是人最重要的感觉,它是人的主要感觉来源。

人类认识外界信息的80%来自视觉。

人有多种感觉,但对人的智力产生影响的主要是视觉和听觉。

味觉和嗅觉是丰富多样的,但很少有人去思考它们。

在视觉和听觉中形状、色彩、运动、声音等就很容易被结合成各种明确和高度复杂、多样的空间和时间的组织结构。

所以这两种感觉就成了理智活动得以行使和发挥作用的非常合适的媒介和环境。

但人听到的声音要想具有意义还需要联系其它的感性材料。

而视觉则不同,它是一种高度清晰的媒介,它提供关于外界世界中各种物体和事件的丰富信息。

因此它是思维的一种最基本的工具。

计算机视觉课后作业1——图像处理基础

计算机视觉课后作业1——图像处理基础刚刚开始接触计算机视觉的课程,此次完成图像处理基础部分的内容,并且将其中的直⽅图,⾼斯滤波和直⽅图均衡化的实验结果写在该博客。

环境:Python+opencv软件:PyCharm 2020.1.1⽬录1 直⽅图1.1 基本原理1.2 代码1.3 实验截图2 直⽅图均衡化2.1 基本原理2.2 代码2.3 实验截图3 ⾼斯滤波(⾼斯模糊)3.1 基本原理3.2 代码3.3 实验截图1 直⽅图1.1 基本原理图像的直⽅图反映了⼀幅图像的像素分布情况。

横坐标代表像素的种类,纵坐标代表每⼀种像素值在图像中的像素总数或者占所有像素个数的百分⽐,能够很直观的展⽰出图像中各个像素值占⽐的多少。

我们⼀般⽤到的直⽅图都是灰度直⽅图,其中横坐标是图像的灰度级(0-255),纵坐标则是该灰度级出现的频率或个数。

通过⼀幅图像的亮暗情况就可以判断出其直⽅图的⼤致分布情况,较暗的图像的直⽅图像素分布聚集在左侧,较亮的图像直⽅图像素分布聚集在右侧。

1.2 代码注意:<1>⽤到了PIL库中的Image模块,⽤来打开本地图⽚。

PIL(Python Imaging Library)是⼀个⾮常好⽤的图像处理库,但新版的Python不⽀持PIL,⽽是使⽤Pillow(也是第三⽅库)。

<2>pylab 模块是进⾏⼆维,三维数据绘制的⼯具模块,由于 pylab是matplotlib中的⼀个模块所以我们直接安装matplotlib库就可以对它进⾏调⽤。

<3>在默认状态下,matplotlb⽆法在图表中使⽤中⽂,在此我们使⽤matplotlib的字体管理器matplotlib.Font_manager来指定字体⽂件。

from PIL import Imagefrom pylab import *from matplotlib.font_manager import FontProperties# 添加中⽂字体⽀持font = FontProperties(fname=r"c:\windows\fonts\SimSun.ttc", size=14)# 指定字体⽂件——中⽂im = array(Image.open('D:\\MATLAB\\bin\\fj.jpg').convert('L')) # 打开图像,并转成灰度图figure()subplot(121)gray()contour(im, origin='image')#在原点左上⾓显⽰轮廓图像axis('equal')#x轴和y轴单位长度⼀致axis('off')#关闭坐标轴线title(u'图像轮廓', fontproperties=font)subplot(122)hist(im.flatten(), 128)#绘制图像灰度直⽅图title(u'图像直⽅图', fontproperties=font)plt.xlim([0,260])plt.ylim([0,11000])show()1.3 实验截图2 直⽅图均衡化2.1 基本原理对于随便⼀张图来说,较暗图像的灰度直⽅图的分量(灰度级)集中在灰度较低的⼀端;⽽较亮图像的灰度直⽅图的分量则偏向于灰度较⾼的⼀端。

计算机视觉作业

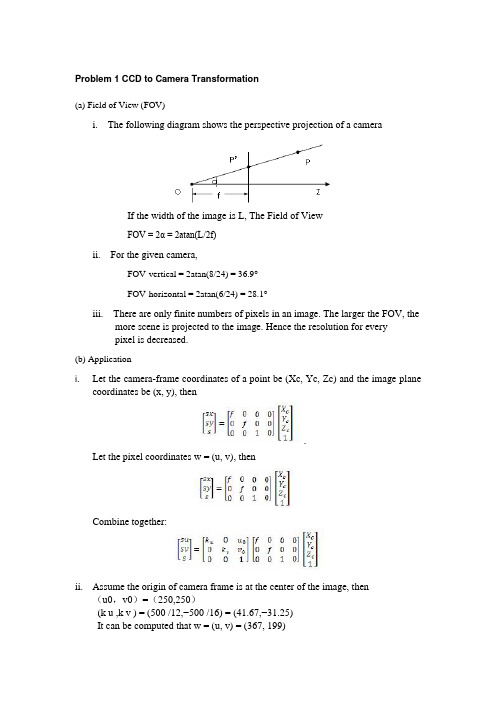

Problem 1 CCD to Camera Transformation(a) Field of View (FOV)i. The following diagram shows the perspective projection of a cameraIf the width of the image is L, The Field of ViewFOV = 2α = 2atan(L/2f)ii. For the given camera,FOV-vertical = 2atan(8/24) = 36.9°FOV-horizontal = 2atan(6/24) = 28.1°iii. There are only finite numbers of pixels in an image. The larger the FOV, the more scene is projected to the image. Hence the resolution for everypixel is decreased.(b) Applicationi. Let the camera-frame coordinates of a point be (Xc, Yc, Zc) and the image planecoordinates be (x, y), then.Let the pixel coordinates w = (u, v), thenCombine together:ii. Assume the origin of camera frame is at the center of the image, then (u0,v0)=(250,250)(k u ,k v ) = (500 /12,−500 /16) = (41.67,−31.25)It can be computed that w = (u, v) = (367, 199)Problem 2 Camera Projection (a) Let X c =a+λb,thenIt represents a line in a 2D space(b)The camera frame coordinates of sphere isThen Simulated in Matlab, the projection is shown asIt is not a circle on the image plane3a.CamMatrix =⎪⎪⎪⎭⎫⎝⎛------0021.00002.00002.00002.06010.00881.03264.00881.06283.01866.00532.02905.0 After defining a 2Nx12 matrix P as given in the reading and can be seen explicitly in my code, I found the desired projection matrix by finding the eigenvector corresponding to the smallest eigenvalue of P’*P, and reshaped this vector into a 3x4 matrix, as in the method described in section 3.1 of the text. Printing out the input (u,v)values and those generated by obtained matrix, both are seen to be projections of equivalent cubes in space, so the matrix appears to be valid.I decomposed my matrix into K[R,T], but I am afraid that my K matrix is not correct. From my notes, the readings, and an outside article, I have not been able to discern what I am missing, but the product of my decomposed matrices is incorrect. Generating code is in the file LinearCalib.mat. I was, however, able to find several of the relevant parameters: rho = 3.3134e+003 u0 = 300.5 v0 = 300.5 theta = 3.14/2alpha = 1.1177e+003 beta = 1.1177e+003R = ⎪⎪⎪⎭⎫ ⎝⎛-----5725.04150.07071.05869.08097.00000.05725.04150.07071.0T = (0.0000 −0.0810 6.9277)T3b.The points (0, 0, 0), (1, 1, 1), and (5, 5, 5) all transform to approximately (300.5,287.4363), the desired result, for they are on the same line. However, the second coordinate takes on values 287.4361, 287.4363, and 287.4337, respectively, demonstrating a small amount of error already by the third decimal place. Other points: (−1, 1, 1) →(549.7931, 143.4970) (1,−1, 1) → (300.5, 574.0207)(−1,−1, 1) → (510.8559, 408.8933).All three of these corner points transformed to the exact values given (up to the decimal places inspected), implying that my matrix is accurate to a reasonable precision, considering that any radial distortion was ignored.4a.For the image hall1.pgm, the four corners of the door in image coordinates and world coordinates are:u = [183, 361, 205, 358]; v = [109, 155, 917, 805];x = [0, 91, 0, 91];y = [182, 182, 0, 0];These points define an 8x9 matrix as in the reading, whose eigenvector corresponding to the smallest eigenvalue defines the desired H matrix. Reshaped to a 3x3 matrix, we find:H =⎪⎪⎪⎭⎫ ⎝⎛---0011.00000.00000.09759.00048.00009.02182.00003.00028.0Applying the inverse of this matrix to the input image, the following is obtained, withvisible aliasing as the image size is stretched.Using the same method on edwardVI.pgm, with the point data:u = [0,607,0,170]; v = [0,0,170,170]; x = [200, 0, 200, 0]; y = [200, 200, 0, 0];I get the following image, where the aliasing occurs as the image is stretched towards the viewer. I would have expected the circle to be more fully circular than my results present.Applying the method to Checkerboard.pgm, with data:u = [113, 144, 504, 471];v = [305, 183, 295, 174];x = [0, 0, 200, 200];y = [0, 100, 0, 100];Results in the image:4b.This method uses the same H matrix as in part A, but is premultiplied by a matrix T−1and postmultiplied by a matrix U, where T rotates and translates the image data to be centered around (0,0) and have an average distance of 1.414 from the origin, and U does the same for the scene points. For the image hall1.pgm,T =⎪⎪⎪⎭⎫ ⎝⎛-0000.1008793.010038.02182.000038.0andU =⎪⎪⎪⎭⎫ ⎝⎛--0000.1002649.10139.006394.000139.0 The resulting images look exactly the same as in part (a) for all three cases, and arenot reprinted here (all three were checked).4c.This method incorporated more errors than parts (a) and (b). For teach image, I found fourpoints on the four corners of a rectangle on a plane in the image, and used the two sets of parallel lines this rectangle defined to find two vanishing points. The line connecting these points is the vanishing line, represented ax+by+c = 0, and then the given matrix formula (with fixed type-os) was used to rectify the image. I found that the value of f I used played a huge role in the accuracy of the resulting image. Large focal lengths resulted in image coordinates many times larger than the desired resulting image, but when f was taken to be in the range 0.3 to 0.5, a reasonable image was generated. The images produced by this method were not as accurate as those from parts (a) and (b), even when the pixel values were centered around the origin. However, the images do approximate the desired results. For the image hall1.pgm, the generated matrix is:⎪⎪⎪⎭⎫ ⎝⎛---3500.00000.00005.00000.09919.01040.00005.01040.03419.0 The resulting image for hall1.pgm is below, and we see that it is not as accurate as theprevious two methods.The same method was applied to Checkerboard.pgm and Railroad.pgm, each time chosing four points on a plane in the scene to determine the vanishing line. The Railroad image, in particular, took a very long time to generate (I actually had to cancel it before it finished the top 100 rows of pixels, as the matrix vector multiplications were somehow taking up too much memory, so the image below is missing the top 100 rows of pixels in the scene). Similar to hall1, we see that the checkerboard example is not as square as it was in parts (a)and (b). The results are below:4d.If we used an affine instead of a projective transformation to describe a plane-to-plane transformation, we would have 6 degrees of freedom. An affine transformation preserves collinearity and ratios of distances, which means it preserves parallel lines, unlike a projective transformation, and the projected midpoint of any line remains the midpoint of the projected line, again a feature not preserved by projective transformations, and affine transformations do not have lines or planes at infinity. Affine transformations can be represented as combinations of rotations, translations, dilations, and shears. A general affine transformation (for the given situation) has 8 degrees of freedom, compared to the 11 of the projective transformation, so although the projective transformation loses 3 degrees of freedom in the plane-to-plane transformation (from allowing z = 0 without loss of generality), the affine transformation only loses 2 degrees of freedom, as it is already limited inthe transformations it can perform.With projective transformations, it is possible for a planar square to project to a triangle in the limit as two of the parallel sides meet at a vanishing point. As affine transformations preserlve parallelism, this cannot be the case in an affine transformation. Affine transformations are appropriate models when the distance between the ”front” and ”back” of the scene is small, so that size changes due toperspective are small enough to be irrelevant. are appropriate models when the distance between the ”front” and ”back” of the scene is small, so that size changes due to perspective are small enough to be irrelevant.4.a – edwardVI.pgm4.a – filecab.pgm。

计算机视觉试题及答案解析

计算机视觉试题及答案解析计算机视觉是计算机科学领域中的一个重要分支,旨在使计算机具有理解和解释图像和视频的能力。

本文将为您提供一些计算机视觉的试题,并对每个试题的答案进行解析。

希望通过本文的学习,您能更好地理解计算机视觉的知识和应用。

1. 在计算机视觉中,什么是图像分割?答:图像分割是将图像划分为若干个具有独立语义的区域的过程。

其目标是将图像中的每个像素归类到特定的区域,以实现对图像的语义理解和分析。

解析:图像分割是计算机视觉中的一个基础任务,常用于目标识别、图像分析等领域。

通过图像分割,可以将图像中的不同物体或区域分离开来,便于后续的处理和分析。

2. 什么是特征提取?在计算机视觉中有哪些常用的特征提取方法?答:特征提取是指从图像或视频中提取出具有代表性的特征,用于描述和表达图像的某些重要属性或结构。

常用的特征提取方法有颜色直方图、纹理特征、边缘检测等。

解析:特征提取是计算机视觉中非常重要的一步,它能提取图像中的关键信息,帮助计算机进行图像分类、目标识别、图像匹配等任务。

不同的特征提取方法适用于不同类型的图像和应用场景。

3. 请解释卷积神经网络(CNN)在计算机视觉中的作用。

答:卷积神经网络是一种深度学习算法,它模拟了人脑中视觉皮层的工作原理,并在计算机视觉中取得了极大的成功。

CNN在计算机视觉中主要用于图像识别、目标检测和图像分割等任务。

解析:卷积神经网络通过多层的卷积和池化操作,可以有效地提取图像的特征,并进行图像分类和目标识别。

它具有良好的特征提取能力和自动学习能力,能够自动学习到图像中的重要特征,并进行高效准确的图像处理和分析。

4. 请简要介绍图像识别中的目标检测算法。

答:目标检测是指在图像中定位和识别出物体或目标的算法。

常用的目标检测算法有基于深度学习的 Faster R-CNN、YOLO(You Only Look Once)、SSD(Single Shot MultiBox Detector)等。

计算机视觉综合实训报告

一、实习目的随着人工智能技术的飞速发展,计算机视觉作为人工智能的重要分支,已成为科技研究和产业发展的热点。

为了提升自身在计算机视觉领域的理论水平和实践能力,本次实训旨在通过综合实训项目,深入理解计算机视觉的基本原理和应用,掌握相关技术和工具,并能够独立完成具体的项目任务。

二、实训背景本次实训项目选取了人脸识别、自动驾驶和图像处理三个领域作为主要研究方向。

人脸识别技术广泛应用于安防监控、身份验证等领域;自动驾驶技术是智能交通的重要组成部分,对提升交通安全和效率具有重要意义;图像处理技术则是计算机视觉的基础,涉及图像增强、特征提取、目标检测等多个方面。

三、实训内容1. 人脸识别(1)人脸检测:通过使用OpenCV库中的Haar级联分类器,实现了对人脸的检测。

(2)人脸特征提取:采用深度学习技术,使用卷积神经网络(CNN)提取人脸特征。

(3)人脸识别:基于特征提取结果,利用相似度计算方法,实现了人脸识别功能。

2. 自动驾驶(1)车道线检测:采用Hough变换方法,实现了车道线的检测。

(2)车辆检测:通过使用SSD(Single Shot MultiBox Detector)算法,实现了车辆的检测。

(3)车辆跟踪:利用卡尔曼滤波和目标跟踪算法,实现了车辆的实时跟踪。

3. 图像处理(1)图像增强:通过直方图均衡化、中值滤波等方法,提高了图像质量。

(2)特征提取:采用SIFT(Scale-Invariant Feature Transform)算法,实现了图像特征的提取。

(3)目标检测:利用YOLO(You Only Look Once)算法,实现了目标的检测。

四、实训成果1. 完成了人脸识别、自动驾驶和图像处理三个领域的综合实训项目。

2. 掌握了OpenCV、深度学习、卡尔曼滤波等关键技术。

3. 提升了编程能力和团队协作能力。

4. 撰写了1500字的实训报告,总结了实训过程中的经验和收获。

五、实训总结1. 计算机视觉技术在各个领域具有广泛的应用前景,本次实训项目使我深刻认识到计算机视觉技术的魅力。

计算机视觉大作业

基于OpenCV的切水果外挂设计第一章引言1.1 背景在计算机视觉课程的前几课中,听覃老师说,曾经有个学长自己动手做了一个游戏的外挂,获得了很大的成功。

跟人感觉这位学长能将自己所学与个人的技能相结合,成功的做出了实际的东西,着实厉害;同时这个过程将会对于个人的学习和成长都将有积极影响和意义。

笔者在听了覃老师的介绍后,对于与计算机视觉相关的游戏外挂的设计产生了浓厚的兴趣。

有考虑到笔者在外来两年内的研究方向都将图像处理或是计算机视觉,且近期笔者正在使用QT+OpenCV+OpenGL进行基于嵌入式Linux的图像处理和开发。

所以笔者若选择一个类似的外挂程序的编写和设计,将对个人今后的学习有着积极的意义。

因此笔者在网上搜索了很多与图像处理有关网页游戏,如图1所示。

笔者试玩了多种计算机视觉相关的游戏,并最终决定写一个切水果的游戏的外挂程序。

图 1 各种网页游戏图2 各类切水果的游戏1.2 OpenCV简介OpenCV[1]的全称是:Open Source Computer Vision Library。

OpenCV是一个基于(开源)发行的跨平台计算机视觉库,OpenCV是由英特尔公司发起并参与开发,以BSD许可证授权发行,可以在商业和研究领域中免费使用,可以运行在Linux、Windows和Mac OS操作系统上。

OpenCV库的所有代码都经过优化,计算效率很高,因为,它更专注于设计成为一种用于实时系统的开源库。

OpenCV采用C语言进行优化,而且,在多核机器上面,其运行速度会更快。

它的一个目标是提供友好的机器视觉接口函数,从而使得复杂的机器视觉产品可以加速面世。

该库包含了横跨工业产品检测、医学图像处理、安防、用户界面、摄像头标定、三维成像、机器视觉等领域的超过500个接口函数。

近年来,在入侵检测、特定目标跟踪、目标检测、人脸检测、人脸识别、人脸跟踪等领域,OpenCV可谓大显身手,而这些,仅仅是其应用的冰山一角。

计算机视觉考试试题及答案

计算机视觉考试试题及答案1. 图像预处理是计算机视觉中的重要步骤,请简要说明以下预处理方法的作用:a) 图像增强b) 图像滤波c) 图像二值化答案:a) 图像增强:通过改变图像的灰度、对比度等属性,使图像更清晰、更易于分析和识别。

b) 图像滤波:通过去除图像中的噪声、平滑图像等方式,提高图像的质量并减少处理中的干扰。

c) 图像二值化:将图像转化为黑白二值图像,通过阈值处理将像素值分为前景和背景,简化后续的图像处理步骤。

2. 请解释以下计算机视觉中常用的特征描述子及其使用场景:a) SIFT (Scale-Invariant Feature Transform)b) SURF (Speeded Up Robust Features)c) ORB (Oriented FAST and Rotated BRIEF)答案:a) SIFT:SIFT特征描述子通过寻找图像中尺度不变的关键点,并在这些关键点周围计算局部特征描述子,用于图像匹配、目标检测等场景。

b) SURF:SURF特征描述子是一种加速版的SIFT算法,利用快速的特征提取和描述方法,适用于实时性要求较高的计算机视觉应用。

c) ORB:ORB特征描述子结合了FAST关键点检测和BRIEF描述子,并加入了旋转不变性,适用于实时目标识别和跟踪等应用场景。

3. 请简要介绍计算机视觉中的目标检测方法,并说明它们的差异性。

答案:目标检测是计算机视觉中一个重要的任务,常用的目标检测方法包括:a) Haar特征分类器:基于Haar-like特征的级联分类器,通过对图像中不同尺度的矩形区域进行特征计算和分类,具有较快的检测速度。

b) HOG (Histogram of Oriented Gradients):基于图像中梯度方向的统计特征,通过计算图像局部区域的梯度直方图来表示图像,常用于行人检测等场景。

c) CNN (Convolutional Neural Network):基于深度学习的卷积神经网络模型,通过多层卷积和全连接层的组合,实现端到端的目标检测,能够学习更丰富的特征表示。

计算机视觉考试试题及答案精选全文完整版

可编辑修改精选全文完整版计算机视觉考试试题及答案一、选择题1. 下列哪个不是计算机视觉的应用领域?A. 人脸识别B. 增强现实C. 虚拟现实D. 股票交易答案:D2. 计算机视觉是指计算机模拟人类的视觉系统进行图像处理和分析的技术。

A. 正确B. 错误答案:A3. 以下哪个不是计算机视觉主要研究的内容?A. 图像处理B. 物体识别C. 机器学习D. 运动跟踪答案:C4. 下列哪个不是计算机视觉处理图像时常用的方法?A. 边缘检测B. 目标跟踪C. 直方图均衡化D. 推理机制答案:D5. 下列哪个不是计算机视觉中常用的特征描述方法?A. 尺度不变特征变换(SIFT)B. 高斯金字塔C. 主成分分析(PCA)D. 平均池化答案:D二、填空题1. 计算机视觉与人工智能、机器学习和模式识别等领域有着密切的______。

答案:关联2. 机器学习在计算机视觉中的应用非常广泛,常用的算法包括支持向量机、______网络和决策树等。

答案:神经3. 图像边缘是指像素灰度发生突变的______。

答案:位置4. 目标跟踪是计算机视觉中的一个重要研究方向,常见的目标跟踪方法包括模板匹配、______跟踪和粒子滤波等。

答案:卡尔曼三、简答题1. 请简要解释计算机视觉中的图像处理是指什么?答:图像处理是计算机视觉中的一个基础部分,它用于对图像进行增强、滤波、几何变换等操作,以提取图像中的有用信息或改善图像的质量。

常见的图像处理方法包括边缘检测、图像平滑、直方图均衡化等。

2. 请简要描述一种常用的目标检测方法。

答:一种常用的目标检测方法是基于深度学习的卷积神经网络(CNN)。

该方法通过训练神经网络,使其能够自动学习目标的特征,并用于检测图像中是否存在目标。

通常,CNN首先通过卷积层提取图像的特征,然后通过池化层降低特征的维度,最后使用全连接层输出目标的概率或位置。

通过大量的训练样本和迭代训练,CNN可以达到较高的目标检测准确率。

计算机视觉考试题目及参考答案

计算机视觉考试题目及参考答案一、选择题(每题2分,共30分)1. 计算机视觉主要研究的是:A. 计算机图像处理B. 计算机图形学C. 计算机视觉系统D. 计算机视觉算法答案:C2. 图像处理与计算机视觉的区别在于:A. 图像处理注重图像的获取和传输,计算机视觉注重图像的解释和理解B. 图像处理主要用于网络传输,计算机视觉主要用于图像处理C. 图像处理是计算机视觉的一个子领域D. 图像处理与计算机视觉没有区别答案:A3. 计算机视觉应用广泛,以下哪项不是计算机视觉的应用之一:A. 人脸识别B. 视频监控C. 自动驾驶D. 家电控制答案:D4. 图像分割是计算机视觉中的重要任务,以下哪种方法常用于图像分割:A. 模糊聚类B. 边缘检测C. 直方图均衡化D. 滤波处理答案:B5. 特征提取是计算机视觉中的关键步骤,以下哪种方法常用于特征提取:A. 主成分分析(PCA)B. 高斯模糊C. 轮廓检测D. 图像压缩答案:A二、填空题(每题3分,共30分)1. 图像的分辨率指的是图像中包含的______。

答案:像素点2. 图像的边缘可以通过______算法来检测。

答案:Canny3. 图像配准是指将多幅图像在______方面进行对齐。

答案:空间4. 在计算机视觉中,用于描述图像颜色的模型有RGB和______。

答案:HSV5. OCR是计算机视觉中的一项重要任务,其全称为______。

答案:Optical Character Recognition三、简答题(每题10分,共30分)1. 请简要介绍计算机视觉的基本原理和流程。

答案:计算机视觉的基本原理是通过图像获取、图像处理和图像解释三个步骤来实现对图像的理解和应用。

图像获取是指通过摄像机等设备获取图像数据;图像处理是指对图像进行预处理,包括去噪、增强、分割等操作;图像解释是指通过特征提取、目标检测和识别等算法对图像进行分析和解释。

2. 请简要介绍计算机视觉在人脸识别中的应用及原理。

《计算机视觉》课程综合作业

《计算机视觉》课程综合作业一、论述题1.计算机视觉的研究领域及其主要支持技术?简述当前的技术进展。

答:计算机视觉是使用计算机及相关设备对生物视觉的一种模拟。

它的主要任务就是通过对采集的图片或视频进行处理以获得相应场景的三维信息,就像人类和许多其他类生物每天所做的那样。

计算机视觉既是工程领域,也是科学领域中的一个富有挑战性重要研究领域。

计算机视觉是一门综合性的学科,它已经吸引了来自各个学科的研究者参加到对它的研究之中。

其中包括计算机科学和工程、信号处理、物理学、应用数学和统计学,神经生理学和认知科学等。

有不少学科的研究目标与计算机视觉相近或与此有关。

主要支持技术包括图象处理、模式识别或图象识别、景物分析、图象理解等。

由于历史发展或领域本身的特点这些学科互有差别,但又有某种程度的相互重迭。

图象处理图象处理技术把输入图象转换成具有所希望特性的另一幅图象。

例如,可通过处理使输出图象有较高的信-噪比,或通过增强处理突出图象的细节,以便于操作员的检验。

在计算机视觉研究中经常利用图象处理技术进行预处理和特征抽取。

模式识别模式识别技术根据从图象抽取的统计特性或结构信息,把图象分成予定的类别。

例如,文字识别或指纹识别。

在计算机视觉中模式识别技术经常用于对图象中的某些部分,例如分割区域的识别和分类。

图象理解给定一幅图象,图象理解程序不仅描述图象本身,而且描述和解释图象所代表的景物,以便对图象代表的内容作出决定。

在人工智能视觉研究的初期经常使用景物分析这个术语,以强调二维图象与三维景物之间的区别。

图象理解除了需要复杂的图象处理以外还需要具有关于景物成象的物理规律的知识以及与景物内容有关的知识。

当前的技术进展:人工智能所研究的一个主要问题是:如何让系统具备“计划”和“决策能力”?从而使之完成特定的技术动作(例如:移动一个机器人通过某种特定环境)。

这一问题便与计算机视觉问题息息相关。

在这里,计算机视觉系统作为一个感知器,为决策提供信息。

计算机视觉课程设计作业

计算机视觉课程设计作业一、教学目标本课程旨在让学生了解和掌握计算机视觉的基本概念、技术和应用,培养学生对计算机视觉的兴趣和好奇心,提高学生的科学素养和创新能力。

具体目标如下:1.知识目标:使学生了解计算机视觉的定义、发展历程和应用领域;掌握图像处理、特征提取、目标检测和识别等基本技术;了解深度学习在计算机视觉中的应用。

2.技能目标:培养学生运用计算机视觉技术解决实际问题的能力,如编写简单的图像处理程序、实现目标检测算法等;提高学生的编程能力和实践操作能力。

3.情感态度价值观目标:培养学生对科学研究的热情,增强学生的团队合作意识和沟通能力,使学生认识到计算机视觉技术在现实生活中的重要作用,提高学生的社会责任感和使命感。

二、教学内容本课程的教学内容主要包括以下几个部分:1.计算机视觉概述:介绍计算机视觉的定义、发展历程、应用领域和未来发展趋势。

2.图像处理基础:讲解图像处理的基本概念、技术和方法,如图像滤波、边缘检测、图像增强等。

3.特征提取与目标检测:介绍特征提取的方法和目标检测的基本算法,如SIFT、HOG、YOLO等。

4.计算机视觉应用:讲解计算机视觉在现实生活中的应用案例,如人脸识别、自动驾驶、医疗诊断等。

5.深度学习与计算机视觉:介绍深度学习在计算机视觉领域的应用,如卷积神经网络(CNN)、循环神经网络(RNN)等。

三、教学方法为了提高教学效果,本课程将采用多种教学方法相结合的方式,包括:1.讲授法:教师讲解基本概念、原理和方法,引导学生掌握计算机视觉的核心知识。

2.讨论法:学生进行小组讨论,培养学生的思考能力和团队合作意识。

3.案例分析法:分析现实生活中的计算机视觉应用案例,让学生了解计算机视觉技术的实际应用。

4.实验法:安排实验室实践环节,让学生动手编写程序,提高学生的实践操作能力。

四、教学资源为了支持本课程的教学,我们将准备以下教学资源:1.教材:选用权威、实用的教材,如《计算机视觉:算法与应用》等。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

《计算机视觉》课程综合作业一、论述题1.计算机视觉的研究领域及其主要支持技术?简述当前的技术进展。

答:计算机视觉是使用计算机及相关设备对生物视觉的一种模拟。

它的主要任务就是通过对采集的图片或视频进行处理以获得相应场景的三维信息,就像人类和许多其他类生物每天所做的那样。

计算机视觉既是工程领域,也是科学领域中的一个富有挑战性重要研究领域。

计算机视觉是一门综合性的学科,它已经吸引了来自各个学科的研究者参加到对它的研究之中。

其中包括计算机科学和工程、信号处理、物理学、应用数学和统计学,神经生理学和认知科学等。

有不少学科的研究目标与计算机视觉相近或与此有关。

主要支持技术包括图象处理、模式识别或图象识别、景物分析、图象理解等。

由于历史发展或领域本身的特点这些学科互有差别,但又有某种程度的相互重迭。

图象处理图象处理技术把输入图象转换成具有所希望特性的另一幅图象。

例如,可通过处理使输出图象有较高的信-噪比,或通过增强处理突出图象的细节,以便于操作员的检验。

在计算机视觉研究中经常利用图象处理技术进行预处理和特征抽取。

模式识别模式识别技术根据从图象抽取的统计特性或结构信息,把图象分成予定的类别。

例如,文字识别或指纹识别。

在计算机视觉中模式识别技术经常用于对图象中的某些部分,例如分割区域的识别和分类。

图象理解给定一幅图象,图象理解程序不仅描述图象本身,而且描述和解释图象所代表的景物,以便对图象代表的内容作出决定。

在人工智能视觉研究的初期经常使用景物分析这个术语,以强调二维图象与三维景物之间的区别。

图象理解除了需要复杂的图象处理以外还需要具有关于景物成象的物理规律的知识以及与景物内容有关的知识。

当前的技术进展:人工智能所研究的一个主要问题是:如何让系统具备“计划”和“决策能力”?从而使之完成特定的技术动作(例如:移动一个机器人通过某种特定环境)。

这一问题便与计算机视觉问题息息相关。

在这里,计算机视觉系统作为一个感知器,为决策提供信息。

另外一些研究方向包括模式识别和机器学习(这也隶属于人工智能领域,但与计算机视觉有着重要联系),也由此,计算机视觉时常被看作人工智能与计算机科学的一个分支。

计算机视觉关注的目标在于充分理解电磁波——主要是可见光与红外线部分——遇到物体表面被反射所形成的图像,而这一过程便是基于光学物理和固态物理,一些尖端的图像感知系统甚至会应用到量子力学理论,来解析影像所表示的真实世界。

同时,物理学中的很多测量难题也可以通过计算机视觉得到解决,例如流体运动。

也由此,计算机视觉同样可以被看作是物理学的拓展。

另一个具有重要意义的领域是神经生物学,尤其是其中生物视觉系统的部分。

在整个20世纪中,人类对各种动物的眼睛、神经元、以及与视觉刺激相关的脑部组织都进行了广泛研究,这些研究得出了一些有关“天然的”视觉系统如何运作的描述(尽管仍略嫌粗略),这也形成了计算机视觉中的一个子领域——人们试图建立人工系统,使之在不同的复杂程度上模拟生物的视觉运作。

同时计算机视觉领域中,一些基于机器学习的方法也有参考部分生物机制。

计算机视觉的另一个相关领域是信号处理。

很多有关单元变量信号的处理方法,尤其对是时变信号的处理,都可以很自然的被扩展为计算机视觉中对二元变量信号或者多元变量信号的处理方法。

但由于图像数据的特有属性,很多计算机视觉中发展起来的方法,在单元信号的处理方法中却找不到对应版本。

这类方法的一个主要特征,便是他们的非线性以及图像信息的多维性,以上二点作为计算机视觉的一部分,在信号处理学中形成了一个特殊的研究方向。

2.双目立体视觉技术原理及其研究现状?答:双目立体视觉是计算机视觉的一个重要分支,即由不同位置的两台或者一台摄像机(CCD)经过移动或旋转拍摄同一幅场景,通过计算空间点在两幅国像中的视差,获得该点的三维坐标值。

基本原理如下:立体视觉系统由左右两部摄像机组成。

如图二所示,图中分别以下标l和r标注左、右摄像机的相应参数。

世界空间中一点A(X,Y,Z)在左右摄像机的成像面Cl和Cr上的像点分别为al(ul,vl)和ar(ur,vr)。

这两个像点是世界空间中同一个对象点A的像,称为“共轭点”。

知道了这两个共轭像点,分别作它们与各自相机的光心Ol和Or的连线,即投影线alOl和arOr,它们的交点即为世界空间中的对象点A(X,Y,Z)。

这就是立体视觉的基本原理。

双目体视目前主要应用于四个领域:机器人导航、微操作系统的参数检测、三维测量和虚拟现实。

目前研究现状如下:日本大阪大学自适应机械系统研究院研制了一种自适应双目视觉伺服系统,利用双目体视的原理,如每幅图像中相对静止的三个标志为参考,实时计算目标图像的雅可比短阵,从而预测出目标下一步运动方向,实现了对动方式未知的目标的自适应跟踪。

该系统仅要求两幅图像中都有静止的参考标志,无需摄像机参数。

而传统的视觉跟踪伺服系统需事先知道摄像机的运动、光学等参数和目标的运动方式。

日本奈良科技大学信息科学学院提出了一种基于双目立体视觉的增强现实系统(AR)注册方法,通过动态修正特征点的位置提高注册精度。

该系统将单摄像机注册(MR)与立体视觉注册(SR)相结合,利用MR和三个标志点算出特征点在每个图像上的二维坐标和误差,利用SR和图像对计算出特征点的三维位置总误差,反复修正特征点在图像对上的二维坐标,直至三维总误差小于某个阈值。

该方法比仅使用MR或SR方法大大提高了AR系统注册深度和精度。

实验结果如图2,白板上三角开的三顶点被作为单摄像机标定的特征点,三个三角形上的模型为虚拟场景,乌龟是真实场景,可见基本上难以区分出虚拟场景(恐龙)和现实场景(乌龟)。

日本东京大学将实时双目立体视觉和机器人整体姿态信息集成,开发了仿真机器人动态行长导航系统。

该系统实现分两个步骤:首先,利用平面分割算法分离所拍摄图像对中的地面与障碍物,再结合机器人身体姿态的信息,将图像从摄像机的二维平面坐标系转换到描述躯体姿态的世界坐标系,建立机器人周围区域的地图;基次根据实时建立的地图进行障碍物检测,从而确定机器人的行走方向。

日本冈山大学使用立体显微镜、两个CCD摄像头、微操作器等研制了使用立体显微镜控制微操作器的视觉反馈系统,用于对细胞进行操作,对钟子进行基因注射和微装配等。

麻省理工学院计算机系统提出了一种新的用于智能交通工具的传感器融合方式,由雷达系统提供目标深度的大致范围,利用双目立体视觉提供粗略的目标深度信息,结合改进的图像分割算法,能够在高速环境下对视频图像中的目标位置进行分割。

华盛顿大学与微软公司合作为火星卫星“探测者”号研制了宽基线立体视觉系统,使“探测者”号能够在火星上对其即将跨越的几千米内的地形进行精确的定位玫导航。

系统使用同一个摄像机在“探测者”的不同位置上拍摄图像对,拍摄间距越大,基线越宽,能观测到越远的地貌。

系统采用非线性优化得到两次拍摄图像时摄像机的相对准确的位置,利用鲁棒性强的最大似然概率法结合高效的立体搜索进行图像匹配,得到亚像素精度的视差,并根据此视差计算图像对中各点的三维坐标。

相比传统的体视系统,能够更精确地绘制“探测者”号周围的地貌和以更高的精度观测到更远的地形。

国内研究动态浙江大学机械系统完全利用透视成像原理,采用双目体视方法实现了对多自由度机械装置的动态、精确位姿检测,仅需从两幅对应图像中抽取必要的特征点的三维坐标,信息量少,处理速度快,尤其适于动态情况。

与手眼系统相比,被测物的运动对摄像机没有影响,且不需知道被测物的运动先验知识和限制条件,有利于提高检测精度。

东南大学电子工程系基于双目立体视觉,提出了一种灰度相关多峰值视差绝对值极小化立体匹配新方法,可对三维不规则物体(偏转线圈)的三维空间坐标进行非接触精密测量。

哈工大采用异构双目活动视觉系统实现了全自主足球机器人导航。

将一个固定摄像机和一个可以水平旋转的摄像机,分别安装在机器人的顶部和中下部,可以同时监视不同方位视点,体现出比人类视觉优越的一面。

通过合理的资源分配及协调机制,使机器人在视野范围、测跟精度及处理速度方面达到最佳匹配。

双目协调技术可使机器人同时捕捉多个有效目标,观测相遇目标时通过数据融合,也可提高测量精度。

在实际比赛中其他传感器失效的情况下,仅仅依靠双目协调仍然可以实现全自主足球机器人导航。

火星863计划课题“人体三维尺寸的非接触测量”,采用“双视点投影光栅三维测量”原理,由双摄像机获取图像对,通过计算机进行图像数据处理,不仅可以获取服装设计所需的特征尺寸,还可根据需要获取人体图像上任意一点的三维坐标。

该系统已通过中国人民解放军总后勤部军需部鉴定。

可达到的技术指标为:数据采集时间小于5s/人;提供身高、胸围、腰围、臀围等围度的测量精度不低于1.0cm。

3.机器视觉的应用原理及场合,机器人视觉属于计算机视觉应用吗?答:机器视觉就是用机器代替人眼来做测量和判断。

机器视觉系统是指通过机器视觉产品(即图像摄取装置,分 CMOS 和CCD 两种)将被摄取目标转换成图像信号,传送给专用的图像处理系统,根据像素分布和亮度、颜色等信息,转变成数字化信号;图像系统对这些信号进行各种运算来抽取目标的特征,进而根据判别的结果来控制现场的设备动作。

应用原理:机器视觉检测系统采用CCD照相机将被检测的目标转换成图像信号,传送给专用的图像处理系统,根据像素分布和亮度、颜色等信息,转变成数字化信号,图像处理系统对这些信号进行各种运算来抽取目标的特征,如面积、数量、位置、长度,再根据预设的允许度和其他条件输出结果,包括尺寸、角度、个数、合格 / 不合格、有 / 无等,实现自动识别功能。

应用场合:1.自动光学检查2.人脸侦测3.无人驾驶汽车机器人视觉属于计算机视觉应用。

4.立体视觉与立体电视有无区别,为什么?答:立体视觉是人眼在观察事物时所具有的立体感。

再进一步讲,人眼对获取的景象有相当的深度感知能力(Depth Perception),而这些感知能力又源自人眼可以提取出景象中的深度要素(Depth Cue)。

立体电视是一种能够模拟实际景物的真实空间关系的电视系统。

又称三维电视(Three-dimensional television,3D-TV)。

立体电视图像不仅能给观众一种深度感觉,而且能给观众一种景物伸展于荧光屏之外似乎伸手可触的感觉。

人眼的立体视觉特性是立体电视的基础。

人类在观看四周世界时,不仅能看到物体的宽度和高度,而且能知道它们的深度,能判定物体之间或观看者与物体之间的距离。

这种三维视觉特性产生的主要原因是:人们通常总是双目同时观看物体,而由于两只眼睛视轴的间距(约65 mm),左眼和右眼在看一定距离的物体时,所接收到的视觉图像是不同的,因而大脑通过眼球的运动、调整,综合了这两幅图像的信息,产生立体感。