C45算法生成决策树的研究

C4.5算法的分析和实现

基于决策树技术的数据挖掘方法分析和研究——C4.5算法的分析和实现摘要大数据时代已经到来,对数据的处理越来越受到人们的关注,人们迫切需要海量数据背后的重要信息和知识,发现数据中存在的关系和规则,获取有用的知识,并且根据现有数据对未来的发展做出预测。

决策树分类算法C4.5算法是数据挖掘中最常用、最经典的分类算法,能够以图形化的形式表现挖掘的结果,从而方便于使用者快速做出决定或预测。

决策树实际在各行业应用非常广泛,如客户资源管理(CRM)系统等。

本报告从决策树的各个方面对决策树进行分析,理解C4.5算法相对于ID3算法的改进,并对C4.5算法加以实现。

同时也指出C4.5算法还存在不足。

一、具体应用场景和意义决策树(Decision Tree)是用于分类和预测的主要技术,它着眼于从一组无规则的样例推理出决策树表示形式的分类规则,采用自顶向下的递归方式,在决策树的内部节点进行属性值的比较,并根据不同属性判断从该节点向下分支,在决策树的叶节点得到结论。

因此,从根节点到叶节点就对应着一条合理规则,整棵树就对应着一组表达式规则。

基于决策树算法的一个最大的优点是它在学习过程中不需要使用者了解很多背景知识,只要训练样例能够用属性-值对的方式表示出来,就能使用该算法进行学习。

决策树算法在很多方面都有应用,如决策树算法在医学、制造和生产、金融分析、天文学、遥感影像分类和分子生物学、机器学习和知识发现等领域得到了广泛应用。

决策树技术是一种对海量数据集进行分类的非常有效的方法。

通过构造决策树模型,提取有价值的分类规则,帮助决策者做出准确的预测已经应用在很多领域。

决策树算法是一种逼近离散函数值的方法。

它是一种典型的分类方法,首先对数据进行处理,利用归纳算法生成可读的规则和决策树,然后对新数据进行分析。

本质上决策树是通过一系列规则对数据进行分类的过程。

决策树的典型算法有ID3、C4.5和CART等,基于决策树的分类模型有如下几个特点:(1)决策树方法结构简单,便于理解;(2)决策树模型效率高,对训练集较大的情况较为适合;(3)决策树方法通常不需要接受训练集数据外的知识;(4)决策树方法具有较高的分类精确度。

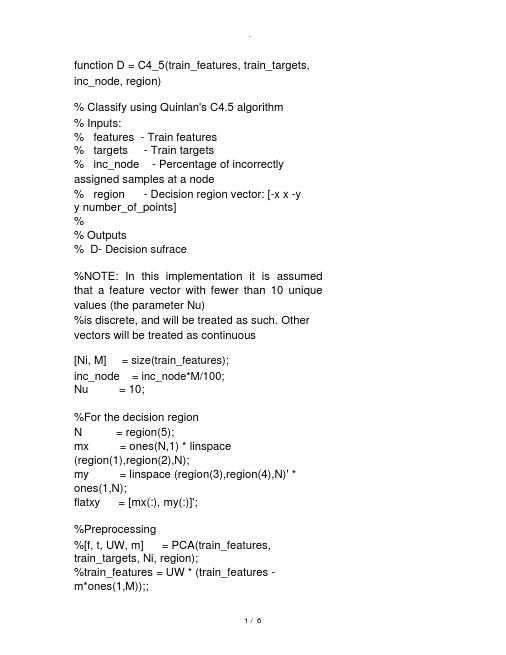

matlab实现的C45分类决策树算法

function D = C4_5(train_features, train_targets, inc_node, region)%Classify using Quinlan's C4.5 algorithm%Inputs:%features - Train features%targets- Train targets%inc_node- Percentage of incorrectly assigned samples at a node%region- Decision region vector: [-x x -yy number_of_points]%% Outputs% D- Decision sufrace%NOTE: In this implementation it is assumed that a feature vector with fewer than 10 unique values (the parameter Nu)%is discrete, and will be treated as such. Other vectors will be treated as continuous[Ni, M]= size(train_features);inc_node= inc_node*M/100;Nu= 10;%For the decision regionN= region(5);mx= ones(N,1) * linspace(region(1),region(2),N);my= linspace (region(3),region(4),N)' * ones(1,N);flatxy= [mx(:), my(:)]';%Preprocessing%[f, t, UW, m]= PCA(train_features,train_targets, Ni, region);%train_features = UW * (train_features -m*ones(1,M));;%flatxy= UW * (flatxy - m*ones(1,N^2));;%Find which of the input features are discrete,and discretisize the corresponding%dimension on the decision regiondiscrete_dim = zeros(1,Ni);for i = 1:Ni,Nb = length(unique(train_features(i,:)));if (Nb <= Nu),%This is a discrete featurediscrete_dim(i)= Nb;[H, flatxy(i,:)] =high_histogram(flatxy(i,:), Nb);endend%Build the tree recursivelydisp( 'Building tree')tree= make_tree(train_features,train_targets, inc_node, discrete_dim,max(discrete_dim), 0);%Make the decision region according to the treedisp( 'Building decision surface using the tree') targets = use_tree(flatxy, 1:N^2, tree,discrete_dim, unique(train_targets));D= reshape(targets,N,N);%ENDfunction targets = use_tree(features, indices,tree, discrete_dim, Uc)%Classify recursively using a treetargets = zeros(1, size(features,2));if (tree.dim == 0)%Reached the end of the treetargets(indices) = tree.child;breakend%This is not the last level of the tree,so: %First, find the dimension we are to work on dim = tree.dim;dims= 1:size(features,1);%And classify according to itif (discrete_dim(dim) == 0),%Continuous featurein= indices(find(features(dim, indices) <= tree.split_loc));targets= targets +use_tree(features(dims, :), in, tree.child(1), discrete_dim(dims), Uc);in= indices(find(features(dim, indices) > tree.split_loc));targets= targets +use_tree(features(dims, :), in, tree.child(2), discrete_dim(dims), Uc);else%Discrete featureUf= unique(features(dim,:));for i = 1:length(Uf),in= indices(find(features(dim, indices) == Uf(i)));targets= targets +use_tree(features(dims, :), in, tree.child(i), discrete_dim(dims), Uc);endend%END use_treefunction tree = make_tree(features, targets, inc_node, discrete_dim, maxNbin, base)%Build a tree recursively[Ni, L]= size(features);Uc= unique(targets);tree.dim= 0;%tree.child(1:maxNbin) = zeros(1,maxNbin);tree.split_loc= inf;if isempty(features),breakend%When to stop: If the dimension is one or the number of examples is smallif ((inc_node> L) | (L == 1) | (length(Uc)== 1)), H= hist(targets, length(Uc));[m, largest]= max(H);tree.child= Uc(largest);breakend%Compute the node's Ifor i = 1:length(Uc),Pnode(i)= length(find(targets== Uc(i)))/L; endInode = -sum(Pnode.*log(Pnode)/log(2));%For each dimension,compute the gain ratio impurity%This is done separately for discrete and continuous featuresdelta_Ib= zeros(1, Ni);split_loc= ones(1, Ni)*inf;for i = 1:Ni,data = features(i,:);Nbins = length(unique(data));if (discrete_dim(i)),%This is a discrete featureP= zeros(length(Uc), Nbins);for j = 1:length(Uc),for k = 1:Nbins,indices = find((targets == Uc(j)) &(features(i,:) == k));P(j,k) = length(indices);endendPk= sum(P);P= P/L;Pk= Pk/sum(Pk);info= sum(-P.*log(eps+P)/log(2));delta_Ib(i) =(Inode-sum(Pk.*info))/-sum(Pk.*log(eps+Pk)/log(2));else%This is a continuous featureP = zeros(length(Uc), 2);%Sort the features[sorted_data, indices] = sort(data);sorted_targets = targets(indices);%Calculate the information for each possiblesplitI = zeros(1, L-1);for j = 1:L-1,for k =1:length(Uc),P(k,1)= length(find(sorted_targets(1:j) ==Uc(k)));P(k,2) =length(find(sorted_targets(j+1:end) == Uc(k)));endPs = sum(P)/L;P= P/L;info= sum(-P.*log(eps+P)/log(2));I(j) = Inode - sum(info.*Ps);end[delta_Ib(i), s] = max(I);split_loc(i) = sorted_data(s);endend%Find the dimension minimizing delta_Ib [m, dim] = max(delta_Ib);dims= 1:Ni;tree.dim = dim;%Split along the 'dim' dimensionNf= unique(features(dim,:));Nbins= length(Nf);if (discrete_dim(dim)),%Discrete featurefor i = 1:Nbins,indices= find(features(dim, :) ==Nf(i));tree.child(i) = make_tree(features(dims, indices), targets(indices), inc_node,discrete_dim(dims), maxNbin, base);endelse%Continuous featuretree.split_loc= split_loc(dim);indices1= find(features(dim,:) <=split_loc(dim));indices2= find(features(dim,:) >split_loc(dim));tree.child(1)= make_tree(features(dims, indices1), targets(indices1), inc_node, discrete_dim(dims), maxNbin);tree.child(2)= make_tree(features(dims, indices2), targets(indices2), inc_node, discrete_dim(dims), maxNbin);end。

C45算法生成决策树的研究

C45算法生成决策树的研究1、基础知识当我们需要对一个随机事件的概率分布进行预测时,我们的预测应当满足全部已知的条件,而对未知的情况不要做任何主观假设。

在这种情况下,概率分布最均匀,预测的风险最小。

由于这时概率分布的信息熵最大,因此称之为“大熵法”最大熵法在数学形式上很漂亮,但是实现起来比较复杂,但把它运用于金融领域的诱惑也比较大,比如说决定股票涨落的因素可能有几十甚至上百种,而最大熵方法恰恰能找到一个同时满足成千上万种不一致条件的模型。

目前,针对分类问题已有了若干不一致领域方法的算法,比如统计学、机器学习、神经网络与粗糙集理论等。

其中从机器学习中引出的决策树方法是一种较为通用并被深入研究的分类方法,由于决策树分类算法是一种直观快速的分类方法,它的分类过程不需要背景知识、同时清晰、易于懂得,因此有很大的有用价值。

目前已经形成了多种决策树算法。

如CLS、ID3、CHAID、CART、FACT、C4.5、Gini、SEE5、SLIQ、SPRINT等。

在决策树分类算法中,最常用的、最经典的是C4.5算法,它继承了ID3算法的优点并对ID3算法进行了改进与补充。

C4.5算法使用信息增益率作为选择分支属性的标准,克服了ID3算法中信息增益选择属性时偏向选择取值多的属性的不足,并能够完成对连续属性离散化的处理,还能够对不完整数据进行处理。

根据分割方法的不一致,目前决策的算法能够分为两类:基于信息论(Information Theory)的方法与最小GINI指标(Lowest GINI index)方法。

对应前者的算法有ID3、C4.5,后者的有CART、SLIQ与SPRINT。

C4.5算法是以信息论为基础,以信息熵与信息增益度为衡量标准,从而实现对数据的归纳分类。

2、算法下列图数据为例,介绍用C4.5建立决策树的算法。

表1ID3算法最初假定属性都是离散值,但在实际应用中,很多属性值都是连续的。

C4.5对ID3不能处理连续型属性的缺点进行了改进。

c4.5决策树算法原理

c4.5决策树算法原理决策树是一种常用的机器学习算法,用于分类和回归问题。

C4.5算法是决策树算法中的一种改进型,相较于其他决策树算法,C4.5在生成决策树的过程中进行了优化,使其具有更高的分类准确率和性能。

**一、决策树算法简介**决策树是一种基于树形结构的分类模型,通过递归地将数据集划分为若干个子集,直到满足某种终止条件(如空子集或达到预设的停止条件)为止。

在每个划分节点处,根据数据特征进行分类或回归,并计算每个分支的代价和信息增益,以确定最优划分方式。

**二、C4.5算法原理**C4.5算法是对传统决策树算法的改进,主要包括以下几点:1. 剪枝策略:C4.5算法引入了剪枝策略,对生成的决策树进行优化,避免过拟合现象的发生。

通过设置停止条件和剪枝比例,可以控制决策树的复杂度,提高模型的泛化能力。

2. 适应度函数优化:C4.5算法在生成决策树的过程中,优化了适应度函数,使其更适用于连续值和离散值的分类问题。

通过对不同类型的数据进行不同的处理方式,可以提高分类准确率。

3. 考虑噪声和离群点:C4.5算法在生成决策树的过程中,会考虑噪声和离群点的存在。

通过对噪声进行平滑处理,对离群点进行特殊处理,可以提高决策树的鲁棒性。

4. 特征选择:C4.5算法在生成决策树的过程中,引入了特征选择机制,通过计算特征重要性得分,选择对分类影响最大的特征,以提高决策树的性能。

**三、应用场景**C4.5算法适用于各种分类和回归问题,尤其适用于数据量大、非线性可分的数据集。

在金融、医疗、保险、生物信息学等领域都有广泛的应用。

**四、总结**C4.5算法通过引入剪枝策略、优化适应度函数、考虑噪声和离群点以及特征选择等机制,对传统决策树算法进行了改进,提高了模型的分类准确率和性能。

在实际应用中,可以根据具体问题选择合适的算法和参数,以达到最佳的分类效果。

C4.5算法的分析和实现

基于决策树技术的数据挖掘方法分析和研究——C4.5算法的分析和实现摘要大数据时代已经到来,对数据的处理越来越受到人们的关注,人们迫切需要海量数据背后的重要信息和知识,发现数据中存在的关系和规则,获取有用的知识,并且根据现有数据对未来的发展做出预测。

决策树分类算法C4.5算法是数据挖掘中最常用、最经典的分类算法,能够以图形化的形式表现挖掘的结果,从而方便于使用者快速做出决定或预测。

决策树实际在各行业应用非常广泛,如客户资源管理(CRM)系统等。

本报告从决策树的各个方面对决策树进行分析,理解C4.5算法相对于ID3算法的改进,并对C4.5算法加以实现。

同时也指出C4.5算法还存在不足。

一、具体应用场景和意义决策树(Decision Tree)是用于分类和预测的主要技术,它着眼于从一组无规则的样例推理出决策树表示形式的分类规则,采用自顶向下的递归方式,在决策树的内部节点进行属性值的比较,并根据不同属性判断从该节点向下分支,在决策树的叶节点得到结论。

因此,从根节点到叶节点就对应着一条合理规则,整棵树就对应着一组表达式规则。

基于决策树算法的一个最大的优点是它在学习过程中不需要使用者了解很多背景知识,只要训练样例能够用属性-值对的方式表示出来,就能使用该算法进行学习。

决策树算法在很多方面都有应用,如决策树算法在医学、制造和生产、金融分析、天文学、遥感影像分类和分子生物学、机器学习和知识发现等领域得到了广泛应用。

决策树技术是一种对海量数据集进行分类的非常有效的方法。

通过构造决策树模型,提取有价值的分类规则,帮助决策者做出准确的预测已经应用在很多领域。

决策树算法是一种逼近离散函数值的方法。

它是一种典型的分类方法,首先对数据进行处理,利用归纳算法生成可读的规则和决策树,然后对新数据进行分析。

本质上决策树是通过一系列规则对数据进行分类的过程。

决策树的典型算法有ID3、C4.5和CART等,基于决策树的分类模型有如下几个特点:(1)决策树方法结构简单,便于理解;(2)决策树模型效率高,对训练集较大的情况较为适合;(3)决策树方法通常不需要接受训练集数据外的知识;(4)决策树方法具有较高的分类精确度。

c4.5决策树原理

c4.5决策树原理C4.5(也称为C5.0)是一种经典的决策树算法,由Ross Quinlan于1993年提出。

它是一种用于机器学习和数据挖掘的强大工具,主要用于分类问题。

以下是C4.5决策树算法的原理概述:1. 信息熵和信息增益:C4.5使用信息熵和信息增益来构建决策树。

信息熵是对数据集的纯度度量,信息增益表示通过某个属性对数据集进行划分所带来的纯度提升。

C4.5的目标是选择信息增益最大的属性作为划分依据。

2. 决策树构建过程:2.1 选择最佳属性:•对每个属性计算信息增益。

•选择信息增益最大的属性作为当前节点的划分属性。

2.2 划分数据集:•使用选定的属性对数据集进行划分,生成子节点。

•对于每个子节点,递归执行上述过程,直到满足停止条件。

2.3 停止条件:•数据集已经纯净(属于同一类别)。

•到达树的最大深度。

•不再有可用属性进行划分。

3. 剪枝:C4.5在决策树构建完成后执行剪枝,以避免过度拟合。

剪枝的目标是去除一些不必要的叶子节点,提高模型的泛化性能。

4. 缺失值处理:C4.5能够处理缺失值,当在某个节点上某个属性的值缺失时,它会考虑所有可能的取值,并按照缺失值所占比例计算信息增益。

5. 数值型属性处理:对于数值型属性,C4.5采用二分法进行处理。

它通过在属性上选择一个阈值,将数据集分为两个子集,然后选择信息增益最大的阈值进行划分。

6. 实例加权:在C4.5中,每个样本都有一个权重,这个权重可以用于调整每个样本在信息增益计算中的贡献度。

7. 优缺点:7.1 优点:•生成的决策树易于理解和解释。

•能够处理混合属性类型。

•能够处理缺失值。

•具有较好的泛化性能。

7.2 缺点:•对噪声敏感。

•生成的树可能过于复杂,需要进行剪枝。

•处理大量数据时可能效率较低。

8. 应用领域:C4.5广泛应用于分类问题,例如医学诊断、金融风险评估、客户分类等领域。

9.C4.5决策树算法通过利用信息熵和信息增益来构建树结构,是一种强大的分类工具。

决策树C4.5算法总结

数据集准备

数据清洗

去除异常值、缺失值,对数据进行预处理,使其满足算法要 求。

数据分割

将数据集分为训练集和测试集,用于训练和评估决策树模型 。

特征选择与划分

特征重要性评估

计算每个特征对目标变量的影响程度,选择最重要的特征作为划分标准。

特征划分

根据特征的重要性和信息增益率,将数据集划分为不同的子集,形成决策树的 节点。

THANKS

感谢观看

案例二:医疗诊断分类

数据集

医疗诊断数据集包含了1452 条样本,每个样本有11个特 征,目标变量为是否患有某

种疾病。

算法应用

使用C4.5算法构建决策树模 型,对数据进行训练和测试 ,评估模型的准确率、召回

率和F1分数等指标。

结果分析

通过决策树模型,可以辅助 医生进行疾病诊断,提高诊 断的准确性和效率。

处理连续属性和缺失值的方法优化

• C4.5算法在处理连续属性和缺失值时采用了一些简单的策略,如将连续属性离散化或忽略缺失值。这些策略可 能导致决策树无法充分利用数据中的信息。因此,一些研究者提出了更复杂的方法来处理连续属性和缺失值, 如使用插值或回归方法来处理连续属性,以及使用特殊标记或填充值来处理缺失值。这些方法可以提高决策树 对连续属性和缺失值的处理能力,从而提高模型的分类准确率。

2

C4.5算法采用了信息增益率、增益率、多变量增 益率等更加复杂的启发式函数,提高了决策树的 构建精度和泛化能力。

3

C4.5算法还引入了剪枝策略,通过去除部分分支 来避免过拟合,提高了决策树的泛化性能。

决策树C4.5算法的应用场景

数据挖掘

C4.5算法广泛应用于数据挖掘 领域,用于分类、回归和聚类

C4.5决策树的生成

CHANGSHA UNIVERSITY OF SCIENCE &TECHNOLOGY题目:C4.5决策树的生成学生姓名:***学号:***********专业:软件工程年级:2014级指导老师:**完成时间:2015年7月10号一、介绍决策树(Decision tree),是以实例为基础的归纳学习算法。

它从一组无次序、无规则的元组中推理出决策树表示形式的分类规则。

它采用自顶向下的递归方式,在决策树的内部结点进行属性值的比较,并根据不同的属性值从该结点向下分支,叶结点是要学习划分的类。

从根到叶结点的一条路径就对应着一条合取规则,整个决策树就对应着一组析取表达式规则。

1986年Quinlan提出了著名的ID3算法。

在ID3算法的基础上,1993年Quinlan又提出了C4.5算法。

二、核心思想采用从信息论知识中我们直到,期望信息越小,信息增益越大,从而纯度越高。

所以ID3算法的核心思想就是以信息增益度量属性选择,选择分裂后信息增益最大的属性进行分裂。

下面先定义几个要用到的概念。

设D为用类别对训练元组进行的划分,则D的熵(entropy)表示为:其中pi表示第i个类别在整个训练元组中出现的概率,可以用属于此类别元素的数量除以训练元组元素总数量作为估计。

熵的实际意义表示是D中元组的类标号所需要的平均信息量。

现在我们假设将训练元组D按属性A进行划分,则A对D划分的期望信息为:而信息增益即为两者的差值:C4.5算法首先定义了“分裂信息”,其定义可以表示成:其中各符号意义与ID3算法相同,然后,增益率被定义为:算法::三、ID3算法和C4.5的比较(1) ID3算法ID3算法的核心是:在决策树各级结点上选择属性时,用信息增益(information gain)作为属性的选择标准,以使得在每一个非叶结点进行测试时,能获得关于被测试记录最大的类别信息。

其具体方法是:检测所有的属性,选择信息增益最大的属性产生决策树结点,由该属性的不同取值建立分支,再对各分支的子集递归调用该方法建立决策树结点的分支,直到所有子集仅包含同一类别的数据为止。

c4.5决策树算法原理 -回复

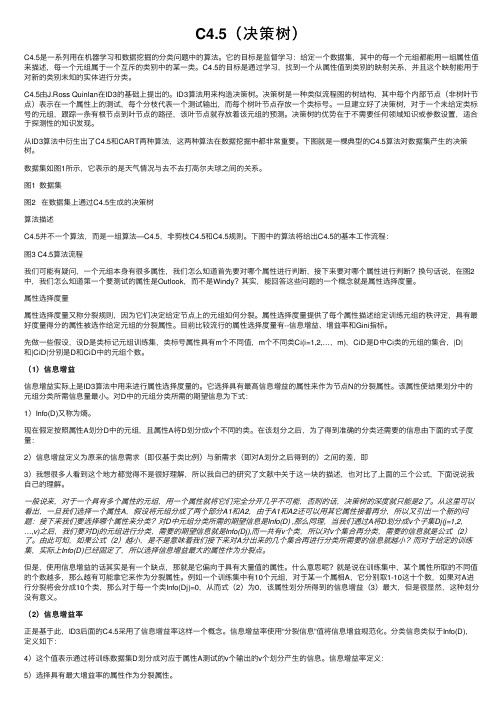

c4.5决策树算法原理-回复C4.5决策树算法原理C4.5决策树算法是一种常用的机器学习算法,可以用于分类和预测任务。

它是ID3算法的改进版本,对于连续属性和缺失数据有更好的处理能力。

本文将从C4.5决策树算法的基本概念、构建过程和剪枝方法等几个方面进行详细介绍。

一、基本概念1. 决策树决策树是一种用于分类和预测的有监督学习模型。

它由根节点、内部节点和叶子节点组成,每个节点表示一个属性或属性集合,用于判断样本的特征,根据属性的取值将样本分到不同的类别或取值。

叶子节点表示最终的分类结果或预测标签。

2. 熵和信息增益熵是信息论中用于度量系统不确定性的指标。

在决策树算法中,我们使用熵来衡量样本集合的纯度。

熵的定义如下:H(D)=-∑p(x)log₂p(x)其中,D是样本集合,p(x)是样本属于类别x的概率。

信息增益表示在已知某一属性的取值的情况下,使得样本集合纯度提高的程度。

信息增益的计算公式为:Gain(A)=H(D)-∑(D_v/D)H(D_v)其中,A是属性,D_v是取值为v的样本子集,D是原始样本集合。

3. 剪枝剪枝是决策树算法中的一个重要步骤,用于防止过拟合。

过拟合是指决策树过于复杂,过度匹配训练数据,导致在未知数据上的泛化性能变差。

剪枝通过删除一些决策树的分支或节点来简化决策树,提高其泛化能力。

二、构建过程1. 特征选择特征选择是C4.5算法中最关键的步骤之一。

在每次选择特征时,我们计算每个属性的信息增益比,选择信息增益比最高的属性作为划分属性。

信息增益比的计算公式为:GainRatio(A)=Gain(A)/SplitInfo(A)其中,SplitInfo(A)为属性A的固有值,用于考虑属性A的分裂度。

属性A的分裂度越大,说明A的取值越多,分支越多。

2. 构建树根据选择的划分属性,将样本集合进行划分,并生成子节点。

如果划分后的子节点中所有样本都属于同一类别,则将该节点标记为叶子节点,并将该类别作为叶子节点的分类结果。

决策树的经典算法ID3与C45

决策树的经典算法ID3与C45决策树是一种常用的机器学习算法,用于分类和回归任务。

决策树算法可以看作是一种基于树结构的分类方法,它将数据集拆分成若干个子集,每个子集对应一个属性测试条件,通过不断递归地划分数据集,最终形成一棵决策树。

经典的决策树算法包括ID3和C5,本文将对这两种算法进行介绍。

ID3(Iterative Dichotomiser 3)是由Ross Quinlan提出的,它是最早的决策树算法之一。

ID3算法采用了信息增益作为属性选择度量,通过计算每个属性的信息增益,选择信息增益最大的属性进行分裂。

我们计算每个属性的信息增益。

信息增益被定义为父节点与子节点之间的信息差异,计算公式为:Gain(S,A)=H(S)-sum(P(a) * H(S_a))其中,H(S)表示节点S的熵,P(a)表示属性A的取值a在节点S中出现的概率,H(S_a)表示子节点S_a的熵。

选择信息增益最大的属性作为当前节点的分裂属性。

根据当前节点的分裂属性将数据集划分成若干个子集,对每个子集递归地执行步骤1和步骤2,直到满足停止条件(例如子集中所有样本都属于同一类别,或每个属性都已使用过)。

C5算法是ID3算法的改进版,它使用了增益率作为属性选择度量,以解决ID3算法中偏好于选择取值较多的属性的问题。

增益率定义为信息增益与分裂信息的比值,分裂信息被定义为:split_info(S,A)=-sum(P(a) * log2(P(a)))其中,P(a)表示属性A 的取值a在节点S中出现的概率。

C5算法的步骤与ID3算法类似,但在选择分裂属性时优先考虑增益率较高的属性。

C5算法还引入了剪枝技术,通过设置一个置信度阈值来避免过拟合,从而生成更加健壮的决策树。

ID3算法和C5算法都是经典的决策树算法,它们在处理分类问题时具有较高的准确率和可解释性。

然而,这两种算法也存在一些局限性,例如对于连续属性和处理缺失值的处理能力有限。

后续的许多研究者对决策树算法进行了改进和优化,如CART、CHD、BOOSTING等,这些算法在处理复杂问题、提高分类准确率和处理连续属性方面做出了更多的探索和实践。

C4.5(决策树)

C4.5(决策树)C4.5是⼀系列⽤在机器学习和数据挖掘的分类问题中的算法。

它的⽬标是监督学习:给定⼀个数据集,其中的每⼀个元组都能⽤⼀组属性值来描述,每⼀个元组属于⼀个互斥的类别中的某⼀类。

C4.5的⽬标是通过学习,找到⼀个从属性值到类别的映射关系,并且这个映射能⽤于对新的类别未知的实体进⾏分类。

C4.5由J.Ross Quinlan在ID3的基础上提出的。

ID3算法⽤来构造决策树。

决策树是⼀种类似流程图的树结构,其中每个内部节点(⾮树叶节点)表⽰在⼀个属性上的测试,每个分枝代表⼀个测试输出,⽽每个树叶节点存放⼀个类标号。

⼀旦建⽴好了决策树,对于⼀个未给定类标号的元组,跟踪⼀条有根节点到叶节点的路径,该叶节点就存放着该元组的预测。

决策树的优势在于不需要任何领域知识或参数设置,适合于探测性的知识发现。

从ID3算法中衍⽣出了C4.5和CART两种算法,这两种算法在数据挖掘中都⾮常重要。

下图就是⼀棵典型的C4.5算法对数据集产⽣的决策树。

数据集如图1所⽰,它表⽰的是天⽓情况与去不去打⾼尔夫球之间的关系。

图1 数据集图2 在数据集上通过C4.5⽣成的决策树算法描述C4.5并不⼀个算法,⽽是⼀组算法—C4.5,⾮剪枝C4.5和C4.5规则。

下图中的算法将给出C4.5的基本⼯作流程:图3 C4.5算法流程我们可能有疑问,⼀个元组本⾝有很多属性,我们怎么知道⾸先要对哪个属性进⾏判断,接下来要对哪个属性进⾏判断?换句话说,在图2中,我们怎么知道第⼀个要测试的属性是Outlook,⽽不是Windy?其实,能回答这些问题的⼀个概念就是属性选择度量。

属性选择度量属性选择度量⼜称分裂规则,因为它们决定给定节点上的元组如何分裂。

属性选择度量提供了每个属性描述给定训练元组的秩评定,具有最好度量得分的属性被选作给定元组的分裂属性。

⽬前⽐较流⾏的属性选择度量有--信息增益、增益率和Gini指标。

先做⼀些假设,设D是类标记元组训练集,类标号属性具有m个不同值,m个不同类Ci(i=1,2,…,m),CiD是D中Ci类的元组的集合,|D|和|CiD|分别是D和CiD中的元组个数。

python决策树之C4.5算法详解

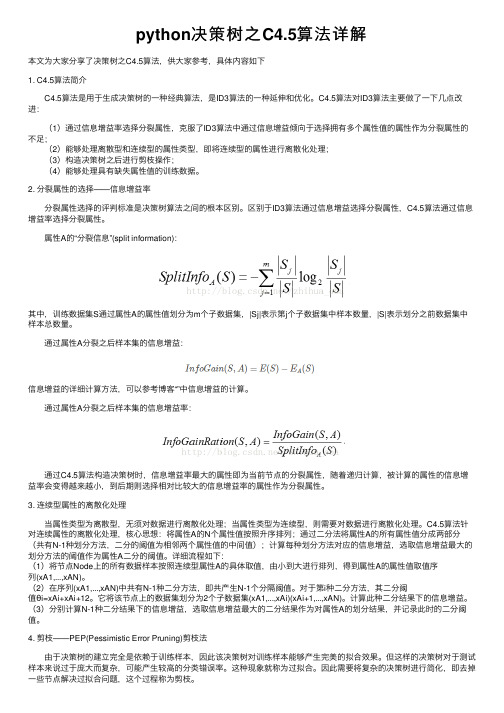

python决策树之C4.5算法详解本⽂为⼤家分享了决策树之C4.5算法,供⼤家参考,具体内容如下1. C4.5算法简介 C4.5算法是⽤于⽣成决策树的⼀种经典算法,是ID3算法的⼀种延伸和优化。

C4.5算法对ID3算法主要做了⼀下⼏点改进: (1)通过信息增益率选择分裂属性,克服了ID3算法中通过信息增益倾向于选择拥有多个属性值的属性作为分裂属性的不⾜; (2)能够处理离散型和连续型的属性类型,即将连续型的属性进⾏离散化处理; (3)构造决策树之后进⾏剪枝操作; (4)能够处理具有缺失属性值的训练数据。

2. 分裂属性的选择——信息增益率 分裂属性选择的评判标准是决策树算法之间的根本区别。

区别于ID3算法通过信息增益选择分裂属性,C4.5算法通过信息增益率选择分裂属性。

属性A的“分裂信息”(split information):其中,训练数据集S通过属性A的属性值划分为m个⼦数据集,|Sj|表⽰第j个⼦数据集中样本数量,|S|表⽰划分之前数据集中样本总数量。

通过属性A分裂之后样本集的信息增益:信息增益的详细计算⽅法,可以参考博客“”中信息增益的计算。

通过属性A分裂之后样本集的信息增益率: 通过C4.5算法构造决策树时,信息增益率最⼤的属性即为当前节点的分裂属性,随着递归计算,被计算的属性的信息增益率会变得越来越⼩,到后期则选择相对⽐较⼤的信息增益率的属性作为分裂属性。

3. 连续型属性的离散化处理 当属性类型为离散型,⽆须对数据进⾏离散化处理;当属性类型为连续型,则需要对数据进⾏离散化处理。

C4.5算法针对连续属性的离散化处理,核⼼思想:将属性A的N个属性值按照升序排列;通过⼆分法将属性A的所有属性值分成两部分(共有N-1种划分⽅法,⼆分的阈值为相邻两个属性值的中间值);计算每种划分⽅法对应的信息增益,选取信息增益最⼤的划分⽅法的阈值作为属性A⼆分的阈值。

详细流程如下:(1)将节点Node上的所有数据样本按照连续型属性A的具体取值,由⼩到⼤进⾏排列,得到属性A的属性值取值序列(xA1,...,xAN)。

应用C4_5算法构造客户分类决策树的方法

其中,

p ij =

S ij S

j

是

S

j

中的样本属于客户等级第i 等级的概率。

最后,计算该属性的熵,计算公式为

3

E(X ) =

—90—

∑

j =1

S1j + L + S S

4 j

I (S 1 j ,L , S

4 j

)

(3) 计算该属性的信息增益。公式为

Gain ( X ) = I ( S 1 , S 2 , S 3 , S 4 ) − E ( X )

2.2 数据预处理 将前面得到的数据对客户进行聚类分析,获取客户分类 的性质,将结果用柱状图表示,即用柱状图表不同的比例 均值,如图4所示。

购 买 金

访问 contract 的比例

I ( s1 , s 2 , s 3 , s 4 ) = - ∑ p i log 2 ( p i )

i =1

4

其中,S1,S2,S3,S4分别为训练集中属于客户等级 4个等级中的 样本数,S为训练集样本总数,pi是任意样本属于客户等级 第i等级的概率,用

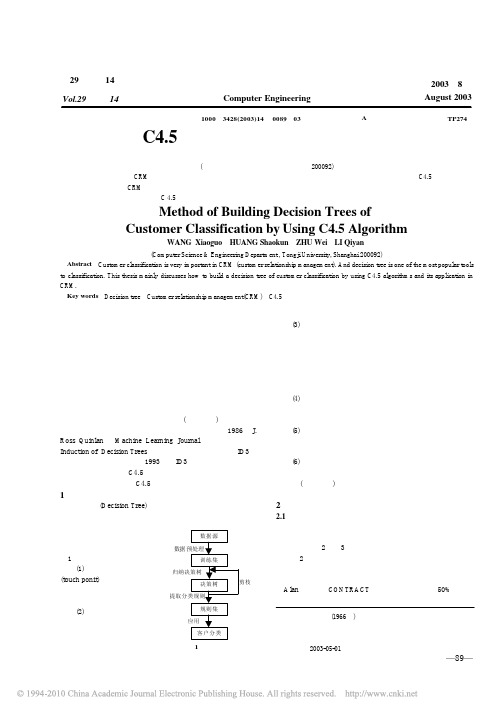

1 决策树生成的基本过程及相关算法

决策树 (Decision Tree) 是一个类似于流程图的数结构, 其中每个内部结点表示在一个属性上的测试,每个分支代表 一个测试输出,而每个树叶节 数据源 点代表类或类分布。 决策树生成的操作过程如 数据预处理 图1所示。 训练集 (1) 系统从内部网各接触点 归纳决策树 (touch ponit)收集客户信息,对 剪枝 决策树 数据信息进行合并,形成结构 提取分类规则 统一的客户信息数据源。 规则集 (2) 对数据源进行数据预处 应用 理,去掉与决策无关的属性和 客户分类 高分支属性、将数值型属性进 行概化以及处理含空缺值的属 图1 操作流程图

决策树C45算法

决策树算法

C4.5算法

2016.04.07

C4.5算法

• 1993年由Quilan提出的C4.5算法(对ID3的改进)

• C4.5比ID3的改进: • 1) 用信息增益率来选择属性,克服了用信息增益选择属性时偏向选择取值多的

属性的不足; 2) 在树构造过程中进行剪枝; 3) 能够完成对连续属性的离散化处理; 4) 能够对不完整数据进行处理。

C

Entropy(S) pi log2 ( pi ) i 1

其中,S表示样本集,

C表示样本集合中类别个数(只含有正负样本,则C=2),

p i

表示第i个类的概率,

(p 可由类别i中含有样本的个数除以总样本数得到) i

• 一个系统越是有序,信息熵就越低;反之,一个系统越乱,信息熵就越高。所以,

信息熵也可以说是系统有序化程度的一个衡量。

C4.5算法

• 与ID3不同,C4.5采用基于信息增益率(information Gain Ratio)的方法选择测试

属性,信息增益率等于信息,F)/SplitInformation(S,F)

• 设样本集S按离散属性F的V个不同的取值划分为,共V个子集

• 定义分割信息量Split(S, F):

•

Split (S ,

那么信息增益率为:

F

)

vV

| Sv |S

| |

* log 2

(| Sv |S

|) |

GainRatio(S, F) Gain(S, F) Split(S, F)

C4.5算法

连续型属性

• 离散化处理:将连续型的属性变量进行离散化处理,形成决策树的训练集

缺点:对于不回溯的贪婪算法,缺乏后效性考虑,可能导致树提前停止。

数据挖掘算法——C4.5决策树算法

数据挖掘算法——C4.5决策树算法参考博客:决策树是⼀种逼近离散值⽬标函数的⽅法,学习到的函数被表⽰为⼀棵决策树根节点包含全部训练样本⾃顶向下分⽽治之的策略决策树算法以树状结构来表⽰数据的分类结果,每⼀个决策点实现⼀个具有离散输出的测试函数,记为分⽀根节点⾮叶⼦节点(代表测试的条件,对数据属性的测试决策点)叶⼦节点(代表分类后所获得的分类标记)分⽀(代表测试的结果)决策树-熵P(X,Y) = P(X) * P(Y) X和Y两个事件相互独⽴ Log(XY) = Log(X) + Log(Y)H(X),H(Y)当成它们发⽣的不确定性P(⼏率越⼤)->H(X)值越⼩如:今天正常上课P(⼏率越⼩)->H(X)值越⼤如:今天没翻车我们统计了14天的⽓象数据(指标包括outlook,temperature,humidity,windy),并已知这些天⽓是否打球(play)。

如果给出新⼀天的⽓象指标数据:sunny,cool,high,TRUE,判断⼀下会不会去打球。

table 1outlook temperature humidity windy playsunny hot high FALSE nosunny hot high TRUE noovercast hot high FALSE yesrainy mild high FALSE yesrainy cool normal FALSE yesrainy cool normal TRUE noovercast cool normal TRUE yessunny mild high FALSE nosunny cool normal FALSE yesrainy mild normal FALSE yessunny mild normal TRUE yesovercast mild high TRUE yesovercast hot normal FALSE yesnorainy mild high TRUE这个问题当然可以⽤求解,分别计算在给定天⽓条件下打球和不打球的概率,选概率⼤者作为推测结果。

一种改进的C4.5决策树算法

一 种改进的 04.5决策树算法

文/王志春 刘丽娜

C4 该

是 足 改

C4

提

奎

【关键词 】数据挖掘 决策树 c4.5算法 信 息 增 益率

1 引 言

数据 挖掘 中决 策树 是解 决分 类 问题 的方 法之一 ,是一种归纳 学习算法。通过一组属性 值向量和相应 的类 ,采用 归纳学习算法构造分 类器和预测模型 ,能够从 一组无序和无规则的 数据中生成决策树形 式的分类规则 。决策树基

2.2 C4.5算法 实现

熵值运算 ,增加 了计 算机 的运算时间,降低 了

每一次属性选择时 算法 的运算效率,所 以为了 解决这个 问题 ,引入 泰勒 中值定理和麦克劳林 展开式 ,对熵值 中的对数运 算进 行变换,优化

熵值运算 ,缩短其运算时间 。

log2( )= 2(m一1)一(用一1)。

5 结 论

在 已有 RFID天线特性研究基础上 ,分析 了 RFID标 签信号强度 的等 值线表达形式 ,提 出通 过旋转 天线来进行 RFID标签 定位 的方法 , 给 出了连续旋转天线定位法 ,建立 了使用步进 电机驱动 的旋转天线定位系统 ,试验表 明该方 法具有 良好 的定位精度 ,可 以用于物体 的精确 定 位 。

3.2 实验 及 结 果 分 析

使 用 Weka作 为 数 据挖 掘 平 台,对 改 进 C4.5算法与传 统 C4.5算 法的分类 性能进 行 比

参考文献

[1】Qui a1 an J R.hdueti on ofdeci sion tree s[M】.Machine Learning,1986,(1):

python决策树c4.5例题经典案例

一、概述Python是一种高效的编程语言,广泛应用于数据分析和机器学习领域。

决策树是一种常用的机器学习算法,C4.5是其中一种经典的决策树算法。

本文将以Python为工具,以C4.5算法为基础,通过经典案例的解析,深入探讨C4.5决策树算法的原理和实践应用。

二、C4.5算法介绍1. C4.5算法是基于信息熵的一种决策树算法,其主要目的是通过对训练数据的分析,构建出一颗能够高效分类的决策树。

2. C4.5算法的关键步骤包括:计算信息增益、选择最优特征、递归构建决策树、处理缺失值等。

3. C4.5算法对连续型特征的处理采用二分策略,对离散型特征的处理采用多分策略,能够有效地处理不同类型的数据。

三、经典案例分析1. 数据准备我们以一个经典的鸢尾花数据集为例,数据集包括花萼长度、花萼宽度、花瓣长度、花瓣宽度等特征,以及鸢尾花的种类标签。

2. 数据预处理我们首先需要对数据进行预处理,包括数据清洗、特征选择、数据划分等步骤,以确保数据的质量和准确性。

3. 模型训练接下来,我们使用Python中的决策树库来训练C4.5决策树模型,通过对训练数据的拟合,构建出一颗能够有效分类的决策树。

4. 模型评估我们使用测试数据来评估模型的性能,包括准确率、召回率等指标,以验证模型的有效性和泛化能力。

四、Python实践1. 数据分析我们可以使用Pandas库对数据集进行加载和分析,通过统计分析和可视化等手段,对数据的特征和分布进行深入了解。

2. 模型构建在Python中,我们可以使用scikit-learn等机器学习库来构建C4.5决策树模型,通过设置参数、训练模型等步骤,得到一颗高效的决策树模型。

3. 模型调优在实践中,我们可以通过交叉验证、网格搜索等技术,对模型进行进一步优化,以获得更好的分类效果。

4. 模型应用我们可以将训练好的决策树模型应用到新的数据中,进行预测和分类,以解决实际的分类问题。

五、总结与展望C4.5决策树算法作为经典的机器学习算法,在实际应用中具有广泛的价值和意义。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

精心整理

C4.5算法生成决策树

1、基础知识

当我们需要对一个随机事件的概率分布进行预测时,我们的预测应当满足全部已知的条件,而对未知的情况不要做任何主观假设。

在这种情况下,概率分布最均SEE5、SLIQ 算法的的标准,克服了ID3算法中信息增益选择属性时偏向选择取值多的属性的不足,并能够完成对连续属性离散化的处理,还能够对不完整数据进行处理。

根据分割方法的不同,目前决策的算法可以分为两类:基于信息论(InformationTheory )的方法和最小GINI 指标(LowestGINIindex )方法。

对应前者的算法有ID3、C4.5,后者的有CART 、SLIQ 和SPRINT 。

C4.5算法是以信息论为基础,以信息熵和信息增益度为衡量标准,从而实现对数据的归纳分类。

2、算法

以下图数据为例,介绍用C4.5建立决策树的算法。

表1

ID3算法最初假定属性都是离散值,但在实际应用中,很多属性值都是连续的。

C4.5对ID3不能处理连续型属性的缺点进行了改进。

如果存在连续型的描述性属性,首先将连续型属性的值分成不同的区间,即“离散化”。

对上表中将实际耗电量分为10个区间(0—9)

(300~320,320~340,340~360,360~380,380~400,400~420,420~440,440~460,460~480,480~500)因为最终是要得到实际的耗电量区间,因此“实际耗电量”属于“类别属性”。

“室外温度”、“室内温度”、“室外湿度”、“风力大小”、“机房楼层”、“机房朝向”、“机房开启设备总额定功率”属于“非类别属性”。

表2

通过表

知,实

际耗电的个数表3

定义1,一个4个比定义2),n p ,则由该分布传递的信息量称为的熵。

即

定义3,k 则识别T )k C 的例如:表3中,得到实际耗电量区间的信息量为(以下单位为比特,下同):

()2222222/10log (2/10)1/10log (1/10)3/10log (3/10)()1/10log (1/10)2/10log (2/10)1/10log (1/10)Info T I P ⨯+⨯+⨯+⎛⎫==- ⎪⨯+⨯+⨯⎝⎭

=2.446

定义4:若我们先根据非类别属性X 的值将T 分成集合12,,n T T T ,则确定T 中一个元素类的信息量可通过确定i T 的加权平均值来得到,即Info(i T )的加权平均值为: 例如:属性“室内温度”的值有“17、18、19”,分类见下表:

表4

P (17P (18P (19(17)

Info ()()22222(18)181/6*log (1/6)1/6*log (1/6)Info I P ⎛⎫

==- ⎪+⎝⎭

=2.252

()()()22(19)191/2*log (1/2)1/2*log (1/2)Info I P ==-+=1.000

2/10(17)6/10(18)2/10(19)(,)Info Info In Inf fo o T =⨯+⨯+⨯室内温度=1.751

定义5:将增益Gain (X ,T )定义为:。

所谓增益,就是指在应用了某一测试之后,

其对应的可能性丰富程度下降,不确定性减小,这个减小的幅度就是增益,其实质上对应着分类带来的好处)。

上式的增益值为:()()()

=-室内温度=2.446-1.751=0.695

Gain X T Info T Info T

,,

以上是ID3计算信息增益的方法,C4.5算法对此进行了改进。

C4.5算法采用信息增益率作为选择分支属性的标准,克服了ID3算法中信息增益选择属性时偏向选

Tn,

,T)为0

,则

3

个候选的分割阈值点的值为上述排序后的属性值链表中两两前后连续元素的中点,那么我们的任务就是从这个N-1个候选分割阈值点中选出一个,使得前面提到的信息论标准最大。

在EXCEL中,对室外温度(第二步)详细介绍了如何分割阈值点并进行计算。

4、树的终止

树的建立实际上是一个递归过程,那么这个递归什么时候到达终止条件退出递归呢?有两种方式,第一种方式是如果某一节点的分支所覆盖的样本都属于同一类的时候,那么递归就可以终止,该分支就会产生一个叶子节点。

还有一种方式就是,如果某一分支覆盖的样本的个数如果小于一个阈值,那么也可产生叶子节点,从而终止建立树。

我们只考虑二叉分割的情况,因为这样生成的树的准确度更高。

5、树的修剪

树一旦生成后,便进入第二阶段——修剪阶段。

决策树为什么要剪枝?原因就是避免决策树“过拟合”样

本。

100%

(

很小时,将所有

对于树的修剪,相对树的生成要简单一些,后续再做讨论。