模式识别(9)人工神经网络

《人工神经网络》课件

动量法:在梯度下降法的基础上,引入动量项,加速收敛速 度

添加项标题

RMSProp:在AdaGrad的基础上,引入指数加权移动平 均,提高了算法的稳定性和收敛速度

添加项标题

随机梯度下降法:在梯度下降法的基础上,每次只使用一个 样本进行更新,提高了训练速度

添加项标题

AdaGrad:自适应学习率算法,根据历史梯度的平方和来 调整学习率,解决了学习率衰减的问题

情感分析:分析文本中的情感 倾向,如正面评价、负面评价 等

推荐系统

推荐系统是一种基于用户历史行为 和偏好的个性化推荐服务

推荐算法:协同过滤、深度学习、 矩阵分解等

添加标题

添加标题

添加标题

添加标题

应用场景:电商、社交媒体、视频 网站等

应用效果:提高用户满意度、增加 用户粘性、提高转化率等

Part Six

类型:Sigmoid、 Tanh、ReLU等

特点:非线性、可 微分

应用:深度学习、 机器学习等领域

权重调整

权重调整的目的:优化神经网络的性能 权重调整的方法:梯度下降法、随机梯度下降法等 权重调整的步骤:计算损失函数、计算梯度、更新权重 权重调整的影响因素:学习率、批次大小、优化器等

Part Four

《人工神经网络》PPT 课件

,

汇报人:

目录

01 添 加 目 录 项 标 题 03 神 经 网 络 基 础 知 识 05 神 经 网 络 应 用 案 例 07 未 来 发 展 趋 势 与 挑 战

02 人 工 神 经 网 络 概 述 04 人 工 神 经 网 络 算 法 06 神 经 网 络 优 化 与 改 进

深度学习算法

卷积神经网络(CNN):用于图像处理和识别 循环神经网络(RNN):用于处理序列数据,如语音识别和自然语言处理 长短期记忆网络(LSTM):改进的RNN,用于处理长序列数据 生成对抗网络(GAN):用于生成新数据,如图像生成和文本生成

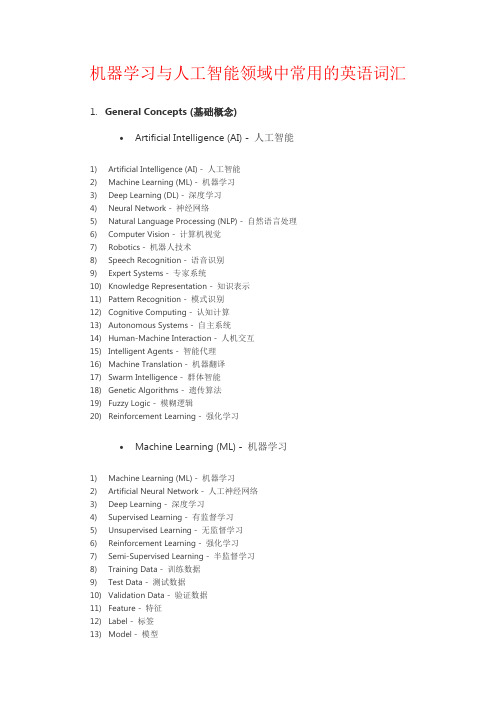

机器学习与人工智能领域中常用的英语词汇

机器学习与人工智能领域中常用的英语词汇1.General Concepts (基础概念)•Artificial Intelligence (AI) - 人工智能1)Artificial Intelligence (AI) - 人工智能2)Machine Learning (ML) - 机器学习3)Deep Learning (DL) - 深度学习4)Neural Network - 神经网络5)Natural Language Processing (NLP) - 自然语言处理6)Computer Vision - 计算机视觉7)Robotics - 机器人技术8)Speech Recognition - 语音识别9)Expert Systems - 专家系统10)Knowledge Representation - 知识表示11)Pattern Recognition - 模式识别12)Cognitive Computing - 认知计算13)Autonomous Systems - 自主系统14)Human-Machine Interaction - 人机交互15)Intelligent Agents - 智能代理16)Machine Translation - 机器翻译17)Swarm Intelligence - 群体智能18)Genetic Algorithms - 遗传算法19)Fuzzy Logic - 模糊逻辑20)Reinforcement Learning - 强化学习•Machine Learning (ML) - 机器学习1)Machine Learning (ML) - 机器学习2)Artificial Neural Network - 人工神经网络3)Deep Learning - 深度学习4)Supervised Learning - 有监督学习5)Unsupervised Learning - 无监督学习6)Reinforcement Learning - 强化学习7)Semi-Supervised Learning - 半监督学习8)Training Data - 训练数据9)Test Data - 测试数据10)Validation Data - 验证数据11)Feature - 特征12)Label - 标签13)Model - 模型14)Algorithm - 算法15)Regression - 回归16)Classification - 分类17)Clustering - 聚类18)Dimensionality Reduction - 降维19)Overfitting - 过拟合20)Underfitting - 欠拟合•Deep Learning (DL) - 深度学习1)Deep Learning - 深度学习2)Neural Network - 神经网络3)Artificial Neural Network (ANN) - 人工神经网络4)Convolutional Neural Network (CNN) - 卷积神经网络5)Recurrent Neural Network (RNN) - 循环神经网络6)Long Short-Term Memory (LSTM) - 长短期记忆网络7)Gated Recurrent Unit (GRU) - 门控循环单元8)Autoencoder - 自编码器9)Generative Adversarial Network (GAN) - 生成对抗网络10)Transfer Learning - 迁移学习11)Pre-trained Model - 预训练模型12)Fine-tuning - 微调13)Feature Extraction - 特征提取14)Activation Function - 激活函数15)Loss Function - 损失函数16)Gradient Descent - 梯度下降17)Backpropagation - 反向传播18)Epoch - 训练周期19)Batch Size - 批量大小20)Dropout - 丢弃法•Neural Network - 神经网络1)Neural Network - 神经网络2)Artificial Neural Network (ANN) - 人工神经网络3)Deep Neural Network (DNN) - 深度神经网络4)Convolutional Neural Network (CNN) - 卷积神经网络5)Recurrent Neural Network (RNN) - 循环神经网络6)Long Short-Term Memory (LSTM) - 长短期记忆网络7)Gated Recurrent Unit (GRU) - 门控循环单元8)Feedforward Neural Network - 前馈神经网络9)Multi-layer Perceptron (MLP) - 多层感知器10)Radial Basis Function Network (RBFN) - 径向基函数网络11)Hopfield Network - 霍普菲尔德网络12)Boltzmann Machine - 玻尔兹曼机13)Autoencoder - 自编码器14)Spiking Neural Network (SNN) - 脉冲神经网络15)Self-organizing Map (SOM) - 自组织映射16)Restricted Boltzmann Machine (RBM) - 受限玻尔兹曼机17)Hebbian Learning - 海比安学习18)Competitive Learning - 竞争学习19)Neuroevolutionary - 神经进化20)Neuron - 神经元•Algorithm - 算法1)Algorithm - 算法2)Supervised Learning Algorithm - 有监督学习算法3)Unsupervised Learning Algorithm - 无监督学习算法4)Reinforcement Learning Algorithm - 强化学习算法5)Classification Algorithm - 分类算法6)Regression Algorithm - 回归算法7)Clustering Algorithm - 聚类算法8)Dimensionality Reduction Algorithm - 降维算法9)Decision Tree Algorithm - 决策树算法10)Random Forest Algorithm - 随机森林算法11)Support Vector Machine (SVM) Algorithm - 支持向量机算法12)K-Nearest Neighbors (KNN) Algorithm - K近邻算法13)Naive Bayes Algorithm - 朴素贝叶斯算法14)Gradient Descent Algorithm - 梯度下降算法15)Genetic Algorithm - 遗传算法16)Neural Network Algorithm - 神经网络算法17)Deep Learning Algorithm - 深度学习算法18)Ensemble Learning Algorithm - 集成学习算法19)Reinforcement Learning Algorithm - 强化学习算法20)Metaheuristic Algorithm - 元启发式算法•Model - 模型1)Model - 模型2)Machine Learning Model - 机器学习模型3)Artificial Intelligence Model - 人工智能模型4)Predictive Model - 预测模型5)Classification Model - 分类模型6)Regression Model - 回归模型7)Generative Model - 生成模型8)Discriminative Model - 判别模型9)Probabilistic Model - 概率模型10)Statistical Model - 统计模型11)Neural Network Model - 神经网络模型12)Deep Learning Model - 深度学习模型13)Ensemble Model - 集成模型14)Reinforcement Learning Model - 强化学习模型15)Support Vector Machine (SVM) Model - 支持向量机模型16)Decision Tree Model - 决策树模型17)Random Forest Model - 随机森林模型18)Naive Bayes Model - 朴素贝叶斯模型19)Autoencoder Model - 自编码器模型20)Convolutional Neural Network (CNN) Model - 卷积神经网络模型•Dataset - 数据集1)Dataset - 数据集2)Training Dataset - 训练数据集3)Test Dataset - 测试数据集4)Validation Dataset - 验证数据集5)Balanced Dataset - 平衡数据集6)Imbalanced Dataset - 不平衡数据集7)Synthetic Dataset - 合成数据集8)Benchmark Dataset - 基准数据集9)Open Dataset - 开放数据集10)Labeled Dataset - 标记数据集11)Unlabeled Dataset - 未标记数据集12)Semi-Supervised Dataset - 半监督数据集13)Multiclass Dataset - 多分类数据集14)Feature Set - 特征集15)Data Augmentation - 数据增强16)Data Preprocessing - 数据预处理17)Missing Data - 缺失数据18)Outlier Detection - 异常值检测19)Data Imputation - 数据插补20)Metadata - 元数据•Training - 训练1)Training - 训练2)Training Data - 训练数据3)Training Phase - 训练阶段4)Training Set - 训练集5)Training Examples - 训练样本6)Training Instance - 训练实例7)Training Algorithm - 训练算法8)Training Model - 训练模型9)Training Process - 训练过程10)Training Loss - 训练损失11)Training Epoch - 训练周期12)Training Batch - 训练批次13)Online Training - 在线训练14)Offline Training - 离线训练15)Continuous Training - 连续训练16)Transfer Learning - 迁移学习17)Fine-Tuning - 微调18)Curriculum Learning - 课程学习19)Self-Supervised Learning - 自监督学习20)Active Learning - 主动学习•Testing - 测试1)Testing - 测试2)Test Data - 测试数据3)Test Set - 测试集4)Test Examples - 测试样本5)Test Instance - 测试实例6)Test Phase - 测试阶段7)Test Accuracy - 测试准确率8)Test Loss - 测试损失9)Test Error - 测试错误10)Test Metrics - 测试指标11)Test Suite - 测试套件12)Test Case - 测试用例13)Test Coverage - 测试覆盖率14)Cross-Validation - 交叉验证15)Holdout Validation - 留出验证16)K-Fold Cross-Validation - K折交叉验证17)Stratified Cross-Validation - 分层交叉验证18)Test Driven Development (TDD) - 测试驱动开发19)A/B Testing - A/B 测试20)Model Evaluation - 模型评估•Validation - 验证1)Validation - 验证2)Validation Data - 验证数据3)Validation Set - 验证集4)Validation Examples - 验证样本5)Validation Instance - 验证实例6)Validation Phase - 验证阶段7)Validation Accuracy - 验证准确率8)Validation Loss - 验证损失9)Validation Error - 验证错误10)Validation Metrics - 验证指标11)Cross-Validation - 交叉验证12)Holdout Validation - 留出验证13)K-Fold Cross-Validation - K折交叉验证14)Stratified Cross-Validation - 分层交叉验证15)Leave-One-Out Cross-Validation - 留一法交叉验证16)Validation Curve - 验证曲线17)Hyperparameter Validation - 超参数验证18)Model Validation - 模型验证19)Early Stopping - 提前停止20)Validation Strategy - 验证策略•Supervised Learning - 有监督学习1)Supervised Learning - 有监督学习2)Label - 标签3)Feature - 特征4)Target - 目标5)Training Labels - 训练标签6)Training Features - 训练特征7)Training Targets - 训练目标8)Training Examples - 训练样本9)Training Instance - 训练实例10)Regression - 回归11)Classification - 分类12)Predictor - 预测器13)Regression Model - 回归模型14)Classifier - 分类器15)Decision Tree - 决策树16)Support Vector Machine (SVM) - 支持向量机17)Neural Network - 神经网络18)Feature Engineering - 特征工程19)Model Evaluation - 模型评估20)Overfitting - 过拟合21)Underfitting - 欠拟合22)Bias-Variance Tradeoff - 偏差-方差权衡•Unsupervised Learning - 无监督学习1)Unsupervised Learning - 无监督学习2)Clustering - 聚类3)Dimensionality Reduction - 降维4)Anomaly Detection - 异常检测5)Association Rule Learning - 关联规则学习6)Feature Extraction - 特征提取7)Feature Selection - 特征选择8)K-Means - K均值9)Hierarchical Clustering - 层次聚类10)Density-Based Clustering - 基于密度的聚类11)Principal Component Analysis (PCA) - 主成分分析12)Independent Component Analysis (ICA) - 独立成分分析13)T-distributed Stochastic Neighbor Embedding (t-SNE) - t分布随机邻居嵌入14)Gaussian Mixture Model (GMM) - 高斯混合模型15)Self-Organizing Maps (SOM) - 自组织映射16)Autoencoder - 自动编码器17)Latent Variable - 潜变量18)Data Preprocessing - 数据预处理19)Outlier Detection - 异常值检测20)Clustering Algorithm - 聚类算法•Reinforcement Learning - 强化学习1)Reinforcement Learning - 强化学习2)Agent - 代理3)Environment - 环境4)State - 状态5)Action - 动作6)Reward - 奖励7)Policy - 策略8)Value Function - 值函数9)Q-Learning - Q学习10)Deep Q-Network (DQN) - 深度Q网络11)Policy Gradient - 策略梯度12)Actor-Critic - 演员-评论家13)Exploration - 探索14)Exploitation - 开发15)Temporal Difference (TD) - 时间差分16)Markov Decision Process (MDP) - 马尔可夫决策过程17)State-Action-Reward-State-Action (SARSA) - 状态-动作-奖励-状态-动作18)Policy Iteration - 策略迭代19)Value Iteration - 值迭代20)Monte Carlo Methods - 蒙特卡洛方法•Semi-Supervised Learning - 半监督学习1)Semi-Supervised Learning - 半监督学习2)Labeled Data - 有标签数据3)Unlabeled Data - 无标签数据4)Label Propagation - 标签传播5)Self-Training - 自训练6)Co-Training - 协同训练7)Transudative Learning - 传导学习8)Inductive Learning - 归纳学习9)Manifold Regularization - 流形正则化10)Graph-based Methods - 基于图的方法11)Cluster Assumption - 聚类假设12)Low-Density Separation - 低密度分离13)Semi-Supervised Support Vector Machines (S3VM) - 半监督支持向量机14)Expectation-Maximization (EM) - 期望最大化15)Co-EM - 协同期望最大化16)Entropy-Regularized EM - 熵正则化EM17)Mean Teacher - 平均教师18)Virtual Adversarial Training - 虚拟对抗训练19)Tri-training - 三重训练20)Mix Match - 混合匹配•Feature - 特征1)Feature - 特征2)Feature Engineering - 特征工程3)Feature Extraction - 特征提取4)Feature Selection - 特征选择5)Input Features - 输入特征6)Output Features - 输出特征7)Feature Vector - 特征向量8)Feature Space - 特征空间9)Feature Representation - 特征表示10)Feature Transformation - 特征转换11)Feature Importance - 特征重要性12)Feature Scaling - 特征缩放13)Feature Normalization - 特征归一化14)Feature Encoding - 特征编码15)Feature Fusion - 特征融合16)Feature Dimensionality Reduction - 特征维度减少17)Continuous Feature - 连续特征18)Categorical Feature - 分类特征19)Nominal Feature - 名义特征20)Ordinal Feature - 有序特征•Label - 标签1)Label - 标签2)Labeling - 标注3)Ground Truth - 地面真值4)Class Label - 类别标签5)Target Variable - 目标变量6)Labeling Scheme - 标注方案7)Multi-class Labeling - 多类别标注8)Binary Labeling - 二分类标注9)Label Noise - 标签噪声10)Labeling Error - 标注错误11)Label Propagation - 标签传播12)Unlabeled Data - 无标签数据13)Labeled Data - 有标签数据14)Semi-supervised Learning - 半监督学习15)Active Learning - 主动学习16)Weakly Supervised Learning - 弱监督学习17)Noisy Label Learning - 噪声标签学习18)Self-training - 自训练19)Crowdsourcing Labeling - 众包标注20)Label Smoothing - 标签平滑化•Prediction - 预测1)Prediction - 预测2)Forecasting - 预测3)Regression - 回归4)Classification - 分类5)Time Series Prediction - 时间序列预测6)Forecast Accuracy - 预测准确性7)Predictive Modeling - 预测建模8)Predictive Analytics - 预测分析9)Forecasting Method - 预测方法10)Predictive Performance - 预测性能11)Predictive Power - 预测能力12)Prediction Error - 预测误差13)Prediction Interval - 预测区间14)Prediction Model - 预测模型15)Predictive Uncertainty - 预测不确定性16)Forecast Horizon - 预测时间跨度17)Predictive Maintenance - 预测性维护18)Predictive Policing - 预测式警务19)Predictive Healthcare - 预测性医疗20)Predictive Maintenance - 预测性维护•Classification - 分类1)Classification - 分类2)Classifier - 分类器3)Class - 类别4)Classify - 对数据进行分类5)Class Label - 类别标签6)Binary Classification - 二元分类7)Multiclass Classification - 多类分类8)Class Probability - 类别概率9)Decision Boundary - 决策边界10)Decision Tree - 决策树11)Support Vector Machine (SVM) - 支持向量机12)K-Nearest Neighbors (KNN) - K最近邻算法13)Naive Bayes - 朴素贝叶斯14)Logistic Regression - 逻辑回归15)Random Forest - 随机森林16)Neural Network - 神经网络17)SoftMax Function - SoftMax函数18)One-vs-All (One-vs-Rest) - 一对多(一对剩余)19)Ensemble Learning - 集成学习20)Confusion Matrix - 混淆矩阵•Regression - 回归1)Regression Analysis - 回归分析2)Linear Regression - 线性回归3)Multiple Regression - 多元回归4)Polynomial Regression - 多项式回归5)Logistic Regression - 逻辑回归6)Ridge Regression - 岭回归7)Lasso Regression - Lasso回归8)Elastic Net Regression - 弹性网络回归9)Regression Coefficients - 回归系数10)Residuals - 残差11)Ordinary Least Squares (OLS) - 普通最小二乘法12)Ridge Regression Coefficient - 岭回归系数13)Lasso Regression Coefficient - Lasso回归系数14)Elastic Net Regression Coefficient - 弹性网络回归系数15)Regression Line - 回归线16)Prediction Error - 预测误差17)Regression Model - 回归模型18)Nonlinear Regression - 非线性回归19)Generalized Linear Models (GLM) - 广义线性模型20)Coefficient of Determination (R-squared) - 决定系数21)F-test - F检验22)Homoscedasticity - 同方差性23)Heteroscedasticity - 异方差性24)Autocorrelation - 自相关25)Multicollinearity - 多重共线性26)Outliers - 异常值27)Cross-validation - 交叉验证28)Feature Selection - 特征选择29)Feature Engineering - 特征工程30)Regularization - 正则化2.Neural Networks and Deep Learning (神经网络与深度学习)•Convolutional Neural Network (CNN) - 卷积神经网络1)Convolutional Neural Network (CNN) - 卷积神经网络2)Convolution Layer - 卷积层3)Feature Map - 特征图4)Convolution Operation - 卷积操作5)Stride - 步幅6)Padding - 填充7)Pooling Layer - 池化层8)Max Pooling - 最大池化9)Average Pooling - 平均池化10)Fully Connected Layer - 全连接层11)Activation Function - 激活函数12)Rectified Linear Unit (ReLU) - 线性修正单元13)Dropout - 随机失活14)Batch Normalization - 批量归一化15)Transfer Learning - 迁移学习16)Fine-Tuning - 微调17)Image Classification - 图像分类18)Object Detection - 物体检测19)Semantic Segmentation - 语义分割20)Instance Segmentation - 实例分割21)Generative Adversarial Network (GAN) - 生成对抗网络22)Image Generation - 图像生成23)Style Transfer - 风格迁移24)Convolutional Autoencoder - 卷积自编码器25)Recurrent Neural Network (RNN) - 循环神经网络•Recurrent Neural Network (RNN) - 循环神经网络1)Recurrent Neural Network (RNN) - 循环神经网络2)Long Short-Term Memory (LSTM) - 长短期记忆网络3)Gated Recurrent Unit (GRU) - 门控循环单元4)Sequence Modeling - 序列建模5)Time Series Prediction - 时间序列预测6)Natural Language Processing (NLP) - 自然语言处理7)Text Generation - 文本生成8)Sentiment Analysis - 情感分析9)Named Entity Recognition (NER) - 命名实体识别10)Part-of-Speech Tagging (POS Tagging) - 词性标注11)Sequence-to-Sequence (Seq2Seq) - 序列到序列12)Attention Mechanism - 注意力机制13)Encoder-Decoder Architecture - 编码器-解码器架构14)Bidirectional RNN - 双向循环神经网络15)Teacher Forcing - 强制教师法16)Backpropagation Through Time (BPTT) - 通过时间的反向传播17)Vanishing Gradient Problem - 梯度消失问题18)Exploding Gradient Problem - 梯度爆炸问题19)Language Modeling - 语言建模20)Speech Recognition - 语音识别•Long Short-Term Memory (LSTM) - 长短期记忆网络1)Long Short-Term Memory (LSTM) - 长短期记忆网络2)Cell State - 细胞状态3)Hidden State - 隐藏状态4)Forget Gate - 遗忘门5)Input Gate - 输入门6)Output Gate - 输出门7)Peephole Connections - 窥视孔连接8)Gated Recurrent Unit (GRU) - 门控循环单元9)Vanishing Gradient Problem - 梯度消失问题10)Exploding Gradient Problem - 梯度爆炸问题11)Sequence Modeling - 序列建模12)Time Series Prediction - 时间序列预测13)Natural Language Processing (NLP) - 自然语言处理14)Text Generation - 文本生成15)Sentiment Analysis - 情感分析16)Named Entity Recognition (NER) - 命名实体识别17)Part-of-Speech Tagging (POS Tagging) - 词性标注18)Attention Mechanism - 注意力机制19)Encoder-Decoder Architecture - 编码器-解码器架构20)Bidirectional LSTM - 双向长短期记忆网络•Attention Mechanism - 注意力机制1)Attention Mechanism - 注意力机制2)Self-Attention - 自注意力3)Multi-Head Attention - 多头注意力4)Transformer - 变换器5)Query - 查询6)Key - 键7)Value - 值8)Query-Value Attention - 查询-值注意力9)Dot-Product Attention - 点积注意力10)Scaled Dot-Product Attention - 缩放点积注意力11)Additive Attention - 加性注意力12)Context Vector - 上下文向量13)Attention Score - 注意力分数14)SoftMax Function - SoftMax函数15)Attention Weight - 注意力权重16)Global Attention - 全局注意力17)Local Attention - 局部注意力18)Positional Encoding - 位置编码19)Encoder-Decoder Attention - 编码器-解码器注意力20)Cross-Modal Attention - 跨模态注意力•Generative Adversarial Network (GAN) - 生成对抗网络1)Generative Adversarial Network (GAN) - 生成对抗网络2)Generator - 生成器3)Discriminator - 判别器4)Adversarial Training - 对抗训练5)Minimax Game - 极小极大博弈6)Nash Equilibrium - 纳什均衡7)Mode Collapse - 模式崩溃8)Training Stability - 训练稳定性9)Loss Function - 损失函数10)Discriminative Loss - 判别损失11)Generative Loss - 生成损失12)Wasserstein GAN (WGAN) - Wasserstein GAN(WGAN)13)Deep Convolutional GAN (DCGAN) - 深度卷积生成对抗网络(DCGAN)14)Conditional GAN (c GAN) - 条件生成对抗网络(c GAN)15)Style GAN - 风格生成对抗网络16)Cycle GAN - 循环生成对抗网络17)Progressive Growing GAN (PGGAN) - 渐进式增长生成对抗网络(PGGAN)18)Self-Attention GAN (SAGAN) - 自注意力生成对抗网络(SAGAN)19)Big GAN - 大规模生成对抗网络20)Adversarial Examples - 对抗样本•Encoder-Decoder - 编码器-解码器1)Encoder-Decoder Architecture - 编码器-解码器架构2)Encoder - 编码器3)Decoder - 解码器4)Sequence-to-Sequence Model (Seq2Seq) - 序列到序列模型5)State Vector - 状态向量6)Context Vector - 上下文向量7)Hidden State - 隐藏状态8)Attention Mechanism - 注意力机制9)Teacher Forcing - 强制教师法10)Beam Search - 束搜索11)Recurrent Neural Network (RNN) - 循环神经网络12)Long Short-Term Memory (LSTM) - 长短期记忆网络13)Gated Recurrent Unit (GRU) - 门控循环单元14)Bidirectional Encoder - 双向编码器15)Greedy Decoding - 贪婪解码16)Masking - 遮盖17)Dropout - 随机失活18)Embedding Layer - 嵌入层19)Cross-Entropy Loss - 交叉熵损失20)Tokenization - 令牌化•Transfer Learning - 迁移学习1)Transfer Learning - 迁移学习2)Source Domain - 源领域3)Target Domain - 目标领域4)Fine-Tuning - 微调5)Domain Adaptation - 领域自适应6)Pre-Trained Model - 预训练模型7)Feature Extraction - 特征提取8)Knowledge Transfer - 知识迁移9)Unsupervised Domain Adaptation - 无监督领域自适应10)Semi-Supervised Domain Adaptation - 半监督领域自适应11)Multi-Task Learning - 多任务学习12)Data Augmentation - 数据增强13)Task Transfer - 任务迁移14)Model Agnostic Meta-Learning (MAML) - 与模型无关的元学习(MAML)15)One-Shot Learning - 单样本学习16)Zero-Shot Learning - 零样本学习17)Few-Shot Learning - 少样本学习18)Knowledge Distillation - 知识蒸馏19)Representation Learning - 表征学习20)Adversarial Transfer Learning - 对抗迁移学习•Pre-trained Models - 预训练模型1)Pre-trained Model - 预训练模型2)Transfer Learning - 迁移学习3)Fine-Tuning - 微调4)Knowledge Transfer - 知识迁移5)Domain Adaptation - 领域自适应6)Feature Extraction - 特征提取7)Representation Learning - 表征学习8)Language Model - 语言模型9)Bidirectional Encoder Representations from Transformers (BERT) - 双向编码器结构转换器10)Generative Pre-trained Transformer (GPT) - 生成式预训练转换器11)Transformer-based Models - 基于转换器的模型12)Masked Language Model (MLM) - 掩蔽语言模型13)Cloze Task - 填空任务14)Tokenization - 令牌化15)Word Embeddings - 词嵌入16)Sentence Embeddings - 句子嵌入17)Contextual Embeddings - 上下文嵌入18)Self-Supervised Learning - 自监督学习19)Large-Scale Pre-trained Models - 大规模预训练模型•Loss Function - 损失函数1)Loss Function - 损失函数2)Mean Squared Error (MSE) - 均方误差3)Mean Absolute Error (MAE) - 平均绝对误差4)Cross-Entropy Loss - 交叉熵损失5)Binary Cross-Entropy Loss - 二元交叉熵损失6)Categorical Cross-Entropy Loss - 分类交叉熵损失7)Hinge Loss - 合页损失8)Huber Loss - Huber损失9)Wasserstein Distance - Wasserstein距离10)Triplet Loss - 三元组损失11)Contrastive Loss - 对比损失12)Dice Loss - Dice损失13)Focal Loss - 焦点损失14)GAN Loss - GAN损失15)Adversarial Loss - 对抗损失16)L1 Loss - L1损失17)L2 Loss - L2损失18)Huber Loss - Huber损失19)Quantile Loss - 分位数损失•Activation Function - 激活函数1)Activation Function - 激活函数2)Sigmoid Function - Sigmoid函数3)Hyperbolic Tangent Function (Tanh) - 双曲正切函数4)Rectified Linear Unit (Re LU) - 矩形线性单元5)Parametric Re LU (P Re LU) - 参数化Re LU6)Exponential Linear Unit (ELU) - 指数线性单元7)Swish Function - Swish函数8)Softplus Function - Soft plus函数9)Softmax Function - SoftMax函数10)Hard Tanh Function - 硬双曲正切函数11)Softsign Function - Softsign函数12)GELU (Gaussian Error Linear Unit) - GELU(高斯误差线性单元)13)Mish Function - Mish函数14)CELU (Continuous Exponential Linear Unit) - CELU(连续指数线性单元)15)Bent Identity Function - 弯曲恒等函数16)Gaussian Error Linear Units (GELUs) - 高斯误差线性单元17)Adaptive Piecewise Linear (APL) - 自适应分段线性函数18)Radial Basis Function (RBF) - 径向基函数•Backpropagation - 反向传播1)Backpropagation - 反向传播2)Gradient Descent - 梯度下降3)Partial Derivative - 偏导数4)Chain Rule - 链式法则5)Forward Pass - 前向传播6)Backward Pass - 反向传播7)Computational Graph - 计算图8)Neural Network - 神经网络9)Loss Function - 损失函数10)Gradient Calculation - 梯度计算11)Weight Update - 权重更新12)Activation Function - 激活函数13)Optimizer - 优化器14)Learning Rate - 学习率15)Mini-Batch Gradient Descent - 小批量梯度下降16)Stochastic Gradient Descent (SGD) - 随机梯度下降17)Batch Gradient Descent - 批量梯度下降18)Momentum - 动量19)Adam Optimizer - Adam优化器20)Learning Rate Decay - 学习率衰减•Gradient Descent - 梯度下降1)Gradient Descent - 梯度下降2)Stochastic Gradient Descent (SGD) - 随机梯度下降3)Mini-Batch Gradient Descent - 小批量梯度下降4)Batch Gradient Descent - 批量梯度下降5)Learning Rate - 学习率6)Momentum - 动量7)Adaptive Moment Estimation (Adam) - 自适应矩估计8)RMSprop - 均方根传播9)Learning Rate Schedule - 学习率调度10)Convergence - 收敛11)Divergence - 发散12)Adagrad - 自适应学习速率方法13)Adadelta - 自适应增量学习率方法14)Adamax - 自适应矩估计的扩展版本15)Nadam - Nesterov Accelerated Adaptive Moment Estimation16)Learning Rate Decay - 学习率衰减17)Step Size - 步长18)Conjugate Gradient Descent - 共轭梯度下降19)Line Search - 线搜索20)Newton's Method - 牛顿法•Learning Rate - 学习率1)Learning Rate - 学习率2)Adaptive Learning Rate - 自适应学习率3)Learning Rate Decay - 学习率衰减4)Initial Learning Rate - 初始学习率5)Step Size - 步长6)Momentum - 动量7)Exponential Decay - 指数衰减8)Annealing - 退火9)Cyclical Learning Rate - 循环学习率10)Learning Rate Schedule - 学习率调度11)Warm-up - 预热12)Learning Rate Policy - 学习率策略13)Learning Rate Annealing - 学习率退火14)Cosine Annealing - 余弦退火15)Gradient Clipping - 梯度裁剪16)Adapting Learning Rate - 适应学习率17)Learning Rate Multiplier - 学习率倍增器18)Learning Rate Reduction - 学习率降低19)Learning Rate Update - 学习率更新20)Scheduled Learning Rate - 定期学习率•Batch Size - 批量大小1)Batch Size - 批量大小2)Mini-Batch - 小批量3)Batch Gradient Descent - 批量梯度下降4)Stochastic Gradient Descent (SGD) - 随机梯度下降5)Mini-Batch Gradient Descent - 小批量梯度下降6)Online Learning - 在线学习7)Full-Batch - 全批量8)Data Batch - 数据批次9)Training Batch - 训练批次10)Batch Normalization - 批量归一化11)Batch-wise Optimization - 批量优化12)Batch Processing - 批量处理13)Batch Sampling - 批量采样14)Adaptive Batch Size - 自适应批量大小15)Batch Splitting - 批量分割16)Dynamic Batch Size - 动态批量大小17)Fixed Batch Size - 固定批量大小18)Batch-wise Inference - 批量推理19)Batch-wise Training - 批量训练20)Batch Shuffling - 批量洗牌•Epoch - 训练周期1)Training Epoch - 训练周期2)Epoch Size - 周期大小3)Early Stopping - 提前停止4)Validation Set - 验证集5)Training Set - 训练集6)Test Set - 测试集7)Overfitting - 过拟合8)Underfitting - 欠拟合9)Model Evaluation - 模型评估10)Model Selection - 模型选择11)Hyperparameter Tuning - 超参数调优12)Cross-Validation - 交叉验证13)K-fold Cross-Validation - K折交叉验证14)Stratified Cross-Validation - 分层交叉验证15)Leave-One-Out Cross-Validation (LOOCV) - 留一法交叉验证16)Grid Search - 网格搜索17)Random Search - 随机搜索18)Model Complexity - 模型复杂度19)Learning Curve - 学习曲线20)Convergence - 收敛3.Machine Learning Techniques and Algorithms (机器学习技术与算法)•Decision Tree - 决策树1)Decision Tree - 决策树2)Node - 节点3)Root Node - 根节点4)Leaf Node - 叶节点5)Internal Node - 内部节点6)Splitting Criterion - 分裂准则7)Gini Impurity - 基尼不纯度8)Entropy - 熵9)Information Gain - 信息增益10)Gain Ratio - 增益率11)Pruning - 剪枝12)Recursive Partitioning - 递归分割13)CART (Classification and Regression Trees) - 分类回归树14)ID3 (Iterative Dichotomiser 3) - 迭代二叉树315)C4.5 (successor of ID3) - C4.5(ID3的后继者)16)C5.0 (successor of C4.5) - C5.0(C4.5的后继者)17)Split Point - 分裂点18)Decision Boundary - 决策边界19)Pruned Tree - 剪枝后的树20)Decision Tree Ensemble - 决策树集成•Random Forest - 随机森林1)Random Forest - 随机森林2)Ensemble Learning - 集成学习3)Bootstrap Sampling - 自助采样4)Bagging (Bootstrap Aggregating) - 装袋法5)Out-of-Bag (OOB) Error - 袋外误差6)Feature Subset - 特征子集7)Decision Tree - 决策树8)Base Estimator - 基础估计器9)Tree Depth - 树深度10)Randomization - 随机化11)Majority Voting - 多数投票12)Feature Importance - 特征重要性13)OOB Score - 袋外得分14)Forest Size - 森林大小15)Max Features - 最大特征数16)Min Samples Split - 最小分裂样本数17)Min Samples Leaf - 最小叶节点样本数18)Gini Impurity - 基尼不纯度19)Entropy - 熵20)Variable Importance - 变量重要性•Support Vector Machine (SVM) - 支持向量机1)Support Vector Machine (SVM) - 支持向量机2)Hyperplane - 超平面3)Kernel Trick - 核技巧4)Kernel Function - 核函数5)Margin - 间隔6)Support Vectors - 支持向量7)Decision Boundary - 决策边界8)Maximum Margin Classifier - 最大间隔分类器9)Soft Margin Classifier - 软间隔分类器10) C Parameter - C参数11)Radial Basis Function (RBF) Kernel - 径向基函数核12)Polynomial Kernel - 多项式核13)Linear Kernel - 线性核14)Quadratic Kernel - 二次核15)Gaussian Kernel - 高斯核16)Regularization - 正则化17)Dual Problem - 对偶问题18)Primal Problem - 原始问题19)Kernelized SVM - 核化支持向量机20)Multiclass SVM - 多类支持向量机•K-Nearest Neighbors (KNN) - K-最近邻1)K-Nearest Neighbors (KNN) - K-最近邻2)Nearest Neighbor - 最近邻3)Distance Metric - 距离度量4)Euclidean Distance - 欧氏距离5)Manhattan Distance - 曼哈顿距离6)Minkowski Distance - 闵可夫斯基距离7)Cosine Similarity - 余弦相似度8)K Value - K值9)Majority Voting - 多数投票10)Weighted KNN - 加权KNN11)Radius Neighbors - 半径邻居12)Ball Tree - 球树13)KD Tree - KD树14)Locality-Sensitive Hashing (LSH) - 局部敏感哈希15)Curse of Dimensionality - 维度灾难16)Class Label - 类标签17)Training Set - 训练集18)Test Set - 测试集19)Validation Set - 验证集20)Cross-Validation - 交叉验证•Naive Bayes - 朴素贝叶斯1)Naive Bayes - 朴素贝叶斯2)Bayes' Theorem - 贝叶斯定理3)Prior Probability - 先验概率4)Posterior Probability - 后验概率5)Likelihood - 似然6)Class Conditional Probability - 类条件概率7)Feature Independence Assumption - 特征独立假设8)Multinomial Naive Bayes - 多项式朴素贝叶斯9)Gaussian Naive Bayes - 高斯朴素贝叶斯10)Bernoulli Naive Bayes - 伯努利朴素贝叶斯11)Laplace Smoothing - 拉普拉斯平滑12)Add-One Smoothing - 加一平滑13)Maximum A Posteriori (MAP) - 最大后验概率14)Maximum Likelihood Estimation (MLE) - 最大似然估计15)Classification - 分类16)Feature Vectors - 特征向量17)Training Set - 训练集18)Test Set - 测试集19)Class Label - 类标签20)Confusion Matrix - 混淆矩阵•Clustering - 聚类1)Clustering - 聚类2)Centroid - 质心3)Cluster Analysis - 聚类分析4)Partitioning Clustering - 划分式聚类5)Hierarchical Clustering - 层次聚类6)Density-Based Clustering - 基于密度的聚类7)K-Means Clustering - K均值聚类8)K-Medoids Clustering - K中心点聚类9)DBSCAN (Density-Based Spatial Clustering of Applications with Noise) - 基于密度的空间聚类算法10)Agglomerative Clustering - 聚合式聚类11)Dendrogram - 系统树图12)Silhouette Score - 轮廓系数13)Elbow Method - 肘部法则14)Clustering Validation - 聚类验证15)Intra-cluster Distance - 类内距离16)Inter-cluster Distance - 类间距离17)Cluster Cohesion - 类内连贯性18)Cluster Separation - 类间分离度19)Cluster Assignment - 聚类分配20)Cluster Label - 聚类标签•K-Means - K-均值1)K-Means - K-均值2)Centroid - 质心3)Cluster - 聚类4)Cluster Center - 聚类中心5)Cluster Assignment - 聚类分配6)Cluster Analysis - 聚类分析7)K Value - K值8)Elbow Method - 肘部法则9)Inertia - 惯性10)Silhouette Score - 轮廓系数11)Convergence - 收敛12)Initialization - 初始化13)Euclidean Distance - 欧氏距离14)Manhattan Distance - 曼哈顿距离15)Distance Metric - 距离度量16)Cluster Radius - 聚类半径17)Within-Cluster Variation - 类内变异18)Cluster Quality - 聚类质量19)Clustering Algorithm - 聚类算法20)Clustering Validation - 聚类验证•Dimensionality Reduction - 降维1)Dimensionality Reduction - 降维2)Feature Extraction - 特征提取3)Feature Selection - 特征选择4)Principal Component Analysis (PCA) - 主成分分析5)Singular Value Decomposition (SVD) - 奇异值分解6)Linear Discriminant Analysis (LDA) - 线性判别分析7)t-Distributed Stochastic Neighbor Embedding (t-SNE) - t-分布随机邻域嵌入8)Autoencoder - 自编码器9)Manifold Learning - 流形学习10)Locally Linear Embedding (LLE) - 局部线性嵌入11)Isomap - 等度量映射12)Uniform Manifold Approximation and Projection (UMAP) - 均匀流形逼近与投影13)Kernel PCA - 核主成分分析14)Non-negative Matrix Factorization (NMF) - 非负矩阵分解15)Independent Component Analysis (ICA) - 独立成分分析16)Variational Autoencoder (VAE) - 变分自编码器17)Sparse Coding - 稀疏编码18)Random Projection - 随机投影19)Neighborhood Preserving Embedding (NPE) - 保持邻域结构的嵌入20)Curvilinear Component Analysis (CCA) - 曲线成分分析•Principal Component Analysis (PCA) - 主成分分析1)Principal Component Analysis (PCA) - 主成分分析2)Eigenvector - 特征向量3)Eigenvalue - 特征值4)Covariance Matrix - 协方差矩阵。

基于人工神经网络的模式识别技术

基于人工神经网络的模式识别技术技术的发展让我们的生活变得更加舒适、便利,而人工智能已成为了当代科技中不可或缺的一部分。

在这个领域里,模式识别技术得到了广泛的应用,其中基于人工神经网络的模式识别技术更是引人注目,在各个领域都得到了广泛的应用。

一、人工神经网络的基本原理人工神经网络是一种源自自然界生物神经系统的计算模型,它有着类似于人类和动物神经系统的结构和功能。

在它的功能实现过程中,利用大量的处理单元(神经元)和它们之间的连接模式,实现了大量的数据处理和分析。

每一个神经元相当于文脉单元,在进行信息传递时,神经元在其周边的神经元可以通过一些特定的权重值同步调整神经元之间的联系,实现了数据处理和计算。

二、人工神经网络的应用随着科技的发展,基于人工神经网络的模式识别技术在各个领域被广泛应用。

以下列举几个典型案例:1. 医学人工神经网络在医学领域的应用非常广泛,它可以通过对大量的数据进行处理和分析,实现疾病的诊断与治疗。

例如,人工神经网络可以用于癌症的筛查和鉴别诊断。

在人员健康管理领域,结合人工神经网络技术,可以便捷地判断患者的健康状况,并作出相应的医疗决策。

2. 金融基于人工神经网络的模式识别技术在金融领域的应用也非常广泛,例如在股票交易领域,可以通过人工神经网络技术对市场趋势进行分析,并做出投资决策。

在金融风险管理领域,可以结合人工神经网络的技术,更好地进行风险预警和风险控制。

3. 汽车在汽车行业中,人工神经网络的应用主要是在智能驾驶方面。

通过与传感器、GPS和电子地图等技术结合,人工神经网络可以实现车辆位置、路况、甚至是驾驶员行为的自主识别、判断,从而实现自动驾驶。

三、人工神经网络的优势1. 可以处理大量数据人工神经网络具有处理大量数据的优势,通过对海量数据的分析和处理,可以更好地从数据中提取特征,实现数据的学习和分类。

2. 适用于复杂问题人工神经网络技术适用于复杂的问题,例如语音识别、人脸识别、文字识别等问题。

人工神经网络概述

2.1 感知器

单层感知器的学习法:

2.1 感知器

多层感知器:

在输入层和输出层之间加入一层或多层隐单元,构成 多层感知器。提高感知器的分类能力。

两层感知器可以解决“异或”问题的分类及识别任一凸 多边形或无界的凸区域。

更多层感知器网络,可识别更为复杂的图形。

2.2 BP网络

多层前馈网络的反向传播 (BP)学习算法,简称BP 算法,是有导师的学习,它 是梯度下降法在多层前馈网 中的应用。

基本感知器

是一个具有单层计算神经元的两层网络。 只能对线性可分输入矢量进行分类。

n个输入向量x1,x2, …, xn 均为实数,w1i,w2i,…,wni 分别是n个输入 的连接权值,b是感知器的阈值,传递函数f一般是阶跃函数,y 是感 知器的输出。通过对网络权值的训练,可以使感知器对一组输入矢量 的响应成为0或1的目标输出,从而达到对输入矢量分类识别的目的。

网络结构 见图,u、y是网络的输

入、输出向量,神经元用节 点表示,网络由输入层、隐 层和输出层节点组成,隐层 可一层,也可多层(图中是 单隐层),前层至后层节点 通过权联接。由于用BP学习 算法,所以常称BP神经网络 。

2.2 BP网络

已知网络的输入/输出样本,即导师信号 。

BP学习算法由正向传播和反向传播组成 :

net.trainparam.goal=0.00001;

网络可能根本不能训

% 进行网络训练和仿真:

练或网络性能很差;

[net,tr]=train(net,X,Y);

若隐层节点数太多,

% 进行仿真预测

虽然可使网络的系统

XX1=[0.556 0.556 0.556 0.556 0.556 0.556 0.556] 误差减小,但一方面

人工神经网络理论简介

人工神经网络理论简介人工神经网络是基于模仿生物大脑结构和功能而构成的一种信息处理系统。

由于人工神经网络具有复杂的动力学特性、并行处理机制、学习、联想和记忆等功能,以及它的高度自组织、自适应能力和灵活活性而受到自然科学领域学者和各行业应用专家的广泛重视[31]。

4.1 神经网络的特点神经网络实际上是由大量简单元件相互连接而成的复杂网络,具有高度的非线性,能够进行复杂的逻辑操作和非线性关系实现的系统。

神经网络吸取了生物神经网络的许多优点,因而有其固有的特点[32]:1、分布式存储信息。

其信息的存储分布在不同的位置,神经网络是用大量神经元的连接及对各连接权值的分布来表示特定的信息,从而使网络在局部网络受损或输入信号因各种原因发生部分畸变时,仍然能够保证网络的正确输出,提高网络的容错性和鲁棒性。

2、并行协同处理信息。

神经网络中的每个神经元都可根据接收到的信息进行独立的运算和处理,并输出结果,同一层中的各个神经元的输出结果可被同时计算出来,然后传输给下一层做进一步处理,这体现了神经网络并行运算的特点,这个特点使网络具有非常强的实时性。

虽然单个神经元的结构及其简单,功能有限,但大量神经元构成的网络系统所能实现的行为是极其丰富多彩的。

3、良好的容错性与联想记忆功能。

神经网络通过自身的网络结构能够实现对信息的记忆。

而所记忆的信息是存储在神经元之间的权值中。

从单个权值中看不出所存储的信息内容,因而是分布式的存储方式。

这使得网络具有良好的容错性,并能进行聚类分析、特征提取、缺损模式复原等模式信息处理工作;又宜于做模式分类、模式联想等模式识别工作。

4、对信息的处理具有自组织、自学习的特点,便于联想、综合和推广。

神经网络的神经元之间的连接强度用权值大小表示,这种权值可以通过对训练样本的学习不断变化,而且随着训练样本量的增加和反复学习,这些神经元之间的连接强度会不断增加,从而提高神经元对这些样本特征的反应灵敏度。

4.2 神经网络的结构与泛化能力4.2.1 神经元模型神经元是人工神经网络的基本处理单元,它一般是一个多输入单输出的非线性元件。

神经网络论文

人工智能专题报告题目模式识别及人工神经网络概述姓名专业学号学院电脑科学与技术学院内容摘要:模式识别是一项极具研究价值的课题,随着神经网络和模糊逻辑技术的发展,人们对这一问题的研究又采用了许多新的方法和手段,也使得这一古老的课题焕发出新的生命力.目前国际上有相当多的学者在研究这一课题,它包括了模式识别领域中所有典型的问题:数据的采集、处理及选择、输入样本表达的选择、模式识别分类器的选择以及用样本集对识别器的有指导的训练。

人工神经网络为数字识别提供了新的手段。

正是神经网络所具有的这种自组织自学习能力、推广能力、非线性和运算高度并行的能力使得模式识别成为目前神经网络最为成功的应用领域。

关键词:模式识别,神经网络,人工智能,原理,应用Abstract:Pattern recognition is an extremely valuable project research, with neural network and fuzzy logic technology development, people on this subject, and adopted many new methods and means, also make the ancient subject coruscate gives new vitality. Current international has quite a number of scholars in the study of this topic, and it includes pattern recognition field of typical problems: the data acquisition, processing and selection, input data express choice, the choice of mode identification classifier and using samples of the reader has guidance training. Artificial neural network for digital recognition to provide a new way. It is neural network which has this kind of self-organization self-learning capability, generalization, nonlinear and computing highly parallel ability makes the pattern recognition become the neural network was the most successful application fields.引言具体的模式识别是多种多样的,如果从识别的基本方法上划分,传统的模式识别大体分为统计模式识别和句法模式识别,在识别系统中引入神经网络是一种近年来发展起来的新的模式识别方法。

人工神经网络

学习训练算法

设有教师向量 T t1 t 2 t m 输入向量 则 初始加权阵 W0 偏差 B

T T

P p1 p 2 p n

t i 0 or 1

W ( k 1) W ( k ) E ( K ) X T B ( K 1) B ( K ) E ( K ) E(K ) T (K ) Y (K )

人工神经网络与神经网络优化算法

1 9 5 7 年 , F.Rosenblatt 提 出 “ 感 知 器”(Perceptron)模型,第一次把神经网络的 研究从纯理论的探讨付诸工程实践,掀起了人工 神经网络研究的第一次高潮。 20世纪60年代以后,数字计算机的发展达到全 盛时期,人们误以为数字计算机可以解决人工智 能、专家系统、模式识别问题,而放松了对“感 知器”的研究。于是,从20世纪60年代末期起, 人工神经网络的研究进入了低潮。

人工神经元的基本构成 x w

1 1

x2 w2 … xn wn

∑

net=XW

人工神经元模拟生物神经元的一阶特性。

输入:X=(x1,x2,…,xn) 联接权:W=(w1,w2,…,wn)T 网络输入: net=∑xiwi 向量形式: net=XW

激活函数(Activation Function)

γ>0为一常数,被称为饱和值,为该神经元 的最大输出。

2、非线性斜面函数(Ramp Function)

o

γ -θ -γ θ net

3、阈值函数(Threshold Function)阶跃函数

f(net)=

β

if net>θ

if net≤ θ

-γ β、γ、θ均为非负实数,θ为阈值 二值形式: 1 f(net)= 0 双极形式: 1 f(net)= -1

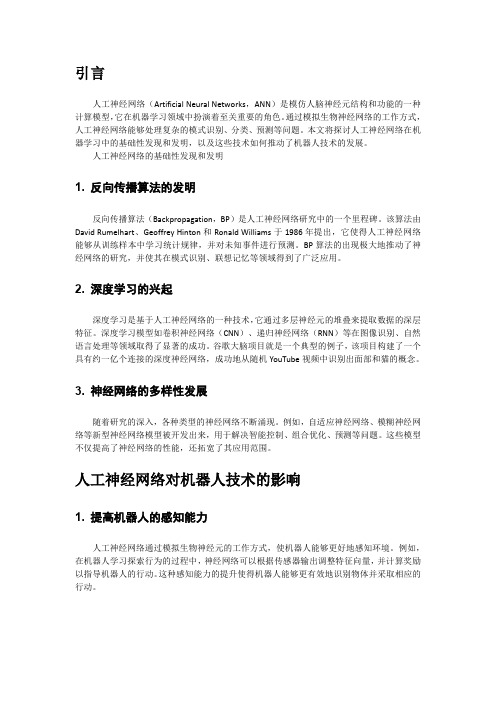

关于人工神经网络进行机器学习的基础性发现和发明如何促进机器人发展的

引言人工神经网络(Artificial Neural Networks,ANN)是模仿人脑神经元结构和功能的一种计算模型,它在机器学习领域中扮演着至关重要的角色。

通过模拟生物神经网络的工作方式,人工神经网络能够处理复杂的模式识别、分类、预测等问题。

本文将探讨人工神经网络在机器学习中的基础性发现和发明,以及这些技术如何推动了机器人技术的发展。

人工神经网络的基础性发现和发明1.反向传播算法的发明反向传播算法(Backpropagation,BP)是人工神经网络研究中的一个里程碑。

该算法由David Rumelhart、Geoffrey Hinton和Ronald Williams于1986年提出,它使得人工神经网络能够从训练样本中学习统计规律,并对未知事件进行预测。

BP算法的出现极大地推动了神经网络的研究,并使其在模式识别、联想记忆等领域得到了广泛应用。

2.深度学习的兴起深度学习是基于人工神经网络的一种技术,它通过多层神经元的堆叠来提取数据的深层特征。

深度学习模型如卷积神经网络(CNN)、递归神经网络(RNN)等在图像识别、自然语言处理等领域取得了显著的成功。

谷歌大脑项目就是一个典型的例子,该项目构建了一个具有约一亿个连接的深度神经网络,成功地从随机YouTube视频中识别出面部和猫的概念。

3.神经网络的多样性发展随着研究的深入,各种类型的神经网络不断涌现。

例如,自适应神经网络、模糊神经网络等新型神经网络模型被开发出来,用于解决智能控制、组合优化、预测等问题。

这些模型不仅提高了神经网络的性能,还拓宽了其应用范围。

人工神经网络对机器人技术的影响1.提高机器人的感知能力人工神经网络通过模拟生物神经元的工作方式,使机器人能够更好地感知环境。

例如,在机器人学习探索行为的过程中,神经网络可以根据传感器输出调整特征向量,并计算奖励以指导机器人的行动。

这种感知能力的提升使得机器人能够更有效地识别物体并采取相应的行动。

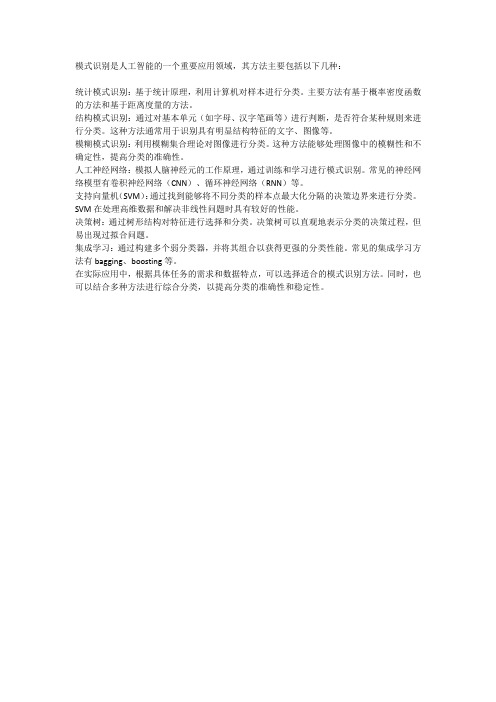

模式识别的主要方法

模式识别是人工智能的一个重要应用领域,其方法主要包括以下几种:

统计模式识别:基于统计原理,利用计算机对样本进行分类。

主要方法有基于概率密度函数的方法和基于距离度量的方法。

结构模式识别:通过对基本单元(如字母、汉字笔画等)进行判断,是否符合某种规则来进行分类。

这种方法通常用于识别具有明显结构特征的文字、图像等。

模糊模式识别:利用模糊集合理论对图像进行分类。

这种方法能够处理图像中的模糊性和不确定性,提高分类的准确性。

人工神经网络:模拟人脑神经元的工作原理,通过训练和学习进行模式识别。

常见的神经网络模型有卷积神经网络(CNN)、循环神经网络(RNN)等。

支持向量机(SVM):通过找到能够将不同分类的样本点最大化分隔的决策边界来进行分类。

SVM在处理高维数据和解决非线性问题时具有较好的性能。

决策树:通过树形结构对特征进行选择和分类。

决策树可以直观地表示分类的决策过程,但易出现过拟合问题。

集成学习:通过构建多个弱分类器,并将其组合以获得更强的分类性能。

常见的集成学习方法有bagging、boosting等。

在实际应用中,根据具体任务的需求和数据特点,可以选择适合的模式识别方法。

同时,也可以结合多种方法进行综合分类,以提高分类的准确性和稳定性。

人工神经网络

神经元

如图所示 a1~an为输入向量的各个分量 w1~wn为神经元各个突触的权值 b为偏置 f为传递函数,通常为非线性函数。以下默认为hardlim() t为神经元输出 数学表示 t=f(WA'+b) W为权向量 A为输入向量,A'为A向量的转置 b为偏置 f为传递函数

分类

根据学习环境不同,神经网络的学习方式可分为监督学习和非监督学习。在监督学习中,将训练样本的数据 加到网络输入端,同时将相应的期望输出与网络输出相比较,得到误差信号,以此控制权值连接强度的调整,经 多次训练后收敛到一个确定的权值。当样本情况发生变化时,经学习可以修改权值以适应新的环境。使用监督学 习的神经网络模型有反传网络、感知器等。非监督学习时,事先不给定标准样本,直接将网络置于环境之中,学 习阶段与工作阶段成为一体。此时,学习规律的变化服从连接权值的演变方程。非监督学习最简单的例子是Hebb 学习规则。竞争学习规则是一个更复杂的非监督学习的例子,它是根据已建立的聚类进行权值调整。自组织映射、 适应谐振理论网络等都是与竞争学习有关的典型模型。

神经网络在很多领域已得到了很好的应用,但其需要研究的方面还很多。其中,具有分布存储、并行处理、 自学习、自组织以及非线性映射等优点的神经网络与其他技术的结合以及由此而来的混合方法和混合系统,已经 成为一大研究热点。由于其他方法也有它们各自的优点,所以将神经网络与其他方法相结合,取长补短,继而可 以获得更好的应用效果。目前这方面工作有神经网络与模糊逻辑、专家系统、遗传算法、小波分析、混沌、粗集 理论、分形理论、证据理论和灰色系统等的融合。

人工神经网络知识概述

人工神经网络知识概述人工神经网络(Artificial Neural Networks,ANN)系统是20世纪40年代后出现的。

它是由众多的神经元可调的连接权值连接而成,具有大规模并行处理、分布式信息存储、良好的自组织自学习能力等特点。

BP(Back Propagation)算法又称为误差反向传播算法,是人工神经网络中的一种监督式的学习算法。

BP 神经网络算法在理论上可以逼近任意函数,基本的结构由非线性变化单元组成,具有很强的非线性映射能力。

而且网络的中间层数、各层的处理单元数及网络的学习系数等参数可根据具体情况设定,灵活性很大,在优化、信号处理与模式识别、智能控制、故障诊断等许多领域都有着广泛的应用前景。

人工神经元的研究起源于脑神经元学说。

19世纪末,在生物、生理学领域,Waldeger等人创建了神经元学说。

人们认识到复杂的神经系统是由数目繁多的神经元组合而成。

大脑皮层包括有100亿个以上的神经元,每立方毫米约有数万个,它们互相联结形成神经网络,通过感觉器官和神经接受来自身体内外的各种信息,传递至中枢神经系统内,经过对信息的分析和综合,再通过运动神经发出控制信息,以此来实现机体与内外环境的联系,协调全身的各种机能活动。

神经元也和其他类型的细胞一样,包括有细胞膜、细胞质和细胞核。

但是神经细胞的形态比较特殊,具有许多突起,因此又分为细胞体、轴突和树突三部分。

细胞体内有细胞核,突起的作用是传递信息。

树突是作为引入输入信号的突起,而轴突是作为输出端的突起,它只有一个。

树突是细胞体的延伸部分,它由细胞体发出后逐渐变细,全长各部位都可与其他神经元的轴突末梢相互联系,形成所谓“突触”。

在突触处两神经元并未连通,它只是发生信息传递功能的结合部,联系界面之间间隙约为(15~50)×10米。

突触可分为兴奋性与抑制性两种类型,它相应于神经元之间耦合的极性。

每个神经元的突触数目正常,最高可达10个。

各神经元之间的连接强度和极性有所不同,并且都可调整、基于这一特性,人脑具有存储信息的功能。

空间特征提取与模式识别

空间特征提取与模式识别一、概述随着计算机技术以及传感器技术的不断发展,各类地理空间数据在不断生成,给地理信息系统(GIS)提供了更多数据资源。

空间特征提取与模式识别是GIS中的一个重要任务,是将地理空间信息的特征提取出来,并通过模式识别技术分析空间现象的规律性和相关性,从而揭示地理现象及其规律性。

本文将对空间特征提取与模式识别技术的研究现状、方法、应用进行详细阐述。

二、空间特征提取方法(一)基于图像处理方法的空间特征提取图像处理方法是一种常用的空间特征提取方法,主要应用于遥感影像、卫星影像等场景。

图像处理方法的过程包括图像的预处理、特征提取和分类识别。

其中,特征提取是图像处理方法的核心环节,主要研究特征值的提取和计算。

在应用过程中,一般采用像元面积统计、纹理特征、形状特征、空间关系度量等方式进行特征提取。

常见的图像处理方法包括主成分分析法(PCA)、多级LBP(Local Binary Pattern)方法、SIFT(Scale-Invariant Feature Transform)方法等。

(二)基于时空数据分析方法的空间特征提取时空数据分析是GIS的重要领域之一,其主要任务是在时间和空间上分析地理数据的变化规律。

时空数据分析方法主要包括空间统计方法、时空监测方法和空间数据挖掘方法等。

空间统计方法主要用于分析地理空间与其他统计变量之间的关系,包括Moran指数、Geary指数、G函数等;时空监测方法主要用于分析时空数据的变化趋势和特征,包括趋势分析法、周期性分析法等;空间数据挖掘方法主要用于空间数据的分类、聚类与关联分析等。

三、模式识别方法(一)机器学习方法机器学习方法是一种基于数据的模式识别方法,其主要任务是通过学习已有数据的特征,预测新的未知数据的属性。

机器学习方法包括无监督学习、有监督学习和半监督学习等。

其中,无监督学习主要用于数据的聚类和降维处理;有监督学习主要用于数据的分类和预测;半监督学习主要用于数据的半监督分类和半监督回归等。

人工神经网络.pdf

y(t )(w(t − 1) ∗ x(t )) > 0 . y(t )(w(t − 1) ∗ x(t )) ≤ 0

( x (t ) 分错)

控制收敛速度的参数

5.1 感知机

学习算法收敛性:

对线性可分的数据有下面的定理。

定理(Novikoff):假设训练数据有界 x(i ) ≤ D, 两类样本的最大边界距离(maximal margin)为 2ρ (线性SVM)。则当学习速度参数η = 1 时, 2 次更新就会收敛。 D 感知机学习算法至多做

x2

x1 0 0 1 1

A

B

B

A

x1

5.2 多层感知机

解决XOR问题

x2

A

B

B

A

x1

5.2 多层感知机

两层神经网络解决XOR问题的真值表

第一层

x1 0 0 1 1

x2 0 1 0 1

y1 0 1 1 1

y2 0 0 0 1

第二 层 B(0) A(1) A(1) B(0)

y2

B

BLeabharlann Ay15.2 多层感知机

5.2 多层感知机

例: (XOR问题)

问题的提出以及重要性:

1956-1958年Rosenblatt提出感知机,是为了实现 另一种形式(模拟)的计算机。与数字计算机形 成鲜明对照。 数字计算机是用逻辑门电路实现的。逻辑门电路 的设计:AND, OR, NOT; 实际上,数字计算机的所有逻辑电路都是用XOR 门实现的。

MLPs具有一致逼近能力,因此可以学习这个函 数,也就解决了XOR问题。后面要讲到的RBF网 络也是一致逼近子,也可以解决XOR问题。

人工神经网络基本原理

人工神经网络基本原理

人工神经网络(Artificial Neural Network,ANN)是一种模拟人类大脑神经元工作方式的计算模型,由多个神经元节点相互连接而成。

它可以通过学习和适应性调整来进行信息处理和模式识别。

人工神经网络由输入层、隐藏层和输出层组成。

输入层接受外部输入信号,隐藏层用于处理这些信号,输出层则给出最终的输出结果。

每个层中的神经元节点与下一层的节点相连接,并通过具有可调整权值的连接进行信息传递。

每个神经元节点接收到输入信号后,会对其进行加权求和,并通过激活函数将结果转换为输出信号。

在训练过程中,人工神经网络根据输入样本和期望输出进行学习。

通过调整连接权值,神经网络逐渐优化其输出结果,使得实际输出与期望输出之间的误差最小化。

这一过程称为反向传播算法,通过梯度下降的方式,不断更新权值以逼近最优解。

人工神经网络具有较强的非线性拟合能力和自适应学习能力,可以用于解决分类、回归、模式识别等各种问题。

它已经广泛应用于图像和语音识别、自然语言处理、金融预测、医学诊断等领域。

然而,人工神经网络也存在一些挑战和限制。

例如,过拟合问题会导致网络在训练集上表现良好但在测试集上表现较差;训练时间较长,且需要大量的训练数据和计算资源;网络结构的选择和调优需要经验和专业知识。

总的来说,人工神经网络是一种模拟人脑神经元工作方式的计算模型,具有强大的非线性拟合能力和自适应学习能力。

虽然存在一些挑战和限制,但它在许多领域中都有广泛应用和研究价值。

人工神经网络简介

人工神经网络简介本文主要对人工神经网络基础进行了描述,主要包括人工神经网络的概念、发展、特点、结构、模型。

本文是个科普文,来自网络资料的整理。

一、人工神经网络的概念人工神经网络(Artificial Neural Network,ANN)简称神经网络(NN),是基于生物学中神经网络的基本原理,在理解和抽象了人脑结构和外界刺激响应机制后,以网络拓扑知识为理论基础,模拟人脑的神经系统对复杂信息的处理机制的一种数学模型。

该模型以并行分布的处理能力、高容错性、智能化和自学习等能力为特征,将信息的加工和存储结合在一起,以其独特的知识表示方式和智能化的自适应学习能力,引起各学科领域的关注。

它实际上是一个有大量简单元件相互连接而成的复杂网络,具有高度的非线性,能够进行复杂的逻辑操作和非线性关系实现的系统。

神经网络是一种运算模型,由大量的节点(或称神经元)之间相互联接构成。

每个节点代表一种特定的输出函数,称为激活函数(activation function)。

每两个节点间的连接都代表一个对于通过该连接信号的加权值,称之为权重(weight),神经网络就是通过这种方式来模拟人类的记忆。

网络的输出则取决于网络的结构、网络的连接方式、权重和激活函数。

而网络自身通常都是对自然界某种算法或者函数的逼近,也可能是对一种逻辑策略的表达。

神经网络的构筑理念是受到生物的神经网络运作启发而产生的。

人工神经网络则是把对生物神经网络的认识与数学统计模型相结合,借助数学统计工具来实现。

另一方面在人工智能学的人工感知领域,我们通过数学统计学的方法,使神经网络能够具备类似于人的决定能力和简单的判断能力,这种方法是对传统逻辑学演算的进一步延伸。

人工神经网络中,神经元处理单元可表示不同的对象,例如特征、字母、概念,或者一些有意义的抽象模式。

网络中处理单元的类型分为三类:输入单元、输出单元和隐单元。

输入单元接受外部世界的信号与数据;输出单元实现系统处理结果的输出;隐单元是处在输入和输出单元之间,不能由系统外部观察的单元。

人工神经网络及模式识别

人工神经网络及模式识别人工神经网络(Artificial Neural Network,ANN)是一种模仿生物神经网络结构和功能的数学模型,是深度学习的基础。

它由大量的神经元(也称为节点或单元)组成,通过连接不同神经元之间的连接权重进行信息传递和处理。

模式识别(Pattern Recognition)是指根据已知的模式进行辨识和分类的过程,人工神经网络在模式识别中有着广泛的应用。

人工神经网络的基本结构包括输入层、隐藏层和输出层。

输入层接收外部数据作为输入,隐藏层用于处理输入数据,输出层输出最终的结果。

神经元之间的连接权重和激活函数决定了信息的传递和处理方式。

常用的激活函数有 sigmoid 函数、ReLU 函数等。

通过调整神经元之间的连接权重和激活函数的选择,可以使神经网络对不同模式的输入数据进行学习和预测。

人工神经网络的训练过程通常包括前向传播和反向传播两个步骤。

前向传播是指依据当前的连接权重和激活函数,将输入数据从输入层传递到输出层,得到预测结果。

反向传播是指根据预测结果与真实结果的差别来调整连接权重,不断优化模型的性能。

模式识别是人工神经网络的主要应用之一、通过训练一个神经网络模型,可以使其具备识别和分类不同模式的能力。

例如,可以利用人工神经网络对图像进行分类,识别图像中的目标物体或区分不同类别的图像。

此外,人工神经网络还可以应用于语音识别、手写体识别、医学诊断等领域。

人工神经网络的模式识别能力取决于网络的深度和规模、数据样本的质量和数量,以及神经网络的参数设置等。

一般情况下,神经网络的规模越大、层数越深,其识别和分类的准确性和鲁棒性更高。

而充分的训练数据和合理的参数设置也是确保识别效果的重要因素。

总的来说,人工神经网络是一种模仿生物神经网络的数学模型,通过调整连接权重和激活函数的选择,实现对不同模式的输入数据进行学习和预测。

在模式识别中,人工神经网络可以应用于图像识别、语音识别、手写体识别等任务,具备较高的识别准确性和鲁棒性。