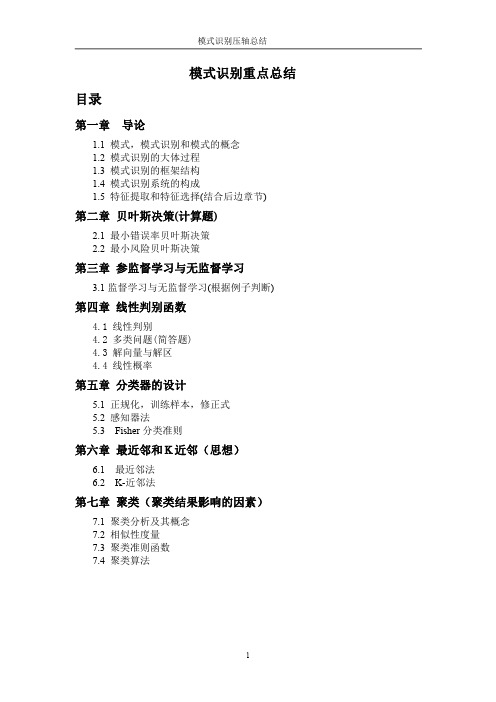

模式识别复习重点总结

模式识别复习重点总结

1.线性判别方法(1)两类:二维及多维判别函数,判别边界,判别规则 二维情况:(a )判别函数: ( ) (b )判别边界:g(x)=0; (cn 维情况:(a )判别函数: 也可表示为:(b )判别边界:g 1(x ) =W T X=0(c )判别规则:(2)多类:3种判别方法(函数、边界、规则)(A)第一种情况:(a)判别函数:M 类可有M 个判别函数(b) 判别边界:ωi (i=1,2,…,n )类与其它类之间的边界由 g i (x )=0确定(c)(B)第二种情况:(a)判别函数:有 M (M _ 1)/2个判别平面(b) 判别边界: (c)判别规则:(C)第三种情况:(a)判别函数: (b) 判别边界:g i (x ) =g j (x ) 或g i (x ) -g j (x ) =0(c)判别规则:32211)(w x w x w x g ++=为坐标向量为参数,21,x x w 12211......)(+++++=n n n w x w x w x w x g X W x g T =)(为增值模式向量。

,=为增值权向量,Tn n T n n x x x x X w w w w W )1,...,,(),,...,,(21121+=+XW x g Tij ij =)(0)(=x g ij j i x g ij ≠⎩⎨⎧∈→<∈→>j ix 0x 0)(ωω当当权向量。

个判别函数的为第式中i w w w w W T in in i i i ),,,...,,(121+=XW x g K k =)(⎩⎨⎧∈=小,其它最大,当i Tki x X W x g ω)(2.分段线性判别方法1)基于距离:(1)子类,类判别函数 (2)判别规则(1)子类:把ωi 类可以分成l i 个子类:∴ 分成l 个子类。

子类判别函数:在同类的子类中找最近的均值 (2)判别规则: 这是在M 类中找最近均值。

模式识别 复习笔记

第一章 概论① 什么是模式识别?使计算机模仿人的感知能力,从感知数据中提取信息(判别物体和行为)的过程。

(老师的简略说法:用机器判断事物类别)② 模式识别系统主要由四个部分组成:原始数据的获取和预处理,特征提取与选择,分类或类聚,后处理。

③ 紧致性:做模式识别的前提条件是每个模式类满足紧致性。

④ 相似性度量满足的条件:1234点⑤ 一些专业术语的中英文:PR (pattern recognition )模式识别 BP (back-propagation )反向传播算法 PCA (principal component analysis )主成分分析NN (neural networks )神经网络 ⑥ 欧式距离:()()Tx u x u -- ⑦ 马氏距离:()()1Tx u x u ---∑第二章 贝叶斯决策(两大贝叶斯决策=最小错误率贝叶斯决策+最小风险贝叶斯决策):①贝叶斯决策的三个前提条件:类别数确定,各类的先验概率p(w i)已知,各类的条件概率密度函数p(x|w i)已知。

②最小错误率贝叶斯决策:使错误率最小的分类决策。

对应于最大后验概率。

贝叶斯公式:P17 白细胞例子③最小风险贝叶斯决策:考虑各种错误造成损失不同时的一种最优决策。

第三章最大似然估计(两大参数估计=最大似然估计+贝叶斯估计):最可能出一题最大似然估计的计算题。

判断估计好坏的标准:无偏性、有效性、一致性。

①最大似然估计的求解流程:1、构造似然函数2、对数化3、求偏导4、求解第四章线性分类器①Fisher判别法Fisher准则:找到一个最合适的投影轴,使两类样本在该轴上的投影之间的距离尽可能远,而每一类样本的投影尽可能紧凑,从而使分类效果为最佳。

各类样本均值向量m i判定函数J(w)越大,说明分子类间距离越大,分母类内距离越小。

符合fisher准则。

引入拉格朗日函数:求偏导②最小二乘法y=ax+b第五章非线性分类器①反向传播算法BP:1.三层结构2.简述BP过程、偏差回来调整权系数P953.学习规则:a.随机给定权系数;b.计算输出;c.得到偏差;d.进行调整4.算法步骤:第七章特征选择遗传算法过程:a.初始化:设置进化代数计数器t=0,设置最大进化代数T,随机生成M个个体作为初始群体P(0).b.个体评价:计算群体P(t)中各个个体的适应度。

模式识别总结

模式识别压轴总结

另外,使用欧氏距离度量时,还要注意模式样本测量值的选取,应该是有效 反映类别属性特征(各类属性的代表应均衡) 。但马氏距离可解决不均衡(一个 多,一个少)的问题。例如,取 5 个样本,其中有 4 个反映对分类有意义的特征 A,只有 1 个对分类有意义的特征 B,欧氏距离的计算结果,则主要体现特征 A。

信息获取 预处理 特征提取与选择 聚类 结果解释

1.4 模式识别系统的构成 基于统计方法的模式识别系统是由数据获取, 预处理, 特征提取和选择, 分类决策构成

2

模式识别压轴总结

1.5 特征提取和特征选择 特征提取 (extraction):用映射(或变换)的方法把原始特征变换为较少 的新特征。 特征选择(selection) :从原始特征中挑选出一些最有代表性,分类性能最 好的特征 特征提取/选择的目的,就是要压缩模式的维数,使之便于处理。 特征提取往往以在分类中使用的某种判决规则为准则,所提取的特征使在 某种准则下的分类错误最小。为此,必须考虑特征之间的统计关系,选用 适当的变换,才能提取最有效的特征。 特征提取的分类准则:在该准则下,选择对分类贡献较大的特征,删除贡 献甚微的特征。 特征选择:从原始特征中挑选出一些最有代表性、分类性能最好的特征进 行分类。 从 D 个特征中选取 d 个,共 CdD 种组合。 - 典型的组合优化问题 特征选择的方法大体可分两大类: Filter 方法:根据独立于分类器的指标 J 来评价所选择的特征子集 S,然后 在所有可能的特征子集中搜索出使得 J 最大的特征子集作为最优特征子 集。不考虑所使用的学习算法。 Wrapper 方法:将特征选择和分类器结合在一起,即特征子集的好坏标准 是由分类器决定的,在学习过程中表现优异的的特征子集会被选中。

模式识别复习提纲2

(2)使用最近邻规则将所有样本分配到各聚类中心所代表的类

ωj(l)中,各类所包含的样本数为Nj(l);

(3)计算各类的重心(均值向量),并令该重心为新的聚类中

心,即:

Zj(l+1)=N-j(1l)∑xi j=1,2,…,c xi∈ωj(l)

(4)如zj(l+1)≠zj(l),表示尚未得到最佳聚类结果,则返回步骤 (2),继续迭代;

(1)绝对可分:

➢ 每个模式类都可用单一判别函数与其他模式类区分开。 ➢ 如是M类分类,则有M个判别函数

x2

d3(X)=0

1

d1(X)=0

2 d2(X)=0

3

x1

判别函数的性质:

di(X)=Wi*TX*

>0, X∈ωi

<0, =0,

X不∈定ωj,j≠i

i,j=1,2,……,M

在模式空间S中,若给定N个样本,如能按 照样本间的相似程度,将S划分为k个决策 区域Si(i=1,2,…..,k),使得各样本 均能归入其中一个类,且不会同时属于两 个类。即 S1∪S2∪S3∪……∪Sk=S

Si∩Sj=0,i≠j

数据聚类的依据是样本间的“相似度”

2、数据聚类的特点:

无监督学习 数据驱动 聚类结果多样化:特征选取、相似度的度 量标准,坐标比例;

dij(X)= -dji(X)

分类决策规则:

x2

d23(X)=0 1 3

d12(X)=0

2 d13(X)=0

IR

x1

分类决策规则:

X∈ω1: d12(X)>0, d13(X)>0,

X∈ω2: d21(X)>0, d23(X)>0,

模式识别知识点

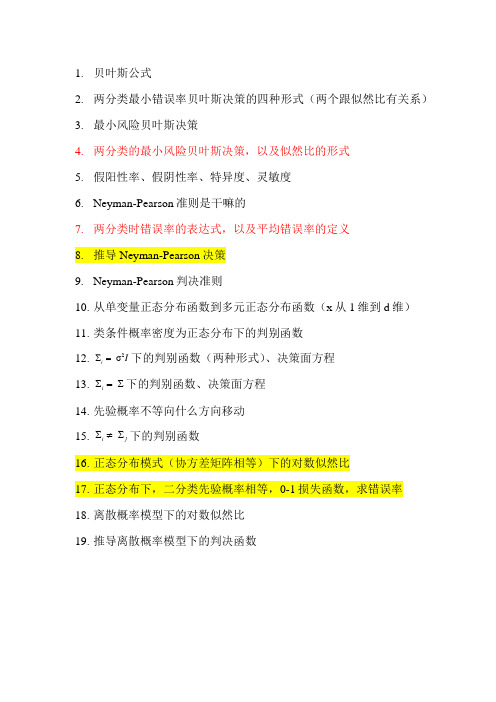

1.贝叶斯公式2.两分类最小错误率贝叶斯决策的四种形式(两个跟似然比有关系)3.最小风险贝叶斯决策4.两分类的最小风险贝叶斯决策,以及似然比的形式5.假阳性率、假阴性率、特异度、灵敏度6.Neyman-Pearson准则是干嘛的7.两分类时错误率的表达式,以及平均错误率的定义8.推导Neyman-Pearson决策9.Neyman-Pearson判决准则10.从单变量正态分布函数到多元正态分布函数(x从1维到d维)11.类条件概率密度为正态分布下的判别函数12.2Σσi I=下的判别函数(两种形式)、决策面方程13.ΣΣi=下的判别函数、决策面方程14.先验概率不等向什么方向移动15.ΣΣi j≠下的判别函数16.正态分布模式(协方差矩阵相等)下的对数似然比17.正态分布下,二分类先验概率相等,0-1损失函数,求错误率18.离散概率模型下的对数似然比19.推导离散概率模型下的判决函数20.极大似然估计的过程,PPT上P14的题目21.回顾正态分布的极大似然估计P1622.贝叶斯估计里面的条件风险和期望风险23.平方误差损失函数的条件下,θ的贝叶斯估计量是啥24.贝叶斯估计的一般步骤25.贝叶斯学习,N个样本与N-1个样本后验概率递推式26.单变量正态分布,已知方差,求均值的估计值P4227.了解期望最大算法(EM)P4828.隐马尔科夫模型里面的转移概率和发射概率29.估值问题的前向算法(求和)30.解码问题的思想,维特比方法的迭代式(找最大)31.概率密度函数在小区域内的估计32.最近邻法的错误率的范围33.k-近邻法的思路34.近邻法的快速算法有哪两个35.顶建立结构计算法的过程36.剪辑近邻法的思想37.parzen窗函数的性质以及常见parzen窗(核)函数38.窗(核)函数的实质是啥39.概率神经网络的训练和分类过程40.两类可分性判据Jij具有的性质41.类间离散度矩阵Sb和类内离散度矩阵Sw42.熵是越大越有助于分类还是越小越有助于分类43.Shannon熵和平方熵,熵可分离判据44.t-test中t的表达式以及自由度的表达式45.会写搜索树(构建搜索树,同一父节点,子节点J左小右大)46.搜索树的性质,一些概念,后继子节点数的计算公式47.分支定界算法(BAB)的要点48.搜索树左边还是右边的结构简单49.同一级中(同一父节点),J的值左边大还是右边大50.回顾特征选择的遗传算法51.wrapper方法的思想:直接把最终将要使用的模型的性能作为特征子集的评价标准,最终为给定的模型选择最有利于其性能的特征子集,缺点是需要多次训练模型52.PCA的基本步骤,协方差矩阵如何计算,矩阵求特征值、向量53.最优描述的K-L变换的基本过程54.为什么是最优?(均方误差)55.感知器、线性回归、Logistic要对样本增广化,即X0=156.感知器算法权重更新公式57.权重向量(不含W0)与分类面垂直58.感知器算法里面的两个不等式(一个有关理想权重和T次权重相似度,一个有关权重的模值)59.Pocket算法的思想60.根据线性回归损失函数梯度为0推导理想的权重61.广义逆是啥62.线性回归的损失函数63.自适应动态学习率与PMSProp64.动量法(Momentum)的权值更新公式65.随机梯度下降法(SGD)与批量(batch)的思想66.逻辑斯蒂函数是啥67.逻辑斯蒂函数的导数是啥68.逻辑斯蒂函数的交叉熵损失69.交叉熵损失的梯度是啥70.总结三个线性模型的Lin,画出函数曲线,总结三个的特点71.Fisher线性判别函数的思想是啥72.每个类别协方差矩阵的计算公式73.Fisher的目标函数,以及用SB和Sw表示的式子74.二分类问题的Fisher的类间SB和类间Sw分别等于啥75.最后向量的投影方向,判决门限76.线性支撑向量机SVM的动机(目的)是啥77.回顾向量到分类面的距离的表达式78.描述一下条件松弛后的最大间隔问题(求min啥,subject to啥)79.支撑向量机的损失函数Hinge Loss是啥,以及它对应的梯度80.二次规划问题(QP)是啥81.SVM对应于QP的各个参数是啥82.PrimeSVM化为拉格朗日目标函数是啥83.αn>0的样本落在边界上,被称为支撑向量84.对b求导得到的结论(上一题),对w求导得到的结论85.一对多策略的优点和缺点86.一对一策略的优点和缺点87.Softmax函数以及它的交叉熵损失88.Softmax交叉熵损失对权值的导数(链式法则)89.反向传播的链式法则90.输入图像尺寸,卷积核边长,通道数,填充数、步长和输出图像尺寸的关系91.参数量的计算92.明考夫斯基距离、兰氏距离、马氏距离93.近邻聚类法的思想94.层次聚类法计算两个簇的相关性的四种方法95.层次聚类法的时间复杂度、空间复杂度96.K-Means算法的过程97.K-Means算法的主要目标。

模式识别期末复习总结

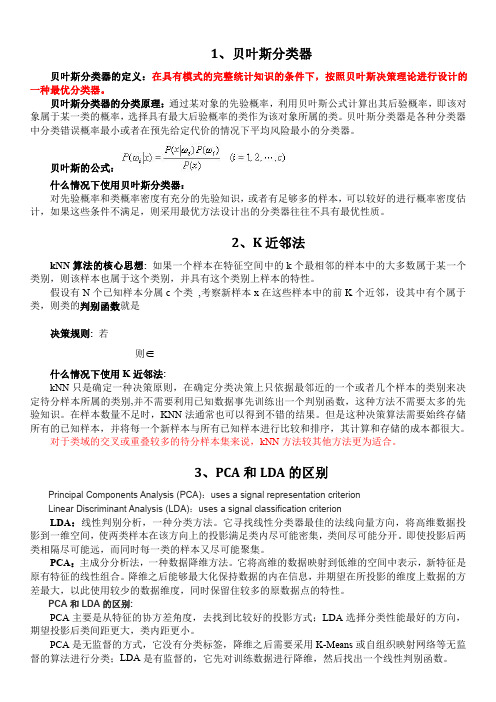

1、贝叶斯分类器贝叶斯分类器的定义:在具有模式的完整统计知识的条件下,按照贝叶斯决策理论进行设计的一种最优分类器。

贝叶斯分类器的分类原理:通过某对象的先验概率,利用贝叶斯公式计算出其后验概率,即该对象属于某一类的概率,选择具有最大后验概率的类作为该对象所属的类。

贝叶斯分类器是各种分类器中分类错误概率最小或者在预先给定代价的情况下平均风险最小的分类器。

贝叶斯的公式:什么情况下使用贝叶斯分类器:对先验概率和类概率密度有充分的先验知识,或者有足够多的样本,可以较好的进行概率密度估计,如果这些条件不满足,则采用最优方法设计出的分类器往往不具有最优性质。

2、K近邻法kNN算法的核心思想:如果一个样本在特征空间中的k个最相邻的样本中的大多数属于某一个类别,则该样本也属于这个类别,并具有这个类别上样本的特性。

假设有N个已知样本分属c个类,考察新样本x在这些样本中的前K个近邻,设其中有个属于类,则类的判别函数就是决策规则:若则∈什么情况下使用K近邻法:kNN只是确定一种决策原则,在确定分类决策上只依据最邻近的一个或者几个样本的类别来决定待分样本所属的类别,并不需要利用已知数据事先训练出一个判别函数,这种方法不需要太多的先验知识。

在样本数量不足时,KNN法通常也可以得到不错的结果。

但是这种决策算法需要始终存储所有的已知样本,并将每一个新样本与所有已知样本进行比较和排序,其计算和存储的成本都很大。

对于类域的交叉或重叠较多的待分样本集来说,kNN方法较其他方法更为适合。

3、PCA和LDA的区别Principal Components Analysis(PCA):uses a signal representation criterionLinear Discriminant Analysis(LDA):uses a signal classification criterionLDA:线性判别分析,一种分类方法。

它寻找线性分类器最佳的法线向量方向,将高维数据投影到一维空间,使两类样本在该方向上的投影满足类内尽可能密集,类间尽可能分开。

模式识别知识重点

1、你如何理解“人工智能”以及“智能”?参考答案:人工智能是通过研制智能机器或者编制程序模拟人或者高级生物的智能行为。

智能的行为具有如下特征:感知能力、记忆与思维能力、学习与自适应能力、行为能力等,这些来自于人脑的活动结果。

2、什么是不确定推理?不确定的因素有哪些?是什么原因造成的?参考答案:从不确定的初始证据出发,通过运用不确定性的知识,最终推出具有一定不确定性但是合理的或者近乎合理的思维过程。

不确定的因素有:证据不确定(存在错误、准确性无法判定)、匹配不确定、知识(规则)不确定、合成规则不确定等。

造成不确定的原因有:主观的和客观的,例如概率的、模糊的、信息不完备、准确性无法验证等,本质上是由于人的认识的有限性。

需要解决的基本问题有:不确定性的表示和量度,不确定性匹配算法以及阈值的选择,组合证据不确定性算法,不确定性的传递算法,结论不确定性的合成等。

3、你如何理解特征空间?表示样本有哪些常见方法?参考答案:由利用某些特征描述的所有样本组成的集合称为特征空间或者样本空间,特征空间的维数是描述样本的特征数量。

描述样本的常见方法:矢量、矩阵、列表等。

4、贝叶斯决策理论中,参数估计和非参数估计有什么区别?参考答案:参数估计就是已知样本分布的概型,通过训练样本确定概型中的一些参数;非参数估计就是未知样本分布概型,利用Parzen窗等方法确定样本的概率密度分布规律。

5、线性和非线性分类器与基于贝叶斯决策理论的分类器之间是什么关系?参考答案:线性分类器与非线性分类器都属于几何分类器,是统计模式识别的一种;基于贝叶斯决策理论的分类器属于概率分类,主要是基于样本在特征空间的概率分布;利用未知样本属于已知类别的概率或者风险大小进行分类。

几何分类的理论基础是概率分类,是一种简单的处理方式,不需要求解样本的概率分布,只需要利用已知样本训练得到一些几何分界面即可。

6、无教师示范的非监督学习与聚类分析之间有何联系?有哪些常见的非监督学习方法?试简要介绍其中一种方法,并给出必要的公式。

模式识别复习资料

(4)如果 Z j( k 1 ) Z j( k )j 1 ,2 , ,K ,则回到(2),将模式 样本逐个重新分类,重复迭代计算。

.

15

例2.3:已知20个模式样本如下,试用K-均值算法分类。

X1 0,0T X2 1,0T X3 0,1T X4 1,1T X5 2,1T X6 1,2T X7 2,2T X8 3,2T

x1

20

8 聚类准则函数Jj与K的关系曲线

上述K-均值算法,其类型数目假定已知为K个。当K未知时,

可以令K逐渐增加, 此时J j 会单调减少。最初减小速度快,但当 K 增加到一定数值时,减小速度会减慢,直到K =总样本数N 时,

Jj = 0。Jj-K关系曲线如下图:

Jj

曲线的拐点 A 对应着接近最优

④ 判断:

Zj(2)Zj(1)

j 1,2 ,故返回第②步。 .

17

② 从新的聚类中心得:

X 1: D D12||||X X11ZZ12((22))|||| X1S1(2) ┋

X 20:D D12||||X X2200Z Z12((22))|||| X20S2(2) 有: S 1 ( 2 ) { X 1 ,X 2 , ,X 8 } N 1 8

(2)将最小距离 3 对应的类 G1(0) 和G2 (0) 合并为1类,得 新的分类。

G 1( 1 2 ) G 1 ( 0 )G , 2 ( 0 ) G 3(1)G 3(0) G 4(1 )G 4(0 ) G 5(1)G 5(0) G 6(1 )G 6(0)

计算聚类后的距离矩阵D(1): 由D(0) 递推出D(1) 。

3)计算合并后新类别之间的距离,得D(n+1)。

4)跳至第2步,重复计算及合并。

模式识别期末复习笔记

模式识别期末复习笔记模式识别ch2 贝叶斯决策1.贝叶斯公式2.贝叶斯决策的特例a)先验概率相同(均匀先验概率):决策仅依赖于类条件概率密度b)类条件概率密度相同:决策仅依赖于先验概率3.计算题(医学测试⽅法)4.计算题(车⾝⾼低)5.贝叶斯决策的最优性a)最⼩化误差概率的⾓度i.每次均选择概率⼤的类做判断结果,因此错误概率永远是最⼩的b)最⼩化风险的⾓度i.每次均选择条件风险最⼩的结果,因此总风险最⼩6.对于两类分类问题,最⼩风险贝叶斯决策a)可以基于似然⽐进⾏决策b)p(x|ω1)p(x|ω2)≥λ12?λ22λ21?λ11p(ω2)p(ω1)则判断为1类,否则为2类c)似然⽐超过某个阈值(θ),那么可判决为ω1类7.0-1损失(误判是等价的):最⼩化风险就是最⼤化后验,也就是选择后验最⼤的a)最⼩化误差概率与最⼩化风险等价,即选择最⼤后验的分类,即满⾜最⼩误差概率,也满⾜最⼩风险8.先验概率未知时如何设计风险最⼩的分类器?a)使先验概率取任意值时的总风险的最坏情况尽可能⼩b)极⼩化极⼤准则:i.极⼩化指的是贝叶斯风险,因为它是总风险的最⼩值ii.极⼤化指的是使贝叶斯风险达到最⼤iii.贝叶斯风险是和先验有关的,其最⼤也就是其极值,就是导数等于0 的时候c)极⼩化极⼤风险是最坏的贝叶斯风险9.从最⼩化误差概率的意义上讲,贝叶斯是最优的;贝叶斯决策得到的总风险也是最⼩的10.判别函数a)对于两类分类,根据判别函数的正负进⾏类的判断;对于多类问题,两两组成两类问题b)两类问题下:g(x)=g1(x)?g2(x)i.若g(x)≥0,即g1(x)≥g2(x),则判断为1类,否则为2类c)g1(x),g2(x)的设计i.最⼩总风险贝叶斯分类器1.g1(x)=?R(α1|x),风险的相反数ii.最⼩误差概率贝叶斯分类器1. g 1(x )=p (ω1|x )2. g 1(x )=p (x|ω1)p (ω1)3. g 1(x )=log(p (x|ω1))+log(p (ω1))11.12. 计算题(决策边界为何下偏)ch3 参数估计1. 模式分类的途径(截图)2. 当可⽤数据很多以⾄于减轻了先验知识的作⽤时,贝叶斯估计可退化为最⼤似然估计。

四川大学模式识别复习要点及答案

简答题1.什么是模式与模式识别?模式:对象之间存在的规律性关系;模式识别:是研究用计算机来实现人类模式识别能力的一门学科。

/*模式:广义地说,模式是一些供模仿用的、完美无缺的标本。

本课程把所见到的具体事物称为模式,而将它们归属的类别称为模式类。

模式的直观特性:可观察性,可区分性,相似性模式识别:指对表征事物或现象的各种形式的(数值的、文字的和逻辑关系的)信息进行处理和分析,以对事物或现象进行描述、辨认、分类和解释的过程。

*/2.一个典型的模式识别系统主要由哪几个部分组成3.什么是后验概率?系统在某个具体的模式样本X条件下位于某种类型的概率。

4.确定线性分类器的主要步骤①采集训练样本,构成训练样本集。

样本应该具有典型性②确定一个准则J=J(w,x),能反映分类器性能,且存在权值w*使得分类器性能最优③设计求解w的最优算法,得到解向量w*5.样本集推断总体概率分布的方法6.近邻法的基本思想是什么?作为一种分段线性判别函数的极端情况,将各类中全部样本都作为代表点,这样的决策方法就是近邻法的基本思想。

7.什么是K近邻法?取未知样本x的k个近邻,看这k个近邻中多数属于哪一类,就把x归为哪一类。

7.监督学习与非监督学习的区别利用已经标定类别的样本集进行分类器设计的方法称为监督学习。

很多情况下无法预先知道样本的类别,从没有标记的样本集开始进行分类器设计,这就是非监督学习。

/*监督学习:对数据实现分类,分类规则通过训练获得。

该训练集由带分类号的数据集组成,因此监督学习方法的训练过程是离线的。

非监督学习方法不需要单独的离线训练过程,也没有带分类号的训练数据集,一般用来对数据集进行分析。

如聚类,确定其分布的主分量等。

*/8.什么是误差平方和准则?对于一个给定的聚类,均值向量是最能代表聚类中所有样本的一个向量,也称其为聚类中心。

一个好的聚类方法应能使集合中的所有向量与这个均值向量的误差的长度平方和最小。

9.分级聚类算法的2种基本途径是什么按事物的相似性,或内在联系组织起来,组成有层次的结构,使得本质上最接近的划为一类,然后把相近的类再合并,依次类推,这就是分级聚类算法的基本思想。

大二上学期末模式识别与人工智能复习要点

大二上学期末模式识别与人工智能复习要点

一、数学基础

在学习模式识别与人工智能课程时,数学基础是非常重要的。

特别

是概率论、统计学和线性代数知识。

要重点复习和掌握这些数学概念,包括概率密度函数、条件概率、贝叶斯定理、协方差矩阵、特征值分

解等内容。

二、模式识别基础

模式识别的基本概念和方法也是复习的重点。

包括特征提取、特征

选择、模式分类、聚类分析等内容。

可以通过复习课本上的相关知识

和做一些练习题来加深对这些概念和方法的理解。

三、机器学习算法

在复习模式识别与人工智能课程时,机器学习算法是需要重点复习

的内容。

包括K近邻算法、支持向量机、决策树、神经网络等。

要对

这些算法的原理和应用有一个清晰的理解。

四、深度学习

近年来,深度学习在模式识别与人工智能领域得到了广泛的应用。

复习时要重点关注深度学习的基本概念、常见的深度学习模型以及它

们的训练和应用。

五、应用案例

复习模式识别与人工智能课程时,要结合一些实际的应用案例来加深对知识的理解。

比如人脸识别、字符识别、语音识别等。

可以通过相关的论文和实验来了解这些应用案例的原理和方法。

六、实践操作

最后,在复习模式识别与人工智能课程时,要进行一些实践操作。

可以通过编程实现一些经典的模式识别算法和人工智能模型,加深对知识的理解和掌握。

通过以上的复习要点,相信能够帮助大家更好地复习模式识别与人工智能课程,取得更好的成绩。

希望大家都能够在期末考试中取得优异的成绩,加油!。

模式识别复习要点

复习要点绪论1、举出日常生活或技术、学术领域中应用模式识别理论解决问题的实例。

答:语音识别,图像识别,车牌识别,文字识别,人脸识别,通信中的信号识别;① 文字识别汉字已有数千年的历史,也是世界上使用人数最多的文字,对于中华民族灿烂文化的形成和发展有着不可磨灭的功勋。

所以在信息技术及计算机技术日益普及的今天,如何将文字方便、快速地输入到计算机中已成为影响人机接口效率的一个重要瓶颈,也关系到计算机能否真正在我过得到普及的应用。

目前,汉字输入主要分为人工键盘输入和机器自动识别输入两种。

其中人工键入速度慢而且劳动强度大;自动输入又分为汉字识别输入及语音识别输入。

从识别技术的难度来说,手写体识别的难度高于印刷体识别,而在手写体识别中,脱机手写体的难度又远远超过了联机手写体识别。

到目前为止,除了脱机手写体数字的识别已有实际应用外,汉字等文字的脱机手写体识别还处在实验室阶段。

②语音识别语音识别技术技术所涉及的领域包括:信号处理、模式识别、概率论和信息论、发声机理和听觉机理、人工智能等等。

近年来,在生物识别技术领域中,声纹识别技术以其独特的方便性、经济性和准确性等优势受到世人瞩目,并日益成为人们日常生活和工作中重要且普及的安验证方式。

而且利用基因算法训练连续隐马尔柯夫模型的语音识别方法现已成为语音识别的主流技术,该方法在语音识别时识别速度较快,也有较高的识别率。

③ 指纹识别我们手掌及其手指、脚、脚趾内侧表面的皮肤凹凸不平产生的纹路会形成各种各样的图案。

而这些皮肤的纹路在图案、断点和交叉点上各不相同,是唯一的。

依靠这种唯一性,就可以将一个人同他的指纹对应起来,通过比较他的指纹和预先保存的指纹进行比较,便可以验证他的真实身份。

一般的指纹分成有以下几个大的类别:环型(loop),螺旋型(whorl),弓型(arch),这样就可以将每个人的指纹分别归类,进行检索。

指纹识别基本上可分成:预处理、特征选择和模式分类几个大的步骤。

模式识别复习

第一、二章1. 模式识别概念、方法?概念:就是要用机器去完成人类智能中通过视觉听觉触觉等感官去识别外界环境的自然信息的这些工作。

方法:统计方法,句法方法,模糊方法,人工神经网络法,人工智能法2. 模式识别系统的组成,简述各部分的作用?数据获取:通过测量、采样和量化获取数据的过程 预处理:去出噪声,加强有用的信息,复原退化现象 特征提取和选择:得到最能反映分类本质的特征分类决策:就是在特征空间中用统计方法把被识别对象归为某一类别3.相似性度量有哪几种方法?(我找不到,要不你找找?)4.最常见的贝叶斯决策规则?分类?以两类模式(w1和w2 )为例,根据Bayes 公式:1(|)()(|)(|)()i i i j j j P x w P w P w x P x w P w =×=×å即利用Bayes 公式将先验概率转化为后验概率。

①基于最小错误概率的Bayes 决策规则为:• 若P(w1|x)>P(w2|x),则x ∈w1 ;反之则x ∈w2 • 或P(wi|x)=maxP(wj|x) ,则x ∈wi (i=1,2)②基于最小风险的贝叶斯决策如果1,...,(|)(|)mini aR a x R a x ==则 a=ak (即应采取的决策为ak )(或述为x ∈wk)③最小和最大决策5.N-P 决策推导过程令 2)(ε=e P 下,求 (1eP 的极小值。

即:()0P e ε-=⎫⎬约束条件:条件极值如下(求极小值)目标函数采用Lagrange 乘子法,构造Lagrange 函数为:其中λ是Lagrange 乘子,目的是求 γ 的极小值。

(即λ为一待定常数)。

将p1(e)与p2(e)的表达式代入 上式。

]))|([)|(01221εωλωγ-+=⎰⎰dx x P dx x P R R化简后 dx x P x P dx R ⎰-+-=1120)]|()|([)1(ωωλλεγ上式中λ是Lagrange 乘子,而R1是变量,这样γ的极小值问题就是要选择R1和R2的边界(边界点为t )问题了,即求R1使γ取极小值。

(完整版)《模式识别》知识重点总结与计算题,推荐文档

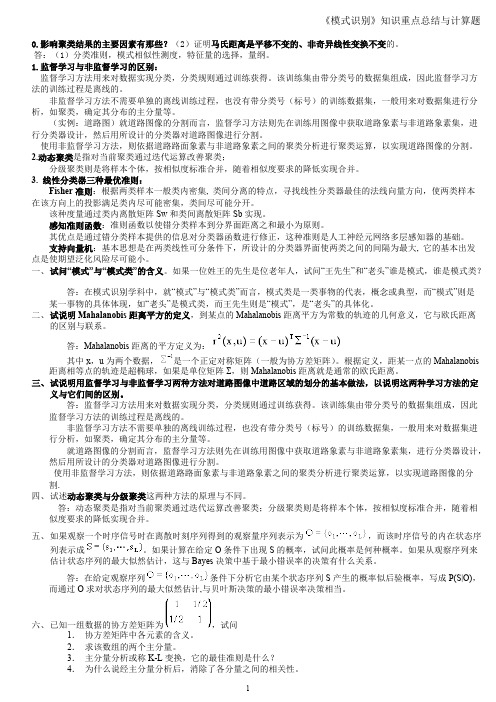

0.影响聚类结果的主要因素有那些?(2)证明马氏距离是平移不变的、非奇异线性变换不变的。

答:(1)分类准则,模式相似性测度,特征量的选择,量纲。

1.监督学习与非监督学习的区别:监督学习方法用来对数据实现分类,分类规则通过训练获得。

该训练集由带分类号的数据集组成,因此监督学习方法的训练过程是离线的。

非监督学习方法不需要单独的离线训练过程,也没有带分类号(标号)的训练数据集,一般用来对数据集进行分析,如聚类,确定其分布的主分量等。

(实例:道路图)就道路图像的分割而言,监督学习方法则先在训练用图像中获取道路象素与非道路象素集,进行分类器设计,然后用所设计的分类器对道路图像进行分割。

使用非监督学习方法,则依据道路路面象素与非道路象素之间的聚类分析进行聚类运算,以实现道路图像的分割。

2.动态聚类是指对当前聚类通过迭代运算改善聚类; 分级聚类则是将样本个体,按相似度标准合并,随着相似度要求的降低实现合并。

3. 线性分类器三种最优准则: Fisher准则:根据两类样本一般类内密集, 类间分离的特点,寻找线性分类器最佳的法线向量方向,使两类样本在该方向上的投影满足类内尽可能密集,类间尽可能分开。

该种度量通过类内离散矩阵Sw和类间离散矩阵Sb实现。

感知准则函数:准则函数以使错分类样本到分界面距离之和最小为原则。

其优点是通过错分类样本提供的信息对分类器函数进行修正,这种准则是人工神经元网络多层感知器的基础。

支持向量机:基本思想是在两类线性可分条件下,所设计的分类器界面使两类之间的间隔为最大, 它的基本出发点是使期望泛化风险尽可能小。

一、试问“模式”与“模式类”的含义。

如果一位姓王的先生是位老年人,试问“王先生”和“老头”谁是模式,谁是模式类?答:在模式识别学科中,就“模式”与“模式类”而言,模式类是一类事物的代表,概念或典型,而“模式”则是某一事物的具体体现,如“老头”是模式类,而王先生则是“模式”,是“老头”的具体化。

上海市考研智能科学与技术复习资料人工智能与模式识别重点知识点总结

上海市考研智能科学与技术复习资料人工智能与模式识别重点知识点总结上海市考研智能科学与技术复习资料——人工智能与模式识别重点知识点总结一、人工智能基础知识1. 人工智能概述人工智能是一门研究如何使计算机能够完成人类智能活动的学科,包括机器学习、自然语言处理、专家系统等。

2. 人工智能发展历程人工智能的发展经历了符号主义、连接主义和统计学习三个阶段,如今已进入深度学习时代。

3. 人工智能的应用领域人工智能在图像识别、语音识别、自动驾驶、医疗诊断等领域有广泛应用。

二、机器学习算法1. 机器学习概述机器学习是人工智能的一个重要分支,通过从数据中学习规律,使计算机具备自主学习和推断能力。

2. 监督学习监督学习是指通过已标记的训练数据来训练模型,并通过模型预测新数据的标签或值。

3. 无监督学习无监督学习是指使用未标记的数据进行模型训练,通过发现数据内在结构和模式来进行分类或聚类。

4. 深度学习深度学习是一种基于神经网络的机器学习方法,通过模拟人脑神经元之间的连接来实现高效的模式识别和推断。

三、模式识别算法1. 模式识别概述模式识别是指根据已有的模式来识别新样本的过程,包括特征提取、特征选择和分类器设计等步骤。

2. 特征提取特征提取是指从原始数据中提取出具有代表性的特征,常用的方法包括主成分分析、线性判别分析和小波变换等。

3. 特征选择特征选择是指从大量特征中选择出最具有代表性和区分性的特征,以提高分类器的性能。

4. 分类器设计分类器设计是指选择合适的算法或模型来对样本进行分类,常用的有支持向量机、决策树和随机森林等。

四、人工智能和模式识别的应用1. 图像识别人工智能和模式识别在图像识别领域有广泛应用,如人脸识别、物体检测和图像分类等。

2. 语音识别人工智能和模式识别在语音识别领域可以实现自动语音识别、语音合成和语音情感识别等技术。

3. 自动驾驶人工智能和模式识别在自动驾驶领域可以实现环境感知、路径规划和智能驾驶等功能。

模式识别复习重点总结85199

1.什么是模式及模式识别?模式识别的应用领域主要有哪些?模式:存在于时间,空间中可观察的事物,具有时间或空间分布的信息; 模式识别:用计算机实现人对各种事物或现象的分析,描述,判断,识别。

模式识别的应用领域:(1)字符识别;(2) 医疗诊断;(3)遥感; (4)指纹识别 脸形识别;(5)检测污染分析,大气,水源,环境监测;(6)自动检测;(7 )语声识别,机器翻译,电话号码自动查询,侦听,机器故障判断; (8)军事应用。

2.模式识别系统的基本组成是什么?(1) 信息的获取:是通过传感器,将光或声音等信息转化为电信息;(2) 预处理:包括A \D,二值化,图象的平滑,变换,增强,恢复,滤波等, 主要指图象处理;(3) 特征抽取和选择:在测量空间的原始数据通过变换获得在特征空间最能反映分类本质的特征;(4) 分类器设计:分类器设计的主要功能是通过训练确定判决规则,使按此类判决规则分类时,错误率最低。

把这些判决规则建成标准库; (5) 分类决策:在特征空间中对被识别对象进行分类。

3.模式识别的基本问题有哪些?(1)模式(样本)表示方法:(a)向量表示;(b)矩阵表示;(c)几何表示;(4)基元(链码)表示;(2)模式类的紧致性:模式识别的要求:满足紧致集,才能很好地分类;如果不满足紧致集,就要采取变换的方法,满足紧致集(3)相似与分类;(a)两个样本x i ,x j 之间的相似度量满足以下要求: ① 应为非负值② 样本本身相似性度量应最大 ③ 度量应满足对称性④ 在满足紧致性的条件下,相似性应该是点间距离的 单调函数(b)用各种距离表示相似性 (4)特征的生成:特征包括:(a)低层特征;(b)中层特征;(c)高层特征 (5) 数据的标准化:(a)极差标准化;(b)方差标准化4.线性判别方法(1)两类:二维及多维判别函数,判别边界,判别规则 二维情况:(a)判别函数: ( )(b)判别边界:g(x )=0; (c)判别规则:n 维情况:(a)判别函数:也可表示为:32211)(w x w x w x g ++=为坐标向量为参数,21,x x w 12211......)(+++++=n n n w x w x w x w x g X W x g T =)(为增值权向量,T T n n w w w w W ),,...,,(121=+(b)判别边界:g1(x ) =W TX =0 (c)判别规则:(2)多类:3种判别方法(函数、边界、规则)(A )第一种情况:(a)判别函数:M 类可有M 个判别函数(b) 判别边界:ωi (i=1,2,…,n )类与其它类之间的边界由 g i(x )=0确定(c)(B)第二种情况:(a)判别函数:有 M (M _1)/2个判别平面(b) 判别边界: (c )判别规则:(C)第三种情况:(a)判别函数: (b) 判别边界:g i (x ) =gj (x ) 或g i (x ) -gj (x ) =0(c)判别规则:5.什么是模式空间及加权空间,解向量及解区? (1)模式空间:由 构成的n 维欧氏空间;(2)加权空间:以为变量构成的欧氏空间; (3)解向量:分界面为H,W 与H 正交,W称为解向量; (4)解区:解向量的变动范围称为解区。

模式识别的重点内容归纳

模式识别的重点内容归纳定义:模式识别是指对表征事物或现象的各种形式的信息进行处理和分析,以对事物或现象进行描述、辨认、分类和解释的过程。

主要指用计算机来完成事物的自动识别工作。

机器识别,计算机识别,机器自动识别。

主要应用领域自动检测、字符识别,指纹识别,图像分析与处理、语音识别、通信、计算机辅助诊断、数据挖掘等学科。

模式识别研究目的利用计算机对客观对象进行分类,在一定的决策策略约束下,使识别的结果尽量与客观物体相符合。

模式识别的主要方法模板匹配、统计方法、句法方法、神经网络模式识别的分类监督分类:(判别分析Discriminant analysis)----将输入的“模式”归入已知的类别中。

非监督分类:(聚类clustering)-----将输入的“模式”归入到划分的未知类别中。

模式识别系统组成1,、图像的获取,通过传感器转化为电信号。

2、预处理包括A\D,二值化、图像平滑、变换、增强、恢复、滤波等,主要指图像处理。

3、特征提取和选择:在测量空间的原始数据通过变换获得在在特征空间中对被识别对象进行分类。

4、分类器设计:分类器设计主要功能是通过训练确定判决规则,使按此类判决规则分类时,错误率最低,将这些判决规则建成标准库。

5、分类决策:在特征空映分类本质的特征测量空间:原始数据组成的空间特征空间:分类识别赖以进行的空间模式表示:维数较高的测量空间->维数较低的特征空间分类决策:在特征空间中用模式识别方法把被识别对象归为某一类别基本做法:在样本训练集基础上确定某个判决规则,使得按这种规则对被识别对象进行分类所造成的错误识别率最小或引起的损失最小。

“模式识别”主要工作就是如何设计一个模式分类器。

其内容归结为:(1)特征提取;(2)学习/训练;(3)分类。

模式识别系统设计步骤1设计目标检测器;2特征选取;3分类器设计;4分类器训练;5性能评估设计周期数据收集(Data collection) 特征选择(Feature Choice)模型选择(Model Choice) 学习训练(Training)性能评价(Evaluation) 计算复杂性(Computational Complexity)。

模式识别复习重点总结

1.什么是模式及模式识别?模式识别的应用领域主要有哪些?模式:存在于时间,空间中可观察的事物,具有时间或空间分布的信息; 模式识别:用计算机实现人对各种事物或现象的分析,描述,判断,识别。

模式识别的应用领域:(1)字符识别;(2) 医疗诊断;(3)遥感; (4)指纹识别 脸形识别;(5)检测污染分析,大气,水源,环境监测; (6)自动检测;(7 )语声识别,机器翻译,电话号码自动查询,侦听,机器故障判断; (8)军事应用。

2.模式识别系统的基本组成是什么?(1) 信息的获取:是通过传感器,将光或声音等信息转化为电信息;(2) 预处理:包括A\D,二值化,图象的平滑,变换,增强,恢复,滤波等, 主要指图象处理;(3) 特征抽取和选择:在测量空间的原始数据通过变换获得在特征空间最能反映分类本质的特征;(4) 分类器设计:分类器设计的主要功能是通过训练确定判决规则,使按此类判决规则分类时,错误率最低。

把这些判决规则建成标准库; (5) 分类决策:在特征空间中对被识别对象进行分类。

3.模式识别的基本问题有哪些? (1)模式(样本)表示方法:(a )向量表示;(b )矩阵表示;(c )几何表示;(4)基元(链码)表示;(2)模式类的紧致性:模式识别的要求:满足紧致集,才能很好地分类;如果不满足紧致集,就要采取变换的方法,满足紧致集(3)相似与分类;(a)两个样本x i ,x j 之间的相似度量满足以下要求: ① 应为非负值② 样本本身相似性度量应最大 ③ 度量应满足对称性④ 在满足紧致性的条件下,相似性应该是点间距离的 单调函数(b)用各种距离表示相似性(4)特征的生成:特征包括:(a)低层特征;(b)中层特征;(c)高层特征 (5) 数据的标准化:(a)极差标准化;(b)方差标准化4.线性判别方法(1)两类:二维及多维判别函数,判别边界,判别规则 二维情况:(a )判别函数: ( ) (b )判别边界:g(x)=0; (cn 维情况:(a )判别函数: 也可表示为: 32211)(w x w x w x g ++=为坐标向量为参数,21,x x w 12211......)(+++++=n n n w x w x w x w x g X W x g T =)(为增值模式向量。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1.线性判别方法(1)两类:二维及多维判别函数,判别边界,判别规则 二维情况:(a )判别函数: ( ) (b )判别边界:g(x)=0; (cn 维情况:(a )判别函数:也可表示为:(b )判别边界:g 1(x ) =W TX =0(c )判别规则:(2)多类:3种判别方法(函数、边界、规则)(A)第一种情况:(a)判别函数:M 类可有M 个判别函数(b) 判别边界:ωi (i=1,2,…,n )类与其它类之间的边界由 g i (x )=0确定 (c)(B)第二种情况:(a)判别函数:有 M (M _ 1)/2个判别平面(b) 判别边界:(c)判别规则:(C)第三种情况:(a)判别函数: (b) 判别边界:g i (x ) =g j (x ) 或g i (x ) -g j (x ) =0(c)判别规则:32211)(w x w x w x g ++=为坐标向量为参数,21,x x w 12211......)(+++++=n n n w x w x w x w x g X W x g T =)(为增值模式向量。

,=为增值权向量,T n n T n n x x x x X w w w w W )1,...,,(),,...,,(21121+=+XW x g Tij ij =)(0)(=x g ij j i x g ij ≠⎩⎨⎧∈→<∈→>j ix 0x 0)(ωω当当权向量。

个判别函数的为第式中i w w w w W T in in i i i ),,,...,,(121+=XW x g K k =)(⎩⎨⎧∈=小,其它最大,当i Tki x X W x g ω)(2.分段线性判别方法1)基于距离:(1)子类,类判别函数 (2)判别规则(1)子类:把ωi 类可以分成l i 个子类:∴ 分成l 个子类。

子类判别函数:在同类的子类中找最近的均值 (2)判别规则: 这是在M 类中找最近均值。

则把x 归于ωj 类完成分类2)基于函数:(1)子类,类判别函数 (2)判别规则(1)子类类判别函数:对每个子类定义一个线性判别函数为:(2)判别规则:在各子类中找最大的判别函数作为此类的代表,则对于M 类,可定义M 个判别函数g i (x ),i =1,2,…..M,因此,决策规则3)基于凹函数的并:(1)析取范式,合取范式,凹函数判别规则析取范式:P=(L 11∧L 12∧…∧L 1m )∨…∨(L q 1∧L q 2∧…∧L q m )合取范式:Q= (L 11 ∨ L 12 ∨ … ∨ L 1m ) ∧ … ∧(L q 1 ∨ L q 2 ∨ … ∨ L q m ) 凹函数:P i =L i 1∧L i 2∧…∧L i m判别规则:设第一类有q 个峰,则有q 个凹函数。

即P=P 1∨P 2∨……∨P q3.非线性判别方法 (1)1ω集中,2ω分散),...,,(21li i i i ωωωω=li ll i x x g μ-==,...,2,1min )(Mi x g x g i j ,...,2,1),(min )(==子类的权向量。

为其中li l i l i l i w x w x g ω,)(=ji M i j x x g x g ω∈==则),(max )(,.....,2,1⎩⎨⎧=∈<=∈>=。

每个子类的判别函数数子类。

m j x q i x x w L ij ij ,...,2,1,,0,...,2,1,,021ωω⎩⎨⎧∈≤∈>21,0,0ωωx P x P 则则判别规则:协方差为均值,为其中:大小。

的大小,决定超平面的判别函数定义1111111121,)()()(:ωωμμμω∑∑---=-k x x k x g T 控制大小是个超球面由判别平面:判别规则:k 0)(,0)(,0)(121=⎩⎨⎧∈<∈>x g x x g x x g ωω(2)1ω, 2ω均集中4.分类器的设计(1)梯度下降法(迭代法):准则函数,学习规则(a )准则函数:J(W)≈J(W k )+ ▽J T (W- W k )+(W- W k )T D(W- W k )T /2其中D 为当W = W k 时 J(W)的二阶偏导数矩阵(b )学习规则:从起始值W 1开始,算出W 1处目标函数的梯度矢量▽J(W 1),则下一步的w 值为:W 2 = W 1-ρ1▽J(W 1) 其中W 1为起始权向量, ρ1为迭代步长,J(W 1) 为目标函数,▽J(W 1)为W 1处的目标函数的梯度矢量 在第K 步的时候W k+1 = W k -ρk ▽J(W k ) 最佳步长为ρk =||▽J||2/▽J T D ▽J 这就是梯度下降法的迭代公式。

(2)感知器法:准则、学习规则(批量,样本) (a )准则函数: 其中x 0为错分样本(b )学习规则:1.错误分类修正w k如w k T x≤0并且x ∈ω1 w k+1= w k +ρk x如w k Tx≥0并且x ∈ω2 w k+1= w k -ρk x 2.正确分类 ,w k 不修正 如w k T x >0并且x ∈ω1 如w k T x <0并且x ∈ω2 w k+1= w k(3)最小平方误差准则法(MSE 法)(非迭代法):准则、权向量解(a)准则函数: (b)权向量解:协方差,为均值,,为其中:,两个判别函数:都比较集中,那么定义,如果212112212,1)()()(ωωωωμμμωω∑∑=---=-i i i i T i i i i x x k x g 。

可用来调整二类错误率判别规则:判别平面方程:21212221212211111221111211221,,0,0)(0)()()(2)()()()(k k x x x g k k x x x x g x g x g T T T T ⎩⎨⎧∈<∈>=-+---+--=-=∑∑∑∑∑∑------ωωμμμμμμ()∑∈-=0)(X X X W W J T ()∑-==-==N i b iX i W T b XW e W J 1222||||||||)(()b X b X X X T W T +-==1()的伪逆(规范矩阵)称为其中X XXX T XT =-+1(4)韦—霍氏法(LMS 法)(迭代法):准则,学习规则 (a)准则函数: (b)学习规则: W 1任意 ,W k+1=W k +ρk (b k -W k T X k ) X kρk 随迭代次数k 而减少,以保证算法收敛于满意的W 值(5)何—卡氏法(H-K 法)(迭代法):准则,b ,W 的学习规则(a)准则: 它的解为:(b )b ,W 的学习规则:其中 c 为矫正系数,e k 为误差矢量,e k =XW k -b k 初始条件 W 1=X +b 1并且b 1>0 迭代时检测如果e k ≥0时,XW >b ,系统线性可分,迭代收敛 如果e k <0时,XW <b ,系统线性不可分,迭代不收敛(6)Fisher 分类法:准则函数的建立,W 权值计算,0W 的选择(a)准则函数的建立:投影样本之间的类间分离性越大越好,投影样本的总离散度越小越好。

即可表示为:其中S w 为类内散布矩阵, S b 为类间散布矩阵(b)W 权值计算:(c)W 0的选择 :()∑-==-==N i b iX i W T b XW e W J 1222||||||||)(k1K ρρ=取()∑-==-==N i b i X i W T b XW e W J 1222||||||||)(()bX b X XX T W T +-==1k k k b b b b δ+=+1前后两次迭代后,对的增量为其中b b k δ]|[][|11k K k k K k K K k e e X c W b X b X b b X b X W ++=+=+==+++++++δδ|]|[k k k e e C b +=δ()2212212||)(σσ+-=Y Y WJ Fisher 准则函数有所以WS W WS W )(w Tb T=W J ()X X S W W J w 211)(-=-求极值得对2.1210Y Y W +=2121212102122.2N N X W N X WN N N Y N Y N W TT ++=++=()()()∑∑∑===-+---+=N Y Y N Y Y N Y Y Y Y Y W k k k k k k 2211111211221121120)(.312w S S S =+()()1111T S X X X X X N =-∈-∑()()2222T S X X X X X N =-∈-∑()()1212Tb X X X X S =--Y ki 表示第i 类中第k 个样本的投影值N 1为ω1样本数 N 2为ω2样本数 (7)电位函数分类器:电位函数,累积电位的计算(a)电位函数:电位分布函数有如下三种形式:α为系数 x k 为某一特定点(b)累计电位的计算: K k+1(x)= K k (x)+r k+1K(x,x k )其中: x k+1∈ω1并且K k (x k+1)>0时 r k+1= 0 x k+1∈ω1并且K k (x k+1) ≤ 0时 r k+1= 1 x k+1∈ω2并且K k (x k+1)<0时 r k+1= 0 x k+1∈ω2并且K k (x k+1) ≥ 0时 r k+1= -15.1)二类问题的贝叶斯判别(1)判别函数的四种形式 (2)决策规则 (3)决策面方程(4)决策系统的结构(1)判别函数的四种形式:(2)判别规则:(3)决策面方程:g (x )=0}||||exp{- )K( 1.2k k x x XX -=α||||11)K( 2.2k k x x XX -+=α|||||||||sin |)K( 3.22k k k x x x x XX --=αα)(,)()(ln )()(ln )()()(,)()()()()()()(),()()()()()()(),()()()(12211221221121取对数方法似然比形式类条件概率密度后验概率ωωωωωωωωωωωωωωP P x P x P x g D P P x P x P x g C P x P P x P x g B x P x P x g A -=-=-=-=2112212112212122112121)()(ln )()(ln )()()()()()()()()()()()()()()(ωωωωωωωωωωωωωωωωωωωωω∈⇒<>=∈⇒<>∈⇒<>∈⇒<>x P P x P x P x g D x P P x P x P C x P x P P x P B x x P x P A2)多类问题的贝叶斯判别 (1)判别函数的四种形式 (2)决策规则 (3)决策面方程 (4)决策系统的结构(1)判别函数的四种形式:M 类有M 个判别函数g 1(x ), g 2(x ),…, g m (x ).(2)决策规则:另一种形式:(3)决策面方程:6.三种最小错误率贝叶斯分类器(正态分布):判别函数,判别规则,决策面方程 (1)第一种情况:各个特征统计独立,且同方差情况。