Greedy Algorithm贪心算法

贪婪算法是一种什么方法

贪婪算法是一种什么方法贪婪算法(Greedy Algorithm)是一种简单而经典的算法设计方法,通常用于解决优化问题。

贪婪算法每一步都采取当前情况下最优的选择,希望最终得到全局最优解。

本文将介绍贪婪算法的基本原理、应用场景以及一些经典的贪婪算法实例。

基本原理贪婪算法的基本原理是通过局部最优解来推导得到全局最优解。

在每一步中,贪婪算法选择当前看起来最好的选择,而不考虑之后的结果能否达到最优。

这种直观的选择策略有时可以给出全局最优解,但并非在所有问题中都成立。

贪婪算法的设计过程通常包含以下几个步骤:1. 定义问题的解空间和解集合,将问题转化成对这些解的选择和判定。

2. 根据问题的特点,设计选择策略,确定选择的标准。

3. 使用选择策略,逐步构建解,直到满足问题要求或无法继续选择。

需要注意的是,贪婪算法只能提供近似解,不能保证一定能得到最优解。

因此,在应用贪婪算法时需要仔细分析问题的性质,确定贪婪选择的合理性。

应用场景贪婪算法通常应用于具有贪婪选择性质的问题,即每一步都可以做出局部最优选择的问题。

这种性质常见于以下场景:最小生成树在图论中,最小生成树问题是指在一个连通无向图中找到一棵包含所有顶点且边权重之和最小的树。

典型的贪婪算法解决该问题的方法是普利姆算法(Prim's Algorithm)和克鲁斯卡尔算法(Kruskal's Algorithm)。

普利姆算法从一个起始顶点出发,每次选择与当前生成树连接的最短边对应的顶点,直到生成树包含所有顶点。

而克鲁斯卡尔算法则是从边集合中每次选择最小的边,同时保证不形成环,直到生成树包含所有顶点。

背包问题背包问题是在给定背包容量和一系列物品的重量和价值的情况下,如何选择物品放入背包中,使得背包中物品的总价值最大。

贪婪算法在背包问题的解决中有时也能给出较好的近似解。

一种典型的贪婪算法解决背包问题的方法是基于每个物品的单位价值(即单位重量所能获得的价值)来进行选择。

启发式算法分类

启发式算法分类

启发式算法可分为以下几类:

1. 贪心算法(Greedy Algorithm):每步选择当前最优解,有时能得到全局最优解,但并非万能算法。

2. 分治算法(Divide and Conquer):将一个大问题分割成若干个小的子问题,然后递归地求解,最后把子问题的解合并成原问题的解。

3. 动态规划算法(Dynamic Programming):把大问题分解成若干个小问题,先求解子问题,把子问题的解缓存起来,最后把子问题的解合并成原问题的解。

与分治算法不同的是,分治算法不能利用子问题的重叠性质,这就是动态规划算法的关键点。

4. 回溯算法(Backtracking):用于在搜索空间中找到所有或一个满足约束条件的解。

适用于解空间树有很多分支的问题,其实就是一种深度优先搜索。

5. 遗传算法(Genetic Algorithm):模拟生物进化过程的算法,用于寻找问题的最优解。

通过选择、交叉和变异等基因操作,生成一群解,并利用适应度函数对解进行排序,优胜劣汰,产生新的一代解。

6. 模拟退火算法(Simulated Annealing):模拟物理上的退火过程,用于在凸

函数或多峰函数的曲面寻找全局最优解。

7. 禁忌搜索算法(Tabu Search):用于处理约束条件存在的优化问题。

算法探索解空间,并避免回到已经探索过的解。

为了能在较短时间内找到最优解,禁忌搜索具有启发性,即在探索解空间时,依据之前的经验和搜索方向进行探索。

贪心算法的基本原理

贪心算法的基本原理贪心算法(Greedy Algorithm)是一种常用的算法思想,它在求解最优化问题时通常能够得到较好的近似解。

贪心算法的基本原理是:每一步都选择当前状态下的最优解,从而希望最终能够得到全局最优解。

在实际应用中,贪心算法常常用于解决一些最优化问题,如最小生成树、最短路径、任务调度等。

一、贪心算法的特点贪心算法具有以下特点:1. 简单:贪心算法通常比较简单,易于实现和理解。

2. 高效:贪心算法的时间复杂度通常较低,能够在较短的时间内得到结果。

3. 局部最优:每一步都选择当前状态下的最优解,但不能保证最终能够得到全局最优解。

4. 适用范围:贪心算法适用于一些特定类型的问题,如无后效性、最优子结构等。

二、贪心算法的基本原理贪心算法的基本原理可以概括为以下几个步骤:1. 初始状态:确定问题的初始状态,定义问题的输入和输出。

2. 状态转移:根据当前状态,选择局部最优解,并更新状态。

3. 筛选解:判断当前状态下是否满足问题的约束条件,若满足则保留该解,否则舍弃。

4. 终止条件:重复以上步骤,直至满足终止条件,得到最终解。

三、贪心算法的应用举例1. 找零钱:假设有 25、10、5、1 四种面额的硬币,需要找零 41 元,如何使得找零的硬币数量最少?贪心算法可以先选择面额最大的硬币,然后逐步选择面额较小的硬币,直至找零完毕。

2. 区间调度:给定一组区间,如何选择最多的互不重叠的区间?贪心算法可以先按照区间的结束时间排序,然后依次选择结束时间最早的区间,直至所有区间都被覆盖。

3. 最小生成树:在一个连通的带权无向图中,如何选择边使得生成树的权值最小?贪心算法可以按照边的权值从小到大排序,然后依次选择权值最小且不构成环的边,直至所有顶点都被连接。

四、贪心算法的优缺点1. 优点:贪心算法简单高效,适用于一些特定类型的问题,能够在较短的时间内得到近似最优解。

2. 缺点:贪心算法不能保证一定能够得到全局最优解,可能会出现局部最优解不是全局最优解的情况。

贪心算法程序设计

贪心算法程序设计贪心算法程序设计1. 什么是贪心算法贪心算法(Greedy Algorithm)是一种常见的算法思想,它在每一步选择中都采取当前状态下的最优选择,从而希望最终达到全局最优解。

贪心算法的核心思想是局部最优解能导致全局最优解。

2. 贪心算法的基本步骤贪心算法的基本步骤如下:1. 定义问题的优化目标。

2. 将问题分解成子问题。

3. 选择当前最优的子问题解,将子问题的解合并成原问题的解。

4. 检查是否达到了问题的优化目标,如果没有达到,则回到第二步,继续寻找下一个最优子问题解。

5. 在所有子问题解合并成原问题解后,得到问题的最优解。

3. 贪心算法的应用场景贪心算法的应用非常广泛,几乎可以用于解决各种优化问题。

以下几个常见的应用场景:1. 零钱找零问题:给定一定面额的纸币和硬币,如何找零使得所需纸币和硬币的数量最小?2. 区间调度问题:给定一些活动的开始时间和结束时间,如何安排活动使得可以办理的活动数量最大?3. 背包问题:给定一些具有重量和价值的物品,如何选择物品使得背包的总价值最大?4. 最小树问题:给定一个带权无向图,如何找到一棵树,使得它的边权之和最小?5. 哈夫曼编码问题:给定一组字符和相应的频率,如何构造一个满足最低编码长度限制的二进制编码?4. 贪心算法的优缺点贪心算法的优点是简单、高效,可以快速得到一个近似最优解。

而且对于一些问题,贪心算法能够得到全局最优解。

贪心算法的缺点在于它不一定能够得到全局最优解,因为在每一步只考虑局部最优解,无法回溯到之前的选择。

5. 贪心算法的程序设计在使用贪心算法进行程序设计时,通常需要以下几个步骤:1. 定义问题的优化目标。

2. 将问题分解成子问题,并设计子问题的解决方案。

3. 设计贪心选择策略,选择局部最优解。

4. 设计贪心算法的递推或迭代公式。

5. 判断贪心算法是否能够得到全局最优解。

6. 编写程序实现贪心算法。

6.贪心算法是一种常见的算法思想,它在每一步选择中都采取当前状态下的最优选择,从而希望最终达到全局最优解。

英语 算法 -回复

英语算法-回复如何使用贪心算法(Greedy Algorithm)解决最优装载问题(Knapsack Problem)。

【引言】贪心算法是一种基于局部最优选择的算法思想,可用于解决最优装载问题,即在给定容量的背包中,如何选择物品使其总价值最大。

本文将介绍如何使用贪心算法逐步解决最优装载问题,帮助读者更好地理解和应用贪心算法。

【步骤一:问题描述】首先,让我们明确最优装载问题的具体要求。

给定一个背包的容量C和N 个物品,每个物品有自己的重量w和价值v。

我们的目标是在不超过背包容量的情况下,选择物品放入背包,使得放入背包的物品的总价值最大。

【步骤二:贪心选择策略】贪心算法的核心思想是进行局部最优选择,以期望最终得到整体最优解。

对于最优装载问题,我们可以采用“单位重量价值最大”的贪心选择策略。

即优先选择单位重量价值最大的物品放入背包中,直至背包无法再放入物品。

【步骤三:算法实现】基于贪心选择策略,我们可以使用如下步骤实现算法:1. 根据物品的重量w和价值v,计算每个物品的单位重量价值vu = v / w。

2. 按照单位重量价值vu从大到小对物品进行排序。

3. 初始化当前背包的总价值val = 0和当前背包的剩余容量rc = C。

4. 逐个遍历排序后的物品列表:a. 如果当前物品的重量小于等于当前背包的剩余容量,则将该物品放入背包中,更新当前背包的总价值val和剩余容量rc。

b. 如果当前物品的重量大于当前背包的剩余容量,则放弃该物品,继续遍历下一个物品。

5. 返回最终的背包总价值val作为最优装载问题的解。

【步骤四:算法示例】接下来,我们通过一个简单的例子演示如何使用贪心算法解决最优装载问题。

假设背包容量C为10,有以下4个物品可供选择:物品1:重量w1 = 2,价值v1 = 5物品2:重量w2 = 3,价值v2 = 8物品3:重量w3 = 4,价值v3 = 9物品4:重量w4 = 5,价值v4 = 10按照贪心选择策略,首先计算每个物品的单位重量价值vu:物品1:vu1 = v1 / w1 = 5 / 2 = 2.5物品2:vu2 = v2 / w2 = 8 / 3 ≈2.67物品3:vu3 = v3 / w3 = 9 / 4 = 2.25物品4:vu4 = v4 / w4 = 10 / 5 = 2.0然后,按照单位重量价值vu从大到小对物品进行排序:物品2 > 物品1 > 物品3 > 物品4接下来,我们按照步骤三中的算法实现进行装载:初始化当前背包的总价值val = 0和剩余容量rc = 10。

贪心算法的概念和适用条件

贪心算法的概念和适用条件什么是贪心算法?贪心算法(Greedy Algorithm)是一种以局部最优解为导向的算法思想,通过每一步选择当前状态下的最佳操作来达到整体最优解的目标。

贪心算法的核心思想是每次都做出当前看来最优的选择,以期望能够达到整体的最优解。

贪心算法通常用于一些问题中,即每一步的选择只依赖于当前状态,而不考虑将来可能出现的情况。

贪心算法的适用条件:1. 贪心选择性质:贪心算法每一步都选择一个当前的最优解,此处的“最优”指的是局部最优。

这种最优选择可以确保问题能够被拆解,并且进行下一步求解。

2. 最优子结构性质:当问题的整体最优解能够通过局部最优解得到时,可以采用贪心算法求解。

这种情况下,问题的最优解可以由子问题的最优解推导出来。

3. 无后效性:贪心算法选择某一步操作时,只考虑当前状态,不会改变以前的操作,并且不关心未来的操作。

这种无后效性使得贪心算法在实际应用中操作简单、效率高。

贪心算法的基本步骤:1. 确定问题的局部最优解:贪心算法的核心是每一步都选择在当前情况下的最优解。

因此,需要确定问题如何拆解以及如何进行局部最优选择。

2. 定义问题的子问题:根据问题的最优子结构性质,将问题拆解为较小规模的子问题。

子问题应该是原问题的一个更小、更简单的实例。

3. 定义贪心选择策略:根据问题的特性,确定当前步骤下的最优选择策略。

这个选择应该是局部最优的,可以在不考虑子问题和整体未来状态的情况下得出。

4. 重复执行步骤2和3,直至求解出全局最优解。

贪心算法的优缺点:贪心算法具有简单易懂、快速高效的特点,适用于许多实际问题。

它可以避免穷举所有可能性,节省了计算时间。

此外,贪心算法常常能够找到近似最优解,尽管不一定能够保证全局最优解。

在实际问题中,近似最优解也往往可以满足实际需求。

然而,贪心算法并非适用于所有问题。

由于贪心算法只考虑当前状态的最优选择,而不考虑未来的影响,因此可能会导致局部最优解与全局最优解不一致。

算法的方法有哪些

算法的方法有哪些算法的方法有很多种,以下是其中一些常见的算法方法:1. 贪心算法(Greedy Algorithm):贪心算法是一种通过每一步的最优选择来达到整体最优解的算法。

贪心算法通常适用于问题具有最优子结构,即整体最优解可以通过局部最优解推导而来的情况。

2. 分治算法(Divide and Conquer):分治算法将问题分解为多个相同或相似的子问题,递归地求解每个子问题,然后合并子问题的解来得到原问题的解。

分治算法通常用于解决可以被分解为多个子问题的问题,并且子问题的解可以通过合并得到原问题的解。

3. 动态规划(Dynamic Programming):动态规划是将原问题划分成多个子问题,通过求解子问题来逐步推导出原问题的解。

动态规划通常适用于具有重叠子问题和最优子结构的问题。

4. 回溯算法(Backtracking):回溯算法是一种深度优先搜索的算法,通过回溯的方式穷举所有可能的解,并在搜索过程中剪枝以减少无效搜索。

回溯算法通常适用于在给定的搜索空间中寻找满足特定限制条件的所有解的问题。

5. 分支限界算法(Branch and Bound):分支限界算法通过在搜索过程中对搜索空间进行限制和剪枝,以减少无效搜索,从而找到最优解或满足特定条件的解。

分支限界算法通常适用于在搜索空间很大且问题有明确界限的情况下。

6. 迭代法(Iterative Method):迭代法通过反复执行相同的计算步骤,逐渐逼近原问题的解。

迭代法通常适用于解决连续函数逼近、方程求根等问题。

7. 枚举法(Enumeration Method):枚举法是一种逐一检查所有可能解的方法,通过枚举所有可能的解空间来找到问题的解。

枚举法通常适用于问题的解空间较小且可以通过穷举法找到所有解的情况。

8. 随机化算法(Randomized Algorithm):随机化算法通过引入随机性来解决问题,可用于加速搜索过程、解决概率性问题或从多个解中选择一个。

数据库查询优化的启发式算法与优化策略

数据库查询优化的启发式算法与优化策略数据库查询优化是提高数据库系统性能和响应速度的关键任务之一。

在大型数据库系统中,查询优化能够有效地减少查询时间,提高查询效率,从而提高整个系统的性能。

本文将介绍数据库查询优化的启发式算法和优化策略,以帮助数据库管理员和开发人员更好地优化数据库查询。

1. 启发式算法在数据库查询优化中的应用启发式算法是一种基于经验和启迪规则的计算方法,能够在较短时间内找到搜索空间中接近最优的解。

在数据库查询优化中,启发式算法可以帮助我们在有限的时间内寻找到接近最优的查询执行计划。

以下是几种常见的启发式算法:(1) 贪心算法(Greedy Algorithm):该算法基于最佳资源利用准则,通过逐步选择最佳操作,直到找到一个近似最优解。

在数据库查询优化中,贪心算法可以优化选择最佳连接顺序的问题。

(2) 遗传算法(Genetic Algorithm):该算法模拟了自然界中的进化过程,通过选择、变异和交叉等操作,在个体之间产生新的解,并逐代演化,从而找到近似最优解。

在数据库查询优化中,遗传算法可以应用于选择最佳执行计划的问题。

(3) 禁忌搜索算法(Tabu Search Algorithm):该算法主要用于解决在搜索过程中出现的局部最优问题。

通过记录和禁忌一些解集合,在搜索过程中避免陷入局部最优解,从而更容易找到全局最优解。

在数据库查询优化中,禁忌搜索算法可以用于优化查询语句中的关联谓词问题。

2. 数据库查询优化的策略除了启发式算法,还有一些常见的优化策略可以应用于数据库查询优化。

下面是几种常见的优化策略:(1) 索引优化:合理创建索引可以大幅提高查询效率。

在数据库查询优化中,通过根据数据库中的查询频率和模式创建合适的索引,可以减少磁盘IO和CPU消耗,提高查询性能。

(2) 分区优化:将大型表分割成更小的物理存储单元可以提高查询性能。

通过将数据按照某种划分策略存储在不同的存储设备上,可以减少查询时的磁盘IO次数,提高查询效率。

易语言 贪心算法

易语言贪心算法贪心算法(Greedy Algorithm)是一种常用的算法思想,它在每一步选择中都采取当前状态下最优的选择,从而希望最终能够获得全局最优解。

本文将介绍贪心算法的基本概念、特点以及应用,并通过一些具体的例子来进一步说明其实现过程和效果。

一、贪心算法的基本概念贪心算法是一种基于贪心策略的求解问题的方法。

它通过不断地做出局部最优选择,来达到全局最优的目标。

贪心算法的基本思想是每一步都选择当前状态下最优的解决方案,而不考虑其对后续步骤的影响。

这种局部最优的选择最终希望能够达到全局最优的结果。

二、贪心算法的特点1. 简单易实现:贪心算法的实现相对简单,不需要复杂的数据结构和算法;同时,贪心算法的思想也较为直观,容易理解和应用。

2. 效率高:相比于其他算法,贪心算法通常具有较高的执行效率,时间复杂度较低。

3. 局限性:贪心算法只关注当前的最优解,而不考虑其对后续步骤的影响,因此可能会得到次优解或不正确的解。

三、贪心算法的应用贪心算法在实际问题中有着广泛的应用。

下面通过几个具体的例子来说明贪心算法的应用过程。

1. 找零问题:假设有一些零钱,如1元、5元、10元、20元、50元和100元,要用最少的零钱凑出一个给定的金额。

贪心算法可以选择面值最大的零钱来凑,然后再选择次大面值的零钱,依次类推,直到凑出给定金额为止。

2. 区间覆盖问题:假设有一些区间,需要选择尽可能少的区间来覆盖给定的目标区间。

贪心算法可以选择结束时间最早的区间,然后排除与该区间重叠的其他区间,依次类推,直到覆盖所有目标区间。

3. 集合覆盖问题:假设有一些需要覆盖的元素,以及一些集合,每个集合包含一些元素,需要选择尽可能少的集合来覆盖所有元素。

贪心算法可以选择包含最多未覆盖元素的集合,然后排除已覆盖的元素,依次类推,直到覆盖所有元素。

四、贪心算法的实现过程贪心算法的实现过程通常包括以下几个步骤:1. 确定问题的最优子结构性质。

2. 建立数学模型来描述问题。

c++贪心算法经典例题

c++贪心算法经典例题和详解贪心算法(Greedy Algorithm)是一种优化问题解决方法,其基本思想是每一步都选择当前状态下的最优解,以期望达到全局最优解。

贪心算法的特点是每一步都要做出一个局部最优的选择,而这些局部最优选择最终构成了全局最优解。

下面是一个经典的贪心算法例题以及详解:例题:活动选择问题(Activity Selection Problem)假设有一个需要在同一时段使用同一个资源的活动集合,每个活动都有一个开始时间和结束时间。

设计一个算法,使得能够安排最多数量的互不相交的活动。

# 输入:-活动的开始时间数组`start[]`。

-活动的结束时间数组`end[]`。

# 输出:-选择的互不相交的活动的最大数量。

# 算法详解:1. 首先,将活动按照结束时间从小到大排序。

2. 选择第一个活动,并将其加入最终选择的集合中。

3. 对于剩下的活动,选择下一个结束时间最早且与前一个活动不冲突的活动。

4. 重复步骤3,直到所有活动都被选择。

```cpp#include <iostream>#include <algorithm>#include <vector>using namespace std;// 定义活动结构体struct Activity {int start, end;};// 比较函数,用于排序bool compareActivities(Activity a, Activity b) {return a.end < b.end;}// 贪心算法解决活动选择问题void activitySelection(vector<Activity>& activities) {// 按照结束时间排序sort(activities.begin(), activities.end(), compareActivities);// 第一个活动总是被选中cout << "Selected activity: (" << activities[0].start << ", " << activities[0].end << ")" << endl;// 选择其余活动int lastSelected = 0;for (int i = 1; i < activities.size(); i++) {// 如果当前活动的开始时间大于等于上一个选择的活动的结束时间,则选择该活动if (activities[i].start >= activities[lastSelected].end) {cout << "Selected activity: (" << activities[i].start << ", " << activities[i].end << ")" << endl;lastSelected = i;}}}int main() {vector<Activity> activities = {{1, 2}, {3, 4}, {0, 6}, {5, 7}, {8, 9}, {5, 9}};cout << "Activities before sorting:" << endl;for (const Activity& activity : activities) {cout << "(" << activity.start << ", " << activity.end << ") ";}cout << endl;activitySelection(activities);return 0;}```在这个例子中,我们首先定义了一个活动的结构体`Activity`,然后编写了一个比较函数`compareActivities` 用于排序。

贪心算法在图像处理中的应用

贪心算法在图像处理中的应用一、引言随着计算机技术的飞速发展,图像处理技术已经成为了现代计算机科学的一个研究热点。

在图像处理领域中,贪心算法被广泛应用于诸如全景拼接、物体跟踪、边缘检测等图像处理应用中,具有较高的实时性和较好的性能表现。

本文将就贪心算法在图像处理领域的应用进行阐述,以期能够增进大家对于贪心算法在图像处理中的认知。

二、贪心算法的基本概念贪心算法(Greedy Algorithm)是一种基于贪心策略的算法,它在每一步都采取当前最优解,最终得到的结果在某些情况下并不一定是全局最优解。

贪心算法通常用于优化问题中,因为优化问题通常可以转化为通过寻找局部最优解获得全局最优解的问题。

贪心算法的基本思想可以概括为:从问题的某个初始解出发,逐步地进行选择,每进行一步选择,就用贪心策略来选择当前最优的解,确保每一步都是最优的选择,以求得最终问题的最优解。

三、贪心算法在图像处理中的应用1. 全景拼接全景拼接是将多张图像拼接为一张图片的过程,其对于图像的平滑过渡和无缝拼接至关重要。

常见的全景拼接算法有图像匹配算法、图像合并算法等。

其中,贪心算法是一种有效的实现方案。

在使用贪心算法进行全景拼接时,我们可以将每张图片划分成若干个局部区域,然后使用贪心算法对每个局部区域进行匹配和拼接,最终得到一张完整的拼接图像。

2. 物体跟踪物体跟踪是指在视频信号中持续追踪物体的过程,其在视频监控、自动驾驶等领域中具有重要的应用价值。

常见的物体跟踪算法有基于颜色分割的算法、基于纹理和形状分割的算法等。

其中,贪心算法可以结合这些算法进行优化。

例如,我们可以使用贪心算法对物体进行预处理,将其划分为若干个局部区域,然后使用颜色、纹理等特征对每个局部区域进行分类和跟踪,以实现更加准确的物体跟踪。

3. 边缘检测边缘检测是指在图像处理中检测出图像中所有不同区域之间的边界线。

常见的边缘检测算法有多种,如Sobel算子、Canny算子等。

其中,贪心算法可以对这些算子进行优化,以提高边缘检测的效率和准确性。

二维装箱问题的算法

二维装箱问题(2D Bin Packing Problem)是一个经典的组合优化问题,它的目标是将一系列的矩形物品放入最小数量的容器中,同时满足每个容器的尺寸限制。

这个问题在实际应用中有很多场景,如物流、仓储、广告排版等。

解决二维装箱问题的算法有很多,以下是一些常见的算法:1. 贪心算法(Greedy Algorithm):贪心算法是一种简单且易于实现的算法。

它的基本思想是在每一步都选择当前最优的解决方案。

对于二维装箱问题,贪心算法可以选择每次放入面积最大的矩形,直到无法再放入为止。

然后开始新的一行,重复这个过程。

贪心算法的缺点是可能得不到最优解,因为它没有考虑到后续的放置情况。

2. 启发式算法(Heuristic Algorithm):启发式算法是一种基于经验的算法,它通过一定的规则来指导搜索过程。

对于二维装箱问题,启发式算法可以根据矩形的长宽比、面积等因素来确定放置的顺序和位置。

启发式算法通常能够得到较好的解,但不一定是最优解。

3. 遗传算法(Genetic Algorithm):遗传算法是一种模拟自然选择和遗传机制的全局搜索算法。

它通过不断地进行交叉、变异和选择操作,来生成新的解决方案。

对于二维装箱问题,遗传算法可以用于优化矩形的放置顺序和位置,以找到更优的解。

4. 模拟退火算法(Simulated Annealing):模拟退火算法是一种基于概率的全局优化算法。

它通过在一定的温度下随机搜索解空间,并在温度降低时逐渐收敛到最优解。

对于二维装箱问题,模拟退火算法可以用于优化矩形的放置顺序和位置,以找到更优的解。

5. 粒子群优化算法(Particle Swarm Optimization):粒子群优化算法是一种基于群体智能的全局优化算法。

它通过模拟鸟群觅食行为,来寻找最优解。

对于二维装箱问题,粒子群优化算法可以用于优化矩形的放置顺序和位置,以找到更优的解。

6. 线性规划(Linear Programming):线性规划是一种数学优化方法,它可以用于求解具有线性约束和目标函数的问题。

c++贪心算法经典例题

c++贪心算法经典例题摘要:一、贪心算法简介1.贪心算法的定义2.贪心算法的特点3.贪心算法适用的问题类型二、C++贪心算法经典例题1.背包问题a.0-1 背包问题b.完全背包问题c.动态背包问题2.最小生成树a.Kruskal 算法b.Prim 算法3.单源点最短路径a.Dijkstra 算法b.Floyd-Warshall 算法4.最长公共子序列a.贪心算法实现b.动态规划实现正文:一、贪心算法简介贪心算法(Greedy Algorithm)是一种求解最优解的方法。

它是在对问题求解时,总是做出在当前看来是最好的选择。

贪心算法并不追求整体最优解,只希望得到较为满意的解。

贪心算法的关键是贪心策略的选择,必须满足无后效性,即某个状态以后的过程不会影响以前的状态,只与当前状态有关。

贪心算法适用的问题类型包括背包问题、最小生成树、单源点最短路径和最长公共子序列等。

二、C++贪心算法经典例题1.背包问题背包问题(Knapsack Problem)是一种典型的贪心算法问题。

它描述的是有一个背包,有一定的容量,需要装载若干物品,每个物品有一定的价值和重量,要求在不超过背包容量的前提下,如何选择装载物品使得背包中的物品总价值最大。

背包问题可以分为0-1 背包问题、完全背包问题和动态背包问题。

2.最小生成树最小生成树(Minimum Spanning Tree,简称MST)是一种图论中的算法问题。

给定一个加权连通图,求解一个生成树,使得该生成树中所有边的权值之和最小。

最小生成树的经典算法有Kruskal 算法和Prim 算法。

3.单源点最短路径单源点最短路径(Single Source Shortest Path)问题是在一个图中,从源点出发到其他所有顶点的最短路径。

经典算法包括Dijkstra 算法和Floyd-Warshall 算法。

4.最长公共子序列最长公共子序列(Longest Common Subsequence,简称LCS)问题是求两个序列中最长的公共子序列。

信息学竞赛常用算法

信息学竞赛常用算法一、贪心算法(Greedy Algorithm)贪心算法是一种简单而直观的算法,它的核心思想是每一步都选择最优解,希望最终的结果也能最优。

贪心算法常常用于求解最小生成树、最短路径、背包问题等。

例如,在最小生成树问题中,贪心算法可以根据边的权重选择最小的边,直到生成树包含所有节点。

二、动态规划(Dynamic Programming)动态规划是一种通过将问题分解为子问题,并存储子问题的解来解决复杂问题的方法。

它常常用于求解最长公共子序列、最大子数组和、背包问题等。

动态规划的核心思想是,通过计算和存储子问题的解,避免重复计算,从而提高算法的效率。

三、深度优先(Depth First Search)深度优先是一种用于遍历或图或树的算法,其核心思想是尽可能深入地一个分支,直到无法继续为止,然后回溯到上一个节点,继续其他分支。

深度优先可以用于求解拓扑排序、连通分量、可达性等问题。

四、广度优先(Breadth First Search)广度优先是一种用于遍历或图或树的算法,其核心思想是从根节点开始,依次与当前节点相邻的节点,直到找到目标节点为止。

广度优先可以用于求解最短路径、连通性、迷宫问题等。

五、并查集(Union Find)并查集是一种用于管理元素间的等价关系的数据结构。

并查集主要包括两个操作:查找和合并。

查找操作用于确定元素所属的集合,合并操作用于将两个元素所属的不同集合合并为一个集合。

并查集常常用于求解连通性问题、最小生成树问题等。

六、最小生成树(Minimum Spanning Tree)最小生成树是一种用于连接一个连通图的所有节点,并且边的权重之和最小的树形结构。

最小生成树算法主要包括Prim算法和Kruskal算法。

Prim算法是一种贪心算法,通过选择最小权重的边进行扩展,直到生成树包含所有节点。

Kruskal算法通过不断添加权重最小的边,直到生成树包含所有节点。

七、最短路径(Shortest Path)最短路径是一种从起点到终点的路径中,总权重最小的路径。

贪心算法总结

贪心算法总结什么是贪心算法?贪心算法(Greedy Algorithm)是一种用于求解优化问题的常见算法,其核心思想是在每一步都选择当前最优解,希望最终能够得到全局最优解。

贪心算法在每一步仅考虑局部最优,而不关心全局最优,因此它的计算速度较快。

然而,由于贪心算法没有考虑全局,在某些情况下可能无法得到最优解。

贪心算法并不适用于所有的问题,只适用于一些特殊的问题,例如背包问题、最小生成树问题等。

在实际应用中,需要根据具体问题的特点来判断是否可以使用贪心算法来解决。

贪心算法的基本思路贪心算法的基本思路可以概括为以下几步:1.确定最优解的性质:首先要确定在每一步选择中,能够得到局部最优解。

2.构造贪心选择:根据最优解的性质,每一步都做出一个贪心选择,选择能够获得当前最大或最小收益的方案。

3.确定限制条件:确定问题的限制条件,包括物品的容量、时间限制等。

4.根据限制条件,进行剪枝策略:如果某种选择在限制条件下无法满足要求,则需要进行剪枝,排除该选择。

5.循环执行贪心选择,直到问题得到解决。

贪心算法的优缺点贪心算法具有以下优点:•计算速度快:贪心算法在每一步只考虑局部最优解,不需要对全局进行搜索,因此计算速度较快。

•算法思路简单:贪心算法的思路相对简单,易于理解和实现。

•适用范围广:贪心算法适用于一些特殊问题,如最短路径、最小生成树等。

然而,贪心算法也存在一些缺点:•可能无法得到最优解:由于贪心算法仅考虑局部最优解,而不关心全局最优解,因此可能无法得到最优解。

•需要满足贪心选择性质:贪心算法要求问题具有贪心选择性质,即每一步都能够得到局部最优解。

如果问题不具备这个性质,贪心算法可能不适用。

贪心算法的应用场景贪心算法适用于一些特殊的问题,以下是一些常见的应用场景:1. 最短路径问题最短路径问题是指在一个加权有向图中,找出从一个顶点到另一个顶点的最短路径。

贪心算法可以用来解决一些简单的最短路径问题,如Dijkstra算法。

自然语言处理中的decoding的常见方法的原理及优缺点

自然语言处理中的decoding的常见方法的原理及优缺点自然语言处理(NaturalLanguageProcessing,NLP)是计算机科学与语言学的交叉学科,它研究计算机如何处理和理解自然语言。

在NLP中,decoding是一个非常重要的环节,它的作用是根据上下文信息,将一段文本转换成另一种形式,比如翻译、摘要等。

本文将介绍在NLP中decoding的常见方法及其原理及优缺点。

1. 贪心算法(Greedy Algorithm)贪心算法是一种简单的解码方法,它的核心思想是每一步都选择最优的解,然后不断地累加到最终结果。

在NLP中,贪心算法常用于序列标注和机器翻译等任务中。

例如,在机器翻译中,贪心算法会根据当前输入的单词,选择概率最高的译文作为输出结果。

由于贪心算法只考虑当前步骤的最优解,因此其效率较高,但是其无法保证全局最优解,容易陷入局部最优解。

2. 束搜索(Beam Search)束搜索是一种基于贪心算法的优化方法。

它在解码过程中,保留多个备选解,称之为“束”。

每次选择最可能的k个备选解作为下一步的备选解,并在这些备选解中选择最优的解作为当前的输出结果。

束搜索的优点是可以保证在一定程度上找到全局最优解,但是k值的大小会影响搜索效率和解码质量。

3. 生成式模型(Generation Model)生成式模型是利用概率模型生成目标序列的方法。

在NLP中,生成式模型常用于语言生成和机器翻译等任务中。

例如,在机器翻译中,生成式模型会利用译文单词的概率模型,生成最优的输出结果。

由于生成式模型考虑了全局的概率信息,因此其能够得到更加准确的结果。

但是,生成式模型的缺点是计算复杂度较高,且难以处理长文本的概率。

4. 判别式模型(Discriminative Model)判别式模型是基于给定特征条件下,预测目标序列的方法。

在NLP中,判别式模型常用于序列标注和情感分析等任务中。

例如,在情感分析中,判别式模型会根据文本的特征,预测文本的情感极性。

贪心算法总结

贪⼼算法总结简介贪⼼算法(英⽂:greedy algorithm),是⽤计算机来模拟⼀个“贪⼼”的⼈做出决策的过程。

这个⼈⼗分贪婪,每⼀步⾏动总是按某种指标选取最优的操作。

⽽且他⽬光短浅,总是只看眼前,并不考虑以后可能造成的影响。

可想⽽知,并不是所有的时候贪⼼法都能获得最优解,所以⼀般使⽤贪⼼法的时候,都要确保⾃⼰能证明其正确性。

本⽂主要介绍,在解决诸多贪⼼算法的问题之后的⼼得。

常⽤场景最常见的贪⼼算法分为两种。

「我们将 XXX 按照某某顺序排序,然后按某种顺序(例如从⼩到⼤)选择。

」。

「我们每次都取 XXX 中最⼤/⼩的东西,并更新 XXX。

」(有时「XXX 中最⼤/⼩的东西」可以优化,⽐如⽤优先队列维护)第⼀种是离线的,先处理后选择,第⼆种是在线的,边处理边选择。

常见的出题背景为:确定某种最优组合(硬币问题)区间问题(合理安排区间)字典序问题最值问题A最优组合硬币问题是贪⼼算法⾮常经典的题⽬,关于最优组合问题,我认为主要分为两种类型:简单 -- 直接排序之后按照某种策略选取即可复杂 -- 除了按照贪⼼策略外,还需要进⾏某些处理或者模拟硬币问题硬币问题有1元、5元、10元、50元、100元、500元的硬币各C1、C5、C10、C50、C100、C500枚。

现在要⽤这些硬币来⽀付A元,最少需要多少枚硬币?假设本题⾄少存在⼀种⽀付⽅法。

0≤C1、C5、C10、C50、C100、C500≤1090≤A≤109本题是上述说的简单类型的题⽬,简⽽⾔之要使得硬币最少,则优先使⽤⼤⾯额的硬币。

因此本题的解法便⾮常清晰了,只需要从后往前遍历⼀遍即可(默认为硬币已经按⾯额⼤⼩进⾏排序)const int V[6] = {1, 5, 10, 50, 100, 500};int A, C[6]; // inputvoid solve(){int ans(0);for (int i = 5; i >= 0; -- i){int t = min(A / V[i], C[i]);A -= t * V[i];ans += t;}cout << ans << '\n';}零花钱问题POJ3040 AllowanceDescriptionAs a reward for record milk production, Farmer John has decided to start paying Bessie the cow a small weekly allowance. FJ has a set of coins in N (1 <= N <= 20) different denominations, where each denomination of coin evenly divides the next-larger denomination (e.g., 1 cent coins, 5 cent coins, 10 cent coins, and 50 cent coins).Using the given set of coins, he would like topay Bessie at least some given amount of money C (1 <= C <= 100,000,000) every week.Please help him ompute the maximum number of weeks he can pay Bessie.Input* Line 1: Two space-separated integers: N and C* Lines 2..N+1: Each line corresponds to a denomination of coin and contains two integers: the value V (1 <= V <= 100,000,000) of the denomination, and the number of coins B (1 <= B <= 1,000,000) of this denomation in Farmer John's possession.Output* Line 1: A single integer that is the number of weeks Farmer John can pay Bessie at least C allowanceSample Input3 610 11 1005 120Sample Output111这题的题⽬⼤意是:农场主每天都要给贝西⾄少为C的津贴。

供应链管理中的订单分配算法使用方法

供应链管理中的订单分配算法使用方法随着电子商务的快速发展,供应链管理已经成为企业不可或缺的一部分。

在供应链管理中,订单分配算法是一个关键的步骤,它能够有效地分配订单给不同的供应商,并确保订单的高效处理和交付。

本文将介绍供应链管理中常用的订单分配算法以及它们的使用方法。

1. 贪心算法(Greedy Algorithm)贪心算法是一种简单而高效的订单分配算法。

它的基本思想是优先选择最有利可得的供应商来分配订单。

贪心算法的优点是简单易实现,并且在大多数情况下能够得到较好的结果。

使用贪心算法进行订单分配时,需要按照一定的优先级规则选择供应商,如价格、可靠性、交货时间等,并根据订单的需求量进行合理的分配。

2. 动态规划算法(Dynamic Programming)动态规划算法是一种更为复杂但优秀的订单分配算法。

它通过将大问题拆分成子问题,并利用已解决的子问题的解来求解更复杂的问题。

使用动态规划算法进行订单分配时,首先需要建立订单和供应商之间的关系模型,然后通过递归地求解子问题来得到最优解。

动态规划算法的优点是能够找到全局最优解,但缺点是计算复杂度较高,需要较长的运行时间。

3. 遗传算法(Genetic Algorithm)遗传算法是一种基于自然遗传和进化理论的优化算法。

在订单分配中,遗传算法通过模拟适者生存和优胜劣汰的自然选择过程,不断优化订单的分配结果。

使用遗传算法进行订单分配时,首先需要利用基因表示供应商的性能指标,如价格、质量、可靠性等,然后通过交叉、变异等操作来产生新的供应商组合,最后通过适应度函数评价每个供应商组合的优劣并选择最优解。

4. 线性规划算法(Linear Programming)线性规划算法是一种常用的优化算法,可以用于解决供应链中的订单分配问题。

它通过建立一组线性方程和约束条件来找到最优的订单分配方案。

线性规划算法的优点是可以在较短的时间内求解最优解,但缺点是对于非线性问题的求解效果较差。

算法导论-贪心算法

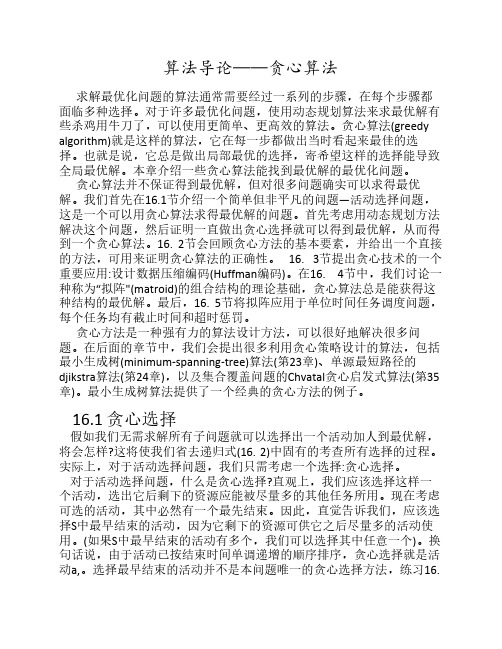

算法导论——贪心算法求解最优化问题的算法通常需要经过一系列的步骤,在每个步骤都面临多种选择。

对于许多最优化问题,使用动态规划算法来求最优解有些杀鸡用牛刀了,可以使用更简单、更高效的算法。

贪心算法(greedy algorithm)就是这样的算法,它在每一步都做出当时看起来最佳的选择。

也就是说,它总是做出局部最优的选择,寄希望这样的选择能导致全局最优解。

本章介绍一些贪心算法能找到最优解的最优化问题。

贪心算法并不保证得到最优解,但对很多问题确实可以求得最优解。

我们首先在16.1节介绍一个简单但非平凡的问题—活动选择问题,这是一个可以用贪心算法求得最优解的问题。

首先考虑用动态规划方法解决这个问题,然后证明一直做出贪心选择就可以得到最优解,从而得到一个贪心算法。

16. 2节会回顾贪心方法的基本要素,并给出一个直接的方法,可用来证明贪心算法的正确性。

16. 3节提出贪心技术的一个重要应用:设计数据压缩编码(Huffman编码)。

在16. 4节中,我们讨论一种称为“拟阵"(matroid)的组合结构的理论基础,贪心算法总是能获得这种结构的最优解。

最后,16. 5节将拟阵应用于单位时间任务调度问题,每个任务均有截止时间和超时惩罚。

贪心方法是一种强有力的算法设计方法,可以很好地解决很多问题。

在后面的章节中,我们会提出很多利用贪心策略设计的算法,包括最小生成树(minimum-spanning-tree)算法(第23章)、单源最短路径的djikstra算法(第24章),以及集合覆盖问题的Chvatal贪心启发式算法(第35章)。

最小生成树算法提供了一个经典的贪心方法的例子。

16.1 贪心选择假如我们无需求解所有子问题就可以选择出一个活动加人到最优解,将会怎样?这将使我们省去递归式(16. 2)中固有的考查所有选择的过程。

实际上,对于活动选择问题,我们只需考虑一个选择:贪心选择。

对于活动选择问题,什么是贪心选择?直观上,我们应该选择这样一个活动,选出它后剩下的资源应能被尽量多的其他任务所用。

贪心算法与背包问题的求解策略

贪心算法与背包问题的求解策略贪心算法(Greedy Algorithm)是一种常用的算法策略,用于求解最优化问题。

背包问题(Knapsack Problem)则是一个经典的组合优化问题,涉及在限制条件下如何选择物品以最大化价值。

本文将探讨贪心算法在解决背包问题时的应用与求解策略。

一、背包问题简介背包问题是一个常见的动态规划问题,其基本形式为:有一个背包,容量为C(常为非负整数),有n个物品,每个物品的重量为w[i],价值为v[i]。

现在需要从这些物品中选择一部分装入背包,使得在满足背包容量的限制下,所装入物品的总价值最大化。

二、贪心算法的基本思想贪心算法的基本思想是,每一步都选择当前情况下的最优解,希望通过每一步的最优解最终达到全局最优解。

然而,贪心算法并不是适用于所有问题的通用解决方法,它适用于一些特定的问题,如背包问题。

三、贪心算法在背包问题中的应用在背包问题中,常见的贪心策略有两种:按价值密度排序和按重量排序。

下面将分别介绍这两种贪心策略的具体应用。

1. 按价值密度排序按价值密度排序是指将物品按照单位重量的价值从大到小进行排序。

具体操作步骤如下:(1)计算每个物品的价值密度,即v[i]/w[i]。

(2)按照价值密度从大到小的顺序对物品进行排序。

(3)从价值密度最高的物品开始,依次将物品放入背包,直至背包容量达到上限或无物品可放。

2. 按重量排序按重量排序是指将物品按照重量从小到大进行排序。

具体操作步骤如下:(1)按照物品的重量从小到大进行排序。

(2)从重量最小的物品开始,依次将物品放入背包,直至背包容量达到上限或无物品可放。

四、贪心算法的优缺点贪心算法相比其他算法具有简单、高效的特点。

然而,贪心算法并不是万能的,它在某些情况下可能无法得到最优解。

例如,在背包问题中,贪心算法按照价值密度排序的策略并不能保证一定能得到最优解,因为可能存在某些物品的价值密度很高,但重量也很大,无法放入背包。

五、贪心算法的应用场景贪心算法常被应用于一些特定的问题领域,如最小生成树、调度问题、图着色等。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Greedy Algorithms Greedy AlgorithmsDr. Zhenyu HeAutumn 2008116Greedy Algorithms z16 Greedy AlgorithmsSimilar to dynamic programming. Used for optimization problems.2zzOptimization problems typically go through a sequence of steps, with a set of choices at each step.For many optimization problems, using dynamic programming to determine z y p p ,g y p g g the best choices is overkill (过度的杀伤威力).Greedy Algorithm: Simpler, more efficient16Greedy Algorithms z 16 Greedy AlgorithmsGreedy algorithms (GA) do not always yield 3y g ()y yoptimal solutions, but for many problems they do.161the activity selection problem 16.1, the activity-selection problem (活动安排)16.2, basic elements of the GA; knapsack prob. (贪婪算法的基本特征;背包问题)16.3, an important application: the design of data compression (Huffman) codes. (哈夫曼编码)16.5, unit-time tasks scheduling 6.5,u t t e tas s sc edu g (有限期作业调度)16Greedy Algorithms z 16 Greedy AlgorithmsThe greedy method is quite powerful and works 4g y q pwell for a wide range of problems:minimum-spanning-tree algorithms (Chap 23) minimum-spanning-tree algorithms (Chap 23)(最小生成图)h t t th f i l (Ch 24) shortest paths from a single source (Chap 24)(最短路径)set-covering heuristic (Chap 35).(集合覆盖)…First example:Activity Selection First example: Activity Selection Horseback Riding (骑马)5Canoeing (独木舟)Surfing (冲浪)Driving Swimming Rock Climbing (攀岩)z 91011121314151617How to make an arrangement to have the more activities?S1Sh i i fi 短优原S1. Shortest activity first (最短活动优先原则)Swimming , DrivingS2First starting activity first S2. First starting activity first (最早开始活动优先原则)Horseback Riding , DrivingS3. First finishing activity first (最早结束活动优先原则)Swimming , Rock Climbing , Surfing161An activity selection problem 16.1 An activity-selection problem 6i i i iz n activities require exclusive use of a common resource.Example, scheduling the use of a classroom.playground p e,sc edu g e use o c ss oo (n 个活动,1 项资源,任一活动进行时需唯一占用该资源)Set of activities S = {a 1, a 2, . . . , a n }. a i needs resource during period [s i , f i ), which is a half-open interval, where s i is start time and f i is finish time.Goal:Select the largest possible set of nonoverlapping (mutually Goal: Select the largest possible set of nonoverlapping (mutually compatible) activities. (安排一个活动计划,使得相容的活动数目最多)Other objectives: Maximize income rental fees , …j ,161An activity selection problemz16.1 An activity-selection problemn activities require exclusive use of a common resource.7Set of activities S = {a1, a2, . . . , a n}a i needs resource during period [s i , f i )l S fi i iz Example: S sorted by finish time:Maximum-size mutuallyMaximum size mutuallycompatible set:{a1 , a3 , a6 , a,a3,a6,a8}.Not unique: also{a2 , a5 , a7 , a9}.16.1.1 Optimal substructure of activity selection Space of subproblems8z S ij = {a k ∈S : f i ≤ s k < f k ≤ s j }= activities that start after a i finishes & finish before a j starts zActivities in S ij are compatible with all activities that finish by f i (完成时间早于f i 的活动), and ll ti iti th t t t li th z all activities that start no earlier than s j .To represent the entire problem, add fictitious activities:a 0=[0);1=[“ z0 = [﹣∞, 0); a n+1 = [∞, “∞+1”)We don’t care about ﹣∞ in a 0 or “∞+1” in a n+1.Then S = S 0,n+1. Range for S ij is 0 i, j n + 1.,g j ≤,j ≤16.1.1 Optimal substructure of activity selection Space of subproblems 9zz p pS ij = {a k ∈S : f i ≤ s k < f k ≤ s j }Assume that activities are sorted by monotonically increasing finish time Assume that activities are sorted by monotonically increasing finish time (以结束时间单调增的方式对活动进行排序)f 0 ≤ f 1 ≤ f 2 ≤ · · · ≤ f n < f n+1 (if i ≤ j, then f i ≤ f j )(16.1)11109876543210123456789101112131416.1.1 Optimal substructure of activity selectionif 012···n <f n+1(if i j then i )(161)10Then i ≥ j S ij =i k <f k j <f j i <f j z if f 0 ≤ f 1 ≤ f 2 ≤ ≤ f n < f n+1 (if i ≤ j, then f i ≤ f j ) (16.1)Proof If there exists a k ∈S ij , thenf i ≤ s k < f k ≤ s j < f j f i < f j .z But i ≥ j f i ≥ f j . Contradiction.So only need to worry about with 0 ≤i <j ≤ n + 1.S All other are ij S ij16.1.1 Optimal substructure of activity selection11S th t l ti t i l d H 2b b zSuppose that a solution to S ij includes a k . Have 2 sub-prob S ik (start after a i finishes, finish before a k starts)S kj (start after a k finishes, finish before a j starts)zSolution to S ij = (solution to S ik )∪{a k }∪(solution to S kj )Since a k is in neither of the subproblems, and the subproblems are disjoint |solution to S |=|solution to ik |+1+|solution to kj |zdisjoint, | solution to S | = | solution to S ik | + 1 + | solution to S kj | .Optimal substructure: If an optimal solution to S ij includes a k , then the solutions to S ik and S kj used within this solution must be optimal ll (l t d t t)zas well. (use usual cut-and-paste argument).Let A ij = optimal solution to S ij ,so A ij = A ik ∪{a k ∪A kj (16.2)so j {}j ,assuming: S ij is nonempty; and we know a k .()A il iz16.1.2 A recursive solution Let c[i, j ] = size of maximum-size subset of mutually compatible activities inij c[i j]ij 12i ≥ j S ij = c[i, j ] = 0.z S ij .(c[i,j] 表示S ij 相容的最大活动数)If S ij ≠ , suppose that a k is used in a maximum-size subsets of mutually S ij .Then c[i j]=c[i k]+1+c[k j ]zThen c[i, j] = c[i, k] + 1 + c[k, j ] .But of course we don’t know which k to use, and so0if Sij = (16.3)0 , if Sij ,c [i , j ] = max{c [i , k ] + c [k , j ] + 1} , if Sij ⎯ .i <k<j Why this range of k? Because S ij = {a k ∈S: f i ≤ s k < f k ≤ s j } a k can’t be a i or a j .k ija S ∈16.1.3 Converting a DP solution to a greedy solution 0 , if S ij = ,] 13 i < k < j c [i , j ]= max{c [i , k ] + c [k , j ] + 1} , if S ij ⎯ .(16.3)z a k S ijIt may be easy to design an algorithm to the problem based on recurrence(16.3).Di t i l ith (l it ?)zDirect recursion algorithm (complexity?)Dynamic programming algorithm (complexity?)Can we simplify our solution?16.1.3 Converting a DP solution to a greedy solutionTheorem 16.1L t d l t b th ti it i ith th li t fi i h ti 14Let S ij ≠ , and let a m be the activity in S ij with the earliest finish time: f m =min {f k : a k ∈S ij }. Then1. a m is used in some maximum-size subset of mutually compatible activities of S i j .(a m 包含在某个最大相容活动子集中)2. S im = , so that choosing a m leaves S mj as the only nonemptysubproblem.(仅剩下一个非空子问题S mj )p j 1110987654321123456789101112131416.1.3 Converting a DP solution to a greedy solutionTheorem 16.1L t d l t b th ti it i ith th li t fi i h ti 15Let S ij ≠ , and let a m be the activity in S ij with the earliest finish time: f m =min {f k : a k ∈S ij }. Then1. a m is used in some maximum-size subset of mutuallycompatible activities of S i j .(a m 包含在某个最大相容活动子集中)2. S im = , so that choosing a m leaves S mj as the onlynonempty subproblem. (仅剩下一个非空子问题S mj )Proof2. Suppose there is some .Then Then a S ∈i l l m m l m f s f s f f f <<≤<⇒<l ij a s ∈a m . Therefore, there is no .and it has an earlier finish time than , which contradicts our choice ofl imm f limima S S ∈⇒=∅16.1.3 Converting a DP solution to a greedy solutionTheorem 16.1 Let S ij ≠ , and let a m be the activity in S ij with the li t fi i h ti i {f }Th16earliest finish time: f m = min {f k : a k ∈S ij }. Then 1. a m is used in some maximum-size subset of mutuallycompatible activities of S i j .(a m 包含在某个最大相容活动子集中)p j Proof 1. Let A ij be a maximum-size subset of mutually Compatibleactivities in ij Order activities in ij in monotonically increasing activities in S ij . Order activities in A ij in monotonically increasing order of finish time. Let a k be the first activity in A ij .If a k = a m , done (a m is used in a maximum-size subset).a k a mOtherwise construct =A ij }(replace k by )first activity in A ij to finish. f m ≤f k a m doesn’t overlap anything Otherwise, construct B ij A ij -{a k }∪{a m } (replace a k by a m ).Activities in B ij are disjoint. (Activities in A ij are disjoint, a k is the else in ij ).Since |B ij |=ij |and ij is a maximum-size subset,else in B ij ). Since |B ij | |A ij | and A ij is a maximum size subset,so is B ij .16.1.3 Converting a DP solution to a greedy solution 0 , if S ij = ,,j ]= 17 i k k Sc [i , j ]max{c [i , k ] + c [k , j ] + 1} , if S ij ⎯ . a < < ij(16.3)Th 161L t d l t b th ti it iTheorem 16.1 Let S ij ≠ , and let a m be the activity in S ij with the earliest finish time: f m = min {f k : a k ∈S ij }. Then 1. a m is used in some maximum-size subset of mutually ycompatible activities of S i j .(a m 包含在某个最大相容活动子集中)2. S im = , so that choosing a m leaves S mj as the only nonempty b bl 仅剩下个非空子问题zsubproblem. (仅剩下一个非空子问题S mj )This theorem is great:before theoremafter theorem # of sub-prob in optimal solution #of choices to consider 2O (j i 1)11# of choices to considerO (j –i –1)16.1.3 Converting a DP solution to a greedy solutionTheorem 16.1 Let S ij ≠ , and let a m be the activity in S ij with the earliest finish time:=min {f k :k ij }Then18earliest finish time: f m = min {f k : a k ∈S ij }. Then 1. a m is used in some maximum-size subset of mutually compatible activitiesof S i j .(a m 包含在某个最大相容活动子集中)2i = so that choosing leaves j as the only nonempty subproblemz2. S im = , so that choosing a m leaves S mj as the only nonempty subproblem.(仅剩下一个非空子问题S mj )Now we can solve a problem ij in a top-down fashion Now we can solve a problem S ij in a top down fashion Choose a m ∈S ij with earliest finish time: the greedy choice. ( it leaves asmuch opportunity as possible for the remaining activities to be scheduled )(留下尽可能的时间来安排活动,贪心选择)Then solve S mj .z16.1.3 Converting a DP solution to a greedy solutionWhat are the subproblems?19Original problem is S 0,n+1 〔a 0 = [﹣∞, 0); a n+1 = [∞, “∞+1”) 〕Suppose our first choice is a m1 (in fact, it is a 1)Then ne t s bproblem is Then next subproblem isS m1,n+1Suppose next choice is a m2 (it must be a 2?)Next subproblem isS m2,n+1p ,And so on11107893546121234567891011121314z16.1.3 Converting a DP solution to a greedy solutionWhat are the subproblems?20Original problem is S 0,n+1Suppose our first choice is a m1Then next subproblem is m1n+1 Then next subproblem is S m1,n+1Suppose next choice is a m2Next subproblem is S m2,n+1zAnd so onEach subproblem is S mi ,n+1.And the subproblems chosen have finish times that increase zzAnd the subproblems chosen have finish times that increase. (所选的子问题,其完成时间是增序排列)Therefore, we can consider each activity just once, in monotonically increasing order of finish time increasing order of finish time.z 16.1.4 A recursive greedy algorithmOriginal problem is S 0,n+1E h b bl i 21z zEach subproblem is S mi ,n+1Assumes activites already sorted by monotonically increasing finish time. (If not, then sort in O(n lg n) time.) Return an optimal solution for S i,n+1:×a m√a ma ia iREC-ACTIVITY-SELECTOR(s,f,i,n)REC ACTIVITY SELECTOR(s, f, i, n)1 m ← i+12 while m ≤n and s m < f i // Find first activity in S i,n+1.3d 13 do m ← m+14 if m ≤ n5 then return {a m ∪REC-ACTIVITY-SELECTOR(s, f, m, n){}(,f,,)6 else returna 2a 116.1.4 A recursive greedy algorithmREC-ACTIVITY-SELECTOR(s, f, i, n)22(,f,,)1 m ← i+12 while m ≤n and s m < f i // Find first activity in S i,n+1.3do m3 do m ← m+14 if m ≤ n5 then return {a m }∪REC-ACTIVITY-SELECTOR(s, f, m, n)6else return6 else returnz √Initial call: REC-ACTIVITY-SELECTOR(s, f, 0, n).a mza iIdea: The while loop checks a i+1 , a i+2 , . . . , a n untilit finds an activity a m that is compatible with a i (need s m ≥ f i ).If the loop terminates because a m is found (m ≤n), thenrecursively solve S m,n+1, and return this solution, along with a m .If the loop never finds a compatible (m >n)then just returnIf the loop never finds a compatible a m (m > n), then just return empty set.a 2a 116.1.4 A recursive greedy algorithmREC-ACTIVITY-SELECTOR(s, f, i, n)23(,f,,)1 m ← i+12 while m ≤n and s m < f i // Find first activity in S i,n+1.3do m3 do m ← m+14 if m ≤ n5 then return {a m }∪REC-ACTIVITY-SELECTOR(s, f, m, n)6else return z6 else returnTime: Θ(n)—each activity examined exactly once.T (n ) =m 1 + T (n m 1 ) =m 1 + m 2 + T (n m 1 m 2 )123T n 123)= m 1 + m 2 + m 3 + T (n m 1 m 2 m 3 ) = =mk+ T (nm k )b 1 th 1∑k T (1)Θ(…because: nm k = 1, thenm k = n −1, mk + T (1) = n )z 16.1.4 A recursive greedy algorithmInitial call: REC-ACTIVITY-SELECTOR(s, f, 0, n).24zIdea: The while loop checksa i+1 , a i+2 , . . . , a n until it finds an activity that is finds an activity a m that is compatible with a i (need s m ≥ f i ). If the loop terminates because a m is found n)then rec rsi el (m ≤n), then recursively solve S m,n+1, and return thissolution, along witha m .,g If the loop never finds a compatible a m (m > n),h jthen just return empty set.z 16.1.5 An iterative greedy algorithmREC-ACTIVITY-SELECTOR is almost "tail recursive“.We easily can convert the recursive procedure to an iterative one (Some 25zWe easily can convert the recursive procedure to an iterative one. (Some compilers perform this task automatically)a 2a 1GREEDY-ACTIVITY-SELECTOR(s, f, n)1 A ← {a 1}2 i ← 1×a m √a m53 for m ← 2 to n 4 do if s m ≥ f i a i a ithen A ←A ∪{a m }6i ← m // a i is most recent addition to A 7 return AzReviewGreedy Algorithm Idea: When we have a choice to make, make the one that looks best right now Make a locally optimal choice in hope of getting a 26looks best right now. Make a locally optimal choice in hope of getting a globally optimal solution.(希望当前选择是最好的,每一个局部最优选择能产生全局最优选择)zGreedy Algorithm: Simpler, more efficient16Greedy Algorithms z 16 Greedy Algorithms16.1, the activity-selection problem (活动安排)27z ,y p 16.2, basic elements of the GA; knapsack probz(贪婪算法的基本特征;背包问题)16.3, an important application: the design of data compression (Huffman)codes compression (Huffman) codes(哈夫曼编码)162Elements of the greedy strategy z16.2 Elements of the greedy strategyThe choice that seems best at the moment is chosen(每次决策时当前所做的选择看起来是“最好”的)28z(每次决策时,当前所做的选择看起来是“最好”的)What did we do for activity selection?1Determine the optimal substructure 1. Determine the optimal substructure.2. Develop a recursive solution.3. Prove that at any stage of recursion, one of the optimal choices is y g ,pthe greedy choice.4. Show that all but one of the subproblems resulting from the greedy choice are empty. (通过贪婪选择,只有一个子问题非空)5. Develop a recursive greedy algorithm.6C t it t it ti l ith6. Convert it to an iterative algorithm.162Elements of the greedy strategy z 16.2 Elements of the greedy strategyThese steps looked like dynamic programming.29z zTypically, we streamline these steps (简化这些步骤)Develop the substructure with an eye towardmaking the greedy choice,leaving just one subproblem.F ti it l ti h d th t th d h i i li d zFor activity selection, we showed that the greedy choice implied that in S ij , only i varied, and j was fixed at n+1,So we could have started out with a greedy algorithm in mind:zSo, we could have started out with a greedy algorithm in mind:define S i = {a k ∈S : f i ≤ s k }, (所有在a i 结束之后开始的活动)show the greedy choice,first m to finish in show the greedy choice, first a m to finish in S icombined with optimal solution to S moptimal solution to S i .162Elements of the greedy strategy z16.2 Elements of the greedy strategyTypical streamlined steps (简化这些步骤)301. Cast the optimization problem as one in which we make a choice and areleft with one subproblem to solve.(最优问题为:做一个选择,留下一个待解的子问题)(最优问题为:做个选择,留下个待解的子问题)2. Prove that there’s always an optimal solution that makes the greedychoice, so that the greedy choice is always safe.3. Show that greedy choice and optimal solution to subproblem optimal solution to the problem (证明存在一个基于贪婪选择的最优解,因此贪婪选择是安全的)solution to the problem.(说明由贪婪选择和子问题的最优解 原问题的最优解)162Elements of the greedy strategy z 16.2 Elements of the greedy strategyNo general way to tell if a greedy algorithm is 31g y g y g optimal, but two key ingredients are(没有一般化的规则来说明贪婪算法是否最优,但有两个基本要点)1. greedy-choice property (贪婪选择属性)2. optimal substructurez 16.2.1 Greedy-choice propertyA globally optimal solution can be arrived at by making a locally optimal (greedy)choice 32(greedy) choice. (通过局部最优解可导出全局最优解)S i,r-1k i ..k r k r ..k j Dynamic programming k r i j i zDynamic programming S i,j .... Make a choice at each step.S r-1,j k k r-1k r+1k j Choice depends on knowing optimal solutions to subproblems.Solve subproblems first. (依赖于已知子问题的最优解再作出选择) Solve bottom-up.S 0,n+110911z Greedy a m1S m1,n+154678 Make a choice at each step.132Make the choice before solving the subproblems. (先作选择,再解子问题)Solve top-down.pz16.2.1 Greedy-choice property We must prove that a greedy choice at each step yields a globally optimal solution Difficulty!Cleverness may be required!33zsolution. Difficulty! Cleverness may be required!Typically, Theorem 16.1, shows that the solution (A ij ) can be modified to use the greedy choice (a m ), resulting in one similar but smaller subproblem (A mj ).z We can get efficiency gains from greedy-choice property. (For example, inactivity-selection, sorted the activities in monotonically increasing order of finish times needed to examine each activity just once )finish times, needed to examine each activity just once.)Preprocess input to put it into greedy orderz 16.2.2 Optimal substructureoptimal substructure: an optimal solution to the 34problem contains within it optimal solutions to subproblems.Just show that optimal solution to subproblem z p p (说明子问题的最优解和贪婪选择andgreedy choice optimal solution to problem.)原问题的最优解16.2.3 Greedy vs. dynamic programming bread cake 35pizza cellphone camera laptop 0-1knapsack problem 背包问题小偷问题)z0-1 knapsack problem (0-1背包问题,小偷问题)n items (n 个物品)Item i is worth $v i , weighs w i P (物品i 价值v i ,重w i ) ,g Find a most valuable subset of items with total weight ≤W.(背包的最大负载量为W ,如何选取物品,使得背包装的物品价值最大)Have to either take an item or not take it can’t take part of it z Have to either take an item or not take it—can t take part of it.(每个物品是一个整体,不能分割,因此,要么选取该物品,要么不选取)Fractional knapsack problem (分数背包问题,小偷问题)Lik h 01k k bl b k f i f iLike the 0-1 knapsack problem, but can take fraction of an item.z 16.2.3 Greedy vs. dynamic programming 0-1 knapsack problem (0-1背包问题,小偷问题)F ti l k k bl (分数背包问题小偷问题)36zzFractional knapsack problem (分数背包问题,小偷问题)Both have optimal substructure property.0-1 : choose the most valuable load j that weighs w j ≤ W,j g remove j , choose the most valuable load i that weighs w i ≤W-w j fractional:choose a weight w from item j (part of j )then fractional: choose a weight w from item j ( part of j ), then remove the part, the remaining load is the most valuable load weighing at most W-w that the thief can take from the n-1 original items plus w j -w pounds from item j.(若先选item j 的一部分,其重w ,则接下来的最优挑选方案为从余n-1j j -w z 下的n 1 个物品〔除j 外〕和j 的另外重w j w 的部分中挑选,其重量不超过W-w )But the fractional problem has the greedy-choice property, and the 0-1problem does not.p16.2.3 Greedy vs. dynamic programming37z Fractional knapsack problem has the greedy-choice property,FRACTIONAL-KNAPSACK(v,w,W) 1 load ← 0has the greedy choice property, and the 0-1 knapsack problem does not.2 i ← 13 while load < W and i ≤n4 do if w i ≤W -loadz To solve the fractional problem, rank decreasingly items by v i /w iL t//5 then take all of item i6 else take W-load of w i from item i7 add what was taken to load8i1z Let v i /w i ≥v i+1 /w i+18 i ←i + 1for all iz Time: O(nlg n) to sort, O(n) to greedy choice thereafter.z 16.2.3 Greedy vs. dynamic programming 0-1 knapsack problem 38has not the greedy-choice property zW = 50.G d l ti Optimal solution:z z Greedy solution:take items 1 and 2value =160weight =30Optimal solution:Take items 2 and 3value=220, weight=50 value 160, weight 3020 pounds of capacity leftover.No leftover capacity.(没有剩余空间)breadcakepizzacellphone camera laptop16Greedy Algorithms z16 Greedy Algorithms16.1, the activity-selection problem (活动安排)39z,y p 16.2, basic elements of the GA; knapsack prob z (贪婪算法的基本特征;背包问题)16.3, an important application: the design of data compression (Huffman)codes compression (Huffman) codes (哈夫曼编码)163Huffman codes z16.3 Huffman codesHuffman codes: widely used and very effective technique for compressing data 40 zdata.savings of 20% to 90%Consider the data to be a sequence of characters q Abaaaabbbdcffeaaeaeec z Huffman's greedy algorithm:uses a table of the frequencies of occurrence of the characters to build up an optimal way of representing each character as a binary string.p y p g y g(依据字符出现的频率表,使用二进串来建立一种表示字符的最佳方法)163Huffman codes z16.3 Huffman codesWish to store compactly 100,000-character data file 41only six different characters appear. frequency table a b c d e f Frequency (in thousands)4513121695Frequency (in thousands)Fixed-length codeword Variable-length codeword 45 13 12 16000 001 010 011 100 1010 101 100 111 1101 1100zz Many ways (encodes) to represent such a file of information binary character code (or code for short): each character is represented by a unique binary stringunique binary string.fixed-length code: if use 3-bit codeword, the file can be encoded in 300,000bits. Can we do better?163Huffman codes z16.3 Huffman codes100,000-character data file 4295a b c d e f Frequency (in thousands)Fixed-length codeword 45 13 12 16000 001 010 011 100 101z Variable-length codeword 0 101 100 111 1101 1100binary character code (or code for short)variable-length code: by giving frequent characters short codewords and infrequent characters long codewords, here the 1-bit string 0 represents a,and the 4-bit string 1100 represents f. (高频出现的字符以短字码表示;g p 低频→长字码)(45·1 + 13·3 + 12·3 + 16·3 + 9·4 + 5·4) · 1,000 = 224,000 bits163Huffman codes z16.3 Huffman codes100,000-character data file 4395a b c d e f Frequency (in thousands)45 13 12 16Fixed-length codeword Variable-length codeword 000 001 010 011 100 1010 101 100 111 1101 1100z binary character code (or code for short)fixed-length code: 300,000 bitsvariable length code:224000bits a savings of approximately 25%In variable-length code: 224,000 bits, a savings of approximately 25%. In fact, this is an optimal character code for this file.z 16.3.1 Prefix codes prefix codes (prefix-free codes): no codeword is a prefix of some other codeword (字首码前缀代码前置代码〔44codeword. (字首码,前缀代码,前置代码〔前缀无关码〕:没有字码是其他字码的前缀)95a b c d e f Frequency (in thousands)Fixed-length codeword 45 13 12 16000001010011100101zFixed length codeword Variable-length codeword 000 001 010 011 100 1010 101 100 111 1101 1100Encoding is always simple for any binary character code Encoding (编码)is always simple for any binary character code Concatenate (连接)the codewords representing each character. For example, “abc”, with the variable-length fi d 01011000101100h ‘’t z prefix code as 0·101·100 = 0101100, where we use ‘·’ to denote concatenation.Prefix codes simplify decoding (解码)z 16.3.1 Prefix codes prefix codes (prefix-free codes): no codeword is a prefix of some other codeword (字首码前缀代码前置代码〔前缀无关码〕:没有字码是45codeword. (字首码,前缀代码,前置代码〔前缀无关码〕:没有字码是其他字码的前缀)a b c d e f 0zVariable-length codeword 101 100 111 1101 1100Encoding is always simple for any binary character code P fi d i lif d diz Prefix codes simplify decoding Since no codeword is a prefix of any other, the codewordthat begins an encoded file is unambiguous that begins an encoded file is unambiguous (明确的).We can simply identify the initial codeword, translate itback to the original character, and repeat the decoding th i d f th d d filprocess on the remainder of the encoded file.Exam: 001011101 uniquely as 0·0·101·1101, which decodesto “aabe”.to aabe .16.3.1 Prefix codes a b c d e f460 101 100 111 1101 1100001011101uniquely as 0·0·101·1101,which decodes to “aabe”.D di z Decodingthe process needs a convenient representation for theprefix code so that the initial codeword can be easily p ypicked off.(为了使初始字码容易识别,解码过程需要一种前置无关码的方便表示) A binary tree whose leaves are the given charactersprovides one such representation.树是种方便的表示方法树叶为给定字符(二叉树是一种方便的表示方法,树叶为给定字符)16.3.1 Prefix codes a b c d e f470 101 100 111 1101 1100001011101uniquely as 0·0·101·1101,which decodes to “aabe”.z DecodingWe interpret the binary codeword for a character as thepath from the root to that character.(将字符的二叉码表示解释为一条路径:从树根到树叶)not binary search trees since the leaves need not appear innot binary search trees, since the leaves need not appear in sorted order and internal nodes do not contain character keys.(不是二叉搜索树)16.3.1 Prefix codes48An optimal code for a file is always represented by a full binary tree every zAn optimal code for a file is always represented by a full binary tree, every nonleaf node has two children (Ex16.3-1). The fixed-length code in our example is not optimal.We can restrict our attention to full binary treesz We can restrict our attention to full binary trees C is the alphabet,all character frequencies >0th t f ti l fi d h |C|l f h l tt f C the tree for an optimal prefix code has |C| leaves, one for each letter of C ,and exactly |C|-1 internal nodes.16.3.1 Prefix codes 49Compute # of bits required to encode a file T ) f )(165)c CB (T ) = f (c )d T (c ) (16.5)z Given a tree T corresponding to a prefix code, for each character c in thealphabet C,f (c): frequency of c in the file f ()q y d T (c): depth of c’s leaf in the tree (length of the codeword for character c ). Then, # of bits required to encode a filewhich we define as the cost of the tree T.16.3.2 Constructing a Huffman code HUFFMAN(C)1n |C|50Huffman code:a greedy algorithm 1 n ← |C|2 Q ← C3 for i ← 1 to n -14do )a new node that constructs an optimal prefix code4 do allocate (分配) a new node z5 left[z] ← x ← EXTRACT-MIN (Q)6 right[z] ← y ← EXTRACT-MIN (Q)7f [z]←f [x]+f 8z 7 f [z] f [x] f [y]INSERT(Q, z)9 return EXTRACT-MIN(Q) //return the root of the tree.C: set of n characters, c ∈C: an object with frequency f [c].j q y f Build the tree T corresponding to the optimal code.Begin with |C| leaves, perform |C|-1 “merging” operations.A min priority queue Q keyed on f is used to identify the twoA min-priority queue Q, keyed on f , is used to identify the two least-frequent objects to merge together. Result of the merger is a new object whose frequency is the sum of the frequencies of the bj h d two objects that were merged.。