基于 Python 的新浪微博数据爬虫

基于Python的新浪微博用户信息爬取与分析

该爬虫程序的工作流程如图1所示,主要步骤为:

(1)登录微博:新浪微博要求用户访问微博数据之前必须登 录,那么爬虫程序面临的首要任务是模拟登录。本文利用Cookie 的特性,事先通过浏览器的方式,登录新浪微博,并正确输入用户 名、口令,从而事先浏览器的登录;当成功登陆后,新浪微博服务 器会记录登录的状态,经加密后,使用Response的方式,发送给 客户端,从而存储于本地客户端的Cookie中。当本文编写的Pyth o n 爬虫, 需要登录新浪微博时, 首先读取已存储于本地的 C o o k i e , 并发送 给新 浪微 博服 务器。而该 服务 器检 查这个 Cookie,可以认定客户端的合法身份,从而实现用户对新浪微博 的成功登录。(2)访问待抓取页面:该模块访问被抓取微博用户的 各类信息界面,利用Requests库下载待抓取页面的html代码。(3) 下载、解析、抽取信息:使用lxml等python库解析页面,并根据预 先定制的规则,抽取有关信息。(4)根据第(3)步骤的信息提取结 果,如若信息内具有下一次待抓取的页面链接,则回至网页下载 模块,重新进行下载、解析。(5)保存至数据库:待抓取完毕后,将 所有信息保存至数据库。

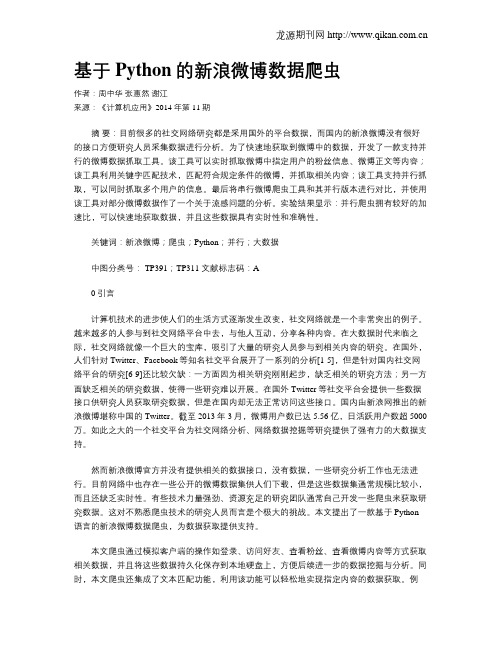

本文使用Python语言,通过模拟用户登录,实现一种针对新浪 微博的爬虫,并对获得的数据进行有效地分析。该文设计并实现了 新浪微博爬虫程序,以微博用户“央视综艺国家宝藏”为例,对他发 布的微博内容进行了全部抓取,并从微博发布行为、微博信息特征、 微博关键词等方面,进行了数据分析,为用户分析与画像打下基础。

本文设计并实现了一个微博用户信息爬取与分析系统利用cookie实现了用户的模拟登录使用python语言的rquestslxml等函数库爬取处理了该微博用户数据并以央视综艺国家宝藏为例从微博发布动作偏好微博信息特征微博关键词等方面展开了分析获取了一些有趣的发现为进一步用户分析与画像打下基础

基于Python的新浪微博数据爬虫

基于Python的新浪微博数据爬虫作者:周中华张惠然谢江来源:《计算机应用》2014年第11期摘要:目前很多的社交网络研究都是采用国外的平台数据,而国内的新浪微博没有很好的接口方便研究人员采集数据进行分析。

为了快速地获取到微博中的数据,开发了一款支持并行的微博数据抓取工具。

该工具可以实时抓取微博中指定用户的粉丝信息、微博正文等内容;该工具利用关键字匹配技术,匹配符合规定条件的微博,并抓取相关内容;该工具支持并行抓取,可以同时抓取多个用户的信息。

最后将串行微博爬虫工具和其并行版本进行对比,并使用该工具对部分微博数据作了一个关于流感问题的分析。

实验结果显示:并行爬虫拥有较好的加速比,可以快速地获取数据,并且这些数据具有实时性和准确性。

关键词:新浪微博;爬虫;Python;并行;大数据中图分类号: TP391;TP311 文献标志码:A0 引言计算机技术的进步使人们的生活方式逐渐发生改变,社交网络就是一个非常突出的例子。

越来越多的人参与到社交网络平台中去,与他人互动,分享各种内容。

在大数据时代来临之际,社交网络就像一个巨大的宝库,吸引了大量的研究人员参与到相关内容的研究。

在国外,人们针对Twitter、Facebook等知名社交平台展开了一系列的分析[1-5],但是针对国内社交网络平台的研究[6-9]还比较欠缺:一方面因为相关研究刚刚起步,缺乏相关的研究方法;另一方面缺乏相关的研究数据,使得一些研究难以开展。

在国外Twitter等社交平台会提供一些数据接口供研究人员获取研究数据,但是在国内却无法正常访问这些接口。

国内由新浪网推出的新浪微博堪称中国的Twitter。

截至2013年3月,微博用户数已达5.56亿,日活跃用户数超5000万。

如此之大的一个社交平台为社交网络分析、网络数据挖掘等研究提供了强有力的大数据支持。

然而新浪微博官方并没有提供相关的数据接口,没有数据,一些研究分析工作也无法进行。

目前网络中也存在一些公开的微博数据集供人们下载,但是这些数据集通常规模比较小,而且还缺乏实时性。

微博爬虫python

微博爬⾍python本⽂爬取的是m站的微博内容,基于python 2.7⼀、微博内容爬取2.⼿机微博是看不到翻页,是⼀直往下加载的,但是其json格式的数据仍然以翻页的形式呈现。

3.打开开发者⼯具,向下翻页⾯,可以在Network下的XHR的响应⽂件中,找到json⽂件的⽹址。

通过分析发现每个JSON页⾯是有规律的,即前⾯的内容都⼀样,只是后⾯的页码不同;每个json页⾯的格式如下:⼀般情况下⼀个json页⾯有11微博评论(我只是查看了⼏个页⾯,所有的页⾯是不是这样,我没有去验证)知道json页⾯的组成规律,我们就可以爬⾍了4.微博内容爬取代码如下:# -*- coding: utf-8 -*-import requestsimport refrom fake_useragent import UserAgentimport pandas as pdua = UserAgent()headers = {'User-Agent':ua.random, # ua.random是随机⽣成⼀个User-Agent'Host': '','Referer': 'https:///p/1005053817188860?sudaref=',}def WriteInCsv(list):df = pd.DataFrame(list, columns=[u'微博内容链接', u'创建时间', u'id', u'微博内容',u'转发数', u'评论数', u'点赞数'])df.to_excel("content.xlsx", encoding="utf_8_sig", index=False)def getMblogContent():list = []bsae_url = 'https:///api/container/getIndex?uid=3817188860&luicode=10000011&lfid=100103type%3D1%26q%3DAlinda&containerid=1076033817188860&page=' for p in range(0, 149):try:url = bsae_url + p.__str__()resp = requests.get(url, headers=headers, timeout=10)JsonData = resp.json()data = JsonData.get('data').get('cards') # cards⾥包含此页⾯的所有微博内容print pfor d in data: # data是列表类型try:scheme = d['scheme']mblog = d['mblog'] # i是字典类型created_at = mblog['created_at'] # mblog也是页⾯⾥的⼀个容器名字,⼀个mblog表⽰⼀个微博id = mblog['idstr']text = re.sub(u"\\<.*?>", "", mblog['text']) # 去除<>标签⾥的内容print textreposts_count = mblog['reposts_count']comments_count = mblog['comments_count']attitudes_count = mblog['attitudes_count']list.append([scheme, created_at, id, text, reposts_count, comments_count, attitudes_count])except:print "error"except:print "打开页⾯错误"return listprint "OK"list = getMblogContent()WriteInCsv(list)5.代码说明:(1)本代码总共⽤了两个try。

pyhton爬虫爬取微博某个用户所有微博配图

pyhton爬⾍爬取微博某个⽤户所有微博配图前⼏天写了个java爬⾍爬花瓣⽹,但是事后总感觉不够舒服,终于在今天下午写了个python爬⾍(爬微博图⽚滴),写完之后就感觉舒服了,果然爬⾍就应该⽤python来写,哈哈(这⾥开个玩笑,⾮引战⾔论)。

话不多说进⼊正题。

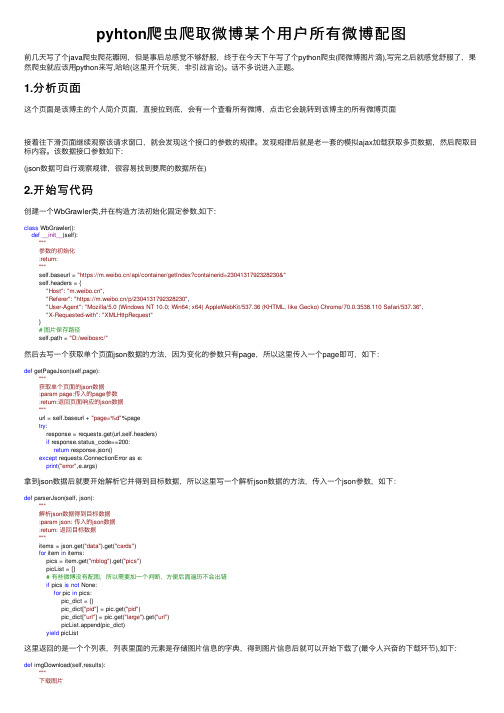

1.分析页⾯这个页⾯是该博主的个⼈简介页⾯,直接拉到底,会有⼀个查看所有微博,点击它会跳转到该博主的所有微博页⾯接着往下滑页⾯继续观察该请求窗⼝,就会发现这个接⼝的参数的规律。

发现规律后就是⽼⼀套的模拟ajax加载获取多页数据,然后爬取⽬标内容。

该数据接⼝参数如下:(json数据可⾃⾏观察规律,很容易找到要爬的数据所在)2.开始写代码创建⼀个WbGrawler类,并在构造⽅法初始化固定参数,如下:class WbGrawler():def__init__(self):"""参数的初始化:return:"""self.baseurl = "https:///api/container/getIndex?containerid=2304131792328230&"self.headers = {"Host": "","Referer": "https:///p/2304131792328230","User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/70.0.3538.110 Safari/537.36","X-Requested-with": "XMLHttpRequest"}# 图⽚保存路径self.path = "D:/weibosrc/"然后去写⼀个获取单个页⾯json数据的⽅法,因为变化的参数只有page,所以这⾥传⼊⼀个page即可,如下:def getPageJson(self,page):"""获取单个页⾯的json数据:param page:传⼊的page参数:return:返回页⾯响应的json数据"""url = self.baseurl + "page=%d"%pagetry:response = requests.get(url,self.headers)if response.status_code==200:return response.json()except requests.ConnectionError as e:print("error",e.args)拿到json数据后就要开始解析它并得到⽬标数据,所以这⾥写⼀个解析json数据的⽅法,传⼊⼀个json参数,如下:def parserJson(self, json):"""解析json数据得到⽬标数据:param json: 传⼊的json数据:return: 返回⽬标数据"""items = json.get("data").get("cards")for item in items:pics = item.get("mblog").get("pics")picList = []# 有些微博没有配图,所以需要加⼀个判断,⽅便后⾯遍历不会出错if pics is not None:for pic in pics:pic_dict = {}pic_dict["pid"] = pic.get("pid")pic_dict["url"] = pic.get("large").get("url")picList.append(pic_dict)yield picList这⾥返回的是⼀个个列表,列表⾥⾯的元素是存储图⽚信息的字典,得到图⽚信息后就可以开始下载了(最令⼈兴奋的下载环节),如下:def imgDownload(self,results):"""下载图⽚:param results::return:"""for result in results:for img_dict in result:img_name = img_dict.get("pid") + ".jpg"try:img_data = requests.get(img_dict.get("url")).content with open(self.path+img_name,"wb") as file:file.write(img_data)file.close()print(img_name+"\tdownload successed!")except Exception as e:print(img_name+"\tdownload failed!",e.args)3.程序的优化def startCrawler(self,page):page_json = self.getPageJson(page)results = self.parserJson(page_json)self.imgDownload(results)if__name__ == '__main__':wg = WbGrawler()pool = threadpool.ThreadPool(10)reqs = threadpool.makeRequests(wg.startCrawler,range(1,5)) [pool.putRequest(req) for req in reqs]pool.wait()4.写在最后。

基于Python的新浪微博爬虫程序设计与实现

基于Python的新浪微博爬虫程序设计与实现孙握瑜(安徽商贸职业技术学院信息与人工智能学院安徽芜湖241000)摘要:在互联网时代,各类新媒体平台出现使得信息数据得到广泛传播。

为加强对新浪微博内容的监管和分析,应对舆情分析的需求,该文主要研究采用Python语言设计新浪微博爬虫程序,在对网络爬虫基本概念和原理研究的基础上,设计了具有配置、爬取、存储、分析这4个功能模块的应用程序,为媒体内容监管和数据分析提供了技术支持。

关键词:Python新浪微博网络爬虫舆情分析中图分类号:TP393.092;TP391.1文献标识码:A文章编号:1672-3791(2022)06(b)-0034-04 Design and Lmplementation of Sina Weibo Crawler ProgramBased on PythonSUN Woyu(School of Information and Artificial Intelligence,Anhui Business College of Vocational Technology,Wuhu,AnhuiProvince,241000China)Abstract:In the Internet era,the emergence of various new media platforms makes information and data widely disseminated.In order to strengthen the management of Sina Weibo information and meet the needs of public opinion analysis,this paper focuses on the design of Sina Weibo crawler program in Python language.Based on the research on the basic concept and principle of web crawler,an application program with four functional modules of configuration,crawling,storage and analysis is designed.It provides technical support for media content manage‐ment and data analysis.Key Words:Python;Sina Weibo;Web crawler;Public opinion analysis随着互联网技术的快速革新,新媒体平台层见叠出,广大网民可以通过互联网平台发表观点和记录日常生活,各类消息事件也得到了广泛传播,为我们带来了信息爆炸的时代,拓宽了广大人民群众的视野,同时也带来了一系列舆情风险。

Python爬虫__微博某个话题的内容数据

Python爬⾍__微博某个话题的内容数据1# -*- coding: utf-8 -*-2# @Time : 2020/8/18 15:393# @Author : Chunfang4# @Email : 3470959534@5# @File : Weibo_content.py6# @Software: PyCharm78from urllib.parse import urlencode9import requests10from pyquery import PyQuery as pq11import time12import os13import csv14import json1516 base_url = 'https:///api/container/getIndex?'1718 headers = {19'Host': '',20'Referer': 'https:///u/2830678474',21'User-Agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_12_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.36', 22'X-Requested-With': 'XMLHttpRequest',23 }24class SaveCSV(object):2526def save(self, keyword_list,path, item):27"""28保存csv⽅法29 :param keyword_list: 保存⽂件的字段或者说是表头30 :param path: 保存⽂件路径和名字31 :param item: 要保存的字典对象32 :return:33"""34try:35# 第⼀次打开⽂件时,第⼀⾏写⼊表头36if not os.path.exists(path):37 with open(path, "w", newline='', encoding='utf-8-sig') as csvfile: # newline='' 去除空⽩⾏38 writer = csv.DictWriter(csvfile, fieldnames=keyword_list) # 写字典的⽅法39 writer.writeheader() # 写表头的⽅法4041# 接下来追加写⼊内容42 with open(path, "a", newline='', encoding='utf-8-sig') as csvfile: # newline='' ⼀定要写,否则写⼊数据有空⽩⾏43 writer = csv.DictWriter(csvfile, fieldnames=keyword_list)44 writer.writerow(item) # 按⾏写⼊数据45print("^_^ write success")4647except Exception as e:48print("write error==>", e)49# 记录错误数据50 with open("error.txt", "w") as f:51 f.write(json.dumps(item) + ",\n")52pass5354def get_page(page,title): #得到页⾯的请求,params是我们要根据⽹页填的,就是下图中的Query String⾥的参数55 params = {56'containerid': '100103type=1&q='+title,57'page': page,#page是就是当前处于第⼏页,是我们要实现翻页必须修改的内容。

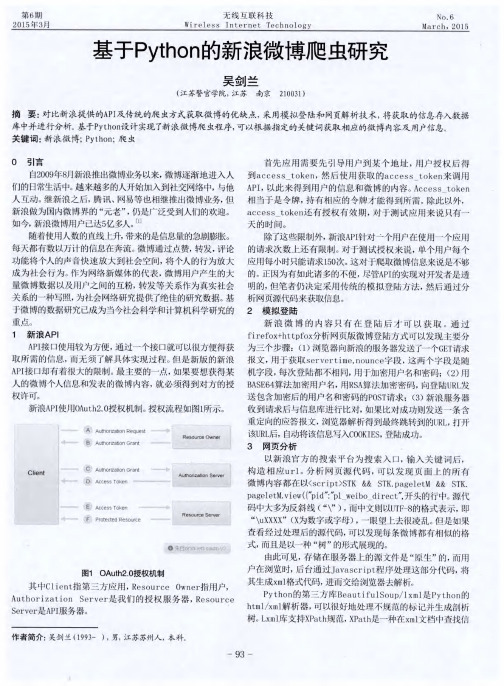

基于Python的新浪微博爬虫研究

文章分析了新浪API的一些认证 限制,新版的API需要被

方法,构建相应的URL来模拟这一滚动过程 。

搜索用户提供相应 的授权 ,因此采用传统爬虫的方 式。然后

4 关 键 词 的提 取

模 拟 登陆 、网页分 析、关键 词 提取等 三个方 面介 绍 了如何 爬 取

这个爬虫程序还有一个可以对爬取 到的微博内容进行分 新浪微博信息,研究用户登陆微博的过程 ,从 网页源代码中

仔 细观察可 以发现 ,每 条微 博都 以<div class=’WB

过 滤 掉之 后 ,可能会 有 多个 词出现 的次 数一 样多,但 这并

cardwrap …>作为起 始,而其 中的<a class=”W texta 不意味着这些词的关键性是一样 的。因此 ,还需要一个重要

w—fb”…>节点含有 昵称 ,<p class=”comment txt”>节点 性调整系数来衡量一个词是不是常见词。如果某个词比较少

出现 ,于是,进行 “词频”(TF)统计。但 是,出现次数最多的

【参考文献】

【1]郭晓云.基于Python和Selenium的新浪微博数据访 问【J].电脑编程技巧与维护,2012. [2]齐鹏,李隐峰,宋玉伟.基于Python的web数据采集技术 [J].电子科技 ,2012. [33]阮二 峰 TF_IDF与余 弦相 似 性 的应 用 【EB/OL】.(2013-03-15).http://www.ruanyifeng.com/blog/2013/03/tf-idf.html

第 6期 2015年 3月

无 线 互 联 科 技 ·计 算 机 世 界

N0.6 MarCh,2015

Python3:一个简单入门的微博网络爬虫

网络上有很多关于Python网络爬虫,但大都是Python2版本,而Python3的版本较少,如果有也会经常有不明就里的错误。

因此小编综合了多个来源程序,终于亲测成功,仅以此分享给需要的朋友。

前期准备本来是想用PC端Sina Weibo API来获取微博内容,但现在新浪微博规定限制太多。

一下是注意事项:该项规定出台,导致你只能爬自己的最新的5条记录,这有什么用,因此果断放弃。

改为爬取移动端的微博,因为移动端的微博可以分页爬取,这就可以一次爬取所有微博内容,这就方便很多。

打开移动端微博网址是:https://;浏览器使用的是:Chrome。

用自己账号登陆请用自己的账号登陆,登陆后,按F12,会出现以下内容找到--Headers--Cookie,把cookie复制到代码中的#your cookie处,待用。

获取你要爬取的用户ID方法是打开用户微博主页,里边有一个u/XXXXXX(一串数字);这串数字就是该用户的ID。

以范冰冰为例,uid=3952070245前期工作已经准备完成,后边开始撸代码了。

载入需要Python模块Python需要的模块如下,这部分不是重点,因此就不细讲,大家可以搜索一下如何下载相关模块。

简单的就是pip install模块名。

或者从官网上下载模块,本地安装。

输入用ID和设置Cookie本次爬取的是范冰冰原创微博(因此转发的不在此列),cookie请大家使用自己的地址。

另外pageNum是总共页数,范冰冰截止目前为56页。

urllist_set 储存爬取的url地址。

爬取具体微博内容和图片为了快速展示,本次仅爬取了前4页内容。

爬取内容保存将爬取的微博内容储存在到相关目录,本次储存在以uid的文件中。

需要注意的是因为Python3升级后,写入文件不支持‘str’,因此需要转换以下,用bytes 函数转换成字节。

微博内容结果如下同时也将爬取的相关图片的URL地址保存下来。

图片URL相关结果如下:将爬取的图片下载保存本地。

如何通过Python进行微博数据分析

话题和趋势分析

话题发现:通过关键词提取和情感 分析,确定微博中的热门话题和趋 势

传播路径:分析微博的转发和评论 关系,揭示信息的传播路径和影响 力

添加标题

添加标题

添加标题

添加标题

用户画像:基于用户行为和社交网 络分析,构建用户画像,了解用户 特征和喜好

话题演化:对热点话题进行时间序 列分析,研究话题的发展和演化趋 势

例

散点图:用于 展示两个变量

之间的关系

数据可视化技巧和注意事项

选择合适的图表类型:根据数据特点和需求选择合适的图表类型,如折线图、柱状图、饼图等。 色彩搭配:使用对比鲜明的色彩,提高图表的可读性和视觉效果。 数据标签:在图表中添加数据标签,使数据更加直观易懂。 图表布局:合理安排图表元素的位置和大小,使其更加美观易读。

选择合适的图表 类型:根据数据 的特点和需求选 择合适的图表类 型,如折线图、 柱状图、散点图

等。

调整图表样式和 细节:使用

matplotlib的函 数调整图表的样 式和细节,如颜 色、字体、标签

等。

可视化图表类型选择

柱状图:用于 比较不同类别

之间的数据

折线图:用于 展示数据随时 间变化的趋势

饼图:用于表 示各部分在整 体中所占的比

数据来源:必须合 法合规,禁止非法 爬取或窃取数据

用户隐私:严格保 密,不得泄露用户 个人信息

授权协议:在使用 数据前需与数据提 供方签订明确的授 权协议

责任与义务:在使用数 据时必须遵守法律法规 和伦理规范,确保数据 的安全与合规性

数据安全存储和传输

数据加密:使用 加密技术对数据 进行保护,确保 数据在存储和传 输过程中的安全

添加标题

添加标题

使用python抓取新浪微博数据

使用python抓取新浪微博数据本篇文章是python爬虫系列的第四篇,介绍如何登录抓取新浪微博的信息。

并对其中的关键内容进行提取和清洗。

开始前的准备工作首先是开始之前的准备工作,与前面的文章相比,我们除了导入库文件,还把设置登录页URL,以及登录用户密码也放在了准备工作中。

下面分别来说明。

导入所需的库文件,第一个是requests,用于请求和页面抓取,第二个是re正则库,用于从页面的代码中提取所需要的信息。

第三个是pandas库,用来进行拼表以及数据导出。

#导入requests库(请求和页面抓取)import requests#导入正则库(从页面代码中提取信息)import re#导入pandas库(用于创建数据表和导出csv)import pandas as pd#设置登陆用户名和密码payload = {'username': '用户名','password': '密码'}#微博登陆页URLurl1='https:///signin/login'#微博内容抓取页URLurl2='/askcliff/home'准备工作完成后,还需要对爬虫进行伪装,下面是具体的步骤和内容。

将爬虫伪装成浏览器首先是设置头文件信息,里面包括浏览器的信息和字符编码以及引荐来源信息等等。

这些信息的获得方法请参考本系列第三篇文章的内容。

#设置请求头文件信息headers = {'User-Agent':'Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.11 (KHTML, like Gecko) Chrome/23.0.1271.64 Safari/537.11','Accept':'text/html;q=0.9,*/*;q=0.8','Accept-Charset':'ISO-8859-1,utf-8;q=0.7,*;q=0.3','Accept-Encoding':'gzip','Connection':'close','Referer':'/'}设置Cookie的内容,获得cookie值的内容也请参考第三篇文章的内容。

Python网络爬虫的博客与微博数据采集

Python网络爬虫的博客与微博数据采集Python网络爬虫具有强大的数据采集能力,可以从互联网上的各种网站上抓取并解析数据。

在本文中,我们将重点介绍Python网络爬虫在博客与微博数据采集方面的应用。

一、博客数据采集博客是一个非常丰富的信息平台,包含了大量的文章、评论、标签等内容。

通过爬取博客网站的数据,我们可以进行文章的分析、评论的情感分析、标签的统计等工作。

1. 确定目标网站首先,我们需要确定需要采集数据的博客网站。

比如我们选择了一个名为“Python博客”的网站。

2. 分析网站结构在进行数据采集之前,我们需要分析目标网站的结构,确定需要采集的数据所在的位置。

常见的分析工具有XPath和BeautifulSoup等。

3. 编写爬虫程序根据分析结果,我们可以编写爬虫程序,通过发送HTTP请求,获取博客网站的内容,并使用相应的解析库进行数据的提取和处理。

4. 数据存储与分析的数据分析和使用。

此外,我们还可以对数据进行清洗和处理,以满足实际需求。

二、微博数据采集微博是一个热门的社交媒体平台,其中包含了大量的用户信息、微博内容、评论等数据。

通过爬取微博数据,我们可以进行用户行为分析、舆情监测等工作。

1. 获取用户信息在进行微博数据采集之前,我们首先需要获取用户的授权,以获取其信息和微博数据。

可以通过微博开放平台提供的API来完成用户授权和数据的获取。

2. 分析微博结构在获取用户授权后,我们可以通过API来获取用户的微博内容、评论等数据。

根据需要,我们可以分析微博的结构,确定需要采集的数据所在的位置。

3. 编写爬虫程序根据分析结果,我们可以编写爬虫程序,通过API发送请求,获取微博数据,并使用相应的解析库进行数据的提取和处理。

4. 数据存储与分析的数据分析和使用。

我们可以对微博数据进行情感分析、关键词提取等处理,以挖掘有价值的信息。

总结:通过Python网络爬虫,我们可以方便地进行博客和微博数据的采集与分析。

Python爬虫爬取新浪微博内容示例【基于代理IP】

Python爬⾍爬取新浪微博内容⽰例【基于代理IP】本⽂实例讲述了Python爬⾍爬取新浪微博内容。

分享给⼤家供⼤家参考,具体如下:⼀般做爬⾍爬取⽹站,⾸选的都是m站,其次是wap站,最后考虑PC站。

当然,这不是绝对的,有的时候PC站的信息最全,⽽你⼜恰好需要全部的信息,那么PC站是你的⾸选。

⼀般m站都以m开头后接域名,所以本⽂开搞的⽹址就是 。

前期准备1.代理IP2.抓包分析通过抓包获取微博内容地址,这⾥不再细说,不明⽩的⼩伙伴可以⾃⾏百度查找相关资料,下⾯直接上完整的代码完整代码:# -*- coding: utf-8 -*-import urllib.requestimport json#定义要爬取的微博⼤V的微博IDid='1259110474'#设置代理IPproxy_addr="122.241.72.191:808"#定义页⾯打开函数def use_proxy(url,proxy_addr):req=urllib.request.Request(url)req.add_header("User-Agent","Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/49.0.2623.221 Safari/537.36 SE 2.X MetaSr 1.0")proxy=urllib.request.ProxyHandler({'http':proxy_addr})opener=urllib.request.build_opener(proxy,urllib.request.HTTPHandler)urllib.request.install_opener(opener)data=urllib.request.urlopen(req).read().decode('utf-8','ignore')return data#获取微博主页的containerid,爬取微博内容时需要此iddef get_containerid(url):data=use_proxy(url,proxy_addr)content=json.loads(data).get('data')for data in content.get('tabsInfo').get('tabs'):if(data.get('tab_type')=='weibo'):containerid=data.get('containerid')return containerid#获取微博⼤V账号的⽤户基本信息,如:微博昵称、微博地址、微博头像、关注⼈数、粉丝数、性别、等级等def get_userInfo(id):url='https:///api/container/getIndex?type=uid&value='+iddata=use_proxy(url,proxy_addr)content=json.loads(data).get('data')profile_image_url=content.get('userInfo').get('profile_image_url')description=content.get('userInfo').get('description')profile_url=content.get('userInfo').get('profile_url')verified=content.get('userInfo').get('verified')guanzhu=content.get('userInfo').get('follow_count')name=content.get('userInfo').get('screen_name')fensi=content.get('userInfo').get('followers_count')gender=content.get('userInfo').get('gender')urank=content.get('userInfo').get('urank')print("微博昵称:"+name+"\n"+"微博主页地址:"+profile_url+"\n"+"微博头像地址:"+profile_image_url+"\n"+"是否认证:"+str(verified)+"\n"+"微博说明:"+description+"\n"+"关注⼈数:"+str(guanzhu)+"\n"+"粉丝数:"+str(fensi)+"\n"+"性别:"+gender+"\n"+"微#获取微博内容信息,并保存到⽂本中,内容包括:每条微博的内容、微博详情页⾯地址、点赞数、评论数、转发数等def get_weibo(id,file):i=1while True:url='https:///api/container/getIndex?type=uid&value='+idweibo_url='https:///api/container/getIndex?type=uid&value='+id+'&containerid='+get_containerid(url)+'&page='+str(i)try:data=use_proxy(weibo_url,proxy_addr)content=json.loads(data).get('data')cards=content.get('cards')if(len(cards)>0):for j in range(len(cards)):print("-----正在爬取第"+str(i)+"页,第"+str(j)+"条微博------")card_type=cards[j].get('card_type')if(card_type==9):mblog=cards[j].get('mblog')attitudes_count=mblog.get('attitudes_count')comments_count=mblog.get('comments_count')created_at=mblog.get('created_at')reposts_count=mblog.get('reposts_count')scheme=cards[j].get('scheme')text=mblog.get('text')with open(file,'a',encoding='utf-8') as fh:fh.write("----第"+str(i)+"页,第"+str(j)+"条微博----"+"\n")fh.write("微博地址:"+str(scheme)+"\n"+"发布时间:"+str(created_at)+"\n"+"微博内容:"+text+"\n"+"点赞数:"+str(attitudes_count)+"\n"+"评论数:"+str(comments_count)+"\n"+"转发数:"+str(reposts_count)+"\n")i+=1else:breakexcept Exception as e:print(e)passif __name__=="__main__":file=id+".txt"get_userInfo(id)get_weibo(id,file)爬取结果更多关于Python相关内容可查看本站专题:《》、《》、《》、《》、《》、《》及《》希望本⽂所述对⼤家Python程序设计有所帮助。

使用Python网络爬虫进行社交网络数据分析与挖掘

使用Python网络爬虫进行社交网络数据分析与挖掘社交网络成为了人们日常生活中不可或缺的一部分,人们在社交平台上分享信息、交流观点、发布动态。

这些数据蕴藏着丰富的信息,通过使用Python网络爬虫工具,我们可以对社交网络数据进行分析与挖掘,从中获取有价值的信息。

本文将介绍使用Python网络爬虫进行社交网络数据分析与挖掘的方法与技巧。

一、爬取社交网络数据要进行社交网络数据分析与挖掘,首先需要收集相关的数据。

使用Python网络爬虫可以方便地从社交平台上爬取数据。

以微博为例,我们可以使用Python中的第三方库,如BeautifulSoup、Scrapy等,通过模拟用户登录、模拟请求等方式,获取微博用户的个人资料、微博动态、关注列表等数据。

二、数据清洗与预处理爬取到的社交网络数据通常包含大量的噪音和冗余信息,需要进行清洗与预处理。

可以使用Python中的字符串处理函数、正则表达式等工具,去除无关信息,提取目标数据。

另外,还可以使用Python中的自然语言处理库,对文本数据进行分词、词性标注等操作,便于后续的分析和挖掘。

三、社交网络关系分析社交网络中用户之间的关系密切相关,通过网络爬虫获取到的数据中包含了用户之间的关注关系、好友关系等信息。

可以使用Python中的图论与网络分析库,如NetworkX、python-louvain等,对社交网络数据进行关系分析。

通过分析社交网络中的节点度中心性、介数中心性等指标,可以了解用户之间的关系紧密程度,还可以通过社区发现算法找出用户之间的社交圈子。

四、情感分析与用户行为挖掘社交网络上的用户行为和情感信息也是数据分析的重要内容。

使用Python中的机器学习库,如scikit-learn、NLTK等,可以进行情感分析。

通过分析用户发布的文本内容,可以判断用户的情感倾向,了解用户对于不同话题的态度与情感。

此外,还可以通过分析用户的行为数据,如发布频率、互动频率等,挖掘用户的行为模式,帮助企业或组织进行用户画像与行为预测。

基于Python的新浪微博爬虫程序设计与研究

2020年第4期信息与电脑China Computer & Communication数据库技术基于Python 的新浪微博爬虫程序设计与研究毕志杰 李 静(南京森林警察学院,江苏 南京 210023)摘 要:随着大数据时代的到来和数据挖掘技术的发展,各类数据都变得愈发重要。

在自媒体发展的热潮中,新浪微博已成为国内最大的社交媒体之一。

网民们可以在微博上以文字、图片、视频等形式发布微博,实现信息的即时分享、传播互动。

如何获取这些非结构化形式的数据并存储以便后续利用是一个挑战。

笔者阐述了新浪微博数据爬取的方式,并模拟登录新浪微博、验证码识别、对网页进行解析、对爬取的数据进行保存和处理。

关键词:网络爬虫;新浪微博;Python中图分类号:TP393.092;TP391.1 文献标识码:A 文章编号:1003-9767(2020)04-150-03Design and Research of Crawler Program of Sina Weibo Based on PythonBi Zhijie, Li Jing(Nanjing Forest Police College, Nanjing Jiangsu 210023, China)Absrtact: With the advent of the era of big data and the development of data mining technology, all kinds of data have becomeincreasingly important. In the upsurge of self media development, Sina Weibo has become one of the largest social media in China. Netizens can publish microblogs in the form of words, pictures, videos, etc. on microblogs to realize instant information sharing, communication and interaction. How to get the unstructured data and store it for future use is a challenge. The author expounds the way of data crawling of sina Weibo, and simulates the login of sina Weibo, the identification of verification code, the analysis ofwebpage, the preservation and processing of crawling data.Key words: web crawler; sina weibo; python0 引言新浪微博自2009年正式投入使用以来,活跃用户就一直保持着爆发式增长。

Python网络爬虫中的微博微信与QQ数据抓取

Python网络爬虫中的微博微信与QQ数据抓取数据在当今的信息时代扮演着至关重要的角色,越来越多的人开始关注和利用这些宝贵的数据。

在网络爬虫领域,Python作为一种强大而灵活的编程语言,广泛应用于数据抓取和处理。

本文将介绍Python 网络爬虫中如何抓取微博、微信和QQ等平台的数据。

一、微博数据抓取1.1 登录微博平台为了抓取微博数据,首先需要登录到微博平台。

可以使用Python的模拟登录技术,模拟浏览器行为,通过输入用户名和密码进行登录。

1.2 抓取微博用户信息登录成功后,可以通过微博的API接口获取微博用户的信息,包括用户的基本信息、关注列表、粉丝列表、微博内容等。

通过请求API 的方式,可以将用户信息以JSON格式返回,并进一步解析和存储。

1.3 抓取微博话题和热门微博除了抓取用户信息,还可以抓取微博中的话题和热门微博。

通过解析微博页面的HTML结构,提取相关的信息,例如话题的名称、热门微博的内容和评论等。

二、微信数据抓取2.1 获取微信公众号信息对于微信数据的抓取,首先需要获取微信公众号的信息。

可以通过微信公众平台的API接口获取公众号的基本信息,包括公众号的名称、认证状态、文章数量等。

2.2 抓取微信文章内容登录微信公众平台后,可以通过API接口抓取微信文章的内容。

可以根据关键词搜索,获取与关键词相关的文章,进一步解析和提取文章的标题、作者、发布时间、内容等信息。

2.3 自动回复和发布文章利用Python的机器学习和自然语言处理技术,可以实现微信公众号的自动回复和文章的智能发布。

通过训练机器学习模型,可以根据用户的提问和关键词等进行智能回复,提高用户体验。

三、QQ数据抓取3.1 登录QQ空间QQ空间是一个用户交流和分享的社交平台,也是一个抓取数据的重要来源。

通过模拟登录QQ空间,可以获取用户的基本信息、好友列表、说说、日志、相册等数据。

3.2 抓取QQ说说和日志在QQ空间中,说说和日志是用户最常用的功能之一。

Python网络爬虫的数据爬取与分析案例分享

Python网络爬虫的数据爬取与分析案例分享网络爬虫是一种自动化程序,能够浏览网络并从网页上提取数据。

Python作为一种强大的编程语言,拥有许多优秀的库和工具,使得编写网络爬虫变得更加简单和高效。

本文将分享一些Python网络爬虫的实际案例,介绍数据爬取和分析的过程。

案例一:豆瓣电影Top250数据爬取与分析1. 数据爬取通过Python的requests库和BeautifulSoup库,我们可以很容易地从豆瓣电影的网页上获取电影的信息,包括电影名称、评分、导演、演员等。

首先,我们发送HTTP请求获取网页的HTML源码,然后使用BeautifulSoup库解析HTML文档,提取所需的数据。

2. 数据分析获得数据后,我们可以使用Python的pandas库进行数据分析。

首先,我们将获取的数据存储到DataFrame对象中,然后使用pandas提供的各种函数和方法进行分析。

例如,我们可以计算电影的平均评分、导演的作品数量、演员的出演次数等等。

案例二:新浪微博用户数据爬取与分析1. 数据爬取新浪微博是中国最大的社交媒体平台之一,拥有庞大的用户群体和海量的数据资源。

利用Python的requests库和正则表达式,我们可以编写爬虫程序来获取新浪微博用户的基本信息、微博内容、转发和评论等数据。

通过模拟登录和浏览器行为,我们可以克服网站的反爬虫机制,有效地获取所需的数据。

2. 数据分析得到微博用户的数据后,我们可以使用Python的matplotlib库和seaborn库进行数据可视化和分析。

例如,我们可以绘制用户粉丝数和关注数的分布图、分析用户的发博频率和转发评论数的关系等等。

这些分析结果有助于了解用户行为特征和社交网络结构。

案例三:知乎用户话题关注数据爬取与分析1. 数据爬取知乎是一个知识分享社区,用户可以关注感兴趣的话题,并在话题下发布问题和回答。

通过Python的Selenium库和ChromeDriver,我们可以模拟人的浏览行为,自动登录知乎并获取话题下用户的关注数据。

基于Python的新浪微博数据爬虫程序设计

基于Python的新浪微博数据爬虫程序设计

陈琳;任芳

【期刊名称】《信息系统工程》

【年(卷),期】2016(0)9

【摘要】为了快速地获取到海量微博中的数据,根据微博网页的特点,提出了一种基于Python爬虫程序设计方法.通过模拟登录新浪微博,实时抓取微博中指定用户的微博正文等内容;该工具利用关键词匹配技术,匹配符合规定条件的微博,并抓取相关内容;最后使用该工具对部分微博数据作了一个关于雾霾问题的分析.实验结果表明:本程序具有针对性强、数据采集速度快、易嵌入开发、简单等优点,为不善于编程的研究者提供了快速获取微博的方法,有利于对微博的后续数据挖掘研究.

【总页数】3页(P97-99)

【作者】陈琳;任芳

【作者单位】四川省气象台;陕西省气象服务中心

【正文语种】中文

【相关文献】

1.基于Python的新浪微博数据爬虫 [J], 周中华;张惠然;谢江

2.基于Python的股票数据爬虫程序设计 [J], 彭莉

3.基于Python的网络数据爬虫程序设计 [J], 张艳; 吴玉全

4.基于Python的新浪微博爬虫程序设计与研究 [J], 毕志杰; 李静

5.基于Python的微博数据爬虫程序设计研究 [J], 王英杰

因版权原因,仅展示原文概要,查看原文内容请购买。